Lernpfad

Hadoop-Experten schreiben Programme und checken ständig wechselnde Daten, um Erkenntnisse zu gewinnen und die Datensicherheit zu gewährleisten. Deshalb haben Personalchefs strenge Kriterien, um den besten Kandidaten für die Stelle zu finden, und können dir alle möglichen Fragen stellen, von einfachen bis hin zu anspruchsvollen.

In diesem Artikel haben wir die 24 häufigsten Fragen und Antworten zu Hadoop aus Vorstellungsgesprächen zusammengestellt.

Dieser Artikel soll dir dabei helfen, dich gründlich auf dein nächstes Vorstellungsgespräch im Bereich Big Data vorzubereiten. Es geht um grundlegende Konzepte und fortgeschrittene Szenarien. Egal, ob du Anfänger oder erfahrener Profi bist, hier findest du wertvolle Einblicke und praktische Infos, die dein Selbstvertrauen stärken und deine Erfolgschancen verbessern.

Grundlegende Fragen zum Thema Hadoop

Interviewer fangen ein Interview meistens mit einfachen Fragen an, um zu sehen, wie gut du Hadoop verstehst und wie wichtig es für die Verwaltung von Big Data ist.

Auch wenn du ein erfahrener Ingenieur bist, solltest du sicherstellen, dass du diese Fragen beantwortet hast.

1. Was ist Big Data?

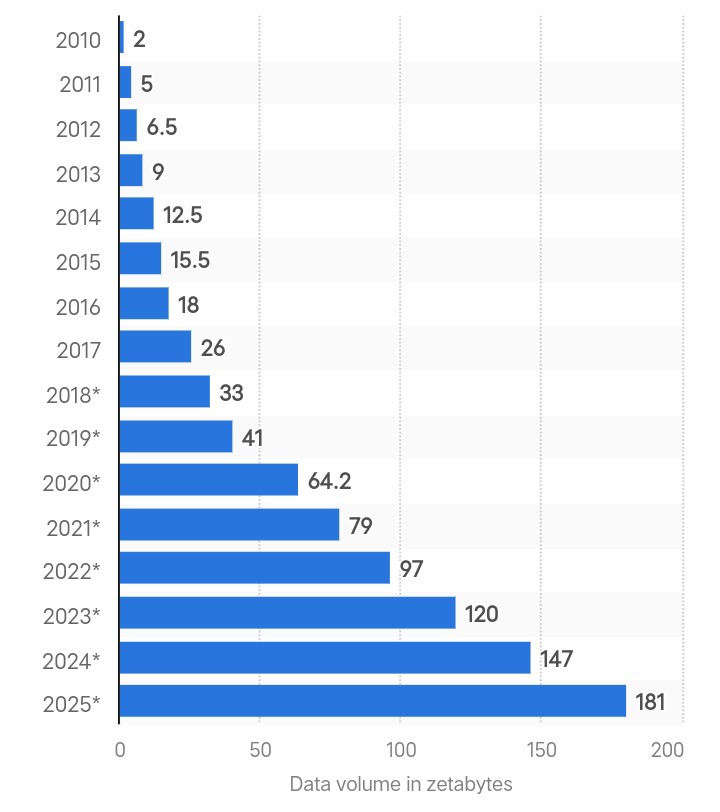

Globale Datenerstellung in Zettabyte. Quelle: Statista.

Big Data ist der Begriff für riesige Mengen komplexer Daten, die schnell aus vielen Quellen zusammenkommen. Die Menge an Daten, die weltweit erstellt wurde, lag 2025 bei 180 Zettabyte und soll sich bis 2029 verdreifachen.

Da immer mehr Daten anfallen, werden die alten Analysemethoden nicht mehr ausreichen, um Echtzeitverarbeitung und Datensicherheit zu gewährleisten. Deshalb nutzen Firmen moderne Frameworks wie Hadoop, um die immer größer werdenden Datenmengen zu verarbeiten und zu verwalten.

Wenn du deine Karriere im Bereich Big Data starten willst, schau dir unseren Leitfaden zur Big-Data-Ausbildung an.

2. Was ist Hadoop und wie löst es das Problem von Big Data?

Hadoop ist ein Open-Source-Framework für die Verarbeitung großer Datensätze, die auf mehrere Computer verteilt sind. Es speichert Daten über mehrere Maschinen hinweg als kleine Blöcke mithilfe des Hadoop Distributed File System (HDFS).

Mit Hadoop kannst du einem Cluster mehr Knoten hinzufügen und große Datenmengen verarbeiten, ohne teure Hardware-Upgrades machen zu müssen.

Sogar große Firmen wie Google und Facebook nutzen Hadoop, um täglich Terabytes bis Petabytes an Daten zu verwalten und zu analysieren.

3. Was sind die beiden Hauptkomponenten von Hadoop?

Hier sind die beiden Hauptkomponenten von Hadoop:

- Hadoop Distributed File System (HDFS): Es kümmert sich um die Datenspeicherung, indem es große Dateien in Blöcke aufteilt, die standardmäßig jeweils 128 MB groß sind, und verteilt sie auf mehrere Knoten in einem Cluster.

- MapReduce: Es ist ein Programmiermodell, auf das Hadoop bei der Datenverarbeitung setzt. Es ist ein zweistufiger Prozess, bei dem Jobs zugeordnet und reduziert werden. Beim Mapping werden die Daten genommen und in einen anderen Datensatz umgewandelt. Der Reducer nimmt die vom Map-Job ausgegebenen Wertepaare als Input und macht daraus kleinere Paare. Das Ziel ist, sie in eine selbst definierte Reduzierungsfunktion zu packen.

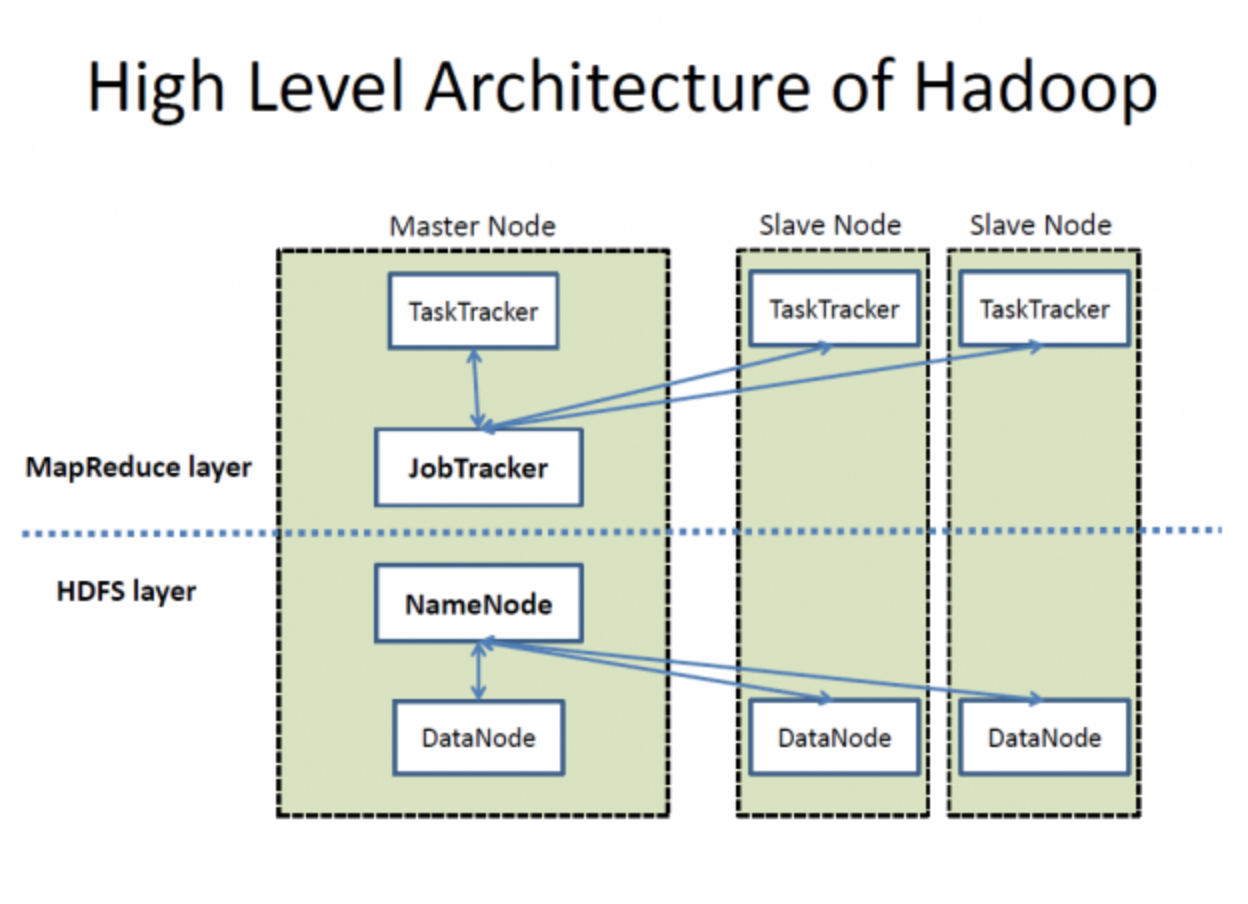

Die Architektur von Hadoop auf hoher Ebene. Quelle: Wikimedia Commons

4. Erkläre mal, was NameNode und DataNode in Hadoop machen.

HDFS besteht aus einem NameNode und mehreren DataNodes für die Datenverwaltung, wie in der Abbildung oben zu sehen ist. So funktionieren sie:

- Als Hauptserver in HDFS kümmert sichNameNode um Sachen wie das Öffnen, Schließen und Umbenennen von Dateien. Es speichert Metadaten zu Berechtigungen und wo die Blöcke sind.

- DataNodes fungieren dagegen als Worker-Knoten, um die eigentlichen Datenblöcke einer Datei zu speichern. Wenn ein Client Daten lesen oder schreiben muss, holt er sich die Position der Datenblöcke von den NameNodes. Danach redet der Client direkt mit den richtigen DataNodes, um die benötigten Vorgänge zu machen.

5. Erkläre mal, was Hadoop YARN macht.

In Hadoop 1.x kümmert sich MapReduce mit JobTracker um die Verwaltung der Ressourcen und die Planung der Jobs. Die langsame Verarbeitung ist allerdings ein ziemlicher Nachteil.

Hadoop 2.0 hat YARN (Yet Another Resource Negotiator) eingeführt, um diese Probleme zu lösen. YARN trennt die Ressourcenverwaltung und die Jobplanung in separate Komponenten, was die Skalierbarkeit und die Ressourcennutzung verbessert. Die Hauptkomponenten von YARN sind:

- ResourceManager (RM): Verwalte die Ressourcen im ganzen Cluster.

- NodeManager (NM): Verwalte die Ressourcen und überwachst einzelne Knoten.

- ApplicationMaster (AM): Verwalten den Lebenszyklus von Anwendungen, einschließlich ihrer Ressourcenanforderungen und Ausführung.

So funktioniert YARN:

- Auftragseinreichungs: Der Kunde schickt eine Anfrage an den YARN-Cluster.

- Ressourcenverteilungs: Der ResourceManager fängt an, Ressourcen zuzuweisen, indem er sich mit dem ApplicationMaster abspricht.

- Anmeldung bei ApplicationMaster: Der ApplicationMaster meldet sich beim ResourceManager an.

- Container-Verhandlungs: Der ApplicationMaster holt sich Ressourcen (Container) vom ResourceManager.

- Container-Start: Sobald die Ressourcen verteilt sind, sagt der ApplicationMaster den NodeManagern, dass sie Container starten sollen.

- Anwendungsausführungs: Der Anwendungscode läuft in den zugewiesenen Containern.

Fragen für Fortgeschrittene zum Thema Hadoop

Die Zwischenfragen konzentrieren sich mehr darauf, dein Wissen über die technischen Details des Hadoop-Frameworks zu checken. Der Interviewer kann dich zum Hadoop-Cluster, seinen Herausforderungen und dem Vergleich verschiedener Versionen fragen.

6. Was ist ein Hadoop-Cluster und gibt's eine bestimmte Clustergröße, die Unternehmen bevorzugen?

Ein Hadoop-Cluster ist eine Gruppe von miteinander verbundenen Master- und Slave-Knoten, die dafür gemacht sind, große Datensätze verteilt zu speichern und zu verarbeiten. Die Cluster-Architektur sorgt für hohe Verfügbarkeit, Skalierbarkeit und Ausfallsicherheit.

Teile eines Hadoop-Clusters:

- Master-Knoten: Diese Knoten kümmern sich um die Ressourcen des Clusters und das verteilte Dateisystem. Die wichtigsten Teile sind:

- NameNode: Verwalte den Hadoop Distributed File System (HDFS)-Namensraum und regle den Zugriff auf Dateien durch Clients.

- ResourceManager: Kümmert sich um die Verteilung der Ressourcen für laufende Anwendungen.

- Slave-Knoten: Diese Knoten sind dafür zuständig, Daten zu speichern und Berechnungen durchzuführen. Die wichtigsten Teile sind:

- DataNode-: Speichert die echten Datenblöcke in HDFS.

- NodeManager-: Verwalte die Ausführung von Containern auf dem Knoten.

Es gibt zwei Hauptmethoden, um einen Hadoop-Cluster einzurichten:

- Lokale Cluster: Bau deinen Cluster mit handelsüblichen Hardwarekomponenten. Dieser Ansatz kann echt kostengünstig sein und ganz nach den spezifischen Anforderungen angepasst werden.

- Cloud-basiertes Cluster-: Entscheide dich für Cloud-basierte Dienste wie Amazon EMR, Google Cloud Dataproc oder Azure HDInsight. Diese Methode ist flexibel, skalierbar und spart Verwaltungsaufwand.

Vergleich zwischen lokalen und Cloud-basierten Clustern:

|

Feature |

Lokaler Cluster |

Cloud-basierter Cluster |

|

Einrichtungskosten |

Höhere Anfangsinvestition |

Umlageverfahren |

|

Skalierbarkeit |

Durch die physische Hardware eingeschränkt |

Praktisch unbegrenzt |

|

Wartung |

Muss intern verwaltet werden |

Vom Cloud-Anbieter verwaltet |

|

Flexibilität |

Anpassbare Hardware und Software |

Vorkonfigurierte Optionen |

|

Bereitstellungszeit |

Längere Einrichtungszeit |

Schnelle und einfache Bereitstellung |

Es gibt keine bestimmte Vorliebe für die Clustergröße. Die Clustergröße ist einfach skalierbar und hängt komplett von den Speicheranforderungen ab. Kleine Firmen nutzen vielleicht Cluster mit etwa 20 Knoten, während Unternehmen wie Yahoo auf Clustern mit bis zu 40.000 Knoten laufen (oder früher gelaufen sind).

7. Was sind ein paar Projekte im Hadoop-Ökosystem?

Verschiedene Branchen haben ganz bestimmte Anforderungen an die Datenanalyse und -verarbeitung. Also hat Hadoop viele Projekte rausgebracht, um Lösungen anzubieten, die genau auf sie zugeschnitten sind, als Teil seines Ökosystems. Die Liste der Hadoop-Projekte ist länger, als du dir vorstellen kannst – aber hier sind die wichtigsten:

- MapReduce: Ein Programmiermodell für die Verarbeitung großer Datensätze mit einem parallelen, verteilten Algorithmus.

- Apache Hive-: Eine Data-Warehouse-Infrastruktur für die Zusammenfassung, Abfrage und Analyse von Daten mit HiveQL.

- Apache HBase: Ein skalierbarer Big-Data-Speicher, der Echtzeit-Lese-/Schreibzugriff auf große Datensätze bietet.

- Apache Pig-: Eine coole Plattform zum Erstellen von MapReduce-Programmen mit Pig Latin.

- Apache Sqoop: Ein Tool zum Verschieben von großen Datenmengen zwischen Hadoop und strukturierten Datenspeichern wie relationalen Datenbanken.

- Apache Flume-: Ein Service zum effizienten Sammeln, Zusammenführen und Verschieben großer Mengen von Protokolldaten.

- Apache Oozie: Ein System, das den Ablauf von Hadoop-Jobs und ihren Abhängigkeiten organisiert.

- Apache Zookeeper: Ein zentraler Dienst, der Konfigurationsinfos verwaltet und für die Synchronisierung sorgt.

- Apache Spark-: Ein schnelles, vielseitiges Cluster-Computing-System mit In-Memory-Verarbeitung.

- Apache Storm-: Ein Echtzeit-Rechensystem, das große Datenströme verarbeitet.

- Apache Kafka: Eine verteilte Streaming-Plattform für die Verarbeitung von Echtzeit-Datenfeeds.

8. Was sind die typischen Probleme mit Hadoop?

Das Hadoop-Framework ist zwar super im Verwalten und Verarbeiten riesiger Mengen wertvoller Daten, bringt aber auch ein paar kritische Herausforderungen mit sich.

Lass uns das mal verstehen:

- Das größte Problem mit Hadoop ist, dass sein NameNode einen Single Point of Failure hat, was bei einem Ausfall zu Datenverlusten führt.

- Hadoop ist anfällig für Sicherheitsrisiken. Du kannst deine Daten nicht direkt kontrollieren und es gibt keine Möglichkeit zu wissen, ob sie missbraucht werden.

- Das MapReduce-Framework von Hadoop verarbeitet Daten in Stapeln und unterstützt keine Echtzeit-Datenverarbeitung.

- Dieses Framework eignet sich gut für Daten mit hoher Kapazität, kann aber keine kleinen Dateien verarbeiten. Wenn die Daten kleiner als die Standard-HDFS-Blockgröße sind, wird der NameNode überlastet und es kommt zu Latenzproblemen.

9. Was ist HBase und was machen seine Teile?

HBase ist eine Datenbank, die für den schnellen Zugriff auf große Dateien entwickelt wurde. Damit kannst du große Datensätze in Echtzeit lesen und schreiben, indem du die Daten in Spalten speicherst und mit eindeutigen Zeilenschlüsseln indizierst.

Diese Konfiguration ermöglicht schnelles Abrufen von Daten und effiziente Scans, was besonders für große und spärlich besetzte Tabellen gut ist, weil wir so viele Knoten hinzufügen können, wie wir brauchen.

HBase hat drei Teile:

- HMaster: Es kümmert sich um die Verwaltung der Regionserver und ist dafür zuständig, Tabellen zu erstellen und zu löschen.

- Regionserver: Es kümmert sich um Lese- und Schreibanfragen und verwaltet Regionsaufteilungen.

- ZooKeeper: Es hält den Cluster-Status aufrecht und kümmert sich um die Serverzuweisungen.

10. Was ist der Unterschied zwischen Hadoop 2.0 und Hadoop 1.x?

Diese Tabelle zeigt die beiden Hadoop-Versionen nebeneinander:

|

Kriterien |

Hadoop 1.x |

Hadoop 2.0 |

|

NameNode-Verwaltung |

Ein einzelner NameNode kümmert sich um den Namensraum. |

Mehrere NameNodes verwalten Namespaces über die HDFS-Föderation. |

|

Unterstützte Betriebssysteme |

Es gibt keine Unterstützung für Microsoft Windows. |

Unterstützung für Microsoft hinzugefügt |

|

Job- und Ressourcenmanagement |

Nutzt JobTracker und TaskTracker für die Job- und Ressourcenverwaltung |

Ich habe sie durch YARN ersetzt, um die beiden Aufgaben zu trennen. |

|

Skalierbarkeit |

Kann auf bis zu 4.000 Knoten pro Cluster erweitert werden |

Kann auf bis zu 10.000 Knoten pro Cluster erweitert werden |

|

Größe des Datenknotens |

Hat eine DataNode-Größe von 64 MB |

Hat die Größe auf 128 MB verdoppelt |

|

Aufgabenerledigung |

Nutzt Slots, die entweder Map- oder Reduce-Aufgaben ausführen können. |

Verwendet Container, die jede Aufgabe ausführen können |

Wenn du dich für einen Job im Bereich Data Engineering bewirbst, schau dir unseren umfassenden Artikel zu Fragen im Vorstellungsgespräch für Data Engineering an.

Fragen für Fortgeschrittene zum Thema Hadoop

Jetzt wird's spannend. Diese Interviewfragen sind dazu da, dich auf einem fortgeschrittenen Niveau zu testen. Diese Fragen sind besonders wichtig für leitende Ingenieure.

11. Was ist das Konzept von aktivem NameNode und Standby-NameNode in Hadoop 2.0?

In Hadoop 2.0 kümmert sich der Active NameNode um den Dateisystem-Namespace und regelt, wie Clients auf Dateien zugreifen können. Im Gegenteil, der Standby NameNode ist ein Backup und hat genug Infos, um einzuspringen, wenn der Active NameNode mal ausfällt.

Das löst das Problem des Single Point of Failure (SPOF), das bei Hadoop 1. x oft auftritt.

12. Was macht der verteilte Cache in Hadoop? Warum kann HDFS keine kleinen Dateien lesen?

HDFS ist nicht so gut darin, viele kleine Dateien zu verarbeiten, was zu einer längeren Latenz führt. Deshalb kannst du mit dem verteilten Cache schreibgeschützte Dateien, Archivdateien und JAR-Dateien speichern und sie für Aufgaben in MapReduce bereitstellen.

Angenommen, du musst 40 Jobs in MapReduce ausführen, und jeder Job muss auf die Datei aus HDFS zugreifen. In Echtzeit kann diese Zahl auf Hunderte oder Tausende von Lesevorgängen ansteigen. Die Anwendung sucht diese Dateien oft in HDFS, was HDFS überlastet und die Leistung beeinträchtigt.

Ein verteilter Cache kann aber viele kleine Dateien verarbeiten, ohne dass die Zugriffszeit und die Verarbeitungsgeschwindigkeit darunter leiden.

13. Erkläre, wie Prüfsummen dabei helfen, beschädigte Daten zu erkennen. Definiere auch den Standardcode zur Fehlererkennung.

Prüfsummen erkennen beschädigte Daten in HDFS. Wenn Daten ins System kommen, wird ein kleiner Wert erstellt, den man als Prüfsumme bezeichnet. Hadoop berechnet die Prüfsumme neu, wenn jemand Daten übertragen will. Wenn die neue Prüfsumme mit der ursprünglichen übereinstimmt, sind die Daten in Ordnung; wenn nicht, sind sie kaputt.

Der Fehlererkennungscode für Hadoop ist CRC-32.

14. Wie schafft HDFS es, fehlertolerant zu sein?

HDFS ist dank eines Replikationsprozesses, der für Zuverlässigkeit und Verfügbarkeit sorgt, ziemlich robust. So läuft der Replikationsprozess ab:

- Anfängliche Blockverteilung: Wenn eine Datei gespeichert wird, teilt HDFS sie in Blöcke auf und verteilt diese auf verschiedene DataNodes. Eine Datei, die in die Blöcke A, B und C aufgeteilt ist, könnte zum Beispiel auf den DataNodes A1, B2 und C3 gespeichert sein.

- Replikation: Jeder DataNode, der einen Block hat, kopiert diesen Block auf andere DataNodes im Cluster. Zum Beispiel erstellt der DataNode A1, der den Block A hat, zusätzliche Kopien auf anderen DataNodes, wie D1 und D2. Das heißt, wenn A1 abstürzt, sind die Kopien von A1 auf D1 und D2 immer noch da.

- Umgang mit Fehlern: Wenn der DataNode D1 ausfällt, kannst du die benötigten Blöcke (B und C) von anderen DataNodes wie B2 und C3 holen.

15. Kannst du eine komprimierte Datei mit MapReduce bearbeiten? Wenn ja, welche Formate unterstützt es und kann man sie teilen?

Ja, komprimierte Dateien kann man mit MapReduce bearbeiten. Hadoop kann mit mehreren Komprimierungsformaten umgehen, aber nicht alle lassen sich aufteilen.

Hier sind die Formate, die MapReduce unterstützt:

- ENTLEEREN

- gzip

- bzip2

- LZO

- LZ4

- Knackig

Von all diesen ist bzip2 das einzige Format, das man aufteilen kann.

HDFS teilt echt große Dateien in kleinere Teile auf, die jeweils 128 MB groß sind. HDFS teilt zum Beispiel eine 1,28 GB große Datei in zehn Blöcke auf. Jeder Block wird dann von einem separaten Mapper in einem MapReduce-Job bearbeitet. Aber wenn eine Datei nicht geteilt werden kann, kümmert sich ein einzelner Mapper um die ganze Datei.

Hive-Interviewfragen

Manche Jobs brauchen Fachwissen über die Integration von Hive mit Hadoop. Bei so einer speziellen Stelle wird sich der Personalchef auf diese Fragen konzentrieren:

16. Definiere Hive.

Hive ist ein Data-Warehouse-System, das Batch-Jobs und Datenanalysen macht. Es wurde von Facebook entwickelt, um SQL-ähnliche Abfragen auf riesigen Datensätzen auszuführen, die in HDFS gespeichert sind, ohne dabei auf Java angewiesen zu sein.

Mit Hive können wir Daten in Tabellen organisieren und einen Megastore nutzen, um Metadaten wie Schemata zu speichern. Es unterstützt eine Reihe von Speichersystemen wie S3, Azure Data Lake Storage (ADLs) und Google Cloud Storage.

17. Was ist ein Hive Metastore (HMS)? Wie würdest du einen verwalteten Metastore von einem externen Metastore unterscheiden?

Der Hive Metastore (HMS) ist eine zentrale Datenbank für Metadaten. Es enthält Infos zu Tabellen, Ansichten und Zugriffsberechtigungen, die im HDFS-Objektspeicher gespeichert sind.

Es gibt zwei Arten von HIVE Metastore-Tabellen:

- Verwalteter Metastore: HIVE speichert und verwaltet diese Tabelle in der JVM des Hive-Dienstes. Wir können diese Tabellen mit diesem Standardwert finden:

/user/hive/warehouse. - Externer Metastore: Diese Tabellen laufen auf einer externen JVM. Also, jede Änderung an den Metadaten von Hive hat keinen Einfluss auf die Daten, die in diesen Tabellen gespeichert sind.

18. Welche Programmiersprachen unterstützt Hive?

Hive bietet super Unterstützung für die Integration mit vielen Programmiersprachen, was seine Vielseitigkeit und Benutzerfreundlichkeit in verschiedenen Anwendungen verbessert:

- Python: Datenanalyse und maschinelles Lernen.

- Java: Unternehmensanwendungen und individuelle Datenverarbeitung.

- C++: Leistungskritische Anwendungen und kundenspezifische SerDes.

- PHP: Webbasierte Anwendungen, die auf Hive-Daten zugreifen.

19. Wie groß kann die Datenmenge maximal sein, die Hive verarbeiten kann?

Dank der Integration mit HDFS und seiner skalierbaren Architektur kann Hive mit Petabytes an Daten umgehen. Es gibt keine feste Obergrenze für die Datenmenge, die Hive verarbeiten kann, was es zu einem super Tool für die Verarbeitung und Analyse von Big Data macht.

20. Wie viele Datentypen gibt's in Hive?

Hive hat eine ganze Reihe von Datentypen, um verschiedene Datenanforderungen zu erfüllen:

- Eingebaute Datentypen: Numerisch, Zeichenfolge, Datum/Uhrzeit und Sonstiges für die grundlegende Datenspeicherung.

- Komplexe Datentypen: ARRAY, MAP, STRUCT und UNIONTYPE für fortgeschrittenere und strukturiertere Datenrepräsentationen.

Eingebaute Datentypen:

|

Kategorie |

Datentyp |

Beschreibung |

Beispiel |

|

Numerische Typen |

TINYINT |

1-Byte-Ganzzahl mit Vorzeichen |

127 |

|

SMALLINT |

2-Byte-Ganzzahl mit Vorzeichen |

32767 |

|

|

INT |

4-Byte-Ganzzahl mit Vorzeichen |

2147483647 |

|

|

BIGINT |

8-Byte-Ganzzahl mit Vorzeichen |

9223372036854775807 |

|

|

FLOAT |

Einfachpräzisions-Gleitkomma |

3,14 |

|

|

DOUBLE |

Doppelpräzisions-Gleitkomma |

3.141592653589793 |

|

|

DECIMAL |

Beliebig genaue Dezimalzahl mit Vorzeichen |

1234567890.1234567890 |

|

|

Zeichenkettentypen |

STRING |

Zeichenkette mit variabler Länge |

Hey, Welt! |

|

VARCHAR |

Zeichenkette mit variabler Länge und einer festgelegten maximalen Länge |

'Beispiel' |

|

|

CHAR |

Zeichenkette mit fester Länge |

'A' |

|

|

Datums-/Zeit-Typen |

TIMESTAMP |

Datum und Uhrzeit, inklusive Zeitzone |

'2023-01-01 12:34:56' |

|

DATUM |

Datum ohne Uhrzeit |

„01.01.2023“ |

|

|

INTERVAL |

Zeitintervall |

INTERVALL „1“ TAG |

|

|

Verschiedene Typen |

BOOLEAN |

Stimmt oder stimmt nicht |

TRUE |

|

BINÄR |

Reihenfolge der Bytes |

0x1A2B3C |

Komplexe Datentypen:

|

Datentyp |

Beschreibung |

Beispiel |

|

ARRAY |

Geordnete Sammlung von Elementen |

ARRAY<STRING> ('Apfel', 'Banane', 'Kirsche') |

|

MAP |

Sammlung von Schlüssel-Wert-Paaren |

MAP<STRING, INT> ('Schlüssel1' -> 1, 'Schlüssel2' -> 2) |

|

STRUCT |

Sammlung von Feldern mit verschiedenen Datentypen |

STRUCT<name: STRING, Alter: INT> („Alice“, 30) |

|

UNIONTYPE |

Kann einen von mehreren bestimmten Typen aufnehmen |

UNIONTYPE<INT, DOUBLE, STRING> (1, 2.0, 'drei') |

Szenariobasierte Hadoop-Interviewfragen für Big-Data-Ingenieure

Diese Fragen prüfen, wie gut du Hadoop für echte Probleme einsetzen kannst. Diese Fragen sind besonders wichtig, wenn du dich für eine Stelle als Datenarchitekt bewirbst, können aber auch in jedem anderen Vorstellungsgespräch gestellt werden, in dem Hadoop-Kenntnisse gefragt sind.

21. Du richtest einen HDFS-Cluster mit dem Replikationssystem von Hadoop ein. Der Cluster hat drei Racks: A, B und C. Sag mal, wie Hadoop eine Datei namens „datafile.text” kopiert.

So repliziert Hadoop die Daten:

- Erste Replik auf Rack A: Hadoop legt die erste Replik auf einen zufällig ausgewählten Knoten in Rack A. Diese Entscheidung minimiert die Schreiblatenz, indem ein lokaler oder nahegelegener Knoten ausgewählt wird.

- Zweite Replik auf Rack B: Die zweite Kopie wird auf einem Knoten in einem anderen Rack, zum Beispiel Rack B, gespeichert. So geht sichergestellt, dass die Daten nicht verloren gehen, wenn Rack A ausfällt, was die Fehlertoleranz verbessert.

- Dritte Replik auf Rack B: Die dritte Replik wird auf einem anderen Knoten innerhalb von Rack B platziert. Wenn man sie auf dem gleichen Rack wie die zweite platziert, hilft das, die Netzwerkauslastung zwischen den Racks auszugleichen und den Datenverkehr zwischen den Racks zu reduzieren.

Die Replikationsstrategie von Hadoop in einem HDFS-Cluster mit drei Racks (A, B und C) ist so gemacht, dass sie die Lastverteilung optimiert, die Fehlertoleranz erhöht und die Netzwerkeffizienz verbessert. So wird das „ datafile.text “ auf eine Art und Weise nachgebildet, die Leistung und Zuverlässigkeit gut ausbalanciert.

22. Du arbeitest an einer Hadoop-basierten Anwendung, die über LocalFileSystem mit Dateien interagiert. Wie willst du die Datenintegrität mit einer Prüfsumme sicherstellen?

Die Verwendung von Prüfsummen in Hadoops „ LocalFileSystem ” sorgt für Datenintegrität, indem:

- Prüfsummen erstellen: Automatisches Erstellen von Prüfsummen für Datenblöcke beim Schreiben von Dateien.

- Speichern von Prüfsummen: Speichern von Prüfsummen in einer versteckten Datei namens „

.filename.crc” im selben Verzeichnis. - Prüfsummen überprüfen: Vergleich der gespeicherten Prüfsummen mit den tatsächlichen Daten beim Lesen.

- Fehler erkennen: Bei Unstimmigkeiten wird ein „

ChecksumException“ ausgelöst.

Wenn wir diese Schritte befolgen, können wir sicherstellen, dass deine Anwendung die Datenintegrität aufrechterhält und mögliche Datenbeschädigungen sofort erkennt.

23. Angenommen, du debugst einen großen Hadoop-Job, der sich über mehrere Knoten erstreckt, und es gibt ungewöhnliche Fälle, die die Ausgabe beeinflussen. Wie würdest du damit umgehen?

Hier ist, was wir machen können:

- Mögliche Probleme protokollieren: Benutz Debug-Anweisungen, um mögliche Probleme unter

stderrzu protokollieren. - Aufgabenstatus aktualisieren: Füge die Speicherorte der Fehlerprotokolle in die Statusmeldungen der Aufgaben ein.

- Benutzerdefinierte Zähler: Zählwerke einbauen, um ungewöhnliche Zustände zu verfolgen und zu analysieren.

- Debugging der Kartenausgabe: Debug-Infos in die Ausgabe der Karte schreiben.

- Log-Analyseprogramm: Mach ein MapReduce-Programm für eine detaillierte Log-Analyse.

Mit diesen Schritten können wir große Hadoop-Jobs systematisch debuggen und ungewöhnliche Fälle, die sich auf die Ausgabe auswirken, effektiv verfolgen und lösen.

24. Du berechnest die Speichereinstellungen für einen Hadoop-Cluster mit YARN. Erkläre, wie du den Speicher für die NodeManager- und MapReduce-Jobs einstellen würdest.

Wenn du die Speichereinstellungen für einen Hadoop-Cluster mit YARN machst, ist es wichtig, die Speicherzuweisung zwischen Hadoop-Daemons, Systemprozessen und dem NodeManager auszugleichen, um die Leistung und die Ressourcennutzung zu optimieren.

Speicher für den NodeManager einstellen:

- Berechne den gesamten physischen Speicher des Knotens: Finde raus, wie viel physischer Speicher insgesamt auf jedem Knoten im Cluster zur Verfügung steht. Wenn ein Knoten zum Beispiel 64 GB RAM hat, beträgt sein physischer Gesamtspeicher 64.000 MB.

- Speicher für Hadoop-Daemons abziehen: Speicherplatz für die Hadoop-Daemons reservieren, die auf dem Knoten laufen, wie zum Beispiel DataNode und NodeManager. Normalerweise reichen 1000 bis 2000 MB pro Daemon aus. Wenn du zum Beispiel dem DataNode und dem NodeManager jeweils 1500 MB zuweist, musst du 3000 MB reservieren.

- Speicher für Systemprozesse reservieren: Speicherplatz für andere Systemprozesse und Hintergrunddienste reservieren, damit das Betriebssystem und wichtige Dienste reibungslos laufen. Eine typische Reservierung könnte 2 GB (2000 MB) sein.

- Verbleibenden Speicher für NodeManager zuweisen: Zieh den reservierten Speicher für Hadoop-Daemons und Systemprozesse vom gesamten physischen Speicher ab, um den Speicher zu ermitteln, den der NodeManager den Containern zuweisen kann.

Speicher für MapReduce-Jobs einstellen:

mapreduce.map.memory.mb-Einstellungen anpassen: Dieser Parameter legt fest, wie viel Speicherplatz jeder Map-Aufgabe zugewiesen wird. Passe diese Einstellung an die Speicheranforderungen deiner Kartenaufgaben an.- Wenn du zum Beispiel „

mapreduce.map.memory.mb“ auf 2048 MB setzt, bekommt jede Map-Aufgabe 2 GB Speicher. mapreduce.reduce.memory.mb-Einstellungen anpassen: Dieser Parameter legt fest, wie viel Speicherplatz für jede Reduzierungsaufgabe bereitgestellt wird. Passe diese Einstellung entsprechend den Speicheranforderungen deiner Reduzierungsaufgaben an.- Wenn du zum Beispiel „

mapreduce.reduce.memory.mb“ auf 4096 MB setzt, bekommt jede Reduzierungsaufgabe 4 GB Speicher zugeteilt. - Containergröße einstellen: Stell sicher, dass die Containergröße in „

yarn-site.xml“ mit Parametern wie „yarn.nodemanager.resource.memory-mb“ richtig eingestellt ist. Diese sollte mit dem dem NodeManager zugewiesenen Speicher übereinstimmen. - Wenn der NodeManager zum Beispiel 59.000 MB zur Verfügung hat, kannst du „

yarn.nodemanager.resource.memory-mb“ auf 59.000 MB setzen.

Zusammenfassung der Speicherkonfiguration:

|

Komponente |

Konfiguration |

Beispielwerte |

|

NodeManager |

Gesamter physischer Speicher |

64.000 MB |

|

Speicher für Hadoop-Daemons |

3000 MB |

|

|

Speicher für Systemprozesse |

2000 MB |

|

|

Verfügbarer Speicher für NodeManager |

59.000 MB |

|

|

MapReduce-Map-Aufgabe |

mapreduce.map.memory.mb |

2048 MB |

|

MapReduce-Reduzierungsaufgabe |

mapreduce.reduce.memory.mb |

4096 MB |

|

Containergröße |

yarn.nodemanager.resource.memory-mb |

59.000 MB |

Abschließende Gedanken

Nachdem du diese Fragen verstanden hast, solltest du die grundlegenden Begriffe kennen und ein

gute Kenntnisse der Komplexität realer Hadoop-Anwendungen. Außerdem musst du dich an neue Projekte auf Basis von Hadoop anpassen, um auf dem Laufenden zu bleiben und bei deinen Vorstellungsgesprächen zu punkten.

Du kannst auch dein Wissen über andere Big-Data-Frameworks wie Spark und Flink erweitern, da diese schnell sind und weniger Probleme mit Latenzzeiten haben als Hadoop.

Wenn du aber nach einem strukturierten Lernpfad suchst, um Big Data zu meistern, kannst du dir die folgenden Ressourcen anschauen:

- Grundlagen von Big Data mit PySpark: Dieser Kurs ist super, um die Grundlagen der Big-Data-Verarbeitung mit PySpark zu lernen.

- Big Data mit PySpark: Dieser Lernpfad gibt dir eine umfassende Einführung in Big-Data-Konzepte mit PySpark und behandelt Themen wie Datenbearbeitung, maschinelles Lernen und vieles mehr.

Werde Dateningenieur

FAQs

Welche weiteren Fähigkeiten sollte ich mir aneignen, um mein Hadoop-Wissen zu ergänzen?

Um deine Karrierechancen zu verbessern, solltest du dich mit weiteren Big-Data-Frameworks wie Apache Spark und Apache Kafka beschäftigen. Es ist echt hilfreich, wenn du dich mit SQL- und nosql-Datenbanken wie MySQL und MongoDB auskennst. Du solltest Python, Java und Scala gut beherrschen und auch mit Data-Warehousing-Tools wie Apache Hive klarkommen. Machine-Learning-Frameworks wie TensorFlow und PyTorch können auch echt nützlich sein.

Wie kann ich praktische Erfahrungen mit Hadoop sammeln?

Sammle praktische Erfahrungen, indem du dich für Online-Kurse und Zertifizierungen auf Plattformen wie DataCamp anmeldest. Mach bei echten Projekten auf GitHub oder Kaggle mit. Such nach Praktika bei Firmen, die mit Big Data arbeiten. Mach bei Hackathons und Programmierwettbewerben mit. Bei Open-Source-Hadoop-Projekten mitzumachen ist auch eine coole Möglichkeit, um Erfahrungen zu sammeln und deine Fähigkeiten zu zeigen.

Welche Karrieremöglichkeiten gibt es für einen Hadoop-Profi?

Karrierewege für Hadoop-Profis umfassen Jobs wie Big-Data-Ingenieur, Datenwissenschaftler, Datenanalyst, Hadoop-Administrator, ETL-Entwickler und Lösungsarchitekt. Jede Rolle umfasst verschiedene Aspekte der Entwicklung, Verwaltung und Analyse von großen Datenverarbeitungssystemen mit Hadoop und ähnlichen Technologien.

Ist es einfach, als Berufseinsteiger einen Job im Bereich Hadoop zu finden, oder muss ich schon Erfahrung haben?

Es ist echt schwer, bei Hadoop-Vorstellungsgesprächen zu punkten. Egal, ob du gerade erst anfängst oder schon ein erfahrener Profi bist – du brauchst einfach nur ein gutes Verständnis der Theorie und praktische Kenntnisse.

Was sind die typischen Herausforderungen, denen Hadoop-Profis in ihrer Karriere begegnen?

Zu den üblichen Herausforderungen gehören die Gewährleistung der Datensicherheit, die Optimierung der Leistung von Hadoop-Clustern, die Integration verschiedener Datenquellen, das Schritthalten mit dem rasanten technologischen Fortschritt sowie die Verwaltung und Skalierung von Clustern. Effizientes Ressourcenmanagement, um Engpässe zu vermeiden, ist auch super wichtig. Wenn du diese Herausforderungen meisterst, kannst du deine Karriere als Hadoop-Profi vorantreiben.

Ich bin ein Inhaltsstratege, der es liebt, komplexe Themen zu vereinfachen. Ich habe Unternehmen wie Splunk, Hackernoon und Tiiny Host geholfen, ansprechende und informative Inhalte für ihr Publikum zu erstellen.