programa

La ingeniería de datos se ha convertido en una de las funciones más importantes del sector tecnológico, ya que constituye la columna vertebral de la infraestructura de datos de empresas de todo el mundo. A medida que las empresas dependen cada vez más de la toma de decisiones basada en datos, la demanda de ingenieros de datos cualificados sigue aumentando.

Si te estás preparando para una entrevista de ingeniería de datos, debes estar bien versado en preguntas generales y técnicas que evalúen tu experiencia, tu capacidad para resolver problemas y tus habilidades técnicas.

En esta entrada del blog, ofrecemos una guía completa para ayudarte a prepararte para las diferentes etapas de una entrevista de ingeniería de datos, desde la selección inicial de RR. HH. hasta las evaluaciones técnicas en profundidad.

Conviértete en Ingeniero de Datos

Preguntas iniciales para la entrevista de ingeniero de datos de RR. HH.

En la primera ronda de entrevistas de RR. HH., el director de RR. HH. te preguntará sobre tu experiencia laboral y el valor que aportas a la empresa. Esta etapa está diseñada para evaluar tu trayectoria, tus habilidades interpersonales y tu adecuación general a la cultura de la empresa.

1. ¿Qué te convierte en el mejor candidato para este puesto?

Si el responsable de contratación te selecciona para una entrevista telefónica, es porque habrá visto algo que le ha gustado en tu perfil. Aborda esta pregunta con confianza y habla sobre tu experiencia y tu crecimiento profesional.

Es importante revisar el perfil de la empresa y la descripción del puesto antes de la entrevista. Hacerlo te ayudará a comprender lo que busca el responsable de contratación y a adaptar tu respuesta en consecuencia.

Céntrate en habilidades y experiencias específicas que se ajusten a los requisitos del puesto, como el diseño y la gestión de flujos de datos, la modelización y los procesos ETL. Destaca cómo tu combinación única de habilidades, experiencia y conocimientos te hace destacar.

2. ¿Cuáles son las responsabilidades diarias de un ingeniero de datos?

Aunque no hay una respuesta definitiva, compartir tus experiencias en trabajos anteriores y hacer referencia a la descripción del puesto puede proporcionar una respuesta completa. En general, las responsabilidades diarias de los ingenieros de datos incluyen:

- Desarrollo, prueba y mantenimiento de bases de datos.

- Creación de soluciones de datos basadas en los requisitos empresariales.

- Adquisición e integración de datos.

- Desarrollo, validación y mantenimiento de canales de datos para procesos ETL, modelado, transformación y servicio.

- Implementación y gestión de modelos de machine learning en algunos casos.

- Mantener la calidad de los datos mediante la limpieza, validación y supervisión de los flujos de datos.

- Mejorar la fiabilidad, el rendimiento y la calidad del sistema.

- Seguir las directrices de gobernanza y seguridad de los datos para garantizar el cumplimiento normativo y la integridad de los datos.

3. ¿Qué es lo más difícil de ser ingeniero de datos?

Esta pregunta variará en función de las experiencias individuales, pero entre los retos más comunes se incluyen:

- Mantenerse al día con el rápido ritmo de los avances tecnológicos e integrar nuevas herramientas para mejorar el rendimiento, la seguridad, la fiabilidad y el retorno de la inversión de los sistemas de datos.

- Comprender e implementar protocolos complejos de gobernanza y seguridad de datos.

- Gestionar planes de recuperación ante desastres y garantizar la disponibilidad e integridad de los datos durante acontecimientos imprevistos.

- Equilibrar los requisitos empresariales con las limitaciones técnicas y predecir las demandas futuras de datos.

- Manejar grandes volúmenes de datos de manera eficiente y garantizar la calidad y coherencia de los datos.

4. ¿Con qué herramientas o marcos de datos tienes experiencia? ¿Hay alguno que prefieras sobre los demás?

Tu respuesta se basará en tus experiencias. Estar familiarizado con las herramientas modernas y las integraciones de terceros te ayudará a responder con seguridad a esta pregunta. Discute las herramientas relacionadas con:

- Gestión de bases de datos (por ejemplo, MySQL, PostgreSQL, MongoDB)

- Almacenamiento de datos (por ejemplo, Amazon Redshift, Google BigQuery, Snowflake)

- Orquestación de datos (por ejemplo, Apache Airflow, Prefect)

- Canales de datos (por ejemplo, Apache Kafka, Apache NiFi)

- Gestión de la nube (por ejemplo, AWS, Google Cloud Platform, Microsoft Azure)

- Limpieza, modelado y transformación de datos (por ejemplo, pandas, dbt, Spark).

- Procesamiento por lotes y en tiempo real (por ejemplo, Apache Spark, Apache Flink)

Recuerda que no hay respuestas incorrectas para esta pregunta. El entrevistador está evaluando tus habilidades y experiencia.

5. ¿Cómo te mantienes al día de las últimas tendencias y avances en ingeniería de datos?

Esta pregunta evalúa tu compromiso con el aprendizaje continuo y con mantenerte al día en tu campo.

Puedes mencionar la suscripción a boletines informativos del sector, seguir blogs influyentes, participar en foros y comunidades online, asistir a seminarios web y conferencias, y realizar cursos online. Destaca las fuentes o plataformas específicas que utilizas para mantenerte informado.

6. ¿Puedes describir una ocasión en la que tuviste que colaborar con un equipo multidisciplinar para completar un proyecto?

La ingeniería de datos a menudo implica trabajar con varios equipos, incluidos científicos de datos, analistas y personal de TI.

Comparte un ejemplo concreto en el que hayas colaborado con éxito con otras personas, haciendo hincapié en tus habilidades comunicativas, tu capacidad para comprender diferentes perspectivas y cómo has contribuido al éxito del proyecto. Explica los retos a los que te enfrentaste y cómo los superaste para lograr el resultado deseado.

Conviértete en Ingeniero de Datos

Preguntas para la entrevista de trabajo como ingeniero técnico de datos

La ingeniería de datos es un campo muy técnico, por lo que no es de extrañar que la mayor parte del proceso de entrevista incluya preguntas y ejercicios técnicos. En esta sección, trataremos diferentes tipos de preguntas y respuestas técnicas, centrándonos en preguntas para principiantes, en Python, en SQL, basadas en proyectos y sobre gestión.

Preguntas para la entrevista de trabajo de ingeniero de datos junior

Las entrevistas para ingenieros junior se centran en herramientas, Python y consultas SQL. También pueden incluir preguntas sobre gestión de bases de datos y procesos ETL, incluyendo retos de programación y pruebas para realizar en casa.

Cuando las empresas contratan a recién graduados, quieren asegurarse de que puedes manejar sus datos y sistemas de manera eficaz.

7. ¿Puedes explicar los esquemas de diseño relevantes para el modelado de datos?

Existen tres esquemas principales de diseño de modelos de datos: estrella, copo de nieve y galaxia.

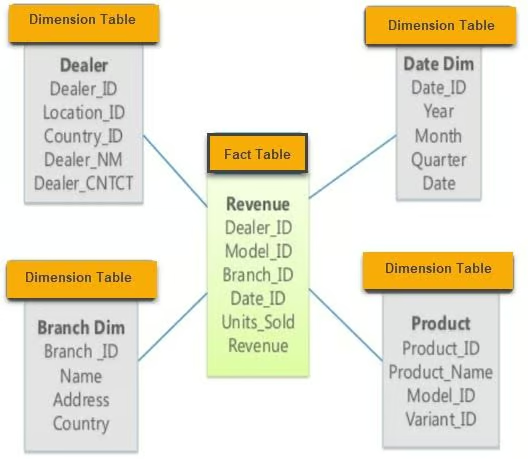

- Esquema en estrella: Este esquema contiene varias tablas de dimensiones conectadas a una tabla de hechos central. Es sencillo y fácil de entender, por lo que resulta adecuado para consultas sencillas.

Ejemplo de esquema en estrella. Imagen de guru99

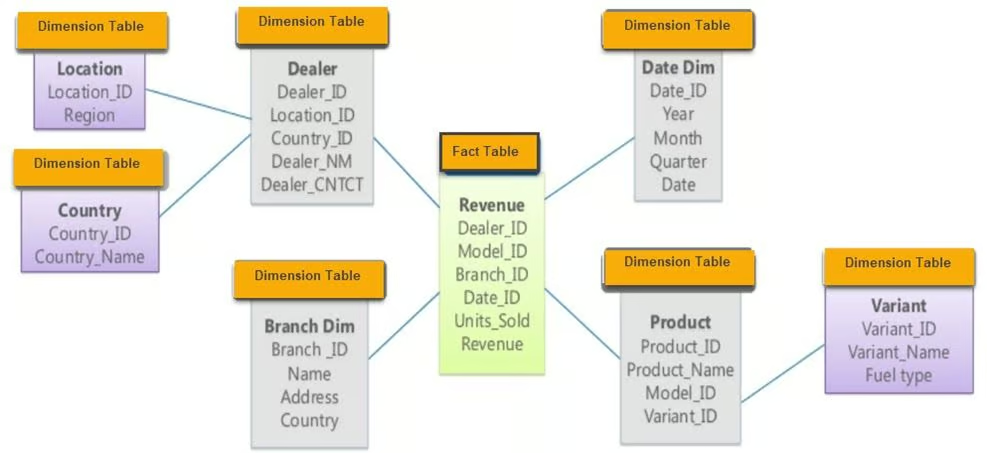

- Esquema Snowflake: El esquema copo de nieve, una extensión del esquema estrella, consta de una tabla de hechos y varias tablas de dimensiones con capas adicionales de normalización, formando una estructura similar a un copo de nieve. Reduce la redundancia y mejora la integridad de los datos.

Ejemplo de esquema Snowflake. Imagen de guru99

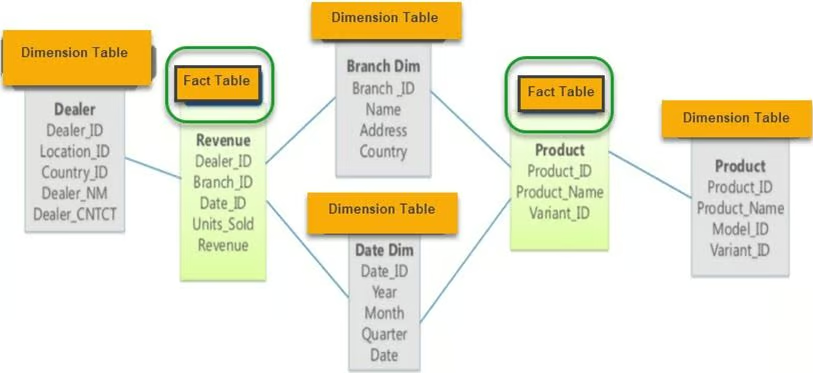

- Esquema de la galaxia: También conocido como esquema de constelación de hechos, contiene dos o más tablas de hechos que comparten tablas de dimensiones. Este esquema es adecuado para sistemas de bases de datos complejos que requieren múltiples tablas de hechos.

Ejemplo de esquema Galaxy. Imagen de guru99

8. ¿Con qué herramientas ETL has trabajado? ¿Cuál es tu favorito y por qué?

Al responder a esta pregunta, menciona las herramientas ETL que dominas y explica por qué elegiste herramientas específicas para determinados proyectos. Analiza las ventajas y desventajas de cada herramienta y cómo encajan en tu flujo de trabajo. Entre las herramientas de código abierto más populares se incluyen:

- dbt (herramienta de creación de datos): Ideal para transformar datos en tu almacén utilizando SQL.

- Apache Spark: Excelente para el procesamiento de datos a gran escala y el procesamiento por lotes.

- Apache Kafka: Se utiliza para canalizaciones de datos en tiempo real y streaming.

- Airbyte: Herramienta de integración de datos de código abierto que ayuda en la extracción y carga de datos.

Si necesitas refrescar tus conocimientos sobre ETL, considera la posibilidad de realizar el curso Introducción a la ingeniería de datos.

9. ¿Qué es la orquestación de datos y qué herramientas puedes utilizar para llevarla a cabo?

La orquestación de datos es un proceso automatizado que permite acceder a datos sin procesar procedentes de múltiples fuentes, realizar tareas de limpieza, transformación y modelado de datos, y utilizarlos para tareas analíticas. Garantiza que los datos fluyan sin problemas entre los diferentes sistemas y etapas del procesamiento.

Entre las herramientas más populares para la orquestación de datos se incluyen:

- Apache Airflow: Ampliamente utilizado para programar y supervisar flujos de trabajo.

- Prefecto: Una herramienta de orquestación moderna centrada en el flujo de datos.

- Dagster: Una herramienta de orquestación diseñada para cargas de trabajo con un uso intensivo de datos.

- AWS Glue: Un servicio ETL gestionado que simplifica la preparación de datos para el análisis.

10. ¿Qué herramientas utilizas para la ingeniería analítica?

La ingeniería analítica consiste en transformar datos procesados, aplicar modelos estadísticos y visualizarlos mediante informes y paneles de control.

Entre las herramientas más populares para la ingeniería analítica se incluyen:

- dbt (herramienta de creación de datos): Se utiliza para transformar datos en tu almacén utilizando SQL.

- BigQuery: Un almacén de datos sin servidor y totalmente gestionado para el análisis de datos a gran escala.

- Postgres: Un potente sistema de base de datos relacional de código abierto.

- Metabase: Una herramienta de código abierto que te permite hacer preguntas sobre tus datos y mostrar las respuestas en formatos comprensibles.

- Google Data Studio: Se utiliza para crear paneles de control e informes visuales.

- Tableau: Una plataforma líder para la visualización de datos.

Estas herramientas ayudan a acceder, transformar y visualizar datos para obtener información significativa y respaldar los procesos de toma de decisiones.

11. ¿Cuál es la diferencia entre los sistemas OLAP y OLTP?

OLAP (procesamiento analítico en línea) analiza datos históricos y admite consultas complejas. Está optimizado para cargas de trabajo con gran volumen de lectura y se utiliza a menudo en almacenes de datos para tareas de inteligencia empresarial. OLTP ( procesamiento de transacciones en línea) está diseñado para gestionar datos transaccionales en tiempo real. Está optimizado para cargas de trabajo con gran volumen de escritura y se utiliza en bases de datos operativas para las operaciones comerciales diarias.

La principal diferencia radica en su finalidad: OLAP te ayuda en la toma de decisiones, mientras que OLTP te ayuda en las operaciones diarias.

Si aún tienes dudas, te recomiendo leer la entrada del blog OLTP vs OLAP.

Preguntas para una entrevista de trabajo como ingeniero de datos en Python

Python es el lenguaje más popular en ingeniería de datos debido a su versatilidad y al rico ecosistema de bibliotecas disponibles para el procesamiento, análisis y automatización de datos. A continuación, te presentamos algunas preguntas relacionadas con Python que podrían plantearte en una entrevista de ingeniería de datos.

12. ¿Qué bibliotecas de Python son más eficientes para el procesamiento de datos?

Las bibliotecas de procesamiento de datos más populares en Python incluyen:

- pandas: Ideal para la manipulación y el análisis de datos, ya que proporciona estructuras de datos como DataFrame.

- NumPy: Esencial para cálculos numéricos, admite grandes arreglos y matrices multidimensionales.

- Dask: Facilita la computación paralela y puede manejar cálculos más grandes que la memoria utilizando una sintaxis similar a la de pandas.

- PySpark: Una API de Python para Apache Spark, útil para el procesamiento de datos a gran escala y el análisis en tiempo real.

Cada una de estas bibliotecas tiene ventajas e inconvenientes, y la elección depende de los requisitos específicos de los datos y de la magnitud de las tareas de procesamiento de datos.

13. ¿Cómo se realiza el web scraping en Python?

El web scraping en Python suele implicar los siguientes pasos:

1. Accede a la página web utilizando la biblioteca requests:

import requests

from bs4 import BeautifulSoup

url = 'http://example.com'

response = requests.get(url)

soup = BeautifulSoup(response.text, 'html.parser')2. Extrae tablas e información utilizando BeautifulSoup:

tables = soup.find_all('table')3. Conviértelo a un formato estructurado utilizando pandas:

import pandas as pd

data = []

for table in tables:

rows = table.find_all('tr')

for row in rows:

cols = row.find_all('td')

cols = [ele.text.strip() for ele in cols]

data.append(cols)

df = pd.DataFrame(data)4. Limpia los datos utilizando pandas y NumPy:

df.dropna(inplace=True) # Drop missing values5. Guarda los datos en forma de archivo CSV:

df.to_csv('scraped_data.csv', index=False)En algunos casos, pandas.read_html puede simplificar el proceso:

df_list = pd.read_html('http://example.com')

df = df_list[0] # Assuming the table of interest is the first one14. ¿Cómo manejas en Python los conjuntos de datos grandes que no caben en la memoria?

El manejo de grandes conjuntos de datos que no caben en la memoria requiere el uso de herramientas y técnicas diseñadas para el cálculo fuera del núcleo:

- Dask: Permite el cálculo paralelo y funciona con conjuntos de datos más grandes que la memoria utilizando una sintaxis similar a pandas.

import dask.dataframe as dd

df = dd.read_csv('large_dataset.csv')- PySpark: Permite el procesamiento distribuido de datos, lo cual resulta útil para manejar datos a gran escala.

from pyspark.sql import SparkSession

spark = SparkSession.builder.appName('data_processing').getOrCreate()

df = spark.read.csv('large_dataset.csv', header=True, inferSchema=True)- Fragmentación con pandas: Lee grandes conjuntos de datos por partes.

import pandas as pd

chunk_size = 10000

for chunk in pd.read_csv('large_dataset.csv', chunksize=chunk_size):

process(chunk) # Replace with your processing function15. ¿Cómo te aseguras de que tu código Python sea eficiente y esté optimizado para un rendimiento óptimo?

Para garantizar que el código Python sea eficiente y esté optimizado para el rendimiento, ten en cuenta las siguientes prácticas:

- Perfil: Utiliza herramientas de perfilado como

cProfile,line_profileromemory_profilerpara identificar cuellos de botella en tu código.

import cProfile

cProfile.run('your_function()')- Vectorización: Utiliza

numpyopandaspara operaciones vectorizadas en lugar de bucles.

import numpy as np

data = np.array([1, 2, 3, 4, 5])

result = data * 2 # Vectorized operation- Estructuras de datos eficientes: Elige las estructuras de datos adecuadas (por ejemplo, listas, conjuntos, diccionarios) en función de tu caso de uso.

data_dict = {'key1': 'value1', 'key2': 'value2'} # Faster lookups compared to lists- Procesamiento paralelo: Utiliza subprocesos múltiples o procesamiento múltiple para las tareas que se puedan paralelizar.

from multiprocessing import Pool

def process_data(data_chunk):

# Your processing logic here

return processed_chunk

with Pool(processes=4) as pool:

results = pool.map(process_data, data_chunks)- Evitar cálculos redundantes: Almacenar en caché los resultados de operaciones costosas si es necesario reutilizarlos.

from functools import lru_cache

@lru_cache(maxsize=None)

def expensive_computation(x):

# Perform expensive computation

return result16. ¿Cómo garantizas la integridad y la calidad de los datos en tus canalizaciones de datos?

La integridad y la calidad de los datos son importantes para una ingeniería de datos fiable. Las mejores prácticas incluyen:

- Validación de datos: Implementa comprobaciones en varias etapas del proceso de datos para validar los formatos, los rangos y la coherencia de los datos.

def validate_data(df):

assert df['age'].min() >= 0, "Age cannot be negative"

assert df['salary'].dtype == 'float64', "Salary should be a float"

# Additional checks...- Limpieza de datos: Utiliza bibliotecas como

pandaspara limpiar y preprocesar datos gestionando los valores perdidos, eliminando duplicados y corrigiendo errores.

df.dropna(inplace=True) # Drop missing values

df.drop_duplicates(inplace=True) # Remove duplicates- Pruebas automatizadas: Desarrollar pruebas unitarias para funciones de procesamiento de datos utilizando marcos como

pytest.

import pytest

def test_clean_data():

raw_data = pd.DataFrame({'age': [25, -3], 'salary': ['50k', '60k']})

clean_data = clean_data_function(raw_data)

assert clean_data['age'].min() >= 0

assert clean_data['salary'].dtype == 'float64'- Supervisión y alertas: Configura la supervisión de tus canalizaciones de datos para detectar anomalías y enviar alertas cuando surjan problemas de calidad de los datos.

from airflow import DAG

from airflow.operators.dummy_operator import DummyOperator

from airflow.operators.email_operator import EmailOperator

# Define your DAG and tasks...17. ¿Cómo gestionas los datos faltantes en tus conjuntos de datos?

El manejo de datos faltantes es una tarea común en la ingeniería de datos. Los enfoques incluyen:

- Eliminación: Simplemente elimina las filas o columnas con datos faltantes si no son significativas.

df.dropna(inplace=True)- Imputación: Rellena los valores que faltan con medidas estadísticas (media, mediana) o utiliza métodos más sofisticados, como la imputación KNN.

df['column'].fillna(df['column'].mean(), inplace=True)- Variable indicadora: Añade una variable indicadora para especificar qué valores faltaban.

df['column_missing'] = df['column'].isnull().astype(int)- Imputación basada en modelos: Utiliza modelos predictivos para estimar los valores que faltan.

from sklearn.impute import KNNImputer

imputer = KNNImputer(n_neighbors=5)

df = pd.DataFrame(imputer.fit_transform(df), columns=df.columns)18. ¿Cómo gestionas los límites de velocidad de la API al recuperar datos en Python?

Para gestionar los límites de velocidad de la API, existen estrategias como:

- Retroceder y volver a intentarlo: Implementación de retroceso exponencial cuando se alcanzan los límites de velocidad.

- Paginación: Obtención de datos en fragmentos más pequeños utilizando las opciones de paginación de la API.

- Almacenamiento en caché: Almacenamiento de respuestas para evitar llamadas API redundantes.

Ejemplo utilizando la biblioteca time de Python y el módulo requests:

import time

import requests

def fetch_data_with_rate_limit(url):

for attempt in range(5): # Retry up to 5 times

response = requests.get(url)

if response.status_code == 429: # Too many requests

time.sleep(2 ** attempt) # Exponential backoff

else:

return response.json()

raise Exception("Rate limit exceeded")Python es sin duda uno de los lenguajes más importantes en ingeniería de datos. Puedes perfeccionar tus habilidades con nuestro programa de ingeniero de datos en Python, que incluye un plan de estudios completo para que adquieras conocimientos sobre conceptos modernos de ingeniería de datos, lenguajes de programación, herramientas y marcos de trabajo.

Preguntas para una entrevista de trabajo como ingeniero de datos SQL

La fase de programación SQL es una parte importante del proceso de contratación de ingenieros de datos. Practicar varios guiones sencillos y complejos puede ayudarte a prepararte. Los entrevistadores pueden pedirte que escribas consultas para el análisis de datos, expresiones de tabla comunes, clasificación, adición de subtotales y funciones temporales.

19. ¿Qué son las expresiones de tabla comunes (CTE) en SQL?

Los CTE se utilizan para simplificar uniones complejas y ejecutar subconsultas. Ayudan a que las consultas SQL sean más legibles y fáciles de mantener. A continuación se muestra un ejemplo de una CTE que muestra todos los estudiantes con especialización en Ciencias y calificación A:

SELECT *

FROM class

WHERE id IN (

SELECT DISTINCT id

FROM students

WHERE grade = "A"

AND major = "Science"

);Usando un CTE, la consulta queda así:

WITH temp AS (

SELECT id

FROM students

WHERE grade = "A"

AND major = "Science"

)

SELECT *

FROM class

WHERE id IN (SELECT id FROM temp);Los CTE se pueden utilizar para problemas más complejos y se pueden encadenar varios CTE.

20. ¿Cómo clasificas los datos en SQL?

Los ingenieros de datos suelen clasificar los valores en función de parámetros como las ventas y los beneficios. La función RANK() se utiliza para clasificar datos en función de una columna específica:

SELECT

id,

sales,

RANK() OVER (ORDER BY sales DESC) AS rank

FROM bill;Como alternativa, puedes utilizar DENSE_RANK(), que no omite los rangos posteriores si los valores son iguales.

21. ¿Se puede crear una función temporal sencilla y utilizarla en una consulta SQL?

Al igual que en Python, puedes crear funciones en SQL para que tus consultas sean más elegantes y evitar sentencias case repetitivas. Aquí tienes un ejemplo de una función temporal get_gender:

CREATE TEMPORARY FUNCTION get_gender(type VARCHAR) RETURNS VARCHAR AS (

CASE

WHEN type = "M" THEN "male"

WHEN type = "F" THEN "female"

ELSE "n/a"

END

);

SELECT

name,

get_gender(type) AS gender

FROM class;Este enfoque hace que tu código SQL sea más limpio y fácil de mantener.

22. ¿Cómo se añaden subtotales en SQL?

Se pueden añadir subtotales utilizando las funciones « GROUP BY » y « ROLLUP() ». Aquí tienes un ejemplo:

SELECT

department,

product,

SUM(sales) AS total_sales

FROM sales_data

GROUP BY ROLLUP(department, product);Esta consulta te dará un subtotal para cada departamento y un total general al final.

23. ¿Cómo se gestionan los datos faltantes en SQL?

El manejo de los datos faltantes es esencial para mantener la integridad de los datos. Los enfoques comunes incluyen:

- Usando

COALESCE(): Esta función devuelve el primer valor no nulo de la lista.

SELECT id, COALESCE(salary, 0) AS salary FROM employees;- Uso de sentencias «

CASE»: Para manejar los valores perdidos de forma condicional.

SELECT id,

CASE

WHEN salary IS NULL THEN 0

ELSE salary

END AS salary

FROM employees;24. ¿Cómo se realiza la agregación de datos en SQL?

La agregación de datos implica el uso de funciones agregadas como SUM(), AVG(), COUNT(), MIN() y MAX(). Aquí tienes un ejemplo:

SELECT department,

SUM(salary) AS total_salary,

AVG(salary) AS average_salary,

COUNT(*) AS employee_count

FROM employees

GROUP BY department;25. ¿Cómo optimizas las consultas SQL para obtener un mejor rendimiento?

Para optimizar las consultas SQL, puedes:

- Utiliza índices en las columnas consultadas con frecuencia para acelerar las búsquedas.

- Evita el error «

SELECT *» especificando solo las columnas necesarias. - Utiliza las uniones con prudencia y evita las innecesarias.

- Optimiza el uso de subconsultas sustituyéndolas por CTE cuando sea apropiado.

- Analizar los planes de ejecución de consultas para identificar cuellos de botella. Ejemplo:

EXPLAIN ANALYZE

SELECT customer_id, COUNT(order_id)

FROM orders

GROUP BY customer_id;Resolver ejercicios de programación SQL es la mejor manera de practicar y repasar conceptos olvidados. Puedes evaluar tus conocimientos de SQL realizando la prueba de análisis de datos en SQL de DataCamp (necesitarás una cuenta para acceder a esta evaluación).

Preguntas para la entrevista a ingenieros de datos relacionados con proyectos

Después de las rondas generales de entrevistas, normalmente pasarás a una fase técnica que consiste en retos de programación, resolución de problemas, diseño de sistemas de bases de datos en una pizarra, un examen para hacer en casa y preguntas analíticas.

Esta etapa puede ser bastante intensa, por lo que conocer algunas de las preguntas y respuestas habituales en las entrevistas de ingeniería de datos puede ayudarte a superar la entrevista con éxito.

26. Explícame un proyecto en el que hayas trabajado desde el principio hasta el final.

Esta respuesta debería ser fácil si has trabajado anteriormente en un proyecto de ingeniería de datos como estudiante o profesional. Dicho esto, prepararse con antelación siempre es útil. A continuación te indicamos cómo estructurar tu respuesta:

- Introducción y problema empresarial:

- Empieza explicando el contexto del proyecto. Describe el problema empresarial que estabas resolviendo y los objetivos del proyecto.

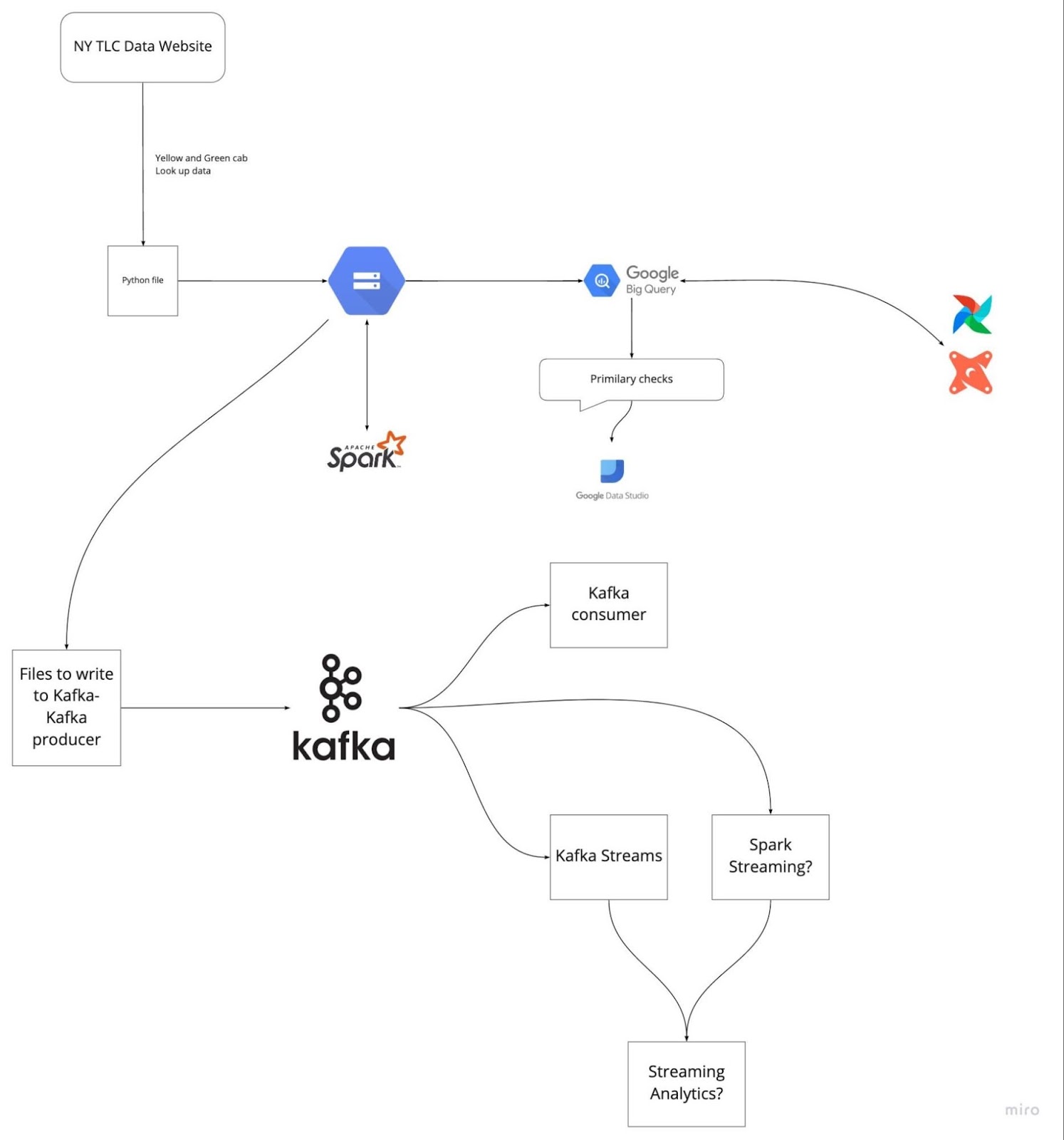

- Ejemplo: «En este proyecto, nuestro objetivo era optimizar el flujo de datos para procesar los datos de los registros de viajes de TLC con el fin de mejorar el rendimiento de las consultas y la precisión de los datos para el equipo de análisis».

- Ingesta de datos:

- Describe cómo accediste e ingestaste los datos sin procesar.

- Ejemplo: Ingestamos los datos sin procesar de TLC Trip Record utilizando GCP, Airflow y PostgreSQL para garantizar una ingesta fiable de datos procedentes de múltiples fuentes.

- Procesamiento y transformación de datos:

- Explica los pasos seguidos para limpiar, transformar y estructurar los datos.

- Ejemplo: Utilizamos Apache Spark para el procesamiento por lotes y Apache Kafka para la transmisión en tiempo real con el fin de gestionar la transformación de datos. Los datos se limpiaron, validaron y convirtieron a un formato estructurado adecuado para su análisis.

- Almacenamiento y depósito de datos:

- Discute las soluciones de almacenamiento de datos utilizadas y por qué se eligieron.

- Ejemplo: Los datos procesados se almacenaron en Google BigQuery, que proporcionó una solución de almacenamiento de datos escalable y eficiente. Se utilizó Airflow para gestionar los flujos de trabajo de datos.

- Ingeniería analítica:

- Destaca las herramientas y métodos utilizados con fines analíticos.

- Ejemplo: Utilizamos dbt (herramienta de creación de datos), BigQuery, PostgreSQL, Google Data Studio y Metabase para la ingeniería analítica. Estas herramientas ayudaron a crear modelos de datos robustos y a generar informes y paneles de control muy útiles.

- Entorno de implementación y nube:

- Menciona las estrategias de implementación y la infraestructura de nube utilizadas.

- Ejemplo: Todo el proyecto se implementó utilizando GCP, Terraform y Docker, lo que garantizó un entorno en la nube escalable y fiable.

- Retos y soluciones:

- Habla de los retos a los que te has enfrentado y cómo los has superado.

- Ejemplo: Uno de los principales retos era gestionar el gran volumen de datos en tiempo real. Abordamos este problema optimizando nuestros trabajos de streaming de Kafka e implementando transformaciones Spark eficientes.

- Resultados e impacto:

- Concluye describiendo los resultados y el impacto del proyecto.

- Ejemplo: El proyecto mejoró significativamente el rendimiento de las consultas y la precisión de los datos para el equipo de análisis, lo que permitió una toma de decisiones más rápida y una mejor comprensión.

Imagen de DataTalksClub/data-engineering-zoomcamp

Prepararte con antelación revisando los últimos cinco proyectos en los que has trabajado puede ayudarte a evitar quedarte bloqueado durante la entrevista. Comprende la descripción del problema y las soluciones que implementaste. Practica explicando cada paso de forma clara y concisa.

Preguntas para la entrevista de trabajo como gerente de ingeniería de datos

En el caso de los puestos de director de ingeniería, las preguntas suelen estar relacionadas con la toma de decisiones, la comprensión del negocio, la gestión y el mantenimiento de conjuntos de datos, el cumplimiento normativo y las políticas de seguridad.

27. ¿Cuál es la diferencia entre un almacén de datos y una base de datos operativa?

Un almacén de datos proporciona datos históricos para tareas de análisis de datos y toma de decisiones. Admite el procesamiento analítico de gran volumen, como el procesamiento analítico en línea (OLAP). Los almacenes de datos están diseñados para gestionar consultas complejas que acceden a múltiples filas y están optimizados para operaciones con un uso intensivo de lectura. Admiten varios usuarios simultáneos y están diseñados para recuperar grandes volúmenes de datos de forma rápida y eficiente.

Los sistemas de gestión de bases de datos operativas (OLTP) gestionan conjuntos de datos dinámicos en tiempo real. Admiten el procesamiento de grandes volúmenes de transacciones para miles de clientes simultáneos, lo que los hace adecuados para las operaciones diarias. Los datos suelen consistir en información actualizada sobre transacciones y operaciones comerciales. Los sistemas OLTP están optimizados para operaciones con gran volumen de escritura y procesamiento rápido de consultas.

28. ¿Por qué crees que todas las empresas que utilizan sistemas de datos necesitan un plan de recuperación ante desastres?

La gestión de desastres es responsabilidad de un gerente de ingeniería de datos. Un plan de recuperación ante desastres garantiza que los sistemas de datos puedan restaurarse y seguir funcionando en caso de un ciberataque, un fallo de hardware, un desastre natural u otros eventos catastróficos. Entre los aspectos relevantes se incluyen:

- Copia de seguridad en tiempo real: Realizar copias de seguridad periódicas de los archivos y bases de datos en ubicaciones de almacenamiento externas seguras.

- Redundancia de datos: Implementación de la replicación de datos en diferentes ubicaciones geográficas para garantizar la disponibilidad.

- Protocolos de seguridad: Establecimiento de protocolos para supervisar, rastrear y restringir tanto el tráfico entrante como el saliente con el fin de evitar violaciones de datos.

- Procedimientos de recuperación: Procedimientos detallados para restaurar datos y sistemas de forma rápida y eficiente con el fin de minimizar el tiempo de inactividad.

- Pruebas y simulacros: Probar periódicamente el plan de recuperación ante desastres mediante simulacros y ejercicios para garantizar su eficacia y realizar los ajustes necesarios.

29. ¿Cómo abordas la toma de decisiones cuando diriges un equipo de ingeniería de datos?

Como gerente de ingeniería de datos, la toma de decisiones implica equilibrar las consideraciones técnicas con los objetivos comerciales. Algunos enfoques incluyen:

- Decisiones basadas en datos: Utilizar el análisis de datos para fundamentar las decisiones, asegurándote de que se basen en información objetiva y no en la intuición.

- Colaboración entre las partes interesadas: Trabajar en estrecha colaboración con las partes interesadas para comprender los requisitos empresariales y alinear los esfuerzos de ingeniería de datos con los objetivos de la empresa.

- Evaluación de riesgos: Evaluar los riesgos potenciales y su impacto en los proyectos y desarrollar estrategias de mitigación.

- Metodologías ágiles: Implementación de prácticas ágiles para adaptarse a los requisitos cambiantes y ofrecer valor de forma incremental.

- Tutoría y desarrollo: Apoyar el crecimiento de los miembros del equipo proporcionando oportunidades de tutoría y formación y fomentando un entorno colaborativo.

30. ¿Cómo gestionas el cumplimiento de la normativa de protección de datos en tus proyectos de ingeniería de datos?

El cumplimiento de la normativa de protección de datos implica varias prácticas, por ejemplo:

- Comprensión de las normativas: Manteneros al día sobre las normativas de protección de datos, como el RGPD, la CCPA y la HIPAA.

- Marco de gobernanza de datos: Implementar un marco sólido de gobernanza de datos que incluya políticas de privacidad, seguridad y control de acceso a los datos.

- Cifrado de datos: Cifrado de datos confidenciales tanto en reposo como en tránsito para evitar el acceso no autorizado.

- Controles de acceso: La implementación de controles de acceso estrictos garantiza que solo el personal autorizado pueda acceder a los datos confidenciales.

- Auditorías y supervisión: Realizar auditorías periódicas y supervisar el acceso y el uso de los datos para detectar y abordar rápidamente cualquier problema de cumplimiento.

31. ¿Puedes describir un proyecto de ingeniería de datos complejo que hayas gestionado?

Al hablar de un proyecto complejo, puedes centrarte en los siguientes aspectos:

- Alcance y objetivos del proyecto: Define claramente los objetivos del proyecto y el problema empresarial que pretende resolver.

- Retos encontrados: Describe retos específicos, como limitaciones técnicas, restricciones de recursos o problemas de coordinación entre las partes interesadas.

- Estrategias y soluciones: Explica tus métodos para superar estos retos, incluyendo soluciones técnicas, prácticas de gestión de equipos y participación de las partes interesadas.

- Resultados e impacto: Destaca los resultados satisfactorios y el impacto en el negocio, como la mejora de la calidad de los datos, el aumento del rendimiento del sistema o el incremento de la eficiencia operativa.

32. ¿Cómo evalúas e implementas las nuevas tecnologías de datos?

La evaluación y la implementación de nuevas tecnologías de datos implica:

- Estudio de mercado: Mantenerse al día de los últimos avances y tendencias en tecnologías de ingeniería de datos.

- Prueba de concepto (PoC): Realización de proyectos PoC para comprobar la viabilidad y las ventajas de las nuevas tecnologías en tu contexto específico.

- Análisis de coste-beneficio: Evaluación de los costes, beneficios y posible retorno de la inversión que supone la adopción de nuevas tecnologías.

- Aceptación por parte de las partes interesadas: Presentar los resultados y recomendaciones a las partes interesadas para garantizar su aceptación y apoyo.

- Plan de implementación: Desarrollar un plan de implementación detallado que incluya plazos, asignación de recursos y estrategias de gestión de riesgos.

- Formación y asistencia: Proporcionar formación y apoyo al equipo para garantizar una transición fluida a las nuevas tecnologías.

33. ¿Cómo priorizas las tareas y los proyectos en un entorno dinámico?

Una forma eficaz de priorizar las tareas se basa en su impacto en los objetivos empresariales y en su urgencia. Puedes utilizar marcos de trabajo como la matriz de Eisenhower para clasificar las tareas en cuatro cuadrantes: urgentes e importantes, importantes pero no urgentes, urgentes pero no importantes, y ninguna de las dos cosas. Además, comunícate con las partes interesadas para alinear las prioridades y garantizar que el equipo se centre en actividades de alto valor.

Preguntas para la entrevista de ingeniero de datos de FAANG

En esta sección, exploramos las preguntas más frecuentes en las entrevistas de ingeniería de datos realizadas por los responsables de Facebook, Amazon y Google para puestos de ingeniería de datos.

Preguntas para la entrevista de ingeniero de datos en Facebook

34. ¿Por qué usamos clústeres en Kafka y cuáles son sus ventajas?

Un clúster Kafka consta de varios brokers que distribuyen datos entre múltiples instancias. Esta arquitectura proporciona escalabilidad y tolerancia a fallos sin tiempo de inactividad. Si el clúster principal deja de funcionar, otros clústeres de Kafka pueden prestar los mismos servicios, lo que garantiza una alta disponibilidad.

La arquitectura del clúster Kafka comprende temas, corredores, ZooKeeper, productores y consumidores. Maneja de manera eficiente los flujos de datos para aplicaciones de big data, lo que permite la creación de aplicaciones robustas basadas en datos.

35. ¿Qué problemas resuelve Apache Airflow?

Apache Airflow te permite gestionar y programar canalizaciones para flujos de trabajo analíticos, gestión de almacenes de datos y transformación y modelado de datos. Proporciona:

- Gestión de proyectos en curso: Una plataforma para definir, programar y supervisar flujos de trabajo.

- Registro centralizado: Supervisa los registros de ejecución en un solo lugar.

- Gestión de errores: Devoluciones de llamada para enviar alertas de fallo a plataformas de comunicación como Slack y Discord.

- Interfaz de usuario: Una interfaz de usuario intuitiva para gestionar y visualizar flujos de trabajo.

- Integración: Integraciones sólidas con diversas herramientas y sistemas.

- Código abierto: Su uso es gratuito y cuenta con un amplio apoyo por parte de la comunidad.

Preguntas de la entrevista para ingeniero de datos de Amazon

36. Se te proporciona una dirección IP como entrada en forma de cadena. ¿Cómo se puede saber si una dirección IP es válida o no?

Para determinar la validez de una dirección IP, puedes dividir la cadena en «.» y crear varias comprobaciones para validar cada segmento. Aquí tienes una función Python para lograrlo:

def is_valid(ip):

ip = ip.split(".")

for i in ip:

if len(i) > 3 or int(i) < 0 or int(i) > 255:

return False

if len(i) > 1 and int(i) == 0:

return False

if len(i) > 1 and int(i) != 0 and i[0] == '0':

return False

return True

A = "255.255.11.135"

B = "255.050.11.5345"

print(is_valid(A)) # True

print(is_valid(B)) # False37. ¿Cuáles son los distintos modos de Hadoop?

Hadoop funciona principalmente en tres modos:

- Modo autónomo: Este modo se utiliza con fines de depuración. No utiliza HDFS y depende del sistema de archivos local para la entrada y salida.

- Modo pseudodistribuido: Se trata de un clúster de un solo nodo en el que NameNode y DataNode residen en la misma máquina. Se utiliza principalmente para pruebas y desarrollo.

- Modo totalmente distribuido: Este es un modo listo para la producción en el que los datos se distribuyen entre varios nodos, con nodos separados para los demonios maestro (NameNode) y esclavo (DataNode).

Preguntas de la entrevista para ingeniero de datos de Google

38. ¿Cómo manejarías los puntos de datos duplicados en una consulta SQL?

Para gestionar los duplicados en SQL, puedes utilizar la palabra clave « DISTINCT » (mantener duplicados) o eliminar las filas duplicadas utilizando « ROWID » (mantener duplicados) con la función « MAX » (mantener duplicados) o « MIN » (mantener duplicados). Aquí hay algunos ejemplos:

Usando DISTINCT:

SELECT DISTINCT Name, ADDRESS

FROM CUSTOMERS

ORDER BY Name;Eliminación de duplicados con ROWID:

DELETE FROM Employee

WHERE ROWID NOT IN (

SELECT MAX(ROWID)

FROM Employee

GROUP BY Name, ADDRESS

);39. Dada una lista de n-1 números enteros, estos números enteros están en el rango de 1 a n. No hay duplicados en la lista. Falta uno de los números enteros en la lista. ¿Puedes escribir un código eficiente para encontrar el número entero que falta?

Este problema habitual de codificación se puede resolver utilizando un enfoque matemático:

def search_missing_number(list_num):

n = len(list_num)

# Check if the first or last number is missing

if list_num[0] != 1:

return 1

if list_num[-1] != n + 1:

return n + 1

# Calculate the sum of the first n+1 natural numbers

total = (n + 1) * (n + 2) // 2

# Calculate the sum of all elements in the list

sum_of_L = sum(list_num)

# Return the difference, which is the missing number

return total - sum_of_L

# Validation

num_list = [1, 2, 3, 4, 5, 6, 7, 8, 9, 10, 11, 13]

print("The missing number is", search_missing_number(num_list)) # The missing number is 12Cómo prepararse para la entrevista de ingeniero de datos

Antes de acudir a una entrevista, debes repasar todos los conceptos y términos estándar utilizados en ingeniería de datos. Estas son algunas de las áreas más importantes en las que debes centrarte:

- Domina SQL: Debes practicar la creación, modificación y gestión de bases de datos. Además, debes dominar el análisis, el modelado y la transformación de datos.

- Resuelve retos de programación: Resuelve retos de programación en Python, Scala o C++. La mayoría de las empresas evalúan las habilidades de programación mediante exámenes para hacer en casa y retos de programación en directo.

- Diseña un canal ETL: practica la creación de canales de datos, ETL o entrega. Debes comprender cómo probar, validar, escalar y mantener los flujos de datos.

- Ingeniería analítica: práctica de carga, transformación y análisis de datos. Aprende a crear un panel de control para la calidad de los datos y el rendimiento del sistema.

- Revisa las posibles preguntas: Prepárate para la entrevista revisando ejemplos de preguntas tipo. Una simple búsqueda en Google te dará acceso a cientos de preguntas.

- Aprende sobre las herramientas modernas de ingeniería de datos: aunque no tengas experiencia con ellas, debes saber cómo funcionan y cómo se integran con otras herramientas. Las empresas siempre están buscando mejores herramientas para mejorar el rendimiento a un menor costo.

- Aprende el procesamiento por lotes y la transmisión: Apache Spark se utiliza para el procesamiento por lotes, y Apache Kafka se utiliza para la transmisión de datos. Estas herramientas tienen una gran demanda y te ayudarán a conseguir un trabajo en las mejores empresas.

- Environment: En ocasiones, el entrevistador preguntará sobre la nube (GCP, AWS, Azure), Docker, scripting, Terraform y Kubernetes. Puedes utilizar estas herramientas para configurar recursos informáticos y de almacenamiento en la nube o locales. Comprender estas tecnologías e integrarlas en los proyectos del portafolio es una buena práctica.

Prepararse para una entrevista de ingeniería de datos puede ser todo un reto, pero con los recursos adecuados y la práctica necesaria, puedes destacar y conseguir el trabajo de tus sueños. Para mejorar aún más tus habilidades y conocimientos, consulta estos valiosos recursos:

- Comprender la ingeniería de datos: Adquiere un conocimiento exhaustivo de los conceptos y principios de la ingeniería de datos.

- Ingeniero de datos en Python: Domina la ingeniería de datos con Python a través de este programa, que abarca herramientas y marcos esenciales.

- Diseño de bases de datos: Aprende los fundamentos del diseño de bases de datos para crear bases de datos eficientes y escalables.

Aprovecha estos cursos para consolidar tus conocimientos básicos y mantenerte a la vanguardia en tu carrera como ingeniero de datos. ¡Buena suerte con tus entrevistas!

Conviértete en Ingeniero de Datos

Preguntas frecuentes

¿Qué puedo esperar de una entrevista para ingeniero de datos?

Puedes esperar una entrevista telefónica con RR. HH., una entrevista telefónica técnica, un examen para hacer en casa, un reto de programación, una entrevista presencial, diseños de bases de datos y sistemas en pizarra, una entrevista sobre SQL y, por último, la entrevista «ejecutiva» para comprobar tu adecuación cultural.

Algunas empresas tienen tres etapas de entrevistas, mientras que otras tienen hasta nueve etapas. Las organizaciones suelen tener una barrera de entrada elevada para evaluar a los candidatos en todos los niveles.

¿Hay demanda de ingenieros de datos?

Sí, todas las empresas que generan datos necesitan ingenieros de datos para crear canales, gestionar y entregar datos a los distintos departamentos. Para 2025, producirán 463 exabytes de datos al día y necesitarán cada vez más ingenieros para extraer, transformar y gestionar los sistemas y canales de datos. weforum.org.

¿Los ingenieros de datos escriben código?

Sí, todas las personas relacionadas con el campo de la informática deben aprender a escribir código, incluso a nivel directivo. Para los ingenieros de datos, Python, SQL, Docker, Yaml y Bash son lenguajes de programación necesarios. Se utilizan en infraestructura como código, canalizaciones, gestión de bases de datos, streaming, web scraping, procesamiento de datos, modelización y análisis.

¿Cuál es la diferencia entre un analista de datos y un ingeniero de datos?

El ingeniero de datos recopila, transforma y prepara datos para que los analistas de datos extraigan información valiosa para el negocio. Los ingenieros de datos gestionan todos los sistemas de bases de datos y se aseguran de que proporcionen datos de alta calidad para tareas de análisis de datos, como informes analíticos, paneles de control, estudios de clientes y previsiones.

¿Qué hace realmente un ingeniero de datos?

Adquirir datos de múltiples fuentes, crear, validar y mantener canales de datos, transformar datos mediante algoritmos, realizar ingeniería analítica, garantizar el cumplimiento de la gobernanza y la seguridad de los datos, y mantener sistemas completos de bases de datos. Son responsables de proporcionar flujos de datos de alta calidad a varios departamentos de una empresa. Puedes obtener más información sobre la ingeniería de datos leyendo ¿Qué es la ingeniería de datos? blog.

¿Qué habilidades se necesitan para ser ingeniero de datos?

Debes tener conocimientos de programación, almacenamiento de datos, ETL (Extract Transform Load), consultas SQL, análisis y modelado de datos, aspectos críticos y habilidades de comunicación. La ingeniería de datos se aprende a través de la experiencia y superando retos complejos en el campo. Nuestra Certificación en Ingeniería de Datos es la iniciativa perfecta para desarrollar tus habilidades y conseguir un puesto como ingeniero de datos.

Soy un científico de datos certificado que disfruta creando aplicaciones de aprendizaje automático y escribiendo blogs sobre ciencia de datos. Actualmente me centro en la creación de contenidos, la edición y el trabajo con grandes modelos lingüísticos.