programa

La generación aumentada por recuperación (RAG) se está convirtiendo rápidamente en una de las evoluciones más prácticas en el uso de grandes modelos lingüísticos. No se trata de un nuevo modelo ni de sustituir a los LLM, sino de un sistema innovador que les ayuda a razonar con hechos extraídos de fuentes de datos reales. En esencia, la RAG resuelve algunos de los mayores retos de la IA generativa: las alucinaciones, la memoria limitada y los conocimientos obsoletos. Combinar la recuperación y la generación en un único proceso permite a los modelos basar sus respuestas en un contexto actual y relevante, a menudo específico de un negocio o dominio.

Este cambio es más importante que nunca. En entornos empresariales, se espera que los LLM respondan con precisión y explicabilidad. Los programadores quieren resultados que reflejen la documentación del producto, las wikis internas o los tickets de soporte, no conocimientos web genéricos. El GAR lo hace posible.

Esta guía explica cómo funciona el marco RAG, dónde encaja en tu pila de IA y cómo utilizarlo con herramientas y datos fundamentales.

¿Qué es un marco RAG?

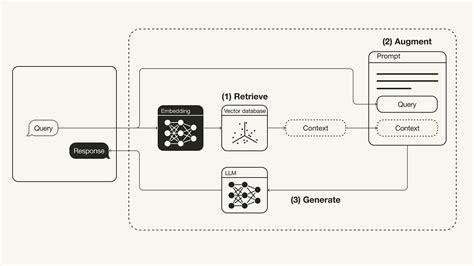

RAG significa Recuperar, Aumentar, Generar. Es inteligente dar a los grandes modelos lingüísticos (LLM) acceso a conocimientos externos sin volver a entrenarlos.

Ésta es la idea: cuando un usuario hace una pregunta, en lugar de lanzarla directamente al modelo y esperar una buena respuesta, RAG recuperaprimero información relevante de una base de conocimientos. Después, aumenta la indicación original con este contexto extra. Por último, elLLM genera una respuesta utilizando la pregunta y la información añadida.

Este enfoque ayuda a resolver las limitaciones clave del LLM -como las alucinaciones, la memoria corta (ventanas de contexto) y los cortes de conocimiento- introduciendo datos reales, actuales y relevantes sobre la marcha.

¿Por qué utilizar un marco RAG?

Los LLM independientes son impresionantes, pero tienen puntos ciegos. Alucinan, olvidan cosas y no saben nada más nuevo que su último entrenamiento. Los GAR cambian eso. Al combinar los LLM con la recuperación en tiempo real, obtienes:

- Precisión de los hechos: Las respuestas se basan en tus datos reales, no en suposiciones.

- Relevancia del dominio: Puedes inyectar conocimientos de nicho o internos.

- No es necesario volver a formarse: Sólo tienes que actualizar tu base de conocimientos: no es necesario afinar es necesario.

- Escalabilidad: Ideal para chatbots, herramientas de búsqueda, asistentes de ayuda y mucho más.

En resumen, RAG te permite construir sistemas de IA más inteligentes y fiables con mucho menos esfuerzo.

Los mejores marcos RAG de código abierto

El ecosistema RAG está creciendo rápidamente, con docenas de proyectos de código abierto que ayudan a los programadores a crear aplicaciones más inteligentes y mejoradas para la recuperación. Tanto si buscas algo conectable y sencillo como un pipeline completo con componentes personalizables, es probable que haya una herramienta para ti.

A continuación, repasaremos los principales marcos RAG de código abierto. Cada entrada destaca su tracción en GitHub, estilo de despliegue, puntos fuertes únicos, casos de uso principales y un elemento visual para que te hagas una idea rápida del proyecto.

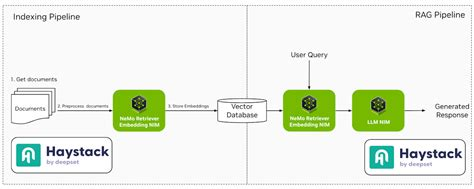

1. Pajar

Haystack es un marco robusto y modular diseñado para construir sistemas de PNL listos para la producción. Admite varios componentes, como recuperadores, lectores y generadores, lo que permite una integración perfecta con herramientas como Elasticsearch y Hugging Face Transformers.

- Estrellas de GitHub: ~13.5k

- Despliegue: Docker, Kubernetes, Espacios Hugging Face

- Características destacadas: Componentes modulares, fuerte integración con Hugging Face, soporte multilingüe

- Casos prácticos: Sistemas de control de calidad, chatbots, búsqueda interna de documentos(TrueFoundry, Anyscale, LobeHub)

2. LlamaIndex

LlamaIndex es un marco de datos que conecta fuentes de datos personalizadas con grandes modelos lingüísticos. Simplifica el proceso de indexación y consulta de datos, facilitando la creación de aplicaciones que requieren respuestas conscientes del contexto.

- Estrellas de GitHub: ~13k

- Despliegue: Basado en Python, se ejecuta en cualquier lugar con datos de archivos o web

- Características destacadas: Abstracciones sencillas para indexación, recuperación y encaminamiento

- Casos prácticos: Asistentes personales, robots de conocimiento, demos RAG (GitHub)

3. LangChain

LangChain es un marco integral que permite a los programadores crear aplicaciones basadas en modelos lingüísticos. Ofrece herramientas para encadenar distintos componentes, como plantillas de avisos, memorias y agentes, para crear flujos de trabajo complejos.

- Estrellas de GitHub: ~72k

- Despliegue: Python, JavaScript, compatible con las principales nubes

- Características destacadas: Encadenamiento de herramientas, agentes, plantillas de avisos, integraciones en abundancia

- Casos prácticos: Aplicaciones LLM de extremo a extremo, agentes de datos, flujos de chat dinámicos

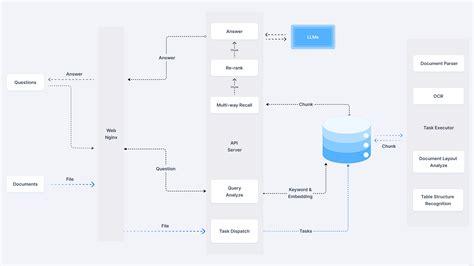

4. RAGFlow

RAGFlow es un motor de código abierto centrado en la comprensión profunda de documentos. Proporciona un flujo de trabajo racionalizado para que las empresas implanten sistemas GAR, haciendo hincapié en la veracidad de las respuestas a las preguntas, respaldadas por citas de formatos de datos complejos.

- Estrellas de GitHub: ~1.1k

- Despliegue: Docker; admite microservicios basados en FastAPI

- Características destacadas: Visualizador de trozos, integración con Weaviate, configuraciones flexibles

- Casos prácticos: Backends RAG ligeros, prototipo empresarialpes(jina.ai)

5. txtAI

txtAI es un marco de IA todo en uno que combina la búsqueda semántica con las capacidades de la GAR. Permite crear aplicaciones que busquen, indexen y recuperen información de forma eficaz, admitiendo varios tipos y formatos de datos.

- Estrellas de GitHub: ~3.9k

- Despliegue: Basado en Python; se ejecuta con unas pocas líneas de código.

- Características destacadas: Extremadamente ligero, modo offline, soporte de puntuación/ranking

- Casos prácticos: Motores de búsqueda basados en incrustaciones, chat-con-PDF, metadatos Preguntas y respuestas(Introducción | LangChain, GitHub, GitHub)

6. Cognita

Cognita es un marco RAG modular diseñado para facilitar la personalización y el despliegue. Ofrece una interfaz frontal para experimentar con distintas configuraciones de RAG, lo que la hace adecuada tanto para entornos de desarrollo como de producción.

- Estrellas de GitHub: Notable

- Despliegue: Integraciones Docker + TrueFoundry

- Características destacadas: Basado en API, preparado para interfaz de usuario, fácil de escalar

- Casos prácticos: Asistentes de IA para empresas, data-backed chatbots(TrueFoundry, LlamaIndex)

7. LLMWare

LLMWare proporciona un marco unificado para crear aplicaciones RAG de nivel empresarial. Hace hincapié en el uso de modelos pequeños y especializados que puedan desplegarse de forma privada, garantizando la seguridad de los datos y el cumplimiento de la normativa.

- Estrellas de GitHub: ~2.5k

- Despliegue: Herramienta CLI, API, plantillas de proyecto personalizables

- Características destacadas: Pipelines sin código, herramientas de análisis de documentos

- Casos prácticos: Agentes documentales, el conocimiento comosistants(LinkedIn)

8. TORMENTA

STORM es un asistente de investigación que amplía el concepto de GAR basado en esquemas. Se centra en generar artículos completos sintetizando información de varias fuentes, lo que lo hace ideal para tareas de creación de contenidos.

- Estrellas de GitHub: Niche

- Despliegue: Instalación del código fuente

- Características destacadas: Motor de razonamiento Co-STORM, exploración basada en grafos

- Casos prácticos: Configuraciones RAG personalizadas, investigación QA pipelines(GitHub)

9. R2R

R2R (Reason to Retrieve) es un sistema avanzado de recuperación de IA compatible con el GAR con funciones listas para la producción. Ofrece ingesta de contenido multimodal, búsqueda híbrida e integración de grafos de conocimiento, atendiendo a las complejas necesidades empresariales.

- Estrellas de GitHub: Niche

- Despliegue: API REST, soporta búsqueda híbrida y gráfica

- Características destacadas: RAG multimodal, validación de documentos

- Casos prácticos: Herramientas de investigación de IA, edad académicants(YouTube, Open Source For You, Weaviate Newsletter)

10. EmbedChain

EmbedChain es una biblioteca de Python que simplifica la creación y el despliegue de aplicaciones de IA utilizando modelos RAG. Admite varios tipos de datos, como PDF, imágenes y páginas web, lo que lo hace versátil para distintos casos de uso.

- Estrellas de GitHub: ~3.5k

- Despliegue: Python lib, también disponible como SaaS alojado

- Características destacadas: Configuración de aplicaciones con un solo comando, API primero

- Casos prácticos: Prototipado rápido, creación de robots de conocimiento para un dominiony(LLMWare AI for Complex Enterprises)

11. RAGatouille

RAGatouille integra métodos avanzados de recuperación, como ColBERT, en los conductos RAG. Permite la experimentación modular con distintas técnicas de recuperación, mejorando la flexibilidad y el rendimiento de los sistemas RAG.

- Estrellas de GitHub: Nicho pero en crecimiento

- Despliegue: Paquete Python

- Características destacadas: Experimentación de recuperación, entradas modulares

- Casos prácticos: Evaluación de las técnicas de recuperación en los conductos RAG

12. Verba

Verba es un asistente personal personalizable que utiliza RAG para consultar datos e interactuar con ellos. Se integra con la base de datos consciente del contexto de Weaviate, lo que permite una recuperación de la información y una interacción eficaces.

- Estrellas de GitHub: Modesto

- Despliegue: Compatible con local y en la nube

- Características destacadas: Memoria contextual, datos personales Preguntas y respuestas

- Casos prácticos: Asistente de construcción, exploración de datosación(LinkedIn, Brandfetch)

13. Jina AI

Jina AI ofrece herramientas para crear aplicaciones multimodales de IA con opciones de despliegue escalables. Es compatible con varios protocolos de comunicación, lo que la hace adecuada para programadores que quieran crear y ampliar servicios de IA.

- Estrellas de GitHub: ~18k (org principal)

- Despliegue: Docker, API REST/gRPC/WebSocket

- Características destacadas: Canalizaciones multimodales, búsqueda híbrida

- Casos prácticos: Aplicaciones de nivel empresarial que combinan texto, imagen o vídeo

14. Neurita

Neurite es un marco RAG emergente que simplifica la creación de aplicaciones potenciadas por IA. Su énfasis en la experiencia de los programadores y la creación rápida de prototipos la convierten en una opción atractiva para la experimentación.

- Estrellas de GitHub: Pequeño pero prometedor

- Despliegue: Configuración de la fuente

- Características destacadas: Fusión neural-simbólica

- Casos prácticos: Experimentos de investigación sobre IA, prototipos systems( GitHub, Hugging Face, GitHub)

15. LLM-App

LLM-App es un marco para crear aplicaciones basadas en grandes modelos lingüísticos. Proporciona plantillas y herramientas para agilizar el proceso de desarrollo, facilitando la integración de las capacidades de RAG en diversas aplicaciones.

- Estrellas de GitHub: Emergente

- Despliegue: Herramientas de despliegue y CLI basadas en Git

- Características destacadas: Plantillas de inicio de aplicaciones, preparadas para OpenAI

- Casos prácticos: Proyectos RAG personales, herramientas de hackathon

Cada marco ofrece características únicas adaptadas a diferentes casos de uso y preferencias de despliegue. En función de tus requisitos específicos, la facilidad de despliegue, la personalización o las capacidades de integración, puedes elegir el marco que mejor se ajuste a los objetivos de tu proyecto.

Elegir el marco RAG adecuado

La selección del marco GAR adecuado depende de tus necesidades específicas: análisis de documentos legales, investigación académica o desarrollo local ligero. Utiliza esta tabla para comparar rápidamente los marcos RAG de código abierto más populares en función de cómo se despliegan, lo personalizables que son, su compatibilidad con la recuperación avanzada, las capacidades de integración y para qué se utiliza mejor cada herramienta.

|

Marco |

Despliegue |

Personalización |

Recuperación avanzada |

Apoyo a la integración |

Lo mejor para |

|

Pajar |

Docker, K8s, Hugging Face |

Alta |

Sí |

Elasticsearch, Hugging Face |

Búsqueda empresarial y control de calidad |

|

LlamaIndex |

Python (local/nube) |

Alta |

Sí |

LangChain, FAISS |

Robots con conciencia documental |

|

LangChain |

Python, JS, Cloud |

Alta |

Sí |

OpenAI, APIs, DBs |

Agentes y conductos LLM |

|

RAGFlow |

Docker |

Medio |

Sí |

Weaviate |

Documentos legales o estructurados |

|

txtAI |

Local (Python) |

Medio |

Básico |

Transformers |

Desarrollo local ligero |

|

Cognita |

Docker + UI |

Alta |

Sí |

TrueFoundry |

Herramientas empresariales basadas en GUI |

|

LLMWare |

CLI, APIs |

Alta |

Sí |

LLM privados |

Empresa privada RAG |

|

TORMENTA |

Fuente instalar |

Alta |

Sí |

LangChain, LangGraph |

Ayudantes de investigación |

|

R2R |

API REST |

Alta |

Sí |

Multimodal |

Académico e híbrido RAG |

|

EmbedChain |

Python, SaaS |

Medio |

Básico |

Web, PDF, Images |

Prototipado rápido |

|

RAGatouille |

Python |

Alta |

Sí |

ColBERT |

Experimentación con Retriever |

|

Verba |

Nube/Local |

Medio |

Básico |

Weaviate |

Asistentes contextuales |

|

Jina AI |

Docker, REST/gRPC |

Alta |

Sí |

API multimodales |

Aplicaciones multimodales escalables |

|

Neurita |

Configuración de la fuente |

Medio |

No |

N/A |

Experimentación |

|

LLM-App |

CLI, Git |

Medio |

No |

OpenAI |

Hackathon LLM apps |

Errores comunes al aplicar la GAR

Los sistemas RAG pueden ser robustos, pero también tienen aristas afiladas. Si no tienes cuidado, las respuestas de tu modelo pueden acabar peor que si no hubieras utilizado la recuperación. He aquí cuatro problemas comunes que debes evitar, y qué hacer en su lugar.

1. Indexar demasiada basura

No todo tiene que ir a tu tienda de vectores. Volcar cada documento, entrada de blog o hilo de correo electrónico puede parecer minucioso, pero sólo contamina tu búsqueda. El recuperador atrae contexto de poco valor, que el modelo debe clasificar (a menudo mal utilizado). En su lugar, sé selectivo. Sólo indexa contenidos que sean precisos, estén bien escritos y sean útiles. Limpia antes de guardar.

2. Ignorar los límites de los tokens

Los LLM tienen poca memoria. Algo se corta si tu petición, más todos los trozos recuperados, supera el límite de tokens del modelo. Ese "algo" podría ser la parte importante. En lugar de eso, mantén las indicaciones ajustadas. Limita el número de trozos recuperados o resúmelos antes de enviarlos al modelo.

3. Optimizar la recuperación, no la precisión

Es tentador recuperar más documentos para asegurarte de que "lo cubres todo". Pero si los resultados adicionales están poco relacionados, llenas el mensaje de palabrería. El modelo se distrae o, peor aún, se confunde. En lugar de eso, busca una gran precisión. Unos pocos trozos muy relevantes son mejores que una larga lista de partidos débiles.

4. Volar a ciegas sin troncos

Cuando el modelo da una mala respuesta, ¿sabes por qué? Estás depurando en la oscuridad si no registras la consulta, los documentos recuperados y la consulta final. En su lugar, Registra el flujo RAG completo. Eso incluye la entrada del usuario, el contenido recuperado, lo que se envió al modelo y la respuesta del modelo.

Conclusión

La RAG no es una solución mágica para todo, pero cuando se utiliza correctamente, es una de las formas más eficaces de hacer que los LLM sean más innovadores, prácticos y basados en los datos que importan a tu empresa.

La clave está en saber con qué trabajas. Elegir el marco adecuado forma parte de ello, pero el éxito se reduce a lo bien que entiendas tus datos y a lo cuidadosamente que afines tu canal de recuperación. El principio de "basura entrante, basura saliente" sigue siendo válido, sobre todo cuando construyes sistemas que generan lenguaje, no sólo recuperan hechos.

Haz una indexación correcta, vigila el uso de tokens y controla el flujo de extremo a extremo. Cuando todas esas piezas encajan, RAG puede transformar tus aplicaciones de IA de impresionantes a auténticamente útiles.

Redactor técnico especializado en IA, ML y ciencia de datos, que hace que las ideas complejas sean claras y accesibles.

Preguntas frecuentes

¿Para qué sirve el marco RAG?

Los marcos RAG ayudan a los LLM a responder preguntas utilizando datos en tiempo real, como documentos, sitios web o wikis internos.

¿Necesito ajustar mi modelo para utilizar el GAR?

No. Los marcos RAG funcionan recuperando datos relevantes y añadiéndolos a la solicitud. No tienes que volver a entrenar al modelo base.

¿Qué tipo de datos pueden utilizar los marcos GAR?

Eso depende del marco. Muchos admiten PDF, sitios web, archivos Markdown, bases de datos y mucho más.

¿Pueden funcionar los marcos RAG con modelos OpenAI o Hugging Face?

Sí, la mayoría de los marcos son agnósticos respecto al modelo y se integran fácilmente con las API de OpenAI, Cohere, Anthropic y Hugging Face.

¿Qué diferencia hay entre la búsqueda vectorial y la búsqueda por palabras clave en RAG?

La búsqueda vectorial utiliza incrustaciones para encontrar texto semánticamente relevante, mientras que la búsqueda por palabras clave se basa en coincidencias exactas de palabras.