Cursus

La génération augmentée par récupération (RAG) devient rapidement l'une des évolutions les plus pratiques dans l'utilisation de grands modèles linguistiques. Il ne s'agit pas d'un nouveau modèle ni d'un substitut aux LLM, mais d'un système innovant qui les aide à raisonner à partir de faits tirés de sources de données réelles. À la base, RAG résout certains des plus grands défis de l'IA générative : les hallucinations, la mémoire limitée et les connaissances obsolètes. La combinaison de la recherche et de la génération dans un seul pipeline permet aux modèles d'ancrer leurs réponses dans un contexte actuel et pertinent, souvent spécifique à une entreprise ou à un domaine.

Cette évolution est plus importante que jamais. Dans les entreprises, on attend des LLM qu'ils répondent de manière précise et explicite. Les développeurs veulent des résultats reflétant la documentation du produit, les wikis internes ou les tickets d'assistance, et non des connaissances génériques sur le web. RAG rend cela possible.

Ce guide explique comment fonctionne le cadre RAG, où il s'insère dans votre pile d'IA et comment l'utiliser avec des outils et des données fondamentaux.

Qu'est-ce que le cadre RAG ?

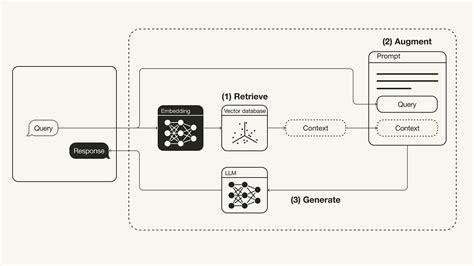

RAG signifie Retrieve, Augment, Generate. Il est judicieux de permettre aux grands modèles de langage (LLM) d'accéder à des connaissances externes sans avoir à les entraîner à nouveau.

Voici l'idée : lorsqu'un utilisateur pose une question, au lieu de la poser directement au modèle et d'espérer une bonne réponse, RAG récupère d'abord les informations pertinentes sur le site à partir d'une base de connaissances. Ensuite, il complète l'invite originale avec ce contexte supplémentaire. Enfin, lesite LLM génère une réponse à partir de la question et des informations ajoutées.

Cette approche permet de résoudre les principales limitations de la LLM, telles que les hallucinations, la mémoire courte (fenêtres contextuelles) et les coupures de connaissances, en introduisant à la volée des données réelles, actuelles et pertinentes.

Pourquoi utiliser un cadre RAG ?

Les LLM autonomes sont impressionnants, mais ils présentent des lacunes. Ils ont des hallucinations, oublient des choses et ne connaissent rien de plus récent que leur dernière course d'entraînement. Les RAG changent la donne. En combinant les LLM avec la recherche en temps réel, vous obtenez :

- Précision des faits: Les réponses sont basées sur vos données réelles, et non sur des suppositions.

- Pertinence du domaine: Vous pouvez injecter des connaissances de niche ou des connaissances internes.

- Aucun recyclage n'est nécessaire : Il suffit de mettre à jour votre base de connaissances. n'est nécessaire.

- Évolutivité: Idéal pour les chatbots, les outils de recherche, les assistants d'assistance, etc.

En bref, RAG vous permet de construire des systèmes d'IA plus intelligents et plus fiables avec beaucoup moins d'efforts.

Les meilleurs frameworks RAG open-source

L'écosystème RAG se développe rapidement, avec des dizaines de projets open-source aidant les développeurs à créer des applications plus intelligentes, augmentées par la recherche. Que vous recherchiez quelque chose d'enfichable et de simple ou un pipeline complet avec des composants personnalisables, il y a probablement un outil pour vous.

Ci-dessous, nous allons passer en revue les meilleurs frameworks RAG open-source. Chaque entrée met en évidence sa traction GitHub, son style de déploiement, ses forces uniques, ses principaux cas d'utilisation, ainsi qu'un visuel pour vous donner une idée rapide du projet.

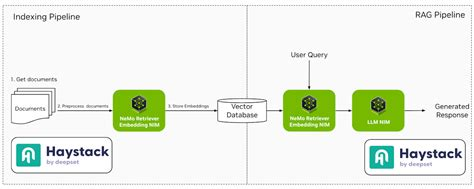

1. Botte de foin

Haystack est un cadre robuste et modulaire conçu pour construire des systèmes NLP prêts à la production. Il prend en charge divers composants tels que les récupérateurs, les lecteurs et les générateurs, ce qui permet une intégration transparente avec des outils tels qu'Elasticsearch et Hugging Face Transformers.

- Étoiles GitHub: ~13.5k

- Déploiement: Docker, Kubernetes, les espaces Hugging Face

- Caractéristiques principales: Composants modulaires, forte intégration de Hugging Face, support multilingue

- Cas d'utilisation: Systèmes d'assurance qualité de niveau entreprise, chatbots, recherche de documents internes(TrueFoundry, Anyscale, LobeHub)

2. LlamaIndex

LlamaIndex est un cadre de données qui relie des sources de données personnalisées à de grands modèles linguistiques. Il simplifie le processus d'indexation et d'interrogation des données, ce qui facilite la création d'applications nécessitant des réponses adaptées au contexte.

- Étoiles GitHub: ~13k

- Déploiement: Basé sur Python, fonctionne n'importe où avec des fichiers ou des données web.

- Caractéristiques principales: Des abstractions simples pour l'indexation, la recherche et le routage

- Cas d'utilisation: Assistants personnels, knowledge bots, démos RAG (GitHub)

3. LangChain

LangChain est un cadre complet qui permet aux développeurs de créer des applications basées sur des modèles linguistiques. Il offre des outils permettant d'enchaîner différents composants tels que des modèles d'invite, des mémoires et des agents afin de créer des flux de travail complexes.

- Étoiles GitHub: ~72k

- Déploiement: Python, JavaScript, pris en charge sur tous les principaux clouds.

- Caractéristiques principales: Enchaînement d'outils, agents, modèles d'invite, intégrations à profusion

- Cas d'utilisation: Applications LLM de bout en bout, agents de données, flux de discussion dynamiques

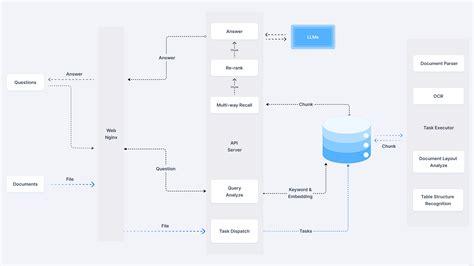

4. RAGFlow

RAGFlow est un moteur open-source axé sur la compréhension approfondie des documents. Il fournit aux entreprises un flux de travail rationalisé pour la mise en œuvre des systèmes RAG, en mettant l'accent sur des questions-réponses véridiques étayées par des citations tirées de formats de données complexes.

- Étoiles GitHub: ~1.1k

- Déploiement: Docker ; prend en charge les microservices basés sur FastAPI

- Caractéristiques principales: Visualiseur de morceaux, intégration de Weaviate, configurations flexibles

- Cas d'utilisation: Backends RAG légers, prototypage d'entreprisepes(jina.ai)

5. txtAI

txtAI est un cadre d'IA tout-en-un qui combine la recherche sémantique et les capacités de RAG. Il permet de créer des applications qui recherchent, indexent et récupèrent efficacement des informations, en prenant en charge différents types et formats de données.

- Étoiles GitHub: ~3.9k

- Déploiement: Basé sur Python ; fonctionne avec seulement quelques lignes de code.

- Caractéristiques principales: Extrêmement léger, mode hors ligne, prise en charge de la notation/du classement

- Cas d'utilisation: Moteurs de recherche basés sur l'intégration, chat avec PDF, métadonnées Q&A(Introduction | LangChain, GitHub, GitHub)

6. Cognita

Cognita est un cadre RAG modulaire conçu pour faciliter la personnalisation et le déploiement. Il offre une interface frontale permettant d'expérimenter différentes configurations RAG, ce qui le rend adapté aux environnements de développement et de production.

- Étoiles GitHub: Notable

- Déploiement: Intégrations Docker + TrueFoundry

- Caractéristiques principales: Piloté par l'API, prêt pour l'interface utilisateur, facile à mettre à l'échelle

- Cas d'utilisation: Assistants d'IA orientés vers les entreprises, chatbots soutenus para(TrueFoundry, LlamaIndex)

7. LLMWare

LLMWare fournit un cadre unifié pour la création d'applications RAG de niveau entreprise. Elle met l'accent sur l'utilisation de petits modèles spécialisés qui peuvent être déployés de manière privée, tout en garantissant la sécurité des données et la conformité.

- Étoiles GitHub: ~2.5k

- Déploiement: Outil CLI, API, modèles de projets personnalisables

- Caractéristiques principales: Pipelines sans code, outils d'analyse de documents

- Cas d'utilisation: Agents documentaires, connaissances commesistants(LinkedIn)

8. STORM

STORM est un assistant de recherche qui étend le concept de RAG axé sur les contours. Il se concentre sur la création d'articles complets en synthétisant des informations provenant de diverses sources, ce qui le rend idéal pour les tâches de création de contenu.

- Étoiles GitHub: Niche

- Déploiement: Installation du code source

- Caractéristiques principales: Moteur de raisonnement Co-STORM, exploration basée sur les graphes

- Cas d'utilisation: Configurations RAG personnalisées, lignes directrices pour l'AQ de la recherche p(GitHub)

9. R2R

R2R (Reason to Retrieve) est un système avancé de récupération de l'IA qui soutient RAG avec des caractéristiques prêtes pour la production. Il permet l'ingestion de contenus multimodaux, la recherche hybride et l'intégration de graphes de connaissances, répondant ainsi aux besoins complexes des entreprises.

- Étoiles GitHub: Niche

- Déploiement: API REST, prise en charge de la recherche hybride et de la recherche par graphe

- Caractéristiques principales: RAG multimodal, validation des documents

- Cas d'utilisation: Outils de recherche en IA, âge académiquents(YouTube, Open Source For You, Weaviate Newsletter)

10. EmbedChain

EmbedChain est une bibliothèque Python qui simplifie la création et le déploiement d'applications d'IA utilisant des modèles RAG. Il prend en charge différents types de données, notamment les PDF, les images et les pages web, ce qui le rend polyvalent pour différents cas d'utilisation.

- Étoiles GitHub: ~3.5k

- Déploiement: lib Python, également disponible en tant que SaaS hébergé

- Caractéristiques principales: Installation d'une application à commande unique, API en premier

- Cas d'utilisation: Prototypage rapide, construction de bots de connaissance pour un domaineny(LLMWare AI for Complex Enterprises)

11. RAGatouille

RAGatouille intègre des méthodes de recherche avancées comme ColBERT dans les pipelines RAG. Il permet d'expérimenter de manière modulaire différentes techniques de recherche, améliorant ainsi la flexibilité et les performances des systèmes RAG.

- Étoiles GitHub: Niche mais en croissance

- Déploiement: Paquet Python

- Caractéristiques principales: Expérimentation de la recherche, entrées modulaires

- Cas d'utilisation: Évaluation des techniques de recherche dans les pipelines RAG

12. Verba

Verba est un assistant personnel personnalisable qui utilise RAG pour interroger et interagir avec les données. Il s'intègre à la base de données contextuelle de Weaviate, ce qui permet une recherche d'informations et une interaction efficaces.

- Étoiles GitHub: Modeste

- Déploiement: Prise en charge locale et cloud

- Caractéristiques principales: Mémoire contextuelle, données personnelles Q&A

- Cas d'utilisation: Assistant personnalisé, exploration des donnéesation(LinkedIn, Brandfetch)

13. Jina AI

Jina AI offre des outils pour construire des applications d'IA multimodales avec des options de déploiement évolutives. Il prend en charge différents protocoles de communication, ce qui le rend adapté aux développeurs qui souhaitent créer et mettre à l'échelle des services d'intelligence artificielle.

- Étoiles GitHub: ~18k (org principal)

- Déploiement: Docker, API REST/gRPC/WebSocket

- Caractéristiques principales: Pipelines multimodaux, recherche hybride

- Cas d'utilisation: Applications d'entreprise combinant texte, image ou vidéo

14. Neurite

Neurite est un cadre RAG émergent qui simplifie la création d'applications alimentées par l'IA. L'accent mis sur l'expérience du développeur et le prototypage rapide en font une option attrayante pour l'expérimentation.

- Étoiles GitHub: Petit mais prometteur

- Déploiement: Configuration de la source

- Caractéristiques principales: Fusion neuronale-symbolique

- Cas d'utilisation: Expériences de recherche en IA, prototypes systems(GitHub, Hugging Face, GitHub)

15. LLM-App

LLM-App est un cadre pour la création d'applications basées sur de grands modèles de langage. Il fournit des modèles et des outils pour rationaliser le processus de développement, facilitant ainsi l'intégration des capacités RAG dans diverses applications.

- Étoiles GitHub: L'émergence

- Déploiement: Outils de déploiement et CLI basés sur Git

- Caractéristiques principales: Modèles de démarrage d'application, prêts pour l'OpenAI

- Cas d'utilisation: Projets RAG personnels, outils de hackathon

Chaque cadre offre des caractéristiques uniques adaptées aux différents cas d'utilisation et aux préférences de déploiement. En fonction de vos besoins spécifiques, de la facilité de déploiement, de la personnalisation ou des capacités d'intégration, vous pouvez choisir le cadre qui correspond le mieux aux objectifs de votre projet.

Choisir le bon cadre RAG

Le choix du cadre RAG approprié dépend de vos besoins spécifiques : analyse de documents juridiques, recherche universitaire ou développement local léger. Utilisez ce tableau pour comparer rapidement les cadres RAG open-source les plus populaires en fonction de leur mode de déploiement, de leur degré de personnalisation, de leur prise en charge de la recherche avancée, de leurs capacités d'intégration et de l'utilisation optimale de chaque outil.

|

Le cadre |

Déploiement |

Personnalisation |

Recherche avancée |

Soutien à l'intégration |

Meilleur pour |

|

Botte de foin |

Docker, K8s, Hugging Face |

Haut |

Oui |

Elasticsearch, Hugging Face |

Recherche d'entreprise et assurance qualité |

|

LlamaIndex |

Python (local/cloud) |

Haut |

Oui |

LangChain, FAISS |

Bots conscients des documents |

|

LangChain |

Python, JS, Cloud |

Haut |

Oui |

OpenAI, APIs, DBs |

Agents et filières LLM |

|

RAGFlow |

Docker |

Moyen |

Oui |

Weaviate |

Documents juridiques ou structurés |

|

txtAI |

Local (Python) |

Moyen |

De base |

Transformateurs |

Développement local léger |

|

Cognita |

Docker + UI |

Haut |

Oui |

TrueFoundry |

Outils commerciaux basés sur une interface graphique |

|

LLMWare |

CLI, API |

Haut |

Oui |

LLM privés |

Entreprise privée RAG |

|

STORM |

Installation de la source |

Haut |

Oui |

LangChain, LangGraph |

Assistants de recherche |

|

R2R |

API REST |

Haut |

Oui |

Multimodal |

RAG académique et hybride |

|

EmbedChain |

Python, SaaS |

Moyen |

De base |

Web, PDF, Images |

Prototypage rapide |

|

RAGatouille |

Python |

Haut |

Oui |

ColBERT |

Expérimentation sur les retrievers |

|

Verba |

Cloud/Local |

Moyen |

De base |

Weaviate |

Assistants contextuels |

|

Jina AI |

Docker, REST/gRPC |

Haut |

Oui |

API multimodales |

Applications multimodales évolutives |

|

Neurite |

Configuration de la source |

Moyen |

Non |

N/A |

Expérimentation |

|

LLM-App |

CLI, Git |

Moyen |

Non |

OpenAI |

Hackathon LLM apps |

Pièges courants lors de la mise en œuvre des RAG

Les systèmes RAG peuvent être robustes, mais ils présentent aussi des arêtes vives. Si vous ne faites pas attention, les réponses de votre modèle risquent d'être moins bonnes que si vous n'aviez pas utilisé l'extraction. Voici quatre problèmes courants à éviter et ce qu'il faut faire à la place.

1. Indexation de trop de déchets

Il n'est pas nécessaire de tout mettre dans votre boutique vectorielle. Le fait de jeter tous les documents, articles de blog ou courriels peut sembler exhaustif, mais cela ne fait que polluer votre recherche. Le récupérateur attire un contexte de faible valeur, que le modèle doit trier (souvent mal utilisé). Au lieu de cela, , soyez sélectif. N'indexez que les contenus exacts, bien rédigés et utiles. Nettoyez avant de stocker.

2. Ignorer les limites des jetons

Les LLM ont la mémoire courte. Quelque chose est coupé si votre invite, plus tous les morceaux récupérés, dépasse la limite de jetons du modèle. Ce "quelque chose" pourrait être la partie qui compte. Au lieu de cela, vous devez vous en tenir à un nombre restreint de questions. Limitez le nombre de morceaux récupérés ou résumez-les avant de les envoyer au modèle.

3. Optimiser pour le rappel, pas pour la précision

Il est tentant de récupérer davantage de documents pour s'assurer de "tout couvrir". Mais si les résultats supplémentaires sont vaguement liés, vous encombrez l'invite avec des informations superficielles. Le modèle est distrait ou, pire, confus. Visez plutôt une grande précision. Quelques morceaux très pertinents valent mieux qu'une longue liste de matches médiocres.

4. Voler à l'aveuglette sans logs

Lorsque le modèle donne une mauvaise réponse, savez-vous pourquoi ? Vous déboguez dans l'obscurité si vous n'enregistrez pas la requête, les documents récupérés et l'invite finale. Au lieu de cela, enregistrez l'ensemble du flux RAG. Il s'agit de l'entrée de l'utilisateur, du contenu récupéré, de ce qui a été envoyé au modèle et de la réponse du modèle.

Conclusion

Le RAG n'est pas la solution miracle à tout, mais lorsqu'il est utilisé correctement, c'est l'un des moyens les plus efficaces pour rendre les MLD plus innovants, plus pratiques et mieux ancrés dans les données qui comptent pour votre entreprise.

La clé est de savoir avec quoi vous travaillez. Le choix du bon cadre en fait partie, mais le succès dépend de la façon dont vous comprenez vos données et de l'attention que vous portez à votre pipeline d'extraction. Le principe du "garbage in, garbage out" s'applique toujours, en particulier lorsque vous construisez des systèmes qui génèrent du langage et ne se contentent pas d'extraire des faits.

Veillez à ce que votre indexation soit correcte, surveillez l'utilisation de vos jetons et contrôlez le flux de bout en bout. Lorsque toutes ces pièces s'emboîtent, RAG peut transformer vos applications d'IA d'impressionnantes en véritablement utiles.

Rédacteur technique spécialisé dans l'IA, la ML et la science des données, rendant les idées complexes claires et accessibles.

FAQ

À quoi sert le cadre RAG ?

Les cadres RAG aident les LLM à répondre aux questions en utilisant des données en temps réel, telles que des documents, des sites web ou des wikis internes.

Dois-je affiner mon modèle pour utiliser RAG ?

Les cadres RAG fonctionnent en récupérant les données pertinentes et en les ajoutant à l'invite. Vous n'avez pas besoin de recycler le modèle de base.

Quels types de données les cadres RAG peuvent-ils utiliser ?

Cela dépend du cadre. Nombre d'entre eux prennent en charge les PDF, les sites web, les fichiers markdown, les bases de données, etc.

Les cadres RAG peuvent-ils fonctionner avec les modèles OpenAI ou Hugging Face ?

Oui, la plupart des frameworks sont agnostiques en termes de modèles et s'intègrent facilement aux API d'OpenAI, Cohere, Anthropic et Hugging Face.

Quelle est la différence entre la recherche vectorielle et la recherche par mot-clé dans RAG ?

La recherche vectorielle s'appuie sur l'intégration pour trouver des textes sémantiquement pertinents, tandis que la recherche par mot-clé repose sur des correspondances exactes entre les mots.