Lernpfad

Die Retrieval-augmented Generation (RAG) wird schnell zu einer der praktischsten Entwicklungen bei der Verwendung großer Sprachmodelle. Es handelt sich nicht um ein neues Modell oder einen Ersatz für LLMs, sondern um ein innovatives System, das ihnen hilft, mit Fakten aus echten Datenquellen zu argumentieren. Im Kern löst RAG einige der größten Herausforderungen der generativen KI: Halluzinationen, begrenztes Gedächtnis und veraltetes Wissen. Durch die Kombination von Abfrage und Generierung in einer einzigen Pipeline können die Modelle ihre Antworten in einem aktuellen, relevanten Kontext verankern, der oft spezifisch für ein Unternehmen oder einen Bereich ist.

Dieser Wandel ist wichtiger denn je. In Unternehmen wird von LLMs erwartet, dass sie mit Genauigkeit und Erklärbarkeit antworten. Entwickler wollen Ergebnisse, die die Produktdokumentation, interne Wikis oder Support-Tickets widerspiegeln, nicht allgemeines Webwissen. Die RAG macht das möglich.

Dieser Leitfaden erklärt, wie das RAG-Framework funktioniert, wo es in deinen KI-Stack passt und wie du es mit grundlegenden Tools und Daten verwendest.

Was ist ein RAG-Rahmen?

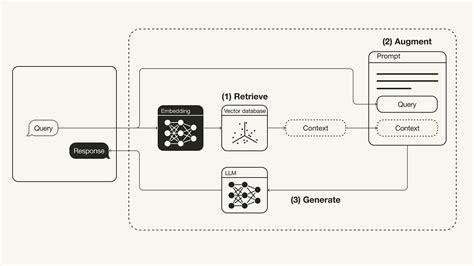

RAG steht für Retrieve, Augment, Generate. Es ist clever, großen Sprachmodellen (LLMs) Zugang zu externem Wissen zu geben, ohne sie neu zu trainieren.

Die Idee ist folgende: Wenn ein/e Nutzer/in eine Frage stellt, stellt RAG diese Frage nicht direkt an das Modell und hofft auf eine gute Antwort, sondern holt sichzunächst relevante Informationen aus einer Wissensdatenbank. Dann ergänzt die ursprüngliche Aufforderung mit diesem zusätzlichen Kontext. Schließlichgeneriert das LLM eine Antwort auf die Frage und die hinzugefügten Informationen.

Dieser Ansatz hilft dabei, die wichtigsten Einschränkungen des LLM zu überwinden - wie Halluzinationen, kurzes Gedächtnis (Kontextfenster) und Wissensabbrüche -, indem reale, aktuelle und relevante Daten spontan eingefügt werden.

Warum einen RAG-Rahmen verwenden?

Eigenständige LLMs sind beeindruckend, aber sie haben blinde Flecken. Sie halluzinieren, vergessen Dinge und wissen nichts Neues mehr als ihren letzten Trainingslauf. Die RAG ändert das. Durch die Kombination von LLMs mit Echtzeitabfragen erhältst du:

- Sachliche Richtigkeit: Die Antworten basieren auf deinen tatsächlichen Daten, nicht auf Vermutungen.

- Domainrelevanz: Du kannst Nischen- oder internes Wissen einbringen.

- Eine Umschulung ist nicht erforderlich: Aktualisiere einfach deine Wissensbasis - eine Feinabstimmung ist nicht erforderlich.

- Skalierbarkeit: Ideal für Chatbots, Suchwerkzeuge, Support-Assistenten und mehr.

Kurz gesagt: Mit RAG kannst du mit viel weniger Aufwand intelligentere und vertrauenswürdigere KI-Systeme entwickeln.

Die besten Open-Source-RAG-Frameworks

Das RAG-Ökosystem wächst schnell, mit Dutzenden von Open-Source-Projekten, die Entwicklern helfen, intelligentere Anwendungen mit Suchfunktionen zu entwickeln. Egal, ob du nach einem einfachen Plug-in oder einer kompletten Pipeline mit anpassbaren Komponenten suchst, es gibt bestimmt ein Tool für dich.

Im Folgenden stellen wir die besten Open-Source-RAG-Frameworks vor. Jeder Eintrag hebt die GitHub-Traktion, den Einsatzstil, die besonderen Stärken, die wichtigsten Anwendungsfälle und eine Grafik hervor, die dir ein schnelles Gefühl für das Projekt vermittelt.

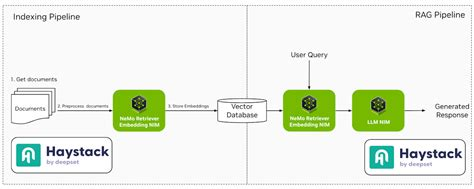

1. Haystack

Haystack ist ein robustes, modulares Framework, das für den Aufbau produktionsreifer NLP-Systeme entwickelt wurde. Sie unterstützt verschiedene Komponenten wie Retriever, Reader und Generatoren und ermöglicht eine nahtlose Integration mit Tools wie Elasticsearch und Hugging Face Transformers.

- GitHub-Sterne: ~13.5k

- Einsatz: Docker, Kubernetes, Hugging Face Spaces

- Herausragende Eigenschaften: Modulare Komponenten, starke Hugging Face Integration, mehrsprachige Unterstützung

- Anwendungsfälle: Unternehmenstaugliche QS-Systeme, Chatbots, interne Dokumentensucheearch(TrueFoundry, Anyscale, LobeHub)

2. LlamaIndex

LlamaIndex ist ein Daten-Framework, das benutzerdefinierte Datenquellen mit großen Sprachmodellen verknüpft. Sie vereinfacht die Indizierung und Abfrage von Daten und erleichtert so die Entwicklung von Anwendungen, die kontextbezogene Antworten erfordern.

- GitHub-Sterne: ~13k

- Einsatz: Python-basiert, läuft überall mit Datei- oder Webdaten

- Herausragende Eigenschaften: Einfache Abstraktionen für Indizierung, Retrieval und Routing

- Anwendungsfälle: Persönliche Assistenten, Wissensbots, RAG-Demos (GitHub)

3. LangChain

LangChain ist ein umfassendes Framework, das es Entwicklern ermöglicht, Anwendungen auf Basis von Sprachmodellen zu erstellen. Es bietet Werkzeuge, um verschiedene Komponenten wie Prompt-Vorlagen, Speicher und Agenten miteinander zu verknüpfen und so komplexe Workflows zu erstellen.

- GitHub-Sterne: ~72k

- Einsatz: Python, JavaScript, unterstützt in allen wichtigen Clouds

- Herausragende Eigenschaften: Werkzeugverkettung, Agenten, Vorlagen für Eingabeaufforderungen, Integrationen im Überfluss

- Anwendungsfälle: End-to-End-LLM-Anwendungen, Datenagenten, dynamische Chat-Flows

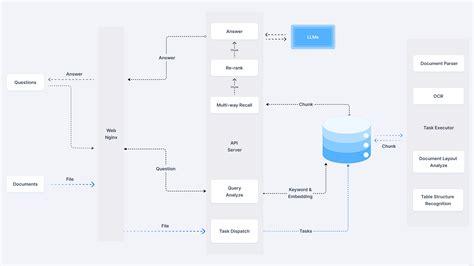

4. RAGFlow

RAGFlow ist eine Open-Source-Engine, die sich auf tiefes Dokumentenverständnis konzentriert. Es bietet einen optimierten Arbeitsablauf für Unternehmen, um RAG-Systeme zu implementieren, wobei der Schwerpunkt auf einer wahrheitsgemäßen Beantwortung von Fragen liegt, die durch Zitate aus komplexen Datenformaten unterstützt werden.

- GitHub-Sterne: ~1.1k

- Einsatz: Docker; unterstützt FastAPI-basierte Microservices

- Herausragende Eigenschaften: Chunk-Visualisierung, Weaviate-Integration, flexible Konfigurationen

- Anwendungsfälle: Leichtgewichtige RAG Backends, Enterprise Prototypes(jina.ai)

5. txtAI

txtAI ist ein All-in-One-KI-Framework, das semantische Suche mit RAG-Funktionen kombiniert. Sie ermöglicht es, Anwendungen zu erstellen, die Informationen effizient suchen, indizieren und abrufen und dabei verschiedene Datentypen und -formate unterstützen.

- GitHub-Sterne: ~3.9k

- Einsatz: Python-basiert; läuft mit nur ein paar Zeilen Code.

- Herausragende Eigenschaften: Extrem leichtgewichtig, Offline-Modus, Scoring/Ranking-Unterstützung

- Anwendungsfälle: Einbettungsbasierte Suchmaschinen, Chat-with-PDFs, metadata Q&A(Einführung | LangChain, GitHub, GitHub)

6. Cognita

Cognita ist ein modulares RAG-Framework, das sich leicht anpassen und einsetzen lässt. Es bietet eine Frontend-Oberfläche, um mit verschiedenen RAG-Konfigurationen zu experimentieren und eignet sich daher sowohl für Entwicklungs- als auch für Produktionsumgebungen.

- GitHub-Sterne: Bemerkenswert

- Einsatz: Docker + TrueFoundry-Integrationen

- Herausragende Eigenschaften: API-gesteuert, UI-fähig, einfach zu skalieren

- Anwendungsfälle: KI-Assistenten für Unternehmen, data-unterstützte Chatbots(TrueFoundry, LlamaIndex)

7. LLMWare

LLMWare bietet ein einheitliches Framework für die Entwicklung von RAG-Anwendungen auf Unternehmensebene. Der Schwerpunkt liegt auf kleinen, spezialisierten Modellen, die privat eingesetzt werden können und die Datensicherheit und Compliance gewährleisten.

- GitHub-Sterne: ~2.5k

- Einsatz: CLI-Tool, APIs, anpassbare Projektvorlagen

- Herausragende Eigenschaften: Codefreie Pipelines, Tools zum Parsen von Dokumenten

- Anwendungsfälle: Dokumentenagenten, Wissen alssistants(LinkedIn)

8. STORM

STORM ist ein Forschungsassistent, der das Konzept der skizzengesteuerten RAG erweitert. Es konzentriert sich darauf, umfassende Artikel zu erstellen, indem es Informationen aus verschiedenen Quellen zusammenfasst, was es ideal für die Erstellung von Inhalten macht.

- GitHub-Sterne: Niche

- Einsatz: Quellcode-Installation

- Herausragende Eigenschaften: Co-STORM Reasoning Engine, Graph-basierte Exploration

- Anwendungsfälle: Benutzerdefinierte RAG-Setups, Forschung QA pipelines(GitHub)

9. R2R

R2R (Reason to Retrieve) ist ein fortschrittliches KI-Retrieval-System, das die RAG mit produktionsreifen Funktionen unterstützt. Sie bietet multimodale Inhaltserfassung, hybride Suche und Wissensgraphenintegration und erfüllt damit komplexe Unternehmensanforderungen.

- GitHub-Sterne: Niche

- Einsatz: REST API, unterstützt hybride und graphische Suche

- Herausragende Eigenschaften: Multimodale RAG, Dokumentenvalidierung

- Anwendungsfälle: KI-Forschungstools, akademisches Alternts(YouTube, Open Source For You, Weaviate Newsletter)

10. EmbedChain

EmbedChain ist eine Python-Bibliothek, die die Erstellung und den Einsatz von KI-Anwendungen mit RAG-Modellen vereinfacht. Sie unterstützt verschiedene Datentypen, darunter PDFs, Bilder und Webseiten, was sie vielseitig für unterschiedliche Anwendungsfälle macht.

- GitHub-Sterne: ~3.5k

- Einsatz: Python lib, auch als gehostetes SaaS verfügbar

- Herausragende Eigenschaften: Ein-Befehl-App-Setup, API-first

- Anwendungsfälle: Schnelles Prototyping, Aufbau von Wissensbots für einenny Bereich(LLMWare AI for Complex Enterprises)

11. RAGatouille

RAGatouille integriert fortschrittliche Retrieval-Methoden wie ColBERT in RAG-Pipelines. Es ermöglicht das modulare Experimentieren mit verschiedenen Abfragetechniken und erhöht so die Flexibilität und Leistung von RAG-Systemen.

- GitHub-Sterne: Nische, aber wachsend

- Einsatz: Python-Paket

- Herausragende Eigenschaften: Experimentieren mit Abrufen, modulare Eingaben

- Anwendungsfälle: Evaluierung von Retrieval-Techniken in RAG-Pipelines

12. Verba

Verba ist ein anpassbarer persönlicher Assistent, der RAG nutzt, um Daten abzufragen und mit ihnen zu interagieren. Sie ist mit der kontextabhängigen Datenbank von Weaviate integriert und ermöglicht so eine effiziente Informationsbeschaffung und Interaktion.

- GitHub-Sterne: Bescheiden

- Einsatz: Lokal und in der Cloud unterstützt

- Herausragende Eigenschaften: Kontextuelles Gedächtnis, persönliche Daten Q&A

- Anwendungsfälle: Eigene Assistenten erstellen, Daten erforschenation(LinkedIn, Brandfetch)

13. Jina AI

Jina AI bietet Werkzeuge für den Aufbau multimodaler KI-Anwendungen mit skalierbaren Einsatzmöglichkeiten. Sie unterstützt verschiedene Kommunikationsprotokolle und eignet sich daher für Entwickler, die KI-Dienste aufbauen und skalieren wollen.

- GitHub-Sterne: ~18k (Hauptorgan)

- Einsatz: Docker, REST/gRPC/WebSocket APIs

- Herausragende Eigenschaften: Multimodale Pipelines, hybride Suche

- Anwendungsfälle: Apps für Unternehmen, die Text, Bild oder Video kombinieren

14. Neurit

Neurite ist ein neues RAG-Framework, das die Entwicklung von KI-gestützten Anwendungen vereinfacht. Der Schwerpunkt auf der Erfahrung der Entwickler und dem schnellen Prototyping macht es zu einer attraktiven Option für Experimente.

- GitHub-Sterne: Klein, aber vielversprechend

- Einsatz: Quelle: Setup

- Herausragende Eigenschaften: Neural-symbolische Verschmelzung

- Anwendungsfälle: KI-Forschungsexperimente, Prototypenystems(GitHub, Hugging Face, GitHub)

15. LLM-App

LLM-App ist ein Framework zum Erstellen von Anwendungen, die auf großen Sprachmodellen basieren. Es bietet Vorlagen und Werkzeuge, um den Entwicklungsprozess zu rationalisieren und die Integration von RAG-Funktionen in verschiedene Anwendungen zu erleichtern.

- GitHub-Sterne: Auftauchen

- Einsatz: Git-basierte Bereitstellung und CLI-Tools

- Herausragende Eigenschaften: App-Starter-Vorlagen, OpenAI-ready

- Anwendungsfälle: Persönliche RAG-Projekte, Hackathon-Tools

Jedes Framework bietet einzigartige Funktionen, die auf unterschiedliche Anwendungsfälle und Einsatzpräferenzen zugeschnitten sind. Je nach deinen spezifischen Anforderungen, der Einfachheit des Einsatzes, der Anpassungsfähigkeit oder den Integrationsmöglichkeiten kannst du das Framework wählen, das am besten zu den Zielen deines Projekts passt.

Die Wahl des richtigen RAG-Rahmens

Die Wahl des geeigneten RAG-Rahmens hängt von deinen spezifischen Bedürfnissen ab: Analyse von Rechtsdokumenten, akademische Forschung oder leichte lokale Entwicklung. Mithilfe dieser Tabelle kannst du beliebte Open-Source-RAG-Frameworks schnell vergleichen, und zwar anhand der Art und Weise, wie sie eingesetzt werden, wie anpassbar sie sind, ob sie erweiterte Abfragen unterstützen, welche Integrationsmöglichkeiten es gibt und wofür die einzelnen Tools am besten geeignet sind.

|

Rahmenwerk |

Einsatz |

Anpassungsfähigkeit |

Erweiterte Abfrage |

Unterstützung bei der Integration |

Am besten für |

|

Haystack |

Docker, K8s, Hugging Face |

Hoch |

Ja |

Elasticsearch, Hugging Face |

Unternehmenssuche & QA |

|

LlamaIndex |

Python (lokal/cloud) |

Hoch |

Ja |

LangChain, FAISS |

Dokumentenbasierte Bots |

|

LangChain |

Python, JS, Cloud |

Hoch |

Ja |

OpenAI, APIs, DBs |

LLM-Agenten & Pipelines |

|

RAGFlow |

Docker |

Medium |

Ja |

Weaviate |

Rechtliche oder strukturierte Dokumente |

|

txtAI |

Lokal (Python) |

Medium |

Basic |

Transformers |

Leichte lokale Entwicklung |

|

Cognita |

Docker + UI |

Hoch |

Ja |

TrueFoundry |

GUI-basierte Business-Tools |

|

LLMWare |

CLI, APIs |

Hoch |

Ja |

Private LLMs |

Privatunternehmen RAG |

|

STORM |

Quelle installieren |

Hoch |

Ja |

LangChain, LangGraph |

Wissenschaftliche Hilfskräfte |

|

R2R |

REST-API |

Hoch |

Ja |

Multimodal |

Academic & hybrid RAG |

|

EmbedChain |

Python, SaaS |

Medium |

Basic |

Web, PDF, Images |

Schnelles Prototyping |

|

RAGatouille |

Python |

Hoch |

Ja |

ColBERT |

Experimentieren mit Retrievern |

|

Verba |

Cloud/Local |

Medium |

Basic |

Weaviate |

Kontextuelle Assistenten |

|

Jina AI |

Docker, REST/gRPC |

Hoch |

Ja |

Multimodale APIs |

Skalierbare multimodale Apps |

|

Neurit |

Quelle: Setup |

Medium |

Nein |

N/A |

Experimentieren |

|

LLM-App |

CLI, Git |

Medium |

Nein |

OpenAI |

Hackathon LLM-Anwendungen |

Häufige Fallstricke bei der Umsetzung der RAG

RAG-Systeme können robust sein, aber sie haben auch ihre Tücken. Wenn du nicht aufpasst, könnten die Antworten deines Modells am Ende schlechter ausfallen, als wenn du keine Abfrage benutzt hättest. Hier sind vier häufige Probleme, die du vermeiden solltest - und was du stattdessen tun kannst.

1. Zu viel Schrott indizieren

Nicht alles muss in deinem Vektorladen landen. Es mag sich gründlich anfühlen, wenn du jedes Dokument, jeden Blogeintrag und jede E-Mail auswirfst, aber das verschmutzt nur deine Suche. Der Retriever zieht minderwertigen Kontext heran, den das Modell sortieren muss (was oft missbraucht wird). Stattdessen sollte selektiv sein. Indexiere nur Inhalte, die korrekt, gut geschrieben und nützlich sind. Räumt auf, bevor ihr einlagert.

2. Token-Limits ignorieren

LLMs haben ein kurzes Gedächtnis. Etwas wird abgeschnitten, wenn dein Prompt plus alle abgerufenen Chunks das Token-Limit des Modells überschreitet. Dieses "etwas" könnte der Teil sein, auf den es ankommt. Halte die Aufforderungen stattdessen knapp. Begrenze die Anzahl der abgerufenen Chunks oder fasse sie zusammen, bevor du sie an das Modell sendest.

3. Optimieren für Recall, nicht für Präzision

Es ist verlockend, mehr Dokumente abzurufen, um sicherzustellen, dass du "alles abdeckst". Aber wenn die zusätzlichen Ergebnisse nur lose miteinander verbunden sind, überfrachtest du die Aufforderung mit Fluff. Das Modell wird abgelenkt oder, schlimmer noch, verwirrt. Strebe stattdessen eine hohe Präzision an. Ein paar hoch relevante Teile sind besser als eine lange Liste von schwachen Treffern.

4. Blindflug ohne Baumstämme

Wenn das Modell eine schlechte Antwort gibt, weißt du dann, warum? Du tappst bei der Fehlersuche im Dunkeln, wenn du die Abfrage, die abgerufenen Dokumente und die letzte Eingabeaufforderung nicht protokollierst. Protokolliere stattdessen den gesamten RAG-Fluss. Dazu gehören die Benutzereingaben, die abgerufenen Inhalte, das, was an das Modell gesendet wurde, und die Antwort des Modells.

Fazit

Die RAG ist kein Allheilmittel, aber wenn sie richtig eingesetzt wird, ist sie eine der effektivsten Methoden, um LLMs innovativer und praktischer zu machen und auf die Daten zu stützen, die für dein Unternehmen wichtig sind.

Der Schlüssel ist zu wissen, womit du arbeitest. Die Wahl des richtigen Frameworks ist ein Teil davon, aber der Erfolg hängt davon ab, wie gut du deine Daten verstehst und wie sorgfältig du deine Abfrage-Pipeline abstimmst. Garbage in, garbage out gilt immer noch, vor allem, wenn du Systeme baust, die Sprache erzeugen und nicht nur Fakten abrufen.

Sorge für die richtige Indizierung, achte auf die Verwendung deiner Token und überwache den gesamten Datenfluss. Wenn all diese Teile zusammenpassen, kann RAG deine KI-Anwendungen von beeindruckend zu wirklich hilfreich machen.

Technischer Redakteur, der sich auf KI, ML und Datenwissenschaft spezialisiert hat und komplexe Ideen verständlich und nachvollziehbar macht.

FAQs

Wofür wird ein RAG-Rahmen verwendet?

RAG-Frameworks helfen LLMs, Fragen anhand von Echtzeitdaten wie Dokumenten, Websites oder internen Wikis zu beantworten.

Muss ich mein Modell anpassen, um RAG nutzen zu können?

Nein. RAG-Frameworks funktionieren, indem sie relevante Daten abrufen und zur Eingabeaufforderung hinzufügen. Du musst das Basismodell nicht neu trainieren.

Welche Arten von Daten können RAG-Rahmenwerke nutzen?

Das hängt von den Rahmenbedingungen ab. Viele unterstützen PDFs, Websites, Markdown-Dateien, Datenbanken und mehr.

Können RAG-Frameworks mit OpenAI- oder Hugging Face-Modellen arbeiten?

Ja, die meisten Frameworks sind modellunabhängig und lassen sich problemlos in die APIs von OpenAI, Cohere, Anthropic und Hugging Face integrieren.

Was ist der Unterschied zwischen der Vektorsuche und der Stichwortsuche in der RAG?

Die Vektorsuche verwendet Einbettungen, um semantisch relevanten Text zu finden, während die Stichwortsuche auf exakten Wortübereinstimmungen beruht.