programa

Asegurarse de que la IA se utiliza de forma responsable no es sólo un bonito objetivo, sino una prioridad clave. Es esencial que la IA se cree, despliegue y utilice de acuerdo con los principios dela IA responsable (RAI) de para ayudar a reducir los riesgos en la sociedad en todos los sectores.

A medida que la IA sigue creciendo rápidamente, tiene el potencial de aportar grandes beneficios si se utiliza de forma responsable, ayudando a alcanzar los Objetivos de Desarrollo Sostenible de las Naciones Unidasproteger los derechos humanos y dar siempre prioridad al bienestar de la humanidad.

En este blog, te presentaré los principios de la IA responsable mediante un estudio comparativo del trabajo realizado en este ámbito por la literatura, el mundo académico, las organizaciones internacionales y los líderes del sector.

Si quieres profundizar en este tema, no dejes de consultar este curso sobre Prácticas Responsables de IA.

¿Qué es la IA responsable?

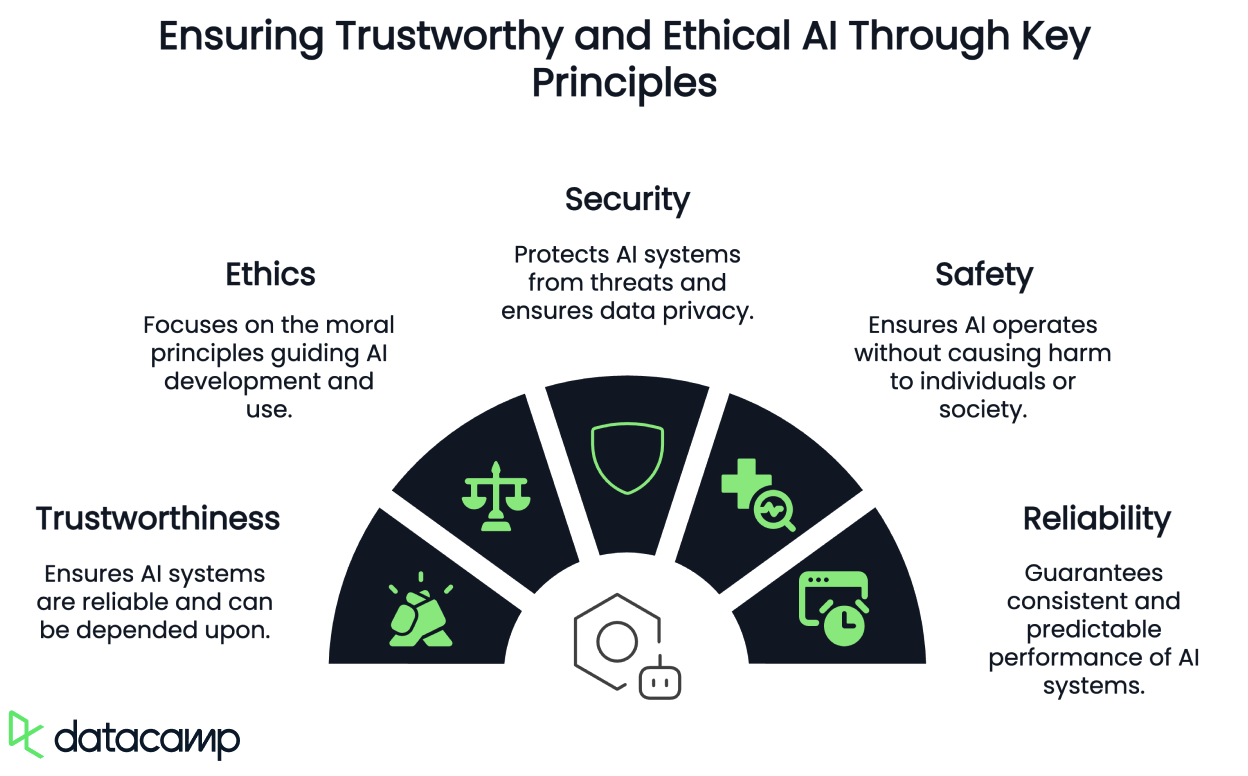

Todavía no tenemos una definición universalmente compartida de "IA Responsable". En algunos casos, se denomina IA fiable, ética, segura o protegida. En otros, se trata simplemente de principios subsumidos en una noción más amplia de RAI o adscritos como categorías totalmente distintas.

El creciente interés por una IA responsable, ética, digna de confianza, segura y protegida se deriva de la preocupación generalizada por sus posibles efectos negativos, tanto intencionados como no intencionados.

En Instituto de Ingenieros Eléctricos y Electrónicos (IEEE) atribuye esta preocupación a la tradicional exclusión del análisis ético de la práctica de la ingeniería, en la que las normas éticas básicas relacionadas con la seguridad, la protección, la funcionalidad, la justicia, la parcialidad, la adicción y los daños indirectos a la sociedad se consideraban a menudo fuera de alcance.

Sin embargo, dada la escalabilidad y el impacto generalizado de la IA en todos los aspectos de la sociedad y de nuestra vida cotidiana, es esencial prever y mitigar los riesgos éticos como práctica habitual. El enfoque actual de liberar tecnología en el mundo sin suficiente supervisión, dejando que otros se ocupen de las consecuencias, ya no es aceptable.

Sin embargo, pasar de la teoría y los principios éticos a la práctica procesable y específica del contexto sigue siendo un obstáculo importante para la adopción generalizada del análisis sistemático del impacto ético en la ingeniería del software.

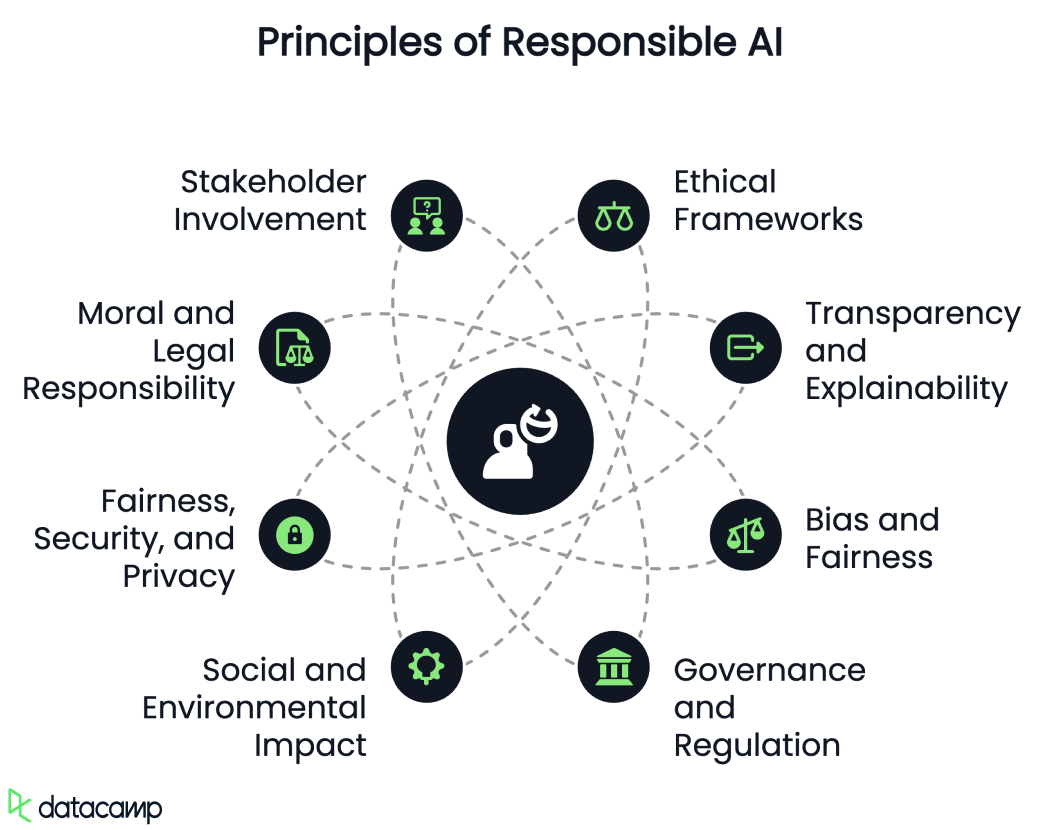

Principios de la IA responsable

Si echamos un vistazo a la bibliografía, podemos observar que se discute bastante sobre el desarrollo de los principios de la RAI. Hablemos brevemente de cada uno de ellos.

Marcos éticos

La IA responsable hace hincapié en el uso de marcos éticos para garantizar la rendición de cuentas, la responsabilidad y la transparencia en los sistemas de IA. Esto incluye abordar cuestiones como la privacidad, la autonomía y la parcialidad.

Transparencia y explicabilidad

La transparencia en los algoritmos de IA y en los procesos de toma de decisiones es crucial para generar confianza entre las partes interesadas. IA explicable (XAI) pretende crear modelos que sean interpretables y comprensibles, fomentando la transparencia y la confianza.

Prejuicios e imparcialidad

La IA responsable trata de identificar y corregir los sesgos de los algoritmos de IA para promover decisiones equitativas. Esto implica utilizar conjuntos de datos diversos e inclusivos para evitar resultados discriminatorios.

Para saber más sobre el sesgo en la IA, consulta este podcast en Lucha por la justicia algorítmica con el Dr. Joy Buolamwini.

Gobernanza y regulación

El desarrollo de normas y marcos para gobernanza de la IA es esencial para guiar el uso responsable de la IA. Esto incluye la creación de enfoques estructurados para mitigar los riesgos a varios niveles, desde los investigadores individuales hasta las normativas gubernamentales.

Impacto social y medioambiental

La IA responsable considera los impactos socioeconómicos y medioambientales más amplios de la IA, como sus efectos sobre el empleo, la desigualdad y el consumo de recursos, y su potencial para causar mercados digitales injustos o daños medioambientales debido al uso de recursos.

Equidad, seguridad y privacidad

El sitio esfuerzos de la Comisión Europea para regular la IA destacan la importancia de la imparcialidad, la seguridad, la privacidad, la explicabilidad, la seguridad y la reproducibilidad como componentes de una IA responsable.

Responsabilidad moral y jurídica

Los debates en torno a la IA responsable suelen implicar la responsabilidad moral, que incluye condiciones causales y epistémicas. Esto significa que las acciones de la IA deben provocar resultados, y los agentes deben ser conscientes de las consecuencias morales. Los marcos jurídicos también exploran la rendición de cuentas, la responsabilidad y la culpabilidad de los sistemas de IA.

Participación de las partes interesadas

Un marco de IA responsable a menudo implica responsabilizar a todas las partes interesadas, incluidos los desarrolladores, los usuarios y, potencialmente, los propios sistemas de IA.

Taxonomías alternativas de los principios de IA responsable en el mundo académico

En el ámbito académico, algunas de las revisiones sistemáticas de los principios éticos de la IA han producido taxonomías algo diferentes Por ejemplo Jobin et al. revisaron 84 directrices éticas y propusieron 11 principios:

- Transparencia

- Justicia y equidad

- No maleficencia

- Responsabilidad

- Privacidad

- Beneficencia

- Libertad y autonomía

- Confía en

- Dignidad

- Sostenibilidad

- Solidaridad

Naturalmente, se encontraron con una gran divergencia en la interpretación de estos principios y en la forma en que las recomendaciones sugerían que se aplicaran. Sin embargo, observaron algunos indicios de convergencia en torno a cinco principios básicos:

- Transparencia

- Justicia y equidad

- No maleficencia

- Responsabilidad

- Privacidad

Sin embargo, otros defensores sugieren que la plétora de marcos éticos de la IA puede consolidarse en sólo cinco metaprincipios:

- Respeto a la autonomía

- Beneficencia

- No maleficencia

- Justicia

- Explicabilidad

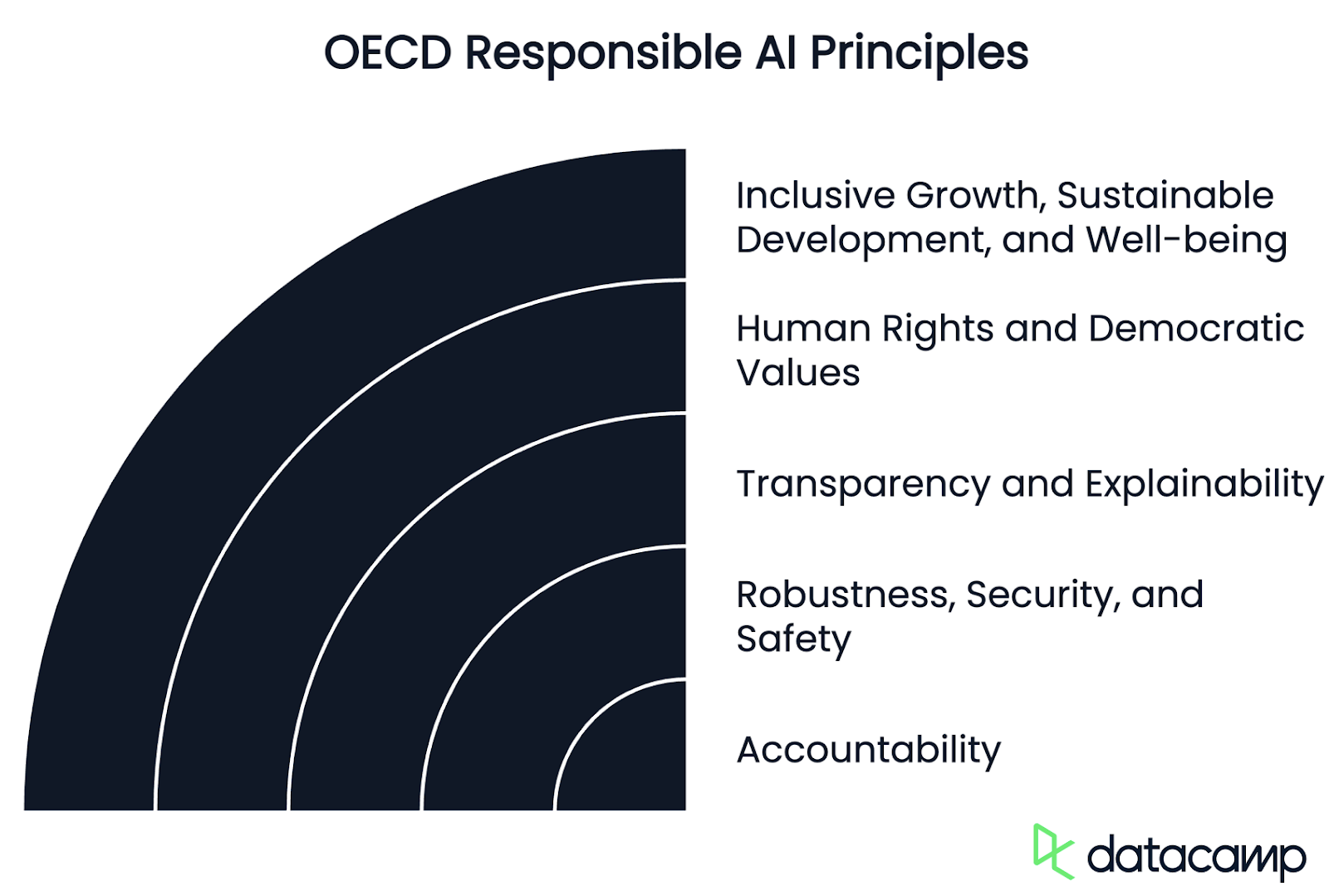

Principios de la OCDE para una IA responsable

Las organizaciones internacionales también han alimentado activamente los debates mundiales sobre cómo se están configurando estas definiciones, con fines políticos y de armonización.

La Organización para la Cooperación y el Desarrollo Económico (OCDE) -donde trabajo como Experto en IA para Riesgos y Responsabilidad, así como para Vigilancia de Incidentes- ha presentado una lista exhaustiva de principios para una IA fiable.

Estos principios promueven el uso de IA innovadora, fiable y respetuosa con los derechos humanos y los valores democráticos. Inicialmente adoptadas en 2019fueron actualizadas en mayo de 2024 para garantizar que siguen siendo sólidas y adecuadas a los nuevos avances tecnológicos y políticos.

En la actualidad, la Unión Europeael Consejo de Europa, los Estados Unidoslas Naciones Unidasy otras jurisdicciones utilizan la definición de sistema de IA y ciclo de vida de la OCDE que figura a continuación en sus marcos legislativos y normativos y en sus orientaciones.

En pocas palabras, todos ellos son principios basados en valores y se agrupan en las siguientes categorías:

Crecimiento integrador, desarrollo sostenible y bienestar

Las partes interesadas en la IA deben participar de forma proactiva en la administración responsable de una IA digna de confianza en busca de resultados beneficiosos para las personas y para el planeta, como aumentar las capacidades humanas y potenciar la creatividad, promover la inclusión de las poblaciones infrarrepresentadas, reducir las desigualdades económicas, sociales, de género y de otro tipo, y proteger los entornos naturales, vigorizando así el crecimiento integrador, el bienestar, el desarrollo sostenible y la sostenibilidad medioambiental.

Los derechos humanos y los valores democráticos, incluyendo la equidad y la privacidad

Los actores de la IA deben respetar el Estado de Derecho, los derechos humanos y los valores democráticos centrados en el ser humano a lo largo de todo el ciclo de vida del sistema de IA. Estos incluyen la no discriminación y la igualdad, la libertad, la dignidad, la autonomía de las personas, la privacidad y la protección de datos, la diversidad, la equidad, la justicia social y los derechos laborales reconocidos internacionalmente.

Transparencia y explicabilidad

Los actores de la IA deben comprometerse a la transparencia y a la divulgación responsable de sus sistemas. Para ello, deben proporcionar información significativa, adecuada al contexto y coherente con el estado de la técnica, con el fin de fomentar una comprensión general de los sistemas de IA, incluidas sus capacidades y limitaciones.

Robustez, seguridad y protección

Los sistemas de IA deben ser robustos, seguros y protegidos a lo largo de todo su ciclo de vida, de modo que, en condiciones de uso normal, uso previsible o uso indebido, u otras condiciones adversas, funcionen adecuadamente y no planteen riesgos de seguridad y/o protección irrazonables.

Responsabilidad

Los actores de la IA deben ser responsables del correcto funcionamiento de los sistemas de IA y de la defensa de los principios anteriores, en función de sus funciones, del contexto y de acuerdo con el estado de la técnica. Para ello, los actores de la IA deben garantizar la trazabilidad, incluso en relación con los conjuntos de datos, los procesos y las decisiones tomadas a lo largo del ciclo de vida del sistema de IA. Esta trazabilidad debe permitir el análisis de los resultados del sistema de IA y las respuestas a las consultas, adecuadas al contexto y coherentes con el estado de la técnica.

Principios ISO de IA Responsable

Por otra parte, para la Organización Internacional de Normalización (ISO), hay tres áreas clave a tener en cuenta para que un sistema de IA sea digno de confianza:

- Alimentarlo con datos buenos y diversos

- Garantizar que los algoritmos puedan manejar esa diversidad

- Y comprobando el software resultante para detectar posibles errores de etiquetado o correlaciones deficientes

La organización proporciona las siguientes directrices para conseguirlo:

- Diseña para humanos utilizando un conjunto diverso de usuarios y escenarios de casos de uso, e incorpora esta información antes y a lo largo del ciclo de vida de la IA.

- Utiliza múltiples métricas para evaluar la formación y la supervisión, como encuestas a los usuarios, indicadores generales de rendimiento del sistema y tasas de falsos positivos y negativos rebanadas en diferentes subgrupos.

- Examina los datos brutos en busca de errores (p. ej., valores omitidos o no alineados, etiquetas incorrectas, muestreo), sesgos de formación (p. ej., métodos de recogida de datos o sesgos sociales inherentes) y redundancias, todo ello crucial para garantizar los principios RAI de imparcialidad, equidad y precisión en los sistemas de IA.

- Comprender las limitaciones de cualquier modelo dado para mitigar el sesgo, mejorar la generalización, garantizar un rendimiento fiable en escenarios cinéticos, y comunicarlas a desarrolladores y usuarios.

- Prueba continuamente tu modelo según los principios de la IA responsable para asegurarte de que tiene debidamente en cuenta el rendimiento en el mundo real y las opiniones de los usuarios, con el fin de mejorar las soluciones a corto y largo plazo para los problemas.

La opinión de los líderes del sector sobre la IA responsable

En cuanto a los ejemplos concretos de los líderes del sector, podemos observar claros contrastes en la nomenclatura y las taxonomías, con distintas interpretaciones de los conceptos de RAI, IA digna de confianza, IA ética y otras diversas interpretaciones acuñadas para sus operaciones o aplicaciones.

Microsoft

Microsoft, por ejemplo, defiende los siguientes Principios de IA Responsable:

- Equidad

- Fiabilidad y seguridad

- Privacidad y seguridad

- Inclusión

- Transparencia y responsabilidad

Apple

Por otro lado, Apple afirma que su IA está diseñada con sus valores fundamentales y construida sobre una base de innovaciones pioneras en materia de privacidad, y han creado un conjunto de principios de IA Responsables para guiar la forma en que desarrollan las herramientas de IA, así como los modelos que las sustentan:

- Capacita a los usuarios con herramientas inteligentes: Identificar las áreas en las que la IA puede utilizarse de forma responsable para crear herramientas que respondan a las necesidades específicas de los usuarios, respetando la forma en que éstos eligen utilizarlas para lograr sus objetivos.

- Representar a los usuarios: Construir productos profundamente personales con el objetivo de representar auténticamente a los usuarios de todo el mundo para evitar perpetuar estereotipos y sesgos sistémicos en las herramientas y modelos de IA.

- Diseña con cuidado: Tomar precauciones en cada fase de nuestro proceso, incluido el diseño, el entrenamiento de modelos, el desarrollo de características y la evaluación de la calidad para identificar cómo nuestras herramientas de IA pueden utilizarse mal o provocar daños potenciales.

- Protege la intimidad: Lo consiguen mediante un potente procesamiento en el dispositivo y una infraestructura innovadora, que garantiza que no utilicen los datos personales privados de nuestros usuarios ni las interacciones de los usuarios al entrenar sus modelos de base.

Nvidia

Nvidia la denomina IA digna de confianza, y creen que la IA debe respetar la normativa sobre privacidad y protección de datos, operar de forma segura y protegida, funcionar de forma transparente y responsable, evitar sesgos y discriminaciones no deseados, y señalar sus cuatro principios básicos:

- Privacidad

- Seguridad y protección

- Transparencia

- No discriminación

De forma algo diversa, Google habla de "Objetivos para las aplicaciones de IA" para ser:

- Ser socialmente beneficioso.

- Evita crear o reforzar prejuicios injustos.

- Ser construidos y probados para la seguridad.

- Sé responsable ante las personas.

- Incorpora principios de diseño de privacidad.

- Mantener un alto nivel de excelencia científica.

- Estar disponibles para su uso de acuerdo con estos principios para limitar las aplicaciones potencialmente perjudiciales o abusivas.

Conclusión

Aún no hay consenso sobre lo que constituye exactamente la IA responsable, la IA digna de confianza, la IA ética, la IA segura y la IA protegida, ni sobre si se trata de terminologías independientes o si son convergentes. Sin embargo, es alentador ver que los elementos de estos términos son comunes y se comparten -al menos en teoría- en torno a los mismos principios básicos en el mundo académico, las organizaciones internacionales y la industria.

En términos generales, podemos decir que la RAI es una disciplina emergente cuyo objetivo es garantizar que el desarrollo, el despliegue y el uso de la inteligencia artificial se realicen de una forma centrada en el ser humano que se ajuste a los derechos humanos fundamentales en la práctica, tanto ética como legalmente.

Jimena Viveros se desempeña actualmente como Jefa de Gabinete y Asesora Jurídica Principal de la Magistrada Loretta Ortiz en la Suprema Corte de Justicia de la Nación. Sus funciones anteriores incluyen cargos de liderazgo nacional en el Consejo Judicial Federal, el Ministerio de Seguridad y el Ministerio de Hacienda, donde ocupó el cargo de Directora General. Jimena es abogada y experta en IA, y posee una amplia y diversa formación internacional. Está ultimando su tesis doctoral, que se centra en el impacto de la IA y las armas autónomas en el derecho y la política internacionales de paz y seguridad, aportando propuestas concretas para lograr una gobernanza global desde diversas perspectivas jurídicas. Su extenso trabajo en IA y otros ámbitos jurídicos ha sido ampliamente publicado y reconocido.