Programa

Garantir que a IA seja usada de forma responsável não é apenas uma boa meta, mas uma prioridade fundamental. É essencial que a IA seja criada, implantada e usada de acordo com os princípiosda IA responsável (RAI) do site para ajudar a reduzir os riscos na sociedade em todos os setores.

Como a IA continua a crescer rapidamente, ela tem o potencial de trazer grandes benefícios se for usada com responsabilidade, ajudando a atingir os Objetivos de Desenvolvimento Sustentável das Nações Unidasdas Nações Unidas, proteger os direitos humanos e sempre priorizar o bem-estar da humanidade.

Neste blog, apresentarei a você os princípios da IA responsável por meio de um estudo comparativo do trabalho realizado nessa área pela literatura, academia, organizações internacionais e líderes do setor.

Se você quiser se aprofundar nesse tópico, não deixe de conferir este curso sobre Práticas responsáveis de IA.

O que é IA responsável?

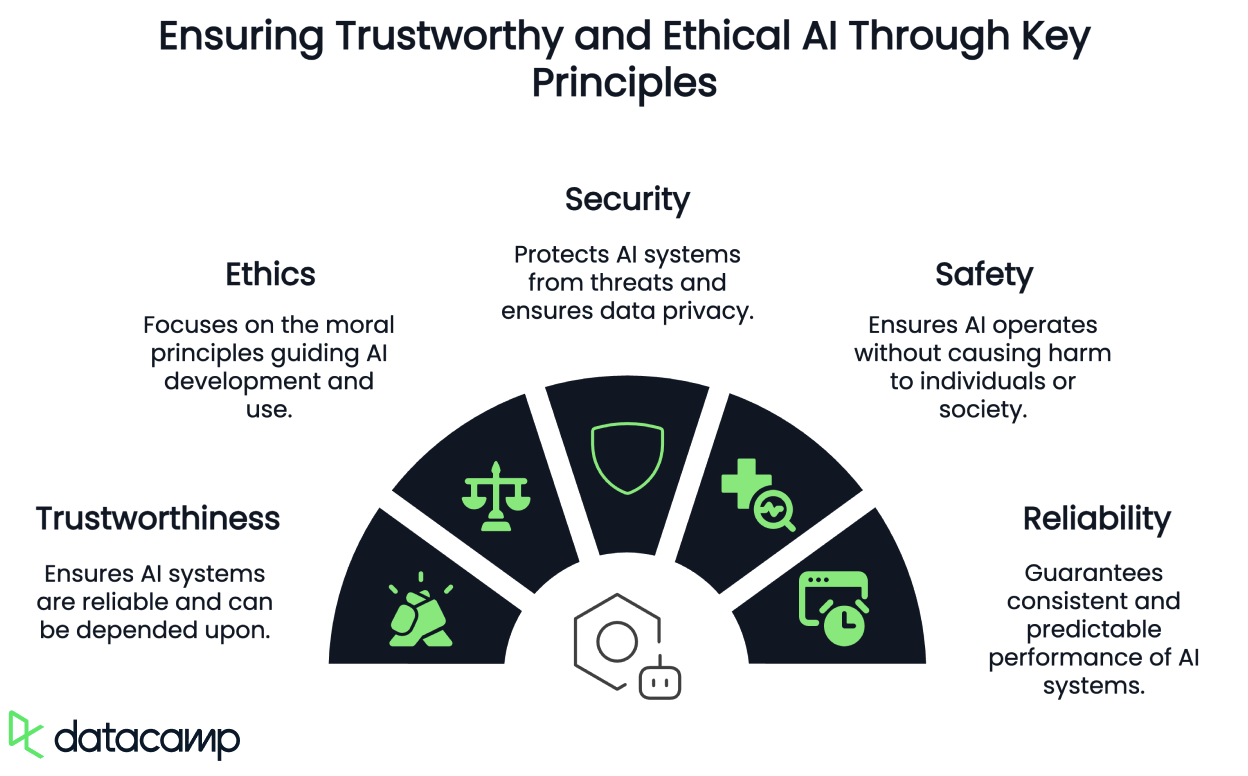

Ainda não temos uma definição universalmente compartilhada de "IA responsável". Em alguns casos, ela é chamada de IA confiável, ética, segura ou protegida. Em outros, esses são apenas princípios incluídos em uma noção mais ampla de RAI ou atribuídos a categorias totalmente diferentes.

O foco crescente em IA responsável, ética, confiável, segura e protegida decorre de uma preocupação generalizada com seus possíveis impactos negativos, tanto intencionais quanto não intencionais.

O Instituto de Engenheiros Elétricos e Eletrônicos (IEEE) atribui essa preocupação à exclusão tradicional da análise ética da prática da engenharia, em que os padrões éticos básicos relacionados à segurança, à funcionalidade, à justiça, à parcialidade, ao vício e aos danos indiretos à sociedade eram geralmente considerados fora do escopo.

No entanto, dada a escalabilidade e o impacto generalizado da IA em todos os aspectos da sociedade e de nossa vida cotidiana, é essencial prever e mitigar os riscos éticos como uma prática padrão. A abordagem atual de liberar a tecnologia no mundo sem supervisão suficiente, deixando que outros lidem com as consequências, não é mais aceitável.

No entanto, a mudança da teoria e dos princípios éticos para a prática específica do contexto e acionável continua sendo uma barreira significativa para a adoção generalizada da análise sistemática do impacto ético na engenharia de software.

Princípios da IA responsável

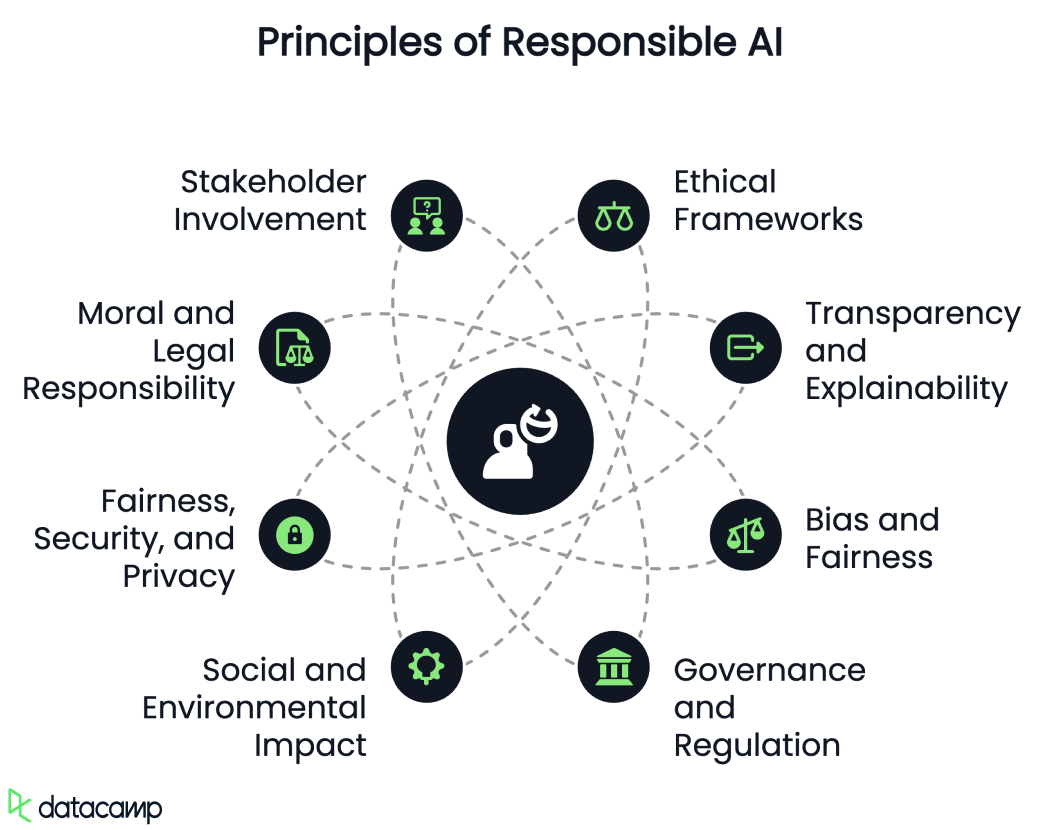

Quando analisamos a literatura, podemos observar um certo desenvolvimento dos princípios da RAI sendo discutidos. Vamos discutir cada um deles brevemente.

Estruturas éticas

A IA responsável enfatiza o uso de estruturas éticas para garantir a prestação de contas, a responsabilidade e a transparência nos sistemas de IA. Isso inclui abordar questões como privacidade, autonomia e preconceito.

Transparência e explicabilidade

A transparência nos algoritmos de IA e nos processos de tomada de decisão é fundamental para criar confiança entre as partes interessadas. IA explicável (XAI) tem como objetivo criar modelos que sejam interpretáveis e compreensíveis, promovendo transparência e confiança.

Preconceito e imparcialidade

A IA responsável busca identificar e corrigir vieses nos algoritmos de IA para promover decisões equitativas. Isso envolve o uso de conjuntos de dados diversos e inclusivos para evitar resultados discriminatórios.

Para saber mais sobre o preconceito na IA, confira este podcast em Fighting for Algorithmic Justice com o Dr. Joy Buolamwini.

Governança e regulamentação

O desenvolvimento de padrões e estruturas para governança da IA é essencial para orientar o uso responsável da IA. Isso inclui a criação de abordagens estruturadas para mitigar os riscos em vários níveis, desde pesquisadores individuais até normas governamentais.

Impacto social e ambiental

A IA responsável considera os impactos socioeconômicos e ambientais mais amplos da IA, como seus efeitos sobre o emprego, a desigualdade e o consumo de recursos e seu potencial de causar mercados digitais injustos ou danos ambientais devido ao uso de recursos.

Equidade, segurança e privacidade

Os esforços da esforços da Comissão Europeia para regulamentar a IA destacam a importância da justiça, segurança, privacidade, explicabilidade, segurança e reprodutibilidade como componentes da IA responsável.

Responsabilidade moral e legal

As discussões sobre IA responsável geralmente envolvem responsabilidade moral, que inclui condições causais e epistêmicas. Isso significa que as ações de IA devem causar resultados, e os agentes devem estar cientes das consequências morais. As estruturas jurídicas também exploram a prestação de contas, a responsabilidade e a culpabilidade dos sistemas de IA.

Envolvimento das partes interessadas

Uma estrutura de IA responsável geralmente envolve a responsabilização de todas as partes interessadas, incluindo desenvolvedores, usuários e, possivelmente, os próprios sistemas de IA.

Taxonomias alternativas de princípios de IA responsável na academia

No meio acadêmico, algumas das análises mais revisões sistemáticas dos princípios éticos da IA produziram taxonomias um pouco diferentes, Jobin et al. analisaram 84 diretrizes éticas e propuseram 11 princípios:

- Transparência

- Justiça e equidade

- Não maleficência

- Responsabilidade

- Privacidade

- Beneficência

- Liberdade e autonomia

- Confiança

- Dignidade

- Sustentabilidade

- Solidariedade

Naturalmente, eles encontraram uma grande divergência na forma como esses princípios foram interpretados e na forma como as recomendações sugeriam que fossem aplicados. No entanto, eles observaram algumas evidências de convergência em torno de cinco princípios fundamentais:

- Transparência

- Justiça e equidade

- Não maleficência

- Responsabilidade

- Privacidade

No entanto, outros proponentes sugerem que a infinidade de estruturas éticas de IA pode ser consolidada em apenas cinco meta-princípios:

- Respeito à autonomia

- Beneficência

- Não maleficência

- Justiça

- Explicabilidade

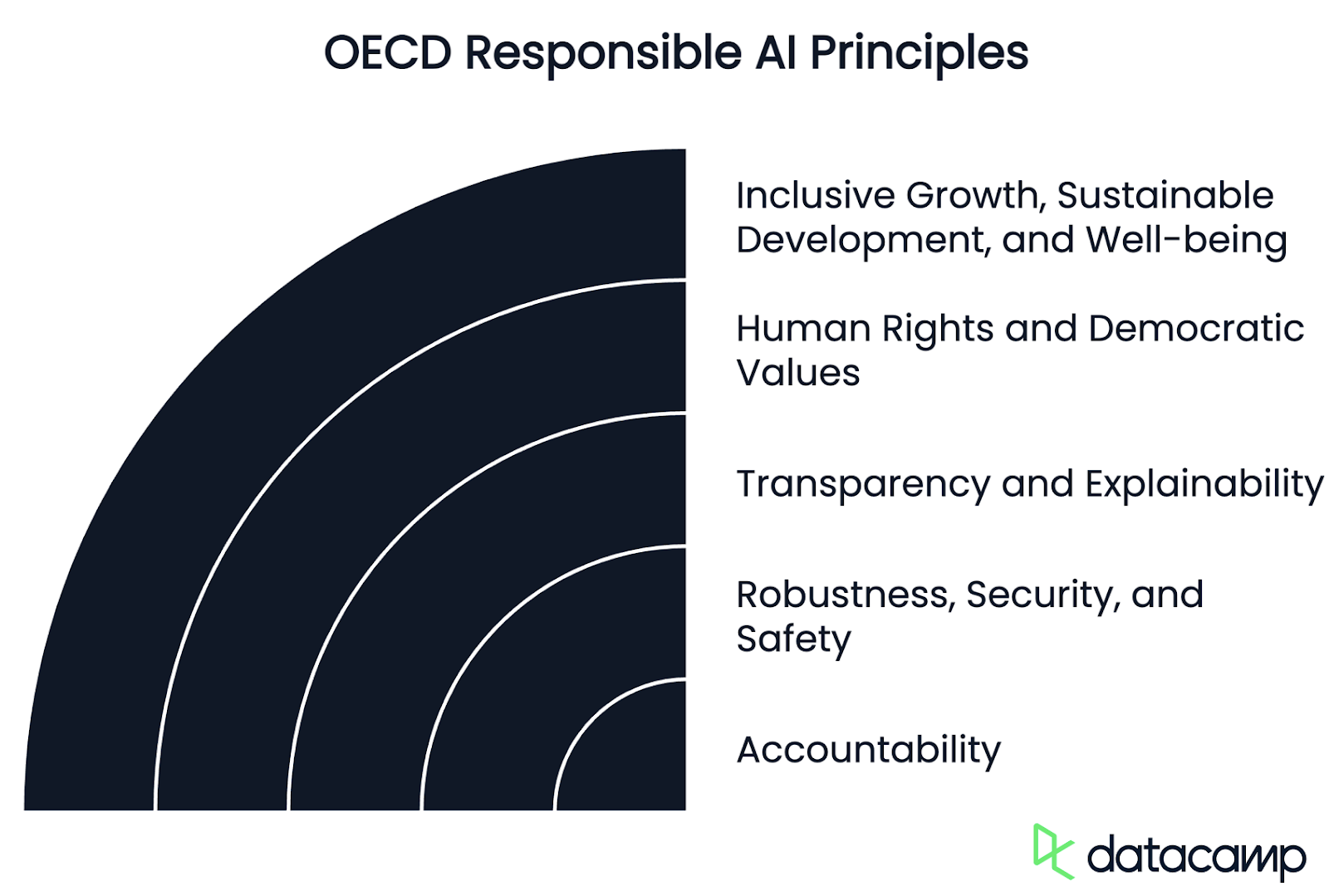

Princípios de IA responsável da OCDE

As organizações internacionais também têm alimentado ativamente as discussões globais sobre como essas definições estão sendo moldadas, para fins de política e harmonização.

A Organização para Cooperação e Desenvolvimento Econômico (OECD), onde atuo como especialista em IA para Riscos e Responsabilidade, bem como para Monitoramento de Incidentes - apresentou uma lista abrangente de uma lista abrangente de princípios para uma IA confiável.

Esses princípios promovem o uso de IA que seja inovadora, confiável e respeite os direitos humanos e os valores democráticos. Inicialmente adotadas em 2019foram atualizadas em maio de 2024 para garantir que permaneçam robustas e adequadas à finalidade à luz dos novos desenvolvimentos tecnológicos e políticos.

Hoje, a União Europeiao Conselho da Europa, os Estados Unidose as Nações Unidase outras jurisdições usam a definição da OCDE de um sistema de IA e o ciclo de vida abaixo em suas estruturas e orientações legislativas e regulatórias.

Em resumo, todos esses princípios são baseados em valores e estão agrupados nas seguintes categorias:

Crescimento inclusivo, desenvolvimento sustentável e bem-estar

As partes interessadas em IA devem se engajar proativamente na administração responsável de IA confiável em busca de resultados benéficos para as pessoas e para o planeta, como aumentar as capacidades humanas e aprimorar a criatividade, promover a inclusão de populações sub-representadas, reduzir as desigualdades econômicas, sociais, de gênero e outras, e proteger os ambientes naturais, revigorando assim o crescimento inclusivo, o bem-estar, o desenvolvimento sustentável e a sustentabilidade ambiental.

Direitos humanos e valores democráticos, incluindo justiça e privacidade

Os atores da IA devem respeitar o estado de direito, os direitos humanos e os valores democráticos e centrados no ser humano durante todo o ciclo de vida do sistema de IA. Isso inclui a não discriminação e a igualdade, a liberdade, a dignidade, a autonomia dos indivíduos, a privacidade e a proteção de dados, a diversidade, a equidade, a justiça social e os direitos trabalhistas reconhecidos internacionalmente.

Transparência e explicabilidade

Os atores da IA devem se comprometer com a transparência e a divulgação responsável de seus sistemas. Para isso, eles devem fornecer informações significativas, adequadas ao contexto e consistentes com o estado da arte, a fim de promover uma compreensão geral dos sistemas de IA, incluindo seus recursos e limitações.

Robustez, segurança e proteção

Os sistemas de IA devem ser robustos, seguros e protegidos durante todo o seu ciclo de vida, de modo que, em condições de uso normal, uso previsível ou uso indevido, ou outras condições adversas, eles funcionem adequadamente e não representem riscos de segurança e/ou proteção não razoáveis.

Responsabilidade

Os atores da IA devem ser responsáveis pelo funcionamento adequado dos sistemas de IA e pela manutenção dos princípios acima, com base em suas funções, no contexto e de acordo com o estado da arte. Para isso, os atores da IA devem garantir a rastreabilidade, inclusive em relação a conjuntos de dados, processos e decisões tomadas durante todo o ciclo de vida do sistema de IA. Essa rastreabilidade deve permitir a análise dos resultados do sistema de IA e das respostas às consultas, de acordo com o contexto e com o estado da arte.

Princípios de IA responsável da ISO

Por outro lado, para a Organização Internacional de Padrões (ISO), há três áreas principais a serem consideradas para que um sistema de IA seja confiável:

- Alimentando-o com dados bons e diversificados

- Garantir que os algoritmos possam lidar com essa diversidade

- E testar o software resultante para verificar se há erros de rotulagem ou correlações ruins

A organização fornece as seguintes diretrizes para você conseguir isso:

- Projete para humanos usando um conjunto diversificado de usuários e cenários de casos de uso e incorpore esse feedback antes e durante todo o ciclo de vida da IA.

- Use várias métricas para avaliar o treinamento e o monitoramento, incluindo pesquisas com usuários, indicadores gerais de desempenho do sistema e taxas de falsos positivos e negativos divididos em diferentes subgrupos.

- Examine os dados brutos em busca de erros (por exemplo, valores ausentes ou desalinhados, rótulos incorretos, amostragem), distorções de treinamento (por exemplo, métodos de coleta de dados ou vieses sociais inerentes) e redundâncias - todos cruciais para garantir os princípios de justiça, equidade e precisão da RAI nos sistemas de IA.

- Entenda as limitações de um determinado modelo para atenuar a tendência, melhorar a generalização, garantir um desempenho confiável em cenários cinéticos e comunicá-las aos desenvolvedores e usuários.

- Teste continuamente seu modelo em relação aos princípios de IA responsável para garantir que ele considere devidamente o desempenho no mundo real e o feedback do usuário, a fim de melhorar as soluções de curto e longo prazo para os problemas.

A opinião dos líderes do setor sobre a IA responsável

Em relação a exemplos concretos de líderes do setor, podemos observar contrastes distintos na nomenclatura e nas taxonomias, com entendimentos variados dos conceitos de RAI, IA confiável, IA ética e outras interpretações diversas cunhadas para suas operações ou aplicações.

Microsoft

A Microsoft, por exemplo, defende os seguintes Princípios de IA Responsável:

- Equidade

- Confiabilidade e segurança

- Privacidade e segurança

- Inclusão

- Transparência e responsabilidade

Apple

Por outro lado, Apple afirma que sua IA foi projetada com seus valores fundamentais e construída sobre uma base de inovações revolucionárias em privacidade, e criou um conjunto de princípios de IA responsável para orientar o desenvolvimento de ferramentas de IA, bem como os modelos que as sustentam:

- Capacite os usuários com ferramentas inteligentes: Identificar áreas em que a IA pode ser usada com responsabilidade para criar ferramentas que atendam às necessidades específicas do usuário, respeitando a forma como os usuários escolhem usar essas ferramentas para atingir seus objetivos.

- Representar os usuários: Criar produtos profundamente pessoais com o objetivo de representar os usuários de todo o mundo de forma autêntica para evitar a perpetuação de estereótipos e preconceitos sistêmicos em ferramentas e modelos de IA.

- Projete com cuidado: Tomar precauções em todos os estágios do nosso processo, incluindo design, treinamento de modelos, desenvolvimento de recursos e avaliação de qualidade para identificar como nossas ferramentas de IA podem ser mal utilizadas ou causar danos potenciais.

- Proteger a privacidade: Conseguimos isso por meio de um poderoso processamento no dispositivo e de uma infraestrutura inovadora, garantindo que eles não usem os dados pessoais privados de nossos usuários ou as interações dos usuários ao treinar seus modelos básicos.

Nvidia

A Nvidia chama isso de IA confiável e acredita que a IA deve respeitar as normas de privacidade e proteção de dados, operar de forma segura e protegida, funcionar de forma transparente e responsável, evitar preconceitos e discriminação indesejados e sinalizar seus quatro princípios fundamentais:

- Privacidade

- Segurança e proteção

- Transparência

- Não discriminação

De forma um pouco diversa, Google fala sobre os "Objetivos para aplicativos de IA" como sendo:

- Ser socialmente benéfico.

- Evite criar ou reforçar preconceitos injustos.

- Ser construído e testado quanto à segurança.

- Seja responsável perante as pessoas.

- Incorporar princípios de design de privacidade.

- Manter altos padrões de excelência científica.

- Ser disponibilizado para uso de acordo com esses princípios para limitar aplicativos potencialmente prejudiciais ou abusivos.

Conclusão

Ainda não há consenso sobre o que exatamente constitui a IA responsável, a IA confiável, a IA ética, a IA segura e a IA protegida, nem se essas são terminologias autônomas ou se são convergentes. No entanto, é encorajador ver que os elementos desses termos são comuns e compartilhados - pelo menos em teoria - em torno dos mesmos princípios fundamentais no meio acadêmico, nas organizações internacionais e no setor.

Em termos gerais, podemos dizer que a RAI é uma disciplina emergente que visa garantir que o desenvolvimento, a implantação e o uso da inteligência artificial sejam feitos de maneira centrada no ser humano e alinhada aos direitos humanos fundamentais na prática, tanto ética quanto legalmente.

Jimena Viveros atualmente trabalha como chefe de gabinete e assessora jurídica principal da juíza Loretta Ortiz na Suprema Corte do México. Suas funções anteriores incluem cargos de liderança nacional no Conselho Judiciário Federal, no Ministério da Segurança e no Ministério das Finanças, onde ocupou o cargo de Diretora Geral. Jimena é advogada e especialista em IA, e possui um histórico internacional amplo e diversificado. Ela está nos estágios finais da conclusão de sua tese de doutorado, que se concentra no impacto da IA e das armas autônomas na política e no direito internacional de paz e segurança, fornecendo propostas concretas para alcançar a governança global a partir de diversas perspectivas jurídicas. Seu extenso trabalho em IA e em outros domínios jurídicos foi amplamente publicado e reconhecido.