Cursus

Veiller à ce que l'IA soit utilisée de manière responsable n'est pas seulement un bel objectif, mais une priorité essentielle. Il est essentiel que l'IA soit créée, déployée et utilisée conformément aux principes de l'IA responsable (RAI) sur le site afin de contribuer à la réduction des risques dans la société, tous secteurs confondus.

Alors que l'IA continue de se développer rapidement, elle peut apporter des avantages majeurs si elle est utilisée de manière responsable, en contribuant à la réalisation des objectifs de développement durable des Nations unies. objectifs de développement durable des Nations uniesde l'ONU, à protéger les droits de l'homme et à toujours donner la priorité au bien-être de l'humanité.

Dans ce blog, je vous introduirai aux principes de l'IA responsable en présentant une étude comparative des travaux réalisés dans ce domaine par la littérature, les universités, les organisations internationales et les leaders de l'industrie.

Si vous souhaitez approfondir ce sujet, n'hésitez pas à consulter ce cours sur les pratiques responsables en matière d'IA. Pratiques responsables en matière d'IA.

Qu'est-ce que l'IA responsable ?

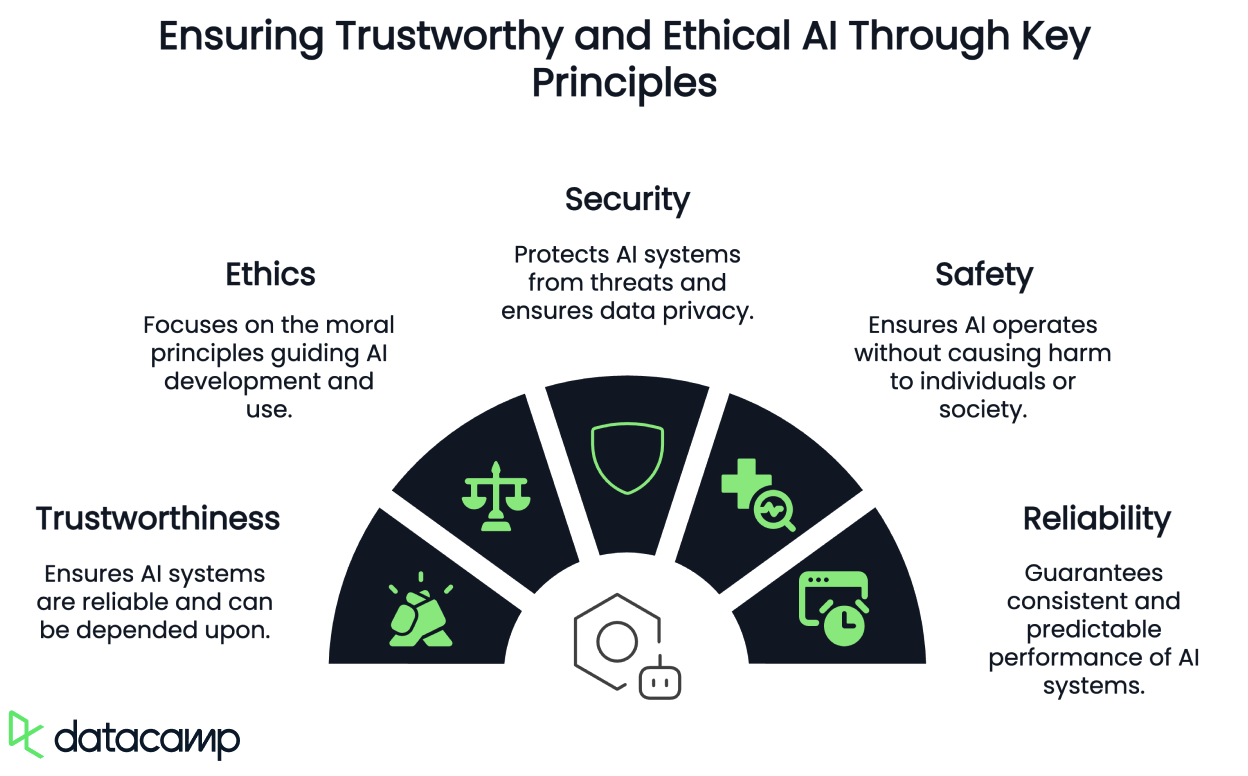

Nous ne disposons pas encore d'une définition universellement partagée de l'"IA responsable". Dans certains cas, on parle d'IA digne de confiance, éthique, sécurisée ou sûre. Dans d'autres, il s'agit simplement de principes subsumés dans une notion plus large de RAI ou de catégories complètement différentes.

L'attention croissante portée à l'IA responsable, éthique, digne de confiance, sûre et sécurisée découle d'une inquiétude généralisée quant à ses effets négatifs potentiels, qu'ils soient intentionnels ou non.

L'Institut des ingénieurs électriciens et électroniciens (IEEE) Institut des ingénieurs électriciens et électroniciens (IEEE) attribue cette préoccupation à l'exclusion traditionnelle de l'analyse éthique de la pratique de l'ingénierie, où les normes éthiques de base liées à la sûreté, à la sécurité, à la fonctionnalité, à la justice, aux préjugés, à la dépendance et aux préjudices sociétaux indirects ont souvent été considérées comme hors de portée.

Toutefois, compte tenu de l'évolutivité et de l'impact généralisé de l'IA dans tous les aspects de la société et de notre vie quotidienne, il est essentiel d'anticiper et d'atténuer les risques éthiques dans le cadre d'une pratique courante. L'approche actuelle, qui consiste à diffuser des technologies dans le monde sans surveillance suffisante, en laissant les autres en assumer les conséquences, n'est plus acceptable.

Pourtant, le passage de la théorie et des principes éthiques à une pratique spécifique au contexte et exploitable reste un obstacle important à l'adoption généralisée de l'analyse systématique de l'impact éthique dans le domaine de l'ingénierie logicielle.

Principes de l'IA responsable

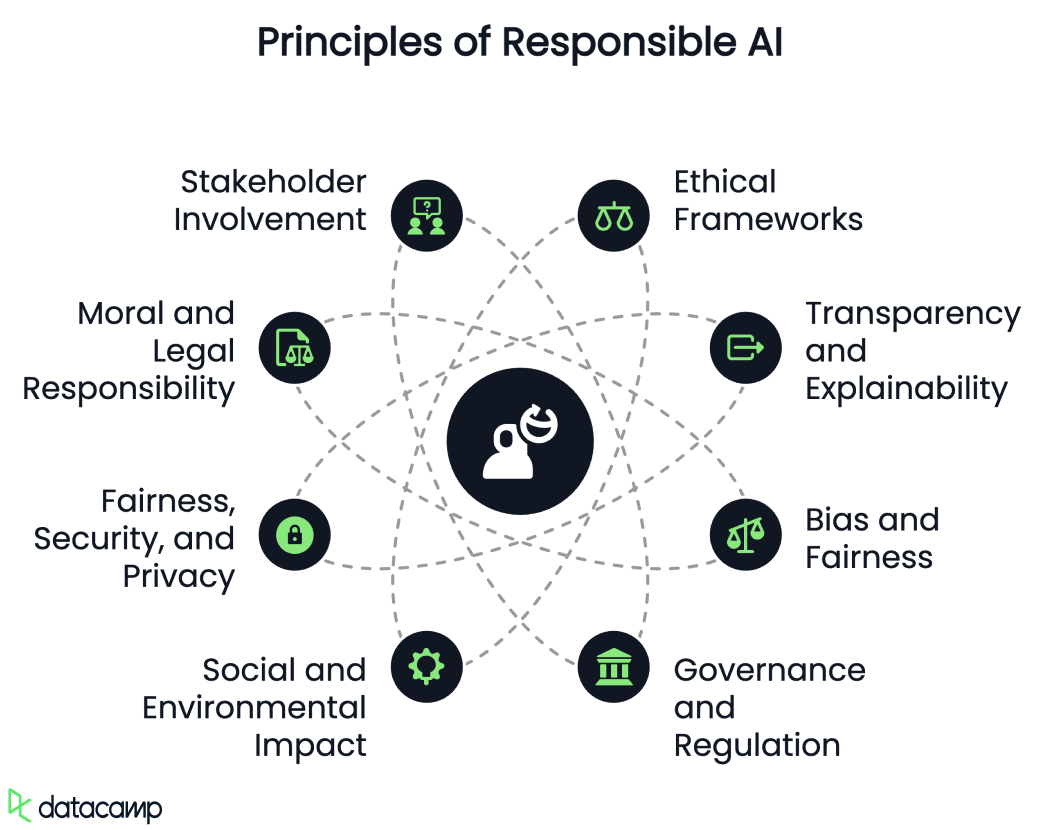

Lorsque nous examinons la littérature, nous constatons que les principes de la RAI ont été développés et discutés. Discutons brièvement de chacun d'entre eux.

Cadres éthiques

L'IA responsable met l'accent sur l'utilisation de cadres éthiques pour garantir l'obligation de rendre compte, la responsabilité et la transparence des systèmes d'IA. Il s'agit notamment d'aborder des questions telles que la protection de la vie privée, l'autonomie et les préjugés.

Transparence et explicabilité

La transparence des algorithmes d'IA et des processus de prise de décision est essentielle pour instaurer la confiance entre les parties prenantes. L'IA explicable (XAI) vise à créer des modèles interprétables et compréhensibles, favorisant la transparence et la confiance.

Préjugés et équité

L'IA responsable cherche à identifier et à corriger les biais des algorithmes d'IA afin de promouvoir des décisions équitables. Il s'agit d'utiliser des ensembles de données diversifiés et inclusifs afin d'éviter les résultats discriminatoires.

Pour en savoir plus sur les préjugés dans l'IA, consultez ce podcast sur Fighting for Algorithmic Justice avec Dr. Joy Buolamwini.

Gouvernance et réglementation

L'élaboration de normes et de cadres pour la gouvernance de l'IA est essentielle pour guider l'utilisation responsable de l'IA. Il s'agit notamment de créer des approches structurées pour atténuer les risques à différents niveaux, depuis les chercheurs individuels jusqu'aux réglementations gouvernementales.

Impact social et environnemental

L'IA responsable prend en compte les impacts socio-économiques et environnementaux plus larges de l'IA, tels que ses effets sur l'emploi, les inégalités et la consommation de ressources, ainsi que son potentiel à provoquer des marchés numériques déloyaux ou des dommages environnementaux dus à l'utilisation des ressources.

Équité, sécurité et respect de la vie privée

Les efforts de la Commission européenne pour réglementer l'IA soulignent l'importance de l'équité, de la sécurité, de la protection de la vie privée, de l'explicabilité, de la sûreté et de la reproductibilité en tant qu'éléments d'une IA responsable.

Responsabilité morale et juridique

Les discussions sur l'IA responsable portent souvent sur la responsabilité morale, qui comprend des conditions causales et épistémiques. Cela signifie que les actions de l'IA doivent entraîner des résultats et que les agents doivent être conscients des conséquences morales. Les cadres juridiques explorent également les questions de responsabilité et d'imputabilité des systèmes d'IA.

Participation des parties prenantes

Un cadre d'IA responsable implique souvent de responsabiliser toutes les parties prenantes, y compris les développeurs, les utilisateurs et potentiellement les systèmes d'IA eux-mêmes.

Taxonomies alternatives des principes de l'IA responsable dans le monde universitaire

Au sein du monde universitaire, certains des examens les plus systématiques des principes éthiques de l'IA ont produit des taxonomies quelque peu différentes, Jobin et al. ont examiné 84 lignes directrices éthiques et proposé 11 principes :

- Transparence

- Justice et équité

- Non-malfaisance

- Responsabilité

- Vie privée

- Bienveillance

- Liberté et autonomie

- Confiance

- Dignité

- Durabilité

- Solidarité

Naturellement, ils ont rencontré de grandes divergences dans l'interprétation de ces principes et dans la manière dont les recommandations suggéraient de les appliquer. Ils ont toutefois noté des signes de convergence autour de cinq principes fondamentaux :

- Transparence

- Justice et équité

- Non-malfaisance

- Responsabilité

- Vie privée

Cependant, d'autres partisans suggèrent que la pléthore de cadres éthiques de l'IA peut être consolidée en cinq méta-principes seulement :

- Respect de l'autonomie

- Bienveillance

- Non-malfaisance

- Justice

- Explicabilité

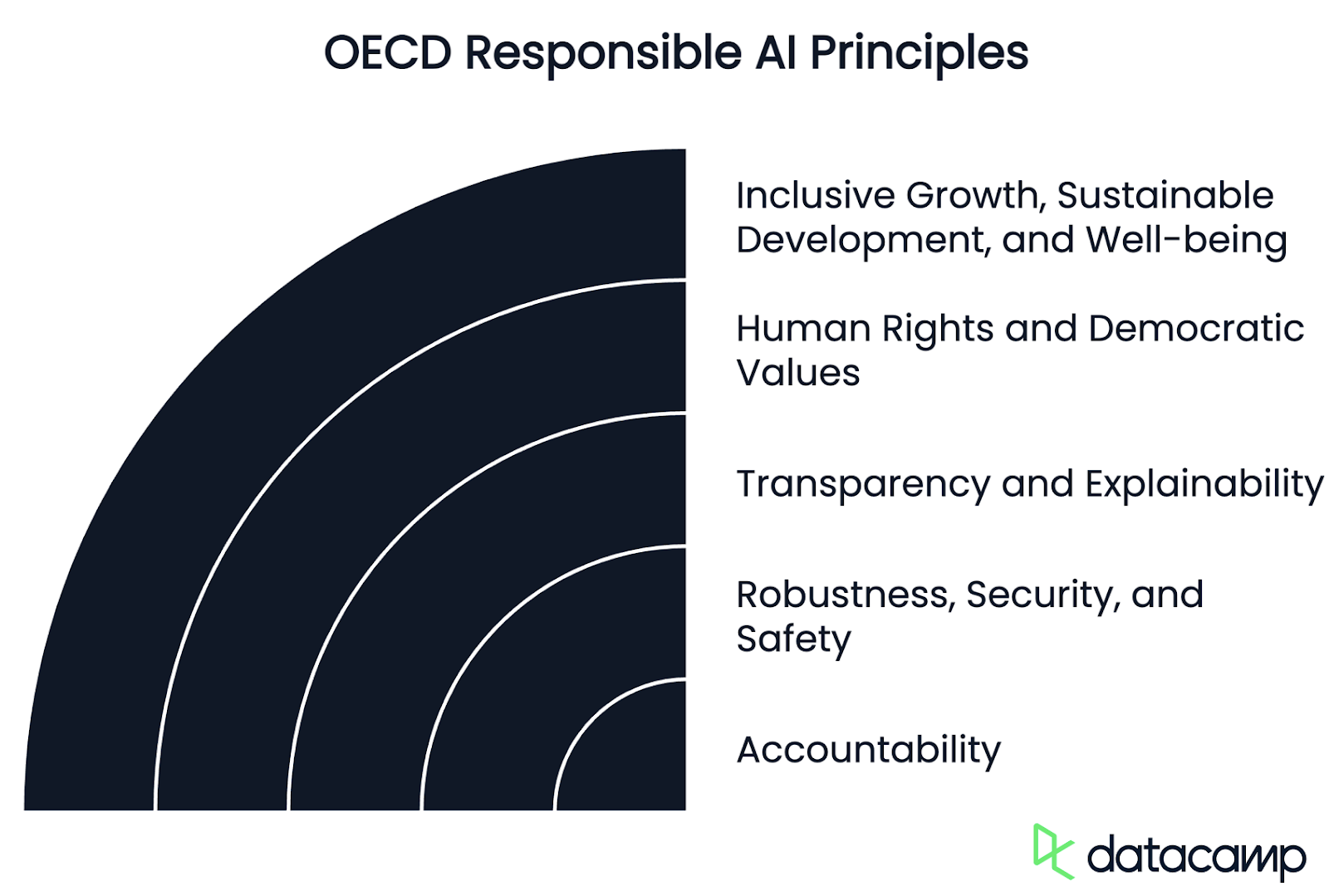

Principes de l'OCDE sur l'IA responsable

Les organisations internationales ont également alimenté activement les discussions mondiales sur la manière dont ces définitions sont façonnées, à des fins de politique et d'harmonisation.

L'Organisation de coopération et de développement économiques (OCDE), au sein de laquelle j'exerce la fonction d'"expert en IA", a mis en place un système de gestion de l'information. expert en IA pour les risques et la responsabilité, ainsi que pour le suivi des incidents - a proposé une une liste complète de principes pour une IA digne de confiance.

Ces principes promeuvent l'utilisation d'une IA innovante, digne de confiance et respectueuse des droits de l'homme et des valeurs démocratiques. Dans un premier temps adoptés en 2019ils ont été mis à jour en mai 2024 afin de s'assurer qu'elles restent robustes et adaptées à l'évolution des technologies et des politiques.

Aujourd'hui, l l'Union européennele Conseil de l'Europe, les États-Unisles Nations uniesL'Union européenne, le Conseil de l'Europe, les États-Unis, les Nations unies et d'autres juridictions utilisent la définition de l'OCDE d'un système d'IA et le cycle de vie ci-dessous dans leurs cadres législatifs et réglementaires et dans leurs orientations.

En bref, il s'agit de principes fondés sur des valeurs et regroupés dans les catégories suivantes :

Croissance inclusive, développement durable et bien-être

Les parties prenantes de l'IA devraient s'engager de manière proactive dans une gestion responsable de l'IA digne de confiance afin d'obtenir des résultats bénéfiques pour les personnes et pour la planète, tels que l'augmentation des capacités humaines et le renforcement de la créativité, la promotion de l'inclusion des populations sous-représentées, la réduction des inégalités économiques, sociales, de genre et autres, et la protection des environnements naturels, stimulant ainsi la croissance inclusive, le bien-être, le développement durable et la viabilité environnementale.

Droits de l'homme et valeurs démocratiques, y compris l'équité et la protection de la vie privée

Les acteurs de l'IA doivent respecter l'État de droit, les droits de l'homme et les valeurs démocratiques et centrées sur l'homme tout au long du cycle de vie du système d'IA. Il s'agit notamment de la non-discrimination et de l'égalité, de la liberté, de la dignité, de l'autonomie des personnes, de la protection de la vie privée et des données, de la diversité, de l'équité, de la justice sociale et des droits du travail internationalement reconnus.

Transparence et explicabilité

Les acteurs de l'IA devraient s'engager à faire preuve de transparence et à divulguer leurs systèmes de manière responsable. À cette fin, ils doivent fournir des informations utiles, adaptées au contexte et conformes à l'état de l'art, afin de favoriser une compréhension générale des systèmes d'IA, y compris de leurs capacités et de leurs limites.

Robustesse, sécurité et sûreté

Les systèmes d'IA doivent être robustes, sûrs et sécurisés tout au long de leur cycle de vie, de sorte que, dans des conditions d'utilisation normale, d'utilisation prévisible ou abusive, ou dans d'autres conditions défavorables, ils fonctionnent correctement et ne présentent pas de risques déraisonnables pour la sécurité et/ou la sûreté.

Responsabilité

Les acteurs de l'IA devraient être responsables du bon fonctionnement des systèmes d'IA et du respect des principes susmentionnés, en fonction de leur rôle et du contexte, et conformément à l'état de l'art. À cette fin, les acteurs de l'IA devraient assurer la traçabilité, notamment en ce qui concerne les ensembles de données, les processus et les décisions prises tout au long du cycle de vie du système d'IA. Cette traçabilité doit permettre d'analyser les résultats du système d'IA et les réponses aux demandes, en fonction du contexte et de l'état de l'art.

Principes ISO de l'IA responsable

En revanche, pour l Organisation internationale de normalisation (ISO), il y a trois domaines clés à prendre en compte pour qu'un système d'IA soit digne de confiance :

- L'alimenter avec des données de qualité et diversifiées

- Veiller à ce que les algorithmes puissent gérer cette diversité

- Et tester le logiciel résultant pour détecter les erreurs d'étiquetage ou les mauvaises corrélations.

L'organisation fournit les lignes directrices suivantes pour y parvenir :

- Concevez pour les humains en utilisant un ensemble varié d'utilisateurs et de scénarios d'utilisation et intégrez ce retour d'information avant et tout au long du cycle de vie de l'IA.

- Utilisez plusieurs mesures pour évaluer la formation et le suivi, notamment des enquêtes auprès des utilisateurs, des indicateurs de performance globale du système et des taux de faux positifs et de faux négatifs répartis entre différents sous-groupes.

- Examinez les données brutes à la recherche d'erreurs (valeurs manquantes ou non alignées, étiquettes incorrectes, échantillonnage), de biais d'apprentissage (méthodes de collecte de données ou biais sociaux inhérents) et de redondances - autant d'éléments essentiels pour garantir les principes de justice, d'équité et d'exactitude de la RAI dans les systèmes d'IA.

- Comprendre les limites d'un modèle donné afin d'atténuer les biais, d'améliorer la généralisation, de garantir des performances fiables dans les scénarios cinétiques et de les communiquer aux développeurs et aux utilisateurs.

- Testez continuellement votre modèle en fonction des principes de l'IA responsable pour vous assurer qu'il tient dûment compte des performances réelles et du retour d'information des utilisateurs, afin d'améliorer les solutions à court et à long terme.

Le point de vue des leaders du secteur sur l'IA responsable

En ce qui concerne les exemples concrets de leaders du secteur, nous pouvons observer des contrastes marqués dans la nomenclature et les taxonomies, avec des compréhensions différentes des concepts de RAI, d'IA digne de confiance, d'IA éthique et d'autres interprétations diverses inventées pour leurs opérations ou leurs applications.

Microsoft

Microsoft, par exemple, respecte les principes suivants en matière d'IA responsable :

- L'équité

- Fiabilité et sécurité

- Vie privée et sécurité

- Inclusion

- Transparence et responsabilité

Pomme

D'autre part, Apple affirme que son IA est conçue en fonction de ses valeurs fondamentales et repose sur des innovations révolutionnaires en matière de protection de la vie privée, et a créé un ensemble de principes d'IA responsables pour guider le développement des outils d'IA, ainsi que les modèles qui les sous-tendent :

- Donnez aux utilisateurs les moyens d'agir grâce à des outils intelligents : Identifier les domaines dans lesquels l'IA peut être utilisée de manière responsable pour créer des outils permettant de répondre aux besoins spécifiques des utilisateurs, en respectant la manière dont ces derniers choisissent d'utiliser ces outils pour atteindre leurs objectifs.

- Représenter les utilisateurs : Construire des produits profondément personnels dans le but de représenter les utilisateurs du monde entier de manière authentique afin d'éviter de perpétuer les stéréotypes et les préjugés systémiques à travers les outils et les modèles d'IA.

- Concevez avec soin : Nous prenons des précautions à chaque étape de notre processus, y compris la conception, la formation des modèles, le développement des fonctionnalités et l'évaluation de la qualité, afin d'identifier la manière dont nos outils d'IA peuvent être utilisés à mauvais escient ou conduire à des dommages potentiels.

- Protéger la vie privée : Ils y parviennent grâce à un traitement puissant sur l'appareil et à une infrastructure révolutionnaire, garantissant qu'ils n'utilisent pas les données personnelles privées de nos utilisateurs ou les interactions des utilisateurs lors de l'entraînement de leurs modèles de base.

Nvidia

Nvidia Elle estime que l'IA doit respecter les réglementations en matière de protection de la vie privée et des données, fonctionner en toute sécurité, de manière transparente et responsable, éviter les préjugés et les discriminations indésirables, et signaler ses quatre principes fondamentaux :

- Vie privée

- Sûreté et sécurité

- Transparence

- Non-discrimination

De manière assez diversifiée, Google parle d'"objectifs pour les applications de l'IA" :

- Être socialement bénéfique.

- Évitez de créer ou de renforcer des préjugés injustes.

- Être construit et testé pour la sécurité.

- Rendre des comptes aux gens.

- Intégrer les principes de conception de la protection de la vie privée.

- Respecter des normes élevées d'excellence scientifique.

- être mis à disposition pour une utilisation conforme à ces principes afin de limiter les applications potentiellement nuisibles ou abusives.

Conclusion

Il n'y a pas encore de consensus sur ce qui constitue exactement l'IA responsable, l'IA digne de confiance, l'IA éthique, l'IA sûre, ni sur la question de savoir s'il s'agit de terminologies autonomes ou si elles sont convergentes. Toutefois, il est encourageant de constater que les éléments de ces termes sont communs et partagés - du moins en théorie - autour des mêmes principes fondamentaux dans les universités, les organisations internationales et l'industrie.

D'une manière générale, nous pouvons dire que la RAI est une discipline émergente qui vise à garantir que le développement, le déploiement et l'utilisation de l'intelligence artificielle se font d'une manière centrée sur l'être humain et conforme aux droits de l'homme fondamentaux dans la pratique, à la fois sur le plan éthique et juridique.

Jimena Viveros est actuellement chef de cabinet et conseillère juridique principale de la juge Loretta Ortiz à la Cour suprême du Mexique. Elle a notamment occupé des postes de direction au niveau national au Conseil judiciaire fédéral, au ministère de la sécurité et au ministère des finances, où elle était directrice générale. Jimena est avocate et experte en IA, et possède une expérience internationale vaste et variée. Elle est sur le point de terminer sa thèse de doctorat, qui porte sur l'impact de l'IA et des armes autonomes sur le droit et la politique en matière de paix et de sécurité internationales, en fournissant des propositions concrètes pour parvenir à une gouvernance mondiale à partir de diverses perspectives juridiques. Ses nombreux travaux dans le domaine de l'IA et dans d'autres domaines juridiques ont été largement publiés et reconnus.