programa

El aprendizaje por refuerzo es una técnica muy utilizada para entrenar a agentes inteligentes para que tomen decisiones eficaces en su entorno. En el ámbito de los grandes modelos lingüísticos (LLM), esto suele implicar guiar el proceso de aprendizaje mediante retroalimentación humana.

Sin embargo, confiar en los humanos para que proporcionen retroalimentación puede ser caro, llevar mucho tiempo y, a veces, ser incoherente. El aprendizaje por refuerzo a partir de la retroalimentación de la IA (RLAIF) presenta una solución alternativa que aprovecha la potencia de los modelos de IA existentes.

En este artículo, desglosaremos los conceptos básicos de la RLAIF, exploraremos cómo funciona en la práctica y debatiremos sus implicaciones para el futuro del desarrollo de la IA.

Si quieres saber más sobre el aprendizaje por refuerzo a partir de la retroalimentación humana (RLHF), consulta este artículo sobre Qué es el aprendizaje por refuerzo a partir de la retroalimentación humana.

Respuesta corta: ¿Qué es el aprendizaje por refuerzo a partir de la retroalimentación de la IA?

El aprendizaje por refuerzo a partir de la retroalimentación de la IA (RLAIF) es una técnica de aprendizaje automático en la que los modelos de IA proporcionan retroalimentación a otros modelos de IA durante el proceso de aprendizaje por refuerzo.

En lugar de depender únicamente de la aportación humana, RLAIF aprovecha las capacidades de los sistemas de IA existentes, como los grandes modelos lingüísticos, para evaluar las acciones y guiar el aprendizaje de otros agentes.

Esta retroalimentación de la IA puede adoptar diversas formas, como generar recompensas, clasificar las respuestas o sugerir directamente mejoras. Al automatizar el bucle de retroalimentación, RLAIF tiene el potencial de agilizar el entrenamiento, reducir los costes y mejorar el rendimiento de diversos sistemas de IA, incluidos los grandes modelos lingüísticos.

RLHF vs. RLAIF

Para entender cómo se compara la RLAIF con la RLHF, empecemos por considerar esta tabla:

|

Función |

RLHF (Aprendizaje por Refuerzo a partir de la Retroalimentación Humana) |

RLAIF (Aprendizaje por Refuerzo a partir de la Retroalimentación de la IA) |

|

Fuente de información |

Anotadores humanos |

Modelos de IA existentes (por ejemplo, LLM) |

|

Escalabilidad |

Limitada por la disponibilidad y el coste de la mano de obra humana |

Altamente escalable gracias a la automatización |

|

Calidad de la información |

Alto potencial para captar las preferencias humanas matizadas |

Depende de las capacidades del modelo de IA que proporciona la información |

|

Coste |

Puede ser caro debido a la necesidad de mano de obra humana |

Potencialmente más rentable gracias a la automatización |

|

Velocidad |

Más lento debido al tiempo necesario para la anotación humana |

Más rápido gracias a la generación automática de respuestas |

|

Sesgo |

Puede estar sujeto a sesgos humanos |

Puede heredar sesgos del modelo de IA que proporciona la información |

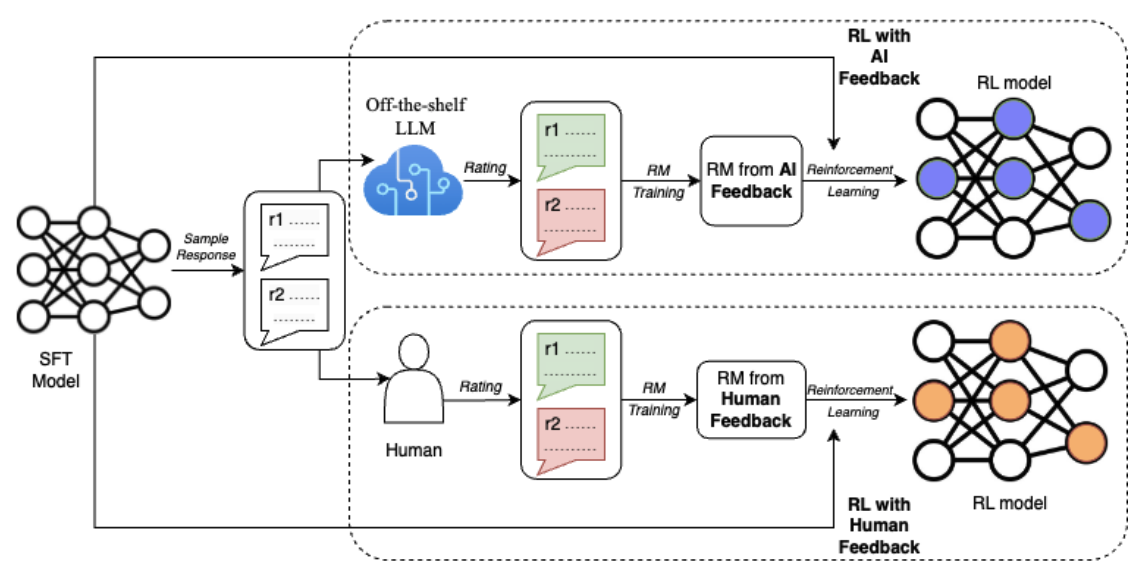

Para comprender mejor las diferencias entre RLHF y RLAIF, consideremos también este diagrama del documento RLAIF: Escalar el aprendizaje por refuerzo a partir de la retroalimentación humana con la retroalimentación de la IA (Lee et al., 2023):

Fuente: Lee y otros, 2023

El diagrama ilustra la diferencia clave entre RLHF y RLAIF en el proceso de aprendizaje por refuerzo. Ambos enfoques parten de un modelo inicial (Modelo SFT) que genera respuestas muestrales. Sin embargo, en RLHF, los evaluadores humanos dan puntuaciones a estas respuestas, mientras que en RLAIF, un LLM estándar actúa como juez.

Estas valoraciones se utilizan después para entrenar un modelo de recompensa (MR). Por último, en el bucle de aprendizaje por refuerzo, el modelo RL recibe recompensas del MR, que está entrenado en base a la retroalimentación humana (RLHF) o a la retroalimentación de la IA (RLAIF). Este bucle de retroalimentación permite al modelo RL aprender continuamente y mejorar su rendimiento en función del tipo específico de retroalimentación que recibe.

Cómo funciona RLAIF

Ahora que hemos establecido los conceptos básicos de la RLAIF y su diferenciación de la RLHF, vamos a sumergirnos en los pasos prácticos para aplicar este enfoque. El proceso RLAIF suele constar de cuatro etapas clave, cada una de las cuales desempeña un papel crucial a la hora de permitir que los modelos de IA aprendan de los comentarios generados por la IA.

Paso 1: Entrenar el modelo de retroalimentación (opcional)

En el artículo original de RLAIF (Lee et.al., 2023), se utilizó un LLM "estándar" como modelo de retroalimentación para el etiquetado de preferencias. Esto sirve como un buen punto de partida, pero en determinados escenarios, sobre todo los que implican conocimientos o terminología específicos del dominio, puede ser ventajoso afinar más el LLM sobre los datos relevantes.

Por ejemplo, si el objetivo es desarrollar un asistente de IA adaptado a los campos de las finanzas o la medicina, afinar el LLM en un corpus de textos financieros o médicos puede mejorar significativamente su comprensión de conceptos y jerga específicos del dominio.

Este paso adicional garantiza que el modelo pueda proporcionar juicios de preferencia más precisos y relevantes, mejorando en última instancia la calidad general y la fiabilidad del sistema de IA en aplicaciones especializadas.

Paso 2: Generar retroalimentación de la IA

Una vez que tenemos nuestro modelo de retroalimentación LLM -ya sea una versión estándar o una variante ajustada- podemos utilizarlo para generar etiquetas de preferencia.

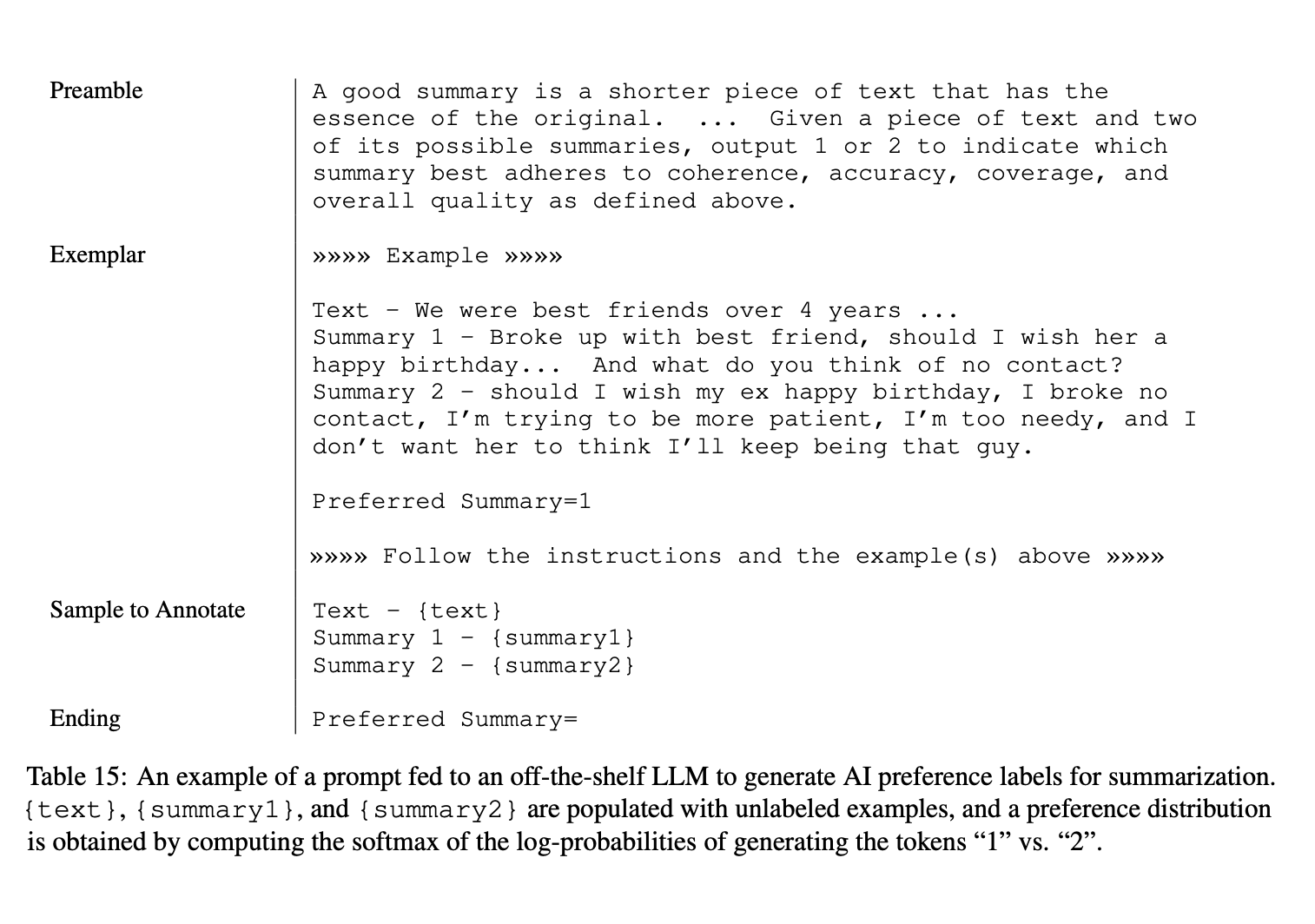

Para generar la respuesta de la IA, al modelo de respuesta se le presenta el contexto y dos respuestas candidatas. A continuación, se pide al modelo que determine qué respuesta prefiere. En el documento RLAIF, la pregunta de entrada al modelo de retroalimentación sigue un formato estructurado:

- Preámbulo: Una instrucción introductoria que describa la tarea.

- Ejemplares de pocos disparos (opcional): Ejemplos de contextos de entrada, pares de respuestas, razonamientos opcionales en cadena y etiquetas de preferencia correspondientes.

- Muestra para anotar: El contexto de entrada y el par de respuestas que hay que etiquetar.

- Fin: Texto final para solicitar al LLM la etiqueta de preferencia (por ejemplo, "Resumen preferido=").

Para comprender mejor esta estructura, considera la siguiente imagen:

Fuente: Lee y otros, 2023

Este enfoque estructurado garantiza que el modelo de respuesta pueda evaluar eficazmente la calidad de las respuestas y proporcionar etiquetas de preferencia precisas. Incluyendo ejemplares de pocas tomas, podemos mejorar aún más el funcionamiento del modelo, mostrando ejemplos concretos de cómo evaluar las respuestas, y haciendo que la respuesta sea más coherente y fiable.

Dada la pregunta de entrada, el modelo de retroalimentación LLM genera las probabilidades logarítmicas de los símbolos "1" y "2", que representan la preferencia del modelo por la primera o la segunda respuesta. A continuación, estas log-probabilidades se pasan por una función softmax para obtener una distribución de preferencias.

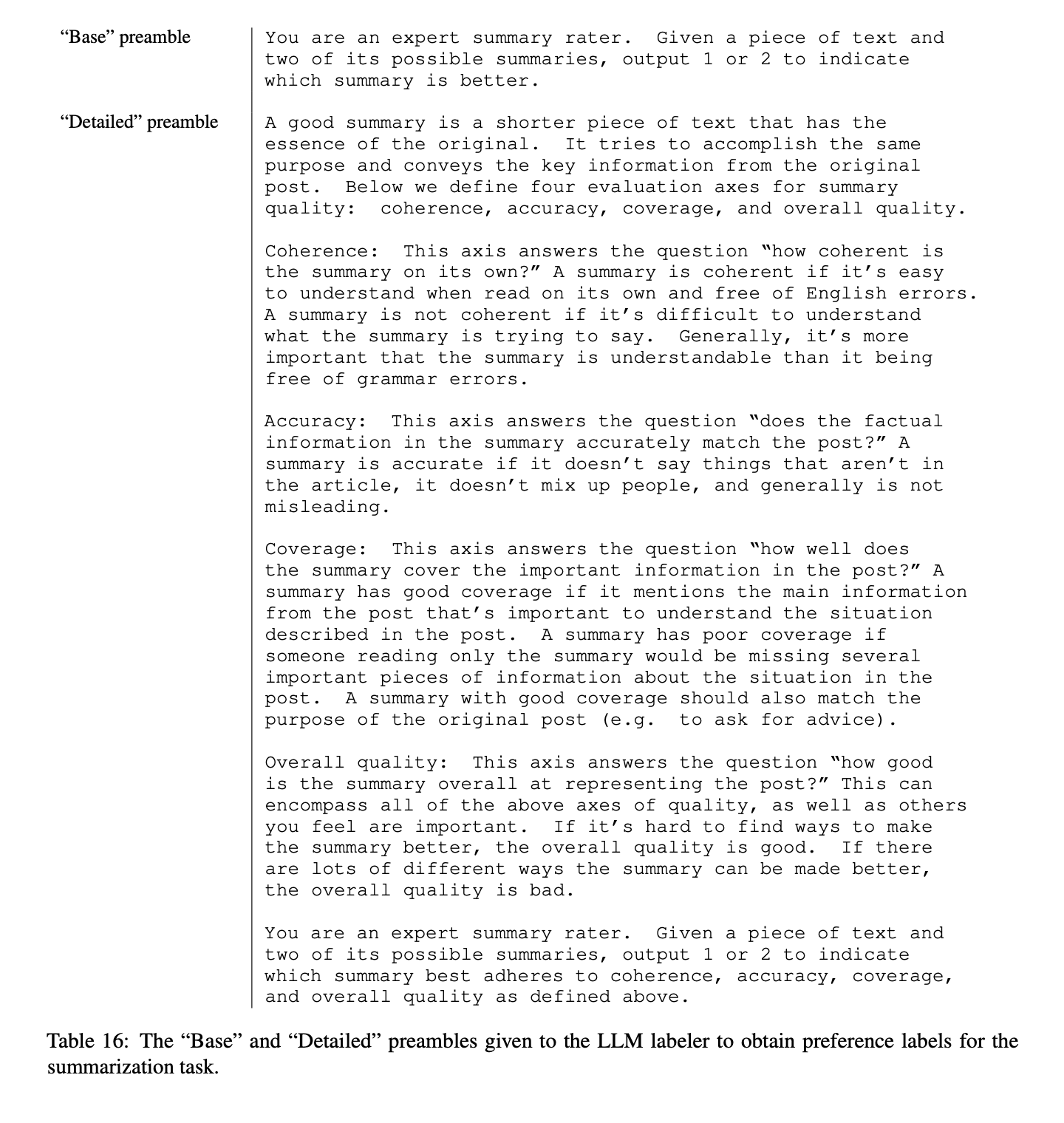

En el documento RLAIF, se experimentó con dos estilos de preámbulos: "Base" y "Detallado". Un preámbulo Base pide al modelo de retroalimentación que juzgue qué respuesta es mejor, mientras que un preámbulo Detallado proporciona instrucciones exhaustivas que suelen darse a los anotadores humanos. Para entenderlo mejor, veamos este ejemplo:

Fuente: Lee y otros, 2023

Por último, se exploraron dos consideraciones importantes para mejorar la eficacia de la metodología RLAIF:

- Abordar el sesgo de posición: La investigación ha demostrado que el orden en que se presentan los candidatos al LLM puede influir en su preferencia de salida. Para mitigar este sesgo, RLAIF realiza dos inferencias para cada par de candidatos intercambiando sus posiciones. La distribución final de preferencias se genera promediando los resultados de ambas inferencias, lo que garantiza una evaluación más equilibrada e imparcial.

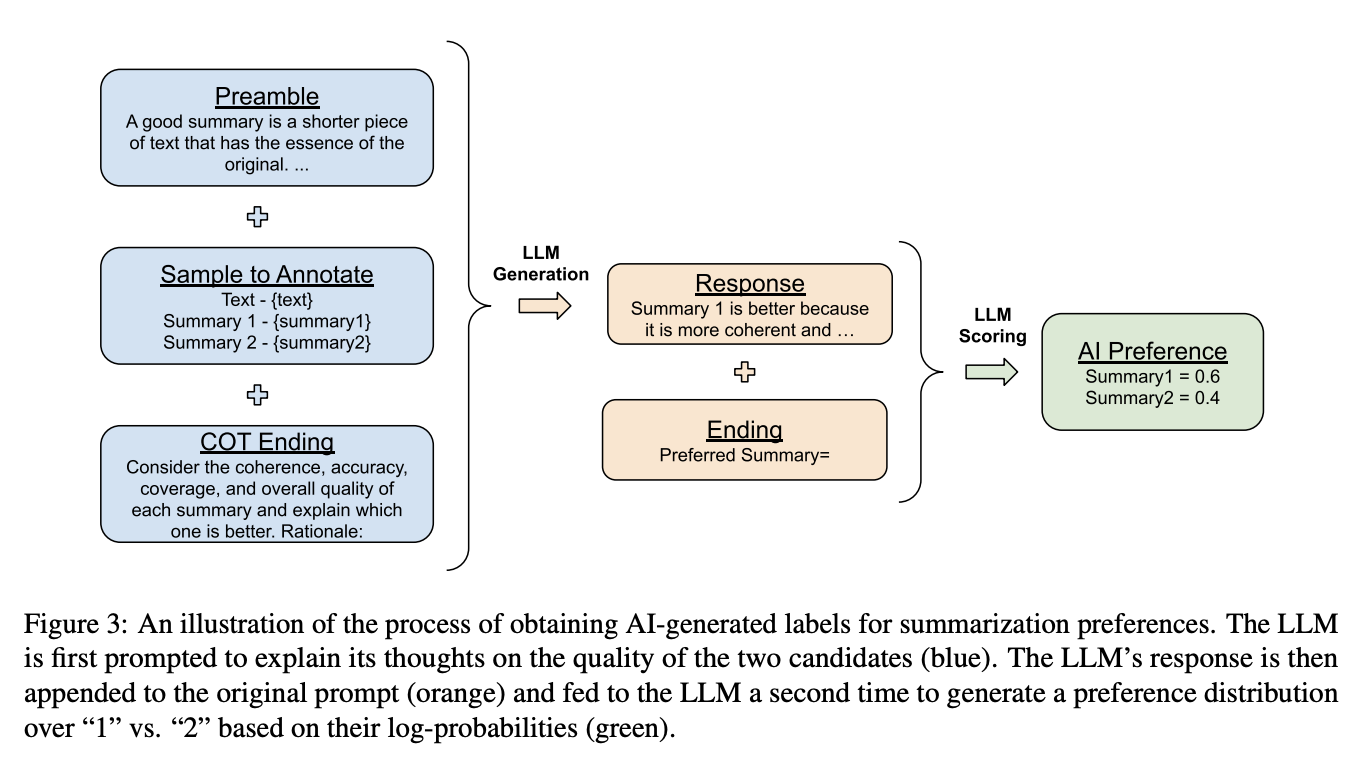

- Razonamiento en cadena: RLAIF aprovecha el razonamiento en cadena (CoT) para mejorar el proceso de inferencia dividiéndolo en dos pasos:

- La parte final de la pregunta se sustituye por una solicitud en la que se pide al LLM que explique su razonamiento para elegir la mejor respuesta.

- A continuación, el razonamiento generado se concatena con el aviso original, seguido de la cadena final estándar para pedir al LLM que emita un testigo de preferencia de "1" o "2". Estas fichas se utilizan posteriormente para entrenar el modelo de preferencias.

Para comprender mejor esta técnica de CoT, considera este diagrama del documento:

Fuente: Lee y otros, 2023

Paso 3: Entrenamiento del modelo de preferencias

Una vez que hemos obtenido las etiquetas de preferencia del modelo de retroalimentación LLM, el siguiente paso es utilizar estas etiquetas para entrenar un modelo de preferencia.

El modelo de preferencias aprende a asignar el contexto y las respuestas de los candidatos a una señal de recompensa escalar, que sirve como sustituto de las preferencias humanas. A continuación, este modelo de preferencias entrenado se integra en el ciclo de aprendizaje por refuerzo.

El documento RLAIF explora un enfoque alternativo en el que la retroalimentación del LLM se utiliza directamente como señal de recompensa, eliminando la necesidad de un modelo de preferencias separado. Sin embargo, este método RLAIF "directo" es costoso desde el punto de vista informático, sobre todo a medida que aumenta el tamaño del etiquetador LLM.

Paso 4: Aprendizaje por refuerzo con retroalimentación de IA

Una vez establecido el modelo de preferencias, se puede realizar el aprendizaje por refuerzo utilizando la retroalimentación de la IA como señal de recompensa. El agente (LLM base) interactúa con el entorno, y sus resultados son evaluados por el modelo de preferencias, que asigna una recompensa en función de lo bien que la acción se alinea con las preferencias deseadas codificadas en el modelo de retroalimentación.

RLAIF Advantages

La RLAIF ofrece varias ventajas convincentes sobre la RLHF tradicional, lo que la convierte en una alternativa atractiva para entrenar y perfeccionar grandes modelos lingüísticos. Profundicemos en algunas de las principales ventajas que aporta la RLAIF.

Escalabilidad

Al automatizar el proceso de generación de opiniones, RLAIF elimina la necesidad de comentaristas humanos, lo que hace que la recopilación de opiniones a gran escala sea más eficaz y rentable.

Este enfoque reduce significativamente los cuellos de botella asociados a la recogida humana de información, como el tiempo, el trabajo y los gastos. A medida que los LLM se vuelven más capaces, aprovechar los sistemas de IA para supervisar a otras IA resulta cada vez más beneficioso, especialmente cuando la supervisión humana puede ser insuficiente para modelos muy avanzados.

Flexibilidad, adaptabilidad y transparencia

RLAIF es muy flexible y adaptable a diversas tareas y ámbitos. Al no depender de conjuntos de datos fijos de retroalimentación humana, podemos ajustar fácilmente la constitución o los datos de entrenamiento utilizados para afinar el modelo de retroalimentación. Esto nos permite adaptar el comportamiento del LLM para que se adapte mejor a diferentes tareas y dominios, proporcionando una solución más personalizada y eficaz.

Además, los principios que guían el modelo de retroalimentación deseado se codifican explícitamente en instrucciones de lenguaje natural, formando una "constitución". Este enfoque aumenta la transparencia, ya que los criterios de evaluación están claramente articulados, a diferencia de los métodos tradicionales, en los que los principios de retroalimentación pueden estar dispersos en miles de etiquetas humanas individuales.

Potencial de mejora del rendimiento

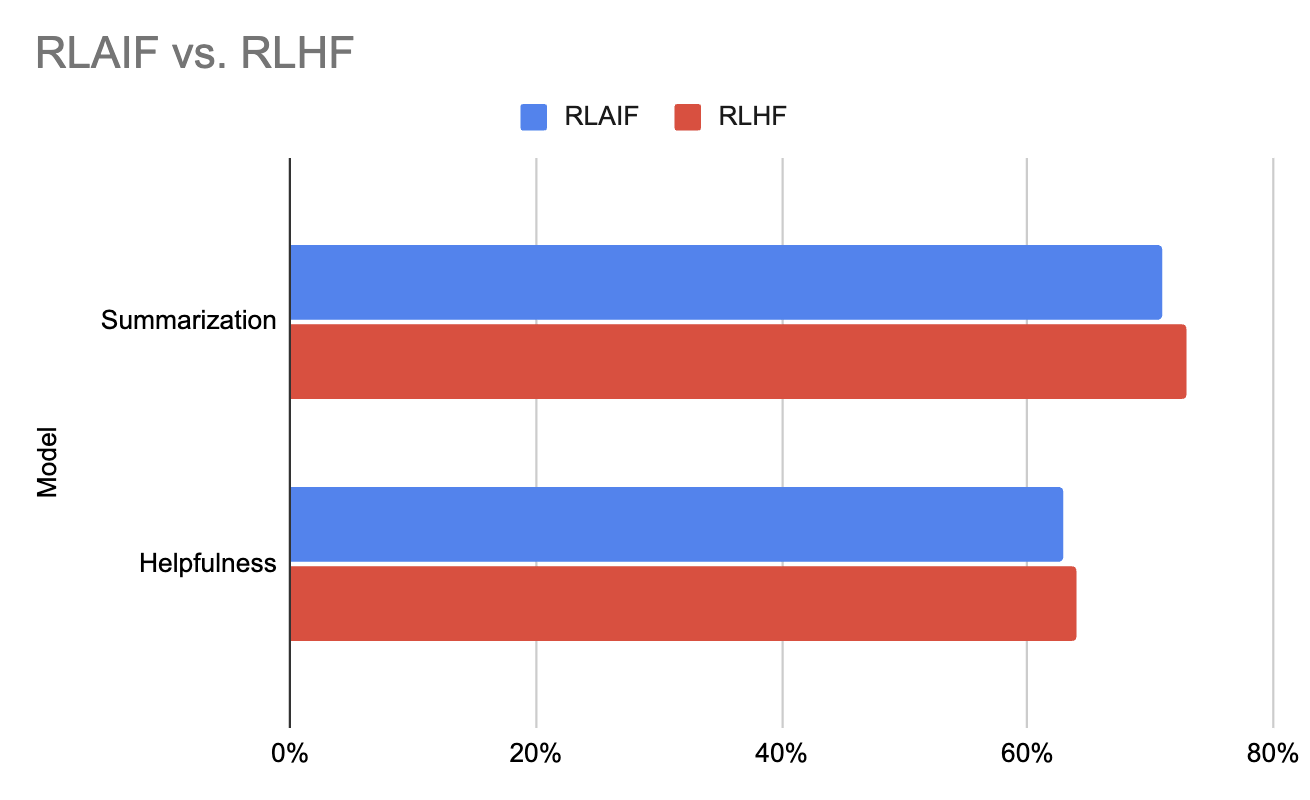

Los resultados experimentales del artículo original de RLAIF indican que RLAIF iguala el rendimiento de RLHF y, en algunos casos, incluso lo supera. Esto demuestra el potencial de RLAIF no sólo para agilizar el proceso de retroalimentación, sino también para mejorar el rendimiento general de los modelos que entrena.

Gráfico generado con los datos de este trabajo (Lee et al., 2023)

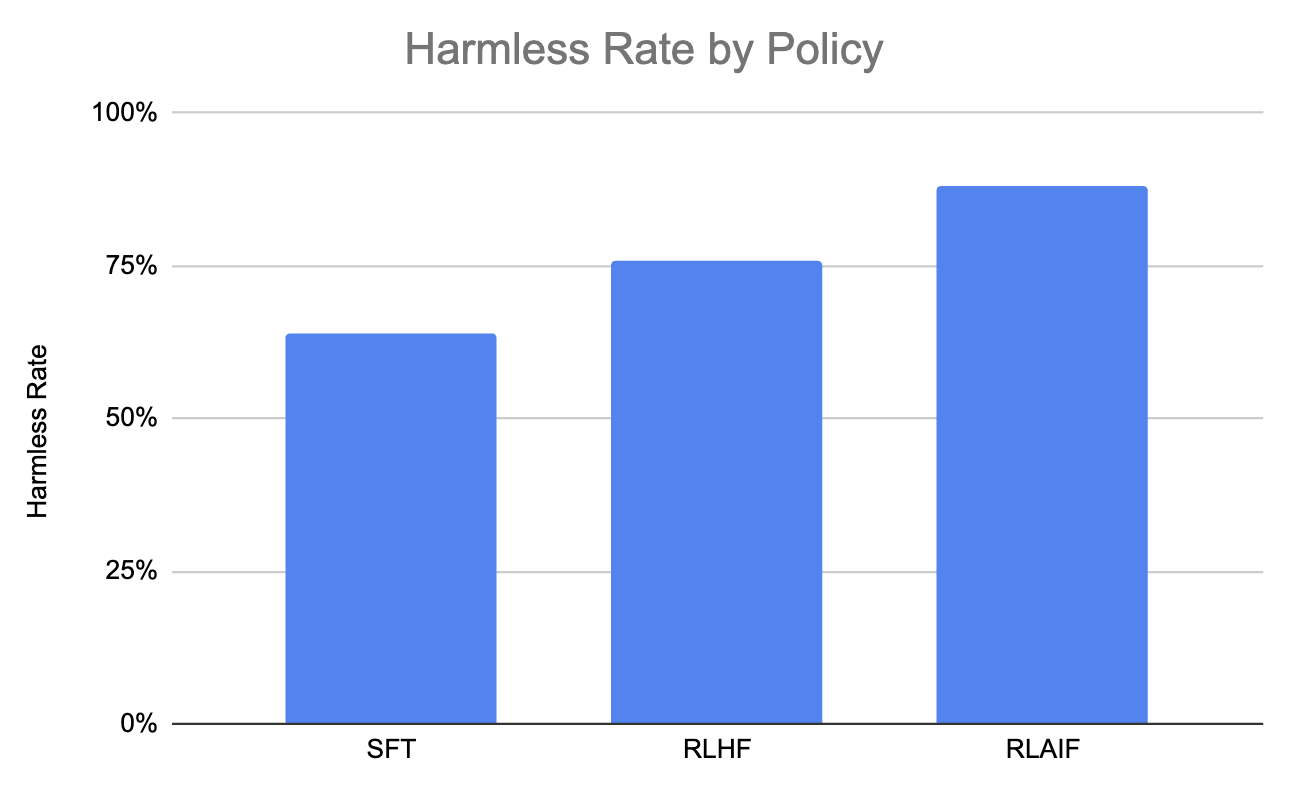

Consideremos también este gráfico, que muestra que RLAIF produce el mayor porcentaje de diálogo inofensivo en comparación con RLHF y SFT.

Gráfico generado con los datos de este trabajo (Lee et al., 2023)

Retos de la RLAIF

Aunque el RLAIF ha demostrado unos resultados impresionantes, también introduce nuevos retos que deben abordarse:

Alineación con los valores humanos

Aunque la "constitución" del lenguaje natural proporciona más transparencia que las etiquetas humanas individuales, el preentrenamiento LLM sigue siendo una "caja negra". Por ello, garantizar que el modelo de retroalimentación se ajuste a los valores y preferencias humanos es un reto fundamental, ya que los desajustes o sesgos en el modelo de retroalimentación pueden provocar consecuencias no deseadas o un comportamiento subóptimo del agente.

Por lo tanto, para mitigar este riesgo, la retroalimentación de la IA podría complementar la supervisión humana en lugar de sustituirla por completo. Este doble enfoque podría ayudar a garantizar que los modelos no se alejen del comportamiento preferido por los humanos a lo largo del tiempo, manteniendo la alineación con los valores humanos.

Evaluar la calidad de la retroalimentación de la IA

Aunque escalar la supervisión humana para modelos muy grandes es un reto, la capacidad de los sistemas de IA actuales para supervisar de forma fiable y mantener un comportamiento robusto en asistentes de IA más capaces sigue siendo una cuestión abierta. Como tal, es esencial disponer de métricas de evaluación rigurosas para valorar la calidad y la alineación de la retroalimentación de la IA generada por el modelo de retroalimentación, garantizando su fiabilidad y eficacia.

Abordar los sesgos en la retroalimentación de la IA

Como cualquier modelo de aprendizaje automático, los modelos de retroalimentación pueden presentar sesgos derivados de los datos de entrenamiento o del propio proceso de aprendizaje. Las estrategias para mitigar los sesgos en la retroalimentación de la IA, como el uso de datos de entrenamiento diversos y representativos, el empleo de métodos de evaluación robustos y la incorporación de técnicas como el razonamiento en cadena, son cruciales.

Al abordar estos retos, RLAIF puede convertirse en una herramienta robusta y fiable para entrenar sistemas avanzados de IA, garantizando que estén alineados con los valores humanos y sean capaces de mantener un alto rendimiento en diversas tareas y dominios.

Aplicaciones RLAIF

Podemos aplicar RLAIF a muchas tareas de procesamiento del lenguaje natural, entre ellas:

- Resumen de textos: RLAIF puede utilizarse para entrenar modelos que produzcan resúmenes que se ajusten a las preferencias humanas en cuanto a brevedad, relevancia y exactitud de los hechos. La retroalimentación de la IA puede ayudar al modelo a aprender a priorizar la información más importante y evitar los detalles superfluos.

- Generación de diálogo: RLAIF puede ayudar a los agentes del diálogo a aprender a responder de forma útil, inofensiva y atractiva. La retroalimentación de la IA puede reforzar las normas conversacionales y desalentar la generación de contenidos perjudiciales o inapropiados.

- Respuesta a las preguntas: La RLAIF puede utilizarse para entrenar a los sistemas de respuesta a preguntas para que proporcionen respuestas precisas y concisas, minimizando al mismo tiempo el riesgo de generar información engañosa o perjudicial. Los comentarios de la IA pueden ayudar al modelo a dar prioridad a la exactitud y relevancia de los hechos en sus respuestas.

- Generación de contenidos: RLAIF puede orientar la creación de contenidos creativos, como relatos, artículos o poemas, para que se ajusten a preferencias estilísticas específicas o a convenciones de género. La retroalimentación de la IA puede reforzar los elementos estilísticos deseados y desalentar la generación de contenidos que se desvíen del estilo pretendido.

Conclusión

En general, el documento RLAIF (Lee et al. 2023) introduce un enfoque escalable para entrenar LLMs sin depender de etiquetas de retroalimentación humana. Aprovechando una "constitución" de principios codificados en lenguaje natural y la capacidad de autocrítica de un modelo inicial útil, los autores demuestran resultados prometedores en la dirección del comportamiento del modelo lingüístico, al tiempo que mejoran la transparencia y la flexibilidad.

Una conclusión clave es que la RLAIF muestra potencial para ampliar la supervisión a medida que los modelos sean más capaces, complementando y automatizando parcialmente la supervisión humana. También mitiga problemas como la especificación errónea de la recompensa y el comportamiento evasivo observados en anteriores enfoques de retroalimentación humana. Sin embargo, mantener una sólida alineación humana, gestionar el cambio distributivo y garantizar una supervisión fiable de los sistemas avanzados de IA siguen siendo retos pendientes.

De cara al futuro, el trabajo podría explorar la integración de demostraciones de razonamiento humano de alta calidad para enfocar y mejorar aún más los modelos RLAIF. Ampliar el enfoque para dirigir el comportamiento de los LLM en otros ejes como la personalidad y el estilo de escritura es también una dirección intrigante.

Para saber más sobre el aprendizaje por refuerzo, consulta este tutorial introductorio sobre Aprendizaje por Refuerzo: Una introducción con ejemplos de Python.