Curso

El objetivo principal de esta guía es facilitar la comprensión del proceso de entrevista de AWS, ofreciendo una lista cuidadosamente seleccionada de preguntas y respuestas de entrevista. Esta gama incluye desde los principios básicos que constituyen la base del amplio ecosistema de AWS hasta preguntas detalladas basadas en escenarios que ponen a prueba tu profundo conocimiento y uso práctico de los servicios de AWS.

Tanto si estás empezando tu carrera profesional en el ámbito de los datos como si eres un profesional con experiencia, este artículo tiene como objetivo proporcionarte los conocimientos y la confianza necesarios para responder a cualquier pregunta en una entrevista de AWS. Al explorar preguntas básicas, intermedias y avanzadas de entrevistas de AWS, junto con preguntas basadas en situaciones del mundo real, esta guía tiene como objetivo cubrir todas las áreas importantes, garantizando una estrategia de preparación completa.

¿Por qué AWS?

Antes de explorar las preguntas y respuestas, es importante comprender por qué vale la pena considerar la nube de AWS como la plataforma de referencia.

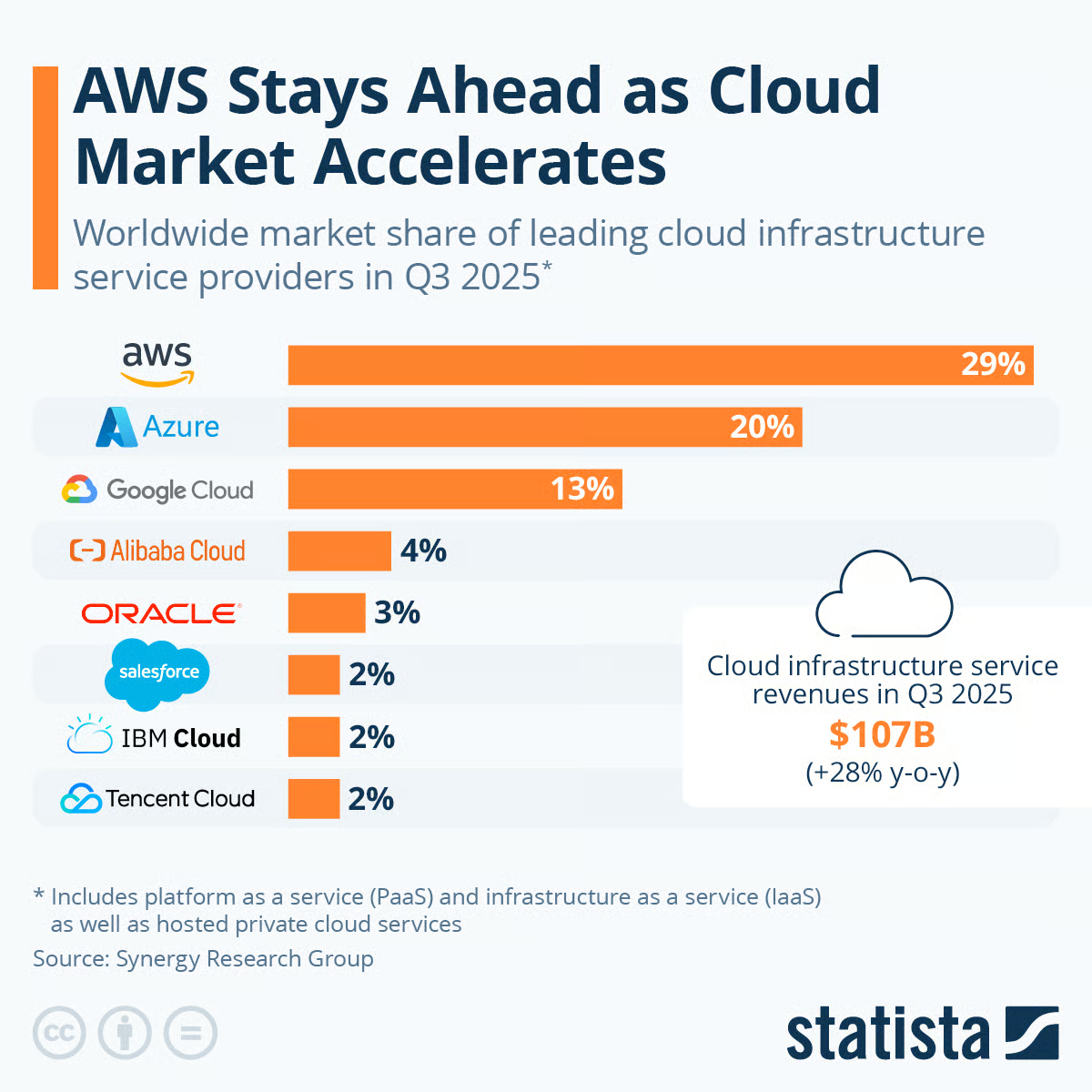

El siguiente gráfico muestra la cuota de mercado mundial de los principales proveedores de servicios de infraestructura en la nube para el tercer trimestre (3T) de 2025. A continuación se muestra un desglose de las cuotas de mercado representadas:

- Amazon Web Services (AWS) tiene la mayor cuota de mercado, con un 29 %.

- Microsoft Azure le sigue con un 20 %.

- Google Cloud tiene el 13 % del mercado de la nube.

- Alibaba Cloud tiene una cuota de 4% en la nube.

- Oracle ha crecido hasta alcanzar el 3 %.

- Salesforce, IBM Cloud y Tencent Cloud se encuentran en la parte inferior, con un 2 % cada uno.

Fuente (Statista)

El gráfico también señala que los datos incluyen la plataforma como servicio (PaaS) y la infraestructura como servicio (IaaS), así como los servicios de nube privada alojados. Además, se menciona que los ingresos por servicios de infraestructura en la nube en el tercer trimestre de 2025 ascendieron a 107 000 millones de dólares, lo que supone un aumento significativo con respecto al tercer trimestre de 2024, cuando fueron de 84 000 millones de dólares.

Amazon Web Services (AWS) sigue siendo el actor dominante en el mercado de la nube en el tercer trimestre de 2025, con una ventaja significativa sobre su competidor más cercano, Microsoft Azure.

El liderazgo de AWS en el mercado de la nube destaca su importancia para la mejora de las habilidades y ofrece importantes ventajas profesionales debido a su amplia adopción y al valor que se otorga a las habilidades de AWS en la industria tecnológica.

Nuestra hoja de referencia «Comparación de servicios de AWS, Azure y GCP para ciencia de datos e inteligencia artificial» ofrece una comparación de los principales servicios necesarios para el trabajo relacionado con los datos y la inteligencia artificial, desde la ingeniería de datos hasta el análisis de datos y la ciencia de datos, pasando por la creación de aplicaciones de datos.

Preguntas básicas para una entrevista sobre AWS

Comenzando por los conceptos fundamentales, esta sección presenta preguntas básicas de entrevistas de AWS esenciales para desarrollar una comprensión básica. Está diseñado para aquellos que son nuevos en AWS o que necesitan un repaso, preparando el terreno para una exploración más detallada más adelante.

¿Qué es la computación en la nube?

La nube proporciona acceso bajo demanda a recursos informáticos como computación, almacenamiento y bases de datos a través de Internet. Los usuarios solo pagan por lo que usan, en lugar de tener que adquirir infraestructura física.

La nube permite acceder a servicios tecnológicos de forma flexible según tus necesidades, sin necesidad de realizar grandes inversiones iniciales. Los principales proveedores, como AWS, ofrecen una amplia gama de servicios en la nube a través del modelo de consumo de pago por uso. Nuestro curso Conceptos de AWS Nube cubre muchos de estos conceptos básicos.

¿Cuál es el problema del enfoque tradicional de TI en comparación con el uso de la nube?

Múltiples industrias están abandonando la informática tradicional para adoptar infraestructuras en la nube por múltiples razones. Esto se debe a que el enfoque de la nube proporciona una mayor agilidad empresarial, una innovación más rápida, una escalabilidad flexible y un menor coste total de propiedad en comparación con la TI tradicional. A continuación se enumeran algunas de las características que los diferencian:

|

Tecnología de la información tradicional |

Computación en la nube |

|

|

¿Cuántos tipos de modelos de implementación existen en la nube?

Existen tres tipos diferentes de modelos de implementación en la nube, que se ilustran a continuación:

- Nube privada: este tipo de servicio es utilizado por una sola organización y no está expuesto al público. Está adaptado a organizaciones que utilizan aplicaciones sensibles.

- Nube pública: estos recursos en la nube son propiedad y están gestionados por servicios en la nube de terceros, como Amazon Web Services, Microsoft Azure y todos los mencionados en la sección sobre cuota de mercado de AWS.

- Nube híbrida: es la combinación de nubes privadas y públicas. Está diseñado para mantener algunos servidores en las instalaciones y ampliar el resto de capacidades a la nube. La nube híbrida ofrece la flexibilidad y la rentabilidad de la nube pública.

¿Cuáles son las cinco características de la nube?

La nube se compone de cinco características principales, que se ilustran a continuación:

- Autoservicio bajo demanda: Los usuarios pueden aprovisionar servicios en la nube según sea necesario sin necesidad de interactuar con el proveedor de servicios.

- Amplio acceso a la red: Los servicios están disponibles a través de la red y se accede a ellos mediante mecanismos estándar como teléfonos móviles, ordenadores portátiles y tabletas.

- Multitenencia y agrupación de recursos: Los recursos se agrupan para dar servicio a múltiples clientes, y los diferentes recursos virtuales y físicos se asignan dinámicamente en función de la demanda.

- Elasticidad y escalabilidad rápidas: Las capacidades se pueden aprovisionar de forma elástica y ampliar o reducir rápida y automáticamente para ajustar la capacidad a la demanda.

- Servicio medido: El uso de los recursos se supervisa, controla, notifica y factura de forma transparente en función de la utilización. El uso se puede gestionar, controlar y notificar, lo que proporciona transparencia tanto al proveedor como al consumidor.

¿Cuáles son los principales tipos de computación en la nube?

Existen tres tipos principales de nube: IaaS, PaaS y SaaS

- Infraestructura como servicio (IaaS): Proporciona los componentes básicos para la TI en la nube, como computación, almacenamiento y redes, a los que los usuarios pueden acceder bajo demanda sin necesidad de gestionar la infraestructura subyacente. Ejemplos: AWS EC2, S3, VPC.

- Plataforma como servicio (PaaS): Proporciona una plataforma o entorno gestionado para desarrollar, implementar y gestionar aplicaciones en la nube sin necesidad de crear la infraestructura subyacente. Ejemplos: AWS Elastic Beanstalk, Heroku

- Software como servicio (SaaS): Proporciona acceso a aplicaciones completas para usuarios finales que se ejecutan en la nube y que ustedes pueden utilizar a través de Internet. Los usuarios no gestionan la infraestructura ni las plataformas. Ejemplos: Servicio de correo electrónico simple de AWS, Google Docs, CRM de Salesforce.

Puedes explorar estos temas con más detalle en nuestro curso «Comprender la nube ».

¿Qué es Amazon EC2 y cuáles son sus principales usos?

Amazon EC2 (Elastic Compute Cloud) proporciona servidores virtuales escalables denominados «instancias» en la nube de AWS. Se utiliza para ejecutar una gran variedad de cargas de trabajo de forma flexible y rentable. A continuación se ilustran algunos de sus principales usos:

- Alojar sitios web y aplicaciones web.

- Ejecutar procesos de backend y trabajos por lotes.

- Implementar soluciones de nube híbrida

- Consigue una alta disponibilidad y escalabilidad.

- Reducir el tiempo de comercialización de nuevos casos de uso.

¿Qué es Amazon S3 y por qué es importante?

Amazon Simple Storage Service (S3) es un servicio de almacenamiento de objetos versátil, escalable y seguro. Sirve como base para muchas aplicaciones y cargas de trabajo basadas en la nube. A continuación se enumeran algunas características que resaltan su importancia:

- Duradero, con una durabilidad del 99,999999999 % y una disponibilidad del 99,99 %, lo que lo hace adecuado para datos críticos.

- Admite sólidas funciones de seguridad, como políticas de acceso, cifrado y puntos de conexión VPC.

- Se integra perfectamente con otros servicios de AWS como Lambda, EC2, EBS, por nombrar solo algunos.

- Tu baja latencia y alto rendimiento lo hacen ideal para el análisis de big data, aplicaciones móviles, almacenamiento y distribución de medios.

- Funciones de gestión flexibles para supervisión, registros de acceso, replicación, control de versiones y políticas de ciclo de vida.

- Respaldado por la infraestructura global de AWS para un acceso de baja latencia en todo el mundo.

Explica el concepto de «regiones» y «zonas de disponibilidad» en AWS.

- Las regiones de AWS corresponden a ubicaciones geográficas independientes donde se encuentran los recursos de AWS. Las empresas eligen regiones cercanas a sus clientes para reducir la latencia, y la replicación entre regiones proporciona una mejor recuperación ante desastres.

- Las zonas de disponibilidad constan de uno o varios centros de datos independientes con alimentación, redes y conectividad redundantes. Permiten el despliegue de recursos de una forma más tolerante a los fallos.

Nuestro curso Conceptos de AWS Nube ofrece a los lectores una guía completa para aprender sobre los principales servicios básicos de AWS, las prácticas recomendadas para diseñar aplicaciones de AWS y las ventajas de utilizar AWS para las empresas.

¿Qué es IAM y por qué es importante?

AWS Identity and Access Management (IAM) es un servicio que te ayuda a controlar de forma segura el acceso a los servicios y recursos de AWS. IAM te permite gestionar usuarios, grupos y roles con permisos muy detallados. Es importante porque ayuda a aplicar el principio del mínimo privilegio, garantizando que los usuarios solo tengan acceso a los recursos que necesitan, lo que mejora la seguridad y el cumplimiento normativo.

Nuestra guía completa sobre AWS IAM explica el servicio con todo detalle.

¿Qué es Amazon RDS y en qué se diferencia de las bases de datos tradicionales?

Amazon Relational Database Service (RDS) es un servicio de bases de datos gestionado que permite a los usuarios configurar, operar y escalar bases de datos sin tener que preocuparse por tareas de gestión de infraestructura como copias de seguridad, parches y escalado. A diferencia de las bases de datos tradicionales, Amazon RDS es escalable y ofrece una alta disponibilidad desde el primer momento, admite copias de seguridad automatizadas y permite réplicas de lectura e implementaciones multizona de disponibilidad (AZ) para la conmutación por error y la redundancia.

Aquí tienes una tabla en la que se destacan las diferencias entre RDS y las bases de datos más tradicionales, para aquellos de ustedes que sean más visuales:

| Característica | Amazon RDS | Bases de datos tradicionales |

|---|---|---|

| Escalabilidad | Se adapta fácilmente en vertical u horizontal. | Requiere actualizaciones de hardware; la ampliación puede resultar costosa. |

| Disponibilidad | Admite implementaciones Multi-AZ para alta disponibilidad. | La configuración de alta disponibilidad requiere una configuración compleja. |

| Mantenimiento | Gestionado por AWS, incluyendo copias de seguridad, actualizaciones y parches. | Gestionado manualmente, incluyendo actualizaciones y copias de seguridad periódicas. |

| Copia de seguridad y recuperación | Copias de seguridad y instantáneas automáticas | Requiere procesos de copia de seguridad manuales. |

| Coste | Precios de pago por uso | Costes fijos; se requiere una mayor inversión inicial. |

¿Qué es Amazon VPC y para qué se utiliza?

Amazon Virtual Private Cloud (VPC) te permite crear una red virtual en AWS muy similar a una red tradicional en un centro de datos local. VPC se utiliza para aislar recursos, controlar el tráfico entrante y saliente, y segmentar las cargas de trabajo en subredes con configuraciones de seguridad estrictas. Proporciona un control granular sobre rangos de IP, grupos de seguridad y listas de control de acceso a la red.

¿Qué es Amazon CloudWatch y cuáles son sus componentes principales?

Amazon CloudWatch es un servicio de supervisión y observabilidad diseñado para realizar un seguimiento de diversas métricas, configurar alarmas y responder automáticamente a los cambios en los recursos de AWS. Ayuda a mejorar la visibilidad del rendimiento de las aplicaciones, el estado del sistema y los problemas operativos, lo que lo convierte en una herramienta esencial para los usuarios de AWS. Estos son los componentes principales de CloudWatch:

- Métricas: CloudWatch recopila puntos de datos, o métricas, que proporcionan información sobre la utilización de los recursos, el rendimiento de las aplicaciones y el estado operativo. Estos datos permiten realizar análisis de tendencias y escalar de forma proactiva.

- Alarmas: Las alarmas notifican a los usuarios o activan acciones automáticas basadas en umbrales métricos específicos. Por ejemplo, si el uso de la CPU supera un umbral establecido, una alarma puede iniciar el autoescalado para gestionar el aumento de la carga.

- Registros: CloudWatch Logs proporciona almacenamiento centralizado para los registros de aplicaciones e infraestructura, lo cual es esencial para solucionar problemas e identificar incidencias. Los registros se pueden filtrar, supervisar y analizar para mantener un funcionamiento fluido.

- Eventos: CloudWatch Events (o Amazon EventBridge) detecta cambios en los recursos de AWS y puede activar acciones predefinidas, como invocar una función Lambda cuando se produce un evento específico. Esto permite una mayor automatización y una respuesta rápida ante eventos críticos.

¿Qué es AWS Lambda y cómo permite la computación sin servidor?

AWS Lambda es un servicio informático sin servidor que elimina la necesidad de gestionar servidores, lo que facilita a los programadores la ejecución de su código en la nube. Así es como funciona y por qué es un facilitador de la computación sin servidor:

- Ejecución de código bajo demanda: Lambda ejecuta código solo cuando lo activa un evento, como una solicitud HTTP o una carga de archivos en Amazon S3. Esto garantiza que solo utilices los recursos cuando sea necesario, optimizando los costes y la eficiencia.

- Escalado automático: Lambda se escala automáticamente en función del número de solicitudes entrantes. Puede gestionar desde una sola solicitud hasta miles por segundo, por lo que las aplicaciones siguen respondiendo incluso cuando el tráfico varía.

- Céntrate en el código, no en la infraestructura: Dado que Lambda abstrae la infraestructura del servidor, los programadores pueden centrarse exclusivamente en escribir e implementar código sin preocuparse por el aprovisionamiento, la gestión o el escalado de los servidores.

Gracias a estas características, Lambda encarna los principios de la computación sin servidor: elimina la carga que supone la gestión de la infraestructura y permite a los programadores crear, probar y escalar aplicaciones con mayor agilidad.

¿Qué es Elastic Load Balancing (ELB) en AWS?

Elastic Load Balancing (ELB) es un servicio que distribuye automáticamente el tráfico entrante de las aplicaciones entre varios destinos, lo que garantiza que tus aplicaciones sigan respondiendo y sean resistentes. ELB ofrece varias ventajas que lo convierten en un componente esencial de las arquitecturas AWS escalables:

- Distribución del tráfico: ELB equilibra de forma inteligente el tráfico entrante entre múltiples destinos, incluyendo instancias EC2, contenedores y direcciones IP. Esto ayuda a evitar la sobrecarga de cualquier recurso individual, lo que garantiza un rendimiento constante de la aplicación.

- Tolerancia a fallos y alta disponibilidad: ELB proporciona tolerancia a fallos mediante la distribución del tráfico entre varias zonas de disponibilidad, lo que ayuda a que tu aplicación siga estando disponible incluso si una zona experimenta problemas.

- Mayor fiabilidad y escalabilidad: ELB ajusta automáticamente la distribución del tráfico a medida que cambia la demanda, lo que facilita gestionar picos repentinos de tráfico sin afectar al rendimiento de las aplicaciones.

Conviértete en Ingeniero de Datos

Preguntas de entrevista de AWS para candidatos con experiencia y nivel intermedio

Preguntas de la entrevista sobre DevOps de AWS

Pasando a funciones especializadas, aquí se hace hincapié en cómo AWS respalda las prácticas de DevOps. Esta parte examina la automatización y optimización de los entornos AWS, y reta a las personas a demostrar sus habilidades en el aprovechamiento de AWS para la integración y entrega continuas. Si aspiramos a un puesto avanzado en AWS, consulta nuestra entrada del blog Preguntas para entrevistas de arquitecto de datos para practicar algunas preguntas sobre infraestructura y arquitectura de datos.

¿Cómo se utiliza AWS CodePipeline para automatizar un proceso de CI/CD para una aplicación de varios niveles?

CodePipeline se puede utilizar para automatizar el flujo desde el registro del código hasta la compilación, las pruebas y la implementación en múltiples entornos, con el fin de optimizar la entrega de actualizaciones y mantener al mismo tiempo unos altos estándares de calidad.

Para automatizar un proceso de CI/CD, puedes seguir los siguientes pasos:

- Crea un canal: Comienza creando un canal en AWS CodePipeline y especificando tu repositorio de código fuente (por ejemplo, GitHub o AWS CodeCommit).

- Define la etapa de compilación: Conéctate a un servicio de compilación como AWS CodeBuild para compilar tu código, ejecutar pruebas y crear artefactos implementables.

- Configura las etapas de implementación: Configura las etapas de implementación para cada nivel de tu aplicación. Utiliza AWS CodeDeploy para automatizar las implementaciones en instancias de Amazon EC2, AWS Elastic Beanstalk para aplicaciones web o AWS ECS para aplicaciones en contenedores.

- Añadir pasos de aprobación (opcional): En entornos críticos, inserta pasos de aprobación manual antes de las fases de implementación para garantizar la calidad y el control.

- Supervisar y repetir: Supervisa el rendimiento del proceso y realiza los ajustes necesarios. Utiliza los comentarios y la iteración para mejorar continuamente el proceso de implementación.

¿Qué factores clave deben tenerse en cuenta al diseñar una solución de implementación en AWS para aprovisionar, configurar, implementar, escalar y supervisar aplicaciones de forma eficaz?

Crear una implementación de AWS bien diseñada implica adaptar los servicios de AWS a las necesidades de tu aplicación, cubriendo los requisitos de computación, almacenamiento y bases de datos. Este proceso, complicado por el amplio catálogo de servicios de AWS, incluye varios pasos cruciales:

- Aprovisionamiento: Configura la infraestructura esencial de AWS, como EC2, VPC, subredes o servicios gestionados como S3, RDS y CloudFront para las aplicaciones subyacentes.

- Configuración: Ajusta tu configuración para cumplir con los requisitos específicos relacionados con el entorno, la seguridad, la disponibilidad y el rendimiento.

- Implementación: Implementa o actualiza de forma eficiente los componentes de la aplicación, garantizando transiciones fluidas entre versiones.

- Escalado: Modifica dinámicamente la asignación de recursos según criterios predefinidos para gestionar los cambios de carga.

- Supervisión: Realiza un seguimiento del uso de los recursos, los resultados de la implementación, el estado de las aplicaciones y los registros para garantizar que todo funcione según lo previsto.

¿Qué es la infraestructura como código? Describe con tus propias palabras

La infraestructura como código (IaC) es un método para gestionar y aprovisionar centros de datos informáticos mediante archivos de definición legibles por máquina, en lugar de mediante la configuración física del hardware o herramientas de configuración interactivas.

Básicamente, permite a los programadores y a los equipos de operaciones de TI gestionar, supervisar y aprovisionar recursos automáticamente mediante código, en lugar de tener que configurar y ajustar el hardware manualmente.

Además, IaC permite implementar entornos coherentes de forma rápida y escalable mediante la codificación de la infraestructura, lo que reduce los errores humanos y aumenta la eficiencia.

¿Cuál es tu enfoque para gestionar la integración y el despliegue continuos en AWS DevOps?

En AWS DevOps, la integración y el despliegue continuos se pueden gestionar utilizando las herramientas para programadores de AWS. Empieza por almacenar y versionar el código fuente de tu aplicación con estas herramientas.

A continuación, aprovecha servicios como AWS CodePipeline para coordinar los procesos de compilación, prueba e implementación. CodePipeline sirve como columna vertebral, integrándose con AWS CodeBuild para compilar y probar código, y con AWS CodeDeploy para automatizar la implementación en diversos entornos. Este enfoque optimizado garantiza flujos de trabajo eficientes y automatizados para una integración y entrega continuas.

¿Cómo beneficia Amazon ECS a AWS DevOps?

Amazon ECS es un servicio de gestión de contenedores escalable que simplifica la ejecución de contenedores Docker en instancias EC2 a través de un clúster gestionado, lo que mejora la implementación y el funcionamiento de las aplicaciones.

¿Cuáles son algunas estrategias para implementaciones azul/verde en AWS?

Las implementaciones azul/verde minimizan el tiempo de inactividad y el riesgo al ejecutar dos entornos: uno (azul) con la versión actual y otro (verde) con la nueva versión. En AWS, esto se puede lograr utilizando servicios como Elastic Beanstalk, AWS CodeDeploy o ECS. Puedes cambiar el tráfico entre entornos utilizando Route 53 o un equilibrador de carga de aplicaciones, probar el entorno verde de forma segura y revertir los cambios al instante si es necesario.

¿Por qué se podría preferir ECS a Kubernetes?

ECS ofrece mayor flexibilidad, escalabilidad y simplicidad en la implementación en comparación con Kubernetes, lo que lo convierte en la opción preferida para algunas implementaciones.

¿Cómo gestionarías y protegerías los secretos de un canal de CI/CD en AWS?

Para gestionar de forma segura los secretos en un canal de CI/CD de AWS, puedes utilizar AWS Secrets Manager o AWS Systems Manager Parameter Store para almacenar información confidencial, como claves API, contraseñas de bases de datos y certificados. Ambos servicios se integran con servicios de AWS como CodePipeline y CodeBuild, lo que permite un acceso seguro a los secretos sin necesidad de codificarlos en tu código base.

Al controlar los permisos de acceso con IAM, puedes garantizar que solo las entidades autorizadas puedan acceder a los datos confidenciales, lo que mejora la seguridad dentro del proceso de CI/CD.

¿Cómo se utiliza AWS Systems Manager en un entorno de producción?

AWS Systems Manager ayuda a automatizar y gestionar tu infraestructura a gran escala. En un entorno de producción, se utiliza habitualmente para la gestión de parches, la ejecución remota de comandos, la recopilación de inventario y el almacenamiento seguro de parámetros de configuración y secretos. Se integra con EC2, RDS y otros servicios de AWS, lo que permite una visibilidad centralizada y un control operativo.

¿Qué es AWS CloudFormation y cómo facilita las prácticas de DevOps?

AWS CloudFormation automatiza el aprovisionamiento y la gestión de la infraestructura de AWS mediante código, lo que permite la infraestructura como código (IaC). Este servicio te permite definir tu infraestructura como plantillas, lo que facilita la creación de versiones, las pruebas y la replicación de entornos en las fases de desarrollo, prueba y producción.

En un entorno DevOps, CloudFormation ayuda a mantener la coherencia, reduce los errores de configuración manual y admite implementaciones automatizadas, lo que lo convierte en una parte integral de la entrega continua y la replicación del entorno.

Para cerrar el conjunto de preguntas sobre DevOps, aquí tienes una tabla que resume los diferentes servicios de AWS utilizados en esta área, así como sus casos de uso:

| Servicio | Objetivo | Casos de uso en DevOps |

|---|---|---|

| AWS CodePipeline | Automatiza los flujos de trabajo de CI/CD en múltiples entornos. | Integración y despliegue continuos para actualizaciones optimizadas. |

| AWS CodeBuild | Compila código, ejecuta pruebas y produce artefactos implementables. | Automatización de la compilación, pruebas y generación de artefactos. |

| AWS CodeDeploy | Gestiona las implementaciones de aplicaciones en diversos entornos de AWS (por ejemplo, EC2, Lambda). | Implementaciones automatizadas en todos los entornos con capacidades de reversión. |

| Amazon ECS | Gestión de contenedores para implementar contenedores Docker | Ejecución de microservicios, simplificación de la implementación y gestión de aplicaciones |

| Administrador de secretos de AWS | Almacena y gestiona información confidencial de forma segura. | Almacenamiento seguro de claves API, contraseñas y otros datos confidenciales. |

| AWS CloudFormation | Automatiza la configuración de la infraestructura mediante código (IaC). | Coherencia de la infraestructura, replicación del entorno, mejores prácticas de IaC. |

Preguntas para la entrevista de arquitecto de soluciones de AWS

Para los arquitectos de soluciones, el objetivo es diseñar soluciones AWS que cumplan requisitos específicos. Este segmento evalúa la capacidad para crear sistemas escalables, eficientes y rentables utilizando AWS, destacando las mejores prácticas arquitectónicas.

¿Cuál es la función de un arquitecto de soluciones de AWS?

Los arquitectos de soluciones de AWS diseñan y supervisan aplicaciones en AWS, garantizando la escalabilidad y un rendimiento óptimo. Guiamos a programadores, administradores de sistemas y clientes en el uso eficaz de AWS para sus necesidades empresariales y comunicamos conceptos complejos tanto a partes interesadas con conocimientos técnicos como sin ellos.

¿Cuáles son las prácticas recomendadas clave en materia de seguridad para AWS EC2?

Las prácticas de seguridad esenciales de EC2 incluyen el uso de IAM para la gestión del acceso, la restricción del acceso a hosts de confianza, la minimización de los permisos, la desactivación de los inicios de sesión basados en contraseñas para las AMI y la implementación de la autenticación multifactorial para mejorar la seguridad.

¿Cómo se garantiza la redundancia multirregional en una arquitectura AWS?

Para diseñar una redundancia multirregional, implementa recursos críticos como instancias EC2, bases de datos RDS y buckets S3 en varias regiones de AWS. Utiliza Route 53 para el enrutamiento DNS basado en la ubicación geográfica y la replicación entre regiones de S3 para la copia de seguridad de datos. Utiliza configuraciones activas-activas o activas-pasivas en función de tu estrategia de conmutación por error y supervisa el rendimiento y la replicación con CloudWatch y AWS Global Accelerator.

¿Cuáles son las estrategias para crear una arquitectura AWS altamente disponible y tolerante a fallos para aplicaciones web críticas?

La creación de una arquitectura de alta disponibilidad y tolerante a fallos en AWS implica varias estrategias para reducir el impacto de los fallos y garantizar un funcionamiento continuo. Los principios fundamentales incluyen:

- Implementación de redundancia en todos los componentes del sistema para eliminar puntos únicos de fallo.

- Uso del equilibrio de carga para distribuir el tráfico de manera uniforme y garantizar un rendimiento óptimo.

- Configuración de la supervisión automatizada para la detección y respuesta de fallos en tiempo real. Los sistemas deben diseñarse para que sean escalables y puedan manejar cargas variables, con una arquitectura distribuida que mejore la tolerancia a fallos.

- El uso de aislamiento de fallos, copias de seguridad periódicas y planes de recuperación ante desastres es esencial para la protección de datos y la recuperación rápida.

- El diseño para una degradación elegante mantiene la funcionalidad durante las interrupciones del servicio, mientras que las prácticas continuas de pruebas e implementación mejoran la fiabilidad del sistema.

Explica cómo elegirías entre Amazon RDS, Amazon DynamoDB y Amazon Redshift para una aplicación basada en datos.

La elección entre Amazon RDS, DynamoDB y Redshift para una aplicación basada en datos depende de tus necesidades específicas:

- Amazon RDS es ideal para aplicaciones que requieren una base de datos relacional tradicional con compatibilidad con SQL estándar, transacciones y consultas complejas.

- Amazon DynamoDB es ideal para aplicaciones que necesitan una base de datos nosql altamente escalable con un rendimiento rápido y predecible a cualquier escala. Es ideal para modelos de datos flexibles y desarrollo rápido.

- Amazon Redshift es ideal para aplicaciones analíticas que requieren consultas complejas en grandes conjuntos de datos, ya que ofrece un rendimiento rápido de las consultas mediante el uso de almacenamiento en columnas y tecnología de almacenamiento de datos.

¿Qué aspectos tendrías en cuenta a la hora de migrar una aplicación local existente a AWS? Utiliza un ejemplo de tu elección.

Al trasladar el software de gestión de relaciones con los clientes (CRM) de una empresa desde una configuración de servidor interno a Amazon Web Services (AWS), es fundamental seguir un marco estratégico similar al que sugiere AWS, adaptado a este escenario específico:

- Preparación inicial y formulación de estrategias

- Evalúa la configuración actual del CRM para identificar limitaciones y áreas de mejora.

- Establece objetivos claros para la migración, como lograr una mejor escalabilidad, mejorar las funciones de análisis de datos o reducir los costes de mantenimiento.

- Identifica las soluciones de AWS necesarias, como el uso de Amazon EC2 para los recursos informáticos y Amazon RDS para la gestión de la base de datos.

- Evaluación y planificación estratégica

- Catalogar los componentes CRM para priorizar qué partes migrar primero.

- Selecciona las técnicas de migración adecuadas, por ejemplo, trasladar la base de datos CRM con AWS Database Migration Service (DMS).

- Planifica una conexión de red estable durante la migración, posiblemente utilizando AWS Direct Connect.

- Ejecución y validación

- Elabora una estrategia de migración detallada, comenzando con los módulos CRM menos críticos como prueba.

- Obtener la aprobación de las partes interesadas clave antes de migrar las principales funciones de CRM, utilizando los servicios de AWS.

- Prueba el rendimiento y la seguridad del CRM migrado en AWS, realizando los ajustes necesarios.

- Transición al funcionamiento en la nube

- Cambiar a la gestión completa de la aplicación CRM en el entorno AWS, eliminando gradualmente los antiguos componentes locales.

- Utiliza el conjunto de herramientas de supervisión y gestión de AWS para llevar a cabo una supervisión y un perfeccionamiento continuos.

- Aplica los conocimientos adquiridos con esta migración para informar futuras transiciones, teniendo en cuenta una adopción más amplia de la nube en otras aplicaciones.

Este enfoque garantiza que la migración del CRM a AWS esté alineada con los objetivos estratégicos del negocio, maximizando los beneficios de la nube en términos de escalabilidad, eficiencia y ahorro de costes.

Describe cómo utilizarías los servicios de AWS para implementar una arquitectura de microservicios.

La implementación de una arquitectura de microservicios implica dividir una aplicación de software en pequeños servicios independientes que se comunican a través de API. Aquí tienes una guía concisa para configurar microservicios:

- Adopta el desarrollo ágil: Utiliza metodologías ágiles para facilitar el rápido desarrollo y la implementación de microservicios individuales.

- Adopta el diseño API-First: Desarrolla primero las API para la interacción de los microservicios con el fin de garantizar una comunicación clara y coherente entre los servicios.

- Aprovecha las prácticas de CI/CD: Implementa la integración continua y la entrega continua (CI/CD) para automatizar las pruebas y la implementación, mejorando la velocidad y la fiabilidad del desarrollo.

- Incorporar los principios de las aplicaciones de doce factores: Aplica estos principios para crear servicios escalables y fáciles de mantener que se puedan implementar fácilmente en nubes como AWS.

- Elige el patrón de arquitectura adecuado: Considera patrones basados en API, eventos o streaming de datos según las necesidades de tu aplicación para optimizar la comunicación y el flujo de datos entre servicios.

- Aprovecha AWS para la implementación: Utiliza servicios de AWS como tecnologías de contenedores para microservicios escalables o computación sin servidor para reducir la complejidad operativa y centrarte en crear lógica de aplicaciones.

- Implementar los principios sin servidor: Cuando sea apropiado, utiliza arquitecturas sin servidor para eliminar la gestión de la infraestructura, escalar automáticamente y pagar solo por lo que usas, mejorando la eficiencia del sistema y la rentabilidad.

- Garantizar la resiliencia del sistema: Diseña microservicios para garantizar la tolerancia a fallos y la resiliencia, utilizando las funciones de disponibilidad integradas de AWS para mantener la continuidad del servicio.

- Céntrate en los aspectos transversales: Aborda la supervisión distribuida, el registro, el seguimiento y la coherencia de los datos para mantener el buen estado y el rendimiento del sistema.

- Revisión con el marco AWS Well-Architected Framework: Utiliza la herramienta AWS Well-Architected Tool para evaluar tu arquitectura según las prácticas recomendadas de AWS, lo que garantiza la fiabilidad, la seguridad, la eficiencia y la rentabilidad.

Al considerar cuidadosamente estos puntos, los equipos pueden implementar de manera eficaz una arquitectura de microservicios que sea escalable, flexible y adecuada para sus necesidades específicas de aplicación, al tiempo que aprovechan las amplias capacidades de la nube de AWS.

¿Cuál es la relación entre AWS Glue y AWS Lake Formation?

AWS Lake Formation se basa en la infraestructura de AWS Glue e incorpora sus capacidades ETL, consola de control, catálogo de datos y arquitectura sin servidor. Mientras que AWS Glue se centra en los procesos ETL, Lake Formation añade funciones para crear, proteger y gestionar lagos de datos, mejorando así las funciones de Glue.

Para las preguntas de la entrevista sobre AWS Glue, es importante comprender cómo Glue es compatible con Lake Formation. Los candidatos deben estar preparados para hablar sobre el papel de Glue en la gestión de lagos de datos dentro de AWS, demostrando su comprensión de la integración y las funcionalidades de ambos servicios en el ecosistema de AWS. Esto demuestra un profundo conocimiento de cómo estos servicios colaboran para procesar y gestionar datos de manera eficiente.

¿Cómo optimizas los costes de AWS para una aplicación web con mucho tráfico?

Para optimizar los costes de AWS para una aplicación con mucho tráfico, puedes empezar utilizando AWS Cost Explorer y AWS Budgets para supervisar y gestionar el gasto. Entonces, ten en cuenta estas estrategias:

- Utiliza instancias reservadas e instancias spot para cargas de trabajo predecibles y flexibles, respectivamente.

- El autoescalado ayuda a ajustar la asignación de recursos en función de la demanda, lo que reduce los costes durante los periodos de poco tráfico.

- Optimiza el almacenamiento con las políticas de ciclo de vida de Amazon S3 y S3 Intelligent-Tiering para trasladar los datos a los que se accede con poca frecuencia a clases de almacenamiento rentables.

- Implementa el almacenamiento en caché con Amazon CloudFront y Amazon ElastiCache para reducir las solicitudes repetidas a los recursos backend, lo que te permitirá ahorrar ancho de banda y costes de computación.

Este enfoque garantiza que la aplicación sea rentable sin comprometer el rendimiento ni la disponibilidad.

¿Cuáles son los pilares fundamentales del marco de arquitectura bien diseñada de AWS?

El marco AWS Well-Architected Framework proporciona un enfoque estructurado para diseñar arquitecturas AWS seguras, eficientes y resilientes. Se compone de cinco pilares principales:

- Excelencia operativa: Se centra en respaldar el desarrollo y las operaciones mediante la supervisión, la respuesta ante incidentes y la automatización.

- Seguridad: Abarca la protección de datos, sistemas y activos mediante la gestión de identidades, el cifrado y la respuesta ante incidentes.

- Fiabilidad: Implica crear sistemas que puedan recuperarse de fallos, escalar recursos de forma dinámica y gestionar problemas de red.

- Eficiencia del rendimiento: Fomenta el uso de recursos escalables y cargas de trabajo optimizadas.

- Optimización de costes: Se centra en la gestión de costes mediante la selección de los recursos adecuados y el uso de modelos de precios como las instancias reservadas.

Comprender estos pilares permite a los arquitectos de AWS crear soluciones bien equilibradas que se ajustan a las prácticas recomendadas en materia de seguridad, rendimiento, fiabilidad y gestión de costes.

Preguntas y respuestas avanzadas para entrevistas sobre AWS

Preguntas de la entrevista para ingeniero de datos de AWS

Dirigida a los ingenieros de datos, esta sección profundiza en los servicios de AWS para el manejo de datos, incluyendo el almacenamiento y el procesamiento en tiempo real. Analiza los conocimientos técnicos necesarios para crear canalizaciones de datos escalables con AWS.

Describe la diferencia entre Amazon Redshift, RDS y S3, y cuándo se debe utilizar cada uno.

- Amazon S3 es un servicio de almacenamiento de objetos que proporciona almacenamiento escalable y duradero para cualquier cantidad de datos. Se puede utilizar para almacenar datos sin procesar y sin estructurar, como archivos de registro, CSV, imágenes, etc.

- Amazon Redshift es un almacén de datos en la nube optimizado para análisis e inteligencia empresarial. Se integra con S3 y puede cargar datos almacenados allí para realizar consultas complejas y generar informes.

- Amazon RDS proporciona bases de datos relacionales gestionadas como PostgreSQL, MySQL, etc. Puede alimentar aplicaciones transaccionales que necesitan bases de datos compatibles con ACID con características como indexación, restricciones, etc.

Describe una situación en la que utilizarías Amazon Kinesis en lugar de AWS Lambda para el procesamiento de datos. ¿Cuáles son las consideraciones clave?

Kinesis se puede utilizar para gestionar grandes cantidades de datos en streaming y permite leer y procesar los flujos con aplicaciones de consumo.

A continuación se ilustran algunas de las consideraciones clave:

- Volumen de datos: Kinesis puede manejar hasta megabytes por segundo de datos, frente al límite de Lambda de 6 MB por invocación, lo que resulta útil para flujos de alto rendimiento.

- Procesamiento de streaming: Los consumidores de Kinesis pueden procesar datos continuamente en tiempo real a medida que llegan, a diferencia de las invocaciones por lotes de Lambda, lo que contribuye a un procesamiento de baja latencia.

- Capacidad de reproducción: Las secuencias de Kinesis conservan los datos durante un período configurado, lo que permite reproducirlos y volver a procesarlos si es necesario, mientras que Lambda no es adecuado para la reproducción.

- Pedidos: Los fragmentos de Kinesis permiten el procesamiento ordenado de registros relacionados. Por otro lado, Lambda puede procesar fuera de orden.

- Escalabilidad y paralelismo: Los fragmentos de Kinesis pueden escalarse para gestionar la carga. Lambda puede necesitar orquestación.

- Integración: Kinesis se integra perfectamente con otros servicios de AWS, como Firehose, Redshift y EMR para análisis.

Además, para casos de procesamiento de flujos de gran volumen, continuos, ordenados y reproducibles, como el análisis en tiempo real, Kinesis ofrece compatibilidad nativa con el streaming, en comparación con el enfoque por lotes de Lambda.

Para obtener más información sobre la transmisión de datos, nuestro curso Transmisión de datos con AWS Kinesis y Lambda ayuda a los usuarios a aprender a aprovechar estas tecnologías para recopilar datos de millones de fuentes y analizarlos en tiempo real. Esto puede ayudar a prepararse mejor para las preguntas de la entrevista de AWS Lambda.

¿Cuáles son las diferencias clave entre el procesamiento de datos por lotes y en tiempo real? ¿Cuándo elegirías un enfoque en lugar de otro para un proyecto de ingeniería de datos?

El procesamiento por lotes consiste en recopilar datos durante un periodo de tiempo y procesarlos en grandes bloques o lotes. Esto funciona bien para analizar datos históricos menos frecuentes.

El procesamiento de streaming en tiempo real analiza los datos de forma continua a medida que llegan en pequeños incrementos. Permite analizar datos recientes y actualizados con frecuencia.

Para un proyecto de ingeniería de datos, se puede optar por la transmisión en tiempo real cuando:

- Necesitas información inmediata y no puedes esperar a que se ejecute un proceso por lotes. Por ejemplo, la detección de fraudes.

- Los datos cambian constantemente y el análisis debe mantenerse al día, al igual que la monitorización de las redes sociales.

- Se requiere una baja latencia, como en los sistemas de negociación automatizados.

El procesamiento por lotes puede ser más adecuado cuando:

- Los datos históricos requieren modelos o análisis complejos, como la previsión de la demanda.

- Los datos proceden de diversas fuentes que solo proporcionan volcados periódicos.

- Los menores costes de procesamiento son más importantes que la velocidad de procesamiento.

Por lo tanto, el tiempo real es ideal para datos que evolucionan rápidamente y requieren un análisis continuo, mientras que el procesamiento por lotes es adecuado para datos disponibles periódicamente que requieren modelos históricos.

¿Cómo se puede automatizar la evolución del esquema en una canalización de datos en AWS?

La evolución del esquema se puede gestionar utilizando las funciones de inferencia dinámica de marcos y esquemas de AWS Glue. En combinación con Glue Data Catalog, puedes realizar un seguimiento automático de los cambios en los esquemas. Para evitar interrumpir los procesos posteriores, implementa pasos de validación de esquemas con herramientas como AWS Deequ o integra lógica personalizada en tus scripts ETL para registrar y resolver discrepancias.

¿Cómo gestionas el esquema en lectura frente al esquema en escritura en los lagos de datos de AWS?

El esquema en lectura se utiliza habitualmente en lagos de datos donde se almacenan datos sin procesar y semiestructurados (por ejemplo, en S3), y el esquema solo se aplica durante el tiempo de consulta utilizando herramientas como Athena o Redshift Spectrum. Este enfoque ofrece flexibilidad para diversas fuentes de datos. El esquema en escritura, que se utiliza a menudo en RDS o Redshift, impone la estructura por adelantado y es preferible para conjuntos de datos transaccionales o estructurados que requieren una validación estricta de los datos.

¿Qué es un almacén de datos operativos y cómo complementa a un almacén de datos?

Un almacén de datos operativos (ODS) es una base de datos diseñada para respaldar las operaciones y los análisis empresariales en tiempo real. Actúa como plataforma provisional entre los sistemas transaccionales y el almacén de datos.

Mientras que un almacén de datos contiene datos de alta calidad optimizados para la inteligencia empresarial y la generación de informes, un ODS contiene datos actualizados, orientados a temas específicos e integrados procedentes de múltiples fuentes.

A continuación se enumeran las características principales de un ODS:

- Proporciona datos en tiempo real para la supervisión de operaciones y la toma de decisiones.

- Integra datos en tiempo real procedentes de múltiples fuentes.

- Está optimizado para consultas y análisis rápidos frente al almacenamiento a largo plazo.

- ODS contiene datos granulares y atómicos frente a datos agregados en el almacén.

Un ODS y un almacén de datos son sistemas complementarios. ODS admite operaciones en tiempo real utilizando datos actuales, mientras que el almacén de datos permite la elaboración de informes y análisis estratégicos aprovechando los datos históricos integrados. Cuando se combinan, proporcionan una plataforma integral para las necesidades operativas y analíticas.

¿Cómo configurarías un lago de datos en AWS y qué servicios utilizarías?

Para crear un lago de datos en AWS, el servicio básico con el que hay que empezar es Amazon S3, que permite almacenar datos sin procesar, estructurados y no estructurados de forma escalable y duradera. A continuación, te ofrecemos un enfoque paso a paso y los servicios adicionales que se incluyen:

- Capa de almacenamiento: Utiliza Amazon S3 para almacenar grandes volúmenes de datos. Organiza los datos con una jerarquía de carpetas estructurada basada en el tipo de datos, la fuente o la actualidad.

- Catalogación de datos: Utiliza AWS Glue para crear un catálogo de datos, lo que facilita la búsqueda y consulta de datos almacenados en S3 mediante la creación de definiciones de metadatos.

- Transformación de datos y ETL: Utiliza AWS Glue ETL para preparar y transformar datos sin procesar en un formato listo para su análisis.

- Seguridad y control de acceso: Implementa AWS IAM y AWS Lake Formation para gestionar el acceso, los permisos y el cifrado de datos.

- Análisis y consultas: Utiliza Amazon Athena para consultas ad hoc, Amazon Redshift Spectrum para análisis y Amazon QuickSight para visualización.

Esta configuración proporciona una arquitectura de lago de datos flexible y escalable que puede manejar grandes volúmenes de datos para análisis estructurados y no estructurados.

Explica las diferentes clases de almacenamiento en Amazon S3 y cuándo utilizar cada una de ellas.

Amazon S3 ofrece varias clases de almacenamiento, cada una optimizada para casos de uso y requisitos de coste específicos. La siguiente tabla los resume:

| Clase de almacenamiento | Caso de uso | Frecuencia de acceso | Rentabilidad |

|---|---|---|---|

| S3 Estándar | Datos a los que se accede con frecuencia | Alto | Precios estándar |

| S3 Intelligent-Tiering | Patrones de acceso impredecibles | Ajustado automáticamente | Rentable con niveles automatizados |

| S3 Estándar-IA | De acceso poco frecuente, pero rápidamente recuperable. | Bajo | Menor costo, rápida recuperación |

| S3 Una zona-IA | Acceso poco frecuente en una sola zona de disponibilidad (AZ) | Bajo | Menor costo, menos redundancia |

| S3 Glacier | Archivo a largo plazo con acceso poco frecuente | Raro | Bajo costo, recuperación en minutos u horas. |

| Archivo profundo S3 Glacier | Archivo normativo o de cumplimiento | Muy raro | Coste mínimo, recuperación en 12-48 horas. |

Comprender las clases de almacenamiento de S3 ayuda a optimizar los costes de almacenamiento y los tiempos de acceso en función de las necesidades específicas de datos.

Preguntas basadas en escenarios de AWS

Centradas en la aplicación práctica, estas preguntas evalúan la capacidad para resolver problemas en situaciones reales, lo que exige un conocimiento exhaustivo de cómo utilizar los servicios de AWS para abordar retos complejos.

La siguiente tabla resume los escenarios que suelen plantearse durante las entrevistas de AWS, junto con su descripción y posibles soluciones:

|

Tipo de caso |

Descripción |

Solución |

|

Migración de aplicaciones |

Una empresa tiene previsto migrar su aplicación heredada a AWS. La aplicación consume muchos datos y requiere un acceso de baja latencia para los usuarios de todo el mundo. ¿Qué servicios y arquitectura de AWS recomendarías para garantizar una alta disponibilidad y una baja latencia? |

|

|

Recuperación ante desastres |

Tu organización quiere implementar un plan de recuperación ante desastres para tus cargas de trabajo críticas de AWS con un RPO (objetivo de punto de recuperación) de 5 minutos y un RTO (objetivo de tiempo de recuperación) de 1 hora. Describe los servicios de AWS que utilizarías para alcanzar estos objetivos. |

|

|

Protección contra ataques DDoS |

Imagina un escenario en el que necesitas diseñar una infraestructura de aplicaciones web escalable y segura en AWS. La aplicación debe gestionar picos repentinos de tráfico y proteger contra ataques DDoS. ¿Qué servicios y funciones de AWS utilizarías en tu diseño? |

|

|

Análisis de datos en tiempo real |

Una startup dedicada al Internet de las cosas (IoT) quiere procesar y analizar datos en tiempo real procedentes de miles de sensores repartidos por todo el mundo. La solución debe ser altamente escalable y rentable. ¿Qué servicios de AWS utilizarías para crear esta plataforma y cómo te asegurarías de que se adapta a la demanda? |

|

|

Análisis de datos de gran volumen |

Una empresa de servicios financieros necesita una solución de análisis de datos en AWS para procesar y analizar grandes volúmenes de datos de transacciones en tiempo real. La solución también debe cumplir con estrictas normas de seguridad y cumplimiento. ¿Cómo diseñarías esta solución utilizando AWS y qué medidas implementarías para garantizar la seguridad y el cumplimiento normativo? |

|

Preguntas no técnicas para entrevistas sobre AWS

Además de los conocimientos técnicos, comprender el impacto general de las soluciones de AWS es fundamental para superar con éxito la entrevista. A continuación, se incluyen algunas preguntas, junto con sus respuestas. Estas respuestas pueden variar de un candidato a otro, dependiendo de tu experiencia y trayectoria.

¿Cómo te mantienes al día de las últimas tendencias en AWS y tecnología en la nube?

- Se espera del candidato: El entrevistador quiere saber cuál es tu compromiso con el aprendizaje continuo y cómo mantienes tus habilidades al día. Buscan recursos o prácticas específicos que utilizan para mantenerse informados.

- Ejemplo de respuesta: Me mantengo al día leyendo los blogs oficiales de AWS y participando en foros comunitarios como el subreddit de AWS. También asisto a reuniones y seminarios web de grupos de usuarios locales de AWS. Estas actividades me ayudan a mantenerme informado sobre las últimas funciones y prácticas recomendadas de AWS.

Describe una ocasión en la que tuviste que explicar un concepto complejo de AWS a alguien sin conocimientos técnicos. ¿Cómo lo hiciste?

- Se espera del candidato: Esta pregunta evalúa tus habilidades comunicativas y tu capacidad para simplificar información compleja. El entrevistador busca pruebas de tu capacidad para enseñar y tu paciencia.

- Ejemplo de respuesta: En mi puesto anterior, tenía que explicar las ventajas del almacenamiento en la nube a nuestros accionistas sin conocimientos técnicos. Utilicé la analogía de almacenar archivos en una unidad de nube frente a un disco duro físico, destacando la facilidad de acceso y la seguridad. Esto les ayudó a comprender el concepto sin entrar en detalles técnicos.

¿Qué te motiva a trabajar en el sector de la nube, concretamente con AWS?

- Se espera del candidato: El entrevistador quiere evaluar tu pasión por el campo y comprender qué te motiva. Buscan motivaciones genuinas que estén en consonancia con el puesto y los valores de la empresa.

- Ejemplo de respuesta: Lo que me entusiasma de la nube, especialmente de AWS, es su poder transformador para ampliar negocios e impulsar la innovación. La constante evolución de los servicios de AWS me motiva a resolver nuevos retos y contribuir a proyectos de gran impacto».

¿Puedes describir un proyecto desafiante que hayas gestionado y cómo te aseguraste de que fuera un éxito?

- Se espera del candidato: Aquí, la atención se centra en tus habilidades de gestión de proyectos y resolución de problemas. El entrevistador está interesado en tu enfoque para superar obstáculos y llevar a cabo proyectos hasta su finalización.

- Ejemplo de respuesta: En un proyecto anterior, sufrimos retrasos importantes debido a la escasez de recursos. Prioricé las tareas en función de su impacto, negocié recursos adicionales y mantuve una comunicación clara con el equipo y las partes interesadas. Este enfoque nos ayudó a cumplir los hitos del proyecto y, en última instancia, a entregarlo a tiempo.

¿Cómo gestionas los plazos ajustados cuando varios proyectos requieren tu atención?

- Se espera del candidato: Esta pregunta evalúa tus habilidades para gestionar el tiempo y establecer prioridades. El entrevistador quiere saber cómo gestionas el estrés y la carga de trabajo de manera eficaz.

- Ejemplo de respuesta: Utilizo una combinación de priorización y delegación. Evalúo la urgencia y el impacto de cada proyecto, establezco prioridades en consecuencia y delego tareas cuando es necesario. También me comunico regularmente con las partes interesadas sobre los avances y cualquier ajuste necesario para cumplir con los plazos.

¿Qué crees que diferencia a AWS de otros proveedores de servicios de nube?

- Se espera del candidato: El entrevistador quiere saber qué entiendes por la propuesta de valor única de AWS. El objetivo es comprobar que comprendes bien qué es lo que convierte a AWS en líder del sector de la nube.

- Ejemplo de respuesta: AWS se distingue por su amplia infraestructura global, que ofrece una escalabilidad y fiabilidad sin igual. Además, el compromiso de AWS con la innovación, con una amplia y profunda gama de servicios, permite soluciones en la nube más flexibles y personalizadas en comparación con sus competidores.

¿Cómo abordas el aprendizaje de nuevas herramientas o servicios de AWS cuando se introducen?

- Se espera del candidato: Esta pregunta evalúa tu capacidad de adaptación y tu estilo de aprendizaje. El entrevistador quiere comprobar que tienes un enfoque proactivo para dominar las nuevas tecnologías, algo esencial en el campo de la nube, que evoluciona rápidamente.

- Ejemplo de respuesta: Cuando AWS presenta un nuevo servicio, empiezo por revisar la documentación oficial y las notas de la versión para comprender su finalidad y funcionalidad. A continuación, exploro tutoriales prácticos y experimento en un entorno de pruebas para adquirir experiencia práctica. Si es posible, hablo del servicio con tus compañeros o participo en foros para ver cómo lo están aprovechando otros. Esta combinación de teoría y práctica me ayuda a familiarizarme rápidamente con las nuevas herramientas.

Describe cómo equilibras la seguridad y la eficiencia al diseñar soluciones AWS.

- Se espera del candidato: El entrevistador está evaluando tu capacidad para pensar estratégicamente sobre la seguridad, al tiempo que tiene en cuenta el rendimiento. El objetivo es lograr que puedas equilibrar las mejores prácticas en materia de seguridad con la necesidad de eficiencia operativa.

- Ejemplo de respuesta: Creo que la seguridad y la eficiencia van de la mano. Al diseñar soluciones AWS, empiezo por dar prioridad a la seguridad mediante la implementación de políticas IAM, el aislamiento de redes con VPC y el cifrado de datos. Para garantizar la eficiencia, me aseguro de que estas prácticas de seguridad no introduzcan una latencia innecesaria optimizando las configuraciones y eligiendo servicios escalables como AWS Lambda para tareas que requieren un uso intensivo de recursos informáticos. Mi enfoque consiste en crear arquitecturas seguras que también sean receptivas y rentables.

Conclusión

Este artículo ofrece una guía completa con preguntas frecuentes en entrevistas de AWS para candidatos con distintos niveles de experiencia, desde aquellos que recién comienzan a explorar el mundo de AWS hasta profesionales con amplia experiencia que buscan avanzar en sus carreras.

Tanto si te estás preparando para tu primera entrevista en AWS como si tu objetivo es conseguir un puesto más avanzado, esta guía te resultará un recurso muy valioso. Te prepara no solo para responder a las preguntas de la entrevista, sino también para familiarizarte en profundidad con la plataforma AWS, mejorando tu comprensión y aplicación de sus amplias capacidades.

Certifícate en el puesto de Ingeniero de Datos de tus sueños

Nuestros programas de certificación te ayudan a destacar y a demostrar que tus aptitudes están preparadas para el trabajo a posibles empleadores.

Preguntas frecuentes

¿Necesito una certificación de AWS para conseguir un trabajo relacionado con la nube?

Aunque no son obligatorias, las certificaciones de AWS, como AWS Certified Solutions Architect Associate o AWS Certified Developer Associate, validan tu experiencia y mejoran tu currículum. Muchos empleadores valoran las certificaciones como prueba de tus habilidades, pero la experiencia práctica es igualmente importante.

¿Cuáles son los servicios de AWS más importantes en los que debes centrarte para las entrevistas?

Los servicios clave de AWS dependen del puesto que solicites. Algunos de los más importantes a nivel universal son:

- Calcular: EC2, Lambda.

- Almacenamiento: S3, EBS, Glacier.

- Redes: VPC, Ruta 53, ELB.

- Seguridad: IAM, KMS.

- Bases de datos: RDS, DynamoDB.

- Herramientas DevOps: CloudFormation, CodePipeline.

¿Qué habilidades no técnicas son esenciales para tener éxito en una entrevista de AWS?

Además de los conocimientos técnicos, los empleadores suelen evaluar:

- Resolución de problemas: ¿Eres capaz de diseñar soluciones escalables y rentables?

- Comunicación: ¿Eres capaz de explicar conceptos técnicos de forma clara a las partes interesadas?

- Gestión del tiempo: ¿Cómo priorizas las tareas y cumples con los plazos en entornos dinámicos?

- Trabajo en equipo: ¿Eres capaz de colaborar eficazmente en equipos multifuncionales?

¿Qué pasa si no sabes la respuesta a una pregunta técnica durante una entrevista de AWS?

No pasa nada por no saberlo todo. En lugar de hacer conjeturas, sé sincero:

- Explica cómo abordarías la búsqueda de la respuesta (por ejemplo, consultando la documentación de AWS o realizando pruebas).

- Destaca los conocimientos relacionados que demuestren tu comprensión del concepto más amplio.

¿Cómo puedes negociar tu salario para un puesto relacionado con AWS?

- Investiga los salarios habituales para tu puesto y ubicación en sitios web como Glassdoor o Payscale.

- Destaca tus certificaciones, experiencia relevante y proyectos durante las negociaciones.

- Demuestra cómo tus habilidades pueden aportar valor a la empresa, por ejemplo, mediante el ahorro de costes o la mejora de la fiabilidad de las infraestructuras.

¿Qué debes hacer después de suspender un examen o una entrevista de certificación de AWS?

- Identifica tus puntos débiles utilizando los comentarios o tu informe de examen.

- Crea un plan de estudio o práctica para reforzar esas áreas.

- Aprovecha recursos adicionales, como exámenes de práctica o laboratorios prácticos.

- No te desanimes: muchos profesionales aprueban tras su segundo o tercer intento.

Zoumana desarrolla herramientas de IA LLM para ayudar a las empresas a llevar a cabo la diligencia debida en materia de sostenibilidad y evaluaciones de riesgos. Anteriormente trabajó como científico de datos e ingeniero de aprendizaje automático en Axionable e IBM. Zoumana es la fundadora de la plataforma tecnológica educativa de aprendizaje entre iguales ETP4Africa. Ha escrito más de 20 tutoriales para DataCamp.