Cours

L'objectif principal de ce guide est de faciliter la compréhension du processus d'entretien AWS en proposant une liste soigneusement sélectionnée de questions et réponses d'entretien. Cette gamme couvre tous les aspects, depuis les principes fondamentaux qui constituent la base de l'écosystème étendu d'AWS jusqu'aux questions détaillées basées sur des scénarios qui évaluent votre compréhension approfondie et votre utilisation pratique des services AWS.

Que vous soyez en début de carrière dans le domaine des données ou que vous soyez un professionnel expérimenté, cet article a pour objectif de vous fournir les connaissances et la confiance nécessaires pour répondre à toute question posée lors d'un entretien chez AWS. En explorant les questions d'entretien AWS de niveau débutant, intermédiaire et avancé, ainsi que des questions basées sur des situations réelles, ce guide vise à couvrir tous les domaines importants, garantissant ainsi une stratégie de préparation complète.

Pourquoi AWS ?

Avant d'examiner les questions et réponses, il est important de comprendre pourquoi il est pertinent d'envisager le cloud AWS comme plateforme de référence.

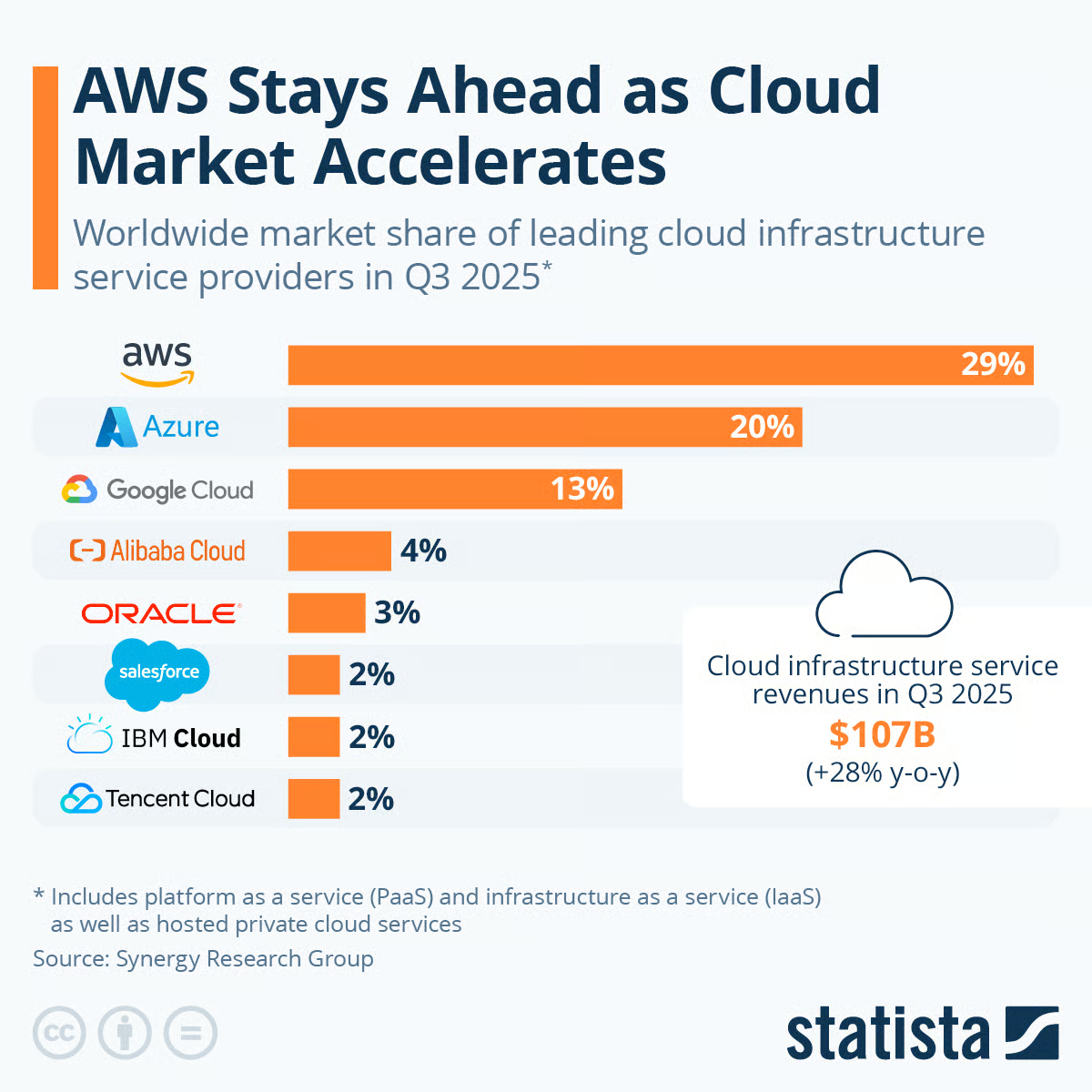

Le graphique suivant présente les parts de marché mondiales des principaux fournisseurs de services d'infrastructure cloud pour le troisième trimestre (T3) de 2025. Vous trouverez ci-dessous une ventilation des parts de marché représentées :

- Amazon Web Services (AWS) détient la plus grande part de marché avec 29 %.

- Microsoft Azure suit avec 20 %.

- Google Cloud détient 13 % du marché du cloud.

- Alibaba Cloud détient une part de marché de 4 %.

- Oracle a connu une croissance pour atteindre 3 %.

- Salesforce, IBM Cloud et Tencent Cloud occupent les dernières places, avec 2 % chacun.

Source (Statista)

Le graphique indique également que les données incluent les plateformes en tant que service (PaaS) et les infrastructures en tant que service (IaaS), ainsi que les services de cloud privé hébergés. De plus, il est mentionné que les revenus des services d'infrastructure cloud au troisième trimestre 2025 se sont élevés à 107 milliards de dollars, ce qui représente une augmentation significative par rapport au troisième trimestre 2024, où ils s'élevaient à 84 milliards de dollars.

Au troisième trimestre 2025, Amazon Web Services (AWS) reste l'acteur dominant sur le marché du cloud, conservant une avance significative sur son concurrent le plus proche, Microsoft Azure.

Le leadership d'AWS sur le marché du cloud souligne son importance pour le perfectionnement des compétences et offre des avantages professionnels significatifs en raison de son adoption généralisée et de la valeur accordée aux compétences AWS dans le secteur technologique.

Notre aide-mémoire « Comparaison des services AWS, Azure et GCP pour la science des données et l'IA » présente une comparaison des principaux services nécessaires aux activités liées aux données et à l'IA, de l'ingénierie des données à l'analyse des données, en passant par la science des données et la création d'applications de données.

Questions d'entretien de base sur AWS

En commençant par les principes fondamentaux, cette section présente les questions d'entretien AWS de base indispensables pour acquérir des connaissances fondamentales. Il est conçu pour les personnes qui découvrent AWS ou qui ont besoin d'une remise à niveau, préparant le terrain pour une exploration plus approfondie ultérieurement.

Qu'est-ce que le cloud computing ?

Le cloud computing permet d'accéder à la demande à des ressources informatiques telles que des capacités de calcul, de stockage et des bases de données via Internet. Les utilisateurs ne paient que pour ce qu'ils utilisent, au lieu de posséder une infrastructure physique.

Le cloud permet d'accéder à des services technologiques de manière flexible, selon les besoins, sans nécessiter d'investissements initiaux importants. Les principaux fournisseurs tels qu'AWS proposent une large gamme de services cloud via un modèle de consommation à la carte. Notre cours sur les concepts du cloud AWS aborde bon nombre de ces notions fondamentales.

Quel est le problème de l'approche informatique traditionnelle par rapport à l'utilisation du cloud ?

De nombreux secteurs d'activité délaissent les technologies informatiques traditionnelles au profit des infrastructures cloud pour diverses raisons. En effet, l'approche Cloud offre une plus grande agilité commerciale, une innovation plus rapide, une évolutivité flexible et un coût total de possession inférieur à celui des technologies informatiques traditionnelles. Voici quelques-unes des caractéristiques qui les distinguent :

|

Informatique traditionnelle |

Informatique dans le cloud |

|

|

Combien de types de modèles de déploiement existe-t-il dans le cloud ?

Il existe trois types de modèles de déploiement dans le cloud, illustrés ci-dessous :

- Cloud privé : ce type de service est utilisé par une seule organisation et n'est pas accessible au public. Il est adapté aux organisations qui utilisent des applications sensibles.

- Cloud public : ces ressources cloud sont détenues et exploitées par des services cloud tiers tels qu'Amazon Web Services, Microsoft Azure et tous ceux mentionnés dans la section consacrée aux parts de marché d'AWS.

- Cloud hybride : il s'agit de la combinaison de clouds privés et publics. Il est conçu pour conserver certains serveurs sur site tout en étendant les capacités restantes au cloud. Le cloud hybride offre la flexibilité et la rentabilité du cloud public.

Quelles sont les cinq caractéristiques du cloud computing ?

Le cloud computing présente cinq caractéristiques principales, illustrées ci-dessous :

- Libre-service à la demande : Les utilisateurs peuvent provisionner des services cloud selon leurs besoins sans interaction humaine avec le fournisseur de services.

- Accès à un vaste réseau : Les services sont disponibles sur le réseau et accessibles via des dispositifs standard tels que les téléphones mobiles, les ordinateurs portables et les tablettes.

- Multi-location et mise en commun des ressources : Les ressources sont mises en commun pour servir plusieurs clients, différentes ressources virtuelles et physiques étant attribuées de manière dynamique en fonction de la demande.

- Élasticité et évolutivité rapides : Les capacités peuvent être fournies de manière flexible et augmentées ou réduites rapidement et automatiquement afin d'adapter la capacité à la demande.

- Service mesuré : L'utilisation des ressources est surveillée, contrôlée, rapportée et facturée de manière transparente en fonction de l'utilisation. L'utilisation peut être gérée, contrôlée et faire l'objet de rapports, ce qui garantit la transparence pour le fournisseur et le consommateur.

Quels sont les principaux types de cloud ?

Il existe trois principaux types de cloud computing : IaaS, PaaS et SaaS

- Infrastructure en tant que service (IaaS) : Fournit les éléments de base pour l'informatique en cloud, tels que le calcul, le stockage et la mise en réseau, auxquels les utilisateurs peuvent accéder à la demande sans avoir à gérer l'infrastructure sous-jacente. Exemples : AWS EC2, S3, VPC.

- Plateforme en tant que service (PaaS) : Fournit une plateforme ou un environnement géré pour développer, déployer et gérer des applications cloud sans avoir besoin de construire l'infrastructure sous-jacente. Exemples : AWS Elastic Beanstalk, Heroku

- Logiciel en tant que service (SaaS) : Permet d'accéder à des applications complètes destinées aux utilisateurs finaux, fonctionnant dans le cloud, que les utilisateurs peuvent utiliser via Internet. Les utilisateurs ne gèrent ni l'infrastructure ni les plateformes. Exemples : Service de messagerie électronique AWS Simple Email Service, Google Docs, Salesforce CRM.

Vous pouvez approfondir ces notions dans notre cours Comprendre le cloud computing.

Qu'est-ce qu'Amazon EC2 et quelles sont ses principales utilisations ?

Amazon EC2 (Elastic Compute Cloud) fournit des serveurs virtuels évolutifs appelés instances dans le cloud AWS. Il est utilisé pour exécuter diverses charges de travail de manière flexible et rentable. Certaines de ses principales utilisations sont illustrées ci-dessous :

- Hébergement de sites Web et d'applications Web

- Exécuter les processus backend et les tâches par lots

- Mettre en œuvre des solutions de cloud hybride

- Atteignez une haute disponibilité et une grande évolutivité

- Réduire le délai de mise sur le marché pour les nouveaux cas d'utilisation

Qu'est-ce qu'Amazon S3 et pourquoi est-ce important ?

Amazon Simple Storage Service (S3) est un service de stockage d'objets polyvalent, évolutif et sécurisé. Il constitue la base de nombreuses applications et charges de travail basées sur le cloud. Voici quelques caractéristiques qui soulignent son importance :

- Durable avec une fiabilité de 99,999999999 % et une disponibilité de 99,99 %, ce qui le rend adapté aux données critiques.

- Prend en charge des fonctionnalités de sécurité robustes telles que les politiques d'accès, le chiffrement et les points de terminaison VPC.

- S'intègre parfaitement à d'autres services AWS tels que Lambda, EC2, EBS, pour n'en citer que quelques-uns.

- Sa faible latence et son débit élevé en font une solution idéale pour l'analyse de données volumineuses, les applications mobiles, le stockage et la diffusion de médias.

- Fonctionnalités de gestion flexibles pour la surveillance, les journaux d'accès, la réplication, la gestion des versions et les politiques de cycle de vie.

- Soutenu par l'infrastructure mondiale AWS pour un accès à faible latence dans le monde entier.

Veuillez expliquer les concepts de « régions » et de « zones de disponibilité » dans AWS.

- Les régions AWS correspondent à des emplacements géographiques distincts où se trouvent les ressources AWS. Les entreprises choisissent des régions proches de leurs clients afin de réduire la latence, et la réplication interrégionale offre une meilleure reprise après sinistre.

- Les zones de disponibilité sont constituées d'un ou plusieurs centres de données distincts dotés d'une alimentation électrique, d'un réseau et d'une connectivité redondants. Ils permettent un déploiement des ressources plus tolérant aux pannes.

Notre cours « AWS Cloud Concepts » fournit aux lecteurs un guide complet pour découvrir les principaux services de base d'AWS, les meilleures pratiques pour concevoir des applications AWS et les avantages de l'utilisation d'AWS pour les entreprises.

Qu'est-ce que l'IAM et pourquoi est-ce important ?

AWS Identity and Access Management (IAM) est un service qui vous aide à contrôler de manière sécurisée l'accès aux services et ressources AWS. IAM vous permet de gérer les utilisateurs, les groupes et les rôles avec des autorisations précises. Ceci est important car cela contribue à appliquer le principe du moindre privilège, garantissant que les utilisateurs n'ont accès qu'aux ressources dont ils ont besoin, renforçant ainsi la sécurité et la conformité.

Notre guide complet sur AWS IAM explique le service en détail.

Qu'est-ce qu'Amazon RDS et en quoi diffère-t-il des bases de données traditionnelles ?

Amazon Relational Database Service (RDS) est un service de base de données géré qui permet aux utilisateurs de configurer, d'exploiter et de faire évoluer des bases de données sans se soucier des tâches de gestion de l'infrastructure telles que les sauvegardes, les correctifs et la mise à l'échelle. Contrairement aux bases de données traditionnelles, Amazon RDS est évolutif et hautement disponible dès son installation, prend en charge les sauvegardes automatisées et permet des répliques en lecture et des déploiements multi-AZ pour le basculement et la redondance.

Voici un tableau qui met en évidence les différences entre RDS et les bases de données plus traditionnelles, pour ceux d'entre vous qui sont plus visuels :

| Caractéristique | Amazon RDS | Bases de données traditionnelles |

|---|---|---|

| Évolutivité | S'adapte facilement à la verticale ou à l'horizontale | Nécessite des mises à niveau matérielles ; la mise à l'échelle peut s'avérer coûteuse. |

| Disponibilité | Prend en charge les déploiements Multi-AZ pour une haute disponibilité. | La configuration haute disponibilité nécessite une configuration complexe. |

| Entretien | Géré par AWS, y compris les sauvegardes, les mises à jour et les correctifs | Géré manuellement, y compris les mises à jour et les sauvegardes régulières |

| Sauvegarde et restauration | Sauvegardes et instantanés automatisés | Nécessite des processus de sauvegarde manuels |

| Coût | Tarification à l'utilisation | Coûts fixes ; investissement initial plus élevé requis |

Qu'est-ce qu'Amazon VPC et à quoi sert-il ?

Amazon Virtual Private Cloud (VPC) vous permet de créer un réseau virtuel dans AWS qui ressemble étroitement à un réseau traditionnel dans un centre de données sur site. Le VPC est utilisé pour isoler les ressources, contrôler le trafic entrant et sortant, et segmenter les charges de travail en sous-réseaux avec des configurations de sécurité strictes. Il offre un contrôle précis sur les plages d'adresses IP, les groupes de sécurité et les listes de contrôle d'accès au réseau.

Qu'est-ce qu'Amazon CloudWatch et quels sont ses principaux composants ?

Amazon CloudWatch est un service de surveillance et d'observabilité conçu pour suivre diverses métriques, définir des alarmes et répondre automatiquement aux changements dans les ressources AWS. Il contribue à améliorer la visibilité sur les performances des applications, l'état du système et les problèmes opérationnels, ce qui en fait un outil essentiel pour les utilisateurs d'AWS. Voici les principaux composants de CloudWatch :

- Indicateurs: CloudWatch collecte des points de données, ou métriques, qui fournissent des informations sur l'utilisation des ressources, les performances des applications et la santé opérationnelle. Ces données permettent d'analyser les tendances et de procéder à une mise à l'échelle proactive.

- Alarmes: Les alertes informent les utilisateurs ou déclenchent des actions automatisées en fonction de seuils métriques spécifiques. Par exemple, si l'utilisation du processeur dépasse un seuil défini, une alarme peut déclencher un ajustement automatique afin de gérer l'augmentation de la charge.

- Journaux: CloudWatch Logs offre un stockage centralisé pour les journaux d'application et d'infrastructure, ce qui est essentiel pour le dépannage et l'identification des problèmes. Les journaux peuvent être filtrés, surveillés et analysés afin de garantir le bon déroulement des opérations.

- Événements: CloudWatch Events (ou Amazon EventBridge) détecte les modifications apportées aux ressources AWS et peut déclencher des actions prédéfinies, telles que l'invocation d'une fonction Lambda lorsqu'un événement spécifique se produit. Cela permet une plus grande automatisation et une réponse rapide aux événements critiques.

Qu'est-ce qu'AWS Lambda et comment permet-il l'informatique sans serveur ?

AWS Lambda est un service informatique sans serveur qui élimine la nécessité de gérer des serveurs, facilitant ainsi l'exécution du code des développeurs dans le cloud. Voici comment cela fonctionne et pourquoi cela facilite l'informatique sans serveur :

- Exécution de code à la demande: Lambda exécute le code uniquement lorsqu'il est déclenché par un événement, tel qu'une requête HTTP ou un téléchargement de fichier dans Amazon S3. Cela vous permet d'utiliser les ressources uniquement lorsque cela est nécessaire, optimisant ainsi les coûts et l'efficacité.

- Mise à l'échelle automatique: Lambda s'adapte automatiquement en fonction du nombre de requêtes entrantes. Il est capable de traiter de la simple requête à des milliers de requêtes par seconde, ce qui permet aux applications de rester réactives même lorsque le trafic varie.

- Concentrez-vous sur le code, pas sur l'infrastructure: Comme Lambda abstrait l'infrastructure serveur, les développeurs peuvent se concentrer uniquement sur l'écriture et le déploiement du code sans se soucier de l'approvisionnement, de la gestion ou de la mise à l'échelle des serveurs.

Grâce à ces fonctionnalités, Lambda incarne les principes du serverless computing : éliminer la charge liée à la gestion de l'infrastructure et permettre aux développeurs de créer, tester et faire évoluer des applications avec une plus grande agilité.

Qu'est-ce que l'équilibrage de charge élastique (ELB) dans AWS ?

Elastic Load Balancing (ELB) est un service qui répartit automatiquement le trafic entrant vers plusieurs cibles, garantissant ainsi la réactivité et la résilience de votre application. ELB offre plusieurs avantages qui en font un composant essentiel des architectures AWS évolutives :

- Répartition du trafic: ELB équilibre intelligemment le trafic entrant entre plusieurs cibles, notamment les instances EC2, les conteneurs et les adresses IP. Cela permet d'éviter la surcharge d'une ressource unique, garantissant ainsi des performances applicatives constantes.

- Tolérance aux pannes et haute disponibilité: ELB assure la tolérance aux pannes en répartissant le trafic sur plusieurs zones de disponibilité, ce qui permet à votre application de rester disponible même si une zone rencontre des problèmes.

- Fiabilité et évolutivité améliorées: ELB ajuste automatiquement la répartition du trafic en fonction de l'évolution de la demande, ce qui facilite la gestion des pics de trafic soudains sans impact sur les performances des applications.

Devenez ingénieur en données

Questions d'entretien AWS pour les candidats de niveau intermédiaire et expérimenté

Questions d'entretien AWS DevOps

En ce qui concerne les rôles spécialisés, l'accent est mis ici sur la manière dont AWS soutient les pratiques DevOps. Cette partie examine l'automatisation et l'optimisation des environnements AWS, invitant les participants à démontrer leurs compétences dans l'utilisation d'AWS pour l'intégration et la livraison continues. Si vous postulez à un poste AWS de niveau avancé, veuillez consulter notre article de blog intitulé « Questions d'entretien pour les architectes de données » afin de vous entraîner à répondre à des questions sur l'infrastructure et l'architecture des données.

Comment utilisez-vous AWS CodePipeline pour automatiser un pipeline CI/CD pour une application multi-niveaux ?

CodePipeline peut être utilisé pour automatiser le flux depuis l'enregistrement du code jusqu'à la compilation, aux tests et au déploiement dans plusieurs environnements, afin de rationaliser la livraison des mises à jour tout en maintenant des normes de qualité élevées.

Les étapes suivantes peuvent être suivies pour automatiser un pipeline CI/CD :

- Veuillez créer un pipeline : Commencez par créer un pipeline dans AWS CodePipeline, en spécifiant votre référentiel de code source (par exemple, GitHub, AWS CodeCommit).

- Définir l'étape de construction : Connectez-vous à un service de compilation tel qu'AWS CodeBuild pour compiler votre code, exécuter des tests et créer des artefacts déployables.

- Définir les étapes de déploiement : Veuillez configurer les étapes de déploiement pour chaque niveau de votre application. Veuillez utiliser AWS CodeDeploy pour automatiser les déploiements vers les instances Amazon EC2, AWS Elastic Beanstalk pour les applications web ou AWS ECS pour les applications conteneurisées.

- Veuillez ajouter des étapes d'approbation (facultatif) : Pour les environnements critiques, veuillez intégrer des étapes d'approbation manuelle avant les phases de déploiement afin de garantir la qualité et le contrôle.

- Surveiller et répéter : Veuillez surveiller les performances du pipeline et procéder aux ajustements nécessaires. Utilisez les commentaires et les itérations pour améliorer continuellement le processus de déploiement.

Quels sont les facteurs clés à prendre en compte lors de la conception d'une solution de déploiement sur AWS afin de provisionner, configurer, déployer, dimensionner et surveiller efficacement les applications ?

La création d'un déploiement AWS bien conçu implique d'adapter les services AWS aux besoins de votre application, en couvrant les exigences en matière de calcul, de stockage et de base de données. Ce processus, rendu complexe par le vaste catalogue de services AWS, comprend plusieurs étapes cruciales :

- Approvisionnement : Configurez l'infrastructure AWS essentielle telle que EC2, VPC, sous-réseaux ou services gérés comme S3, RDS, CloudFront pour les applications sous-jacentes.

- Configuration : Veuillez adapter votre configuration afin de répondre aux exigences spécifiques liées à l'environnement, à la sécurité, à la disponibilité et aux performances.

- Déploiement : Déployez ou mettez à jour efficacement les composants de l'application, en garantissant des transitions fluides entre les versions.

- Mise à l'échelle : Modifiez de manière dynamique l'allocation des ressources en fonction de critères prédéfinis afin de gérer les variations de charge.

- Surveillance : Suivez l'utilisation des ressources, les résultats des déploiements, l'état des applications et les journaux afin de vous assurer que tout fonctionne comme prévu.

Qu'est-ce que l'infrastructure en tant que code ? Veuillez décrire avec vos propres mots

L'infrastructure en tant que code (IaC) est une méthode de gestion et de provisionnement des centres de données informatiques à l'aide de fichiers de définition lisibles par machine, plutôt que par le biais d'une configuration matérielle physique ou d'outils de configuration interactifs.

Essentiellement, cela permet aux développeurs et aux équipes informatiques de gérer, surveiller et provisionner automatiquement les ressources via du code, plutôt que de devoir configurer manuellement le matériel.

De plus, IaC permet de déployer rapidement et de manière évolutive des environnements cohérents en codifiant l'infrastructure, ce qui réduit les erreurs humaines et augmente l'efficacité.

Quelle est votre approche en matière d'intégration et de déploiement continus dans AWS DevOps ?

Dans AWS DevOps, l'intégration et le déploiement continus peuvent être gérés à l'aide des outils de développement AWS. Commencez par stocker et gérer les versions du code source de votre application à l'aide de ces outils.

Ensuite, utilisez des services tels qu'AWS CodePipeline pour coordonner les processus de compilation, de test et de déploiement. CodePipeline sert de base, s'intégrant à AWS CodeBuild pour la compilation et le test du code, et à AWS CodeDeploy pour l'automatisation du déploiement dans divers environnements. Cette approche simplifiée garantit des flux de travail efficaces et automatisés pour une intégration et une livraison continues.

En quoi Amazon ECS est-il avantageux pour AWS DevOps ?

Amazon ECS est un service de gestion de conteneurs évolutif qui simplifie l'exécution de conteneurs Docker sur des instances EC2 via un cluster géré, améliorant ainsi le déploiement et le fonctionnement des applications.

Quelles sont les stratégies possibles pour les déploiements bleus/verts sur AWS ?

Les déploiements bleus/verts minimisent les temps d'arrêt et les risques en exécutant deux environnements : l'un (bleu) avec la version actuelle et l'autre (vert) avec la nouvelle version. Dans AWS, cela peut être réalisé à l'aide de services tels qu'Elastic Beanstalk, AWS CodeDeploy ou ECS. Vous pouvez transférer le trafic entre les environnements à l'aide de Route 53 ou d'un équilibreur de charge d'application, tester l'environnement vert en toute sécurité et revenir en arrière instantanément si nécessaire.

Pourquoi ECS pourrait-il être préféré à Kubernetes ?

ECS offre une plus grande flexibilité, évolutivité et simplicité de mise en œuvre par rapport à Kubernetes, ce qui en fait un choix privilégié pour certains déploiements.

Comment géreriez-vous et sécuriseriez-vous les secrets pour un pipeline CI/CD dans AWS ?

Pour gérer de manière sécurisée les secrets dans un pipeline CI/CD AWS, vous pouvez utiliser AWS Secrets Manager ou AWS Systems Manager Parameter Store afin de stocker des informations sensibles telles que les clés API, les mots de passe de base de données et les certificats. Ces deux services s'intègrent aux services AWS tels que CodePipeline et CodeBuild, permettant un accès sécurisé aux secrets sans les coder en dur dans votre base de code.

En contrôlant les autorisations d'accès avec IAM, vous pouvez garantir que seules les entités autorisées peuvent accéder aux données sensibles, renforçant ainsi la sécurité au sein du processus CI/CD.

Comment utilisez-vous AWS Systems Manager dans un environnement de production ?

AWS Systems Manager facilite l'automatisation et la gestion de votre infrastructure à grande échelle. Dans un environnement de production, il est couramment utilisé pour la gestion des correctifs, l'exécution de commandes à distance, la collecte d'inventaire et le stockage sécurisé des paramètres de configuration et des secrets. Il s'intègre à EC2, RDS et d'autres services AWS, permettant ainsi une visibilité centralisée et un contrôle opérationnel.

Qu'est-ce qu'AWS CloudFormation et comment facilite-t-il les pratiques DevOps ?

AWS CloudFormation automatise le provisionnement et la gestion de l'infrastructure AWS via du code, permettant ainsi la mise en œuvre de l'infrastructure en tant que code (IaC). Ce service vous permet de définir votre infrastructure sous forme de modèles, ce qui facilite la gestion des versions, les tests et la réplication des environnements tout au long du développement, de la mise en scène et de la production.

Dans un environnement DevOps, CloudFormation contribue à maintenir la cohérence, réduit les erreurs de configuration manuelle et prend en charge les déploiements automatisés, ce qui en fait un élément essentiel de la livraison continue et de la réplication d'environnement.

Pour conclure la série de questions sur le DevOps, voici un tableau récapitulatif des différents services AWS utilisés dans ce domaine, ainsi que leurs cas d'utilisation :

| Service | Objectif | Cas d'utilisation dans DevOps |

|---|---|---|

| AWS CodePipeline | Automatise les workflows CI/CD dans plusieurs environnements | Intégration et déploiement continus pour des mises à jour simplifiées |

| AWS CodeBuild | Compile le code, exécute les tests et produit des artefacts déployables. | Automatisation de la construction, des tests et de la génération d'artefacts |

| AWS CodeDeploy | Gère les déploiements d'applications dans divers environnements AWS (par exemple, EC2, Lambda). | Déploiements automatisés dans tous les environnements avec capacités de restauration |

| Amazon ECS | Gestion des conteneurs pour le déploiement de conteneurs Docker | Exécution de microservices, simplification du déploiement et de la gestion des applications |

| Gestionnaire de secrets AWS | Stocke et gère les informations sensibles de manière sécurisée | Stockage sécurisé des clés API, mots de passe et autres données sensibles |

| AWS CloudFormation | Automatise la configuration de l'infrastructure via du code (IaC) | Cohérence de l'infrastructure, réplication de l'environnement, meilleures pratiques IaC |

Questions d'entretien pour le poste d'architecte de solutions AWS

Pour les architectes de solutions, l'accent est mis sur la conception de solutions AWS qui répondent à des exigences spécifiques. Ce segment évalue la capacité à créer des systèmes évolutifs, efficaces et rentables à l'aide d'AWS, en mettant l'accent sur les meilleures pratiques en matière d'architecture.

Quel est le rôle d'un architecte de solutions AWS ?

Les architectes de solutions AWS conçoivent et supervisent les applications sur AWS, garantissant leur évolutivité et des performances optimales. Ils conseillent les développeurs, les administrateurs système et les clients sur l'utilisation efficace d'AWS pour répondre à leurs besoins commerciaux et communiquent des concepts complexes aux parties prenantes techniques et non techniques.

Quelles sont les meilleures pratiques en matière de sécurité pour AWS EC2 ?

Les pratiques de sécurité EC2 essentielles comprennent l'utilisation d'IAM pour la gestion des accès, la restriction des accès aux hôtes de confiance, la réduction des autorisations, la désactivation des connexions par mot de passe pour les AMI et la mise en œuvre d'une authentification multifactorielle pour une sécurité renforcée.

Comment garantissez-vous la redondance multirégionale dans une architecture AWS ?

Pour concevoir une redondance multirégionale, veuillez déployer les ressources critiques telles que les instances EC2, les bases de données RDS et les compartiments S3 dans plusieurs régions AWS. Veuillez utiliser Route 53 pour le routage DNS géolocalisé et la réplication interrégionale S3 pour la sauvegarde des données. Utilisez des configurations actives-actives ou actives-passives en fonction de votre stratégie de basculement, et surveillez les performances et la réplication à l'aide de CloudWatch et d'AWS Global Accelerator.

Quelles sont les stratégies permettant de créer une architecture AWS hautement disponible et tolérante aux pannes pour les applications web critiques ?

La mise en place d'une architecture hautement disponible et tolérante aux pannes sur AWS implique plusieurs stratégies visant à réduire l'impact des défaillances et à garantir un fonctionnement continu. Les principes clés comprennent :

- Mettre en œuvre la redondance entre les composants du système afin d'éliminer les points de défaillance uniques.

- Utilisation de l'équilibrage de charge pour répartir le trafic de manière uniforme et garantir des performances optimales

- Mise en place d'une surveillance automatisée pour la détection et la réponse en temps réel aux défaillances. Les systèmes doivent être conçus pour être évolutifs afin de pouvoir gérer des charges variables, avec une architecture distribuée pour améliorer la tolérance aux pannes.

- Il est essentiel de mettre en place des mesures d'isolation des pannes, des sauvegardes régulières et des plans de reprise après sinistre pour assurer la protection des données et une récupération rapide.

- La conception axée sur la dégradation gracieuse permet de maintenir la fonctionnalité pendant les pannes, tandis que les pratiques de test et de déploiement continus améliorent la fiabilité du système.

Veuillez expliquer comment vous choisiriez entre Amazon RDS, Amazon DynamoDB et Amazon Redshift pour une application axée sur les données.

Le choix entre Amazon RDS, DynamoDB et Redshift pour une application axée sur les données dépend de vos besoins spécifiques :

- Amazon RDS est particulièrement adapté aux applications qui nécessitent une base de données relationnelle traditionnelle avec prise en charge SQL standard, transactions et requêtes complexes.

- Amazon DynamoDB convient aux applications nécessitant une base de données nosql hautement évolutive, offrant des performances rapides et prévisibles à n'importe quelle échelle. Il est idéal pour les modèles de données flexibles et le développement rapide.

- Amazon Redshift est particulièrement adapté aux applications analytiques nécessitant des requêtes complexes sur de grands ensembles de données. Il offre des performances de requête rapides grâce à l'utilisation d'un stockage en colonnes et d'une technologie d'entreposage de données.

Quels éléments prendriez-vous en considération lors de la migration d'une application locale existante vers AWS ? Veuillez utiliser un exemple de votre choix.

Lors du transfert du logiciel de gestion de la relation client (CRM) d'une entreprise d'un serveur interne vers Amazon Web Services (AWS), il est essentiel de suivre un cadre stratégique similaire à celui suggéré par AWS, adapté à ce scénario spécifique :

- Préparation initiale et élaboration de la stratégie

- Veuillez évaluer la configuration actuelle du CRM afin d'identifier ses limites et les domaines susceptibles d'être améliorés.

- Définissez des objectifs de migration clairs, tels que l'amélioration de l'évolutivité, le renforcement des fonctionnalités d'analyse des données ou la réduction des coûts de maintenance.

- Identifiez les solutions AWS requises, telles que l'utilisation d'Amazon EC2 pour les ressources informatiques et d'Amazon RDS pour la gestion de la base de données.

- Évaluation et planification stratégique

- Veuillez répertorier les composants CRM afin de déterminer les éléments à migrer en priorité.

- Veuillez sélectionner les techniques de migration appropriées, par exemple, transférer la base de données CRM à l'aide du service AWS Database Migration Service (DMS).

- Veuillez prévoir une connexion réseau stable pendant le déménagement, éventuellement en utilisant AWS Direct Connect.

- Exécution et validation

- Élaborez une stratégie de migration détaillée en commençant par les modules CRM les moins critiques à titre d'essai.

- Obtenir l'accord des principales parties prenantes avant de migrer les principales fonctions CRM, en utilisant les services AWS.

- Veuillez évaluer les performances et la sécurité du CRM migré sur AWS, en effectuant les ajustements nécessaires.

- Transition vers le fonctionnement dans le cloud

- Passer à la gestion complète de l'application CRM dans l'environnement AWS, en supprimant progressivement les anciens composants sur site.

- Veuillez utiliser la suite d'outils de surveillance et de gestion d'AWS pour assurer une supervision et une amélioration continues.

- Utilisez les enseignements tirés de cette migration pour éclairer les transitions futures, en envisageant une adoption plus large du cloud pour d'autres applications.

Cette approche garantit que la migration du CRM vers AWS est alignée sur les objectifs stratégiques de l'entreprise, maximisant ainsi les avantages du cloud computing en termes d'évolutivité, d'efficacité et de réduction des coûts.

Veuillez décrire comment vous utiliseriez les services AWS pour mettre en œuvre une architecture de microservices.

La mise en œuvre d'une architecture microservice implique la division d'une application logicielle en petits services indépendants qui communiquent via des API. Voici un guide succinct pour la mise en place de microservices :

- Adoptez le développement agile : Utilisez des méthodologies agiles pour faciliter le développement et le déploiement rapides de microservices individuels.

- Adoptez une conception axée sur les API : Développez d'abord des API pour l'interaction des microservices afin de garantir une communication claire et cohérente entre les services.

- Tirez parti des pratiques CI/CD : Mettez en œuvre l'intégration continue et la livraison continue (CI/CD) afin d'automatiser les tests et le déploiement, améliorant ainsi la rapidité et la fiabilité du développement.

- Intégrer les principes des applications à douze facteurs : Appliquez ces principes pour créer des services évolutifs et faciles à maintenir, qui peuvent être déployés facilement sur des plateformes cloud telles qu'AWS.

- Sélectionner le modèle d'architecture approprié : Veuillez envisager des modèles basés sur les API, les événements ou le streaming de données en fonction des besoins de votre application afin d'optimiser la communication et le flux de données entre les services.

- Tirez parti d'AWS pour le déploiement : Utilisez les services AWS tels que les technologies de conteneurs pour les microservices évolutifs ou l'informatique sans serveur afin de réduire la complexité opérationnelle et de vous concentrer sur la création d'une logique d'application.

- Mettre en œuvre les principes sans serveur : Lorsque cela est approprié, veuillez utiliser des architectures sans serveur afin d'éliminer la gestion de l'infrastructure, de vous adapter automatiquement et de ne payer que pour ce que vous utilisez, améliorant ainsi l'efficacité du système et la rentabilité.

- Assurer la résilience du système : Concevez des microservices pour assurer la tolérance aux pannes et la résilience, en utilisant les fonctionnalités de disponibilité intégrées d'AWS afin de maintenir la continuité du service.

- Concentrez-vous sur les aspects transversaux : Traitez la surveillance distribuée, la journalisation, le traçage et la cohérence des données afin de maintenir la santé et les performances du système.

- Révision à l'aide du cadre AWS Well-Architected : Veuillez utiliser l'outil AWS Well-Architected Tool pour évaluer votre architecture par rapport aux meilleures pratiques d'AWS, garantissant ainsi fiabilité, sécurité, efficacité et rentabilité.

En tenant compte de ces points, les équipes peuvent mettre en œuvre efficacement une architecture microservice évolutive, flexible et adaptée aux besoins spécifiques de leurs applications, tout en tirant parti des vastes capacités cloud d'AWS.

Quelle est la relation entre AWS Glue et AWS Lake Formation ?

AWS Lake Formation s'appuie sur l'infrastructure d'AWS Glue, intégrant ses capacités ETL, sa console de contrôle, son catalogue de données et son architecture sans serveur. Alors qu'AWS Glue se concentre sur les processus ETL, Lake Formation ajoute des fonctionnalités permettant de créer, sécuriser et gérer des lacs de données, améliorant ainsi les fonctions de Glue.

Pour les questions d'entretien relatives à AWS Glue, il est essentiel de comprendre comment Glue prend en charge Lake Formation. Les candidats doivent être prêts à discuter du rôle de Glue dans la gestion des lacs de données au sein d'AWS, en démontrant leur compréhension de l'intégration et des fonctionnalités des deux services dans l'écosystème AWS. Cela démontre une compréhension approfondie de la manière dont ces services collaborent pour traiter et gérer efficacement les données.

Comment optimisez-vous les coûts AWS pour une application web à fort trafic ?

Afin d'optimiser les coûts AWS pour une application à fort trafic, nous vous recommandons de commencer par utiliser AWS Cost Explorer et AWS Budgets pour surveiller et gérer vos dépenses. Ensuite, veuillez envisager les stratégies suivantes :

- Veuillez utiliser les instances réservées et les instances ponctuelles respectivement pour les charges de travail prévisibles et flexibles.

- L'auto-scaling permet d'ajuster l'allocation des ressources en fonction de la demande, réduisant ainsi les coûts pendant les périodes de faible trafic.

- Optimisez le stockage grâce aux politiques de cycle de vie Amazon S3 et à S3 Intelligent-Tiering afin de transférer les données rarement consultées vers des classes de stockage plus économiques.

- Mettez en œuvre la mise en cache avec Amazon CloudFront et Amazon ElastiCache afin de réduire les requêtes répétées vers les ressources backend, ce qui permet d'économiser de la bande passante et de réduire les coûts de calcul.

Cette approche garantit la rentabilité de l'application sans compromettre ses performances ou sa disponibilité.

Quels sont les principaux piliers du cadre AWS Well-Architected ?

Le cadre AWS Well-Architected Framework fournit une approche structurée pour concevoir des architectures AWS sécurisées, efficaces et résilientes. Il repose sur cinq piliers principaux :

- Excellence opérationnelle: Se concentre sur le soutien au développement et aux opérations par le biais de la surveillance, de la réponse aux incidents et de l'automatisation.

- Sécurité: Couvre la protection des données, des systèmes et des actifs grâce à la gestion des identités, au chiffrement et à la réponse aux incidents.

- Fiabilité: Implique la mise en place de systèmes capables de récupérer après des pannes, d'adapter les ressources de manière dynamique et de gérer les problèmes réseau.

- Efficacité des performances: Encourage l'utilisation de ressources évolutives et de charges de travail optimisées.

- Optimisation des coûts: Se concentre sur la gestion des coûts en sélectionnant les ressources appropriées et en utilisant des modèles de tarification tels que les instances réservées.

La compréhension de ces piliers permet aux architectes AWS de concevoir des solutions équilibrées qui respectent les meilleures pratiques en matière de sécurité, de performances, de fiabilité et de gestion des coûts.

Questions et réponses avancées pour les entretiens AWS

Questions d'entretien pour le poste d'ingénieur de données AWS

Destinée aux ingénieurs de données, cette section explore les services AWS pour le traitement des données, y compris le stockage et le traitement en temps réel. Il examine l'expertise nécessaire pour créer des pipelines de données évolutifs avec AWS.

Veuillez décrire la différence entre Amazon Redshift, RDS et S3, et dans quels cas chacun d'entre eux devrait être utilisé.

- Amazon S3 est un service de stockage d'objets qui offre un stockage évolutif et durable pour tout volume de données. Il peut être utilisé pour stocker des données brutes et non structurées telles que des fichiers journaux, des fichiers CSV, des images, etc.

- Amazon Redshift est un entrepôt de données cloud optimisé pour l'analyse et la veille économique. Il s'intègre à S3 et peut charger les données qui y sont stockées afin d'effectuer des requêtes complexes et de générer des rapports.

- Amazon RDS fournit des bases de données relationnelles gérées telles que PostgreSQL, MySQL, etc. Il peut alimenter des applications transactionnelles qui nécessitent des bases de données conformes à ACID avec des fonctionnalités telles que l'indexation, les contraintes, etc.

Veuillez décrire un scénario dans lequel vous utiliseriez Amazon Kinesis plutôt qu'AWS Lambda pour le traitement des données. Quels sont les principaux éléments à prendre en considération ?

Kinesis peut être utilisé pour traiter de grandes quantités de données en continu et permet la lecture et le traitement des flux avec des applications grand public.

Certaines des considérations clés sont illustrées ci-dessous :

- Volume de données : Kinesis peut traiter jusqu'à plusieurs mégaoctets de données par seconde, contrairement à Lambda qui est limité à 6 Mo par invocation, ce qui est particulièrement utile pour les flux à haut débit.

- Traitement en continu : Les utilisateurs de Kinesis peuvent traiter les données en continu et en temps réel dès leur arrivée, contrairement aux invocations par lots de Lambda, ce qui contribue à réduire la latence du traitement.

- Capacité de relecture : Les flux Kinesis conservent les données pendant une période configurée, ce qui permet de les rejouer et de les retraiter si nécessaire, tandis que Lambda n'est pas adapté à la relecture.

- Commande : Les fragments Kinesis permettent le traitement ordonné des enregistrements associés. Lambda, quant à lui, peut traiter les données dans un ordre aléatoire.

- Évolutivité et parallélisme : Les fragments Kinesis peuvent s'adapter pour gérer la charge. Lambda pourrait nécessiter une orchestration.

- Intégration : Kinesis s'intègre parfaitement à d'autres services AWS tels que Firehose, Redshift et EMR pour l'analyse.

De plus, pour les cas de traitement de flux à haut volume, continus, ordonnés et reproductibles, tels que l'analyse en temps réel, Kinesis offre une prise en charge native du streaming, contrairement à l'approche par lots de Lambda.

Pour en savoir plus sur le streaming de données, notre cours Streaming de données avec AWS Kinesis et Lambda aide les utilisateurs à apprendre comment exploiter ces technologies pour ingérer des données provenant de millions de sources et les analyser en temps réel. Cela peut vous aider à mieux vous préparer aux questions d'entretien AWS Lambda.

Quelles sont les principales différences entre le traitement des données par lots et le traitement des données en temps réel ? Dans quelles circonstances opteriez-vous pour une approche plutôt qu'une autre dans le cadre d'un projet d'ingénierie des données ?

Le traitement par lots consiste à collecter des données sur une période donnée et à les traiter en grands blocs ou lots. Cette méthode est particulièrement efficace pour analyser des données historiques moins fréquentes.

Le traitement en temps réel analyse les données de manière continue à mesure qu'elles arrivent par petits incréments. Il permet d'analyser des données récentes et fréquemment mises à jour.

Dans le cadre d'un projet d'ingénierie des données, le streaming en temps réel peut être envisagé lorsque :

- Vous avez besoin d'informations immédiates et ne pouvez pas attendre l'exécution d'un processus par lots. Par exemple, la détection des fraudes.

- Les données évoluent constamment et l'analyse doit suivre le rythme, à l'instar de la surveillance des réseaux sociaux.

- Une faible latence est requise, comme pour les systèmes de trading automatisés.

Le traitement par lots peut être préférable dans les cas suivants :

- Les données historiques nécessitent une modélisation ou une analyse complexe, comme la prévision de la demande.

- Les données proviennent de diverses sources qui ne fournissent que des sauvegardes périodiques.

- La réduction des coûts de traitement est plus importante que la vitesse de traitement.

Le traitement en temps réel est donc idéal pour les données en constante évolution qui nécessitent une analyse continue, tandis que le traitement par lots convient mieux aux données disponibles périodiquement qui nécessitent une modélisation historique.

Comment automatiser l'évolution des schémas dans un pipeline de données sur AWS ?

L'évolution des schémas peut être gérée à l'aide des fonctionnalités de cadre dynamique et d'inférence de schéma d'AWS Glue. En combinaison avec le catalogue de données Glue, vous pouvez suivre automatiquement les modifications apportées au schéma. Afin d'éviter d'interrompre les processus en aval, veuillez mettre en œuvre des étapes de validation de schéma à l'aide d'outils tels qu'AWS Deequ ou intégrer une logique personnalisée dans vos scripts ETL pour enregistrer et résoudre les incohérences.

Comment gérez-vous le schéma à la lecture par rapport au schéma à l'écriture dans les lacs de données AWS ?

Le schéma à la lecture est couramment utilisé dans les lacs de données où sont stockées des données brutes semi-structurées (par exemple, dans S3), et le schéma n'est appliqué qu'au moment de la requête à l'aide d'outils tels qu'Athena ou Redshift Spectrum. Cette approche offre une grande flexibilité pour diverses sources de données. Le schéma à l'écriture, fréquemment utilisé dans RDS ou Redshift, impose une structure dès le départ et est privilégié pour les ensembles de données transactionnels ou structurés nécessitant une validation stricte des données.

Qu'est-ce qu'un magasin de données opérationnelles et comment complète-t-il un entrepôt de données ?

Un magasin de données opérationnelles (ODS) est une base de données conçue pour prendre en charge les opérations commerciales et les analyses en temps réel. Il sert de plateforme intermédiaire entre les systèmes transactionnels et l'entrepôt de données.

Alors qu'un entrepôt de données contient des données de haute qualité optimisées pour la veille économique et le reporting, un ODS contient des données actualisées, thématiques et intégrées provenant de plusieurs sources.

Voici les principales caractéristiques d'un ODS :

- Il fournit des données en temps réel pour la surveillance des opérations et la prise de décision.

- Intègre des données en temps réel provenant de plusieurs sources.

- Il est optimisé pour les requêtes et les analyses rapides par opposition au stockage à long terme.

- ODS contient des données granulaires et atomiques par opposition aux données agrégées dans l'entrepôt.

Un système ODS et un entrepôt de données sont des systèmes complémentaires. ODS prend en charge les opérations en temps réel à l'aide des données actuelles, tandis que l'entrepôt de données permet la création de rapports et d'analyses stratégiques en exploitant les données historiques intégrées. Une fois combinés, ils offrent une plateforme complète répondant à la fois aux besoins opérationnels et analytiques.

Comment mettriez-vous en place un lac de données sur AWS et quels services utiliseriez-vous ?

Pour créer un lac de données sur AWS, le service principal à utiliser est Amazon S3, qui permet de stocker des données brutes, structurées et non structurées de manière évolutive et durable. Voici une approche étape par étape et les services supplémentaires impliqués :

- Couche de stockage: Veuillez utiliser Amazon S3 pour stocker de grands volumes de données. Organisez les données à l'aide d'une hiérarchie de dossiers structurée en fonction du type de données, de la source ou de la fraîcheur.

- Catalogage des données: Veuillez utiliser AWS Glue pour créer un catalogue de données, ce qui facilite la recherche et l'interrogation des données stockées dans S3 en créant des définitions de métadonnées.

- Transformation des données et ETL: Utilisez AWS Glue ETL pour préparer et transformer les données brutes en un format prêt à être analysé.

- Sécurité et contrôle d'accès: Mettez en œuvre AWS IAM et AWS Lake Formation pour gérer les accès, les autorisations et le chiffrement des données.

- Analyses et requêtes: Veuillez utiliser Amazon Athena pour les requêtes ad hoc, Amazon Redshift Spectrum pour les analyses et Amazon QuickSight pour la visualisation.

Cette configuration offre une architecture de lac de données flexible et évolutive, capable de traiter de grands volumes de données pour des analyses structurées et non structurées.

Veuillez expliquer les différentes classes de stockage dans Amazon S3 et dans quels cas chacune d'entre elles est recommandée.

Amazon S3 propose plusieurs classes de stockage, chacune étant optimisée pour des cas d'utilisation et des exigences de coût spécifiques. Le tableau suivant les résume :

| Catégorie de stockage | Cas d'utilisation | Fréquence d'accès | Rentabilité |

|---|---|---|---|

| S3 Standard | Données fréquemment consultées | Élevé | Tarification standard |

| S3 Intelligent-Tiering | Modèles d'accès imprévisibles | Réglage automatique | Rentable grâce à la hiérarchisation automatisée |

| S3 Standard-IA | Rarement consulté mais rapidement accessible | Faible | Coût réduit, récupération rapide |

| S3 Zone unique IA | Accès peu fréquent dans une seule zone de disponibilité | Faible | Coût réduit, moins de redondance |

| S3 Glacier | Archivage à long terme avec accès peu fréquent | Rare | À faible coût, récupération en quelques minutes ou quelques heures |

| Archive profonde S3 Glacier | Archivage réglementaire ou de conformité | Très rare | Coût le plus bas, récupération en 12 à 48 heures |

Comprendre les classes de stockage S3 permet d'optimiser les coûts de stockage et les temps d'accès en fonction des besoins spécifiques en matière de données.

Questions basées sur des scénarios AWS

Axées sur l'application pratique, ces questions évaluent les capacités de résolution de problèmes dans des scénarios réalistes, exigeant une compréhension approfondie de la manière d'utiliser les services AWS pour relever des défis complexes.

Le tableau suivant résume les scénarios généralement abordés lors des entretiens AWS, accompagnés de leur description et des solutions possibles :

|

Type de cas |

Description |

Solution |

|

Transfert d'applications |

Une entreprise envisage de migrer son application existante vers AWS. L'application est gourmande en données et nécessite un accès à faible latence pour les utilisateurs du monde entier. Quels services et quelle architecture AWS recommanderiez-vous pour garantir une haute disponibilité et une faible latence ? |

|

|

Reprise après sinistre |

Votre organisation souhaite mettre en œuvre un plan de reprise après sinistre pour ses charges de travail AWS critiques avec un RPO (objectif de point de reprise) de 5 minutes et un RTO (objectif de temps de reprise) d'une heure. Veuillez décrire les services AWS que vous utiliseriez pour atteindre ces objectifs. |

|

|

Protection contre les attaques DDoS |

Envisagez un scénario dans lequel vous devez concevoir une infrastructure d'application Web évolutive et sécurisée sur AWS. L'application doit être en mesure de gérer les pics soudains de trafic et de se protéger contre les attaques DDoS. Quels services et fonctionnalités AWS envisageriez-vous d'utiliser dans votre conception ? |

|

|

Analyse des données en temps réel |

Une start-up spécialisée dans l'Internet des objets souhaite traiter et analyser en temps réel les données provenant de milliers de capteurs répartis à travers le monde. La solution doit être hautement évolutive et rentable. Quels services AWS utiliseriez-vous pour développer cette plateforme et comment vous assureriez-vous qu'elle s'adapte à la demande ? |

|

|

Analyse de données volumineuses |

Une société de services financiers requiert une solution d'analyse de données sur AWS afin de traiter et d'analyser de grands volumes de données transactionnelles en temps réel. La solution doit également respecter des normes strictes en matière de sécurité et de conformité. Comment concevriez-vous cette solution à l'aide d'AWS, et quelles mesures mettriez-vous en place pour garantir la sécurité et la conformité ? |

|

Questions d'entretien non techniques sur AWS

Outre les compétences techniques, il est essentiel de comprendre l'impact global des solutions AWS pour réussir un entretien. Vous trouverez ci-dessous quelques questions, accompagnées de leurs réponses. Ces réponses peuvent varier d'un candidat à l'autre, en fonction de leur expérience et de leur parcours.

Comment vous tenez-vous informé des dernières tendances en matière d'AWS et de technologies cloud ?

- Attentes vis-à-vis du candidat : Le recruteur souhaite connaître votre engagement envers l'apprentissage continu et la manière dont vous maintenez vos compétences à jour. Ils recherchent des ressources ou des pratiques spécifiques qu'ils utilisent pour se tenir informés.

- Exemple de réponse : Je me tiens informé en consultant les blogs officiels d'AWS et en participant à des forums communautaires tels que le subreddit AWS. Je participe également à des rencontres et à des webinaires organisés par le groupe d'utilisateurs AWS local. Ces activités me permettent de rester informé des dernières fonctionnalités et meilleures pratiques AWS.

Veuillez décrire une situation où vous avez dû expliquer un concept AWS complexe à une personne sans connaissances techniques. Comment avez-vous procédé ?

- Attentes vis-à-vis du candidat : Cette question évalue vos compétences en communication et votre capacité à simplifier des informations complexes. L'intervieweur cherche à évaluer vos compétences pédagogiques et votre patience.

- Exemple de réponse : Dans le cadre de mes fonctions précédentes, j'ai dû expliquer les avantages du stockage dans le cloud à nos parties prenantes non techniciennes. J'ai utilisé l'analogie du stockage de fichiers dans un cloud drive par opposition à un disque dur physique, en mettant l'accent sur la facilité d'accès et la sécurité. Cela leur a permis de comprendre le concept sans entrer dans les détails techniques.

Qu'est-ce qui vous motive à travailler dans le secteur du cloud computing, et plus particulièrement chez AWS ?

- Attentes vis-à-vis du candidat : Le recruteur souhaite évaluer votre passion pour le domaine et comprendre ce qui vous motive. Ils recherchent des motivations sincères qui correspondent au poste et aux valeurs de l'entreprise.

- Exemple de réponse : Ce qui m'intéresse dans le cloud computing, en particulier AWS, c'est son pouvoir de transformation dans la croissance des entreprises et la stimulation de l'innovation. L'évolution constante des services AWS me motive à relever de nouveaux défis et à contribuer à des projets d'envergure.

Pourriez-vous décrire un projet ambitieux que vous avez géré et comment vous avez assuré son succès ?

- Attentes vis-à-vis du candidat : Ici, l'accent est mis sur vos compétences en gestion de projet et en résolution de problèmes. Le recruteur souhaite connaître votre approche pour surmonter les obstacles et mener à bien les projets.

- Exemple de réponse : Dans le cadre d'un projet précédent, nous avons rencontré des retards importants en raison de contraintes de ressources. J'ai classé les tâches par ordre de priorité en fonction de leur impact, négocié des ressources supplémentaires et maintenu une communication claire avec l'équipe et les parties prenantes. Cette approche nous a permis d'atteindre les étapes clés de notre projet et, au final, de le livrer dans les délais impartis.

Comment gérez-vous les délais serrés lorsque plusieurs projets requièrent votre attention ?

- Attentes vis-à-vis du candidat : Cette question évalue vos compétences en matière de gestion du temps et de hiérarchisation des priorités. Le recruteur souhaite comprendre comment vous gérez efficacement le stress et la charge de travail.

- Exemple de réponse : J'utilise une combinaison de hiérarchisation et de délégation. J'évalue l'urgence et l'impact de chaque projet, je les classe par ordre de priorité et je délègue les tâches lorsque cela est approprié. Je communique également régulièrement avec les parties prenantes au sujet des progrès réalisés et des ajustements nécessaires pour respecter les délais.

Selon vous, qu'est-ce qui distingue AWS des autres fournisseurs de services cloud ?

- Attentes vis-à-vis du candidat : Le recruteur souhaite évaluer votre compréhension de la proposition de valeur unique d'AWS. L'objectif est de s'assurer que vous comprenez bien ce qui fait d'AWS un leader dans le secteur du cloud.

- Exemple de réponse : AWS se distingue par son infrastructure mondiale étendue, qui offre une évolutivité et une fiabilité inégalées. De plus, l'engagement d'AWS en faveur de l'innovation, avec une gamme de services étendue et approfondie, permet d'offrir des solutions cloud plus flexibles et personnalisées que celles de ses concurrents.

Comment abordez-vous l'apprentissage des nouveaux outils ou services AWS lorsqu'ils sont lancés ?

- Attentes vis-à-vis du candidat: Cette question évalue votre capacité d'adaptation et votre style d'apprentissage. Le recruteur souhaite s'assurer que vous adoptez une approche proactive pour maîtriser les nouvelles technologies, ce qui est essentiel dans le domaine en constante évolution du cloud computing.

- Exemple de réponse: Lorsque AWS lance un nouveau service, je commence par examiner la documentation officielle et les notes de mise à jour afin de comprendre son objectif et ses fonctionnalités. Je me suis ensuite intéressé aux tutoriels pratiques et j'ai mené des expériences dans un environnement sandbox afin d'acquérir une expérience pratique. Dans la mesure du possible, je discute du service avec mes collègues ou participe à des forums pour observer comment d'autres personnes l'utilisent. Cette combinaison de théorie et de pratique me permet de me familiariser rapidement avec de nouveaux outils.

Veuillez décrire comment vous conciliez sécurité et efficacité lors de la conception de solutions AWS.

- Attentes vis-à-vis du candidat: L'intervieweur évalue votre capacité à réfléchir de manière stratégique à la sécurité tout en tenant compte des performances. L'objectif est de veiller à ce que vous puissiez trouver un équilibre entre les meilleures pratiques en matière de sécurité et la nécessité d'une efficacité opérationnelle.

- Exemple de réponse: Je suis convaincu que la sécurité et l'efficacité vont de pair. Lors de la conception de solutions AWS, je commence par adopter une approche axée sur la sécurité en mettant en œuvre des politiques IAM, l'isolation du réseau avec des VPC et le chiffrement des données. Pour garantir l'efficacité, je m'assure que ces pratiques de sécurité n'introduisent pas de latence inutile en optimisant les configurations et en choisissant des services évolutifs tels qu'AWS Lambda pour les tâches nécessitant une grande puissance de calcul. Mon approche consiste à développer des architectures sécurisées qui sont également réactives et rentables.

Conclusion

Cet article propose un guide complet des questions d'entretien AWS pour les candidats de différents niveaux d'expertise, depuis ceux qui commencent tout juste à explorer l'univers AWS jusqu'aux professionnels chevronnés qui cherchent à faire progresser leur carrière.

Que vous vous prépariez à votre premier entretien chez AWS ou que vous cherchiez à obtenir un poste plus élevé, ce guide constitue une ressource inestimable. Il vous prépare non seulement à répondre aux questions d'entretien, mais aussi à vous familiariser avec la plateforme AWS, en améliorant votre compréhension et votre utilisation de ses nombreuses fonctionnalités.

Obtenez une certification pour le poste de Data Engineer de vos rêves

Nos programmes de certification vous aident à vous démarquer et à prouver aux employeurs potentiels que vos compétences sont adaptées à l'emploi.

Questions fréquentes

Est-ce que j'ai besoin d'une certification AWS pour obtenir un poste dans le domaine du cloud ?

Bien qu'elles ne soient pas obligatoires, les certifications AWS telles que AWS Certified Solutions Architect Associate ou AWS Certified Developer Associate valident votre expertise et enrichissent votre CV. De nombreux employeurs accordent de l'importance aux certifications comme preuve de vos compétences, mais l'expérience pratique est tout aussi importante.

Quels sont les services AWS les plus importants à mettre en avant lors des entretiens ?

Les principaux services AWS dépendent du poste auquel vous postulez. Parmi les plus importants, on peut citer :

- Calculer : EC2, Lambda.

- Stockage : S3, EBS, Glacier.

- Réseautage : VPC, Route 53, ELB.

- Sécurité : IAM, KMS.

- Bases de données : RDS, DynamoDB.

- Outils DevOps : CloudFormation, CodePipeline.

Quelles compétences non techniques sont indispensables pour réussir un entretien chez AWS ?

Outre l'expertise technique, les employeurs évaluent souvent :

- Résolution de problèmes : Êtes-vous en mesure de concevoir des solutions évolutives et rentables ?

- Communication : Êtes-vous en mesure d'expliquer clairement les concepts techniques aux parties prenantes ?

- Gestion du temps : Comment établissez-vous les priorités parmi vos tâches et respectez-vous les délais dans des environnements dynamiques ?

- Travail d'équipe : Êtes-vous capable de collaborer efficacement au sein d'équipes interfonctionnelles ?

Que faire si je ne connais pas la réponse à une question technique lors d'un entretien chez AWS ?

Il est normal de ne pas tout savoir. Au lieu de deviner, soyez franc :

- Veuillez expliquer comment vous procéderiez pour trouver la réponse (par exemple, en consultant la documentation AWS ou en effectuant des tests).

- Mettez en avant les connaissances pertinentes qui démontrent votre compréhension du concept dans son ensemble.

Comment puis-je négocier mon salaire pour un poste lié à AWS ?

- Veuillez consulter les taux du marché pour votre poste et votre lieu de travail à l'aide de sites tels que Glassdoor ou Payscale.

- Mettez en avant vos certifications, votre expérience pertinente et vos projets lors des négociations.

- Veuillez démontrer comment vos compétences peuvent apporter une valeur ajoutée à l'entreprise, par exemple en permettant de réaliser des économies ou en améliorant la fiabilité des infrastructures.

Que dois-je faire après avoir échoué à un examen de certification AWS ou à un entretien ?

- Identifiez vos points faibles à l'aide des commentaires ou de votre rapport d'examen.

- Veuillez élaborer un plan d'étude ou d'entraînement pour renforcer ces domaines.

- Tirez parti de ressources supplémentaires, telles que des examens blancs ou des travaux pratiques.

- Ne vous découragez pas : de nombreux professionnels réussissent après leur deuxième ou troisième tentative.

Scientifique de données aux multiples talents qui aime partager ses connaissances et rendre service aux autres, Zoumana est un créateur de contenu sur YouTube et un rédacteur technique de premier plan sur Medium. Il prend plaisir à parler, à coder et à enseigner. Zoumana est titulaire de deux masters. Le premier en informatique avec une spécialisation en apprentissage automatique à Paris, en France, et le second en science des données à l'université Texas Tech aux États-Unis. Son parcours professionnel a débuté en tant que développeur de logiciels au sein du Groupe OPEN en France, avant de rejoindre IBM en tant que consultant en apprentissage automatique, où il a développé des solutions d'IA de bout en bout pour les compagnies d'assurance. Zoumana a rejoint Axionable, la première startup d'IA durable basée à Paris et Montréal. Il y a occupé le poste de Data Scientist et a mis en œuvre des produits d'IA, principalement des cas d'utilisation NLP, pour des clients en France, à Montréal, à Singapour et en Suisse. En outre, 5 % de son temps a été consacré à la recherche et au développement. Il travaille actuellement en tant que scientifique de données senior à l'IFC, le groupe de la Banque mondiale.