programa

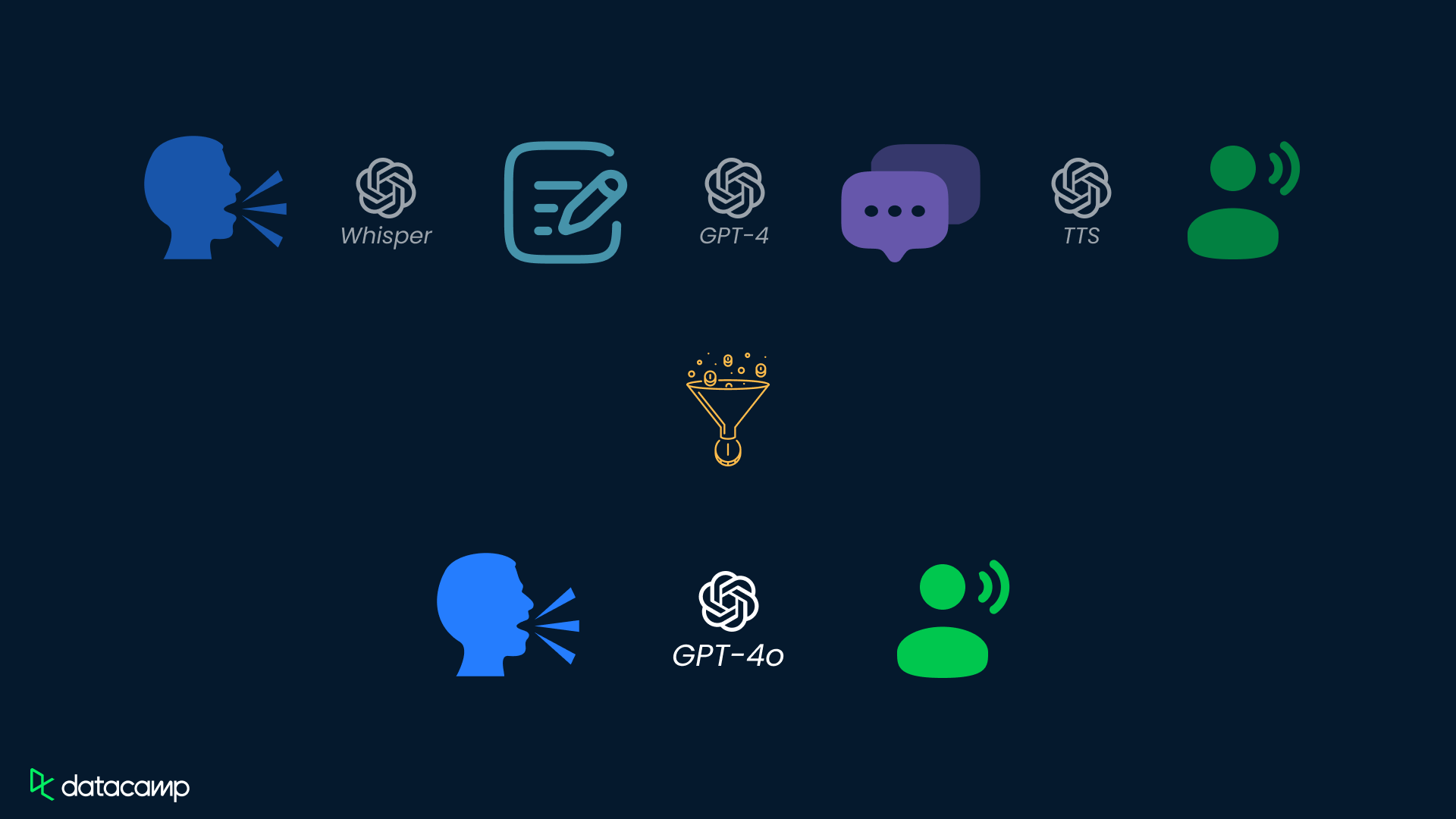

El GPT-4o de OpenAI integra capacidades de audio, visión y texto en un único y potente modelo lingüístico.

Este avance supone un paso importante hacia una interacción más natural e intuitiva entre los seres humanos y los ordenadores.

En este tutorial, te proporcionaré una guía paso a paso sobre cómo utilizar GPT-4o a través de la API de OpenAI.

Aunque OpenAI ha lanzado recientemente el modelo o3, su modelode razonamiento más capaz, GPT-4o y GPT-4o mini siguen siendo las mejores opciones para aplicaciones que requieren respuestas rápidas, manejo de imágenes o llamadas a funciones. Si tu proyecto requiere un razonamiento avanzado, no te pierdas este tutorial sobre la API O1 de OpenAI, que te guiará a través del proceso de uso de un modelo de razonamiento a través de la API.

¿Qué es GPT-4o?

GPT-4o, abreviatura de «omni», representa un avance significativo en la IA. A diferencia de GPT-4, que solo maneja texto, GPT-4o es un modelo multimodal que procesa y genera texto, audio y datos visuales.

Al incorporar datos audiovisuales junto con el texto, GPT-4o se libera de las limitaciones de los modelos tradicionales basados únicamente en texto, creando interacciones más naturales e intuitivas.

GPT-4o tiene un tiempo de respuesta más rápido, es un 50 % más barato que GPT-4 Turbo y es mejor en la comprensión de audio y visión que los modelos existentes.

Si deseas obtener una descripción más detallada de GPT-4o, consulta este artículo sobre ¿Qué es GPT-4o de OpenAI?

Casos de uso de GPT-4o

Además de interactuar con GPT-4o a través de la interfaz ChatGPT, los programadores pueden interactuar con GPT-4o a través de la API de OpenAI, lo que les permite integrar las capacidades de GPT-4o en vuestras aplicaciones y sistemas.

La API GPT-4o abre un amplio arreglo de posibles casos de uso gracias a sus capacidades multimodales:

Modalidad | Casos de uso | Descripción |

Texto | Generación de texto, resumen de texto, análisis de datos y codificación | Creación de contenido, resúmenes concisos, explicaciones de código y asistencia en la codificación. |

Audio | Transcripción de audio, traducción en tiempo real, generación de audio | Convierte audio a texto, traduce en tiempo real, crea asistentes virtuales o aprende idiomas. |

Visión | Subtitulado de imágenes, análisis y lógica de imágenes, accesibilidad para personas con discapacidad visual | Describe imágenes, analiza información visual y proporciona accesibilidad a personas con discapacidad visual. |

Multi | Interacciones multimodales, escenarios de juego de roles | Combina modalidades a la perfección y crea experiencias inmersivas. |

GPT-4o API: Cómo conectarse a la API de OpenAI

Ahora exploremos cómo utilizar GPT-4o a través de la API de OpenAI.

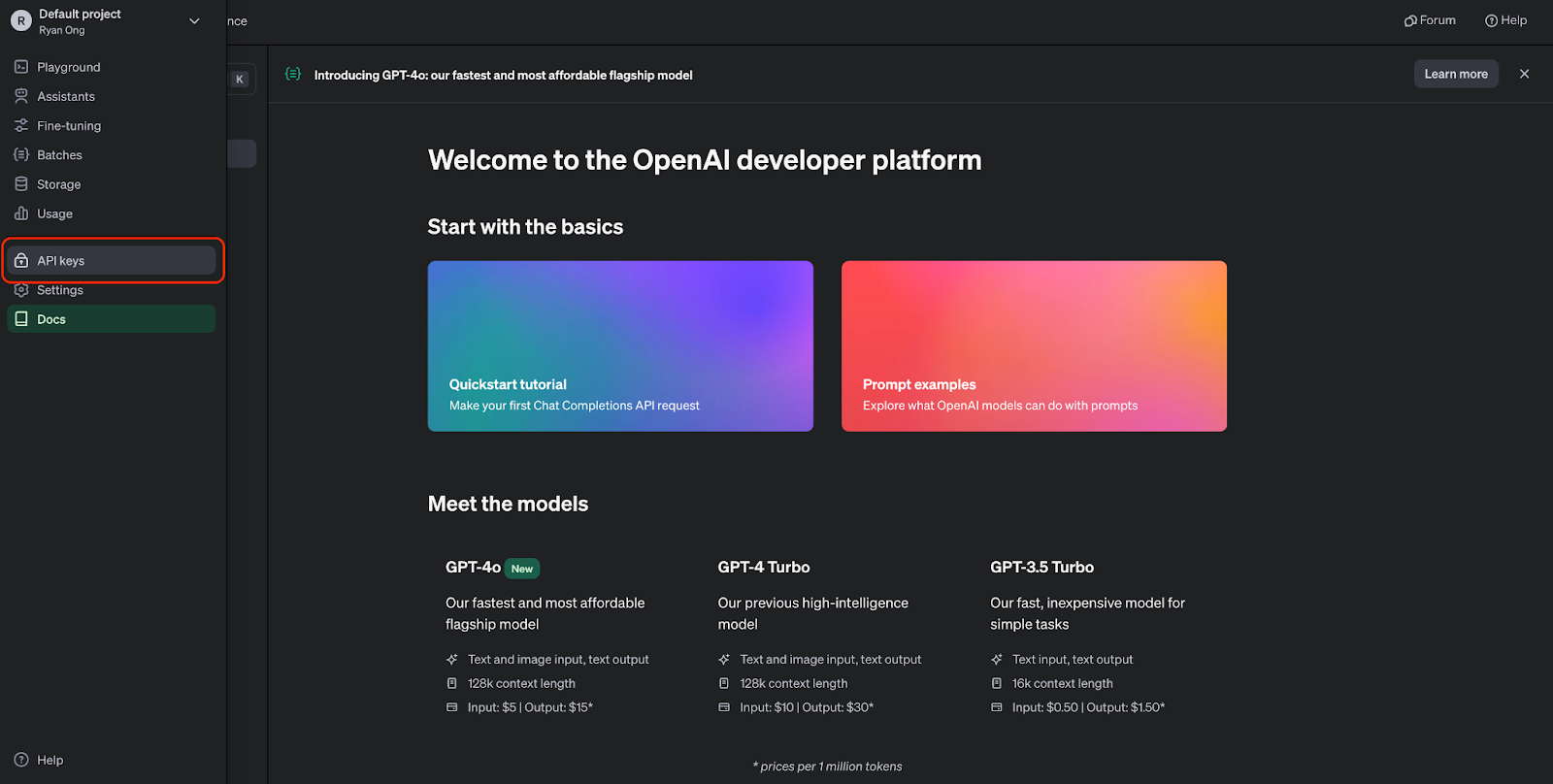

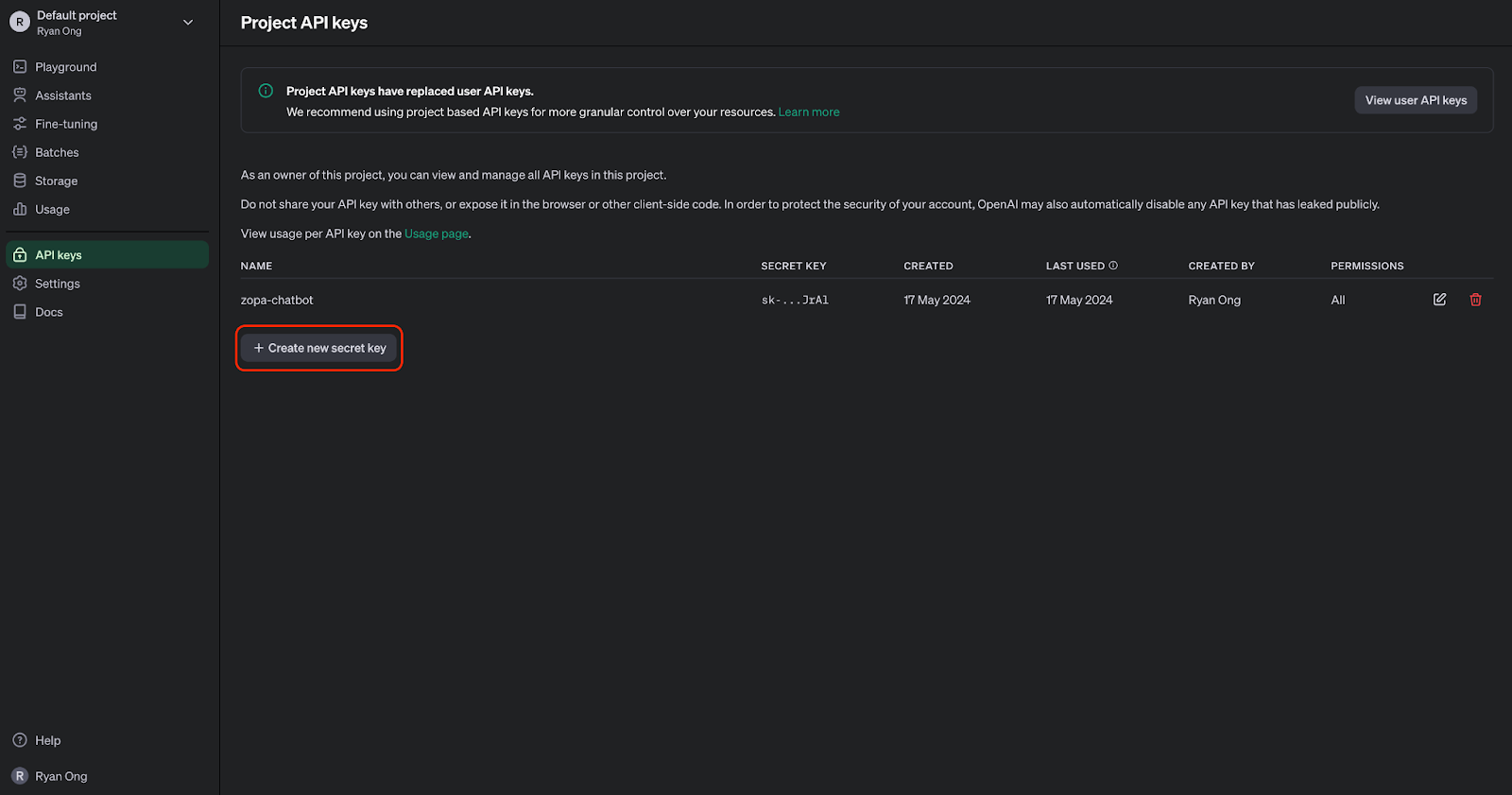

Paso 1: Generar una clave API

Antes de utilizar la API GPT-4o, debemos registrarte en OpenAI y obtener una clave API. Podemos crear una cuenta en el sitio web de OpenAI API.

Una vez que tengas una cuenta, puedes navegar a la página de claves API:

Ahora podemos generar una clave API. Tenemos que guardarlo bien, ya que no podremos volver a verlo. Pero siempre podemos generar uno nuevo si lo perdemos o necesitamos uno para un proyecto diferente.

Paso 2: Importa la API de OpenAI a Python

Para interactuar con la API de GPT-4o mediante programación, necesitaremos instalar la biblioteca Python de OpenAI. Podemos hacerlo ejecutando el siguiente comando:

Una vez instalado, podemos importar los módulos necesarios a nuestro script de Python:

from openai import OpenAIPaso 3: Realizar una llamada API

Antes de poder realizar solicitudes API, tendremos que autenticarnos con nuestra clave API:

# Set the API keyclient = OpenAI(api_key="your_api_key_here")Reemplaza "your_api_key_here" por tu clave API real.

Una vez completada la conexión con el cliente, podemos empezar a generar texto utilizando GPT-4o:

MODEL = "gpt-4o"completion = client.chat.completions.create( model=MODEL, messages=[ {"role": "system", "content": "You are a helpful assistant that helps me with my math homework!"}, {"role": "user", "content": "Hello! Could you solve 20 x 5?"} ])print("Assistant: " + completion.choices[0].message.content)Este fragmento de código utiliza la API de autocompletado de chat con el modelo GPT-4o, que acepta preguntas relacionadas con las matemáticas como entrada y genera una respuesta:

GPT-4o API: Casos de uso de audio

La transcripción y el resumen de audio se han convertido en herramientas esenciales en diversas aplicaciones, desde la mejora de la accesibilidad hasta el aumento de la productividad. Con la API GPT-4o, podemos gestionar de forma eficiente tareas como la transcripción y el resumen de contenido de audio.

Aunque GPT-4o tiene el potencial de manejar audio directamente, la función de entrada de audio directa aún no está disponible a través de la API. Por ahora, podemos utilizar un proceso de dos pasos con la API GPT-4o para transcribir y luego resumir el contenido de audio.

Paso 1: Transcribir audio a texto

Para transcribir un archivo de audio con GPT-4o, debemos proporcionar los datos de audio a la API. Aquí tienes un ejemplo:

# Transcribe the audioaudio_path = "path/to/audio.mp3"transcription = client.audio.transcriptions.create( model="whisper-1", file=open(audio_path, "rb"),)Reemplaza "path/to/audio.mp3" por la ruta real de tu archivo de audio. Este ejemplo utiliza el modelo de transcripción « whisper-1 » (palabra, frase, oración, párrafo, párrafo, oración, frase

Paso 2: Resume el texto del audio.

response = client.chat.completions.create( model=MODEL, messages=[ { "role": "system", "content": """You are generating a transcript summary. Create a summary of the provided transcription. Respond in Markdown.""" }, { "role": "user", "content": [ {"type": "text", "text": f"The audio transcription is: {transcription.text}"} ], } ], temperature=0,)print(response.choices[0].message.content)GPT-4o API: Casos de uso de la visión

El análisis visual de datos es fundamental en diversos ámbitos, desde la sanidad hasta la seguridad, entre otros. Con la API GPT-4o, puedes analizar imágenes a la perfección, participar en conversaciones sobre contenido visual y extraer información valiosa de las imágenes.

Paso 1: Añadir datos de imagen a la API

Para analizar una imagen con GPT-4o, primero debemos proporcionar los datos de la imagen a la API. Podemos hacerlo codificando una imagen local como una cadena base64 o proporcionando una URL a una imagen en línea:

import base64IMAGE_PATH = "image_path"# Open the image file and encode it as a base64 stringdef encode_image(image_path): with open(image_path, "rb") as image_file: return base64.b64encode(image_file.read()).decode("utf-8")base64_image = encode_image(IMAGE_PATH) "url": "<https://images.saymedia-content.com/.image/c_limit%2Ccs_srgb%2Cq_auto:eco%2Cw_538/MTczOTQ5NDQyMzQ3NTc0NTc5/compound-shapes-how-to-find-the-area-of-a-l-shape.webp>"Paso 2: Analiza los datos de la imagen.

Una vez procesada la imagen introducida, podemos pasar los datos de la imagen a la API para su análisis.

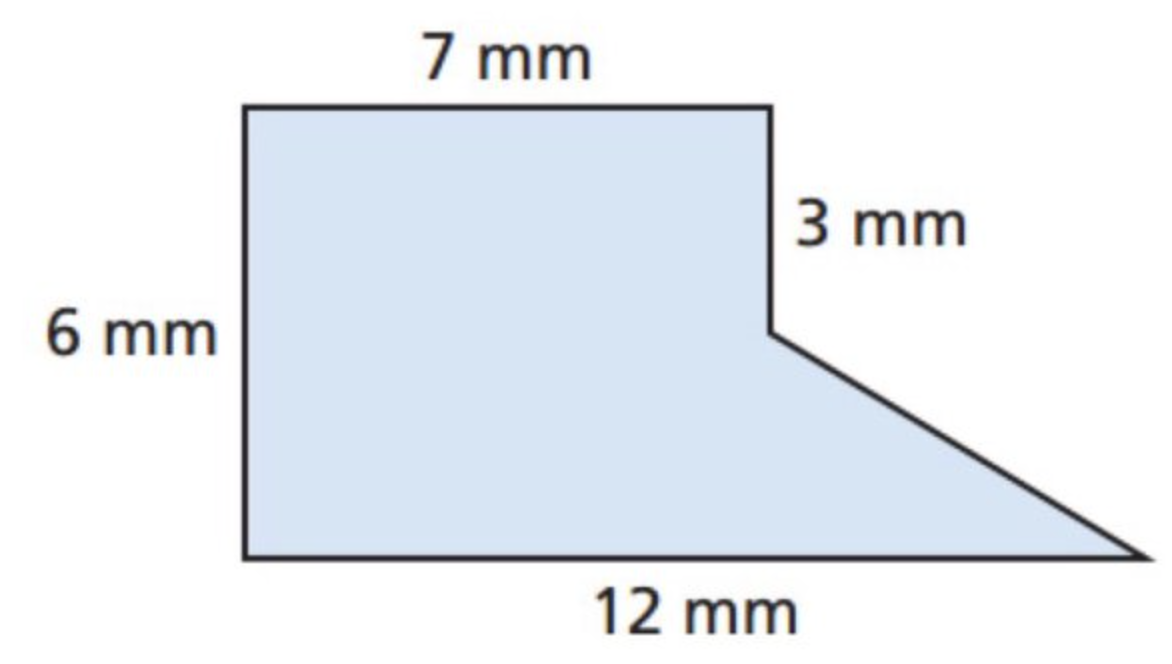

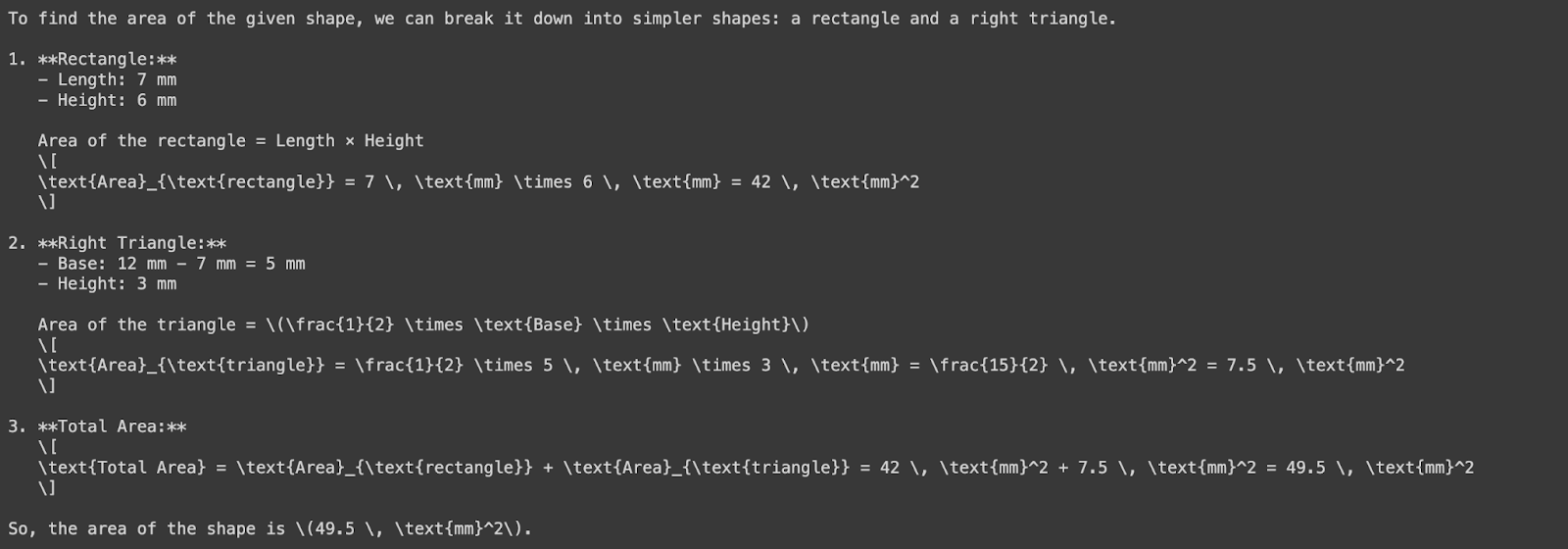

Intentemos analizar una imagen para determinar el área de una forma. Primero, utilicemos la imagen siguiente:

Ahora le pediremos a GPT-4o que calcule el área de esta forma. Observa que estamos utilizando una imagen en formato base64 como entrada:

response = client.chat.completions.create( model=MODEL, messages=[ { "role": "system", "content": "You are a helpful assistant that responds in Markdown. Help me with my math homework!" }, { "role": "user", "content": [ {"type": "text", "text": "What's the area of the shape in this image?"}, { "type": "image_url", "image_url": { "url": f"data:image/png;base64,{base64_image}" } } ] } ], temperature=0.0,)print(response.choices[0].message.content)

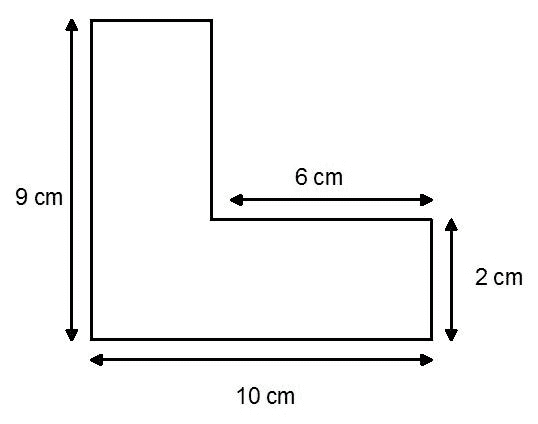

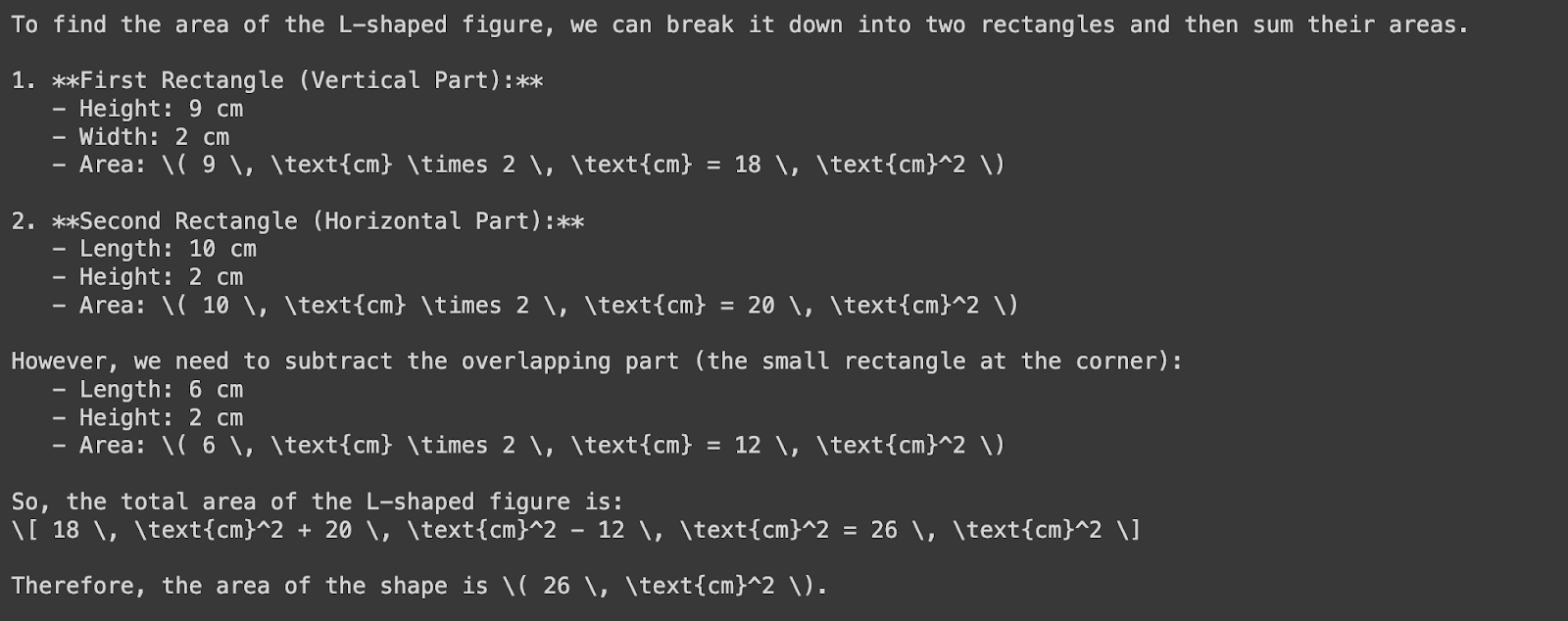

Consideremos ahora esta forma:

Pasaremos la URL de la imagen a GPT-4o para encontrar el área de la forma:

response = client.chat.completions.create( model=MODEL, messages=[ { "role": "system", "content": "You are a helpful assistant that responds in Markdown. Help me with my math homework!" }, { "role": "user", "content": [ {"type": "text", "text": "What's the area of the shape in the image?"}, { "type": "image_url", "image_url": { "url": "https://images.saymedia-content.com/.image/c_limit%2Ccs_srgb%2Cq_auto:eco%2Cw_538/MTczOTQ5NDQyMzQ3NTc0NTc5/compound-shapes-how-to-find-the-area-of-a-l-shape.webp" } } ] } ], temperature=0.0,)print(response.choices[0].message.content)

Observa que GPT-4o midió incorrectamente el ancho del rectángulo vertical: debería ser cuatro centímetros, no dos. Esta discrepancia se debe a la desalineación entre las etiquetas de medición y las proporciones reales del rectángulo. En todo caso, esto pone de relieve una vez más la importancia de la supervisión y la validación humanas.

Precios de la API GPT-4o

A partir de julio de 2025, el precio de pago por uso de GPT-4o será el siguiente:

Tokens de entrada: 5,00 $ por cada millón de tokens

Tokens de entrada almacenados en caché: 2,50 $ por cada millón de tokens

Tokens de salida: 20,00 $ por cada millón de tokens

GPT-4o Mini: Una alternativa rentable

Para aplicaciones que requieren llamadas API de gran volumen, OpenAI ofrece GPT-4o Mini, una versión optimizada de GPT-4o:

Tokens de entrada: 0,60 $ por cada millón de tokens

Tokens de entrada almacenados en caché: 0,30 $ por millón de tokens

Tokens de salida: 2,40 $ por millón de tokens

Descuentos por API por lotes

La API por lotes de OpenAI ofrece un descuento del 50 % en los costes de tokens de entrada y salida para GPT-4o:

Tokens de entrada: 2,50 $ por cada millón de tokens

Tokens de salida: 10,00 $ por cada millón de tokens

Esto es ideal para procesar grandes volúmenes de datos de forma asíncrona.

GPT-4o API: Consideraciones clave

Al trabajar con la API de GPT-4o, es importante tener en cuenta algunas consideraciones clave para garantizar un rendimiento óptimo, la rentabilidad y la alineación con cada caso de uso específico. Aquí hay tres factores cruciales a tener en cuenta:

Gestión de precios y costes

La API de OpenAI sigue un modelo de pago por uso, en el que los costes se incurren en función del número de tokens procesados.

Aunque GPT-4o es más barato que GPT-4 Turbo, planificar tu uso en consecuencia es fundamental para estimar y gestionar los costes.

Para minimizar los costes, puedes considerar técnicas como la agrupación y la optimización de las solicitudes para reducir el número de llamadas a la API y los tokens procesados.

Latencia y rendimiento

Aunque GPT-4o ofrece un rendimiento impresionante y una baja latencia, sigue siendo un modelo de lenguaje grande, lo que significa que el procesamiento de las solicitudes puede requerir un gran esfuerzo computacional, lo que da lugar a una latencia relativamente alta.

Necesitamos optimizar nuestro código y utilizar técnicas como el almacenamiento en caché y el procesamiento asíncrono para mitigar los problemas de latencia.

Además, podemos explorar el uso de instancias dedicadas de OpenAI o ajustar el modelo a vuestro caso de uso específico, lo que puede mejorar el rendimiento y reducir la latencia.

Alineación de casos de uso

GPT-4o es un potente modelo general con una amplia gama de capacidades, pero debemos asegurarnos de que vuestro caso de uso específico se ajusta a los puntos fuertes del modelo.

Antes de confiar únicamente en GPT-4o, debemos evaluar cuidadosamente nuestro caso de uso y considerar si las capacidades del modelo se ajustan a nuestras necesidades.

Si fuera necesario, podríamos ajustar modelos más pequeños o explorar otros modelos que puedan ser más adecuados para nuestra tarea concreta.

Conclusión

Las capacidades multimodales de GPT-4 superan las limitaciones de los modelos anteriores, que tenían dificultades para integrar y procesar diferentes tipos de datos de forma fluida.

Al aprovechar la API GPT-4o, los programadores pueden crear soluciones innovadoras que integran a la perfección datos de texto, audio y visuales.

Si deseas practicar más con GPT-4o, te recomiendo este código para crear asistentes de IA con GPT-4o. Del mismo modo, si deseas obtener más información sobre cómo trabajar con API, te recomiendo estos recursos:

Preguntas frecuentes

¿Qué es GPT-4o y en qué se diferencia de los modelos anteriores?

GPT-4o es un modelo de lenguaje multimodal desarrollado por OpenAI, capaz de procesar y generar datos de texto, audio y visuales. A diferencia de modelos anteriores como GPT-4, que solo manejaban texto, GPT-4o integra información auditiva y visual, lo que permite interacciones más naturales y capacidades mejoradas en todas las modalidades.

¿Cómo pueden los programadores acceder a GPT-4o a través de la API de OpenAI?

Los programadores pueden acceder a GPT-4o a través de la API de OpenAI registrándote para obtener una cuenta de OpenAI, obteniendo una clave API e instalando la biblioteca Python de OpenAI.

¿Cuáles son los costes de utilizar la API GPT-4o y cómo se compara con otros modelos?

La API GPT-4o sigue un modelo de pago por uso, en el que los costes se calculan en función del número de tokens procesados. En comparación con modelos anteriores como GPT-4, GPT-4o ofrece una reducción del 50 % en los costes, lo que lo hace más asequible. En el artículo se incluye una comparación de precios con otros modelos.

¿Se puede ajustar GPT-4o para casos de uso o sectores específicos?

Sí, GPT-4o se puede ajustar para casos de uso o sectores específicos mediante técnicas como el aprendizaje por transferencia. Mediante el ajuste fino de datos o tareas específicos del dominio, los programadores pueden mejorar el rendimiento del modelo y adaptarlo a vuestros requisitos únicos.

¿Qué recursos hay disponibles para seguir aprendiendo y aplicando la API GPT-4o?

Hay varios recursos disponibles, como tutoriales, cursos y ejemplos prácticos, para seguir aprendiendo y aplicando la API GPT-4o. El artículo recomienda explorar el curso Working with the OpenAI API (Trabajar con la API de OpenAI) de DataCamp, el OpenAI Cookbook (Libro de recetas de OpenAI) y la hoja de referencia rápida de DataCamp para obtener información rápida y orientación práctica sobre la implementación.

¿Cuándo debo usar GPT-4o en lugar de GPT-4o-mini?

GPT-4o es ideal para casos de uso más complejos que requieren un análisis en profundidad, comprensión del lenguaje o interacciones más largas. Por otro lado, GPT-4o-mini es más rápido y rentable, lo que lo hace más adecuado para tareas ligeras o cuando se necesita una respuesta rápida. Ambos modelos ofrecen capacidades multimodales, pero GPT-4o destaca cuando se requiere un razonamiento más avanzado y una mayor interacción entre modalidades.

¿En qué se diferencia la API GPT-4o de la API o1 en casos de uso específicos?

Mientras que GPT-4o es excelente para tareas que implican datos multimodales (texto, audio e imágenes), la API o1 destaca en tareas complejas de razonamiento y resolución de problemas, especialmente en ciencias, codificación y matemáticas. Si necesitas respuestas rápidas con un razonamiento moderado, GPT-4o es tu mejor opción. Sin embargo, para tareas que requieren un análisis lógico profundo y precisión, como generar código complejo o resolver problemas matemáticos avanzados, la API o1 ofrece capacidades más potentes.

Introducción a los agentes de IA

Ryan es un científico de datos líder especializado en la creación de aplicaciones de IA utilizando LLMs. Es candidato al doctorado en Procesamiento del Lenguaje Natural y Grafos de Conocimiento en el Imperial College de Londres, donde también completó su máster en Informática. Fuera de la ciencia de datos, escribe un boletín semanal de Substack, The Limitless Playbook, donde comparte una idea procesable de los mejores pensadores del mundo y ocasionalmente escribe sobre conceptos básicos de la IA.