Cursus

Le GPT-4o d'OpenAI intègre des capacités audio, visuelles et textuelles dans un modèle linguistique unique et puissant.

Cette avancée marque une étape importante vers une interaction homme-machine plus naturelle et intuitive.

Dans ce tutoriel, je vais vous expliquer étape par étape comment utiliser GPT-4o via l'API OpenAI.

Même si OpenAI a récemment publié le modèle o3, son modèlede raisonnement le plus performant, GPT-4o et GPT-4o mini restent les meilleures options pour les applications qui nécessitent des réponses rapides, le traitement d'images ou l'appel de fonctions. Si votre projet nécessite un raisonnement avancé, nous vous recommandons de consulter ce tutoriel sur l'API OpenAI O1, qui vous guidera tout au long du processus d'utilisation d'un modèle de raisonnement via l'API.

Qu'est-ce que le GPT-4o ?

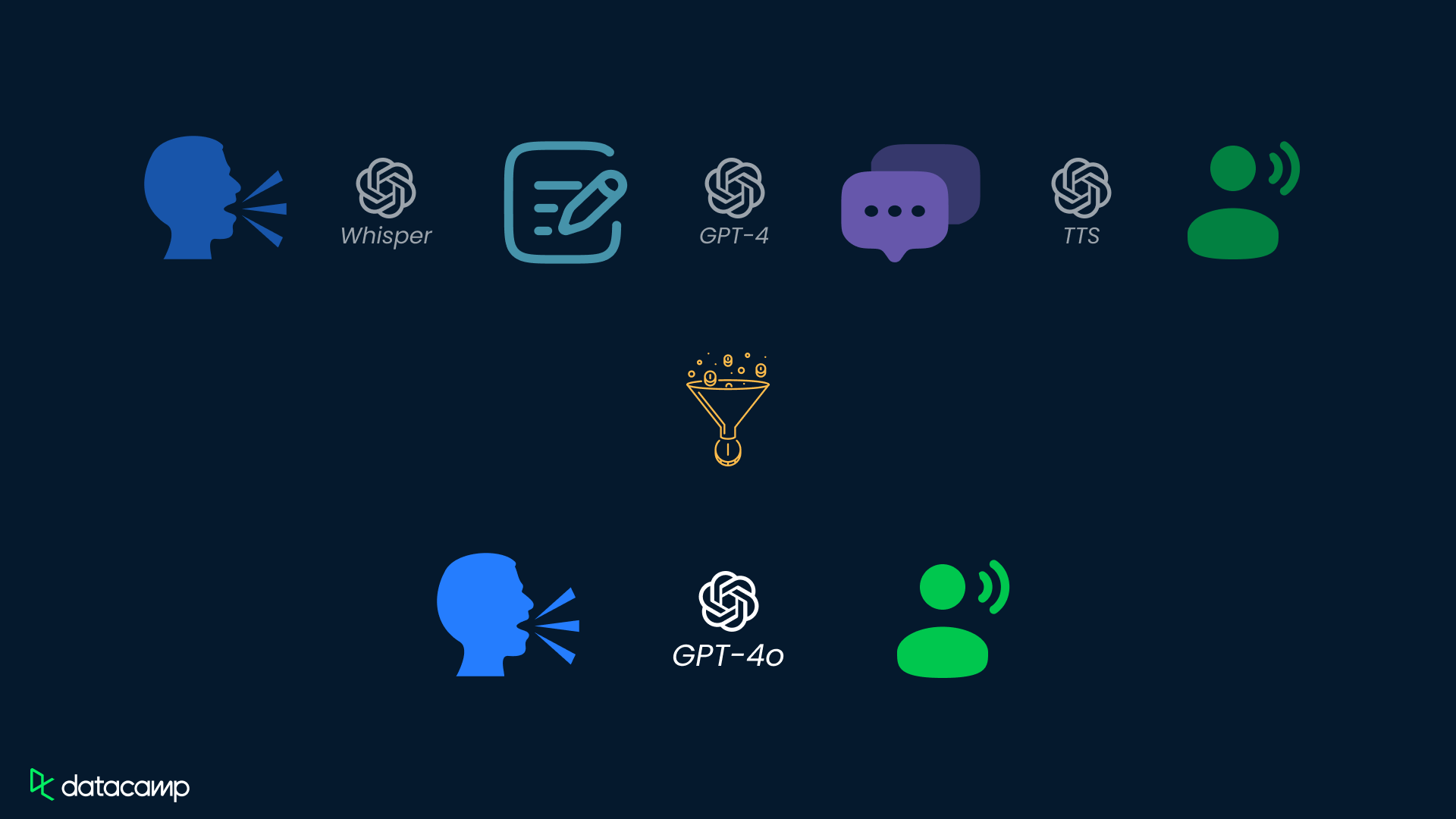

GPT-4o, abréviation de « omni », représente une avancée significative dans le domaine de l'IA. Contrairement à GPT-4, qui ne traite que du texte, GPT-4o est un modèle multimodal qui traite et génère des données textuelles, audio et visuelles.

En intégrant des données audio et visuelles au texte, GPT-4o s'affranchit des contraintes des modèles traditionnels basés uniquement sur le texte, créant ainsi des interactions plus naturelles et intuitives.

GPT-4o offre un temps de réponse plus rapide, est 50 % moins cher que GPT-4 Turbo et est plus performant que les modèles existants en matière de compréhension audio et visuelle.

Si vous souhaitez obtenir un aperçu plus détaillé de GPT-4o, veuillez consulter cet article intitulé « Qu'est-ce que GPT-4o d'OpenAI ? ».

Cas d'utilisation de GPT-4o

En plus d'interagir avec GPT-4o via l'interface ChatGPT, les développeurs peuvent interagir avec GPT-4o via l'API OpenAI, ce qui leur permet d'intégrer les capacités de GPT-4o dans leurs applications et leurs systèmes.

L'API GPT-4o ouvre la voie à une multitude de cas d'utilisation potentiels grâce à ses capacités multimodales :

Modalité | Cas d'utilisation | Description |

Text | Génération de texte, résumé de texte, analyse de données et codage | Création de contenu, résumés concis, explications de code et assistance au codage. |

Audio | Transcription audio, traduction en temps réel, génération audio | Convertissez l'audio en texte, traduisez en temps réel, créez des assistants virtuels ou apprenez des langues. |

Vision | Légendes d'images, analyse et logique des images, accessibilité pour les personnes malvoyantes | Décrire des images, analyser des informations visuelles, assurer l'accessibilité aux personnes malvoyantes. |

Multi | Interactions multimodales, scénarios de jeux de rôle | Combinez harmonieusement différentes modalités et créez des expériences immersives. |

API GPT-4o : Comment se connecter à l'API d'OpenAI

Explorons maintenant comment utiliser GPT-4o via l'API OpenAI.

Étape 1 : Générer une clé API

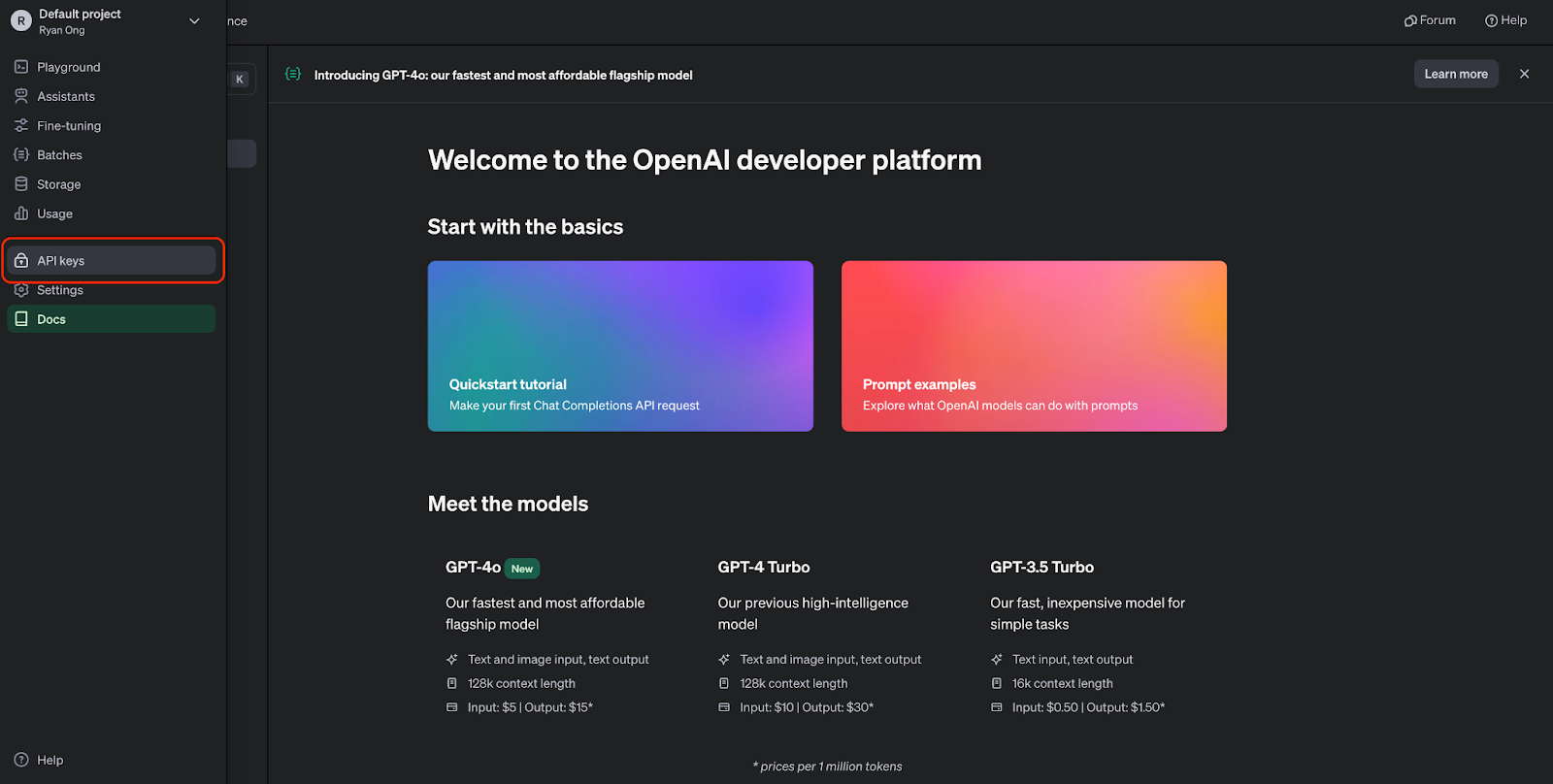

Avant d'utiliser l'API GPT-4o, il est nécessaire de créer un compte OpenAI et d'obtenir une clé API. Nous pouvons créer un compte sur le site web de l'API OpenAI.

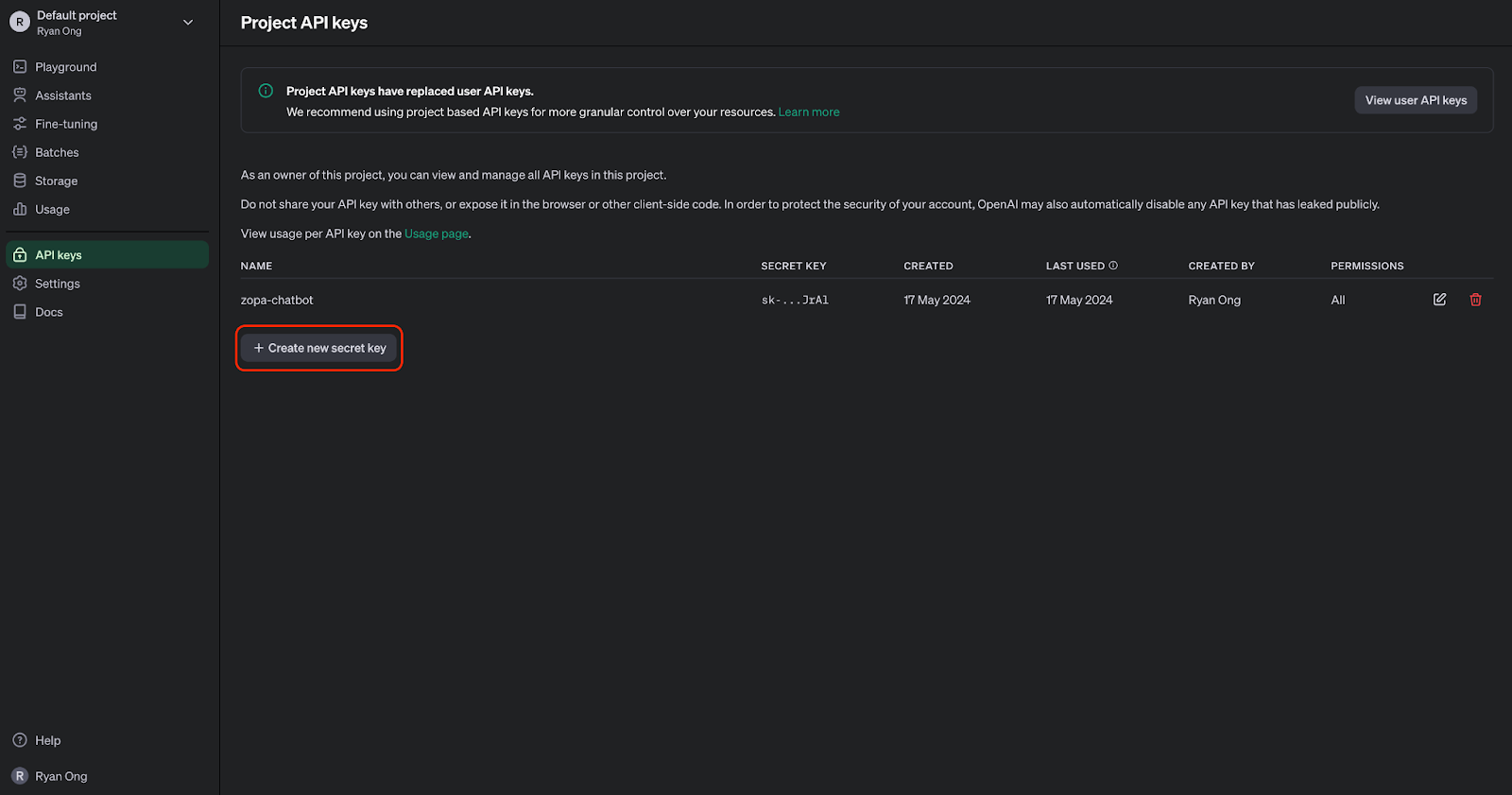

Une fois le compte créé, nous pouvons accéder à la page des clés API :

Nous pouvons maintenant générer une clé API. Nous devons le conserver en lieu sûr, car nous ne pourrons plus le consulter. Cependant, nous pouvons toujours en générer un nouveau si nous le perdons ou si nous en avons besoin pour un autre projet.

Étape 2 : Importez l'API OpenAI dans Python

Pour interagir avec l'API GPT-4o par programmation, nous devons installer la bibliothèque Python OpenAI. Pour ce faire, veuillez exécuter la commande suivante :

Une fois installé, nous pouvons importer les modules nécessaires dans notre script Python :

from openai import OpenAIÉtape 3 : Effectuer un appel API

Avant de pouvoir effectuer des requêtes API, nous devons nous authentifier à l'aide de notre clé API :

# Set the API keyclient = OpenAI(api_key="your_api_key_here")Veuillez remplacer « "your_api_key_here" » par votre clé API réelle.

Une fois la connexion client établie, nous pouvons commencer à générer du texte à l'aide de GPT-4o :

MODEL = "gpt-4o"completion = client.chat.completions.create( model=MODEL, messages=[ {"role": "system", "content": "You are a helpful assistant that helps me with my math homework!"}, {"role": "user", "content": "Hello! Could you solve 20 x 5?"} ])print("Assistant: " + completion.choices[0].message.content)Cet extrait de code utilise l'API de complétion de chat avec le modèle GPT-4o, qui accepte les questions mathématiques en entrée et génère une réponse :

API GPT-4o : Cas d'utilisation audio

La transcription et le résumé audio sont devenus des outils indispensables dans diverses applications, qu'il s'agisse d'améliorer l'accessibilité ou d'accroître la productivité. Grâce à l'API GPT-4o, nous sommes en mesure de traiter efficacement des tâches telles que la transcription et le résumé de contenus audio.

Bien que GPT-4o soit capable de traiter directement l'audio, la fonctionnalité d'entrée audio directe n'est pas encore disponible via l'API. Pour l'instant, nous pouvons utiliser un processus en deux étapes avec l'API GPT-4o pour transcrire puis résumer le contenu audio.

Étape 1 : Transcrire un fichier audio en texte

Pour transcrire un fichier audio à l'aide de GPT-4o, il est nécessaire de fournir les données audio à l'API. Voici un exemple :

# Transcribe the audioaudio_path = "path/to/audio.mp3"transcription = client.audio.transcriptions.create( model="whisper-1", file=open(audio_path, "rb"),)Veuillez remplacer « "path/to/audio.mp3" » par le chemin d'accès réel de votre fichier audio. Cet exemple utilise le modèle de transcription « whisper-1 ».

Étape 2 : Résumez un texte audio

response = client.chat.completions.create( model=MODEL, messages=[ { "role": "system", "content": """You are generating a transcript summary. Create a summary of the provided transcription. Respond in Markdown.""" }, { "role": "user", "content": [ {"type": "text", "text": f"The audio transcription is: {transcription.text}"} ], } ], temperature=0,)print(response.choices[0].message.content)API GPT-4o : Cas d'utilisation de la vision

L'analyse visuelle des données est essentielle dans divers domaines, allant des soins de santé à la sécurité, et bien plus encore. Grâce à l'API GPT-4o, vous pouvez analyser des images de manière transparente, engager des conversations sur du contenu visuel et extraire des informations précieuses des images.

Étape 1 : Ajouter des données d'image à l'API

Pour analyser une image à l'aide de GPT-4o, il est nécessaire de fournir les données de l'image à l'API. Pour ce faire, nous pouvons soit encoder une image locale sous forme de chaîne de caractères base64, soit fournir une URL vers une image en ligne :

import base64IMAGE_PATH = "image_path"# Open the image file and encode it as a base64 stringdef encode_image(image_path): with open(image_path, "rb") as image_file: return base64.b64encode(image_file.read()).decode("utf-8")base64_image = encode_image(IMAGE_PATH) "url": "<https://images.saymedia-content.com/.image/c_limit%2Ccs_srgb%2Cq_auto:eco%2Cw_538/MTczOTQ5NDQyMzQ3NTc0NTc5/compound-shapes-how-to-find-the-area-of-a-l-shape.webp>"Étape 2 : Analysez les données de l'image.

Une fois l'image traitée, nous pouvons transmettre les données à l'API pour analyse.

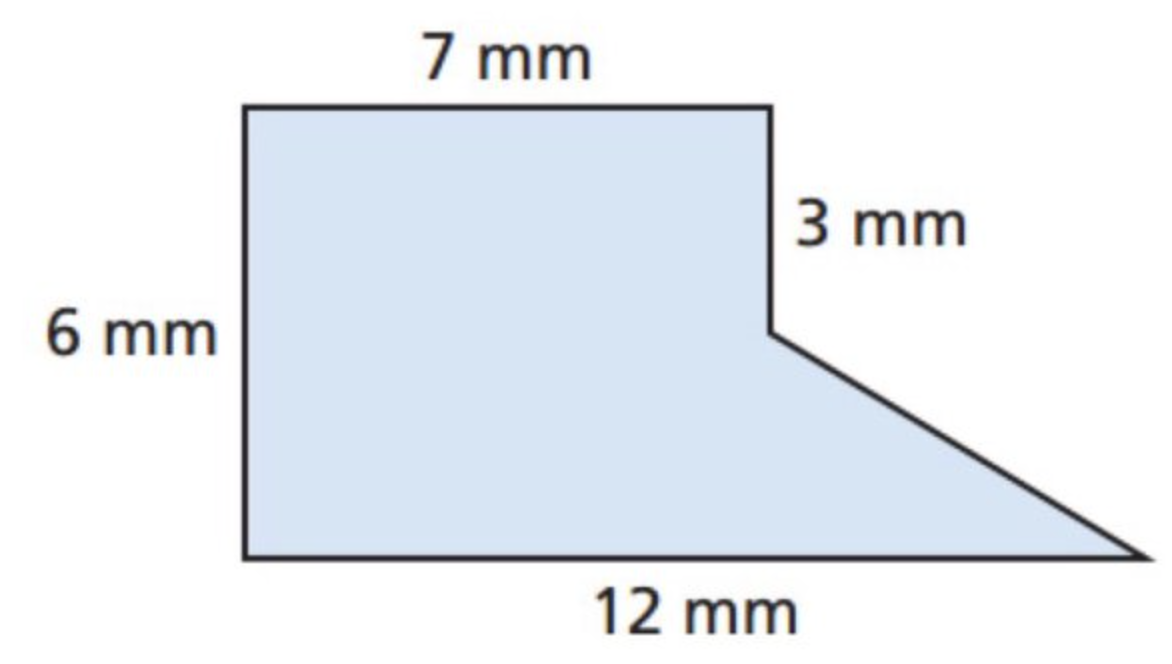

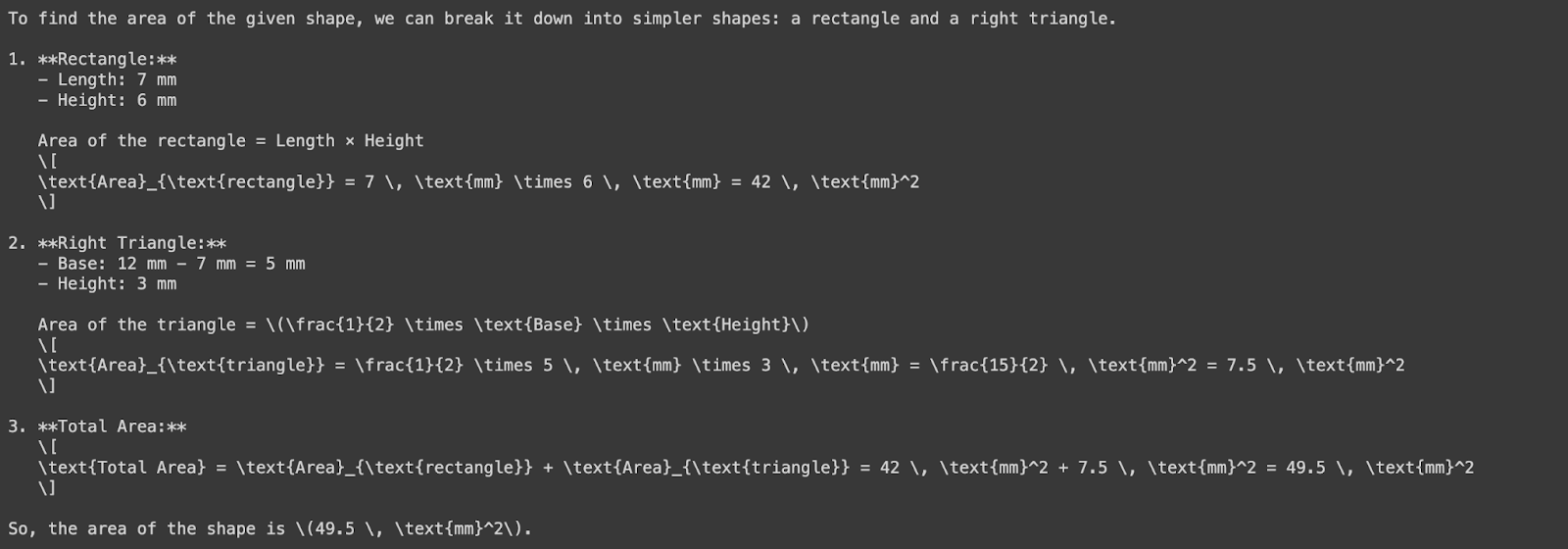

Essayons d'analyser une image afin de déterminer la surface d'une forme. Commençons par l'image ci-dessous :

Nous allons maintenant demander à GPT-4o de calculer l'aire de cette forme. Veuillez noter que nous utilisons une image au format base64 comme entrée ci-dessous :

response = client.chat.completions.create( model=MODEL, messages=[ { "role": "system", "content": "You are a helpful assistant that responds in Markdown. Help me with my math homework!" }, { "role": "user", "content": [ {"type": "text", "text": "What's the area of the shape in this image?"}, { "type": "image_url", "image_url": { "url": f"data:image/png;base64,{base64_image}" } } ] } ], temperature=0.0,)print(response.choices[0].message.content)

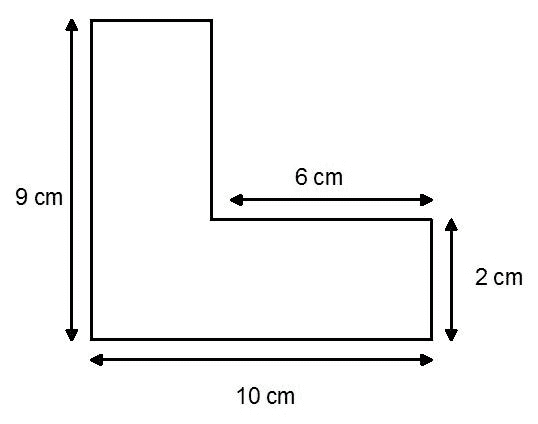

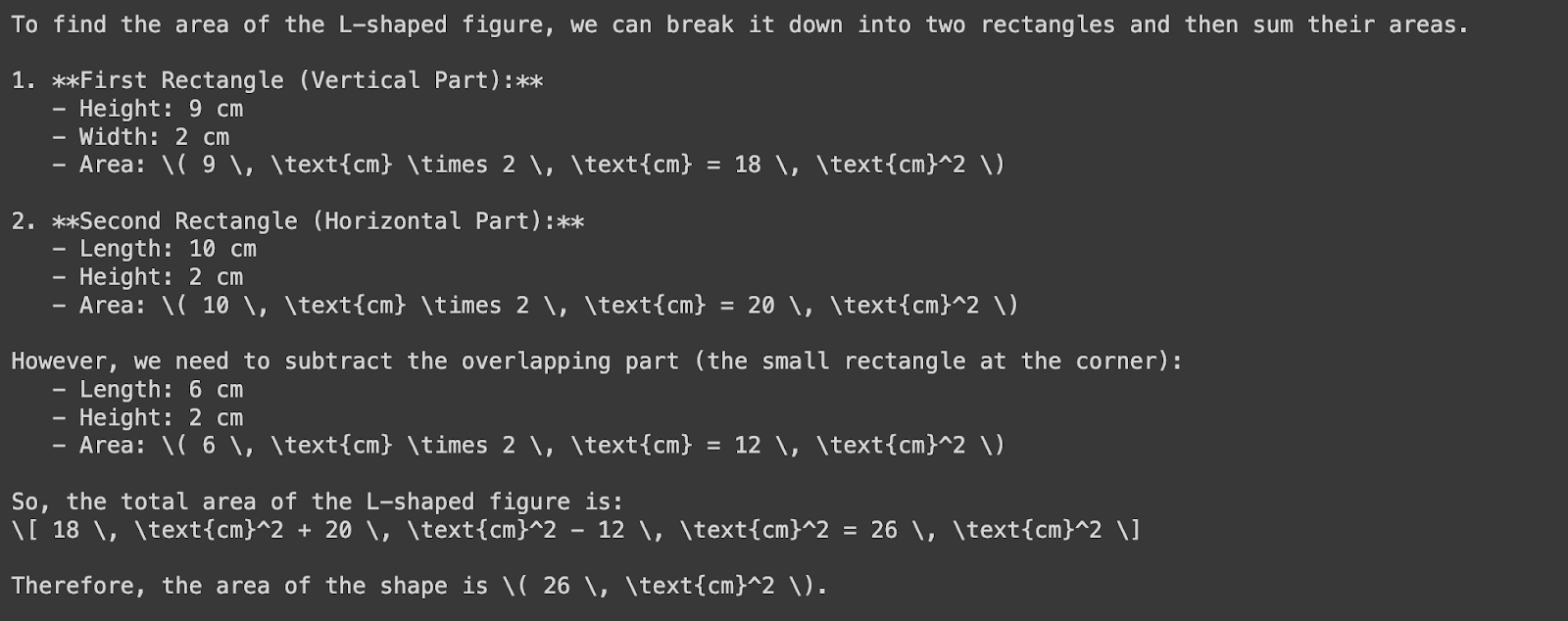

Examinons maintenant cette forme :

Nous transmettrons l'URL de l'image à GPT-4o afin de déterminer la surface de la forme :

response = client.chat.completions.create( model=MODEL, messages=[ { "role": "system", "content": "You are a helpful assistant that responds in Markdown. Help me with my math homework!" }, { "role": "user", "content": [ {"type": "text", "text": "What's the area of the shape in the image?"}, { "type": "image_url", "image_url": { "url": "https://images.saymedia-content.com/.image/c_limit%2Ccs_srgb%2Cq_auto:eco%2Cw_538/MTczOTQ5NDQyMzQ3NTc0NTc5/compound-shapes-how-to-find-the-area-of-a-l-shape.webp" } } ] } ], temperature=0.0,)print(response.choices[0].message.content)

Veuillez noter que GPT-4o a mal mesuré la largeur du rectangle vertical : elle devrait être de quatre centimètres, et non de deux. Cette divergence résulte d'un décalage entre les étiquettes de mesure et les proportions réelles du rectangle. Cela ne fait que souligner une fois de plus l'importance de la supervision et de la validation humaines.

Tarification de l'API GPT-4o

À compter de juillet 2025, la tarification à l'utilisation pour GPT-4o sera la suivante :

Jetons d'entrée: 5,00 $ par million de jetons

Jetons d'entrée mis en cache: 2,50 $ par million de jetons

Jetons de sortie: 20,00 $ par million de jetons

GPT-4o Mini : Une alternative économique

Pour les applications nécessitant un volume élevé d'appels API, OpenAI propose GPT-4o Mini, une version simplifiée de GPT-4o :

Jetons d'entrée: 0,60 $ par million de jetons

Jetons d'entrée mis en cache: 0,30 $ par million de jetons

Jetons de sortie: 2,40 $ par million de jetons

Remises API par lots

L'API Batch d'OpenAI offre une réduction de 50 % sur les coûts des jetons d'entrée et de sortie pour GPT-4o :

Jetons d'entrée: 2,50 $ par million de jetons

Jetons de sortie: 10,00 $ par million de jetons

Ceci est idéal pour traiter de grands volumes de données de manière asynchrone.

API GPT-4o : Considérations importantes

Lorsque vous travaillez avec l'API GPT-4o, il est important de garder à l'esprit quelques considérations essentielles afin de garantir des performances optimales, une rentabilité maximale et une adéquation parfaite avec chaque cas d'utilisation spécifique. Voici trois facteurs essentiels à prendre en considération :

Tarification et gestion des coûts

L'API OpenAI suit un modèle de paiement à l'utilisation, dans lequel les coûts sont facturés en fonction du nombre de jetons traités.

Bien que GPT-4o soit moins cher que GPT-4 Turbo, il est essentiel de planifier notre utilisation en conséquence afin d'estimer et de gérer les coûts.

Afin de minimiser les coûts, vous pouvez envisager des techniques telles que le traitement par lots et l'optimisation des invites afin de réduire le nombre d'appels API et de jetons traités.

Latence et performances

Même si GPT-4o offre des performances impressionnantes et une faible latence, il s'agit toujours d'un modèle linguistique volumineux, ce qui signifie que le traitement des demandes peut être très gourmand en ressources informatiques, entraînant une latence relativement élevée.

Il est nécessaire d'optimiser notre code et d'utiliser des techniques telles que la mise en cache et le traitement asynchrone afin de réduire les problèmes de latence.

De plus, nous pouvons envisager d'utiliser les instances dédiées d'OpenAI ou d'ajuster le modèle à notre cas d'utilisation spécifique, ce qui peut améliorer les performances et réduire la latence.

Alignement des cas d'utilisation

GPT-4o est un modèle général puissant doté d'un large éventail de capacités, mais nous devons nous assurer que notre cas d'utilisation spécifique correspond aux points forts du modèle.

Avant de nous fier uniquement à GPT-4o, nous devons évaluer soigneusement notre cas d'utilisation et déterminer si les capacités du modèle répondent à nos besoins.

Si nécessaire, nous pourrions affiner des modèles plus petits ou explorer d'autres modèles qui pourraient être mieux adaptés à notre tâche particulière.

Conclusion

Les capacités multimodales de GPT-4o permettent de surmonter les limites des modèles précédents qui peinaient à intégrer et à traiter différents types de données de manière fluide.

En exploitant l'API GPT-4o, les développeurs peuvent créer des solutions innovantes qui intègrent de manière transparente des données textuelles, audio et visuelles.

Si vous souhaitez vous exercer davantage avec GPT-4o, je vous recommande ce code-along sur la création d'assistants IA avec GPT-4o. De même, si vous souhaitez en savoir plus sur l'utilisation des API, je vous recommande les ressources suivantes :

Foire aux questions

Qu'est-ce que le GPT-4o et en quoi diffère-t-il des modèles précédents ?

GPT-4o est un modèle linguistique multimodal développé par OpenAI, capable de traiter et de générer des données textuelles, audio et visuelles. Contrairement aux modèles précédents tels que GPT-4, qui ne traitaient que du texte, GPT-4o intègre des informations audio et visuelles, permettant ainsi des interactions plus naturelles et des capacités améliorées dans toutes les modalités.

Comment les développeurs peuvent-ils accéder à GPT-4o via l'API OpenAI ?

Les développeurs peuvent accéder à GPT-4o via l'API OpenAI en créant un compte OpenAI, en obtenant une clé API et en installant la bibliothèque Python OpenAI.

Quels sont les coûts liés à l'utilisation de l'API GPT-4o et comment se compare-t-elle à d'autres modèles ?

L'API GPT-4o fonctionne selon un modèle de paiement à l'utilisation, les coûts étant calculés en fonction du nombre de jetons traités. Par rapport aux modèles précédents tels que GPT-4, GPT-4o offre une réduction des coûts de 50 %, ce qui le rend plus abordable. Une comparaison des prix avec d'autres modèles est fournie dans l'article.

Le GPT-4o peut-il être ajusté pour des cas d'utilisation ou des secteurs spécifiques ?

Oui, GPT-4o peut être ajusté pour des cas d'utilisation ou des secteurs spécifiques grâce à des techniques telles que l'apprentissage par transfert. En affinant les données ou les tâches spécifiques à un domaine, les développeurs peuvent améliorer les performances du modèle et l'adapter à leurs besoins particuliers.

Quelles sont les ressources disponibles pour approfondir vos connaissances et mettre en œuvre l'API GPT-4o ?

Diverses ressources, notamment des tutoriels, des cours et des exemples pratiques, sont disponibles pour approfondir vos connaissances et mettre en œuvre l'API GPT-4o. L'article recommande de consulter le cours « Working with the OpenAI API » (Travailler avec l'API OpenAI) de DataCamp, le « OpenAI Cookbook » (Livre de recettes OpenAI) et l'aide-mémoire de DataCamp pour une référence rapide et des conseils pratiques de mise en œuvre.

Quand dois-je utiliser GPT-4o plutôt que GPT-4o-mini ?

GPT-4o est idéal pour les cas d'utilisation plus complexes qui nécessitent une analyse approfondie, une compréhension du langage ou des interactions plus longues. D'autre part, GPT-4o-mini est plus rapide et plus économique, ce qui le rend plus adapté aux tâches légères ou lorsqu'une réponse rapide est nécessaire. Les deux modèles offrent des capacités multimodales, mais GPT-4o se distingue lorsque des capacités de raisonnement et d'interaction plus avancées entre les modalités sont essentielles.

Comment l'API GPT-4o se compare-t-elle à l'API o1 pour des cas d'utilisation spécifiques ?

Alors que GPT-4o est particulièrement performant pour les tâches impliquant des données multimodales (texte, audio et images), l'API o1 excelle dans les tâches de raisonnement complexe et de résolution de problèmes, notamment dans les domaines des sciences, du codage et des mathématiques. Si vous avez besoin de réponses rapides avec un raisonnement modéré, GPT-4o est la solution idéale. Toutefois, pour les tâches nécessitant une analyse logique approfondie et une grande précision, telles que la génération de code complexe ou la résolution de problèmes mathématiques avancés, l'API o1 offre des capacités plus performantes.

Introduction aux agents d'intelligence artificielle

Ryan est un data scientist de premier plan spécialisé dans la création d'applications d'IA utilisant des LLM. Il est candidat au doctorat en traitement du langage naturel et graphes de connaissances à l'Imperial College de Londres, où il a également obtenu une maîtrise en informatique. En dehors de la science des données, il rédige une lettre d'information hebdomadaire Substack, The Limitless Playbook, dans laquelle il partage une idée exploitable provenant des plus grands penseurs du monde et écrit occasionnellement sur les concepts fondamentaux de l'IA.