programa

OpenAI ha lanzado GPT-4o mini, una versión más accesible del potente GPT-4o. Este nuevo modelo pretende equilibrar el rendimiento con la rentabilidad, atendiendo a las necesidades de las empresas y los desarrolladores que desean soluciones de IA potentes a un precio más bajo.

En 2024, la narrativa en torno a la IA parece estar pasando de modelos más grandes y mejores a opciones más rentables, especialmente para aplicaciones B2B. Hay un cambio de la IA basada en la nube a la IA localhaciendo que los modelos más pequeños sean más importantes.

Hasta ahora, OpenAI carecía de un candidato fuerte para este espacio desde GPT-3.5. GPT-4o mini cambia eso haciendo que la potente IA sea accesible y asequible para su integración en cualquier aplicación y sitio web.

En este artículo, exploraremos las características clave de GPT-4o mini, cómo se compara con otros LLM similares y qué significa este lanzamiento para los desarrollos de IA.

¿Qué es GPT-4o Mini?

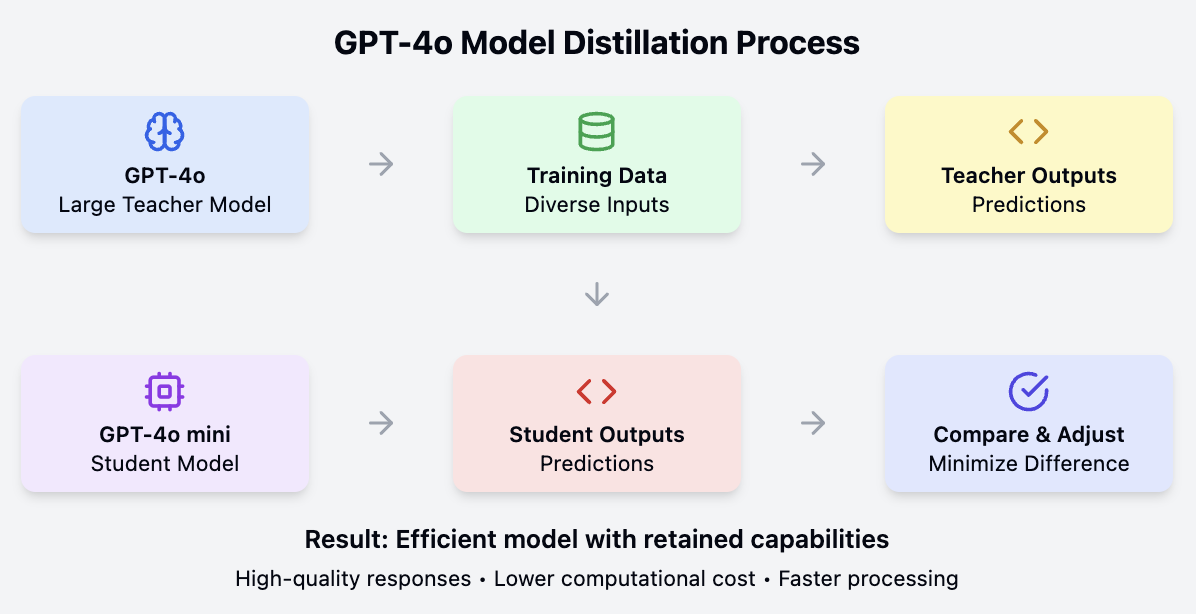

GPT-4o mini se deriva del modelo mayor GPT-4o mediante un proceso de destilación. Este proceso consiste en entrenar un modelo más pequeño para que imite el comportamiento y el rendimiento del modelo más grande y complejo, lo que da como resultado una versión rentable pero muy capaz del original.

Características principales

- Ventana contextual grande: GPT-4o mini conserva la ventana contextual de fichas de 128 k de GPT-4o, lo que le permite manejar textos largos con eficacia. Esto es ideal para aplicaciones que necesitan un contexto amplio, como el análisis de grandes documentos o el mantenimiento del historial de conversaciones.

- Capacidades multimodales: El modelo procesa tanto entradas de texto como de imagen, y está previsto que en el futuro admita entradas y salidas de vídeo y audio. Esta versatilidad lo hace adecuado para diversas aplicaciones, desde el análisis de textos al reconocimiento de imágenes.

- Coste reducido: GPT-4o mini es mucho más asequible que sus predecesores. Cuesta 0,15 $ por millón de fichas de entrada y 0,60 $ por millón de fichas de salida, bastante más barato que el modelo GPT-4o, cuyo precio es de 5 $ por millón de fichas de entrada y 15 $ por millón de fichas de salida. Comparado con el GPT-3,5 Turbo, el GPT-4o mini es más de un 60% más barato.

- Seguridad mejorada: El modelo incluye las mismas características de seguridad que el GPT-4o y es el primero de la API que utiliza el método de jerarquía de instrucciones. Esto mejora su resistencia a los jailbreaks, a las inyecciones de prompt y a las extracciones de prompt del sistema, haciendo más seguro su uso en diversas aplicaciones.

Gpt-4o mini concurso

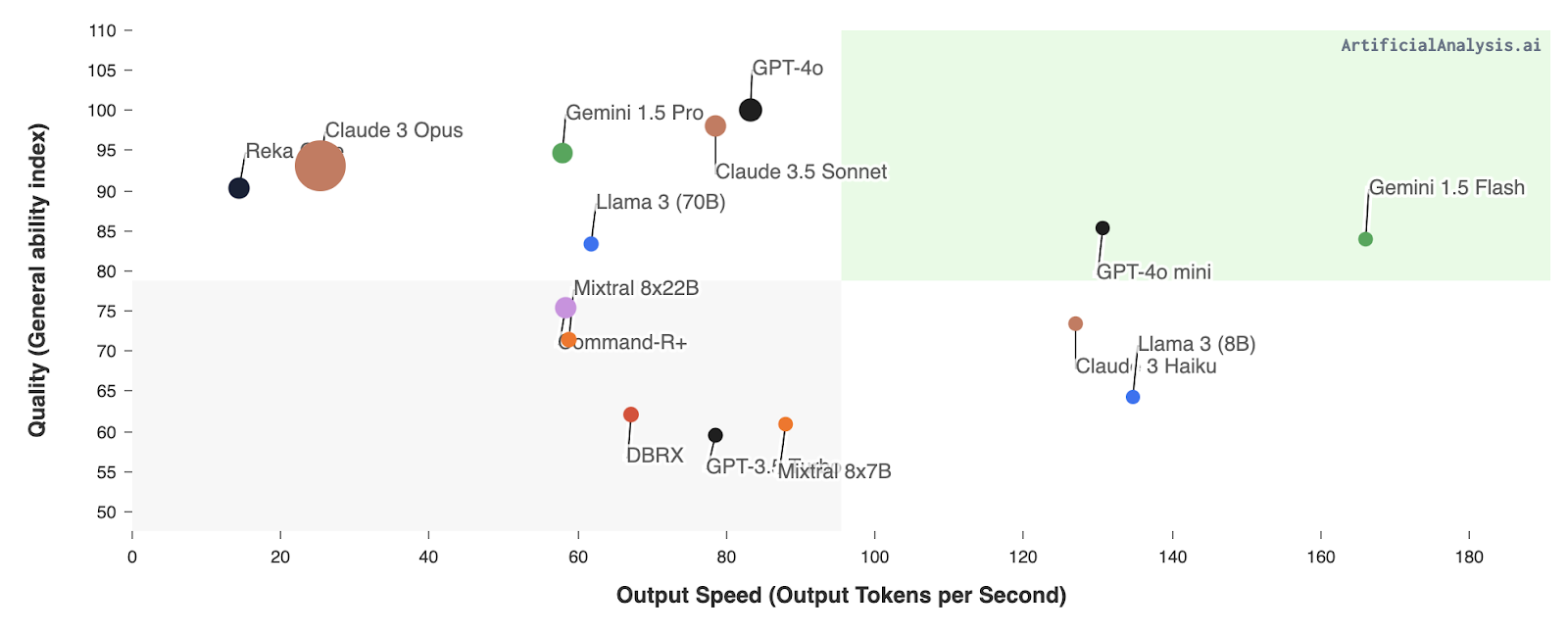

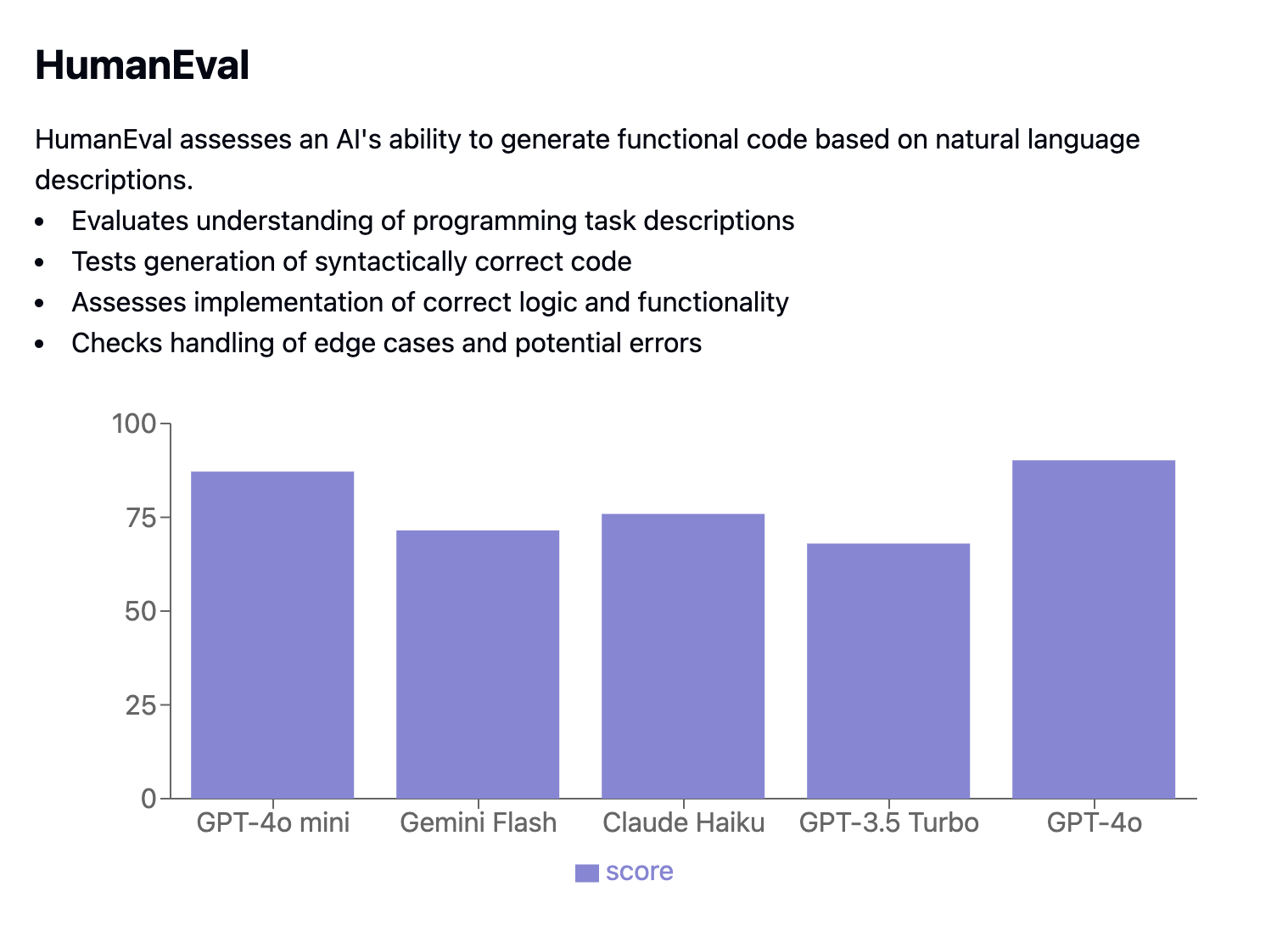

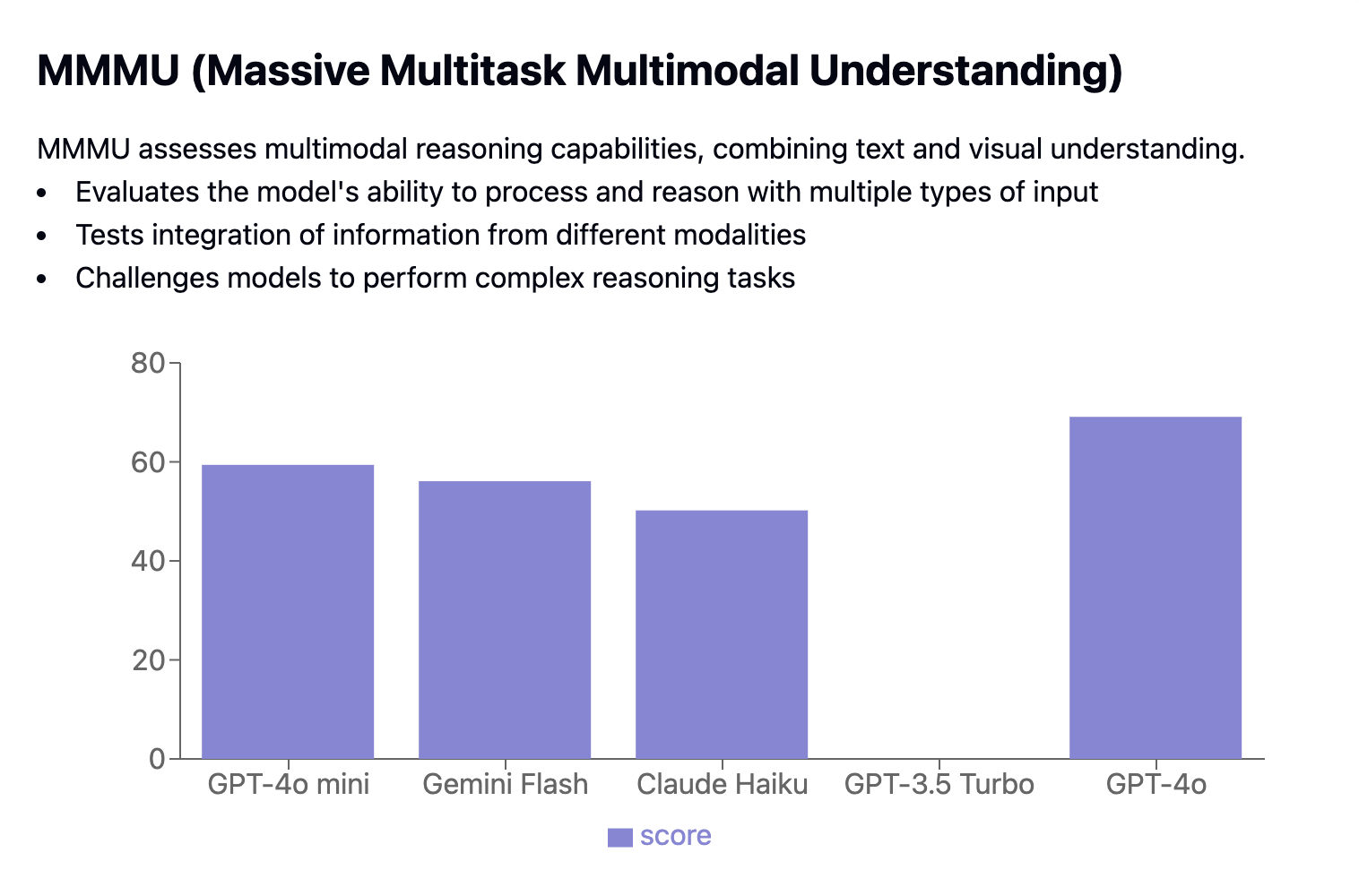

GPT-4o mini compite con modelos como Llama 3 8B, Gemini 1.5 Flash y Claude Haiku, así como el propio GPT-3.5 Turbo de OpenAI. Estos modelos ofrecen funcionalidades similares, pero a menudo tienen un coste más elevado o unas métricas de rendimiento menos avanzadas.

- Flash Géminis 1.5: Aunque el Flash Gemini 1,5 tiene una velocidad de salida ligeramente superior, el GPT-4o mini destaca en calidad, lo que lo convierte en una opción más equilibrada para las aplicaciones que necesitan tanto velocidad como gran precisión.

- Claude 3 Haiku y Llama 3 (8B): GPT-4o mini supera a estos modelos tanto en calidad como en velocidad de salida, demostrando su eficiencia y eficacia.

- GPT-3.5 Turbo: GPT-4o mini supera a GPT-3.5 Turbo en velocidad de salida y calidad general, y ofrece capacidades de visión de las que carece GPT-3.5 Turbo.

Fuente: Análisis Artificial

Cómo funciona el GPT-4o Mini: La Mecánica de la Destilación

La GPT-4o mini consigue su equilibrio de rendimiento y eficacia mediante un proceso conocido como destilación modelo. En esencia, se trata de entrenar a un modelo más pequeño y simplificado (el "alumno") para que imite el comportamiento y los conocimientos de un modelo más grande y complejo (el "maestro").

El modelo mayor, en este caso, GPT-4o, ha sido preentrenado en grandes cantidades de datos y posee un profundo conocimiento de los patrones lingüísticos, la semántica e incluso la capacidad de razonamiento. Sin embargo, su gran tamaño hace que sea caro computacionalmente y menos adecuado para determinadas aplicaciones.

La destilación de modelos aborda este problema transfiriendo los conocimientos y capacidades del modelo GPT-4o más grande al GPT-4o mini más pequeño. Esto suele hacerse haciendo que el modelo más pequeño aprenda a predecir los resultados del modelo más grande con un conjunto diverso de datos de entrada. Mediante este proceso, el GPT-4o mini "destila" eficazmente los conocimientos y habilidades más importantes de su homólogo mayor.

El resultado es un modelo que, aunque más pequeño y eficiente, conserva gran parte de las prestaciones y capacidades del original. GPT-4o mini puede manejar tareas lingüísticas complejas, comprender el contexto y generar respuestas de alta calidad, todo ello consumiendo menos recursos informáticos. Esto la convierte en una solución práctica y asequible para una amplia gama de aplicaciones, especialmente aquellas en las que la velocidad y la rentabilidad son importantes.

GPT-4o Mini Performance

GPT-4o mini muestra un rendimiento impresionante en varios benchmarks. He creado Artefactos Claude para cada punto de referencia con el fin de explicar qué es cada punto de referencia LLM y qué mide.

Tareas de razonamiento

Para las tareas de razonamiento, evaluamos GPT-4o mini en lo siguiente:

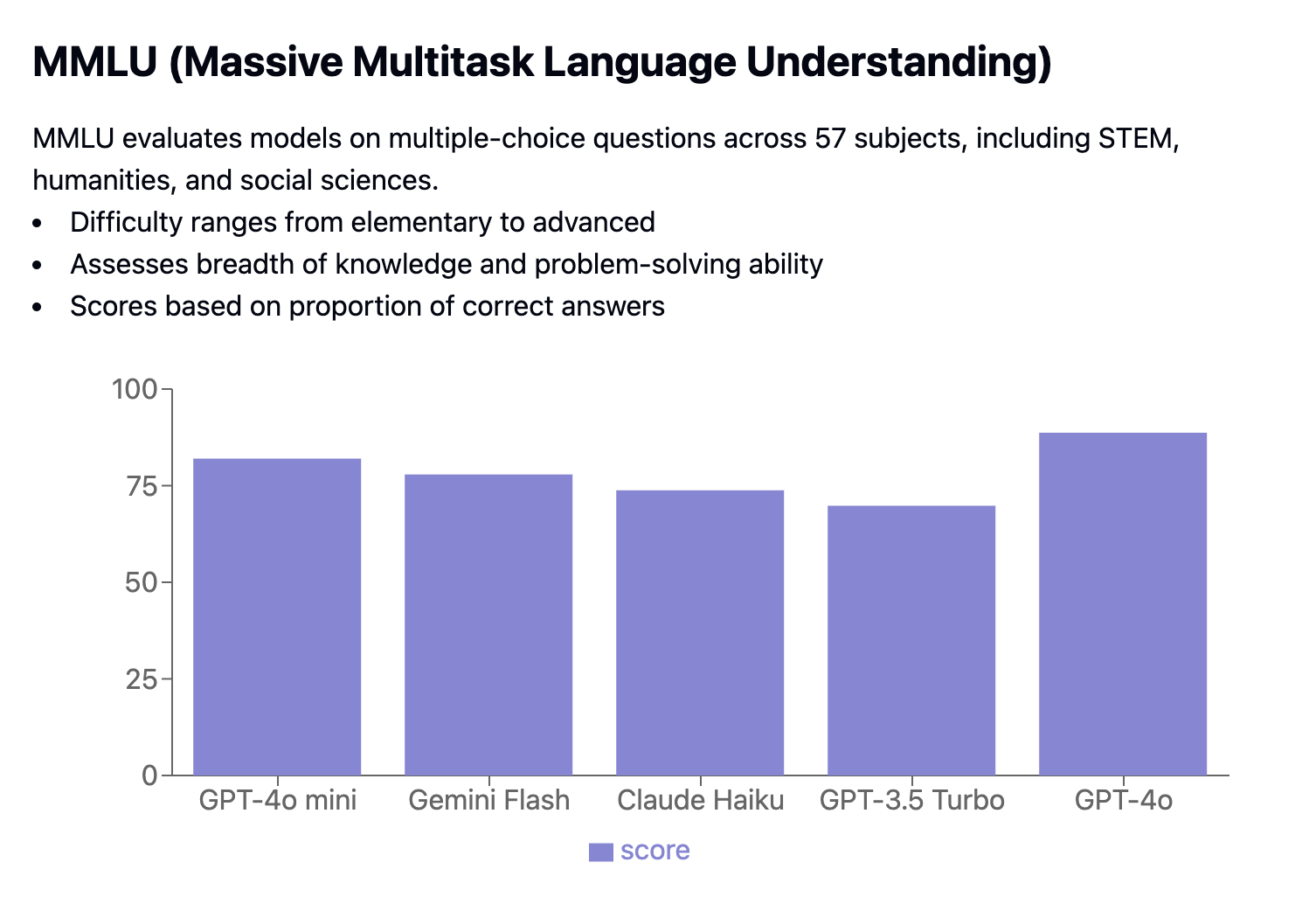

MMLU (Massive Multitask Language Understanding) es una prueba que evalúa modelos con preguntas de opción múltiple en 57 asignaturas diferentes, incluidas STEM, humanidades y ciencias sociales. La dificultad de las preguntas varía de básica a avanzada. Mide cuántas respuestas son correctas y requieren coincidencias exactas. GPT-4o Mini obtuvo un 82,0%, superando a competidores como Gemini Flash (77,9%) y Claude Haiku (73,8%).

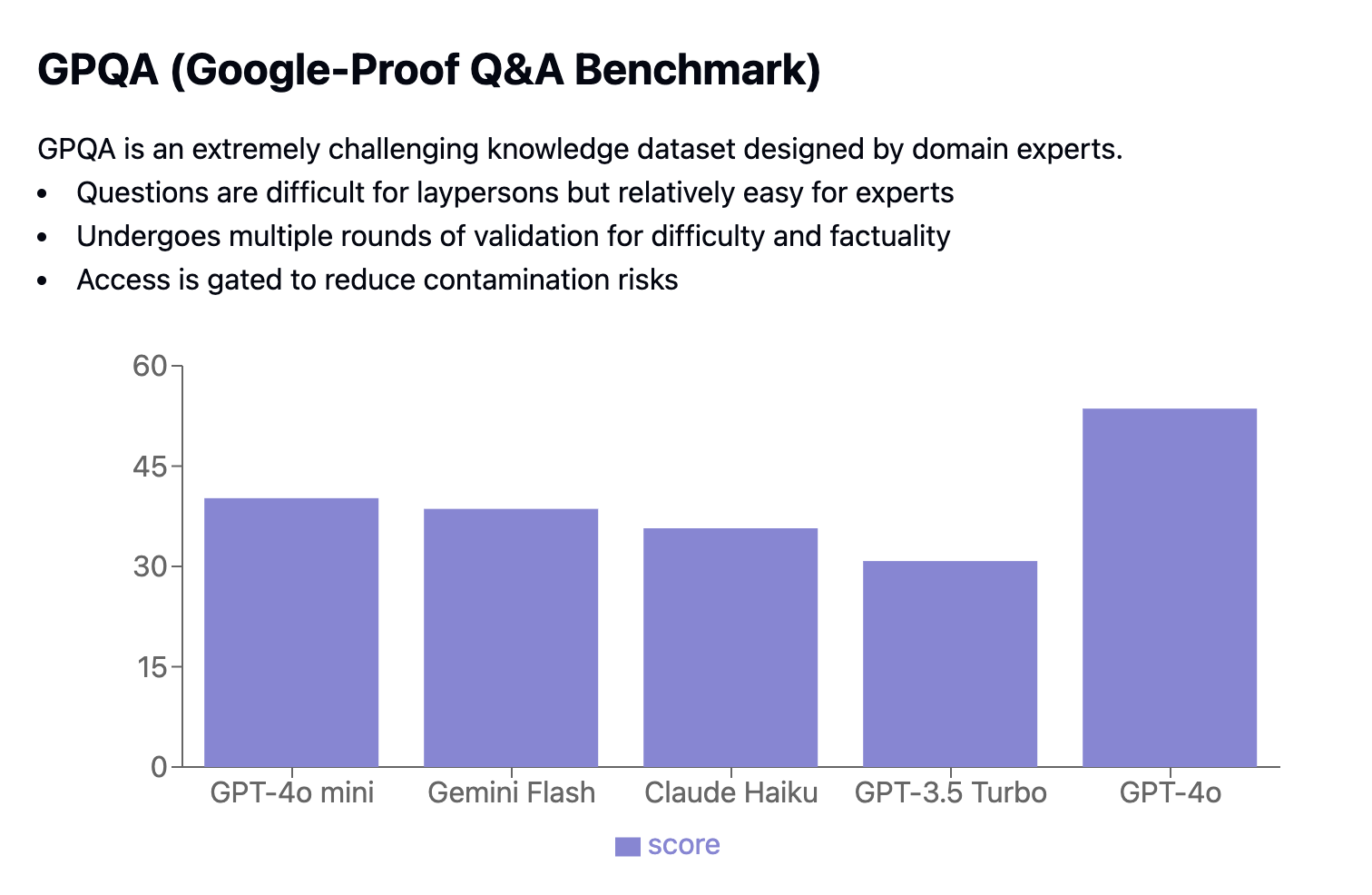

GPQA (Google-Proof Q&A Benchmark) es un duro conjunto de datos con preguntas elaboradas por expertos para desafiar a los no expertos, al tiempo que resultan manejables para los especialistas. Las preguntas se validan cuidadosamente tanto en dificultad como en precisión mediante rondas múltiples para reducir los riesgos de contaminación.

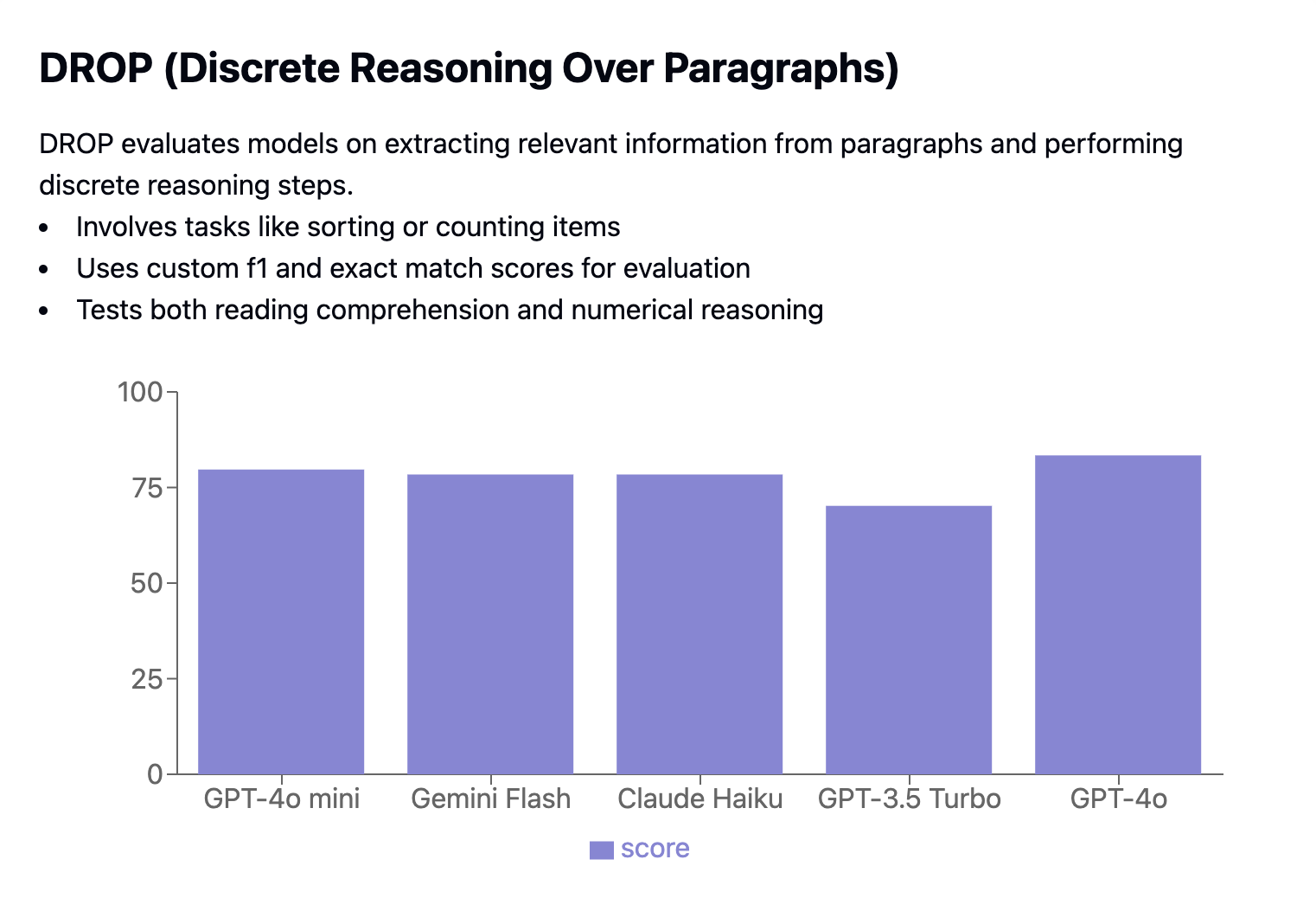

DROP (Discrete Reasoning Over Paragraphs) evalúa la capacidad de los modelos para extraer información relevante de los párrafos y realizar tareas de razonamiento como ordenar o contar. El rendimiento se evalúa utilizando puntuaciones F1 y de coincidencia exacta personalizadas.

Dominio de las matemáticas y la codificación

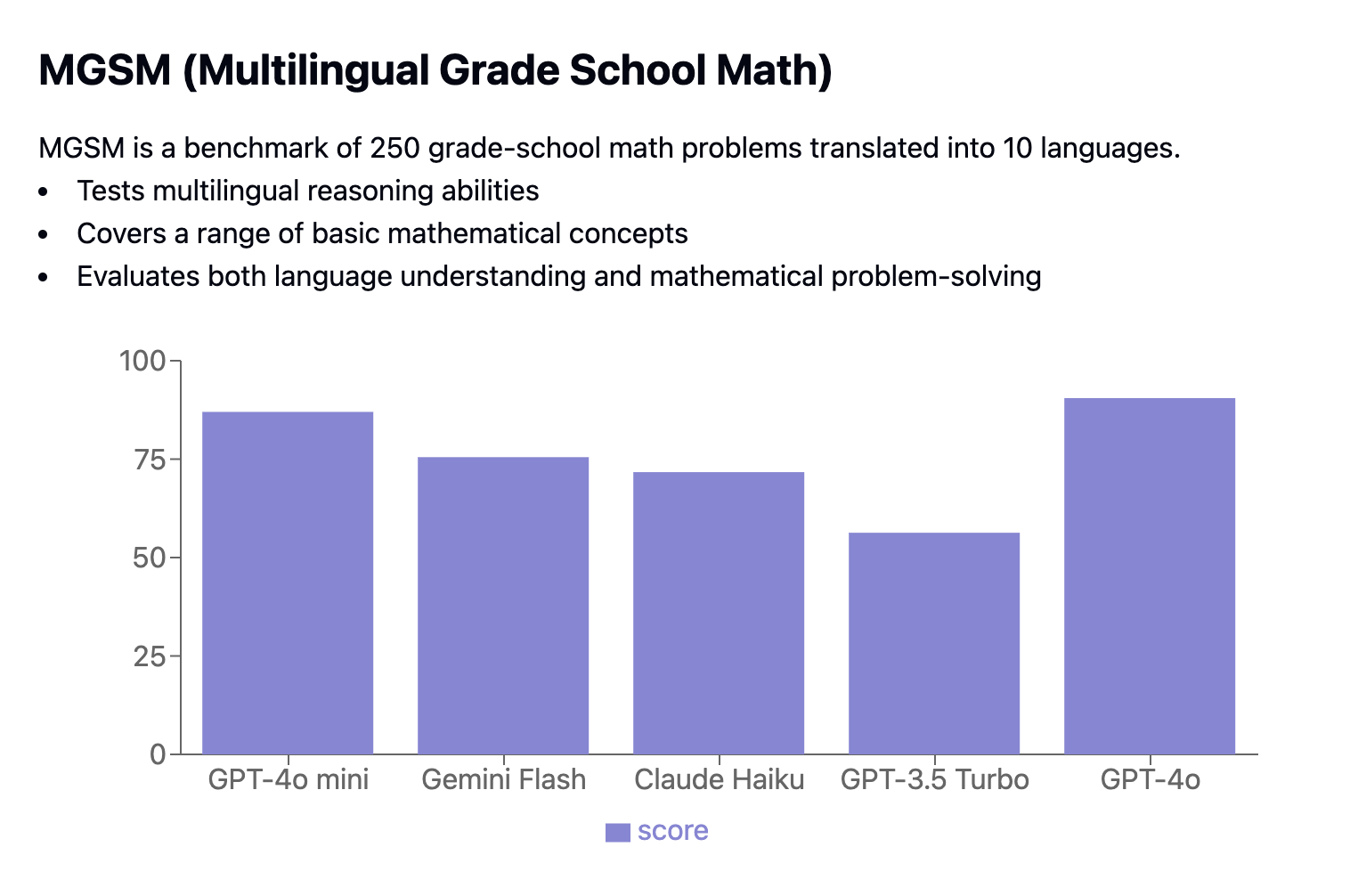

El punto de referencia MGSM incluye 250 problemas matemáticos de primaria traducidos a 10 idiomas, que ponen a prueba la capacidad de razonamiento multilingüe.

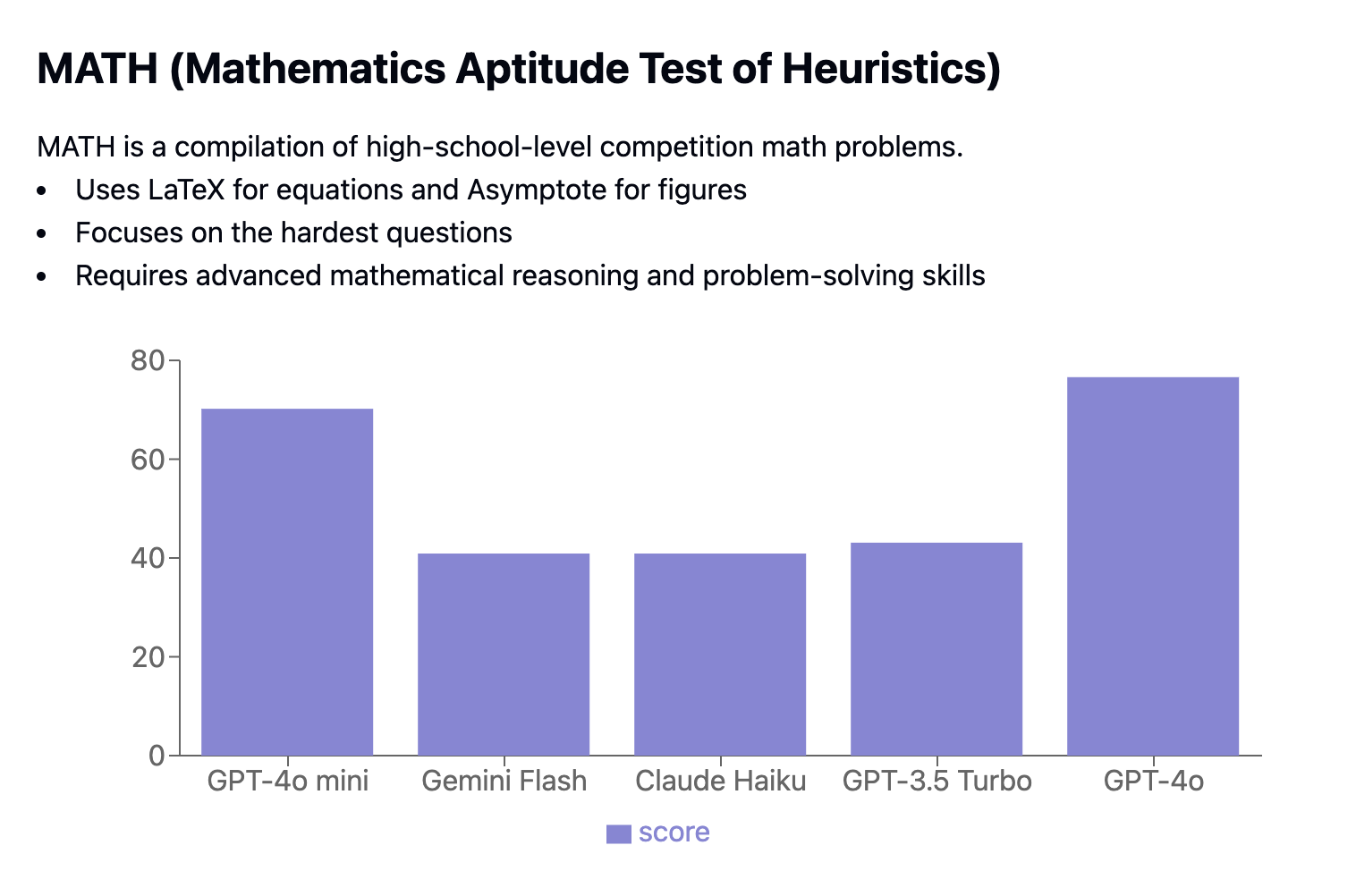

La Prueba de Aptitud Matemática Heurística (MATH) presenta problemas de competición de nivel de enseñanza secundaria. Evalúa los modelos en función de su capacidad para resolver problemas matemáticos complejos formateados en Latex y Asymptote, centrándose en las preguntas más difíciles.

El punto de referencia HumanEval mide el rendimiento de la generación de código evaluando si el código generado supera pruebas unitarias específicas. Utiliza la métrica pass@k para determinar la probabilidad de que al menos una de las k soluciones de un problema de codificación supere las pruebas.

Razonamiento multimodal

La prueba de referencia Comprensión Lingüística Multitarea Masiva (MMLU) pone a prueba la amplitud de conocimientos, la profundidad de comprensión del lenguaje natural y la capacidad de resolución de problemas de un modelo. Contiene más de 15.000 preguntas de opción múltiple que abarcan 57 temas, desde conocimientos generales hasta campos especializados. La MMLU evalúa los modelos en configuraciones de pocos disparos y cero disparos, midiendo la precisión entre sujetos y promediando los resultados para obtener una puntuación final.

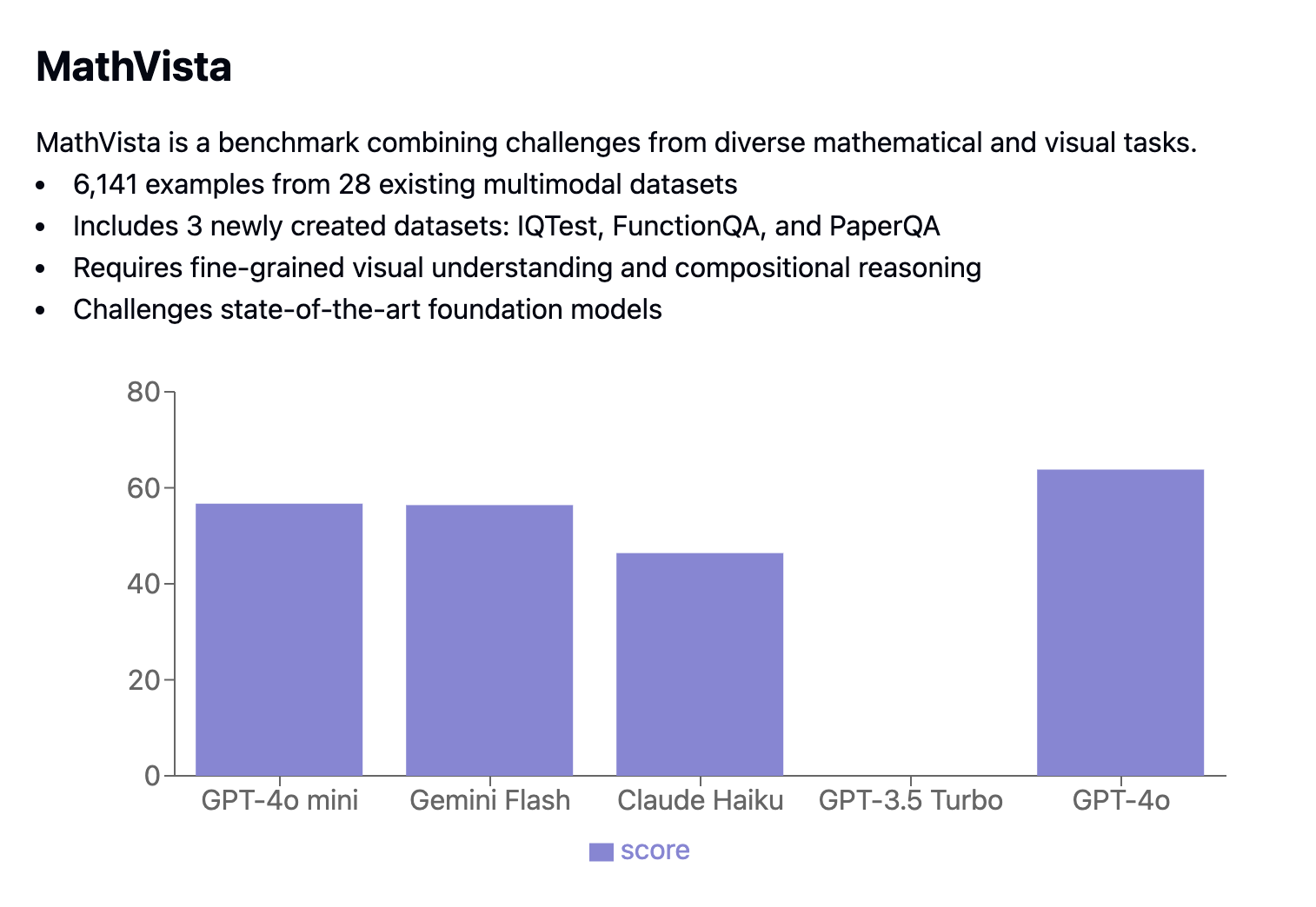

El punto de referencia MathVista combina tareas matemáticas y visuales, con 6.141 ejemplos extraídos de 28 conjuntos de datos multimodales existentes y 3 conjuntos de datos de nueva creación (IQTest, FunctionQA y PaperQA). Desafía a los modelos con tareas que requieren una comprensión visual avanzada y un razonamiento compositivo complejo.

Casos de uso del Gpt 4o Mini

El pequeño tamaño, el bajo coste y el gran rendimiento de GPT-4o mini lo hacen perfecto para su uso en dispositivos personales, la creación rápida de prototipos y en entornos con recursos limitados. Además, su capacidad de respuesta en tiempo real mejora las aplicaciones interactivas. He aquí cómo puede utilizarse eficazmente el GPT-4o mini:

|

Categoría de caso de uso |

Beneficios |

Ejemplos de aplicaciones |

|

IA en el dispositivo |

Su menor tamaño permite el procesamiento local en ordenadores portátiles, teléfonos inteligentes y servidores de borde, reduciendo la latencia y mejorando la privacidad. |

Aplicaciones de aprendizaje de idiomas, asistentes personales, herramientas de traducción offline |

|

Prototipado rápido |

Una iteración más rápida y unos costes más bajos permiten experimentar y perfeccionar antes de escalar a modelos más grandes. |

Probar nuevas ideas de chatbot, desarrollar prototipos impulsados por IA, experimentar con diferentes funciones de IA de forma rentable |

|

Aplicaciones en tiempo real |

Un tiempo de respuesta rápido mejora las experiencias interactivas. |

Chatbots, asistentes virtuales, traducción de idiomas en tiempo real, narración interactiva en juegos y realidad virtual |

|

Uso educativo |

Asequible y accesible para las instituciones educativas, proporciona experiencia práctica con la IA. |

Sistemas de tutoría basados en IA, plataformas de aprendizaje de idiomas, herramientas de práctica de codificación |

Acceder a Gpt 4o Mini

Puedes utilizar GPT-4o Mini a través de la API OpenAIque incluye opciones como la API de Asistentes, la API de Completaciones de Chat y la API de Lotes. Aquí tienes una guía sencilla sobre cómo utilizar GPT-4o Mini con la API OpenAI.

En primer lugar, tendrás que autenticarte utilizando tu clave de API: sustituye your_api_key_here por tu clave de API real. Una vez configurado, puedes empezar a generar texto con GPT-4o Mini:

from openai import OpenAI

MODEL="gpt-4o-mini"

## Set the API key

client = OpenAI(api_key="your_api_key_here")

completion = client.chat.completions.create(

model=MODEL,

messages=[

{"role": "system", "content": "You are a helpful assistant that helps me with my math homework!"},

{"role": "user", "content": "Hello! Could you solve 20 x 5?"}

]

)Para más detalles sobre la configuración y el uso de la API OpenAI, consulta el tutorial de la API GPT-4o.

Conclusión

GPT-4o mini destaca como un modelo de IA potente y rentable, que logra un notable equilibrio entre rendimiento y asequibilidad.

Su destilación del modelo GPT-4o, de mayor tamaño, combinada con su gran ventana contextual, sus capacidades multimodales y sus funciones de seguridad mejoradas, lo convierten en una opción versátil y accesible para una amplia gama de aplicaciones.

Como la demanda de soluciones de IA eficaces y asequibles sigue creciendo, GPT-4o mini está bien posicionada para desempeñar un papel importante en la democratización de la tecnología de IA.

Preguntas frecuentes

¿Cuál es la diferencia clave entre GPT-4o y GPT-4o Mini?

La principal diferencia radica en su tamaño y coste. El GPT-4o es un modelo más grande y potente, pero tiene un precio más elevado. GPT-4o Mini es una versión destilada de GPT-4o, que la hace más pequeña, más asequible y más rápida para determinadas tareas.

¿Puede GPT-4o Mini procesar imágenes, vídeo y audio?

Actualmente, GPT-4o Mini admite entradas de texto e imagen, y está previsto que en el futuro admita vídeo y audio.

¿Cómo se compara el rendimiento del GPT-4o Mini con el de otros modelos?

GPT-4o Mini supera a varios modelos similares, como Llama 3 (8B), Claude 3 Haiku y GPT-3.5 Turbo, tanto en calidad como en velocidad. Aunque Gemini 1.5 Flash puede tener una ligera ventaja en velocidad de salida, GPT-4o Mini sobresale en calidad general.

¿Es GPT-4o Mini adecuado para aplicaciones en tiempo real?

Sí, su rápido procesamiento y menor latencia lo hacen ideal para aplicaciones en tiempo real como chatbots, asistentes virtuales y experiencias de juego interactivas.

¿Cómo puedo acceder a GPT-4o Mini?

Puedes acceder a GPT-4o Mini a través de la API OpenAI, que ofrece diferentes opciones como la API de Asistentes, la API de Completaciones de Chat y la API de Lotes.