Programa

O GPT-4o da OpenAI junta recursos de áudio, visão e texto num único modelo de linguagem super poderoso.

Esse avanço é um grande passo em direção a uma interação mais natural e intuitiva entre humanos e computadores.

Neste tutorial, vou te mostrar passo a passo como usar o GPT-4o através da API OpenAI.

Mesmo que a OpenAI tenha lançado recentemente o modelo o3 — o seu modelode raciocínio mais capaz —, o GPT-4o e o GPT-4o mini continuam sendo as melhores opções para aplicações que precisam de respostas rápidas, processamento de imagens ou chamada de funções. Se o seu projeto precisa de raciocínio avançado, não deixe de conferir este tutorial da API O1 da OpenAI, que mostra como usar um modelo de raciocínio por meio da API.

O que é o GPT-4o?

GPT-4o, que é a abreviação de “omni”, é um grande avanço na IA. Diferente do GPT-4, que só trabalha com texto, o GPT-4o é um modelo multimodal que processa e gera texto, áudio e dados visuais.

Ao juntar dados de áudio e vídeo com texto, o GPT-4o se livra das limitações dos modelos tradicionais só de texto, criando interações mais naturais e intuitivas.

O GPT-4o tem um tempo de resposta mais rápido, é 50% mais barato que o GPT-4 Turbo e é melhor em compreensão de áudio e visão do que os modelos existentes.

Se você quiser saber mais sobre o GPT-4o, dá uma olhada nesse artigo sobre O que é o GPT-4o da OpenAI.

Casos de uso do GPT-4o

Além de interagir com o GPT-4o pela interface ChatGPT, os desenvolvedores podem interagir com o GPT-4o pela API OpenAI, o que permite integrar os recursos do GPT-4o em seus aplicativos e sistemas.

A API GPT-4o abre um monte de possibilidades de uso com suas funcionalidades multimodais:

Modalidade | Casos de uso | Descrição |

Texto | Geração de texto, resumo de texto, análise de dados e codificação | Criação de conteúdo, resumos curtos, explicações de código e ajuda com programação. |

Áudio | Transcrição de áudio, tradução em tempo real, geração de áudio | Converta áudio em texto, traduza em tempo real, crie assistentes virtuais ou aprenda idiomas. |

Visão | Legendas de imagens, análise e lógica de imagens, acessibilidade para pessoas com deficiência visual | Descreva imagens, analise informações visuais, ofereça acessibilidade para pessoas com deficiência visual. |

Multi | Interações multimodais, cenários de dramatização | Combine modalidades de forma integrada e crie experiências imersivas. |

GPT-4o API: Como se conectar à API da OpenAI

Agora vamos ver como usar o GPT-4o através da API OpenAI.

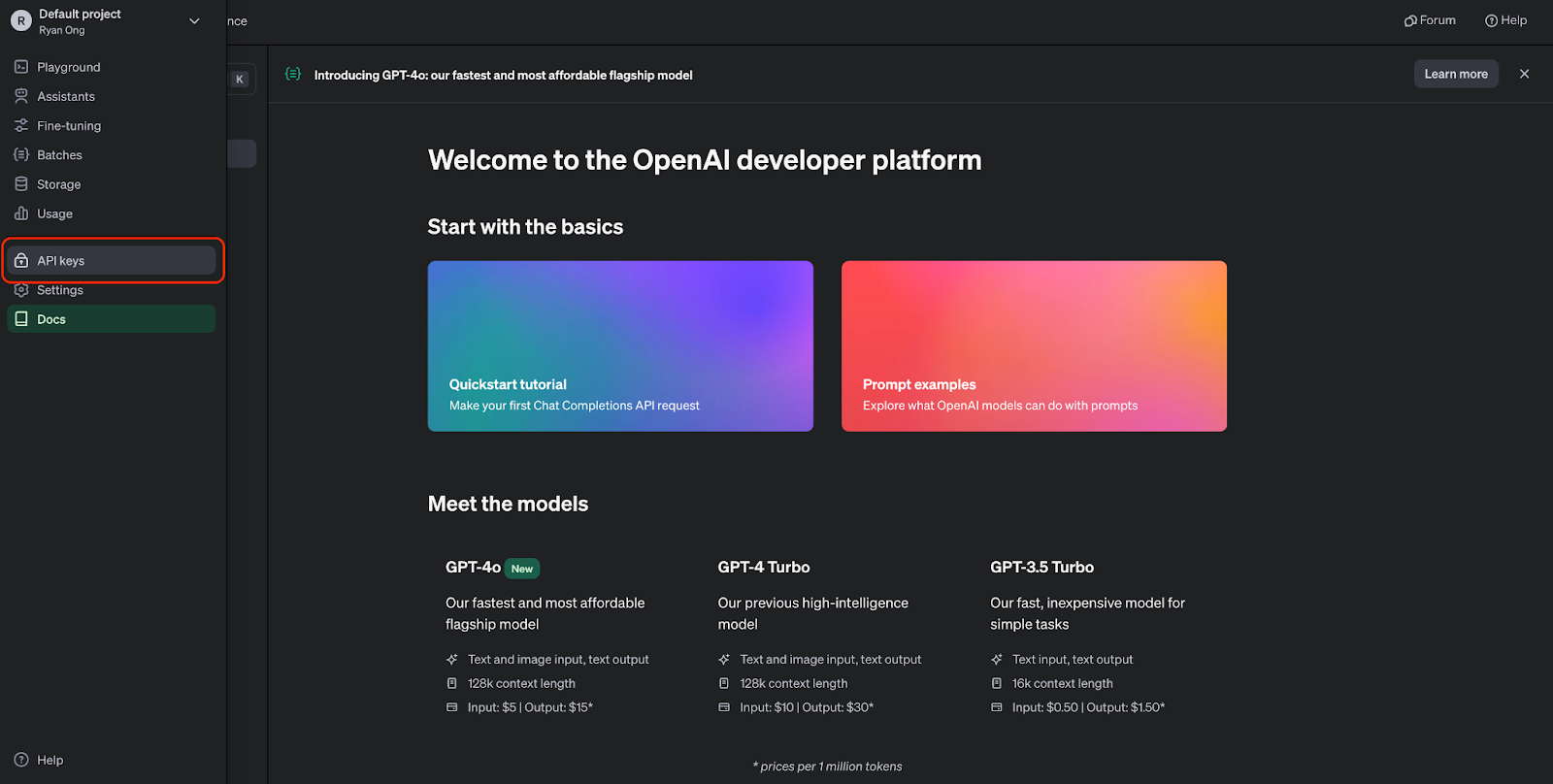

Passo 1: Crie uma chave API

Antes de usar a API GPT-4o, a gente precisa criar uma conta OpenAI e pegar uma chave API. A gente pode criar uma conta no site da API OpenAI.

Depois de criar uma conta, dá pra ir até a página de chaves API:

Agora podemos criar uma chave API. Precisamos mantê-lo em segurança, pois não poderemos visualizá-lo novamente. Mas a gente sempre pode criar um novo se perder ou precisar de um para outro projeto.

Passo 2: Importar a API OpenAI para Python

Para interagir com a API GPT-4o de forma programática, precisamos instalar a biblioteca Python OpenAI. A gente consegue fazer isso executando o seguinte comando:

Depois de instalado, podemos importar os módulos necessários para o nosso script Python:

from openai import OpenAIPasso 3: Fazer uma chamada API

Antes de podermos fazer solicitações de API, precisamos autenticar com nossa chave API:

# Set the API keyclient = OpenAI(api_key="your_api_key_here")Troca "your_api_key_here" pela tua chave API de verdade.

Depois de conectar o cliente, dá pra começar a gerar texto usando o GPT-4o:

MODEL = "gpt-4o"completion = client.chat.completions.create( model=MODEL, messages=[ {"role": "system", "content": "You are a helpful assistant that helps me with my math homework!"}, {"role": "user", "content": "Hello! Could you solve 20 x 5?"} ])print("Assistant: " + completion.choices[0].message.content)Esse trecho de código usa a API de preenchimento automático de bate-papo com o modelo GPT-4o, que aceita perguntas relacionadas a matemática como entrada e gera uma resposta:

GPT-4o API: Casos de uso de áudio

A transcrição e o resumo de áudio viraram ferramentas essenciais em várias aplicações, desde melhorar a acessibilidade até aumentar a produtividade. Com a API GPT-4o, a gente consegue lidar com tarefas como transcrever e resumir conteúdo de áudio de um jeito eficiente.

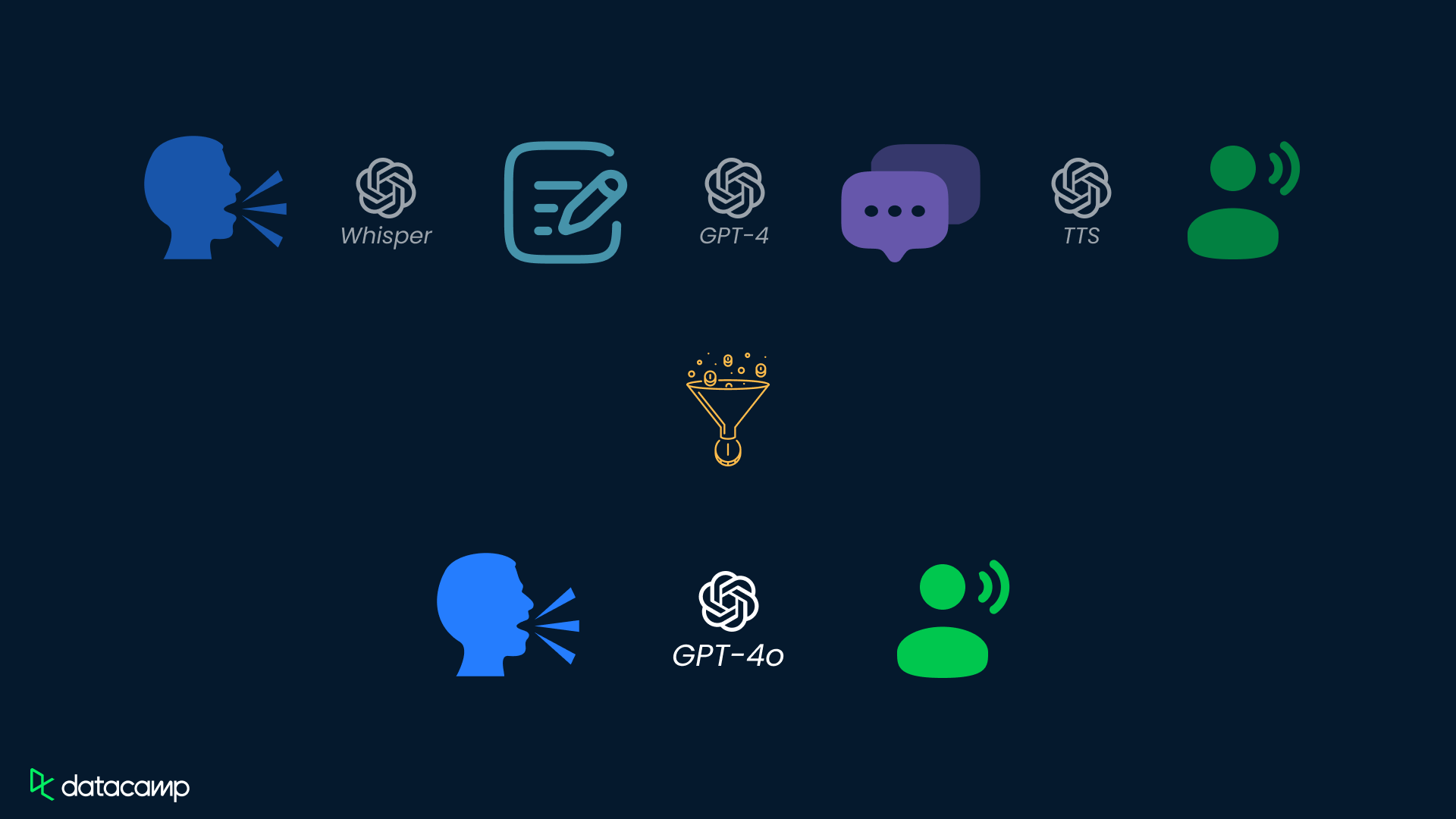

Embora o GPT-4o tenha o potencial de lidar diretamente com áudio, o recurso de entrada direta de áudio ainda não está disponível por meio da API. Por enquanto, dá pra usar um processo de duas etapas com a API GPT-4o pra transcrever e resumir o conteúdo de áudio.

Passo 1: Transcrever áudio para texto

Para transcrever um arquivo de áudio usando o GPT-4o, precisamos mandar os dados de áudio para a API. Aqui vai um exemplo:

# Transcribe the audioaudio_path = "path/to/audio.mp3"transcription = client.audio.transcriptions.create( model="whisper-1", file=open(audio_path, "rb"),)Troca “ "path/to/audio.mp3" ” pelo caminho real do seu arquivo de áudio. Esse exemplo usa o modelo whisper-1 para transcrição.

Passo 2: Resuma o texto do áudio

response = client.chat.completions.create( model=MODEL, messages=[ { "role": "system", "content": """You are generating a transcript summary. Create a summary of the provided transcription. Respond in Markdown.""" }, { "role": "user", "content": [ {"type": "text", "text": f"The audio transcription is: {transcription.text}"} ], } ], temperature=0,)print(response.choices[0].message.content)GPT-4o API: Casos de uso da visão

A análise de dados visuais é super importante em várias áreas, desde saúde até segurança e muito mais. Com a API GPT-4o, você pode analisar imagens sem complicações, participar de conversas sobre conteúdo visual e extrair informações valiosas das imagens.

Passo 1: Adicionar dados de imagem à API

Para analisar uma imagem usando o GPT-4o, primeiro precisamos mandar os dados da imagem para a API. A gente pode fazer isso codificando uma imagem local como uma sequência de caracteres base64 ou fornecendo uma URL para uma imagem online:

import base64IMAGE_PATH = "image_path"# Open the image file and encode it as a base64 stringdef encode_image(image_path): with open(image_path, "rb") as image_file: return base64.b64encode(image_file.read()).decode("utf-8")base64_image = encode_image(IMAGE_PATH) "url": "<https://images.saymedia-content.com/.image/c_limit%2Ccs_srgb%2Cq_auto:eco%2Cw_538/MTczOTQ5NDQyMzQ3NTc0NTc5/compound-shapes-how-to-find-the-area-of-a-l-shape.webp>"Passo 2: Analisar os dados da imagem

Depois de processar a imagem, a gente pode passar os dados da imagem para a API para análise.

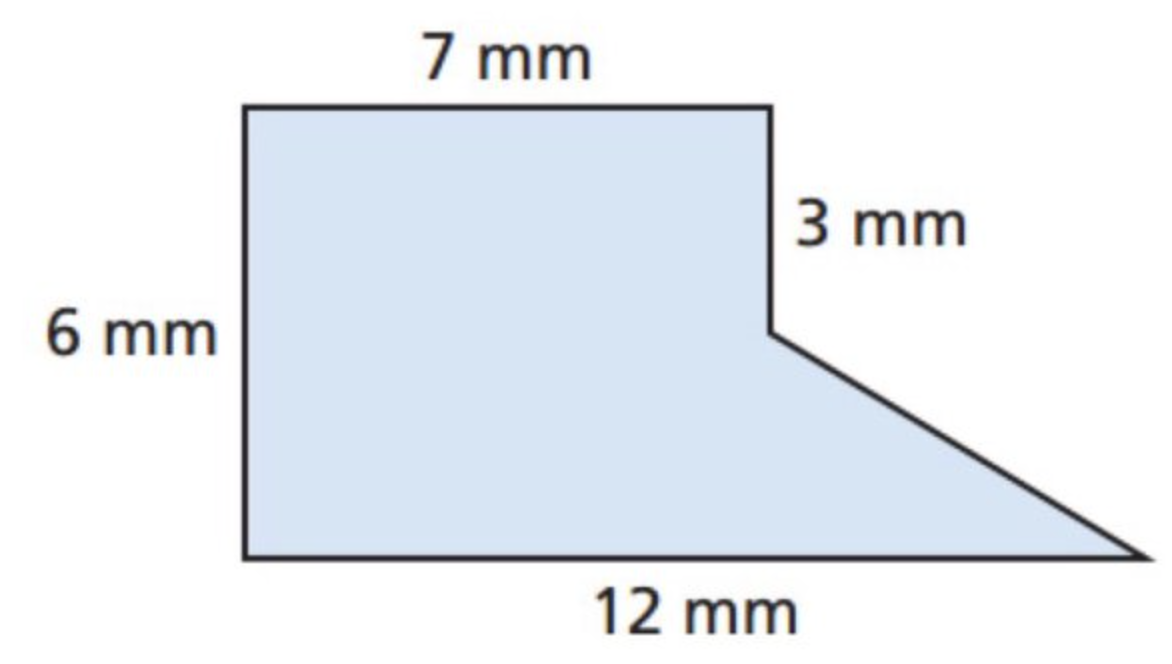

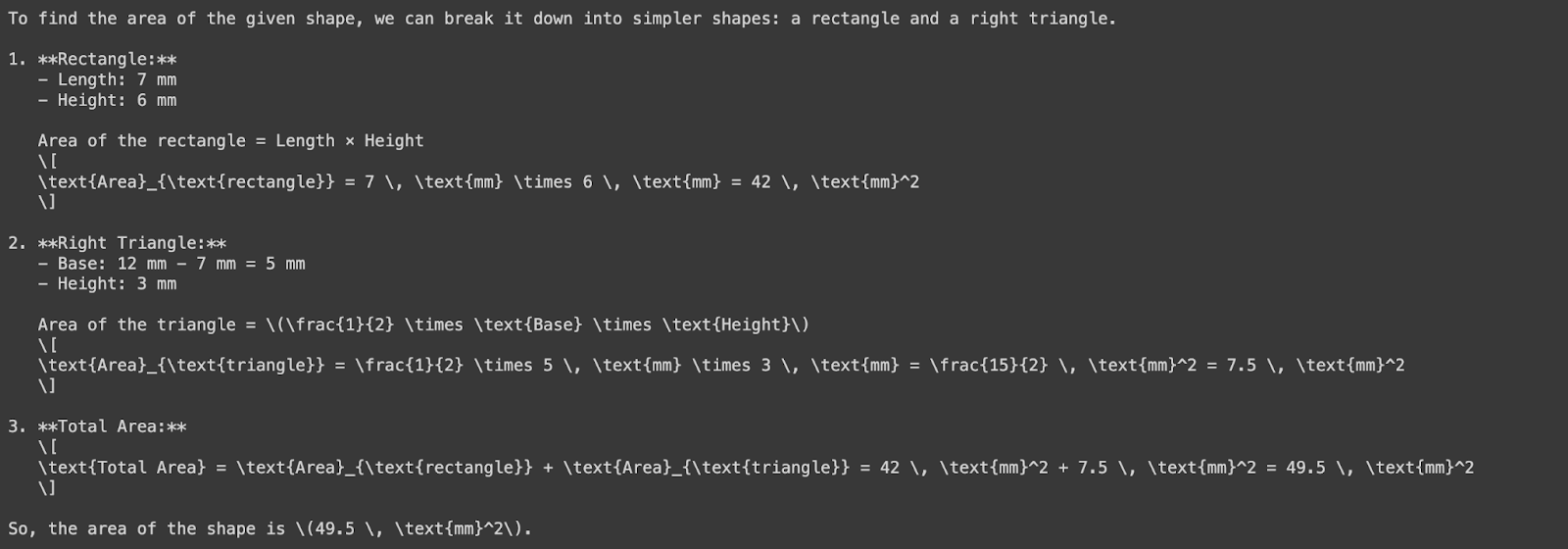

Vamos tentar analisar uma imagem para ver a área de uma forma. Vamos primeiro usar a imagem abaixo:

Agora vamos pedir ao GPT-4o para perguntar a área dessa forma — repara que estamos usando uma imagem base64 como entrada abaixo:

response = client.chat.completions.create( model=MODEL, messages=[ { "role": "system", "content": "You are a helpful assistant that responds in Markdown. Help me with my math homework!" }, { "role": "user", "content": [ {"type": "text", "text": "What's the area of the shape in this image?"}, { "type": "image_url", "image_url": { "url": f"data:image/png;base64,{base64_image}" } } ] } ], temperature=0.0,)print(response.choices[0].message.content)

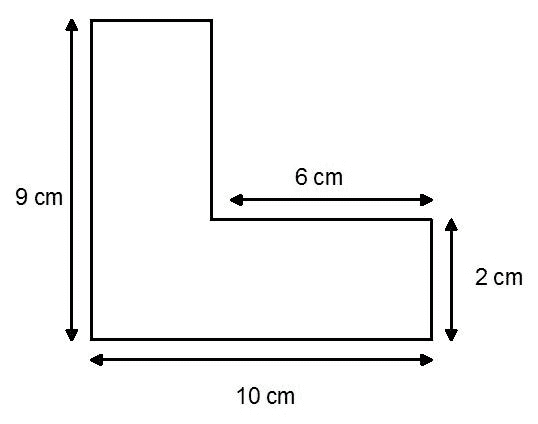

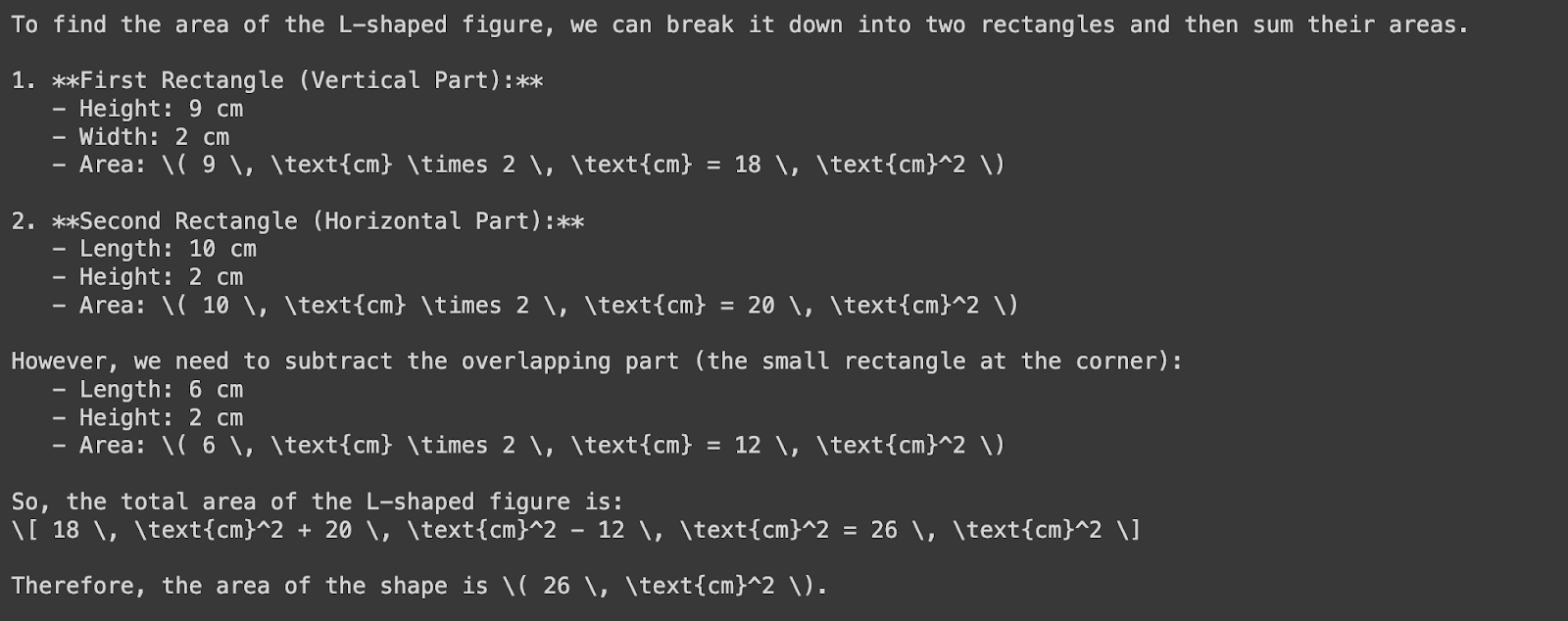

Agora vamos pensar nessa forma:

Vamos passar a URL da imagem pro GPT-4o pra achar a área da forma:

response = client.chat.completions.create( model=MODEL, messages=[ { "role": "system", "content": "You are a helpful assistant that responds in Markdown. Help me with my math homework!" }, { "role": "user", "content": [ {"type": "text", "text": "What's the area of the shape in the image?"}, { "type": "image_url", "image_url": { "url": "https://images.saymedia-content.com/.image/c_limit%2Ccs_srgb%2Cq_auto:eco%2Cw_538/MTczOTQ5NDQyMzQ3NTc0NTc5/compound-shapes-how-to-find-the-area-of-a-l-shape.webp" } } ] } ], temperature=0.0,)print(response.choices[0].message.content)

Repara que o GPT-4o mediu errado a largura do retângulo vertical — deveria ser quatro centímetros, não dois. Essa diferença é por causa do desalinhamento entre as etiquetas de medida e as proporções reais do retângulo. Isso só mostra mais uma vez como é importante ter alguém de olho e conferir tudo.

Preços da API GPT-4o

A partir de julho de 2025, o preço do GPT-4o será pago conforme o uso:

Tokens de entrada: US$ 5,00 por milhão de tokens

Tokens de entrada armazenados em cache: US$ 2,50 por milhão de tokens

Tokens de saída: US$ 20,00 por milhão de tokens

GPT-4o Mini: Uma alternativa econômica

Para aplicações que precisam de muitas chamadas API, a OpenAI tem o GPT-4o Mini, uma versão mais simples do GPT-4o:

Tokens de entrada: US$ 0,60 por milhão de tokens

Tokens de entrada em cache: US$ 0,30 por milhão de tokens

Tokens de saída: US$ 2,40 por milhão de tokens

Descontos na API em lote

A API Batch da OpenAI dá um desconto de 50% nos custos de tokens de entrada e saída para o GPT-4o:

Tokens de entrada: US$ 2,50 por milhão de tokens

Tokens de saída: US$ 10,00 por milhão de tokens

Isso é perfeito pra processar grandes volumes de dados de forma assíncrona.

GPT-4o API: Considerações importantes

Quando estiver usando a API GPT-4o, é importante lembrar algumas coisas importantes pra garantir um desempenho ótimo, custo-benefício e alinhamento com cada caso específico. Aqui estão três fatores importantes pra você pensar:

Preços e gerenciamento de custos

A API da OpenAI funciona com um modelo de pagamento por uso, onde você paga de acordo com o número de tokens processados.

Embora o GPT-4o seja mais barato que o GPT-4 Turbo, planejar o uso de acordo com as necessidades é essencial para estimar e controlar os custos.

Para minimizar os custos, você pode pensar em usar técnicas como agrupamento e otimização de prompts para reduzir o número de chamadas de API e tokens processados.

Latência e desempenho

Mesmo que o GPT-4o tenha um desempenho incrível e baixa latência, ainda é um modelo de linguagem grande, o que significa que processar pedidos pode exigir muito da computação, levando a uma latência relativamente alta.

Precisamos otimizar nosso código e usar técnicas como cache e processamento assíncrono para resolver problemas de latência.

Além disso, a gente pode ver como usar as instâncias dedicadas da OpenAI ou ajustar o modelo pro nosso caso específico, o que pode melhorar o desempenho e reduzir a latência.

Alinhamento do caso de uso

O GPT-4o é um modelo geral bem poderoso, com várias capacidades, mas a gente precisa garantir que o nosso caso específico de uso esteja de acordo com os pontos fortes do modelo.

Antes de confiar só no GPT-4o, a gente precisa avaliar com cuidado o nosso caso de uso e ver se as capacidades do modelo são adequadas para as nossas necessidades.

Se precisar, a gente pode ajustar modelos menores ou ver outros modelos que possam ser mais legais para o que a gente precisa fazer.

Conclusão

Os recursos multimodais do GPT-4 resolvem as limitações dos modelos anteriores, que tinham dificuldade para integrar e processar diferentes tipos de dados de maneira integrada.

Usando a API GPT-4o, os desenvolvedores podem criar soluções inovadoras que juntam texto, áudio e dados visuais de um jeito super legal.

Se você quiser praticar mais com o GPT-4o, recomendo este código sobre como criar assistentes de IA com o GPT-4o. Da mesma forma, se você quiser saber mais sobre como trabalhar com APIs, recomendo estes recursos:

Perguntas frequentes

O que é o GPT-4o e como ele é diferente dos modelos anteriores?

O GPT-4o é um modelo de linguagem multimodal desenvolvido pela OpenAI, capaz de processar e gerar texto, áudio e dados visuais. Diferente dos modelos anteriores, como o GPT-4, que só lidava com texto, o GPT-4o junta áudio e imagem, permitindo interações mais naturais e melhores recursos em várias modalidades.

Como os desenvolvedores podem acessar o GPT-4o através da API da OpenAI?

Os desenvolvedores podem acessar o GPT-4o através da API OpenAI, criando uma conta OpenAI, pegando uma chave API e instalando a biblioteca Python OpenAI.

Quanto custa usar a API GPT-4o e como ela se compara a outros modelos?

A API GPT-4o funciona com um modelo de pagamento por uso, com os custos baseados no número de tokens processados. Comparado com modelos anteriores, como o GPT-4, o GPT-4o tem uma redução de 50% nos custos, o que o torna mais acessível. Uma comparação de preços com outros modelos é apresentada no artigo.

O GPT-4o pode ser ajustado para casos de uso ou setores específicos?

Sim, o GPT-4o pode ser ajustado para casos de uso ou setores específicos por meio de técnicas como o aprendizado por transferência. Ao ajustar os dados ou tarefas específicas do domínio, os desenvolvedores podem melhorar o desempenho do modelo e adaptá-lo às suas necessidades específicas.

Que recursos estão disponíveis para aprender mais e implementar a API GPT-4o?

Tem vários recursos, tipo tutoriais, cursos e exemplos práticos, pra quem quer aprender mais e usar a API GPT-4o. O artigo recomenda dar uma olhada no curso Trabalhando com a API OpenAI do DataCamp, no OpenAI Cookbook e na folha de dicas do DataCamp pra uma referência rápida e orientações práticas de implementação.

Quando devo usar o GPT-4o em vez do GPT-4o-mini?

O GPT-4o é ideal para casos de uso mais complexos que exigem análise detalhada, compreensão da linguagem ou interações mais longas. Por outro lado, o GPT-4o-mini é mais rápido e econômico, o que o torna mais adequado para tarefas leves ou quando é preciso uma resposta rápida. Os dois modelos têm recursos multimodais, mas o GPT-4o é melhor quando é preciso raciocínio mais avançado e interação entre modalidades.

Como a API GPT-4o se compara à API o1 em casos de uso específicos?

Enquanto o GPT-4o é ótimo pra tarefas que envolvem dados multimodais (texto, áudio e imagens), a API o1 é excelente em raciocínio complexo e resolução de problemas, principalmente em ciências, programação e matemática. Se você precisa de respostas rápidas com um raciocínio moderado, o GPT-4o é a melhor opção. Mas, pra tarefas que precisam de uma análise lógica mais profunda e precisão, tipo gerar códigos complexos ou resolver problemas matemáticos avançados, a API o1 tem recursos mais fortes.

Introdução aos agentes de IA

Ryan é um cientista de dados líder, especializado na criação de aplicativos de IA usando LLMs. Ele é candidato a PhD em Processamento de Linguagem Natural e Gráficos de Conhecimento no Imperial College London, onde também concluiu seu mestrado em Ciência da Computação. Fora da ciência de dados, ele escreve um boletim informativo semanal da Substack, The Limitless Playbook, no qual compartilha uma ideia prática dos principais pensadores do mundo e, ocasionalmente, escreve sobre os principais conceitos de IA.