programa

OpenAI acaba de lanzar el esperado modelo o3. Originalmente anunciados durante el evento navideño de 12 días de la empresa en diciembre de 2024, o3 y o3-mini se presentaron como un gran salto adelante, hasta el punto de que OpenAI omitió por completo "o2", citando la posible confusión de marca con O2 de Telefónica, pero probablemente también para señalar un salto sustancial con respecto a OpenAI o1.

Tras meses de idas y venidas -incluido un breve desvío en el que se dijo que o3 se integraría en GPT-5-OpenAI ha hecho de o3 su nuevo modelo estrella. Ahora supera a o1 en casi todas las pruebas comparativas, con acceso total a la herramienta en ChatGPT y a través de la API.

Sigue leyendo para saber más sobre o3 y o3-mini. Si también quieres leer sobre el modelo más reciente, o4-mini, consulta esta guía introductoria sobre o4-mini.

Fundamentos de OpenAI

¡Empieza a utilizar la API OpenAI y mucho más!

¿Qué es OpenAI o3?

o3 es el último modelo de frontera de OpenAI, diseñado para hacer avanzar las capacidades de razonamiento en una serie de tareas complejas como la codificación, las matemáticas, la ciencia y la percepción visual.

El modelo de razonamiento o3 es el primer modelo de razonamientocon acceso alusoautónomode la herramienta . Esto significa que o3 puede utilizar la búsqueda, Python, la generación de imágenes y la interpretación para realizar sus tareas.

Esto se ha traducido en un gran rendimiento en pruebas comparativas avanzadas que ponen a prueba la resolución de problemas en el mundo real, donde los modelos anteriores han tenido dificultades. OpenAI destaca la mejora de o3 respecto a o1, posicionándolo como su modelo más capaz y versátil hasta la fecha.

O1 vs. O3

o3 se basa directamente en los cimientos establecidos por o1, pero las mejoras son significativas en áreas clave. OpenAI ha posicionado o3 como un modelo diseñado para manejar tareas de razonamiento más complejas, con mejoras de rendimiento reflejadas en sus puntos de referencia.

Codificación

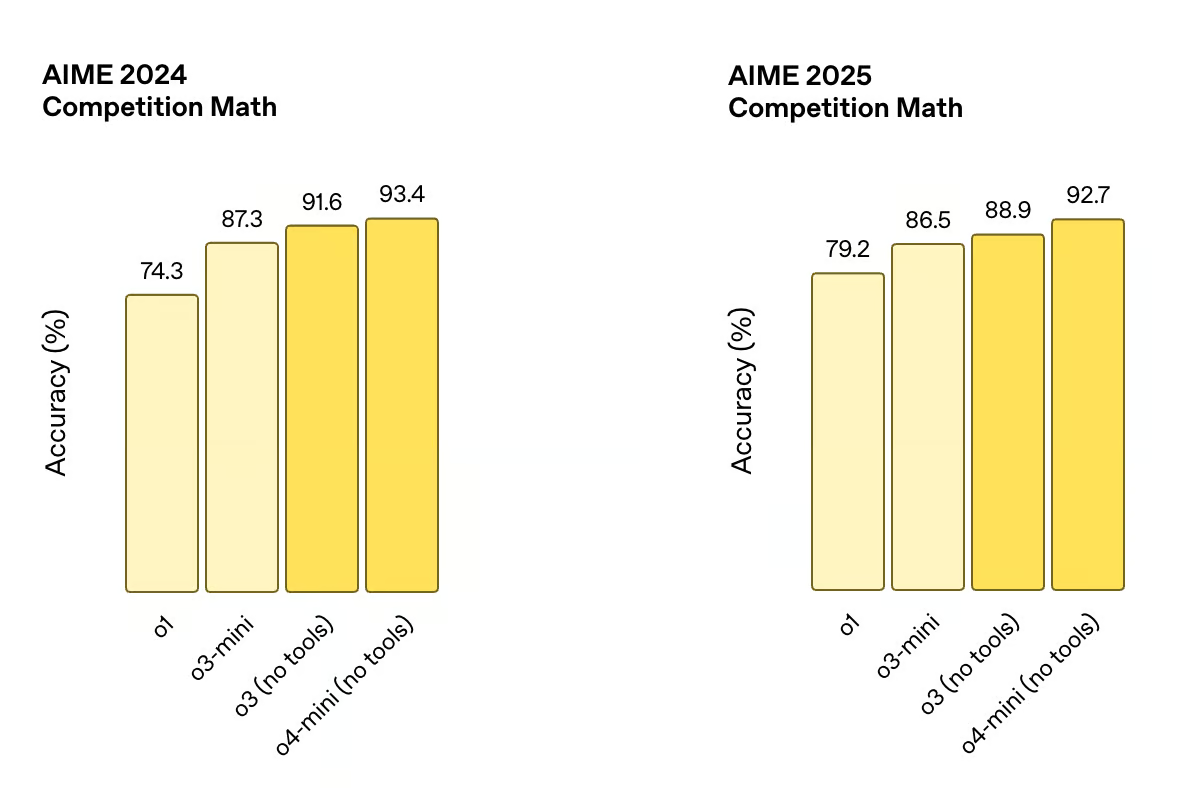

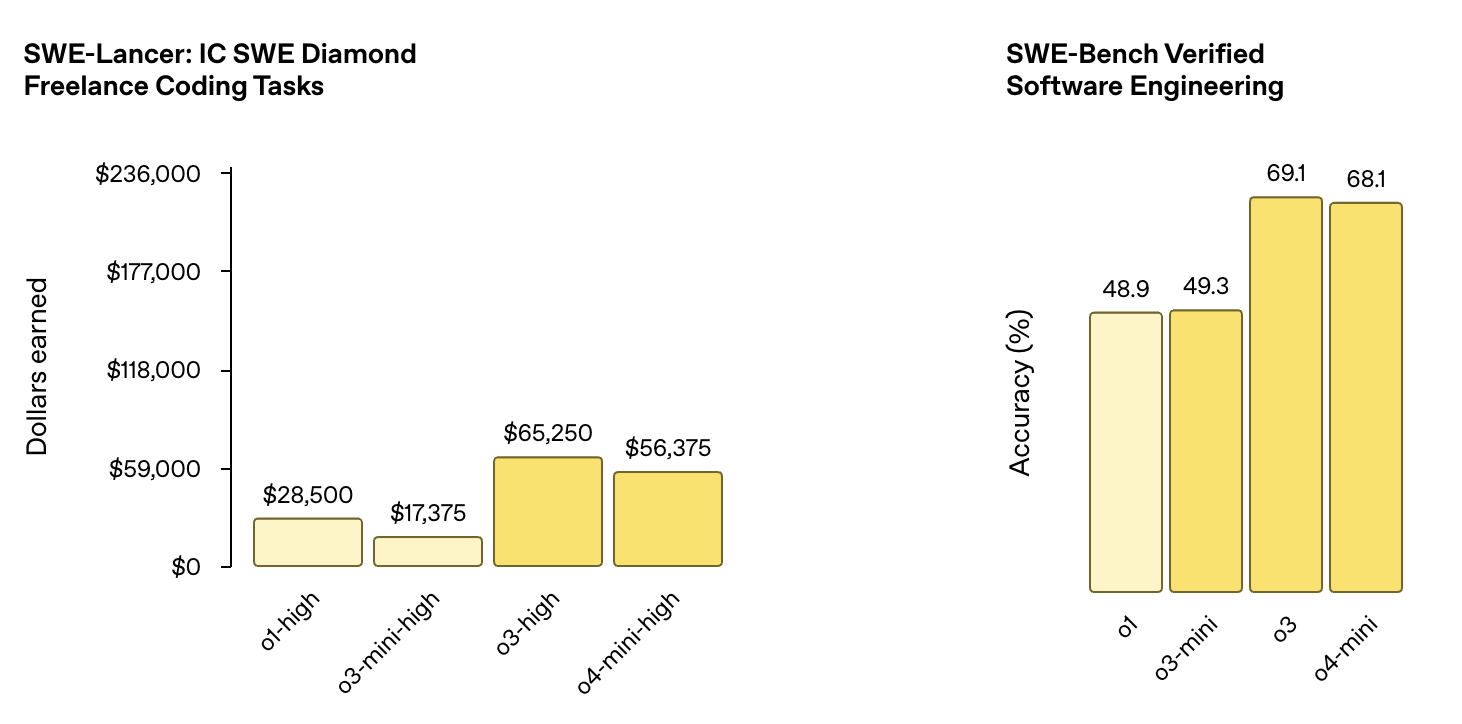

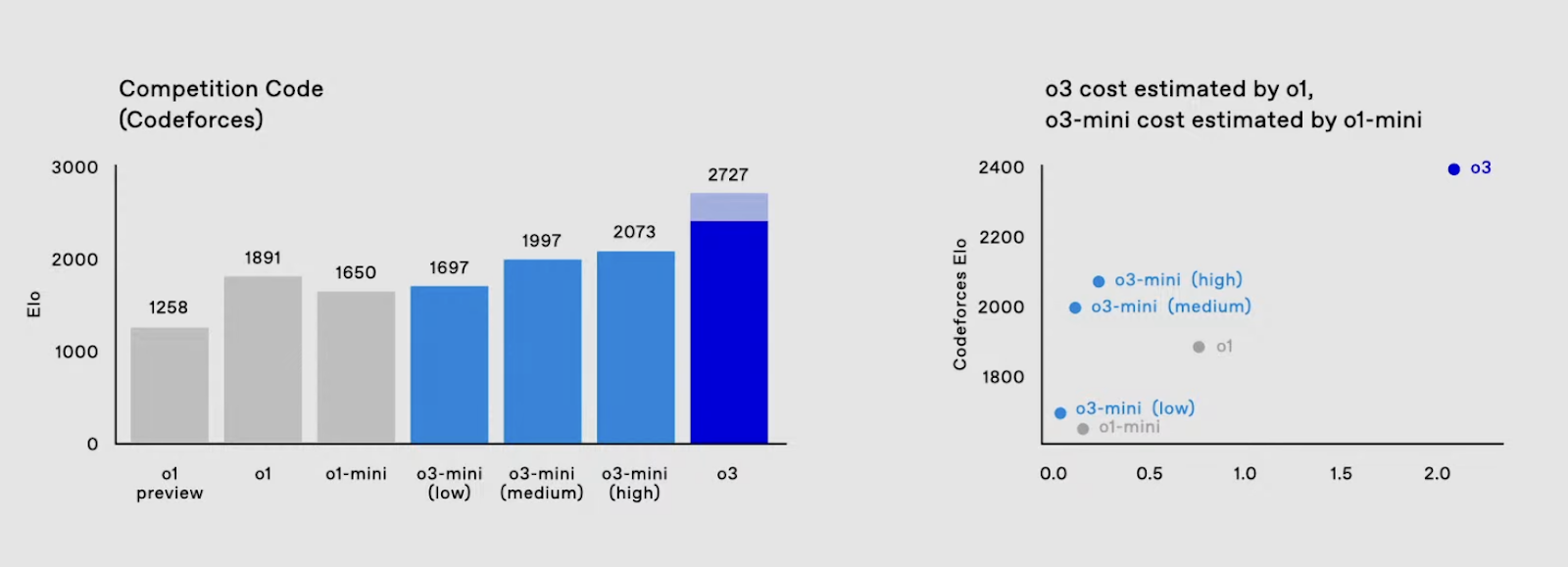

Cuando se probó en tareas de ingeniería de software, o3 alcanzó una precisión del 69,1% en la prueba de referencia SWE-Bench Verified Software Engineering, una mejora sustancial respecto a la puntuación de o1, que fue del 48,9%.

Fuente: OpenAI

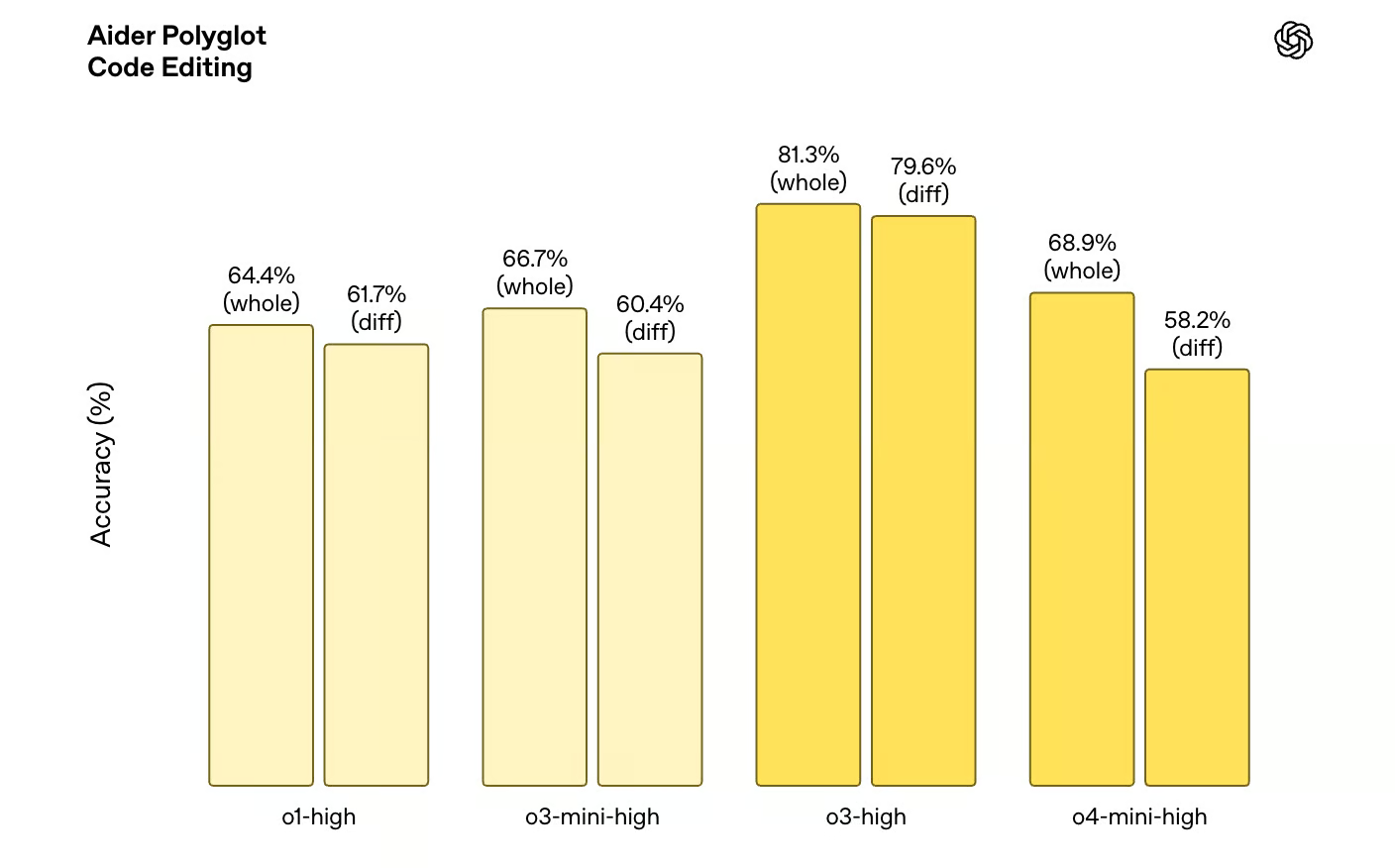

Del mismo modo, en programación competitiva, o3 alcanzó una puntuación ELO de 2706, superando con creces el máximo anterior de o1 de 1891. Además, o3 tiene un rendimiento significativamente mejor en las pruebas comparativas de edición de código, y las variantes de o3 superan a las de o1 en todos los ámbitos en la prueba comparativa Aider Polyglot Code Editing.

Fuente: OpenAI

Matemáticas y ciencias

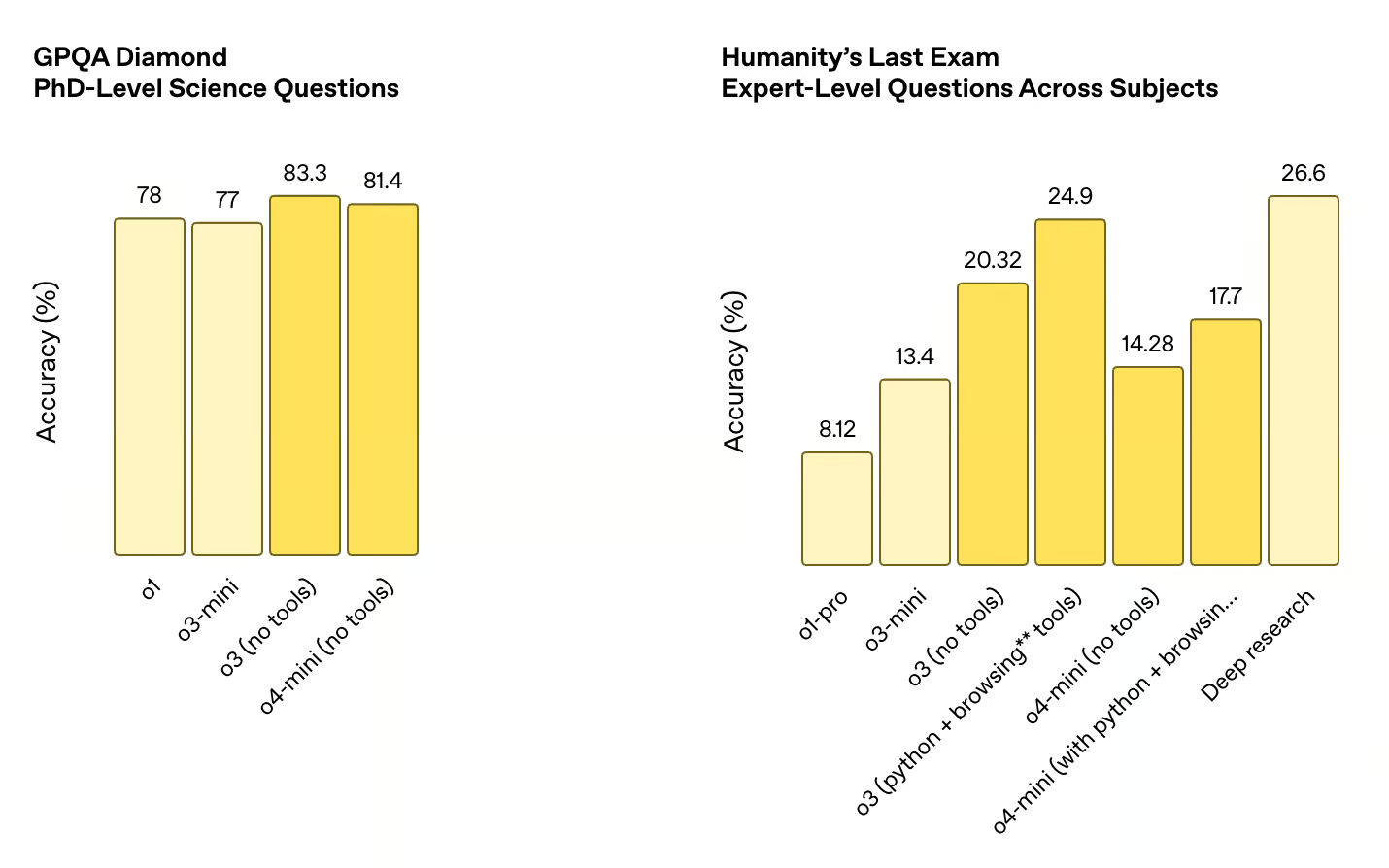

Las mejoras no se limitan a la codificación. o3 también destaca en razonamiento matemático, con un 91,6% de acierto en el AIME 2024, frente al 74,3% de o1. También obtuvo un 88,9% en el AIME 2025. Estos avances sugieren un modelo que puede manejar problemas más matizados y difíciles, acercándose a puntos de referencia tradicionalmente dominados por expertos humanos.

Fuente: OpenAI

El salto es igualmente evidente en los puntos de referencia relacionados con la ciencia. En el GPQA Diamond, que mide el rendimiento en preguntas científicas de nivel de doctorado, o3 alcanzó una precisión del 83,3%, por encima del 78% de o1. Estos avances demuestran una amplia mejora de la capacidad del modelo para resolver problemas técnicamente exigentes en todas las disciplinas.

Fuente: OpenAI

Razonamiento visual

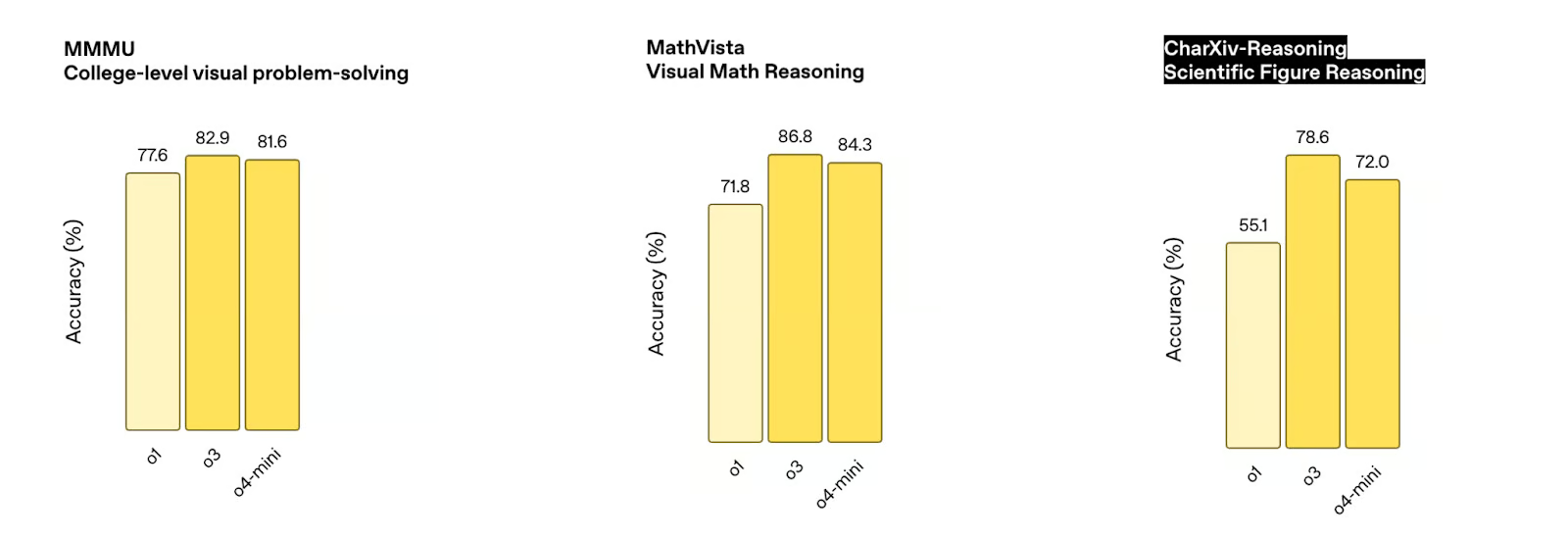

Uno de los aspectos más sorprendentes del nuevo modelo o3 es su capacidad para razonar con imágenes directamente en su cadena de pensamiento. Esto significa que o3 puede combinar el razonamiento visual y textual mientras resuelve problemas, y esto se refleja en el rendimiento de o3 en múltiples pruebas de razonamiento visual.

Fuente: OpenAI

Por ejemplo, o3 supera a o1 en una serie de pruebas comparativas de razonamiento visual, como la prueba comparativa de resolución de problemas visuales de nivel universitario MMMU (82,9% frente al 77,6% de o1), la prueba comparativa de razonamiento matemático visual MathVista (86,8% frente al 71,8% de o1) y la prueba comparativa de razonamiento de figuras científicas CharXiv-Reasoning (78,6% frente al 55,1% de o1).

Fuente: OpenAI

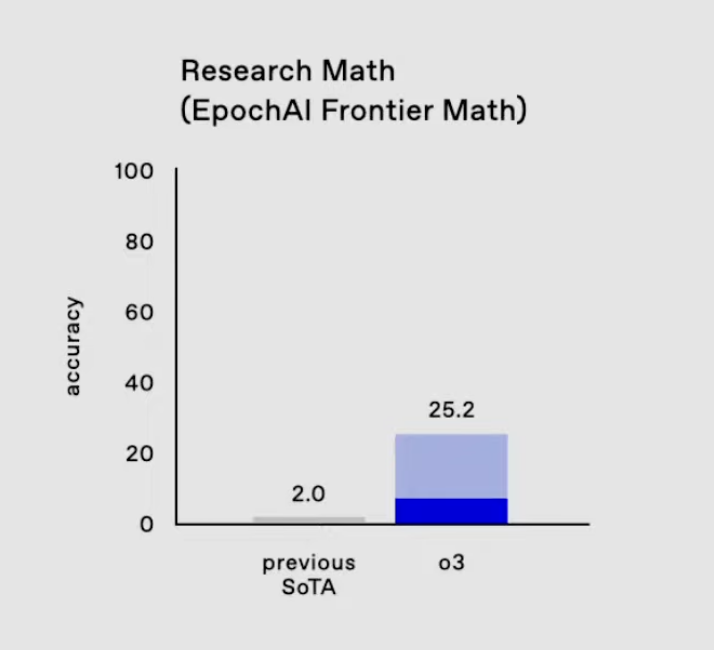

EpochAI frontera matemática

Un área en la que los progresos de o3 son especialmente notables es en la prueba comparativa EpochAI Frontier Math.

Se considera uno de los puntos de referencia más desafiantes de la IA porque consiste en problemas novedosos e inéditos, diseñados intencionadamente para que sean mucho más difíciles que los conjuntos de datos estándar. Muchos de estos problemas están al nivel de la investigación matemática, y a menudo requieren horas o incluso días a matemáticos profesionales para resolver un solo problema. Los sistemas de IA actuales suelen obtener una puntuación inferior al 2% en este parámetro, lo que pone de manifiesto su dificultad.

O3 en EpochAI Frontier Math. Fuente: OpenAI

Las Matemáticas Fronterizas de Epic AI son importantes porque llevan a los modelos más allá de la memorización u optimización de patrones familiares. En cambio, pone a prueba su capacidad para generalizar, razonar de forma abstracta y abordar problemas que no se han planteado antes, rasgos esenciales para el avance de las capacidades de razonamiento de la IA. La puntuación de o3 del 25,2% en este punto de referencia es un salto adelante respecto al rendimiento anterior del estado de la técnica. .

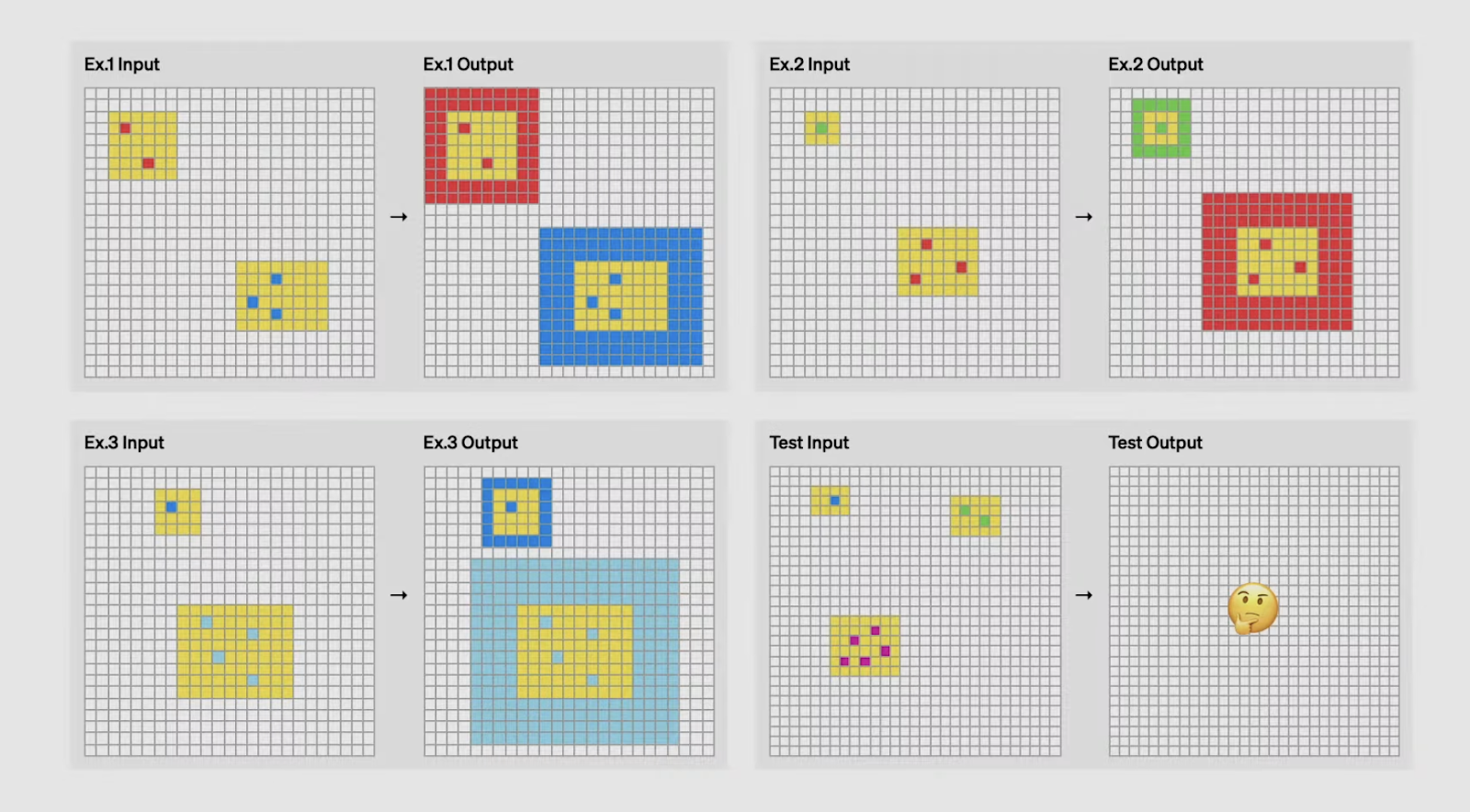

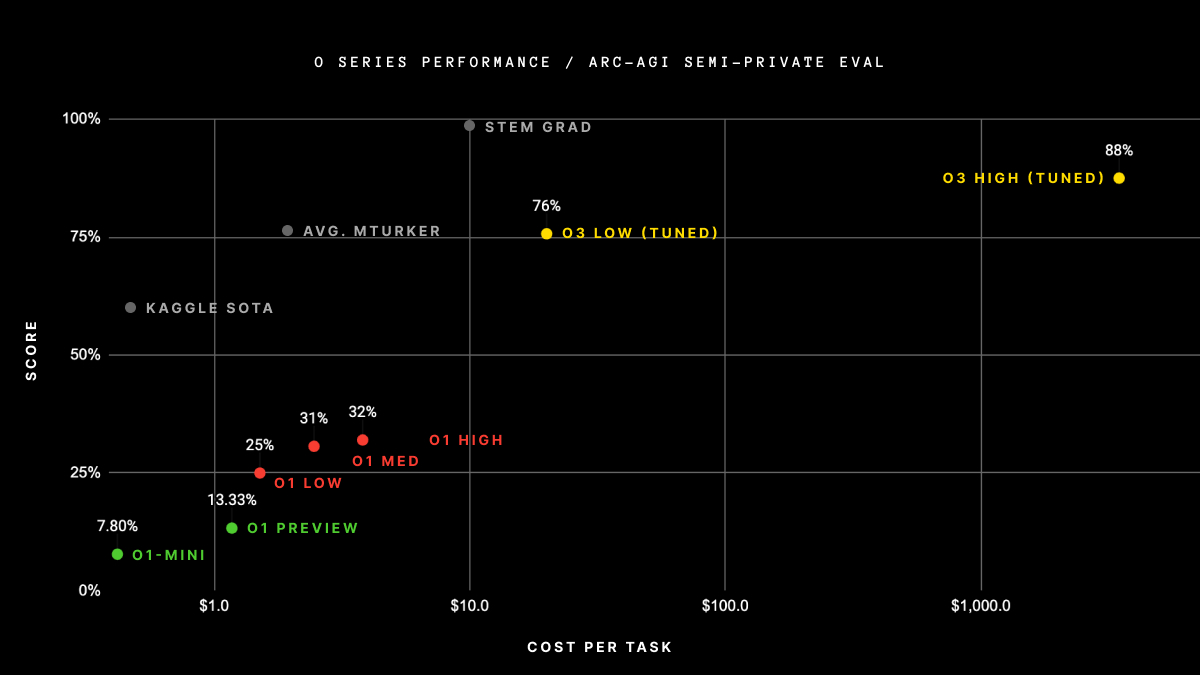

Avance de O3 en ARC AGI

Uno de los logros más sorprendentes de o3 es su rendimiento en la prueba de referencia ARC AGI, una prueba ampliamente considerada como patrón oro para evaluar la inteligencia general en la IA.

Desarrollado en 2019 por François Chollet, el ARC (Corpus de Abstracción y Razonamiento) se centra en evaluar la capacidad de una IA para aprender y generalizar nuevas habilidades a partir de ejemplos mínimos. A diferencia de los puntos de referencia tradicionales, que a menudo ponen a prueba el conocimiento preformado o el reconocimiento de patrones, las tareas ARC están diseñadas para desafiar a los modelos a inferir reglas y transformaciones sobre la marcha, tareas que los humanos pueden resolver intuitivamente, pero con las que la IA ha tenido históricamente dificultades.

Lo que hace que la AGI ARC sea especialmente difícil es que cada tarea requiere distintas capacidades de razonamiento. Los modelos no pueden basarse en soluciones o plantillas memorizadas, sino que deben adaptarse a retos totalmente nuevos en cada prueba. Por ejemplo, una tarea podría implicar la identificación de patrones en transformaciones geométricas, mientras que otra podría requerir el razonamiento sobre secuencias numéricas. Esta diversidad hace que ARC AGI sea una poderosa medida de lo bien que una IA puede pensar y aprender realmente como un humano.

¿Puedes adivinar la lógica por la que la entrada se transforma en salida? Fuente: OpenAI

El rendimiento de o3 en ARC AGI marca un hito importante. En configuraciones de bajo cálculo, el o3 obtuvo un 76% en el conjunto semiprivado de espera, una cifra muy superior a la de cualquier modelo anterior.

Cuando se probó con ajustes de alta computación, alcanzó un 88% aún más impresionante, superando el umbral del 85% citado a menudo como rendimiento de nivel humano. Es la primera vez que una IA supera a los humanos en este punto de referencia, estableciendo un nuevo estándar para las tareas basadas en el razonamiento.

Fuente: ArcPrize

Creemos que estos resultados son especialmente dignos de mención porque demuestran la capacidad de o3 para realizar tareas que exigen adaptabilidad y generalización en lugar de conocimiento memorístico o cálculo de fuerza bruta. Es un claro indicio de que el o3 se está acercando a la verdadera inteligencia general, yendo más allá de las capacidades específicas de un dominio y adentrándose en áreas que antes se consideraban territorio exclusivamente humano.

Dicho esto, los resultados anteriores se basan en la versión de o3 compartida en el evento "12 días de Navidad" de OpenAI en diciembre, y OpenAI ha confirmado que la versión recién lanzada de o3 es diferente de la que se muestra en las pruebas anteriores. ARC AGI publicará en breve los resultados actualizados del rendimiento de o3.

o3 Innovaciones técnicas

Una mejora del rendimiento tan grande no se produce porque sí. El equipo de OpenAI descubrió algunos avances para alcanzar este tipo de cifras:

Innovaciones en el aprendizaje por refuerzo

OpenAI descubrió que aumentar el presupuesto de cálculo durante el entrenamiento del aprendizaje por refuerzo mejora el rendimiento del modelo, reflejando el comportamiento de escalado que hemos visto con el preentrenamiento supervisado en los modelos GPT. Pero esta vez, en lugar de optimizar la predicción de la siguiente palabra, o3 aprende maximizando las recompensas del aprendizaje por refuerzo, a menudo mediante entornos potenciados por herramientas.

En otras palabras, OpenAI está tratando el aprendizaje por refuerzo más como un preentrenamiento -aumentándolo tanto en duración como en computación- y parece que funciona. Esto desbloquea habilidades que se benefician de la planificación a largo plazo y el razonamiento secuencial, como la programación competitiva y las pruebas matemáticas de varios pasos. Cuando se combina con el uso de herramientas, el aumento del rendimiento se hace aún más evidente.

Innovaciones en razonamiento visual

o3 también muestra mejoras significativas en el razonamiento visual. No sólo entiende las imágenes, sino que las integra directamente en su bucle de razonamiento. Eso incluye interpretar, manipular y reinspeccionar imágenes mientras se resuelven problemas. Esta es una de las razones por las que o3 rinde bien en tareas que implican figuras científicas, diagramas matemáticos e incluso programación a partir de fotos.

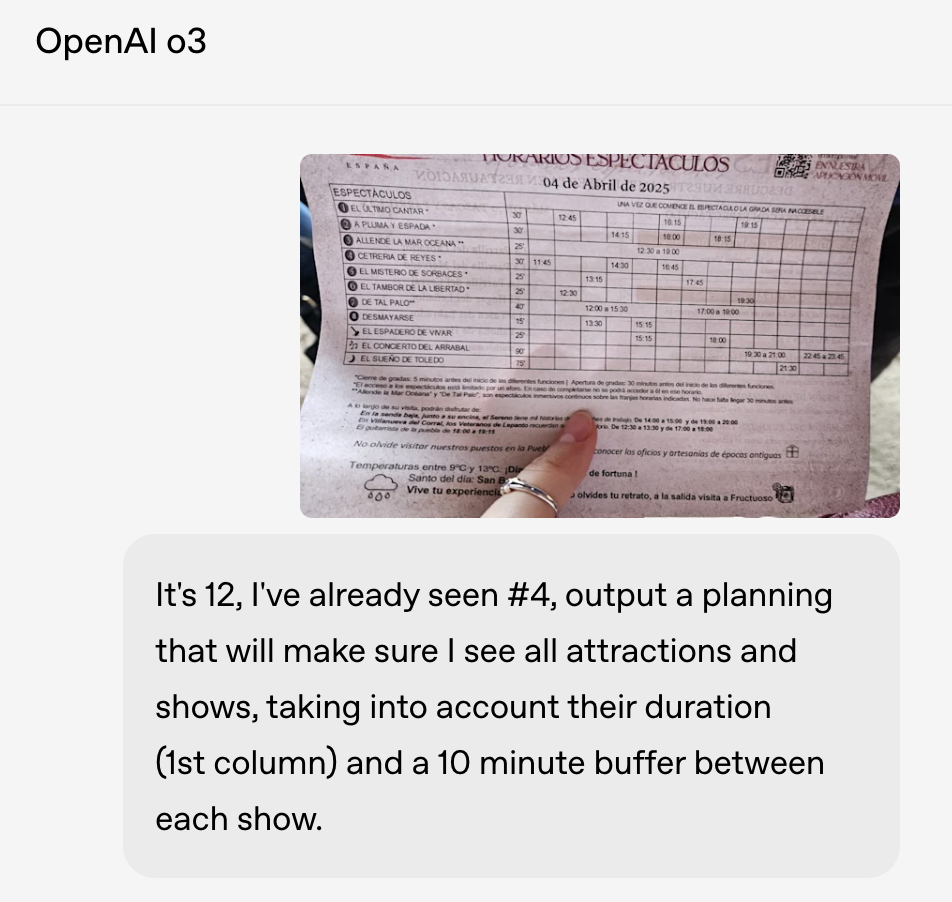

Una innovación clave es cómo o3 conserva la imagen en bruto en la memoria durante todo su proceso de razonamiento. En lugar de procesar un pie de foto estático y descartar la imagen, puede ampliar, girar o volver a visitar distintas partes de la imagen a petición mediante herramientas. Esto hace que su razonamiento sea más dinámico y le permite enfrentarse a entradas visuales más confusas, como una pizarra borrosa, un diagrama dibujado a mano o una foto del horario de una conferencia.

En un ejemplo, OpenAI utilizó o3 para leer una imagen de baja calidad del programa de un espectáculo y planificar un itinerario que se ajustara a cada evento con descansos de diez minutos entre ellos, algo que requeriría tanto analizar el diseño visual como aplicar restricciones en tiempo real.

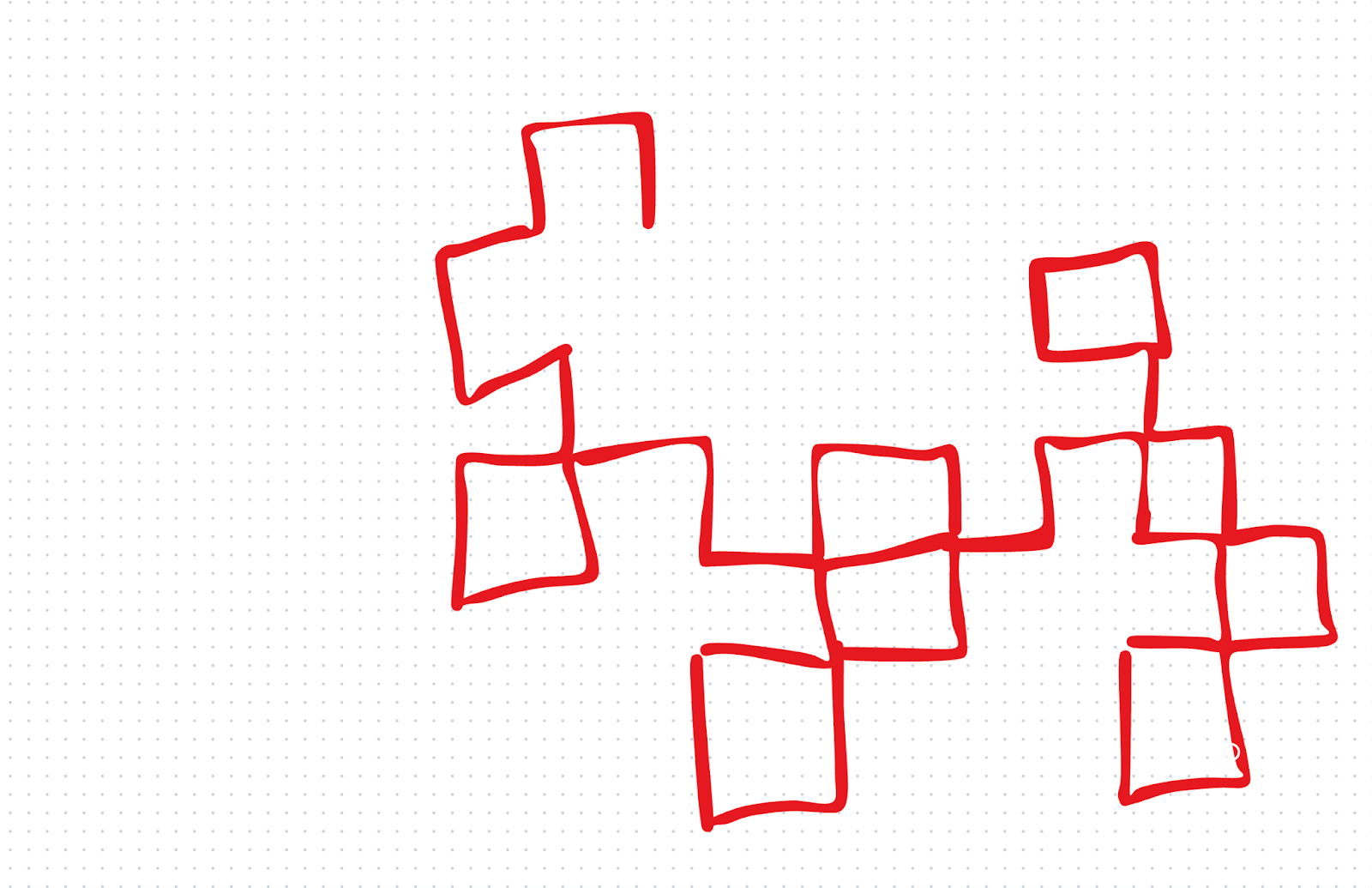

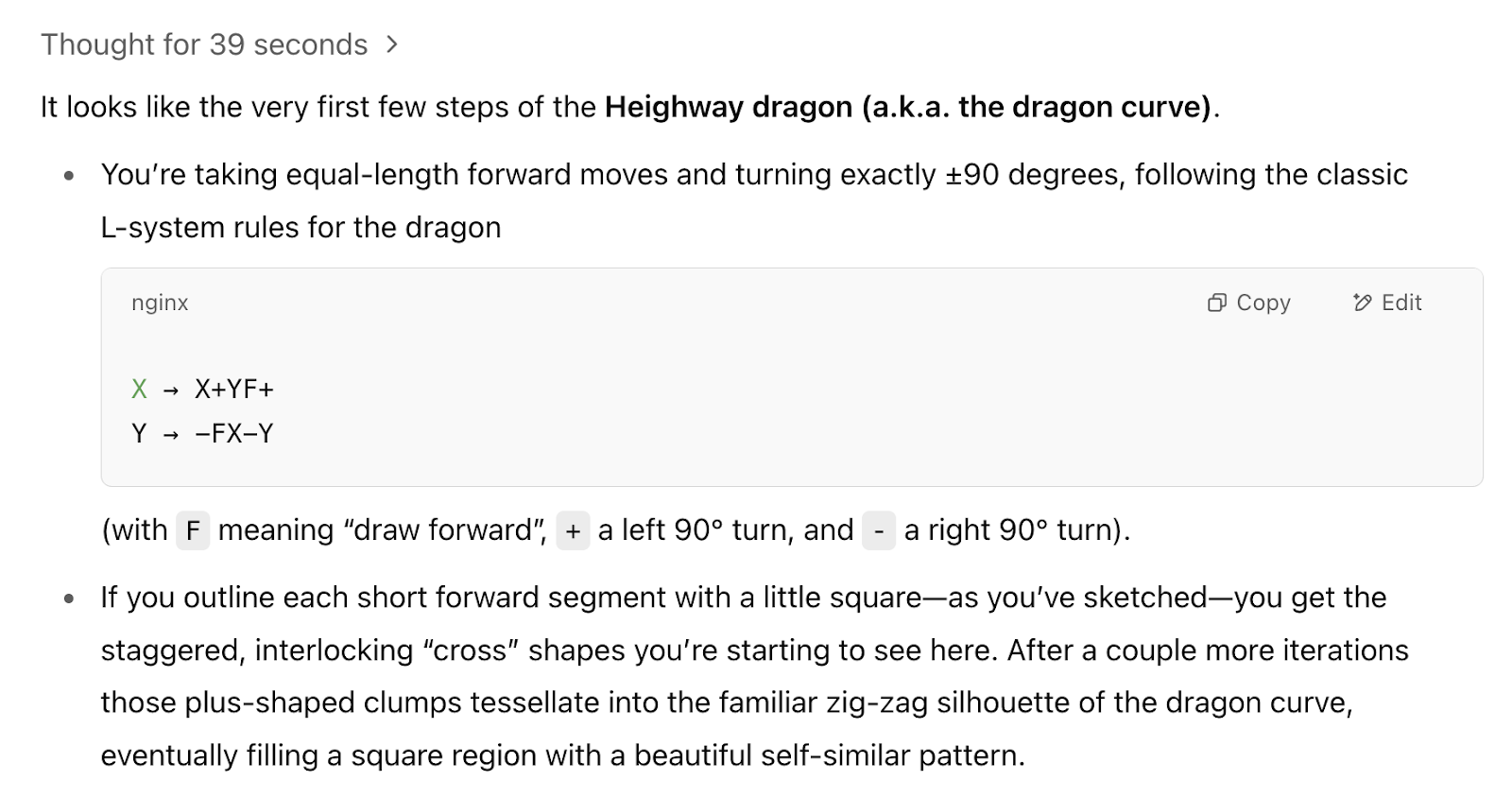

Queríamos poner a prueba las habilidades visuales con una prueba rápida propia. Primero le dimos a o1 un dibujo rudimentario y le preguntamos: "¿Qué fractal estamos empezando a dibujar?".

o1 respondió incorrectamente. o3, en cambio, acertó: Nos dijo que estábamos empezando a dibujar la curva del dragón. Fue una prueba pequeña, pero nos impresionó el resultado porque no dimos a o3 mucho con lo que trabajar.

Innovaciones en eficiencia de costes

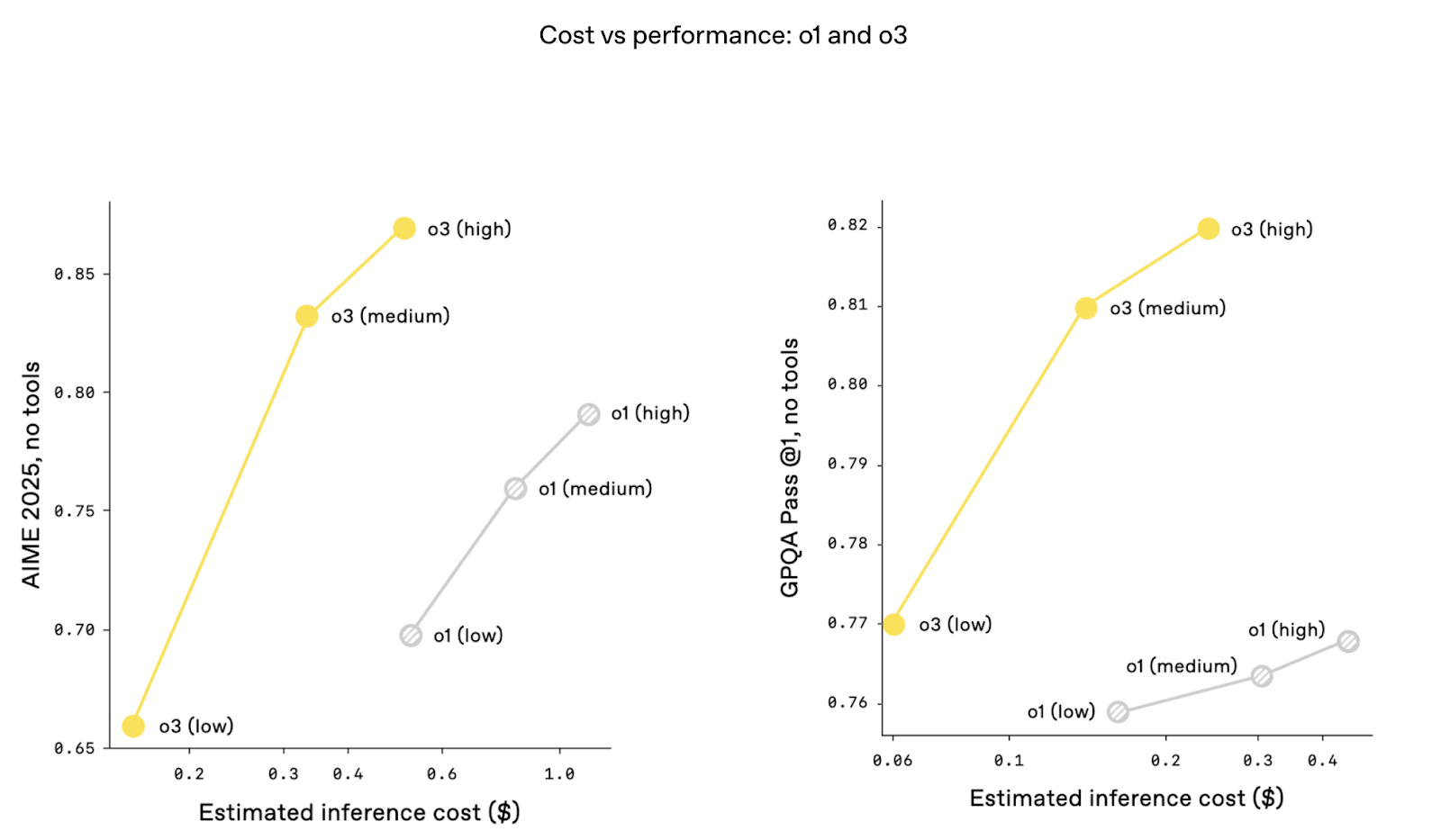

Curiosamente, las métricas de coste frente a rendimiento son mejores con o3. Es decir, el rendimiento es mayor con los mismos niveles de coste de inferencia. Esto podría deberse a optimizaciones arquitectónicas que mejoran el rendimiento de los tokens y reducen la latencia. El coste ha sido un gran tema de debate desde que Deepseek-R1 anunció un rendimiento superalto a una fracción del coste de ChatGPT.

¿Qué es o3 Mini?

A partir de abril de 2025 , o3-mini ha sido totalmente sustituido por o4-mini en ChatGPT y en la API. o4-mini ofrece un mejor rendimiento en la mayoría de los puntos de referencia, añade entrada multimodal nativa y mantiene la compatibilidad con herramientas, todo ello sin dejar de ser más rápido y asequible que o3. En efecto, o4-mini asume ahora la función para la que se diseñó o3-mini. Sin embargo, el contenido que aparece a continuación sigue siendo válido sobre o3-mini.

o3-mini se introdujo junto a o3 como una alternativa rentable diseñada para llevar las capacidades avanzadas de razonamiento a más usuarios, manteniendo el rendimiento. OpenAI describió o3-mini como la redefinición de la "frontera coste-rendimiento" en los modelos de razonamiento, haciéndolo accesible para tareas que exigen una gran precisión pero necesitan equilibrar las limitaciones de recursos.

Una de las características destacadas de o3-mini es su tiempo de pensamiento adaptativo, que permite a los usuarios ajustar el esfuerzo de razonamiento del modelo en función de la complejidad de la tarea. Para problemas más sencillos, los usuarios pueden seleccionar razonamiento de bajo esfuerzo para maximizar la velocidad y la eficacia.

Para tareas más exigentes, las opciones de mayor esfuerzo de razonamiento permiten al modelo rendir a niveles comparables al propio o3, pero a una fracción del coste. Esta flexibilidad es especialmente atractiva para los desarrolladores e investigadores que trabajan en diversos casos de uso.

Fuente: OpenAI

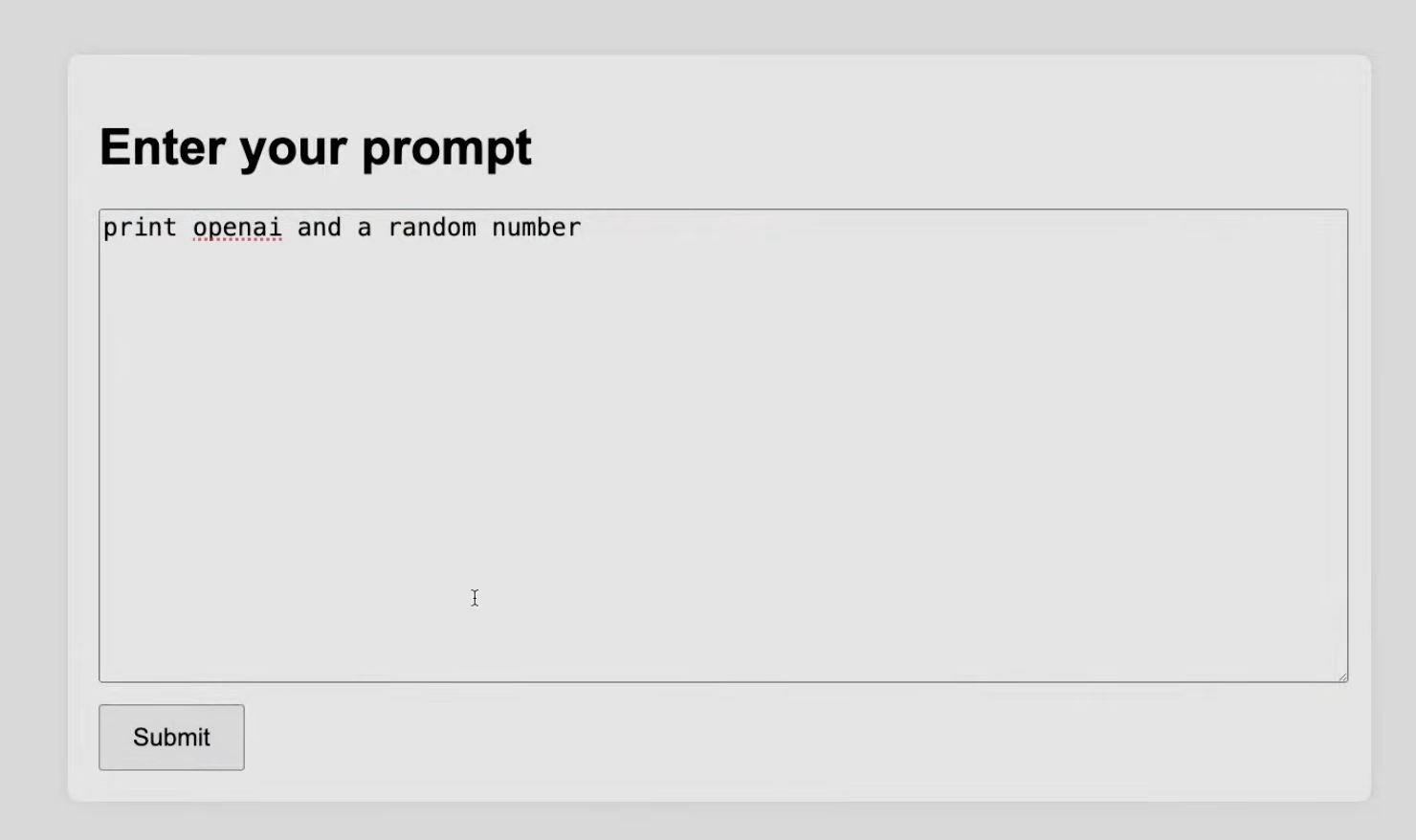

La demostración en directo mostró cómo o3-mini cumple su promesa. Por ejemplo, en una tarea de codificación, se encargó a o3-mini que generara un script Python para crear un servidor local con una interfaz de usuario interactiva para realizar pruebas. A pesar de la complejidad de la tarea, el modelo funcionó bien, demostrando su capacidad para afrontar retos de programación.

Fuente: OpenAI

Consideramos que o3-mini es una solución práctica para situaciones en las que la rentabilidad y el rendimiento deben estar alineados.

o3 Actualizaciones en las pruebas de seguridad

El O3 tardó algún tiempo más en estar disponible, y algunas de las razones podrían estar relacionadas con las innovaciones en seguridad.

Entrenamiento para el rechazo redefinido

OpenAI dijo que reconstruyó sus conjuntos de datos de entrenamiento de seguridad e introdujo miles de avisos de rechazo dirigidos. Señalaron categorías específicas: amenazas biológicas, generación de malware y técnicas de jailbreak. Estos datos de entrenamiento renovados han permitido a o3 demostrar una gran precisión de rechazo en pruebas de referencia internas, como el manejo de la jerarquía de instrucciones y la resistencia al jailbreak. Para conseguirlo, según se dice, OpenAI hizo que los miembros de su equipo pasaran mil horas marcando contenidos inseguros.

Seguimiento con razonamiento LLM

OpenAI también ha implementado un monitor LLM basado en el razonamiento (lo que ellos llaman un "monitor de razonamiento centrado en la seguridad"). Así que, además de entrenar al modelo para que diga "no" a las indicaciones inseguras, OpenAI ha introducido una capa de seguridad adicional, que es un LLM basado en el razonamiento. Piensa en ello como un modelo de vigilancia que funciona en paralelo, entrenado específicamente para razonar sobre la intención y los riesgos potenciales de las entradas del usuario, utilizando como guía las reglas de seguridad escritas por humanos.

Alineación deliberativa

OpenAI ha adoptado un enfoque proactivo en las pruebas de seguridad de o3 y o3 mini, abriendo el acceso a los investigadores para que realicen evaluaciones públicas de seguridad antes de la publicación completa de los modelos.

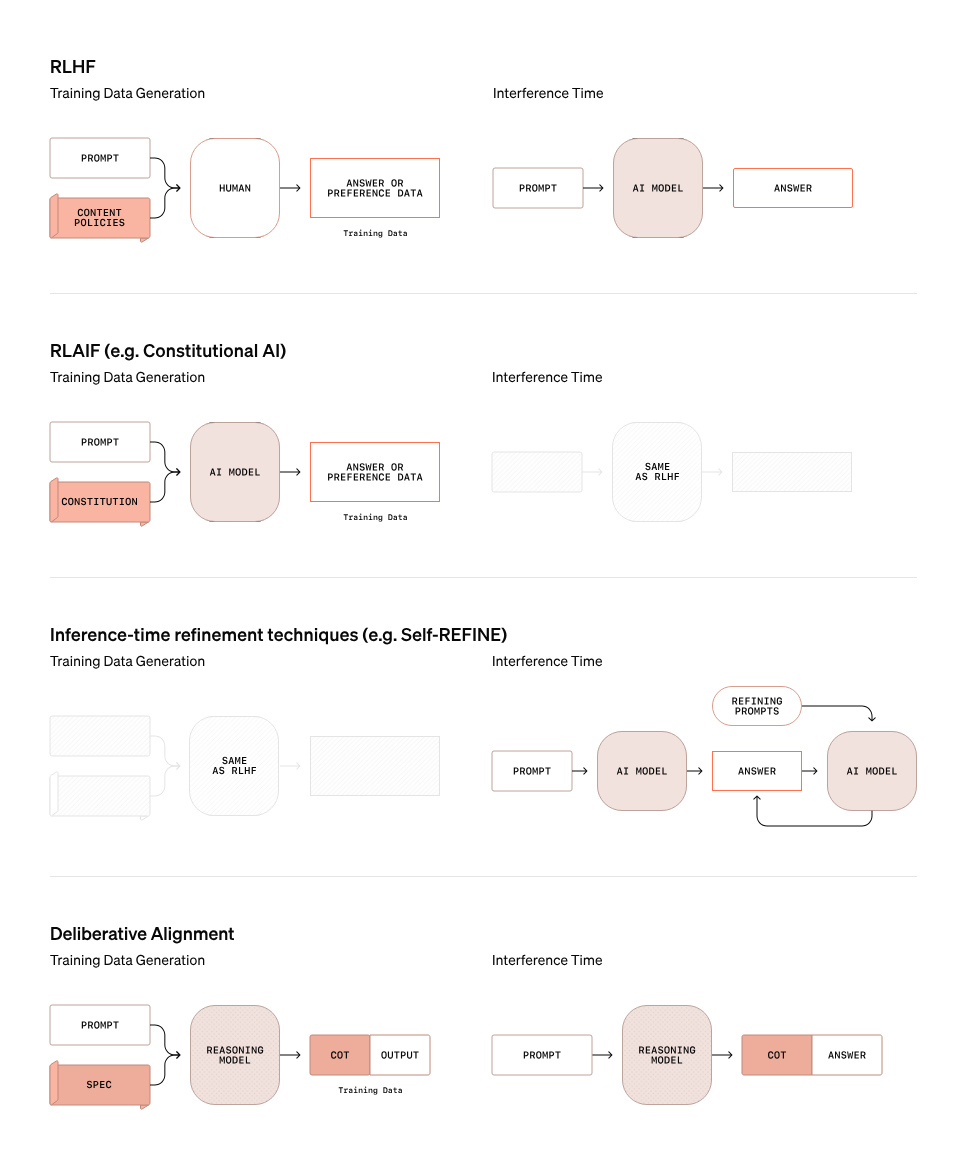

Una característica central de la estrategia de seguridad de OpenAI para o3 es la alineación deliberativa, un método que va más allá de los enfoques de seguridad tradicionales. El siguiente gráfico muestra en qué se diferencia el alineamiento deliberativo de otros métodos como el RLHF (Aprendizaje por Refuerzo con Retroalimentación Humana), RLAIF (Aprendizaje por Refuerzo con Retroalimentación AI), y técnicas de refinamiento en tiempo de inferencia como Self-REFINE.

Fuente: OpenAI

En la alineación deliberativa, el modelo no se basa simplemente en reglas estáticas o conjuntos de datos de preferencias para determinar si una indicación es segura o insegura. En su lugar, utiliza sus capacidades de razonamiento para evaluar las indicaciones en tiempo real. El gráfico anterior ilustra este proceso:

- Generación de datos de entrenamiento: A diferencia del RLHF, en el que la aportación humana informa directamente al modelo, el alineamiento deliberativo utiliza un modelo de razonamiento para generar cadena de pensamiento (CoT) para indicaciones concretas. Estos resultados de CoT proporcionan patrones de razonamiento matizados que guían el proceso de entrenamiento, ayudando al modelo a comprender el contexto y la intención con mayor eficacia.

- Tiempo de inferencia: Durante la inferencia, el modelo de razonamiento evalúa las indicaciones y proporciona una explicación de la cadena de pensamiento junto con sus respuestas. Este paso permite al modelo evaluar dinámicamente la intención y el contexto de una indicación, identificando posibles riesgos ocultos o ambigüedades que las reglas estáticas podrían pasar por alto.

OpenAI espera que queramos seguir leyendo sobre seguridad. En previsión de ello, publicaron su Marco de Preparación con sus ideas sobre la medición y la protección frente a daños graves.

¿Qué pasa con o3-Pro?

En el selector de modelos de ChatGPT, ahora verás disponibles o3 y o4-mini. Según el anuncio de OpenAI, se espera que o3-pro se lance en las próximas semanas. Incluirá las mismas funciones de uso de herramientas -como Python, navegación y análisis de imágenes- que los demás modelos de la serie o.

Si te interesa recibir información actualizada sobre cuándo estará disponible o3-pro, suscríbete al boletín de DataCamp, The Median, y te avisaremos en cuanto esté disponible.

Conclusión

O3 y o3 mini ponen de relieve la creciente complejidad de los sistemas de IA y los retos que plantea su liberación responsable. Aunque los puntos de referencia son impresionantes, nos interesan más las preguntas que plantean estos modelos: ¿Cómo seguirán funcionando en situaciones reales? ¿Son las medidas de seguridad lo suficientemente sólidas como para abordar casos extremos a escala?

Para nosotros, el o3 y el o3 mini son las primeras señales de que los sistemas de IA avanzan hacia una mayor autonomía. Su impresionante razonamiento y adaptabilidad sugieren un cambio de herramientas que manejamos a agentes que actúan en nuestro nombre. ¿Qué ocurre cuando estos sistemas navegan por tareas abiertas sin indicaciones humanas? ¿Cómo evaluamos los modelos que generan sus propios objetivos, no sólo sus resultados?

Si te interesa explorar más temas de IA, te recomendamos:

Preguntas frecuentes

¿Qué es OpenAI o3 y en qué se diferencia de o1?

o3 es la última iteración de los modelos de razonamiento de OpenAI. En comparación con OpenAI o1, los modelos o3 y o3-mini demuestran un rendimiento mejorado en tareas de razonamiento, como la codificación, el análisis científico y la capacidad de avance hacia tareas novedosas.

¿Es OpenAI o3 multimodal?

De momento, no se ha anunciado nada sobre las capacidades multimodales de o3.

¿Cuál es la diferencia entre OpenAI o3 y o3-mini?

Al igual que OpenAI O1 y O1-mini, se espera que OpenAI O3-mini tenga un rendimiento ligeramente inferior a O3, pero que su ejecución y utilización sean más rentables.

Soy editora y redactora de blogs, tutoriales y noticias sobre IA, y me aseguro de que todo se ajuste a una sólida estrategia de contenidos y a las mejores prácticas de SEO. He escrito cursos de ciencia de datos sobre Python, estadística, probabilidad y visualización de datos. También he publicado una novela premiada y dedico mi tiempo libre a escribir guiones y dirigir películas.

Adel es educador de Ciencia de Datos, conferenciante y Evangelista en DataCamp, donde ha publicado varios cursos y formación en directo sobre análisis de datos, aprendizaje automático e ingeniería de datos. Le apasiona difundir las habilidades y la alfabetización en materia de datos en las organizaciones y en la intersección entre tecnología y sociedad. Tiene un máster en Ciencia de Datos y Análisis Empresarial. En su tiempo libre, puedes encontrarle pasando el rato con su gato Louis.