O GPT-4 é a IA generativa mais avançada desenvolvida pela OpenAI. Isso está mudando o cenário de como trabalhamos. No entanto, o GPT-4 não é de código aberto, o que significa que não temos acesso ao código, à arquitetura do modelo, aos dados ou aos pesos do modelo para reproduzir os resultados. Não podemos criar nosso próprio GPT-4 como um chatbot.

Para equilibrar a escala, as comunidades de código aberto começaram a trabalhar em alternativas ao GPT-4 que oferecem desempenho e funcionalidade quase semelhantes e exigem menos recursos computacionais.

Você pode aprender sobre GPT-1, GPT-2, GPT-3 e GPT-4 revisando: O que é GPT-4 e por que ele é importante?, ou você pode aprender a usar o ChatGPT For Data Science Projects e dominar a engenharia de prompt para melhorar a criação de projetos de ciência de dados de ponta a ponta.

No artigo, apresentaremos 12 alternativas de GPT-4 com uma breve descrição e links para o artigo de pesquisa relevante, publicação de blog, demonstração de chatbot, código-fonte e cartão de modelo.

Observação: Alguns dos modelos mencionados têm uma licença não comercial, que restringe seu uso apenas para fins acadêmicos e de pesquisa. Você precisa entender essas limitações antes de usá-las.

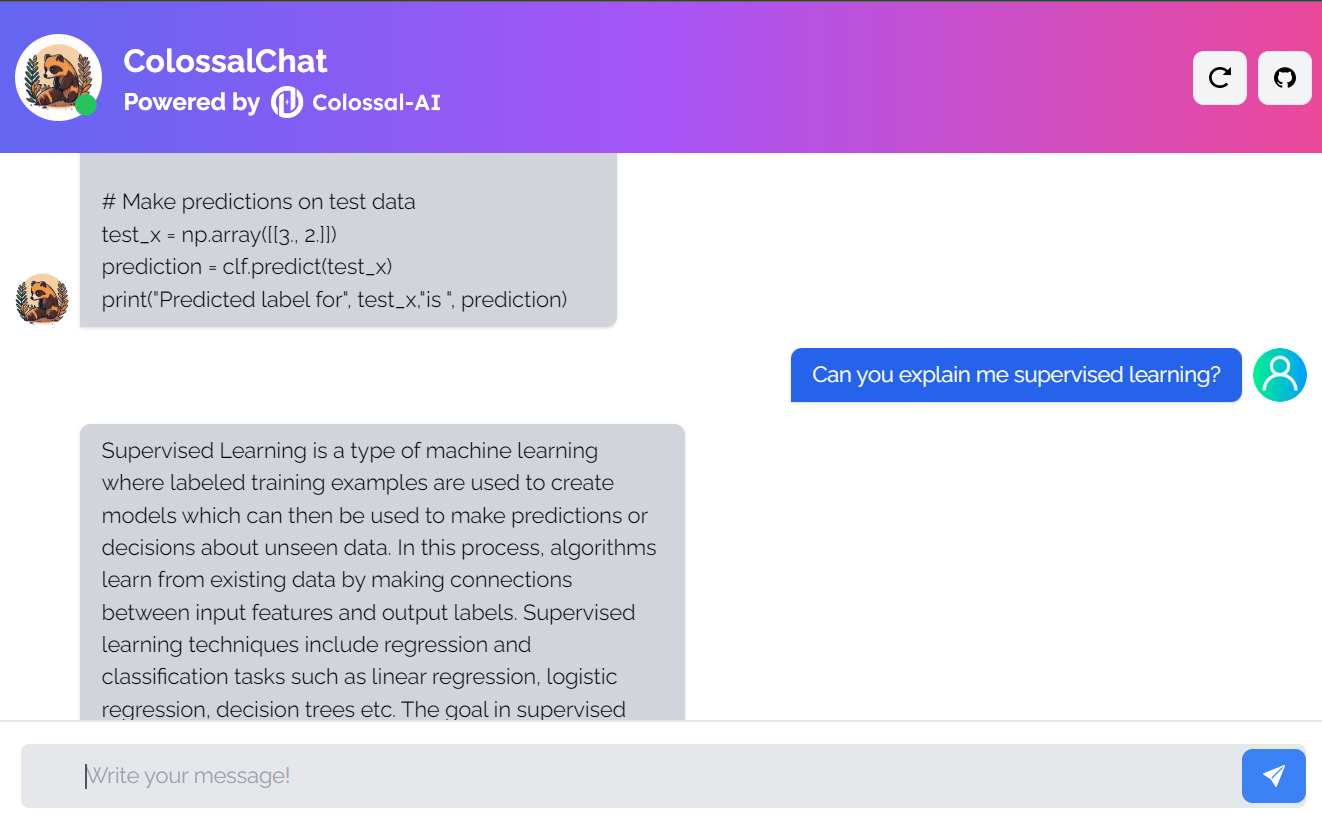

1. ColossalChat

O ColossalChat é um projeto de código aberto que permite que você clone modelos de IA usando um pipeline completo de RLHF (Reinforcement Learning from Human Feedback).

É um projeto totalmente de código aberto que inclui o conjunto de dados bilíngue, o código de treinamento, a demonstração e a inferência quantizada de 4 bits. Todos os componentes ajudarão você a criar um chatbot personalizado de forma mais barata e rápida.

Imagem do ColossalChat

- Artigo de pesquisa: Colossal-AI: Um sistema unificado de aprendizagem profunda para treinamento paralelo em larga escala

- Postagem no blog: ColossalChat: Uma solução de código aberto para clonagem de ChatGPT com um pipeline completo de RLHF

- GitHub: hpcaitech/ColossalAI

- Demonstração: ColossalChat (colossalai.org)

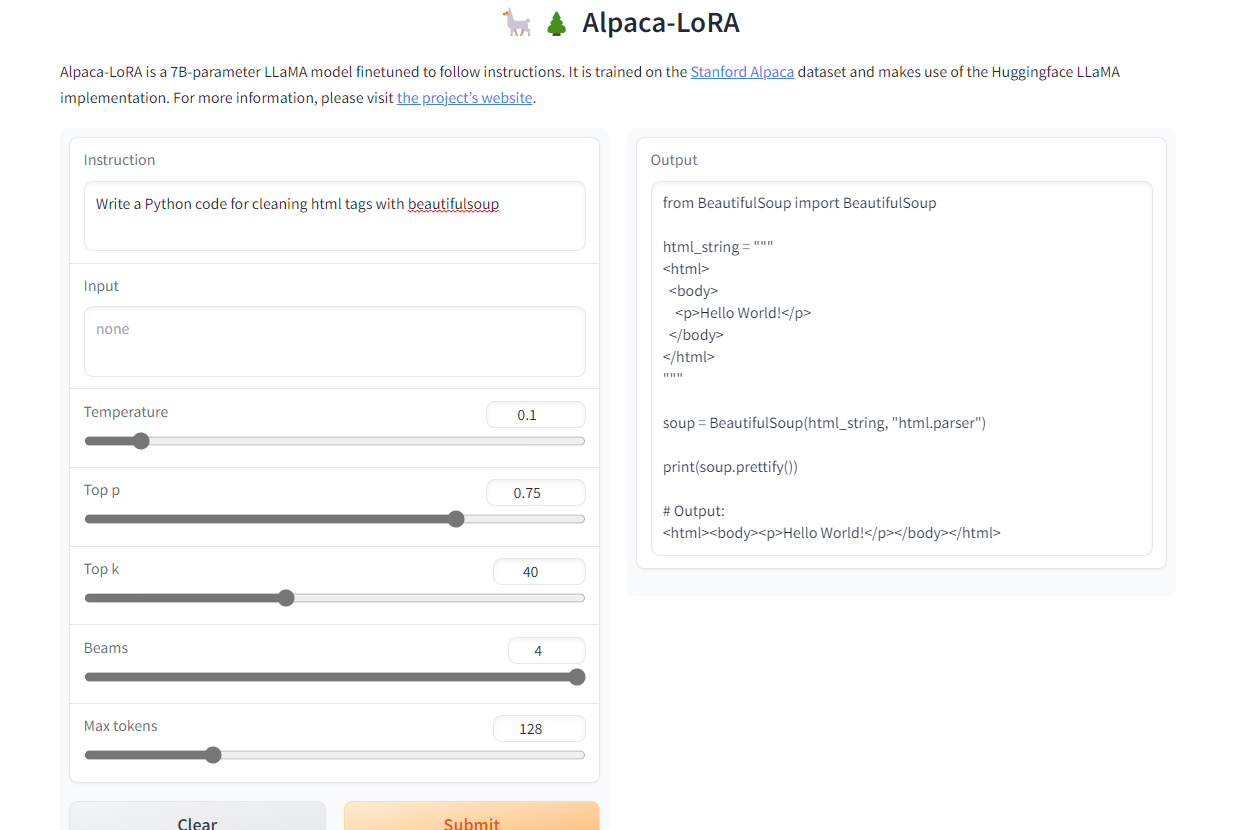

2. Alpaca-LoRA

O Alpaca-LoRA é um modelo que foi criado usando o Stanford Alpaca e a adaptação de baixa classificação (LoRA). A adoção do low-rank nos permite executar um modelo Instruct de qualidade semelhante ao GPT-3.5 no Raspberry Pi 4 com 4 GB de RAM.

O projeto fornece código-fonte, exemplos de ajuste fino, código de inferência, pesos do modelo, conjunto de dados e demonstração. A melhor parte é que podemos treinar nosso modelo em poucas horas com uma única RTX 4090.

Imagem de Alpaca-LoRA

- GitHub: tloen/alpaca-lora

- Modelo de cartão: tloen/alpaca-lora-7b

- Demonstração: Alpaca-LoRA

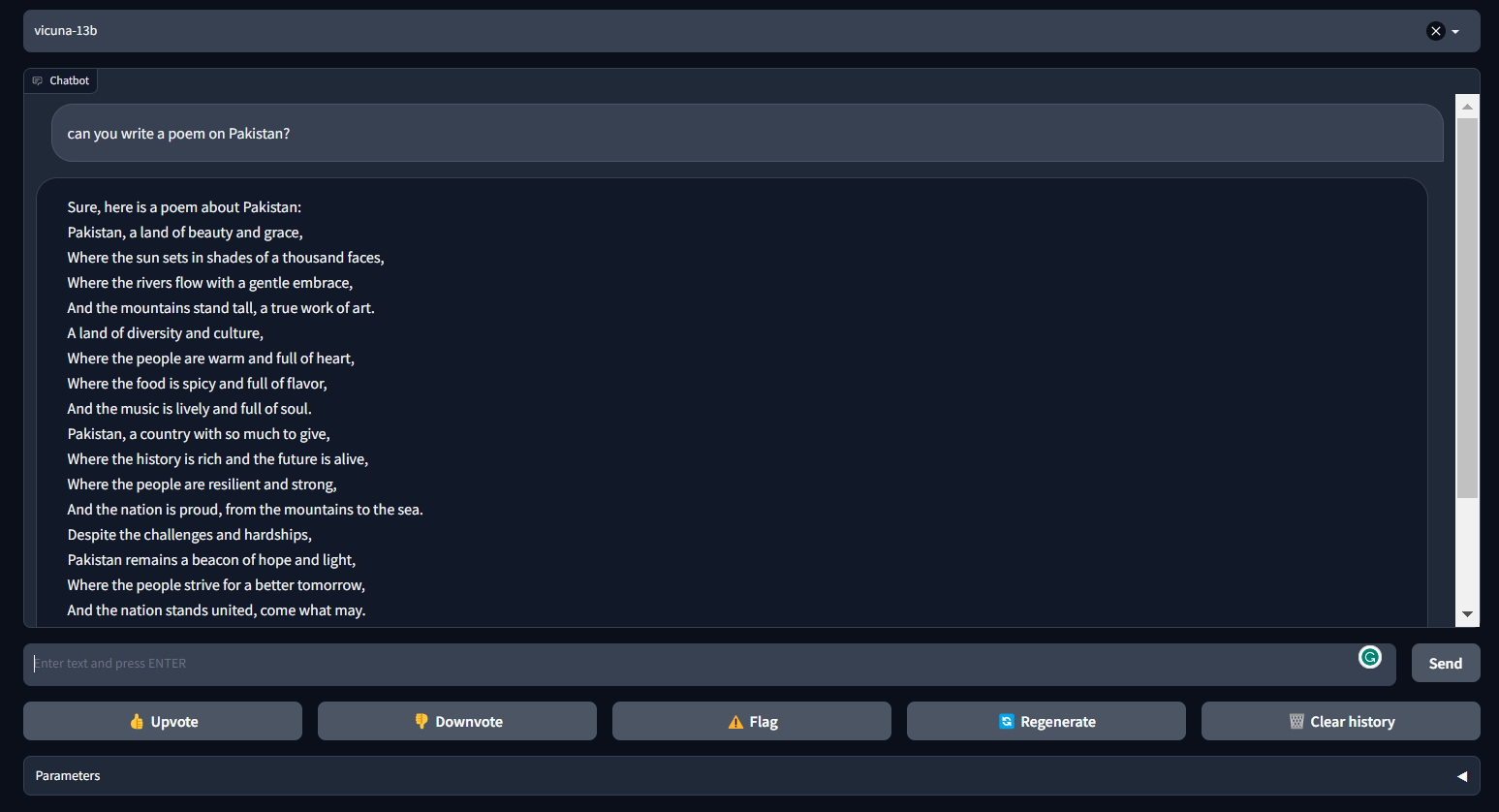

3. Vicuna

A Vicuna pode gerar textos coerentes e criativos para chatbots. Trata-se de uma arquitetura baseada em transformador que foi aperfeiçoada em um conjunto de dados de conversação coletado do ShareGPT.com.

A Vicuna fornece quase 90% do desempenho do ChatGPT. Ele faz parte do FastChat, uma plataforma aberta que permite que os usuários treinem, atendam e avaliem seus chatbots. O FastChat fornece todos os componentes e ferramentas necessários para você criar um modelo de chatbot personalizado.

Imagem do FastChat (lmsys.org)

- Postagem no blog: Vicuna: Um chatbot de código aberto que impressiona o GPT-4 com 90%* de qualidade do ChatGPT | pela equipe com membros da UC Berkeley, CMU, Stanford e UC San Diego

- GitHub: lm-sys/FastChat

- Demonstração: FastChat (lmsys.org)

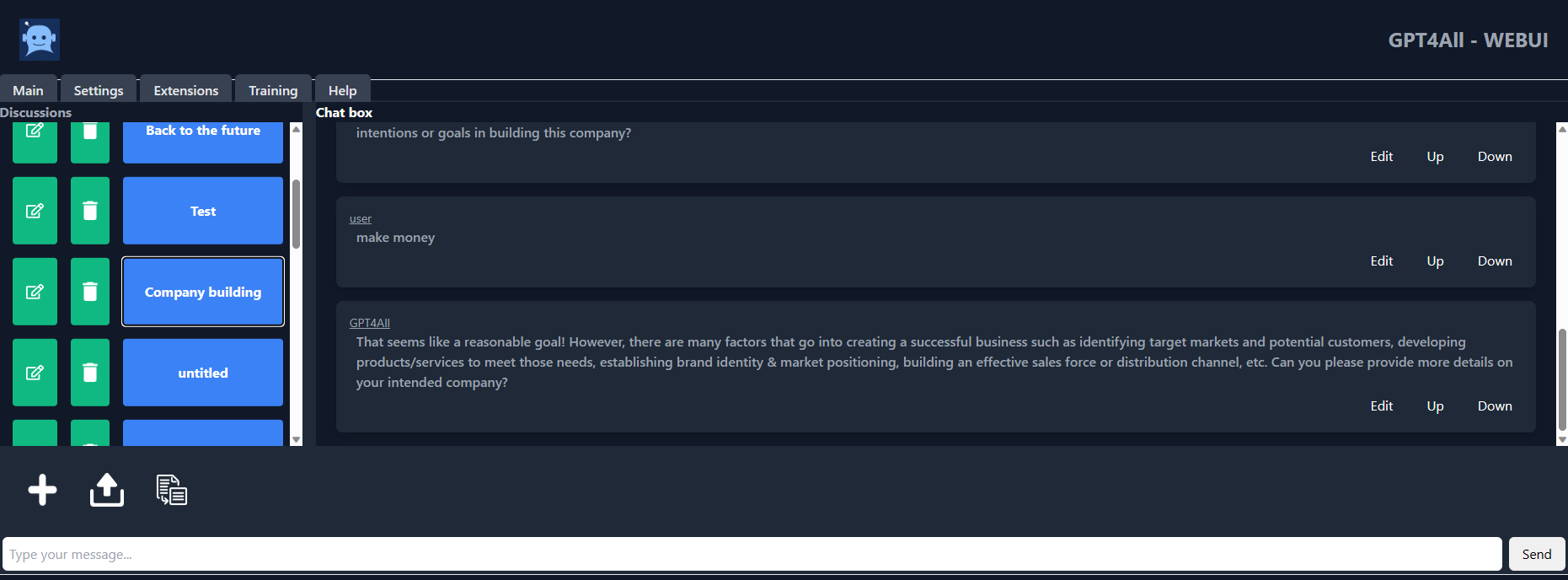

4. GPT4ALL

O GPT4ALL é um chatbot desenvolvido pela equipe de IA da Nomic com base em dados de interação assistida com curadoria massiva, como problemas de palavras, códigos, histórias, representações e diálogos de várias voltas. A arquitetura do modelo é baseada no LLaMa e usa aceleradores de aprendizado de máquina de baixa latência para uma inferência mais rápida na CPU.

Com o GPT4ALL, você obtém um cliente Python, interferência de GPU e CPU, ligações Typescript, uma interface de bate-papo e um backend Langchain.

Imagem de gpt4all-ui

- Relatório técnico: GPT4All

- GitHub: nomic-ai/gpt4al

- UI do chatbot: nomic-ai/gpt4all-ui

- Modelo de cartão: nomic-ai/gpt4all-lora

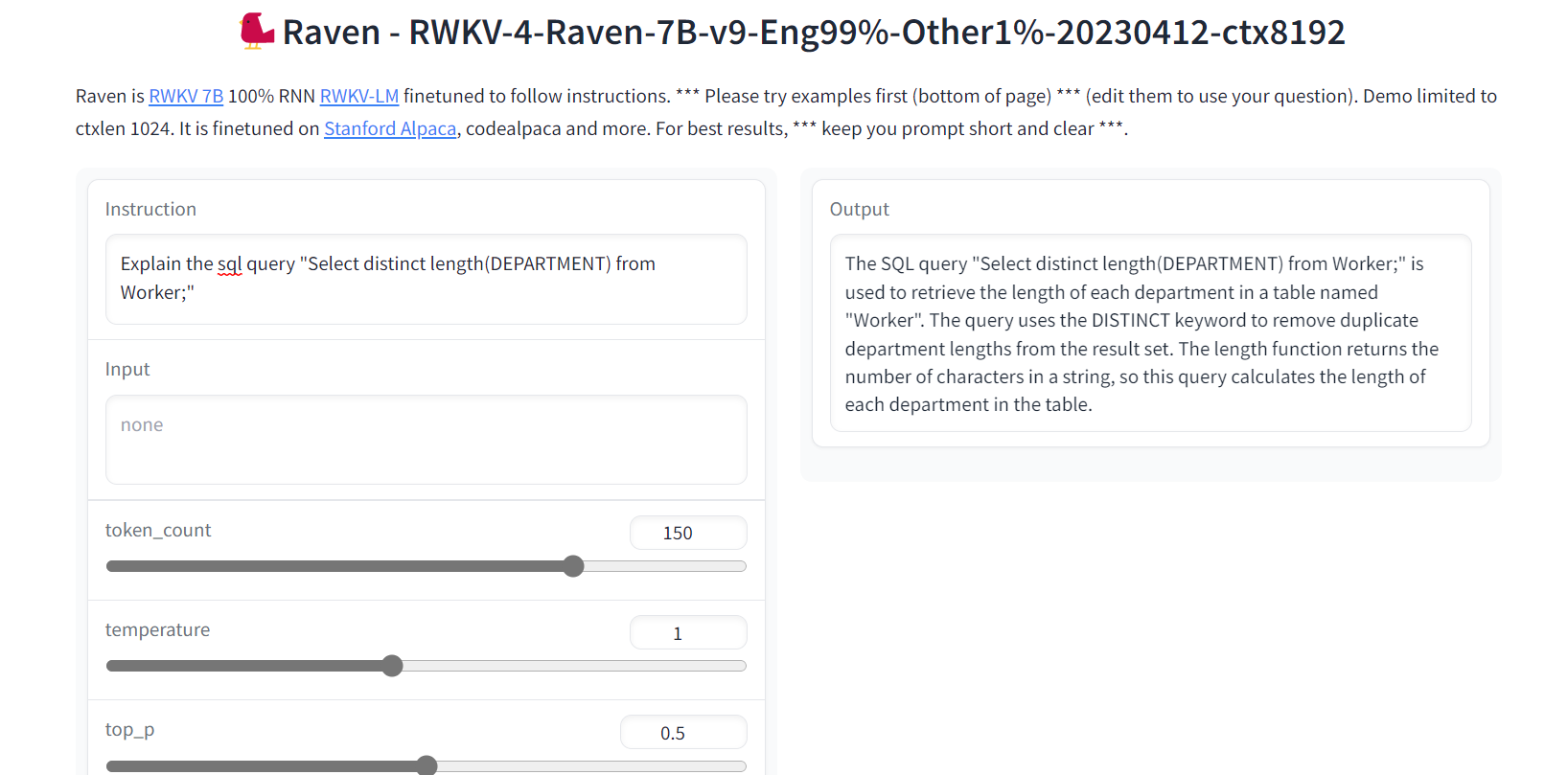

5. Raven RWKV

O Raven RWKV faz parte do ChatRWKV, que é um modelo de código aberto como o ChatGPT, mas alimentado pelo modelo de linguagem RWKV (100% RNN), não baseado em transformador.

Ao utilizar RNNs, o modelo atinge níveis comparáveis de qualidade e escalabilidade como transformadores, com os benefícios adicionais de maior velocidade de processamento e conservação de VRAM. O Raven foi ajustado para seguir instruções e foi ajustado no Stanford Alpaca, no code-alpaca e em outros conjuntos de dados.

Imagem do Raven RWKV 7B

- GitHub: BlinkDL/ChatRWKV

- Demonstração: Raven RWKV 7B

- Modelo de cartão: BlinkDL/rwkv-4-raven

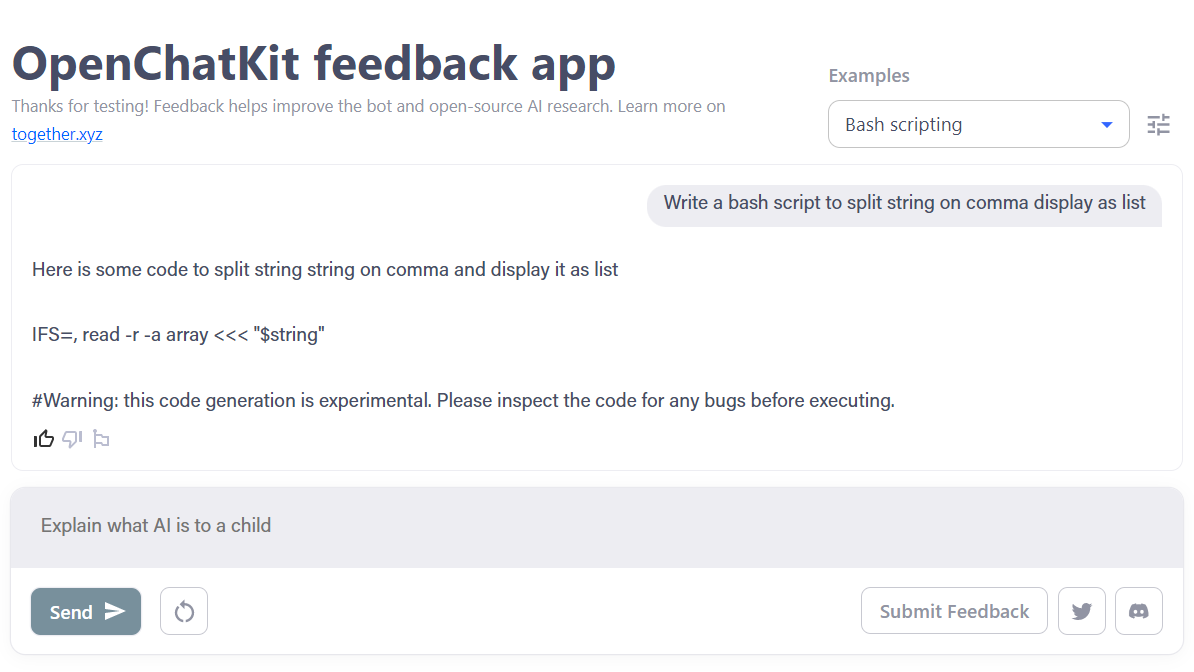

6. OpenChatKit

O OpenChatKit é um kit de ferramentas abrangente que oferece uma alternativa de código aberto ao ChatGPT para o desenvolvimento do aplicativo de chatbot.

O kit de ferramentas inclui instruções passo a passo para você treinar seu próprio modelo de linguagem grande ajustado por instruções, ajustar o modelo e um sistema de recuperação extensível para atualizar as respostas do bot. Além disso, ele inclui recursos de moderação que podem ajudar a filtrar perguntas inadequadas.

Imagem do OpenChatKit

- Postagem no blog: Anunciando o OpenChatKit - TOGETHER

- GitHub: togethercomputer/OpenChatKit

- Demonstração: OpenChatKit

- Modelo de cartão: togethercomputer/GPT-NeoXT-Chat-Base-20B

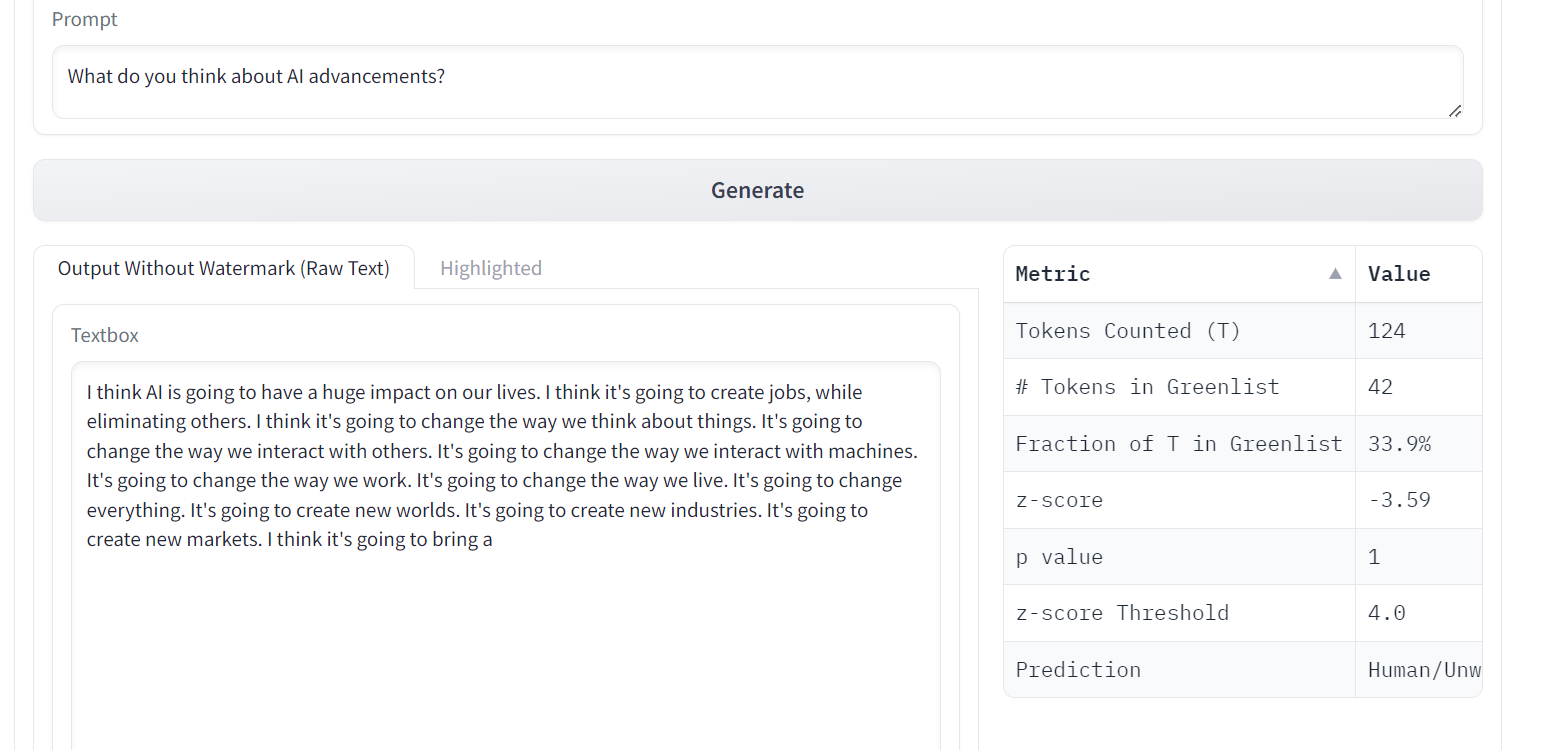

7. OPT

Os modelos de idioma OPT (Open Pre-trained Transformer) demonstraram habilidades notáveis no aprendizado de zero e poucos disparos, bem como na análise de viés estereotipado, apesar de não corresponderem à qualidade do ChatGPT.

OPT é uma família de grandes modelos de linguagem que variam de 125M a 175B parâmetros. Os modelos são transformadores somente de decodificador, o que significa que eles geram texto autorregressivo da esquerda para a direita.

Imagem de Uma marca d'água para LLMs

- Trabalho de pesquisa: OPT: Modelos de linguagem de transformador pré-treinados abertos

- GitHub: facebookresearch/metaseq

- Demonstração: Uma marca d'água para LLMs

- Cartão de modelo: facebook/opt-1.3b

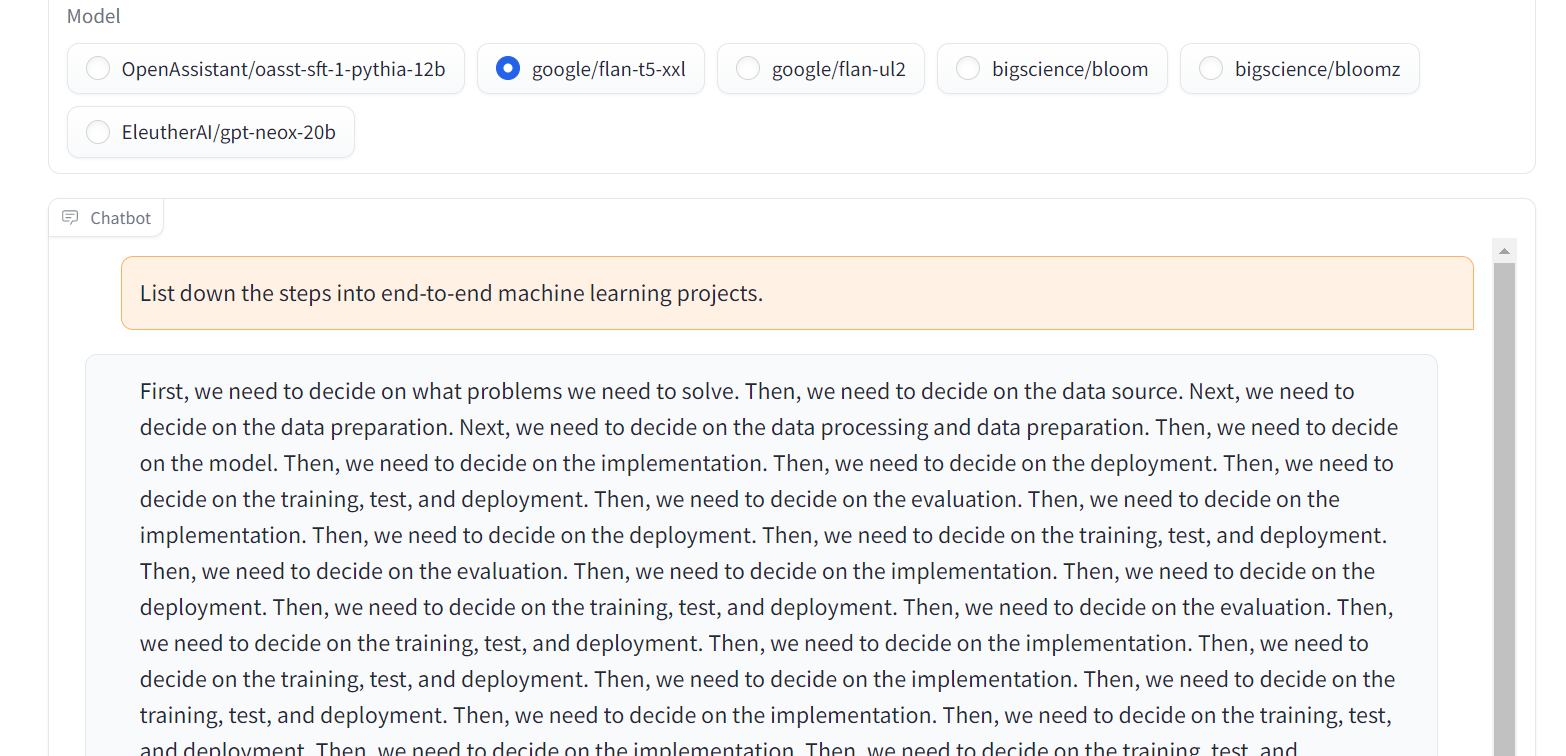

8. Flan-T5-XXL

O Flan-T5-XXL foi um modelo T5 ajustado que foi treinado em uma vasta coleção de conjuntos de dados apresentados na forma de instruções. Esse tipo de ajuste fino melhorou significativamente o desempenho em uma variedade de classes de modelos, como PaLM, T5 e U-PaLM. Além disso, o modelo Flan-T5-XXL foi ajustado em mais de 1.000 tarefas adicionais que abrangem vários idiomas.

Imagem de Chat Llm Streaming

- Trabalho de pesquisa: Dimensionamento da instrução - modelos de linguagem ajustados

- GitHub: google-research/t5x

- Demonstração: Chat Llm Streaming

- Cartão do modelo: google/flan-t5-xxl

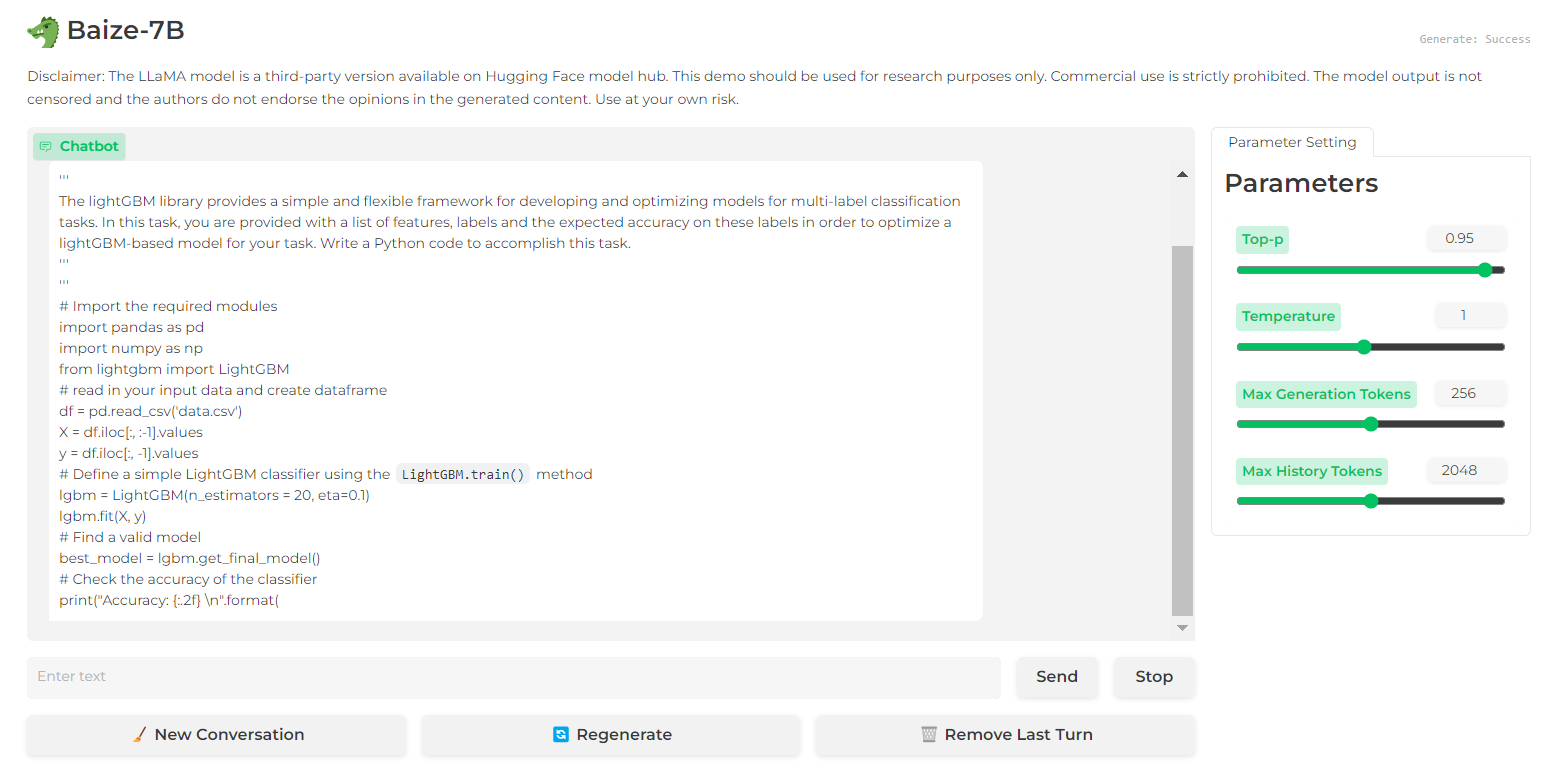

9. Baize

O Baize apresenta um desempenho impressionante em diálogos de várias voltas graças às suas proteções que ajudam a reduzir os riscos potenciais. Isso foi alcançado por meio de um corpus de bate-papo de alta qualidade com várias voltas, que foi desenvolvido com o ChatGPT para facilitar as conversas com você mesmo.

O código-fonte, o modelo e o conjunto de dados do Baize são liberados sob uma licença não comercial (para fins de pesquisa).

do Baize 7B

do Baize 7B

- Trabalho de pesquisa: Baize: Um modelo de bate-papo de código aberto com ajuste eficiente de parâmetros em dados de bate-papo próprio

- GitHub: project-baize/baize-chatbot

- Demonstração: Baize 7B

- Cartão de modelo: project-baize/baize-lora-7B

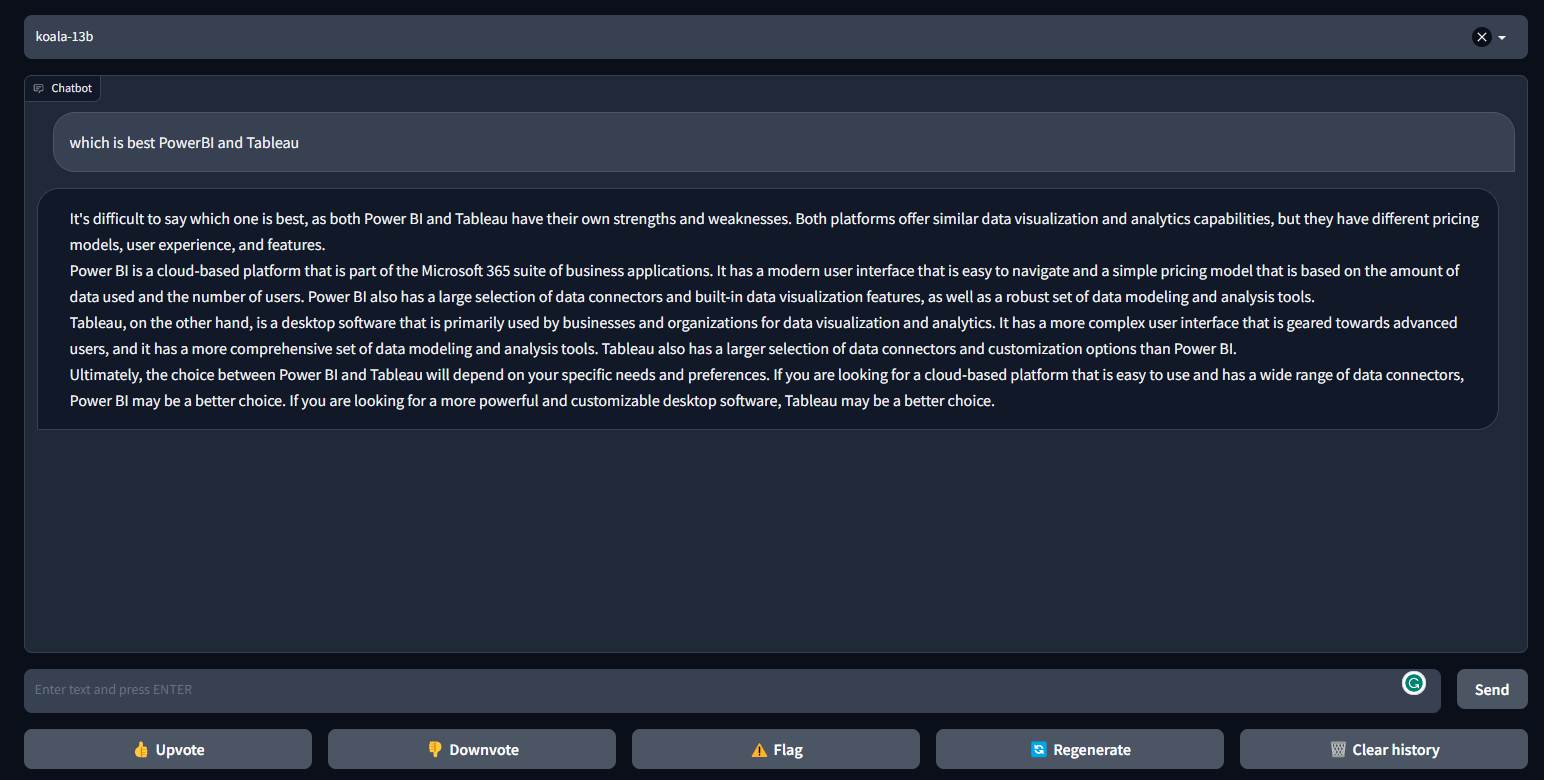

10. Koala

O Koala é um chatbot treinado pelo ajuste fino do LLaMa em um conjunto de dados de diálogo extraído da Web. O Koala teve um desempenho melhor do que o Alpaca e é semelhante ao ChatGPT em muitos casos.

O Koala fornece código de treinamento, pesos públicos e ajuste fino de diálogo, e foi avaliado por 100 humanos.

Imagem de FastChat/Koala

- Postagem no blog: Koala: Um modelo de diálogo para pesquisa acadêmica

- GitHub: young-geng/EasyLM

- Demonstração: FastChat/Koala

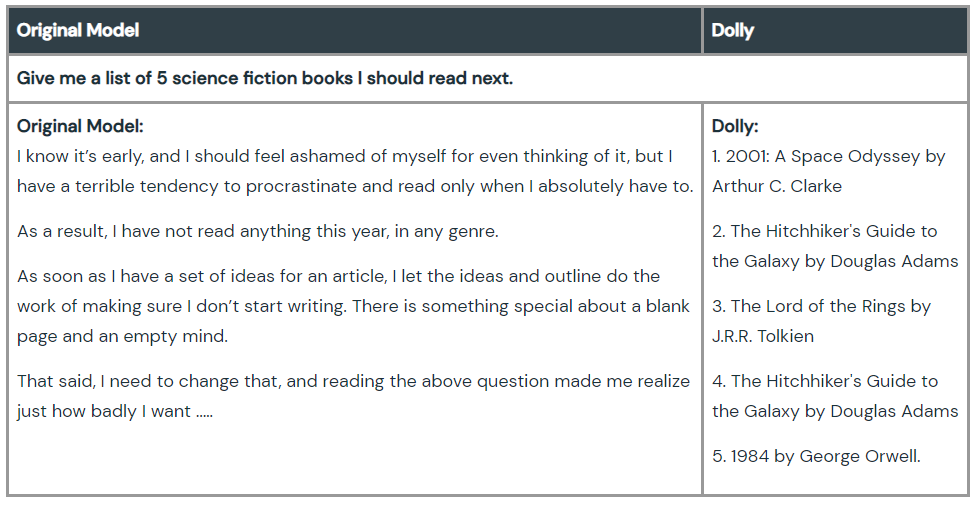

11. Dolly

Dolly é um modelo de linguagem grande que foi treinado pela máquina da Databricks para demonstrar que podemos usar o antigo modo de linguagem de código aberto e dar a eles a capacidade de seguir instruções mágicas do ChatGPT. O treinamento do modelo requer 30 minutos em uma máquina, usando dados de treinamento de alta qualidade. Você não precisa nem mesmo de modelos grandes para obter alta qualidade. A equipe usou o modelo de 6 bilhões de parâmetros, em comparação com 175 bilhões do GPT-3.

Confira o Dolly 2.0, um modelo de linguagem que segue instruções que pode ser usado comercialmente.

Imagem de Hello Dolly

- Postagem no blog: Olá, Dolly: Democratizando a magia do ChatGPT com modelos abertos

- GitHub: databrickslabs/dolly

- Placa de modelo: databricks/dolly-v1-6b

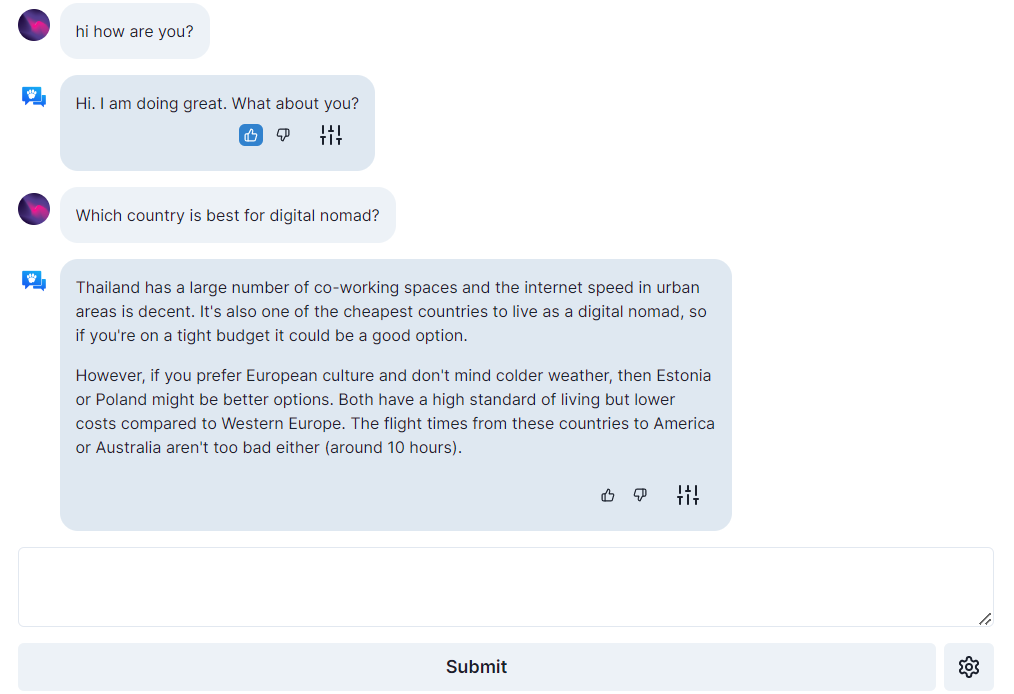

12. Assistente Aberto

O Open Assistant é um projeto verdadeiramente de código aberto, o que significa dar a todos acesso aos principais modelos de linguagem de grande porte baseados em bate-papo. Seu objetivo é criar uma revolução na inovação da linguagem, permitindo que as pessoas interajam com sistemas de terceiros, recuperem informações dinamicamente e criem novos aplicativos usando a linguagem.

Você pode executar o chatbot de linguagem ampla em uma única GPU de consumo de ponta, e seu código, modelos e dados são licenciados sob licenças de código aberto.

Imagem de open-assistant.io

- Postagem no blog: Os primeiros modelos do Open Assistant estão aqui!

- GitHub: LAION-AI/Open-Assistant

- Demonstração: open-assistant.io

- Modelo de cartão: OpenAssistant/oasst-sft-1-pythia-12b

Conclusão

Essas alternativas ao GPT-4 podem ajudar pesquisadores, desenvolvedores e pequenas empresas a criar sua tecnologia baseada em linguagem e competir com os gigantes do setor. O desempenho dos modelos não está acima do GPT-4, mas com o tempo e a contribuição da comunidade, alguns podem ter o potencial de superar o GPT-4.

Se você é novo no ChatGPT, experimente fazer nosso curso de Introdução ao ChatGPT e, se você conhece a IA generativa, pode melhorar sua capacidade de solicitação analisando a abrangente Folha de dicas do ChatGPT para ciência de dados ou conferindo os recursos abaixo.

- [Webinar] Um guia para iniciantes sobre a engenharia de prompts com o ChatGPT

- [Folha de consulta] Folha de consulta do ChatGPT para cientistas de dados

- [Podcast] ChatGPT e como a IA generativa está aumentando os fluxos de trabalho

- [Blog] O que é o GPT4-o da OpenAI?

- Comece a aprender IA com o DataCamp