GPT-4 est l'IA générative la plus avancée développée par OpenAI. Il modifie le paysage de notre travail. Cependant, GPT-4 n'est pas un logiciel libre, ce qui signifie que nous n'avons pas accès au code, à l'architecture du modèle, aux données ou aux poids du modèle pour reproduire les résultats. Nous ne pouvons pas créer notre propre GPT-4 comme un chatbot.

Pour équilibrer l'échelle, les communautés LLM à source ouverte ont commencé à travailler sur des alternatives GPT-4 qui offrent des performances et des fonctionnalités presque similaires et nécessitent moins de ressources informatiques.

Vous pouvez vous familiariser avec GPT-1, GPT-2, GPT-3 et GPT-4 en consultant le site : Qu'est-ce que le GPT-4 et pourquoi est-ce important ? ou vous pouvez apprendre à utiliser ChatGPT pour les projets de science des données et maîtriser l'ingénierie rapide pour mieux construire des projets de science des données de bout en bout.

Dans cet article, nous présenterons 12 alternatives au GPT-4 avec une brève description et des liens vers le document de recherche, l'article de blog, la démo du chatbot, la source du code et la carte de modèle pertinents.

Note : Certains des modèles mentionnés ont une licence non commerciale, qui limite leur utilisation à des fins de recherche et d'enseignement. Vous devez comprendre ces limitations avant de les utiliser.

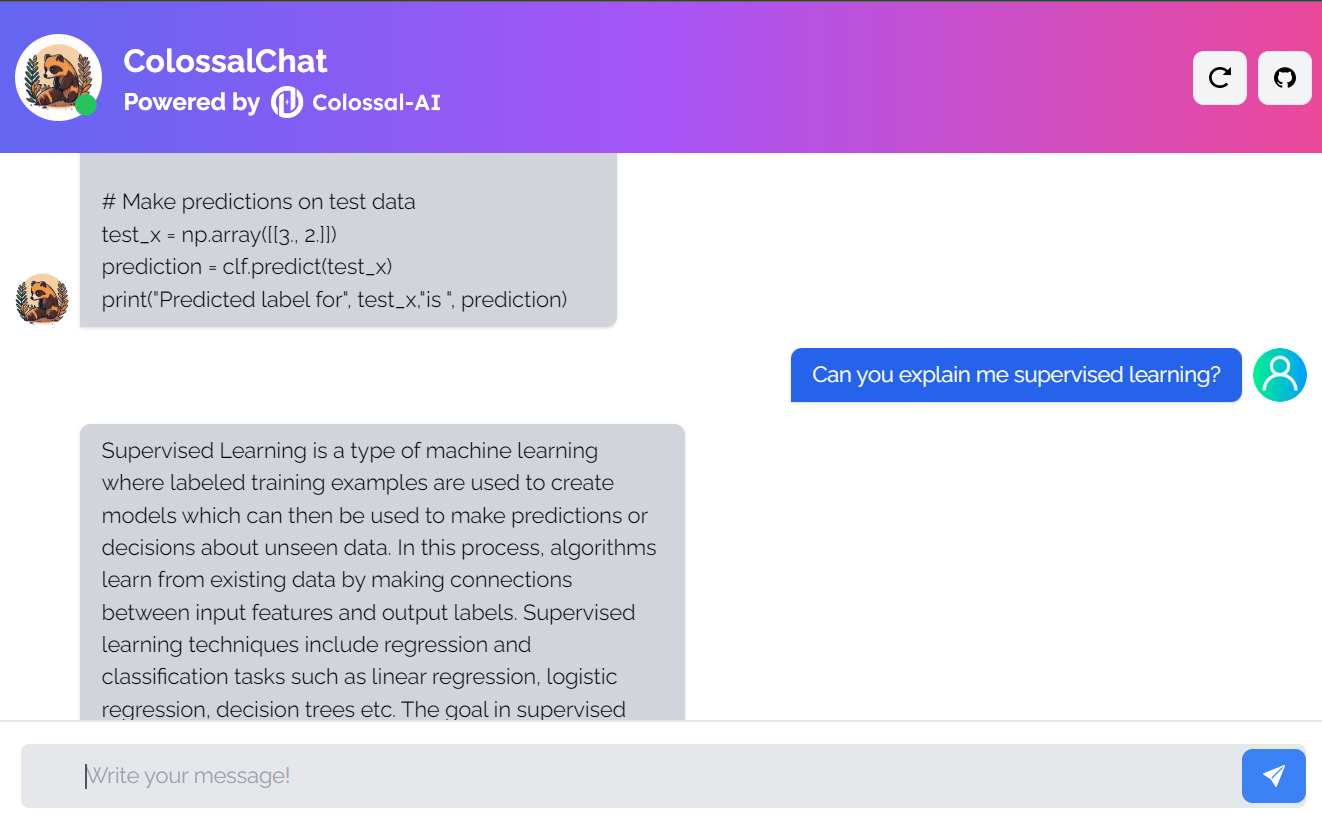

1. ColossalChat

ColossalChat est un projet open-source qui vous permet de cloner des modèles d'IA en utilisant un pipeline RLHF (Reinforcement Learning from Human Feedback) complet.

Il s'agit d'un projet entièrement libre comprenant l'ensemble de données bilingues, le code d'entraînement, la démo et l'inférence quantifiée à 4 bits. Tous ces composants vous aideront à créer un chatbot personnalisé plus rapidement et à moindre coût.

Image de ColossalChat

- Document de recherche : Colossal-AI : Un système unifié d'apprentissage profond pour l'entraînement parallèle à grande échelle

- Blog post : ColossalChat : Une solution open-source pour le clonage de ChatGPT avec un pipeline RLHF complet

- GitHub : hpcaitech/ColossalAI

- Démonstration : ColossalChat (colossalai.org)

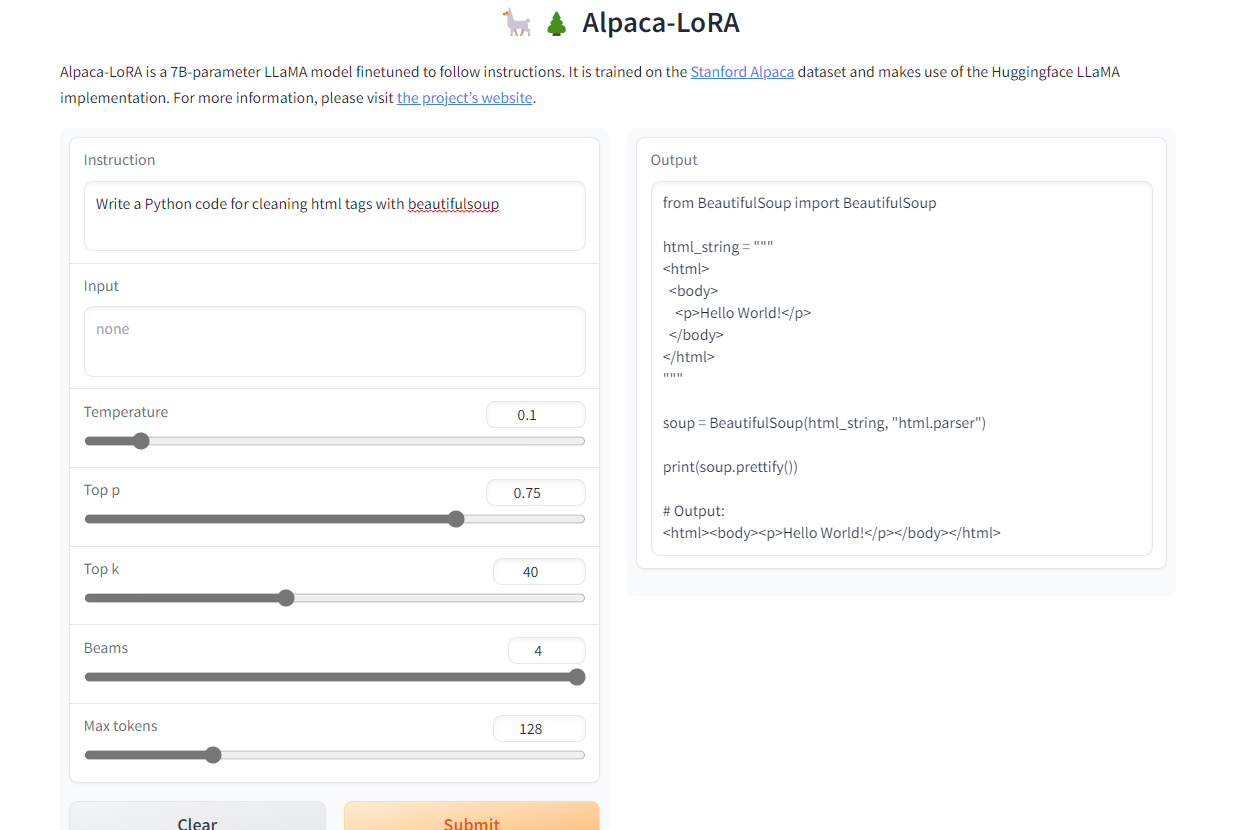

2. Alpaca-LoRA

Alpaca-LoRA est un modèle qui a été créé en utilisant l'Alpaca de Stanford et l'adaptation de bas rang (LoRA). L'adoption d'un rang faible nous permet d'exécuter un modèle Instruct de qualité similaire à GPT-3.5 sur un Raspberry Pi 4 avec 4 Go de RAM.

Le projet fournit le code source, des exemples de mise au point, le code d'inférence, les poids du modèle, un ensemble de données et une démo. Le plus beau, c'est que nous pouvons entraîner notre modèle en quelques heures avec une seule RTX 4090.

Image d'Alpaca-LoRA

- GitHub : tloen/alpaca-lora

- Carte Modèle : tloen/alpaca-lora-7b

- Démonstration : Alpaca-LoRA

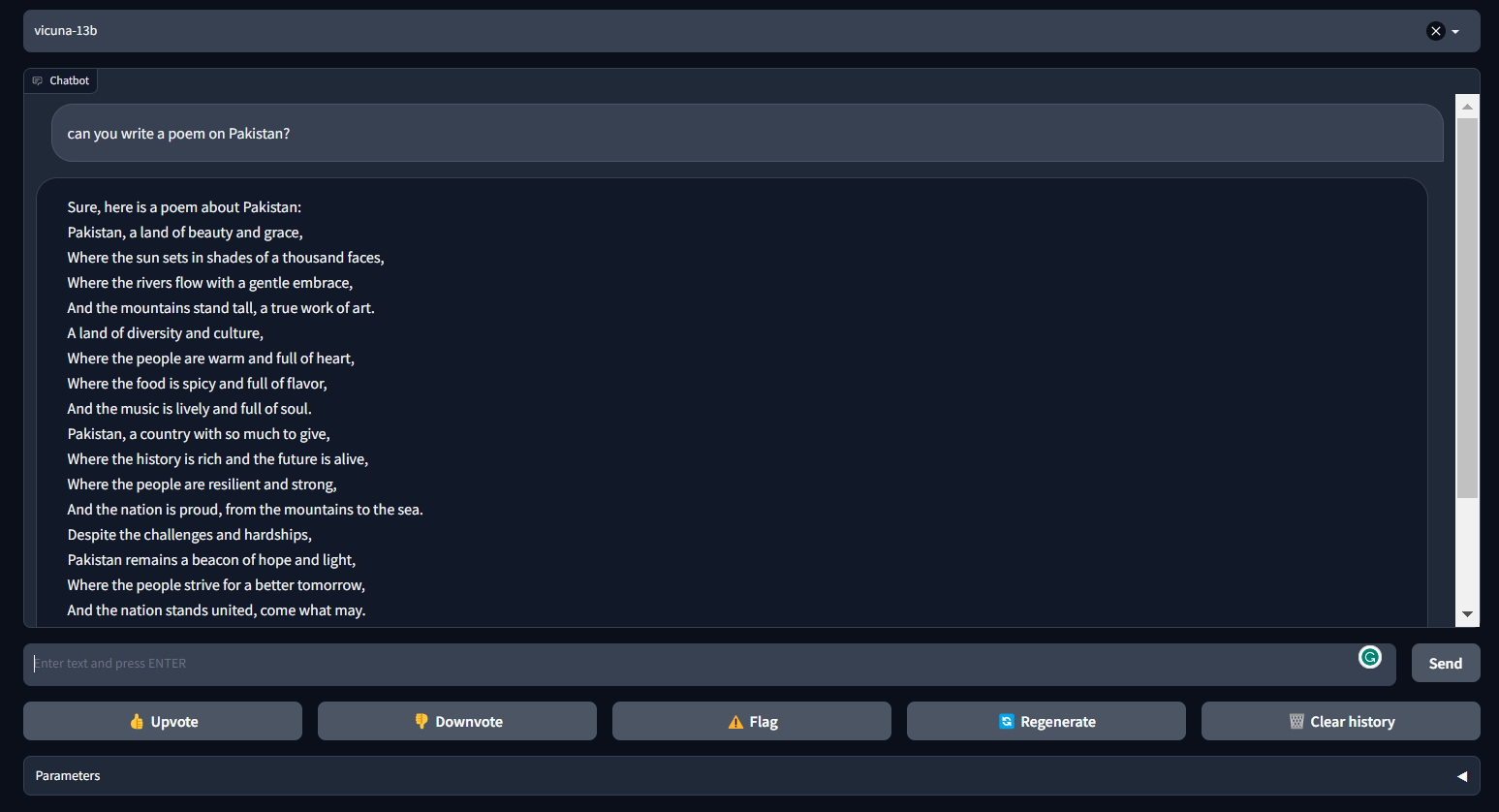

3. Vicuna

La Vicuna peut générer des textes cohérents et créatifs pour les chatbots. Il s'agit d'une architecture basée sur des transformateurs qui a été affinée sur un ensemble de données conversationnelles recueillies sur ShareGPT.com.

Vicuna fournit près de 90 % des performances de ChatGPT. Il fait partie de FastChat, une plateforme ouverte qui permet aux utilisateurs de former, de servir et d'évaluer leurs chatbots. FastChat fournit tous les composants et outils nécessaires pour construire un modèle de chatbot personnalisé.

Image de FastChat (lmsys.org)

- Blog post : Vicuna : Un Chatbot Open-Source qui impressionne GPT-4 avec 90%* de qualité ChatGPT | par l'équipe avec des membres de UC Berkeley, CMU, Stanford, et UC San Diego

- GitHub : lm-sys/FastChat

- Démonstration : FastChat (lmsys.org)

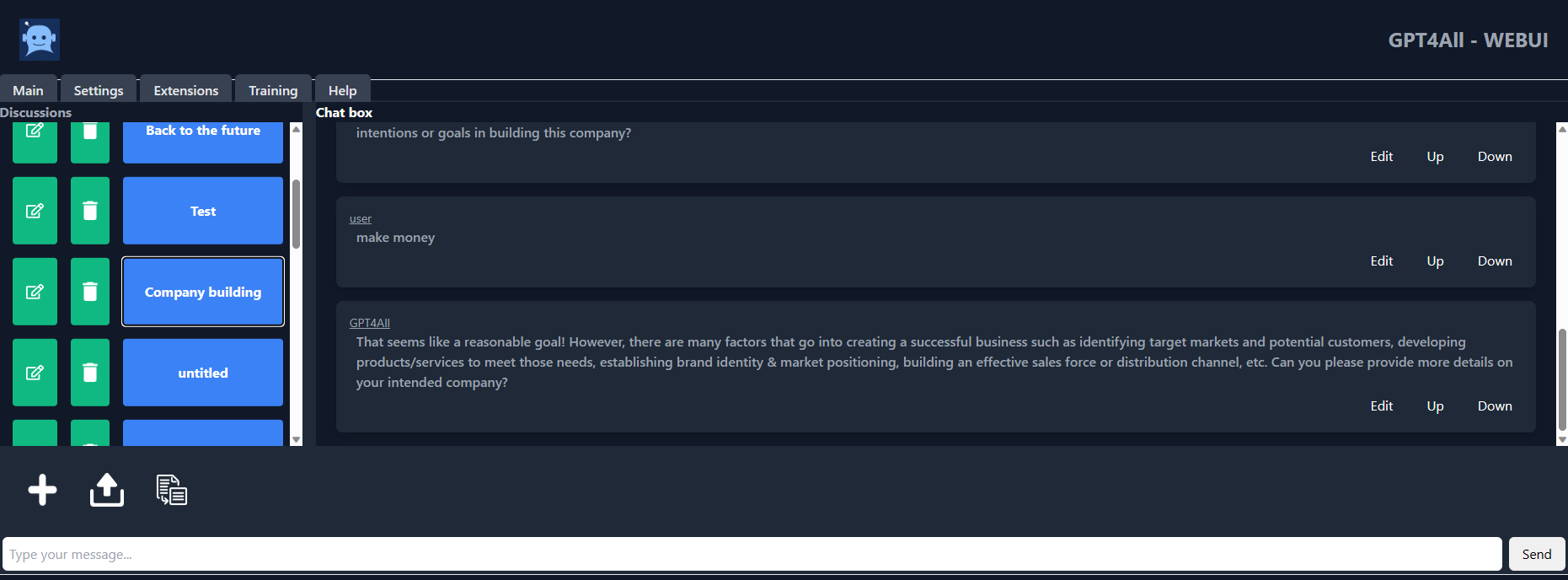

4. GPT4ALL

GPT4ALL est un chatbot développé par l'équipe Nomic AI sur la base de données massives d'interactions assistées telles que des problèmes de mots, des codes, des histoires, des représentations et des dialogues à plusieurs tours. L'architecture du modèle est basée sur LLaMa et utilise des accélérateurs d'apprentissage automatique à faible latence pour une inférence plus rapide sur l'unité centrale.

Avec GPT4ALL, vous disposez d'un client Python, d'interférences GPU et CPU, de liens Typescript, d'une interface de chat et d'un backend Langchain.

Image de gpt4all-ui

- Rapport technique : GPT4All

- GitHub : nomic-ai/gpt4al

- Chatbot UI : nomic-ai/gpt4all-ui

- Carte modèle : nomic-ai/gpt4all-lora

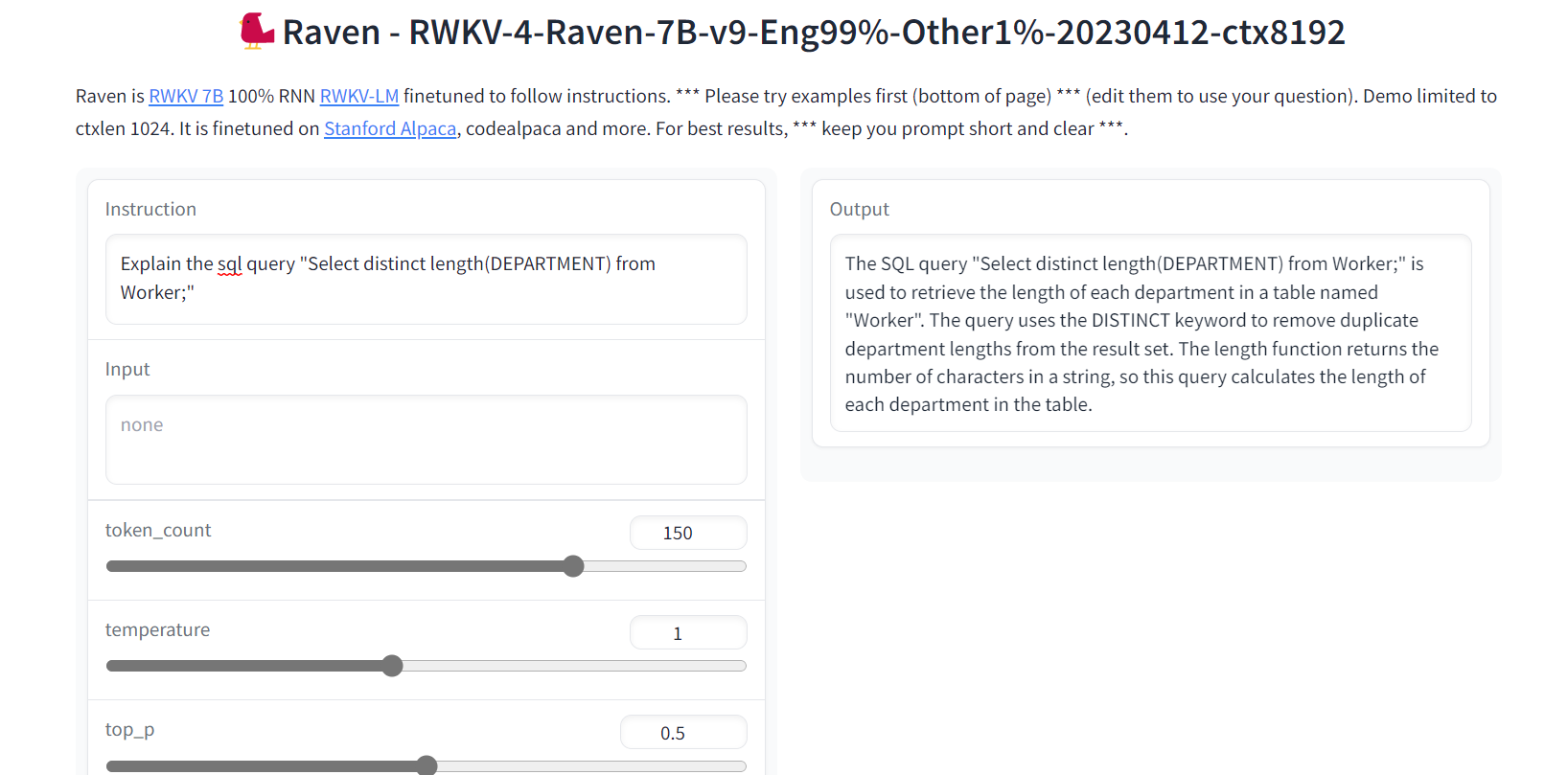

5. Corbeau RWKV

Raven RWKV fait partie de ChatRWKV, qui est un modèle open-source comme ChatGPT mais basé sur le modèle de langage RWKV (100% RNN), et non sur un transformateur.

En utilisant les RNN, le modèle atteint des niveaux de qualité et d'évolutivité comparables à ceux des transformateurs, avec les avantages supplémentaires d'une vitesse de traitement plus rapide et d'une conservation de la VRAM. Raven a été perfectionné pour suivre les instructions, et il a été perfectionné sur Stanford Alpaca, code-alpaca et d'autres ensembles de données.

Image de Raven RWKV 7B

- GitHub : BlinkDL/ChatRWKV

- Démonstration : Raven RWKV 7B

- Modèle de carte : BlinkDL/rwkv-4-raven

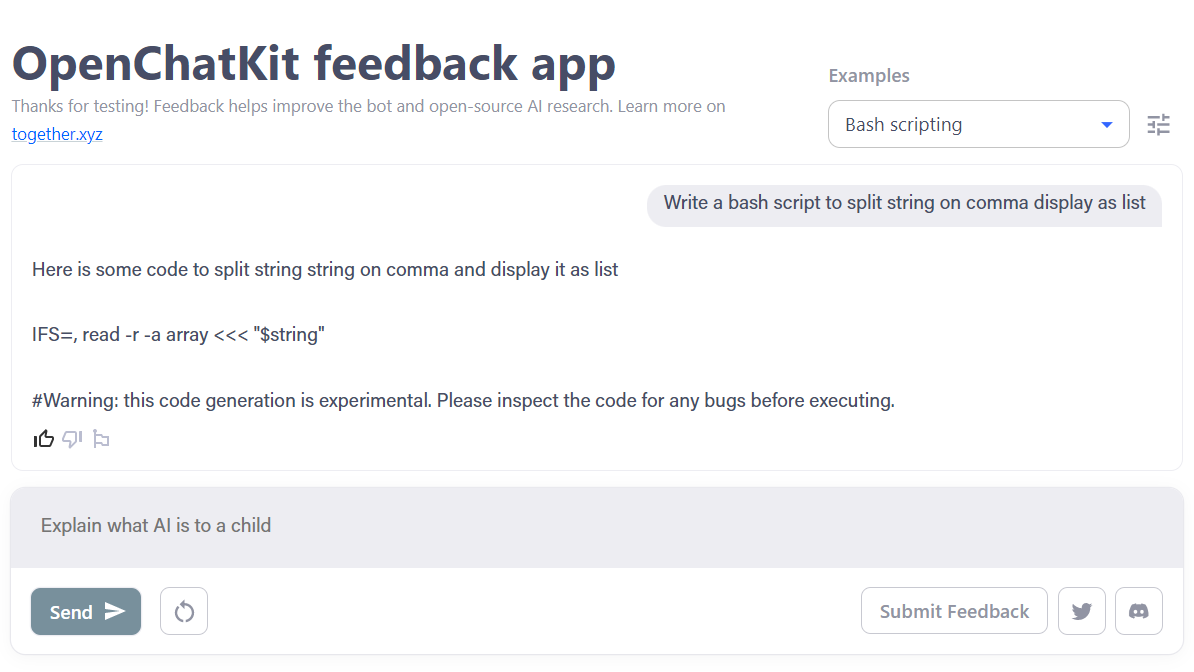

6. OpenChatKit

OpenChatKit est une boîte à outils complète qui offre une alternative open-source à ChatGPT pour le développement d'une application de chatbot.

La boîte à outils comprend des instructions pas à pas pour former votre propre modèle de langage étendu adapté aux instructions, pour affiner le modèle et pour mettre en place un système de récupération extensible permettant de mettre à jour les réponses du robot. En outre, il comprend des fonctions de modération qui peuvent aider à filtrer les questions inappropriées.

Image de OpenChatKit

- Blog Post : Annonce d'OpenChatKit - ENSEMBLE

- GitHub : togethercomputer/OpenChatKit

- Démonstration : OpenChatKit

- Carte modèle : togethercomputer/GPT-NeoXT-Chat-Base-20B

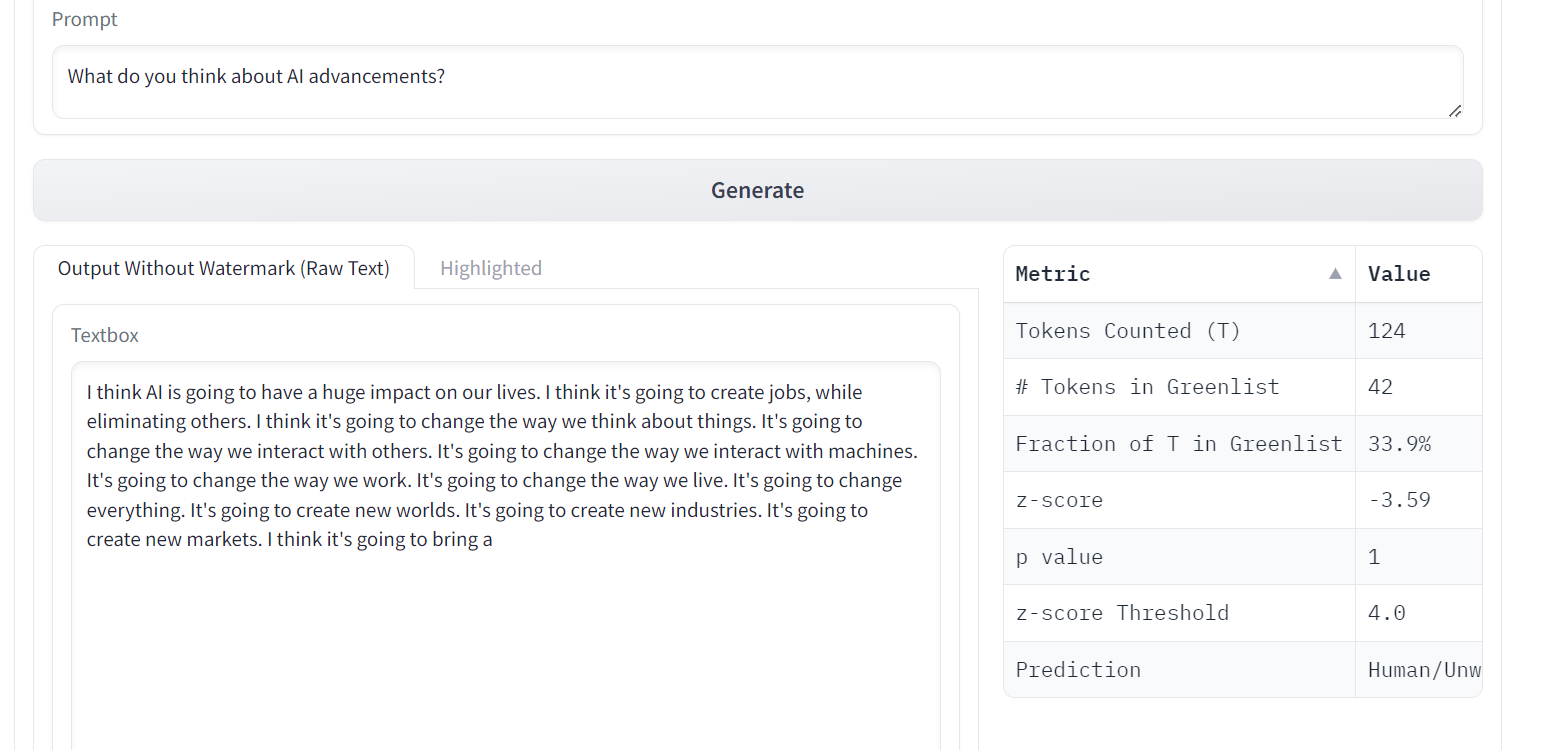

7. OPT

Les modèles linguistiques OPT (Open Pre-trained Transformer) ont démontré des capacités remarquables en matière d'apprentissage zéro-shot et few-shot, ainsi qu'en matière d'analyse des biais stéréotypés, bien qu'ils n'atteignent pas la qualité de ChatGPT.

L'OPT est une famille de grands modèles de langage allant de 125M à 175B paramètres. Les modèles sont des transformateurs de décodeur uniquement, ce qui signifie qu'ils génèrent un texte autorégressif de gauche à droite.

Image de Un filigrane pour les LLM

- Document de recherche : OPT : Ouvrez les modèles linguistiques de transformateurs pré-entraînés

- GitHub : facebookresearch/metaseq

- Démonstration : Un filigrane pour les LLM

- Modèle de carte : facebook/opt-1.3b

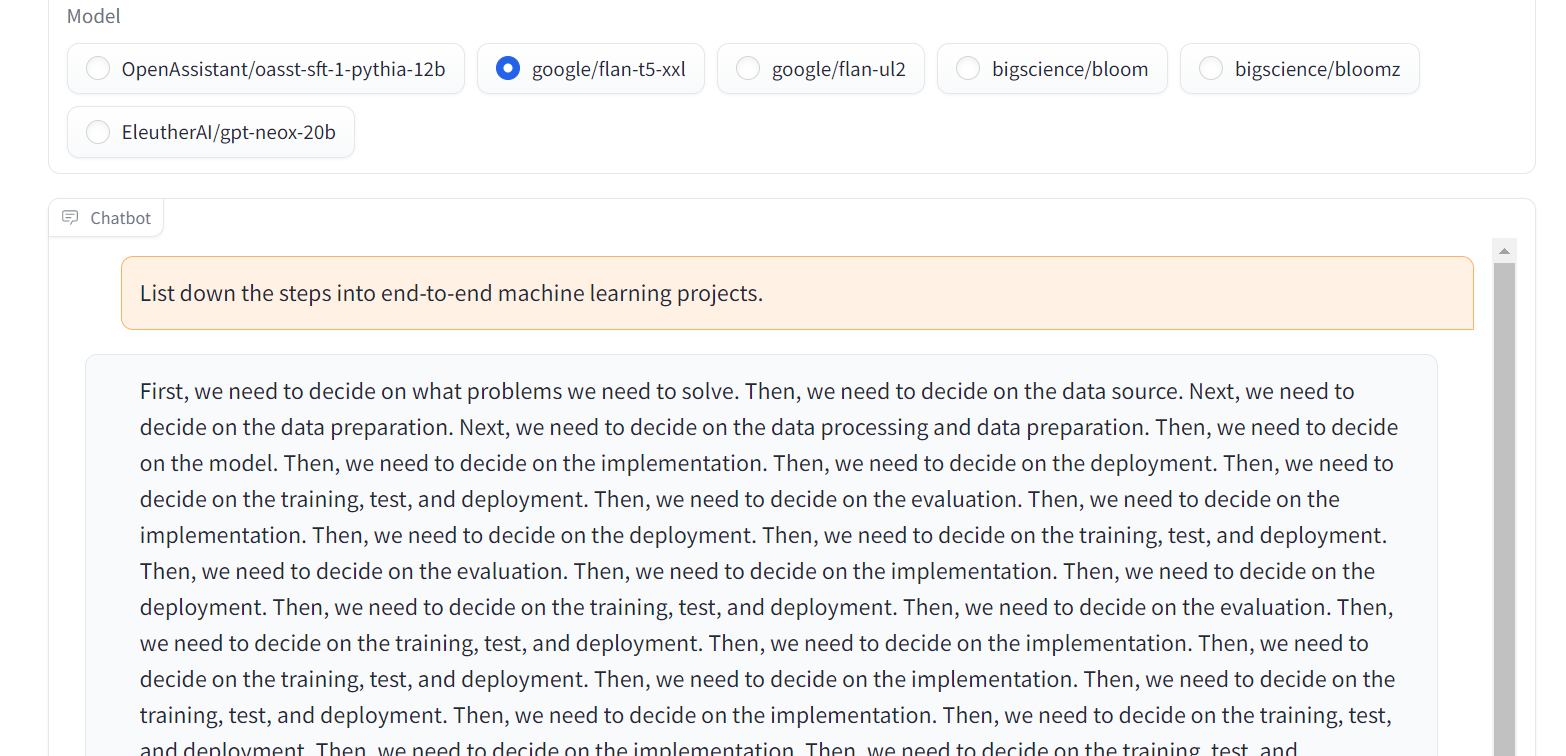

8. Flan-T5-XXL

Flan-T5-XXL est un modèle T5 affiné qui a été entraîné sur une vaste collection d'ensembles de données présentés sous forme d'instructions. Ce type de réglage fin a permis d'améliorer de manière significative les performances de diverses classes de modèles, telles que PaLM, T5 et U-PaLM. En outre, le modèle Flan-T5-XXL a été affiné sur plus de 1000 tâches supplémentaires couvrant plusieurs langues.

Image de Chat Llm Streaming

- Document de recherche : Modifier l'enseignement - Des modèles linguistiques affinés

- GitHub : google-research/t5x

- Démonstration : Chat Llm Streaming

- Carte du modèle : google/flan-t5-xxl

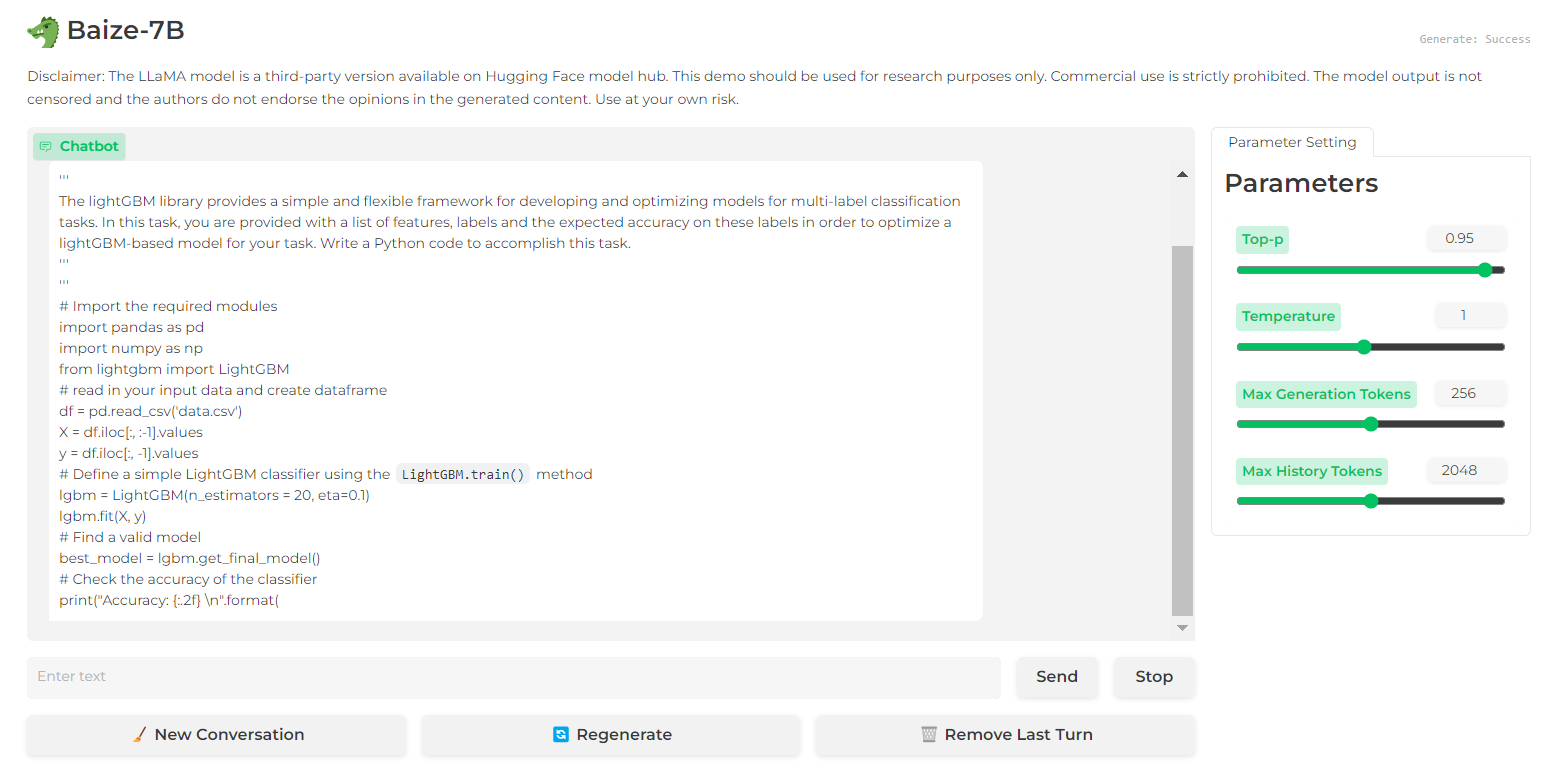

9. Baize

Baize fait preuve d'une performance impressionnante dans les dialogues à plusieurs tours grâce à ses garde-fous qui aident à atténuer les risques potentiels. Il y est parvenu grâce à un corpus de chat multi-tours de haute qualité, qui a été développé en exploitant ChatGPT pour faciliter les conversations avec lui-même.

Le code source, le modèle et l'ensemble des données de Baize sont publiés sous une licence non commerciale (à des fins de recherche).

de Baize 7B

de Baize 7B

- Document de recherche : Baize : Un modèle de chat à source ouverte avec un réglage efficace des paramètres sur les données d'auto-chat

- GitHub : projet-baize/baize-chatbot

- Démonstration : Baize 7B

- Carte modèle : project-baize/baize-lora-7B

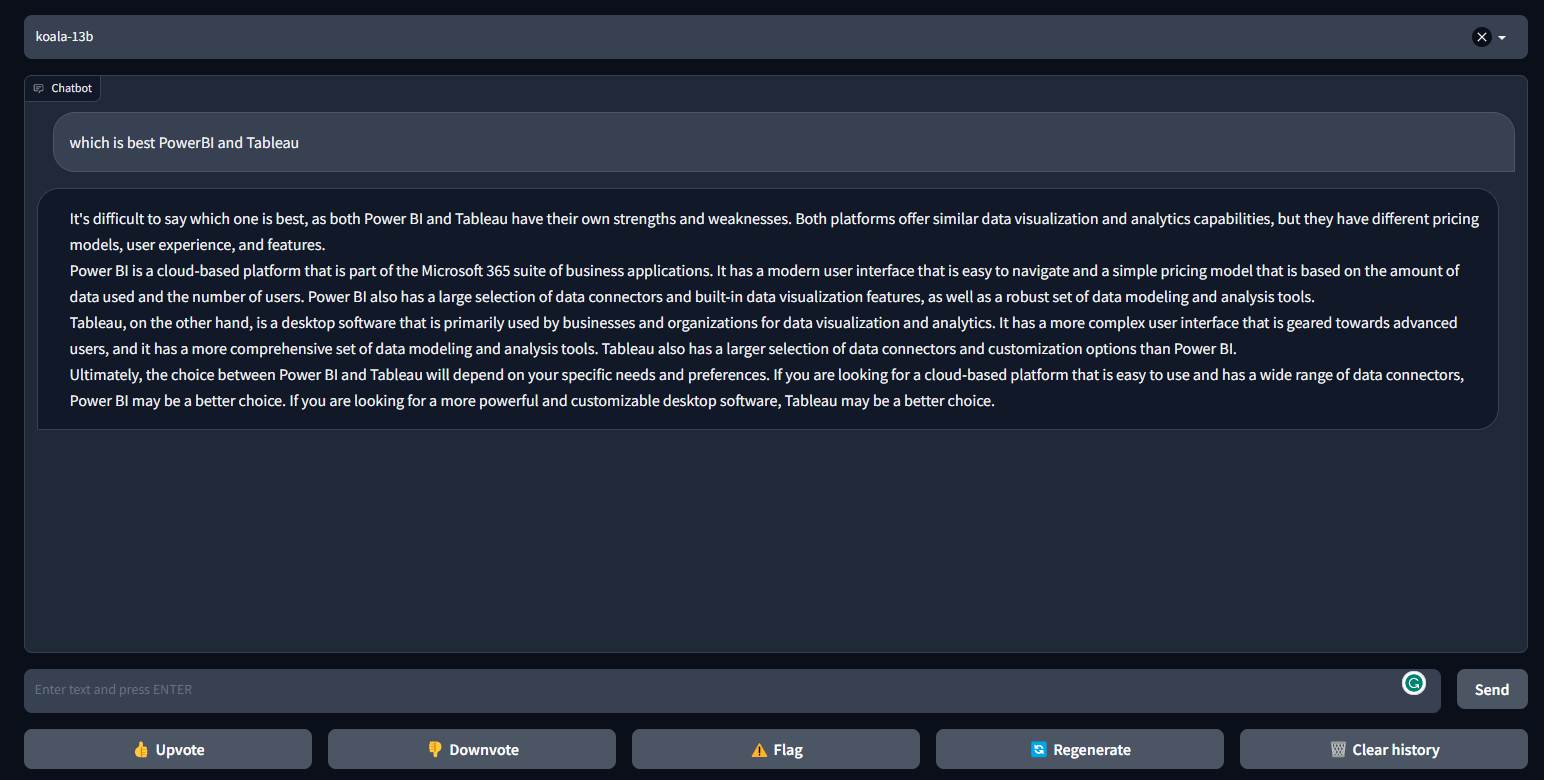

10. Koala

Le Koala est un chatbot formé en affinant LLaMa sur un ensemble de données de dialogue extraites du Web. Koala a obtenu de meilleurs résultats qu'Alpaca et est similaire à ChatGPT dans de nombreux cas.

Koala fournit un code d'entraînement, des poids publics et un accordeur de dialogue, et il a été évalué par 100 humains.

Image de FastChat/Koala

- Blog Post : Koala : Un modèle de dialogue pour la recherche universitaire

- GitHub : young-geng/EasyLM

- Démonstration : FastChat/Koala

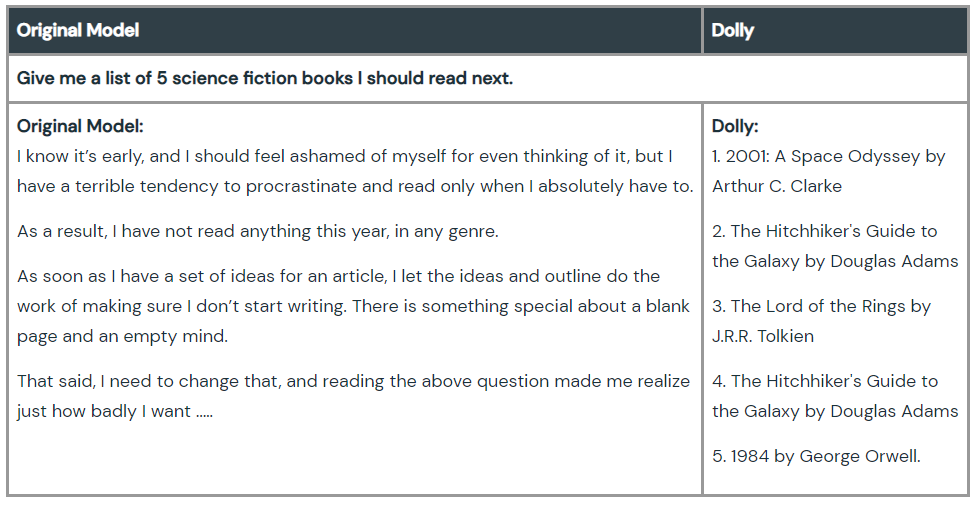

11. Dolly

Dolly est un grand modèle de langage qui a été entraîné par la machine Databricks pour démontrer que nous pouvons utiliser un ancien mode de langage open-source et leur donner la capacité de suivre des instructions magiques ChatGPT. L'apprentissage d'un modèle nécessite 30 minutes sur une machine, en utilisant des données d'apprentissage de haute qualité. Vous n'avez même pas besoin de grands modèles pour obtenir une qualité élevée. L'équipe a utilisé le modèle à 6 milliards de paramètres, contre 175 milliards pour le GPT-3.

Découvrez Dolly 2.0, un modèle de langage qui suit les instructions et qui peut être utilisé à des fins commerciales.

Image tirée de Hello Dolly

- Blog Post : Hello Dolly : Démocratiser la magie de ChatGPT avec des modèles ouverts

- GitHub : databrickslabs/dolly

- Modèle de carte : databricks/dolly-v1-6b

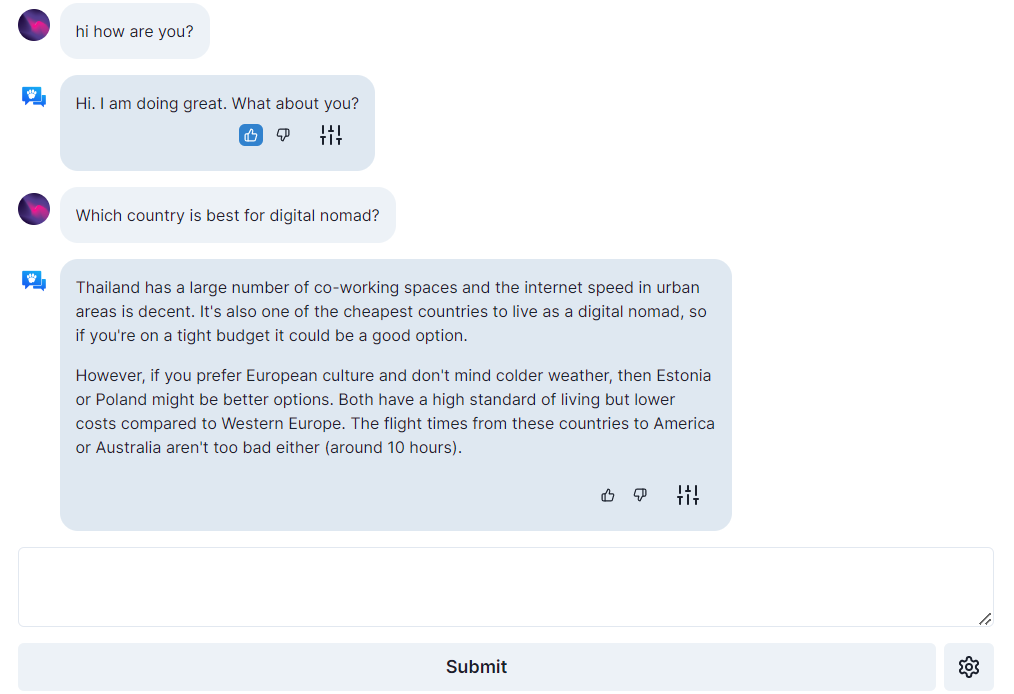

12. Assistant ouvert

Open Assistant est un projet véritablement open-source, ce qui signifie que tout le monde a accès aux meilleurs modèles linguistiques basés sur le chat. Il vise à créer une révolution dans l'innovation linguistique en permettant aux gens d'interagir avec des systèmes tiers, d'extraire des informations de manière dynamique et de créer de nouvelles applications à l'aide de la langue.

Vous pouvez faire fonctionner le chatbot en langue étrangère sur un seul GPU grand public haut de gamme, et son code, ses modèles et ses données font l'objet de licences libres.

Image de open-assistant.io

- Blog Post : Les premiers modèles de l'Open Assistant sont là !

- GitHub : LAION-AI/Open-Assistant

- Démonstration : open-assistant.io

- Modèle de carte : OpenAssistant/oasst-sft-1-pythia-12b

GPT-4 Alternatives : Une approche comparative

Passons en revue ce que nous avons couvert jusqu'à présent dans ce tableau comparatif :

| Nom du modèle | Caractéristiques principales | Avantages | Licences |

| ColossalChat | Pipeline RLHF complet, ensemble de données bilingues, inférence quantifiée sur 4 bits | Une personnalisation plus rapide et moins coûteuse des chatbots | Source ouverte |

| Alpaca-LoRA | Adaptation de faible rang, fonctionne sur Raspberry Pi 4 | Modèle Instruct de haute qualité sur un matériel limité | Source ouverte |

| Vicuna | Affiné sur l'ensemble de données conversationnelles ShareGPT.com | Près de 90 % des performances de ChatGPT, qui fait partie de la plateforme FastChat | Source ouverte |

| GPT4ALL | Architecture LLaMa, accélérateurs à faible latence | Inférence rapide sur les CPU, dialogue multi-tour | Source ouverte |

| Corbeau RWKV | Modèle linguistique basé sur le RNN (pas de transformateur) | Traitement plus rapide, conservation de la VRAM | Source ouverte |

| OpenChatKit | LLM adapté aux instructions, réglage fin, fonctions de modération | Boîte à outils complète pour le développement de chatbots | Source ouverte |

| OPT | Transformateurs pour décodeurs uniquement, différentes tailles de paramètres | Apprentissage à zéro et à quelques coups, analyse des préjugés stéréotypés |

Licence non commerciale (recherche et université uniquement)

|

| Flan-T5-XXL | Instruction - affinée sur plus de 1000 tâches, multilingue | Amélioration des performances dans diverses classes de modèles | Source ouverte |

| Baize | Dialogue à plusieurs voix, garde-fous pour l'atténuation des risques | Corpus de chat de haute qualité |

Licence non commerciale (recherche et université uniquement)

|

| Koala | LLaMa affiné sur l'ensemble de données de dialogue | Les performances sont supérieures à celles de l'Alpaga, similaires à celles du ChatGPT dans de nombreux cas. | Source ouverte |

| Dolly | LLM suivant les instructions formé en 30 minutes sur une machine | Démonstration de capacités similaires à celles de ChatGPT avec des modèles plus petits | Source ouverte |

| Assistant ouvert | Chatbot multilingue sur un seul GPU grand public | Recherche d'informations dynamique et véritablement libre | Source ouverte |

Considérations importantes

Bien que ces alternatives open-source offrent des possibilités intéressantes, il est important d'être conscient de leurs limites par rapport à GPT-4.

- Lacunes dans les performances : Si certains modèles s'approchent des capacités du GPT-4, aucun n'a reproduit ses performances sur l'ensemble des tâches.

- Contraintes de ressources : Certains modèles peuvent nécessiter d'importantes ressources informatiques pour l'entraînement et l'ajustement.

- L'initiative de la communauté : Les projets à code source ouvert reposent sur les contributions de la communauté, ce qui peut entraîner des variations en termes de qualité et de soutien.

Conclusion

Ces alternatives GPT-4 peuvent aider les chercheurs, les développeurs et les petites entreprises à créer leur technologie basée sur le langage et à rivaliser avec les géants de l'industrie. Les performances des modèles ne sont pas supérieures à celles du GPT-4, mais avec le temps et la contribution de la communauté, certains d'entre eux pourraient dépasser le GPT-4.

Si vous ne connaissez pas encore ChatGPT, essayez de suivre notre cours Introduction à ChatGPT, et si vous connaissez l'IA générative, vous pouvez vous améliorer en consultant l'aide-mémoire complet de ChatGPT pour la science des données, ou en consultant les ressources ci-dessous.

Développer des applications d'IA

En tant que data scientist certifié, je suis passionné par l'utilisation des technologies de pointe pour créer des applications innovantes d'apprentissage automatique. Avec une solide expérience en reconnaissance vocale, en analyse de données et en reporting, en MLOps, en IA conversationnelle et en NLP, j'ai affiné mes compétences dans le développement de systèmes intelligents qui peuvent avoir un impact réel. En plus de mon expertise technique, je suis également un communicateur compétent, doué pour distiller des concepts complexes dans un langage clair et concis. En conséquence, je suis devenu un blogueur recherché dans le domaine de la science des données, partageant mes idées et mes expériences avec une communauté grandissante de professionnels des données. Actuellement, je me concentre sur la création et l'édition de contenu, en travaillant avec de grands modèles linguistiques pour développer un contenu puissant et attrayant qui peut aider les entreprises et les particuliers à tirer le meilleur parti de leurs données.