GPT-4 ist die fortschrittlichste generative KI, die von OpenAI entwickelt wurde. Sie verändert die Landschaft, in der wir arbeiten. Allerdings ist GPT-4 nicht quelloffen, d.h. wir haben keinen Zugriff auf den Code, die Modellarchitektur, die Daten oder die Modellgewichte, um die Ergebnisse zu reproduzieren. Wir können unser eigenes GPT-4 nicht wie einen Chatbot erstellen.

Um die Skala auszugleichen, haben die Open-Source-LLM-Gemeinschaften begonnen, an GPT-4-Alternativen zu arbeiten, die fast die gleiche Leistung und Funktionalität bieten und weniger Rechenressourcen benötigen.

Du kannst dich mit GPT-1, GPT-2, GPT-3 und GPT-4 vertraut machen, indem du sie nachschlägst: Was ist GPT-4 und warum ist es wichtig? oder du kannst lernen, ChatGPT für Data Science-Projekte zu nutzen und das Prompt-Engineering zu beherrschen, um bessere End-to-End Data Science-Projekte zu erstellen.

In diesem Artikel stellen wir 12 GPT-4-Alternativen mit einer kurzen Beschreibung und Links zu den entsprechenden Forschungsarbeiten, Blogposts, Chatbot-Demos, Code-Quellen und Modellkarten vor.

Hinweis: Einige der genannten Modelle haben eine nicht-kommerzielle Lizenz, die ihre Nutzung auf Forschung und akademische Zwecke beschränkt. Du musst diese Einschränkungen verstehen, bevor du sie benutzt.

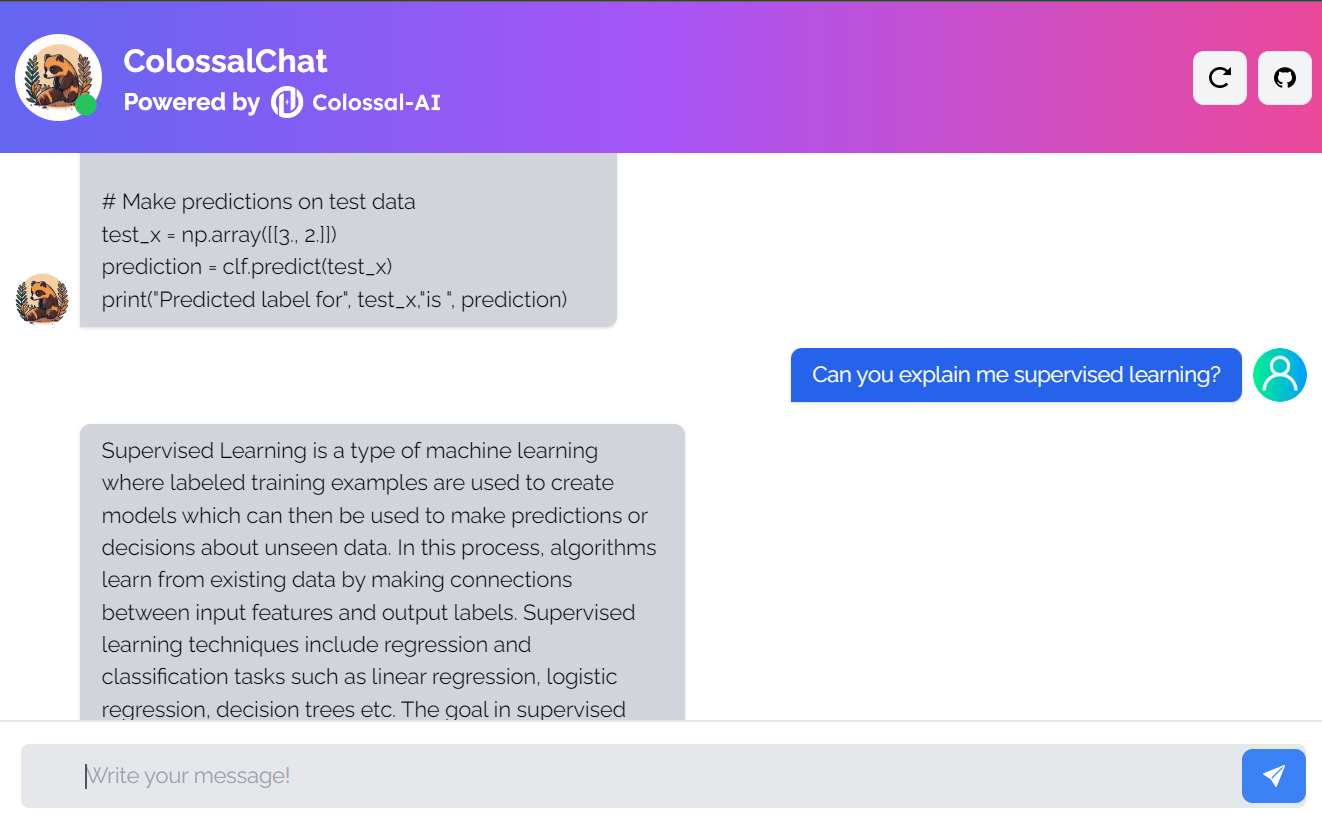

1. ColossalChat

ColossalChat ist ein Open-Source-Projekt, mit dem du KI-Modelle mithilfe einer kompletten RLHF-Pipeline (Reinforcement Learning from Human Feedback) klonen kannst.

Es ist ein vollständig quelloffenes Projekt, das den zweisprachigen Datensatz, den Trainingscode, die Demo und die quantisierte 4-Bit-Inferenz umfasst. Alle Komponenten helfen dir, einen individuellen Chatbot billiger und schneller zu erstellen.

Bild von ColossalChat

- Forschungspapier: Colossal-AI: Ein einheitliches Deep Learning System für paralleles Training in großem Maßstab

- Blogbeitrag: ColossalChat: Eine Open-Source-Lösung zum Klonen von ChatGPT mit einer kompletten RLHF-Pipeline

- GitHub: hpcaitech/ColossalAI

- Demo: ColossalChat (colossalai.org)

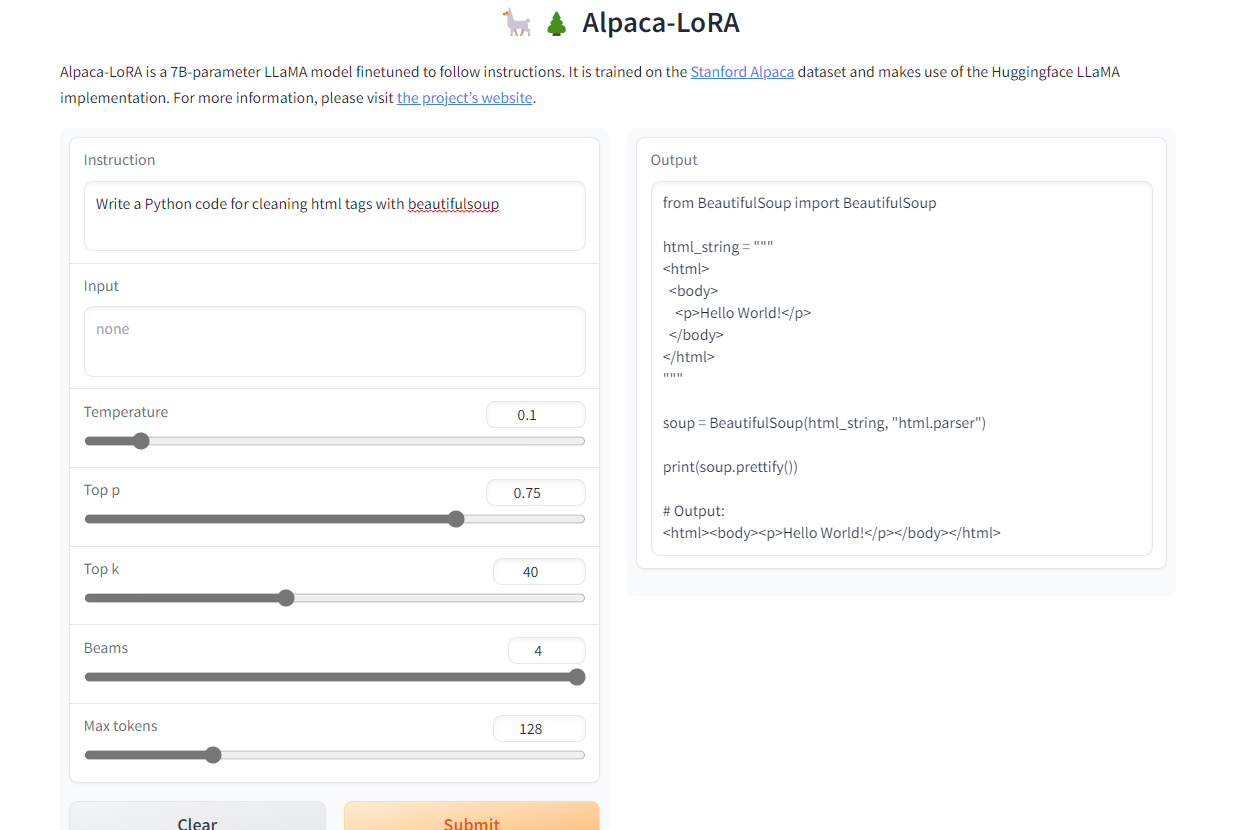

2. Alpaca-LoRA

Alpaca-LoRA ist ein Modell, das mit dem Stanford Alpaca und der Low-Rank-Adaptation (LoRA) erstellt wurde. Die Low-Rank-Annahme ermöglicht es uns, ein Instruct-Modell von ähnlicher Qualität wie GPT-3.5 auf einem Raspberry Pi 4 mit 4 GB RAM laufen zu lassen.

Das Projekt bietet Quellcode, Beispiele für die Feinabstimmung, Inferenzcode, Modellgewichte, Datensätze und eine Demo. Das Beste daran ist, dass wir unser Modell innerhalb weniger Stunden auf einer einzigen RTX 4090 trainieren können.

Bild von Alpaca-LoRA

- GitHub: tloen/alpaca-lora

- Modellkarte: tloen/alpaca-lora-7b

- Demo: Alpaca-LoRA

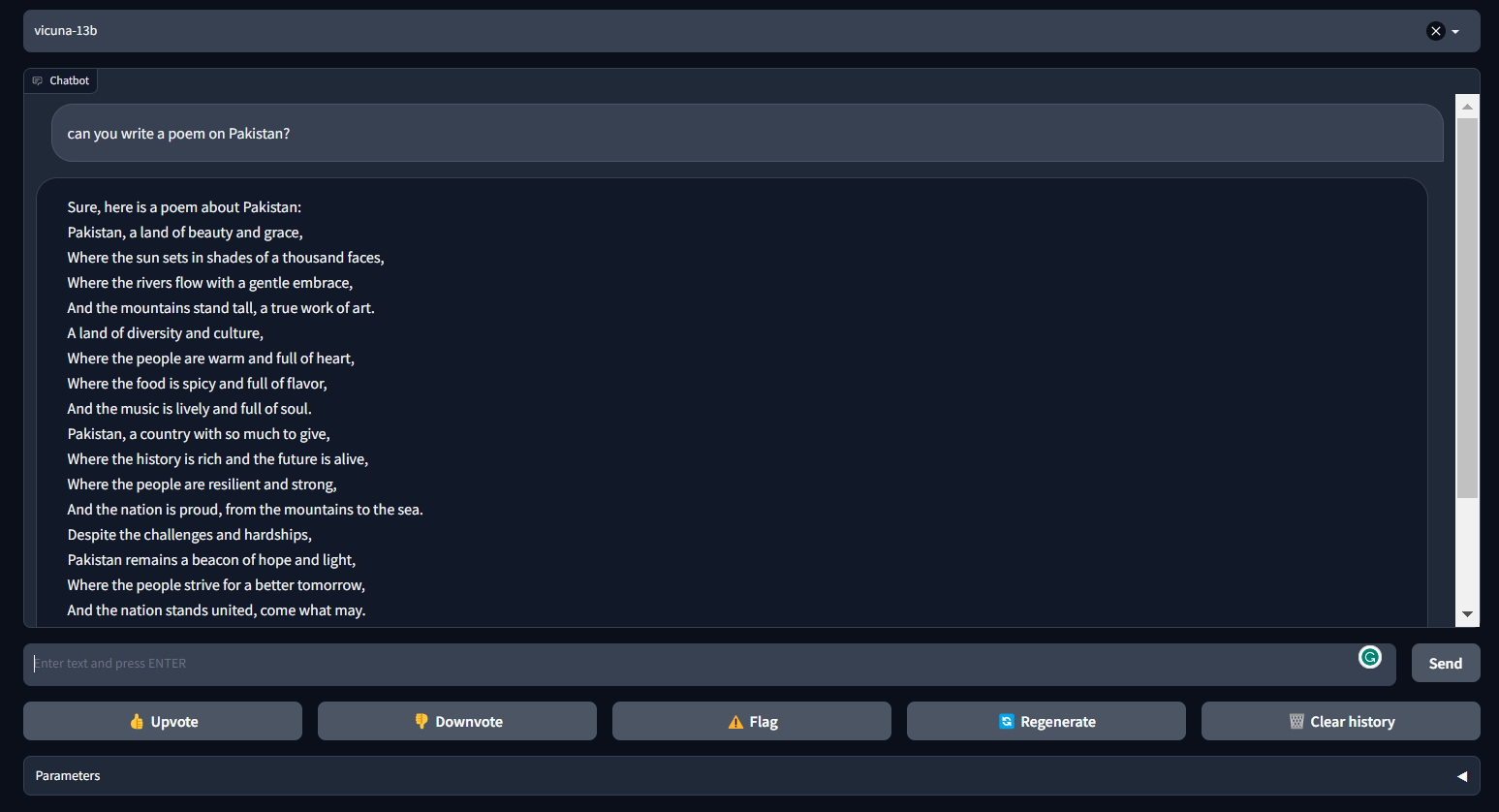

3. Vicuna

Die Vicuna kann kohärente und kreative Texte für Chatbots erstellen. Es handelt sich um eine Transformator-basierte Architektur, die auf einem Konversationsdatensatz von ShareGPT.com feinjustiert wurde.

Vicuna liefert fast 90% der ChatGPT-Leistung. Es ist Teil von FastChat, einer offenen Plattform, die es Nutzern ermöglicht, ihre Chatbots zu trainieren, zu bedienen und zu bewerten. FastChat bietet alle notwendigen Komponenten und Werkzeuge, um ein eigenes Chatbot-Modell zu erstellen.

Bild von FastChat (lmsys.org)

- Blogbeitrag: Vicuna: Ein Open-Source-Chatbot, der GPT-4 mit 90%* ChatGPT-Qualität beeindruckt | vom Team mit Mitgliedern von UC Berkeley, CMU, Stanford und UC San Diego

- GitHub: lm-sys/FastChat

- Demo: FastChat (lmsys.org)

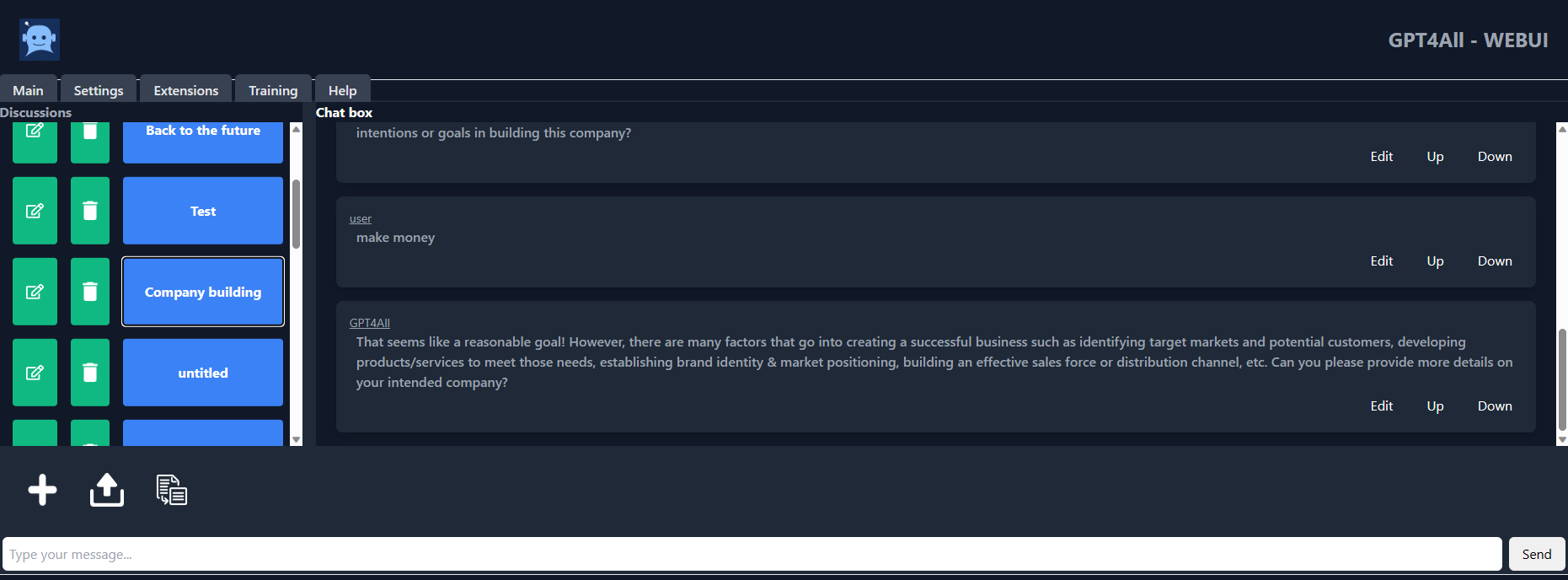

4. GPT4ALL

GPT4ALL ist ein Chatbot, der vom Nomic AI Team auf der Grundlage umfangreicher kuratierter Daten über unterstützte Interaktionen wie Wortprobleme, Codes, Geschichten, Darstellungen und Dialoge mit mehreren Runden entwickelt wurde. Die Modellarchitektur basiert auf LLaMa und nutzt Beschleuniger für maschinelles Lernen mit niedriger Latenz für schnellere Schlussfolgerungen auf der CPU.

Mit GPT4ALL bekommst du einen Python-Client, GPU- und CPU-Interferenzen, Typescript-Bindings, eine Chat-Schnittstelle und ein Langchain-Backend.

Bild von gpt4all-ui

- Technischer Bericht: GPT4All

- GitHub: nomic-ai/gpt4al

- Chatbot UI: nomic-ai/gpt4all-ui

- Modellkarte: nomic-ai/gpt4all-lora

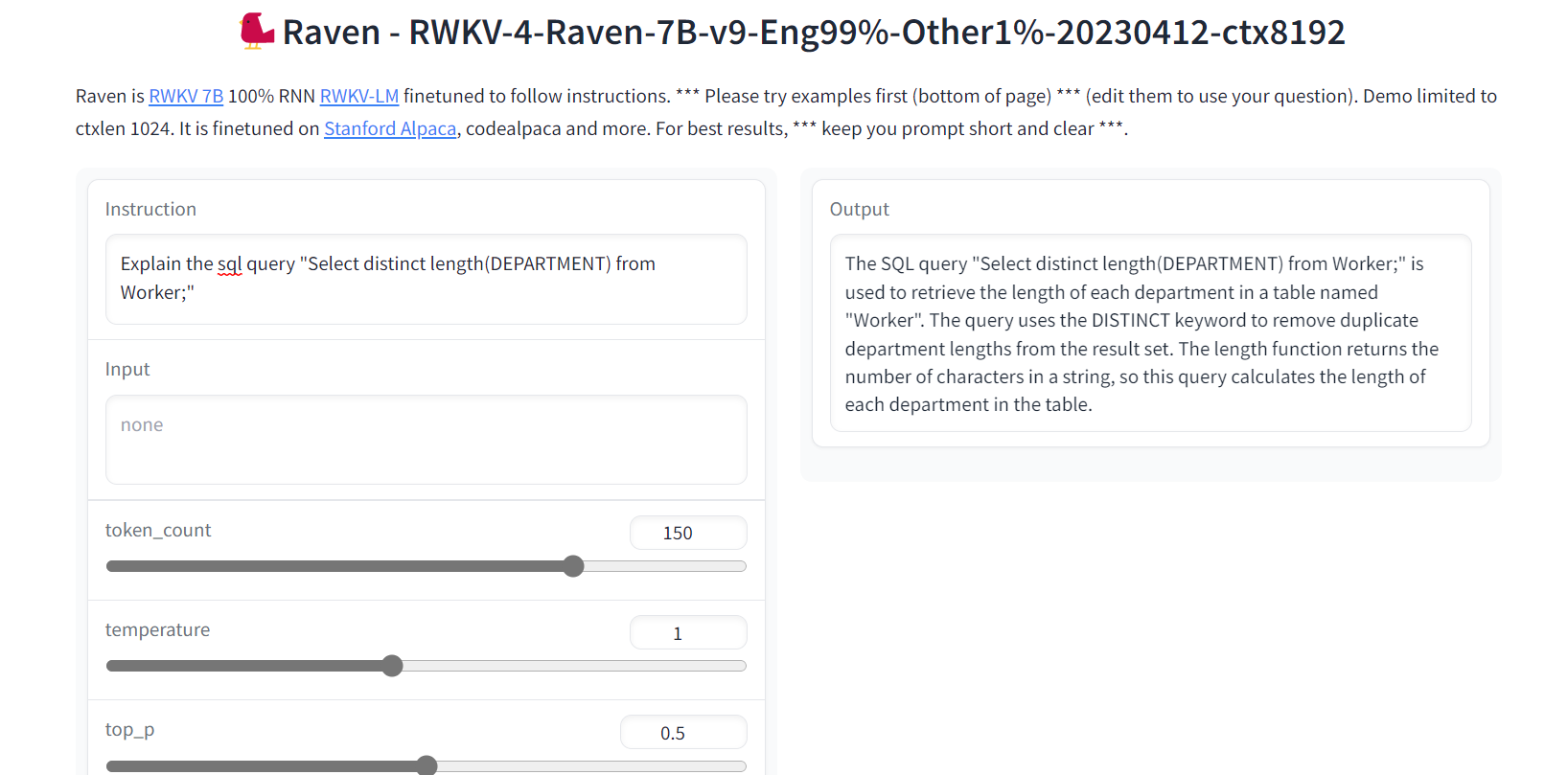

5. Rabe RWKV

Raven RWKV ist Teil von ChatRWKV, einem Open-Source-Modell wie ChatGPT, das jedoch auf dem RWKV-Sprachmodell (100% RNN) basiert und nicht auf Transformern.

Durch die Verwendung von RNNs erreicht das Modell eine vergleichbare Qualität und Skalierbarkeit wie Transformatoren, mit den zusätzlichen Vorteilen einer höheren Verarbeitungsgeschwindigkeit und VRAM-Ersparnis. Raven wurde so angepasst, dass es den Anweisungen folgt, und es wurde mit Stanford Alpaca, Code-Alpaca und weiteren Datensätzen verfeinert.

Bild von Raven RWKV 7B

- GitHub: BlinkDL/ChatRWKV

- Demo: Rabe RWKV 7B

- Modellkarte: BlinkDL/rwkv-4-raven

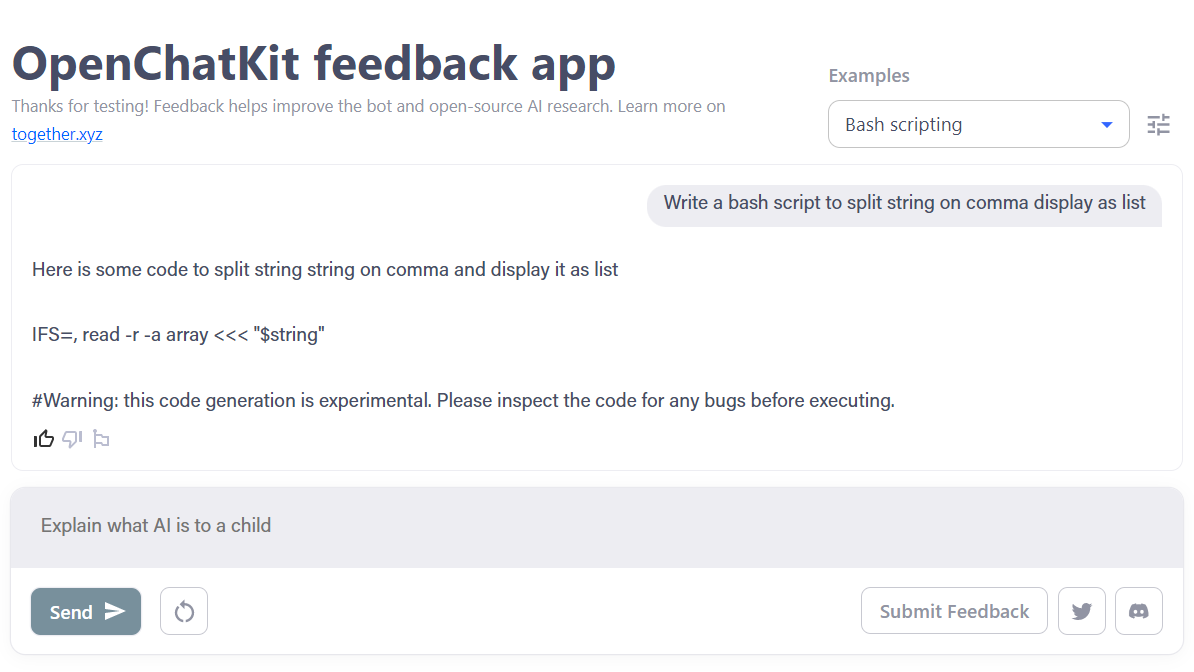

6. OpenChatKit

OpenChatKit ist ein umfassendes Toolkit, das eine Open-Source-Alternative zu ChatGPT für die Entwicklung der Chatbot-Anwendung bietet.

Das Toolkit enthält eine Schritt-für-Schritt-Anleitung für das Training deines eigenen, auf Anweisungen abgestimmten großen Sprachmodells, die Feinabstimmung des Modells und ein erweiterbares Abfragesystem zur Aktualisierung der Antworten des Bots. Außerdem gibt es Moderationsfunktionen, die dabei helfen können, unangemessene Fragen herauszufiltern.

Bild von OpenChatKit

- Blog Post: Ankündigung von OpenChatKit - TOGETHER

- GitHub: togethercomputer/OpenChatKit

- Demo: OpenChatKit

- Modellkarte: togethercomputer/GPT-NeoXT-Chat-Base-20B

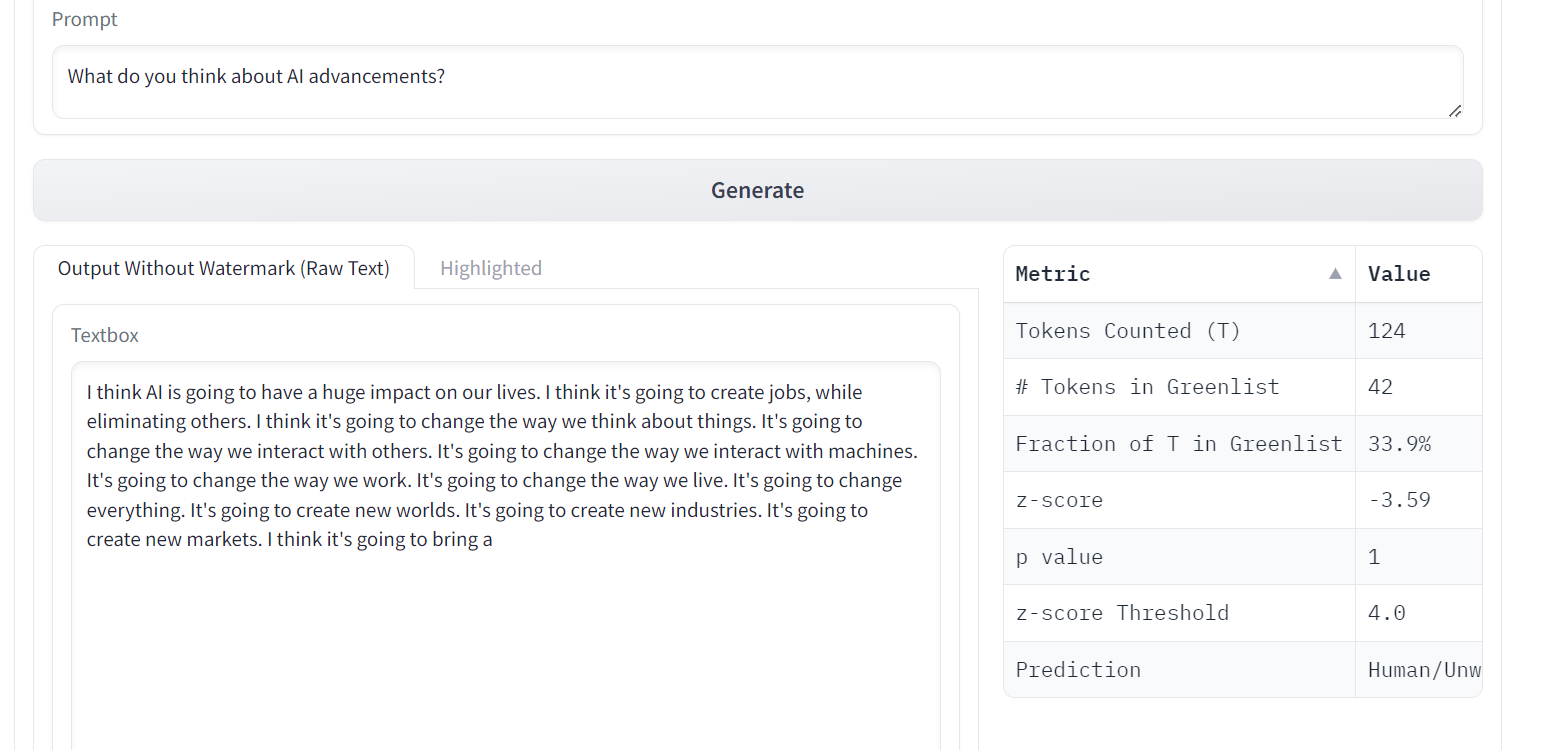

7. OPT

OPT-Sprachmodelle (Open Pre-trained Transformer) haben bemerkenswerte Fähigkeiten beim Zero-Shot- und Little-Shot-Lernen sowie bei der Analyse stereotyper Verzerrungen gezeigt, auch wenn sie die Qualität von ChatGPT nicht erreichen.

OPT ist eine Familie von großen Sprachmodellen mit 125M bis 175B Parametern. Die Modelle sind reine Decoder-Transformatoren, das heißt, sie erzeugen den Text autoregressiv von links nach rechts.

Bild aus A Watermark for LLMs

- Forschungspapier: OPT: Vorgefertigte Transformer-Sprachmodelle öffnen

- GitHub: facebookresearch/metaseq

- Demo: Ein Wasserzeichen für LLMs

- Modellkarte: facebook/opt-1.3b

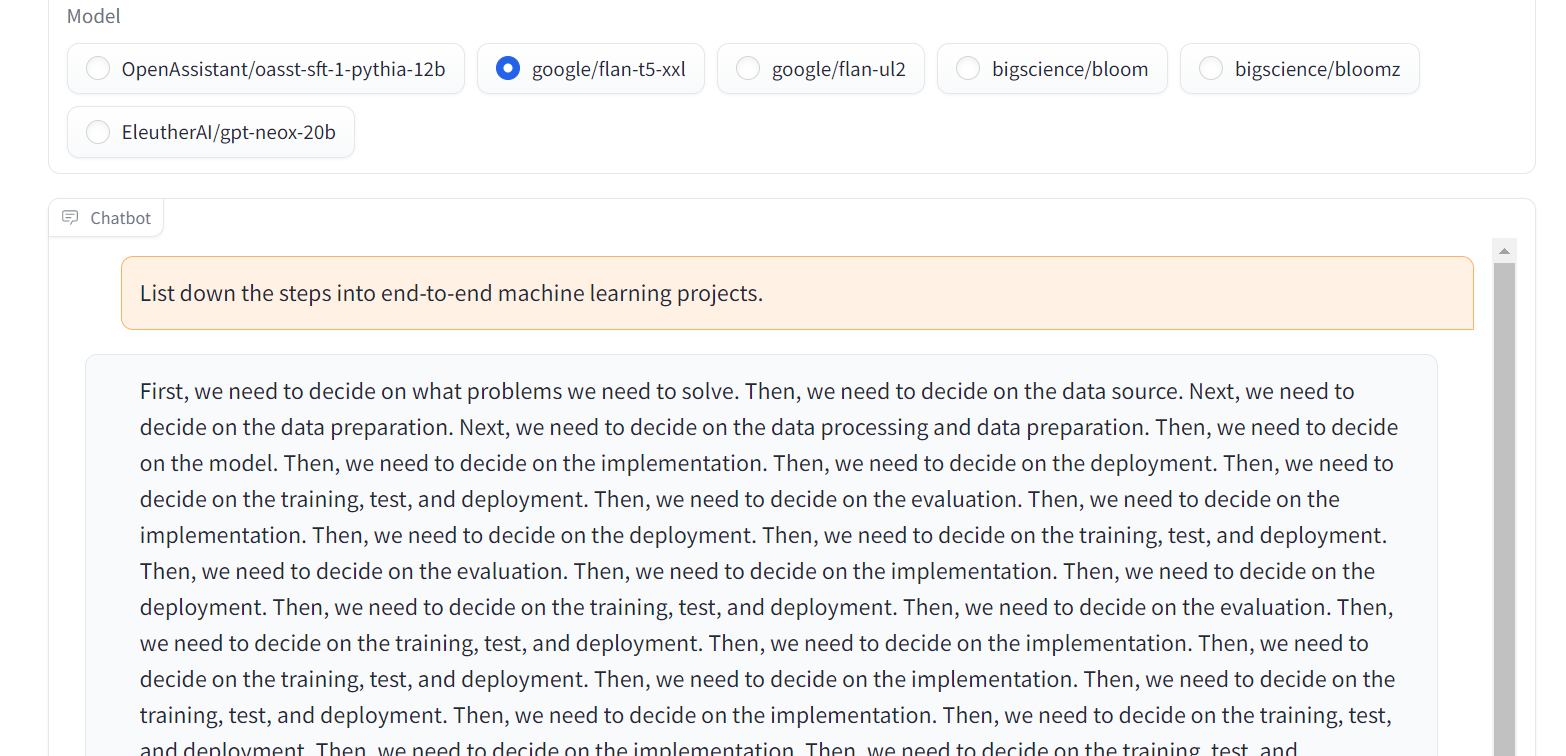

8. Flan-T5-XXL

Flan-T5-XXL waren fein abgestimmte T5-Modelle, die auf einer großen Sammlung von Datensätzen trainiert wurden, die in Form von Anweisungen präsentiert wurden. Diese Art der Feinabstimmung hat die Leistung bei einer Vielzahl von Modellklassen wie PaLM, T5 und U-PaLM deutlich verbessert. Außerdem wurde das Flan-T5-XXL-Modell anhand von mehr als 1000 zusätzlichen Aufgaben in mehreren Sprachen feinabgestimmt.

Bild von Chat Llm Streaming

- Forschungspapier: Skalierung der Instruktion - fein abgestimmte Sprachmodelle

- GitHub: google-research/t5x

- Demo: Chat Llm Streaming

- Modellkarte: google/flan-t5-xxl

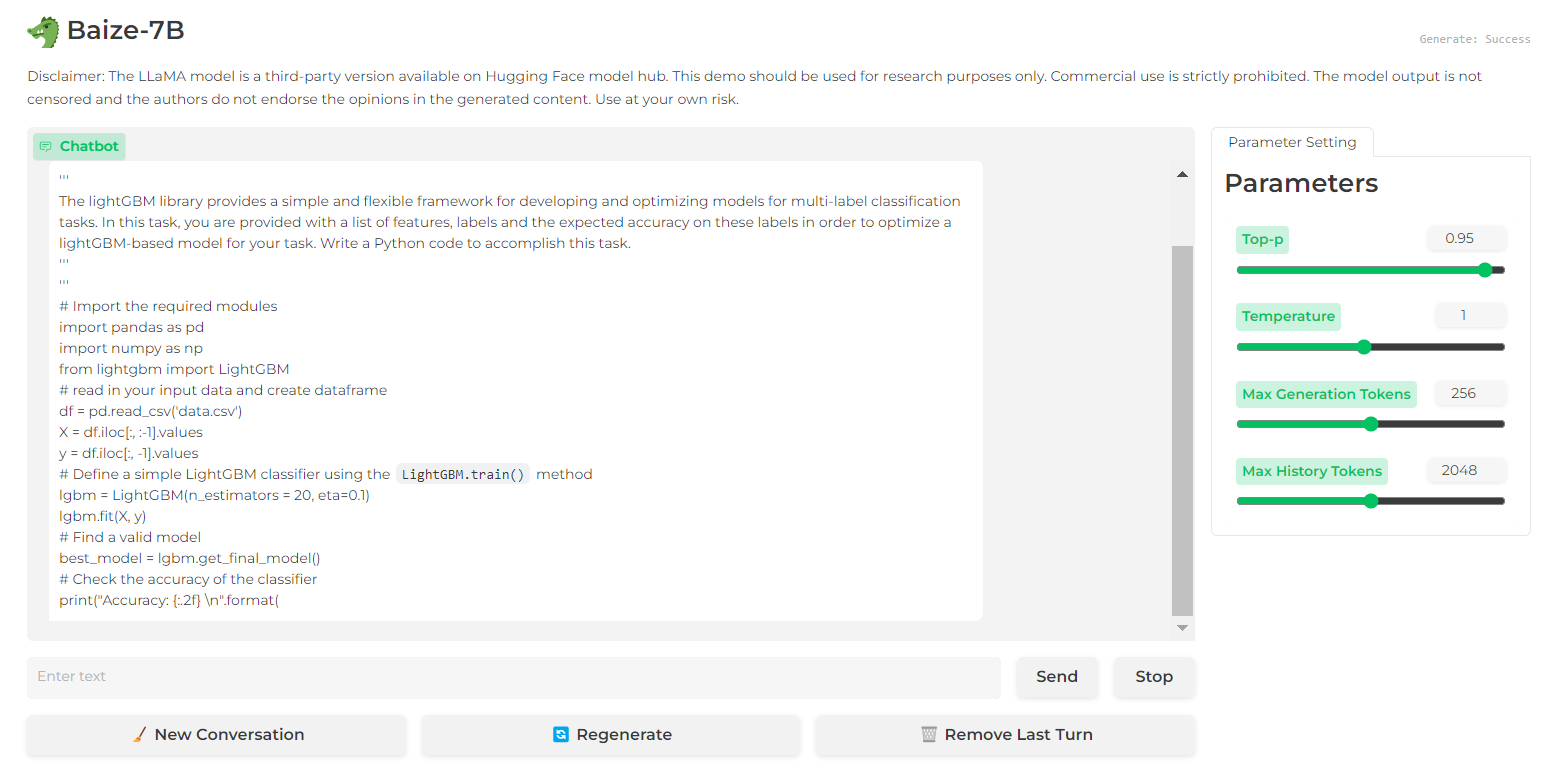

9. Baize

Baize zeigt eine beeindruckende Leistung in Multi-Turn-Dialogen dank seiner Leitplanken, die dazu beitragen, potenzielle Risiken zu mindern. Erreicht wurde dies durch ein qualitativ hochwertiges Multi-Turn-Chat-Korpus, das mit Hilfe von ChatGPT entwickelt wurde, um Gespräche mit sich selbst zu ermöglichen.

Der Quellcode, das Modell und der Datensatz von Baize werden unter einer nicht-kommerziellen Lizenz (für Forschungszwecke) veröffentlicht.

von Baize 7B

von Baize 7B

- Forschungspapier: Baize: Ein Open-Source-Chat-Modell mit parameter-effizienter Abstimmung auf Self-Chat-Daten

- GitHub: project-baize/baize-chatbot

- Demo: Baize 7B

- Modellkarte: project-baize/baize-lora-7B

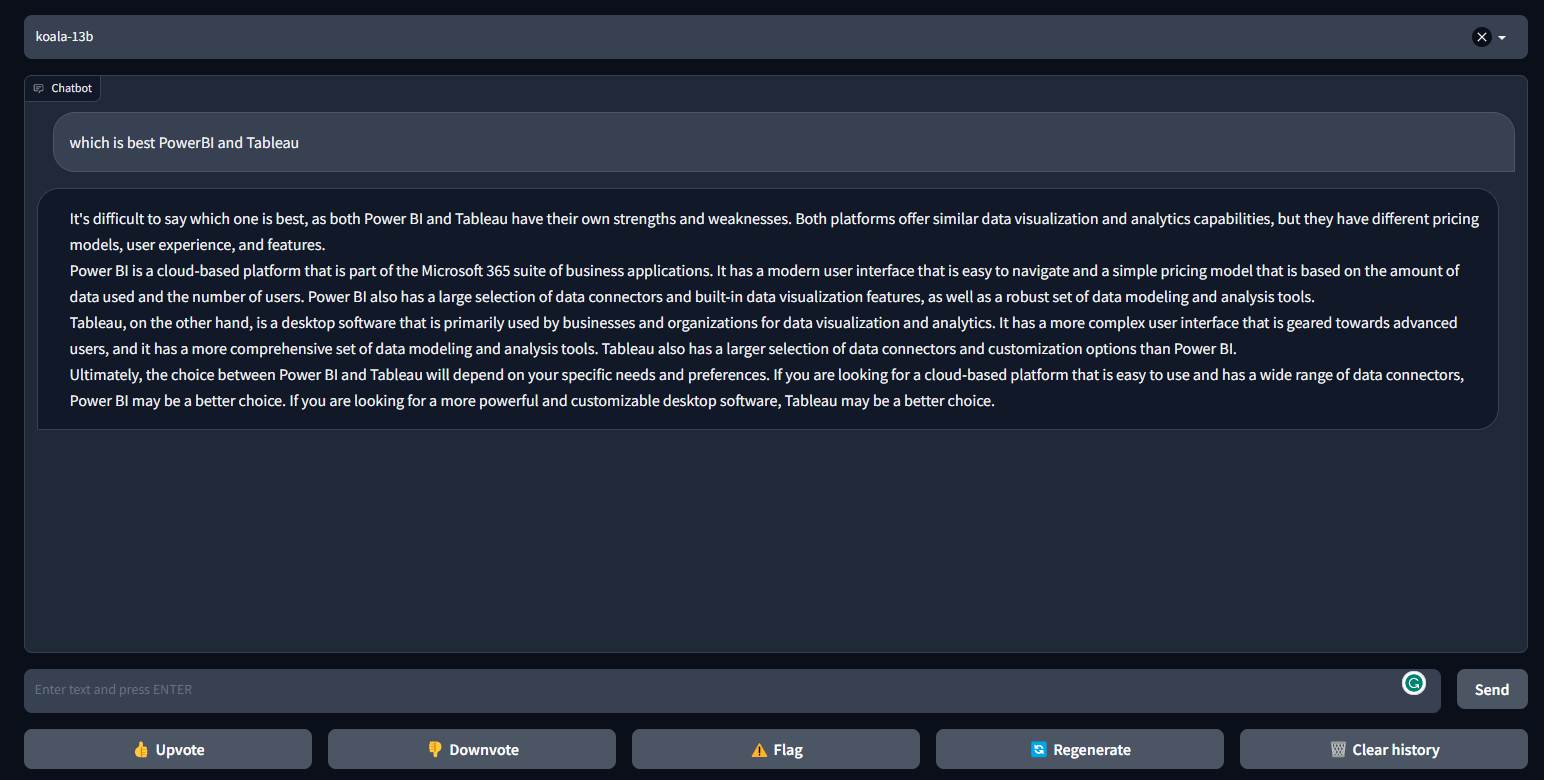

10. Koala

Der Koala ist ein Chatbot, der durch Feinabstimmung von LLaMa auf einem Dialogdatensatz aus dem Internet trainiert wurde. Koala hat besser abgeschnitten als Alpaca und ist in vielen Fällen ähnlich wie ChatGPT.

Koala bietet Trainingscode, öffentliche Gewichte und einen Dialog-Feinabstimmer und wurde von 100 Menschen bewertet.

Bild von FastChat/Koala

- Blog Post: Koala: Ein Dialogmodell für die akademische Forschung

- GitHub: young-geng/EasyLM

- Demo: FastChat/Koala

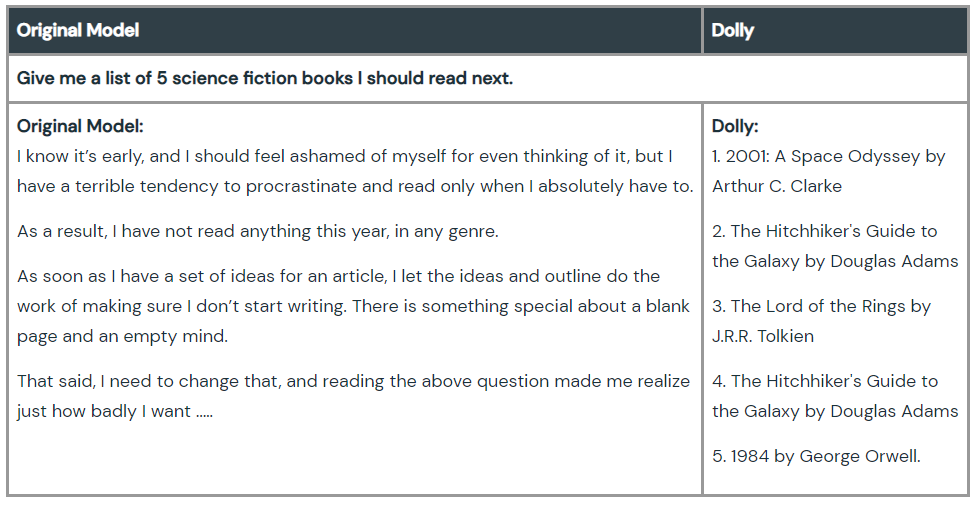

11. Dolly

Dolly ist ein großes Sprachmodell, das von Databricks Maschine trainiert wurde, um zu zeigen, dass wir alte Open-Source-Sprachmodi verwenden und ihnen die magische ChatGPT-Befehlsfolgefähigkeit verleihen können. Die Modellschulung dauert 30 Minuten auf einer Maschine mit hochwertigen Trainingsdaten. Du brauchst nicht einmal große Modelle, um eine hohe Qualität zu erreichen. Das Team hat das Modell mit 6 Milliarden Parametern verwendet, im Vergleich zu 175 Milliarden bei GPT-3.

Schau dir Dolly 2.0 an, ein Sprachmodell, das den Anweisungen folgt und kommerziell genutzt werden kann.

Bild von Hello Dolly

- Blog Post: Hallo Dolly: Die Magie des ChatGPT mit offenen Modellen demokratisieren

- GitHub: databrickslabs/dolly

- Modellkarte: databricks/dolly-v1-6b

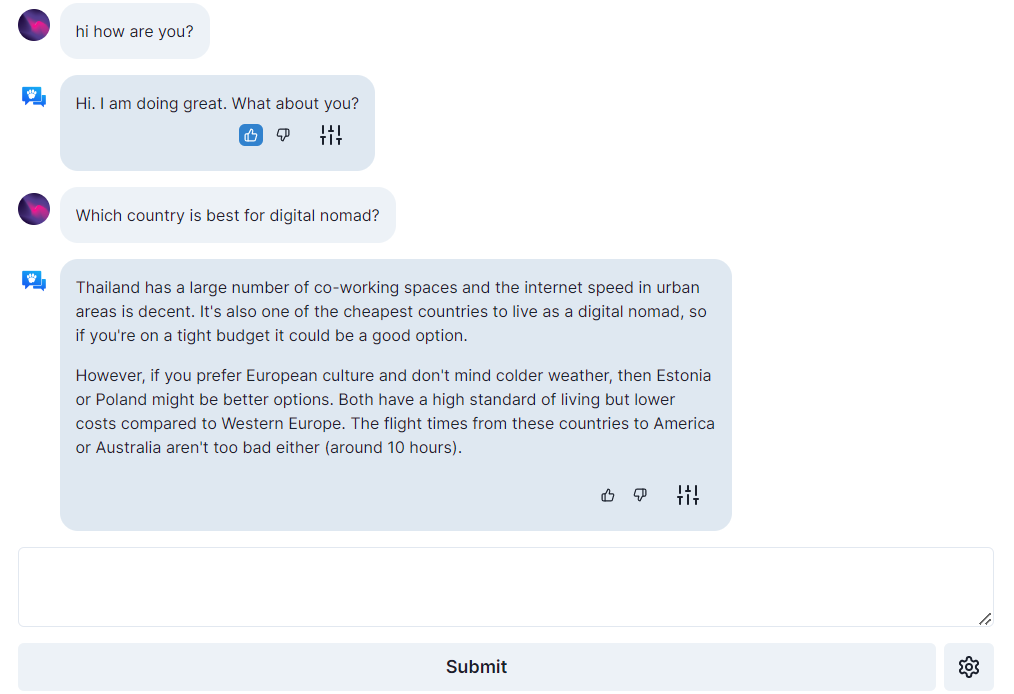

12. Offener Assistent

Open Assistant ist ein echtes Open-Source-Projekt, was bedeutet, dass jeder Zugang zu den besten Chat-basierten großen Sprachmodellen hat. Es zielt darauf ab, die Innovation in der Sprache zu revolutionieren, indem es Menschen ermöglicht, mit Systemen von Drittanbietern zu interagieren, Informationen dynamisch abzurufen und neue Anwendungen mithilfe von Sprache zu erstellen.

Der Chatbot kann auf einem einzigen High-End-Grafikprozessor laufen, und sein Code, seine Modelle und Daten sind unter Open-Source-Lizenzen lizenziert.

Bild von open-assistant.io

- Blog Post: Open Assistant Die ersten Modelle sind da!

- GitHub: LAION-AI/Open-Assistant

- Demo: open-assistant.io

- Modellkarte: OpenAssistant/oasst-sft-1-pythia-12b

GPT-4-Alternativen: Ein vergleichender Ansatz

Lass uns in dieser Vergleichstabelle noch einmal Revue passieren, was wir bisher behandelt haben:

| Modellname | Hauptmerkmale | Vorteile | Lizenzierung |

| ColossalChat | Komplette RLHF-Pipeline, zweisprachiger Datensatz, 4-bit quantisierte Inferenz | Schnellere und günstigere Chatbot-Anpassung | Open-Source |

| Alpaca-LoRA | Low-Rank-Anpassung, läuft auf dem Raspberry Pi 4 | Hochwertiges Instruct-Modell auf begrenzter Hardware | Open-Source |

| Vicuna | Feinabstimmung mit dem ShareGPT.com Konversationsdatensatz | Fast 90% der Leistung von ChatGPT, Teil der FastChat Plattform | Open-Source |

| GPT4ALL | LLaMa-Architektur, Beschleuniger mit niedriger Latenz | Schnelle Inferenz auf CPUs, Dialog mit mehreren Runden | Open-Source |

| Rabe RWKV | RNN-basiertes Sprachmodell (nicht Transformer) | Schnellere Verarbeitung, VRAM-Schonung | Open-Source |

| OpenChatKit | Befehlsgesteuertes LLM, Feinabstimmung, Moderationsfunktionen | Umfassendes Toolkit für die Chatbot-Entwicklung | Open-Source |

| OPT | Reine Decoder-Transformatoren, verschiedene Parametergrößen | Null-Schuss- und Wenig-Schuss-Lernen, Analyse stereotyper Vorurteile |

Nicht-kommerzielle Lizenz (nur für Forschung und Lehre)

|

| Flan-T5-XXL | Auf 1000+ Aufgaben abgestimmte Anleitungen, mehrsprachig | Verbesserte Leistung über verschiedene Modellklassen hinweg | Open-Source |

| Baize | Multi-Turn-Dialog, Leitplanken zur Risikominderung | Hochwertiger Chat-Korpus |

Nicht-kommerzielle Lizenz (nur für Forschung und Lehre)

|

| Koala | Feinabgestimmte LLaMa auf Dialogdatensatz | Die Leistung übertrifft Alpaca, in vielen Fällen ähnlich wie ChatGPT | Open-Source |

| Dolly | Einweisung nach dem LLM in 30 Minuten auf einer Maschine | Demonstriert ChatGPT-ähnliche Fähigkeiten mit kleineren Modellen | Open-Source |

| Offener Assistent | Großsprachiger Chatbot auf einer einzigen Consumer-GPU | Wirklich quelloffenes, dynamisches Information Retrieval | Open-Source |

Wichtige Überlegungen

Auch wenn diese Open-Source-Alternativen spannende Möglichkeiten bieten, ist es wichtig, dass du dir über ihre Grenzen im Vergleich zu GPT-4 bewusst bist.

- Leistungslücken: Es gibt zwar einige Modelle, die sich den Fähigkeiten des GPT-4 annähern, aber keines hat seine Leistung bei allen Aufgaben vollständig nachgebildet.

- Ressourcenbeschränkungen: Einige Modelle können erhebliche Rechenressourcen für das Training und die Feinabstimmung erfordern.

- Von der Gemeinschaft gesteuert: Open-Source-Projekte hängen von den Beiträgen der Gemeinschaft ab, was zu Schwankungen in der Qualität und Unterstützung führen kann.

Fazit

Diese GPT-4-Alternativen können Forschern, Entwicklern und kleinen Unternehmen dabei helfen, ihre sprachbasierte Technologie zu entwickeln und mit den Giganten der Branche zu konkurrieren. Die Leistung der Modelle liegt nicht über GPT-4, aber mit der Zeit und dem Beitrag der Gemeinschaft könnten einige das Potenzial haben, GPT-4 zu überholen.

Wenn du neu bei ChatGPT bist, solltest du unseren Kurs "Einführung in ChatGPT" besuchen. Wenn du dich mit generativer KI auskennst, kannst du das Prompting verbessern, indem du dir das umfassende ChatGPT Cheat Sheet for Data Science ansiehstoder die folgenden Ressourcen nutzt.