Atualmente, muitas organizações querem usar dados para orientar suas decisões, mas precisam de ajuda para gerenciar suas crescentes fontes de dados. Mais importante ainda, quando não conseguem transformar seus dados brutos em formatos utilizáveis, eles podem ter pouca disponibilidade de dados, o que pode prejudicar o desenvolvimento de uma cultura de dados.

As ferramentas ETL (Extract, Transform, Load) são uma parte importante da solução desses problemas. Há muitas ferramentas ETL diferentes para escolher, o que dá às empresas o poder de selecionar a melhor opção. Entretanto, a análise de todas as opções disponíveis pode consumir muito tempo.

Nesta postagem, compilamos uma lista com as 16 principais ferramentas de ETL, detalhando algumas das melhores opções do mercado.

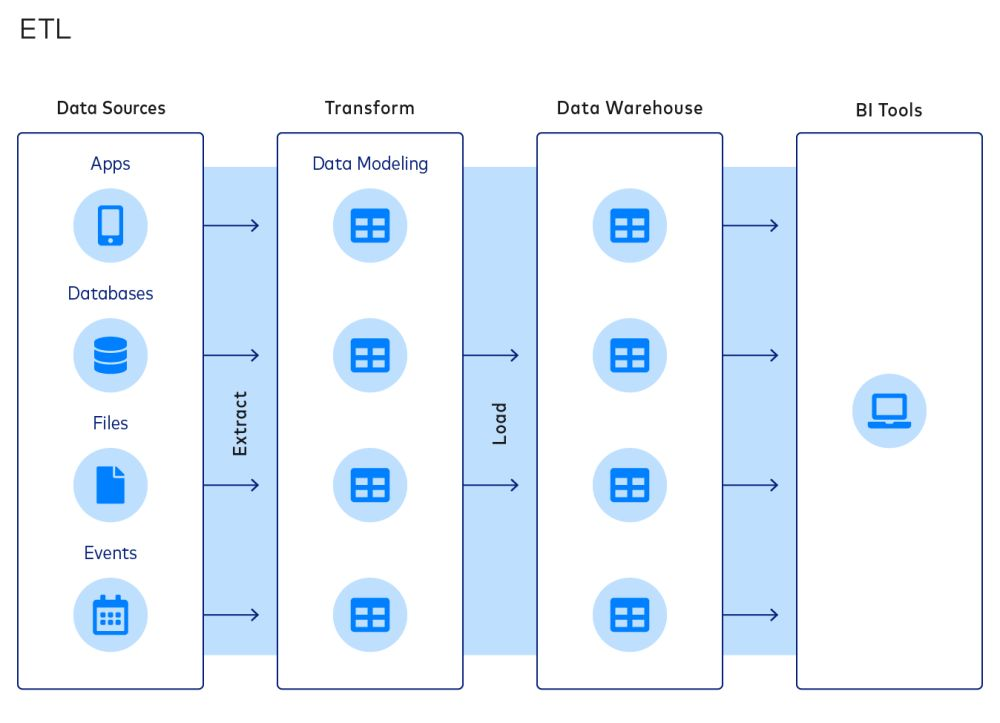

O que é ETL?

O ETL é uma abordagem comum para integrar dados e organizar pilhas de dados. Um processo típico de ETL compreende os seguintes estágios:

- Extração de dados de fontes

- Transformação de dados em modelos de dados

- Carregamento de dados em data warehouses

O paradigma ETL é popular porque permite que as empresas reduzam o tamanho de seus data warehouses, o que pode economizar em custos de computação, armazenamento e largura de banda.

No entanto, essas economias de custo estão se tornando menos importantes à medida que essas restrições desaparecem. Como resultado, o ELT (Extract, Load, Transform) está se tornando mais popular. No processo ELT, os dados são carregados em um destino após a extração, e a transformação é a etapa final do processo. Apesar disso, muitas empresas ainda dependem do ETL.

O que são ferramentas de ETL?

Como o nome sugere, as ferramentas ETL são um conjunto de ferramentas de software usadas para extrair, transformar e carregar dados de uma ou mais fontes em um sistema ou banco de dados de destino. As ferramentas de ETL são projetadas para automatizar e simplificar o processo de extração de dados de várias fontes, transformando-os em um formato consistente e limpo e carregando-os no sistema de destino de maneira oportuna e eficiente. Na próxima seção, veremos as principais considerações que as equipes de dados devem fazer ao considerar uma ferramenta de ETL.

Principais considerações sobre as ferramentas de ETL

Aqui estão três considerações importantes sobre as ferramentas de ETL de uma empresa.

- A extensão da integração de dados. As ferramentas de ETL podem se conectar a uma variedade de fontes e destinos de dados. As equipes de dados devem optar por ferramentas de ETL que ofereçam uma ampla gama de integrações. Por exemplo, as equipes que desejam mover dados do Google Sheets para o Amazon Redshift devem selecionar ferramentas de ETL que suportem esses conectores.

- Nível de personalização. As empresas devem escolher suas ferramentas de ETL com base em seus requisitos de personalização e conhecimento técnico de sua equipe de TI. Uma empresa iniciante pode achar que os conectores e as transformações incorporados na maioria das ferramentas de ETL são suficientes; uma grande empresa com coleta de dados sob medida provavelmente precisará da flexibilidade para criar transformações sob medida com a ajuda de uma equipe forte de engenheiros.

- Estrutura de custos. Ao escolher uma ferramenta de ETL, as organizações devem considerar não apenas o custo da ferramenta em si, mas também os custos da infraestrutura e dos recursos humanos necessários para manter a solução a longo prazo. Em alguns casos, uma ferramenta de ETL com um custo inicial mais alto, mas com menos tempo de inatividade e requisitos de manutenção, pode ser mais econômica no longo prazo. Por outro lado, existem ferramentas ETL gratuitas e de código aberto que podem ter altos custos de manutenção.

Algumas outras considerações incluem:

- O nível de automação fornecido

- O nível de segurança e conformidade

- O desempenho e a confiabilidade da ferramenta.

As 19 principais ferramentas de ETL que as equipes de dados podem considerar

Com essas considerações em mente, apresentamos as 16 principais ferramentas de ETL disponíveis no mercado. Observe que as ferramentas não estão ordenadas por qualidade, pois diferentes ferramentas têm diferentes pontos fortes e fracos.

1. Informatica PowerCenter

O Informatica PowerCenter é uma das melhores ferramentas de ETL do mercado. Ele tem uma ampla gama de conectores para data warehouses e lagos de dados em nuvem, incluindo AWS, Azure, Google Cloud e SalesForce. Suas ferramentas com pouco ou nenhum código foram projetadas para economizar tempo e simplificar os fluxos de trabalho.

O Informatica PowerCenter inclui vários serviços que permitem aos usuários projetar, implantar e monitorar pipelines de dados. Por exemplo, o Repository Manager ajuda no gerenciamento de usuários, o Designer permite que os usuários especifiquem o fluxo de dados da origem para o destino e o Workflow Manager define a sequência de tarefas.

2. Fluxo de ar Apache

O Apache Airflow é uma plataforma de código aberto para criar, agendar e monitorar fluxos de trabalho de forma programática. A plataforma apresenta uma interface de usuário baseada na Web e uma interface de linha de comando para gerenciar e acionar fluxos de trabalho.

Os fluxos de trabalho são definidos usando gráficos acíclicos direcionados (DAGs), que permitem a visualização e o gerenciamento claros de tarefas e dependências. O Airflow também se integra a outras ferramentas comumente usadas em engenharia de dados e ciência de dados, como o Apache Spark e o Pandas.

As empresas que usam o Airflow podem se beneficiar de sua capacidade de dimensionar e gerenciar fluxos de trabalho complexos, bem como de sua comunidade ativa de código aberto e ampla documentação. Você pode aprender sobre o Airflow no seguinte curso do DataCamp.

3. IBM Infosphere Datastage

O Infosphere Datastage é uma ferramenta ETL oferecida pela IBM como parte de seu ecossistema Infosphere Information Server. Com sua estrutura gráfica, os usuários podem projetar pipelines de dados que extraem dados de várias fontes, realizam transformações complexas e entregam os dados aos aplicativos de destino.

O IBM Infosphere é conhecido por sua velocidade, graças a recursos como balanceamento de carga e paralelização. Ele também oferece suporte a metadados, detecção automatizada de falhas e uma ampla gama de serviços de dados, desde o armazenamento de dados até aplicativos de IA.

Como outras ferramentas ETL empresariais, o Infosphere Datastage oferece uma variedade de conectores para integrar diferentes fontes de dados. Ele também se integra perfeitamente a outros componentes do IBM Infosphere Information Server, permitindo que os usuários desenvolvam, testem, implementem e monitorem trabalhos de ETL.

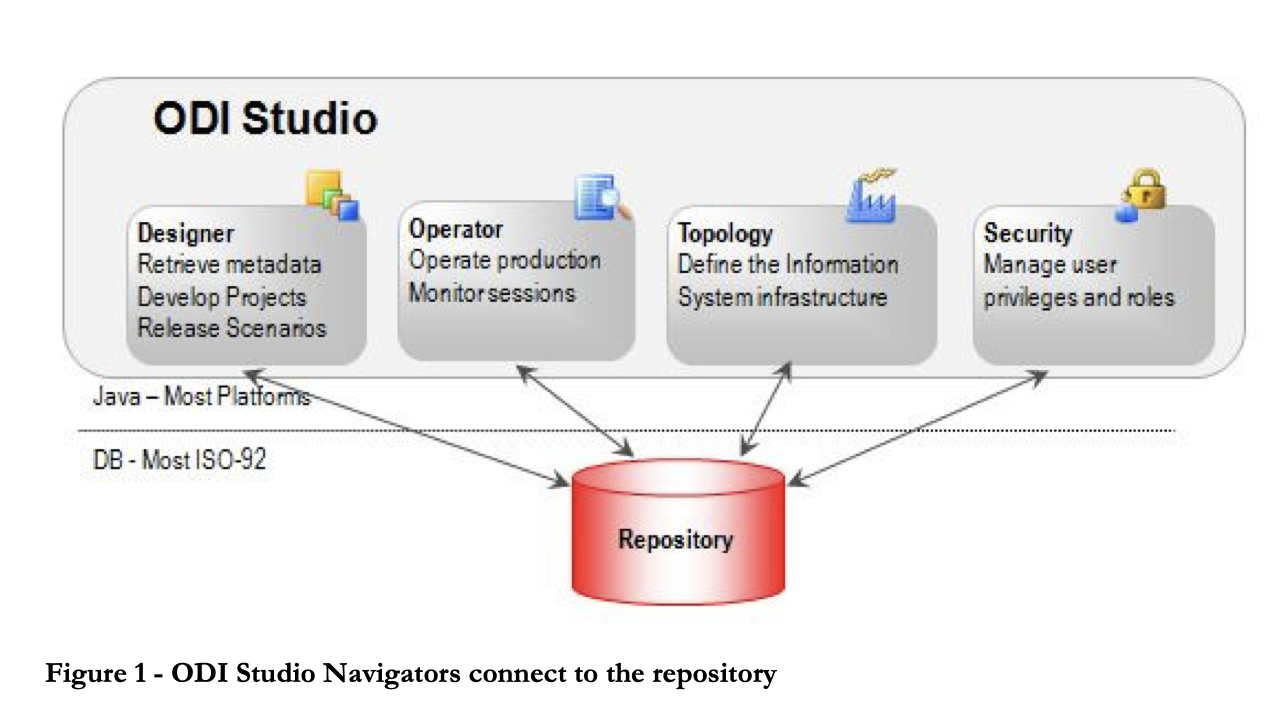

4. Integrador de dados Oracle

O Oracle Data Integrator é uma ferramenta de ETL que ajuda os usuários a criar, implementar e gerenciar data warehouses complexos. Ele vem com conectores prontos para uso em vários bancos de dados, incluindo Hadoop, EREPs, CRMs, XML, JSON, LDAP, JDBC e ODBC.

O ODI inclui o Data Integrator Studio, que fornece aos usuários corporativos e desenvolvedores acesso a vários artefatos por meio de uma interface gráfica de usuário. Esses artefatos oferecem todos os elementos de integração de dados, desde a movimentação de dados até a sincronização, a qualidade e o gerenciamento.

5. Serviços de integração do Microsoft SQL Server (SSIS)

O SSIS é uma plataforma de nível empresarial para integração e transformação de dados. Ele vem com conectores para extrair dados de fontes como arquivos XML, arquivos simples e bancos de dados relacionais. Os profissionais podem usar a interface gráfica do usuário do designer do SSIS para construir fluxos e transformações de dados.

A plataforma inclui uma biblioteca de transformações incorporadas que minimizam a quantidade de código necessária para o desenvolvimento. O SSIS também oferece uma documentação abrangente para a criação de fluxos de trabalho personalizados. No entanto, a curva de aprendizado acentuada e a complexidade da plataforma podem desencorajar os iniciantes a criar rapidamente pipelines de ETL.

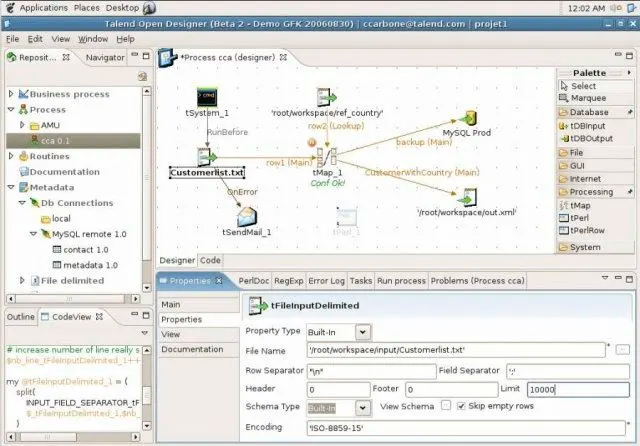

6. Talend Open Studio (TOS)

O Talend Open Studio é um software popular de integração de dados de código aberto que apresenta uma interface gráfica amigável. Os usuários podem arrastar e soltar componentes, configurá-los e conectá-los para criar pipelines de dados. Nos bastidores, o Open Studio converte a representação gráfica em código Java e Perl.

Como uma ferramenta de código aberto, o TOS é uma opção acessível com uma ampla variedade de conectores de dados, incluindo conectores RDBMS e SaaS. A plataforma também se beneficia de uma comunidade ativa de código aberto que contribui regularmente com a documentação e fornece suporte.

7. Integração de dados Pentaho (PDI)

O Pentaho Data Integration (PDI) é uma ferramenta ETL oferecida pela Hitachi. Ele captura dados de várias fontes, limpa-os e os armazena em um formato uniforme e consistente.

Anteriormente conhecido como Kettle, o PDI apresenta várias interfaces gráficas de usuário para definir pipelines de dados. Os usuários podem criar trabalhos e transformações de dados usando o cliente PDI, Spoon, e depois executá-los usando o Kitchen. Por exemplo, o cliente PDI pode ser usado para ETL em tempo real com o Pentaho Reporting.

8. Hadoop

O Hadoop é uma estrutura de código aberto para processamento e armazenamento de big data em clusters de servidores de computador. Ele é considerado a base do big data e permite o armazenamento e o processamento de grandes quantidades de dados.

A estrutura do Hadoop consiste em vários módulos, incluindo o HDFS (Hadoop Distributed File System) para armazenar dados, o MapReduce para ler e transformar dados e o YARN para gerenciamento de recursos. O Hive é comumente usado para converter consultas SQL em operações de MapReduce.

As empresas que estão pensando em usar o Hadoop devem estar cientes de seus custos. Uma parte significativa do custo de implementação do Hadoop vem da capacidade de computação necessária para o processamento e da experiência necessária para manter o ETL do Hadoop, e não das ferramentas ou do armazenamento em si.

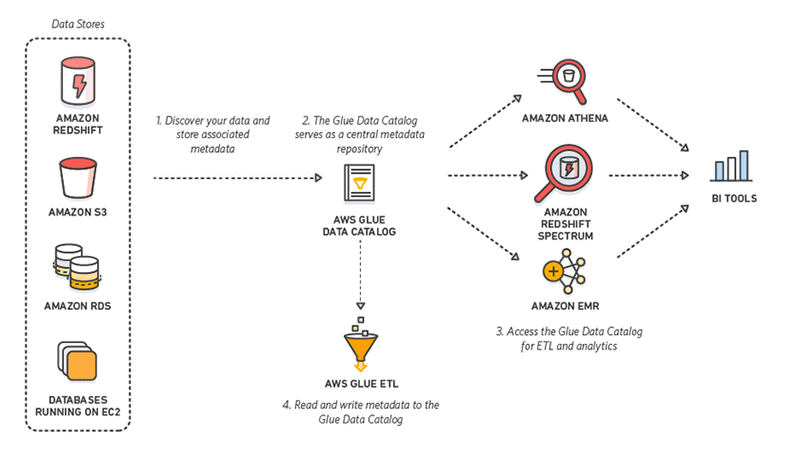

9. AWS Glue

O AWS Glue é uma ferramenta de ETL sem servidor oferecida pela Amazon. Ele descobre, prepara, integra e transforma dados de várias fontes para casos de uso de análise. Sem a necessidade de configurar ou gerenciar a infraestrutura, o AWS Glue promete reduzir o alto custo da integração de dados.

Melhor ainda, ao interagir com o AWS Glue, os profissionais podem escolher entre uma GUI de arrastar e soltar, um notebook Jupyter ou código Python/Scala. O AWS Glue também oferece suporte a vários processamentos de dados e cargas de trabalho que atendem a diferentesnecessidades comerciais, incluindo ETL, ELT, batch e streaming.

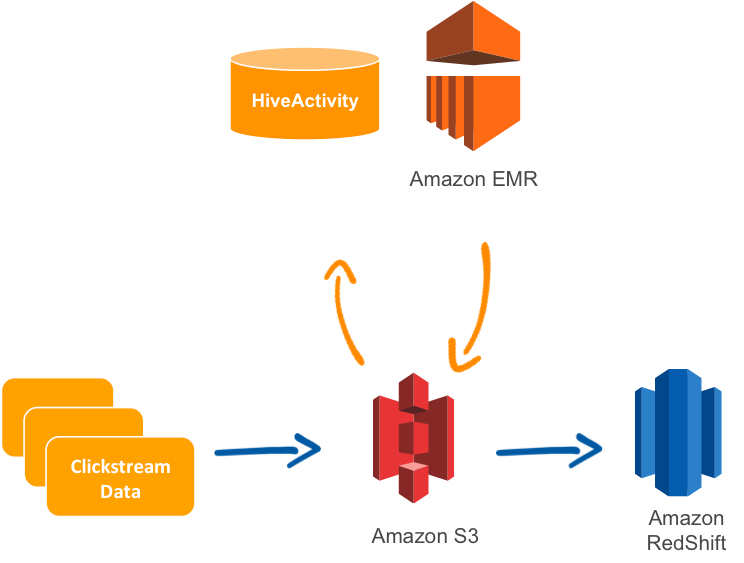

10. AWS Data Pipeline

O Data Pipeline da AWS é um serviço ETL gerenciado que permite a movimentação de dados entre os serviços da AWS ou recursos locais. Os usuários podem especificar os dados a serem movidos, os trabalhos ou consultas de transformação e um cronograma para realizar as transformações.

O Data Pipeline é conhecido por sua confiabilidade, flexibilidade e escalabilidade, bem como por sua tolerância a falhas e configurabilidade. A plataforma também apresenta um console de arrastar e soltar para facilitar o uso. Além disso, ele é relativamente barato.

Um caso de uso comum do AWS Data Pipeline é replicar dados do Relational Database Service (RDS) e carregá-los no Amazon Redshift.

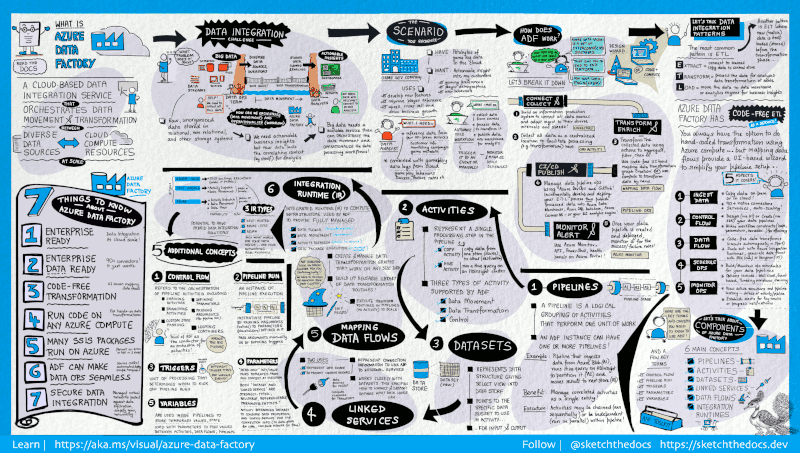

11. Azure Data Factory

O Azure Data Factory é um serviço de ETL baseado em nuvem oferecido pela Microsoft e usado para criar fluxos de trabalho que movem e transformam dados em escala.

Ele é composto por uma série de sistemas interconectados.stems. Juntos, esses sistemas permitem que os engenheiros não apenas ingiram um etransformem dados, mas também projetem, programem e monitorem pipelines de dados .

A força do Data Factory está no grande número de conectores disponíveis, do MySQL ao AWS, MongoDB, Salesforce e SAP. Ele também é elogiado por sua flexibilidade; os usuários podem optar por interagir com uma interface gráfica de usuário sem código ou com uma interface de linha de comando.

12. Fluxo de dados do Google Cloud

O Dataflow é o serviço de ETL sem servidor oferecido pelo Google Cloud. Ele permite o processamento de dados em fluxo e em lote e não exige que as empresas possuam um servidor ou cluster. Em vez disso, os usuários pagam apenas pelos recursos consumidos, que são dimensionados automaticamente com base nos requisitos e na carga de trabalho.

O Google Dataflow executa pipelines do Apache Beam no ecossistema do Google Cloud Platform. A Apache oferece SDKs Java, Python e Go para representar e transferir conjuntos de dados, tanto em lote quanto em fluxo contínuo. Isso permite que os usuários escolham o SDK apropriado para definir seus pipelines de dados.

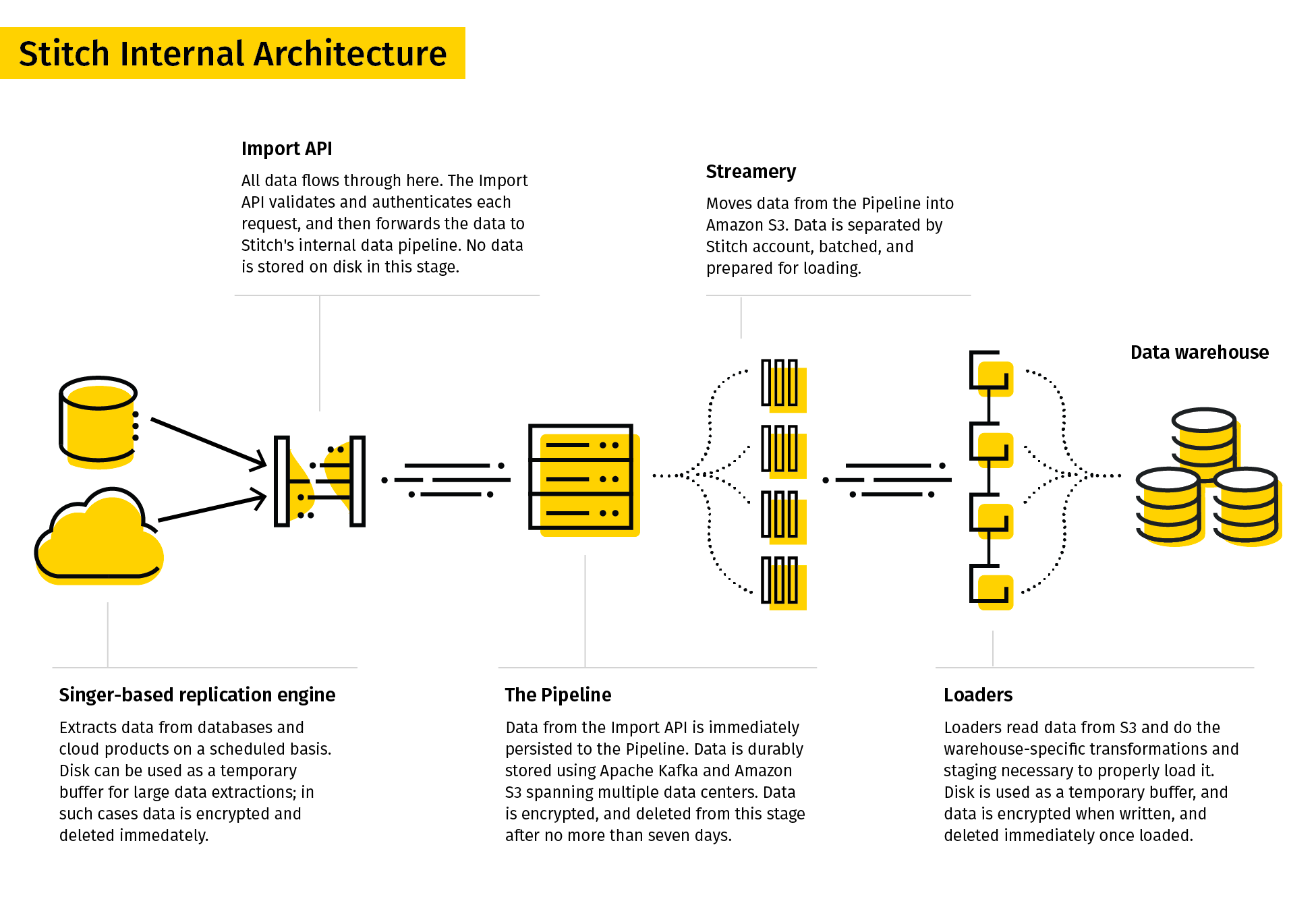

13. Stitch

O Stitch se descreve como uma ferramenta de ETL simples e extensível criada para equipes de dados.

O processo de replicação do Stitch extrai dados de várias fontes de dados, transforma-os em um formato bruto útil e os carrega no destino. Seus conectores de dados incluíam bancos de dados e aplicativos SaaS. Os destinos podem incluir data lakes, data warehousese plataformas de armazenamento.

Devido à sua simplicidade, o Stitch suporta apenas transformações simples e não transformações definidas pelo usuário.

14. SAP BusinessObjects Data Services

O SAP BusinessObjects Data Services é uma ferramenta ETL empresarial que permite aos usuários extrair dados de vários sistemas, transformá-los e carregá-los em data warehouses.

O Data Services Designer oferece uma interface gráfica de usuário para definir pipelines de dados e especificar transformações de dados. As regras e os metadados são armazenados em um repositório, e um servidor de trabalho executa o trabalho em lote ou em tempo real.

No entanto, os serviços de dados SAP podem ser caros, pois o custo da ferramenta, do servidor, do hardware e da equipe de engenharia pode aumentar rapidamente.

O SAP Data Services é uma boa opção para empresas que usam o SAP como seu sistema de planejamento de recursos empresariais (ERP), pois se integra perfeitamente ao SAP Data Services

15. Hevo

O Hevo é uma plataforma de integração de dados para ETL e ELT que vem com mais de 150 conectores para extrair dados de várias fontes. É uma ferramenta com pouco código, o que facilita aos usuários a criação de pipelines de dados sem a necessidade de muita experiência em codificação.

O Hevo oferece uma série de recursos e benefícios, incluindo integração de dados em tempo real, detecção automática de esquemas e a capacidade de lidar com grandes volumes de dados. A plataforma também vem com uma interface fácil de usar e suporte ao cliente 24 horas por dia, 7 dias por semana.

16. Qlik Compose

O Qlik Compose é uma solução de armazenamento de dados que projeta automaticamente armazéns de dados e gera código ETL. Essa ferramenta automatiza o desenvolvimento e a manutenção de ETLs tediosos e propensos a erros. Isso reduz o tempo de execução dos projetos de data warehousing.

Para isso, o Qlik Compose executa o código gerado automaticamente, que carrega os dados das fontes e os move para seus data warehouses. Esses fluxos de trabalho podem ser projetados e programados usando o Workflow Designer e o Scheduler.

O Qlik Compose também vem com a capacidade de validar os dados e garantir a qualidade dos dados. Os profissionais que precisam de dados em tempo real também podem integrar o Compose ao Qlik Replicate.

17. Integrate.io

A Integrate.io, anteriormente conhecida como Xplenty, conquistou um lugar merecido em nossa lista das principais ferramentas de ETL. Sua interface intuitiva e fácil de usar abre as portas para o gerenciamento abrangente de dados, mesmo para membros da equipe com menos conhecimento técnico. Como uma plataforma baseada na nuvem, a Integrate.io elimina a necessidade de instalações de hardware ou software volumosas e oferece uma solução altamente escalável que evolui de acordo com as necessidades de sua empresa.

Sua capacidade de se conectar a uma ampla variedade de fontes de dados, de bancos de dados a sistemas de CRM, torna-o uma opção versátil para diversos requisitos de integração de dados. Priorizando a segurança dos dados, ele oferece recursos como criptografia em nível de campo e está em conformidade com os principais padrões, como GDPR e HIPAA. Com recursos avançados de transformação de dados, os usuários podem facilmente limpar, formatar e enriquecer seus dados como parte do processo de ETL.

18. Airbyte

A Airbyte é uma das principais plataformas ELT de código aberto. A Airbyte oferece o maior catálogo de conectores de dados - 350 e está crescendo - e tem 40.000 engenheiros de dados usando-o em junho de 2023.

19. Astera Centerprise

O Astera Centerprise é uma ferramenta ETL/ELT de nível empresarial, 100% livre de código. Como parte do Astera Data Stack, o Centerprise apresenta uma interface intuitiva e fácil de usar que vem com uma curva de aprendizado curta e permite que usuários de todos os níveis técnicos criem pipelines de dados em minutos.

A ferramenta de integração de dados automatizada oferece uma série de recursos, como conectividade pronta para uso com várias fontes e destinos de dados, extração de dados com IA, mapeamento automático com IA, transformações avançadas integradas e recursos de qualidade de dados. Os usuários podem extrair facilmente dados estruturados e não estruturados, transformá-los e carregá-los no destino de sua escolha usando fluxos de dados. Esses fluxos de dados podem ser automatizados para serem executados em intervalos, condições ou quedas de arquivos específicos usando o agendador de tarefas incorporado.

Recursos adicionais

Concluindo, há muitas ferramentas diferentes de ETL e integração de dados disponíveis, cada uma com seus próprios recursos e capacidades exclusivos. Algumas opções populares incluem SSIS, Talend Open Studio, Pentaho Data Integration, Hadoop, Airflow, AWS Data Pipeline, Google Dataflow, SAP BusinessObjects Data Services e Hevo. As empresas que estão considerando essas ferramentas devem avaliar cuidadosamente seus requisitos específicos e seu orçamento paraescolher a solução certa para suas necessidades. Para obter mais recursos sobre ferramentas de ETL e outros, confira os links a seguir:

Perguntas frequentes

O que é ETL?

ETL significa Extract, Transform, Load (extrair, transformar e carregar). É um processo de extração de dados de várias fontes, transformando-os em um formato útil e carregando-os em um sistema de destino, como um data warehouse.

Quais são os benefícios de usar ferramentas de ETL?

As ferramentas de ETL automatizam o processo de integração de dados, reduzindo o tempo e o esforço necessários para criar e manter pipelines de dados. Eles também ajudam a garantir a precisão e a consistência dos dados, melhoram a qualidade dos dados e permitem uma tomada de decisão mais rápida.

Quais são alguns casos de uso comuns para ETL?

Os casos de uso comuns de ETL incluem armazenamento de dados, business intelligence, migração de dados, integração de dados e consolidação de dados.

Quais são algumas ferramentas ETL populares?

Algumas ferramentas populares de ETL incluem o IBM Infosphere Information Server, o Oracle Data Integrator, o Microsoft SQL Server Integration Services (SSIS), o Talend Open Studio, o Pentaho Data Integration (PDI), o Hadoop, o AWS Glue, o AWS Data Pipeline, o Azure Data Factory, o Google Cloud Dataflow, o Stitch, o SAP BusinessObjects Data Services e o Hevo.

O que devo considerar ao escolher uma ferramenta de ETL?

Ao escolher uma ferramenta de ETL, considere fatores como seus requisitos específicos, orçamento, fontes e destinos de dados, escalabilidade, facilidade de uso e suporte e documentação disponíveis.

Há alguma ferramenta de ETL de código aberto disponível?

Sim, há várias ferramentas de ETL de código aberto disponíveis, incluindo Talend Open Studio, Pentaho Data Integration (PDI) e Apache NiFi.

Qual é a diferença entre ETL e ELT?

ETL significa Extract, Transform, Load (extrair, transformar, carregar), enquanto ELT significa Extract, Load, Transform (extrair, carregar, transformar). No ETL, os dados são transformados antes de serem carregados no sistema de destino, enquanto no ELT, os dados são carregados primeiro no sistema de destino e depois transformados.

Posso usar ferramentas de ETL para integração de dados em tempo real?

Sim, algumas ferramentas de ETL, como o AWS Glue e o Hevo, oferecem suporte à integração de dados em tempo real.

Quais são as práticas recomendadas para o desenvolvimento de ETL?

Algumas práticas recomendadas para o desenvolvimento de ETL incluem projetar para escalabilidade, otimizar a qualidade e o desempenho dos dados, testar e depurar completamente e documentar o processo de ETL e a linhagem de dados.