Programa

Nesta postagem do blog, compartilharei minha experiência ao testar a nova ferramentaAct-One da Runway ML . Mostrarei a você como isso funciona, usando a interface da Web e a API Python. Também discutirei os resultados que obtive, que não foram tão impressionantes quanto eu esperava.

Se você estiver curioso sobre o Act-One e quiser vê-lo em ação, continue lendo!

Você quer começar a usar a IA generativa?

Saiba como trabalhar com LLMs em Python diretamente em seu navegador

O que é o Runway Act-One?

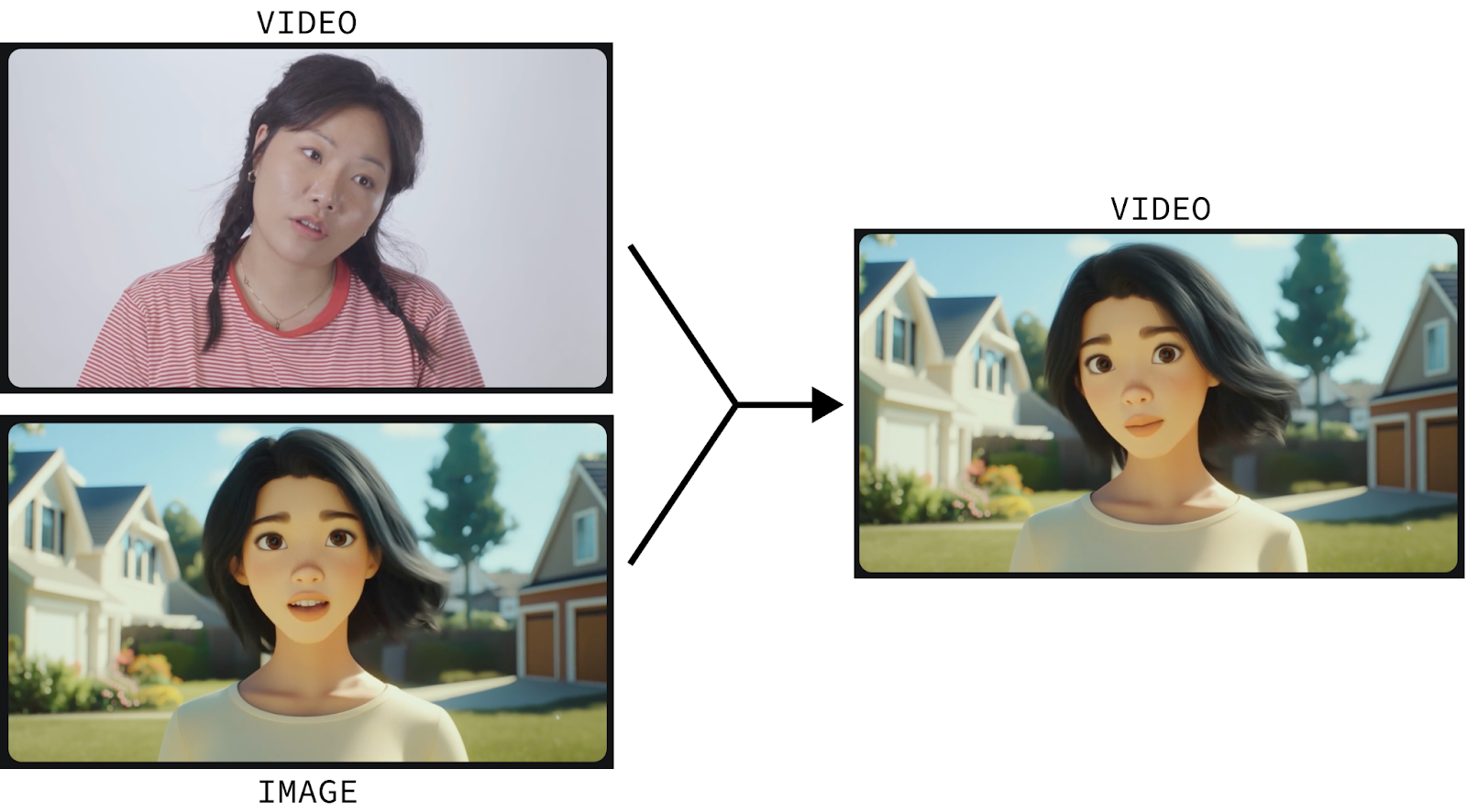

O Runway Act-One é uma ferramenta que anima imagens estáticas de personagens usando a entrada de vídeo. Vamos ver isso em ação:

Este vídeo foi criado usando:

- Um vídeo de um ator humano; e

- Uma imagem estática do personagem da animação.

Em seguida, a Runway Act-One anima o personagem para refletir os movimentos e as expressões faciais do ator humano.

A animação de personagens é um processo sofisticado que somente profissionais altamente treinados podem fazer do zero. A Act-One tenta mudar o jogo ao permitir que qualquer pessoa anime um personagem simplesmente gravando a si mesma e fornecendo uma imagem estática do personagem que deseja animar.

E isso não se limita a personagens animados. Ele também funciona com personagens cinematográficos e realistas. E nósTambém podemos criar um diálogo atraente criando vários vídeos curtos dos personagens falando de um lado para o outro e juntando-os:

Eu me filmei para testar o Runway Act-One

Vamos explorar o Runway Act-One por conta própria. Embora haja um nível gratuito disponível, que oferece 125 créditos e opções de fila, o Act-One não está incluído nesse nível e requer uma assinatura.

Primeiro, vá para a página de login do página de login da Runway e faça login ou crie uma conta. Em seguida, assine um de seus planos disponíveis. É importante observar que, mesmo com uma assinatura, há um limite para a quantidade de vídeos que podemos gerar. Experimentei a assinatura mensal de US$ 15, que me deu 625 créditos (mais os 125 créditos gratuitos, totalizando 750 créditos).

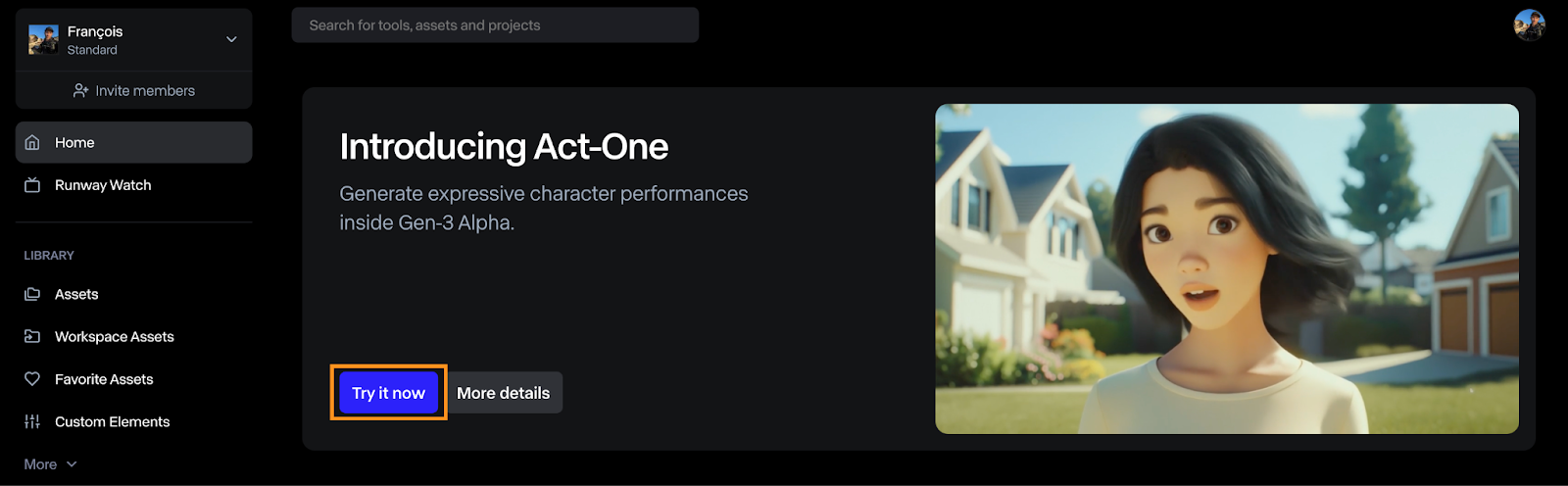

Como abrir o Runway Act-One

Para gerar um vídeo com a Act-One, clique no botão "Experimente agora" no painel de controle.

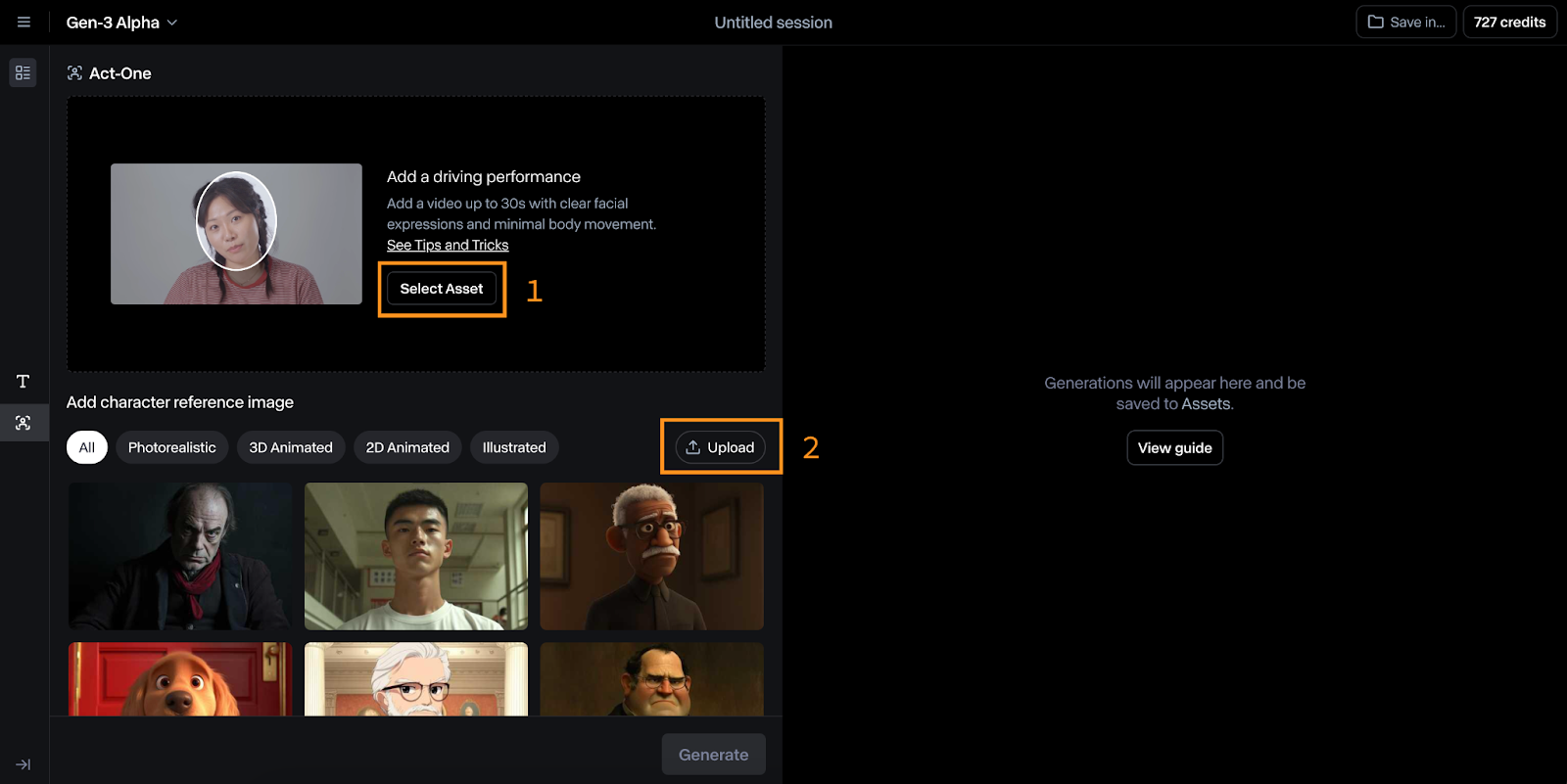

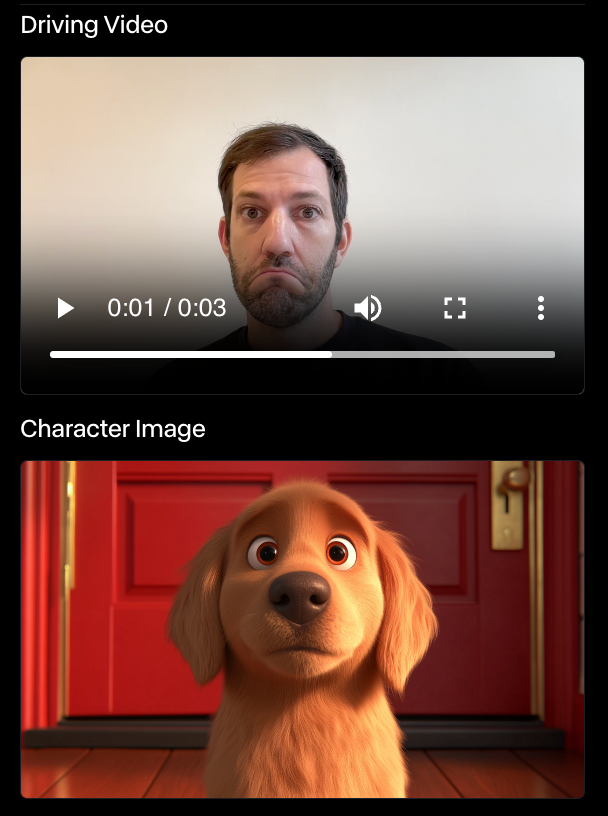

A interface do Act-One é relativamente simples de usar. Na imagem abaixo, você pode ver isso:

- Na parte superior, selecionamos o vídeo de condução, que é o vídeo usado para conduzir a animação.

- Na parte inferior, selecionamos a imagem de referência do personagem que desejamos animar.

Testando o Runway Act-One com minha própria animação

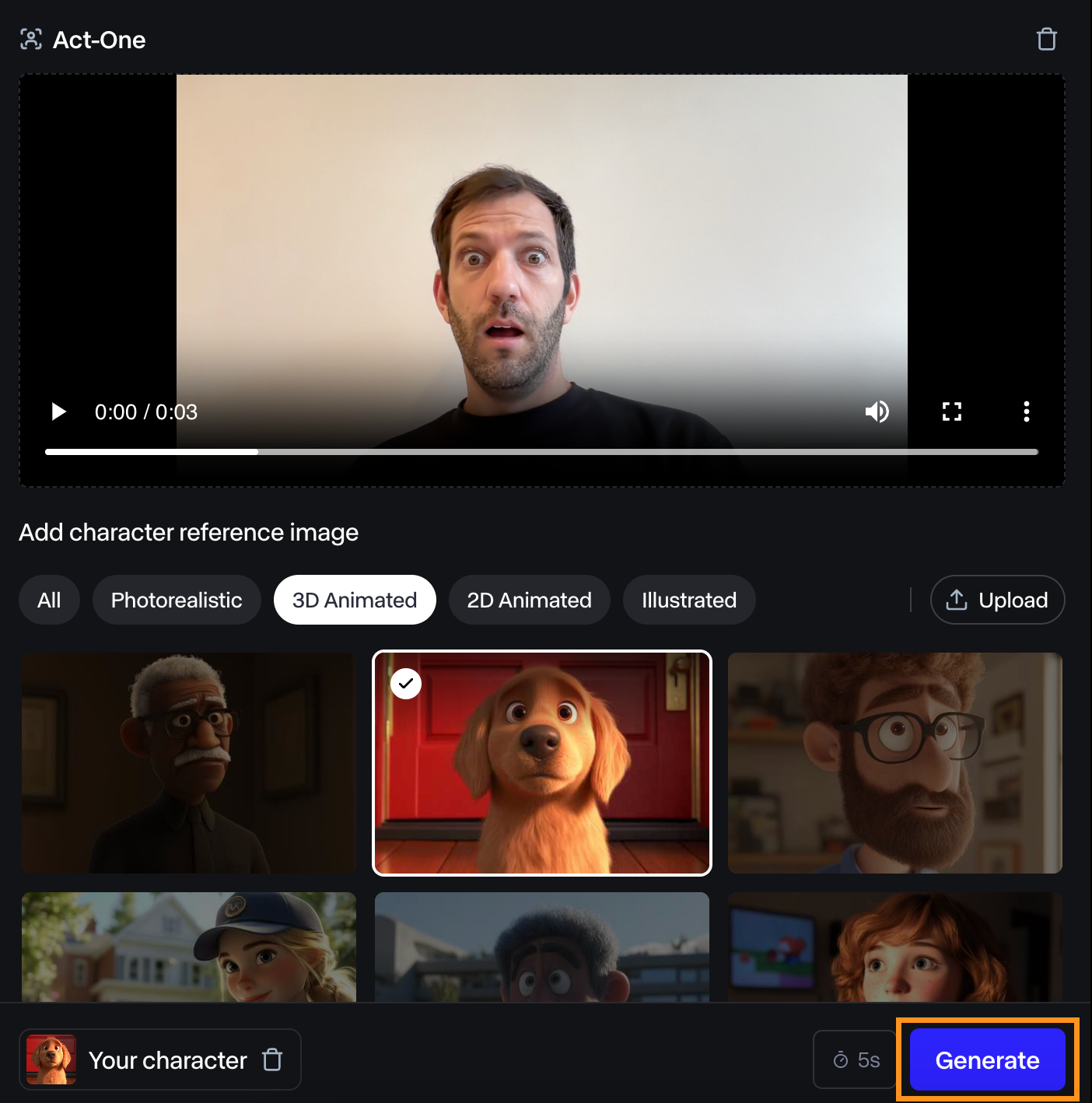

Para experimentar, filmei a mim mesmo fazendo uma cara de surpresa e experimentei usando a referência do personagem do cachorro.

Achei o vídeo resultante apenas razoável. A expressão facial não é muito pronunciada, mas ainda assim combina com a minha.

Fiz outros experimentos com o mesmo personagem, e o Runway Act-One nunca me impressionou. Em alguns casos, não havia sequer uma expressão. No exemplo abaixo, o cão não se moveu, apesar da minha expressão facial.

Não sou ator, então talvez esse seja o problema. Entretanto, se o objetivo do Act-One é capacitar qualquer pessoa a animar personagens, ele ainda tem um longo caminho a percorrer antes de ser realmente utilizável por qualquer pessoa sem experiência no setor.

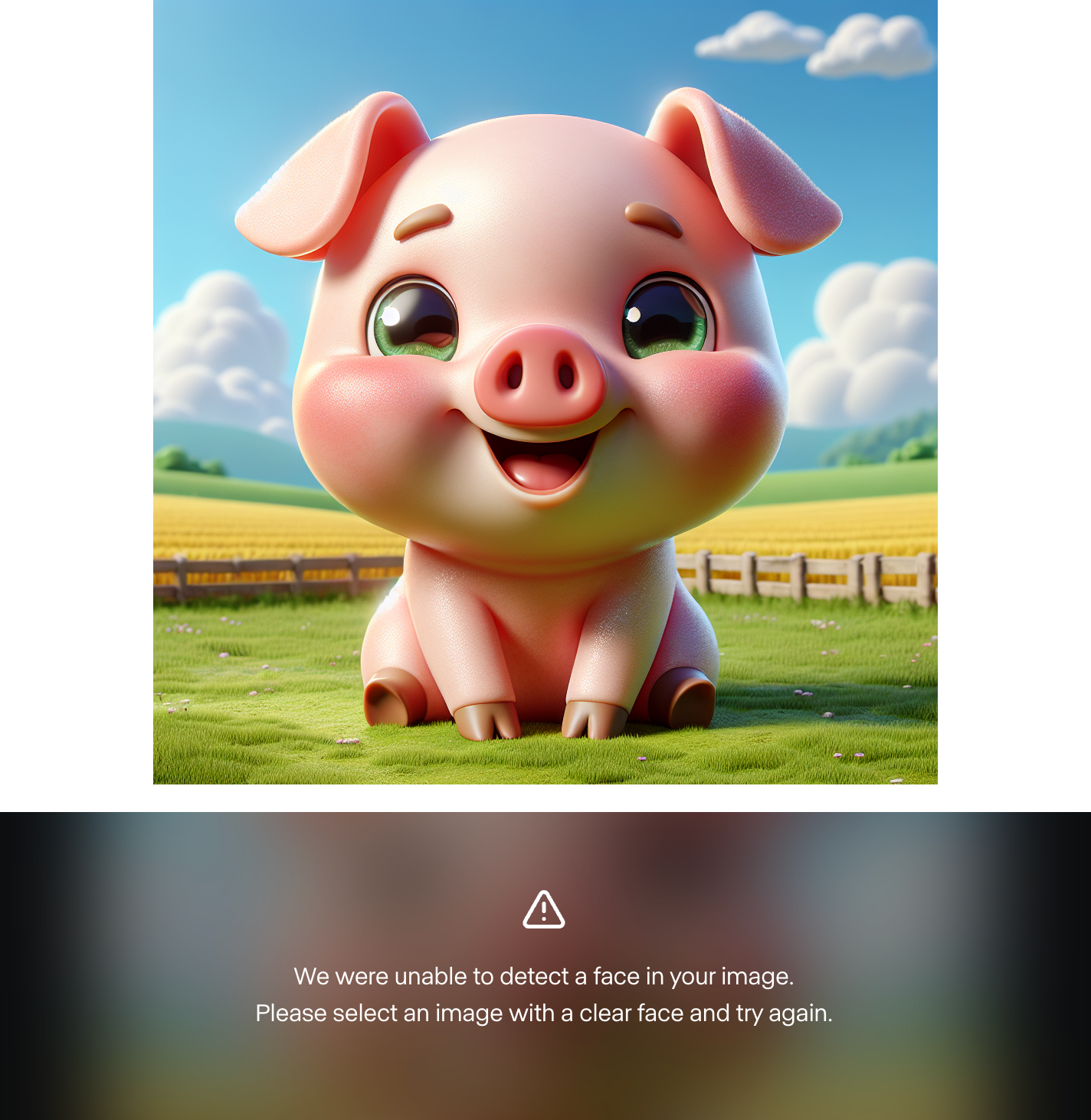

Também achei impossível usar uma imagem de personagem personalizada. Gerei cerca de 10 personagens diferentes usando o Dall-E 3, e o Runway falhou todas as vezes em encontrar um rosto. Aqui está um exemplo:

Isso me indica que os exemplos apresentados são escolhidos a dedo e que o modelo não está pronto para o público em geral. No entanto, tentei fazer isso com personagens humanos e funcionou. Portanto, pode ser que o modelo ainda não ofereça suporte a personagens animados personalizados.

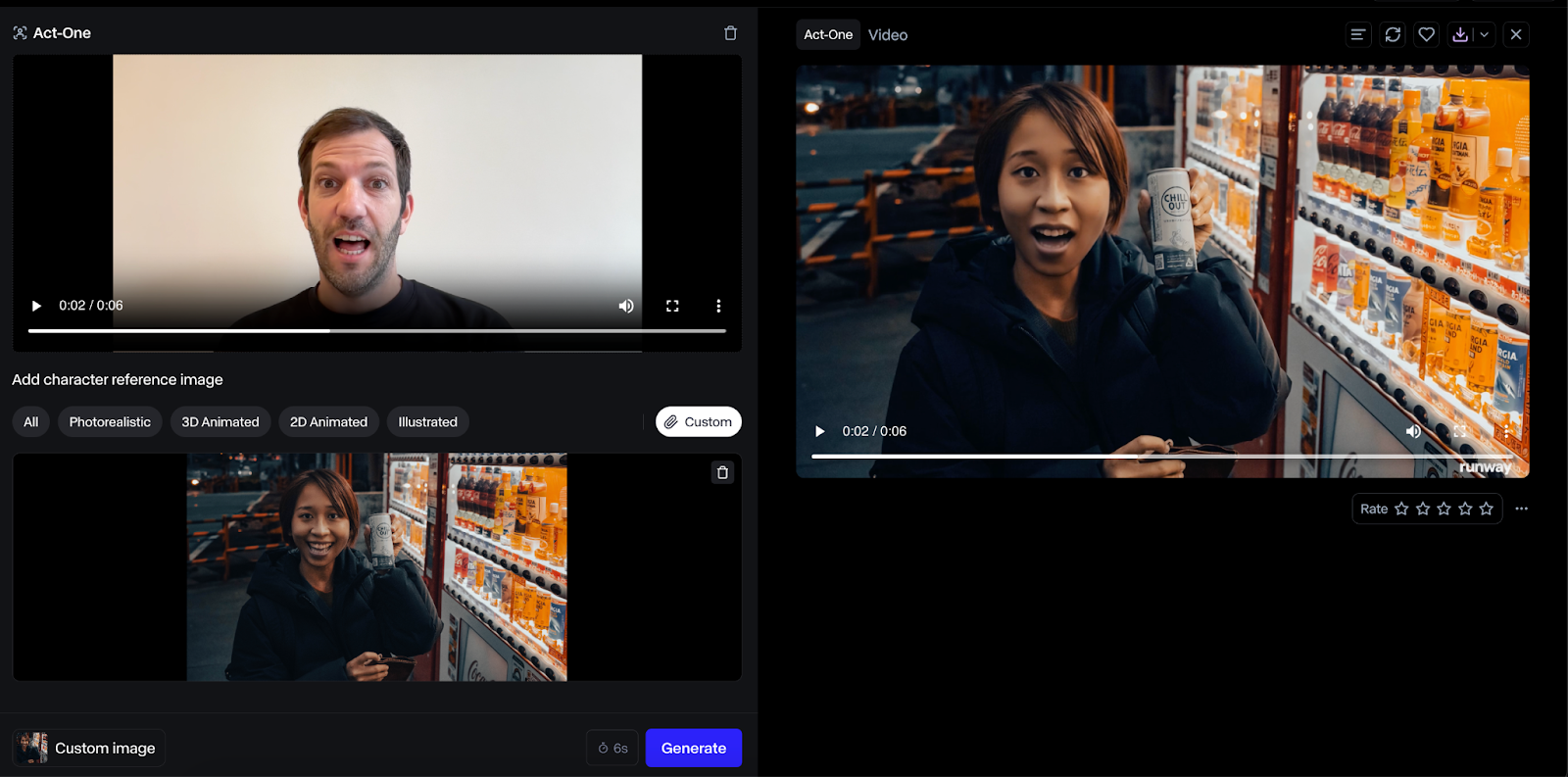

Aqui está um exemplo com um personagem humano:

O resultado com o uso de um rosto humano foi muito melhor, e achei que o resultado foi de maior fidelidade. No entanto, esse caso de uso parece menos impactante, pois, em vez disso, poderíamos simplesmente fazer com que o ser humano agisse diretamente.

Uma observação sobre preços

A duração do vídeo de saída corresponderá à do vídeo de entrada, e os créditos serão cobrados de acordo com a duração do vídeo.

Combinando o Act-One com a Runway Gen-3 Alpha

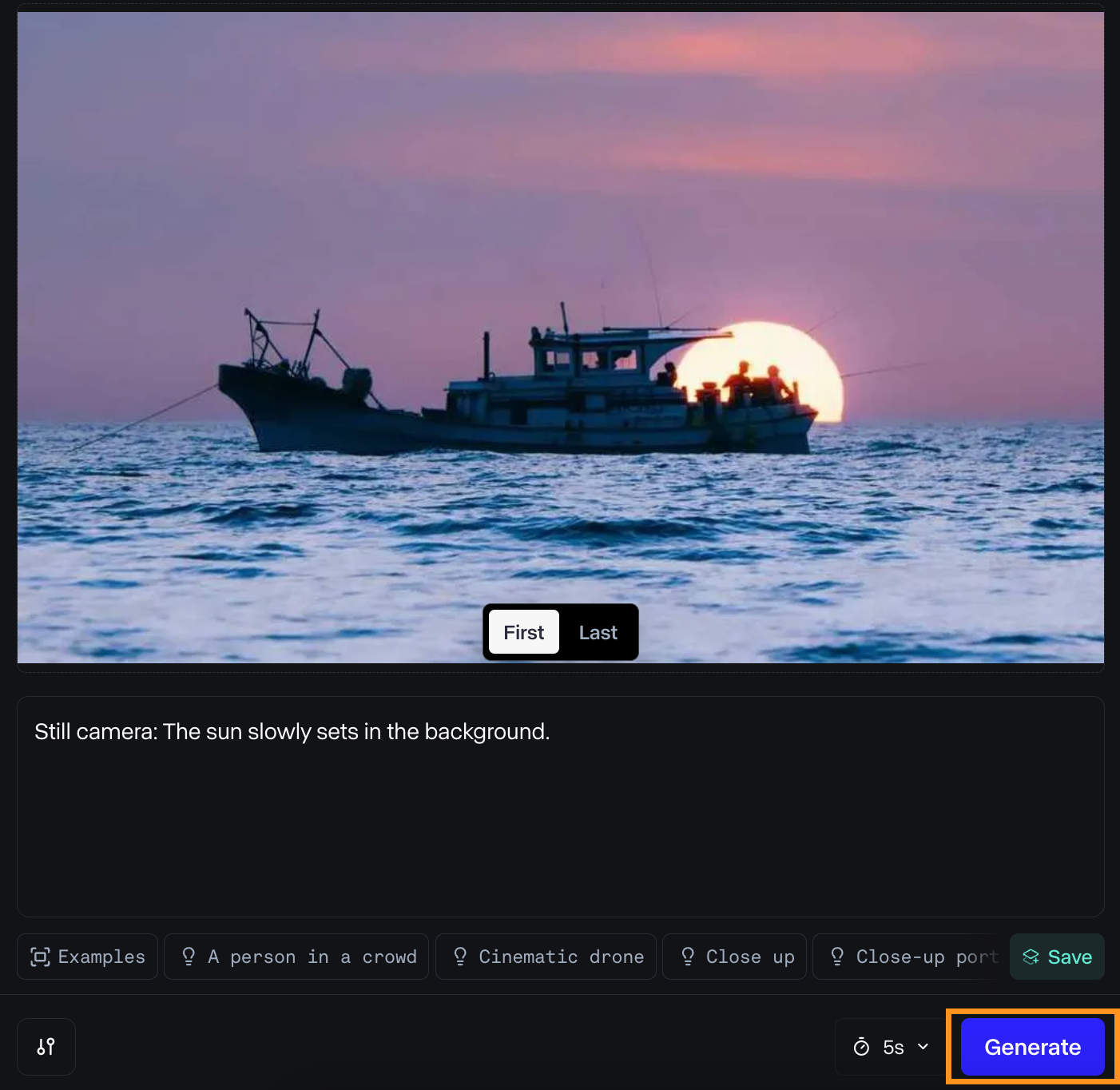

No início deste ano, em junho, a Runway ML apresentou seu modelo Gen-3 Alpha, que cria vídeos com base em uma imagem estática e um prompt de texto.

Como a Act-One se concentra em close-ups do rosto, esses dois modelos se complementam. O Act-One pode ser usado para criar diálogos, enquanto o Gen-3 Alpha pode gerar as cenas entre os diálogos.

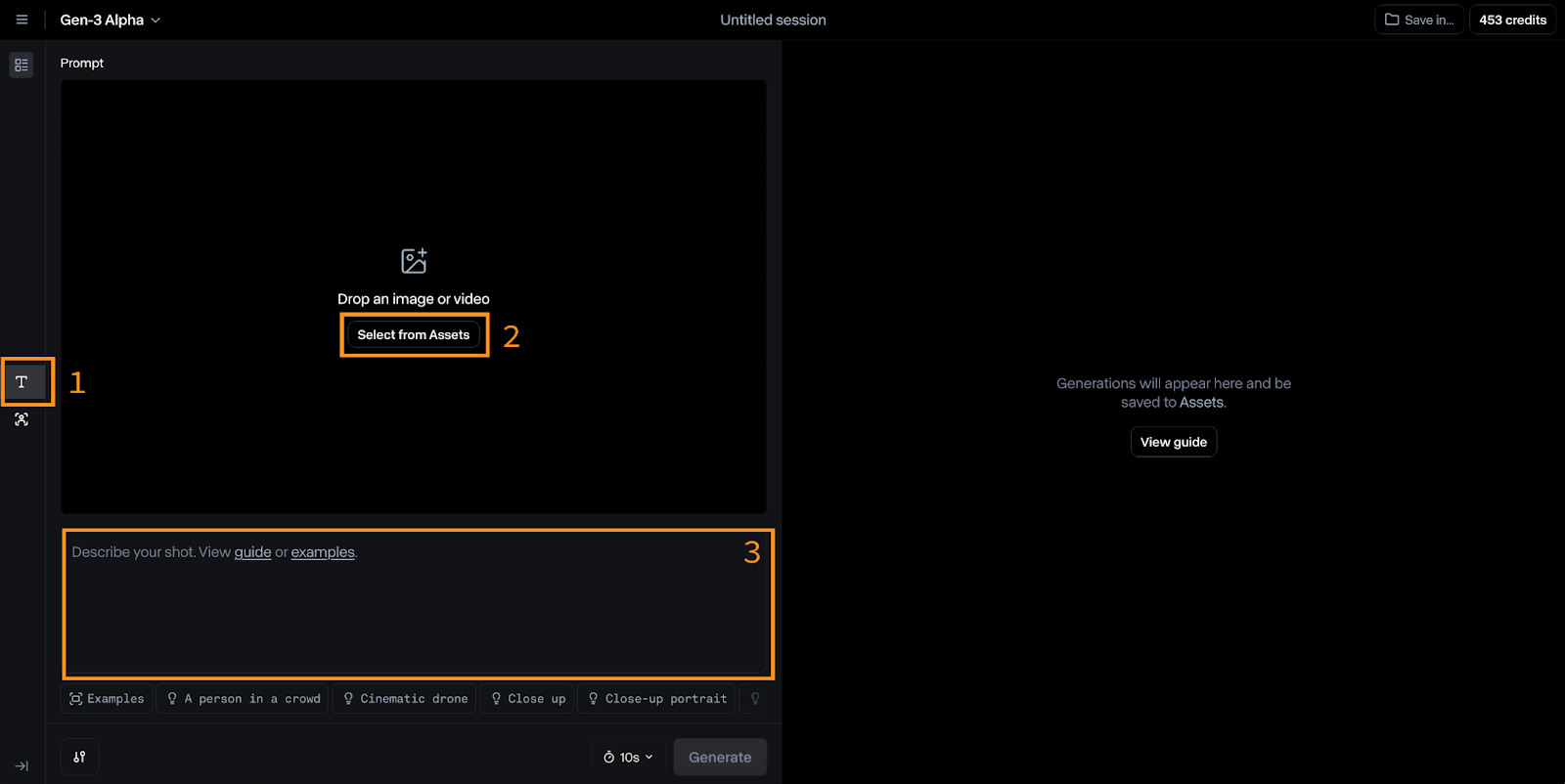

Gerar um vídeo com o Gen-3 Alpha

Para mudar para o Alfa Gen-3, clique no ícone "T" à esquerda (nº 1 na imagem abaixo).

As entradas para esse modelo são uma imagem (nº 2) e um prompt de texto (nº 3). A Runway sugere que o prompt de texto siga este formato:

[camera movement]: [establishing scene]. [additional details].Por exemplo:

Low-angle static shot: The camera is angled up at a woman wearing all orange as she stands in a tropical rainforest with colorful flora. The dramatic sky is overcast and gray.Tentei animar uma foto que tirei recentemente. Aqui estão as entradas que usei:

E aqui está o resultado:

Gostei do resultado. A luz parece agradável à medida que o barco se afasta do sol, e o movimento da água é suave.

No entanto, o resultado é bem diferente do que eu imaginava originalmente. Esse é, sem dúvida, um dos principais problemas para os criadores de vídeos: a incapacidade de controlar todos os detalhes de uma cena, o que é possível com os métodos tradicionais de criação de filmes. Se essa limitação persistir, os futuros diretores que usarem IA poderão se ver limitados a cenas geradas por IA, em vez de poderem realizar sua visão original.

Combine com close-ups da Act-One

Nesse caso, podemos combinar de forma criativa três clipes de vídeo distintos.

Em primeiro lugar, temos um vídeo de um barco se movendo na água. Esse clipe estabelece o cenário e fornece o contexto para as ações subsequentes.

Em seguida, poderíamos ter um close-up de um personagem parado na praia, com o olhar fixo no barco e expressando um sentimento de saudade.

Por fim, temos um vídeo do barco se afastando da costa, visto do ponto de vista do personagem. Esse terceiro clipe oferece uma sensação de movimento e progressão.

Usando a API do Runway ML com Python

O Runway ML também oferece uma API para usar seus modelos fora da interface da Web. Embora seja compatível com o Alpha Turbo Gen-3, parece que o Act-One ainda não está disponível. Este guia abordará os princípios básicos do uso da API, que permanecerão os mesmos quando a Act-One estiver disponível.

Criando a chave da API

Para começar, precisamos criar uma conta de desenvolvedor e gerar uma chave de API.

Navegue até a a página do desenvolvedor e clique no botão de login. Se não tiver uma conta, você poderá criar uma lá.

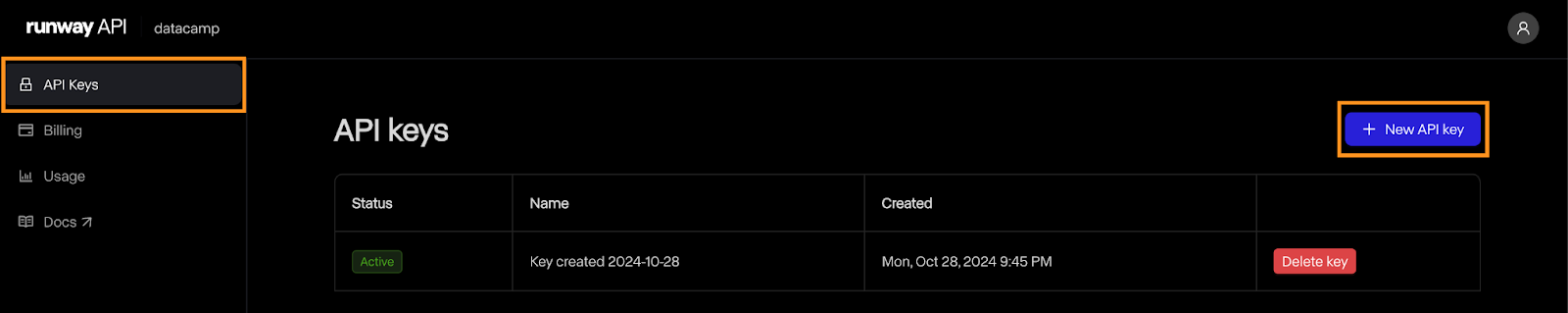

Depois que a conta for criada, navegue até a página "API Keys" (Chaves de API) e clique em "New API key" (Nova chave de API):

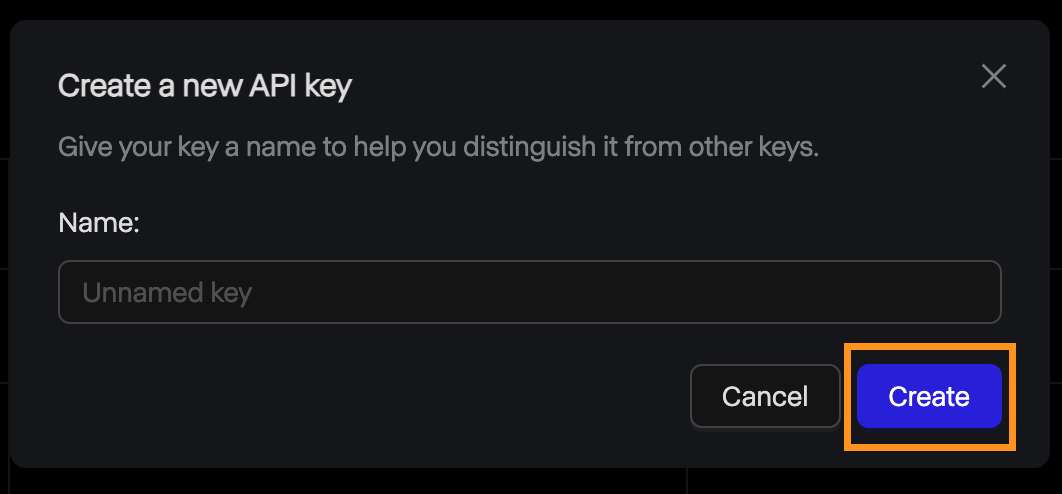

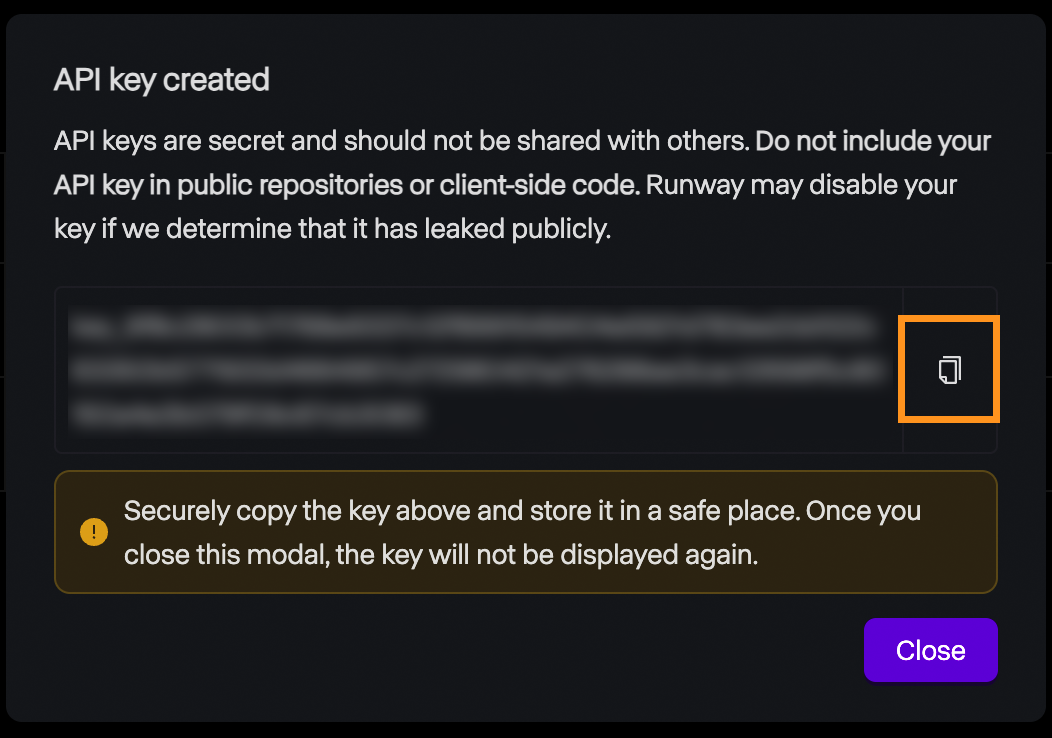

Isso abrirá uma janela pop-up solicitando o nome da chave. Você pode deixá-lo vazio e clicar em "Create".

Depois disso, a chave é exibida e você pode copiá-la. Lembre-se de que, por motivos de segurança, esta é a única vez que a chave será exibida, portanto, certifique-se de copiá-la. Se ele se perder por algum motivo, sempre poderemos excluí-lo e criar um novo.

Preços

A API do Runway ML não oferece um nível gratuito. Para experimentá-lo, precisamos adicionar créditos à nossa conta. O preço é idêntico ao da interface da Web: US$ 0,25 para um vídeo de 5 segundos e US$ 0,50 para um vídeo de 10 segundos.

É importante observar que os créditos da API são diferentes dos créditos de uma conta de assinatura, portanto, esses créditos não podem ser usados para gerar vídeos por meio da interface da Web e vice-versa.

Configuração

O Runway ML fornece uma biblioteca Python chamada runwayml que precisamos instalar para interagir com a API. Para instalá-lo, use o comando:

pip install runwaymlPara acessar a API, a chave da API deve ser definida como uma variável de ambiente chamada RUNWAYML_API_SECRET. Você pode fazer isso usando o seguinte comando:

export RUNWAYML_API_SECRET=api_key

```Replacing api_key with the key created above.

Generating a videoRecently, I took this photo of the night sky:

Source: Instagram @fran.a.photo

I wanted to try out runwayml to see if it could generate a time-lapse video from the photo. To generate a video from an image using the API, we:

Import and initialize RunwayML client. Note that we don’t need to provide the API key as it is automatically loaded from the environment variable we set up before.Call the image_to_video.create() method from the client, providing the name of the model, the image URL, and the prompt.Store the task into a variable and print its identifier so that we can retrieve the video later. This is important as it seems that their API doesn’t have any way to list the past tasks. Without it, we’ll pay the generation credits but won’t have a way to get our video.```python

from runwayml import RunwayML

url = "https://i.ibb.co/LC7Kfrq/Z72-5415.jpg"

client = RunwayML()

task = client.image_to_video.create(

model="gen3a_turbo",

prompt_image=url,

prompt_text="Camera slowly zooms out: Astrophotography time-lapse featuring shooting stars.",

)

print(task.id)Para ver o resultado, precisamos aguardar a conclusão da tarefa. Podemos acessar o status da tarefa usando task.status. O status será igual à string ”SUCCEEDED” quando o vídeo for gerado com êxito.

Você pode acessar o URL do vídeo usando task.output. Observe que esse campo é uma lista de saídas. Por padrão, um único vídeo é gerado, portanto, o URL do vídeo será task.output[0].

Aqui está um script simples que imprime o URL do vídeo com o identificador da tarefa:

from runwayml import RunwayML

task_id = "af0a95ed-b0ff-4120-aecd-2473d7a42891"

client = RunwayML()

task = client.tasks.retrieve(id=task_id)

if task.status == "SUCCEEDED":

print(task.output[0])

else:

print(f"Video not ready, status={task.status}")Este é o vídeo que geramos a partir da foto:

Mais uma vez, eu esperava que o resultado fosse diferente. Gosto da maneira como o céu gira, emulando um lapso de tempo noturno. No entanto, as estrelas cadentes são muito irreais. O primeiro plano também se torna menos realista à medida que o vídeo avança. Um detalhe interessante que você achou foram os reflexos na água.

Opções avançadas

Vamos examinar algumas opções que você tem ao gerar vídeos com a API. Para obter mais detalhes, consulte a página de documentação do a página de documentação do Runway.

O Runway ML suporta vídeos com duração de 5 ou 10 segundos. Por padrão, ele gera um vídeo de 10 segundos. Isso pode ser definido usando o parâmetro duration, da seguinte forma:

task = client.image_to_video.create(

model="gen3a_turbo",

prompt_image=url,

prompt_text="Camera slowly zooms out: Astrophotography time-lapse featuring shooting stars.",

duration=5,

)Por padrão, os vídeos são gerados com uma proporção de 16:9. Você também pode configurá-lo para o modo retrato especificando uma proporção de 9:16 usando o parâmetro ratio:

task = client.image_to_video.create(

model="gen3a_turbo",

prompt_image=url,

prompt_text="Camera slowly zooms out: Astrophotography time-lapse featuring shooting stars.",

ratio=”9:16”,

)Com relação ao modelo, parece que, no momento em que este artigo foi escrito, o único modelo disponível na API é gen3a_turbo.

Carregando uma foto local

No exemplo acima, usamos um URL de imagem para especificar a imagem que queremos usar. Também podemos usar um arquivo local em nosso computador, lendo-o como um URI de dados.

Abaixo está uma função Python que usa os pacotes base64 e mimetypes para fazer isso. Esses dois pacotes são incorporados, portanto, não há necessidade de instalá-los.

def image_to_data_uri(image_path):

mime_type, _ = mimetypes.guess_type(image_path)

with open(image_path, "rb") as img_file:

img_data = img_file.read()

b64_encoded = base64.b64encode(img_data).decode("utf-8")

data_uri = f"data:{mime_type};base64,{b64_encoded}"

return data_uriAqui está um exemplo de como criar uma solicitação usando a função image_to_data_uri() para carregar a imagem:

task = client.image_to_video.create(

model="gen3a_turbo",

prompt_image=image_to_data_uri("nightsky.jpg"),

prompt_text="Camera slowly zooms out: Astrophotography time-lapse featuring shooting stars.",

)Conclusão

Nesta publicação do blog, exploramos o Act-One do Runway ML, uma ferramenta projetada para simplificar a animação de personagens. Abordamos sua funcionalidade básica, como usá-la por meio da interface da Web e sua integração com a API do Python. Também nos aprofundamos no modelo Gen-3 Alpha da Runway para gerar vídeos a partir de imagens estáticas.

Como mencionei anteriormente, meus experimentos pessoais com o Act-One não corresponderam totalmente aos exemplos refinados fornecidos pelo Runway ML. Os resultados não tiveram a vibração e a expressividade que eu esperava, o que indica que o modelo ainda pode estar em desenvolvimento ou que precisa de mais contribuições profissionais. Além disso, a impossibilidade de usar personagens animados personalizados era uma desvantagem significativa.

Apesar dessas limitações, o Act-One e o Gen-3 Alpha da Runway ML demonstram o potencial empolgante da IA na criação e animação de vídeos. Se você quiser saber mais sobre a geração de vídeos com IA, recomendo estas publicações do blog: