Kurs

Ein Message Broker ist eine Serversoftware, die die Kommunikation zwischen verschiedenen Diensten, Anwendungen und Komponenten ermöglicht, insbesondere in verteilten Systemen. Sie spielt eine wichtige Rolle bei der Unterstützung asynchroner Nachrichtenübermittlung und ermöglicht es Systemen, sich zu entkoppeln und unabhängig zu skalieren.

Zwei beliebte Optionen in diesem Bereich sind ActiveMQ und Apache Kafka.

In diesem Artikel vergleichen wir ActiveMQ und Kafka im Detail und beleuchten ihre Funktionen, Architekturen, Leistung und Anwendungsfälle. Am Ende wirst du besser verstehen, welche Plattform am besten für deine spezifischen Anforderungen geeignet ist.

Was ist ActiveMQ?

ActiveMQ wurde ursprünglich von LogicBlaze entwickelt, einem Unternehmen, das sich auf Open-Source-Integrations- und Messaging-Lösungen spezialisiert hat. LogicBlaze brachte ActiveMQ 2007 in die Apache Software Foundation (ASF) ein, wo es ein Apache Top-Level-Projekt wurde.

Seitdem hat die Open-Source-Gemeinschaft unter der Leitung der Apache Software Foundation ActiveMQ gepflegt und weiterentwickelt, mit Beiträgen von verschiedenen Entwicklern und Organisationen aus der ganzen Welt.

ActiveMQ ist ein in Java geschriebener Open-Source Message Broker, der die Java Message Service (JMS) API implementiert, eine von Oracle definierte Standard-API für nachrichtenorientierte Middleware (MOM). Der Dienst ist bekannt für seine Benutzerfreundlichkeit, die ausführliche Dokumentation und die Flexibilität bei der Bereitstellung, zu der auch die Unterstützung von Clustering, Failover und mehreren Transportprotokollen gehört.

Merkmale von ActiveMQ

Dies sind die wichtigsten Funktionen und Merkmale von ActiveMQ:

- JMS-Konformität: Unterstützt die JMS-API vollständig und ist damit die erste Wahl für Java-Anwendungen.

- Mehrere Protokolle: Unterstützt verschiedene Messaging-Protokolle, darunter AMQP, STOMP, MQTT und mehr.

- Flexibler Einsatz: Kann im Standalone-Modus, eingebettet in Anwendungen oder als Teil einer Cloud-Infrastruktur eingesetzt werden.

- Erweiterte Sicherheit: Bietet Funktionen wie SSL/TLS-Verschlüsselung, Authentifizierung und Autorisierung.

- Persistenz und Zuverlässigkeit von Nachrichten: Unterstützt persistentes Messaging, um sicherzustellen, dass Nachrichten im Falle eines Broker-Ausfalls nicht verloren gehen.

- Clustering und Failover: Bietet Clustering-Optionen für Lastausgleich und Failover-Funktionen, um die Zuverlässigkeit zu erhöhen.

Anwendungsfälle für ActiveMQ

Dies sind die beliebtesten Anwendungsfälle für ActiveMQ:

- Integration von Altsystemen: Ideal für die Integration mit Altsystemen, die auf JMS basieren oder Punkt-zu-Punkt-Nachrichten benötigen.

- Enterprise Messaging: Wird häufig in Unternehmensumgebungen eingesetzt, in denen erweiterte Sicherheit, JMS-Konformität und flexible Bereitstellung Priorität haben.

- Geringer bis mittlerer Durchsatz: Geeignet für Anwendungen mit geringeren Durchsatzanforderungen, bei denen ein zuverlässiger Nachrichtenaustausch mit niedriger Latenzzeit entscheidend ist.

Werde Dateningenieur

Was ist Apache Kafka?

Apache Kafka wurde ursprünglich von LinkedIn entwickelt, um die Echtzeit-Datenfeeds des Unternehmens zu verarbeiten, und wurde Anfang 2011 als Open Source veröffentlicht.

Im Jahr 2012 wurde Kafka in die Apache Software Foundation (ASF) eingebracht, wo es zu einem Top-Level-Projekt wurde. Seitdem wird es von der Open-Source-Gemeinschaft unter der Leitung der Apache Software Foundation gepflegt und weiterentwickelt, wobei Unternehmen wie LinkedIn, Confluent und andere wichtige Beiträge leisten.

Kafka ist eine verteilte Event-Streaming-Plattform, die für durchsatzstarken, fehlertoleranten und skalierbaren Nachrichtenaustausch entwickelt wurde. Es ist in Scala und Java geschrieben und seine Architektur ist für die Verarbeitung von Echtzeit-Datenströmen optimiert, sodass es sich für den Aufbau von Datenpipelines und ereignisgesteuerten Anwendungen eignet.

Kafka ist bekannt für seine Fähigkeit, große Datenmengen mit geringer Latenz, robuster Datenspeicherung und Wiederholbarkeit zu verarbeiten. Das umfangreiche Ökosystem umfasst Kafka Connect und Kafka Streams für die Integration mit anderen Datensystemen und die Verarbeitung von Datenströmen in Echtzeit.

Eigenschaften von Kafka

Hier sind die wichtigsten Funktionen von Kafka:

- Hoher Durchsatz und geringe Latenzzeit: Optimiert für hohen Durchsatz und niedrige Latenzzeiten, wodurch es für Echtzeitanwendungen geeignet ist.

- Skalierbar und verteilt: Er kann horizontal skaliert werden, indem weitere Broker zum Cluster hinzugefügt werden, sodass er große Datenmengen verarbeiten kann.

- Fehlertoleranz und Haltbarkeit: Gewährleistet die Beständigkeit der Daten durch Replikation über mehrere Knotenpunkte und bietet integrierte Fehlertoleranz.

- Event-Streaming: Unterstützt Event-Streaming und Echtzeit-Datenverarbeitung, was für die Log-Aggregation, Stream-Verarbeitung und Datenintegration hilfreich ist.

- Wiederholbarkeit: Die Daten werden für einen konfigurierbaren Zeitraum gespeichert, damit die Verbraucher die Ereignisse bei Bedarf erneut abspielen und verarbeiten können.

- Ecosystem: Bietet ein robustes Ökosystem, darunter Kafka Connect, Kafka Streams und die Integration mit zahlreichen Big Data- und Analysetools.

Anwendungsfälle für Kafka

Dies sind die wichtigsten und beliebtesten Anwendungsfälle für Apache Kafka:

- Streaming mit hohem Durchsatz: Ideal für Anwendungen, bei denen große Datenmengen in Echtzeit verarbeitet werden müssen, z. B. bei der Log-Aggregation und beim Event-Sourcing.

- Skalierbare Microservices-Architekturen: Geeignet für Microservices, die skalierbares, fehlertolerantes und verteiltes Messaging benötigen.

- Datenpipeline und Analytik: Wird häufig für den Aufbau von Echtzeit-Datenpipelines und Analyseplattformen verwendet, bei denen die Haltbarkeit und Wiederverwendbarkeit der Daten entscheidend ist.

Wenn du darüber nachdenkst, Kafka für deine Echtzeitdaten zu nutzen oder einfach nur neugierig auf diese Technologie bist, besuche den Kurs Einführung in Apache Kafka, um dich auf den neuesten Stand zu bringen!

ActiveMQ vs Kafka: Hauptunterschiede

Die Wahl der richtigen Messaging-Plattform für deine Anwendung ist wichtig, um einen effizienten Datenfluss, Skalierbarkeit und Systemzuverlässigkeit zu gewährleisten.

Wie wir bereits gesehen haben, dienen sowohl ActiveMQ als auch Apache Kafka als Nachrichten-Broker, aber sie erfüllen unterschiedliche Bedürfnisse und Anwendungsfälle. Jede bietet eine einzigartige Architektur, Leistungsmerkmale und Betriebsfunktionen.

Schauen wir uns die Hauptunterschiede dieser Nachrichtenmakler in verschiedenen Kategorien an:

Architektur

ActiveMQ verwendet eine broker-zentrierte Architektur und speichert Nachrichten in einem zentralen Broker, der Warteschlangen und Themen verwaltet. Dieses System beruht auf Nachrichtenbestätigungen und persistenter Speicherung, um eine zuverlässige Zustellung und Haltbarkeit der Nachrichten zu gewährleisten.

Im Gegensatz dazu verwendet Kafka eine verteilte Log-Architektur, bei der die Daten auf mehrere Broker in einem Cluster aufgeteilt und repliziert werden. Das Design von Kafka entkoppelt Produzenten und Konsumenten, was eine hohe Skalierbarkeit und Leistung ermöglicht und es ideal für die Verarbeitung großer Datenmengen in verteilten Systemen macht.

Messaging-Modell

ActiveMQ unterstützt sowohl Punkt-zu-Punkt (Warteschlangen) und Publish-Subscribe (Topics) Modelleund bietet damit Flexibilität für eine Reihe von Messaging-Szenarien mit einem starken Fokus auf garantierte Nachrichtenübermittlung.

Kafka hingegen arbeitet in erster Linie mit einem Publish-Subscribe-Modell, das auf verteilten Logs basiert. Dieser Ansatz ermöglicht es mehreren Verbrauchern, unabhängig voneinander und in ihrem eigenen Tempo Daten aus derselben Partition zu lesen, was für Anwendungen, die einen hohen Durchsatz und eine gleichzeitige Verarbeitung erfordern, von Vorteil ist.

Leistung und Durchsatz

Wenn es um Leistung und Durchsatz geht, eignet sich ActiveMQ für Anwendungsfälle, die einen moderaten Durchsatz und eine geringe Latenzerfordern , aber seine Leistung kann durch die Notwendigkeit von persistentem Messaging und komplexem Routing durch einen zentralen Broker beeinträchtigt werden. Das kann seine Fähigkeit einschränken, extrem hohe Datenmengen effizient zu verarbeiten.

Kafka dagegen ist für hohen Durchsatz und niedrige Latenzzeitenkonzipiert und kann Millionen von Nachrichten pro Sekunde verarbeiten. Seine Architektur ist für das Streaming von Echtzeitdaten optimiert, was ihn zu einer bevorzugten Wahl für Anwendungen macht, die eine kontinuierliche Hochgeschwindigkeitsdatenverarbeitung erfordern, wie z. B. die Log-Aggregation und Echtzeitanalysen.

Skalierbarkeit

ActiveMQ kann skaliert werden durch Clustering und ein Netzwerk von BrokernDieser Prozess kann jedoch komplex sein und erfordert oft eine sorgfältige Konfiguration und Verwaltung.

Kafka wurde jedoch mit Blick auf die Skalierbarkeit entwickelt und ermöglicht eine einfache horizontale Skalierung durch Hinzufügen weiterer Broker zum Cluster. Die Partitionierungs- und Replikationsstrategien von Kafka ermöglichen ein effizientes Datenmanagement über eine große Anzahl von Knotenpunkten hinweg, so dass eine höhere Last mit minimalem Konfigurationsaufwand bewältigt werden kann.

Fehlertoleranz und Haltbarkeit

ActiveMQ verwendet persistente Speicheroptionen und Broker-Clustering mit Failover-Mechanismen um die Dauerhaftigkeit von Nachrichten zu gewährleisten und sicherzustellen, dass sich das System von Ausfällen ohne Datenverlust erholen kann.

Auf der anderen Seite bietet Kafka eine robuste Fehlertoleranz durch die Datenreplikation über mehrere Broker im Cluster, die eine hohe Beständigkeit auch bei Brokerausfällen gewährleistet. Die Fähigkeit von Kafka, Nachrichten aus dem Protokollspeicher wiederzugeben, sorgt für zusätzliche Zuverlässigkeit und ermöglicht es den Nutzern, Daten bei Bedarf erneut zu verarbeiten.

Ökosystem und Integration

ActiveMQ eignet sich gut für Unternehmensanwendungen, insbesondere für solche, die JMS-Konformität erfordern. Sie unterstützt eine Vielzahl von Messaging-Protokollen, darunter AMQP, STOMP und MQTT, und ist damit eine vielseitige Wahl für die Verbindung verschiedener Systeme und Anwendungen.

Kafka hingegen verfügt über ein schnell wachsendes Ökosystem, das Tools wie Kafka Connect für die Integration mit verschiedenen Datenquellen und -senken und Kafka Streams für die Echtzeit-Datenverarbeitung umfasst. Seine Integrationsmöglichkeiten erstrecken sich auf Big-Data-Plattformen, Cloud-Dienste und andere moderne Technologien und machen es zu einer leistungsstarken Option für den Aufbau skalierbarer Echtzeit-Datenpipelines und ereignisgesteuerter Architekturen.

ActiveMQ vs Kafka: Eine Zusammenfassung

Die folgende Tabelle fasst die Unterschiede zwischen ActiveMQ und Kafka in den zuvor besprochenen Kategorien zusammen:

|

Feature |

ActiveMQ |

Apache Kafka |

|

Architektur |

Broker-zentriert |

Verteiltes Protokoll |

|

Messaging-Modell |

Punkt-zu-Punkt, Publish-Subscribe |

Publish-subscribe, verteilte Logs |

|

Leistung |

Moderater Durchsatz, niedrige Latenz |

Hoher Durchsatz, niedrige Latenz |

|

Skalierbarkeit |

Komplexes Clustering durch ein Netzwerk von Brokern |

Horizontale Skalierung (einfach zu erweitern) |

|

Fehlertoleranz |

Clustering, persistente Speicherung |

Replikation, dauerhafte Protokollspeicherung |

|

Langlebigkeit |

Persistenz der Nachricht |

Datenreplikation, Wiederverwendbarkeit |

|

Ökosystem |

JMS-Unterstützung, mehrere Protokolle |

Kafka Connect, Streams, Big Data Integration |

Lass uns nun die idealen Anwendungsfälle für jeden dieser Makler untersuchen.

Wann sollte ActiveMQ verwendet werden?

ActiveMQ ist eine robuste Option für eine Vielzahl von Messaging-Szenarien, vor allem wenn es um Altsysteme, unternehmensweite Messaging-Anforderungen oder spezifische Compliance-Anforderungen geht.

Hier ist ein detaillierterer Blick auf seine Eignung für verschiedene Anwendungsfälle:

Integration von Altsystemen

ActiveMQ eignet sich besonders gut für die Integration mit Legacy-Systemen, die auf der Java Message Service (JMS) API basieren. Sie implementiert die JMS-Spezifikation und ist damit die ideale Wahl für Anwendungen, die mit älteren Systemen kommunizieren müssen, die auf Basis von JMS-Standards entwickelt wurden.

Darüber hinaus unterstützt ActiveMQ Point-to-Point Messaging (Queues) und Publish-Subscribe Messaging (Topics), was für die Kompatibilität mit bestehenden Infrastrukturen, die auf diesen Messaging-Paradigmen beruhen, entscheidend sein kann.

Unternehmensnachricht

ActiveMQ bietet erhebliche Vorteile in Unternehmensumgebungen, in denen fortschrittliche Sicherheitsfunktionen, Compliance und flexible Einsatzmöglichkeiten wichtig sind.

Es bietet robuste Sicherheitsmechanismen, die für die Wahrung der Vertraulichkeit und Integrität von Nachrichten unerlässlich sind. Die Einhaltung der JMS-Standards stellt sicher, dass es sich nahtlos in andere Unternehmenssysteme integrieren lässt, die die gleichen Standards einhalten.

Darüber hinaus unterstützt ActiveMQ verschiedene Bereitstellungsoptionen wie eigenständige Broker, Clusterkonfigurationen und vernetzte Broker, so dass Unternehmen das Bereitstellungsmodell wählen können, das am besten zu ihrer Infrastruktur und ihren betrieblichen Anforderungen passt.

Geringere Durchsatzanforderungen

ActiveMQ ist ein guter Kandidat für Anwendungen, die keinen extrem hohen Durchsatz benötigen, aber auf zuverlässiges Messaging mit niedriger Latenz angewiesen sind. Sein Design eignet sich für Szenarien, in denen ein moderates Nachrichtenaufkommen zu erwarten ist, und sein Fokus auf Garantien für die Nachrichtenübermittlung stellt sicher, dass die Nachrichten auch in komplexen Umgebungen zuverlässig übertragen werden.

Die Persistenz- und Acknowledgment-Mechanismen von ActiveMQ bieten die Zuverlässigkeit, die für Anwendungen benötigt wird, bei denen die Integrität der Nachrichten entscheidend ist, die Menge der Nachrichten aber innerhalb der Durchsatzkapazitäten des Systems verwaltet werden kann.

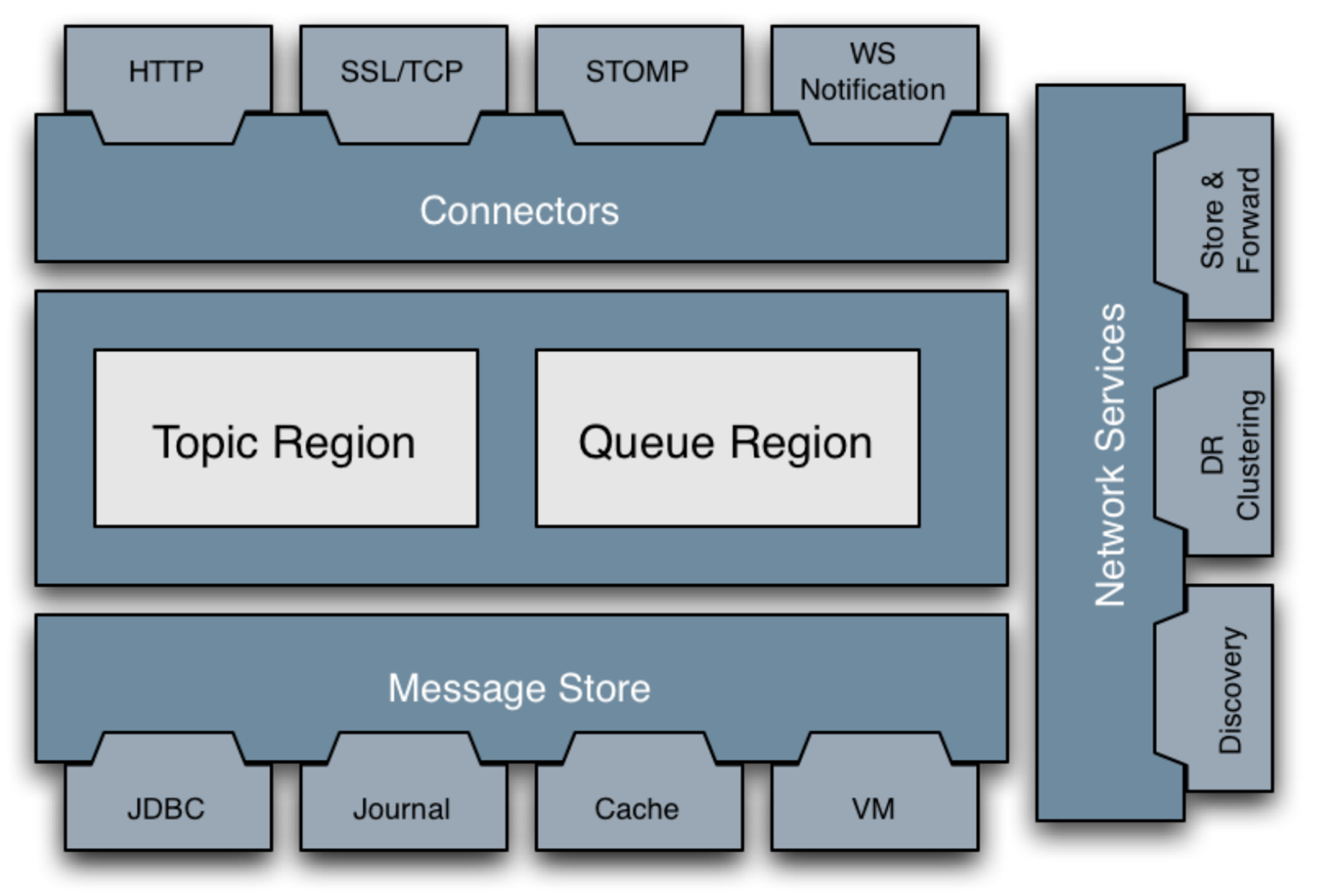

ActiveMQ Classic Hauptkomponenten. Bildquelle: ActiveMQ-Dokumentation.

Wann sollte man Apache Kafka verwenden?

Kafka eignet sich besonders gut für Szenarien, die einen hohen Durchsatz, außergewöhnliche Skalierbarkeit und fortschrittliche Datenverarbeitungsfunktionen erfordern.

Hier ist ein detaillierter Blick darauf, wann du Kafka verwenden solltest:

Streaming mit hohem Durchsatz

Kafka ist die erste Wahl für Anwendungen, die Echtzeit-Datenverarbeitung und hohen Durchsatz erfordern. Sie eignet sich hervorragend für Log-Aggregations- und Event-Sourcing-Szenarien, bei denen riesige Datenmengen in Echtzeit gesammelt, verarbeitet und analysiert werden müssen.

Die Architektur von Kafka ist für die Verarbeitung von Millionen von Nachrichten pro Sekunde bei geringer Latenzzeit optimiert und damit ideal für Streaming-Anwendungen, die einen kontinuierlichen Datenfluss und minimale Verzögerungen erfordern.

Skalierbare Microservice-Architekturen

Kafka ist sehr effektiv bei der Unterstützung skalierbarer Microservice-Architekturen. Es bietet ein verteiltes, fehlertolerantes Messaging-System, das mit der dynamischen und verteilten Natur von Microservices umgehen kann.

Die Fähigkeit von Kafka, Produzenten und Konsumenten zu entkoppeln, ermöglicht es Microservices, effizient zu kommunizieren, selbst wenn die Anzahl der Dienste und das Datenvolumen wachsen. Seine robuste Fehlertoleranz sorgt dafür, dass Nachrichten auch in komplexen, verteilten Umgebungen zuverlässig zugestellt und verarbeitet werden.

Datenpipeline und Analytik

Kafka zeichnet sich beim Aufbau von Echtzeit-Datenpipelines und Analyseplattformen durch seine robuste Datenhaltbarkeit und Wiederverwendbarkeit aus. Die verteilte Log-Architektur ermöglicht eine zuverlässige Datenspeicherung und -abfrage und damit den Aufbau anspruchsvoller Datenpipelines, die große Datenmengen aufnehmen und verarbeiten können.

Die Fähigkeit, Nachrichten aus den Protokollen zu speichern und wiederzugeben, ist entscheidend für Analyseplattformen, die historische Daten verarbeiten und komplexe analytische Abfragen unterstützen.

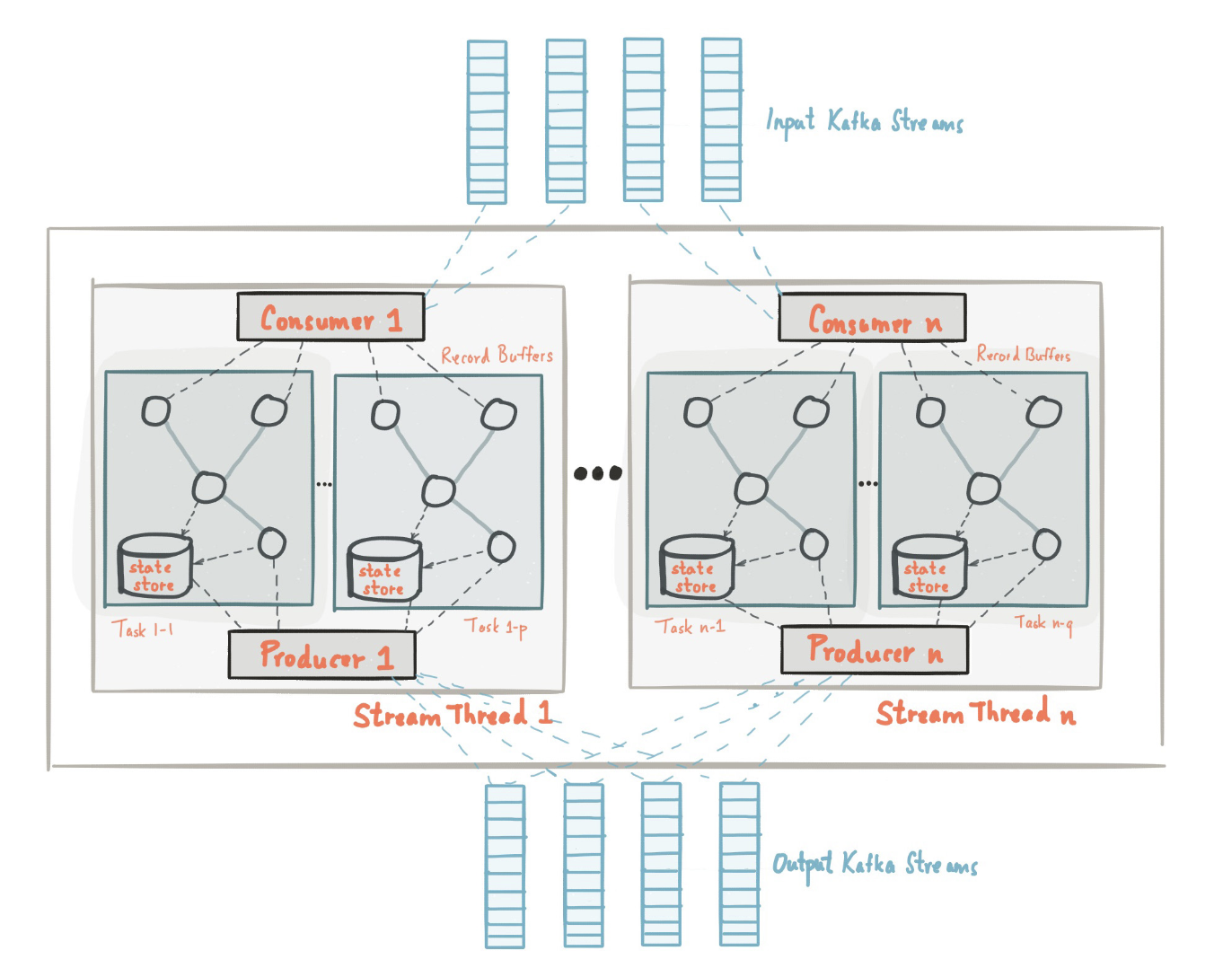

Die Anatomie einer Anwendung, die die Kafka-Streams-Bibliothek nutzt. Bildquelle: Kafka-Dokumentation.

Fazit

Die Entscheidung zwischen ActiveMQ und Kafka hängt von deinen spezifischen Bedürfnissen und Anwendungsfällen ab. ActiveMQ eignet sich gut für traditionelle Messaging-Szenarien, insbesondere in Unternehmen, die JMS-Konformität und einen geringeren Durchsatz benötigen. Im Gegensatz dazu glänzt Kafka in skalierbaren Umgebungen mit hohem Durchsatz und ist daher ideal für die Verarbeitung von Echtzeitdaten und Streaming.

Wenn du mehr über Data Engineering erfahren möchtest, findest du in den folgenden Ressourcen weitere Informationen:

Lass dich für deine Traumrolle als Data Engineer zertifizieren

Unsere Zertifizierungsprogramme helfen dir, dich von anderen abzuheben und potenziellen Arbeitgebern zu beweisen, dass deine Fähigkeiten für den Job geeignet sind.

FAQs

Was sind die wichtigsten Unterschiede zwischen ActiveMQ und Kafka?

ActiveMQ ist bekannt für seine Broker-zentrierte Architektur und die Unterstützung von JMS, während Kafka eine verteilte Log-Architektur verwendet, die für hohen Durchsatz und Datenstreaming in Echtzeit ausgelegt ist.

Welche Messaging-Plattform ist besser für Anwendungen mit hohem Durchsatz geeignet?

Kafka eignet sich aufgrund seiner Architektur, die die Verarbeitung von Millionen von Nachrichten pro Sekunde bei geringer Latenz ermöglicht, hervorragend für Szenarien mit hohem Durchsatz. Sie ist ideal für Echtzeit-Datenverarbeitung und Streaming-Anwendungen.

Wie handhabt ActiveMQ die Haltbarkeit und Fehlertoleranz von Nachrichten?

ActiveMQ gewährleistet die Haltbarkeit von Nachrichten durch persistente Speicherung und bietet Fehlertoleranz durch Broker-Clustering und Failover-Mechanismen. Dieses System hilft dabei, die Integrität der Nachrichten und die Zuverlässigkeit des Systems zu gewährleisten.

Kann Kafka für die Integration von Altsystemen genutzt werden?

Kafka wird in der Regel für moderne, skalierbare Architekturen verwendet und ist möglicherweise nicht die beste Lösung für die Integration mit Altsystemen. ActiveMQ ist mit seiner JMS-Konformität und der Unterstützung für verschiedene Protokolle oft besser für die Integration von Altsystemen geeignet.

Was sind die wichtigsten Faktoren, die bei der Wahl zwischen ActiveMQ und Kafka zu beachten sind?

Zu den Schlüsselfaktoren gehören das erforderliche Messaging-Modell (Punkt-zu-Punkt oder Publish-Subscribe), der benötigte Durchsatz, die Skalierbarkeit und spezielle Anwendungsfälle wie Echtzeit-Datenverarbeitung oder Enterprise Messaging.