Lernpfad

Amazon EC2 (Elastic Compute Cloud) ist ein wichtiger Baustein von AWS. Damit können wir virtuelle Server in der Cloud aufstellen, die sich an unsere Bedürfnisse anpassen lassen. Aber nicht alle EC2-Instanzen sind gleich, und die Wahl des richtigen Typs kann einen großen Unterschied für unsere Leistung und Kosten machen.

In diesem Leitfaden erkläre ich dir die verschiedenen EC2-Instanztypen, ihre Einsatzmöglichkeiten und wie du die für dich am besten geeignete Instanz auswählst.

Was sind EC2-Instanztypen?

Wenn du eine Instanzin AWSstartest, musst dueinen Instanztyp auswählen. Jeder Typ ist ein anderes Paket an Rechenleistung, das CPU, Arbeitsspeicher, Speicher und Netzwerkkapazität umfasst. Diese Typen helfen dabei, den Bedarf deiner Anwendung mit der richtigen Menge an Ressourcen abzustimmen, damit du nicht mehr bezahlst, als du verbrauchst.

Deshalb ist die Wahl des richtigen Instanztyps die Grundlage für den Aufbau einer effizienten, kostengünstigen Infrastruktur. Das ist eine der besten Möglichkeiten, um sicherzustellen, dass deine Cloud-Einrichtung reibungslos funktioniert und mit deiner Arbeitslast mitwächst.

Die Rolle der Instanzfamilien

AWS sortiert seine Instance-Typen in Familien. Jede Familiengruppe hat ähnliche Leistungsprofile, so dass es einfacher ist, die richtige Gruppe für deine Arbeit zu finden.

Zum Beispiel:

- Rechenoptimierte Instanzen eignen sich hervorragend für die Stapelverarbeitung und Hochleistungsberechnungen.

- Speicher-optimierte Instanzen eignen sich besser für Aufgaben, die viel Arbeitsspeicher benötigen, wie z.B. In-Memory-Datenbanken oder Echtzeit-Analysen.

- Allzweck-Instanzen eignen sich perfekt für Situationen, in denen ein ausgewogenes Verhältnis von Rechen-, Speicher- und Netzwerkressourcen benötigt wird.

- Storage-optimierte Instanzen sind für Ein-/Ausgabeoperationen mit niedriger Latenz optimiert.

Diese Struktur hilft uns, uns schnell auf die Optionen zu konzentrieren, die für unseren speziellen Anwendungsfall geeignet sind.

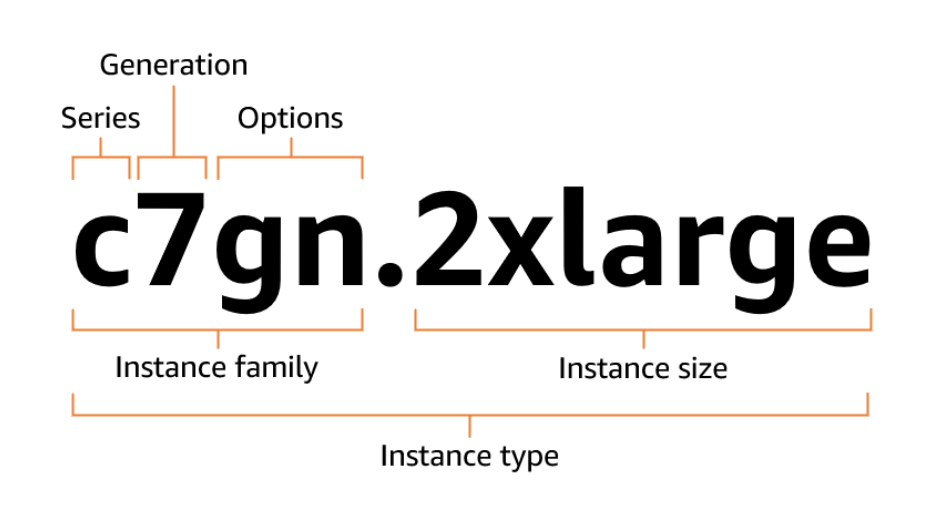

EC2 Instanz-Namenskonvention

Die AWS EC2-Instanztypenfolgen Namenskonventionen, diedir zeigen, was jede Instanz kann oder wofür sie optimiert ist. Mal sehen, wie du diese Namen entschlüsseln kannst, um den richtigen zu wählen.

Format Aufschlüsselung

Die Instanztypen werden nach ihrer Instanzfamilie und Instanzgröße benannt. Der erste Teil des Instanznamens beschreibt die Instanzfamilie und der zweite Teil gibt die Instanzgröße an. Beide werden durch einen Punkt getrennt ..

Nimm einen Instanznamen wie m5.large. Sie besteht aus drei wichtigen Teilen:

- Serie (

m) verrät dir den allgemeinen Zweck der Instanz. In diesem Fall stehtmfür "general-purpose". - Generation (

5) gibt die Version an. Höhere Zahlen bedeuten in der Regel neuere Hardware und bessere Leistung. - Größe (

large) bezieht sich auf die Größe von Ressourcen wie CPU und Speicher.

m5.large bedeutet, dass du eine universell einsetzbare Instanz der fünften Generation mit einer moderaten Menge an Ressourcen bekommst.

Das Bild unten erklärt das Format:

EC2-Instanztyp-Nennungskonvention. Source: AWS-Dokumente

Beispiele und Dekodierung

Schauen wir uns ein paar weitere Beispiele an und entschlüsseln sie:

t4g.microist eine burstable Instanz, die Graviton (ARM-basierte) Prozessoren verwendet und für leichte, gelegentliche Arbeitslasten geeignet ist.r6g.xlargeist eine speicheroptimierte Instanz der 6. Generation, die ebenfalls auf Graviton basiert und ideal für speicherintensive Anwendungen ist, wie z. B. In-Memory-Datenbanken.c7gn.2xlargeist eine rechenoptimierte Instanz der 7. Generation mit verbesserter Netzwerk- und EBS-Unterstützung, angetrieben von Graviton-Prozessoren.

Hier sind einige beliebte Serien und die dazugehörigen Optionen, zusammen mit Notationen.

|

Serie |

Optionen |

|

|

Die vollständige Liste der Serien und Optionen findest du in der AWS-Dokumentation.

Schauen wir uns nun die verschiedenen Instanztypen genauer an.

Allzweck-Instanzen

General-Purpose-Instanzen bieten eine ausgewogene Mischung aus Rechen-, Speicher- und Netzwerkleistung. Sie sind eine gute Wahl, wenn deine Arbeitslast nicht stark in eine Richtung geht, was ideal für Webserver, Entwicklungsumgebungen und Backend-Systeme ist.

AWS bietet zwei Hauptserien in dieser Kategorie an: die T-Serie und die M-Serie. Schauen wir uns diese genauer an:

T-series

Die Instanzen der T-Serie sind für Burstable Performance ausgelegt. Sie bieten eine Grundausstattung an CPU-Leistung, können aber bei Bedarf vorübergehend hochgefahren werden. Die Burst-Fähigkeit basiert auf einem Credit-System, d.h. wenn deine Instanz weniger als ihre Basis-CPU nutzt, erhält sie Credits. Wenn die Nachfrage ansteigt, gibt er diese Guthaben aus, um die Leistung zu steigern.

Wenn du den "unbegrenzten" Modus aktivierst, kann deine Instanz weiterhin über ihr Guthaben hinausgehen, aber du musst für die zusätzliche Nutzung bezahlen.

Diese Instanzen sind ideal für variable oder niedrige bis mittlere CPU-Auslastungen, wie z. B.:

- Webanwendungen mit geringem Datenverkehr

- Entwicklungs- und Testumgebungen

- Kleine Datenbanken

- CI/CD-Pipelines

Angenommen, du betreibst eine kleine Web-App. Die meiste Zeit läuft es reibungslos mit minimaler CPU-Auslastung. Wenn du eine Kampagne startest und der Traffic in die Höhe schießt, werden die gespeicherten Credits verwendet, um die zusätzliche Last zu bewältigen. Nach dem Rausch kehrt er zu seinem Ausgangswert zurück und fängt wieder an, Credits zu sammeln.

Zu den beliebten Typen gehören t4g, t3 und t2, erhältlich in Größen wie t4g.nano.

M-series

Die Instanzen der M-Serie bieten ein ausgewogenes Verhältnis zwischen CPU und Speicher, mit etwa 4 GB RAM pro vCPU. Das macht sie vielseitig einsetzbar für allgemeine Arbeitslasten, die keine speziellen Rechen- oder Speicherkonfigurationen benötigen.

Wir können sie verwenden für:

- Kleine bis mittelgroße Datenbanken (z. B. MySQL, PostgreSQL)

- Anwendungsserver

- Backend-Dienste für Unternehmensanwendungen

- Caching Schichten

- Spiel-Server

Einige Beispiele dafür sind m6i, m8g und mac, die jeweils in verschiedenen Größen erhältlich sind, wie z.B. m8g.medium.

Optimierte Instanzen berechnen

Wenn deine Workloads viel Verarbeitung, aber wenig Speicher benötigen, sind rechenoptimierte Instanzen eine gute Wahl. Sie liefern Hochgeschwindigkeitsleistung für CPU-intensive Aufgaben, ideal für Analysen, Mediencodierung oder Spieleinrichtungen.

AWS bietet diese Leistung mit der C-Serie an. Schauen wir uns diese im Detail an:

C-Reihe

Die Instanzen der C-Serie sind für hohe Rechenleistung bei geringem Speicher-Overhead ausgelegt. Das bedeutet, dass du mehr CPU-Leistung pro Gigabyte Arbeitsspeicher bekommst, was perfekt für Anwendungen ist, bei denen Geschwindigkeit wichtiger ist als Speicher oder Arbeitsspeicher.

Für maximalen Durchsatz und Effizienz verwenden diese Instanzen die neuesten Prozessoren, darunter Intel-, AMD- und AWS Graviton-Chips.

Wir können sie verwenden für:

- Leistungsstarke Webserver

- Videokodierung und Medientranskodierung

- Wissenschaftliche Simulationen und Modellierung

- Stapelverarbeitung und Data Crunching

- Spieleserver, die niedrige Latenzzeiten und schnelle Tickraten benötigen

Einige Beispiele, die dir begegnen könnten, sind c6g, c7i, c5n und c4. Es gibt sie in verschiedenen Größen, so dass du sie je nach deinem Bedarf vergrößern oder verkleinern kannst.

Das ist der Unterschied zwischen rechenoptimierten Instanzen:

- Niedrige Latenz: Sie reagieren schnell und eignen sich daher hervorragend für Echtzeitanwendungen wie Streaming und Spiele.

- Schnelle Verarbeitungsgeschwindigkeiten: Mit hohen Taktraten und optimierten CPU-Kernen können sie Millionen von Anfragen pro Sekunde verarbeiten.

- Kostengünstige Skalierung: Du kannst deine Rechenleistung erhöhen, ohne zu viel Geld für Speicher zu bezahlen, den du nicht brauchst.

Nachhaltigkeit: Viele Instanzen der C-Serie verwenden AWS Graviton-Prozessoren, die energieeffizienter sind und dazu beitragen, deinen ökologischen Fußabdruck zu verringern.

Speicheroptimierte Instanzen

Speicheroptimierte Instanzen sind am besten für Arbeitslasten geeignet, die mehr Speicher als CPU-Leistung oder Speicherplatz benötigen. Diese Instanzen sind für Hochleistungsdatenbanken und In-Memory-Anwendungen geeignet, die große Datenmengen vollständig im Speicher verarbeiten und so ultraschnelle Antwortzeiten ermöglichen.

R-series

Die Instanzen der R-Serie sind für speicherintensive Workloads konzipiert. Sie bieten ein höheres Verhältnis von Arbeitsspeicher zu CPU, was sie besonders geeignet macht, wenn deine Anwendung viel Arbeitsspeicher, aber nicht unbedingt viel Rechenleistung benötigt.

Wir können sie verwenden für:

- In-Memory-Caching: Ideal für Tools wie Redis oder Memcached, die einen blitzschnellen Zugriff auf Daten benötigen.

- Big-Data-Analysen in Echtzeit: Perfekt für die Verarbeitung und Analyse von Daten im Arbeitsspeicher mit geringer Latenz.

- Unternehmensanwendungen: Ideal für große Anwendungen, die eine solide Speicherzuweisung benötigen, um zuverlässig zu laufen.

Zu den beliebtesten Optionen gehören r5, r6a, r8g und r4. Es gibt sie in verschiedenen Größen, je nach deinem Bedarf.

X-series und Z-series

Die Instanzen der X-Serie bieten eine extreme Speicherkapazität und sind speziell für speicherintensive Unternehmens-Workloads konzipiert. Sie sind die erste Wahl für:

- SAP HANA

- In-Memory-Datenbanken

- Echtzeit-Analysen im großen Maßstab

Einige ihrer Standardmodelle sind x1e, x2gd und x8g.

Die Instanzen der Z-Serie sind ein bisschen anders. Sie kombinieren hohen Speicher und hohe CPU-Frequenz, was sie ideal macht für:

- Elektronische Entwurfsautomatisierung (EDA)

- Finanzielle Simulationen

- Große relationale Datenbanken

- Computergestützte Lithografie

Wenn deine Arbeitslast eine starke Single-Thread-Leistung und eine beträchtliche Menge an Arbeitsspeicher erfordert, bietet die Z-Serie (wie z. B. die Z1d) eine ausgewogene Leistung.

Speicheroptimierte Instanzen

Speicheroptimierte Instanzen verwenden lokal angeschlossene Hochgeschwindigkeits-SSDs (NVMe), die sich ideal für Workloads eignen, die eine extrem schnelle und zuverlässige Speicherung erfordern. Deshalb können wir sie für NoSQL-Datenbanken, Data Lakes oder groß angelegte Datenverarbeitungen einsetzen, die hohe IOPS (Input/Output Operations Per Second) erfordern.

Schauen wir uns einige gängige speicheroptimierte Instanzen an:

I-Reihe, D-Reihe, H-Reihe

In der folgenden Tabelle findest du Einzelheiten zu den einzelnen Instanzreihen:

|

I-series |

D-Reihe |

H-Reihe |

|

|

Primäre Verwendung |

Transaktionsworkloads mit hohen IOPS und Datenzugriff mit niedriger Latenz. |

Datenintensive Anwendungen, Big Data-Verarbeitung und Workloads, die eine große Speicherkapazität benötigen. |

High-Performance-Computing (HPC)-Anwendungen mit speichergebundenen Anforderungen. |

|

Ideal für |

NoSQL-Datenbanken (wie Cassandra, MongoDB), Transaktionsdatenbanken, Echtzeit-Analysen und verteilte Dateisysteme. |

Data Lakes, verteiltes Hadoop-Computing, Protokollverarbeitung und groß angelegte Datenanalysen. |

HPC-Simulationen, wissenschaftliches Rechnen, seismische Analysen und maschinelles Lernen mit großen lokalen Datensätzen. |

|

Lagerung |

Lokaler Hochgeschwindigkeits-NVMe-SSD-Speicher (kurzlebig). |

Lokaler Speicher mit hoher Kapazität, in der Regel HDD oder SSD (je nach Instanztyp). |

Lokaler NVMe-SSD-Speicher mit hohem Durchsatz (kurzlebig). |

|

Leistung |

Sehr hohe IOPS und niedrige Latenz. |

Hoher sequentieller Lese-/Schreibdurchsatz und weniger zufällige IOPS als bei der I-Serie, aber ausgezeichnet für das Streaming großer Dateien. |

Bietet einen hervorragenden Durchsatz und hohe IOPS, zugeschnitten auf datenintensive Simulationen und HPC-Workloads. |

|

Beispiele |

I8g, I7ie, I3en |

D3, D3en |

H1 |

Die vollständige Liste der Instanzen der I-Serie, H-Serie und D-Serie findest du in der Dokumentation.

Leistung des lokalen Speichers

Der lokale Speicher nutzt NVMe-SSDs, die eine blitzschnelle Leistung mit sehr hohen IOPS (Input/Output Operations Per Second), Latenzzeiten von unter einer Millisekunde und einen hohen Durchsatz für deine Anwendungen bieten. Sie ist jedoch flüchtig, d.h. die Daten gehen verloren, wenn die Instanz gestoppt oder beendet wird.

Deshalb wird ephemerer Speicher vor allem dafür verwendet:

- Temporärer Kratzspalt

- Puffer/Cache-Speicher

- Temporäre Hochgeschwindigkeitsdatenbanken (wie Redis, Cassandra mit Replikaten)

Im Gegensatz dazu sind EBS-gestützte Volumes (Elastic Block Store) persistenter Speicher, der auch dann verfügbar bleibt, wenn die Instanz angehalten wird. EBS ist netzwerkgebunden und sehr langlebig und bietet Funktionen wie Snapshots für eine einfache Sicherung und Wiederherstellung. Das macht sie ideal für Workloads, bei denen Datenpersistenz wichtig ist, wie z. B. Datenbanken und wichtige Dateien.

Ephemerer Speicher bietet zwar eine unglaubliche Leistung, aber keine Dauerhaftigkeit der Daten. Auf der anderen Seite bietet EBS-gestützter Speicher eine hervorragende Haltbarkeit und Ausfallsicherheit, ideal für Workloads, die sowohl Leistung als auch Datensicherheit benötigen.

Beschleunigte Berechnungsinstanzen

Beschleunigte Recheninstanzen, auch hardwarebeschleunigte Instanzen genannt, kommen zum Einsatz, wenn wir spezielle Hardware wie GPUs (Graphics Processing Units), FPGAs (Field Programmable Gate Arrays) oder kundenspezifische AWS-Chips benötigen, um rechenintensive Aufgaben auszulagern, die auf CPUs allein zu langsam oder ineffizient wären.

Deshalb bieten sie eine bessere Leistung und sind für Arbeitslasten geeignet, die eine starke Parallelverarbeitung oder komplexe Berechnungen erfordern.

GPU-basierte Instanzen (P- und G-Familien)

GPU-basierte Instanzen sind perfekt für Aufgaben, die leistungsstarkes paralleles Rechnen erfordern. Mit NVIDIA-GPUs als Herzstück sind diese Instanzen für anspruchsvolle Workloads wie ML-Modelltraining, 3D-Rendering, High-End-Gaming und andere grafikintensive Aufgaben optimiert.

Zwei wichtige Familien in der Kategorie der GPU-basierten Instanzen sind:

- P-Familie (z. B.

P4,P5): Diese sind mit NVIDIA-GPUs ausgestattet und für maschinelles Lernen (ML) und High-Performance-Computing (HPC)-Anwendungen konzipiert. - G Familie (z. B.

G4,G5): Diese werden ebenfalls von NVIDIA-GPUs angetrieben und sind ideal für Grafik-Workloads, ML-Inferenz und Game-Streaming.

Spezialisierte AI/ML-Instanzen (Infm- und Trn-Familien)

Für KI- und Machine-Learning-Arbeitslasten werden die Familien Inferentia-optimierte Instanz (Inf) und Trainium-optimierte Instanz (Trn) mit maßgeschneidertem AWS-Silizium wie AWS Inferentia- und AWS Trainium-Chips gebaut. Sie können Deep-Learning-Modelle in großem Umfang trainieren und ableiten, um ein erstklassiges Preis-Leistungs-Verhältnis zu erzielen.

- Inf-Familie (z. B.

Inf1,Inf2): Diese Instances sind perfekt für Inferenzaufgaben mit niedriger Latenz und hohem Durchsatz geeignet und werden von AWS Inferentia-Chips unterstützt. - Trn-Familie (z. B.

Trn1,Trn2): Sie sind für die verteilte Schulung von Deep-Learning-Modellen optimiert und bieten Hochgeschwindigkeitsverbindungen und umfangreiche Rechenkapazitäten, die von AWS Trainium-Chips gesteuert werden.

Diese Instanzen sind skalierbar und unterstützen die Frameworks TensorFlow, PyTorch und Apache MXNet, um die Effizienz zu steigern und eine nahtlose Leistung zu bieten.

Wir können sie verwenden für:

- Deep Learning Training im großen Maßstab: Nutze Trn1 für ein kostengünstiges, leistungsstarkes Training großer Modelle.

- KI-Schlussfolgerungen zu niedrigen Kosten: Verwende Inf1 für schnelle, kostengünstige Modellinferenz.

- Groß angelegte KI-Einsätze: Unterstützung von Umgebungen mit Millionen von Schlussfolgerungen pro Sekunde, wie z.B. Empfehlungsmaschinen, Spracherkennung und autonome Fahrzeuge.

Wie wähle ich die richtige EC2-Instanz?

Bei so vielen Instanztypen ist es gar nicht so einfach zu wissen, worauf du achten musst, damit du das Beste aus dem AWS-Angebot herausholen kannst. Lass uns also sehen, wie du und dein Team sichere Entscheidungen treffen können, die Leistung, Kosten und Skalierbarkeit in Einklang bringen.

Wichtige Entscheidungsfaktoren

Überlege dir zunächst, was dein Arbeitspensum wirklich braucht. Bestimme die benötigte CPU-Leistung, den Arbeitsspeicher, den Speicherplatz und die Netzwerkanforderungen, da unterschiedliche Arbeitslasten unterschiedliche Instanztypen erfordern.

Du solltest auch berücksichtigen, wie sich dein Traffic verhält. Ist sie gleichmäßig und vorhersehbar, oder gibt es zu bestimmten Zeiten Spitzenwerte? Das kann uns bei der Entscheidung helfen, ob wir uns für etwas entscheiden, das nach Bedarf skaliert werden kann.

Und meistens arbeiten wir innerhalb eines Kostenrahmens, also wägen wir die Leistung gegen das ab, was wir bereit sind, auszugeben. Wenn wir keinen persistenten Speicher benötigen, können wir mit ephemerem Speicher im Vergleich zu EBS-Volumes einiges sparen.

AWS-Tools für die Auswahl

Zum Glück gibt uns AWS mehrere Tools an die Hand, um die Suche einzugrenzen. Hier sind einige von ihnen:

- Mit dem Instance Explorer kannst du die Instanztypen schnell nach den von dir gewünschten Spezifikationen filtern.

- AWS Compute Optimizer prüft, wie du die Instances derzeit nutzt, und schlägt bessere Optionen vor, wenn es sie gibt.

- Der AWS-Preisrechner schätzt die Kosten im Voraus. Das ist toll, wenn wir die Optionen vor der Bereitstellung vergleichen wollen.

Benchmarking und Tests

Auch mit all diesen Tools lohnt es sich, selbst einige Tests durchzuführen. Das Benchmarking verschiedener Instanzen in unserer Umgebung zeigt uns, wie sie sich unter realen Arbeitsbelastungen verhalten. Das gibt uns ein besseres Gefühl für Leistung, Latenz und Kosten, und zwar auf der Grundlage dessen, was für uns wirklich wichtig ist.

Kosten und Kaufoptionen

Wenn es um EC2 geht, kann die Art und Weise, wie wir Instanzen kaufen, unsere Gesamtkosten beeinflussen. Da AWS mehrere Kaufoptionen anbietet, die jeweils auf unterschiedliche Arbeitslasten zugeschnitten sind, schauen wir uns an, wie wir die richtige für unser aktuelles Projekt auswählen und wie wir unsere Cloud-Rechnungen effektiv verwalten können.

On-Demand-Instanzen

On-Demand-Instanzen bieten uns die größte Flexibilität. Wir können sie starten, wann immer wir wollen, sekundengenau bezahlen und sie genauso einfach wieder abschalten, ohne Verpflichtungen einzugehen. Sie sind perfekt für:

- Kurzfristige Projekte

- Spontane oder unvorhersehbare Arbeitsbelastungen

- Schnell loslegen ohne vorherige Planung

Aber diese Flexibilität hat einen höheren Preis. Bei lang andauernden oder vorhersehbaren Arbeitsbelastungen können wir mit anderen Optionen im Laufe der Zeit viel mehr sparen.

Reservierte und Spot-Instanzen

Reservierte Instanzen sind ideal, wenn wir wissen, dass eine Arbeitslast über einen längeren Zeitraum konstant laufen wird. Wenn du dich für eine ein- oder dreijährige Laufzeit verpflichtest, kannst du bis zu 75 % im Vergleich zu den Preisen auf Abruf sparen. Das ist ein kluger Schachzug, um stabile, ständig aktive Apps zu betreiben.

Spot-Instanzen hingegen sind besser für ein knappes Budget geeignet. AWS bietet ungenutzte Kapazitäten zu massiven Rabatten von bis zu 90 % an, die aber kurzfristig wieder zurückgenommen werden können. Das bedeutet, dass sie am besten für Berufe geeignet sind, die mit Unterbrechungen umgehen können, wie z. B.:

- Stapelverarbeitung

- Datenanalyse

- CI/CD-Workloads

- Zustandslose Dienste

Schneller Vergleich: On-demand vs. reservierte vs. Spot-Instanzen

Hier ist eine kurze Tabelle, die dir bei der Entscheidung hilft :

|

Option |

Am besten für |

Kosten |

Flexibilität |

Gut zu wissen |

|

Abrufbar unter |

Kurzfristige oder unvorhersehbare Arbeit |

Höchste |

Sehr flexibel |

Ideal für Tests oder unvorhersehbare Belastungen |

|

Reserviert |

Langfristige, gleichmäßige Arbeitsbelastungen |

Niedriger (mit Verpflichtung) |

Weniger flexibel |

1 oder 3 Jahre Laufzeit sparen bis zu 75% |

|

Spot |

Unterbrechbare, fehlertolerante Aufgaben |

Niedrigste |

Begrenzt (kann jederzeit beendet werden) |

Bis zu 90% Ersparnis, aber keine Garantie |

Einen genaueren Vergleich findest du auf der offiziellen AWS-Website.

Tipps zur Kostenoptimierung

Umunser Budget noch weiter zu strecken, gibt es ein paar Instrumente und Strategien, auf die wir uns stützen können:

- Sparpläne: Diese bieten flexible, verbindliche Preise für EC2 und andere Dienste. Wir können bis zu 72% sparen, wenn wir uns zu einer konsequenten Nutzung verpflichten.

- Automatische Skalierung: Passt unsere Kapazität automatisch an die Nachfrage an, sodass wir nie überversorgt sind.

- Right-sizing: Überprüfe regelmäßig die Instanztypen und -größen, um sicherzustellen, dass sie noch passen. Kleine Änderungen können mit der Zeit große Einsparungen bedeuten.

Fazit

Es gibt keine Einheitsgröße, wenn es um EC2-Instanzen geht, und das ist auch gut so. Egal, ob wir eine schnelle Entwicklungsumgebung einrichten oder eine komplexe Pipeline für maschinelles Lernen skalieren wollen, AWS gibt uns die Flexibilität, genau das zu wählen, was wir brauchen.

Entscheidend ist, dass wir unsere Arbeitsbelastung verstehen, unsere Leistungsziele kennen und die Kosten im Blick behalten. Je bewusster wir unsere Entscheidungen treffen, unterstützt durch Tools, Tests und ein bisschen Ausprobieren, desto mehr können wir aus unserer Infrastruktur herausholen.

Wenn du deine AWS-Kenntnisse weiter ausbauen oder mehr über die Möglichkeiten von EC2 erfahren möchtest, findest du hier ein paar Ressourcen, die du dir ansehen solltest:

- Einführung in AWS - Ein guter Ausgangspunkt, um die wichtigsten AWS-Konzepte und -Dienste zu verstehen.

- AWS Cloud-Technologie und -Services - Erkunde die AWS-Services und wie sie im Cloud-Ökosystem zusammenpassen.

- AWS-Sicherheit und Kostenmanagement - Erfahre mehr über die besten Methoden zur Sicherung deiner AWS-Umgebung und zur effektiven Kostenverwaltung.

- Einführung in AWS Boto in Python - Ein praktischer Kurs, in dem du lernst, wie du mit Boto3 (AWS SDK für Python) Aufgaben automatisieren und AWS-Ressourcen verwalten kannst.

Diese Ressourcen helfen dir, deine AWS-Kenntnisse auf die nächste Stufe zu bringen, mit praktischen Beispielen und Anwendungen aus der Praxis.

FAQs

Was ist der Unterschied zwischen ECS und EC2?

EC2 ist ein Dienst für virtuelle Maschinen, bei dem du die gesamte virtuelle Maschine verwaltest, einschließlich des Betriebssystems und der Anwendungen. ECS hingegen ist ein verwalteter Container-Orchestrierungsdienst, der sich auf die Ausführung und Skalierung von containerisierten Anwendungen konzentriert.

Ist AWS EC2 serverlos?

EC2 erfordert die Verwaltung und Bereitstellung der Umgebung.

Was ist Elastic IP in AWS?

In AWS ist eine Elastic IP-Adresse eine statische, öffentliche IPv4-Adresse, die du mit einer Instanz oder Netzwerkschnittstelle verknüpfen kannst, um eine konsistente öffentliche IP zu gewährleisten, auch wenn die Instanz angehalten oder neu gestartet oder in eine andere Region verschoben wird.

Wie kann ich eine EC2-Instanz löschen?

Melde dich in der AWS Management Console an, gehe zum EC2 Dashboard und wähle die Instanz aus, die du löschen möchtest. Wähle dann "Beenden" aus dem Dropdown-Menü "Instanzstatus". Bestätige die Kündigung, wenn du dazu aufgefordert wirst.

Was ist AMI in AWS?

Amazon Machine Image (AMI) ist eine Vorlage, die die Informationen enthält, die zum Starten einer Amazon Elastic Compute Cloud (EC2) Instanz benötigt werden.

Wie schneiden Graviton-basierte Instanzen im Vergleich zu Intel- oder AMD-basierten Instanzen ab?

Graviton-Instanzen nutzen die ARM-Architektur, die für viele Workloads ein besseres Preis-Leistungs-Verhältnis und eine höhere Energieeffizienz bietet. Die Kompatibilität mit x86-Anwendungen sollte jedoch überprüft werden.

Ich bin ein Inhaltsstratege, der es liebt, komplexe Themen zu vereinfachen. Ich habe Unternehmen wie Splunk, Hackernoon und Tiiny Host geholfen, ansprechende und informative Inhalte für ihr Publikum zu erstellen.