Kurs

Ich bin dem Konzept der Kardinalität zum ersten Mal während meines Physikstudiums in einem Quantenmechanikkurs begegnet. In dieser Klasse bezog sich die Kardinalität auf die Größe einer Menge, ob endlich oder unendlich, und wurde mit abstrakten Konzepten wie Abzählbarkeit und Unendlichkeit verknüpft. Als ich zur Softwaretechnik wechselte, wurde mir klar, dass der Begriff Kardinalität für einen Dateningenieur oder Wissenschaftler eine viel praktischere Bedeutung hat: die Unterscheidbarkeit von Werten in einem Datensatz.

In einem meiner ersten Projekte, in dem ich Daten aus der realen Welt analysierte, lernte ich, wie schwierig eine hohe Kardinalität sein kann. Es verlangsamte meine Datenbankabfragen und verwandelte das, was eigentlich klar sein sollte, in ein verwirrendes Durcheinander. Seitdem habe ich einige praktische Erfahrungen gesammelt und diesen Leitfaden zusammengestellt, in der Hoffnung, dass er anderen in der gleichen Situation helfen könnte. Hier bist du richtig, wenn du lernen willst, was eine hohe Kardinalität ist, welche Herausforderungen sie mit sich bringt und wie du sie auf praktische und effektive Weise bewältigen kannst!

Was ist Kardinalität, und was ist hohe Kardinalität?

Die Konzepte der Kardinalität und der hohen Kardinalität können etwas abstrakt klingen, also lass sie uns aufschlüsseln.

Definition und Beispiele

Die Kardinalität bezieht sich auf die Anzahl der eindeutigen Werte in einer Spalte eines Datensatzes. Eine Spalte mit hoher Kardinalität enthält eine große Anzahl von eindeutigen Werten, während Spalten mit niedriger Kardinalität weniger eindeutige Einträge enthalten.

Eine hohe Kardinalität ist besonders häufig bei Datensätzen mit eindeutigen Identifikatoren, wie z. B.:

- Zeitstempel: Fast jeder Wert ist einzigartig, wenn die Daten auf Milli- oder Nanosekundenebene aufgezeichnet werden.

- Kunden-IDs: Jeder Kunde hat einen eigenen Lernpfad, um seine Aktivitäten zu verfolgen.

- Transaktions-IDs: Finanzdatensätze enthalten oft eindeutige Codes für jede Transaktion.

Diese eindeutigen Werte sind wichtig, um Daten zu verfolgen, zu aggregieren oder zu personalisieren. Ihre große Anzahl kann jedoch erhebliche Herausforderungen in Bezug auf Speicherung, Leistung und Visualisierung mit sich bringen, auf die wir gleich noch eingehen werden.

Häufige Fälle aus der Praxis

Hohe Kardinalität kann sich in jedem Bereich und jeder Branche manifestieren. Damit du besser verstehst, was eine hohe Kardinalität in der Praxis bedeutet, habe ich im Folgenden ein paar Beispiele aufgeführt.

E-Commerce und Kundendaten

E-Commerce-Plattformen generieren täglich enorme Mengen an hochkardinalen Daten:

- Kunden-IDs: Jedem Nutzer wird eine eindeutige Kennung zugewiesen, um sein Verhalten, seine Einkäufe und seine Vorlieben zu verfolgen.

- Sitzungs-IDs: Jeder Lernpfad wird eindeutig protokolliert, was zu einer großen Anzahl von unterschiedlichen Werten in den Lernpfad-Datensätzen führt.

- Produkt SKUs: Lagerhaltungseinheiten sind für jede Produktvariante einzigartig und bilden eine Spalte mit hoher Kardinalität in den Bestands- und Verkaufsdaten.

Diese Datensätze sind unerlässlich, um das Nutzerverhalten zu verstehen, den Bestand zu verfolgen und die Verkaufsstrategien zu optimieren, aber die schiere Anzahl einzigartiger Einträge macht die Analyse oft komplex.

Gesundheitswesen und Patientenakten

Im Gesundheitswesen führt die Notwendigkeit einer präzisen Verfolgung und Identifizierung natürlich zu Daten mit hoher Kardinalität. Wir können zum Beispiel finden:

- Patienten-IDs: Jeder Patient hat eine eindeutige Kennung, um eine genaue und sichere Aufzeichnung zu gewährleisten.

- Zeitstempel für die Verabredung: Für jede Patienteninteraktion, vom Arztbesuch bis zum Labortest, können eindeutige Zeitstempel erstellt werden.

- Versicherungsfallnummern: Jeder von den Versicherern bearbeitete Anspruch wird zu Aufzeichnungs- und Prüfzwecken mit einem bestimmten Code versehen.

Diese Daten werden benötigt, um die Patientenhistorie zu führen und die Einhaltung der Datenschutzbestimmungen zu gewährleisten.

IoT-Sensoren und Streaming-Daten

Die zunehmende Verbreitung von IoT-Geräten hat zu einem Anstieg von Datensätzen mit hoher Kardinalität geführt:

- Sensor-IDs: Jedes IoT-Gerät hat eine eindeutige Kennung, um seine Aktivität und seinen Standort zu verfolgen.

- Zeitstempeldaten: Kontinuierliche Datenströme protokollieren Ereignisse oft in Intervallen von Millisekunden oder Nanosekunden, was zu fast ausschließlich eindeutigen Werten führt.

- Ereignis-IDs: Jedes aufgezeichnete Ereignis in einem System, von der Temperaturmessung bis zur Bewegungserkennung, wird mit einer eindeutigen Kennung versehen.

Im IoT entsteht eine hohe Kardinalität durch die Notwendigkeit, feinkörnige Echtzeitdaten von zahlreichen Geräten zu verarbeiten. Diese Daten sind wichtig für die Analyse und Überwachung, aber schwierig zu speichern und effizient abzufragen - dazu später mehr!

Herausforderungen bei hoher Kardinalität

Eine hohe Kardinalität stellt verschiedene Herausforderungen an die Datenverarbeitung, die Technik, die Analyse und das maschinelle Lernen. Datensätze mit hoher Kardinalität liefern eine Fülle nützlicher Informationen, können aber oft zu einem Engpass werden und die Leistung, Interpretierbarkeit und Skalierbarkeit behindern.

Datenspeicherung und Leistungsprobleme

Eine der größten Herausforderungen bei hoher Kardinalität sind die Auswirkungen auf die Datenspeicherung und die Systemleistung.

- Lagerung über Kopf: Spalten mit hoher Kardinalität, wie z. B. eindeutige Bezeichner oder Zeitstempel, führen zu größeren Datensätzen. Die Protokollierung von Millionen von Benutzerinteraktionen auf einer E-Commerce-Plattform beispielsweise verursacht aufgrund der Eindeutigkeit von Sitzungs-IDs oder Transaktionszeitstempeln einen immensen Speicheraufwand.

- Geringere Abfrageleistung: Bei der Abfrage von Spalten mit hoher Kardinalität haben Datenbanken mit der erhöhten Komplexität der Indizierung und des Scannens zu kämpfen. Abfragen, die das Filtern oder Verknüpfen von Spalten mit hoher Kardinalität beinhalten, dauern in der Regel länger, da die Datenbank eine große Anzahl von unterschiedlichen Werten durchsuchen muss.

- Herausforderungen bei der Indexierung: Indizes, die für die Beschleunigung von Datenbankabfragen unerlässlich sind, werden bei Spalten mit hoher Kardinalität aufgebläht und weniger effizient. Das kann zu langsameren Suchvorgängen und einer schlechteren Leistung führen.

Nehmen wir als Beispiel eine Datenbank, die IoT-Sensordaten mit eindeutigen Sensor-IDs und genauen Zeitstempeln speichert. Abfragen, die nach einem bestimmten Sensor und Zeitbereich filtern, können dazu führen, dass die Datenbank Millionen von Einträgen verarbeiten muss, was zu extrem langsamen Antwortzeiten und ressourcenintensiven Vorgängen führt.

Schwierigkeiten bei der Datenvisualisierung

Die Herausforderung besteht darin, eine große Anzahl verschiedener Werte so darzustellen, dass sie verständlich und sinnvoll sind. Ohne sorgfältige Überlegungen können Daten mit hoher Kardinalität Erkenntnisse verbergen, anstatt sie zu offenbaren.

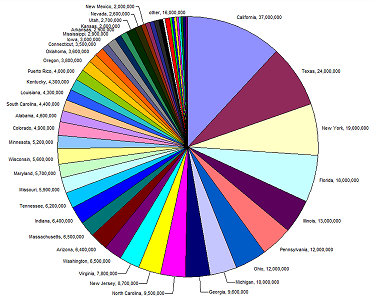

Ein gutes Beispiel dafür ist das Tortendiagramm unten. Die Legende und die Werte sind unleserlich, weil es zu viele eindeutige Einträge (Zustände) für die Art des verwendeten Diagramms gibt. Manchmal hilft es, die Art der Grafik zu ändern, aber nicht immer.

Quelle: Europäische Umweltagentur

Stell dir ein Balkendiagramm vor, das die Kundenaktivitäten einer E-Commerce-Plattform nach Sitzungsnummer darstellt. Bei Tausenden oder Millionen von eindeutigen IDs wird das Diagramm zu einem Wirrwarr von unleserlichen Balken, und es ist unwahrscheinlich, dass ein Wechsel des Diagrammtyps, den wir für die Darstellung dieser Daten verwenden, einen Unterschied macht.

Okay, warum fassen wir die Daten nicht einfach zusammen, um Muster und Beziehungen aus unseren Diagrammen abzuleiten? Das können wir, aber es muss sorgfältig gemacht werden. Die Aggregation von Daten mit hoher Kardinalität kann dazu führen, dass wir die Granularität verlieren, die wir brauchen, um Erkenntnisse zu gewinnen. Wenn du zum Beispiel IoT-Daten nach Standort gruppierst, können subtile, aber wichtige Unterschiede auf der Ebene der einzelnen Sensoren übersehen werden. Die Techniken zur Behebung dieses Problems können sehr subtil sein. Ich empfehle unseren Kurs Datenmodellierung in Power BI für Fortgeschrittene, um praktische Erfahrungen mit Eins-zu-Eins- und Eins-zu-Viel-Beziehungen zu sammeln.

Relevanz für maschinelles Lernen

Eine hohe Kardinalität kann beim maschinellen Lernen erhebliche Herausforderungen mit sich bringen, vor allem wenn es um Feature Engineering, Modellkomplexität und Interpretierbarkeit geht. Modelle für maschinelles Lernen gedeihen gut mit strukturierten und aussagekräftigen Eingaben, aber Merkmale mit hoher Kardinalität stören dieses Gleichgewicht oft und führen zu Komplikationen:

- Erhöhte Sparsamkeit: Merkmale mit hoherarinalität führen oft zu spärlichen Datensätzen. Die One-Hot-Codierung eines kategorialen Merkmals mit hoher Kardinalität, wie z. B. der Postleitzahl, erzeugt eine Matrix mit einer großen Anzahl von Dimensionen, von denen die meistenleer sind. Diese Spärlichkeit erschwert es Modellen, insbesondere abstandsbasierten Modellen wie k-nearest neighbors oder Clustering-Algorithmen, sinnvolle Beziehungen in den Daten zu finden.

- Das Risiko einer Überanpassung: Merkmale mit hoher Kardinalität können zu einer Überanpassung von Modellen führen, die Daten in feinkörnige Kategorien aufteilen, wie z. B. Entscheidungsbäume oder Zufallswälder. Wenn jede Kategorie nur durch einige wenige Stichproben repräsentiert wird, kann das Modell Rauschen statt echter Muster lernen, was zu einer schlechten Generalisierung auf ungesehene Daten führt.

Im E-Commerce könnte ein maschinelles Lernmodell, das die Kundenabwanderung vorhersagt, zum Beispiel ein Merkmal mit hoher Kardinalität wie "Benutzer-ID" oder "Produkt-ID" enthalten. Wenn das Modell nicht richtig gehandhabt wird, kann es zu einer Überanpassung an bestimmte Kunden oder Produkte in den Trainingsdaten kommen. Dies würde die Vorhersage der Abwanderung von neuen Nutzern weniger effektiv machen, da es Muster erlernt, die nur im Trainingsdatensatz vorkommen, und keine verallgemeinerbaren Trends.

Strategien für den Umgang mit hoher Kardinalität

Um eine hohe Kardinalität effektiv zu verwalten, ist eine Mischung aus domänenspezifischen Strategien und allgemeinen Datenoptimierungstechniken erforderlich. Diese Ansätze verbessern nicht nur die Systemleistung, sondern machen die Daten auch besser interpretierbar und umsetzbar.

Nutzung von Technologie und Tools

Glücklicherweise sind die Herausforderungen, die hochkardinale Datensätze mit sich bringen, so weit verbreitet, dass verschiedene Techniken und Werkzeuge speziell für sie entwickelt und abgestimmt wurden.

Datenbank-Optimierung

Der Umgang mit einer hohen Kardinalität in Datenbanken beginnt oft mit der Optimierung der Datenspeicherung und -abfrage und geht über das Entfernen von Duplikaten hinaus. Die am häufigsten verwendeten Techniken sind:

- Bucketing (oder Binning): Gruppierung von Daten mit hoher Kardinalität in breitere Kategorien, um die Anzahl der eindeutigen Werte zu reduzieren. Zum Beispiel, indem du die Postleitzahlen nach Regionen gruppierst, anstatt sie einzeln zu speichern.

- Partitionierung: Strukturierung von Tabellen durch Partitionen, die auf häufig abgefragten Feldern basieren. Die Partitionierung von Kundendaten nach Ländern kann zum Beispiel die Abfrageleistung in geografisch verteilten Systemen verbessern.

- Indizierung: Die Verwendung von Indizes, die speziell für Felder mit hoher Kardinalität entwickelt wurden, wie z. B. Bitmap- oder Composite-Indizes, kann die Abfragegeschwindigkeit erhöhen und gleichzeitig die Speichereffizienz verbessern.

Spezialisierte Software

Wenn du es mit einer extrem hohen Kardinalität zu tun hast, gibt es spezielle Tools und Plattformen, die dir helfen können:

- Säulenförmige Datenbanken: Diese Datenbanken, wie Apache Parquet oder Amazon Redshift, sind für analytische Abfragen konzipiert und können Spalten mit hoher Kardinalität effizient speichern und verarbeiten.

- NoSQL-Datenbanken: In einigen Fällen können NoSQL-Datenbanken wie MongoDB oder Elasticsearch besser mit der Variabilität und Größe von Datensätzen mit hoher Kardinalität umgehen, insbesondere wenn sie mit schemafreien Designs kombiniert werden.

- Zeitreihen-Datenbanken: Für Datensätze, die von Zeitstempeln und Ereignissen dominiert werden, wie IoT-Sensordaten oder Börsentransaktionen, sind Zeitreihendatenbanken wie InfluxDB oder TimescaleDB sehr hilfreich. Sie sind speziell für die effiziente Speicherung von Dimensionen mit hoher Kardinalität optimiert und nutzen fortschrittliche Komprimierungstechniken, um die Speicherkosten zu minimieren und gleichzeitig sehr leistungsfähig zu sein. Ich habe an einigen Projekten mit großen Mengen an IoT-Daten gearbeitet, und Zeitreihendatenbanken haben einen großen Unterschied gemacht, wenn es darum ging, Trends und Vorhersagen abzuleiten. Ich habe diesen Leitfaden für Zeitreihendatenbanken geschrieben, wenn du mehr erfahren möchtest!

- Tools zur Erstellung von Datenprofilen: Tools wie Talend, OpenRefine oder sogar benutzerdefinierte Python-Skripte können schnell Felder mit hoher Kardinalität identifizieren und dabei helfen, die beste Vorverarbeitungs- oder Speicherstrategie zu bestimmen.

Techniken zur Vorverarbeitung von Daten

Die Vorverarbeitung in der Datenwissenschaft und beim maschinellen Lernen bezieht sich auf die Schritte, die unternommen werden, um Rohdaten zu bereinigen, umzuwandeln und in ein geeignetes Format für die Analyse oder Modellierung zu bringen.

Das ist ein ziemlich umfangreiches Thema, und wenn du wenig bis gar keine Kenntnisse in Data Engineering oder Data Science hast, sind die Informationen in diesem Abschnitt vielleicht etwas schwierig zu verstehen. Trotzdem habe ich relevante Links und Beispiele eingefügt, damit du mitreden kannst!

Die Datenvorverarbeitung ist ein wichtiger Schritt bei der Bewältigung einer hohen Kardinalität, da sie die Komplexität reduziert, die Leistung erhöht und sicherstellt, dass die Datenqualität für Analysen oder maschinelle Lernaufgaben ausreichend ist. Indem wir Rohdaten in besser handhabbare Formen umwandeln, können wir Herausforderungen wie Sparsamkeit, ineffiziente Speicherung und Rechenengpässe angehen.

Dimensionalitätsreduktion

Techniken zur Dimensionalitätsreduktion sind besonders wertvoll, wenn eine hohe Kardinalität zu Datensätzen mit zahlreichen Merkmalen oder dünnen Matrizen führt. Diese Methoden komprimieren die Daten auf weniger Dimensionen, während wichtige Informationen erhalten bleiben.

Hauptkomponentenanalyse (PCA)

Stell dir vor, du hast einen Datensatz über das Verhalten von E-Commerce-Kunden mit vielen Merkmalen, z. B. wie oft ein Kunde ein Produkt angesehen hat, wie er mit verschiedenen Produktkategorien interagiert hat, wie viel Zeit er auf der Website verbracht hat und so weiter. Jede dieser Funktionen kann sehr wichtig sein, vor allem, wenn du eine große Anzahl von Produkten verfolgst. Mit der PCA können diese Merkmale zu weniger Komponenten zusammengefasst werden, die dennoch die wichtigsten Muster in den Daten erfassen, z. B. das allgemeine Kundenengagement oder das Interesse an bestimmten Produkttypen. Betrachte es als die Marie Kondo der Daten: Er behält die Funktionen, die Freude machen, und wirft den Rest sanft weg!

t-SNE und UMAP

t-SNE und UMAP sind Techniken, die besonders nützlich sind, um hochdimensionale Daten zu visualisieren, indem sie sie in zwei oder drei Dimensionen abbilden und dabei ihre Struktur beibehalten. In Gesundheitsdaten kann UMAP zum Beispiel helfen, Patienten mit ähnlichen Krankheiten oder Behandlungsmethoden in Gruppen zusammenzufassen. So lassen sich Trends erkennen, z. B. häufig auftretende Krankheiten oder Behandlungserfolge.

Auswahl der Merkmale

Wenn du ein maschinelles Lernmodell erstellst, um die Verkaufsleistung einer E-Commerce-Plattform vorherzusagen, und dein Datensatz Merkmale wie die Anzahl der Klicks eines Kunden auf eine Anzeige, die Anzahl der angesehenen Produkte und die Anzahl der Tage seit dem letzten Kauf enthält, wirst du feststellen, dass viele dieser Merkmale miteinander korreliert sein können, was zu einer hohen Kardinalität und Redundanz führt.

Mit Techniken zur Merkmalsauswahl wie der gegenseitigen Information oder der rekursiven Merkmalseliminierung kannst du herausfinden, welche Merkmale die größte Vorhersagekraft haben (z. B. könnte "Zeit seit dem letzten Kauf" wichtiger sein als "Klicks auf die Anzeige") und die irrelevanten ausschließen, was letztendlich die Leistung deines Modells verbessert.

Wenn du mehr über dieses Thema erfahren möchtest, solltest du den Kurs Preprocessing for Machine Learning besuchen. Du wirst Python verwenden, um deine Daten zu bereinigen und aufzubereiten, bevor du sie in deine Modelle einspeist.

Kodierungsmethoden

Die Kodierung ist ein entscheidender Vorverarbeitungsschritt bei der Verarbeitung kategorialer Daten, insbesondere wenn es sich um hochkardinale Merkmale handelt. Die Wahl der Kodierungsmethode hängt vom jeweiligen Anwendungsfall und dem Grad der Kardinalität des Datensatzes ab.

- One-Hot-Codierung: Bei der One-Hot-Kodierung wird eine binäre Spalte für jede eindeutige Kategorie in einem Datensatz erstellt. Während dies bei Daten mit geringer Kardinalität einfach und effektiv ist, kann es bei Merkmalen mit hoher Kardinalität zu extrem dünnen Matrizen führen. Die Verschlüsselung von 1.000 eindeutigen Postleitzahlen würde zum Beispiel 1.000 Binärspalten ergeben, was den Speicher und die Rechenressourcen überfordern kann. Glaub mir, ich habe das auf die harte Tour gelernt...

- Zielkodierung (mittlere Kodierung): Bei dieser Methode werden die kategorialen Werte durch den Mittelwert der Zielvariablen für jede Kategorie ersetzt. Wenn du zum Beispiel die Kundenabwanderung vorhersagen willst, könnte die Zielcodierung jede Postleitzahl durch die durchschnittliche Abwanderungsrate der Kunden in diesem Gebiet ersetzen. Dieser Ansatz reduziert die Dimensionalität, kann aber zu Verzerrungen führen und erfordert eine sorgfältige Validierung, um Datenverluste zu vermeiden.

- Frequenzcodierung: Bei der Häufigkeitskodierung wird die Häufigkeit einer Kategorie als Wert zugewiesen, wodurch die Anzahl der eindeutigen Werte reduziert wird. In einem E-Commerce-Datensatz könnten zum Beispiel die Produkt-IDs durch die Kaufhäufigkeit ersetzt werden. Diese Technik ist ressourcenschonend und korreliert oft mit der Wichtigkeit des Merkmals.

- Hashing-Verschlüsselung: Bei der Hashing-Kodierung werden die Kategorien mithilfe einer Hash-Funktion auf Ganzzahlen abgebildet, die einige Kategorien zusammenfassen. Diese Methode ist speichereffizient und funktioniert gut bei Streaming-Daten oder extrem hoher Kardinalität, birgt aber das Risiko von Hash-Kollisionen. Hast du dich schon mal gefragt, warum deine Online-Shopping-Website dir Babynahrung empfiehlt, wenn du nach Autoöl gesucht hast? Nun, das sind Hash-Kollisionen für dich.

- Schichten einbetten: Für maschinelle Lernmodelle wie neuronale Netze können Einbettungsschichten kategoriale Merkmale mit hoher Kardinalität in dichte, niedrigdimensionale Darstellungen umwandeln. Dieser Ansatz wird häufig in Empfehlungssystemen verwendet, z. B. bei der Verschlüsselung von Millionen von Produkt- oder Benutzer-IDs in E-Commerce-Plattformen.

Fazit

Datensätze mit hoher Kardinalität können sich manchmal überwältigend anfühlen, und wertvolle Erkenntnisse aus diesen Datensätzen zu extrahieren, kann eine echte Herausforderung sein. Wenn du das nächste Mal auf einen Datensatz mit hoher Kardinalität stößt, denke daran, dass es nicht die Schuld der Daten ist - sie sind einfach voller Potenzial, das darauf wartet, erschlossen zu werden. Ob durch Dimensionalitätsreduzierung, intelligente Kodierungstechniken oder Tools wie Zeitreihendatenbanken- du kannst deine Datensätze effektiv verwalten und sie in leistungsstarke Assets verwandeln.

Da du nun weißt, wie du theoretisch mit hochkardinalen Daten arbeiten kannst, ist es an der Zeit, dies in die Praxis umzusetzen:

- Mach dich mit Dimensionalitätsreduktion und Kodierungstechniken vertraut - fang klein an und arbeite dich hoch. Unsere Dimensionalitätsreduktion in Python ist eine gute Wahl.

- Probiere einige der hier erwähnten Tools aus (ja, Zeitreihen-Datenbanken sind so cool, wie sie klingen!).

Und das Wichtigste: Nimm die Herausforderung an. Eine hohe Kardinalität mag schwierig sein, aber sie ist auch eine Chance, viel über Datentechnik und -analyse zu lernen!

FAQs

Wie kann ich eine hohe Kardinalität in meinen eigenen Datensätzen erkennen?

Eine hohe Kardinalität kannst du erkennen, indem du nach Spalten mit einer großen Anzahl eindeutiger Werte im Verhältnis zur Anzahl der Zeilen suchst. In einem Kundendatensatz zum Beispiel hat eine Spalte wie "Kunden-ID" wahrscheinlich eine hohe Kardinalität, weil jeder Eintrag einzigartig ist. Werkzeuge wie Pandas in Python können dir mit Befehlen wie df['column_name'].nunique() helfen, die Anzahl der eindeutigen Werte in einer Spalte zu überprüfen.

Welche Folgen hat es in der Praxis, wenn eine hohe Kardinalität bei der Datenanalyse ignoriert wird?

Das Ignorieren einer hohen Kardinalität kann zu verschiedenen Problemen führen, z. B. zu Leistungsproblemen (langsamere Abfragezeiten), zu Problemen bei der Auswertung der Daten (zu komplexe Visualisierungen) und zu Schwierigkeiten bei maschinellen Lernmodellen (Overfitting oder ineffizientes Training). Wenn du die hohe Kardinalität nicht berücksichtigst, kann deine Datenanalyse unübersichtlich, ungenau oder einfach nicht mehr zu bewältigen sein.

Kann eine hohe Kardinalität bei der Datenanalyse von Vorteil sein, oder ist sie zu vermeiden?

Eine hohe Kardinalität wird zwar oft als Herausforderung angesehen, kann aber in bestimmten Kontexten wertvolle Informationen liefern. In Empfehlungssystemen zum Beispiel helfen Merkmale mit hoher Kardinalität (wie die Benutzer- oder Produkt-ID) dem System, Empfehlungen zu personalisieren. Es ist jedoch wichtig, die Verwendung dieser Merkmale in den Modellen sorgfältig zu steuern, um eine Überanpassung und Leistungseinbußen zu vermeiden.

Ist eine hohe Kardinalität eher ein Problem bei strukturierten oder unstrukturierten Daten?

Eine hohe Kardinalität kann sowohl bei strukturierten als auch bei unstrukturierten Daten ein Problem darstellen. Bei strukturierten Datensätzen (z. B. relationalen Datenbanken), bei denen die Kardinalität oft mit bestimmten Spalten wie Bezeichnern oder Zeitstempeln verknüpft ist, ist dies jedoch in der Regel eine größere Herausforderung. Bei unstrukturierten Daten, wie z. B. Text- oder Bilddaten, können Kardinalitätsprobleme auf subtilere Weise auftreten, z. B. durch zu viele eindeutige Wörter oder Pixel, was die Verarbeitung komplexer macht.