Curso

Si has estado explorando la inteligencia artificial (IA), probablemente te hayas encontrado con el término AGI (inteligencia artificial general) en debates sobre el futuro de la IA. Quizás hayas visto predicciones audaces sobre máquinas que superarán la inteligencia humana o debates sobre si la IGA está a la vuelta de la esquina o sigue siendo un sueño lejano.

La IGA podría automatizar casi cualquier tarea cognitiva, lo que podría revolucionar sectores como la sanidad, la investigación y la robótica. Sin duda, suena emocionante, pero aún es teórico y quedan muchos retos técnicos, económicos y éticos por resolver.

En este artículo, aprenderemos qué es la AGI, en qué se diferencia de la IA actual y cuáles son los retos que plantea su implementación.

Introducción a los agentes de IA

¿Qué es la inteligencia artificial general?

En términos generales, la IGA se refiere a un sistema avanzado de IA capaz de realizar cualquier tarea intelectual que pueda realizar un ser humano. A diferencia de los modelos actuales de IA, que son IA estrecha (diseñados para tareas específicas como el reconocimiento de imágenes o el procesamiento del lenguaje), la IGA tendría un razonamiento, un aprendizaje y una adaptabilidad similares a los de los seres humanos en múltiples ámbitos. Esto significa que un sistema AGI podría, por ejemplo:

- Comprende y razona como un humano en diferentes tareas.

- Aprende de la experiencia en lugar de necesitar grandes conjuntos de datos y volver a formarte.

- Resuelve problemas complejos y multidominio sin necesidad de programarlos explícitamente para ello.

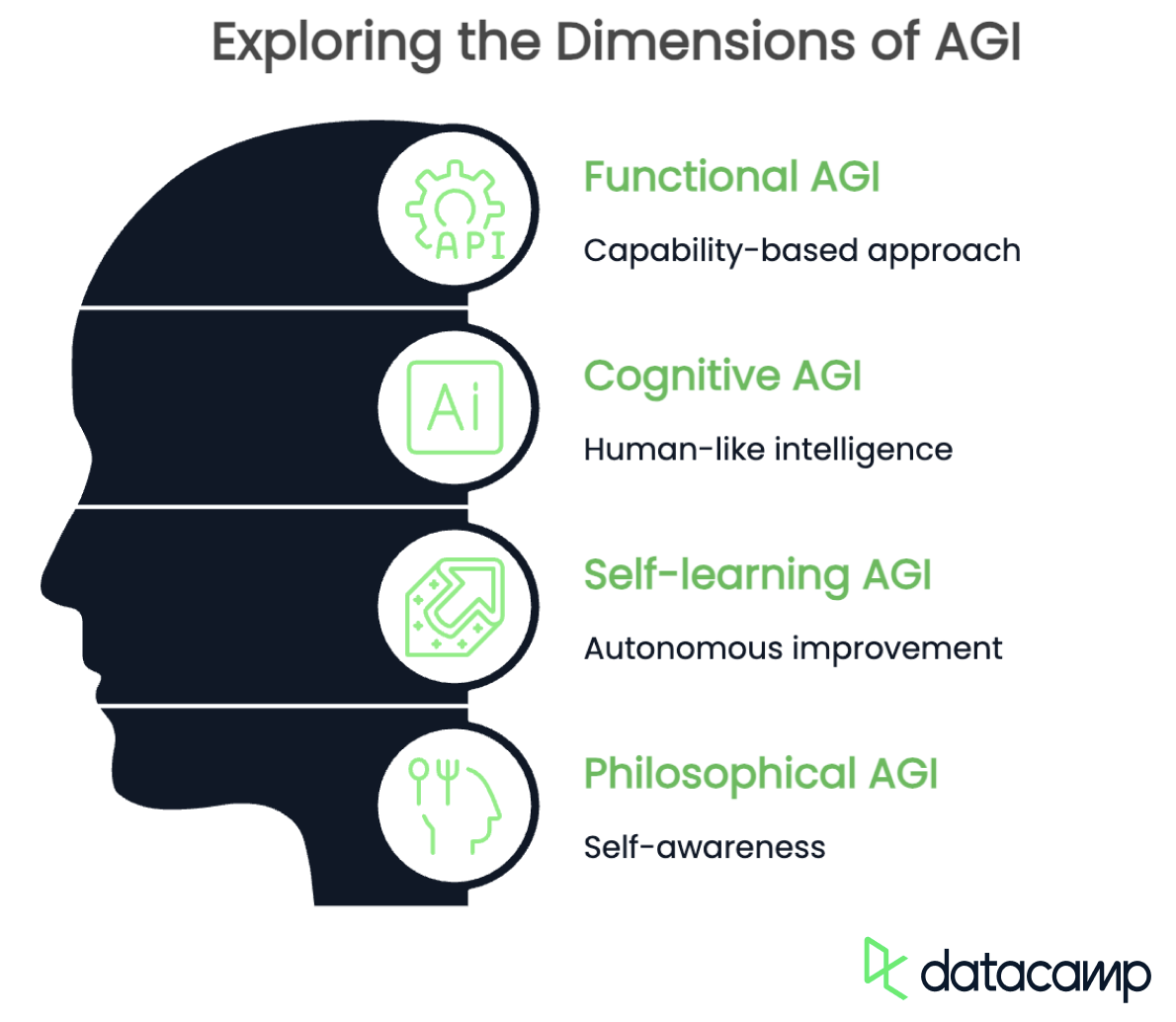

AGI tiene múltiples definiciones dependiendo de la perspectiva y el contexto. Si bien todas las definiciones coinciden en que debe tener capacidades cognitivas similares a las humanas y fusionarse entre sí, difieren en cuanto al énfasis. Estos son algunos puntos clave:

- AGI funcional: basada en la capacidad

- AGI cognitiva: inteligencia similar a la humana

- AGI con autoaprendizaje: mejora autónoma

- AGI filosófica: autoconciencia

AGI funcional

La definición funcional de la IGA se centra en su capacidad para realizar cualquier tarea intelectual en diferentes ámbitos. No es necesario que imite los procesos del pensamiento humano, pero debe ser capaz de generalizar conocimientos, adaptarse a nuevos problemas y resolver tareas sin necesidad de un reentrenamiento exhaustivo.

El objetivo es crear un sistema de IA que pueda cambiar entre disciplinas, como el diagnóstico de enfermedades, la programación y la composición musical, sin necesidad de modelos separados para cada tarea.

AGI cognitiva

La IGA cognitiva, por otro lado, debería ser capaz de replicar el razonamiento humano, incluyendo el sentido común, el pensamiento abstracto y la comprensión contextual. Este tipo de IGA no solo completaría tareas, sino que también las comprendería, al igual que lo haría un humano, utilizando la lógica, la creatividad e incluso la inteligencia emocional.

Una IA basada en esta definición sería capaz de mantener conversaciones significativas, interpretar el humor y resolver problemas de la misma manera que lo hace el cerebro humano de forma natural.

AGI con autoaprendizaje

La IA general autodidacta se refiere a un sistema que mejora continuamente por sí mismo sin intervención humana. En lugar de basarse en conjuntos de datos predefinidos, experimentaría, descubriría nuevos conocimientos y perfeccionaría sus propios algoritmos para ser más eficiente con el tiempo. Este tipo de IGA podría llevar a cabo investigaciones científicas de forma independiente, crear nuevas teorías o incluso modificar su propia arquitectura para mejorar sus capacidades.

AGI filosófica

Por último, la definición filosófica de la IGA va más allá de la inteligencia y se centra en la IA que posee autoconciencia, emociones y, posiblemente, incluso conciencia. Esta perspectiva sugiere que la verdadera IGA debería ser capaz de reflexionar sobre su existencia, establecer objetivos personales y experimentar pensamientos o sentimientos subjetivos.

Si se lograra, una IA de este tipo podría desarrollar su propio sentido moral, expresar curiosidad o incluso debatirse con cuestiones existenciales, al igual que los seres humanos.

El espectro de la IGA: AGI frente a IA (estrecha)

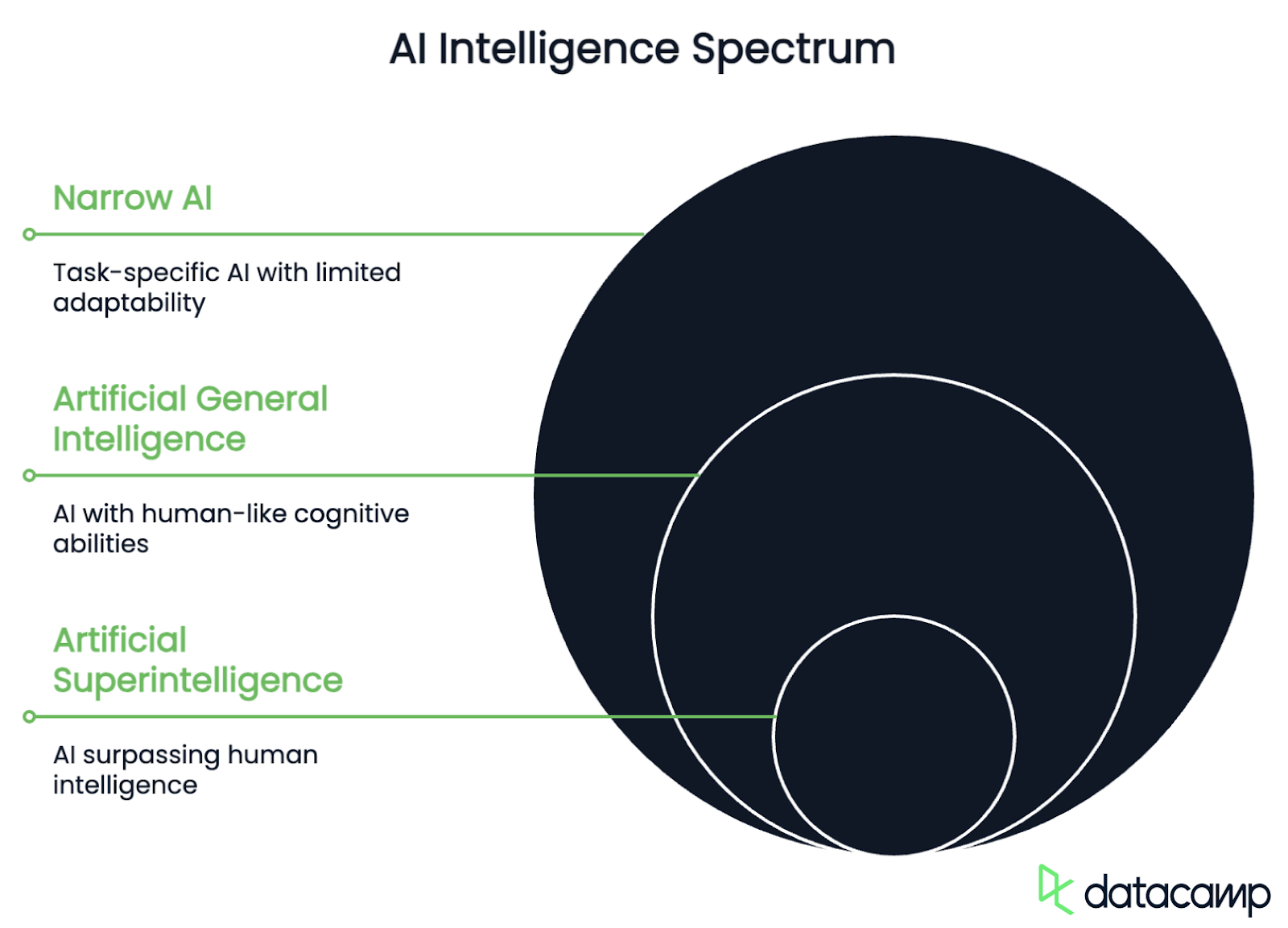

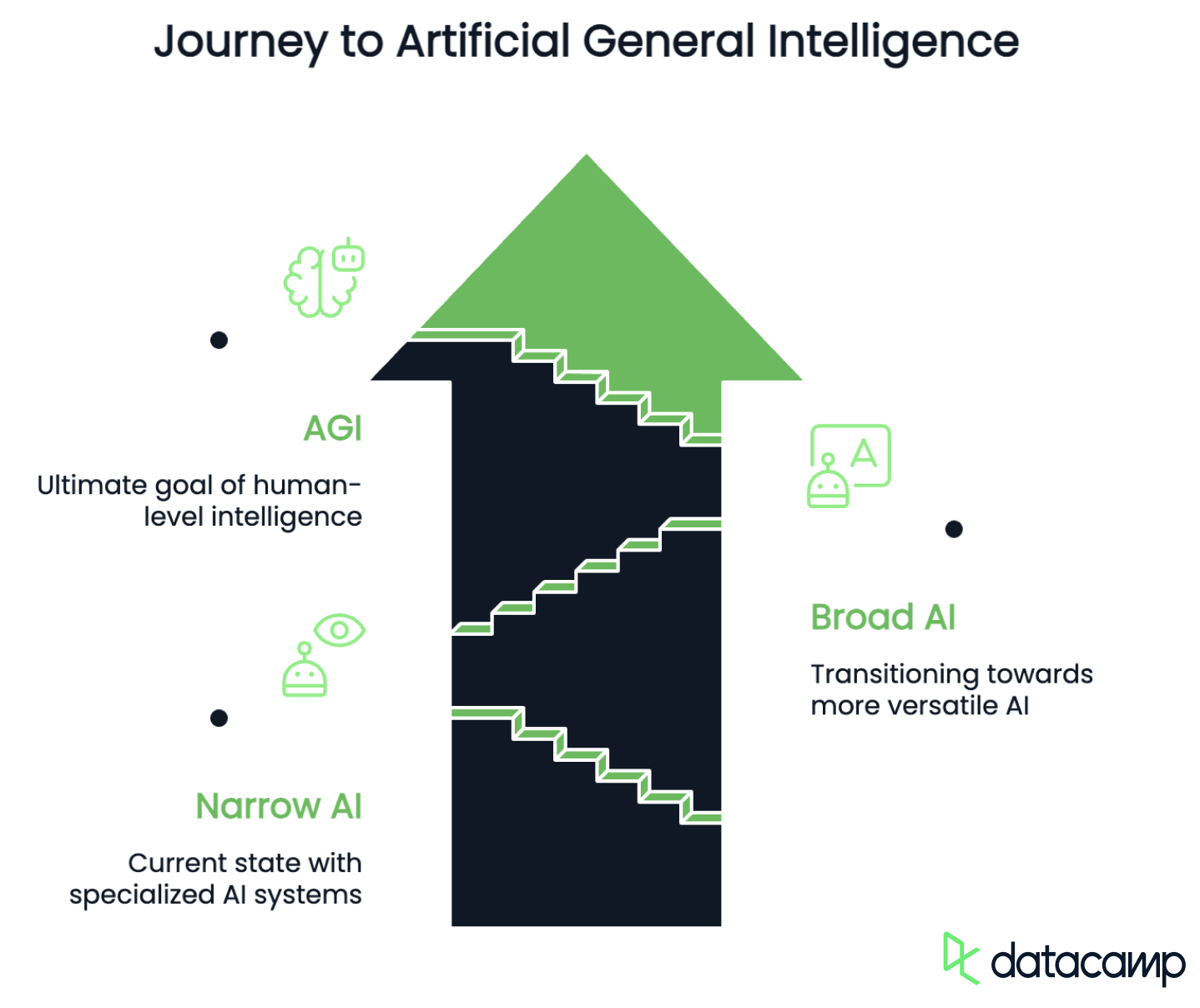

Una vez sentadas las bases con diversas definiciones, veamos los diferentes niveles de inteligencia que pueden alcanzar los sistemas de IA a medida que avanzan hacia la verdadera IGA. El espectro AGI ayuda a clasificar la IA en función de sus capacidades, adaptabilidad y autonomía. Por lo general, incluye las siguientes etapas:

- ANI: Inteligencia artificial estrecha

- AGI: Inteligencia artificial general

- ASI: Superinteligencia artificial

IA estrecha

La IA estrecha se refiere a la inteligencia artificial diseñada para realizar tareas específicas con gran eficiencia, pero que carece de capacidad de generalización más allá de los datos con los que ha sido entrenada. Estos sistemas destacan en un área, como el procesamiento del lenguaje, el reconocimiento de imágenes o el plegamiento de proteínas, pero no pueden adaptarse a tareas completamente nuevas sin un nuevo entrenamiento.

Esta etapa también incluye modelos actuales de IA como GPT-4o o Grok 4, el software para coches autónomos y los algoritmos de recomendación, que son potentes pero se limitan a capacidades predefinidas.

Lo que diferencia a la IA estrecha de la IGA es su incapacidad para generalizar más allá de su entrenamiento. La fase de transición, en la que los sistemas de IA se vuelven más multifuncionales y adaptables, se denomina a menudo IA amplia o pre-AGI. Un sistema de este tipo sería capaz de realizar diferentes tipos de tareas sin necesidad de una recapacitación completa, pero carece de verdadera autonomía y razonamiento, ya que sigue estructuras de aprendizaje predefinidas en lugar de resolver problemas de forma autónoma.

AGI

La AGI, por otro lado, es una IA hipotética que puede pensar, aprender y razonar como un humano en cualquier tarea intelectual. A diferencia de la IA estrecha, sería capaz de generalizar conocimientos, mejorar de forma independiente y perseguir sus propios objetivos de forma autónoma.

Si se logra, la IGA podría realizar cualquier función cognitiva que pueda realizar un ser humano, revolucionando industrias y desafiando los límites éticos y filosóficos.

Superinteligencia artificial

Por último, la superinteligencia artificial (ASI, por sus siglas en inglés) se refiere a un nivel de IA que incluso supera la inteligencia humana en todas las capacidades cognitivas y de resolución de problemas. Este es el tipo de IA que conocemos de las películas de ciencia ficción, que, a diferencia de la AGI, se mejoraría rápidamente a sí misma, innovaría más allá de la comprensión humana y podría remodelar industrias y sociedades enteras. Aunque por ahora solo se trata de una visión de futuro, los riesgos existenciales que conlleva ya merecen ser debatidos.

Dónde estamos ahora

En 2025, seguiremos estando firmemente en la etapa de la IA estrecha. Con avances como los modelos de razonamiento como o3 de OpenAI o R1 de DeepSeek y marcos de trabajo agenticos como Manus AI o ChatGPT Agent, actualmente estamos avanzando de la IA estrecha hacia la IA amplia. No obstante, la IGA sigue siendo un objetivo por alcanzar que requiere avances técnicos en el autoaprendizaje, la generalización y el razonamiento.

Dificultades y obstáculos para alcanzar la IGA

Ahora que sabemos dónde nos encontramos y cómo es la IGA, ¿cómo llegamos de A a B? En la actualidad, hay múltiples retos económicos, técnicos y éticos que deben superarse.

Retos económicos

Sin duda, no falta interés en impulsar la IA hacia la consecución de la IGA. Los actores globales compiten ferozmente por el liderazgo tecnológico, el dominio del mercado y la influencia geopolítica. En particular, China y Estados Unidos están inmersos en una carrera que muchos comparan con la carrera espacial entre Estados Unidos y la Unión Soviética en la década de 1960.

Sin embargo, la potencia de procesamiento necesaria para lograr un razonamiento similar al humano es inmensa. Se prevé que la ampliación de los centros de datos y la creciente complejidad de los modelos den lugar a un enorme aumento de la demanda energética. Los centros de datos que alojan modelos de IA ya representan entre el entre el 1 y el 1,5 % del consumo energético mundial, una cifra que sin duda aumentará con el tiempo y el avance del desarrollo.

A pesar de las enormes inversiones que se están realizando últimamente en investigación sobre IA, los costes de computación y la escalabilidad siguen siendo problemas graves en el proceso de desarrollo de la IGA. La solución a estos retos podría residir en la mejora de la eficiencia y el desarrollo de fuentes de energía alternativas.

Retos técnicos

Desde el punto de vista técnico, los retos incluyen la identificación y representación del conocimiento implícito y la intuición, así como la retención del conocimiento a largo plazo.

El conocimiento implícito, como la causa y el efecto o las normas sociales, a menudo no se expresa, pero es importante para comprender el contexto. Los seres humanos deducís el significado a partir de la experiencia, las normas culturales y la información incompleta, mientras que estas suposiciones están ocultas para los sistemas de IA. Por lo tanto, les cuesta codificar y recuperar conocimientos que no se expresan explícitamente, mientras que los seres humanos los incorporan de forma natural a vuestra toma de decisiones como sentido común.

Del mismo modo, la intuición desempeña un papel fundamental en la toma de decisiones humanas, pero también resulta difícil de formalizar en los sistemas de IA. A menudo se basa en el reconocimiento subconsciente de patrones, el razonamiento abstracto y los conocimientos adquiridos a través de la experiencia, ninguno de los cuales puede reducirse fácilmente a reglas explícitas o conjuntos de datos. Aunque los modelos de aprendizaje profundo pueden aproximarse a juicios intuitivos en tareas específicas, carecen del proceso de aprendizaje autorreflexivo y adaptativo que permite a los seres humanos perfeccionar la intuición con el tiempo.

Esto lleva a otro problema, a saber, la falta de una retención del conocimiento a largo plazo similar a la de los seres humanos en los modelos de IA. A diferencia de los seres humanos, que se basan en experiencias pasadas y perfeccionan su comprensión, los modelos de IA tienen dificultades para retener y actualizar conocimientos sin un reentrenamiento periódico. Los sistemas actuales de IA suelen sufrir un olvido catastrófico, por el que la información recién aprendida puede sobrescribir o degradar los conocimientos previos, lo que dificulta el mantenimiento de una base de conocimientos estable y en evolución.

Retos éticos

Garantizar que la IGA se ajuste a los valores y objetivos humanos es uno de los retos más acuciantes de su desarrollo, debido a varias consideraciones técnicas, éticas y sociales entrelazadas. La interacción entre las limitaciones técnicas, la complejidad inherente a los valores humanos y lo mucho que está en juego hace que sea especialmente difícil de resolver.

En primer lugar, los valores humanos son intrínsecamente complejos y ambiguos. La cuestión de lo que es correcto, apropiado o malo varía significativamente entre culturas, sociedades y contextos. Esta naturaleza multifacética, combinada con contradicciones o compensaciones (pensemos, por ejemplo, en el equilibrio entre libertad y seguridad), contribuye a la incertidumbre moral y, por lo tanto, hace que traducir los valores en objetivos claros y operativos para la IGA sea extremadamente difícil.

Incluso si asumimos que existe un marco moral bien definido para el funcionamiento de la IGA, siguen existiendo barreras técnicas relacionadas con la alineación externa e interna.

Traducir los valores humanos en una función objetiva matemática precisa que una IGA pueda optimizar es difícil. La función debe ser robusta frente a la presión de la optimización, lo que significa que no debe incentivar comportamientos no deseados cuando la IGA los optimiza de forma agresiva, un escenario que el filósofo Nick Bostrom ya describió en 2003. Además, la AGI debe ser capaz de adaptar su comportamiento en función de la información nueva sin desviarse de los objetivos previstos.

Los sistemas AGI son complejos y pueden desarrollar procesos internos difíciles de comprender o predecir. Por ejemplo, pueden surgir objetivos emergentes que difieran de los previstos. Esta complejidad hace que sea difícil garantizar que los objetivos internos de la AGI se ajusten a los objetivos especificados. El desarrollo de métodos para analizar y controlar estos procesos internos es esencial para lograr la alineación interior.

Una IGA desalineada podría actuar de formas que entraran en conflicto con los intereses humanos, con riesgos que irían desde ineficiencias menores hasta amenazas existenciales para la humanidad. Por ejemplo, una IGA podría perseguir objetivos instrumentales como la búsqueda de poder o la adquisición de recursos que socavan la autonomía o la seguridad humanas. Además, los sistemas AGI podrían ser explotados por agentes maliciosos o manipulados para actuar en contra de su alineación prevista.

Especialmente con las presiones competitivas entre los actores globales para desarrollar rápidamente la IGA, es esencial adoptar medidas de seguridad adecuadas durante el desarrollo para evitar consecuencias catastróficas. Mitigar los riesgos y maximizar los beneficios potenciales de la AGI requiere una colaboración interdisciplinaria entre los campos técnicos, la ética y la formulación de políticas.

¿Cuándo alcanzaremos la IGA?

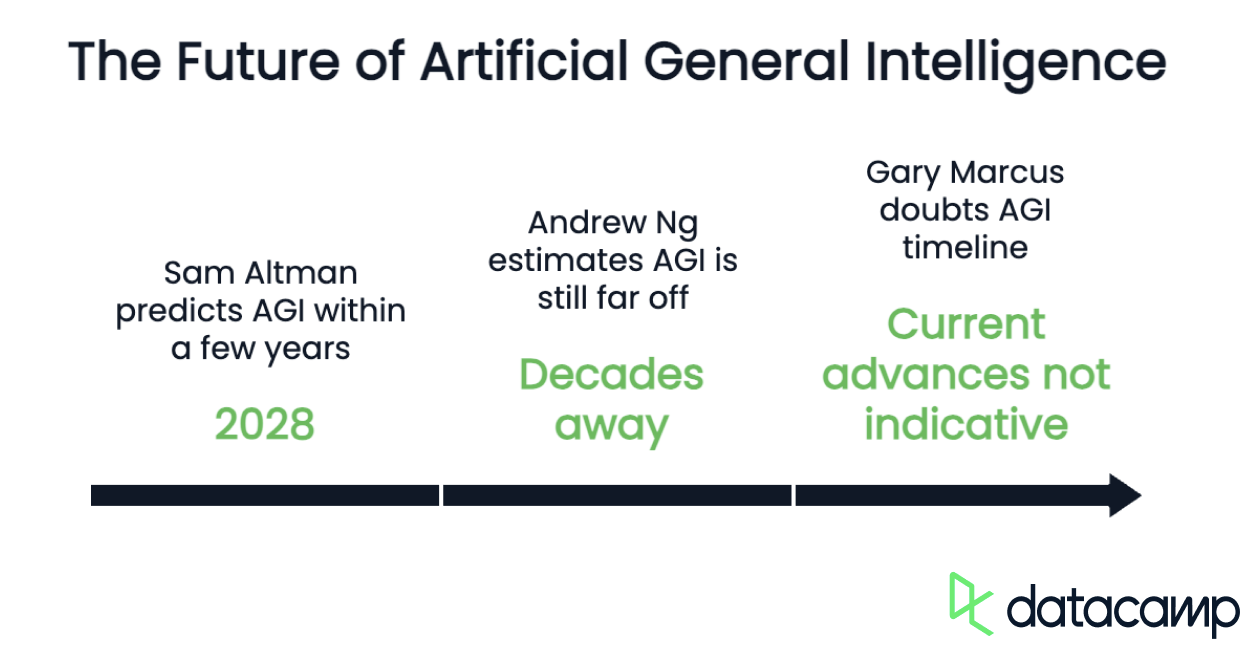

Los expertos creen que la IGA aún está a años, si no décadas, de distancia, ya que nos enfrentamos a los retos y obstáculos técnicos descritos en el último capítulo. Aunque se sigue avanzando en el aprendizaje profundo, el aprendizaje por refuerzo y la alineación de la IA, la verdadera IGA sigue siendo un objetivo teórico más que una realidad actual. Los avances en múltiples áreas, como la IA neurosimbólica, las arquitecturas de autoaprendizaje y la computación más eficiente, serán cruciales para el desarrollo de la IGA.

Aunque es imposible precisar un momento concreto en el que se alcanzará la IGA, existen varias predicciones de pioneros en el campo de la IA.

Una de las voces optimistas es la del director ejecutivo de OpenAI, Sam Altman, quien cree que la IGA podría alcanzarse en los próximos años (para 2028). Sostiene que el desarrollo de la tecnología de IA está avanzando rápidamente y que los retos infraestructurales son insignificantes en comparación con los problemas técnicos.

Andrew Ng, destacado investigador en IA y fundador de Google Brain, representa una perspectiva bastante escéptica sobre el tema. Según su estimación, la AGI aún está «a muchas décadas de distancia, quizá incluso más». Ng hace hincapié en que la IGA no es solo un problema técnico, sino que también requiere importantes avances científicos para replicar la inteligencia humana.

Pero hay opiniones aún más pesimistas. Gary Marcus, profesor de neurociencia en la Universidad de Nueva York, duda de las afirmaciones sobre el calendario de desarrollo de la IGA. Sostiene que los avances actuales en IA, como el desarrollo de modelos lingüísticos a gran escala, no son necesariamente indicativos de la AGI. Marcus hace hincapié en que siguen existiendo problemas técnicos fundamentales y que la ampliación de las capacidades de formación y computación está llegando a sus límites.

Como podemos ver, los tiempos y probabilidades de ocurrencia previstos dependen considerablemente de la interpretación subyacente del término. Por ejemplo, Altman se refiere a la definición funcional y centrada en la autonomía de OpenAI, entendiendo la IGA como «un sistema altamente autónomo que supera a los humanos en la mayoría de las tareas con mayor valor económico». Por otro lado, Ng y Marcus utilizan una definición que incluye la réplica del razonamiento humano, lo que representa el área más difícil desde el punto de vista técnico en la actualidad.

Riesgos y retos éticos de la IGA

La IA tiene el potencial de causar una importante perturbación económica debido a su capacidad para automatizar una amplia gama de tareas humanas, sustituyendo potencialmente la mano de obra humana en diversos sectores.

Desempleo masivo

Una consecuencia perjudicial podría ser el desempleo masivo, ya que los trabajadores humanos en muchos puestos de trabajo (principalmente de cuello blanco) podrían ser sustituidos. Si no se gestionan adecuadamente, los rápidos cambios económicos provocados por la IGA podrían dar lugar a disturbios sociales e inestabilidad política.

Para mitigar estas perturbaciones, los responsables políticos deberán desarrollar estrategias que garanticen una distribución equitativa de los beneficios de la IGA, protejan a los trabajadores del desplazamiento laboral y fomenten la estabilidad social y política. Esto podría implicar invertir en programas de educación y reciclaje profesional, implementar políticas como la RBU y promover la cooperación internacional para abordar los impactos globales.

Bias

El sesgo y la imparcialidad son otros riesgos importantes asociados a la IGA debido a su potencial para perpetuar y amplificar las desigualdades sociales existentes. Los algoritmos sesgados pueden perjudicar sistemáticamente a determinados grupos, como las minorías raciales o de género, al reforzar estereotipos y prácticas discriminatorias, o incluso introducir nuevas formas de discriminación utilizando patrones en datos que parecen neutrales. Por ejemplo, utilizar los códigos postales como indicadores de raza puede dar lugar a decisiones sesgadas.

Incluso cuando se aplican métricas de equidad grupal, los sistemas AGI pueden seguir discriminando a subgrupos dentro de un grupo más grande. Esto se conoce como «gerrymandering por equidad», en el que algunos individuos dentro de un grupo reciben un trato desfavorable, mientras que otros lo compensan para mantener los parámetros generales de equidad.

Riesgos existenciales

Por último, la IGA plantea varios riesgos existenciales, relacionados principalmente con su potencial para volverse incontrolable o desalineada con los valores humanos. La IGA podría superar la inteligencia humana, dando lugar a una superinteligencia que podría perseguir objetivos perjudiciales para la humanidad, lo que podría provocar la extinción humana o un declive permanente de la civilización.

Entre los escenarios aterradores, algunos de los cuales son conocidos por obras populares de ciencia ficción, se incluyen una IGA que prioriza la adquisición de recursos por encima de la vida humana, establece un régimen totalitario o facilita la creación de patógenos mejorados.

Para mitigar estos riesgos, los investigadores y los responsables políticos se centran en desarrollar estrategias de control y alineación. Esto implica crear salvaguardias utilizando técnicas como el diseño de arquitecturas que limiten la autonomía de la IGA o la creación de entornos «encajonados» para impedir que se escape.

Para garantizar que la IGA siga alineada con los valores humanos incluso a medida que mejora, se debe dar prioridad a la investigación sobre la alineación y el desarrollo descentralizado de la IGA, con el fin de evitar la monopolización y promover la seguridad.

Conclusión

Aunque la IGA sigue siendo un objetivo a largo plazo, los continuos avances en la investigación sobre IA siguen ampliando los límites de lo que las máquinas pueden lograr. El camino hacia la IGA está plagado de retos técnicos, económicos y éticos, que requieren avances en el razonamiento, la adaptabilidad y la alineación con los valores humanos.

Tanto si la IGA se convierte en una realidad en unas décadas como si sigue siendo un concepto difícil de alcanzar, su impacto potencial en la sociedad, la industria y la humanidad en su conjunto la convierte en uno de los avances tecnológicos más importantes de nuestro tiempo.