Curso

Se você já está explorando a inteligência artificial (IA), provavelmente já se deparou com o termo IAG (Inteligência Artificial Geral) em discussões sobre o futuro da IA. Talvez você já tenha visto previsões ousadas sobre máquinas ultrapassando a inteligência humana ou debates sobre se a IGA está prestes a acontecer ou ainda é um sonho distante.

A AGI pode automatizar quase todas as tarefas cognitivas, revolucionando setores como saúde, pesquisa e robótica. Isso parece bem legal – mas ainda é só teoria, e tem muitos desafios técnicos, econômicos e éticos pela frente.

Neste artigo, vamos aprender o que é a AGI, como ela é diferente da IA atual e os desafios que a gente vai enfrentar no caminho pra ela se tornar realidade.

Introdução aos agentes de IA

O que é Inteligência Artificial Geral?

Em geral, AGI é um sistema de IA avançado que consegue fazer qualquer tarefa intelectual que um humano consegue. Diferente dos modelos atuais de IA, que são IA estreita (feita pra tarefas específicas, tipo reconhecimento de imagens ou processamento de linguagem), a AGI teria raciocínio, aprendizado e adaptabilidade parecidos com os humanos em vários campos. Isso quer dizer que um sistema AGI poderia, por exemplo:

- Entenda e raciocine como um humano em diferentes tarefas.

- Aprenda com a experiência em vez de precisar de um monte de dados e reciclagem.

- Resolva problemas complexos e de vários domínios sem precisar programar nada específico pra isso.

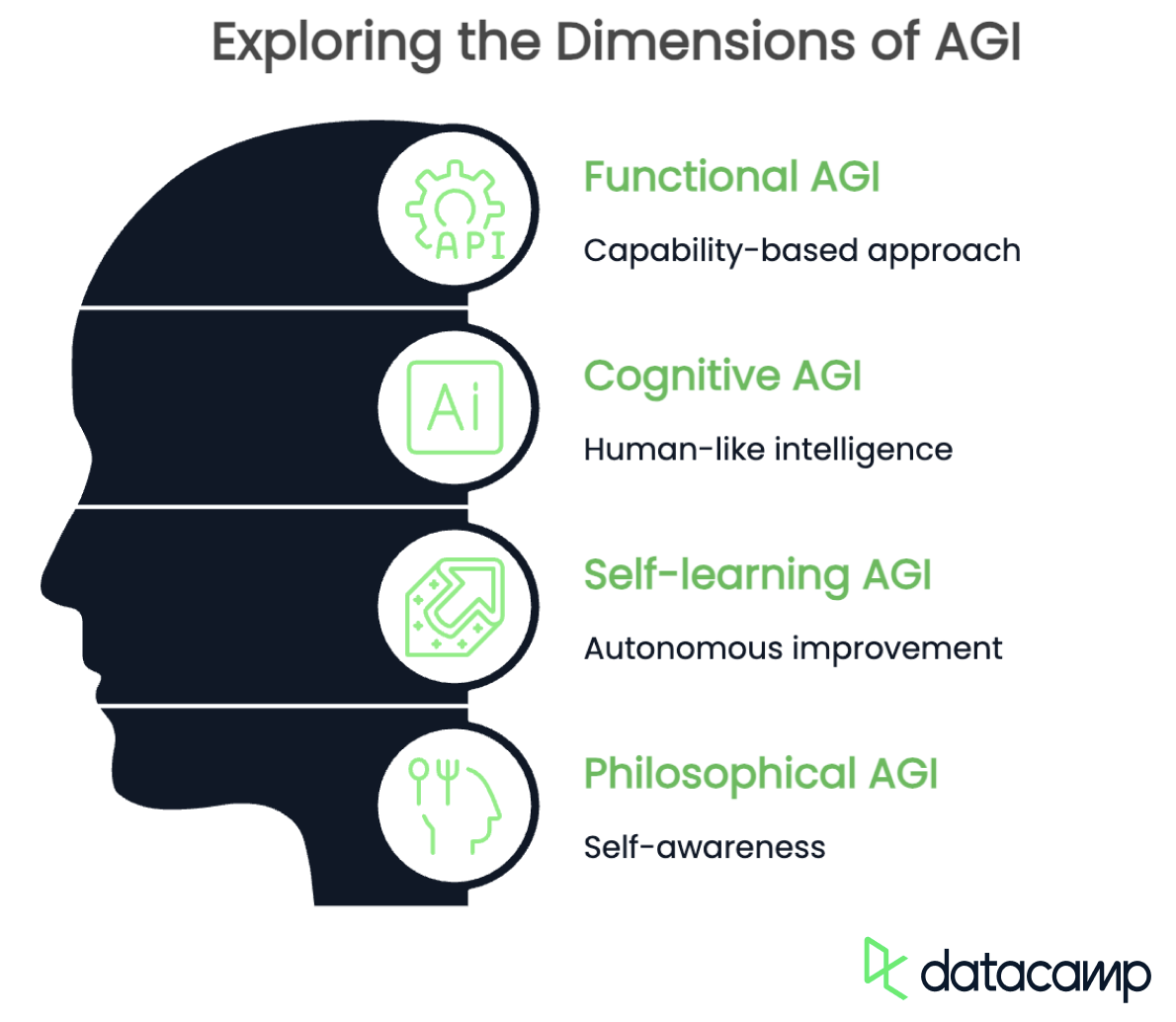

AGI tem várias definições, dependendo da perspectiva e do contexto. Embora todas as definições concordem que ele deve ter habilidades cognitivas parecidas com as dos humanos e se fundir uns com os outros, elas diferem na ênfase. Aqui estão alguns pontos importantes:

- AGI funcional: baseada em capacidades

- AGI cognitiva: inteligência parecida com a humana

- AGI com autoaprendizagem: melhoria autônoma

- AGI filosófica: autoconsciência

AGI funcional

A definição funcional da IGA é a capacidade de fazer qualquer tarefa intelectual em diferentes áreas. Não precisa imitar os processos de pensamento humano, mas deve ser capaz de generalizar conhecimentos, adaptar-se a novos problemas e resolver tarefas sem necessidade de um retreinamento extenso.

O foco é um sistema de IA que consegue alternar entre disciplinas, como diagnosticar condições médicas, programar e compor música, sem precisar de modelos separados para cada tarefa.

AGI cognitiva

Já a IGA cognitiva deve ser capaz de copiar o raciocínio humano, incluindo senso comum, pensamento abstrato e compreensão contextual. Esse tipo de IGA não só faria as tarefas, mas também entenderia o que tá rolando, tipo um humano, usando lógica, criatividade e até inteligência emocional.

Uma IA feita com base nessa definição seria capaz de ter conversas que fazem sentido, entender piadas e resolver problemas da mesma forma que o cérebro humano faz naturalmente.

AGI com autoaprendizagem

A AGI de autoaprendizagem é um sistema que melhora a si mesmo sem precisar de ajuda de ninguém. Em vez de depender de conjuntos de dados pré-definidos, ele experimentaria, descobriria novos conhecimentos e refinar os seus próprios algoritmos para se tornar mais eficiente ao longo do tempo. Esse tipo de IGA poderia fazer pesquisas científicas de forma independente, criar novas teorias ou até mesmo mudar sua própria estrutura para melhorar suas capacidades.

AGI filosófica

Por fim, a definição filosófica de AGI vai além da inteligência e foca na IA que tem autoconsciência, emoções e, talvez, até consciência. Essa perspectiva sugere que a verdadeira IGA deve ser capaz de refletir sobre sua existência, formar objetivos pessoais e experimentar pensamentos ou sentimentos subjetivos.

Se isso rolar, essa IA pode acabar criando seu próprio senso de moral, mostrar curiosidade ou até mesmo se perguntar sobre questões existenciais, assim como a gente faz.

O Espectro da AGI: AGI vs. IA (estreita)

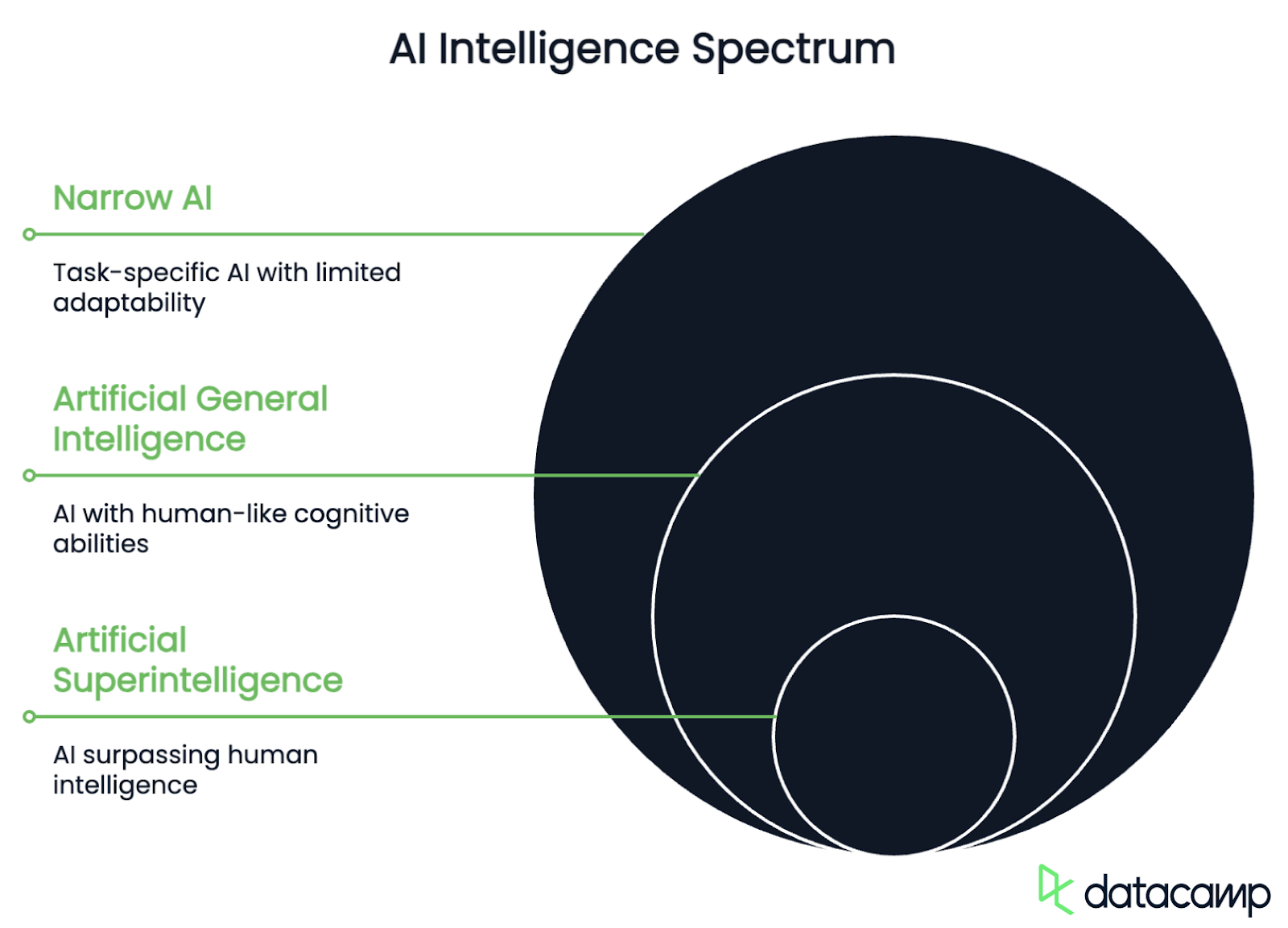

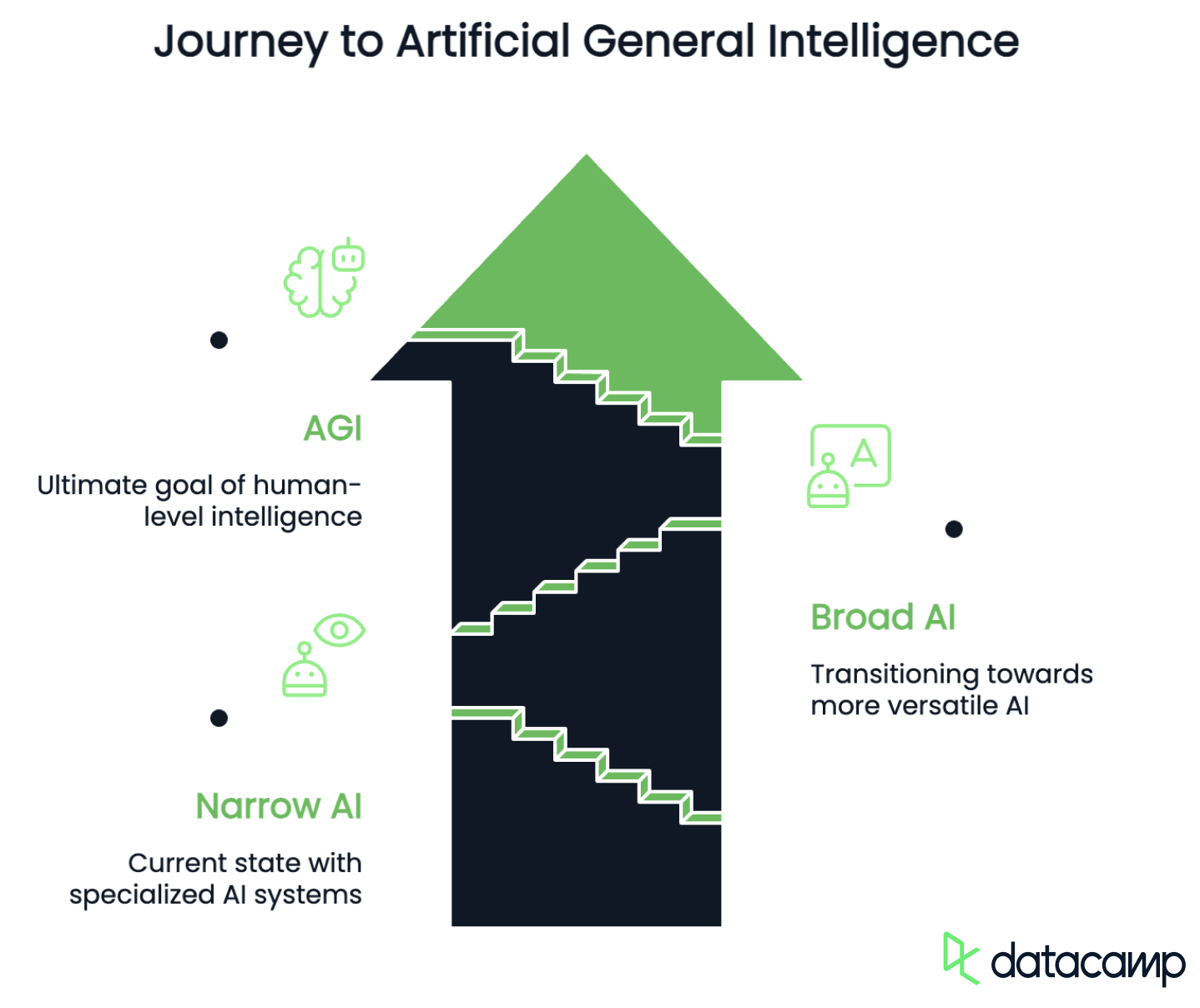

Depois de definir o cenário com várias definições, vamos dar uma olhada nos diferentes níveis de inteligência que os sistemas de IA podem alcançar à medida que avançam em direção à verdadeira AGI. O espectro AGI ajuda a categorizar a IA com base em suas capacidades, adaptabilidade e autonomia. Geralmente inclui as seguintes etapas:

- ANI: Inteligência Artificial Estreita

- AGI: Inteligência Artificial Geral

- ASI: Superinteligência Artificial

IA estreita

IA estreita é quando a inteligência artificial é feita pra fazer tarefas específicas com muita eficiência, mas não consegue generalizar além dos dados que aprendeu. Esses sistemas são ótimos em uma área, tipo processamento de linguagem, reconhecimento de imagens ou dobramento de proteínas, mas não conseguem se adaptar a tarefas totalmente novas sem um novo treinamento.

Essa fase também inclui modelos atuais de IA, como o GPT-4o ou Grok 4, software para carros autônomos e algoritmos de recomendação, que são poderosos, mas limitados a recursos pré-definidos.

O que diferencia a IA estreita da IGA é que ela não consegue generalizar além do que aprendeu. A fase de transição, em que os sistemas de IA se tornam mais multifuncionais e adaptáveis, é frequentemente chamada de IA ampla ou pré-AGI. Um sistema assim seria capaz de lidar com diferentes tipos de tarefas sem precisar de um novo treinamento completo, mas não tem autonomia e raciocínio de verdade, já que segue estruturas de aprendizado pré-definidas em vez de resolver problemas por conta própria.

AGI

Já a AGI é uma IA hipotética que consegue pensar, aprender e raciocinar como um ser humano em qualquer tarefa intelectual. Diferente da IA estreita, ela seria capaz de generalizar o conhecimento, melhorar de forma independente e buscar seus próprios objetivos de forma autônoma.

Se isso rolar, a IGA vai poder fazer qualquer função cognitiva que um humano consegue, revolucionando indústrias e desafiando limites éticos e filosóficos.

Superinteligência Artificial

Por fim, a Superinteligência Artificial (ASI) é um nível de IA que é ainda mais esperta do que a gente, em todas as habilidades cognitivas e de resolução de problemas. Esse é o tipo de IA que a gente conhece dos filmes de ficção científica, que, diferente da AGI, melhoraria rapidinho, inovaria além da compreensão humana e poderia até mudar setores e sociedades inteiras. Embora isso seja só uma visão do futuro por enquanto, os riscos que isso traz já merecem ser discutidos.

Onde estamos agora

Em 2025, ainda estaremos bem na fase da IA estreita. Com avanços como modelos de raciocínio como o o3 da OpenAI ou o R1 da DeepSeek e estruturas de agentes como o Manus AI ou ChatGPT Agent, estamos avançando da IA estreita para a IA ampla. Mesmo assim, a IGA continua sendo um objetivo que ainda não foi alcançado e precisa de avanços técnicos em autoaprendizagem, generalização e raciocínio.

Dificuldades e obstáculos para alcançar a AGI

Agora que já sabemos onde estamos e como é a AGI, como vamos do ponto A ao ponto B? Atualmente, existem vários desafios econômicos, técnicos e éticos a serem enfrentados.

Desafios econômicos

Não falta interesse em fazer a IA avançar para a realização da AGI. Os grandes players globais estão competindo muito pra ficar na frente em tecnologia, dominar o mercado e ter influência geopolítica. Em particular, a China e os Estados Unidos estão numa corrida que muita gente compara com a corrida espacial entre os EUA e a União Soviética nos anos 60.

Mas, o poder de processamento necessário pra chegar a um raciocínio parecido com o humano é enorme. A expansão dos centros de dados e a complexidade cada vez maior dos modelos devem aumentar bastante a demanda por energia. Os centros de dados que hospedam modelos de IA já representam cerca de 1 a 1,5% do consumo global de energia atualmente — um número que certamente aumentará com o tempo e o avanço do desenvolvimento.

Mesmo com os investimentos pesados em pesquisa de IA que rolam hoje em dia, os custos de computação e a escalabilidade continuam sendo problemas sérios no desenvolvimento da IGA. A solução para esses desafios pode estar em melhorar a eficiência e desenvolver fontes alternativas de energia.

Desafios técnicos

Do lado técnico, os desafios incluem identificar e mostrar o conhecimento implícito e a intuição, além de manter o conhecimento por muito tempo.

O conhecimento implícito, como causa e efeito ou normas sociais, muitas vezes não é dito, mas é importante para entender o contexto. A gente entende o que as coisas significam com base na experiência, nas regras culturais e em informações incompletas, mas essas suposições ficam escondidas para os sistemas de IA. Por isso, eles têm dificuldade em codificar e recuperar conhecimentos que não estão explicitamente expressos, enquanto os humanos incorporam naturalmente esses conhecimentos em suas decisões como senso comum.

Da mesma forma, a intuição é super importante na tomada de decisões humanas, mas também é difícil de formalizar em sistemas de IA. Muitas vezes, depende do reconhecimento de padrões subconscientes, do raciocínio abstrato e de insights baseados na experiência, nenhum dos quais pode ser facilmente reduzido a regras explícitas ou conjuntos de dados. Embora os modelos de aprendizado profundo possam chegar perto de julgamentos intuitivos em tarefas específicas, eles não têm aquele processo de aprendizado auto-reflexivo e adaptável que permite que a gente refine a intuição com o tempo.

Isso leva a outra questão, que é a falta de uma retenção de conhecimento a longo prazo parecida com a dos humanos nos modelos de IA. Diferente de nós, que aprendemos com o que já vivemos e vamos entendendo melhor as coisas, os modelos de IA têm dificuldade em guardar e atualizar o que aprenderam sem precisar ser treinados de novo de vez em quando. Os sistemas de IA atuais muitas vezes sofrem de esquecimento catastrófico, onde as informações recém-aprendidas podem sobrescrever ou degradar o conhecimento anterior, dificultando a manutenção de uma base de conhecimento estável e em evolução.

Desafios éticos

Garantir que a IGA esteja alinhada com os valores e objetivos humanos é um dos desafios mais urgentes no seu desenvolvimento, por causa de várias questões técnicas, éticas e sociais que estão todas ligadas. A interação entre as limitações técnicas, a complexidade inerente aos valores humanos e os altos riscos envolvidos tornam essa questão particularmente difícil de resolver.

Primeiro, os valores humanos são complexos e confusos por natureza. A questão do que é certo, apropriado ou errado varia bastante entre culturas, sociedades e contextos. Essa natureza multifacetada, junto com contradições ou compromissos (pense em equilibrar liberdade com segurança, por exemplo), contribui para a incerteza moral e, por isso, torna super desafiador transformar valores em objetivos operacionais claros para a AGI.

Mesmo se a gente pensar que existe uma estrutura moral bem definida para a IGA funcionar, ainda tem obstáculos técnicos relacionados ao alinhamento externo e interno.

É difícil transformar valores humanos em uma função objetiva precisa e matemática que uma IGA possa otimizar. A função precisa ser resistente à pressão da otimização, ou seja, não deve incentivar comportamentos indesejados quando a AGI otimiza agressivamente para eles — um cenário que o filósofo Nick Bostrom já descreveu em 2003. o filósofo Nick Bostrom já descreveu em 2003. Além disso, a AGI precisa ser capaz de se adaptar com base em novas informações sem se desviar dos objetivos pretendidos.

Os sistemas AGI são complexos e podem desenvolver processos internos difíceis de entender ou prever. Por exemplo, podem surgir objetivos que não estavam nos planos. Essa complexidade torna difícil garantir que as metas internas da AGI estejam alinhadas com seus objetivos específicos. Desenvolver métodos para analisar e controlar esses processos internos é essencial para alcançar o alinhamento interno.

Uma IAG mal alinhada pode agir de maneiras que vão contra os interesses humanos, com riscos que vão desde pequenas ineficiências até ameaças à existência da humanidade. Por exemplo, uma IGA pode buscar objetivos importantes, como poder ou recursos, que podem prejudicar a autonomia ou a segurança das pessoas. Além disso, os sistemas AGI podem ser usados por pessoas mal-intencionadas ou manipulados para fazer o contrário do que foram feitos.

Principalmente com a pressão da concorrência entre os grandes players globais pra desenvolver AGI rapidinho, é super importante ter medidas de segurança adequadas durante o desenvolvimento pra evitar consequências catastróficas. Para reduzir os riscos e aproveitar ao máximo os benefícios da IGA, é preciso ter uma colaboração entre várias áreas técnicas, ética e políticas.

Quando vamos chegar à IGA?

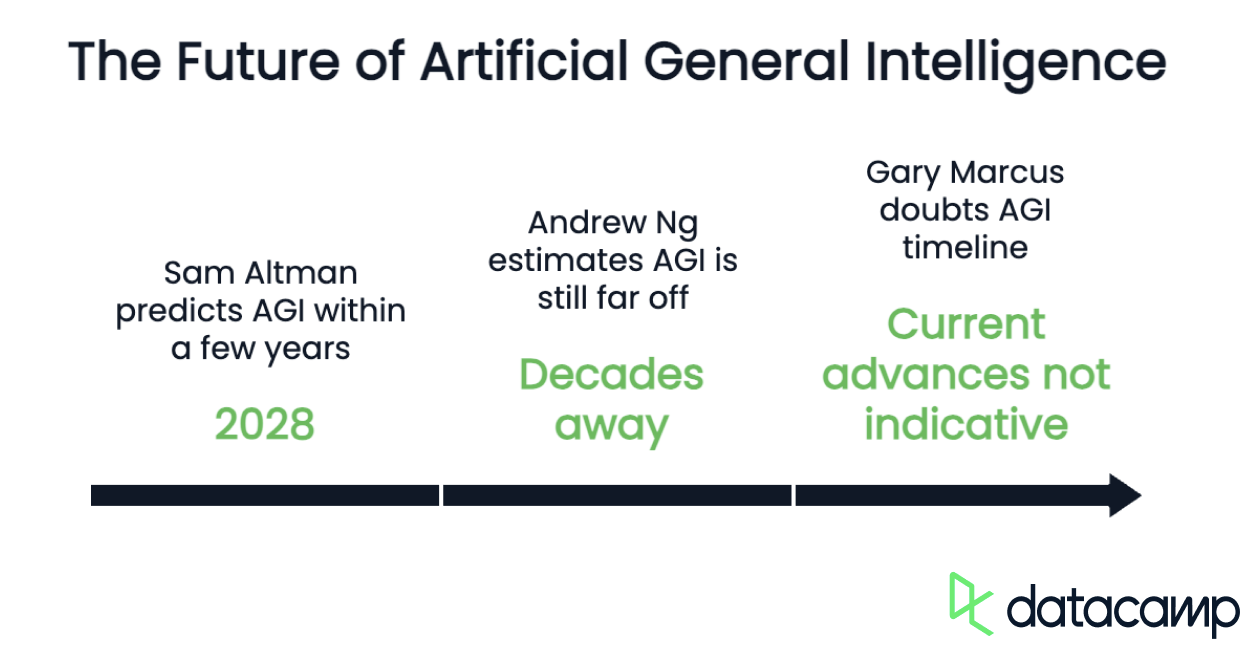

Os especialistas acham que ainda vai demorar anos, se não décadas, pra gente chegar lá, já que ainda temos que lidar com os desafios e os problemas técnicos que falamos no último capítulo. Enquanto a gente avança em deep learning, aprendizado por reforço e alinhamento de IA, a verdadeira IGA continua sendo mais um objetivo teórico do que uma realidade atual. Avanços em várias áreas, como IA neurosimbólica, arquiteturas de autoaprendizagem e computação mais eficiente, vão ser essenciais para o desenvolvimento da IGA.

Embora não dê pra dizer exatamente quando a AGI vai chegar, tem várias previsões de quem tá na frente nessa área da IA.

Uma das vozes otimistas é a do CEO da OpenAI, Sam Altman, que acha que a AGI pode ser alcançada nos próximos anos (até 2028). Ele diz que a tecnologia de IA tá avançando rápido e que os desafios de infraestrutura são bem pequenos comparados com os problemas técnicos.

Andrew Ng, um dos principais pesquisadores de IA e fundador do Google Brain, tem uma visão meio cética sobre o assunto. De acordo com a estimativa dele, a AGI ainda está “muitas décadas de distância, talvez até mais”. Ng diz que a AGI não é só um problema técnico, mas também precisa de avanços científicos importantes pra conseguir copiar a inteligência humana.

Mas tem gente que vê tudo ainda mais sombrio. Gary Marcus, professor de neurociência na Universidade de Nova York, dúvida das afirmações sobre o cronograma de desenvolvimento da IGA. Ele diz que os avanços atuais em IA, tipo o desenvolvimento de modelos de linguagem em grande escala, não querem dizer necessariamente que a AGI está chegando. Marcus diz que ainda tem uns problemas técnicos importantes e que a expansão das capacidades de treinamento e computação está quase no limite.

Como dá pra ver, os tempos e as probabilidades de ocorrência que a gente prevê dependem bastante da interpretação que a gente faz do termo. Por exemplo, Altman fala sobre a definição funcional e focada na autonomia da OpenAI, entendendo a AGI como “um sistema super autônomo que faz melhor do que a gente na maioria dos trabalhos que valem dinheiro”. Por outro lado, Ng e Marcus usam uma definição que inclui a replicação do raciocínio humano, que é a área mais desafiadora tecnicamente até agora.

Riscos e desafios éticos da AGI

A AGI pode causar uma grande confusão na economia por conseguir automatizar várias tarefas que a gente faz, podendo até substituir o trabalho humano em vários setores.

Desemprego em massa

Uma consequência ruim pode ser o desemprego em massa, já que os trabalhadores humanos em muitos empregos (principalmente os de escritório) podem ser substituídos. Se não forem bem gerenciadas, as mudanças econômicas rápidas causadas pela AGI podem levar a agitação social e instabilidade política.

Para diminuir essas mudanças, os políticos vão precisar criar estratégias que garantam que os benefícios da AGI sejam distribuídos de forma justa, protejam os trabalhadores de perderem seus empregos e promovam a estabilidade social e política. Isso pode envolver investir em programas de educação e reciclagem profissional, implementar políticas como a Renda Básica Universal (UBI) e promover a cooperação internacional para lidar com os impactos globais.

Preconceito

Preconceito e injustiça são outros riscos importantes associados à IGA, porque ela pode manter e aumentar as desigualdades sociais que já existem. Algoritmos tendenciosos podem prejudicar certos grupos, como minorias raciais ou de gênero, reforçando estereótipos e práticas discriminatórias, ou até mesmo criando novas formas de discriminação usando padrões nos dados que parecem neutros. Por exemplo, usar códigos postais como indicadores de raça pode levar a decisões tendenciosas.

Mesmo quando métricas de equidade de grupo são usadas, os sistemas AGI ainda podem discriminar subgrupos dentro de um grupo maior. Isso é conhecido como manipulação da justiça, em que algumas pessoas dentro de um grupo são tratadas de forma injusta, enquanto outras são compensadas para manter os indicadores gerais de justiça.

Riscos existenciais

Por fim, a IGA traz vários riscos existenciais, principalmente por poder ficar fora de controle ou não alinhada com os valores humanos. A IGA pode acabar superando a inteligência humana, criando uma superinteligência que pode querer fazer coisas ruins para a humanidade, o que pode acabar com a gente ou fazer a civilização perder o rumo pra sempre.

Cenários assustadores, alguns dos quais conhecidos de obras populares de ficção científica, incluem uma IAG que prioriza a aquisição de recursos em detrimento da vida humana, estabelece um regime totalitário ou facilita a criação de patógenos aprimorados.

Para diminuir esses riscos, os pesquisadores e os responsáveis pelas políticas públicas estão focados em criar estratégias de controle e alinhamento. Isso envolve criar proteções usando técnicas como projetar arquiteturas que limitam a autonomia da AGI ou criar ambientes “encaixotados” para impedir a fuga.

Para garantir que a IGA continue alinhada com os valores humanos, mesmo à medida que se aprimora, a pesquisa sobre alinhamento e desenvolvimento descentralizado da IGA deve ser priorizada para evitar a monopolização e promover a segurança.

Conclusão

Embora a AGI continue sendo uma meta de longo prazo, os avanços contínuos na pesquisa em IA continuam expandindo os limites do que as máquinas podem alcançar. O caminho para a AGI é cheio de desafios técnicos, econômicos e éticos, que exigem avanços no raciocínio, na adaptabilidade e no alinhamento com os valores humanos.

Se a IGA vai virar realidade nas próximas décadas ou continuar sendo só um conceito, o impacto que ela pode ter na sociedade, na indústria e na humanidade como um todo faz dela uma das coisas mais importantes que a gente está tentando descobrir hoje em dia.