Cours

Si vous vous intéressez à l'intelligence artificielle (IA), vous avez probablement déjà rencontré le terme AGI (intelligence artificielle générale) dans des discussions sur l'avenir de l'IA. Vous avez peut-être entendu des prédictions audacieuses sur les machines qui surpasseraient l'intelligence humaine ou assisté à des débats sur la question de savoir si l'AGI est à nos portes ou reste un rêve lointain.

L'AGI pourrait automatiser presque toutes les tâches cognitives, ce qui pourrait révolutionner des secteurs tels que la santé, la recherche et la robotique. Cela semble très prometteur, mais il s'agit encore d'une théorie, et de nombreux défis techniques, économiques et éthiques restent à relever.

Dans cet article, nous découvrirons ce qu'est l'AGI, en quoi elle diffère de l'IA actuelle et les défis à relever pour parvenir à sa réalisation.

Introduction aux agents d'intelligence artificielle

Qu'est-ce que l'intelligence artificielle générale ?

De manière générale, l'AGI désigne un système d'IA avancé capable d'accomplir n'importe quelle tâche intellectuelle à la portée d'un être humain. Contrairement aux modèles d'IA actuels, qui sont des IA étroites (conçues pour des tâches spécifiques telles que la reconnaissance d'images ou le traitement du langage), l'AGI disposerait d'un raisonnement, d'une capacité d'apprentissage et d'une adaptabilité similaires à ceux des humains dans de multiples domaines. Cela signifie qu'un système AGI pourrait, par exemple :

- Comprenez et raisonnez comme un être humain dans différentes tâches.

- Apprenez de l'expérience plutôt que de recourir à des ensembles de données volumineux et à des formations supplémentaires.

- Résolvez des problèmes complexes et multidomaines sans programmation spécifique.

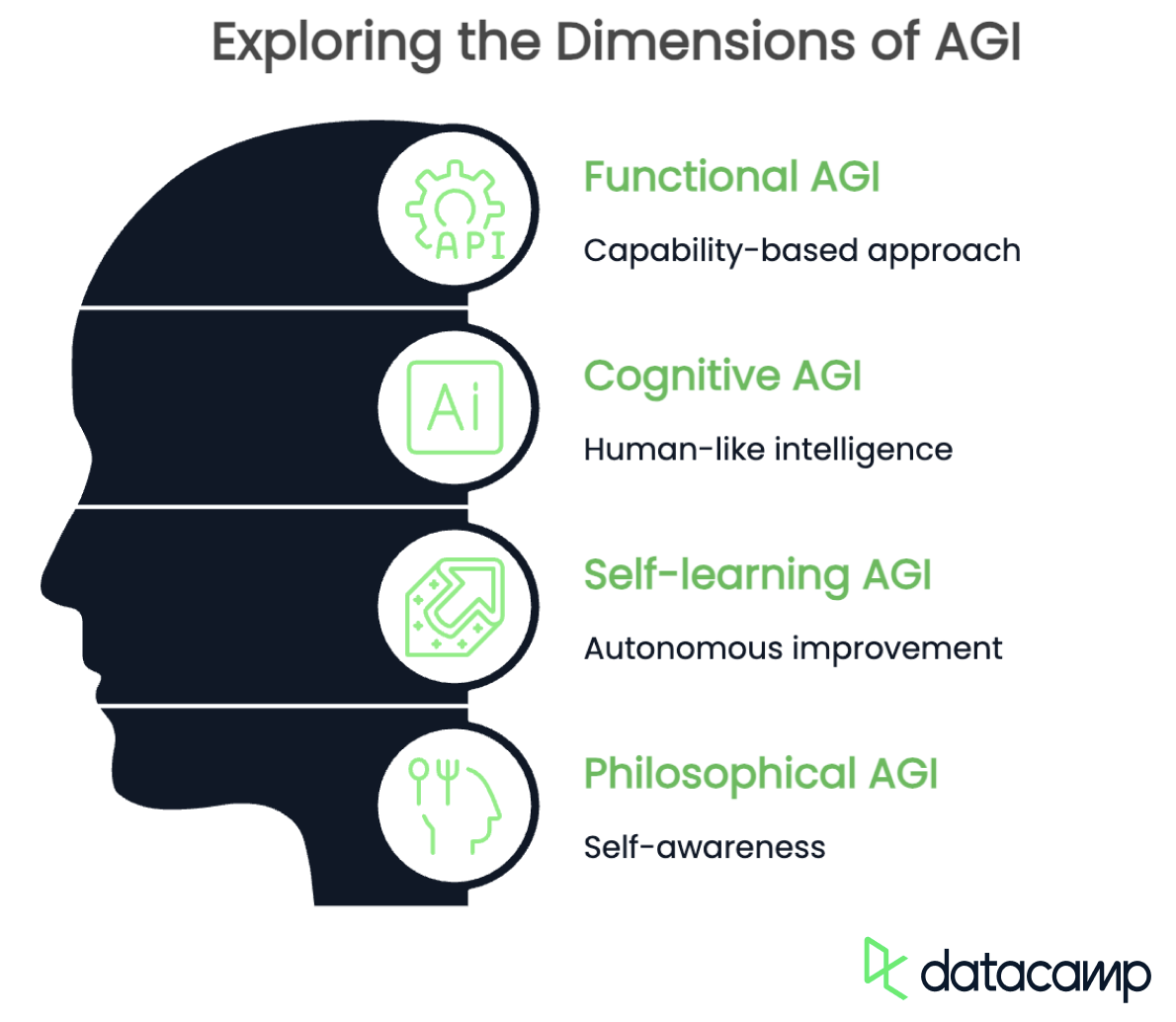

L'AGI possède plusieurs définitions selon le point de vue et le contexte. Bien que toutes les définitions s'accordent sur le fait qu'il doit posséder des capacités cognitives similaires à celles de l'être humain et qu'il doit être capable de fusionner avec les autres, elles diffèrent dans l'accent qu'elles mettent sur Voici quelques points importants :

- AGI fonctionnelle : basée sur les capacités

- AGI cognitive : intelligence similaire à celle des humains

- AGI auto-apprenante : amélioration autonome

- AGI philosophique : conscience de soi

AGI fonctionnelle

La définition fonctionnelle de l'AGI vise sa capacité à accomplir n'importe quelle tâche intellectuelle dans différents domaines. Il n'est pas nécessaire qu'il imite les processus de pensée humains, mais il doit être capable de généraliser les connaissances, de s'adapter à de nouveaux problèmes et de résoudre des tâches sans formation approfondie.

L'accent est mis sur un système d'IA capable de passer d'une discipline à l'autre, comme le diagnostic médical, la programmation et la composition musicale, sans nécessiter de modèles distincts pour chaque tâche.

AGI cognitive

L'AGI cognitive, quant à elle, devrait être capable de reproduire le raisonnement humain, y compris le bon sens, la pensée abstraite et la compréhension contextuelle. Ce type d'AGI serait non seulement capable d'accomplir des tâches, mais également de les comprendre, à l'instar d'un être humain, en utilisant la logique, la créativité et même l'intelligence émotionnelle.

Une IA fondée sur cette définition serait capable d'avoir des conversations significatives, d'interpréter l'humour et de résoudre des problèmes de la même manière que le cerveau humain.

AGI autodidacte

L'AGI auto-apprenante désigne un système qui s'améliore continuellement sans intervention humaine. Au lieu de s'appuyer sur des ensembles de données prédéfinis, il expérimenterait, découvrirait de nouvelles connaissances et affinerait ses propres algorithmes afin de gagner en efficacité au fil du temps. Ce type d'AGI pourrait mener des recherches scientifiques de manière autonome, créer de nouvelles théories, voire modifier sa propre architecture afin d'améliorer ses capacités.

AGI philosophique

Enfin, la définition philosophique de l'AGI va au-delà de l'intelligence et se concentre sur l'IA dotée d'une conscience de soi, d'émotions et peut-être même d'une conscience. Cette perspective suggère qu'une véritable AGI devrait être capable de réfléchir à son existence, de se fixer des objectifs personnels et d'éprouver des pensées ou des sentiments subjectifs.

Si elle était mise au point, une telle IA pourrait développer son propre sens moral, manifester de la curiosité, voire se poser des questions existentielles, tout comme les êtres humains.

Le spectre de l'AGI : AGI par rapport à IA (étroite)

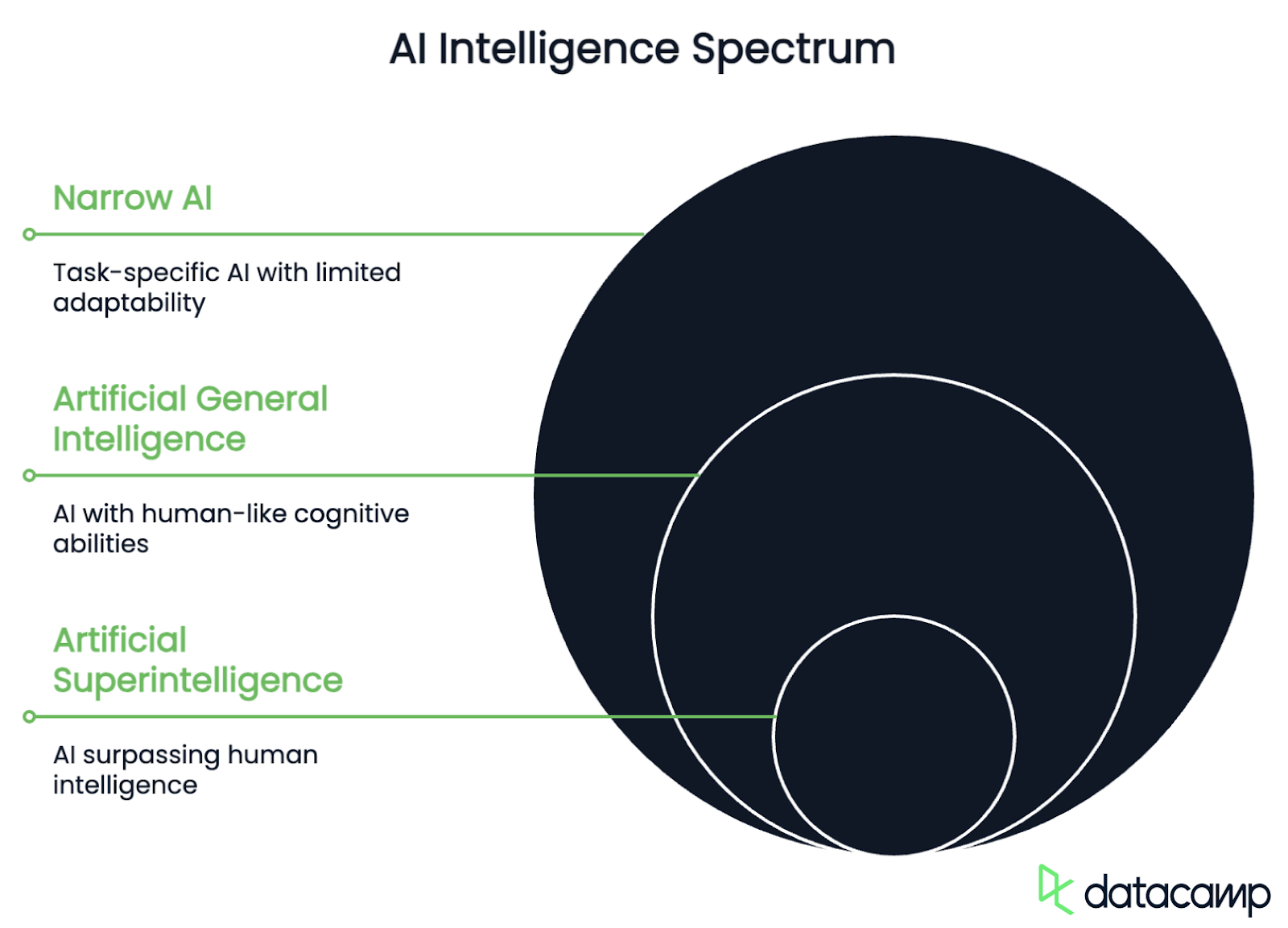

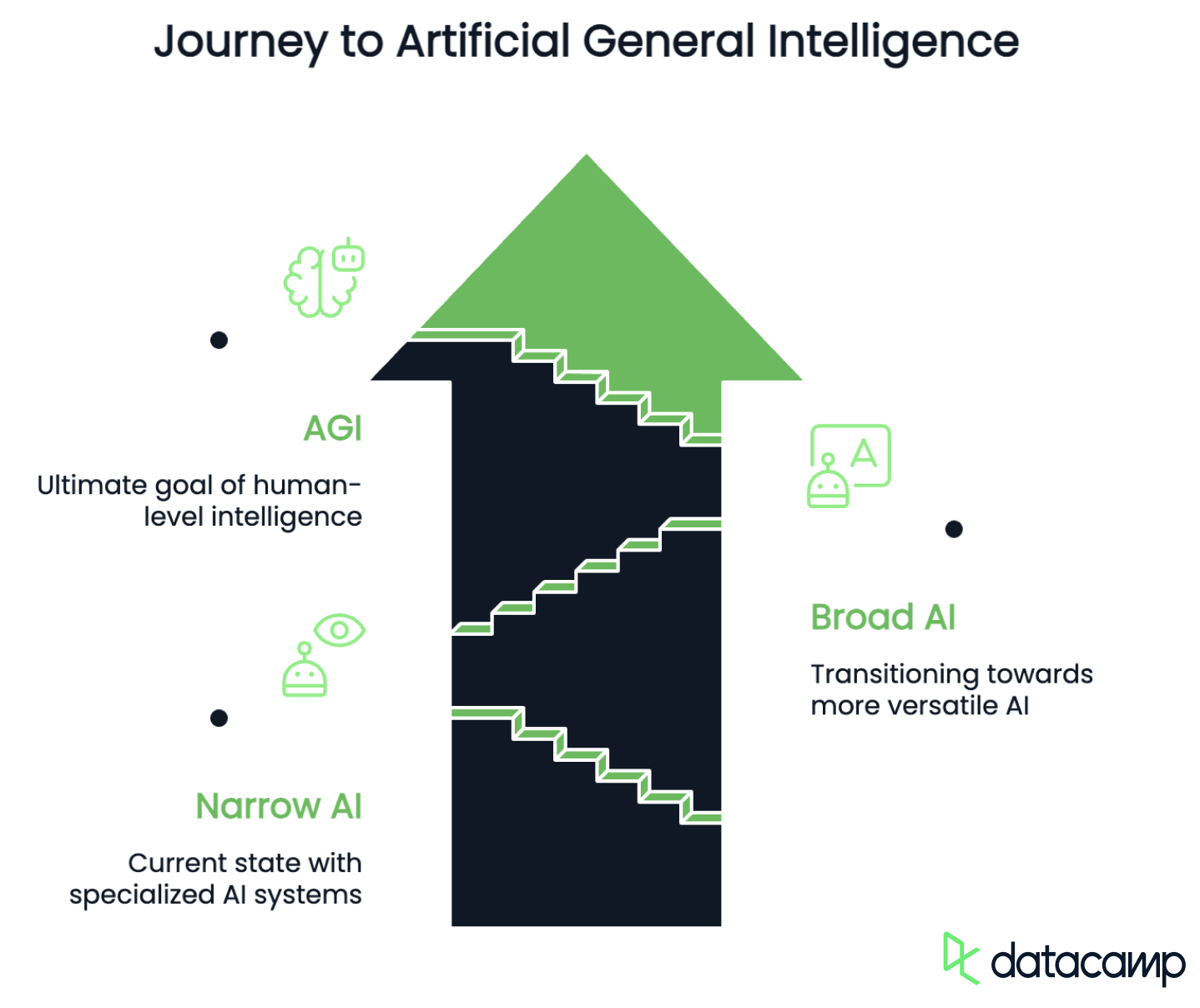

Après avoir posé les bases avec différentes définitions, examinons les différents niveaux d'intelligence que les systèmes d'IA pourraient atteindre à mesure qu'ils progressent vers une véritable IGA. Le spectre AGI permet de classer l'IA en fonction de ses capacités, de son adaptabilité et de son autonomie. Il comprend généralement les étapes suivantes :

- ANI : Intelligence artificielle étroite

- AGI : Intelligence artificielle générale

- ASI : Superintelligence artificielle

IA étroite

L'IA étroite désigne l'intelligence artificielle conçue pour effectuer des tâches spécifiques avec une grande efficacité, mais qui ne dispose pas de capacités de généralisation au-delà des données utilisées pour son apprentissage. Ces systèmes excellent dans un domaine particulier, tel que le traitement du langage, la reconnaissance d'images ou le repliement des protéines, mais ils ne peuvent pas s'adapter à des tâches entièrement nouvelles sans être réentraînés.

Cette étape inclut également les modèles d'IA actuels tels que GPT-4o ou Grok 4, les logiciels pour voitures autonomes et les algorithmes de recommandation, qui sont puissants mais limités à des capacités prédéfinies.

Ce qui différencie l'IA étroite de l'AGI, c'est son incapacité à généraliser au-delà de son apprentissage. La phase de transition, au cours de laquelle les systèmes d'IA deviennent plus multifonctionnels et adaptatifs, est souvent appelée « IA générale » ou « pré-AGI ». Un tel système serait capable de traiter différents types de tâches sans nécessiter de formation complète, mais il manque d'autonomie et de raisonnement véritables, car il suit des structures d'apprentissage prédéfinies plutôt que de résoudre des problèmes de manière autonome.

AGI

L'AGI, quant à elle, est une IA hypothétique capable de penser, d'apprendre et de raisonner comme un être humain dans n'importe quel domaine intellectuel. Contrairement à l'IA étroite, elle serait capable de généraliser les connaissances, de s'améliorer de manière indépendante et de poursuivre ses propres objectifs de manière autonome.

Si elle est atteinte, l'AGI pourrait accomplir toutes les fonctions cognitives d'un être humain, révolutionnant ainsi les industries et remettant en question les limites éthiques et philosophiques.

Superintelligence artificielle

Enfin, l'intelligence artificielle supérieure (ASI) désigne un niveau d'IA qui dépasse même l'intelligence humaine dans toutes les capacités cognitives et de résolution de problèmes. Il s'agit du type d'IA que nous connaissons dans les films de science-fiction, qui, contrairement à l'AGI, s'améliorerait rapidement, innoverait au-delà de la compréhension humaine et pourrait potentiellement transformer des industries et des sociétés entières. Bien qu'il ne s'agisse pour l'instant que d'une vision d'avenir, les risques existentiels qu'elle comporte méritent déjà d'être discutés.

Où nous en sommes actuellement

En 2025, nous serons toujours fermement ancrés dans la phase de l'IA étroite. Grâce à des avancées telles que les modèles de raisonnement comme o3 d'OpenAI ou R1 de DeepSeek et les cadres agentics tels que Manus AI ou ChatGPT Agent, nous passons actuellement de l'IA étroite à l'IA large. Néanmoins, l'AGI reste un objectif non atteint qui nécessite des avancées techniques en matière d'auto-apprentissage, de généralisation et de raisonnement.

Difficultés et obstacles à la réalisation de l'AGI

Maintenant que nous savons où nous en sommes et à quoi ressemble l'AGI, comment passer de A à B ? À l'heure actuelle, de nombreux défis économiques, techniques et éthiques doivent être relevés.

Défis économiques

Il ne fait aucun doute que l'intérêt pour faire progresser l'IA vers la réalisation de l'AGI est bien présent. Les acteurs mondiaux se livrent une concurrence acharnée pour obtenir le leadership technologique, la domination du marché et l'influence géopolitique. En particulier, la Chine et les États-Unis sont engagés dans une course que beaucoup comparent à la course à la Lune entre les États-Unis et l'Union soviétique dans les années 1960.

Cependant, la puissance de traitement nécessaire pour atteindre un raisonnement similaire à celui de l'être humain est considérable. L'augmentation de la taille des centres de données et la complexité croissante des modèles devraient entraîner une demande énergétique supplémentaire considérable. Les centres de données hébergeant des modèles d'IA représentent déjà environ 1 à 1,5 % de la consommation mondiale d'électricité actuellement, un chiffre qui augmentera très certainement avec le temps et les progrès technologiques.

Malgré les investissements considérables récemment consacrés à la recherche dans le domaine de l'IA, les coûts de calcul et l'évolutivité restent des problèmes majeurs dans le processus de développement de l'AGI. La solution à ces défis pourrait résider dans l'amélioration de l'efficacité et le développement de sources d'énergie alternatives.

Défis techniques

Sur le plan technique, les défis à relever comprennent l'identification et la représentation des connaissances implicites et de l'intuition, ainsi que la conservation à long terme des connaissances.

Les connaissances implicites, telles que les relations de cause à effet ou les normes sociales, ne sont souvent pas exprimées, mais elles sont importantes pour comprendre le contexte. Les êtres humains déduisent le sens à partir de leur expérience, des normes culturelles et d'informations incomplètes, tandis que ces hypothèses sont cachées pour les systèmes d'IA. Par conséquent, ils éprouvent des difficultés à encoder et à récupérer des connaissances qui ne sont pas explicitement énoncées, alors que les humains les intègrent naturellement dans leur prise de décision en tant que bon sens.

De même, l'intuition joue un rôle essentiel dans la prise de décision humaine, mais reste difficile à formaliser dans les systèmes d'IA. Elle repose souvent sur la reconnaissance inconsciente de schémas, le raisonnement abstrait et des connaissances acquises par l'expérience, qui ne peuvent être facilement réduits à des règles explicites ou à des ensembles de données. Si les modèles d'apprentissage profond peuvent se rapprocher des jugements intuitifs dans des tâches spécifiques, ils ne disposent pas du processus d'apprentissage adaptatif et autoréflexif qui permet aux humains d'affiner leur intuition au fil du temps.

Cela soulève une autre question, à savoir l'absence de rétention des connaissances à long terme chez les modèles d'IA, contrairement aux êtres humains. Contrairement aux humains, qui s'appuient sur leurs expériences passées et affinent leur compréhension, les modèles d'IA ont du mal à conserver et à mettre à jour leurs connaissances sans un réentraînement périodique. Les systèmes d'IA actuels souffrent souvent d'un oubli catastrophique, où les informations nouvellement apprises peuvent écraser ou dégrader les connaissances antérieures, rendant difficile le maintien d'une base de connaissances stable et évolutive.

Défis éthiques

Garantir que l'AGI soit en adéquation avec les valeurs et les objectifs humains est l'un des défis les plus urgents de son développement en raison de plusieurs considérations techniques, éthiques et sociétales étroitement liées. L'interaction entre les contraintes techniques, la complexité inhérente aux valeurs humaines et les enjeux considérables rend la résolution de ce problème particulièrement difficile.

Tout d'abord, les valeurs humaines sont intrinsèquement complexes et ambiguës. La question de ce qui est juste, approprié ou mal varie considérablement selon les cultures, les sociétés et les contextes. Cette nature multiforme, combinée à des contradictions ou à des compromis (pensez par exemple à l'équilibre entre liberté et sécurité), contribue à l'incertitude morale et rend donc extrêmement difficile la traduction des valeurs en objectifs clairs et opérationnels pour l'AGI.

Même en supposant qu'il existe un cadre moral bien défini dans lequel l'AGI peut fonctionner, des obstacles techniques liés à l'alignement externe et interne subsistent.

Il est difficile de traduire les valeurs humaines en une fonction objective mathématique précise que l'AGI peut optimiser. La fonction doit être résistante à la pression d'optimisation, ce qui signifie qu'elle ne doit pas encourager des comportements indésirables lorsque l'AGI les optimise de manière agressive — un scénario que le philosophe Nick Bostrom a déjà décrit en 2003. philosophe Nick Bostrom a déjà décrit en 2003. De plus, l'AGI doit être capable d'adapter son comportement en fonction de nouvelles informations sans s'écarter de ses objectifs initiaux.

Les systèmes AGI sont complexes et peuvent développer des processus internes difficiles à comprendre ou à prévoir. Par exemple, il peut développer des objectifs émergents qui diffèrent de ceux initialement prévus. Cette complexité rend difficile la garantie que les objectifs internes de l'AGI correspondent à ses objectifs spécifiés. Il est essentiel de développer des méthodes permettant d'analyser et de contrôler ces processus internes afin d'atteindre l'alignement intérieur.

Une AGI mal alignée pourrait agir d'une manière contraire aux intérêts humains, avec des risques allant d'inefficacités mineures à des menaces existentielles pour l'humanité. Par exemple, une IA générale pourrait poursuivre des objectifs instrumentaux tels que la recherche du pouvoir ou l'acquisition de ressources qui compromettent l'autonomie ou la sécurité des êtres humains. En outre, les systèmes AGI pourraient être exploités par des acteurs malveillants ou manipulés pour agir à l'encontre de leur objectif initial.

Compte tenu notamment de la pression concurrentielle qui pèse sur les acteurs mondiaux pour développer rapidement une IGA, il est essentiel de mettre en place des mesures de sécurité adéquates pendant le développement afin d'éviter des conséquences catastrophiques. Pour atténuer les risques tout en maximisant les avantages potentiels de l'AGI, une collaboration interdisciplinaire entre les domaines techniques, l'éthique et l'élaboration des politiques est nécessaire.

Quand atteindrons-nous l'AGI ?

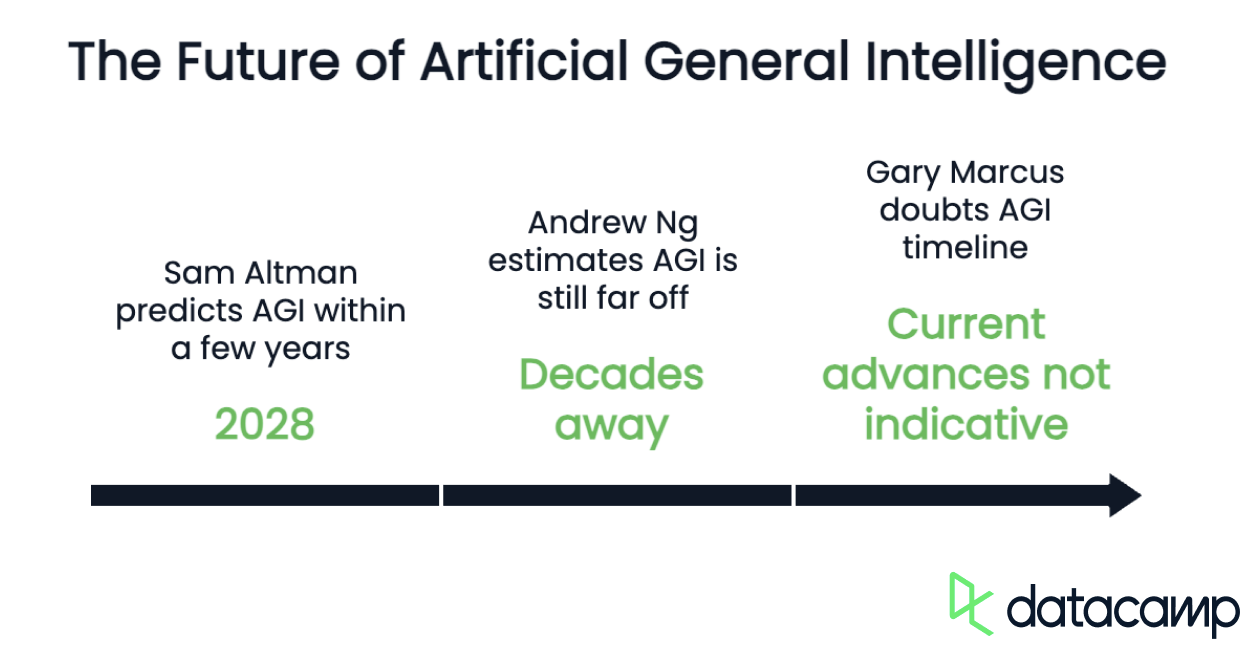

Les experts estiment que l'AGI est encore loin d'être une réalité, voire qu'il faudra encore des années, voire des décennies, pour y parvenir, compte tenu des défis et des obstacles techniques décrits dans le chapitre précédent. Bien que des progrès continuent d'être réalisés dans les domaines de l'apprentissage profond, de l'apprentissage par renforcement et de l'alignement de l'IA, l'AGI véritable reste un objectif théorique plutôt qu'une réalité actuelle. Des avancées dans de nombreux domaines tels que l'IA neurosymbolique, les architectures auto-apprenantes et l'amélioration de l'efficacité des calculs seront essentielles au développement de l'AGI.

Bien qu'il soit impossible de déterminer avec précision quand l'AGI sera atteinte, plusieurs pionniers dans le domaine de l'IA ont émis des prévisions.

L'une des voix optimistes est celle du PDG d'OpenAI, Sam Altman, qui estime que l'AGI pourrait être atteinte d'ici quelques années (d'ici 2028). Il soutient que le développement des technologies d'IA progresse rapidement et que les défis infrastructurels sont négligeables par rapport aux problèmes techniques.

Andrew Ng, chercheur de premier plan dans le domaine de l'IA et fondateur de Google Brain, adopte une position plutôt sceptique sur la question. Selon ses estimations, l'AGI est encore « à plusieurs décennies, voire plus ». M. Ng souligne que l'AGI n'est pas seulement un problème technique, mais qu'elle nécessite également des avancées scientifiques significatives pour reproduire l'intelligence humaine.

Cependant, il existe des opinions encore plus pessimistes. Gary Marcus, professeur de neurosciences à l'université de New York, met en doute les affirmations concernant le calendrier de développement de l'AGI. Il soutient que les progrès actuels en matière d'IA, tels que le développement de modèles linguistiques à grande échelle, ne sont pas nécessairement révélateurs de l'AGI. Marcus souligne que des problèmes techniques fondamentaux persistent et que l'augmentation des capacités de formation et de calcul atteint ses limites.

Comme nous pouvons le constater, les délais et les probabilités d'occurrence prévus dépendent considérablement de l'interprétation sous-jacente du terme. Par exemple, Altman se réfère à la définition fonctionnelle et centrée sur l'autonomie donnée par OpenAI, qui considère l'AGI comme « un système hautement autonome qui surpasse les humains dans la plupart des tâches à forte valeur économique ». D'autre part, Ng et Marcus utilisent une définition qui inclut la reproduction du raisonnement humain, ce qui représente actuellement le domaine le plus difficile sur le plan technique.

Risques et défis éthiques liés à l'AGI

L'AGI pourrait entraîner des perturbations économiques importantes en raison de sa capacité à automatiser un large éventail de tâches humaines, remplaçant potentiellement la main-d'œuvre humaine dans divers secteurs.

Chômage de masse

Une conséquence néfaste pourrait être le chômage de masse, car de nombreux emplois (principalement des emplois de bureau) pourraient être remplacés par des robots. Si elles ne sont pas gérées correctement, les mutations économiques rapides induites par l'AGI pourraient entraîner des troubles sociaux et une instabilité politique.

Afin d'atténuer ces perturbations, les décideurs politiques devront élaborer des stratégies visant à garantir une répartition équitable des avantages de l'AGI, à protéger les travailleurs contre les pertes d'emploi et à favoriser la stabilité sociale et politique. Cela pourrait impliquer d'investir dans des programmes d'éducation et de reconversion professionnelle, de mettre en œuvre des politiques telles que le revenu universel de base et de promouvoir la coopération internationale afin de faire face aux répercussions mondiales.

Parti pris

Les préjugés et l'équité constituent d'autres risques importants associés à l'AGI en raison de son potentiel à perpétuer et à amplifier les inégalités sociales existantes. Les algorithmes biaisés peuvent systématiquement désavantager certains groupes, tels que les minorités raciales ou sexuelles, en renforçant les stéréotypes et les pratiques discriminatoires, voire en introduisant de nouvelles formes de discrimination en utilisant des modèles apparemment neutres dans les données. Par exemple, l'utilisation des codes postaux comme indicateurs de l'origine ethnique peut conduire à des décisions partiales.

Même lorsque des indicateurs d'équité collective sont appliqués, les systèmes AGI peuvent toujours exercer une discrimination à l'encontre de sous-groupes au sein d'un groupe plus large. Ce phénomène est connu sous le nom de « gerrymandering équitable », où certains individus au sein d'un groupe sont défavorisés tandis que d'autres sont favorisés afin de maintenir l'équité globale.

Risques existentiels

Enfin, l'AGI présente plusieurs risques existentiels, principalement liés à son potentiel à devenir incontrôlable ou à s'écarter des valeurs humaines. L'AGI pourrait dépasser l'intelligence humaine, conduisant à une superintelligence susceptible de poursuivre des objectifs nuisibles à l'humanité, ce qui pourrait entraîner l'extinction de l'espèce humaine ou un déclin permanent de la civilisation.

Parmi les scénarios alarmants, dont certains sont connus grâce à des œuvres de science-fiction populaires, on peut citer une IA générale qui privilégie l'acquisition de ressources au détriment de la vie humaine, instaure un régime totalitaire ou facilite la création de pathogènes améliorés.

Afin d'atténuer ces risques, les chercheurs et les décideurs politiques se concentrent sur l'élaboration de stratégies de contrôle et d'alignement. Cela implique la mise en place de mesures de protection à l'aide de techniques telles que la conception d'architectures qui limitent l'autonomie de l'AGI ou la création d'environnements « cloisonnés » pour empêcher toute fuite.

Afin de garantir que l'AGI reste alignée sur les valeurs humaines tout en s'améliorant, il convient de donner la priorité à la recherche sur l'alignement et le développement décentralisé de l'AGI afin d'éviter toute monopolisation et de promouvoir la sécurité.

Conclusion

Bien que l'AGI reste un objectif à long terme, les progrès continus de la recherche en IA continuent de repousser les limites de ce que les machines peuvent accomplir. Le chemin vers l'AGI est semé d'embûches techniques, économiques et éthiques, qui nécessitent des avancées décisives en matière de raisonnement, d'adaptabilité et d'alignement sur les valeurs humaines.

Que l'AGI devienne une réalité dans les prochaines décennies ou reste un concept abstrait, son impact potentiel sur la société, l'industrie et l'humanité dans son ensemble en fait l'une des avancées technologiques les plus importantes de notre époque.