Kurs

Wenn du dich schon mal mit künstlicher Intelligenz (KI) beschäftigt hast, bist du wahrscheinlich in Diskussionen über die Zukunft der KI auf den Begriff AGI (Artificial General Intelligence) gestoßen. Vielleicht hast du schon mal kühne Vorhersagen gelesen, dass Maschinen die menschliche Intelligenz übertreffen werden, oder Debatten darüber, ob die allgemeine künstliche Intelligenz (AGI) schon vor der Tür steht oder noch ein ferner Traum ist.

AGI könnte fast jede kognitive Aufgabe automatisieren und damit Branchen wie das Gesundheitswesen, die Forschung und die Robotik total auf den Kopf stellen. Das klingt echt spannend – ist aber noch Theorie und es gibt noch viele technische, wirtschaftliche und ethische Probleme zu lösen.

In diesem Artikel erfahren wir, was AGI ist, wie sie sich von der heutigen KI unterscheidet und welche Herausforderungen auf dem Weg zu ihrer Verwirklichung zu bewältigen sind.

Einführung in KI-Agenten

Was ist künstliche allgemeine Intelligenz?

Im Allgemeinen geht es bei AGI um ein echt fortschrittliches KI-System, das alles machen kann, was ein Mensch mit seinem Verstand kann. Im Gegensatz zu den aktuellen KI-Modellen, die nur für bestimmte Aufgaben wie Bilderkennung oder Sprachverarbeitung gedacht sind, würde AGI wie ein Mensch denken, lernen und sich an verschiedene Bereiche anpassen können. Das heißt, ein AGI-System könnte zum Beispiel:

- Verstehe und denke wie ein Mensch bei verschiedenen Aufgaben.

- Lerne lieber aus Erfahrungen, statt riesige Datensätze und Umschulungen zu brauchen.

- Löse komplizierte Probleme aus verschiedenen Bereichen, ohne dass du dafür extra programmiert werden musst.

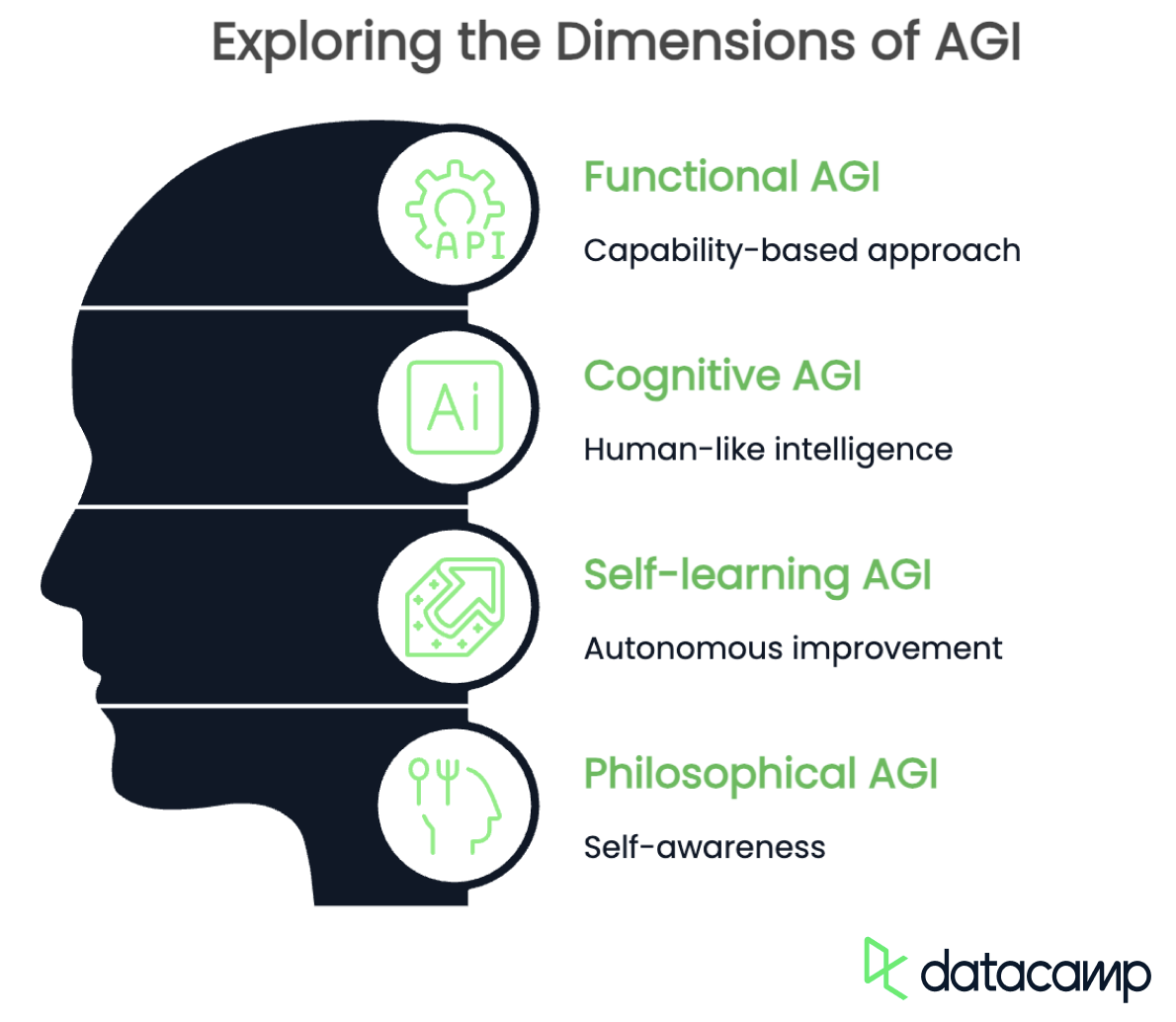

AGI hat mehrere Bedeutungen, je nachdem, wie man es sieht und wo man es benutzt. Alle Definitionen sagen zwar, dass es menschenähnliche kognitive Fähigkeiten haben und ineinander übergehen sollte, aber sie legen den Fokus auf unterschiedliche Sachen. Hier sind ein paar wichtige Punkte:

- Funktionale AGI: Fähigkeitsbasiert

- Kognitive AGI: menschliche Intelligenz

- Selbstlernende AGI: selbstständige Verbesserung

- Philosophische AGI: Selbstbewusstsein

Funktionale AGI

Die funktionale Definition von AGI zielt auf die Fähigkeit ab, jede intellektuelle Aufgabe in verschiedenen Bereichen zu erledigen. Es muss nicht wie ein Mensch denken, sondern sollte Wissen zusammenfassen, sich an neue Probleme anpassen und Aufgaben ohne viel Nachhilfe erledigen können.

Der Fokus liegt auf einem KI-System, das zwischen verschiedenen Bereichen wie der Diagnose von Krankheiten, der Programmierung und dem Komponieren von Musik wechseln kann, ohne dass für jede Aufgabe separate Modelle erforderlich sind.

Kognitive AGI

Kognitive AGI hingegen sollte in der Lage sein, menschenähnliches Denken nachzubilden, einschließlich gesunden Menschenverstands, abstraktem Denken und Kontextverständnis. Diese Art von AGI würde nicht nur Aufgaben erledigen, sondern sie auch verstehen, ähnlich wie ein Mensch, indem sie Logik, Kreativität und sogar emotionale Intelligenz einsetzt.

Eine KI, die auf dieser Definition basiert, könnte sinnvolle Gespräche führen, Humor verstehen und Probleme so lösen, wie es das menschliche Gehirn ganz natürlich macht.

Selbstlernende AGI

Selbstlernende AGI ist ein System, das sich ohne menschliches Zutun immer weiter verbessert. Anstatt sich auf vordefinierte Datensätze zu verlassen, würde es experimentieren, neues Wissen entdecken und seine eigenen Algorithmen verfeinern, um mit der Zeit immer effizienter zu werden. So eine AGI könnte selbstständig wissenschaftliche Forschung machen, neue Theorien entwickeln oder sogar ihre eigene Architektur anpassen, um besser zu werden.

Philosophische AGI

Schließlich geht die philosophische Definition von AGI über Intelligenz hinaus und konzentriert sich darauf, dass KI Selbstbewusstsein, Emotionen und möglicherweise sogar Bewusstsein besitzt. Diese Sichtweise legt nahe, dass eine echte AGI in der Lage sein sollte, über ihre Existenz nachzudenken, persönliche Ziele zu setzen und subjektive Gedanken oder Gefühle zu erleben.

Wenn das klappt, könnte so eine KI ihren eigenen moralischen Kompass entwickeln, Neugier zeigen oder sogar mit existenziellen Fragen kämpfen, so wie wir Menschen das tun.

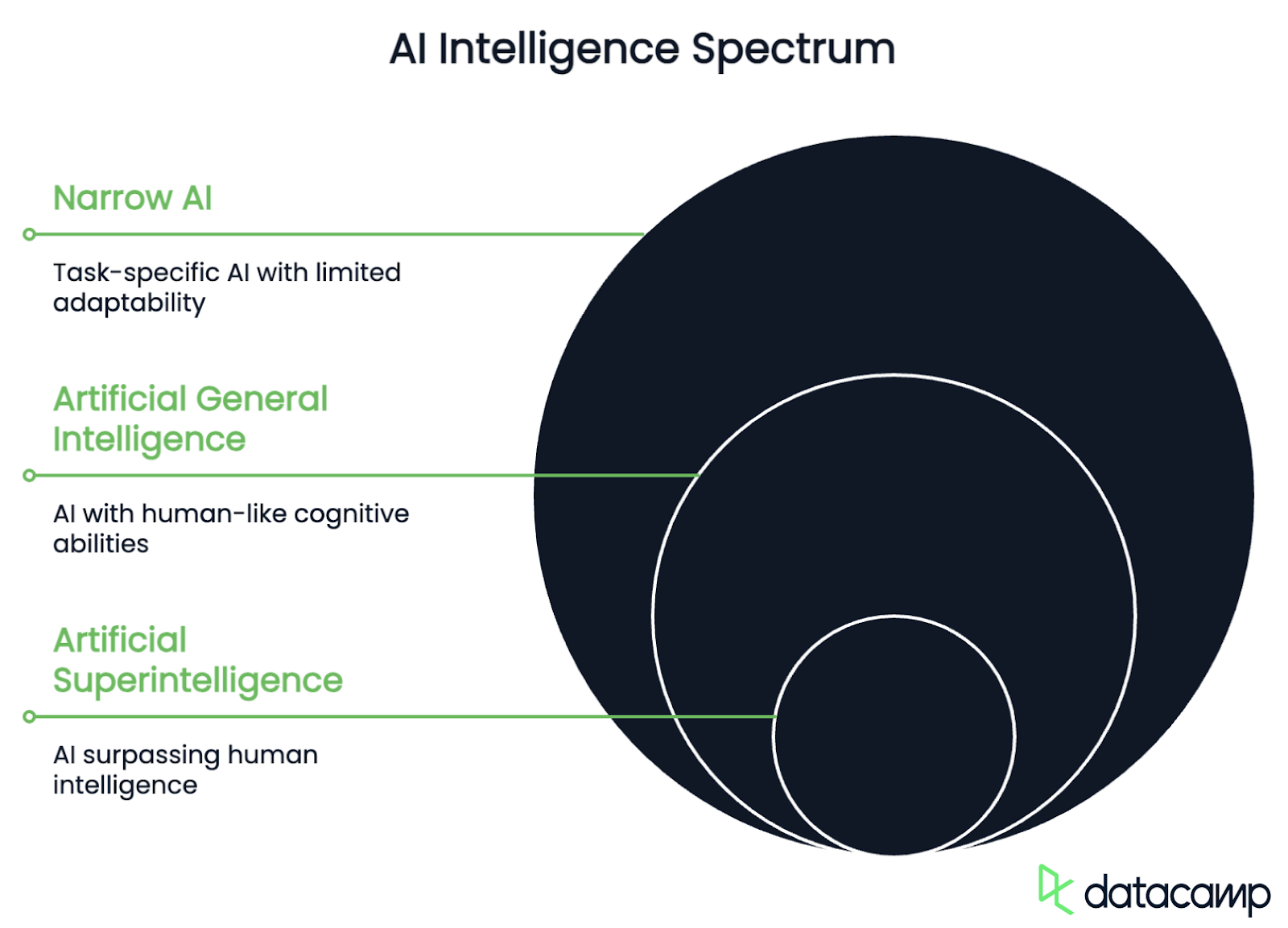

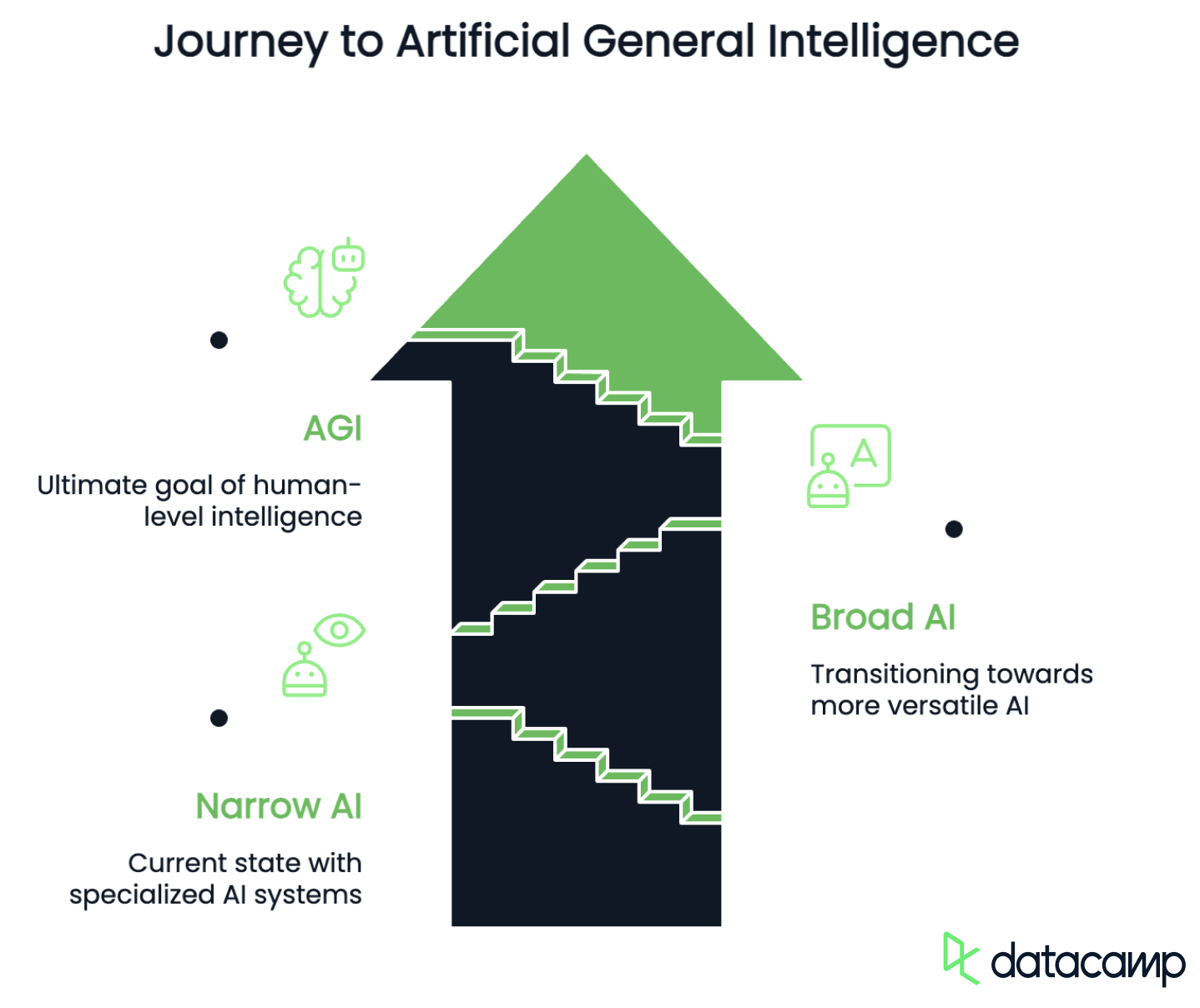

Das AGI-Spektrum: AGI vs. (Schmale) KI

Nachdem wir mit verschiedenen Definitionen die Grundlagen geschaffen haben, schauen wir uns mal die verschiedenen Intelligenzstufen an, die KI-Systeme auf ihrem Weg zur echten AGI erreichen können. Das AGI-Spektrum hilft dabei, KI nach ihren Fähigkeiten, ihrer Anpassungsfähigkeit und ihrer Autonomie zu kategorisieren. Im Allgemeinen umfasst es die folgenden Phasen:

- ANI: Künstliche enge Intelligenz

- AGI: Künstliche allgemeine Intelligenz

- ASI: Künstliche Superintelligenz

Schmale KI

Schmale KI ist künstliche Intelligenz, die bestimmte Aufgaben super effizient erledigen kann, aber nicht über ihre Trainingsdaten hinausgeht. Diese Systeme sind in einem Bereich super, wie Sprachverarbeitung, Bilderkennung oder Proteinfaltung, aber sie können sich nicht ohne neues Training an ganz neue Aufgaben anpassen.

Diese Phase umfasst auch aktuelle KI-Modelle wie GPT-4o oder Grok 4, Software für selbstfahrende Autos und Empfehlungsalgorithmen, die zwar leistungsstark, aber auf vordefinierte Funktionen beschränkt sind.

Was Narrow AI von AGI unterscheidet, ist, dass sie nicht über das hinaus, was sie gelernt hat, denken kann. Die Übergangsphase, in der KI-Systeme immer vielseitiger und anpassungsfähiger werden, wird oft als „Broad AI“ oder „Pre-AGI“ bezeichnet. So ein System könnte verschiedene Aufgaben erledigen, ohne dass man die Leute komplett neu trainieren muss, aber es fehlt ihm echte Autonomie und Denkvermögen, weil es vordefinierten Lernstrukturen folgt, anstatt Probleme selbstständig zu lösen.

AGI

AGI hingegen ist eine hypothetische KI, die wie ein Mensch denken, lernen und argumentieren kann, egal um welche intellektuelle Aufgabe es geht. Anders als bei der schmalen KI könnte sie Wissen verallgemeinern, sich selbstständig verbessern und ihre Ziele eigenständig verfolgen.

Wenn das klappt, könnte AGI alles machen, was ein Mensch kann, was die Industrie total auf den Kopf stellen und ethische und philosophische Grenzen in Frage stellen würde.

Künstliche Superintelligenz

Schließlich gibt es noch die künstliche Superintelligenz (ASI), die in allen kognitiven Fähigkeiten und bei der Problemlösung sogar besser ist als wir Menschen. Das ist die Art von KI, die wir aus Science-Fiction-Filmen kennen. Im Gegensatz zur AGI würde sie sich schnell verbessern, Innovationen entwickeln, die wir nicht verstehen, und möglicherweise ganze Branchen und Gesellschaften verändern. Auch wenn das im Moment nur eine Zukunftsvision ist, sind die Risiken, die damit verbunden sind, schon jetzt eine Diskussion wert.

Wo wir jetzt stehen

Bis 2025 sind wir immer noch fest in der Phase der schmalen KI. Mit Fortschritten wie den Argumentationsmodellen von OpenAI's o3 oder DeepSeeks R1 und agentenbasierten Frameworks wie Manus AI oder ChatGPT Agententwickeln wir gerade Narrow AI zu Broad AI weiter. Trotzdem ist AGI immer noch ein Ziel, das wir noch nicht erreicht haben und für das wir technische Durchbrüche in Sachen Selbstlernen, Verallgemeinerung und Schlussfolgerungen brauchen.

Schwierigkeiten und Hindernisse auf dem Weg zur AGI

Jetzt, wo wir wissen, wo wir stehen und wie AGI aussieht, wie kommen wir von A nach B? Im Moment gibt's noch ein paar wirtschaftliche, technische und ethische Probleme, die gelöst werden müssen.

Wirtschaftliche Herausforderungen

Es gibt echt kein Mangel an Interesse daran, KI weiter in Richtung AGI zu entwickeln. Die großen Unternehmen auf der ganzen Welt kämpfen hart um die Führung in der Technologie, um Marktanteile und um geopolitischen Einfluss. Vor allem China und die USA sind in einem Wettlauf, den viele mit dem Wettlauf zum Mond zwischen den USA und der Sowjetunion in den 1960er Jahren vergleichen.

Allerdings ist die Rechenleistung, die man braucht, um menschenähnliches Denken hinzukriegen, echt krass. Die Größe von Rechenzentren wird immer größer und die Modelle werden immer komplizierter, was wahrscheinlich zu einem riesigen zusätzlichen Energiebedarf führen wird. Rechenzentren, die KI-Modelle hosten, machen schon jetzt etwa 1 bis 1,5 % des weltweiten Stromverbrauchs – eine Zahl, die mit der Zeit und der Weiterentwicklung sicher steigen wird.

Trotz der vielen Investitionen, die in letzter Zeit in die KI-Forschung geflossen sind, sind Rechenkosten und Skalierbarkeit immer noch echte Probleme bei der Entwicklung von AGI. Die Lösung für diese Probleme könnte in Effizienzsteigerungen und der Entwicklung von alternativen Energiequellen liegen.

Technische Herausforderungen

Technisch gesehen sind die Herausforderungen die Identifizierung und Darstellung von implizitem Wissen und Intuition sowie die langfristige Speicherung von Wissen.

Implizites Wissen, wie zum Beispiel Ursache und Wirkung oder soziale Normen, wird oft nicht ausgesprochen, ist aber wichtig, um den Kontext zu verstehen. Menschen leiten Bedeutung aus Erfahrungen, kulturellen Normen und unvollständigen Infos ab, während diese Annahmen für KI-Systeme nicht sichtbar sind. Deshalb haben sie Probleme damit, Wissen, das nicht klar gesagt wird, zu speichern und abzurufen, während wir Menschen das ganz natürlich als gesunden Menschenverstand in unsere Entscheidungen einbauen.

Genauso ist Intuition super wichtig, wenn wir Entscheidungen treffen, aber es ist echt schwierig, das in KI-Systemen zu erklären. Das hängt oft von unbewussten Mustern, abstraktem Denken und Erfahrungen ab, die man nicht einfach in Regeln oder Daten packen kann. Deep-Learning-Modelle können zwar intuitive Entscheidungen bei bestimmten Aufgaben ziemlich gut nachahmen, aber ihnen fehlt der selbstreflexive, adaptive Lernprozess, der es uns Menschen ermöglicht, unsere Intuition mit der Zeit zu verfeinern.

Das führt zu einem anderen Problem, nämlich dass KI-Modelle nicht so wie wir Menschen Wissen langfristig behalten können. Im Gegensatz zu uns Menschen, die auf Erfahrungen aufbauen und unser Verständnis verbessern, haben KI-Modelle echt Probleme, Wissen zu behalten und zu aktualisieren, wenn sie nicht regelmäßig neu trainiert werden. Aktuelle KI-Systeme haben oft mit katastrophalem Vergessen zu kämpfen, bei dem neu gelernte Infos vorheriges Wissen überschreiben oder verschlechtern können, was es schwierig macht, eine stabile, sich weiterentwickelnde Wissensbasis aufrechtzuerhalten.

Ethische Herausforderungen

Sicherzustellen, dass AGI mit menschlichen Werten und Zielen im Einklang steht, ist eine der größten Herausforderungen bei ihrer Entwicklung, weil dabei viele technische, ethische und gesellschaftliche Aspekte zusammenkommen. Das Zusammenspiel von technischen Einschränkungen, der Komplexität menschlicher Werte und den hohen Risiken macht es besonders schwierig, dieses Problem zu lösen.

Zuerst mal sind menschliche Werte von Natur aus komplex und nicht eindeutig. Die Frage, was richtig, angemessen oder falsch ist, ist in verschiedenen Kulturen, Gesellschaften und Kontexten ziemlich unterschiedlich. Diese Vielschichtigkeit, zusammen mit Widersprüchen oder Kompromissen (man denke zum Beispiel an das Gleichgewicht zwischen Freiheit und Sicherheit), sorgt für moralische Unsicherheit und macht es extrem schwierig, Werte in klare, umsetzbare Ziele für AGI zu übersetzen.

Selbst wenn wir davon ausgehen, dass es einen klaren moralischen Rahmen für die AGI gibt, bleiben technische Hindernisse in Bezug auf die äußere und innere Ausrichtung bestehen.

Es ist echt schwierig, menschliche Werte in eine genaue, mathematische Zielfunktion zu übersetzen, die eine AGI optimieren kann. Die Funktion muss robust gegenüber Optimierungsdruck sein, d. h. sie sollte keine unbeabsichtigten Verhaltensweisen fördern, wenn die AGI diese aggressiv optimiert – ein Szenario, das der Philosoph Nick Bostrom bereits 2003 beschrieben hat. der Philosoph Nick Bostrom bereits 2003 beschrieben hat. Außerdem muss die AGI in der Lage sein, ihr Verhalten anhand neuer Infos anzupassen, ohne dabei von ihren Zielen abzuweichen.

AGI-Systeme sind ziemlich kompliziert und können interne Abläufe entwickeln, die schwer zu verstehen oder vorherzusagen sind. Zum Beispiel können neue Ziele auftauchen, die sich von den geplanten unterscheiden. Diese Komplexität macht es schwierig, sicherzustellen, dass die internen Ziele der AGI mit den festgelegten Zielen übereinstimmen. Die Entwicklung von Methoden zur Analyse und Steuerung dieser internen Prozesse ist super wichtig, um innere Ausrichtung zu erreichen.

Eine falsch ausgerichtete AGI könnte auf eine Weise handeln, die den Interessen der Menschen zuwiderläuft, wobei die Risiken von geringfügigen Ineffizienzen bis hin zu existenziellen Bedrohungen für die Menschheit reichen. Zum Beispiel könnte eine AGI instrumentelle Ziele wie Machtstreben oder Ressourcenbeschaffung verfolgen, die die Autonomie oder Sicherheit von Menschen gefährden. Außerdem könnten AGI-Systeme von bösen Leuten ausgenutzt oder so manipuliert werden, dass sie nicht mehr so funktionieren, wie sie eigentlich sollen.

Gerade weil die großen Unternehmen auf der ganzen Welt schnell eine AGI entwickeln wollen, sind gute Sicherheitsmaßnahmen während der Entwicklung super wichtig, um katastrophale Folgen zu vermeiden. Um die Risiken zu verringern und gleichzeitig die potenziellen Vorteile der AGI zu maximieren, ist eine interdisziplinäre Zusammenarbeit zwischen Technik, Ethik und Politik erforderlich.

Wann werden wir AGI erreichen?

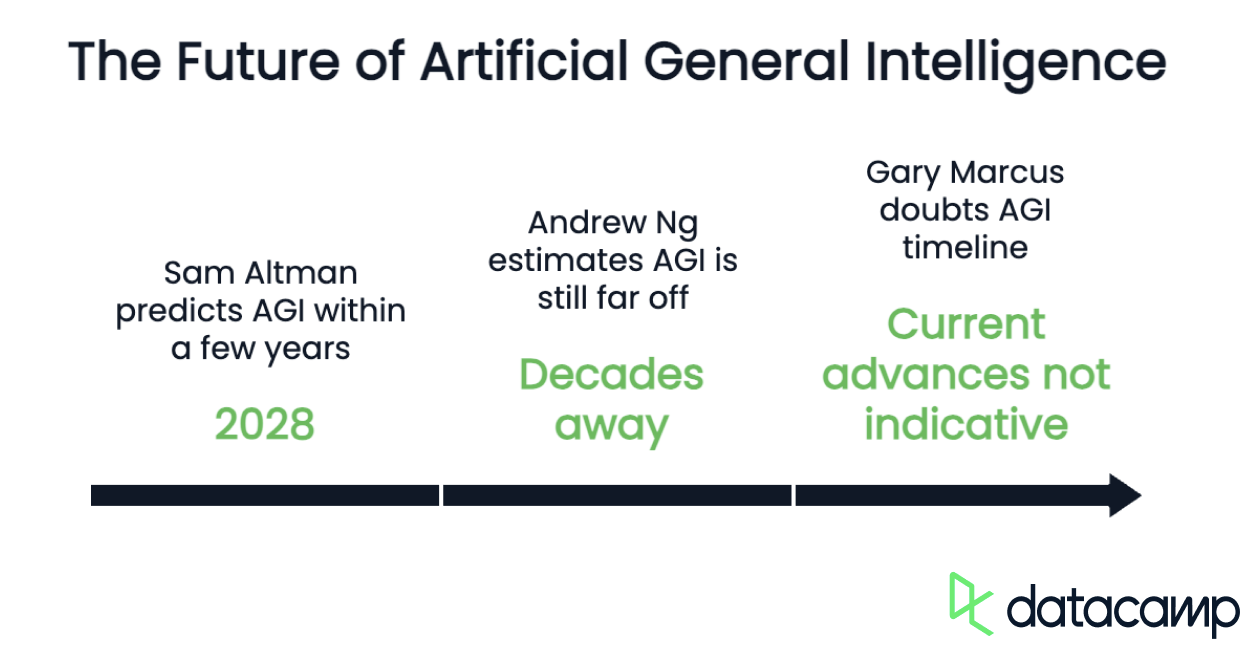

Experten denken, dass es noch Jahre, wenn nicht Jahrzehnte dauern wird, bis wir AGI haben, weil wir noch mit den Herausforderungen und technischen Hindernissen aus dem letzten Kapitel klären müssen. Auch wenn es bei Deep Learning, Reinforcement Learning und der Ausrichtung von KI immer besser wird, ist echte AGI noch eher ein theoretisches Ziel als eine aktuelle Realität. Durchbrüche in verschiedenen Bereichen wie neurosymbolische KI, selbstlernende Architekturen und effizientere Berechnungen werden für die Entwicklung der AGI echt wichtig sein.

Es ist zwar unmöglich, einen genauen Zeitpunkt für die Erreichung der AGI zu nennen, aber es gibt ein paar Prognosen von Leuten, die in diesem Bereich ganz vorne mit dabei sind.

Einer der Optimisten ist Sam Altman, der Chef von OpenAI. Er denkt, dass AGI schon in den nächsten Jahren möglich sein könnte. innerhalb der nächsten Jahre (bis 2028) erreicht werden könnte. Er meint, dass die KI-Technologie echt schnell vorankommt und die Probleme mit der Infrastruktur im Vergleich zu den technischen Herausforderungen nicht so schlimm sind.

Andrew Ng, ein bekannter KI-Forscher und Gründer von Google Brain, sieht das Ganze eher skeptisch. Seiner Einschätzung nach ist AGI noch „noch viele Jahrzehnte entfernt, vielleicht sogar noch länger“. Ng betont, dass AGI nicht nur ein technisches Problem ist, sondern auch echt große wissenschaftliche Durchbrüche braucht, um menschliche Intelligenz nachzumachen.

Aber es gibt auch noch pessimistischere Ansichten. Gary Marcus, Professor für Neurowissenschaften an der New York University, zweifelt an den Aussagen zum Zeitplan für die Entwicklung der AGI. Er meint, dass die aktuellen Fortschritte in der KI, wie zum Beispiel die Entwicklung von großen Sprachmodellen, nicht unbedingt auf eine AGI hindeuten. Marcus betont, dass es immer noch grundlegende technische Probleme gibt und dass die Skalierung von Trainings- und Rechenkapazitäten langsam an ihre Grenzen stößt.

Wie wir sehen können, hängen die vorhergesagten Zeiten und Wahrscheinlichkeiten, dass etwas passiert, ziemlich stark davon ab, wie man den Begriff versteht. Altman nimmt zum Beispiel die funktionale und auf Autonomie fokussierte Definition von OpenAI und sieht AGI als „ein super autonomes System, das Menschen bei den meisten wirtschaftlich wichtigen Aufgaben übertrifft“. Ng und Marcus hingegen verwenden eine Definition, die die Nachahmung menschenähnlicher Denkprozesse einschließt, was derzeit technisch gesehen die größte Herausforderung darstellt.

Risiken und ethische Herausforderungen der AGI

AGI kann echt große wirtschaftliche Probleme machen, weil es viele Sachen, die wir normalerweise machen, automatisch erledigen kann und so in vielen Bereichen die Arbeit von Menschen ersetzen könnte.

Masseneinstellung

Eine schlimme Folge könnte Massenarbeitslosigkeit sein, weil viele Jobs (vor allem Bürojobs) von Maschinen übernommen werden könnten. Wenn man das nicht richtig im Griff hat, könnten die schnellen wirtschaftlichen Veränderungen durch AGI zu sozialen Unruhen und politischer Instabilität führen.

Um diese Probleme zu mildern, müssen die Politiker Strategien entwickeln, die dafür sorgen, dass die Vorteile der AGI fair verteilt werden, die Arbeitnehmer vor dem Verlust ihrer Jobs geschützt werden und die soziale und politische Stabilität gefördert wird. Das könnte bedeuten, dass man in Bildung und Umschulungsprogramme investiert, Maßnahmen wie das BGE einführt und die internationale Zusammenarbeit fördert, um globale Auswirkungen anzugehen.

Voreingenommenheit

Voreingenommenheit und Fairness sind weitere wichtige Risiken, die mit AGI verbunden sind, weil sie bestehende soziale Ungleichheiten aufrechterhalten und verstärken können. Voreingenommene Algorithmen können bestimmte Gruppen, wie zum Beispiel ethnische oder geschlechtliche Minderheiten, systematisch benachteiligen, indem sie Stereotypen und diskriminierende Praktiken verstärken oder sogar neue Formen der Diskriminierung einführen, indem sie scheinbar neutrale Muster in Daten nutzen. Wenn man zum Beispiel Postleitzahlen als Ersatz für die ethnische Zugehörigkeit nimmt, kann das zu unfairen Entscheidungen führen.

Selbst wenn man Fairness-Maßstäbe für Gruppen anwendet, können AGI-Systeme immer noch bestimmte Untergruppen innerhalb einer größeren Gruppe benachteiligen. Das nennt man „Fairness-Gerrymandering“, wo einige Leute in einer Gruppe schlechter behandelt werden, während andere das ausgleichen, um die Fairness insgesamt zu halten.

Existenzielle Risiken

Schließlich birgt AGI einige existenzielle Risiken, vor allem weil sie außer Kontrolle geraten oder nicht mehr mit menschlichen Werten übereinstimmen könnte. AGI könnte die menschliche Intelligenz übertreffen und zu einer Superintelligenz führen, die Ziele verfolgt, die der Menschheit schaden könnten, was zum Aussterben der Menschheit oder einem dauerhaften Niedergang der Zivilisation führen könnte.

Beängstigende Szenarien, von denen einige aus beliebten Science-Fiction-Werken bekannt sind, umfassen eine AGI, die die Beschaffung von Ressourcen über Menschenleben stellt, eine totalitäre Herrschaft errichtet oder die Entwicklung verbesserter Krankheitserreger ermöglicht.

Um diese Risiken zu verringern, arbeiten Forscher und Politiker daran, Strategien zur Kontrolle und Anpassung zu entwickeln. Dazu muss man Sicherheitsmaßnahmen einbauen, zum Beispiel durch das Entwerfen von Architekturen, die die Autonomie der AGI einschränken, oder durch das Erstellen von „abgeschotteten“ Umgebungen, die ein Entkommen verhindern.

Damit AGI auch bei ihrer Weiterentwicklung immer mit menschlichen Werten im Einklang bleibt, sollte die Forschung zu Alignment und dezentraler AGI-Entwicklung ganz oben auf der Liste stehen, um Monopole zu vermeiden und die Sicherheit zu fördern.

Fazit

Auch wenn AGI noch ein langfristiges Ziel ist, werden durch die ständigen Fortschritte in der KI-Forschung die Grenzen dessen, was Maschinen erreichen können, immer weiter verschoben. Der Weg zur AGI ist mit technischen, wirtschaftlichen und ethischen Herausforderungen gepflastert und erfordert Durchbrüche in den Bereichen Argumentation, Anpassungsfähigkeit und Übereinstimmung mit menschlichen Werten.

Ob AGI in ein paar Jahrzehnten echt Realität wird oder nur ein cooler Gedanke bleibt, ist egal – die möglichen Auswirkungen auf die Gesellschaft, die Industrie und die ganze Menschheit machen es zu einem der wichtigsten technologischen Ziele unserer Zeit.