programa

Las tecnologías de big data son esenciales, ya que el volumen y la complejidad de los datos que generan las empresas aumentan cada día. Las herramientas tradicionales no son suficientes para gestionar grandes volúmenes de datos, y ahí es donde estas tecnologías permiten una gestión eficiente de los datos y la extracción de información que impulsa la toma de decisiones informadas. Mantenerse al día con las últimas herramientas y tendencias es fundamental para los profesionales interesados en desarrollar o acelerar su carrera en este ámbito.

¿Qué es la tecnología de big data?

La tecnología de big data hace referencia a las herramientas y los marcos que procesan, almacenan y analizan conjuntos de datos complejos y de gran tamaño.

Según Gartner, ladefinición de big data es «activos de información de gran volumen, alta velocidad y gran variedad que exigen formas rentables e innovadoras de procesamiento de la información para mejorar el conocimiento y la toma de decisiones».

Características del Big Data. Fuente de la imagen: Autor

- Volumen: El volumen de datos ha crecido a una escala enorme. Cada segundo se generan enormes cantidades de datos procedentes de las redes sociales, sensores, transacciones financieras y otras fuentes. Gestionar un volumen de esta magnitud requiere sistemas de almacenamiento avanzados y una potencia de procesamiento escalable para mantener el ritmo.

- Variedad: Los datos se presentan en todas las formas. Puede estructurarse, como datos perfectamente organizados en hojas de cálculo y bases de datos. O puede ser no estructurado, como texto, imágenes, vídeos y publicaciones en redes sociales que no encajan en un formato sencillo. Luego también tenemos datos semiestructurados, como archivos JSON y XML, que se encuentran en un término medio. Cada tipo de datos requiere enfoques diferentes para analizarlos y darles sentido.

- A continuación está la velocidad, que se refiere a la rapidez con la que se generan los datos y deben procesarse. Con los dispositivos IoT (Internet de las cosas) y las transmisiones en tiempo real de las redes sociales y las transacciones financieras, la capacidad de capturar, procesar y analizar rápidamente estos datos se ha vuelto fundamental para tomar decisiones oportunas.

- Veracidad: Es fundamental asegurarse de que los datos sean precisos y fiables, ya que los datos erróneos pueden dar lugar a decisiones equivocadas e incluso perjudicar a una empresa. Pero, al mismo tiempo, si nos esforzamos demasiado por conseguir datos perfectos, eso puede ralentizar las cosas y provocar retrasos en la toma de decisiones. Por lo tanto, hay que encontrar un equilibrio perfecto en consonancia con la sensibilidad empresarial.

Las tecnologías de big data permiten a las organizaciones gestionar de forma eficiente datos estructurados y no estructurados y obtener información significativa. Dado que los datos son un activo estratégico, las tecnologías de big data se han vuelto esenciales para mantener una ventaja competitiva sostenible en sectores como la sanidad, las finanzas y el comercio minorista. El big data ya no es un requisito técnico, sino que se ha convertido en una necesidad empresarial.

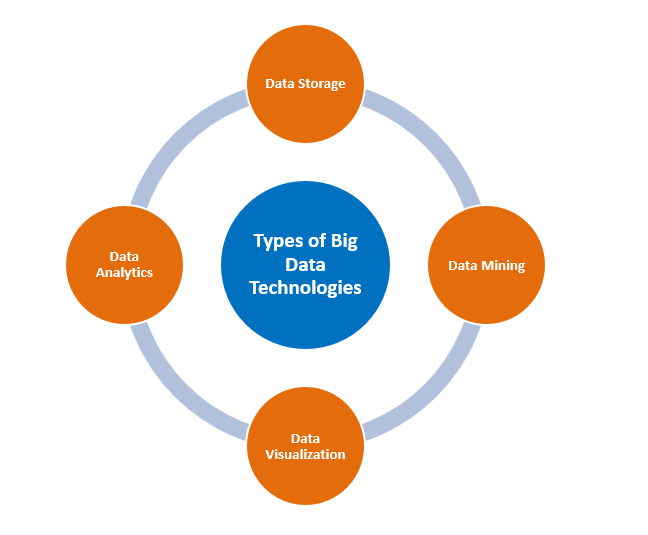

Tipos de tecnologías de big data

Tipos de tecnologías de big data. Fuente de la imagen: Autor

Almacenamiento de datos

Apache Hadoop

Hadoop es un marco de código abierto que proporciona almacenamiento escalable mediante la distribución de datos entre clústeres de máquinas. Está diseñado para ampliarse desde un único servidor hasta miles de máquinas, lo que lo convierte en un marco fundamental y potente en las infraestructuras de big data. La rentabilidad de Hadoop también lo convierte en una opción atractiva para las organizaciones que gestionan grandes cantidades de datos a un precio más bajo en comparación con las bases de datos tradicionales.

Hadoop tiene dos componentes principales:

- HDFS: Sistema de archivos de Hadoop ( ), que es un sistema de almacenamiento escalable que divide los datos en bloques más pequeños y los distribuye entre varios servidores. Esto significa que, aunque algunos servidores fallen, los datos siguen estando seguros.

- MapReduce, por otro lado, es un modelo de programación que divide las tareas grandes en partes más pequeñas, que pueden procesarse al mismo tiempo, lo que acelera el proceso.

Apache Spark

Apache Spark es otra potente herramienta para big data. A diferencia de MapReduce de Hadoop, Spark procesa los datos en memoria, lo que lo hace mucho más rápido y eficiente. También puede realizar diversas tareas, como procesamiento por lotes, datos en tiempo real, machine learning y análisis de gráficos, lo que lo convierte en una opción versátil para diferentes necesidades de big data.

Los conjuntos de datos distribuidos resilientes (RDD) de Spark permiten almacenar datos en la memoria y procesarlos rápidamente, al tiempo que garantizan la tolerancia a fallos. Spark también puede funcionar con HDFS de Hadoop para el almacenamiento, al tiempo que aprovecha sus rápidas capacidades de procesamiento.

MongoDB

MongoDB es una base de datos nosql diseñada para datos no estructurados. Tu flexibilidad para manejar diferentes tipos de datos lo hace ideal para entornos de datos en rápido crecimiento y aplicaciones dinámicas. La capacidad de MongoDB para escalar horizontalmente lo hace especialmente útil en situaciones en las que las bases de datos relacionales se quedan cortas, como las plataformas de redes sociales y el análisis en tiempo real. Se utiliza a menudo para el análisis de datos en tiempo real, los sistemas de gestión de contenidos y las aplicaciones del Internet de las cosas (IoT), donde la flexibilidad y la velocidad son fundamentales.

Minería de datos

RapidMiner

RapidMiner de Altair es una plataforma de análisis de datos e inteligencia artificial que admite todo el ciclo de vida de la ciencia de datos, lo que permite a los usuarios extraer grandes conjuntos de datos y crear modelos predictivos con facilidad.

Su naturaleza de código abierto y su integración con bibliotecas de machine learning le dan una ventaja para aquellos que desean una rápida creación de prototipos y una rápida implementación en producción.

La plataforma unificada está diseñada para diferentes conjuntos de habilidades, desde científicos e ingenieros de datos hasta analistas de negocios y ejecutivos, para hacer precisamente eso en un entorno unificado. entorno.

También puedes integrar RapidMiner con múltiples bibliotecas de machine learning, como TensorFlow, Weka y H2O, lo que te permite experimentar rápidamente con diferentes algoritmos y enfoques.

Presto

Presto afirma ser un «motor de consultas SQL rápido y fiable para el análisis de datos y el open lakehouse».

El motor proporciona una interfaz ANSI SQL sencilla, que permite consultar grandes conjuntos de datos procedentes de múltiples fuentes. También proporciona análisis en tiempo real. Presto es eficaz para las empresas que necesitan análisis interactivos sobre datos distribuidos. La capacidad de Presto para consultar lagos de datos sin necesidad de transformar los datos lo convierte en el favorito de los ingenieros de datos que buscan flexibilidad y rendimiento.

Análisis de datos

Apache Spark

El análisis de macrodatos es probablemente uno de los términos que viene a la mente de la gente cuando se menciona Apache Spark. Esto se debe a que Spark destaca en el procesamiento de datos a gran escala gracias a su arquitectura en memoria, que permite realizar análisis en tiempo real y acelerar el procesamiento de datos.

En cuanto al uso de datos por lotes y en streaming, Spark está perfectamente equipado para la tarea, y esta cualidad es la razón por la que se suele emplear en machine learning, el procesamiento en tiempo real e incluso en el análisis de gráficos.

La característica más importante en este sentido es el cálculo iterativo de Spark, que es la razón de su amplia aplicación en problemas de machine learning en los que se requieren múltiples rondas de machine learning computacional intensivo.

Además, la compatibilidad con API para Python, Java, Scala y otros lenguajes de programación facilita la transición de un programador a otro y, por lo tanto, en toda la organización.

Splunk

Las capacidades de análisis de datos en tiempo real y de inteligencia artificial de Splunk permiten a las empresas supervisar los datos generados por máquinas, detectar anomalías y tomar decisiones basadas en datos con mayor rapidez.

Splunk ha sido sin duda un gran activo para las organizaciones cuyas operaciones dependen de la disponibilidad instantánea de inteligencia operativa. Recopila y procesa una variedad de datos generados por máquinas, incluyendo, entre otros, registros, métricas y eventos, que ayudan a determinar lo que está sucediendo en los sistemas informáticos de cualquier organización.

Splunk también cuenta con una importante función denominada «Reporting» (Informes), que ayuda a los usuarios finales a crear paneles de control complejos de varias páginas que son fáciles de interpretar y agradables a la vista.

Visualización de datos

Cuadro

El sitio web de Tableau lo define como«una plataforma de análisis visual que transforma la forma en que usamos los datos para resolver problemas, permitiendo a las personas y a las organizaciones sacar el máximo partido a sus datos».

Como líder en el ámbito de la inteligencia empresarial, ofrece a los usuarios una interfaz potente e intuitiva para crear visualizaciones dinámicas que proporcionan información detallada. Su capacidad para integrar datos de diversas fuentes lo hace mucho más compatible con los requisitos de los usuarios empresariales.

Tu punto fuerte radica en tu versatilidad, desde la creación de paneles ejecutivos de alto nivel hasta informes detallados y desglosados para analistas de datos.

Power BI

Según Microsoft, Power BI es un conjunto de servicios de software, aplicaciones y conectores que funcionan conjuntamente para convertir fuentes de datos inconexas en información coherente, visualmente inmersiva e interactiva.

Power BI se integra perfectamente con otras herramientas, especialmente las de Microsoft, y permite crear informes completos e interactivos. Los equipos pueden colaborar en tiempo real gracias a su servicio basado en la nube.

Aplicaciones de las tecnologías de big data

Atención sanitaria

El big data está revolucionando el sector sanitario a través de numerosas áreas de aplicación:

Una de sus aplicaciones clave es el análisis predictivo, en el que se analizan variables como el historial del paciente, la genética, los niveles de presión arterial y otros datos sobre el estilo de vida para predecir la probabilidad de que se desarrollen enfermedades. Esto permite una intervención temprana y tratamientos personalizados, lo que ayuda a prevenir o controlar las enfermedades de forma más eficaz, al tiempo que se reducen los costes sanitarios.

La monitorización preventiva de pacientes es otro ámbito en el que destaca el big data. Los datos de salud en tiempo real se recopilan a través de dispositivos portátiles que permiten la detección temprana de anomalías y una intervención oportuna. Esto resulta especialmente útil para controlar enfermedades crónicas y prevenir reingresos hospitalarios.

En la investigación médica, el big data acelera el descubrimiento de nuevos fármacos y tratamientos mediante el análisis de vastos conjuntos de datos procedentes de ensayos clínicos, estudios genómicos e historiales de pacientes. Esto se consigue mediante una mejor identificación, prueba y evaluación de la eficacia de los medicamentos, lo que permite avances más rápidos.

Por último, pero no menos importante, , podrían utilizarse, facilitadas por las tecnologías de big data, para optimizar la programación, reducir los tiempos de espera y mejorar la prestación general de la atención sanitaria.

Finanzas

Las instituciones financieras utilizan el big data para muchos casos de uso, tales como:

- El trading cuantitativo utiliza algoritmos para analizar datos de mercado en tiempo real, precios históricos y tendencias con el fin de ejecutar operaciones más rápido que nunca. Esto requiere manejar un gran volumen de datos en tiempo real, un área que exige capacidades de big data.

- La detección de fraudes es, sin duda, la aplicación más reconocida. El análisis de macrodatos permite detectar patrones y anomalías en tiempo real, y señalar las transacciones sospechosas para su posterior investigación. Esto ayuda a las instituciones financieras a prevenir el fraude, proteger a los clientes y reducir las pérdidas financieras.

- Las técnicas de machine learning no supervisadas pueden utilizarse en big data para impulsar análisis de clientes, lo que a su vez permitirá tomar decisiones estratégicas relacionadas con el marketing dirigido, las recomendaciones de inversión y la planificación financiera personalizada.

- Por último, el big data mejora la eficiencia operativa al identificar los cuellos de botella y automatizar los procesos. Desde el mantenimiento predictivo hasta la optimización de procesos, las instituciones financieras pueden reducir costes, mejorar la productividad y ofrecer mejores servicios.

Venta al por menor

Los minoristas aprovechan el big data en varias áreas de aplicación, tales como:

- El big data ayuda a los minoristas a optimizar la cadena de suministro y la gestión de inventario mediante el análisis de datos históricos de ventas, demanda y rendimiento de los proveedores. Esto garantiza, por un lado, que se eviten las carencias de productos y, por otro, que no aumenten los costes de mantenimiento de inventario.

- El análisis de ubicación es otra área en la que los macrodatos desempeñan un papel diferenciador. Al aprovechar y analizar datos geográficos y demográficos, las cadenas minoristas pueden tomar decisiones basadas en análisis sobre la ubicación de las tiendas, los tipos de tiendas y la estrategia.

- El big data también está transformando el panorama minorista al convertir grandes cantidades de datos de clientes en información útil. El análisisdel comportamiento de los clientes , como el historial de compras y los patrones de navegación, permite a estos minoristas ofrecer sugerencias de productos personalizadas. Esto mejora la experiencia de compra y aumenta las ventas y la fidelidad de los clientes.

Tendencias emergentes en tecnologías de big data

Computación periférica

Según la definición de IBM, «la computación periférica es un marco de computación distribuida que acerca las aplicaciones empresariales a las fuentes de datos, como los dispositivos IoT o los servidores periféricos locales». Esta proximidad a los datos en su origen puede aportar importantes ventajas empresariales, como una mayor rapidez en la obtención de información, mejores tiempos de respuesta y una mayor disponibilidad de ancho de banda».

La proximidad a los datos permite procesarlos más cerca de la fuente, lo que reduce la latencia y mejora la velocidad de la toma de decisiones. Esto es sumamente importante en aplicaciones de IoT, donde el procesamiento en tiempo real es esencial. Además, dado que no es necesario transferir datos a ubicaciones centralizadas, la computación periférica también puede reducir el uso de ancho de banda y los tiempos de respuesta. Esto significa una toma de decisiones más rápida y precisa basada en datos.

Integración de IA

Según la definición de RST, «la integración de la IA (AI integration) entrelaza las capacidades de la inteligencia artificial directamente en los productos y sistemas». En lugar de que la IA funcione como una herramienta externa, la integración incorpora su capacidad analítica de forma nativa para mejorar todas las facetas del rendimiento.

La integración de la inteligencia artificial (IA) con el big data ha transformado la forma en que las empresas analizan los datos y actúan en consecuencia. Los algoritmos de IA, en particular los modelos de machine learning (ML), permiten a los sistemas detectar patrones, realizar predicciones y automatizar los procesos de toma de decisiones.

Por ejemplo, en el sector manufacturero, la integración de la IA ayuda con el mantenimiento predictivo, lo que permite a las empresas identificar cuándo es probable que falle un equipo y tomar medidas preventivas. Esto reduce el tiempo de inactividad y los costes operativos. Del mismo modo, la detección de anomalías basada en inteligencia artificial puede identificar transacciones inusuales en el ámbito financiero, lo que ayuda a prevenir el fraude en tiempo real.

Entornos de nube híbrida

Según Microsoft, «unanube híbrida, también denominada híbrida en la nube, es un entorno informático que combina un centro de datos local con una nube pública, lo que permite compartir datos y aplicaciones entre ambos».

Una arquitectura de nube híbrida combina lo mejor de la escalabilidad de la nube pública y la seguridad local. Ofrece la flexibilidad de almacenar datos confidenciales de forma segura en tus propias instalaciones, mientras que utilizas la nube para tareas más grandes y menos confidenciales. Los entornos de nube híbrida también proporcionan rentabilidad al permitir a las empresas ampliar o reducir su infraestructura en función de sus necesidades.

Retos en la implementación de tecnologías de big data

La implementación de tecnologías de big data ofrece varias ventajas, pero también plantea una serie de retos. A continuación se enumeran algunas de estas consideraciones:

- Integración de datos: La integración de datos procedentes de diversas fuentes —estructurados, no estructurados y semiestructurados— plantea retos a la hora de garantizar la coherencia y la precisión.

- Escalabilidad: A medida que aumenta el volumen de datos, la infraestructura debe poder escalarse de manera eficiente sin que se vea afectado el rendimiento.

- Preocupaciones de seguridad: Proteger los datos confidenciales dentro de los ecosistemas de big data requiere un cifrado robusto, controles de acceso y el cumplimiento de las normativas. Con normativas como el RGPD y la CCPA, las organizaciones de todo el mundo se enfrentan a una presión cada vez mayor para implementar prácticas de seguridad y garantizar al mismo tiempo la privacidad de los usuarios.

- Costes elevados: La implementación y el mantenimiento de una infraestructura de big data requieren una inversión considerable tanto en tecnología como en talento.

- Calidad y gobernanza de los datos: Dado que los datos se recopilan de múltiples fuentes, garantizar su precisión, coherencia y fiabilidad se convierte en un reto. Además, la falta de gobernanza puede dar lugar a problemas de cumplimiento normativo y riesgos empresariales.

Conclusión

Las tecnologías de big data son un requisito estratégico para que las organizaciones obtengan ventajas competitivas al obtener información útil a partir de conjuntos de datos masivos. Desde el almacenamiento hasta el análisis y la visualización, estas herramientas son los pilares sobre los que se basa la toma de decisiones basada en datos en la actualidad. Mantenerse informados sobre las tendencias emergentes, como la integración de la inteligencia artificial, la computación periférica y las arquitecturas de nube híbrida, permitirá a las empresas escalar de manera eficiente e innovar en la gestión de datos. El dominio de estas tecnologías permite a las organizaciones transformar datos sin procesar en activos valiosos, lo que les proporciona una ventaja competitiva en una economía centrada en los datos. Sin embargo, es importante comprender el costo y otros retos antes de tomar cualquier decisión sobre la implementación.

Para ampliar tus conocimientos, te recomendamos que consultes las siguientes fuentes:

- Guía para la formación en big data: Descubre la importancia de la formación en big data y las soluciones empresariales de DataCamp.

- Aprendizaje por transferencia: Aprovecha la información que te brinda el big data: Descubre qué es el aprendizaje por transferencia, sus aplicaciones clave y por qué es esencial para los científicos de datos.

- Aprovecha todo el potencial de la ciencia de datos en la nube: Los líderes en análisis en la nube de Exasol debaten sobre las ventajas de la migración a la nube, los factores económicos desencadenantes, los casos de éxito y la importancia de la flexibilidad.

- Flink frente a Spark: Comparación entre Flink y Spark, dos marcos de código abierto a la vanguardia del procesamiento por lotes y en tiempo real.

Profesional experimentado en Ciencia de Datos, Inteligencia Artificial, Analítica y Funciones Estratégicas con más de 18 años de experiencia en las áreas de -: Ciencia de datos, ML e IA ~ Ciencia de datos, Aprendizaje automático supervisado y no supervisado, Aprendizaje profundo, Modelado predictivo, Procesamiento del lenguaje natural (NLP), Modelado y análisis estadístico, Optimización, Estrategia empresarial y Analítica ~ Desarrollo y evaluación de modelos empresariales, Analítica descriptiva y de diagnóstico, EDA, Visualización, Análisis de causa raíz, Análisis de sensibilidad y de escenarios.

Preguntas frecuentes

¿Qué es el big data?

El término «big data» hace referencia a grandes cantidades de datos estructurados y no estructurados que son demasiado voluminosos o complejos para que el software tradicional de procesamiento de datos pueda gestionarlos de manera eficiente.

¿Cómo beneficia el big data al sector minorista?

El big data ayuda a los minoristas a optimizar la ubicación de sus tiendas, personalizar el marketing, gestionar el inventario y mejorar la experiencia del cliente a través de información sobre la ubicación y el comportamiento.

¿Qué es la computación periférica en el big data?

La computación periférica procesa los datos más cerca de su fuente, lo que reduce la latencia y permite una toma de decisiones más rápida y en tiempo real, lo que resulta especialmente útil en aplicaciones de IoT.

¿Cómo ayuda el big data a detectar el fraude en las finanzas?

El big data analiza los patrones de transacción en tiempo real, identificando anomalías y previniendo actividades fraudulentas al señalar comportamientos inusuales.

¿Cuáles son los retos que plantea la implementación de tecnologías de big data?

Entre los retos más comunes se encuentran la integración de datos, la escalabilidad, las cuestiones de seguridad, los altos costes, el mantenimiento de la calidad de los datos y el procesamiento de datos en tiempo real.