Cursus

Les technologies du big data sont indispensables, car la taille et la complexité des données produites par les entreprises augmentent chaque jour. Les outils traditionnels ne sont pas suffisants pour traiter les mégadonnées, et c'est là que ces technologies permettent une gestion efficace des données et l'extraction d'informations qui favorisent une prise de décision éclairée. Il est essentiel pour les professionnels souhaitant faire carrière ou progresser dans ce domaine de se tenir informés des derniers outils et tendances.

Qu'est-ce que la technologie Big Data ?

La technologie du big data désigne les outils et les cadres qui traitent, stockent et analysent des ensembles de données complexes et volumineux.

Selon Gartner,le big data se définit comme « un ensemble d'informations volumineuses, rapides et variées qui nécessitent des formes innovantes et rentables de traitement de l'information afin d'améliorer la compréhension et la prise de décision ».

Caractéristiques du Big Data. Source de l'image : Auteur

- Volume : L'augmentation du volume des données a été considérable. Chaque seconde, des quantités considérables de données sont générées à partir des réseaux sociaux, des capteurs, des transactions financières, etc. La gestion d'un volume d'une telle ampleur nécessite des systèmes de stockage avancés et une puissance de traitement évolutive pour suivre le rythme.

- Variété : Les données peuvent se présenter sous différentes formes. Elle peut être structurée, à l'instar des données soigneusement organisées dans des tableurs et des bases de données. Ou bien il peut s'agir de données non structurées, telles que du texte, des images, des vidéos et des publications sur les réseaux sociaux qui ne correspondent pas à un format simple. Nous disposons également de données semi-structurées, telles que les fichiers JSON et XML, qui se situent entre les deux. Chaque type de données nécessite des approches différentes pour être analysé et compris.

- Ensuite, il y a l'de la vitesse, qui fait référence à la rapidité avec laquelle les données sont générées et doivent être traitées. Avec les appareils IoT (Internet des objets) et les flux en temps réel provenant des réseaux sociaux et des transactions financières, la capacité à capturer, traiter et analyser rapidement ces données est devenue essentielle pour prendre des décisions opportunes.

- Véracité : Il est essentiel de s'assurer que les données sont exactes et fiables, car des données erronées peuvent conduire à de mauvaises décisions et même nuire à une entreprise. Cependant, si nous nous efforçons trop d'obtenir des données parfaites, cela peut ralentir le processus et entraîner des retards dans la prise de décision. Il est donc nécessaire de trouver un équilibre parfait, en accord avec les sensibilités commerciales.

Les technologies Big Data permettent aux organisations de traiter efficacement les données structurées et non structurées et d'en tirer des informations pertinentes. Les données constituant un atout stratégique, les technologies liées au big data sont devenues indispensables pour conserver un avantage concurrentiel durable dans des secteurs tels que la santé, la finance et la vente au détail. Le big data n'est plus une exigence technique, il est devenu un impératif commercial.

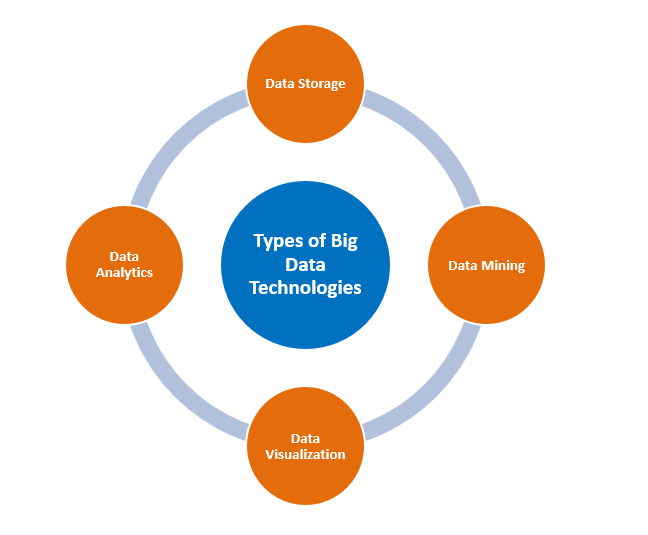

Types de technologies Big Data

Types de technologies Big Data. Source de l'image : Auteur

Stockage des données

Apache Hadoop

Hadoop est un framework open source qui offre un stockage évolutif en répartissant les données entre plusieurs clusters de machines. Il est conçu pour passer d'un seul serveur à des milliers de machines, ce qui en fait un cadre fondamental et puissant dans les infrastructures de mégadonnées. La rentabilité de Hadoop en fait également une option intéressante pour les organisations qui gèrent des volumes considérables de données, à un coût inférieur à celui des bases de données traditionnelles.

Hadoop comprend deux composants principaux :

- HDFS : Système de fichiers Hadoop ( ), un système de stockage évolutif qui divise les données en blocs plus petits et les répartit sur plusieurs serveurs. Cela signifie que même si certains serveurs tombent en panne, les données restent sécurisées.

- MapReduce, quant à lui, est un modèle de programmation qui divise les tâches volumineuses en plusieurs parties plus petites pouvant être traitées simultanément, ce qui accélère le processus.

Apache Spark

Apache Spark est un autre outil performant pour le big data. Contrairement à MapReduce de Hadoop, Spark traite les données en mémoire, ce qui le rend beaucoup plus rapide et efficace. Il est également capable de gérer diverses tâches, notamment le traitement par lots, les données en temps réel, l'apprentissage automatique et l'analyse graphique, ce qui en fait un choix polyvalent pour différents besoins en matière de mégadonnées.

Les ensembles de données distribuées résilientes (RDD) de Spark lui permettent de stocker des données en mémoire et de les traiter rapidement, tout en garantissant la tolérance aux pannes. Spark peut également fonctionner avec le HDFS de Hadoop pour le stockage tout en tirant parti de ses capacités de traitement rapide.

MongoDB

MongoDB est une base de données nosql conçue pour les données non structurées. Sa flexibilité dans le traitement de différents types de données le rend idéal pour les environnements de données en croissance rapide et les applications dynamiques. La capacité de MongoDB à évoluer horizontalement le rend particulièrement utile dans les scénarios où les bases de données relationnelles ne suffisent pas, comme les plateformes de réseaux sociaux et l'analyse en temps réel. Il est fréquemment utilisé pour l'analyse de données en temps réel, les systèmes de gestion de contenu et les applications de l'Internet des objets (IoT), où la flexibilité et la rapidité sont essentielles.

Exploration de données

RapidMiner

RapidMiner d'Altair est une plateforme d'analyse de données et d'intelligence artificielle qui prend en charge l'ensemble du cycle de vie de la science des données, permettant aux utilisateurs d'exploiter de grands ensembles de données et de créer facilement des modèles prédictifs.

Sa nature open source et son intégration avec des bibliothèques d'apprentissage automatique lui confèrent un avantage certain pour ceux qui souhaitent réaliser rapidement des prototypes et les déployer en production.

La plateforme unifiée est conçue pour différents profils professionnels, des scientifiques et ingénieurs spécialisés dans les données aux analystes commerciaux et cadres supérieurs, afin de leur permettre de réaliser ces tâches dans un environnement unifié. environnement.

Il est également possible d'intégrer RapidMiner à plusieurs bibliothèques d'apprentissage automatique telles que TensorFlow, Weka et H2O, ce qui vous permet d'expérimenter rapidement différents algorithmes et approches.

Presto

Presto se présente comme un « moteur de requêtes SQL rapide et fiable pour l'analyse de données et l'open lakehouse ».

Le moteur fournit une interface ANSI SQL simple, permettant d'interroger de grands ensembles de données provenant de plusieurs sources. Il fournit également des analyses en temps réel. Presto est particulièrement efficace pour les entreprises qui ont besoin d'analyses interactives sur des données distribuées. La capacité de Presto à interroger des lacs de données sans nécessiter de transformation des données en fait un outil de prédilection pour les ingénieurs de données qui recherchent flexibilité et performances.

Analyse de données

Apache Spark

L'analyse des mégadonnées est probablement l'un des termes qui vient à l'esprit lorsque l'on évoque Apache Spark. En effet, Spark excelle dans le traitement de données à grande échelle grâce à son architecture en mémoire, qui permet des analyses en temps réel et un traitement plus rapide des données.

En termes d'utilisation des données par lots et en continu, Spark est parfaitement adapté à cette tâche, et c'est précisément pour cette raison qu'il est généralement utilisé dans le domaine de l'apprentissage automatique, du traitement en temps réel et même pour l'analyse de graphiques.

La caractéristique la plus importante à cet égard est le calcul itératif de Spark, qui explique sa large application dans les problèmes d'apprentissage automatique nécessitant plusieurs cycles de calculs intensifs.

De plus, la prise en charge des API pour Python, Java, Scala et d'autres langages de programmation facilite la transition d'un développeur à un autre et, par conséquent, au sein des organisations.

Splunk

Les capacités d'analyse de données en temps réel et d'intelligence artificielle de Splunk permettent aux entreprises de surveiller les données générées par les machines, de détecter les anomalies et de prendre plus rapidement des décisions fondées sur les données.

Splunk s'est avéré être un atout considérable pour les organisations dont les opérations dépendent de la disponibilité immédiate de renseignements opérationnels. Il collecte et traite diverses données générées par des machines, notamment des journaux, des métriques et des événements, qui permettent de déterminer ce qui se passe au sein des systèmes informatiques d'une organisation.

Splunk dispose également d'une fonctionnalité importante appelée « Reporting », qui aide les utilisateurs finaux à créer des tableaux de bord complexes de plusieurs pages, faciles à interpréter et agréables à consulter.

Visualisation des données

Tableau

Le site Web de Tableau le définit comme «une plateforme d'analyse visuelle qui transforme la manière dont nous utilisons les données pour résoudre des problèmes, permettant ainsi aux individus et aux organisations de tirer le meilleur parti de leurs données ».

En tant que leader dans le domaine de l'intelligence économique, il offre aux utilisateurs une interface puissante et intuitive permettant de créer des visualisations dynamiques qui fournissent des informations approfondies. Sa capacité à intégrer des données provenant de diverses sources le rend d'autant plus compatible avec les exigences des utilisateurs professionnels.

Sa force réside dans sa polyvalence, qui lui permet de créer aussi bien des tableaux de bord destinés aux cadres supérieurs que des rapports détaillés et approfondis pour les analystes de données.

Power BI

Selon Microsoft, Power BI est un ensemble de services logiciels, d'applications et de connecteurs qui fonctionnent ensemble pour transformer vos sources de données disparates en informations cohérentes, visuellement immersives et interactives.

Power BI s'intègre parfaitement à d'autres outils, en particulier ceux de Microsoft, et permet de créer des rapports complets et interactifs. Les équipes peuvent collaborer en temps réel grâce à ce service basé sur le cloud.

Applications des technologies Big Data

Soins de santé

Le big data révolutionne le secteur de la santé grâce à de nombreux domaines d'application :

L'une de ses principales applications est l'analyse prédictive, qui consiste à analyser des variables telles que les antécédents médicaux, la génétique, la tension artérielle et d'autres données relatives au mode de vie afin de prédire la probabilité de développer certaines maladies. Cela permet une intervention précoce et des traitements personnalisés, contribuant ainsi à prévenir ou à gérer plus efficacement les maladies tout en réduisant les coûts des soins de santé.

L' de surveillance préventive des patients est un autre domaine où le big data démontre son efficacité. Les données de santé en temps réel sont recueillies à l'aide d'appareils portables qui permettent une détection précoce des anomalies et une intervention rapide. Ceci est particulièrement utile pour la gestion des maladies chroniques et la prévention des réadmissions à l'hôpital.

Dans le domaine de la recherche médicale, le big data accélère la découverte de nouveaux médicaments et traitements en analysant de vastes ensembles de données issues d'essais cliniques, d'études génomiques et de dossiers médicaux. Cela est réalisé grâce à une meilleure identification, à des tests et à une évaluation de l'efficacité des médicaments, ce qui accélère les avancées.

Enfin, les techniques d'optimisation linéaires et non linéaires , facilitées par les technologies du big data, pour optimiser la planification, réduire les temps d'attente et améliorer la prestation globale des soins.

Finances

Les institutions financières utilisent le big data dans de nombreux cas, tels que :

- L', ou analyse quantitative , utilise des algorithmes pour analyser les données du marché en temps réel, les prix historiques et les tendances afin d'exécuter les transactions plus rapidement que jamais. Cela implique de traiter un volume important de données en temps réel, un domaine qui nécessite des capacités en matière de mégadonnées.

- L' de détection des fraudes est sans conteste l'application la plus largement reconnue. L'analyse des mégadonnées permet de détecter en temps réel les tendances et les anomalies, et de signaler les transactions suspectes afin qu'elles fassent l'objet d'une enquête plus approfondie. Cela permet aux institutions financières de prévenir la fraude, de protéger leurs clients et de réduire les pertes financières.

- Les techniques d'apprentissage automatique non supervisées peuvent être utilisées sur des mégadonnées pour alimenter l'analyse client. analyse de la clientèle, ce qui permettra ensuite de prendre des décisions stratégiques en matière de marketing ciblé, de recommandations d'investissement et de planification financière personnalisée.

- Enfin, le big data améliore l'efficacité opérationnelle en identifiant les goulots d'étranglement et en automatisant les processus. De la maintenance prédictive à l'optimisation des processus, les institutions financières peuvent réduire leurs coûts, améliorer leur productivité et offrir de meilleurs services.

Commerce de détail

Les détaillants exploitent le big data dans plusieurs domaines d'application, tels que :

- Le big data aide les détaillants à optimiser la gestion de la chaîne logistique et des stocks en analysant les données historiques sur les ventes, la demande et les performances des fournisseurs. Cela permet d'éviter les pénuries de produits tout en garantissant que les coûts de stockage n'augmentent pas.

- L'analyse de localisation est un autre domaine dans lequel le big data joue un rôle déterminant. En exploitant et en analysant les données géographiques et démographiques, les chaînes de distribution sont en mesure de prendre des décisions fondées sur l'analyse concernant l'emplacement et le type de leurs magasins, ainsi que leur stratégie.

- Le big data transforme également le paysage du commerce de détail en transformant de grandes quantités de données clients en informations exploitables. L'analysedu comportement des clients , notamment l'historique des achats et les habitudes de navigation, permet à ces acteurs du commerce de détail de proposer des suggestions de produits personnalisées. Cela améliore l'expérience d'achat et stimule les ventes ainsi que la fidélité des clients.

Nouvelles tendances dans les technologies du Big Data

Informatique en périphérie

Conformément à la définition donnée par IBM, , « l'Edge Computing est une infrastructure informatique distribuée qui rapproche les applications d'entreprise des sources de données telles que les appareils IoT ou les serveurs locaux périphériques. Cette proximité avec les données à leur source peut offrir des avantages commerciaux considérables, notamment des informations plus rapides, des temps de réponse améliorés et une meilleure disponibilité de la bande passante.

La proximité des données permet leur traitement plus près de la source, ce qui réduit la latence et améliore la rapidité de la prise de décision. Ceci est extrêmement important dans les applications IoT où le traitement en temps réel est essentiel. De plus, comme il n'est pas nécessaire de transférer les données vers des emplacements centralisés, l'edge computing peut également réduire l'utilisation de la bande passante et les temps de réponse. Cela permet une prise de décision plus rapide et plus précise, fondée sur des données.

Intégration de l'intelligence artificielle

Selon la définition de RST, « l'ration de l'IA intègre directement les capacités de l'intelligence artificielle dans les produits et les systèmes. Plutôt que de considérer l'IA comme un outil externe, l'intégration intègre ses capacités analytiques de manière native afin d'améliorer tous les aspects de la performance.

L'intégration de l'intelligence artificielle (IA) au big data a transformé la manière dont les entreprises analysent les données et agissent en conséquence. Les algorithmes d'IA, en particulier les modèles d'apprentissage automatique (ML), permettent aux systèmes de détecter des modèles, de faire des prédictions et d'automatiser les processus décisionnels.

Par exemple, dans le secteur manufacturier, l'intégration de l'IA facilite la maintenance prédictive, permettant aux entreprises d'identifier quand un équipement est susceptible de tomber en panne et de prendre des mesures préventives. Cela permet de réduire les temps d'arrêt et les coûts d'exploitation. De même, la détection des anomalies basée sur l'intelligence artificielle permet d'identifier les transactions inhabituelles dans le domaine financier, contribuant ainsi à prévenir la fraude en temps réel.

Environnements cloud hybrides

Selon Microsoft, « uncloud hybride, parfois appelé cloud mixte, est un environnement informatique qui combine un centre de données sur site avec un cloud public, permettant ainsi le partage de données et d'applications entre les deux. »

Une architecture cloud hybride combine les avantages de l'évolutivité du cloud public et de la sécurité sur site. Il offre la flexibilité nécessaire pour stocker en toute sécurité les données sensibles en interne tout en utilisant le cloud pour les tâches plus importantes et moins sensibles. Les environnements cloud hybrides offrent également une rentabilité accrue en permettant aux entreprises d'adapter leur infrastructure à la hausse ou à la baisse en fonction de leurs besoins.

Difficultés liées à la mise en œuvre des technologies Big Data

La mise en œuvre des technologies big data présente plusieurs avantages, mais elle s'accompagne également de défis spécifiques. Certaines de ces considérations sont énumérées ci-dessous :

- Intégration des données: L'intégration de données provenant de diverses sources – structurées, non structurées, semi-structurées – pose des défis en matière de cohérence et d'exactitude.

- s de l'évolutivité: À mesure que les volumes de données augmentent, l'infrastructure doit pouvoir évoluer efficacement sans perte de performances.

- Préoccupations en matière de sécurité: La sécurisation des données sensibles au sein des écosystèmes Big Data nécessite un cryptage robuste, des contrôles d'accès et le respect des réglementations. Avec des réglementations telles que le RGPD et le CCPA, les organisations du monde entier sont confrontées à une pression croissante pour mettre en œuvre des pratiques de sécurité tout en garantissant la confidentialité des utilisateurs.

- Coûts élevés: La mise en œuvre et la maintenance d'une infrastructure Big Data nécessitent des investissements considérables tant en matière de technologie que de ressources humaines.

- Qualité et gouvernance des données : Étant donné que les données sont collectées à partir de multiples sources, il devient difficile de garantir leur exactitude, leur cohérence et leur fiabilité. De plus, l'absence de gouvernance peut entraîner des problèmes de conformité et des risques commerciaux.

Conclusion

Les technologies Big Data constituent un impératif stratégique pour les organisations qui souhaitent obtenir des avantages concurrentiels en tirant des informations exploitables à partir d'ensembles de données volumineux. Du stockage à l'analyse et à la visualisation, ces outils constituent les piliers sur lesquels repose la prise de décision moderne fondée sur les données. En se tenant informées des nouvelles tendances telles que l'intégration de l'IA, l'edge computing et les architectures cloud hybrides, les entreprises pourront évoluer efficacement et innover dans le domaine de la gestion des données. La maîtrise de ces technologies permet aux organisations de transformer des données brutes en actifs précieux, ce qui leur confère un avantage concurrentiel dans une économie centrée sur les données. Il est toutefois essentiel de bien comprendre les coûts et les autres défis avant de prendre toute décision de mise en œuvre.

Pour approfondir vos connaissances, nous vous invitons à consulter les ressources suivantes :

- Guide de formation sur le Big Data: Découvrez l'importance de la formation au big data et les solutions commerciales proposées par DataCamp.

- Apprentissage par transfert : Tirez parti des informations issues du Big Data: Découvrez ce qu'est l'apprentissage par transfert, ses principales applications et pourquoi il est essentiel pour les scientifiques des données.

- Libérer le potentiel de la science des données dans le cloud: Les responsables de l'analyse cloud chez Exasol examinent les avantages de la migration vers le cloud, les facteurs économiques, les réussites et l'importance de la flexibilité.

- Flink par rapport à s sur Spark : Comparaison entre Flink et Spark, deux frameworks open source à la pointe du traitement par lots et en continu.

Professionnel chevronné de la science des données, de l'intelligence artificielle, de l'analyse et de la stratégie des données.

Questions fréquentes

Qu'est-ce que le big data ?

Le terme « mégadonnées » désigne de grandes quantités de données structurées et non structurées qui sont trop volumineuses ou trop complexes pour être gérées efficacement par les logiciels traditionnels de traitement des données.

En quoi le big data est-il avantageux pour le secteur de la vente au détail ?

Le big data aide les détaillants à optimiser l'emplacement de leurs magasins, à personnaliser leur marketing, à gérer leurs stocks et à améliorer l'expérience client grâce à des informations sur l'emplacement et le comportement.

Qu'est-ce que l'edge computing dans le domaine du big data ?

L'informatique en périphérie traite les données plus près de leur source, ce qui réduit la latence et permet une prise de décision plus rapide et en temps réel, particulièrement utile dans les applications IoT.

Comment le big data contribue-t-il à la détection des fraudes dans le secteur financier ?

Le big data analyse les modèles de transaction en temps réel, identifiant les anomalies et prévenant les activités frauduleuses en signalant les comportements inhabituels.

Quels sont les défis liés à la mise en œuvre des technologies de mégadonnées ?

Les défis courants comprennent l'intégration des données, l'évolutivité, les préoccupations en matière de sécurité, les coûts élevés, le maintien de la qualité des données et le traitement des données en temps réel.