Lernpfad

Big-Data-Technologien sind echt wichtig, weil die Daten, die Unternehmen produzieren, jeden Tag größer und komplizierter werden. Traditionelle Tools reichen nicht aus, um mit Big Data klarzukommen, und genau da kommen diese Technologien ins Spiel, die ein effizientes Datenmanagement und die Gewinnung von Erkenntnissen ermöglichen, die eine fundierte Entscheidungsfindung unterstützen. Für Leute, die in diesem Bereich Karriere machen oder vorankommen wollen, ist es echt wichtig, immer auf dem Laufenden zu bleiben, was die neuesten Tools und Trends angeht.

Was ist Big-Data-Technologie?

Big-Data-Technologie ist die Bezeichnung für die Tools und Rahmenbedingungen, die komplexe und große Datensätze verarbeiten, speichern und analysieren.

Laut Gartnerist dieDefinition von Big Data: „Informationsbestände mit hohem Volumen, hoher Geschwindigkeit und großer Vielfalt, die kosteneffiziente, innovative Formen der Informationsverarbeitung erfordern, um bessere Einblicke und Entscheidungen zu ermöglichen.“

Eigenschaften von Big Data. Quelle des Bildes: Autor

- Volumen: Das Datenvolumen ist echt krass gewachsen. Jede Sekunde werden riesige Datenmengen aus sozialen Medien, Sensoren, Finanztransaktionen und vielem mehr erzeugt. Um mit so viel Daten umgehen zu können, braucht man echt gute Speichersysteme und eine skalierbare Rechenleistung, damit alles läuft.

- Vielfalt: Daten gibt's in allen Formen. Es kann strukturiert sein, wie ordentlich organisierte Daten in Tabellenkalkulationen und Datenbanken. Oder es kann unstrukturiert sein, wie Texte, Bilder, Videos und Social-Media-Beiträge, die nicht in ein einfaches Format passen. Dann gibt's auch noch halbstrukturierte Daten wie JSON- und XML-Dateien, die irgendwo dazwischen liegen. Jede Art von Daten braucht unterschiedliche Methoden, um sie zu analysieren und zu verstehen.

- Als Nächstes kommt die Geschwindigkeits, die sich auf die Geschwindigkeit bezieht, mit der die Daten generiert werden und verarbeitet werden müssen. Mit IoT-Geräten (Internet der Dinge) und Echtzeit-Streams aus sozialen Medien und Finanztransaktionen ist es echt wichtig geworden, diese Daten schnell zu erfassen, zu verarbeiten und zu analysieren, um rechtzeitig Entscheidungen treffen zu können.

- Veracity: Es ist super wichtig, dass die Daten richtig und zuverlässig sind, weil falsche Daten zu schlechten Entscheidungen führen und sogar einem Unternehmen schaden können. Aber wenn wir zu sehr auf perfekte Daten fixiert sind, kann das alles verlangsamen und zu Verzögerungen bei der Entscheidungsfindung führen. Also muss man ein perfektes Gleichgewicht finden, das zu den geschäftlichen Gegebenheiten passt.

Mit Big-Data-Technologien können Unternehmen strukturierte und unstrukturierte Daten effizient verarbeiten und daraus wichtige Erkenntnisse gewinnen. Da Daten echt wichtig sind, sind Big-Data-Technologien mittlerweile unverzichtbar, um in Branchen wie dem Gesundheitswesen, dem Finanzwesen und dem Einzelhandel immer einen Vorsprung zu haben. Big Data ist nicht mehr nur eine technische Sache, sondern mittlerweile echt wichtig fürs Geschäft.

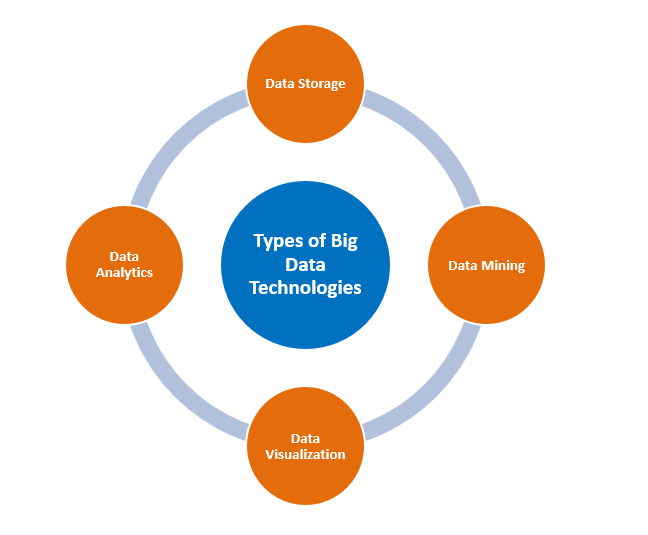

Arten von Big-Data-Technologien

Arten von Big-Data-Technologien. Quelle des Bildes: Autor

Datenspeicherung

Apache Hadoop

Hadoop ist ein Open-Source-Framework, das skalierbaren Speicher bietet, indem es Daten auf mehrere Computer-Cluster verteilt. Es ist so gemacht, dass man es von einem einzigen Server auf Tausende von Rechnern ausweiten kann, was es zu einem wichtigen und starken Framework in Big-Data-Infrastrukturen macht. Die Kosteneffizienz von Hadoop macht es auch zu einer coolen Option für Unternehmen, die riesige Datenmengen zu einem niedrigeren Preis als bei herkömmlichen Datenbanken verwalten.

Hadoop hat zwei Hauptkomponenten:

- HDFS: Das „ “ ist ein skalierbares Speichersystem, das Daten in kleinere Blöcke aufteilt und auf mehrere Server verteilt. Das heißt, selbst wenn ein paar Server ausfallen, sind die Daten trotzdem sicher.

- MapReduceist dagegen ein Programmiermodell, das große Aufgaben in kleinere Teile aufteilt, die gleichzeitig bearbeitet werden können, was den Prozess beschleunigt.

Apache Spark

Apache Spark ist ein weiteres starkes Tool für Big Data. Anders als Hadoops MapReduce verarbeitet Spark Daten im Speicher, was es viel schneller und effizienter macht. Es kann auch viele Aufgaben erledigen, wie zum Beispiel Stapelverarbeitung, Echtzeitdaten, maschinelles Lernen und Graphenanalyse, was es zu einer vielseitigen Wahl für verschiedene Big-Data-Anforderungen macht.

Die robusten verteilten Datensätze (RDDs) von Spark machen es möglich, Daten im Speicher abzulegen und schnell zu verarbeiten, während gleichzeitig die Fehlertoleranz gewährleistet ist. Spark kann auch mit Hadoops HDFS für die Speicherung zusammenarbeiten und dabei seine schnellen Verarbeitungsfähigkeiten nutzen.

MongoDB

MongoDB ist eine nosql-Datenbank, die für unstrukturierte Daten gemacht ist. Die Flexibilität beim Umgang mit unterschiedlichen Datentypen macht es super für schnell wachsende Datenumgebungen und dynamische Anwendungen. Die Fähigkeit von MongoDB, horizontal zu skalieren, macht es besonders nützlich in Situationen, in denen relationale Datenbanken nicht ausreichen, wie zum Beispiel bei Social-Media-Plattformen und Echtzeitanalysen. Es wird oft für Echtzeit-Datenanalysen, Content-Management-Systeme und Anwendungen im Bereich des Internets der Dinge (IoT) genutzt, wo Flexibilität und Geschwindigkeit echt wichtig sind.

Datenauswertung

RapidMiner

RapidMiner von Altair ist eine Datenanalyse- und KI-Plattform, die den ganzen Datenwissenschafts-Lebenszyklus abdeckt. Damit können Leute große Datensätze durchforsten und ganz einfach Vorhersagemodelle erstellen.

Durch seine Open-Source-Natur und die Integration mit Machine-Learning-Bibliotheken ist es super für alle, die schnell Prototypen erstellen und in die Produktion gehen wollen.

Die einheitliche Plattform ist für verschiedene Fachbereiche konzipiert – von Datenwissenschaftlern und Ingenieuren bis hin zu Business-Analysten und Führungskräften –, um genau das in einer einheitlichen Umgebung zu tun. Umgebung.

Du kannst RapidMiner auch mit verschiedenen Machine-Learning-Bibliotheken wie TensorFlow, Weka und H2O verbinden, um schnell mit verschiedenen Algorithmen und Ansätzen zu experimentieren.

Presto

Presto sagt, es sei eine „schnelle und zuverlässige SQL-Abfrage-Engine für Datenanalysen und das Open Lakehouse“.

Die Engine hat eine einfache ANSI-SQL-Schnittstelle, mit der man große Datensätze aus verschiedenen Quellen abfragen kann. Es bietet auch Echtzeit-Analysen. Presto ist super für Firmen, die interaktive Analysen von verteilten Daten brauchen. Presto kann Daten aus Data Lakes abfragen, ohne dass die Daten vorher umgewandelt werden müssen. Deshalb ist es bei Dateningenieuren, die Flexibilität und Leistung wollen, echt beliebt.

Datenanalyse

Apache Spark

Big-Data-Analytik ist wahrscheinlich einer der Begriffe, die einem in den Sinn kommen, wenn man von Apache Spark spricht. Das liegt daran, dass Spark mit seiner In-Memory-Architektur super bei der Verarbeitung großer Datenmengen ist und so Echtzeitanalysen und schnellere Datenverarbeitung ermöglicht.

Wenn es darum geht, Batch- und Streaming-Daten zu nutzen, ist Spark echt gut aufgestellt. Deshalb wird es oft für maschinelles Lernen, Echtzeitverarbeitung und sogar bei der Analyse von Graphen eingesetzt.

Das wichtigste Feature dabei ist die iterative Berechnung von Spark, weshalb es bei Machine-Learning-Problemen, die mehrere Runden rechenintensiven Machine Learning erfordern, so oft eingesetzt wird.

Außerdem macht die API-Unterstützung für Python, Java, Scala und andere Programmiersprachen den Wechsel von einem Entwickler zum anderen und damit innerhalb von Unternehmen einfach.

Splunk

Mit den Echtzeit-Datenanalyse- und KI-Funktionen von Splunk können Unternehmen maschinengenerierte Daten überwachen, Anomalien erkennen und schneller datengestützte Entscheidungen treffen.

Splunk ist echt super für Unternehmen, die auf sofortige Betriebsdaten angewiesen sind. Es sammelt und verarbeitet verschiedene maschinell erzeugte Daten, wie zum Beispiel Protokolle, Metriken und Ereignisse, die dabei helfen, zu verstehen, was in den IT-Systemen einer Organisation gerade so los ist.

Splunk hat auch eine coole Funktion namens „Reporting“, mit der Endnutzer komplexe Dashboards mit mehreren Seiten erstellen können, die einfach zu verstehen und echt schick sind.

Datenvisualisierung

Tableau

Auf der Website von Tableau wird es so beschrieben:„Eine visuelle Analyseplattform, die die Art und Weise verändert, wie wir Daten zur Problemlösung nutzen – und Menschen und Organisationen dabei hilft, das Beste aus ihren Daten herauszuholen.“

Als einer der Top-Anbieter im Bereich Business Intelligence gibt's hier eine coole, intuitive Oberfläche, mit der du dynamische Visualisierungen erstellen kannst, die echt tiefgehende Einblicke bieten. Die Möglichkeit, Daten aus verschiedenen Quellen zusammenzuführen, macht es viel besser für die Bedürfnisse von Geschäftsanwendern geeignet.

Seine Stärke liegt in seiner Vielseitigkeit, von der Erstellung von Dashboards für Führungskräfte bis hin zu detaillierten Drilldown-Berichten für Datenanalysten.

Power BI

Laut Microsoftist Power BI eine Sammlung von Software-Diensten, Apps und Konnektoren, die zusammenarbeiten, um deine nicht miteinander verbundenen Datenquellen in zusammenhängende, visuell ansprechende und interaktive Einblicke zu verwandeln.

Power BI lässt sich super mit anderen Tools verbinden, vor allem mit denen von Microsoft, und man kann damit richtig gute, interaktive Berichte erstellen. Die Teams können dank des Cloud-Dienstes in Echtzeit zusammenarbeiten.

Anwendungen von Big-Data-Technologien

Gesundheitswesen

Big Data verändert den Gesundheitssektor durch viele Anwendungsbereiche:

Eine der wichtigsten Anwendungen ist die prädiktive Analytik, bei der Sachen wie Krankengeschichte, Genetik, Blutdruckwerte und andere Lebensstil-Daten analysiert werden, um die Wahrscheinlichkeit von Krankheiten vorherzusagen. Das ermöglicht frühzeitiges Eingreifen und maßgeschneiderte Behandlungen, was dabei hilft, Krankheiten besser vorzubeugen oder zu behandeln und gleichzeitig die Gesundheitskosten zu senken.

Präventive Patientenüberwachungs en sind ein weiterer Bereich, in dem Big Data echt gut ist. Echtzeit-Gesundheitsdaten werden über tragbare Geräte gesammelt, die eine frühzeitige Erkennung von Anomalien und ein rechtzeitiges Eingreifen ermöglichen. Das ist besonders nützlich, um chronische Krankheiten zu behandeln und erneute Krankenhausaufenthalte zu vermeiden.

In der medizinischen Forschung beschleunigt Big Data die Entdeckung neuer Medikamente und Behandlungsmethoden, indem riesige Datensätze aus klinischen Studien, Genomstudien und Patientenakten analysiert werden. Das wird durch eine bessere Identifizierung, Prüfung und Bewertung der Wirksamkeit von Medikamenten erreicht, was zu schnelleren Durchbrüchen führt.

Zu guter Letzt noch lineare und nichtlineare Optimierungstechniken , die durch Big-Data-Technologien unterstützt werden, um die Planung zu optimieren, Wartezeiten zu verkürzen und die gesamte Gesundheitsversorgung zu verbessern.

Finanzen

Finanzinstitute nutzen Big Data für viele verschiedene Sachen, zum Beispiel:

- Quantitative Handels s nutzen Algorithmen, um Echtzeit-Marktdaten, historische Preise und Trends zu checken und so Trades schneller als je zuvor durchzuführen. Das bedeutet, dass man mit einer Menge Echtzeitdaten klarkommen muss, was Big-Data-Fähigkeiten braucht.

- Betrugserkennungs e sind echt die bekannteste Anwendung. Mit Big-Data-Analysen kann man Muster und Auffälligkeiten in Echtzeit erkennen und verdächtige Transaktionen für weitere Untersuchungen markieren. Das hilft Finanzinstituten, Betrug zu verhindern, Kunden zu schützen und finanzielle Verluste zu reduzieren.

- Unüberwachte maschinelle Lernverfahren können bei Big Data eingesetzt werden, um Kundenanalysen, was wiederum strategische Entscheidungen in Bezug auf gezieltes Marketing, Anlageempfehlungen und maßgeschneiderte Finanzplanung ermöglicht.

- Schließlich verbessert Big Data die betriebliche Effizienz , indem es Engpässe identifiziert und Prozesse automatisiert. Von der vorausschauenden Wartung bis zur Prozessoptimierung können Finanzinstitute Kosten sparen, die Produktivität steigern und bessere Dienstleistungen anbieten.

Einzelhandel

Einzelhändler nutzen Big Data in verschiedenen Bereichen, zum Beispiel:

- Big Data hilft Einzelhändlern dabei, ihre Lieferkette und ihr Bestandsmanagementzu optimieren , indem es alte Verkaufsdaten, die Nachfrage und die Leistung der Lieferanten checkt. So wird sichergestellt, dass einerseits Produktknappheiten vermieden werden, andererseits aber auch die Lagerhaltungskosten nicht steigen.

- Standortanalysen sind ein weiterer Bereich, in dem Big Data eine wichtige Rolle spielt. Durch die Nutzung und Analyse von geografischen und demografischen Daten können Einzelhandelsketten fundierte Entscheidungen über Ladenstandorte, Ladentypen und Strategien treffen.

- Big Data verändert auch den Einzelhandel, indem es riesige Mengen an Kundendaten in nützliche Erkenntnisse verwandelt. Durchdie Analysedes Kundenverhaltens, wie zum Beispiel Kaufhistorie und Surfgewohnheiten, können diese Einzelhändler maßgeschneiderte Produktvorschläge machen. Das macht das Einkaufen angenehmer und bringt mehr Umsatz und treue Kunden.

Neue Trends bei Big-Data-Technologien

Edge-Computing

Nach der Definition von IBM„Edge Computing ein verteiltes Computing-Framework, das Unternehmensanwendungen näher an Datenquellen wie IoT-Geräte oder lokale Edge-Server bringt. Diese Nähe zu den Daten an ihrer Quelle kann echt coole Vorteile für dein Unternehmen bringen, wie schnellere Einblicke, bessere Reaktionszeiten und eine bessere Verfügbarkeit der Bandbreite.

Die Nähe zu den Daten ermöglicht eine Verarbeitung näher an der Quelle, was die Latenz reduziert und die Geschwindigkeit der Entscheidungsfindung verbessert. Das ist bei IoT-Anwendungen, wo Echtzeitverarbeitung wichtig ist, echt entscheidend. Da du keine Daten an zentrale Standorte übertragen musst, kann Edge Computing außerdem die Bandbreitennutzung und die Reaktionszeiten reduzieren. Das heißt, man kann schneller und genauer Entscheidungen treffen, die auf Daten basieren.

KI-Integration

Laut der Definition von RST „verknüpft die KI-Integration künstliche Intelligenz direkt mit Produkten und Systemen.ration entwines artificial intelligence capabilities directly into products and systems. Anstatt dass KI als externes Tool genutzt wird, bringt die Integration ihre Analysefähigkeiten direkt mit ein, um alle Aspekte der Leistung zu verbessern.

Die Kombination von künstlicher Intelligenz (KI) mit Big Data hat die Art und Weise verändert, wie Firmen Daten analysieren und darauf reagieren. KI-Algorithmen, vor allem Modelle für maschinelles Lernen (ML), machen es Systemen möglich, Muster zu erkennen, Vorhersagen zu treffen und Entscheidungsprozesse zu automatisieren.

In der Fertigung hilft die KI-Integration zum Beispiel bei der vorausschauenden Wartung, sodass Firmen erkennen können, wann Geräte wahrscheinlich ausfallen werden, und vorbeugende Maßnahmen ergreifen können. Das spart Ausfallzeiten und Betriebskosten. Genauso kann KI-gestützte Anomalieerkennung ungewöhnliche Transaktionen im Finanzbereich erkennen und so in Echtzeit Betrug verhindern.

Hybride Cloud-Umgebungen

Laut Microsoftist „eineHybrid Cloud – manchmal auch Cloud Hybrid genannt – eine Computerumgebung, die ein lokales Rechenzentrum mit einer öffentlichen Cloud verbindet, sodass Daten und Anwendungen zwischen beiden geteilt werden können.“

Eine Hybrid-Cloud-Architektur bringt das Beste aus der Skalierbarkeit der Public Cloud und der Sicherheit vor Ort zusammen. Es bietet die Flexibilität, sensible Daten sicher intern zu speichern und gleichzeitig die Cloud für größere, weniger sensible Aufgaben zu nutzen. Hybride Cloud-Umgebungen sind auch kosteneffizient, weil Unternehmen ihre Infrastruktur je nach Bedarf vergrößern oder verkleinern können.

Herausforderungen bei der Umsetzung von Big-Data-Technologien

Die Nutzung von Big-Data-Technologien hat viele Vorteile, bringt aber auch einige Herausforderungen mit sich. Einige dieser Überlegungen sind unten aufgeführt:

- Datenintegrations: Das Zusammenführen von Daten aus verschiedenen Quellen – egal ob strukturiert, unstrukturiert oder halbstrukturiert – ist eine Herausforderung, wenn es darum geht, Konsistenz und Genauigkeit zu gewährleisten.

- Skalierbarkeit: Wenn die Datenmengen wachsen, muss die Infrastruktur effizient skalierbar sein, ohne dass die Leistung darunter leidet.

- Sicherheitsbedenken: Um sensible Daten in Big-Data-Systemen zu schützen, braucht man starke Verschlüsselung, Zugriffskontrollen und muss die Vorschriften einhalten. Mit Vorschriften wie der DSGVO und dem CCPA stehen Unternehmen weltweit unter zunehmendem Druck, Sicherheitsmaßnahmen umzusetzen und gleichzeitig die Privatsphäre der Nutzer zu schützen.

- Hohe Kosten: Die Einrichtung und Pflege einer Big-Data-Infrastruktur braucht echt viel Geld für Technik und Leute.

- Datenqualität und -verwaltung: Da die Daten aus verschiedenen Quellen kommen, ist es echt schwierig, ihre Genauigkeit, Konsistenz und Zuverlässigkeit sicherzustellen. Außerdem kann mangelnde Governance zu Compliance-Problemen und Geschäftsrisiken führen.

Fazit

Big-Data-Technologien sind echt wichtig für Unternehmen, um sich einen Vorsprung zu verschaffen, indem sie aus riesigen Datenmengen nützliche Erkenntnisse gewinnen. Von der Speicherung bis hin zur Analyse und Visualisierung sind diese Tools die Grundpfeiler, auf denen die moderne datengestützte Entscheidungsfindung basiert. Wenn man sich über neue Trends wie KI-Integration, Edge-Computing und Hybrid-Cloud-Architekturen auf dem Laufenden hält, können Unternehmen effizient wachsen und im Datenmanagement innovativ sein. Wenn man diese Technologien richtig nutzt, können Unternehmen Rohdaten in wertvolle Ressourcen verwandeln und sich so in einer datengesteuerten Wirtschaft einen Wettbewerbsvorteil verschaffen. Bevor man sich für die Umsetzung entscheidet, sollte man sich aber über die Kosten und andere Herausforderungen im Klaren sein.

Wenn du mehr wissen willst, schau dir doch mal die folgenden Quellen an:

- Ein Leitfaden für Big-Data-Schulungen: Schau dir mal an, wie wichtig Big-Data-Schulungen sind und welche Business-Lösungen DataCamp anbietet.

- Transferlernen: Nutze die Erkenntnisse aus Big-Data-: Finde heraus, was Transferlernen ist, wofür es hauptsächlich genutzt wird und warum es für Datenwissenschaftler so wichtig ist.

- Die Kraft der Datenwissenschaft in der Cloud nutzen: Die Cloud-Analytics-Experten von Exasol reden über die Vorteile der Cloud-Migration, wirtschaftliche Auslöser, Erfolgsgeschichten und wie wichtig Flexibilität ist.

- Flink gegen Spark-: Flink im Vergleich zu Spark, zwei Open-Source-Frameworks, die bei der Batch- und Stream-Verarbeitung ganz vorne mit dabei sind.

Erfahrener Profi in den Bereichen Datenwissenschaft, künstliche Intelligenz, Analytik und Datenstrategie.

FAQs

Was ist Big Data?

Big Data ist die Bezeichnung für riesige Mengen an strukturierten und unstrukturierten Daten, die zu groß oder zu komplex sind, um mit herkömmlicher Datenverarbeitungssoftware effizient zu verarbeiten.

Wie kann Big Data dem Einzelhandel helfen?

Mit Big Data können Einzelhändler ihre Ladenstandorte besser planen, ihr Marketing anpassen, ihren Lagerbestand verwalten und das Kundenerlebnis durch Standort- und Verhaltensdaten verbessern.

Was ist Edge-Computing bei Big Data?

Edge Computing verarbeitet Daten näher an ihrer Quelle, was die Latenzzeit reduziert und eine schnellere Entscheidungsfindung in Echtzeit ermöglicht, was besonders bei IoT-Anwendungen nützlich ist.

Wie hilft Big Data bei der Betrugsaufdeckung im Finanzbereich?

Big Data checkt Transaktionsmuster in Echtzeit, findet Unregelmäßigkeiten und stoppt betrügerische Aktivitäten, indem es auf ungewöhnliches Verhalten aufmerksam macht.

Was sind die Herausforderungen bei der Umsetzung von Big-Data-Technologien?

Zu den üblichen Herausforderungen gehören Datenintegration, Skalierbarkeit, Sicherheitsbedenken, hohe Kosten, die Aufrechterhaltung der Datenqualität und die Echtzeit-Datenverarbeitung.