Curso

Esta guía está dirigida a cualquier persona que trabaje con analistas de datos, ingenieros, científicos o responsables de la toma de decisiones y desee comprender qué es la buena calidad de los datos y cómo conseguirla. Analizaremos las dimensiones clave de la calidad de los datos, exploraremos cómo evaluarlas y gestionarlas, y abordaremos medidas prácticas para mejorar tus conjuntos de datos con el tiempo.

Si eres nuevo en este tema, te recomendamos que empieces por nuestro curso Introducción a la calidad de los datos, queofrece una visión general de los conceptos básicos y los retos cotidianos.

Al finalizar, podrás identificar problemas con los datos de forma temprana, comprender cómo resolverlos y sentar las bases para obtener datos más precisos, coherentes y útiles en todos tus proyectos.

¿Qué es la calidad de los datos?

Antes de corregir los datos erróneos, debes saber cómo son los datos correctos.

La calidad de los datos se refiere a si tus datos son adecuados para el uso previsto. Los datos fiables reflejan los valores del mundo real, lo que te ayuda a tomar decisiones con confianza, ya sea analizando tendencias, ejecutando operaciones o creando sistemas.

Esta definición no es válida para todos los casos. Es posible que a un equipo de marketing le importe más tener los correos electrónicos actualizados, mientras que un ingeniero podría centrarse en la coherencia del esquema. Por lo tanto, la calidad de los datos tiene tanto estándares universales como partes específicas del contexto.

Para aportar coherencia a la forma en que los equipos evalúan los datos, la mayoría de los marcosdefinen un conjunto de dimensiones de calidad de los datos, como la precisión, la integridad, la validez, la puntualidad, la unicidad y la coherencia. Esto ayuda a los equipos a hablar el mismo idioma a la hora de evaluar y mejorar vuestros datos.

¿Por qué es importante la calidad de los datos?

Los datos afectan a casi todos los ámbitos de una organización, desde la información sobre los clientes hasta el cumplimiento normativo. Cuando esos datos son erróneos, las cosas se estropean. Las decisiones se tuercen. Los equipos pierden tiempo.

Y en los sectores regulados, los riesgos son aún mayores. Supongamos que un minorista envía una campaña promocional basada en una lista de contactos obsoleta. No solo perderán compromiso, sino que probablemente también desperdiciarán la inversión publicitaria. O imagina un hospital que tiene que lidiar con registros duplicados o incoherentes de pacientes.

Los datos incorrectos pueden provocar problemas de cumplimiento normativo, pérdida de ingresos y una mala experiencia del cliente. Según Gartner, los datos erróneos cuestan a las empresas millones cada año solo en ineficiencias. Por otro lado, los datos fiables permiten tomar decisiones más rápidas, automatizar mejor, mejorar la eficiencia ( ) y colaborar mejor. No es algo que esté bien tener, es una parte fundamental para gestionar un negocio funcional.

Dimensiones fundamentales de la calidad de los datos

Para saber qué hay que arreglar, primero hay que saber qué hay que medir. Ya he mencionado estas ideas anteriormente, al explicar qué es la calidad de los datos, pero aquí voy a entrar en más detalle. Las siguientes dimensiones estructuran el proceso y demuestran la utilidad y fiabilidad de tus datos en el mundo real.

1. Exactitud y exhaustividad

La precisión significa que tus datos reflejan la verdad. Si la dirección de un cliente es incorrecta, ni siquiera una logística perfecta podrá ayudar. La exhaustividad se refiere a disponer de toda la información necesaria. Un campo «categoría de producto» vacío podría estropearlo todo, como el filtrado, el análisis o los informes de cumplimiento. A menudo necesitarás una combinación de comprobaciones de validación, bucles de retroalimentación y auditorías para mantener tanto la precisión como la integridad. Una empresa de comercio electrónico redujo los errores en el cumplimiento de los pedidos al marcar los formularios de pedido incompletos antes de su envío.

2. Coherencia y puntualidad

La coherencia se refiere a que tus datos sean consistentes en todos los sistemas. Si un cliente está marcado como «activo» en el CRM pero «inactivo» en la facturación, es probable que se produzca algún tipo de confusión o, lo que es peor, errores de facturación. La puntualidad se refiere a la frescura de los datos, por así decirlo. Un panel de ventas actualizado semanalmente no te ayudará a responder a una caída que se produjo ayer. Ahí es donde entran en juego el ETL en tiempo real, las tareas programadas y/o la supervisión de marcas de tiempo.

3. Validez y singularidad

La validez comprueba que los datos siguen los formatos y la lógica esperados. Un número de teléfono al que le falta el código de país puede ser válido desde el punto de vista técnico, pero no se puede utilizar. Depende. La singularidad consiste en evitar duplicados. Los registros duplicados pueden alterar los informes y provocar experiencias frustrantes para los usuarios, como recibir el mismo correo electrónico dos veces. Creo que las reglas de validación y las rutinas de deduplicación son muy útiles en este sentido. Una empresa de SaaS mejoró la precisión de la incorporación en un 40 % tras añadir comprobaciones de formato y detección de duplicados aproximados.

4. Integridad y utilidad

La integridad garantiza que los datos se mantengan coherentes y conectados mientras se transfieren entre sistemas. Se trata de preservar las relaciones y evitar la corrupción silenciosa de los datos. La utilidad es más sencilla: ¿Estos datos ayudan a alguien a realizar su trabajo? Si recopilas todas las visitas a la página pero no puedes vincularlas a los usuarios, creo que lo que tienes es ruido, no un. Los marcos de gobernanza ayudan a gestionar ambos aspectos. Garantizan que los datos fluyan de forma limpia y sigan siendo significativos para el negocio.

Ventajas de una buena calidad de los datos

Cuando los datos están limpios, son precisos y oportunos, toda la organización nota la diferencia:

1. Mejores decisiones

Los datos precisos dan confianza a los equipose. Las finanzas pueden confiar en las previsiones. El marketing puede confiar en las tasas de interacción. El producto puede actuar sobre las tendencias de los usuarios. Por ejemplo, un hospital con datos limpios puede realizar un seguimiento más sencillo de las deficiencias en la atención y mejorar los planes de tratamiento.

2. Eficiencia operativa

Por otro lado, los datos incorrectos ralentizan todo el proceso. Tú u otra persona pierden horas depurando informes, conciliando sistemas o corrigiendo importaciones incorrectas. Los datos limpios significan menos sorpresas y menos tiempo dedicado a la gestión de e es. Una empresa de logística redujo las solicitudes de asistencia en un 23 % simplemente limpiando los metadatos de los productos.

3. Cumplimiento normativo y gestión de riesgos

Normativas como el RGPD y la HIPAA te obligan a gestionar tus datos con cuidado. Eso significa saber dónde se encuentra, quién es su propietario y si es correcto. Los datos limpios también facilitan las auditorías y reducen la posibilidad de cometer errores.

4. Mejores experiencias para los clientes

Cuando tus sistemas están sincronizados, los clientes no tienen que repetir la misma información. No enviar correos electrónicos duplicados. No hay facturas rotas. No hay perfiles incompatibles entre los distintos puntos de contacto. Una visión unificada ayuda a los equipos a ofrecer un servicio más rápido y recomendaciones más relevantes.

Retos y problemas comunes relacionados con la calidad de los datos

A continuación se presentan algunos de los obstáculos más comunes en materia de calidad de los datos que se me ocurren y sus soluciones correspondientes.

1. Datos incompletos e inexactos

Las entradas descuidadas, las fuentes obsoletas o los errores manuales crean lagunas en tus conjuntos de datos. Estos errores se propagan a los informes y a la toma de decisiones. Las correcciones incluyen una mejor validación de la entrada, limpieza ascendente y alertas para datos faltantes o sospechosos.

2. Duplicación e inconsistencia

Los registros múltiples para el mismo cliente o los formatos incompatibles pueden minar la confianza en tus paneles de control. La lógica de coincidencia y fusión (aquí esperamos que también esté respaldada por reglas de formato claras) ayuda a resolver este tipo de problemas.

3. Seguridad, privacidad y frescura

Los datos antiguos o expuestos crean riesgos de cumplimiento normativo. Normativas como el RGPD, que he mencionado anteriormente, y la CCPA, que voy a mencionar ahora, penalizan el mal manejo de los datos. Mantener los datos actualizados y seguros implica equilibrar las políticas de retención, las técnicas de enmascaramiento y las actualizaciones rápidas.

4. Integración y silos de datos

Cuando los departamentos utilizan herramientas independientes, los datos se fragmentan y no existe una única fuente de información veraz. La integración, a través de API, almacenes o canalizaciones basadas en eventos, reúne tus datos y reduce la duplicación.

5. IA, datos oscuros y retos emergentes

Los archivos de registro, los resultados de la IA y las fuentes no estructuradas generan toneladas y toneladas de datos desordenados. Estos datos suelen ocultar valor o errores. Los procesos de filtrado, enriquecimiento y etiquetado ayudan a que estos datos sean utilizables y minimizan la introducción de ruido.

Gestión de la calidad de los datos: Procesos y mejores prácticas

El siguiente paso y lo siguiente de lo que voy a hablar es de la implantación de sistemas de gestión eficaces.

Evaluación y estrategia

Empieza con un chequeo médico. Perfilad vuestros datos, calculad métricas básicas (como, por ejemplo, valores que faltan, duplicados) y comparáos con los estándares relevantes en vuestro campo. A continuación, crea una estrategia que se adapte a tus necesidades. Las aplicaciones orientadas al cliente pueden dar prioridad a la actualidad. Los sistemas financieros se centran en la precisión.

Limpieza y supervisión

Limpiar significa arreglar lo que ya está mal: campos que faltan, enlaces rotos, lo que sea. SQL, Python y Excel siguen siendo las herramientas más utilizadas, junto con otras como OpenRefine o Power Query. La supervisión evita que surjan nuevos problemas. Añade reglas de validación, comprobaciones programadas y herramientas de alerta para detectar problemas en una fase temprana.

Mejores prácticas

Automatiza todo lo que puedas. Utiliza tareas programadas para la limpieza, escribe pruebas para métricas clave y configura alertas de canalización. Y asigna la propiedad porque alguien tiene que ocuparse cuando algo se rompe. Ahí es donde entran en juego los administradores de datos. Vincula los objetivos de calidad de los datos a los resultados reales y realiza un análisis de las causas fundamentales cuando surjan problemas.

Herramientas y tecnologías para la calidad de los datos

La gestión de la calidad de los datos a gran escala requiere las herramientas adecuadas. Tanto si estás limpiando millones de registros como si estás supervisando flujos de datos en tiempo real, contar con la tecnología adecuada marca realmente la diferencia.

1. Criterios de evaluación

La escalabilidad, la flexibilidad y la integración son imprescindibles. Busca herramientas que admitan tu volumen de datos, gestionen comprobaciones en tiempo real y se conecten a tu pila, ya sea en la nube, híbrida o local. Se valorará que la herramienta incluya machine learning, del que todo el mundo habla y con razón, o funciones de creación de reglas para automatizar las correcciones más habituales.

2. Soluciones líderes

Entre las herramientas más conocidas se encuentran Talend, Informatica, Ataccama e IBM InfoSphere. Incluyen flujos de trabajo para la creación de perfiles, la limpieza y la supervisión. Las pilas nativas de la nube, como AWS Glue y Azure Purview, también ofrecen funciones de DQ integradas.

3. Calidad de los datos como servicio (DQaaS)

Si no deseas gestionar tu propia infraestructura, DQaaS podría ser una opción más adecuada. Estas herramientas exponen la validación, la creación de perfiles o la supervisión como API, lo que imagino que es ideal para añadir comprobaciones a los formularios de los clientes o a los procesos de ingestión sin necesidad de alojar nada vosotros mismos.

Calidad de los datos en la gobernanza de datos

La calidad de los datos no existe de forma aislada, sino que está estrechamente relacionada con la gobernanza. Un marco de gobernanza sólido sienta las bases para una buena gestión de los datos en toda la organización.

Integración de la gobernanza

Las políticas y normas definen qué es la calidad, quién es responsable y cómo se garantiza su cumplimiento. Sin esta estructura, las expectativas varían y los problemas se multiplican. Una gobernanza sólida significa menos sorpresas y traspasos más claros entre equipos.

Gestión de datos maestros (MDM)

MDM crea una fuente única y precisa ( ) para entidades básicas, como clientes o productos. Si se hace correctamente, reduce la duplicación y mejora la coherencia entre los sistemas. Los minoristas utilizan MDM para fusionar los registros de la tienda y los registros online. Los fabricantes sincronizan los catálogos de productos entre regiones. El MDM es una de las formas más directas de mejorar la calidad de los datos a gran escala.

Marcos y normas de calidad de los datos

Los marcos y las normas ayudan a las organizaciones a estructurar sus iniciativas de calidad de datos de forma coherente y cuantificable. Ofrecen metodologías probadas para evaluar las prácticas actuales e identificar áreas de crecimiento.

1. ISO 8000

La norma ISO 8000 proporciona una definición clara de la calidad de los datos y describe los métodos para medirla. Abarca la integridad, la precisión y la normalización del formato. Es especialmente útil para equipos que trabajan en diferentes países o departamentos con definiciones diferentes.

2. TDQM y DAMA DMBOK

TDQM se centra en la mejora continua. Mides, analizas, mejoras y repites el proceso. Sencillo, pero eficaz, especialmente para equipos que desarrollan procesos iterativos. DAMA DMBOK amplía la imagen. Abarca no solo la calidad, sino también la arquitectura, la gobernanza, la integración y la seguridad de los datos. Piensa en ello como un manual completo para operaciones de datos a nivel empresarial.

3. Modelos de madurez

Los modelos de madurez muestran dónde te encuentras y hacia dónde debes dirigirte. Pasas de un enfoque ad hoc (limpieza manual, soluciones reactivas) a uno optimizado (controles automatizados, gobernanza integrada). Comprender tu nivel actual ayuda a priorizar los siguientes pasos, ya sea introducir comprobaciones de validación o asignar propietarios de datos.

Medición del ROI en la calidad de los datos

Para justificar las inversiones en calidad de datos, es recomendable vincular los esfuerzos de mejora con resultados empresariales reales. Esta sección trata sobre métodos prácticos para medir el retorno de la inversión (ROI), incluyendo el ahorro de costes y las métricas de rendimiento.

Análisis coste-beneficio

Empieza por enumerar el coste que supone disponer de datos erróneos: correcciones manuales, informes fallidos, pérdida de clientes. A continuación, enumera las ventajas de contar con datos limpios: mejores conversiones, menos errores, decisiones más rápidas.

Utiliza una fórmula básica de ROI:

ROI = (Net Benefits – Total Costs) / Total CostsSé práctico: menos tickets de soporte, menos tiempo dedicado a la depuración y auditorías de cumplimiento más rápidas.

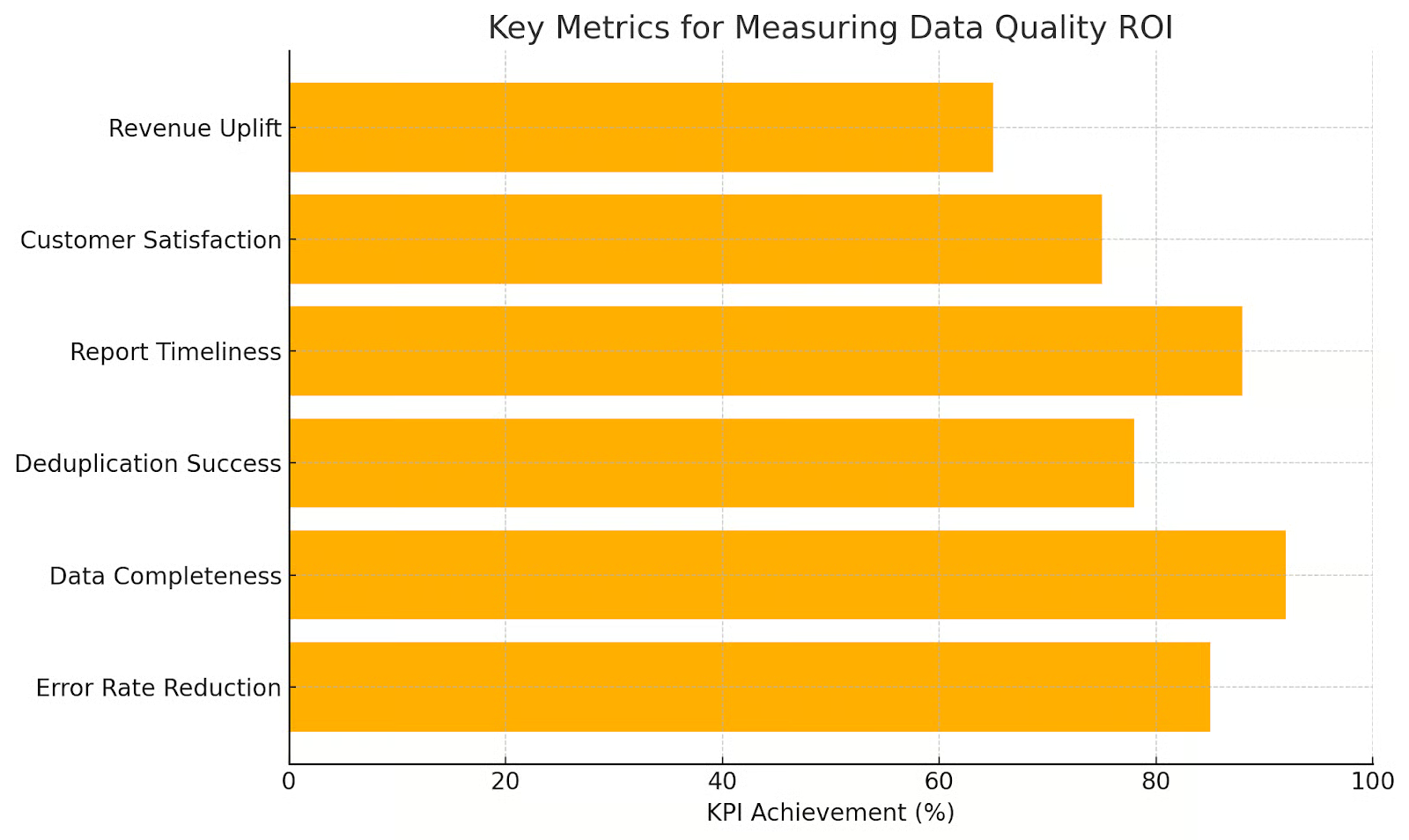

Métricas y KPI

Realiza un seguimiento de las métricas que se corresponden con los resultados. Ejemplos:

- Tasa de error: ¿Cuántos campos faltan o son inválidos?

- Tiempo de reparación: ¿Con qué rapidez se resuelven los problemas?

- Precisión de las previsiones: ¿Están mejorando los modelos de ventas?

Fomentar una cultura de calidad de los datos

Lo último que mencionaré: Crear sistemas de datos de alta calidad no es solo cuestión de herramientas y procesos, como gran parte de lo que hemos hablado hasta ahora, sino que también requiere personas que comprendan y valoren el papel de los datos. El liderazgo, la formación y el compromiso continuo contribuyen a crear una cultura de calidad de los datos.

Liderazgo y responsabilidad

El liderazgo establece prioridades. Si los ejecutivos no se preocupan por la calidad de los datos, nadie más lo hará. Eso está garantizado. Asigna la propiedad, define las responsabilidades y vincula los indicadores de calidad al rendimiento real del trabajo.

Formación y herramientas

La mayoría de la gente quiere hacer lo correcto. Solo necesitan orientación para ayudarles a hacerlo. Ofrece formación. Facilita el marcado de datos insuficientes. Proporciona herramientas para la limpieza autónoma. Herramientas como Great Expectations o Soda permiten a equipos sin conocimientos técnicos validar y supervisar datos sin necesidad de escribir código.

Cultura sostenible

La cultura se desvanece sin refuerzo. Realiza auditorías. Comparte tus éxitos y tus fracasos. Celebra las mejoras. Vincula los esfuerzos a los objetivos empresariales, como la expansión a nuevos mercados o la mejora de la retención de clientes. Haz que la calidad de los datos forme parte del trabajo diario, no sea un proyecto puntual.

Conclusión

Espero que a estas alturas aprecien dos palabras muy sencillas pero importantes: Calidad de los datos. La calidad de los datos afecta a todas las áreas del negocio, y contar con datos de calidad significa disponer de datos optimizados, coherentes y fiables que generan confianza, mejoran la toma de decisiones y (lo que más importa a las empresas) favorecen el crecimiento.

Si ocupas un puesto directivo y estás leyendo sobre la calidad de los datos, debes saber que DataCamp for Business ofrece soluciones empresariales que pueden ayudarte. Podemos ayudarte a crear soluciones para todo tipo de retos y trabajar para mejorar las habilidades de todo tu equipo a la vez. Además, creamos programas de aprendizaje personalizados con informes únicos, así que ponte en contacto con nosotros hoy mismo.

Redactor técnico especializado en IA, ML y ciencia de datos, que hace que las ideas complejas sean claras y accesibles.