Kurs

Dieser Leitfaden ist für alle gedacht, die mit Datenanalysten, Ingenieuren, Wissenschaftlern oder Entscheidungsträgern zusammenarbeiten und wissen wollen, was gute Datenqualität ist und wie man sie erreicht. Wir schauen uns die wichtigsten Aspekte der Datenqualität an, zeigen, wie man sie bewertet und verwaltet, und geben praktische Tipps, wie du deine Datensätze mit der Zeit verbessern kannst.

Wenn du dich noch nicht so gut auskennst, solltest du vielleicht mit unserem Kurs „Einführung in die Datenqualität“ anfangen. Dabekommst du einen Überblick über die Grundlagen und die alltäglichen Herausforderungen.

Am Ende kannst du Datenprobleme früh erkennen, weißt, wie du sie löst, und hast eine Basis für genauere, konsistentere und besser nutzbare Daten in all deinen Projekten.

Was ist Datenqualität?

Bevor du schlechte Daten bereinigen kannst, musst du wissen, wie gute Daten aussehen.

Bei der Datenqualität geht's darum, ob deine Daten für den vorgesehenen Zweck passen. Gute Daten zeigen, wie es wirklich läuft, und helfen dir, gute Entscheidungen zu treffen, egal ob du Trends analysierst, den Betrieb am Laufen hältst oder Systeme aufbaust.

Diese Definition passt nicht für alle. Ein Marketingteam legt vielleicht am meisten Wert auf aktuelle E-Mail-Adressen, während ein Techniker sich eher auf die Konsistenz des Schemas konzentriert. Datenqualität hat also sowohl allgemeine Standards als auch kontextspezifische Teile.

Um die Art und Weise, wie Teams Daten bewerten, einheitlicher zu gestalten , definieren die meisten Frameworkseine Reihe von Datenqualitätsdimensionen, wie Genauigkeit, Vollständigkeit, Gültigkeit, Aktualität, Eindeutigkeit und Konsistenz. So können Teams bei der Bewertung und Verbesserung ihrer Daten auf einer Wellenlänge bleiben.

Warum ist Datenqualität wichtig?

Daten sind in fast jedem Bereich einer Organisation wichtig, von Kundeninfos bis hin zur Einhaltung von Vorschriften. Wenn diese Daten fehlerhaft sind, geht was schief. Entscheidungen gehen schief. Teams verschwenden Zeit.

Und in regulierten Branchen sind die Risiken sogar noch größer. Nehmen wir mal an, ein Einzelhändler verschickt eine Werbekampagne anhand einer veralteten Kontaktliste. Sie verlieren nicht nur das Engagement, sondern verschwenden wahrscheinlich auch Werbegeld. Oder stell dir ein Krankenhaus vor, das mit doppelten oder widersprüchlichen Patientenakten zu kämpfen hat.

Schlechte Daten können zu Problemen mit der Einhaltung von Vorschriften, Umsatzverlusten und schlechten Kundenerfahrungen führen. Laut Gartner kosten schlechte Daten Unternehmen jedes Jahr Millionen allein durch Ineffizienzen. Auf der anderen Seite sorgen zuverlässige Daten für schnellere Entscheidungen, sauberere Automatisierung, bessere Zusammenarbeit und mehr Transparenz. Das ist kein nettes Extra, sondern ein wichtiger Teil davon, ein funktionierendes Unternehmen zu führen.

Kernaspekte der Datenqualität

Um zu wissen, was man verbessern muss, muss man erst mal wissen, was man messen soll. Ich hab diese Ideen schon mal angeschnitten, als ich erklärt hab, was Datenqualität ist, aber jetzt geh ich genauer drauf ein. Die folgenden Dimensionen geben dem Prozess Struktur und zeigen, wie gut deine Daten in der Praxis funktionieren und wie zuverlässig sie sind.

1. Richtig und komplett

Genauigkeit heißt, dass deine Daten echt stimmen. Wenn die Adresse eines Kunden falsch ist, hilft auch die beste Logistik nicht weiter. Vollständigkeit bedeutet, dass alle wichtigen Infos da sind. Ein leeres Feld „Produktkategorie“ kann alles durcheinanderbringen, wie zum Beispiel Filter, Analysen oder Compliance-Berichte. Oft brauchst du eine Mischung aus Validierungsprüfungen, Feedback-Schleifen und Audits, um sowohl die Genauigkeit als auch die Vollständigkeit zu gewährleisten. Ein E-Commerce-Unternehmen hat Fehler bei der Auftragsabwicklung reduziert, indem es unvollständige Bestellformulare vor dem Absenden markiert hat.

2. Konsequenz und Pünktlichkeit

Konsistenz bedeutet, dass deine Daten in allen Systemen übereinstimmen. Wenn ein Kunde im CRM als „aktiv“, aber in der Abrechnung als „inaktiv“ markiert ist, kann das zu Verwirrung oder (schlimmer noch) zu Abrechnungsfehlern führen. Aktualität ist sozusagen die Frische der Daten. Ein wöchentlich aktualisiertes Verkaufs-Dashboard hilft dir nicht, auf einen Rückgang von gestern zu reagieren. Hier kommen Echtzeit-ETL, geplante Jobs und/oder Zeitstempelüberwachung ins Spiel.

3. Gültigkeit und Einzigartigkeit

Die Gültigkeit checkt, ob die Daten so aussehen, wie sie sollen, und ob alles logisch passt. Eine Telefonnummer ohne Ländervorwahl kann zwar technisch funktionieren, ist aber trotzdem nicht brauchbar. Das kommt drauf an. Einzigartigkeit bedeutet, Duplikate zu vermeiden. Doppelte Datensätze können die Berichterstellung durcheinanderbringen und zu frustrierenden Benutzererfahrungen führen, wie zum Beispiel, dass man dieselbe E-Mail zweimal bekommt. Ich denke, Validierungsregeln und Routinen zur Duplikatsbereinigung sind hier echt hilfreich. Ein SaaS-Unternehmen hat die Genauigkeit beim Onboarding um 40 % verbessert, nachdem es Formatprüfungen und die Erkennung von ungenauen Duplikaten eingeführt hat.

4. Integrität und Nützlichkeit

Integrität sorgt dafür, dass Daten konsistent und verknüpft bleiben, wenn sie zwischen Systemen verschoben werden. Es geht darum, Beziehungen zu pflegen und versteckte Datenbeschädigungen zu vermeiden. Nützlichkeit ist einfacher: Sind diese Daten für jemanden bei der Arbeit hilfreich? Wenn du alle Seitenaufrufe sammelst, sie aber nicht mit Nutzern verknüpfen kannst, hast du meiner Meinung nach nur Rauschen und keine-Einblicke. Governance-Rahmenbedingungen helfen dabei, beides zu regeln. Sie sorgen dafür, dass die Daten sauber fließen und für das Unternehmen sinnvoll bleiben.

Vorteile guter Datenqualität

Wenn die Daten sauber, genau und aktuell sind, merkt das die ganze Firma:

1. Bessere Entscheidungen

Genaue Daten geben Teams Selbstvertrauene. Die Finanzwelt kann sich auf Prognosen verlassen. Das Marketing kann sich auf die Interaktionsraten verlassen. Das Produkt kann auf Trends der Nutzer eingehen. Ein Krankenhaus mit sauberen Daten kann zum Beispiel Versorgungslücken leichter erkennen und Behandlungspläne verbessern.

2. Betriebliche Effizienz

Schlechte Daten hingegen bremsen alles aus. Du oder jemand anderes verschwendet Stunden damit, Berichte zu debuggen, Systeme abzugleichen oder fehlerhafte Importe zu reparieren. Saubere Daten bedeuten weniger Überraschungen und weniger Zeit für das Löschen von Bränden. Ein Logistikunternehmen hat die Support-Tickets um 23 % reduziert, indem es einfach die Produkt-Metadaten aufgeräumt hat.

3. Compliance und Risikomanagement

Vorschriften wie die DSGVO und HIPAA verlangen, dass du deine Daten sorgfältig verwaltest. Das heißt, man muss wissen, wo es ist, wem es gehört und ob es stimmt. Saubere Daten machen auch Audits einfacher und verringern das Risiko von Fehlern.

4. Bessere Kundenerfahrungen

Wenn deine Systeme zusammenarbeiten, müssen sich Kunden nicht mehr wiederholen. Keine doppelten E-Mails. Keine kaputten Rechnungen. Keine falschen Profile an den Kontaktpunkten. Mit einer einheitlichen Ansicht können Teams schneller helfen und bessere Vorschläge machen.

Häufige Probleme und Herausforderungen bei der Datenqualität

Hier sind ein paar der häufigsten Probleme bei der Datenqualität, die mir einfallen, und die Lösungen dafür.

1. Unvollständige und falsche Daten

Schlampige Eingaben, veraltete Quellen oder manuelle Fehler führen zu Lücken in deinen Datensätzen. Diese Fehler wirken sich auf die Berichterstattung und die Entscheidungsfindung aus. Die Fehlerbehebungen umfassen eine bessere Eingabevalidierung, eine Bereinigung der Upstream-Daten und Warnmeldungen bei fehlenden oder verdächtigen Daten.

2. Doppelte Angaben und Unstimmigkeiten

Mehrere Datensätze für denselben Kunden oder nicht passende Formate können das Vertrauen in deine Dashboards zerstören. Eine Logik zum Abgleichen und Zusammenführen (hoffentlich mit klaren Formatierungsregeln) hilft dabei, solche Probleme zu lösen.

3. Sicherheit, Datenschutz und Aktualität

Alte oder offengelegte Daten bringen Compliance-Risiken mit sich. Vorschriften wie die bereits erwähnte DSGVO und die jetzt erwähnte CCPA bestrafen den unsachgemäßen Umgang mit Daten. Um Daten aktuell und sicher zu halten, muss man Aufbewahrungsrichtlinien, Maskierungstechniken und schnelle Updates aufeinander abstimmen.

4. Integration und Datensilos

Wenn Abteilungen verschiedene Tools nutzen, werden die Daten unübersichtlich und es gibt keine zentrale Quelle für die Infos. Integration – über APIs, Lager oder ereignisgesteuerte Pipelines – bringt deine Daten zusammen und reduziert so Doppelarbeit.

5. KI, Dark Data und neue Herausforderungen

Logdateien, KI-Ausgaben und unstrukturierte Quellen machen jede Menge Daten, die echt chaotisch sind. Diese Daten verbergen oft wertvolle Infos oder Fehler. Filter-, Anreicherungs- und Tagging-Pipelines helfen dabei, diese Daten nutzbar zu machen und gleichzeitig Störsignale zu minimieren.

Datenqualitätsmanagement: Prozesse und bewährte Vorgehensweisen

Der nächste Schritt und das nächste Thema, über das ich reden werde, ist die Einrichtung von guten Managementsystemen.

Bewertung und Strategie

Mach erst mal einen Gesundheitscheck. Erstell ein Profil deiner Daten, berechne grundlegende Kennzahlen (wie zum Beispiel fehlende Werte oder Duplikate) und vergleiche sie mit den relevanten Standards in deinem Bereich. Dann leg eine passende Strategie fest. Kundenorientierte Apps legen vielleicht Wert auf Aktualität. Finanzsysteme legen Wert auf Genauigkeit.

Reinigung und Überwachung

Reinigen heißt, alles zu reparieren, was nicht stimmt – fehlende Felder, kaputte Links – was auch immer. SQL, Python und Excel sind hier immer noch die Hauptwerkzeuge, zusammen mit Tools wie OpenRefine oder Power Query. Überwachung verhindert, dass neue Probleme auftauchen. Füge Validierungsregeln, geplante Überprüfungen und Warnmeldungen hinzu, um Probleme frühzeitig zu erkennen.

Bewährte Vorgehensweisen

Mach alles, was du kannst, automatisch. Nutze geplante Jobs zum Aufräumen, schreib Tests für wichtige Kennzahlen und richte Pipeline-Warnungen ein. Und gib jemandem die Verantwortung, weil sich jemand darum kümmern muss, wenn was kaputt geht. Hier kommen die Datenverwalter ins Spiel. Verbinde die Ziele für die Datenqualität mit den tatsächlichen Ergebnissen und mach eine Ursachenanalyse, wenn Probleme auftauchen.

Tools und Technologien für Datenqualität

Um Datenqualität in großem Stil zu verwalten, braucht man die richtigen Tools. Egal, ob du Millionen von Datensätzen bereinigst oder Datenpipelines in Echtzeit überwachst – mit dem richtigen Tech-Stack machst du echt einen Unterschied.

1. Bewertungskriterien

Skalierbarkeit, Flexibilität und Integration sind ein Muss. Such nach Tools, die dein Datenvolumen unterstützen, Echtzeitprüfungen durchführen und sich in deine Infrastruktur einbinden lassen – egal, ob Cloud, Hybrid oder vor Ort. Bonuspunkte gibt's, wenn das Tool maschinelles Lernen hat, worüber alle reden und das echt Sinn macht, oder Funktionen zum Erstellen von Regeln, um häufige Korrekturen zu automatisieren.

2. Top-Lösungen

Bekannte Tools sind zum Beispiel Talend, Informatica, Ataccama und IBM InfoSphere. Die kommen mit Workflows für Profilerstellung, Bereinigung und Überwachung. Cloud-native Stacks wie AWS Glue und Azure Purview haben auch eingebaute DQ-Funktionen.

3. Datenqualität als Service (DQaaS)

Wenn du deine Infrastruktur nicht selbst verwalten willst, könnte DQaaS besser zu dir passen. Diese Tools stellen Validierung, Profilerstellung oder Überwachung als APIs zur Verfügung, was meiner Meinung nach super ist, um Kundenformulare oder Erfassungspipelines zu überprüfen, ohne selbst etwas hosten zu müssen.

Datenqualität in der Datenverwaltung

Datenqualität kommt nicht von allein, sie hängt stark mit der Unternehmensführung zusammen. Ein solides Governance-Framework ist die Basis für gut verwaltete Daten im ganzen Unternehmen.

Integration der Unternehmensführung

Richtlinien und Standards legen fest, wie Qualität aussieht, wer dafür verantwortlich ist und wie die Einhaltung sichergestellt wird. Ohne diese Struktur gibt's unterschiedliche Erwartungen und Probleme häufen sich. Gute Führung heißt weniger Überraschungen und klarere Übergaben zwischen den Teams.

Stammdatenverwaltung (MDM)

MDM sorgt für eine einzige, genaue Quelle für Infos zu wichtigen Sachen wie Kunden oder Produkten. Wenn das gut gemacht ist, gibt's weniger Doppelarbeit und alles läuft in allen Systemen gleich. Einzelhändler nutzen MDM, um Daten aus dem Laden und dem Online-Shop zusammenzuführen. Hersteller synchronisieren Produktkataloge über Regionen hinweg. MDM ist eine der direktesten Möglichkeiten, die Datenqualität in großem Maßstab zu verbessern.

Rahmenbedingungen und Standards für Datenqualität

Rahmenbedingungen und Standards helfen Unternehmen dabei, ihre Bemühungen um Datenqualität auf eine einheitliche und messbare Weise zu organisieren. Sie bieten bewährte Methoden, um aktuelle Praktiken zu bewerten und Bereiche mit Wachstumspotenzial zu erkennen.

1. ISO 8000

ISO 8000 gibt eine klare Definition von Datenqualität und zeigt, wie man sie messen kann. Es geht um Vollständigkeit, Genauigkeit und einheitliche Formate. Das ist besonders praktisch für Teams, die in verschiedenen Ländern oder Abteilungen mit unterschiedlichen Definitionen arbeiten.

2. TDQM und DAMA DMBOK

TDQM geht es um ständige Verbesserung. Du misst, analysierst, verbesserst und wiederholst den Prozess. Einfach, aber effektiv, vor allem für Teams, die iterative Prozesse aufbauen. DAMA DMBOK macht das Bild noch größer. Das umfasst nicht nur Qualität, sondern auch Datenarchitektur, Governance, Integration und Sicherheit. Stell dir das wie ein komplettes Handbuch für Datenoperationen auf Unternehmensebene vor.

3. Reifegradmodelle

Reifegradmodelle zeigen, wo du gerade stehst und wo du hinwillst. Sie wechseln von Ad-hoc-Maßnahmen (manuelle Bereinigung, reaktive Korrekturen) zu optimierten Prozessen (automatisierte Kontrollen, integrierte Governance). Wenn du weißt, wo du gerade stehst, kannst du besser entscheiden, was als Nächstes dran ist, ob du Validierungsprüfungen einführst oder Datenverantwortliche festlegst.

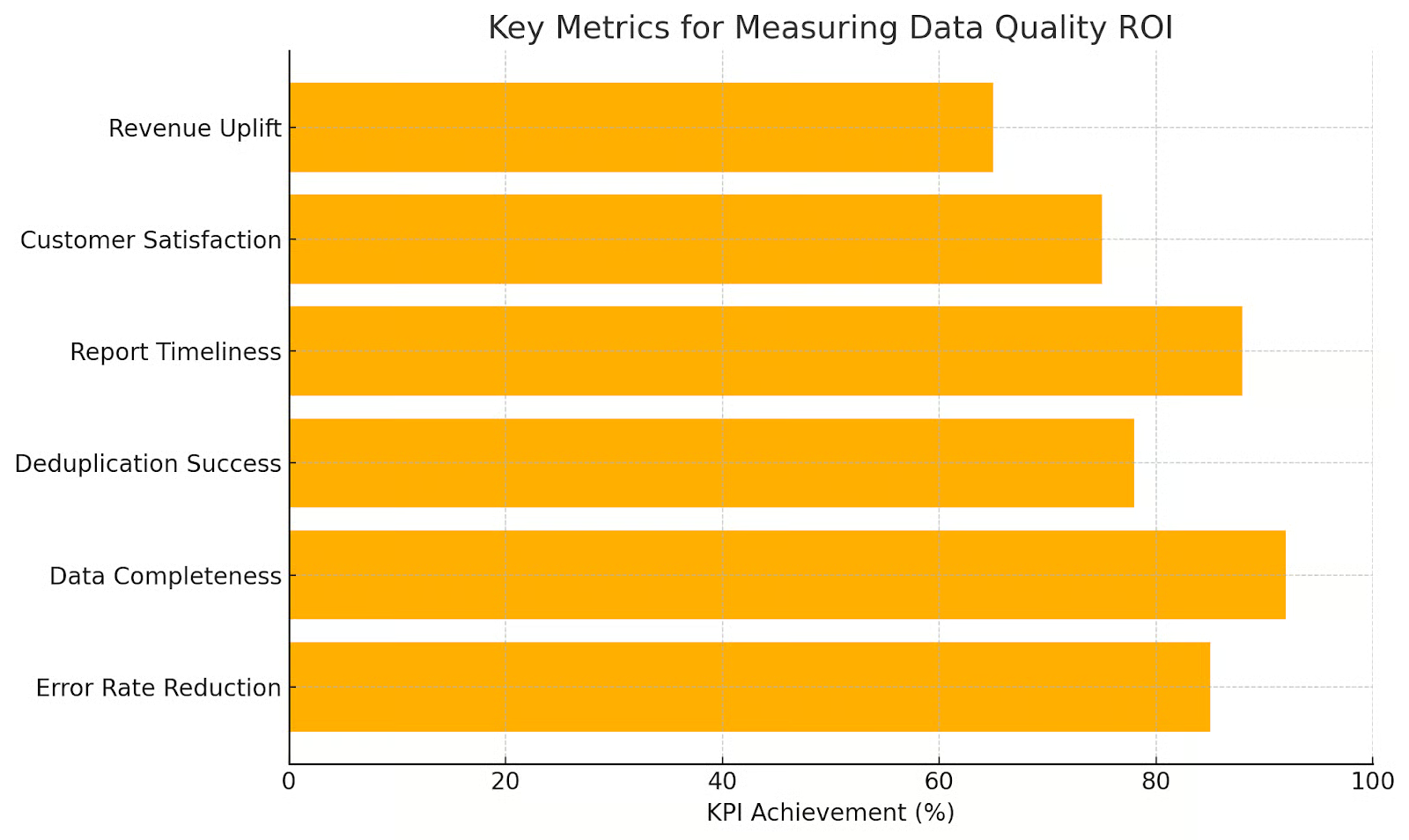

Den ROI von Datenqualität messen

Um Investitionen in die Datenqualität zu rechtfertigen, ist es gut, Verbesserungsmaßnahmen mit echten Geschäftsergebnissen zu verknüpfen. In diesem Abschnitt geht's um praktische Methoden, um den Return on Investment (ROI) zu messen, einschließlich Kosteneinsparungen und Leistungskennzahlen.

Kosten-Nutzen-Analyse

Mach dir erst mal klar, was schlechte Daten kosten: manuelles Ausbessern, fehlerhafte Berichte, verlorene Kunden. Schreib dann die Vorteile sauberer Daten auf: bessere Conversions, weniger Fehler, schnellere Entscheidungen.

Verwende eine einfache ROI-Formel:

ROI = (Net Benefits – Total Costs) / Total CostsBleib's einfach: weniger Support-Tickets, weniger Zeit für Fehlerbehebung, schnellere Compliance-Prüfungen.

Kennzahlen und KPIs

Lernpfad-Metriken, die auf Ergebnisse ausgerichtet sind. Beispiele:

- Fehlerquote: Wie viele Felder fehlen oder sind nicht in Ordnung?

- Zeit zum Reparieren: Wie schnell werden Probleme gelöst?

- Prognosegenauigkeit: Werden die Vertriebsmodelle besser?

Eine Kultur der Datenqualität schaffen

Das Letzte, was ich noch sagen will: Um gute Datensysteme auf die Beine zu stellen, braucht's nicht nur Tools und Prozesse, wie wir schon oft gesagt haben. Man braucht auch Leute, die wissen, wie wichtig Daten sind, und die das wirklich schätzen. Führung, Schulung und ständiges Engagement tragen zu einer Kultur der Datenqualität bei.

Führung und Verantwortung

Die Führung legt Prioritäten fest. Wenn die Chefs sich nicht um die Datenqualität kümmern, macht es auch sonst niemand. Das ist garantiert. Verteil die Verantwortung, leg Aufgaben fest und verknüpfe Qualitätskennzahlen mit der tatsächlichen Arbeitsleistung.

Schulungen und Tools

Die meisten Leute wollen das Richtige machen. Sie brauchen nur ein bisschen Hilfe dabei. Biete Schulungen an. Mach es einfach, unvollständige Daten zu markieren. Stell Tools für die Selbstbereinigung bereit. Mit Tools wie Great Expectations oder Soda können auch Leute ohne Programmierkenntnisse Daten checken und überwachen, ohne Code schreiben zu müssen.

Kultur pflegen

Kultur verblasst, wenn sie nicht gepflegt wird. Mach Audits. Teile deine Erfolge und Misserfolge. Freu dich über Verbesserungen. Verbinde die Bemühungen mit den Geschäftszielen, wie zum Beispiel die Expansion in neue Märkte oder die Verbesserung der Kundenbindung. Mach die Datenqualität zu einem Teil deiner Arbeit, nicht nur zu einem einmaligen Projekt.

Fazit

Ich hoffe, du weißt jetzt zwei ganz einfache, aber wichtige Wörter zu schätzen: Datenqualität. Die Datenqualität ist wichtig für alles im Unternehmen. Gute Daten sind schlank, konsistent und zuverlässig, schaffen Vertrauen, helfen bei der Entscheidungsfindung und – was für Unternehmen am wichtigsten ist – sie bringen das Unternehmen voran.

Wenn du in einer Führungsposition bist und dich über Datenqualität informierst, solltest du wissen, dass DataCamp for Business Unternehmenslösungen anbietet, die dir helfen können. Wir helfen dir dabei, Lösungen für alle möglichen Herausforderungen zu finden, dein gesamtes Team auf einmal weiterzubilden und individuelle Lernpfade mit einzigartigen Berichten zu erstellen. Also, melde dich noch heute bei uns.

Technischer Redakteur, der sich auf KI, ML und Datenwissenschaft spezialisiert hat und komplexe Ideen verständlich und nachvollziehbar macht.