Cours

Ce guide s'adresse à toute personne travaillant avec des analystes de données, des ingénieurs, des scientifiques ou des décideurs et souhaitant comprendre ce qu'est une bonne qualité des données et comment l'obtenir. Nous analyserons les principaux aspects de la qualité des données, examinerons comment les évaluer et les gérer, et aborderons les mesures pratiques à prendre pour améliorer vos ensembles de données au fil du temps.

Si vous débutez dans ce domaine, nous vous recommandons de commencer par notre cours Introduction à la qualité des données, quiprésente les principes fondamentaux et les défis quotidiens.

À la fin de cette formation, vous serez en mesure d'identifier rapidement les problèmes liés aux données, de comprendre comment les résoudre et d'établir les bases nécessaires pour obtenir des données plus précises, cohérentes et exploitables dans tous vos projets.

Qu'est-ce que la qualité des données ?

Avant de corriger les données erronées, il est important de savoir à quoi ressemblent les données correctes.

La qualité des données consiste à déterminer si vos données sont adaptées à l'usage auquel elles sont destinées. Des données fiables reflètent la réalité et vous aident à prendre des décisions en toute confiance, que ce soit pour analyser des tendances, gérer des opérations ou développer des systèmes.

Cette définition n'est pas universelle. Une équipe marketing peut accorder une grande importance à la mise à jour des adresses e-mail, tandis qu'un ingénieur se concentrera plutôt sur la cohérence des schémas. La qualité des données est donc soumise à des normes universelles, mais également à des spécificités contextuelles.

Afin d'harmoniser la manière dont les équipes évaluent les données, la plupart des cadresdéfinissent un ensemble de dimensions de qualité des données, telles que l'exactitude, l'exhaustivité, la validité, l'actualité, l'unicité et la cohérence. Cela permet aux équipes de parler le même langage lorsqu'elles évaluent et améliorent leurs données.

Pourquoi la qualité des données est-elle importante ?

Les données touchent presque tous les aspects d'une organisation, des informations sur les clients à la conformité. Lorsque ces données sont erronées, des problèmes surviennent. Les décisions prennent une tournure inattendue. Les équipes perdent du temps.

Et dans les secteurs réglementés, les risques sont encore plus élevés. Supposons qu'un détaillant lance une campagne promotionnelle à partir d'une liste de contacts obsolète. Non seulement ils perdront leur engagement, mais ils risquent également de gaspiller leurs dépenses publicitaires. Ou imaginez un hôpital confronté à des dossiers de patients en double ou incohérents.

Des données erronées peuvent entraîner des problèmes de conformité, des pertes de revenus et une expérience client insatisfaisante. Selon Gartner, les données erronées coûtent chaque année des millions aux entreprises, rien qu'en termes d'inefficacité. D'autre part, des données fiables permettent de prendre des décisions plus rapidement, d'automatiser et d' r plus efficacement et d'améliorer la collaboration. Ce n'est pas un simple atout, c'est un élément essentiel au bon fonctionnement d'une entreprise.

Dimensions fondamentales de la qualité des données

Pour savoir ce qu'il convient de corriger, il faut d'abord savoir ce qu'il convient de mesurer. J'ai commencé à évoquer ces concepts précédemment, lorsque j'ai expliqué ce qu'est la qualité des données, mais je vais maintenant les développer plus en détail. Les dimensions suivantes structurent le processus et démontrent la facilité d'utilisation et la fiabilité de vos données dans le monde réel.

1. Exactitude et exhaustivité

L'exactitude signifie que vos données reflètent la réalité. Si l'adresse d'un client est incorrecte, même une logistique parfaite ne pourra pas aider. L'exhaustivité fait référence au fait de disposer de toutes les informations nécessaires. Un champ « catégorie de produit » vide peut perturber certaines ou toutes les fonctionnalités telles que le filtrage, l'analyse ou les rapports de conformité. Vous aurez souvent besoin d'une combinaison de contrôles de validation, de boucles de rétroaction et d'audits pour garantir à la fois l'exactitude et l'exhaustivité des données. Une entreprise de commerce électronique a réduit les erreurs de traitement des commandes en signalant les formulaires de commande incomplets avant leur soumission.

2. Cohérence et ponctualité

La cohérence fait référence à la concordance de vos données entre les différents systèmes. Si un client est marqué comme « actif » dans le CRM mais « inactif » dans la facturation, vous risquez de rencontrer une certaine confusion ou, pire encore, des erreurs de facturation. La pertinence fait référence à l'actualité des données, pour ainsi dire. Un tableau de bord des ventes mis à jour chaque semaine ne vous aidera pas à réagir à une baisse qui s'est produite hier. C'est là qu'interviennent l'ETL en temps réel, les tâches planifiées et/ou la surveillance des horodatages.

3. Validité et unicité

La validité vérifie que les données respectent les formats et la logique attendus. Un numéro de téléphone auquel il manque l'indicatif du pays peut être techniquement valide, mais inutilisable. Cela dépend. L'unicité consiste à éviter les doublons. Les enregistrements en double peuvent perturber la création de rapports et entraîner des expériences utilisateur frustrantes, comme la réception du même e-mail à deux reprises. Je pense que les règles de validation et les routines de déduplication sont très utiles à cet égard. Une entreprise SaaS a amélioré la précision de son processus d'intégration de 40 % après avoir ajouté des vérifications de format et la détection des doublons approximatifs.

4. Intégrité et utilité

L'intégrité garantit la cohérence et la connectivité des données lors de leur transfert entre les systèmes. Il s'agit de préserver les relations et d'éviter la corruption silencieuse des données. L'utilité est plus simple : Ces données sont-elles utiles à quelqu'un dans le cadre de son travail ? Si vous collectez toutes les pages vues mais que vous ne pouvez pas les associer à des utilisateurs, je pense que vous obtenez du bruit, et non des données pertinentes pour l'. Les cadres de gouvernance facilitent la gestion de ces deux aspects. Ils garantissent que les données circulent de manière fluide et restent pertinentes pour l'entreprise.

Avantages d'une bonne qualité des données

Lorsque les données sont propres, précises et disponibles en temps opportun, l'ensemble de l'organisation en ressent les avantages :

1. De meilleures décisions

Des données précises renforcent la confiance des équipes.e. Le service financier peut se fier aux prévisions. Le marketing peut se fier aux taux d'engagement. Le produit peut s'adapter aux tendances des utilisateurs. Par exemple, un hôpital disposant de données fiables peut plus facilement identifier les lacunes en matière de soins et améliorer les plans de traitement.

2. Efficacité opérationnelle

Les données de mauvaise qualité, en revanche, ralentissent l'ensemble du processus. Vous ou quelqu'un d'autre passez des heures à déboguer des rapports, à réconcilier des systèmes ou à corriger des importations incorrectes. Des données propres signifient moins de surprises et moins de temps consacré à la résolution de problèmes. Une entreprise de logistique a réduit de 23 % le nombre de tickets d'assistance simplement en nettoyant les métadonnées de ses produits.

3. Conformité et gestion des risques

Les réglementations telles que le RGPD et la loi HIPAA vous imposent de gérer vos données avec soin. Cela implique de savoir où il se trouve, à qui il appartient et s'il est correct. Des données propres facilitent également les audits et réduisent le risque d'erreurs.

4. Amélioration de l'expérience client

Lorsque vos systèmes sont synchronisés, vos clients n'ont pas besoin de se répéter. Veuillez ne pas envoyer de courriels en double. Aucune facture manquante. Aucune incohérence entre les profils sur les différents points de contact. Une vue unifiée aide les équipes à fournir un service plus rapide et des recommandations plus pertinentes.

Défis et problèmes courants liés à la qualité des données

Vous trouverez ci-dessous quelques-uns des obstacles les plus courants en matière de qualité des données auxquels j'ai pu être confronté, ainsi que les solutions correspondantes.

1. Données incomplètes et inexactes

Des saisies imprécises, des sources obsolètes ou des erreurs manuelles créent des lacunes dans vos ensembles de données. Ces erreurs se répercutent sur les rapports et la prise de décision. Les corrections apportées comprennent une meilleure validation des entrées, un nettoyage en amont et des alertes en cas de données manquantes ou suspectes.

2. Duplication et incohérence

La présence de plusieurs enregistrements pour un même client ou des formats incompatibles peut nuire à la fiabilité de vos tableaux de bord. Une logique de correspondance et de fusion (qui, nous l'espérons, s'appuie également sur des règles de formatage claires) permet de résoudre ce type de problèmes.

3. Sécurité, confidentialité et actualité

Les données anciennes ou exposées présentent des risques en matière de conformité. Les réglementations telles que le RGPD, que j'ai mentionné précédemment, et le CCPA, que je mentionne maintenant, sanctionnent les mauvaises pratiques en matière de traitement des données. Pour garantir la fraîcheur et la sécurité des données, il est nécessaire de trouver un équilibre entre les politiques de conservation, les techniques de masquage et la rapidité des mises à jour.

4. Intégration et silos de données

Lorsque les services utilisent des outils distincts, les données sont fragmentées et il n'existe pas de source unique de vérité. L'intégration, via des API, des entrepôts ou des pipelines événementiels, rassemble vos données et réduit les doublons.

5. IA, données obscures et nouveaux défis

Les fichiers journaux, les résultats de l'IA et les sources non structurées génèrent des quantités considérables de données désorganisées. Ces données masquent souvent des informations importantes ou des erreurs. Les pipelines de filtrage, d'enrichissement et de balisage contribuent à rendre ces données exploitables tout en minimisant l'introduction de bruit.

Gestion de la qualité des données : Processus et meilleures pratiques

La prochaine étape et le prochain sujet que j'aborderai concernent la mise en place de systèmes de gestion efficaces.

Évaluation et stratégie

Commencez par un bilan de santé. Profilagez vos données, calculez des indicateurs de base (tels que les valeurs manquantes ou les doublons) et comparez-les aux normes pertinentes dans votre domaine. Ensuite, élaborez une stratégie adaptée. Les applications destinées aux clients peuvent privilégier la fraîcheur. Les systèmes financiers accordent une grande importance à la précision.

Nettoyage et surveillance

Le nettoyage consiste à corriger ce qui ne fonctionne pas : champs manquants, liens rompus, etc. SQL, Python et Excel restent les outils les plus utilisés, parallèlement à des outils tels qu'OpenRefine ou Power Query. La surveillance permet d'éviter l'apparition de nouveaux problèmes. Ajoutez des règles de validation, des vérifications planifiées et des outils d'alerte pour détecter les problèmes dès leur apparition.

Meilleures pratiques

Automatisez tout ce qui peut l'être. Utilisez des tâches planifiées pour le nettoyage, rédigez des tests pour les indicateurs clés et configurez des alertes de pipeline. Et attribuez la responsabilité, car quelqu'un doit s'occuper des problèmes lorsque quelque chose ne fonctionne pas correctement. C'est là que les gestionnaires de données entrent en jeu. Associez les objectifs de qualité des données aux résultats réels et procédez à une analyse des causes profondes lorsque des problèmes surviennent.

Outils et technologies pour la qualité des données

La gestion de la qualité des données à grande échelle nécessite des outils adaptés. Que vous nettoyiez des millions d'enregistrements ou surveilliez des pipelines de données en temps réel, disposer de la bonne pile technologique fait vraiment la différence.

1. Critères d'évaluation

L'évolutivité, la flexibilité et l'intégration sont des critères indispensables. Recherchez des outils qui prennent en charge votre volume de données, effectuent des vérifications en temps réel et s'intègrent à votre infrastructure, qu'elle soit cloud, hybride ou sur site. Des points supplémentaires peuvent être attribués si l'outil inclut l'apprentissage automatique, dont tout le monde parle à juste titre, ou des fonctionnalités de création de règles pour automatiser les corrections courantes.

2. Solutions de pointe

Parmi les outils les plus connus, on peut citer Talend, Informatica, Ataccama et IBM InfoSphere. Ils sont accompagnés de workflows pour le profilage, le nettoyage et la surveillance. Les piles cloud natives telles qu'AWS Glue et Azure Purview offrent également des fonctionnalités de qualité des données intégrées.

3. Qualité des données en tant que service (DQaaS)

Si vous ne souhaitez pas gérer votre propre infrastructure, DQaaS pourrait être une solution plus adaptée. Ces outils exposent la validation, le profilage ou la surveillance sous forme d'API, ce qui, selon moi, est idéal pour ajouter des vérifications aux formulaires clients ou aux pipelines d'ingestion sans avoir à héberger quoi que ce soit soi-même.

Qualité des données dans la gouvernance des données

La qualité des données n'existe pas de manière isolée, elle est étroitement liée à la gouvernance. Un cadre de gouvernance solide constitue la base d'une bonne gestion des données dans toute l'organisation.

Intégration de la gouvernance

Les politiques et les normes définissent ce qu'est la qualité, qui en est responsable et comment la conformité est assurée. Sans cette structure, les attentes varient et les problèmes se multiplient. Une gouvernance solide garantit moins de surprises et des transferts plus clairs entre les équipes.

Gestion des données de référence (MDM)

Le MDM crée une source unique et précise d' s sur les entités fondamentales, telles que les clients ou les produits. Bien exécutée, elle réduit les doublons et améliore la cohérence entre les systèmes. Les détaillants utilisent la gestion des données d'entreprise (MDM) pour fusionner les données en magasin et en ligne. Les fabricants synchronisent leurs catalogues de produits entre les différentes régions. La gestion des données master (MDM) est l'un des moyens les plus directs d'améliorer la qualité des données à grande échelle.

Cadres et normes relatifs à la qualité des données

Les cadres et les normes aident les organisations à structurer leurs efforts en matière de qualité des données de manière cohérente et mesurable. Ils proposent des méthodologies éprouvées pour évaluer les pratiques actuelles et identifier les domaines à améliorer.

1. ISO 8000

La norme ISO 8000 fournit une définition claire de la qualité des données et décrit les méthodes permettant de la mesurer. Il couvre l'exhaustivité, l'exactitude et la normalisation du format. Il est particulièrement utile pour les équipes travaillant dans différents pays ou départements avec des définitions différentes.

2. TDQM et DAMA DMBOK

La TDQM met l'accent sur l'amélioration continue. Vous mesurez, analysez, améliorez et répétez le processus. Simple, mais efficace, en particulier pour les équipes qui mettent en place des processus itératifs. DAMA DMBOK élargit le champ de vision. Cela englobe non seulement la qualité, mais également l'architecture des données, la gouvernance, l'intégration et la sécurité. Considérez-le comme un guide complet pour les opérations de données au niveau de l'entreprise.

3. Modèles de maturité

Les modèles de maturité indiquent où vous en êtes et où vous devez viser. Ils passent d'une approche ponctuelle (nettoyage manuel, corrections réactives) à une approche optimisée (contrôles automatisés, gouvernance intégrée). Comprendre votre niveau actuel vous aide à hiérarchiser les prochaines étapes, qu'il s'agisse d'introduire des contrôles de validation ou de désigner des propriétaires de données.

Mesurer le retour sur investissement de la qualité des données

Afin de justifier les investissements dans la qualité des données, il est recommandé de relier les efforts d'amélioration aux résultats commerciaux réels. Cette section présente des méthodes pratiques pour mesurer le retour sur investissement (ROI), notamment les économies réalisées et les indicateurs de performance.

Analyse coûts-avantages

Commencez par dresser la liste des coûts liés aux données erronées : corrections manuelles, rapports erronés, clients perdus. Ensuite, énumérez les avantages liés à des données propres : meilleures conversions, moins d'erreurs, décisions plus rapides.

Utilisez une formule de retour sur investissement de base :

ROI = (Net Benefits – Total Costs) / Total CostsRestez pragmatique : moins de tickets d'assistance, moins de temps passé au débogage, des audits de conformité plus rapides.

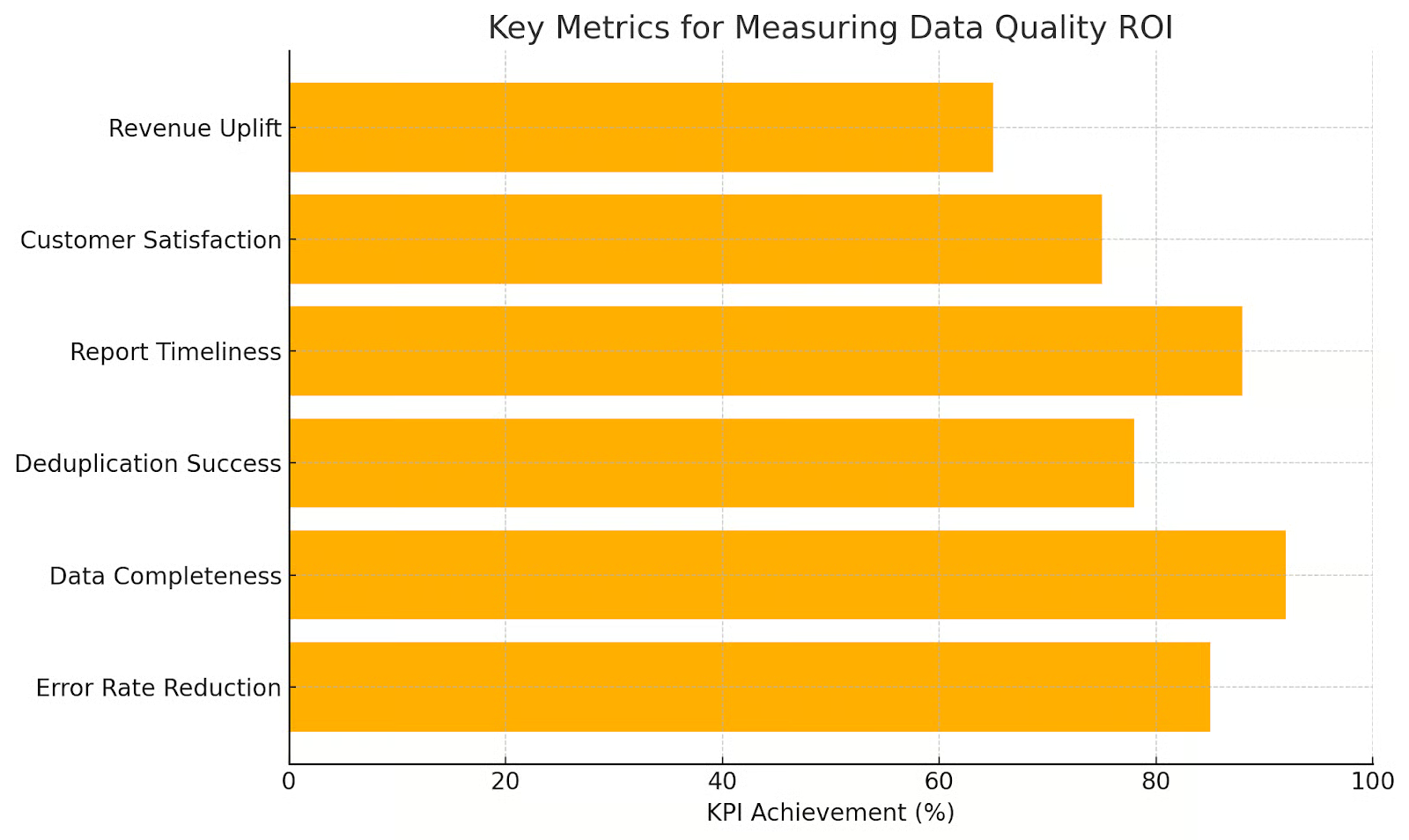

Indicateurs et KPI

Suivez les indicateurs qui correspondent aux résultats. Exemples :

- Taux d'erreur: Combien de champs sont manquants ou invalides ?

- Temps nécessaire pour la réparation: À quelle vitesse les problèmes sont-ils résolus ?

- Précision des prévisions: Les modèles de vente s'améliorent-ils ?

Promouvoir une culture de la qualité des données

Dernière chose que je mentionnerai : La création de systèmes de données de haute qualité ne se limite pas aux outils et aux processus, comme nous l'avons largement évoqué jusqu'à présent. Elle nécessite également des personnes qui comprennent et apprécient le rôle des données. Le leadership, la formation et l'engagement continu contribuent à instaurer une culture de la qualité des données.

Leadership et responsabilité

Le leadership établit les priorités. Si les dirigeants ne se soucient pas de la qualité des données, personne d'autre ne le fera. C'est garanti. Attribuez les responsabilités, définissez les rôles et reliez les indicateurs de qualité aux performances réelles.

Formation et outils

La plupart des gens souhaitent agir de manière appropriée. Ils ont simplement besoin d'être guidés pour y parvenir. Veuillez proposer des formations. Facilitez le signalement des données insuffisantes. Fournissez des outils permettant aux utilisateurs de procéder eux-mêmes au nettoyage. Des outils tels que Great Expectations ou Soda permettent aux équipes non techniques de valider et de surveiller les données sans avoir à écrire de code.

Préserver la culture

La culture s'estompe sans renforcement. Effectuez des audits. Partagez vos réussites et vos échecs. Célébrez les améliorations. Reliez vos efforts à vos objectifs commerciaux, tels que l'expansion sur de nouveaux marchés ou l'amélioration de la fidélisation de la clientèle. Intégrez la qualité des données dans votre processus de travail, ne la considérez pas comme un projet ponctuel.

Conclusion

J'espère que vous comprenez désormais l'importance de deux mots très simples : Qualité des données. La qualité des données a une incidence sur tous les aspects de l'entreprise. Disposer de données de qualité signifie disposer de données rationalisées, cohérentes et fiables qui renforcent la confiance, améliorent la prise de décision et, ce qui importe le plus aux entreprises, favorisent la croissance.

Si vous occupez un poste de direction et que vous vous intéressez à la qualité des données, sachez que DataCamp for Business propose des solutions d'entreprise pour vous aider. Nous pouvons vous aider à élaborer des solutions adaptées à tous types de défis et à améliorer les compétences de l'ensemble de votre équipe. De plus, nous créons des cursus personnalisés avec des rapports uniques. N'hésitez pas à nous contacter dès aujourd'hui.

Rédacteur technique spécialisé dans l'IA, la ML et la science des données, rendant les idées complexes claires et accessibles.