Curso

Las empresas recopilan constantemente cantidades ingentes de datos, y darles sentido requiere potentes plataformas analíticas. Dos nombres que aparecen a menudo en este espacio en los últimos años son Databricks y Snowflake. Pero, ¿cómo elegir entre ellos?

Esta entrada del blog te guiará a través de una comparación general entre las características clave de Databricks y Snowflake.

¿Qué es Databricks?

Databricks es una plataforma analítica unificada conocida por su capacidad para gestionar cargas de trabajo de big data y aprendizaje automático. Fue fundada por los creadores de Apache Spark, y ofrece una serie de funciones diseñadas para facilitar la ingeniería de datos, la ciencia de datos y la analítica empresarial. Puedes obtener más información sobre la plataforma en nuestro curso Introducción a Databricks.

Características

Databricks utiliza el marco de código abierto Apache Spark para crear lagos de datos que pueden combinar lo mejor de los almacenes de datos y los lagos de datos. También ofrece una amplia gama de herramientas y servicios, entre los que se incluyen:

- Cuadernos colaborativos para Python, Scala, R y SQL

- Gestión automatizada de clústeres

- Marco LLM de código abierto DBRX

- Bibliotecas de aprendizaje automático integradas y compatibilidad con marcos de trabajo de ML populares como TensorFlow y PyTorch

- Integración con herramientas de BI populares como Tableau y Looker.

Casos prácticos

Databricks se utiliza habitualmente para análisis en tiempo real, procesos ETL y aprendizaje automático. Con su reciente lanzamiento de nuevas herramientas de IA, Databricks también puede utilizarse en:

- Construir modelos RAG utilizando la Búsqueda Vectorial Mosaico AI

- Crear LLMs utilizando el preentrenamiento de IA Mosaico

Ventajas

Databricks tiene varias ventajas clave que destacan entre la competencia:

- Manejo de grandes datos: Databricks está diseñado específicamente para manejar cantidades masivas de datos y puede escalar fácilmente para satisfacer demandas crecientes.

- Plataforma unificada: Al ofrecer una serie de funciones y herramientas, Databricks proporciona una solución única para todas tus necesidades de análisis de datos.

- Aprendizaje automático incorporado y soporte de IA: Databricks tiene buenas integraciones con marcos y bibliotecas comunes de aprendizaje automático e inteligencia artificial, lo que lo hace atractivo para las empresas que buscan adoptar e incorporar rápidamente estas tecnologías a sus procesos analíticos.

¿Qué es Copo de Nieve?

Snowflake es una solución de almacenamiento de datos basada en la nube que ha ganado popularidad por su sencillez y escalabilidad. Separa los recursos de almacenamiento y de cálculo, lo que permite a las empresas aumentar o disminuir su escala en función de sus necesidades. Nuestro curso de Introducción a Snowflake te lleva a través de los fundamentos de la plataforma.

Características

Snowflake ofrece un almacén de datos totalmente gestionado, nativo de la nube, rápido y fácil de usar.

Algunas de sus características destacables son:

- Escalado automático y gestión de recursos

- Soporte SQL estándar y ampliado

- Capacidad para manejar datos estructurados y semiestructurados

- Intercambio seguro de datos

Casos prácticos

Snowflake se utiliza normalmente en escenarios en los que las empresas necesitan almacenar y analizar grandes cantidades de datos rápidamente. Esto incluye casos de uso como:

- Análisis en tiempo real

- Consultas ad hoc

- Informes de inteligencia empresarial

Por ejemplo, puede utilizarse para crear un repositorio de datos centralizado para que distintos equipos y departamentos accedan a los datos compartidos y los analicen.

Ventajas

Snowflake es conocido por su sencillez, escalabilidad y velocidad. Sus principales ventajas son:

- Fácil concurrencia: Snowflake permite que varios usuarios consulten simultáneamente los mismos datos sin problemas de rendimiento.

- Compartir datos: Con funciones integradas como Compartir datos de forma segura, Snowflake simplifica la colaboración entre equipos y socios al permitir un acceso seguro a los datos compartidos desde diferentes cuentas.

- Flexibilidad: Snowflake ofrece opciones de almacenamiento versátiles y admite varios formatos de datos, lo que lo hace adecuado para distintos tipos de cargas de trabajo.

- Interfaz sencilla: Snowflake tiene una interfaz fácil de usar que requiere una formación y unos conocimientos técnicos mínimos, por lo que también es accesible para usuarios no técnicos. Las consultas también pueden hacerse mediante SQL, lo que facilita su adopción.

Puedes aprender más sobre cómo funciona Copo de nieve en este práctico tutorial de Copo de nieve.

Databricks vs Snowflake: Similitudes

Las dos plataformas comparten algunas similitudes, como las siguientes:

1. En la nube

Tanto Databricks como Snowflake son plataformas basadas en la nube, por lo que son accesibles desde cualquier lugar con conexión a Internet. Disponer de una solución basada en la nube también significa que los usuarios pueden ampliarla o reducirla fácilmente en función de sus necesidades, sin limitaciones físicas.

2. Escalabilidad

Ambas plataformas pueden ampliarse o reducirse en función de la demanda, lo que proporciona a las empresas flexibilidad a medida que crecen sus datos. Esta función de autoescalado la hace perfecta para empresas que se mueven rápidamente y tienen un crecimiento dinámico.

3. Soporte del lenguaje de consulta

Tanto Databricks como Snowflake ofrecen soporte para SQL, el lenguaje más utilizado para consultar bases de datos.

SQL ya es una herramienta de uso común entre muchos analistas e ingenieros de datos. Esto significa que las empresas pueden aprovechar los conocimientos de SQL de sus empleados para trabajar con estas plataformas.

4. Capacidades del lago de datos

Ambas plataformas admiten lagos de datos, lo que proporciona a las empresas flexibilidad para almacenar y analizar una variedad de datos estructurados y no estructurados. Dado que ambos están diseñados desde cero para gestionar big data, pueden manejar fácilmente la carga de trabajo de los grandes lagos de datos.

Databricks vs Snowflake: Diferencias

1. Comparación de resultados

En cuanto al rendimiento, tanto Databricks como Snowflake brillan, pero en áreas diferentes.

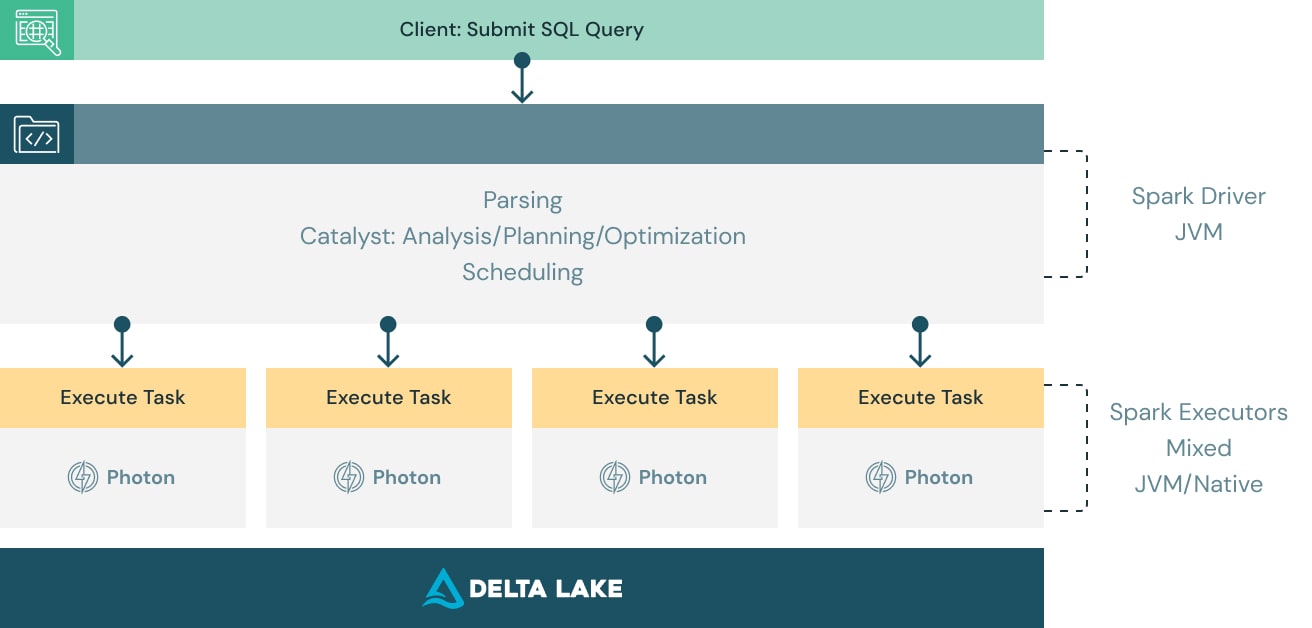

Databricks

Databricks destaca en el procesamiento rápido de grandes conjuntos de datos, lo que lo hace ideal para el análisis en tiempo real y el aprendizaje automático. Su uso de Apache Spark garantiza un procesamiento de datos de alta velocidad, incluso para consultas complejas.

Fuente: Databricks

Copo de nieve

Snowflake, en cambio, está optimizado para el almacenamiento de datos. Su arquitectura permite un rápido rendimiento de las consultas, especialmente para datos estructurados. La separación de los recursos de almacenamiento y computación significa que las empresas pueden escalar cada uno de ellos de forma independiente, garantizando un rendimiento óptimo.

Ganador

Databricks es el ganador absoluto en rendimiento por su mejor relación rendimiento-coste. El motor de consulta de Databricks funciona con Apache Spark, que es la mejor opción para el procesamiento de big data.

2. Comparación de escalabilidad

La escalabilidad es crucial para las empresas a medida que crecen sus necesidades de datos. Aquí es donde las dos plataformas difieren ligeramente.

Databricks

Databricks ofrece una sólida escalabilidad, especialmente para cargas de trabajo de big data y aprendizaje automático. Su integración con plataformas en la nube como AWS, Azure y Google Cloud permite a las empresas escalar los recursos según sus necesidades.

Copo de nieve

La función de escalado automático de Snowflake es genial. Permite a las empresas aumentar o reducir automáticamente los recursos informáticos en función de su carga de trabajo. Esto es posible gracias a sus almacenes multiclúster, en los que el número de clústeres se añade o elimina en función de la carga de cálculo.

Esta característica garantiza que las empresas sólo utilicen (y paguen) lo que necesitan, lo que la hace muy eficiente.

Ganador

Snowflake es el ganador absoluto en escalabilidad, gracias a su función de escalado automático y a sus versátiles opciones de almacenamiento.

3. Comparación de la facilidad de uso

La facilidad de uso puede influir significativamente en la velocidad a la que los equipos pueden adoptar una plataforma y empezar a beneficiarse de ella. Tener una herramienta demasiado difícil de usar puede llevar a una baja adopción por parte de los equipos de datos.

Comparemos ambas plataformas a continuación.

Databricks

Databricks ofrece un entorno colaborativo que puede resultar complejo para los principiantes, pero que se vuelve intuitivo a medida que los usuarios se familiarizan con la plataforma. Su compatibilidad con varios idiomas lo hace flexible, pero también aumenta la curva de aprendizaje.

Copo de nieve

Snowflake es elogiado por su sencillez y su interfaz fácil de usar. Su lenguaje de consulta basado en SQL lo hace accesible a usuarios familiarizados con las bases de datos tradicionales. La arquitectura de la plataforma también simplifica muchas tareas administrativas, lo que facilita su gestión.

Ganador

Snowflake se lleva la corona en facilidad de uso gracias a su sencilla interfaz y a que requiere unos conocimientos técnicos mínimos. Sin embargo, si el usuario es de nivel intermedio, esta diferencia no es exactamente perceptible, ya que está más versado en software técnico.

4. Capacidad de integración

Las capacidades de integración se han convertido en una necesidad en los últimos años, debido al gran número de herramientas existentes que dan lugar a diversas formas de flujos de trabajo de datos.

Databricks

Databricks se integra bien con varias fuentes y plataformas de datos, como Hadoop, Apache Kafka y soluciones de almacenamiento en la nube. Su flexibilidad lo hace adecuado para diversos entornos de datos.

Algunas integraciones notables son:

- dbt, AirFlow para flujos de trabajo ETL

- Amazon S3, Google BigQuery y Cloud Storage, Snowflake para fuentes de datos

- Qlik, Power BI y Tableau para herramientas de inteligencia empresarial (BI)

Copo de nieve

Snowflake ofrece sólidas capacidades de integración con herramientas de BI populares como Tableau, Looker y Power BI. También es compatible con plataformas de integración de datos como Fivetran y Talend, lo que facilita la conexión con los ecosistemas de datos existentes.

Ganador

Ambas herramientas están igual de igualadas en esta categoría, con sus amplias opciones de integración. Sin embargo, la compatibilidad de Snowflake con muchas herramientas de BI desde hace más tiempo en el mercado podría darle una ligera ventaja.

5. Seguridad

La seguridad es una prioridad máxima para las empresas que manejan datos sensibles.

Databricks

Databricks ofrece sólidas funciones de seguridad, como claves gestionadas por el cliente, infraestructura sin servidor y seguridad unificada para la gobernanza de los datos y la IA.

Las claves gestionadas por el cliente están estrechamente integradas con proveedores como:

- Bóveda de claves de Microsoft Azure para Azure

- Servicio de administración de claves (KMS) de AWS mediante Amazon Web Services (AWS)

Copo de nieve

Snowflake también ofrece sólidas funciones de seguridad, como la encriptación de extremo a extremo, la seguridad del tráfico de red, la autenticación multifactor mediante el Control de Acceso y el cumplimiento de diversas normas del sector. Su arquitectura soporta intrínsecamente el intercambio seguro de datos y el control de acceso, garantizando la protección de los datos.

También garantiza el cumplimiento de normativas como HIPAA, PCI DSS y FedRAMP mediante sus capacidades y controles de seguridad.

Ganador

En el aspecto de la seguridad, ambas plataformas ofrecen funciones sólidas, por lo que resulta difícil elegir un ganador. Sin embargo, la estrecha integración de Databricks con los proveedores de la nube podría darle una ligera ventaja.

6. Coste

El coste es siempre un factor importante a la hora de elegir una plataforma de datos. Es un factor importante a tener en cuenta a la hora de equilibrar la carga computacional necesaria para tus aplicaciones o consultas.

Databricks

Databricks ofrece un modelo de precios de pago por uso, que puede resultar rentable para empresas con cargas de trabajo fluctuantes. Sin embargo, los costes pueden acumularse rápidamente, especialmente en el caso de tareas de procesamiento de datos extensas.

Copo de nieve

El modelo de precios de Snowflake es ligeramente diferente. Te cobra una comisión en función del uso del crédito. Se basa en la separación del almacenamiento y la informática, lo que permite a las empresas escalar los costes en función del uso. Este modelo puede ser más predecible y a menudo más asequible, especialmente para las necesidades de almacenamiento de datos. Sin embargo, esto puede ser restrictivo si la carga de trabajo del usuario es variable.

Ganador

Ambas plataformas ofrecen modelos de precios razonables, pero en general, la separación de almacenamiento y cálculo de Snowflake puede resultar más asequible para las empresas con cargas de trabajo predecibles. Sin embargo, el modelo de pago por uso de Databricks también puede ser rentable para cargas de trabajo fluctuantes.

Databricks vs Snowflake: Un resumen

He aquí un resumen general de las dos plataformas y sus principales diferencias.

|

Función |

Databricks |

Copo de nieve |

|

Visión general |

- Plataforma analítica unificada para big data y aprendizaje automático |

- Solución de almacenamiento de datos basada en la nube |

|

Características principales |

- Lagos de datos basados en Apache Spark - Cuadernos colaborativos para múltiples lenguajes (Python, Scala, R, SQL) - Gestión automatizada de clústeres - Aprendizaje automático y soporte de IA - Integración con herramientas BI |

- Almacén de datos totalmente gestionado y nativo de la nube - Escalado automático y gestión de recursos - Soporte SQL - Maneja datos estructurados y semiestructurados - Intercambio seguro de datos |

|

Casos prácticos |

- Análisis en tiempo real, procesos ETL, aprendizaje automático, creación de modelos de IA |

- Análisis en tiempo real, consultas ad hoc, informes de inteligencia empresarial |

|

Ventajas |

- Manejo de big data y escalabilidad - Plataforma unificada de análisis y aprendizaje automático - Soporte integrado de IA y ML |

- Fácil concurrencia para múltiples usuarios - Compartir datos de forma segura para colaborar - Almacenamiento versátil y soporte de formatos de datos - Interfaz sencilla para usuarios no técnicos |

|

Rendimiento |

- Optimizado para big data, análisis en tiempo real y ML - Procesamiento de datos a alta velocidad mediante Apache Spark |

- Optimizado para almacenamiento de datos y datos estructurados - Rápido rendimiento de las consultas gracias a la separación de los recursos de almacenamiento y cálculo |

|

Escalabilidad |

- Escalable para big data y ML con integración en AWS, Azure, GCP |

- Escalado automático con almacenes multiclúster - Paga sólo por los recursos utilizados |

|

Facilidad de uso |

- Colaborativo, complejo para los principiantes pero intuitivo para los usuarios experimentados - El soporte multilingüe añade curva de aprendizaje |

- Interfaz sencilla y fácil de usar con consultas SQL - Se requieren conocimientos técnicos mínimos |

|

Capacidades de integración |

- Amplia integración con plataformas como Hadoop, Apache Kafka, herramientas de BI (Tableau, Looker), almacenamientos en la nube |

- Amplia integración con herramientas BI (Tableau, Looker, Power BI), plataformas ETL (Fivetran, Talend) |

|

Seguridad |

- Claves gestionadas por el cliente, infraestructura sin servidor, gobernanza unificada de datos e IA - Integrado con Azure Key Vault y AWS KMS |

- Cifrado de extremo a extremo, seguridad del tráfico de red, autenticación multifactor, control de acceso - Cumple con HIPAA, PCI DSS, FedRAMP |

|

Coste |

- Precios de pago por uso - Rentable para cargas de trabajo fluctuantes |

- Precios basados en créditos (almacenamiento e informática por separado) - Previsible y potencialmente más asequible para cargas de trabajo estables |

Reflexiones finales

En general, tanto Databricks como Snowflake ofrecen potentes soluciones para la gestión y el análisis de datos. Databricks destaca en procesamiento de datos en tiempo real y aprendizaje automático, mientras que Snowflake brilla en almacenamiento de datos y facilidad de uso. Tu elección dependerá de tus necesidades específicas y de tus objetivos futuros.

Si quieres saber más sobre Databricks, nuestro seminario web Introducción a Databricks o el curso Introducción a Databricks son el lugar perfecto para empezar. Para los interesados en Snowflake, también tenemos un curso de Introducción a Snowflake pensado para principiantes.

Preguntas frecuentes sobre Databricks vs Snowflake

¿Qué es mejor Snowflake o Databricks?

Depende de tus necesidades específicas y de tu caso de uso. Snowflake es una plataforma de almacenamiento de datos basada en la nube, mientras que Databricks es una plataforma de análisis y aprendizaje automático. En general, Databricks es mejor para análisis avanzados y Snowflake es mejor para análisis más sencillos.

¿Debo aprender Spark antes que Databricks?

Aunque Spark es la tecnología subyacente utilizada por Databricks, no es necesario aprender Spark antes de utilizar Databricks. Sin embargo, tener conocimientos de Spark puede ayudarte a sacar más partido a Databricks.

¿Por qué Databricks es tan popular?

Databricks ofrece una plataforma completa para el análisis de datos y el aprendizaje automático, con funciones como cuadernos colaborativos, gestión automatizada de clústeres y bibliotecas integradas. También se integra bien con otras herramientas y plataformas populares.

¿Puedo utilizar Databricks y Snowflake juntos?

Sí, Databricks y Snowflake pueden integrarse para trabajar juntos en el análisis y almacenamiento eficaz de los datos. Esto permite a los usuarios aprovechar los puntos fuertes de ambas plataformas y crear un flujo de trabajo sin fisuras.

¿Es necesario tener experiencia previa con SQL o codificación para utilizar Databricks y Snowflake?

Sí, es necesario tener buenos conocimientos de SQL para utilizar tanto Databricks como Snowflake. SQL se utiliza para consultar y gestionar datos en estas plataformas.

Soy Austin, bloguero y escritor técnico con años de experiencia como científico de datos y analista de datos en el sector sanitario. Empecé mi andadura tecnológica con una formación en biología, y ahora ayudo a otros a hacer la misma transición a través de mi blog tecnológico. Mi pasión por la tecnología me ha llevado a escribir para decenas de empresas de SaaS, inspirando a otros y compartiendo mis experiencias.