programa

Estoy seguro de que la mayoría de nosotros ya nos hemos topado con deepfakes, ya sea en forma de memes virales o de clips de noticias hábilmente alterados. Nos guste o no, se han convertido en una parte habitual de nuestro paisaje online.

Los deepfakes son medios sintéticos como vídeos, imágenes o audio que se crean o modifican utilizando inteligencia artificial para imitar de forma convincente a personas o acontecimientos reales. A medida que avance la IA, será más difícil distinguir los hechos de la ficción, lo que convierte a los deepfakes tanto en una herramienta creativa como en una amenaza para la verdad y la privacidad.

En este artículo trataré:

- Qué son los deepfakes

- La tecnología que hay detrás

- Posibles aplicaciones en distintos ámbitos

- Desafíos éticos en torno a los deepfakes

- Posibles formas de detectarlos

¿Qué son los Deepfakes?

Los deepfakes son medios generados artificialmente o manipulados, creados utilizando aprendizaje profundo para producir representaciones altamente realistas pero sintéticas de personas, objetos o acontecimientos.

Aunque a menudo se utilizan para imitar rostros, voces o acciones humanas, las técnicas de deepfake también pueden generar o alterar objetos, escenas, animales o incluso entornos enteros en vídeos e imágenes para crear contenidos realistas pero falsos, difuminando la línea entre realidad y fabricación en una amplia gama de contextos.

Los orígenes de los deepfakes se remontan a grandes avances académicos. En 2014, Ian Goodfellow y sus colegas publicaron un artículo fundamental que introdujo las Redes Generativas Adversariales (GAN). Las GAN, que investigaremos en la siguiente sección, proporcionan la base para generar contenido sintético.

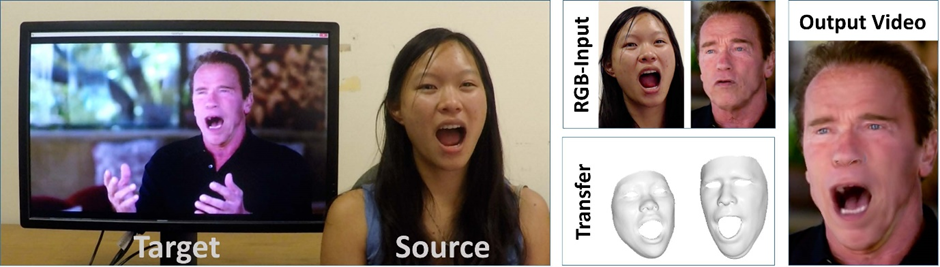

Otro hito se produjo con el artículo Face2Face de Justus Thies y su equipo, que se centró en las técnicas de captura y recreación de rostros en tiempo real. Un ejemplo de su uso se muestra en la imagen siguiente, donde se transfiere una expresión facial al famoso actor y político Arnold Schwarzenegger.

Ejemplo de combinación de imágenes de origen y destino para transferir expresiones faciales mediante Face2Face. Fuente: Papel Face2Face

El fenómeno recibió una gran atención pública a finales de 2017, cuando empezaron a circular por Reddit vídeos manipulados -a menudo con intercambios de caras de famosos, especialmente en contenido para adultos-, lo que finalmente llevó a que las plataformas de redes sociales prohibieran el uso perjudicial de las técnicas de deepfake.

Uno de los ejemplos más reconocidos surgió en 2018: un vídeo viral con un presidente Barack Obama alterado digitalmente, creado por BuzzFeed en colaboración con Jordan Peele, que puso de relieve el potencial de la tecnología para remodelar el discurso público.

En 2020, los creadores de South Park, Trey Parker y Matt Stone, crearon otra notable pieza de deepfake art: el piloto de la serie "Justicia descarada"presentaba personajes ficticios "interpretados" por deepfakes de Donald Trump y Mark Zuckerberg, entre otros.

¿Cómo funcionan los Deepfakes?

Cuando hablamos de deepfakes, a menudo nos centramos en el producto final. Profundicemos un poco más e intentemos comprender cómo se crean; me aseguraré de que entiendas cómo funciona aunque no tengas conocimientos técnicos.

Modelos discriminativos y generativos

Los modelos discriminativos se utilizan para diferenciar las cosas, por ejemplo, si una imagen es real o falsa. Observan los datos e intentan predecir la etiqueta correcta (como "real" o "deepfake"). Algunos ejemplos de modelos comunes son regresión logísticaárboles de decisión, redes neuronales y máquinas de vectores de apoyo. Estos modelos son excelentes para tareas como la detección de deepfakes, porque están entrenados para detectar señales de que algo ha sido cambiado o manipulado.

Los modelos generativos, en cambio, intentan comprender cómo funcionan los datos reales para poder crear nuevos datos similares. Aprenden de muchos ejemplos reales -como fotos de caras reales o clips de voces reales- y luego utilizan ese conocimiento para generar medios falsos pero de aspecto realista. Así es como se hacen los deepfakes.

La principal diferencia es para qué se utilizan: los modelos discriminativos detectan, y los modelos generativos crean. En la tecnología deepfake, ambas son importantes: una para crear falsificaciones convincentes y la otra para descubrirlas.

Para saber más sobre la diferencia, consulta este blog sobre modelos generativos frente a modelos discriminativos.

Redes Generativas Adversariales

GANs son un tipo de IA generativa que entrena conjuntamente un modelo generativo y otro discriminativo. La mejor forma de describir la relación entre ambos modelos es como una competición amistosa: mientras el generador crea contenidos sintéticos, el discriminador trabaja para distinguir los medios reales de los falsos. Esta rivalidad empuja al generador a mejorar su trabajo hasta que sus resultados se vuelven casi indistinguibles de los medios auténticos.

Para los deepfakes, el papel del modelo generativo es el de un falsificador de arte que pinta obras de arte falsificadas, mientras que el modelo discriminativo encarna a un crítico de arte que escudriña cada pieza para detectar las falsificaciones. A medida que van acumulando experiencia al exponerse a más y más datos, tanto el falsificador como el crítico mejoran en su trabajo, lo que da lugar a reproducciones cada vez más convincentes y a evaluaciones más precisas.

El proceso implica entrenar modelos en amplios conjuntos de datos para captar los rasgos únicos de un sujeto, como el tono de voz y las características faciales. Analizando estos datos, el sistema construye gradualmente una representación precisa del objetivo, que utiliza para imitarlo de forma convincente.

Técnicas Deepfake

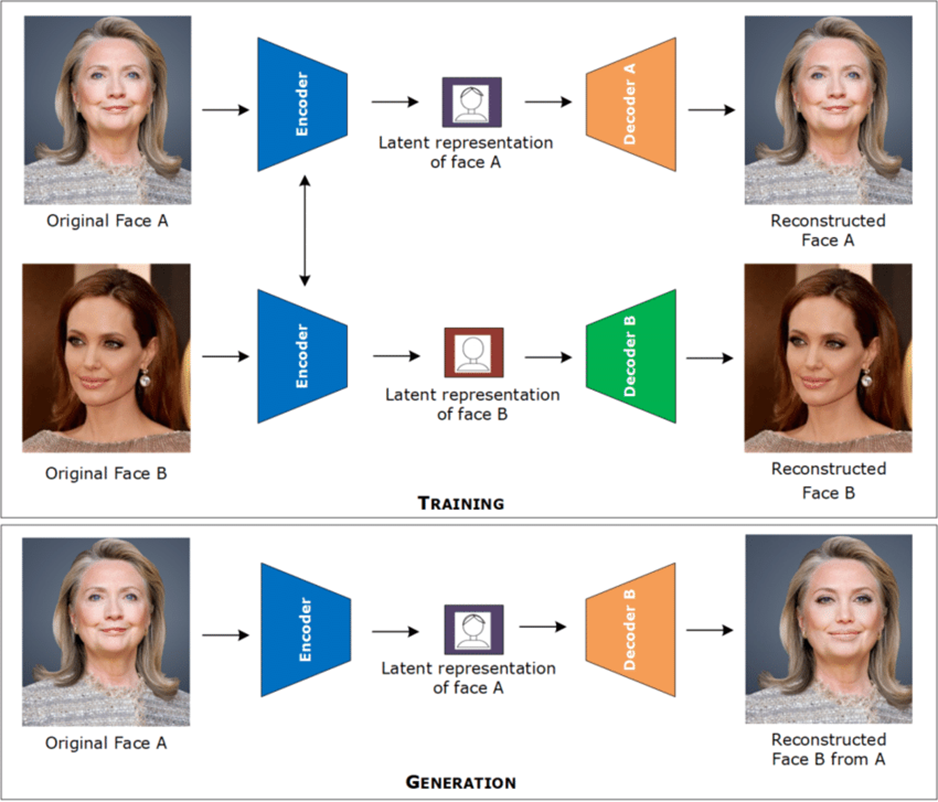

Las técnicas habituales de intercambio de caras suelen implicar autocodificadores y redes neuronales convolucionales. Estas herramientas se entrenan con montones de imágenes o fotogramas de vídeo de una persona para aprender cómo es su cara: su forma, sus expresiones y sus rasgos clave. La IA convierte esta información en un formato que pueda entender, algo así como un resumen digital de la cara de la persona.

Luego, utiliza ese resumen para copiar las expresiones faciales de una persona y aplicarlas a otra, haciendo que el intercambio de caras parezca realista.

Para la sincronización labial, las redes neuronales analizan no sólo los movimientos de la boca, sino también las entradas de audio, para alinear con precisión la salida de vídeo con las palabras habladas.

Se entrenan utilizando conjuntos de datos etiquetados, en los que cada fotograma de vídeo se empareja con una etiqueta de audio que indica el fonema hablado exacto, lo que permite al modelo aprender la relación precisa entre el sonido y la articulación visual.

Analizando simultáneamente estos pares de datos y etiquetas, la red aprende a generar salidas de vídeo en las que los movimientos de la boca reflejan la relación aprendida.

Por último, la clonación de la voz se puede conseguir entrenando modelos de síntesis del habla utilizando amplios conjuntos de datos de audio emparejados con las transcripciones correspondientes. Estos conjuntos de datos capturan las características únicas de la voz de un individuo (como el tono, el timbre y la cadencia) en un formato estructurado que los modelos pueden analizar.

Al aprender de estos pares de datos y etiquetas, los modelos generan un habla sintética que reproduce fielmente las cualidades vocales naturales del objetivo, imitando su voz de forma convincente.

Aplicaciones Deepfakes

Estoy bastante seguro de que la mayoría de nosotros hemos visto vídeos sintéticos en los que aparecen actores famosos o personajes públicos en situaciones humorísticas. Pero los deepfakes pueden servir para muchas otras cosas, como fines educativos o para mejorar la accesibilidad.

Entretenimiento

Los deepfakes ofrecen a los cineastas herramientas innovadoras, que les permiten hacer que los actores parezcan más jóvenes o crear versiones dobladas de películas que se asemejan mucho a las interpretaciones originales.

Un ejemplo notable de lo primero es "The Irishman" (2019), de Martin Scorsese, en la que Robert De Niro, Al Pacino y Joe Pesci aparecen décadas más jóvenes en escenas retrospectivas. De este modo, la historia pudo fluir con naturalidad sin necesidad de que varios intérpretes interpretaran a sus yoes más jóvenes. Ver una explicación de este proceso en este vídeo.

Los deepfakes también revolucionan la creación de personajes digitales al generar avatares realistas para videojuegos y realidad virtual. Ser capaz de diseñar personajes realistas que interactúen de forma natural con los usuarios en entornos digitales inmersivos supone un avance hacia experiencias de entretenimiento más interactivas y personalizadas. Por ejemplo, MetaHuman Creator de Epic Games permite a los programadores crear avatares fotorrealistas que se mueven y responden de forma convincente en tiempo real.

El potencial de los deepfakes para producir contenido satírico también es enorme. Aunque las imitaciones tradicionales forman parte del repertorio de un cómico desde hace mucho tiempo, las deepfakes introducen un nuevo nivel de detalle y realismo en las suplantaciones. Artistas como Snicklink y Kyle Dunnigan ya están explorando este enfoque innovador, ampliando los límites de la sátira digital.

Educación y accesibilidad

Un uso reciente de la tecnología deepfake procede de BBC Maestro, que lanzó un curso de escritura con una Agatha Christie recreada (casi 50 años después de su muerte).

Utilizando imágenes generadas por IA y modelado de voz basado en sus cartas, entrevistas y manuscritos, el curso ofrece una versión de Christie impartiendo lecciones con sus propias palabras. Es un claro ejemplo de cómo pueden utilizarse los medios generativos para trasladar figuras históricas a entornos educativos contemporáneos.

Los deepfakes también prometen mejorar la accesibilidad, especialmente para las personas con problemas de habla. Desarrollar voces sintéticas que capten las características vocales de una persona a partir de grabaciones puede permitir una comunicación más natural.

Un ejemplo digno de mención es "Proyecto Revoice". que ayuda a las personas con enfermedades de las neuronas motoras (que a menudo provocan la pérdida del habla), a preservar y recrear su voz natural mediante la captura temprana de grabaciones de voz.

Desafíos éticos y sociales de los Deepfakes

Cualquier debate sobre los deepfakes estaría incompleto sin abordar los retos que plantean. Entre las preocupaciones más acuciantes están las siguientes:

- Erosión de la confianza

- Actividad fraudulenta

- Violación de la intimidad

Los deepfakes tienen el potencial de erosionar la confianza del público al hacer cada vez más difícil distinguir entre contenido real y manipulado. Cuando se difunde información falsa, puede moldear la opinión pública, dañar la reputación o crear confusión en situaciones críticas.

En el peor de los casos, los deepfakes pueden ser utilizados como arma para desestabilizar sociedades por parte de actores malintencionados, alimentando divisiones políticas o incluso influyendo en las elecciones mediante la difusión de declaraciones o acciones inventadas atribuidas a figuras públicas.

La capacidad de suplantar convincentemente a alguien mediante la tecnología deepfake abre las puertas a actividades fraudulentas, como estafas financieras o robo de identidad. Los ciberdelincuentes pueden utilizar voces clonadas para engañar a las personas para que transfieran dinero o concedan acceso a datos confidenciales. Esto suscita preocupación en sectores como la banca y la ciberseguridad, donde los métodos de verificación tradicionales pueden dejar de ser suficientes.

Una de las aplicaciones más inquietantes de los deepfakes es la creación de contenidos no consentidos, a menudo utilizados para explotar o intimidar a las personas. Las víctimas pueden verse insertadas en medios de comunicación inventados que dañan su reputación o invaden su intimidad. Esto pone de manifiesto una cuestión ética importante, ya que el uso indebido de imágenes personales sin consentimiento puede tener consecuencias psicológicas y profesionales a largo plazo para los afectados.

A pesar de los crecientes riesgos, las leyes y normativas que rodean la creación y distribución de deepfakes siguen sin estar claras en muchos países. Aunque algunas jurisdicciones han introducido legislación específica, su aplicación sigue siendo difícil debido al rápido avance de la tecnología. La falta de un marco jurídico claro dificulta la exigencia de responsabilidades a los autores y plantea interrogantes sobre cómo equilibrar la libertad de expresión con la necesidad de prevenir daños.

Cómo detectar Deepfakes

Como hemos visto, detectar el contenido original del manipulado se está convirtiendo en una habilidad crucial en la era de la IA. Veamos distintos enfoques para distinguirlos.

Observación humana

Aunque cada vez son más difíciles de reconocer, hay signos reveladores de manipulación que el ojo humano puede captar con mayor o menor facilidad. La mayoría de nosotros probablemente hemos oído hablar de imágenes generadas por la IA en las que los humanos tenían de repente cuatro o seis dedos, pero otros signos son más sutiles que eso.

En el caso de las fotos, un indicio de manipulación es el desenfoque no natural o el pixelado incoherente a lo largo de los bordes de caras u objetos. Esto implica que el modelo no distinguió con precisión qué píxel pertenece a la cara y cuál al fondo, dejando una costura más o menos evidente.

Otra pista puede ser la iluminación o las sombras que no coinciden con el entorno, haciendo que la imagen parezca artificialmente compuesta.

Imagen generada por la IA que ilustra un desajuste entre la fuente de luz y las sombras.

En los vídeos, los problemas de iluminación pueden llamar la atención aún más fácilmente si la dirección de la fuente de luz cambia bruscamente entre fotogramas. También podemos detectar patrones de parpadeo inusuales o expresiones faciales rígidas que parecen desajustadas con el contexto circundante, lo que produce una sutil sensación de "extrañeza". En algunos casos, los bordes alrededor de la cabeza o el pelo parpadean, revelando que el vídeo podría haber sido manipulado.

Métodos técnicos

La detección de deepfakes suele requerir una combinación de métodos de detección basados en IA que analizan las incoherencias en los rasgos faciales, el movimiento y otros artefactos. Algunos ejemplos de software especializado en la detección de contenidos multimedia manipulados son:

- GoogleSynthID

- Truepic

- DuckDuckGoose

- Intel FakeCatcher

- Defensor de la Realidad

- Sensibilidad AI

- Escáner Deepware

Cada herramienta tiene un enfoque único dirigido a su caso de uso principal respectivo. Mientras que todas las demás herramientas mencionadas se centran en validar contenidos ya creados, Google SynthID y Truepic pueden considerarse medidas preventivas para identificar contenidos generados por IA.

Google SynthID incorpora marcas de agua digitales imperceptibles imperceptibles directamente en las imágenes generadas por IA para marcar su origen, mientras que Truepic utiliza hash criptográfico y verificación basada en blockchain para autenticar los medios en el momento de la captura.

DuckDuckGoose, que analiza sobre todo las incoherencias faciales, e Intel FakeCatcher, cuya fuerza reside en la detección de señales biológicas como los patrones de flujo sanguíneo, ambos dirigidos a aplicaciones forenses y de investigación.

La diferencia entre Reality Defender, Sensity AI y Deepware Scanner, que utilizan modelos de aprendizaje profundo para diferenciar entre contenidos reales y falsos, radica en el grupo destinatario: mientras que los dos primeros ofrecen integración con herramientas de seguridad empresarial y son adecuados para misiones de detección corporativas a gran escala, Deepware Scanner es una herramienta más ligera enfocada al consumidor para usuarios ocasionales.

Conclusión

Las falsificaciones profundas representan tanto un avance tecnológico como un importante desafío ético. Aunque abren posibilidades apasionantes en el entretenimiento, la educación y la accesibilidad, su uso indebido puede conducir a la desinformación, el fraude y la violación de la intimidad.

En el futuro, podemos esperar que los deepfakes sean aún más realistas, especialmente en las aplicaciones de realidad virtual, mientras que las herramientas de detección intentarán seguir el ritmo de las técnicas de manipulación cada vez más sofisticadas.

Si quieres saber más sobre los aspectos teóricos y tecnológicos de los deepfakes, DataCamp te ofrece los siguientes recursos: