Lernpfad

Ich bin mir sicher, dass die meisten von uns schon einmal auf Deepfakes gestoßen sind, sei es in Form von viralen Memes oder geschickt veränderten Nachrichtenclips. Ob es uns gefällt oder nicht, sie sind ein fester Bestandteil unserer Online-Landschaft geworden.

Deepfakes sind synthetische Medien wie Videos, Bilder oder Audiodateien, die mithilfe künstlicher Intelligenz erstellt oder verändert werden, um echte Menschen oder Ereignisse überzeugend zu imitieren. Je weiter die KI voranschreitet, desto schwieriger wird es, Fakten von Fiktion zu unterscheiden, was Deepfakes sowohl zu einem kreativen Werkzeug als auch zu einer Bedrohung für Wahrheit und Privatsphäre macht.

In diesem Artikel gehe ich darauf ein:

- Was Deepfakes sind

- Die Technologie dahinter

- Mögliche Anwendungen in verschiedenen Bereichen

- Ethische Herausforderungen rund um Deepfakes

- Mögliche Wege, sie zu entdecken

Was sind Deepfakes?

Deepfakes sind künstlich erzeugte oder manipulierte Medien, die mithilfe von Deep Learning Modelle erstellt werden, um höchst realistische, aber synthetische Darstellungen von Menschen, Objekten oder Ereignissen zu erzeugen.

Sie werden häufig eingesetzt, um menschliche Gesichter, Stimmen oder Handlungen zu imitieren. Deepfake-Techniken können aber auch Objekte, Szenen, Tiere oder sogar ganze Umgebungen in Videos und Bildern erzeugen oder verändern, um realistische, aber gefälschte Inhalte zu schaffen, wodurch die Grenze zwischen Realität und Fälschung in vielen Bereichen verschwimmt.

Die Ursprünge von Deepfakes lassen sich bis zu großen akademischen Durchbrüchen zurückverfolgen. Im Jahr 2014 veröffentlichten Ian Goodfellow und seine Kollegen einen entscheidenden Artikel die Generative Adversarial Networks (GANs) vorstellten. GANs, die wir im nächsten Abschnitt untersuchen werden, bilden die Grundlage für die Erstellung synthetischer Inhalte.

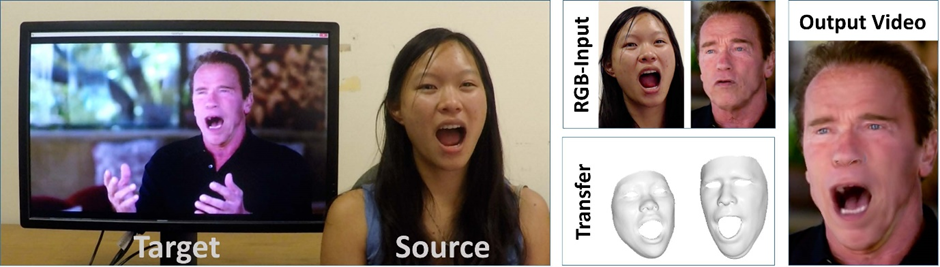

Ein weiterer Meilenstein war das 2016 veröffentlichte Face2Face-Veröffentlichung von Justus Thies und seinem Team, in dem es um Techniken zur Erfassung und Nachstellung von Gesichtern in Echtzeit ging. Ein Beispiel für die Anwendung ist das folgende Bild, in dem ein Gesichtsausdruck auf den berühmten Schauspieler und Politiker Arnold Schwarzenegger übertragen wird.

Beispiel für die Kombination von Quell- und Zielbildern zur Übertragung von Gesichtsausdrücken mit Face2Face. Quelle: Face2Face Papier

Das Phänomen erlangte Ende 2017 große öffentliche Aufmerksamkeit, als manipulierte Videos - oft mit ausgetauschten Gesichtern von Prominenten, vor allem bei Erwachsenen - auf Reddit zu kursieren begannen und schließlich dazu führten, dass soziale Medienplattformen die schädliche Verwendung von Deepfake-Techniken verboten.

Eines der bekanntesten Beispiele tauchte 2018 auf: ein virales Video mit einem digital veränderten Präsidenten Barack Obama, das von BuzzFeed in Zusammenarbeit mit Jordan Peele erstellt wurde und das Potenzial der Technologie zur Umgestaltung des öffentlichen Diskurses aufzeigte.

Im Jahr 2020 schufen die South Park-Schöpfer Trey Parker und Matt Stone ein weiteres bemerkenswertes Stück Deepfake-Kunst: den Pilotfilm der Serie "Freche Gerechtigkeit" zeigte fiktive Charaktere, die von Deepfakes von Donald Trump und Mark Zuckerberg "gespielt" wurden.

Wie funktionieren Deepfakes?

Wenn wir über Deepfakes sprechen, konzentrieren wir uns oft auf das Endprodukt. Lass uns ein bisschen tiefer graben und versuchen zu verstehen, wie sie erstellt werden - ich werde sicherstellen, dass du verstehst, wie das funktioniert, auch wenn du keinen technischen Hintergrund hast.

Diskriminierende und generative Modelle

Diskriminative Modelle werden verwendet, um zwischen Dingen zu unterscheiden - zum Beispiel, ob ein Bild echt oder gefälscht ist. Sie schauen sich die Daten an und versuchen, die richtige Bezeichnung (wie "echt" oder "Deepfake") vorherzusagen. Gängige Modellbeispiele sind logistische RegressionEntscheidungsbäume, neuronale Netze und Support-Vektor-Maschinen. Diese Modelle eignen sich hervorragend für Aufgaben wie die Erkennung von Deepfakes, denn sie sind darauf trainiert, Anzeichen dafür zu erkennen, dass etwas verändert oder manipuliert wurde.

Generative Modelle hingegen versuchen zu verstehen, wie reale Daten funktionieren, damit sie neue, ähnliche Daten erstellen können. Sie lernen von vielen realen Beispielen - wie Bildern von echten Gesichtern oder Clips von echten Stimmen - und nutzen dann dieses Wissen, um gefälschte, aber realistisch aussehende Medien zu erstellen. So werden Deepfakes gemacht.

Der Hauptunterschied besteht darin, wofür sie verwendet werden: Diskriminative Modelle erkennen, und generative Modelle erstellen. Bei der Deepfake-Technologie ist beides wichtig - das eine, um überzeugende Fälschungen zu erstellen, und das andere, um sie zu erkennen.

Um mehr über den Unterschied zu erfahren, schau dir diesen Blog an generative vs. diskriminative Modelle.

Generative kontradiktorische Netzwerke

GANs sind eine Art der generativen KI, die ein generatives und ein diskriminatives Modell zusammen trainiert. Die Beziehung zwischen den beiden Modellen lässt sich am besten als freundschaftliche Konkurrenz beschreiben: Während der Generator synthetische Inhalte erstellt, arbeitet der Diskriminator daran, echte Medien von Fälschungen zu unterscheiden. Diese Konkurrenz treibt den Generator dazu an, seine Arbeit zu verbessern, bis seine Ergebnisse von den echten Medien kaum noch zu unterscheiden sind.

Bei Deepfakes ist die Rolle des generativen Modells die eines Kunstfälschers, der gefälschte Kunstwerke malt, während das diskriminative Modell die eines Kunstkritikers verkörpert, der jedes Werk genau untersucht, um die Fälschungen zu erkennen. Da sie durch den Kontakt mit immer mehr Daten Erfahrungen sammeln, werden sowohl der Fälscher als auch der Kritiker besser in ihrer Arbeit, was zu immer überzeugenderen Reproduktionen und genaueren Bewertungen führt.

Dabei werden Modelle auf umfangreichen Datensätzen trainiert, um die einzigartigen Merkmale einer Person zu erfassen, z. B. den Tonfall und die Gesichtszüge. Durch die Analyse dieser Daten erstellt das System nach und nach ein genaues Abbild der Zielperson, das es nutzt, um sie überzeugend zu imitieren.

Deepfake-Techniken

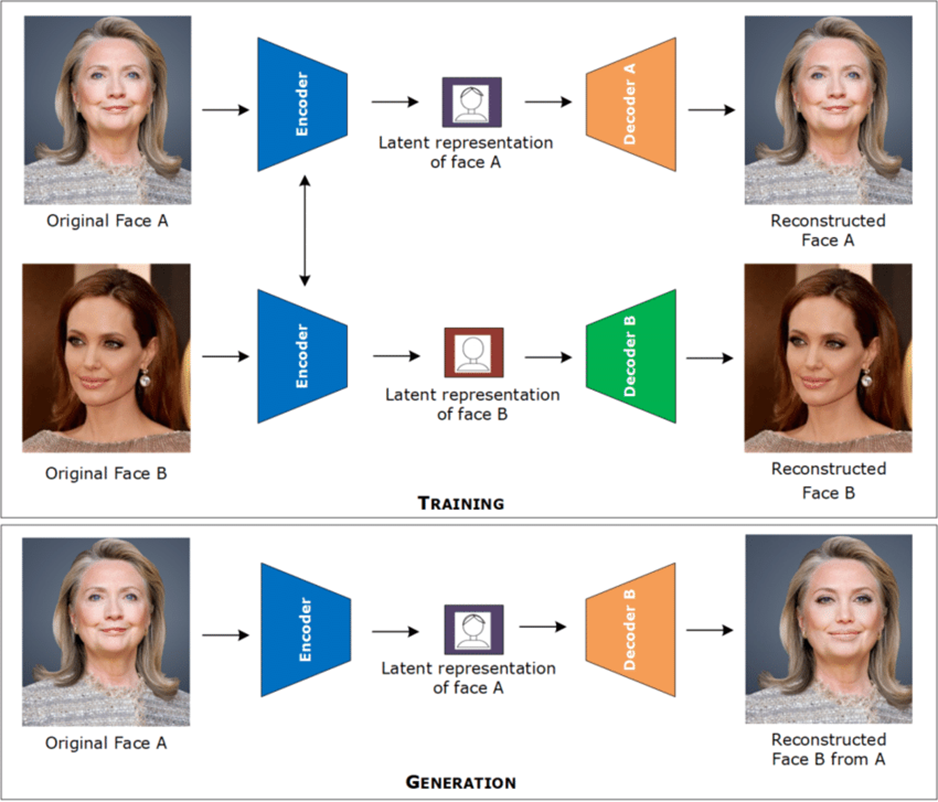

Gängige Techniken für das Face-Swapping sind Autocodierer und neuronale Faltungsnetzwerke. Diese Tools werden auf viele Bilder oder Videos einer Person trainiert, um zu lernen, wie ihr Gesicht aussieht - seine Form, seine Mimik und seine wichtigsten Merkmale. Die KI wandelt diese Informationen in ein Format um, das sie verstehen kann, sozusagen eine digitale Zusammenfassung des Gesichts der Person.

Anhand dieser Zusammenfassung kopiert es die Mimik einer Person und überträgt sie auf eine andere, sodass der Gesichtstausch realistisch aussieht.

Bei der Lippensynchronisation analysieren neuronale Netze nicht nur die Mundbewegungen, sondern auch die Audioeingänge, um die Videoausgabe genau auf die gesprochenen Worte abzustimmen.

Sie werden mit gelabelten Datensätzen trainiert, bei denen jedes Videobild mit einer Audiobeschriftung gepaart ist, die das genaue gesprochene Phonem angibt, so dass das Modell die genaue Beziehung zwischen Ton und visueller Artikulation lernen kann.

Durch die gleichzeitige Analyse dieser Daten- und Labelpaare lernt das Netzwerk, Videoausgaben zu erzeugen, bei denen die Mundbewegungen die gelernte Beziehung widerspiegeln.

Schließlich kann das Klonen von Stimmen durch das Trainieren von Sprachsynthesemodellen anhand umfangreicher Audiodatensätze in Verbindung mit den entsprechenden Transkripten erreicht werden. Diese Datensätze erfassen die einzigartigen Merkmale der Stimme einer Person (wie Tonhöhe, Klangfarbe und Kadenz) in einem strukturierten Format, das die Modelle analysieren können.

Durch das Lernen aus diesen Daten und Label-Paaren erzeugen die Modelle synthetische Sprache, die die natürlichen stimmlichen Eigenschaften der Zielperson genau nachahmt und ihre Stimme überzeugend imitiert.

Deepfakes Anwendungen

Ich bin mir ziemlich sicher, dass die meisten von uns schon einmal synthetische Videos gesehen haben, in denen berühmte Schauspieler oder Persönlichkeiten des öffentlichen Lebens in humorvollen Szenen zu sehen sind. Deepfakes können aber auch vielen anderen Zwecken dienen, z. B. zu Bildungszwecken oder zur Verbesserung der Zugänglichkeit.

Unterhaltung

Deepfakes bieten Filmemachern innovative Werkzeuge, mit denen sie Schauspieler jünger aussehen lassen oder Synchronfassungen von Filmen erstellen können, die den Originalaufführungen sehr nahe kommen.

Ein bemerkenswertes Beispiel für Ersteres ist Martin Scorseses "The Irishman" (2019), in dem Robert De Niro, Al Pacino und Joe Pesci in Rückblenden Jahrzehnte jünger erscheinen. Auf diese Weise konnte die Geschichte ganz natürlich ablaufen, ohne dass mehrere Darsteller ihre jüngeren Ichs spielen mussten. Sehen Sie eine Erklärung dieses Prozesses in diesem Video.

Deepfakes revolutionieren auch die Erstellung von digitalen Charakteren, indem sie realistische Avatare für Videospiele und virtuelle Realität erzeugen. Die Möglichkeit, lebensechte Charaktere zu entwerfen, die in immersiven digitalen Umgebungen auf natürliche Weise mit den Nutzerinnen und Nutzern interagieren, macht den Weg frei für interaktive und personalisierte Unterhaltungserlebnisse. Der MetaHuman Creator von Epic Games ermöglicht es Entwicklern zum Beispiel, fotorealistische Avatare zu erstellen, die sich in Echtzeit bewegen und überzeugend reagieren.

Das Potenzial von Deepfakes für die Produktion satirischer Inhalte ist ebenfalls enorm. Während traditionelle Imitationen schon lange zum Repertoire eines Comedians gehören, bringen Deepfakes eine neue Ebene von Details und Realismus in die Nachahmungen. Künstler wie Snicklink und Kyle Dunnigan erforschen bereits diesen innovativen Ansatz und erweitern die Grenzen der digitalen Satire.

Bildung und Zugänglichkeit

Ein neuerer Einsatz der Deepfake-Technologie stammt von BBC Maestro, die einen Schreibkurs mit einer nachgestellten Agatha Christie (fast 50 Jahre nach ihrem Tod) gestartet hat.

Mit Hilfe von KI-generierten Bildern und Sprachmodellen, die auf ihren Briefen, Interviews und Manuskripten basieren, bietet der Kurs eine Version von Christie, die in ihren eigenen Worten unterrichtet. Es ist ein klares Beispiel dafür, wie generative Medien genutzt werden können, um historische Figuren in zeitgenössische Bildungssituationen zu bringen.

Deepfakes versprechen auch, die Zugänglichkeit zu verbessern, insbesondere für Menschen mit Sprachbehinderungen. Die Entwicklung von synthetischen Stimmen, die die stimmlichen Eigenschaften einer Person aus Aufnahmen einfangen, kann eine natürlichere Kommunikation ermöglichen.

Ein bemerkenswertes Beispiel ist "Projekt Revoice". das Menschen mit einer Motoneuronenerkrankung (die oft zum Verlust der Sprache führt) hilft, ihre natürliche Stimme zu bewahren und wiederherzustellen, indem es frühzeitig Sprachaufnahmen macht.

Ethische und soziale Herausforderungen von Deepfakes

Jede Diskussion über Deepfakes wäre unvollständig, ohne auf die Herausforderungen einzugehen, die sie mit sich bringen. Zu den dringendsten Anliegen gehören die folgenden:

- Vertrauenserosion

- Betrügerische Aktivitäten

- Verletzungen der Privatsphäre

Deepfakes haben das Potenzial, das Vertrauen der Öffentlichkeit zu untergraben, da es immer schwieriger wird, zwischen echten und manipulierten Inhalten zu unterscheiden. Wenn sich falsche Informationen verbreiten, können sie die öffentliche Meinung beeinflussen, den Ruf schädigen oder in kritischen Situationen Verwirrung stiften.

In den schlimmsten Fällen können Deepfakes von böswilligen Akteuren als Waffe eingesetzt werden, um Gesellschaften zu destabilisieren, politische Spaltungen zu schüren oder sogar Wahlen zu beeinflussen, indem sie gefälschte Aussagen oder Handlungen verbreiten, die öffentlichen Personen zugeschrieben werden.

Die Fähigkeit, sich mit Hilfe der Deepfake-Technologie überzeugend als jemand anderes auszugeben, öffnet Türen für betrügerische Aktivitäten, wie Finanzbetrug oder Identitätsdiebstahl. Cyberkriminelle können geklonte Stimmen verwenden, um Menschen dazu zu verleiten, Geld zu überweisen oder Zugang zu sensiblen Daten zu gewähren. Dies gibt Anlass zur Sorge für Branchen wie das Bankwesen und die Cybersicherheit, wo herkömmliche Überprüfungsmethoden möglicherweise nicht mehr ausreichen.

Eine der beunruhigendsten Anwendungen von Deepfakes ist die Erstellung von nicht-einvernehmlichen Inhalten, die oft zur Ausbeutung oder Einschüchterung von Personen verwendet werden. Die Opfer können sich in fabrizierten Medien wiederfinden, die ihren Ruf schädigen oder ihre Privatsphäre verletzen. Dies wirft ein großes ethisches Problem auf, da der Missbrauch von persönlichen Bildern ohne Zustimmung langfristige psychologische und berufliche Folgen für die Betroffenen haben kann.

Trotz der wachsenden Risiken sind die Gesetze und Vorschriften zur Erstellung und Verbreitung von Deepfakes in vielen Ländern noch immer unklar. Obwohl einige Länder gezielte Gesetze eingeführt haben, bleibt die Durchsetzung aufgrund der rasanten Entwicklung der Technologie schwierig. Das Fehlen eines klaren Rechtsrahmens macht es schwierig, die Täter zur Rechenschaft zu ziehen und wirft die Frage auf, wie das Recht auf freie Meinungsäußerung mit der Notwendigkeit, Schaden zu verhindern, in Einklang gebracht werden kann.

Wie man Deepfakes erkennt

Wie wir gesehen haben, wird das Erkennen von Originalen und manipulierten Inhalten zu einer entscheidenden Fähigkeit im Zeitalter der KI. Schauen wir uns die verschiedenen Ansätze an, um sie zu unterscheiden.

Menschliche Beobachtung

Obwohl es immer schwieriger wird, sie zu erkennen, gibt es verräterische Anzeichen für Manipulation, die das menschliche Auge mehr oder weniger leicht erkennen kann. Die meisten von uns haben wahrscheinlich schon von KI-generierten Bildern gehört, auf denen Menschen plötzlich vier oder sechs Finger haben, aber andere Anzeichen sind subtiler als das.

Bei Bildern ist ein Hinweis auf Manipulation eine unnatürliche Unschärfe oder uneinheitliche Verpixelung an den Rändern von Gesichtern oder Objekten. Das bedeutet, dass das Modell nicht genau unterscheiden konnte, welcher Pixel zum Gesicht und welcher zum Hintergrund gehört, wodurch eine mehr oder weniger offensichtliche Naht entsteht.

Ein weiteres Indiz können Beleuchtungen oder Schatten sein, die nicht zur Umgebung passen und das Bild künstlich komponiert erscheinen lassen.

KI-generiertes Bild, das eine Diskrepanz zwischen Lichtquelle und Schatten zeigt.

In Videos können Beleuchtungsprobleme noch leichter ins Auge fallen, wenn sich die Richtung der Lichtquelle zwischen den Bildern abrupt ändert. Wir können auch ungewöhnliche Blinzelmuster oder starre Gesichtsausdrücke erkennen, die nicht in den Kontext passen, was zu einem subtilen "unheimlichen" Gefühl führt. In manchen Fällen flackern die Ränder um den Kopf oder die Haare und verraten, dass das Video manipuliert worden sein könnte.

Technische Methoden

Die Erkennung von Deepfakes erfordert oft eine Kombination von KI-gesteuerten Erkennungsmethoden, die Unstimmigkeiten in Gesichtszügen, Bewegungen und anderen Artefakten analysieren. Einige Beispiele für Software, die auf die Erkennung von manipulierten Medieninhalten spezialisiert ist, sind:

- GoogleSynthID

- Truepic

- DuckDuckGoose

- Intel FakeCatcher

- Reality Defender

- Sensibilität AI

- Deepware Scanner

Jedes Tool hat einen einzigartigen Ansatz, der auf den jeweiligen Hauptanwendungsfall ausgerichtet ist. Während sich alle anderen genannten Tools auf die Validierung bereits erstellter Inhalte konzentrieren, können Google SynthID und Truepic als präventive Maßnahmen zur Identifizierung von KI-generierten Inhalten betrachtet werden.

Google SynthID bettet unmerkliche digitale Wasserzeichen direkt in KI-generierte Bilder ein, um deren Herkunft zu kennzeichnen, während Truepic kryptografisches Hashing und Blockchain-basierte Verifizierung nutzt, um Medien im Moment der Aufnahme zu authentifizieren.

DuckDuckGoose, das hauptsächlich Unregelmäßigkeiten im Gesicht analysiert, und Intel FakeCatcher, dessen Stärke in der Erkennung von biologischen Signalen wie Blutflussmustern liegt, zielen beide auf forensische und wissenschaftliche Anwendungen ab.

Der Unterschied zwischen Reality Defender, Sensity AI und Deepware Scanner, die alle Deep-Learning-Modelle verwenden, um zwischen echten und gefälschten Inhalten zu unterscheiden, liegt in der Zielgruppe: Während die beiden erstgenannten Tools eine Integration mit Sicherheitstools für Unternehmen bieten und für groß angelegte Erkennungsmissionen in Unternehmen geeignet sind, ist Deepware Scanner ein eher leichtgewichtiges, verbraucherorientiertes Tool für gelegentliche Nutzer.

Fazit

Deepfakes sind sowohl ein technologischer Fortschritt als auch eine große ethische Herausforderung. Während sie spannende Möglichkeiten in den Bereichen Unterhaltung, Bildung und Zugänglichkeit eröffnen, kann ihr Missbrauch zu Fehlinformationen, Betrug und Verletzungen der Privatsphäre führen.

In Zukunft ist damit zu rechnen, dass Deepfakes noch realistischer werden, vor allem in Virtual-Reality-Anwendungen, während die Erkennungswerkzeuge versuchen werden, mit den immer ausgefeilteren Manipulationstechniken Schritt zu halten.

Wenn du mehr über die theoretischen und technischen Aspekte von Deepfakes erfahren möchtest, findest du auf dem DataCamp die folgenden Ressourcen: