Cursus

Je suis sûr que la plupart d'entre nous ont déjà rencontré des deepfakes, que ce soit sous la forme de mèmes viraux ou de clips d'information habilement modifiés. Qu'on le veuille ou non, ils font désormais partie intégrante de notre paysage en ligne.

Les "deepfakes" sont des médias synthétiques tels que des vidéos, des images ou des sons qui sont créés ou modifiés à l'aide d'une intelligence artificielle pour imiter de manière convaincante des personnes ou des événements réels. À mesure que l'IA progresse, il sera de plus en plus difficile de distinguer la réalité de la fiction, ce qui fait des "deepfakes" à la fois un outil créatif et une menace pour la vérité et la vie privée.

Dans cet article, j'aborderai les sujets suivants :

- Ce que sont les deepfakes

- La technologie qui les sous-tend

- Applications possibles dans différents domaines

- Défis éthiques liés aux "deepfakes

- Moyens possibles de les détecter

Qu'est-ce qu'un "deepfake" ?

Les deepfakes sont des médias artificiellement générés ou manipulés, créés à l'aide d'outils d'apprentissage profond ("deep learning"). apprentissage profond pour produire des représentations très réalistes mais synthétiques de personnes, d'objets ou d'événements.

Bien qu'elles soient souvent utilisées pour imiter des visages, des voix ou des actions humaines, les techniques de deepfake peuvent également générer ou modifier des objets, des scènes, des animaux ou même des environnements entiers dans des vidéos et des images afin de créer un contenu réaliste mais faux, brouillant ainsi la frontière entre la réalité et la fabrication dans un large éventail de contextes.

Les origines des "deepfakes" remontent à des percées universitaires majeures. En 2014, Ian Goodfellow et ses collègues ont publié un article essentiel qui présentait les réseaux adversoriels génératifs (GAN). Les GAN, que nous étudierons dans la section suivante, constituent la base de la génération de contenu synthétique.

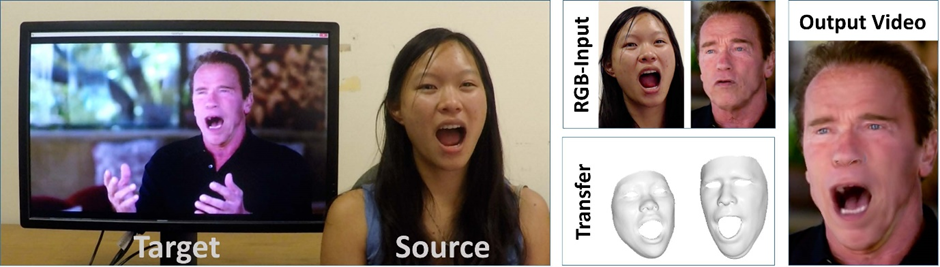

Une nouvelle étape a été franchie avec la publication en 2016 du document article Face2Face de Justus Thies et de son équipe, qui portait sur les techniques de capture et de reconstitution de visages en temps réel. Un exemple de son utilisation est présenté dans l'image ci-dessous, où une expression faciale est transférée au célèbre acteur et politicien Arnold Schwarzenegger.

Exemple de combinaison d'images source et cible pour transférer des expressions faciales à l'aide de Face2Face. Source : Papier Face2Face

Le phénomène a attiré l'attention du grand public à la fin de l'année 2017, lorsque des vidéos manipulées - présentant souvent des échanges de visages de célébrités, notamment dans des contenus pour adultes - ont commencé à circuler sur Reddit, ce qui a finalement conduit les plateformes de médias sociaux à interdire l'utilisation préjudiciable des techniques de deepfake.

L'un des exemples les plus reconnus a émergé en 2018 : une vidéo virale mettant en scène un président Barack Obama modifié numériquement, créée par BuzzFeed en collaboration avec Jordan Peele, qui a mis en évidence le potentiel de la technologie pour remodeler le discours public.

En 2020, les créateurs de South Park, Trey Parker et Matt Stone, ont créé une autre œuvre notable de deepfake art : le pilote de la série "Sassy Justice"mettait en scène des personnages fictifs "joués" par des deepfakes de Donald Trump et de Mark Zuckerberg, entre autres.

Comment fonctionnent les Deepfakes ?

Lorsque nous parlons de deepfakes, nous nous concentrons souvent sur le produit final. Nous allons creuser un peu plus et essayer de comprendre comment ils sont créés - je m'assurerai que vous comprenez comment cela fonctionne même si vous n'avez pas de connaissances techniques.

Modèles discriminatifs et génératifs

Les modèles discriminants sont utilisés pour faire la différence entre les choses, par exemple pour déterminer si une image est réelle ou fausse. Ils examinent les données et tentent de prédire l'étiquette correcte (comme "vrai" ou "deepfake"). Parmi les exemples de modèles courants, on peut citer la régression logistiqueles arbres de décision, les réseaux neuronaux et les machines à vecteurs de support. Ces modèles sont parfaits pour des tâches telles que la détection des "deepfakes", car ils sont entraînés à repérer les signes indiquant que quelque chose a été modifié ou manipulé.

Les modèles génératifs, quant à eux, tentent de comprendre le fonctionnement des données réelles afin de pouvoir créer de nouvelles données similaires. Ils apprennent à partir de nombreux exemples réels, tels que des photos de vrais visages ou des clips de vraies voix, et utilisent ensuite ces connaissances pour générer des médias factices mais réalistes. C'est ainsi que sont fabriqués les deepfakes.

La principale différence réside dans leur utilisation : les modèles discriminatifs détectent et les modèles génératifs créent. Dans la technologie des "deepfakes", les deux sont importants : l'un pour fabriquer des faux convaincants, l'autre pour les repérer.

Pour en savoir plus sur la différence, consultez ce blog sur les modèles génératifs et modèles discriminatifs.

Réseaux adversaires génératifs

Les GAN sont un type d'IA générative qui entraîne un modèle génératif et un modèle discriminatif ensemble. La relation entre les deux modèles peut être décrite comme une compétition amicale : tandis que le générateur crée du contenu synthétique, le discriminateur s'efforce de distinguer les vrais médias des faux. Cette rivalité pousse le générateur à améliorer son travail jusqu'à ce que ses résultats soient presque impossibles à distinguer des médias authentiques.

Dans le cas des deepfakes, le rôle du modèle génératif est celui d'un faussaire peignant des œuvres d'art contrefaites, tandis que le modèle discriminatif incarne un critique d'art examinant minutieusement chaque œuvre pour repérer les contrefaçons. Au fur et à mesure qu'ils acquièrent de l'expérience en étant exposés à un nombre croissant de données, le faussaire et le critique deviennent meilleurs dans leur travail, ce qui se traduit par des reproductions de plus en plus convaincantes et des évaluations de plus en plus précises.

Le processus consiste à former des modèles sur de vastes ensembles de données afin de capturer les caractéristiques uniques d'un sujet, telles que le ton de la voix et les caractéristiques faciales. En analysant ces données, le système construit progressivement une représentation précise de la cible, qu'il utilise pour l'imiter de manière convaincante.

Techniques d'imitation profonde (deepfake)

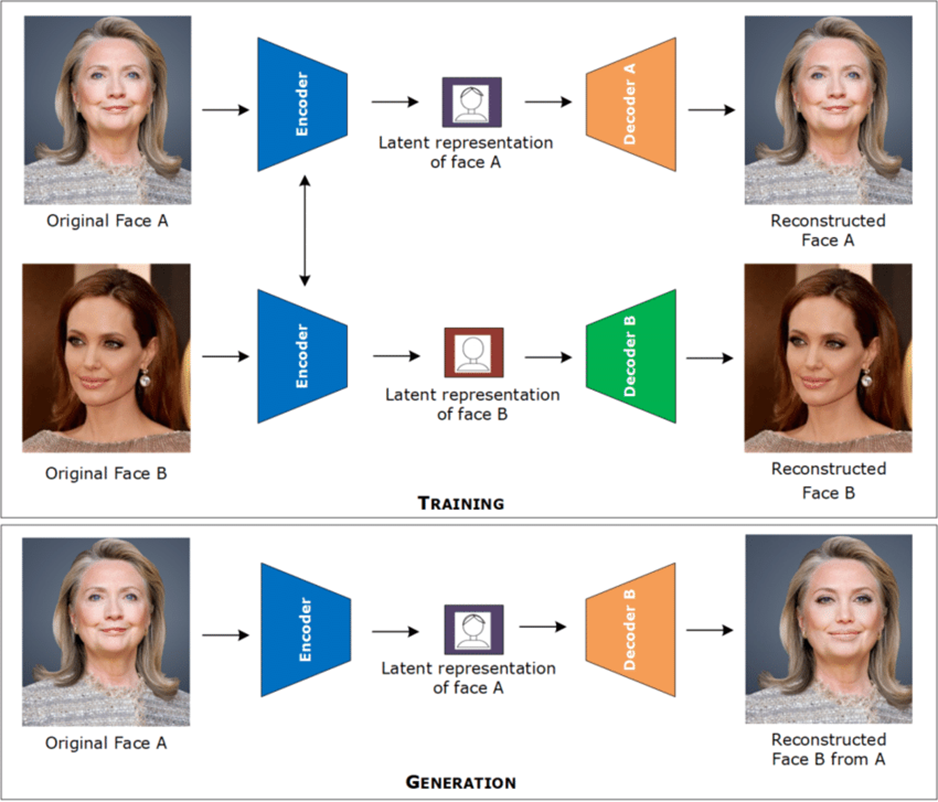

Les techniques courantes d'échange de visages font souvent appel à des autoencodeurs et à des réseaux neuronaux convolutifs. Ces outils sont formés à partir de nombreuses images ou séquences vidéo d'une personne afin d'apprendre à quoi ressemble son visage - sa forme, ses expressions et ses principales caractéristiques. L'IA transforme ces informations dans un format qu'elle peut comprendre, un peu comme un résumé numérique du visage de la personne.

Il utilise ensuite ce résumé pour copier les expressions faciales d'une personne et les appliquer à une autre, ce qui donne un aspect réaliste à l'échange de visages.

Pour la synchronisation labiale, les réseaux neuronaux analysent non seulement les mouvements de la bouche, mais aussi les entrées audio, afin d'aligner avec précision la sortie vidéo sur les mots prononcés.

Ils sont formés à l'aide d'ensembles de données étiquetés, où chaque image vidéo est associée à une étiquette audio indiquant le phonème parlé exact, ce qui permet au modèle d'apprendre la relation précise entre le son et l'articulation visuelle.

En analysant simultanément ces paires de données et d'étiquettes, le réseau apprend à générer des sorties vidéo où les mouvements de la bouche reflètent la relation apprise.

Enfin, le clonage vocal peut être réalisé en formant des modèles de synthèse vocale à l'aide de vastes ensembles de données audio associées aux transcriptions correspondantes. Ces ensembles de données capturent les caractéristiques uniques de la voix d'un individu (telles que la hauteur, le ton et la cadence) dans un format structuré que les modèles peuvent analyser.

En apprenant à partir de ces paires de données et d'étiquettes, les modèles génèrent un discours synthétique qui reproduit fidèlement les qualités vocales naturelles de la cible, imitant ainsi sa voix de manière convaincante.

Applications Deepfakes

Je suis certain que la plupart d'entre nous ont déjà vu des vidéos synthétiques mettant en scène des acteurs célèbres ou des personnalités publiques dans des scénarios humoristiques. Mais les deepfakes peuvent servir à bien d'autres fins, notamment à des fins éducatives ou pour améliorer l'accessibilité.

Divertissement

Les "deepfakes" offrent aux cinéastes des outils innovants, leur permettant de rajeunir les acteurs ou de créer des versions doublées de films qui correspondent étroitement aux performances originales.

Un exemple notable du premier est "The Irishman" (2019) de Martin Scorsese, dans lequel Robert De Niro, Al Pacino et Joe Pesci apparaissent des dizaines d'années plus jeunes pour des scènes de flash-back. De cette manière, l'histoire a pu se dérouler naturellement sans qu'il soit nécessaire d'avoir plusieurs interprètes pour jouer leur rôle de jeunes. Vous trouverez une explication de ce processus dans cette vidéo.

Les deepfakes révolutionnent également la création de personnages numériques en générant des avatars réalistes pour les jeux vidéo et la réalité virtuelle. La possibilité de concevoir des personnages réalistes qui interagissent naturellement avec les utilisateurs dans des environnements numériques immersifs ouvre la voie à des expériences de divertissement plus interactives et personnalisées. Par exemple, MetaHuman Creator d'Epic Games permet aux développeurs de créer des avatars photoréalistes qui bougent et réagissent de manière convaincante en temps réel.

Le potentiel des deepfakes pour la production de contenu satirique est également énorme. Si les imitations traditionnelles font depuis longtemps partie du répertoire des humoristes, les "deepfakes" introduisent un nouveau niveau de détail et de réalisme dans les imitations. Des artistes comme Snicklink et Kyle Dunnigan explorent déjà cette approche innovante, repoussant les limites de la satire numérique.

Éducation et accessibilité

La BBC Maestro, qui a lancé un cours d'écriture avec une Agatha Christie recréée (près de 50 ans après sa mort), a récemment utilisé la technologie du "deepfake".

À l'aide de visuels générés par l'IA et d'une modélisation vocale basée sur ses lettres, ses interviews et ses manuscrits, le cours offre une version de Christie délivrant des leçons dans ses propres mots. C'est un exemple clair de la manière dont les médias génératifs peuvent être utilisés pour introduire des personnages historiques dans des contextes éducatifs contemporains.

Les deepfakes promettent également d'améliorer l'accessibilité, en particulier pour les personnes souffrant de troubles de la parole. La mise au point de voix synthétiques qui reproduisent les caractéristiques vocales d'une personne à partir d'enregistrements peut permettre une communication plus naturelle.

Un exemple remarquable est celui du "Projet Revoice". qui aide les personnes atteintes d'une maladie du motoneurone (qui entraîne souvent la perte de la parole) à préserver et à recréer leur voix naturelle en enregistrant leur voix dès le début.

Défis éthiques et sociaux des Deepfakes

Toute discussion sur les "deepfakes" serait incomplète si l'on n'abordait pas les défis qu'ils posent. Les préoccupations les plus pressantes sont les suivantes :

- Érosion de la confiance

- Activité frauduleuse

- Violations de la vie privée

Les "deepfakes" ont le potentiel d'éroder la confiance du public en rendant de plus en plus difficile la distinction entre un contenu réel et un contenu manipulé. Lorsque de fausses informations se répandent, elles peuvent façonner l'opinion publique, nuire à la réputation ou semer la confusion dans des situations critiques.

Dans le pire des cas, les "deepfakes" peuvent être utilisés par des acteurs malveillants pour déstabiliser des sociétés, alimenter des divisions politiques ou même influencer des élections en diffusant des déclarations ou des actions fabriquées attribuées à des personnalités publiques.

La possibilité d'usurper de manière convaincante l'identité d'une personne grâce à la technologie deepfake ouvre la voie à des activités frauduleuses, telles que les escroqueries financières ou l'usurpation d'identité. Les cybercriminels peuvent utiliser des voix clonées pour tromper les individus et les inciter à transférer de l'argent ou à donner accès à des données sensibles. Cela soulève des inquiétudes dans des secteurs comme la banque et la cybersécurité, où les méthodes de vérification traditionnelles pourraient ne plus suffire.

L'une des applications les plus inquiétantes des deepfakes est la création de contenus non consensuels, souvent utilisés pour exploiter ou intimider des individus. Les victimes peuvent se retrouver insérées dans des médias fabriqués de toutes pièces qui portent atteinte à leur réputation ou à leur vie privée. Il s'agit là d'un problème éthique majeur, car l'utilisation abusive d'images personnelles sans consentement peut avoir des conséquences psychologiques et professionnelles à long terme pour les personnes concernées.

Malgré les risques croissants, les lois et réglementations relatives à la création et à la distribution de deepfake restent floues dans de nombreux pays. Bien que certaines juridictions aient introduit une législation ciblée, l'application reste difficile en raison de l'évolution rapide de la technologie. L'absence d'un cadre juridique clair rend difficile la responsabilisation des auteurs et soulève des questions sur la manière de concilier la liberté d'expression et la nécessité de prévenir les préjudices.

Comment détecter les "deepfakes" ?

Comme nous l'avons vu, la détection des contenus originaux et des contenus manipulés devient une compétence cruciale à l'ère de l'IA. Examinons différentes approches pour les distinguer.

Observation humaine

Bien que de plus en plus difficiles à reconnaître, il existe des signes révélateurs de manipulation que l'œil humain peut capter plus ou moins facilement. La plupart d'entre nous ont probablement entendu parler d'images générées par l'IA dans lesquelles des humains avaient soudainement quatre ou six doigts, mais d'autres signes sont plus subtils que cela.

Pour les photos, un indice de manipulation est un flou non naturel ou une pixellisation incohérente sur les bords des visages ou des objets. Cela signifie que le modèle n'a pas pu distinguer avec précision quel pixel appartient au visage et quel pixel appartient à l'arrière-plan, ce qui laisse un joint plus ou moins évident.

Un autre indice peut être l'éclairage ou les ombres qui ne correspondent pas à l'environnement, ce qui donne l'impression que l'image est composée artificiellement.

Image générée par l'IA illustrant une inadéquation entre la source lumineuse et les ombres.

Dans les vidéos, les problèmes d'éclairage peuvent attirer l'attention encore plus facilement si la direction de la source lumineuse change brusquement d'une image à l'autre. Nous pouvons également repérer des clignements d'yeux inhabituels ou des expressions faciales rigides qui ne semblent pas correspondre au contexte environnant, ce qui provoque un sentiment subtil d'"étrangeté". Dans certains cas, les contours de la tête ou des cheveux vacillent, révélant que la vidéo a pu être manipulée.

Méthodes techniques

La détection des deepfakes nécessite souvent une combinaison de méthodes de détection pilotées par l'IA qui analysent les incohérences dans les traits du visage, les mouvements et d'autres artefacts. Voici quelques exemples de logiciels spécialisés dans la détection de contenus médiatiques manipulés :

- GoogleSynthID

- Truepic

- DuckDuckGoose

- Intel FakeCatcher

- Défenseur de la réalité

- Sensité AI

- Scanner de logiciels profonds

Chaque outil a une approche unique visant à répondre à son cas d'utilisation principal respectif. Alors que tous les autres outils mentionnés se concentrent sur la validation de contenus déjà créés, Google SynthID et Truepic peuvent être considérés comme des mesures préventives pour identifier les contenus générés par l'IA.

Google SynthID intègre des filigranes numériques imperceptibles filigranes directement dans les images générées par l'IA pour en marquer l'origine, tandis que Truepic utilise le hachage cryptographique et la vérification basée sur la blockchain pour authentifier les médias au moment de leur capture.

DuckDuckGoose, qui analyse principalement les incohérences faciales, et Intel FakeCatcher, dont la force réside dans la détection de signaux biologiques tels que les flux sanguins, visent tous deux des applications médico-légales et de recherche.

La différence entre Reality Defender, Sensity AI et Deepware Scanner, qui utilisent tous des modèles d'apprentissage profond pour différencier les contenus réels des contenus factices, réside dans le groupe cible : alors que les deux premiers proposent une intégration avec les outils de sécurité d'entreprise et sont adaptés aux missions de détection à grande échelle des entreprises, Deepware Scanner est un outil plus léger axé sur le consommateur et destiné aux utilisateurs occasionnels.

Conclusion

Les "deepfakes" représentent à la fois une avancée technologique et un défi éthique important. S'ils ouvrent des perspectives passionnantes en matière de divertissement, d'éducation et d'accessibilité, leur utilisation abusive peut conduire à la désinformation, à la fraude et à la violation de la vie privée.

À l'avenir, nous pouvons nous attendre à ce que les deepfakes deviennent encore plus réalistes, en particulier dans les applications de réalité virtuelle, tandis que les outils de détection tenteront de suivre le rythme des techniques de manipulation de plus en plus sophistiquées.

Si vous souhaitez en savoir plus sur les aspects théoriques et technologiques des deepfakes, DataCamp vous propose les ressources suivantes :