programa

El Día 1 de Google I/O 2025 ha terminado. En este artículo, te guiaré a través de los anuncios más importantes para la industria de la IA.

Me centraré en las actualizaciones que están listas para usar o que se espera que salgan pronto. Por el camino, compartiré impresiones rápidas y, cuando sea pertinente, pondré las cosas en contexto con la competencia.

Mantenemos a nuestros lectores al día de lo último en IA enviándoles The Median, nuestro boletín gratuito de los viernes que desglosa las noticias clave de la semana. Suscríbete y mantente alerta en sólo unos minutos a la semana:

Veo 3

Lo que más me llamó la atención de Veo 3 es que ofrece salida de audio nativa. Ahora puedes generar vídeos que incluyan sonido directamente, sin necesidad de pasos adicionales de edición. Veamos un ejemplo:

La salida de audio nativa es algo que aún no he visto en Pista o Sora. En este punto, diría que Veo 3 está un paso por delante.

Aunque la demostración tiene buena pinta, he aprendido que los vídeos de demostración rara vez reflejan cómo se comportan estos modelos en la práctica. En cuanto el estímulo se sale de la forma de los datos de entrenamiento -una escena desconocida, un personaje extraño o una idea con demasiada sutileza-, el modelo tiende a colapsarse. Estoy deseando dar una vuelta con Veo 3 para ver qué tal lo hace.

El acceso a Veo 3 requiere una suscripción AI Ultra, que cuesta 250 $/mes. Aunque estés dispuesto a pagar, la disponibilidad es limitada. Por ahora, sólo es accesible en EE.UU., y sólo dentro del nuevo editor de vídeo de Google basado en IA llamado Flow (del que hablaremos a continuación).

Si tienes curiosidad por los detalles técnicos o quieres explorar más ejemplos, echa un vistazo a la página oficial de Veo aquí.

Flujo

Flow es una herramienta cinematográfica de IA que te permite generar planos individuales utilizando una combinación de Veo, Imagen y Gemini.

Una cosa que me parece útil es que puedes crear elementos separados (llamados "ingredientes") y luego agruparlos en una sola escena. Esto te da un control modular y puede ser especialmente útil cuando quieras reutilizar los mismos elementos en varios avisos o tomas.

Veamos un ejemplo:

También hay herramientas para el control de la cámara y las transiciones dentro de Flow, que ayudan a dar a los clips una sensación más cinematográfica. Son útiles, pero no nuevas: Sora y Runway ya ofrecen funciones similares, así que yo no diría que aquí haya nada innovador.

Aun así, merece la pena prestar atención a cómo evolucionan este tipo de herramientas. Flow parece la primera versión de un editor de vídeo basado en IA, y no es difícil imaginar un futuro en el que este tipo de flujo de trabajo se convierta en estándar. Al igual que ahora damos por sentadas herramientas como Premiere Pro o DaVinci Resolve, algo como Flow podría convertirse en la norma dentro de unos años.

Flujo actualmente sólo está disponible en EE.UU., y puedes acceder a él a través de las suscripciones AI Pro y AI Ultra de Google.

Imagen 4

Otro anuncio importante fue Imagen 4, el nuevo modelo de generación de imágenes de Google. Puedes utilizarlo directamente en Géminis o dentro de Whiskla herramienta de diseño de Google.

Google afirma que se han introducido mejoras en todos los ámbitos: mejor fotorrealismo, detalles más limpios en los primeros planos y más variedad de estilos artísticos. Todo eso está muy bien, pero la parte que me llamó la atención fue la promesa de ortografía y tipografía avanzadas. Si has utilizado algún generador de imágenes recientemente, probablemente habrás visto que la mayoría de ellos siguen desordenando las palabras o deformando las letras por completo.

Veamos una imagen generada por Imagen 4:

Fuente: Google

En este momento, yo diría la generación de imágenes de GPT-4o es la más potente del mercado. Sin embargo, a veces sigue teniendo problemas con el texto y el cumplimiento de los plazos. Si Imagen 4 acierta realmente con la ortografía y mantiene la intención de prontitud, creo que tiene posibilidades de ponerse a la cabeza de la generación de imágenes.

Gemma 3n

Gemma 3n es el último y más capaz modelo de Google en el dispositivo. Si no estás familiarizado con el término, un modelo en el dispositivo es aquel que se ejecuta directamente en tu teléfono, tableta u ordenador portátil, sin necesidad de enviar datos a la nube. Esto es importante por varias razones: menor latencia, mayor privacidad y disponibilidad sin conexión.

Pero para que eso funcione, el modelo tiene que ser lo suficientemente pequeño como para caber en una memoria limitada, pero lo suficientemente potente como para manejar tareas reales. Ése es el reto que Gemma 3n intenta superar.

Está construido sobre una nueva arquitectura compartida con Gemini Nano y, de hecho, la "n" de "3n" significa "nano". Esta arquitectura está optimizada para un bajo uso de memoria, tiempos de respuesta rápidos y soporte para múltiples tipos de entrada como texto, audio e imágenes.

Gemma 3n se presenta en dos variantes, con tamaños de parámetro de 5B y 8B. Ambos están diseñados para funcionar de forma eficiente, con requisitos de memoria más cercanos a los modelos 2B y 4B gracias a unas cuantas optimizaciones bajo el capó.

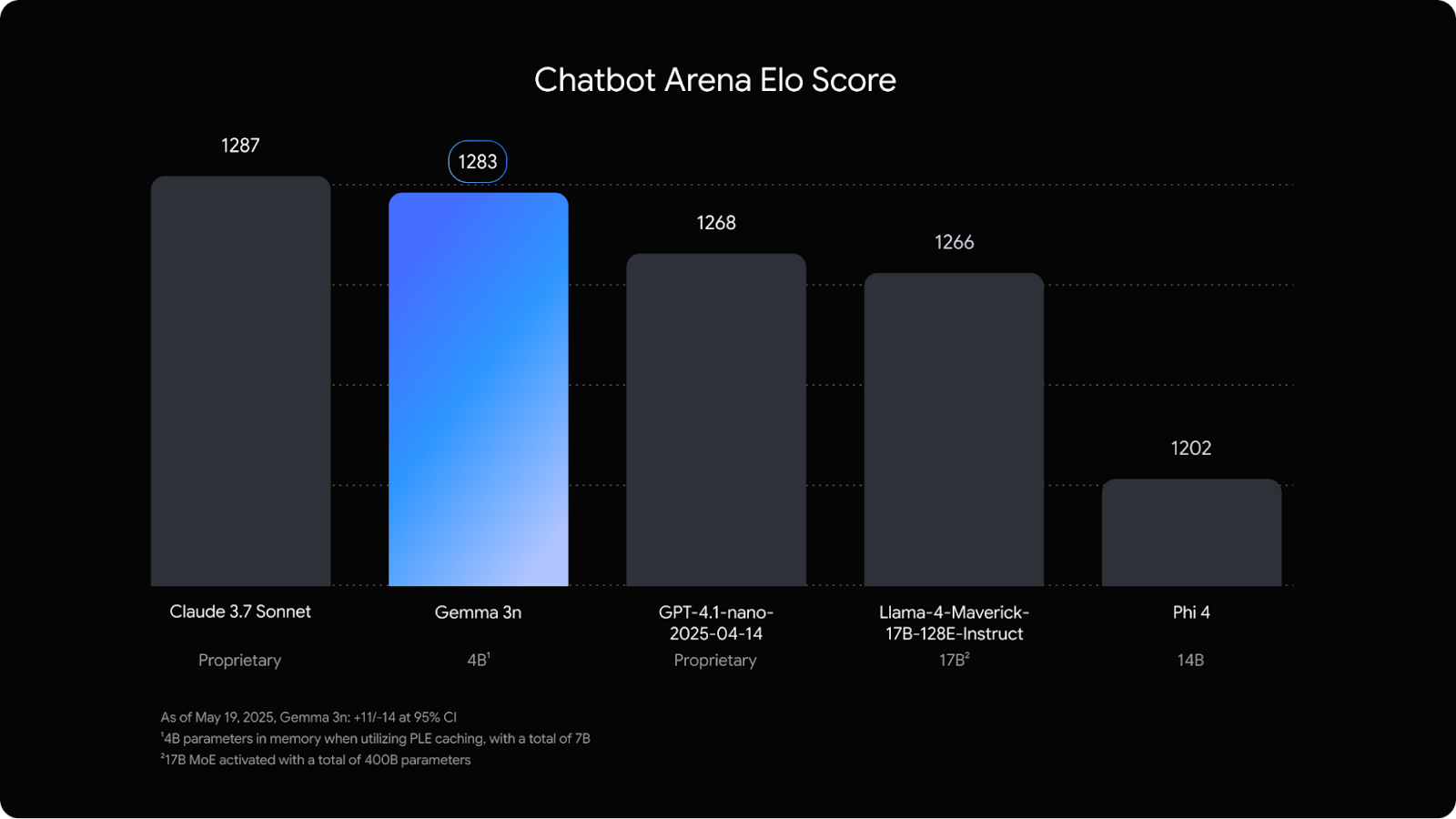

Lo que me ha parecido realmente sorprendente es que está casi a la par en el Chatbot Arena con Claude 3.7 Sonnetun modelo mucho más grande.

Fuente: Google

Esta versión está dirigida principalmente a los programadores, especialmente a los que crean aplicaciones móviles o integradas que pueden beneficiarse de la IA local. Mientras nuestro equipo de DataCamp trabaja en nuevos tutoriales de Gemma 3n, te recomiendo que empieces por estos blogs de Gemma 3:

Géminis Difusión

La tecnología por la que siento más curiosidad es la Difusión Gemini.

Gemini Difusión es una nueva arquitectura de modelos experimentales diseñada para mejorar la velocidad y la coherencia en la generación de textos. A diferencia de los modelos lingüísticos tradicionales, que generan tokens uno a uno en una secuencia fija, los modelos de difusión funcionan refinando el ruido a través de múltiples pasos, un método tomado de la generación de imágenes.

En lugar de predecir directamente la siguiente palabra, Gemini Diffusion comienza con una aproximación aproximada y la mejora iterativamente, lo que la hace mejor en tareas que se benefician del refinamiento y la corrección de errores, como las matemáticas, el código y la edición.

En las primeras pruebas comparativas, se ha informado de que genera tokens hasta cinco veces más rápido que los modelos autorregresivos estándar como Gemini 2.0 Flash-Lite, al tiempo que ofrece un rendimiento similar o mejor en tareas de razonamiento estructurado.

Ahora mismo, el acceso está limitado a probadores seleccionados. No se ha anunciado ninguna fecha de lanzamiento público. Apúntate a la lista de espera en esta página.

Proyecto Mariner

El Proyecto Mariner es la apuesta de Google por un agente de IA que pueda operar directamente en el navegador. Está diseñado para ayudar en tareas complejas de varios pasos, como planificar viajes, investigar productos o resumir contenido denso en varias pestañas.

En ese sentido, es similar a Manus AI o Operador de OpenAIde OpenAI, que ya está disponible a través de ChatGPT. Veamos un ejemplo de Mariner en acción:

De momento, Mariner no está disponible públicamente, pero Google dice que pronto habrá un acceso más amplio. Pronto se espera el acceso de los programadores a través de la API Gemini.

Mira más ejemplos aquí:

Proyecto Astra

El Proyecto Astra es el prototipo de Google DeepMind para un asistente de IA de propósito más general, algo que no se limite a responder a indicaciones, sino que vea, escuche, recuerde y reaccione. Se presentó por primera vez el año pasado como proyecto de investigación, y en I/O 2025 pudimos ver mejor lo que puede hacer.

Veámoslo en acción:

Todavía no está disponible para el público, pero algunas partes de Astra ya se están introduciendo en Gemini Live, y se espera que más adelante se produzca un despliegue más amplio. Está por ver si se convierte en un producto real o se queda en la fase de investigación, pero la dirección está clara: esto es lo que Google considera la base de un asistente universal de IA.

Modo IA en la Búsqueda

El Modo IA es la nueva experiencia de búsqueda de Google, que se parece más a un chatbot que a un motor de búsqueda. Es diferente de los Resúmenes de IA, que son breves resúmenes de IA colocados en la parte superior de la página tradicional de resultados de Google que todos conocemos. El Modo IA, en cambio, se hace cargo de toda la interfaz: es una nueva pestaña en la que puedes hacer preguntas complejas y hacer un seguimiento conversacional.

Veamos un ejemplo:

La interfaz se parece mucho a ChatGPT o Perplexity. Introduces una pregunta y el Modo IA responde con respuestas más largas y estructuradas, que incluyen enlaces, citas, gráficos y, a veces, incluso un desglose completo de la investigación. Utiliza un enfoque de "consulta en abanico" para dividir tu pregunta en subtemas y extraerlos de toda la web, todo de una sola vez.

Una característica notable es la integración de las capacidades agenticas del Proyecto Mariner. Esto puede ahorrarte tiempo en tareas como comprar entradas para eventos, hacer reservas o buscar disponibilidad en varios sitios web.

Está claro que la búsqueda está experimentando un cambio fundamental. Estamos pasando de un modelo basado en listas de enlaces a otro centrado en respuestas directas, resúmenes y realización de tareas. Esto tiene importantes implicaciones para la forma en que la información sale a la superficie y se consume. Los sectores del SEO y del marketing de contenidos ya están viendo el impacto.

El Modo IA ya se está desplegando en EE.UU., y en las próximas semanas llegarán más funciones a Labs. Puedes activar el experimento en Google Labs si quieres probarlo antes.

Conclusión

Esto resume los anuncios más importantes sobre IA del primer día de la I/O 2025. Como siempre, se muestra mucha ambición, pero la verdadera prueba es cómo funcionan estas herramientas en manos de los usuarios y programadores cotidianos.

Parte de esta tecnología es aún incipiente o está oculta tras costosas suscripciones, pero algunas funciones ya están llegando a todos los usuarios.

Soy editora y redactora de blogs, tutoriales y noticias sobre IA, y me aseguro de que todo se ajuste a una sólida estrategia de contenidos y a las mejores prácticas de SEO. He escrito cursos de ciencia de datos sobre Python, estadística, probabilidad y visualización de datos. También he publicado una novela premiada y dedico mi tiempo libre a escribir guiones y dirigir películas.