Lernpfad

Tag 1 der Google I/O 2025 ist vorbei. In diesem Artikel stelle ich dir die wichtigsten Ankündigungen für die KI-Branche vor.

Ich werde mich auf die Updates konzentrieren, die entweder schon fertig sind oder bald veröffentlicht werden sollen. Auf dem Weg dorthin werde ich kurze Eindrücke schildern und, wenn nötig, einen Vergleich mit der Konkurrenz anstellen.

Wir halten unsere Leserinnen und Leser mit The Median auf dem Laufenden, unserem kostenlosen Freitags-Newsletter, der die wichtigsten Meldungen der Woche aufschlüsselt. Melde dich an und bleibe in nur ein paar Minuten pro Woche auf dem Laufenden:

Veo 3

Was mich an Veo 3 besonders beeindruckt hat, ist, dass er eine native Audioausgabe bietet. Du kannst jetzt direkt Videos mit Ton erstellen, ohne dass zusätzliche Bearbeitungsschritte erforderlich sind. Sehen wir uns ein Beispiel an:

Native Audioausgabe ist etwas, das ich noch nicht gesehen habe in Startbahn oder Sora. Zu diesem Zeitpunkt würde ich sagen, dass Veo 3 einen Schritt voraus ist.

Die Demo sieht zwar gut aus, aber ich habe gelernt, dass Demo-Videos selten widerspiegeln, wie sich diese Modelle in der Praxis verhalten. Sobald die Eingabeaufforderung von den Trainingsdaten abweicht - eine ungewohnte Szene, ein seltsamer Charakter oder eine Idee mit zu viel Subtilität - bricht das Modell zusammen. Ich freue mich schon darauf, Veo 3 auszuprobieren, um zu sehen, wie gut es funktioniert.

Der Zugang zu Veo 3 erfordert ein AI Ultra-Abonnement, das $250/Monat kostet. Selbst wenn du bereit bist zu zahlen, ist die Verfügbarkeit begrenzt. Im Moment ist sie nur in den USA verfügbar und nur in Googles neuem KI-gestützten Videoeditor namens Flow (über den wir als Nächstes berichten werden).

Wenn du neugierig auf die technischen Details bist oder mehr Beispiele sehen willst, schau dir die offizielle Seite von Veo an hier.

Flow

Flow ist ein KI-Filmemacher-Tool, mit dem du einzelne Aufnahmen mit einer Kombination aus Veo, Imagen und Gemini erstellen kannst.

Eine Sache, die ich sehr nützlich finde, ist, dass du einzelne Elemente (sogenannte "Zutaten") erstellen und sie dann in einer einzigen Szene zusammenfassen kannst. Das gibt dir eine modulare Kontrolle und kann besonders hilfreich sein, wenn du dieselben Elemente in mehreren Prompts oder Aufnahmen wiederverwenden willst.

Sehen wir uns ein Beispiel an:

Außerdem gibt es in Flow Werkzeuge für die Kamerasteuerung und Übergänge, die den Clips einen filmischen Charakter verleihen. Diese sind nützlich, aber nicht neu - Sora und Runway bieten bereits ähnliche Funktionen, also würde ich nicht sagen, dass es hier etwas Bahnbrechendes gibt.

Trotzdem lohnt es sich, darauf zu achten, wie sich solche Tools weiterentwickeln. Flow fühlt sich an wie die frühe Version eines KI-gestützten Videoeditors und es ist nicht schwer, sich eine Zukunft vorzustellen, in der diese Art von Workflow zum Standard wird. So wie wir heute Werkzeuge wie Premiere Pro oder DaVinci Resolve als selbstverständlich ansehen, könnte etwas wie Flow in ein paar Jahren zur Norm werden.

Flow ist derzeit nur in den USA verfügbar und du kannst es über Googles AI Pro- und AI Ultra-Abonnements nutzen.

Imagen 4

Eine weitere wichtige Ankündigung war Imagen 4, Googles neuestes Modell zur Bilderzeugung. Du kannst es direkt in Gemini oder im Whisk, dem Design-Tool von Google, verwenden.

Google spricht von Verbesserungen in allen Bereichen - besserer Fotorealismus, sauberere Details bei Nahaufnahmen, mehr Vielfalt bei den Kunststilen. Das ist alles schön und gut, aber der Teil, der meine Aufmerksamkeit erregte, war das Versprechen einer fortschrittlichen Rechtschreibung und Typografie. Wenn du in letzter Zeit einen Bildgenerator benutzt hast, hast du wahrscheinlich gesehen, dass die meisten von ihnen immer noch Wörter durcheinander bringen oder Buchstaben komplett verzerren.

Schauen wir uns ein Bild an, das Imagen 4 erstellt hat:

Quelle: Google

Momentan würde ich sagen Die Bilderzeugung des GPT-4o ist die stärkste auf dem Markt. Allerdings hat sie manchmal noch Probleme mit dem Einhalten von Texten und Aufforderungen. Wenn Imagen 4 die Rechtschreibung richtig hinbekommt und sich an die Promptheit hält, hat es meiner Meinung nach eine Chance, die Führung bei der Bilderzeugung zu übernehmen.

Gemma 3n

Gemma 3n ist Googles neuestes und leistungsstärkstes On-Device-Modell. Falls du mit dem Begriff nicht vertraut bist: Ein On-Device-Modell läuft direkt auf deinem Telefon, Tablet oder Laptop - ohne dass Daten in die Cloud gesendet werden müssen. Das ist aus mehreren Gründen wichtig: geringere Latenzzeiten, besserer Datenschutz und Offline-Verfügbarkeit.

Aber damit das funktioniert, muss das Modell klein genug sein, um in den begrenzten Speicher zu passen, und trotzdem leistungsfähig genug, um echte Aufgaben zu bewältigen. Das ist die Herausforderung, die Gemma 3n zu meistern versucht.

Er basiert auf einer neuen Architektur, die er mit Gemini Nano teilt - und tatsächlich steht das "n" in "3n" für "nano". Diese Architektur ist für geringen Speicherbedarf, schnelle Reaktionszeiten und die Unterstützung verschiedener Eingabearten wie Text, Audio und Bilder optimiert.

Gemma 3n gibt es in zwei Varianten, mit den Parametergrößen 5B und 8B. Beide sind so konzipiert, dass sie dank einiger Optimierungen unter der Haube effizient laufen, wobei der Speicherbedarf eher bei 2B- und 4B-Modellen liegt.

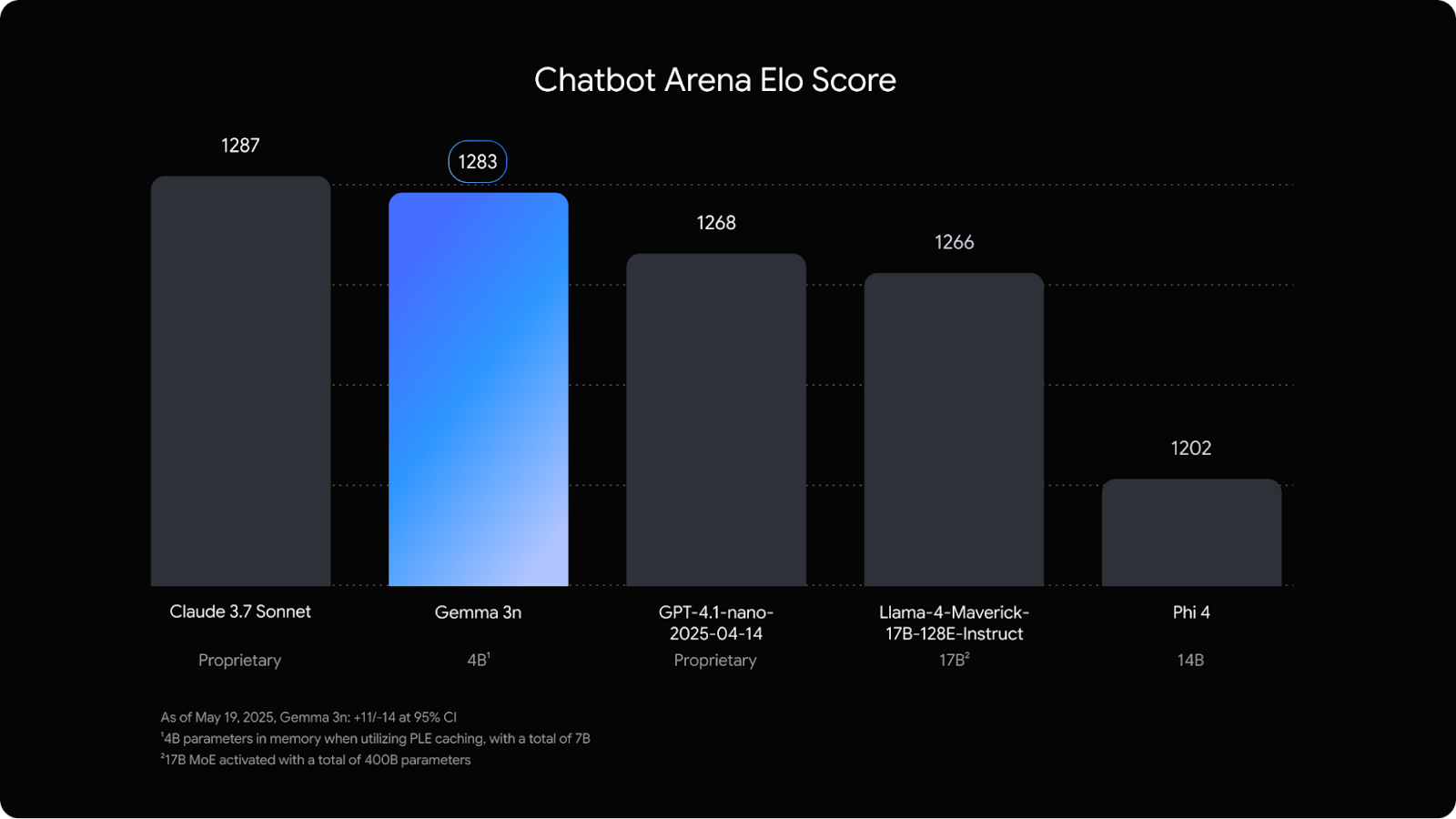

Was mir aufgefallen ist, ist, dass er in der Chatbot-Arena fast gleichauf ist mit Claude 3.7 Sonneteinem viel größeren Modell.

Quelle: Google

Diese Version richtet sich vor allem an Entwickler, die mobile oder eingebettete Anwendungen entwickeln, die von lokaler KI profitieren können. Während unser Team bei DataCamp an neuen Gemma 3n-Tutorials arbeitet, empfehle ich, mit diesen Gemma 3-Blogs zu beginnen:

- Wie man Gemma 3 lokal mit Ollama einrichtet und betreibt

- Feinabstimmung Gemma 3: Eine Schritt-für-Schritt-Anleitung

Zwillings-Difussion

Die Technologie, auf die ich am meisten gespannt bin, ist Gemini Difussion.

Gemini Diffusion ist eine neue experimentelle Modellarchitektur, die entwickelt wurde, um die Geschwindigkeit und Kohärenz bei der Texterstellung zu verbessern. Im Gegensatz zu traditionellen Sprachmodellen, die Token einzeln in einer festen Reihenfolge generieren, arbeiten Diffusionsmodelle mit der Verfeinerung von Rauschen in mehreren Schritten - eine Methode, die aus der Bilderzeugung stammt.

Anstatt das nächste Wort direkt vorherzusagen, beginnt Gemini Diffusion mit einer groben Annäherung und verbessert diese iterativ. Das macht es besser für Aufgaben, die von Verfeinerung und Fehlerkorrektur profitieren, wie Mathematik, Code und Bearbeitung.

In ersten Benchmarks wurde berichtet, dass es Tokens bis zu fünfmal schneller generiert als autoregressive Standardmodelle wie Gemini 2.0 Flash-Lite und dabei eine ähnliche oder bessere Leistung bei strukturierten Argumentationsaufgaben erzielt.

Im Moment ist der Zugang auf ausgewählte Tester/innen beschränkt. Es wurde noch kein Veröffentlichungsdatum bekannt gegeben. Trage dich auf der Warteliste auf dieser Seite.

Projekt Mariner

Project Mariner ist Googles Ansatz für einen KI-Agenten, der direkt im Browser arbeiten kann. Es wurde entwickelt, um bei komplexen, mehrstufigen Aufgaben zu helfen - zum Beispiel bei der Reiseplanung, bei der Produktrecherche oder beim Zusammenfassen von dichten Inhalten auf mehreren Registerkarten.

In diesem Sinne ist es ähnlich wie die Manus KI oder OpenAIs Operatordas bereits über ChatGPT verfügbar ist. Lass uns ein Beispiel für Mariner in Aktion sehen:

Im Moment ist Mariner noch nicht öffentlich zugänglich, aber Google sagt, dass ein breiterer Zugang kommen wird. Der Zugang für Entwickler wird bald über die Gemini-API erwartet.

Weitere Beispiele findest du hier:

Projekt Astra

Projekt Astra ist der Prototyp von Google DeepMind für einen universellen KI-Assistenten, der nicht nur auf Aufforderungen reagiert, sondern auch sieht, zuhört, sich erinnert und reagiert. Es wurde letztes Jahr erstmals als Forschungsprojekt vorgestellt, und auf der I/O 2025 konnten wir einen genaueren Blick darauf werfen, was es leisten kann.

Lass es uns in Aktion sehen:

Das ist noch nicht für die Öffentlichkeit zugänglich, aber Teile von Astra finden bereits ihren Weg in Gemini Live, und eine breitere Einführung wird später erwartet. Ob es ein echtes Produkt wird oder in der Forschungsphase bleibt, bleibt abzuwarten, aber die Richtung ist klar: Das ist es, was Google als Grundlage für einen universellen KI-Assistenten sieht.

KI-Modus in der Suche

Der KI-Modus ist das neue Sucherlebnis von Google, das sich mehr wie ein Chatbot als eine Suchmaschine anfühlt. Es unterscheidet sich von den KI-Überblicken, die kurze KI-Zusammenfassungen sind, die oben auf der traditionellen Google-Ergebnisseite erscheinen, die wir alle kennen. Der KI-Modus hingegen übernimmt die gesamte Benutzeroberfläche - es ist eine neue Registerkarte, auf der du komplexe Fragen stellen und im Gespräch nachhaken kannst.

Sehen wir uns ein Beispiel an:

Die Oberfläche sieht ChatGPT oder Perplexity sehr ähnlich. Du gibst eine Frage ein, und der KI-Modus antwortet mit längeren, strukturierten Antworten, die Links, Zitate, Diagramme und manchmal sogar eine vollständige Aufschlüsselung der Recherche enthalten. Es verwendet einen "Query Fan-Out"-Ansatz, um deine Frage in Unterthemen aufzuteilen und in einem Durchgang aus dem gesamten Web zu ziehen.

Ein bemerkenswertes Merkmal ist die Integration der agenturischen Fähigkeiten von Project Mariner. So kannst du bei Aufgaben wie dem Kauf von Veranstaltungstickets, der Reservierung oder der Suche nach Verfügbarkeiten auf verschiedenen Websites Zeit sparen.

Es ist klar, dass die Suche einen grundlegenden Wandel durchmacht. Wir bewegen uns von einem Modell, das auf Linklisten basiert, zu einem Modell, das sich auf direkte Antworten, Zusammenfassungen und die Erledigung von Aufgaben konzentriert. Das hat große Auswirkungen darauf, wie Informationen auftauchen und konsumiert werden. Die SEO- und Content-Marketing-Branche sehen bereits die Auswirkungen.

Der KI-Modus wird jetzt in den USA eingeführt, weitere Funktionen werden in den nächsten Wochen in den Labs verfügbar sein. Du kannst das Experiment in Google Labs aktivieren, wenn du es frühzeitig ausprobieren möchtest.

Fazit

Damit sind die wichtigsten KI-Ankündigungen von Tag 1 der I/O 2025 zusammengefasst. Wie immer wird viel Ehrgeiz an den Tag gelegt - aber der wirkliche Test ist, wie sich diese Tools in den Händen von alltäglichen Nutzern und Entwicklern schlagen.

Einige dieser Technologien befinden sich noch im Anfangsstadium oder sind durch teure Abonnements geschützt, aber ein paar Funktionen werden bereits für alle Nutzer/innen eingeführt.

Ich bin Redakteurin und Autorin für KI-Blogs, Tutorials und Nachrichten und sorge dafür, dass alles zu einer starken Content-Strategie und SEO-Best Practices passt. Ich habe Data-Science-Kurse über Python, Statistik, Wahrscheinlichkeit und Datenvisualisierung geschrieben. Außerdem habe ich einen preisgekrönten Roman veröffentlicht und verbringe meine Freizeit mit Drehbuchschreiben und Filmregie.