Cursus

La première journée de la conférence Google I/O 2025 est terminée. Dans cet article, je vous présenterai les annonces les plus importantes pour le secteur de l'IA.

Je me concentrerai sur les mises à jour qui sont prêtes à être utilisées ou qui devraient être publiées prochainement. En cours de route, je vous ferai part de mes impressions rapides et, le cas échéant, je replacerai les choses dans leur contexte par rapport à la concurrence.

Nous tenons nos lecteurs informés des dernières nouveautés en matière d'IA en leur envoyant The Median, notre lettre d'information gratuite du vendredi qui analyse les principaux sujets de la semaine. Abonnez-vous et restez à la pointe de la technologie en quelques minutes par semaine :

Veo 3

Ce qui m'a frappé dans Veo 3, c'est qu'il offre une sortie audio native. Vous pouvez désormais générer des vidéos qui contiennent du son directement, sans étape d'édition supplémentaire. Prenons un exemple :

La sortie audio native est quelque chose que je n'ai pas encore vu dans Runway ou Sora. À ce stade, je dirais que Veo 3 a une longueur d'avance.

Bien que la démo ait l'air bien, j'ai appris que les vidéos de démonstration reflètent rarement le comportement de ces modèles dans la pratique. Dès que l'invite s'écarte de la forme des données d'apprentissage - une scène inconnue, un personnage bizarre ou une idée trop subtile - le modèle a tendance à s'effondrer. J'ai hâte d'essayer Veo 3 pour voir comment il se comporte.

L'accès à Veo 3 nécessite un abonnement AI Ultra, qui coûte 250 $/mois. Même si vous êtes prêt à payer, la disponibilité est limitée. Pour l'instant, il n'est accessible qu'aux États-Unis, et uniquement dans le nouvel éditeur vidéo de Google basé sur l'intelligence artificielle, appelé Flow (que nous aborderons plus loin).

Si vous êtes curieux des détails techniques ou si vous souhaitez découvrir d'autres exemples, consultez la page officielle de Veo ici.

Débit

Flow est un outil d'IA pour la réalisation de films qui vous permet de générer des plans individuels en utilisant une combinaison de Veo, Imagen et Gemini.

Une chose que je trouve utile, c'est que vous pouvez créer des éléments distincts (appelés "ingrédients") et les regrouper ensuite en une seule scène. Vous disposez ainsi d'un contrôle modulaire qui peut s'avérer particulièrement utile lorsque vous souhaitez réutiliser les mêmes éléments dans plusieurs messages ou prises de vue.

Prenons un exemple :

Flow propose également des outils de contrôle de la caméra et des transitions, qui contribuent à donner aux clips un aspect plus cinématographique. Ces fonctions sont utiles, mais elles ne sont pas nouvelles. Sora et Runway proposent déjà des fonctions similaires, je ne dirais donc pas qu'il y a quelque chose de révolutionnaire ici.

Néanmoins, il vaut la peine d'être attentif à l'évolution de ce type d'outils. Flow ressemble à la première version d'un éditeur vidéo doté d'une intelligence artificielle, et il n'est pas difficile d'imaginer un avenir où ce type de flux de travail deviendra la norme. Tout comme nous considérons aujourd'hui comme acquis des outils tels que Premiere Pro ou DaVinci Resolve, quelque chose comme Flow pourrait devenir la norme dans quelques années.

Flow n'est actuellement disponible qu'aux États-Unis, et vous pouvez y accéder par le biais des abonnements AI Pro et AI Ultra de Google.

Imagen 4

Une autre annonce importante concerne Imagen 4, le nouveau modèle de génération d'images de Google. Vous pouvez l'utiliser directement dans Gemini ou à l'intérieur Whiskl'outil de conception de Google.

Google revendique des améliorations dans tous les domaines : meilleur photoréalisme, détails plus nets sur les gros plans, plus grande variété de styles artistiques. C'est très bien, mais ce qui a attiré mon attention, c'est la promesse d'une orthographe et d'une typographie avancées. Si vous avez utilisé récemment un générateur d'images, vous avez probablement constaté que la plupart d'entre eux brouillent les mots ou déforment complètement les lettres.

Voyons une image générée par Imagen 4 :

Source : Google

Pour l'instant, je dirais que la génération d'images de GPT-4o est la plus puissante du marché. Cependant, il a parfois du mal à respecter les textes et les consignes. Si Imagen 4 parvient à corriger l'orthographe et à conserver l'intention de l'utilisateur, je pense qu'il a une chance de s'imposer dans le domaine de la génération d'images.

Gemma 3n

Gemma 3n est le modèle le plus récent et le plus performant de Google. Si vous n'êtes pas familier avec ce terme, un modèle "on-device" est un modèle qui fonctionne directement sur votre téléphone, tablette ou ordinateur portable - sans avoir besoin d'envoyer des données dans le cloud. Cela est important pour plusieurs raisons : une latence plus faible, une meilleure protection de la vie privée et une disponibilité hors ligne.

Mais pour que cela fonctionne, le modèle doit être suffisamment petit pour tenir dans une mémoire limitée, tout en étant assez puissant pour gérer des tâches réelles. C'est le défi que Gemma 3n tente de relever.

Il est construit sur une nouvelle architecture partagée avec Gemini Nano- et en fait, le "n" de "3n" signifie "nano". Cette architecture est optimisée pour une faible utilisation de la mémoire, des temps de réponse rapides et la prise en charge de plusieurs types d'entrée comme le texte, l'audio et les images.

Gemma 3n existe en deux variantes, avec des paramètres de taille 5B et 8B. Les deux sont conçus pour fonctionner efficacement, avec des besoins en mémoire plus proches des modèles 2B et 4B grâce à quelques optimisations sous le capot.

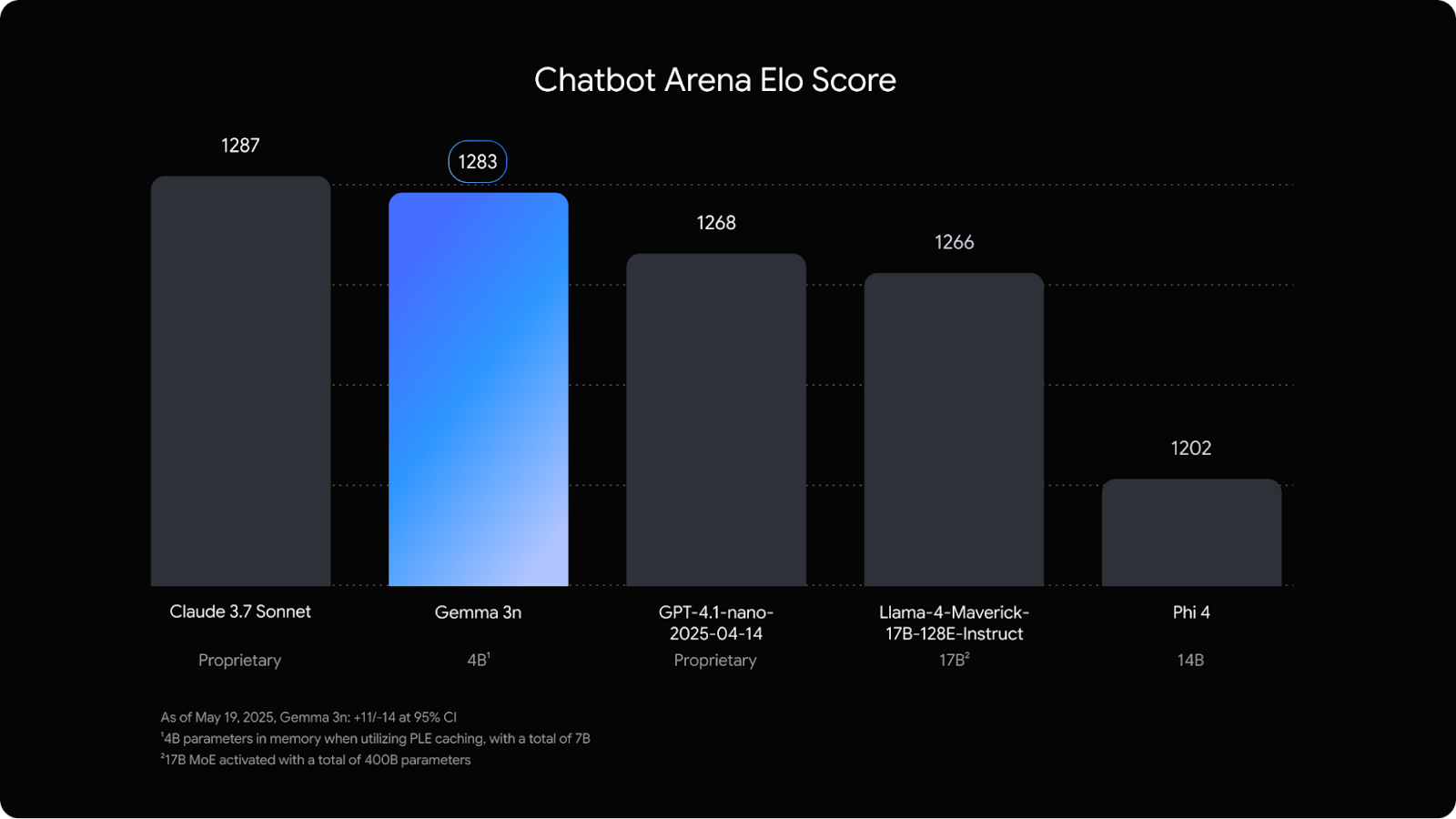

Ce que j'ai trouvé vraiment frappant, c'est qu'il est presque à égalité sur le Chatbot Arena avec Claude 3.7 Sonnetun modèle beaucoup plus grand.

Source : Google

Cette version est principalement destinée aux développeurs, en particulier ceux qui conçoivent des applications mobiles ou embarquées pouvant bénéficier de l'IA locale. Pendant que notre équipe à DataCamp travaille sur de nouveaux tutoriels Gemma 3n, je vous recommande de commencer par ces blogs Gemma 3 :

- Comment configurer et faire fonctionner Gemma 3 localement avec Ollama

- Ajustement de Gemma 3 : Un guide pas à pas

Différences entre les Gémeaux

La technologie qui m'intrigue le plus est celle de Gemini Difussion.

Gemini Diffusion est une nouvelle architecture de modèle expérimental conçue pour améliorer la vitesse et la cohérence de la génération de textes. Contrairement aux modèles linguistiques traditionnels qui génèrent des mots un par un dans une séquence fixe, les modèles de diffusion fonctionnent en affinant le bruit en plusieurs étapes, une méthode empruntée à la génération d'images.

Au lieu de prédire directement le mot suivant, Gemini Diffusion part d'une approximation grossière et l'améliore de manière itérative, ce qui le rend plus performant pour les tâches qui bénéficient d'un raffinement et d'une correction d'erreurs, comme les mathématiques, le code et l'édition.

Selon les premières études comparatives, il génère des jetons jusqu'à cinq fois plus rapidement que les modèles autorégressifs standard tels que Gemini 2.0 Flash-Lite, tout en offrant des performances similaires, voire supérieures, dans les tâches de raisonnement structuré.

Pour l'instant, l'accès est limité à une sélection de testeurs. Aucune date de diffusion publique n'a été annoncée. Inscrivez-vous sur la liste d'attente sur cette page.

Projet Mariner

Le projet Mariner est l'idée que se fait Google d'un agent d'intelligence artificielle capable d'opérer directement dans le navigateur. Il est conçu pour vous aider à effectuer des tâches complexes en plusieurs étapes, telles que la planification d'un voyage, la recherche d'un produit ou la synthèse d'un contenu dense dans plusieurs onglets.

En ce sens, il est similaire à Manus AI ou à OpenAI's Operatorde Manus AI ou d'OpenAI, qui est déjà disponible par l'intermédiaire du ChatGPT. Voyons un exemple de Mariner en action :

Pour l'instant, Mariner n'est pas accessible au public, mais Google affirme qu'un accès plus large est prévu. L'accès des développeurs est prévu prochainement via l'API Gemini.

Vous trouverez d'autres exemples ici :

Projet Astra

Le projet Astra est le prototype de Google DeepMind pour un assistant d'intelligence artificielle plus polyvalent, qui ne se contente pas de répondre à des invites, mais qui voit, écoute, se souvient et réagit. Il a été présenté pour la première fois l'année dernière en tant que projet de recherche, et la conférence I/O 2025 nous a permis de mieux voir ce qu'il peut faire.

Voyons ce qu'il en est :

Le public n'y a pas encore accès, mais certaines parties d'Astra sont déjà intégrées dans Gemini Live, et un déploiement plus large est prévu ultérieurement. Reste à savoir s'il deviendra un produit réel ou s'il restera au stade de la recherche, mais la direction est claire : c'est ce que Google considère comme la base d'un assistant universel d'intelligence artificielle.

Mode IA dans la recherche

AI Mode est la nouvelle expérience de recherche de Google qui ressemble davantage à un chatbot qu'à un moteur de recherche. Elle diffère des aperçus d'IA, qui sont de brefs résumés d'IA placés en haut de la page de résultats traditionnelle de Google que nous connaissons tous. Le mode IA, en revanche, prend en charge l'intégralité de l'interface. Il s'agit d'un nouvel onglet dans lequel vous pouvez poser des questions complexes et assurer un suivi conversationnel.

Prenons un exemple :

L'interface ressemble beaucoup à celle de ChatGPT ou de Perplexity. Vous saisissez une question et AI Mode vous répond par des réponses plus longues et plus structurées, comprenant des liens, des citations, des graphiques et parfois même une analyse complète de la recherche. Il utilise une approche de type "query fan-out" pour diviser votre question en sous-thèmes et tirer des informations de l'ensemble du web, en une seule fois.

L'une des caractéristiques notables est l'intégration des capacités agentiques du projet Mariner. Cela peut vous faire gagner du temps pour des tâches telles que l'achat de billets d'événements, les réservations ou la recherche de disponibilités sur plusieurs sites web.

Il est clair que la recherche est en train de subir un changement fondamental. Nous passons d'un modèle fondé sur des listes de liens à un modèle centré sur les réponses directes, les résumés et l'accomplissement des tâches. Cela a des conséquences importantes sur la manière dont l'information est diffusée et consommée. Les secteurs du référencement et du marketing de contenu déjà l'impact.

Le mode IA est actuellement déployé aux États-Unis, et d'autres fonctionnalités seront disponibles dans les laboratoires au cours des prochaines semaines. Vous pouvez activer l'expérience dans Google Labs si vous souhaitez l'essayer en avant-première.

Conclusion

Voilà qui résume les annonces les plus importantes en matière d'IA de la première journée de la conférence I/O 2025. Comme toujours, l'ambition est au rendez-vous, mais le véritable test est celui de la performance de ces outils dans les mains des utilisateurs et des développeurs de tous les jours.

Certaines de ces technologies sont encore balbutiantes ou protégées par des abonnements onéreux, mais quelques fonctionnalités sont déjà accessibles à tous les utilisateurs.

Je suis rédacteur et écrivain et je couvre les blogs, les tutoriels et les actualités sur l'IA, en m'assurant que tout est conforme à une stratégie de contenu solide et aux meilleures pratiques en matière de référencement. J'ai rédigé des cours de science des données sur Python, les statistiques, les probabilités et la visualisation des données. J'ai également publié un roman primé et je consacre mon temps libre à l'écriture de scénarios et à la réalisation de films.