Curso

Azure Data Factory (ADF) es el servicio de integración de datos basado en la nube de Microsoft diseñado para las organizaciones modernas. Permite a los usuarios diseñar, gestionar y automatizar flujos de trabajo que gestionan tareas de movimiento y transformación de datos a escala empresarial.

ADF destaca por su interfaz fácil de usar y sin código, que permite tanto a usuarios técnicos como no técnicos crear fácilmente canales de datos. Tus amplias capacidades de integración admiten más de 90 conectores nativos, lo que permite el flujo de datos entre diversas fuentes, incluidos sistemas locales y servicios basados en la nube.

En esta guía, ofrezco una introducción completa a Azure Data Factory, en la que se describen sus componentes y características y se proporciona un tutorial práctico para ayudarte a crear tu primera canalización de datos.

¿Qué es Azure Data Factory?

Azure Data Factory (ADF) es un servicio de integración de datos basado en la nube diseñado para coordinar y automatizar flujos de trabajo de datos.

Se utiliza para recopilar, transformar y entregar datos, garantizando que la información sea fácilmente accesible para el análisis y la toma de decisiones.

Gracias a su arquitectura escalable y sin servidor, ADF puede gestionar flujos de trabajo de cualquier tamaño, desde simples migraciones de datos hasta complejos procesos de transformación de datos.

ADF salva la brecha entre los silos de datos, permitiendo a los usuarios mover y transformar datos entre sistemas locales, servicios en la nube y plataformas externas. Tanto si trabajas con macrodatos, bases de datos operativas o API, Azure Data Factory te proporciona las herramientas necesarias para conectar, procesar y unificar datos de forma eficaz.

Características de Azure Data Factory

Estas son algunas de las características más importantes que ofrece ADF.

1. Integración de datos

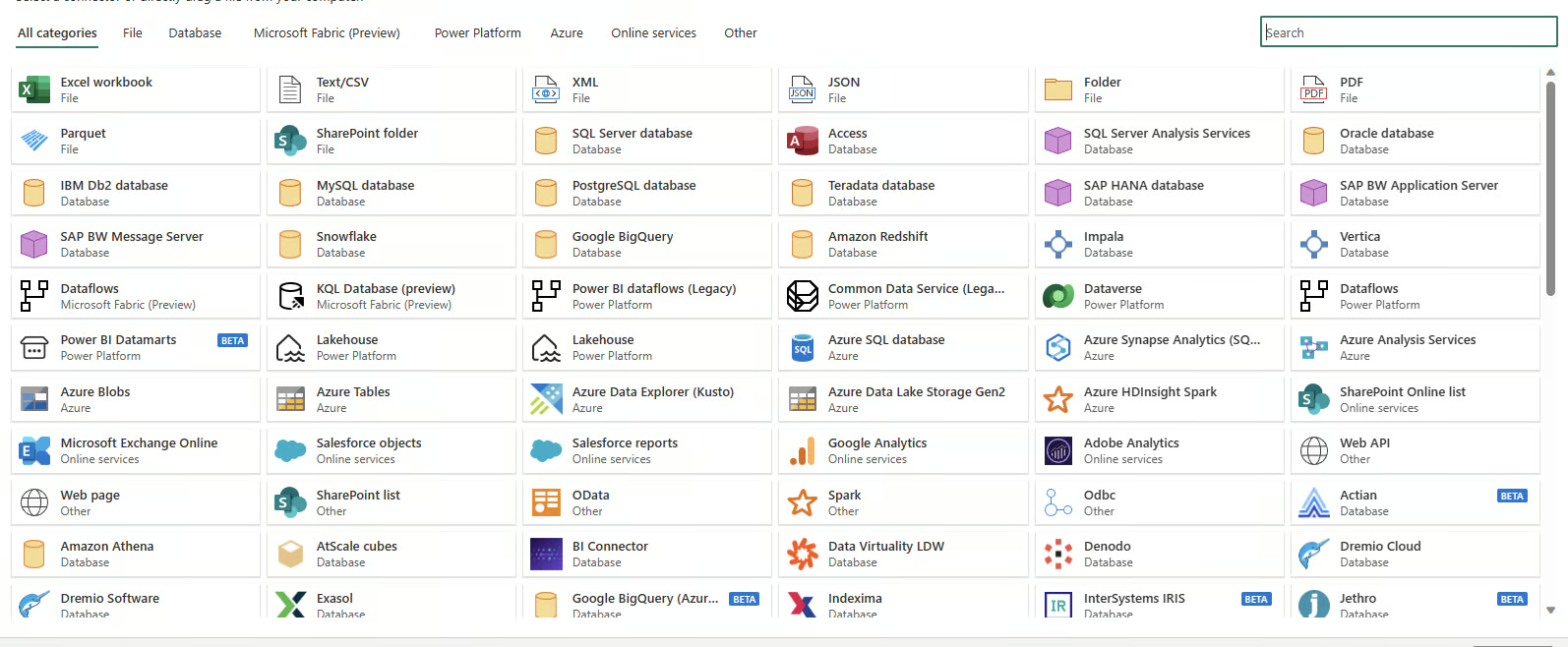

Azure Data Factory admite la integración con más de 100 conectores nativos, incluidos sistemas basados en la nube y locales. Incluye compatibilidad con bases de datos SQL, sistemas nosql, API REST y fuentes de datos basadas en archivos, lo que te permite unificar los flujos de trabajo de datos independientemente de la fuente o el formato. Es el motor fundamental que también impulsa las capacidades de integración de datos en Microsoft Fabric, la plataforma de datos unificada de Microsoft.

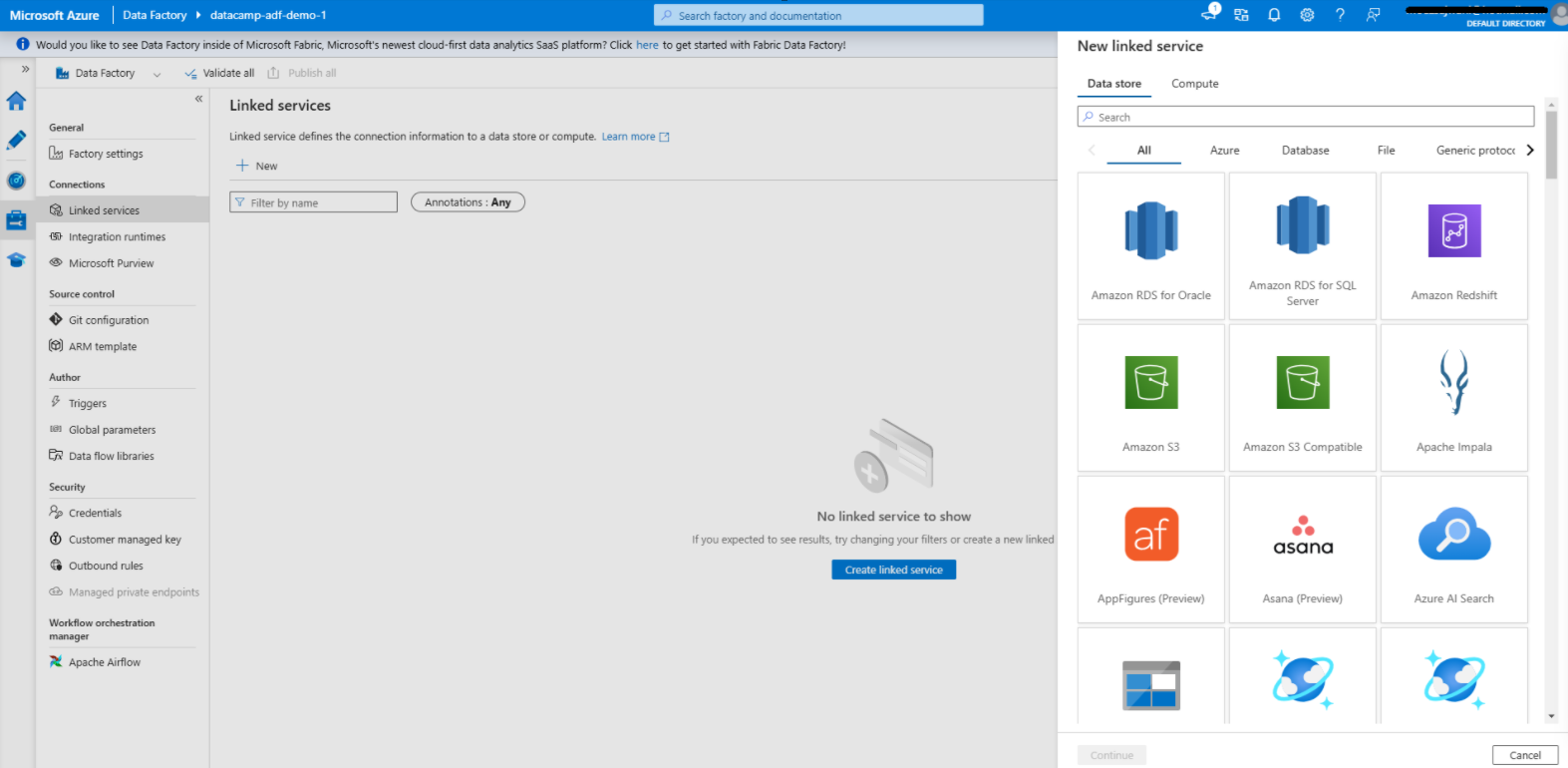

Conectores de datos disponibles en Azure Data Factory

2. Creación de procesos sin código

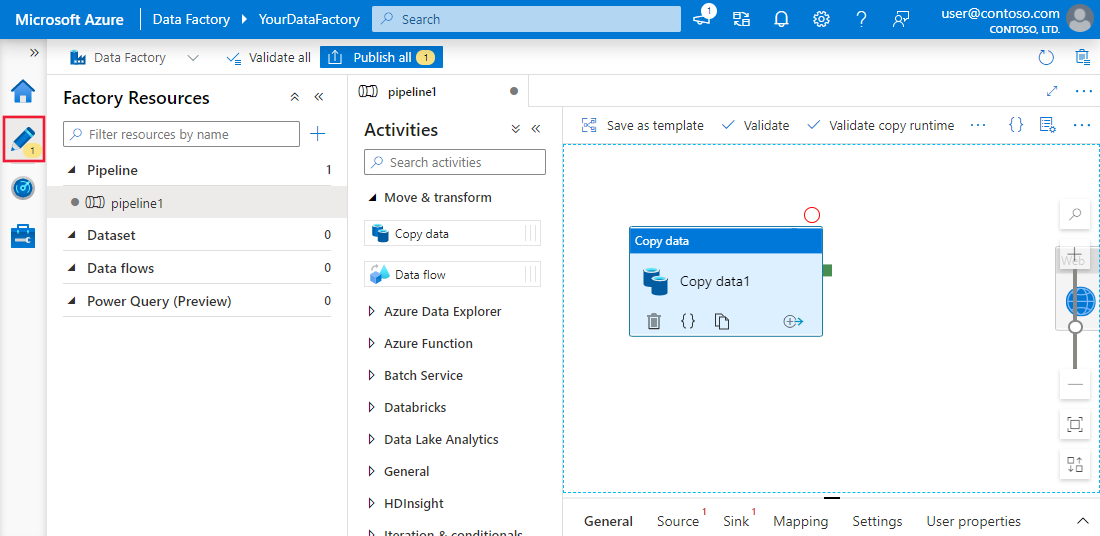

La interfaz de arrastrar y soltar de ADF simplifica la forma en que ustedes crean canalizaciones de datos. Gracias a las plantillas prediseñadas, los asistentes de configuración guiados y un editor visual intuitivo, incluso los usuarios sin conocimientos de programación pueden diseñar flujos de trabajo completos de principio a fin.

Experiencia de creación sin código en Azure Data Factory

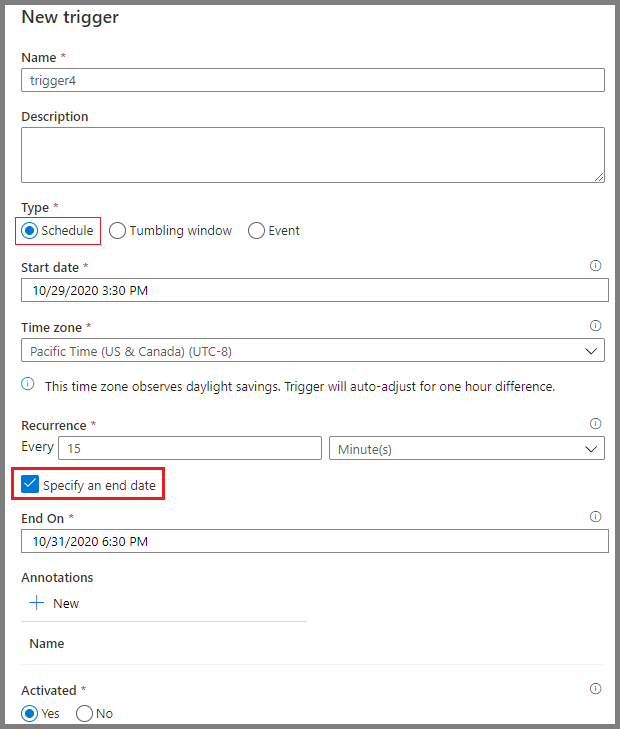

3. Programación

Las herramientas de programación de Azure Data Factory ofrecen automatización de flujos de trabajo. Los usuarios pueden configurar activadores basados en condiciones específicas, como la llegada de un archivo al almacenamiento en la nube o intervalos de tiempo programados. Estas opciones de programación eliminan la necesidad de intervenciones manuales y garantizan que los flujos de trabajo se ejecuten de forma coherente y fiable.

Programación de canalizaciones en Azure Data Factory

Componentes principales de Azure Data Factory

Comprender los componentes básicos de Azure Data Factory es esencial para crear flujos de trabajo eficientes.

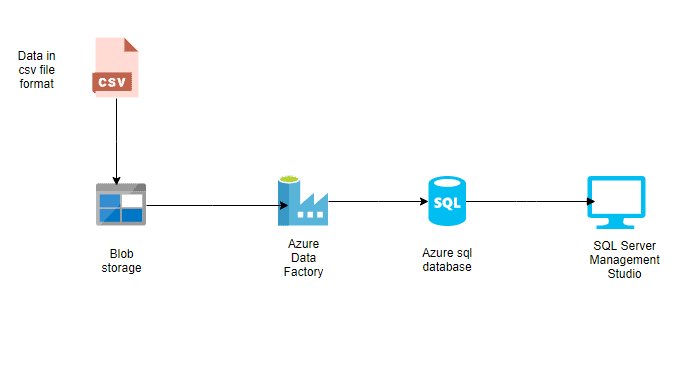

1. Tuberías

Las canalizaciones son la columna vertebral de Azure Data Factory. Representan flujos de trabajo basados en datos que definen los pasos necesarios para mover y transformar datos.

Cada canalización sirve como contenedor de una o varias actividades, ejecutadas de forma secuencial o en paralelo, para lograr el flujo de datos deseado.

Estas canalizaciones permiten a los ingenieros de datos crear procesos integrales, como la ingesta de datos sin procesar, su transformación a un formato utilizable y su carga en los sistemas de destino.

Ejemplo de canalización simple en Azure Data Factory

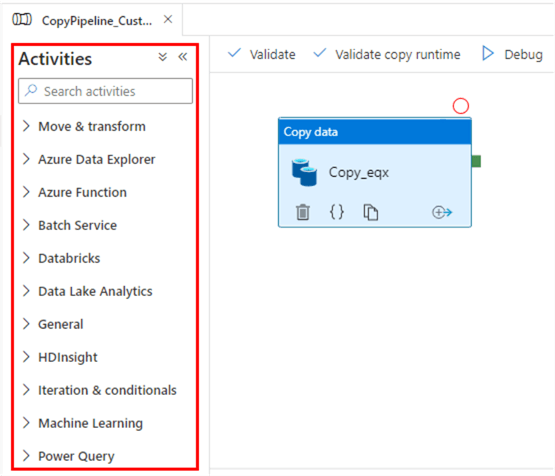

2. Actividades

Las actividades son los componentes funcionales básicos de los procesos, y cada una de ellas realiza una operación específica. Se clasifican, en términos generales, en:

- Actividades de movimiento de datos: Estas actividades facilitan la transferencia de datos entre diferentes sistemas de almacenamiento. Por ejemplo, la actividad «Copiar datos» mueve datos desde Azure Blob Storage a una base de datos SQL de Azure.

- Actividades de transformación de datos: Estas actividades te permiten manipular o procesar datos. Por ejemplo, los flujos de datos o los scripts personalizados pueden utilizarse para transformar formatos de datos, agregar valores o limpiar conjuntos de datos.

- Actividades de control de flujo: Estos gestionan el flujo lógico de ejecución dentro de las canalizaciones. Algunos ejemplos son las ramificaciones condicionales, los bucles y la ejecución paralela, que proporcionan flexibilidad a la hora de gestionar flujos de trabajo complejos.

Actividades en Azure Data Factory

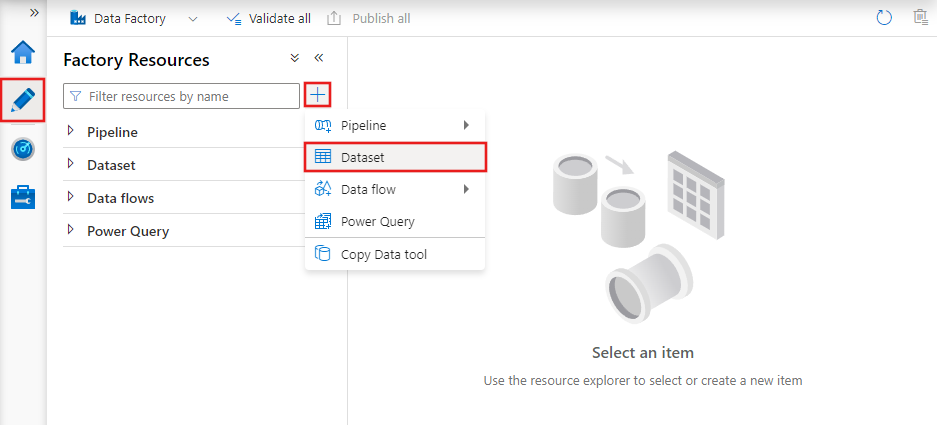

3. Conjuntos de datos

Los conjuntos de datos son representaciones de los datos utilizados en las actividades. Definen el esquema, el formato y la ubicación de los datos que se ingieren o procesan.

Por ejemplo, un conjunto de datos puede describir un archivo CSV en Azure Blob Storage o una tabla en una base de datos SQL de Azure. Los conjuntos de datos son la capa intermediaria que conecta las actividades con las fuentes y destinos reales de datos.

Conjuntos de datos en Azure Data Factory

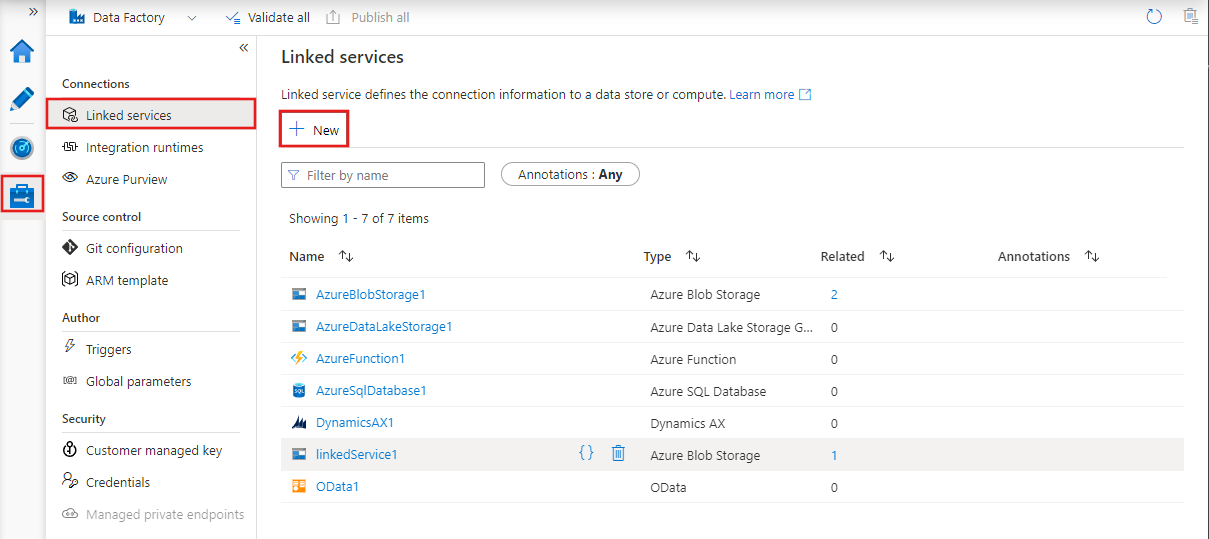

4. Servicios vinculados

Los servicios vinculados son cadenas de conexión que permiten a las actividades y los conjuntos de datos acceder a sistemas y servicios externos.

Actúan como puentes entre Azure Data Factory y los recursos externos con los que interactúa, como bases de datos, cuentas de almacenamiento o entornos informáticos.

Por ejemplo, un servicio vinculado puede conectarse a un servidor SQL local o a un lago de datos basado en la nube.

Servicios vinculados en Azure Data Factory

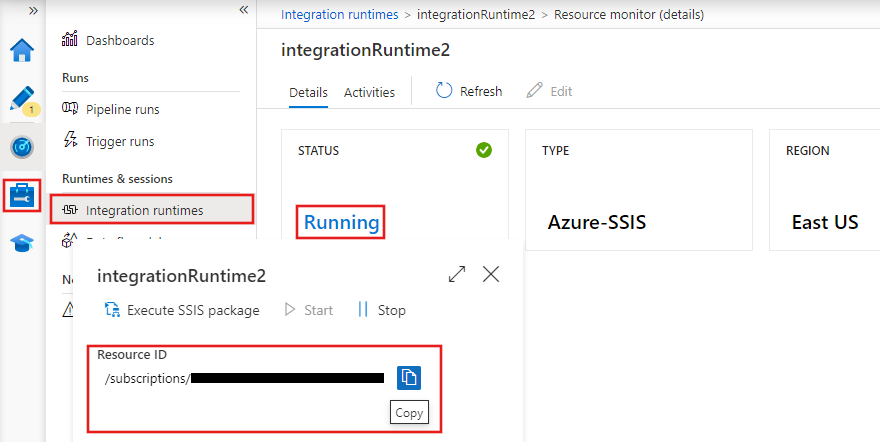

5. Tiempos de ejecución de integración

Los tiempos de ejecución de integración (IR) son los entornos informáticos que impulsan el movimiento de datos, la transformación y la ejecución de actividades dentro de Azure Data Factory. ADF ofrece tres tipos de entornos de ejecución de integración:

- Azure IR: Gestiona tareas de integración de datos basadas en la nube y está gestionado íntegramente por Azure.

- IR autohospedado: Admite la transferencia de datos entre sistemas locales y la nube, lo que lo hace ideal para entornos híbridos.

- SSIS IR: Permite la ejecución de paquetes de SQL Server Integration Services (SSIS) enAzure, lo que te permite reutilizar flujos de trabajo SSIS existentes en la nube.

Tiempos de ejecución de integración en Azure Data Factory

Domina Azure desde cero

Configuración de Azure Data Factory

Ahora, pasemos a la sección práctica de esta guía.

1. Requisitos previos

1. Una suscripción activa ay Azure.

2. Un grupo de recursos para administrarrecursos de Azure.

2. Creación de una instancia de Azure Data Factory

1. Inicia sesión en el portal de Azure.

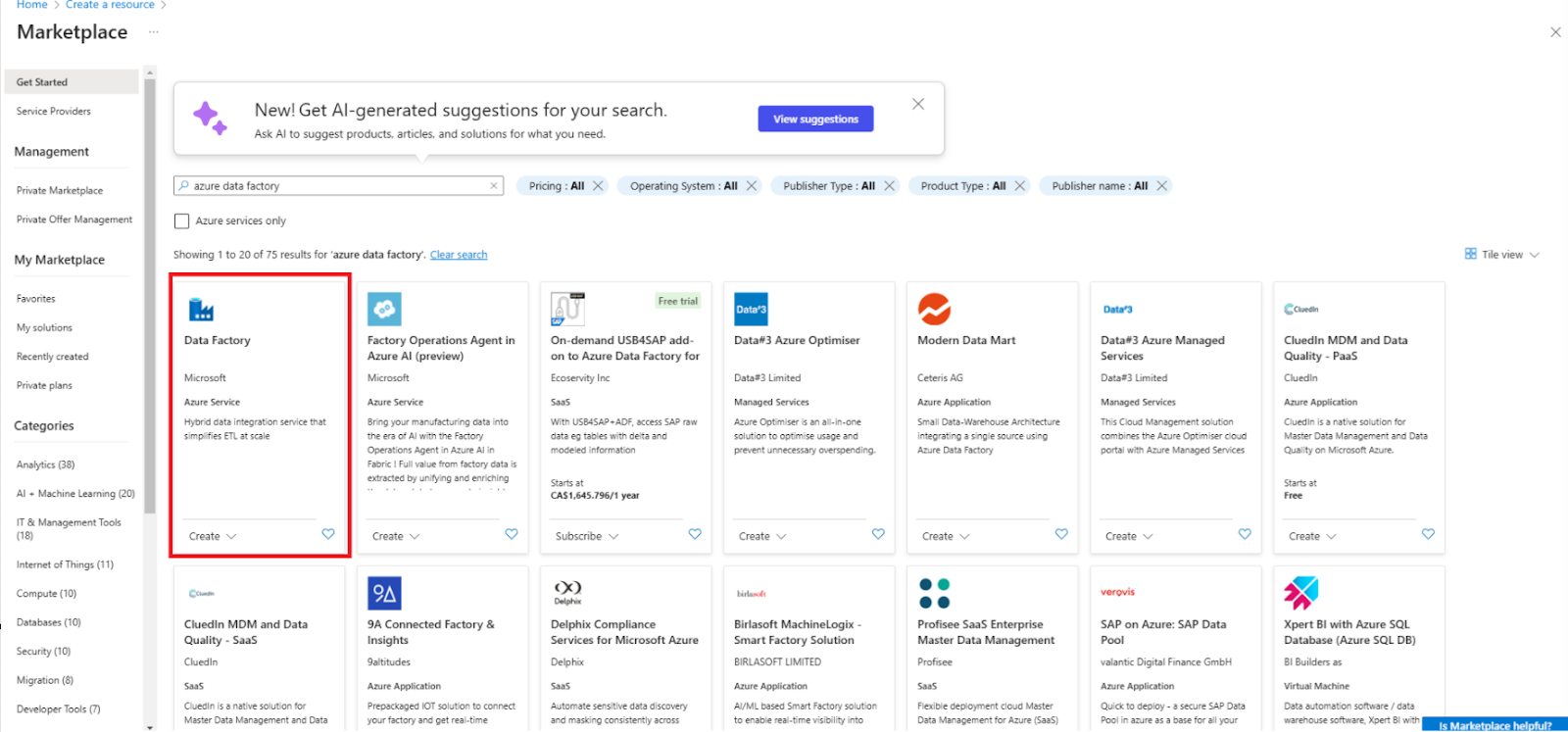

2. Ve a Crea un recurso y selecciona Data Factory.

Crear un nuevo recurso de Data Factory

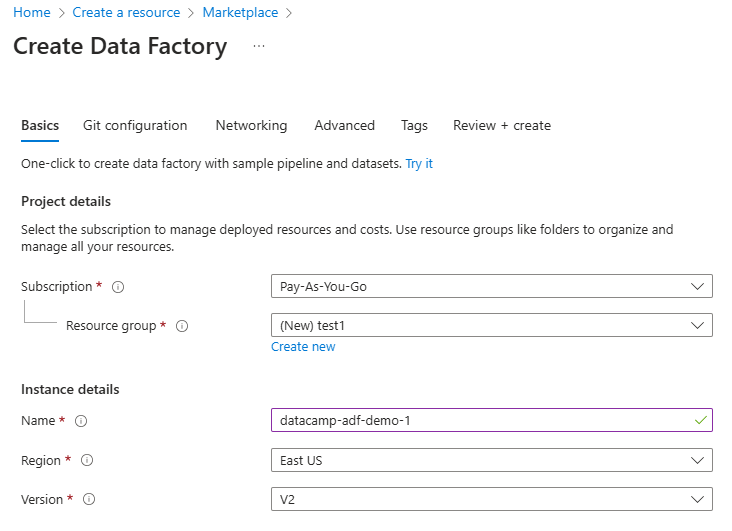

3. Rellena los campos obligatorios, incluyendo la suscripción, el grupo de recursos y la región.

Configurar el recurso Data Factory

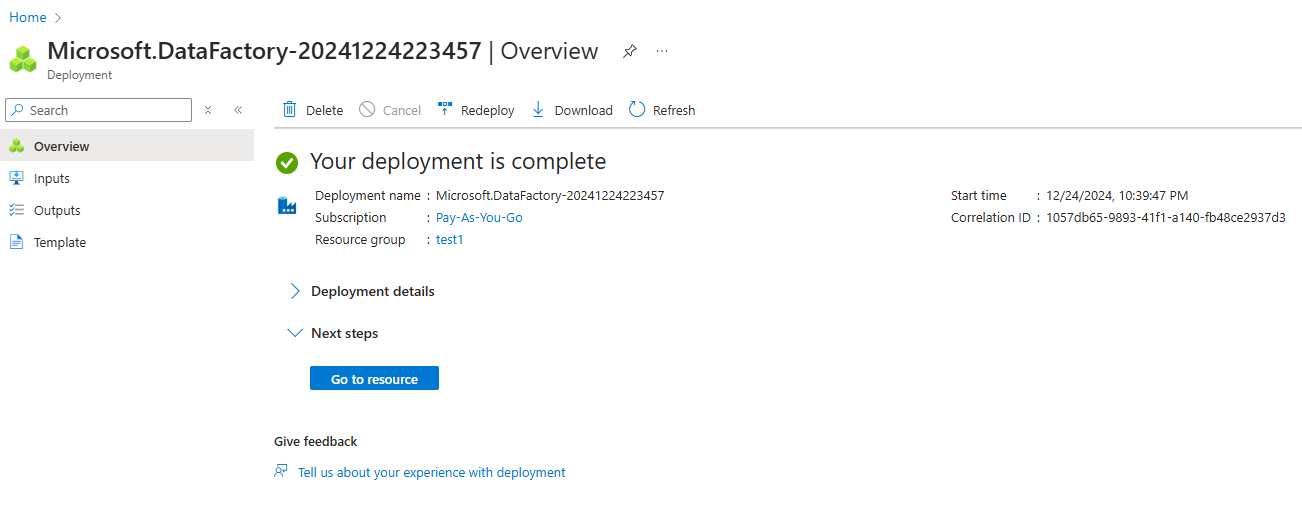

4. Revisa y crea la instancia.

Instancia de Azure Data Factory creada

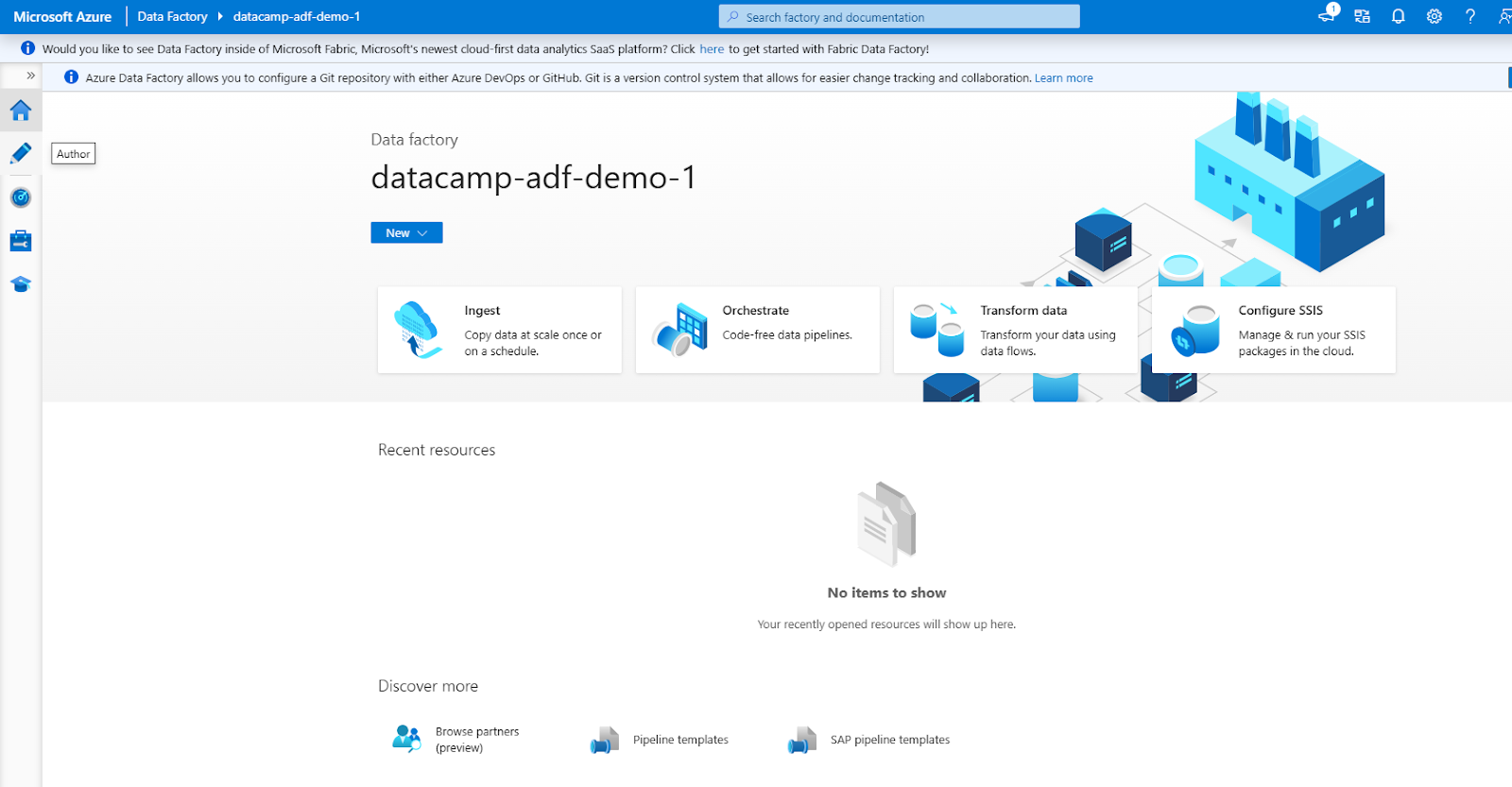

3. Navegación por la interfaz ADF

La interfaz ADF consta de las siguientes secciones principales (accesibles a través del menú de navegación de la izquierda)

1. Autor: Para crear y gestionar canalizaciones.

2. Monitor: Para realizar un seguimiento de las ejecuciones de los procesos y solucionar problemas.

3. Gestionar: Para configurar servicios vinculados y tiempos de ejecución de integración.

Interfaz de Azure Data Factory

Creación de tu primer canal en Azure Data Factory

Veamos los pasos para crear un canal de datos sencillo.

Paso 1: Crear servicios vinculados

Creación de un servicio vinculado en Azure Data Factory

1. Ve a la pestaña Administrar.

- Abre tu instancia de Azure Data Factory y ve a la pestañaAdministrar e s en la interfaz de ADF. Aquí es donde se definen los servicios vinculados, que conectan tus fuentes y destinos de datos.

2. Añadir un servicio vinculado para el origen de datos

- Haz clic en Servicios vinculados en la pestaña Administrar.

- Seleccionar + Nuevo para crear un nuevo servicio vinculado.

- En la lista de opciones disponibles, selecciona el origen de datos al que deseas conectarte, como Azure Blob Storage.

- Proporciona los detalles de conexión necesarios, como el nombre de la cuenta de almacenamiento y el método de autenticación (por ejemplo, clave de cuenta o identidad administrada).

- Comprueba la conexión para asegurarte de que todo está configurado correctamente y haz clic en Crear.

3. Añadir un servicio vinculado para el destino de los datos

- Repite el proceso para el destino de los datos, como Azure SQL Database.

- Selecciona el tipo de destino adecuado, configura los ajustes de conexión (por ejemplo, el nombre del servidor, el nombre de la base de datos y el método de autenticación) y comprueba la conexión.

- Una vez verificado, guarda el servicio vinculado.

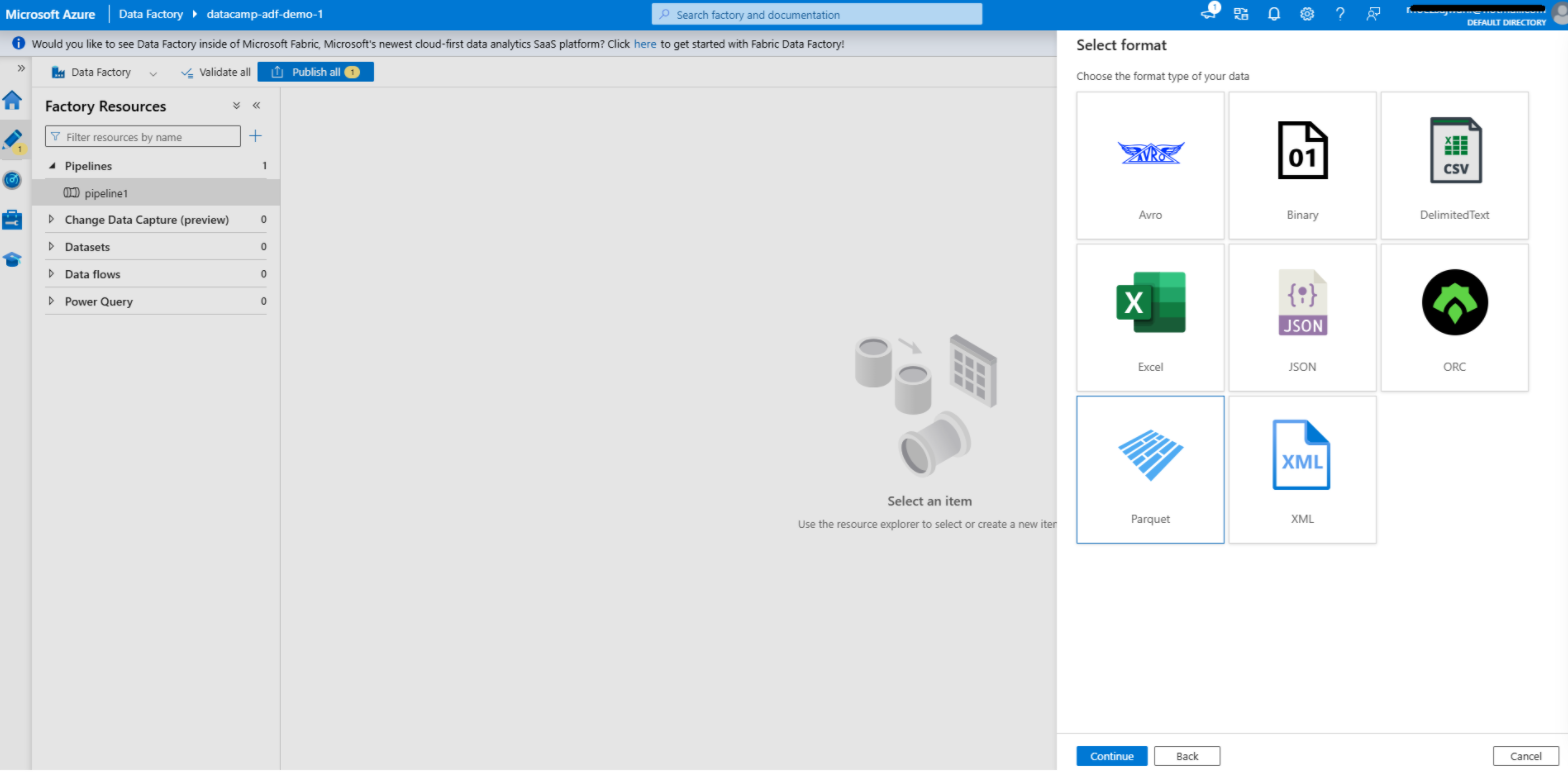

Paso 2: Crear un conjunto de datos

Creación de un conjunto de datos en Azure Data Factory

1. Ve a la pestaña Autor.

- Abre la pestañaAutor en la interfaz de Azure Data Factory. Aquí es donde diseñas y gestionas tus canalizaciones, conjuntos de datos y otros componentes del flujo de trabajo.

2. Añadir un conjunto de datos para la fuente

- Haz clic en el + y selecciona Conjunto de datos en el menú desplegable.

- Elige el tipo de almacén de datos que coincida con tu servicio vinculado de origen. Por ejemplo, si tu fuente esun almacén de objetos blob de Azure , selecciona el tipo de almacén de datos correspondiente, como Texto delimitado, Parquet u otra opción relevante.

- Configura el conjunto de datos:

- Servicio vinculado: Selecciona el servicio vinculado que creaste anteriormente para el origen de datos.

- Ruta del archivo: Especifica la ruta o el contenedor donde se encuentran tus datos de origen.

- Esquema y formato: Define el formato de datos (por ejemplo, CSV, JSON) e importa el esquema si procede. Esto permite a ADF comprender la estructura de tus datos.

- Haz clic en Aceptar para guardar el conjunto de datos.

3. Añadir un conjunto de datos para el destino

- Repite el proceso para el conjunto de datos de destino.

- Elige el tipo de almacén de datos que coincida con tu servicio vinculado de destino. Por ejemplo, si tu destino esuna base de datos SQL de Azure , selecciona el tipo adecuado, como tabla.

- Configura el conjunto de datos:

- Servicio vinculado: Selecciona el servicio vinculado que has creado para el destino.

- Nombre o ruta de la tabla: Especifica la tabla o la ruta de destino donde se escribirán los datos.

- Schema: Opcionalmente, define o importa el esquema del conjunto de datos de destino para garantizar la compatibilidad con los datos de origen.

- Guarda el conjunto de datos.

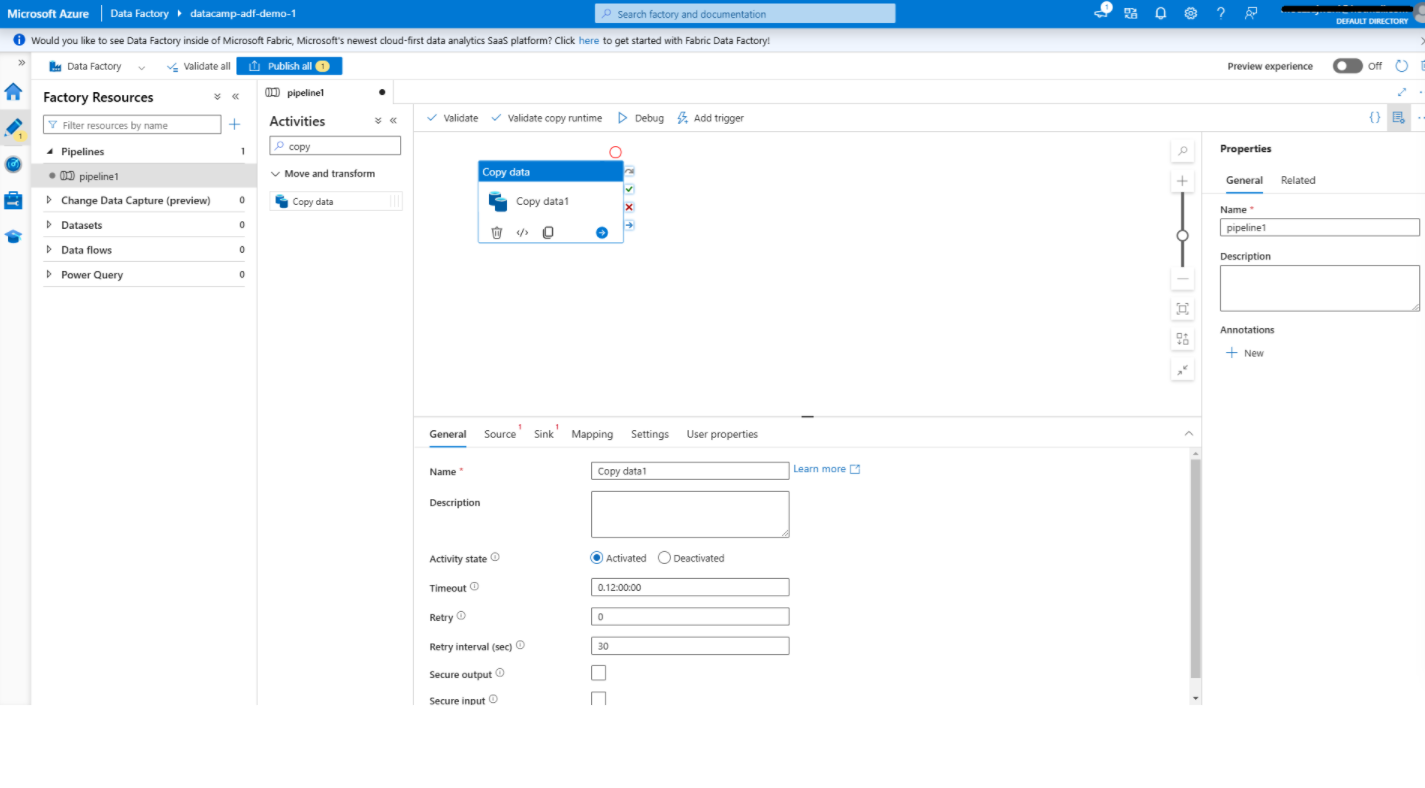

Paso 3: Añadir actividades

Agregar una actividad de copia de datos en Azure Data Factory

1. Abre el editor de canalizaciones.

- En el pestaña Autor , crea una nueva canalización haciendo clic en + y seleccionando Canalización.

- Esto abrirá el editor de canalizaciones, una interfaz visual en la que podrás diseñar tus flujos de trabajo de datos.

2. Añadir la actividad de copia de datos

- En la caja de herramientas de la izquierda, busca la opción copiar datos en Mover y transformar .

- Arrastra la actividadCopiar datos al lienzo. Esta actividad traslada datos desde el origen hasta el destino.

3. Configura la actividad de copia de datos.

- Haz clic en copiar datos para abrir su panel de configuración.

- Bajo el pestaña Fuente :

- Selecciona el conjunto de datos de origen que has creado anteriormente.

- Configura opciones adicionales, como filtros de archivos o carpetas, si es necesario.

- Debajo del fregadero :

- Selecciona el conjunto de datos de destino.

- Especifica cualquier configuración adicional, como la forma de gestionar los datos existentes en el destino (por ejemplo, sobrescribir o añadir).

- Utiliza el pestaña Asignación para alinear los campos o columnas del origen con el destino, asegurando la compatibilidad de los datos.

- Guarda tu configuración.

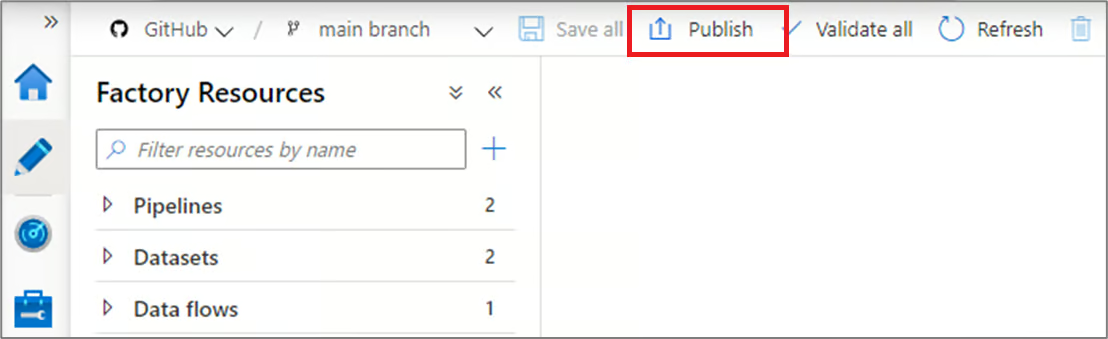

Paso 4: Publica y ejecuta el proceso.

Publicar canalizaciones en Azure Data Factory

1. Publica tu canalización

- Una vez configurada la canalización, haz clic en Publicar en la barra de herramientas.

- Esto guarda tu canalización y la prepara para su ejecución. Sin publicar, los cambios realizados en tu canalización permanecen como borradores y no se pueden ejecutar.

2. Ejecuta el proceso.

- Para probar tu canalización, haz clic en Agregar desencadenador en la parte superior y selecciona Desencadenar ahora para ejecutarla manualmente. Esto te permite verificar que el proceso funciona según lo previsto.

- Como alternativa, configura un programa automático:

- Ve a la pestaña y crea un nuevo desencadenante.

- Define las condiciones de activación, como una programación basada en el tiempo (por ejemplo, todos los días a las 8:00 a. m.) o una condición basada en eventos (por ejemplo, la llegada de un archivo a Azure Blob Storage).

- Asocia el desencadenante a tu canalización para habilitar la automatización.

Capacidades de integración y transformación de Azure Data Factory

Azure Data Factory ofrece potentes funciones de integración y transformación de datos que simplifican los flujos de trabajo complejos y mejoran la productividad. En esta sección, repasaremos estas características.

1. Flujos de datos

Data Flows Proporciona un entorno visual para definir la lógica de transformación, lo que facilita a los usuarios la manipulación y el procesamiento de datos sin necesidad de escribir código complejo. Las tareas comunes que se realizan con los flujos de datos incluyen:

- Agregaciones: Resume los datos para extraer información significativa, como el cálculo de las ventas totales o las métricas de rendimiento medio.

- Únete a: Combina datos de múltiples fuentes para crear conjuntos de datos enriquecidos para procesos posteriores.

- Filtros: Selecciona subconjuntos específicos de datos basados en criterios definidos, lo que te ayuda a centrarte en la información relevante.

Los flujos de datos también admiten operaciones avanzadas como derivaciones de columnas, conversiones de tipos de datos y transformaciones condicionales, lo que los convierte en herramientas versátiles para manejar diversos requisitos de datos.

2. Integración con Azure Synapse Analytics

ADF se integra perfectamente con Azure Synapse Analytics, lo que proporcionauna plataforma unificada para el procesamiento de big data y el análisis avanzado. Esta integración permite a los usuarios:

- Organiza flujos de trabajo de datos integrales que incluyan la ingesta, la preparación y el análisis de datos.

- Aprovecha el potente motor de consultas de Synapse para procesar grandes conjuntos de datos de manera eficiente.

- Crea canalizaciones de datos que se alimenten directamente en Synapse Analyticsparacasos de uso de machine learning ygeneración de informes.

Esta sinergia entre ADF y Synapse ayuda a optimizar los flujos de trabajo y reduce la complejidad de gestionar herramientas independientes para la integración y el análisis de datos.

3. Programación y supervisión de procesos

- Programación: Como se ha mencionado, las capacidades de programación de ADF ofrecen sólidas funciones de automatización. Los usuarios pueden definir desencadenadores basados en intervalos de tiempo (por ejemplo, cada hora, cada día) o eventos (por ejemplo, la llegada de un archivo a Azure Blob Storage).

- Supervisión: La pestaña Monitor de Azure Data Factory, combinadacon Azure Monitor, proporcionaun seguimiento y diagnóstico en tiempo real de las ejecuciones de canalizaciones. Los usuarios pueden ver registros detallados, realizar un seguimiento del progreso e identificar rápidamente los cuellos de botella o los fallos. Las alertas y notificaciones también se pueden configurar fácilmente.

Casos de uso de Azure Data Factory

Tras un análisis en profundidad de las características y componentes de ADF, veamos para qué se puede utilizar.

1. Migración de datos

ADF es una potente herramienta para migrar datos de sistemas locales a plataformas basadas en la nube. Simplifica las migraciones complejas al automatizar el movimiento de datos, garantizar la integridad de los datos y minimizar el tiempo de inactividad.

Por ejemplo, puedes utilizar ADF para migrar datos desde un servidor SQL locala una base de datos SQL de Azure con una intervención manual mínima. Al aprovechar los conectores integrados y los tiempos de ejecución de integración, ADF garantiza un proceso de migración seguro y eficiente, que admite tanto datos estructurados como no estructurados.

2. ETL para el almacenamiento de datos

Los procesos de extracción, transformación y carga (ETL) son el núcleo del almacenamiento de datos moderno. Azure Data Factory optimiza estos flujos de trabajo mediante la integración de datos de múltiples fuentes, la aplicación de lógica de transformación y la carga en un almacén de datos.

Por ejemplo, ADF puede consolidar datos de ventas de diferentes regiones, transformarlos a un formato unificado y cargarlos en Azure Synapse Analytics. Este proceso optimizado te permite mantener datos actualizados y de alta calidad para la elaboración de informes y la toma de decisiones.

|

Echa un vistazo a las 23 mejores herramientas ETL de 2024 y descubre por qué elegirlas. |

3. Integración de datos para lagos de datos

Los lagos de datos sirven como repositorio central para diversos conjuntos de datos, lo que permite realizar análisis avanzados y machine learning. ADF facilita la ingesta de datos de diversas fuentes en Azure Data Lake Storage, y admite escenarios por lotes y de transmisión.

Por ejemplo, puedes utilizar ADF para recopilar archivos de registro, fuentes de redes sociales y datos de sensores IoT en un único lago de datos. Al proporcionar herramientas de transformación e integración de datos, ADF garantiza que el lago de datos esté bien organizado y listo para el análisis posterior y las cargas de trabajo de IA.

Prácticas recomendadas para usar Azure Data Factory

Por último, vale la pena repasar algunas prácticas recomendadas para utilizar ADF de forma eficaz.

1. Diseño modular de tuberías

Para crear flujos de trabajo mantenibles y escalables, diseña canalizaciones con componentes reutilizables. El diseño modular facilita la depuración, las pruebas y la actualización de secciones individuales del proceso. Por ejemplo, en lugar de incorporar la lógica de transformación de datos en cada canalización, crea una canalización reutilizable que se pueda invocar en múltiples flujos de trabajo. Esto reduce la redundancia y mejora la coherencia entre los proyectos.

2. Optimizar el movimiento de datos

- Utiliza compresión: Para minimizar los tiempos de transferencia de datos y reducir el uso del ancho de banda de la red, comprime los conjuntos de datos grandes antes de moverlos. Por ejemplo, el uso de gzip o métodos similares puede acelerar considerablemente el movimiento de archivos de gran tamaño.

- Selecciona el tiempo de ejecución de integración adecuado: La elección del tiempo de ejecución de integración (Azure IR, IR autohospedado o SSIS IR) es fundamental para optimizar el rendimiento. Por ejemplo, el IR autohospedado se puede utilizar para el movimiento de datos locales con el fin de garantizar transferencias seguras y eficientes, mientras que el IR de Azure es ideal para operaciones nativas de la nube.

3. Implementar un manejo de errores robusto.

- Políticas de reintento: Configura políticas de reintento para errores transitorios, como interrupciones temporales de la red o tiempos de espera del servidor. Esto garantiza que las tuberías puedan recuperarse y completarse con éxito sin intervención manual.

- Configurar alertas: Implementa alertas y notificaciones para informar de forma proactiva a tu equipo sobre fallos o problemas de rendimiento en el proceso.ne Utiliza herramientas como Azure Monitor para configurar alertas personalizadas basadas en tipos de errores específicos o retrasos en la ejecución, lo que garantiza una resolución rápida y un tiempo de inactividad mínimo.

Entonces, ¿en qué se diferencia Azure Data Factoryde Databricks? Si tienes curiosidad y quieres descubrir las diferencias entre Azure Data Factory y Databricks, echa un vistazo a Azure Data Factory frente a Databricks: Un blog con una comparación detallada.

Azure Data Factory frente a Microsoft Fabric

A medida que domines Azure Data Factory, es fundamental comprender su evolución: Microsoft Fabric.

Aunque Azure Data Factory (ADF) sigue siendo una solución robusta e independiente de plataforma como servicio (PaaS) muy utilizada en las empresas, Microsoft ha presentado Fabric como el futuro de tu ecosistema de datos. Fabric es una plataforma SaaS todo en uno que unifica Data Factory, Synapse Analytics y Power BI en un único entorno.

¿Deberías usar ADF o Fabric?

- Sigue utilizando ADF si: Necesitas una solución PaaS madura y altamente personalizable con una profunda integración en los sistemas locales heredados, o si necesitas un control granular sobre la infraestructura (como entornos de ejecución de integración dedicados).

- Echa un vistazo a Fabric si: Estás creando una nueva plataforma de datos moderna y deseas una experiencia unificada en la que la ingeniería de datos, el almacenamiento de datos y la visualización de Power BI se realicen en un único espacio de trabajo sin mover datos (gracias a OneLake).

Nota: Las canalizaciones de ADF y las canalizaciones de Fabric Data Factory son muy similares, por lo que los conocimientos que adquieras hoy en ADF se pueden transferir directamente a Fabric. Puedes realizar nuestro curso Introducción a Microsoft Fabric para obtener más información.

Conclusión

Azure Data Factory simplifica el proceso de creación, administración y escalado de canalizaciones de datos en la nube. Proporciona una plataforma intuitiva que se adapta tanto a usuarios técnicos como no técnicos, permitiéndoles integrar y transformar datos de diversas fuentes de manera eficiente.

Al aprovechar sus características, como la creación de canalizaciones sin código, las capacidades de integración y las herramientas de supervisión, los usuarios pueden crear fácilmente flujos de trabajo escalables y fiables.

Para obtener más información sobre Azure Data Factory, te recomiendo que consultes las 27 preguntas y respuestas más frecuentes en las entrevistas sobre Azure Data Factory.

Si deseas explorar la estructura básica de Azure, incluyendo temas como contenedores, máquinas virtuales y mucho más, te recomiendo este fantástico curso gratuito sobre Comprensión de la arquitectura y los servicios de Microsoft Azure.

Preguntas frecuentes sobre Azure Data Factory

¿Azure Data Factory es una herramienta ETL o ELT?

Admite ambos. ADF se utiliza tradicionalmente para ELT (Extraer, Cargar, Transformar), donde los datos sin procesar se cargan en un destino en la nube antes de ser procesados. Sin embargo, con Mapping Data Flows, ofrece capacidades ETL visuales completas, lo que te permite transformar datos en tiempo real sin necesidad de escribir código.

¿Cuál es la diferencia entre Azure Data Factory y Microsoft Fabric?

Azure Data Factory (ADF) es una herramienta PaaS (plataforma como servicio) independiente centrada exclusivamente en la integración de datos. Microsoft Fabric es una plataforma SaaS (Software as a Service) unificada que incluye capacidades de Data Factory junto con Power BI, Synapse y herramientas de ciencia de datos en un único entorno.

¿Necesitas conocimientos de programación para utilizar Azure Data Factory?

No. ADF es principalmente una plataforma de bajo código/sin código con una interfaz de arrastrar y soltar para crear canalizaciones. Sin embargo, es muy recomendable conocer SQL para interactuar con bases de datos, y Python resulta útil si se planea utilizar funciones de orquestación avanzadas como Airflow.

¿Cómo funciona la tarificación de Azure Data Factory?

ADF utiliza un modelo de consumo de pago por uso. No se te cobra una tarifa plana mensual, sino que los costes se calculan en función del número de ejecuciones de actividades, las horas de movimiento de datos y la duración de la ejecución del flujo de datos. Esto lo hace rentable tanto para cargas de trabajo pequeñas como grandes.

¿Puede Azure Data Factory conectarse a datos locales?

Sí. Puedes conectarte de forma segura a servidores locales (como SQL Server, Oracle o sistemas de archivos) instalando Self-Hosted Integration Runtime en un equipo local dentro de tu red. Esto actúa como una puerta de enlace/puente segura a la nube sin abrir puertos del cortafuegos.

¿Cuál es la diferencia entre ADF y Databricks?

ADF es un coordinador diseñado para programar y gestionar flujos de trabajo. Databricks es un motor informático optimizado para el procesamiento intensivo de datos mediante Spark y Python. En muchas arquitecturas, ADF activa los cuadernos de Databricks para realizar transformaciones complejas.

¿Cómo gestiona ADF la seguridad?

Azure Data Factory ofrece seguridad de nivel empresarial, incluida una identidad administrada de Azure Key Vault para una autenticación fluida sin necesidad de administrar credenciales, compatibilidad c Key Vault para almacenar secretos y puntos de conexión privados (a través de Azure Private Link) para garantizar que el tráfico de datos nunca entre en la Internet pública.