Curso

O Azure Data Factory (ADF) é o serviço de integração de dados baseado em nuvem da Microsoft, feito sob medida para organizações modernas. Ele permite que os usuários projetem, gerenciem e automatizem fluxos de trabalho que lidam com tarefas de movimentação e transformação de dados em escala empresarial.

O ADF se destaca por sua interface amigável e sem código, que permite que usuários técnicos e não técnicos criem pipelines de dados com facilidade. Seus amplos recursos de integração suportam mais de 90 conectores nativos, permitindo o fluxo de dados entre diversas fontes, incluindo sistemas locais e serviços baseados na nuvem.

Neste guia, faço uma introdução abrangente ao Azure Data Factory, abordando seus componentes e recursos e fornecendo um tutorial prático para ajudar você a criar seu primeiro pipeline de dados.

O que é o Azure Data Factory?

O Azure Data Factory (ADF) é um serviço de integração de dados baseado em nuvem projetado para orquestrar e automatizar fluxos de trabalho de dados.

Ele é usado para coletar, transformar e fornecer dados, garantindo que os insights sejam prontamente acessíveis para análise e tomada de decisões.

Com sua arquitetura dimensionável e sem servidor, o ADF pode lidar com fluxos de trabalho de qualquer tamanho, desde simples migrações de dados até complexos pipelines de transformação de dados.

O ADF preenche a lacuna entre os silos de dados, permitindo que os usuários movam e transformem dados entre sistemas locais, serviços em nuvem e plataformas externas. Não importa se você está trabalhando com big data, bancos de dados operacionais ou APIs, o Azure Data Factory fornece as ferramentas para conectar, processar e unificar dados com eficiência.

Recursos do Azure Data Factory

Aqui estão alguns dos recursos mais importantes que o ADF oferece.

1. Integração de dados

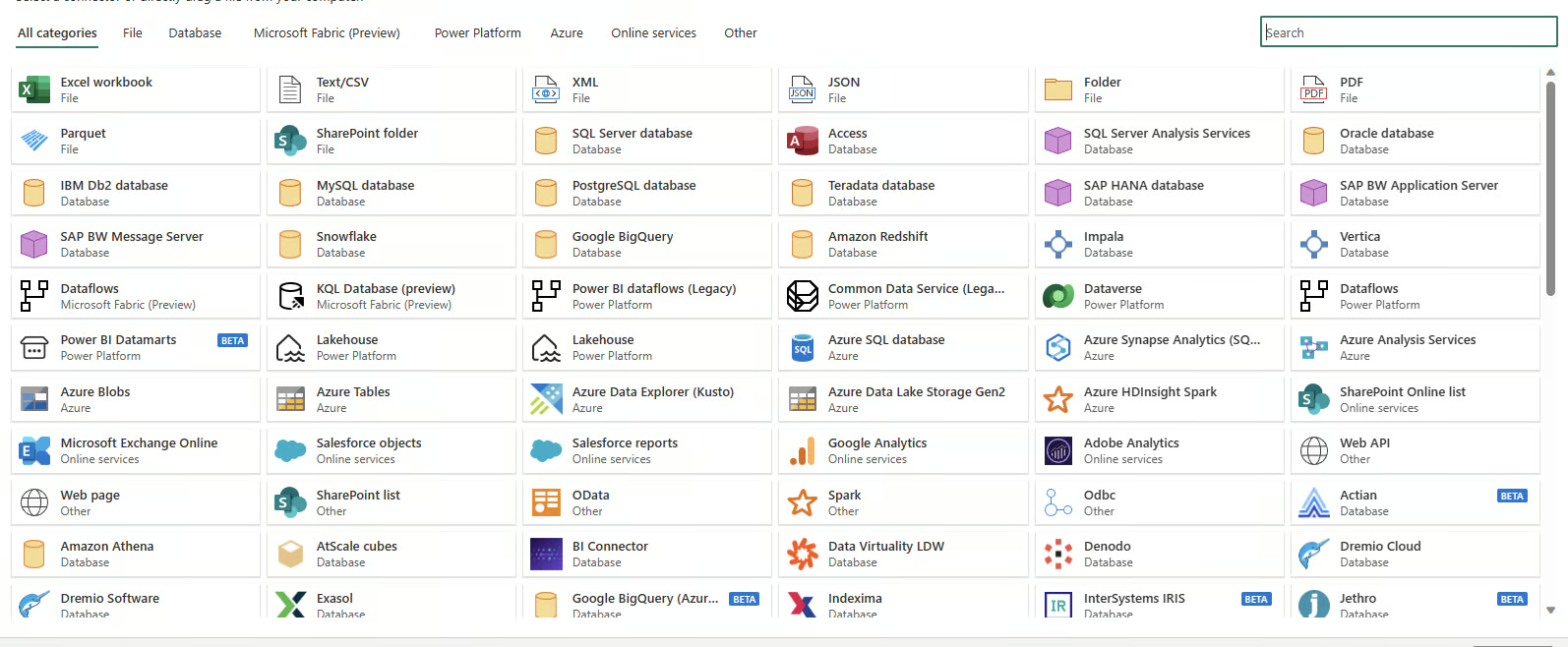

O Azure Data Factory oferece suporte à integração com mais de 90 fontes de dados, incluindo sistemas baseados na nuvem e no local. Ele inclui suporte para bancos de dados SQL, sistemas NoSQL, APIs REST e fontes de dados baseadas em arquivos, permitindo que você unifique os fluxos de trabalho de dados independentemente da fonte ou do formato.

Conectores de dados disponíveis no Azure Data Factory

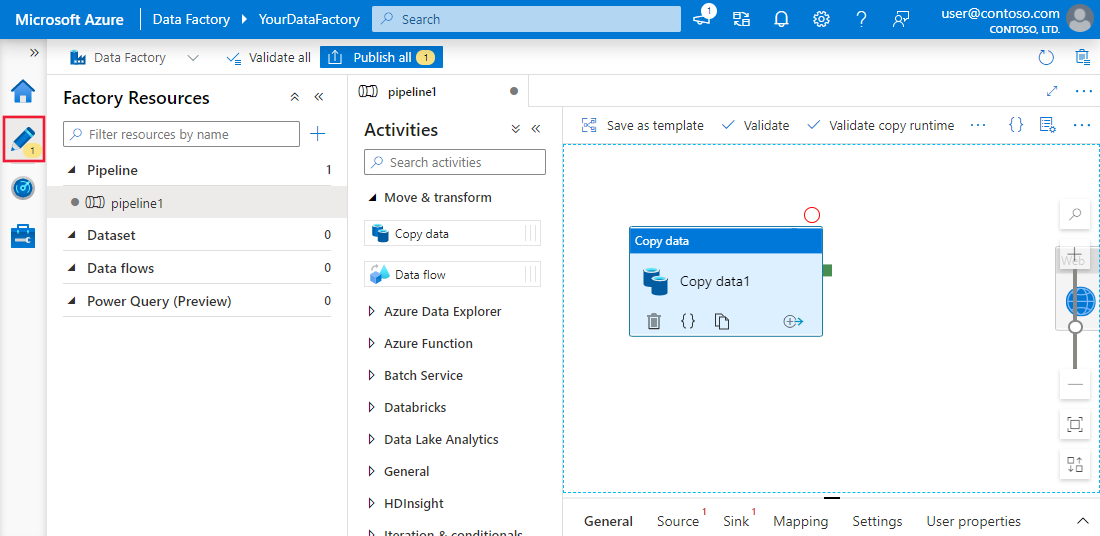

2. Criação de pipeline sem código

A interface de arrastar e soltar do ADF simplifica a forma como os usuários criam pipelines de dados. Com modelos pré-criados, assistentes de configuração guiados e um editor visual intuitivo, até mesmo usuários sem experiência em codificação podem projetar fluxos de trabalho abrangentes de ponta a ponta.

Experiência de criação sem código no Azure Data Factory

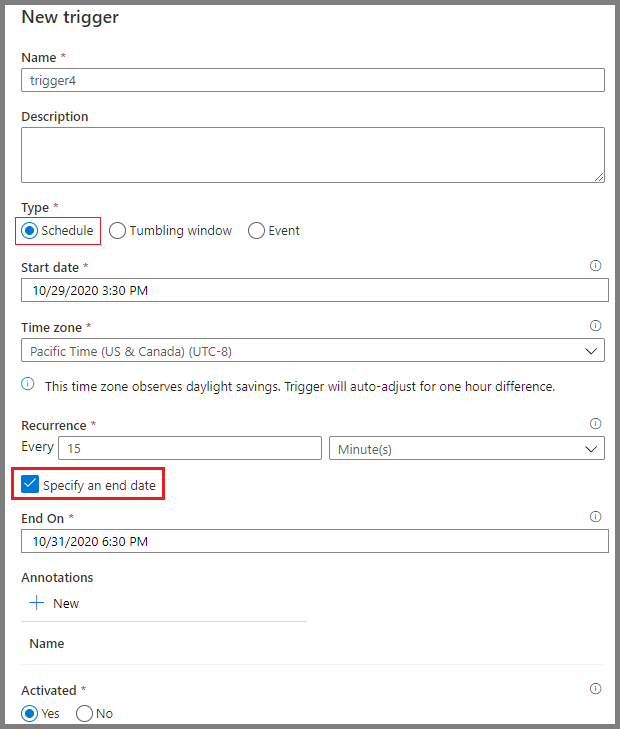

3. Agendamento

As ferramentas de agendamento do Azure Data Factory oferecem automação do fluxo de trabalho. Os usuários podem configurar acionadores com base em condições específicas, como a chegada de um arquivo ao armazenamento em nuvem ou intervalos de tempo programados. Essas opções de agendamento eliminam a necessidade de intervenções manuais e garantem que os fluxos de trabalho sejam executados de forma consistente e confiável.

Agendamento de pipelines no Azure Data Factory

Componentes principais do Azure Data Factory

Compreender os principais componentes do Azure Data Factory é essencial para que você crie fluxos de trabalho eficientes.

1. Dutos

Os pipelines são a espinha dorsal do Azure Data Factory. Eles representam fluxos de trabalho orientados por dados que definem as etapas necessárias para mover e transformar dados.

Cada pipeline serve como um contêiner para uma ou mais atividades, executadas sequencialmente ou em paralelo, para obter o fluxo de dados desejado.

Esses pipelines permitem que os engenheiros de dados criem processos de ponta a ponta, como a ingestão de dados brutos, a transformação em um formato utilizável e o carregamento em sistemas de destino.

Exemplo de pipeline simples no Azure Data Factory

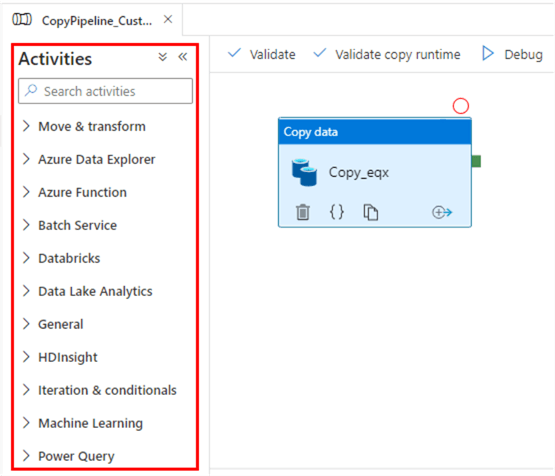

2. Atividades

As atividades são os blocos de construção funcionais dos pipelines, cada um executando uma operação específica. Eles são amplamente categorizados em:

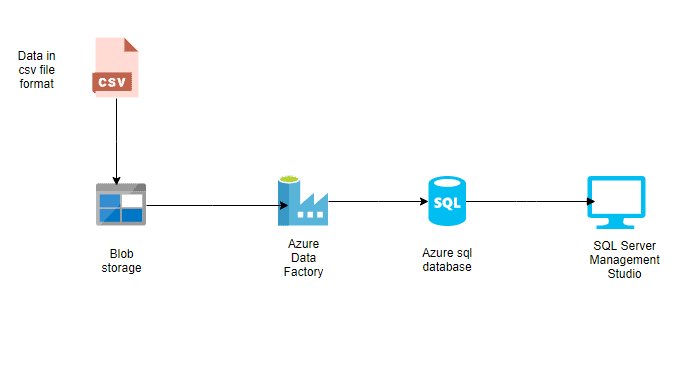

- Atividades de movimentação de dados: Essas atividades facilitam a transferência de dados entre diferentes sistemas de armazenamento. Por exemplo, a atividade "Copiar dados" move os dados do Azure Blob Storage para um banco de dados SQL do Azure.

- Atividades de transformação de dados: Essas atividades permitem que você manipule ou processe dados. Por exemplo, os fluxos de dados ou scripts personalizados podem ser usados para transformar formatos de dados, agregar valores ou limpar conjuntos de dados.

- Atividades de fluxo de controle: Eles gerenciam o fluxo lógico de execução nos pipelines. Os exemplos incluem ramificação condicional, loops e execução paralela, que proporcionam flexibilidade no tratamento de fluxos de trabalho complexos.

Atividades no Azure Data Factory

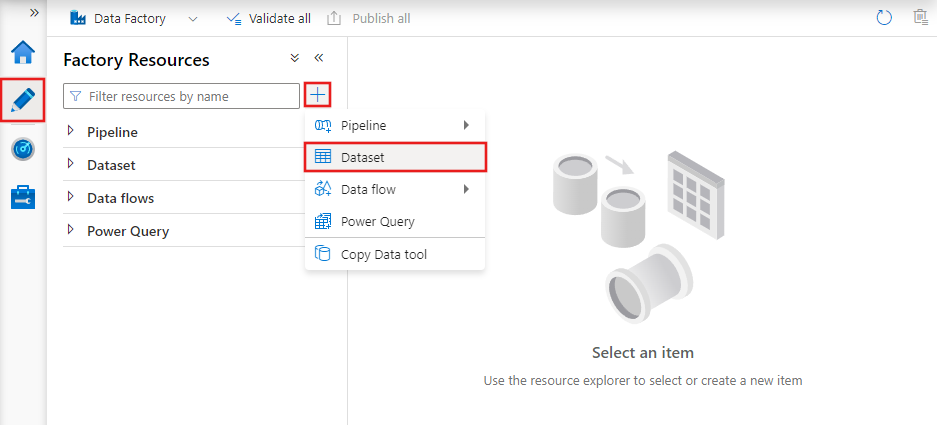

3. Conjuntos de dados

Os conjuntos de dados são representações dos dados utilizados nas atividades. Eles definem o esquema, o formato e o local dos dados que estão sendo ingeridos ou processados.

Por exemplo, um conjunto de dados pode descrever um arquivo CSV no Azure Blob Storage ou uma tabela em um banco de dados SQL do Azure. Os conjuntos de dados são a camada intermediária que conecta as atividades às fontes e aos destinos reais dos dados.

Conjuntos de dados no Azure Data Factory

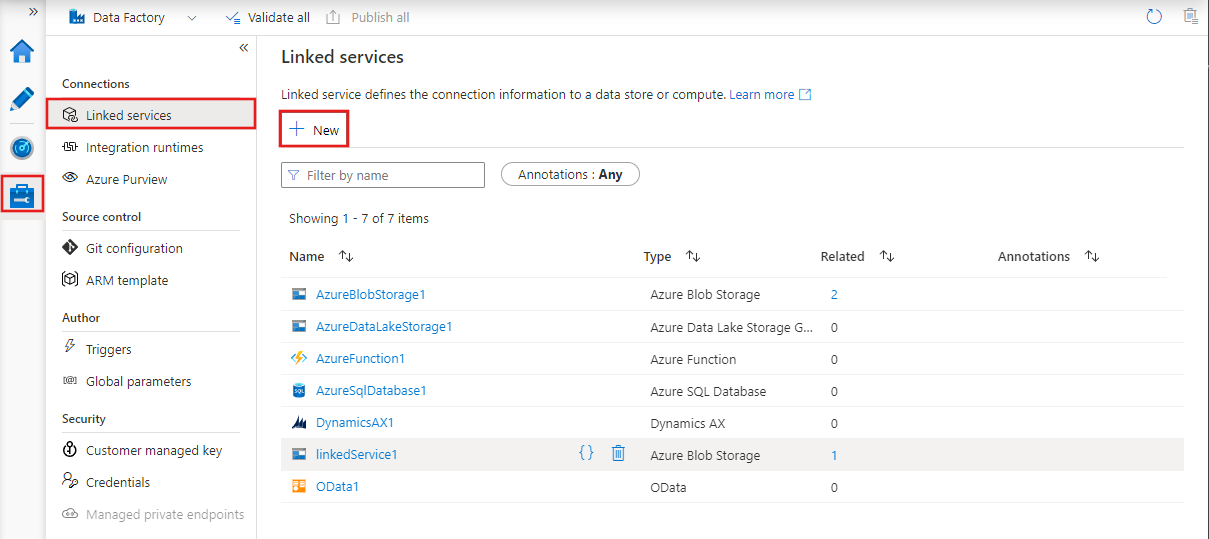

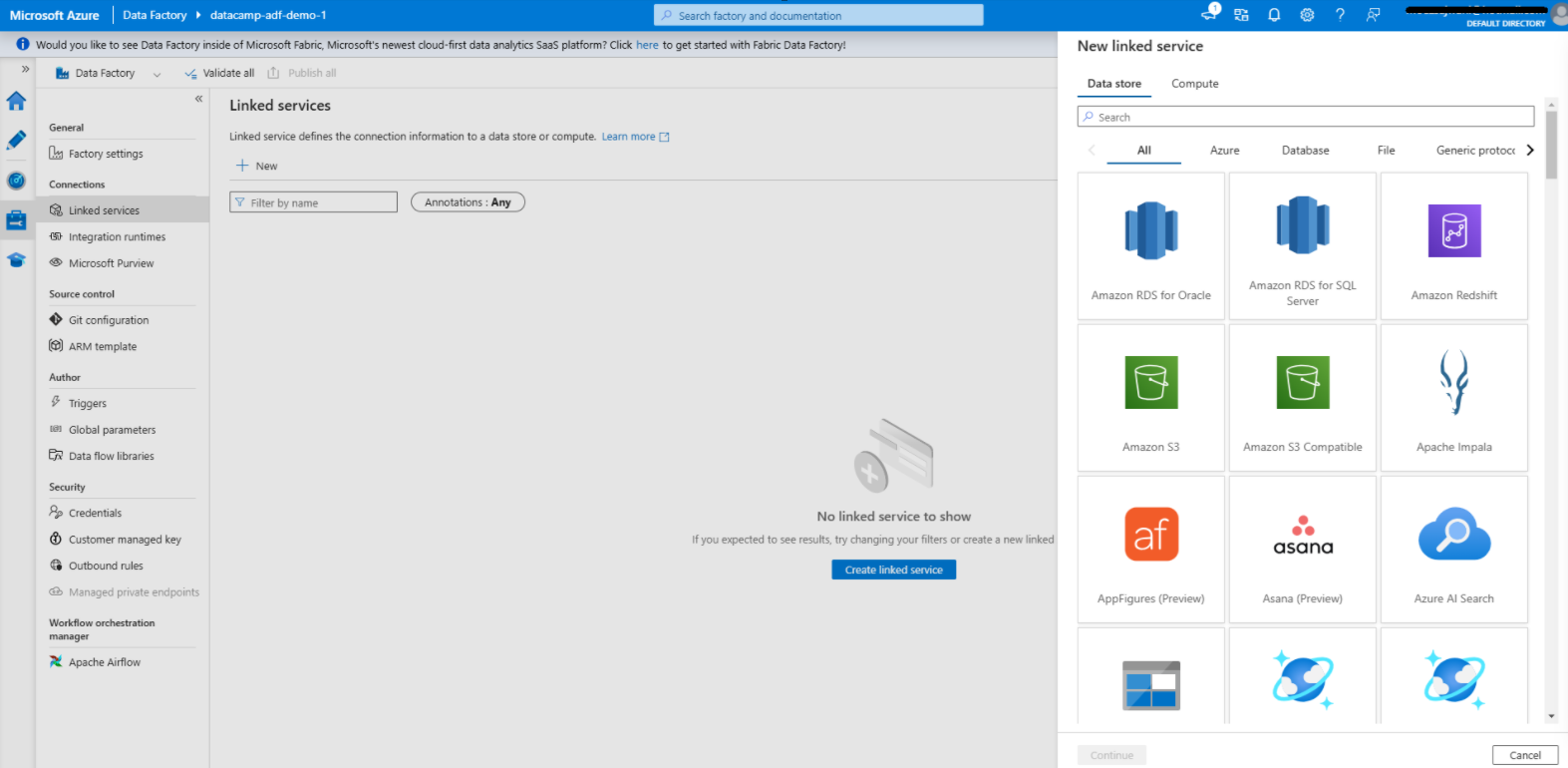

4. Serviços vinculados

Os serviços vinculados são cadeias de conexão que permitem que atividades e conjuntos de dados acessem sistemas e serviços externos.

Eles atuam como pontes entre o Azure Data Factory e os recursos externos com os quais ele interage, como bancos de dados, contas de armazenamento ou ambientes de computação.

Por exemplo, um serviço vinculado pode se conectar a um SQL Server local ou a um data lake baseado na nuvem.

Serviços vinculados no Azure Data Factory

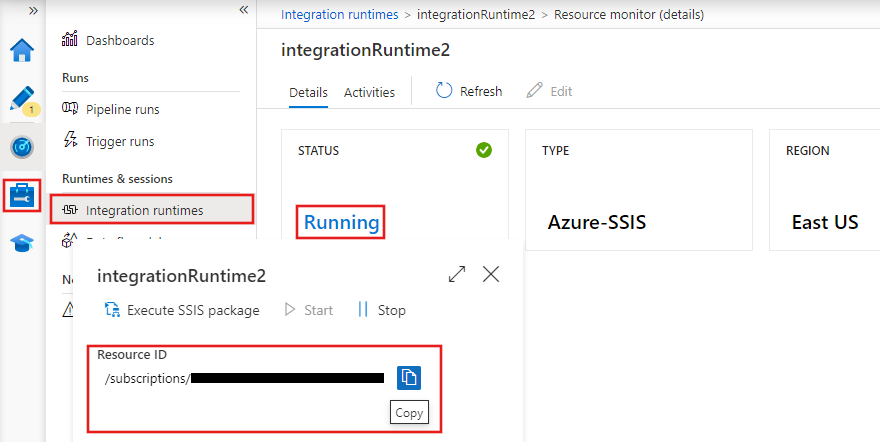

5. Tempos de execução de integração

Os runtimes de integração (IRs) são os ambientes de computação que potencializam a movimentação de dados, a transformação e a execução de atividades no Azure Data Factory. O ADF oferece três tipos de tempos de execução de integração:

- Azure IR: Lida com tarefas de integração de dados baseadas na nuvem e é gerenciado inteiramente pelo Azure.

- IR auto-hospedado: Oferece suporte à movimentação de dados entre sistemas locais e a nuvem, o que o torna ideal para cenários híbridos.

- SSIS IR: Habilita a execução de pacotes do SQL Server Integration Services (SSIS) no Azure, permitindo que você reutilize fluxos de trabalho SSIS existentes na nuvem.

Tempos de execução de integração no Azure Data Factory

Domine o Azure do zero

Configuração do Azure Data Factory

Agora, vamos passar para a seção prática deste guia!

1. Pré-requisitos

1. Uma assinatura ativa doe do Azure.

2. Um grupo de recursos para gerenciaros recursos do Azure.

2. Criando uma instância do Azure Data Factory

1. Faça login em no portal do Azure.

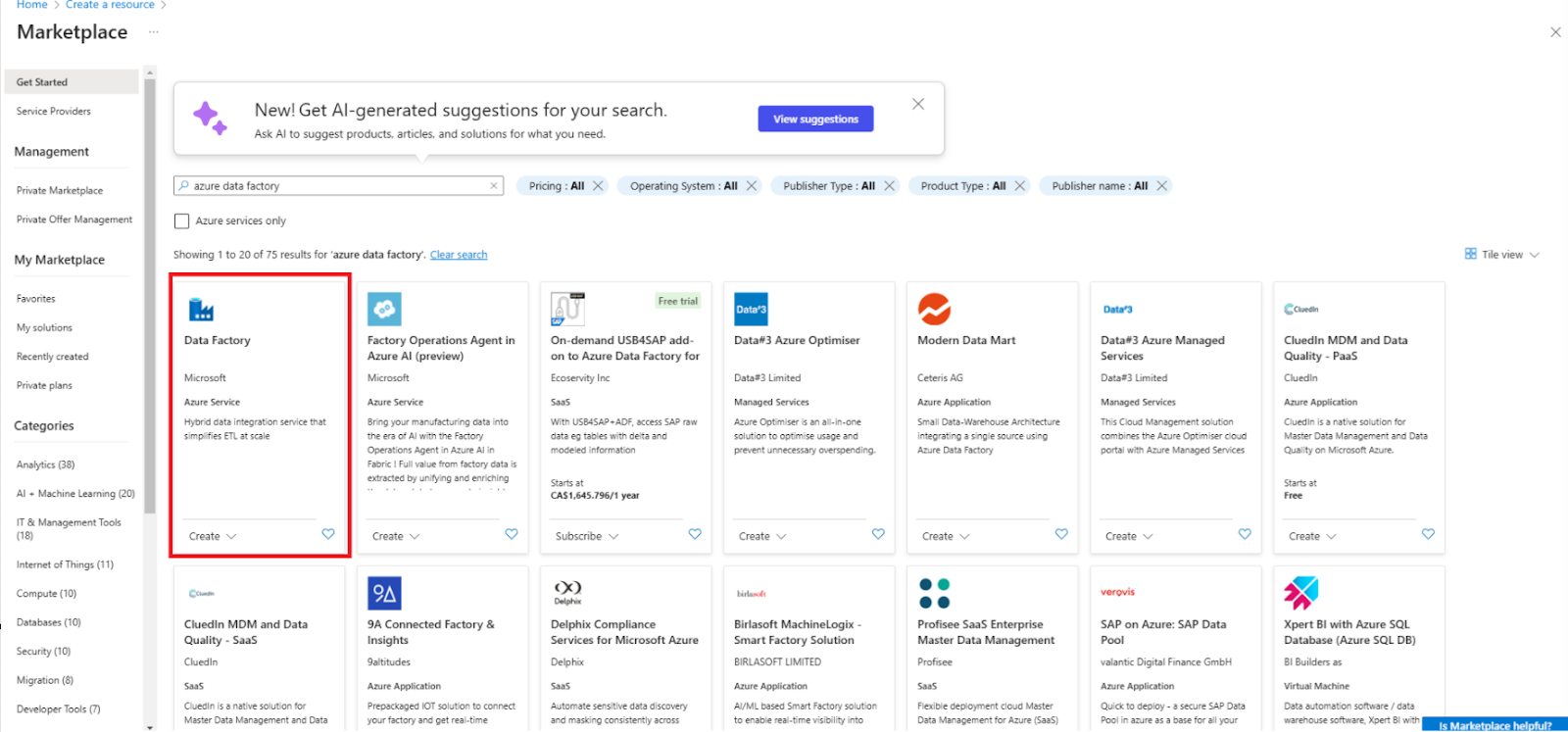

2. Navegue até Criar um recurso e selecione Data Factory.

Criar um novo recurso do Data Factory

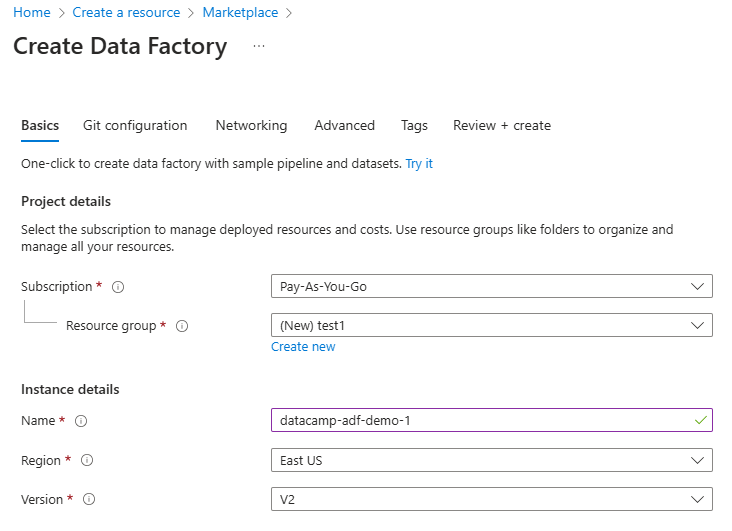

3. Preencha os campos obrigatórios, incluindo assinatura, grupo de recursos e região.

Configurar o recurso Data Factory

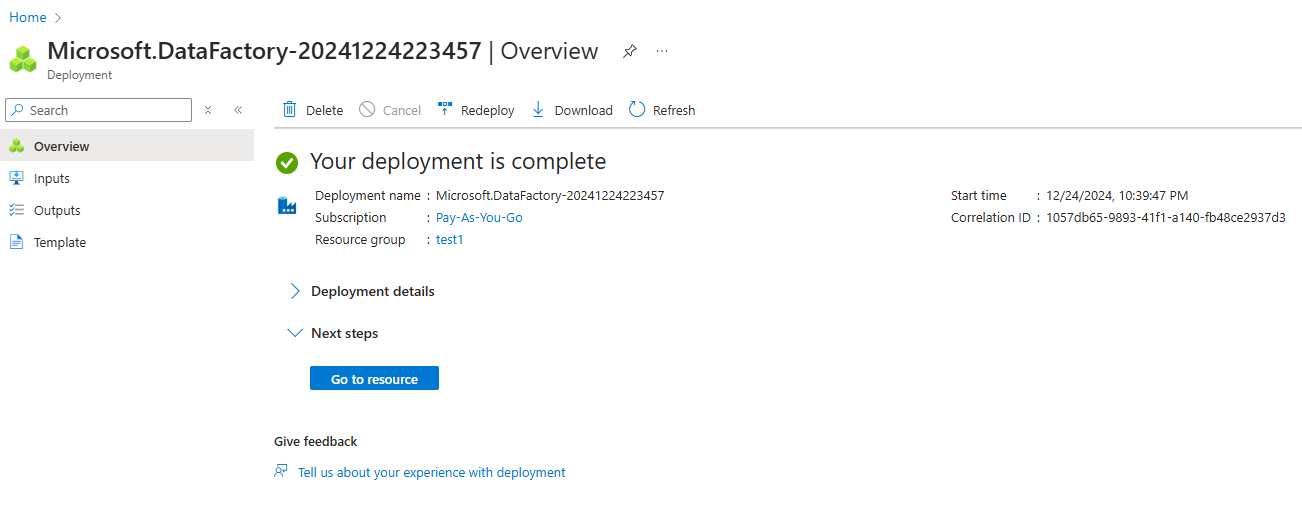

4. Revise e crie a instância.

Instância do Azure Data Factory criada

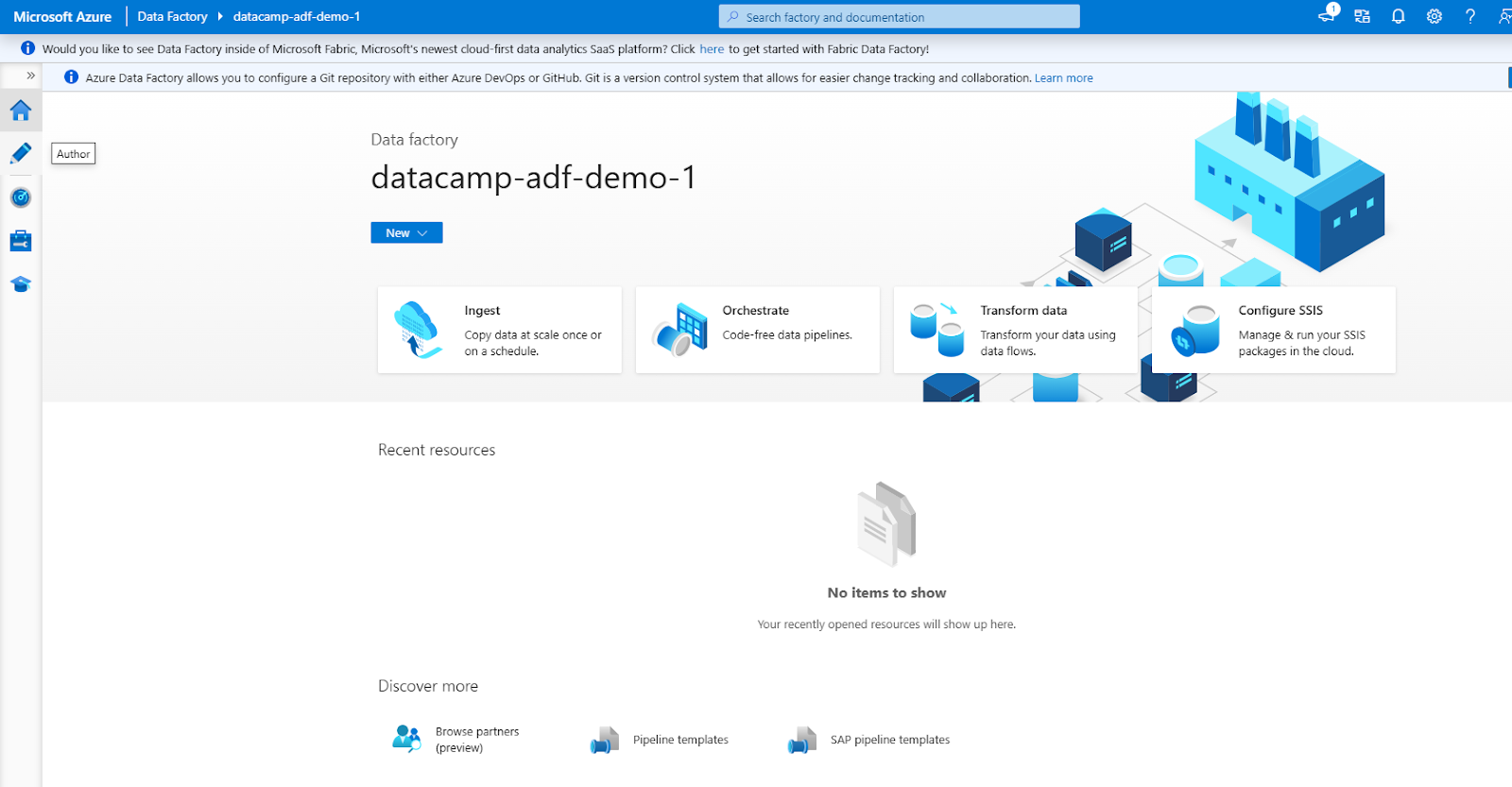

3. Navegando na interface do ADF

A interface do ADF consiste nas seguintes seções principais (acessíveis pelo menu de navegação à esquerda)

1. Autor: Para criar e gerenciar pipelines.

2. Monitor: Acompanhar as execuções do pipeline e solucionar problemas.

3. Gerencie: Para configurar serviços vinculados e tempos de execução de integração.

Interface do Azure Data Factory

Criando seu primeiro pipeline no Azure Data Factory

Vamos examinar as etapas para criar um pipeline de dados simples.

Etapa 1: Criar serviços vinculados

Criando um serviço vinculado no Azure Data Factory

1. Navegue até a guia Gerenciar

- Abra a instância do Azure Data Factory e acesse a guiaGerenciar na interface do ADF. É aqui que você define os serviços vinculados, que conectam suas fontes e destinos de dados.

2. Adicionar um serviço vinculado para a fonte de dados

- Clique em Serviços vinculados na guia Gerenciar.

- Selecione + Novo para criar um novo serviço vinculado.

- Na lista de opções disponíveis, selecione a fonte de dados à qual você deseja se conectar, como Blob do Azure do Azure.

- Forneça os detalhes de conexão necessários, como o nome da conta de armazenamento e o método de autenticação (por exemplo, chave de conta ou identidade gerenciada).

- Teste a conexão para garantir que tudo esteja configurado corretamente e clique em Criar.

3. Adicionar um serviço vinculado para o destino dos dados

- Repita o processo para o destino dos dados, como Banco de dados SQL do Azure.

- Selecione o tipo de destino apropriado, defina as configurações de conexão (por exemplo, nome do servidor, nome do banco de dados e método de autenticação) e teste a conexão.

- Depois de verificado, salve o serviço vinculado.

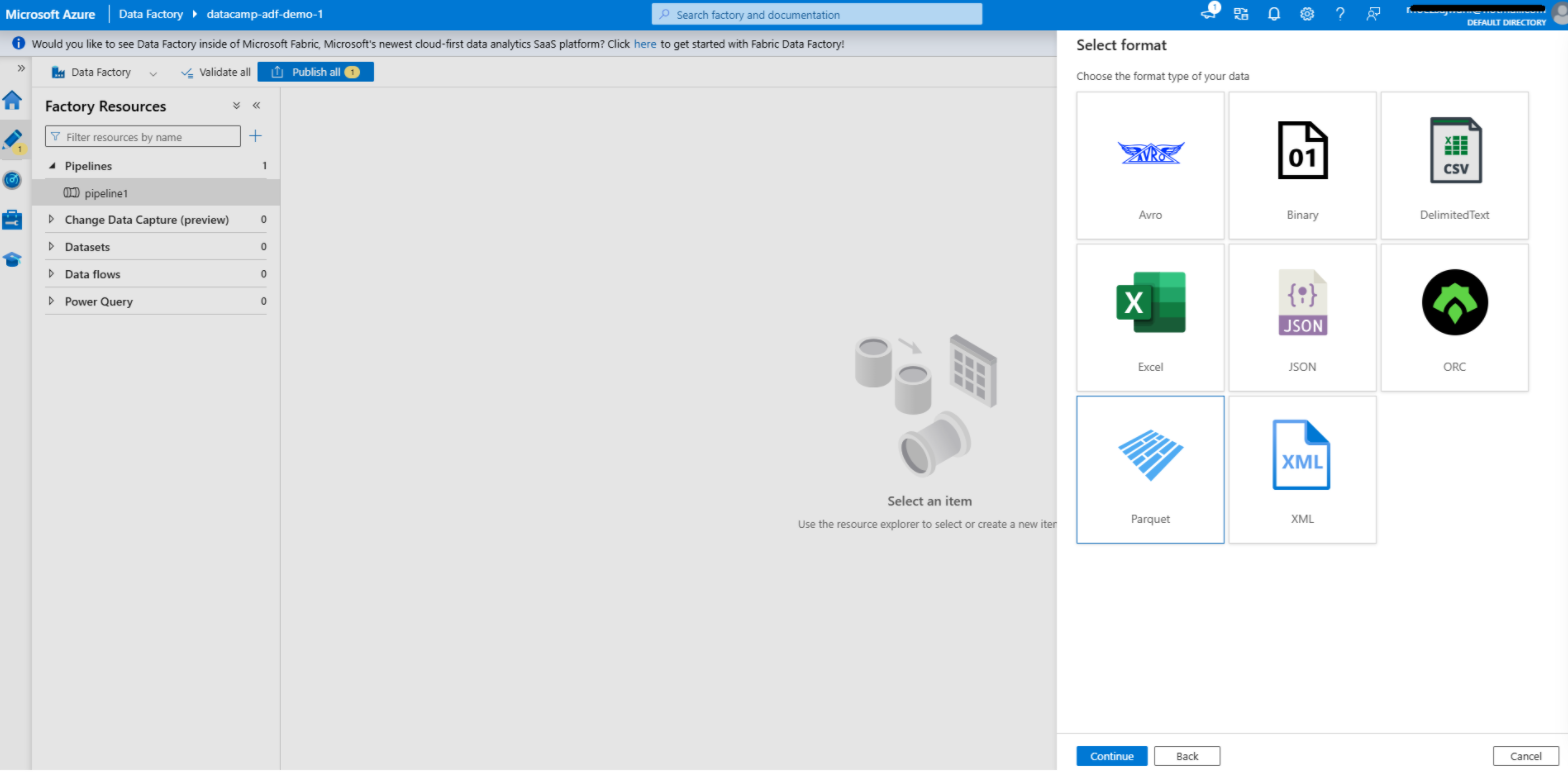

Etapa 2: Criar um conjunto de dados

Criar um conjunto de dados no Azure Data Factory

1. Navegue até a guia Author (Autor)

- Abra a guiaAuthor na interface do Azure Data Factory. É aqui que você projeta e gerencia seus pipelines, conjuntos de dados e outros componentes do fluxo de trabalho.

2. Adicionar um conjunto de dados para a fonte

- Clique no botão + e selecione Conjunto de dados no menu suspenso.

- Escolha o tipo de armazenamento de dados que corresponde ao serviço vinculado de origem. Por exemplo, se sua fonte for Azure Blob Storage, selecione o tipo de armazenamento de dados correspondente, como Delimited Text, Parquet ou outra opção relevante.

- Configure o conjunto de dados:

- Serviço vinculado: Selecione o serviço vinculado que você criou anteriormente para a fonte de dados.

- Caminho do arquivo: Especifique o caminho ou o contêiner onde os dados de origem residem.

- Esquema e formato: Defina o formato dos dados (por exemplo, CSV, JSON) e importe o esquema, se aplicável. Isso permite que o ADF compreenda a estrutura dos seus dados.

- Clique em OK para salvar o conjunto de dados.

3. Adicionar um conjunto de dados para o destino

- Repita o processo para o conjunto de dados de destino.

- Escolha o tipo de armazenamento de dados que corresponde ao serviço vinculado de destino. Por exemplo, se o destino for Banco de dados SQL do Azure, selecione o tipo apropriado, como Tabela.

- Configure o conjunto de dados:

- Serviço vinculado: Selecione o serviço vinculado que você criou para o destino.

- Nome ou caminho da tabela: Especifique a tabela ou o caminho de destino onde os dados serão gravados.

- Schema: Opcionalmente, você pode definir ou importar o esquema do conjunto de dados de destino para garantir a compatibilidade com os dados de origem.

- Salve o conjunto de dados.

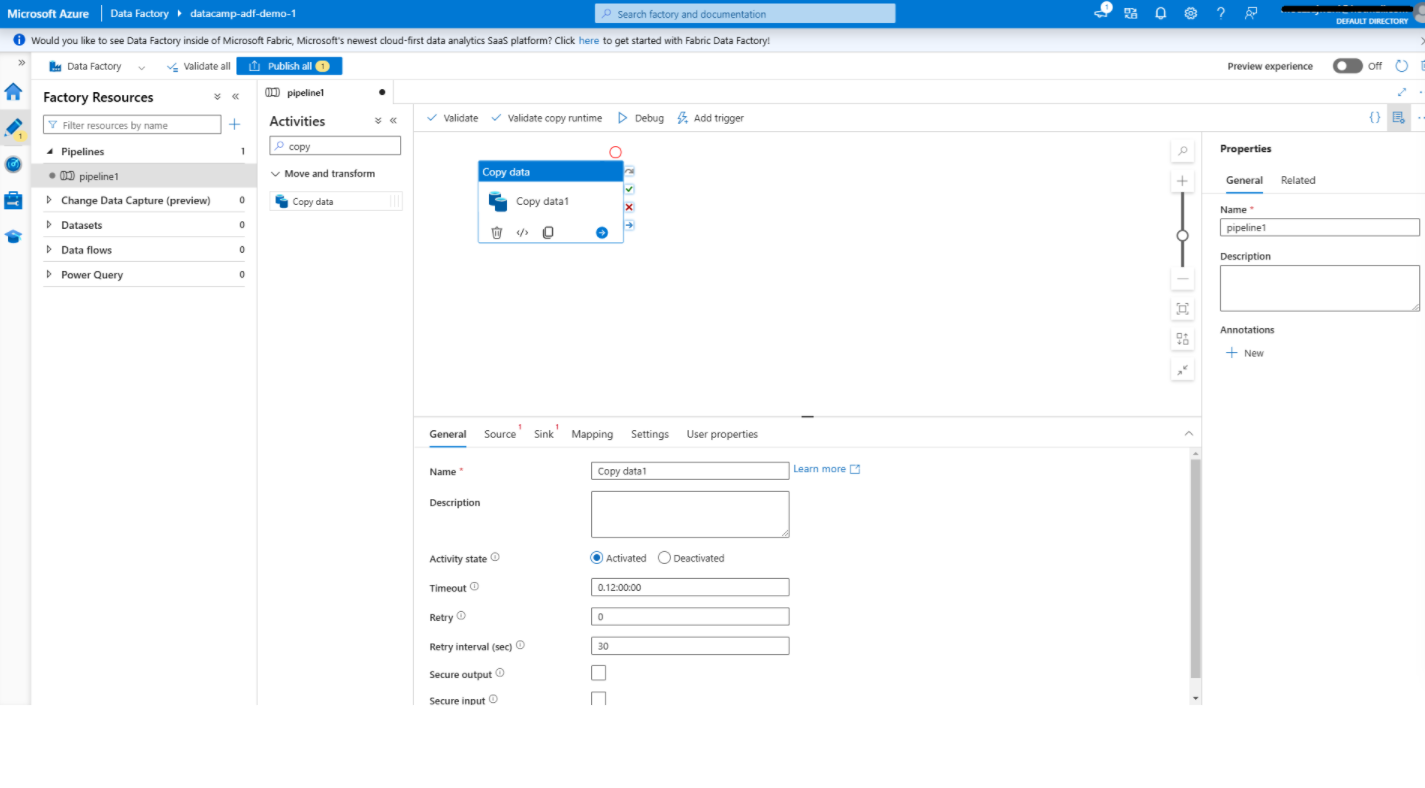

Etapa 3: Adicionar atividades

Adição de uma atividade de cópia de dados no Azure Data Factory

1. Abra o editor de pipeline

- No Autor crie um novo pipeline clicando em + e selecionando Pipeline.

- Isso abrirá o editor de pipeline, uma interface visual na qual você pode projetar seus fluxos de trabalho de dados.

2. Adicione a atividade de cópia de dados

- Na caixa de ferramentas à esquerda, localize a opção Copiar dados na atividade Mover e transformar você pode usar a categoria Move & Transform.

- Arraste a atividadeCopiar dados para a tela. Essa atividade move os dados da origem para o destino.

3. Configurar a atividade de cópia de dados

- Clique no botão Copiar dados para abrir o painel de configurações.

- Sob o Fonte você pode ver a guia Source:

- Selecione o conjunto de dados de origem que você criou anteriormente.

- Configure opções adicionais, como filtros de arquivos ou pastas, se necessário.

- Sob a pia Pia tab:

- Selecione o conjunto de dados de destino.

- Especifique quaisquer configurações adicionais, como a forma de lidar com os dados existentes no destino (por exemplo, sobrescrever ou anexar).

- Use o Mapeamento para alinhar os campos ou colunas da origem ao destino, garantindo a compatibilidade dos dados.

- Salve sua configuração.

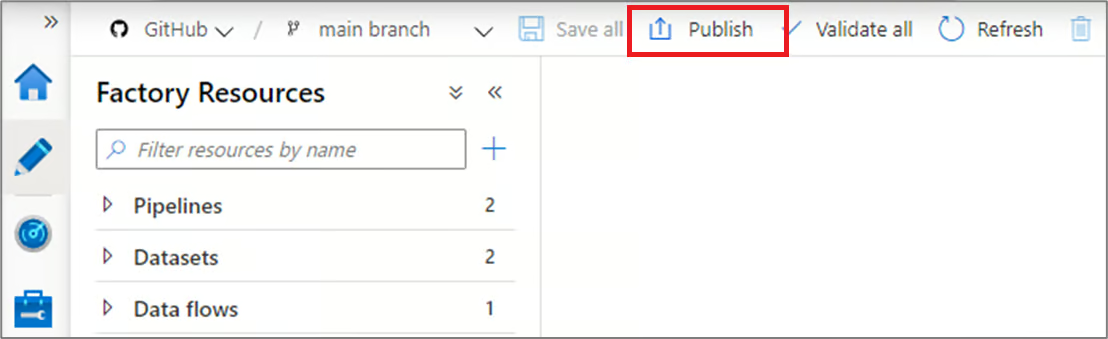

Etapa 4: Publicar e executar o pipeline

Publicação de pipelines no Azure Data Factory

1. Publique seu pipeline

- Quando o pipeline estiver configurado, clique em Publicar na barra de ferramentas.

- Isso salva seu pipeline e o deixa pronto para execução. Sem a publicação, as alterações feitas em seu pipeline permanecem como rascunhos e não podem ser executadas.

2. Executar o pipeline

- Para testar o pipeline, clique em Add Trigger (Adicionar acionador ) na parte superior e selecione Trigger Now (Acionar agora) para uma execução manual. Isso permite que você verifique se o pipeline está funcionando conforme o esperado.

- Como alternativa, configure uma programação automatizada:

- Vá para a seção Triggers (Acionadores) e crie um novo acionador.

- Defina as condições de acionamento, como uma programação baseada em tempo (por exemplo, todos os dias às 8:00 AM) ou uma condição baseada em evento (por exemplo, chegada de arquivo no Armazenamento de Blob do Azure).

- Associe o acionador ao seu pipeline para permitir a automação.

Recursos de integração e transformação do Azure Data Factory

O Azure Data Factory oferece recursos avançados de integração e transformação de dados que simplificam fluxos de trabalho complexos e aumentam a produtividade. Nesta seção, analisaremos esses recursos.

1. Fluxos de dados

Fluxos de dados provide um ambiente visual para definir a lógica de transformação, facilitando aos usuários a manipulação e o processamento de dados sem a necessidade de escrever códigos complexos. As tarefas comuns realizadas com fluxos de dados incluem:

- Agregações: Resuma os dados para extrair insights significativos, como o cálculo do total de vendas ou métricas médias de desempenho.

- Participa: Combine dados de várias fontes para criar conjuntos de dados enriquecidos para processos downstream.

- Filtros: Selecione subconjuntos específicos de dados com base em critérios definidos, ajudando você a se concentrar em informações relevantes.

Os fluxos de dados também suportam operações avançadas, como derivações de colunas, conversões de tipos de dados e transformações condicionais, o que os torna ferramentas versáteis para lidar com diversos requisitos de dados.

2. Integração com o Azure Synapse Analytics

O ADF se integra perfeitamente ao Azure Synapse Analytics, providenciando uma plataforma unificada para processamento de big data e análise avançada. Essa integração permite que os usuários:

- Orquestrar fluxos de trabalho de dados de ponta a ponta que incluam ingestão, preparação e análise de dados.

- Aproveite o poderoso mecanismo de consulta do Synapse para processar grandes conjuntos de dados com eficiência.

- Crie pipelines de dados que alimentam diretamente o Synapse Analyticsparacasos de uso de aprendizado de máquina erelatórios.

Essa sinergia entre o ADF e o Synapse ajuda a otimizar os fluxos de trabalho e reduz a complexidade do gerenciamento de ferramentas separadas para integração e análise de dados.

3. Agendamento e monitoramento de pipelines

- Agendamento: Conforme mencionado, os recursos de agendamento do ADF oferecem recursos robustos de automação. Os usuários podem definir acionadores com base em intervalos de tempo (por exemplo, a cada hora, diariamente) ou eventos (por exemplo, a chegada de um arquivo noAzure Blob Storage).

- Monitoramento: A guia Monitor no Azure Data Factory, combinada com o Azure Monitor, fornece a você rastreamento e diagnóstico em tempo real para execuções de pipeline. Os usuários podem visualizar logs detalhados, acompanhar o progresso e identificar rapidamente gargalos ou falhas. Os alertas e as notificações também podem ser configurados facilmente.

Casos de uso do Azure Data Factory

Depois de uma análise detalhada dos recursos e componentes do ADF, vamos ver para que ele pode ser usado.

1. Migração de dados

O ADF é uma ferramenta poderosa para migrar dados de sistemas locais para plataformas baseadas na nuvem. Ele simplifica migrações complexas, automatizando a movimentação de dados, garantindo a integridade dos dados e minimizando o tempo de inatividade.

Por exemplo, você pode usar o ADF para migrar dados de um SQL Server localpara um banco de dados SQL do Azure com o mínimo de intervenção manual. Ao aproveitar os conectores integrados e os tempos de execução de integração, o ADF garante um processo de migração seguro e eficiente, acomodando dados estruturados e não estruturados.

2. ETL para armazenamento de dados

Os processos de extração, transformação e carregamento (ETL) estão no centro do armazenamento de dados moderno. O Azure Data Factory simplifica esses fluxos de trabalho integrando dados de várias fontes, aplicando a lógica de transformação e carregando-os em um data warehouse.

Por exemplo, o ADF pode consolidar dados de vendas de diferentes regiões, transformá-los em um formato unificado e carregá-los no Azure Synapse Analytics. Esse processo simplificado permite que você mantenha dados atualizados e de alta qualidade para relatórios e tomada de decisões.

|

Confira as 23 melhores ferramentas de ETL em 2024 e por que você deve escolhê-las. |

3. Integração de dados para lagos de dados

Os data lakes funcionam como um repositório central para diversos conjuntos de dados, permitindo análises avançadas e aprendizado de máquina. O ADF facilita a ingestão de dados de várias fontes no armazenamento do Azure Data Lake, oferecendo suporte a cenários de fluxo contínuo e em lote.

Por exemplo, você pode usar o ADF para coletar arquivos de log, feeds de mídia social e dados de sensores de IoT em um único data lake. Ao fornecer ferramentas de transformação e integração de dados, o ADF garante que o data lake esteja bem organizado e pronto para análises downstream e cargas de trabalho de IA.

Práticas recomendadas para usar o Azure Data Factory

Por fim, vale a pena revisar algumas práticas recomendadas para usar o ADF de forma eficaz.

1. Projeto modular de tubulação

Para criar fluxos de trabalho manuteníveis e dimensionáveis, projete pipelines com componentes reutilizáveis. O design modular facilita a depuração, o teste e a atualização de seções individuais do pipeline. Por exemplo, em vez de incorporar a lógica de transformação de dados em cada pipeline, crie um pipeline reutilizável que possa ser invocado em vários fluxos de trabalho. Isso reduz a redundância e aumenta a consistência entre os projetos.

2. Otimize a movimentação de dados

- Use a compressão: Para minimizar o tempo de transferência de dados e reduzir o uso da largura de banda da rede, comprima conjuntos de dados grandes antes de movê-los. Por exemplo, o uso do gzip ou de métodos semelhantes pode acelerar significativamente a movimentação de arquivos grandes.

- Selecione o tempo de execução de integração correto: A escolha do tempo de execução da integração (Azure IR, Self-hosted IR ou SSIS IR) é fundamental para otimizar o desempenho. Por exemplo, o IR auto-hospedado pode ser usado para a movimentação de dados no local para garantir transferências seguras e eficientes, enquanto o IR do Azure é ideal para operações nativas da nuvem.

3. Implementar um tratamento robusto de erros

- Políticas de repetição: Configure políticas de repetição para erros transitórios, como interrupções temporárias da rede ou tempo limite do servidor. Isso garante que os pipelines possam se recuperar e ser concluídos com êxito sem intervenção manual.

- Configure alertas: Implemente alertas e notificações para informar proativamente sua equipe sobre pipeline falhas ou problemas de desempenho. Use ferramentas como o Azure Monitor para configurar alertas personalizados com base em tipos de erro específicos ou atrasos de execução, garantindo uma resolução rápida e um tempo de inatividade mínimo.

Então, qual é a diferença entre o Azure Data Factorye o Databricks? Se você estiver curioso e quiser descobrir as diferenças entre o Azure Data Factory e o Databricks, consulte Azure Data Factory vs Databricks: Uma comparação detalhada blog.

Conclusão

O Azure Data Factory simplifica o processo de criação, gerenciamento e dimensionamento de pipelines de dados na nuvem. Ele fornece uma plataforma intuitiva que atende a usuários técnicos e não técnicos, permitindo que eles integrem e transformem dados de várias fontes com eficiência.

Ao aproveitar seus recursos, como criação de pipeline sem código, recursos de integração e ferramentas de monitoramento, os usuários podem criar facilmente fluxos de trabalho dimensionáveis e confiáveis.

Para saber mais sobre o Azure Data Factory, recomendo que você confira as 27 principais perguntas e respostas da entrevista sobre o Azure Data Factory.

Se você quiser explorar a espinha dorsal do Azure, incluindo tópicos como contêineres, máquinas virtuais e muito mais, minha recomendação é este incrível curso gratuito sobre Entendendo a arquitetura e os serviços do Microsoft Azure.