Cours

Azure Data Factory (ADF) est le service d'intégration de données basé sur le cloud de Microsoft, adapté aux organisations modernes. Il permet aux utilisateurs de concevoir, de gérer et d'automatiser les flux de travail qui traitent les tâches de déplacement et de transformation des données à l'échelle de l'entreprise.

ADF se distingue par son interface conviviale, sans code, qui permet aux utilisateurs techniques et non techniques de créer facilement des pipelines de données. Ses capacités d'intégration étendues prennent en charge plus de 90 connecteurs natifs, permettant la circulation des données entre diverses sources, y compris les systèmes sur site et les services basés sur le cloud.

Dans ce guide, j'offre une introduction complète à Azure Data Factory, couvrant ses composants et ses fonctionnalités et fournissant un tutoriel pratique pour vous aider à créer votre premier pipeline de données.

Qu'est-ce que Azure Data Factory ?

Azure Data Factory (ADF) est un service d'intégration de données basé sur le cloud, conçu pour orchestrer et automatiser les flux de données.

Il est utilisé pour collecter, transformer et fournir des données, en veillant à ce que les informations soient facilement accessibles pour l'analyse et la prise de décision.

Grâce à son architecture évolutive et sans serveur, ADF peut gérer des flux de travail de toute taille, qu'il s'agisse de simples migrations de données ou de pipelines de transformation de données complexes.

ADF comble le fossé entre les silos de données, permettant aux utilisateurs de déplacer et de transformer les données entre les systèmes sur site, les services cloud et les plateformes externes. Que vous travailliez avec des big data, des bases de données opérationnelles ou des API, Azure Data Factory fournit les outils nécessaires pour connecter, traiter et unifier les données de manière efficace.

Caractéristiques d'Azure Data Factory

Voici quelques-unes des principales caractéristiques de l'ADF.

1. Intégration des données

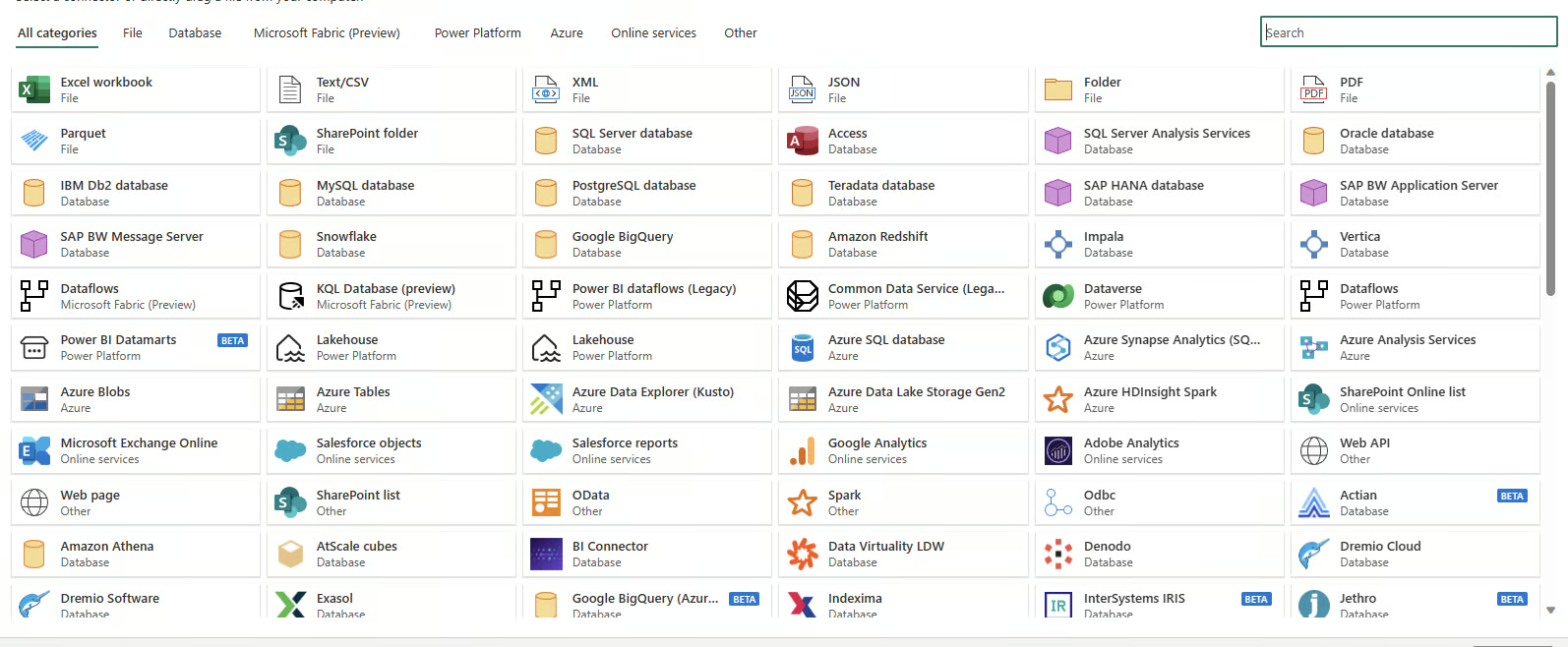

Azure Data Factory prend en charge l'intégration avec plus de 90 sources de données, y compris des systèmes basés sur le cloud et sur site. Il inclut la prise en charge des bases de données SQL, des systèmes NoSQL, des API REST et des sources de données basées sur des fichiers, ce qui vous permet d'unifier les flux de travail des données, quelle que soit la source ou le format.

Connecteurs de données disponibles dans Azure Data Factory

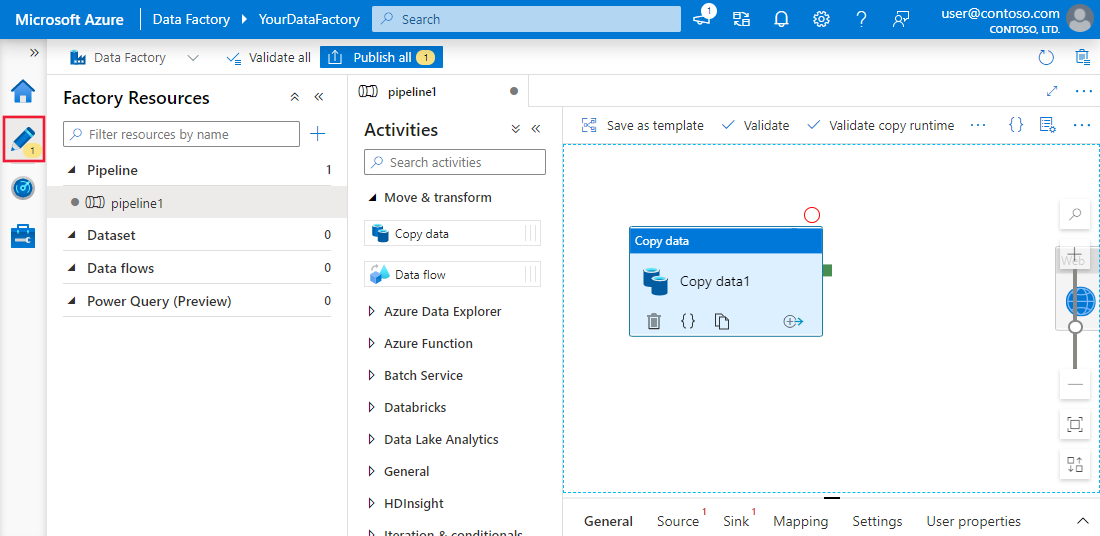

2. Création d'un pipeline sans code

L'interface "glisser-déposer" d'ADF simplifie la création de pipelines de données par les utilisateurs. Grâce à des modèles prédéfinis, à des assistants de configuration guidés et à un éditeur visuel intuitif, même les utilisateurs n'ayant aucune compétence en matière de codage peuvent concevoir des flux de travail complets de bout en bout.

Expérience de création sans code dans Azure Data Factory

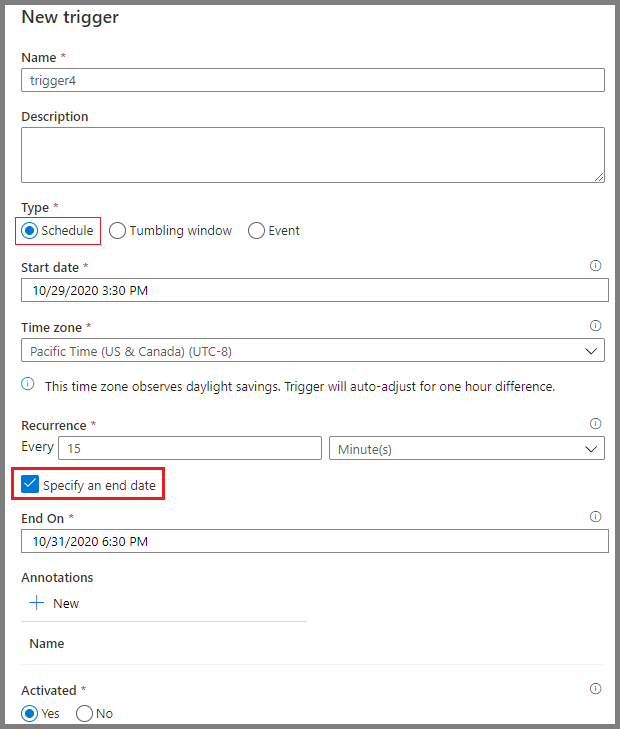

3. Programmation

Les outils de planification d'Azure Data Factory permettent d'automatiser les flux de travail. Les utilisateurs peuvent mettre en place des déclencheurs basés sur des conditions spécifiques, telles que l'arrivée d'un fichier dans le stockage cloud ou des intervalles de temps programmés. Ces options de planification éliminent le besoin d'interventions manuelles et garantissent une exécution cohérente et fiable des flux de travail.

Programmation de pipelines dans Azure Data Factory

Composants principaux d'Azure Data Factory

Il est essentiel de comprendre les composants de base d'Azure Data Factory pour créer des flux de travail efficaces.

1. Pipelines

Les pipelines constituent l'épine dorsale d'Azure Data Factory. Ils représentent des flux de travail axés sur les données qui définissent les étapes nécessaires pour déplacer et transformer les données.

Chaque pipeline sert de conteneur pour une ou plusieurs activités, exécutées séquentiellement ou en parallèle, afin d'obtenir le flux de données souhaité.

Ces pipelines permettent aux ingénieurs de données de créer des processus de bout en bout, tels que l'ingestion de données brutes, leur transformation dans un format utilisable et leur chargement dans des systèmes cibles.

Exemple de pipeline simple dans Azure Data Factory

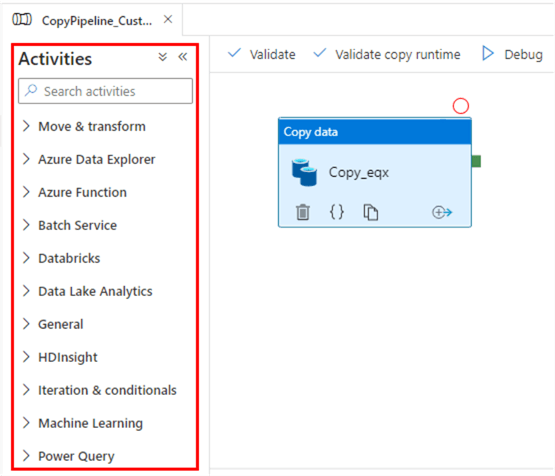

2. Activités

Les activités sont les éléments fonctionnels des pipelines, chacune effectuant une opération spécifique. Ils se répartissent en plusieurs catégories :

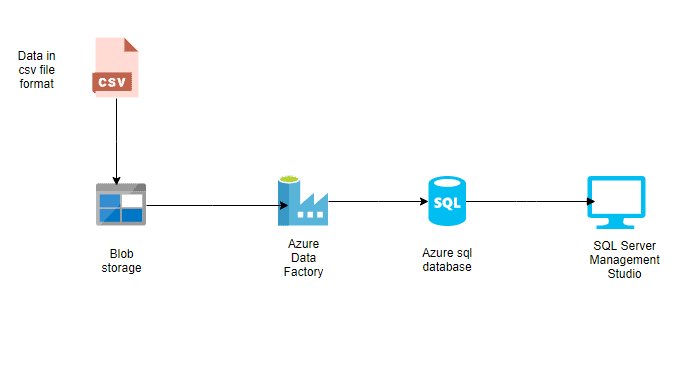

- Activités de circulation des données : Ces activités facilitent le transfert de données entre différents systèmes de stockage. Par exemple, l'activité "Copier les données" déplace les données d'Azure Blob Storage vers une base de données Azure SQL.

- Activités de transformation des données : Ces activités vous permettent de manipuler ou de traiter des données. Par exemple, les flux de données ou les scripts personnalisés peuvent être utilisés pour transformer les formats de données, agréger les valeurs ou nettoyer les ensembles de données.

- Contrôler les activités de flux : Ils gèrent le flux logique de l'exécution au sein des pipelines. Les exemples incluent le branchement conditionnel, les boucles et l'exécution parallèle, qui offrent une certaine flexibilité dans la gestion de flux de travail complexes.

Activités dans Azure Data Factory

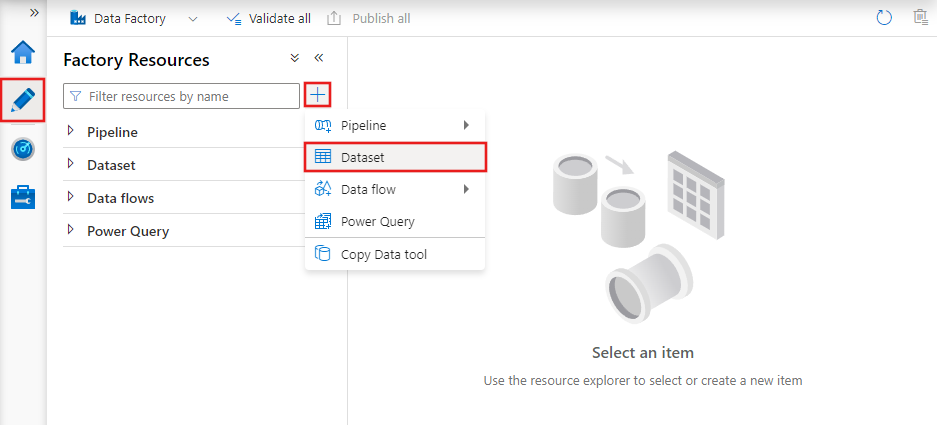

3. Ensembles de données

Les ensembles de données sont des représentations des données utilisées dans les activités. Ils définissent le schéma, le format et l'emplacement des données ingérées ou traitées.

Par exemple, un ensemble de données peut décrire un fichier CSV dans Azure Blob Storage ou un tableau dans une base de données Azure SQL. Les ensembles de données sont la couche intermédiaire qui relie les activités aux sources de données réelles et aux destinations.

Ensembles de données dans Azure Data Factory

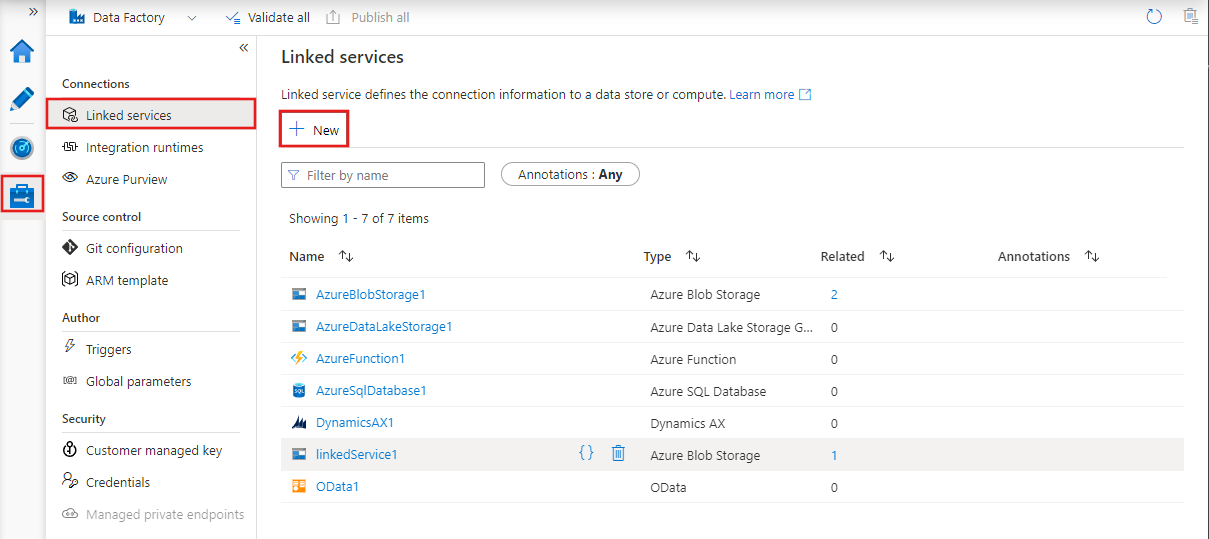

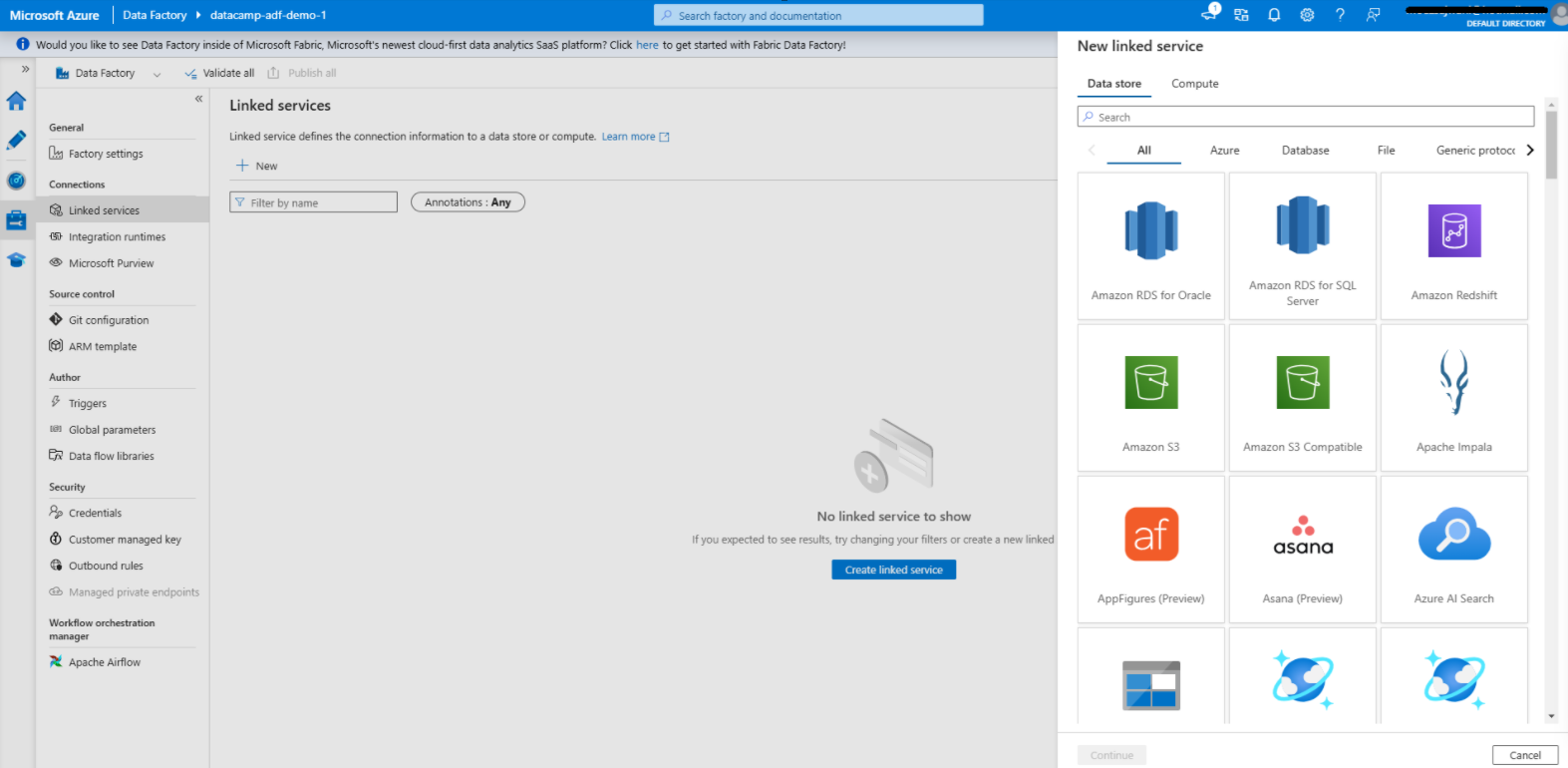

4. Services liés

Les services liés sont des chaînes de connexion qui permettent aux activités et aux ensembles de données d'accéder à des systèmes et services externes.

Ils servent de passerelles entre Azure Data Factory et les ressources externes avec lesquelles il interagit, telles que les bases de données, les comptes de stockage ou les environnements informatiques.

Par exemple, un service lié peut se connecter à un serveur SQL sur site ou à un lac de données basé dans le cloud.

Services liés dans Azure Data Factory

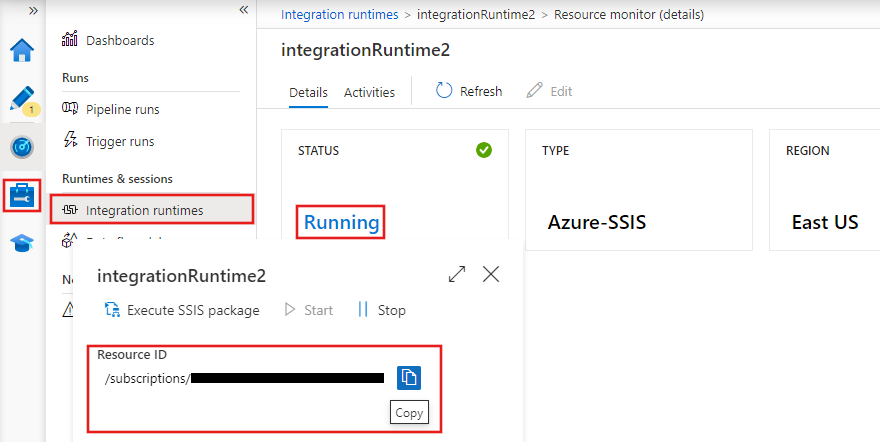

5. Temps d'exécution de l'intégration

Les runtimes d'intégration (IR) sont les environnements de calcul qui alimentent le mouvement des données, la transformation et l'exécution des activités au sein d'Azure Data Factory. ADF propose trois types d'exécution d'intégration :

- Azure IR : S'occupe des tâches d'intégration de données basées sur le cloud et est entièrement géré par Azure.

- RI auto-hébergée : Prend en charge le mouvement des données entre les systèmes sur site et le cloud, ce qui le rend idéal pour les scénarios hybrides.

- SSIS IR : Permet l'exécutionn des packages SQL Server Integration Services (SSIS) au sein d'Azure, ce qui vous permet de réutiliser les workflows SSIS existants dans le cloud.

Exécutions d'intégration dans Azure Data Factory

Maîtriser Azure de A à Z

Configuration d'Azure Data Factory

Passons maintenant à la partie pratique de ce guide !

1. Pré-requis

1. Un abonnement actif àe Azure.

2. Un groupe de ressources pour gérer lesressources Azure.

2. Créer une instance Azure Data Factory

1. Connectez-vous à sur le portail Azure.

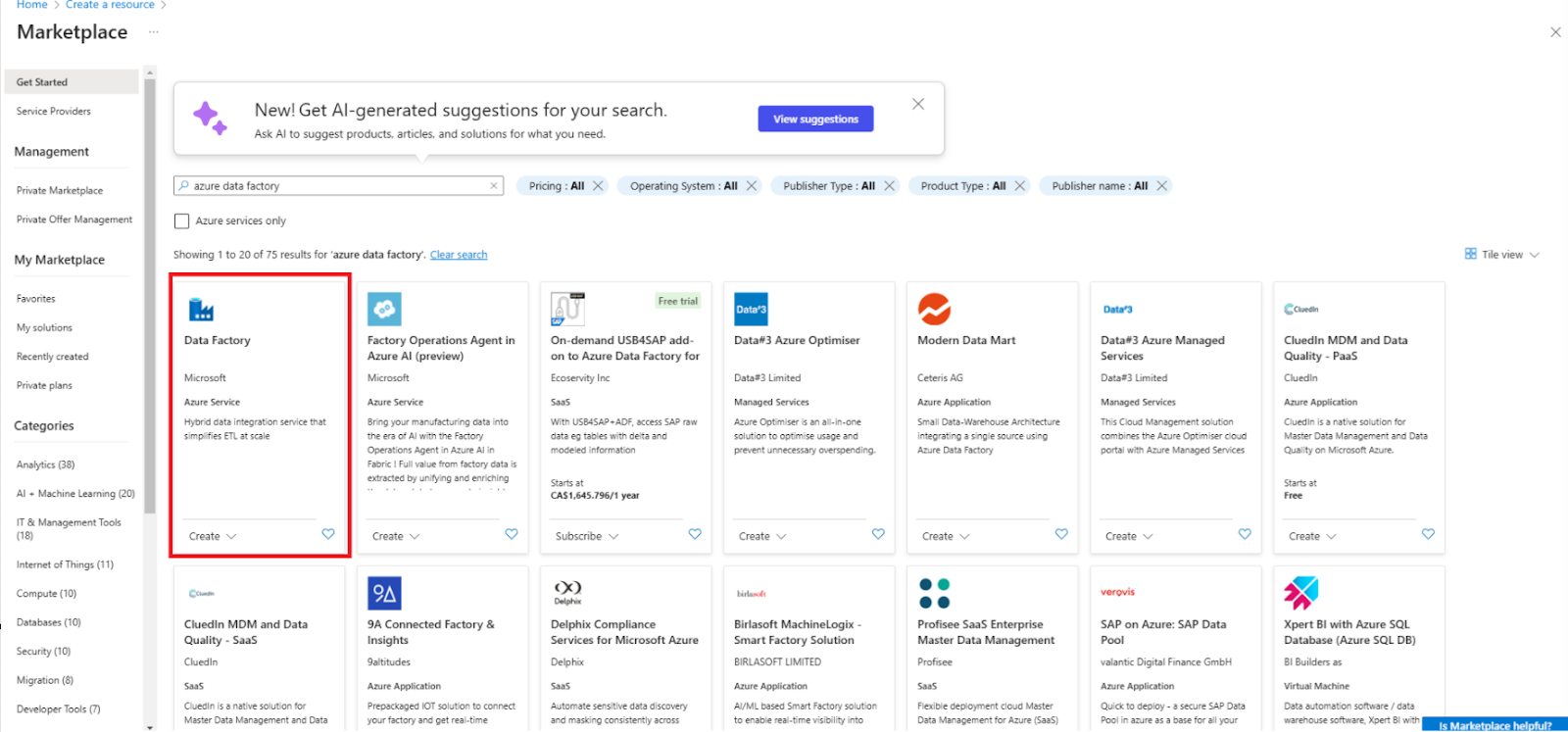

2. Allez sur Créer une ressource et sélectionnez Data Factory.

Créez une nouvelle ressource Data Factory

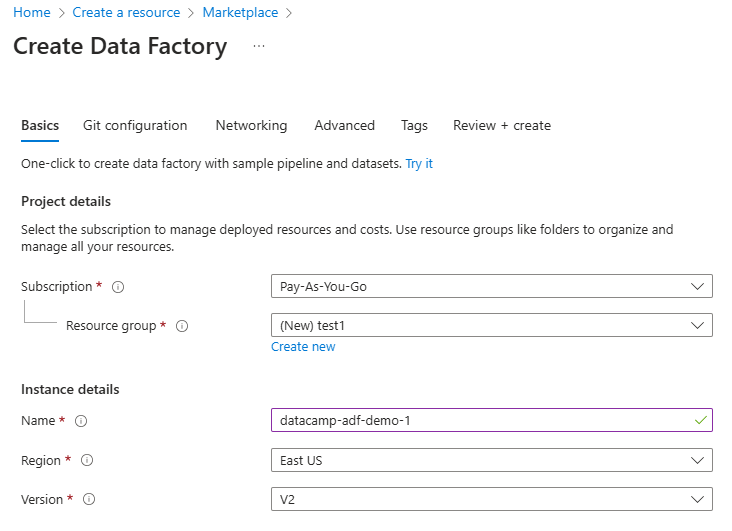

3. Remplissez les champs obligatoires, y compris l'abonnement, le groupe de ressources et la région.

Configurer la ressource Data Factory

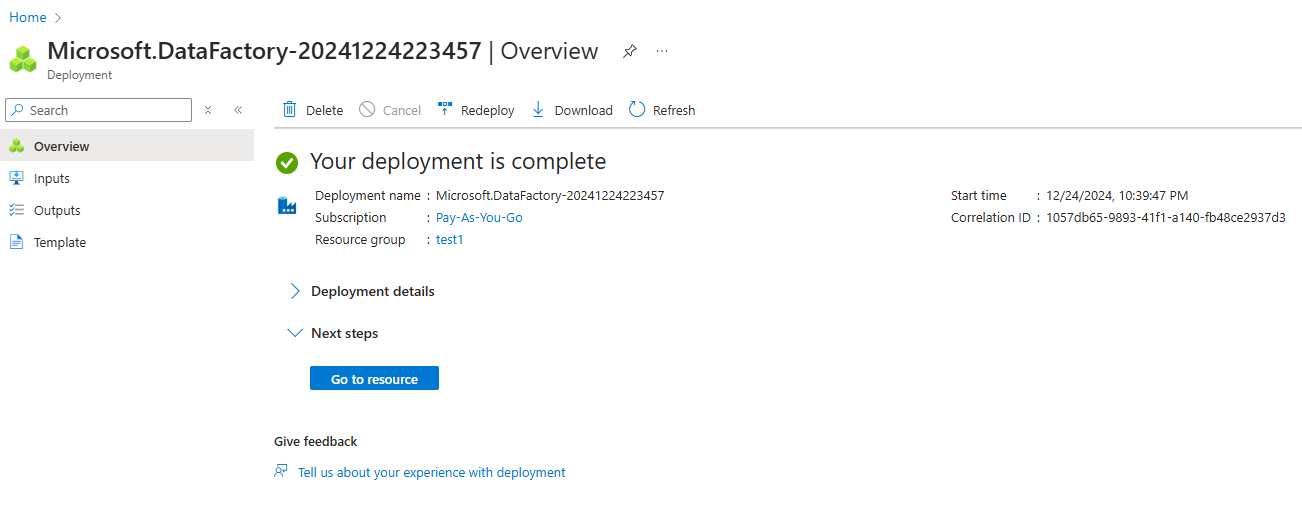

4. Examinez et créez l'instance.

Création d'une instance Azure Data Factory

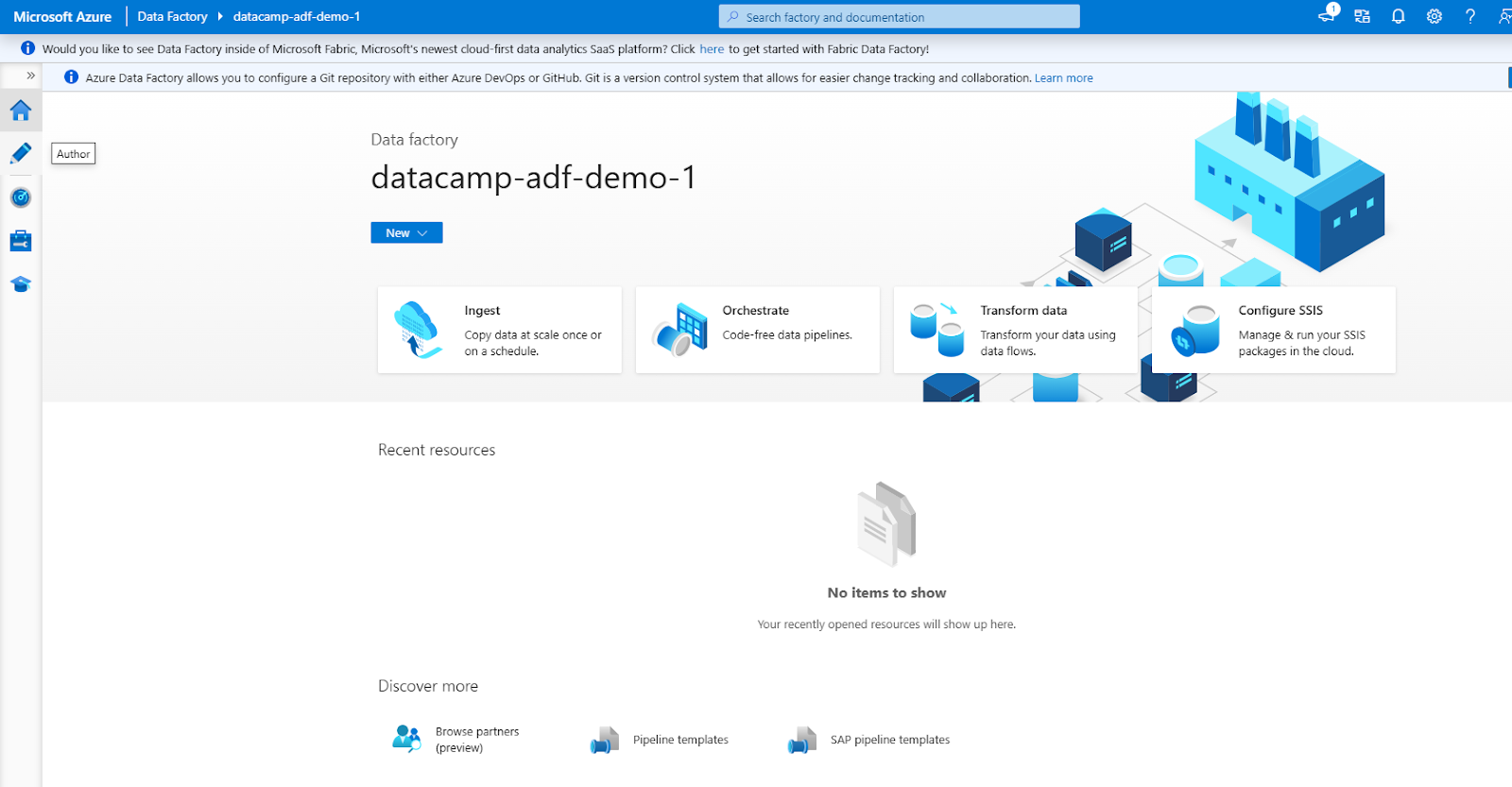

3. Navigation dans l'interface de l'ADF

L'interface de l'ADF se compose des sections principales suivantes (accessibles par le menu de navigation de gauche)

1. Auteur : Pour créer et gérer des pipelines.

2. Moniteur : Assurer le cursus du pipeline et résoudre les problèmes.

3. Gérer : Pour configurer les services liés et les runtimes d'intégration.

Interface Azure Data Factory

Construire votre premier pipeline dans Azure Data Factory

Voyons les étapes de la création d'un pipeline de données simple.

Étape 1 : Créer des services liés

Création d'un service lié dans Azure Data Factory

1. Naviguez vers l'onglet Gérer

- Ouvrez votre instance Azure Data Factory et allez sur l'ongletManage dans l'interface ADF. C'est ici que vous définissez les services liés, qui connectent vos sources et destinations de données.

2. Ajouter un service lié pour la source de données

- Cliquez sur Services liés sous l'onglet Gérer.

- Sélectionnez + Nouveau pour créer un nouveau service lié.

- Dans la liste des options disponibles, sélectionnez la source de données à laquelle vous souhaitez vous connecter, par exemple Azure Blob Azure.

- Fournissez les détails de connexion requis, tels que le nom du compte de stockage et la méthode d'authentification (par exemple, clé de compte ou identité gérée).

- Testez la connexion pour vous assurer que tout est correctement configuré, puis cliquez sur Créez.

3. Ajouter un service lié pour la destination des données

- Répétez le processus pour la destination des données, par exemple Azure SQL Database.

- Sélectionnez le type de destination approprié, configurez les paramètres de connexion (par exemple, le nom du serveur, le nom de la base de données et la méthode d'authentification) et testez la connexion.

- Une fois vérifié, enregistrez le service lié.

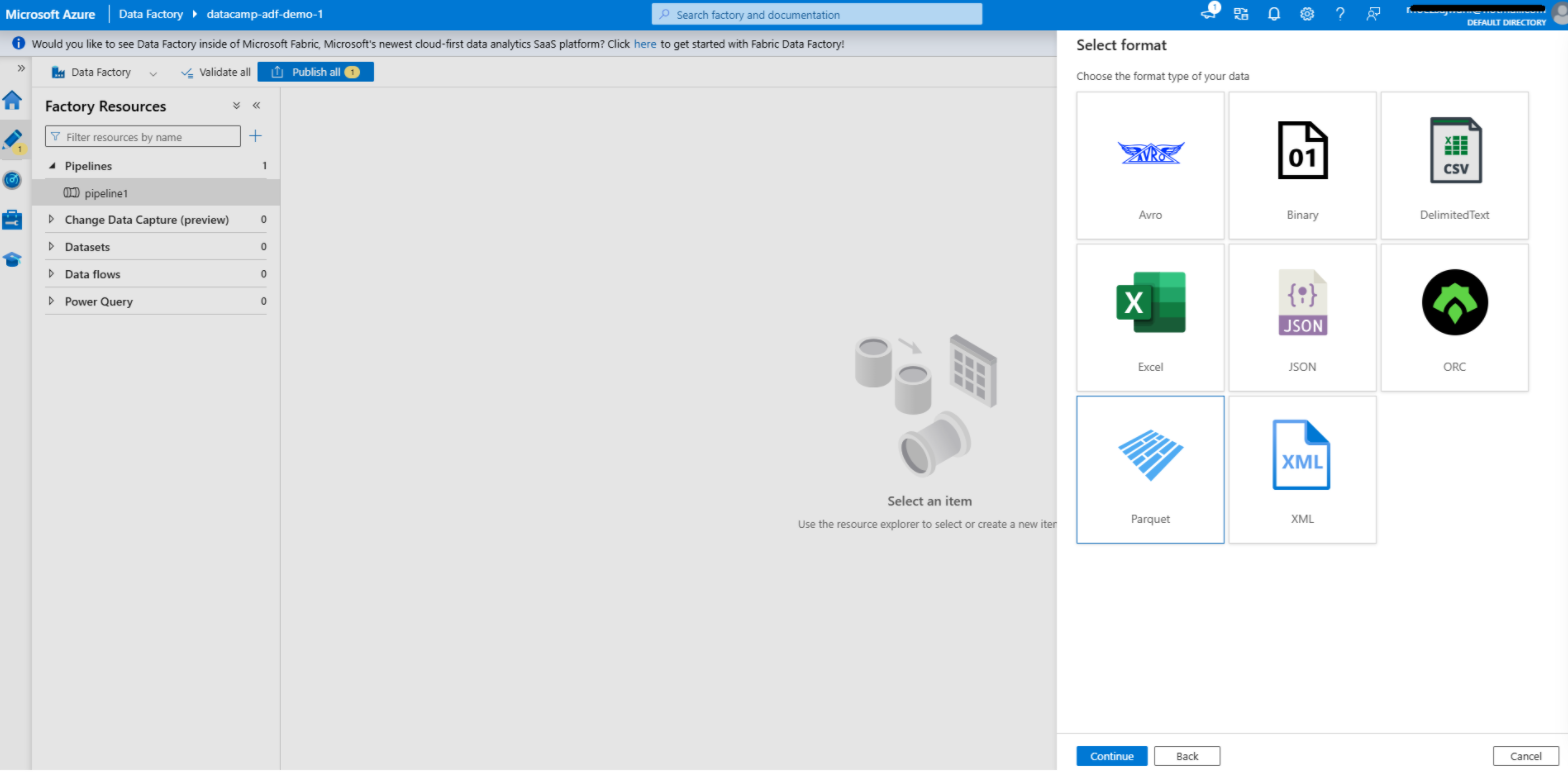

Étape 2 : Créer un jeu de données

Création d'un jeu de données dans Azure Data Factory

1. Accédez à l'onglet Auteur

- Ouvrez l'ongletAuthor dans votre interface Azure Data Factory. C'est ici que vous concevez et gérez vos pipelines, vos ensembles de données et d'autres composants du flux de travail.

2. Ajouter un jeu de données pour la source

- Cliquez sur le bouton + et sélectionnez Jeu de données dans le menu déroulant.

- Choisissez le type de magasin de données qui correspond à votre service lié à la source. Par exemple, si votre source est Azure Blob Storage, sélectionnez le type de magasin de données correspondant, tel que Delimited Text, Parquet , ou toute autre option pertinente.

- Configurez l'ensemble de données :

- Service lié : Sélectionnez le service lié que vous avez créé précédemment pour la source de données.

- Chemin d'accès au fichier : Indiquez le chemin d'accès ou le conteneur dans lequel se trouvent vos données sources.

- Schéma et format : Définissez le format des données (par exemple, CSV, JSON) et importez le schéma le cas échéant. Cela permet à l'ADF de comprendre la structure de vos données.

- Cliquez sur OK POUR ENREGISTRER LE JEU DE DONNÉES. pour enregistrer le jeu de données.

3. Ajouter un jeu de données pour la destination

- Répétez le processus pour l'ensemble de données de destination.

- Choisissez le type de magasin de données qui correspond à votre service lié de destination. Par exemple, si votre destination est Azure SQL Database, sélectionnez le type approprié, tel que Tableau.

- Configurez l'ensemble de données :

- Service lié : Sélectionnez le service lié que vous avez créé pour la destination.

- Nom du tableau ou chemin d'accès : Indiquez le tableau ou le chemin de destination où les données seront écrites.

- Schéma : Il est possible de définir ou d'importer le schéma de l'ensemble de données de destination afin d'assurer la compatibilité avec les données sources.

- Enregistrez le jeu de données.

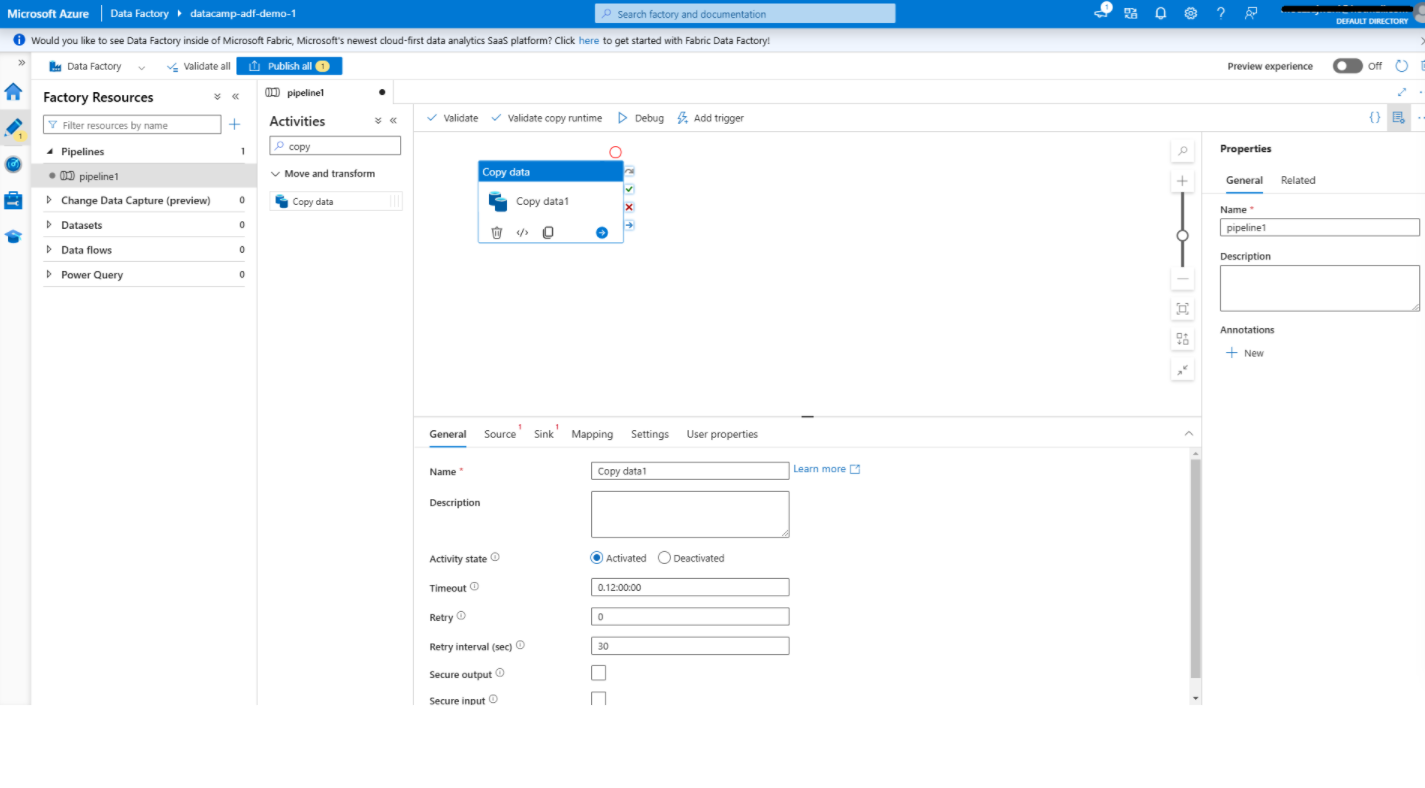

Étape 3 : Ajouter des activités

Ajouter une activité de copie de données dans Azure Data Factory

1. Ouvrez l'éditeur de pipeline

- Dans le Auteur créez un nouveau pipeline en cliquant sur + et en sélectionnant Pipeline.

- Cela ouvrira l'éditeur de pipeline, une interface visuelle où vous pouvez concevoir vos flux de données.

2. Ajoutez l'activité de copie de données

- Dans la boîte à outils située à gauche, localisez la fonction Copier les données sous l'activité Déplacer et transformer dans la catégorie Déplacer et transformer.

- Faites glisser l'activitéCopier les données sur le canevas. Cette activité permet de déplacer des données de la source à la destination.

3. Configurer l'activité de copie des données

- Cliquez sur le bouton Copier les données pour ouvrir son panneau de configuration.

- Sous la Source l'onglet

- Sélectionnez l'ensemble de données source que vous avez créé précédemment.

- Configurez des options supplémentaires telles que des filtres de fichiers ou de dossiers si nécessaire.

- Sous l'évier Plongez onglet :

- Sélectionnez le jeu de données de destination.

- Spécifiez d'autres paramètres, tels que la manière de traiter les données existantes dans la destination (par ex, écraser ou ajouter).

- Utilisez la fonction Mapping pour aligner les champs ou les colonnes de la source à la destination, afin d'assurer la compatibilité des données.

- Sauvegardez votre configuration.

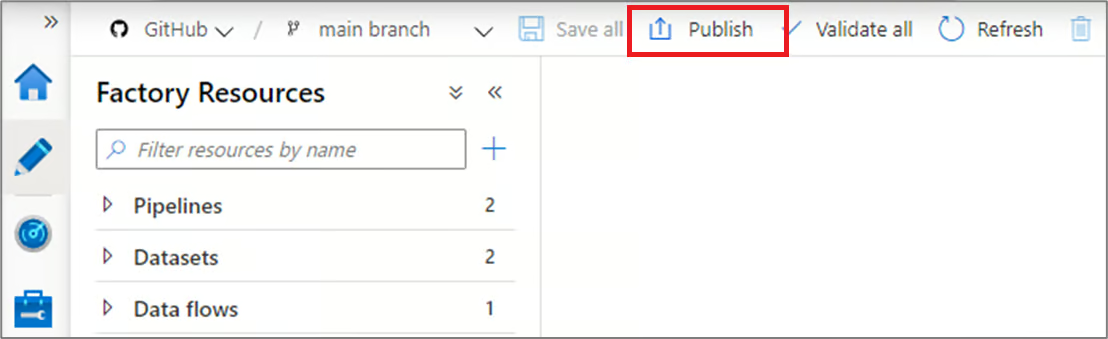

Étape 4 : Publier et exécuter le pipeline

Publier des pipelines dans Azure Data Factory

1. Publier votre pipeline

- Une fois votre pipeline configuré, cliquez sur Publier dans la barre d'outils.

- Cela permet de sauvegarder votre pipeline et de le rendre prêt à être exécuté. Sans publication, les modifications apportées à votre pipeline restent à l'état de projet et ne peuvent pas être exécutées.

2. Exécuter le pipeline

- Pour tester votre pipeline, cliquez sur Add Trigger en haut et sélectionnez Trigger Now pour une exécution manuelle. Cela vous permet de vérifier que le pipeline fonctionne comme prévu.

- Vous pouvez également mettre en place un programme automatisé :

- Allez à la page Déclencheurs et créez un nouveau déclencheur.

- Définissez les conditions de déclenchement, telles qu'un calendrier (par exemple, tous les jours à 8h00) ou une condition basée sur un événement (par exemple, l'arrivée d'un fichier dans Azure Blob Storage).

- Associez le déclencheur à votre pipeline pour permettre l'automatisation.

Capacités d'intégration et de transformation d'Azure Data Factory

Azure Data Factory offre de puissantes fonctionnalités d'intégration et de transformation des données qui simplifient les flux de travail complexes et améliorent la productivité. Dans cette section, nous allons passer en revue ces caractéristiques.

1. Flux de données

Data flows provide un environnement visuel pour définir la logique de transformation, ce qui facilite la manipulation et le traitement des données par les utilisateurs sans qu'ils aient à écrire un code complexe. Les tâches courantes effectuées avec les flux de données sont les suivantes

- Agrégations : Résumez les données pour en extraire des informations significatives, par exemple en calculant les ventes totales ou les performances moyennes.

- Rejoint : Combinez des données provenant de sources multiples pour créer des ensembles de données enrichies pour les processus en aval.

- Filtres : Sélectionnez des sous-ensembles spécifiques de données sur la base de critères définis, ce qui permet de se concentrer sur les informations pertinentes.

Les flux de données prennent également en charge des opérations avancées telles que les dérivations de colonnes, les conversions de types de données et les transformations conditionnelles, ce qui en fait des outils polyvalents permettant de répondre à diverses exigences en matière de données.

2. Intégration avec Azure Synapse Analytics

ADF s'intègre de manière transparente à Azure Synapse Analytics, ce qui permet de créer une plateforme unifiée pour le traitement des données volumineuses et l'analyse avancée (). Cette intégration permet aux utilisateurs de :

- Orchestrez les flux de données de bout en bout, y compris l'ingestion, la préparation et l'analyse des données.

- Tirez parti du puissant moteur de requête de Synapse pour traiter efficacement de vastes ensembles de données.

- Créez des pipelines de données qui alimentent directement Synapse Analyticspour l'apprentissage automatique et lescas d'utilisation de rapports.

Cette synergie entre ADF et Synapse permet de rationaliser les flux de travail et de réduire la complexité de la gestion d'outils distincts pour l'intégration et l'analyse des données.

3. Planification et suivi des pipelines

- Programmation : Comme nous l'avons mentionné, les capacités de planification de l'ADF offrent de solides fonctions d'automatisation. Les utilisateurs peuvent définir des déclencheurs basés sur des intervalles de temps (par exemple, toutes les heures, tous les jours) ou des événements (par exemple, l'arrivée d'un fichier surdans Azure Blob Storage).

- Contrôle : L'onglet Monitor dans Azure Data Factory, combinéavec Azure Monitor, fournites suivis et des diagnostics en temps réel pour les exécutions de pipeline. Les utilisateurs peuvent consulter des journaux détaillés, suivre les progrès réalisés et identifier rapidement les goulets d'étranglement ou les défaillances. Les alertes et les notifications peuvent également être configurées facilement.

Cas d'utilisation d'Azure Data Factory

Après un examen approfondi des caractéristiques et des composants de l'ADF, voyons à quoi il peut servir.

1. Migration des données

L'ADF est un outil puissant pour la migration des données des systèmes sur site vers des plateformes basées sur le cloud. Il simplifie les migrations complexes en automatisant le déplacement des données, en garantissant l'intégrité des données et en minimisant les temps d'arrêt.

Par exemple, vous pouvez utiliser ADF pour migrer des données d'un serveur SQL sur sitevers une base de données SQL Azure avecune intervention manuelle minimale. En s'appuyant sur des connecteurs intégrés et des runtimes d'intégration, ADF garantit un processus de migration sécurisé et efficace, prenant en charge les données structurées et non structurées.

2. ETL pour l'entreposage de données

Les processus d'extraction, de transformation et de chargement (ETL) sont au cœur des entrepôts de données modernes. Azure Data Factory rationalise ces flux de travail en intégrant des données provenant de sources multiples, en appliquant une logique de transformation et en les chargeant dans un entrepôt de données.

Par exemple, ADF peut consolider les données de vente de différentes régions, les transformer dans un format unifié et les charger dans Azure Synapse Analytics. Ce processus rationalisé vous permet de conserver des données actualisées et de haute qualité pour l'établissement de rapports et la prise de décision.

|

Découvrez les 23 meilleurs outils ETL en 2024 et pourquoi les choisir. |

3. Intégration de données pour les lacs de données

Les lacs de données servent de référentiel central pour divers ensembles de données, permettant des analyses avancées et l'apprentissage automatique. ADF facilite l'ingestion de données provenant de diverses sources dans Azure Data Lake Storage, en prenant en charge les scénarios de traitement par lots et en continu.

Par exemple, vous pouvez utiliser ADF pour collecter des fichiers journaux, des flux de médias sociaux et des données de capteurs IoT dans un lac de données unique. En fournissant des outils de transformation et d'intégration des données, ADF s'assure que le lac de données est bien organisé et prêt pour les charges de travail d'analyse et d'IA en aval.

Meilleures pratiques pour l'utilisation d'Azure Data Factory

Enfin, il convient de passer en revue les meilleures pratiques pour utiliser efficacement l'ADF.

1. Conception modulaire des pipelines

Pour créer des flux de travail maintenables et évolutifs, concevez des pipelines avec des composants réutilisables. La conception modulaire facilite le débogage, les essais et la mise à jour des différentes sections de la canalisation. Par exemple, au lieu d'intégrer une logique de transformation des données dans chaque pipeline, créez un pipeline réutilisable qui peut être invoqué dans plusieurs flux de travail. Cela permet de réduire les redondances et d'améliorer la cohérence entre les projets.

2. Optimiser le mouvement des données

- Utilisez la compression : Pour réduire les temps de transfert des données et l'utilisation de la bande passante du réseau, comprimez les grands ensembles de données avant de les déplacer. Par exemple, l'utilisation de gzip ou de méthodes similaires peut accélérer considérablement le déplacement de fichiers volumineux.

- Sélectionnez la bonne durée d'exécution de l'intégration : Le choix du moteur d'exécution de l'intégration (Azure IR, Self-hosted IR ou SSIS IR) est essentiel pour optimiser les performances. Par exemple, la RI auto-hébergée peut être utilisée pour les mouvements de données sur site afin de garantir des transferts sécurisés et efficaces, tandis que la RI Azure est idéale pour les opérations cloud-natives.

3. Mise en œuvre d'une gestion robuste des erreurs

- Politiques de réessai : Configurez des politiques de relance pour les erreurs transitoires, telles que les perturbations temporaires du réseau ou les dépassements de délai du serveur. Cela garantit que les pipelines peuvent se rétablir et s'achever sans intervention manuelle.

- Créez des alertes : Mettez en place des alertes et des notifications pour informer de manière proactive votre équipe des défaillances de pipeline ou des problèmes de performance. Utilisez des outils comme Azure Monitor pour configurer des alertes personnalisées basées sur des types d'erreurs spécifiques ou des retards d'exécution, afin de garantir une résolution rapide et un temps d'arrêt minimal.

En quoi Azure Data Factory est-il différentde Databricks ? Si vous êtes curieux et souhaitez découvrir les différences entre Azure Data Factory et Databricks, consultez Azure Data Factory vs Databricks : Une comparaison détaillée blog.

Conclusion

Azure Data Factory simplifie le processus de création, de gestion et de mise à l'échelle des pipelines de données dans le cloud. Il s'agit d'une plateforme intuitive qui s'adresse à la fois aux utilisateurs techniques et non techniques, leur permettant d'intégrer et de transformer efficacement des données provenant de différentes sources.

En tirant parti de ses fonctionnalités, telles que la création de pipelines sans code, les capacités d'intégration et les outils de surveillance, les utilisateurs peuvent facilement créer des flux de travail évolutifs et fiables.

Pour en savoir plus sur Azure Data Factory, je vous recommande de consulter le Top 27 Azure Data Factory Interview Questions and Answers.

Si vous souhaitez explorer l'épine dorsale d'Azure, y compris des sujets tels que les conteneurs, les machines virtuelles, et plus encore, je vous recommande ce cours gratuit extraordinaire sur la compréhension de l'architecture et des services Microsoft Azure.