Kurs

Azure Data Factory (ADF) ist Microsofts cloudbasierter Datenintegrationsdienst, der auf moderne Unternehmen zugeschnitten ist. Sie ermöglicht es den Nutzern, Workflows zu entwerfen, zu verwalten und zu automatisieren, die Datenbewegungen und -umwandlungen auf Unternehmensebene durchführen.

ADF zeichnet sich durch seine benutzerfreundliche, programmierfreie Oberfläche aus, die es sowohl technischen als auch nicht-technischen Nutzern ermöglicht, Datenpipelines einfach zu erstellen. Die umfangreichen Integrationsfunktionen unterstützen mehr als 90 native Konnektoren, die den Datenfluss über verschiedene Quellen hinweg ermöglichen, einschließlich lokaler Systeme und Cloud-basierter Dienste.

In diesem Leitfaden biete ich eine umfassende Einführung in die Azure Data Factory, in der ich auf die Komponenten und Funktionen eingehe und ein praktisches Tutorial anbiete, das dir hilft, deine erste Datenpipeline zu erstellen.

Was ist Azure Data Factory?

Azure Data Factory (ADF) ist ein Cloud-basierter Datenintegrationsdienst zur Orchestrierung und Automatisierung von Daten-Workflows.

Sie wird verwendet, um Daten zu sammeln, umzuwandeln und bereitzustellen und sicherzustellen, dass die Erkenntnisse für Analysen und Entscheidungen leicht zugänglich sind.

Mit seiner skalierbaren und serverlosen Architektur kann ADF Workflows jeder Größe bewältigen - von einfachen Datenmigrationen bis hin zu komplexen Datenumwandlungspipelines.

ADF überbrückt die Lücke zwischen Datensilos und ermöglicht es den Nutzern, Daten zwischen lokalen Systemen, Cloud-Diensten und externen Plattformen zu verschieben und zu transformieren. Ganz gleich, ob du mit Big Data, operativen Datenbanken oder APIs arbeitest, Azure Data Factory bietet die Werkzeuge, um Daten effizient zu verbinden, zu verarbeiten und zu vereinheitlichen.

Merkmale von Azure Data Factory

Hier sind einige der wichtigsten Funktionen, die ADF bietet.

1. Datenintegration

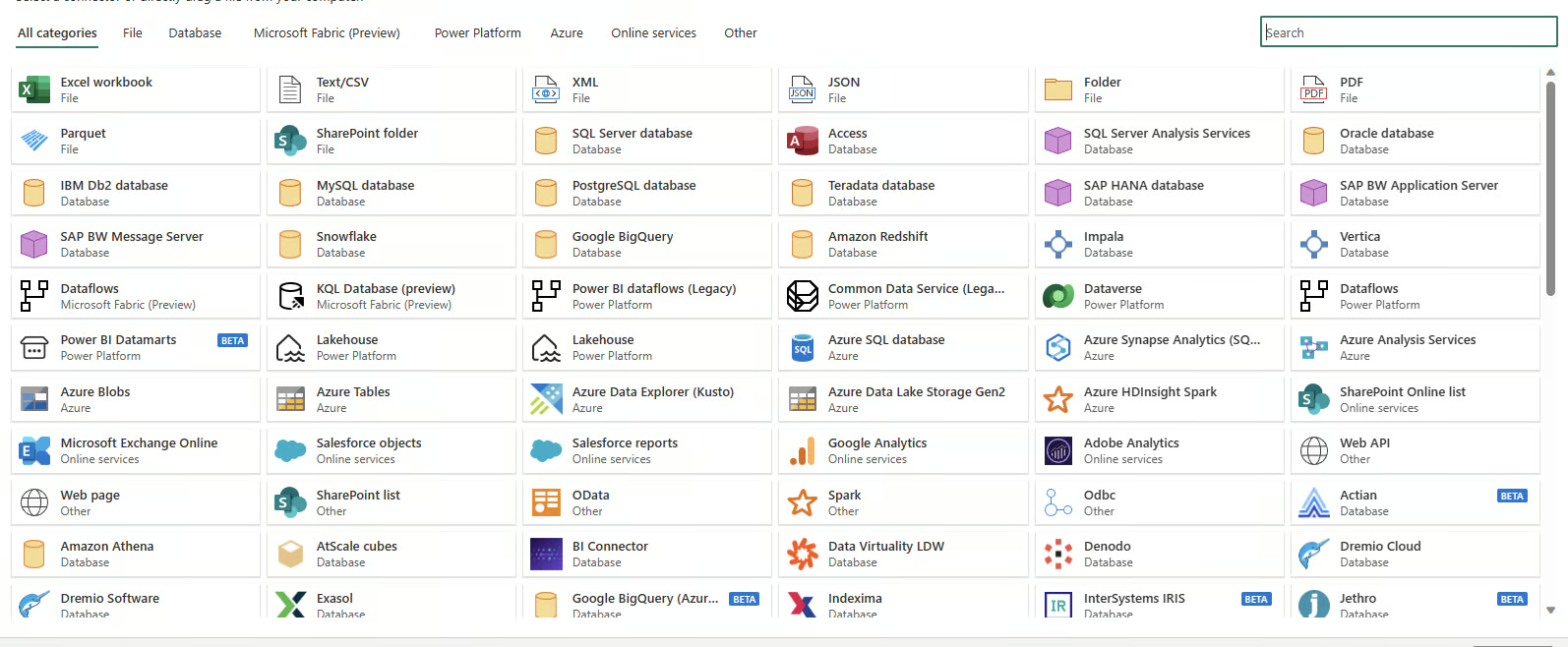

Azure Data Factory unterstützt die Integration von über 90 Datenquellen, darunter cloudbasierte und lokale Systeme. Sie unterstützt SQL-Datenbanken, NoSQL-Systeme, REST-APIs und dateibasierte Datenquellen und ermöglicht es dir, Datenworkflows unabhängig von der Quelle oder dem Format zu vereinheitlichen.

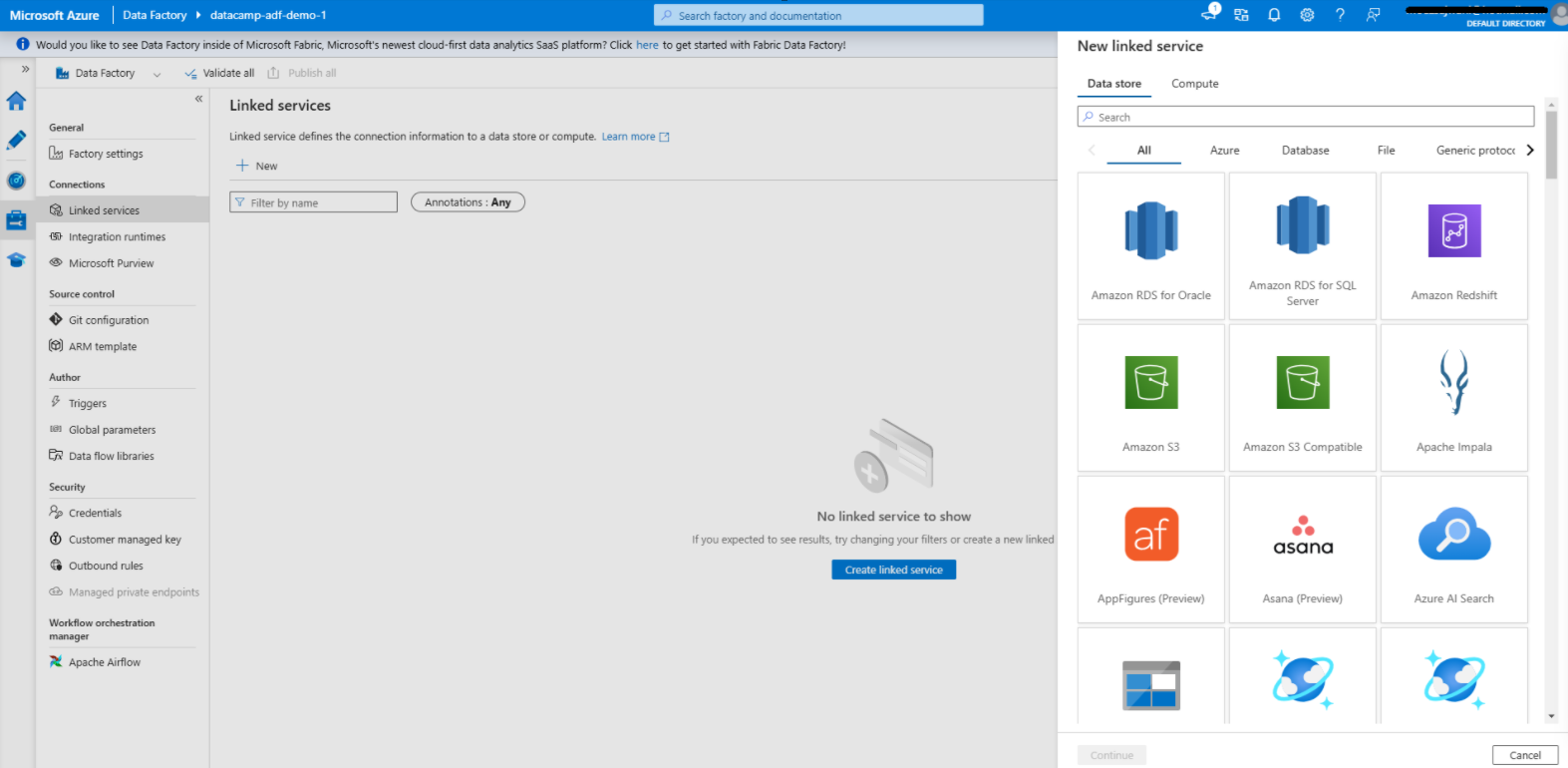

In Azure Data Factory verfügbare Datenkonnektoren

2. Pipeline-Authoring ohne Code

Die Drag-and-Drop-Schnittstelle von ADF vereinfacht die Erstellung von Datenpipelines. Mit vorgefertigten Vorlagen, geführten Konfigurationsassistenten und einem intuitiven visuellen Editor können auch Nutzer ohne Programmierkenntnisse umfassende End-to-End-Workflows erstellen.

Erfahrung mit No-Code-Authoring in Azure Data Factory

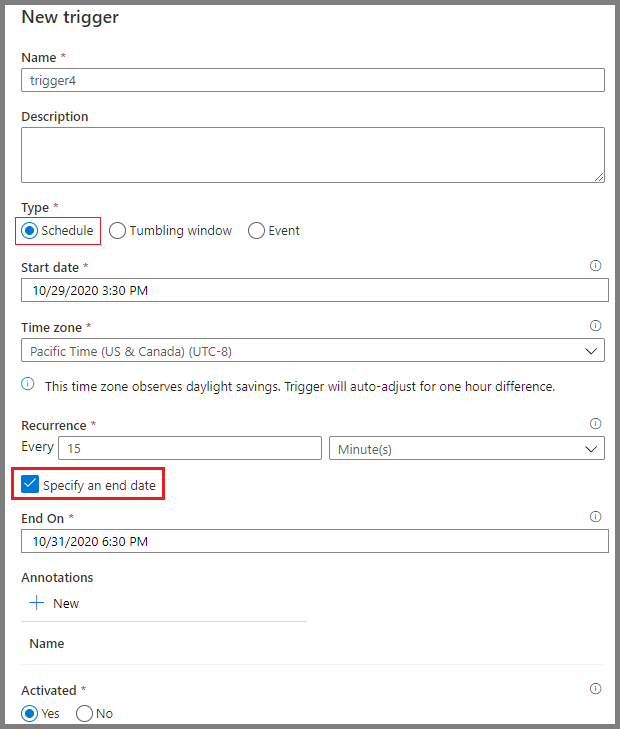

3. Terminplanung

Die Planungswerkzeuge von Azure Data Factory ermöglichen die Automatisierung von Arbeitsabläufen. Du kannst Auslöser einrichten, die auf bestimmten Bedingungen basieren, z. B. dem Eintreffen einer Datei im Cloud-Speicher oder geplanten Zeitintervallen. Diese Planungsoptionen machen manuelle Eingriffe überflüssig und stellen sicher, dass die Arbeitsabläufe konsistent und zuverlässig ausgeführt werden.

Planen von Pipelines in Azure Data Factory

Kernkomponenten der Azure Data Factory

Das Verständnis der Kernkomponenten von Azure Data Factory ist für den Aufbau effizienter Arbeitsabläufe unerlässlich.

1. Pipelines

Pipelines sind das Rückgrat der Azure Data Factory. Sie stellen datengesteuerte Workflows dar, die die Schritte definieren, die erforderlich sind, um Daten zu bewegen und umzuwandeln.

Jede Pipeline dient als Container für eine oder mehrere Aktivitäten, die sequentiell oder parallel ausgeführt werden, um den gewünschten Datenfluss zu erreichen.

Diese Pipelines ermöglichen es Dateningenieuren, End-to-End-Prozesse zu erstellen, z. B. Rohdaten aufzunehmen, sie in ein brauchbares Format umzuwandeln und sie in Zielsysteme zu laden.

Beispiel einer einfachen Pipeline in Azure Data Factory

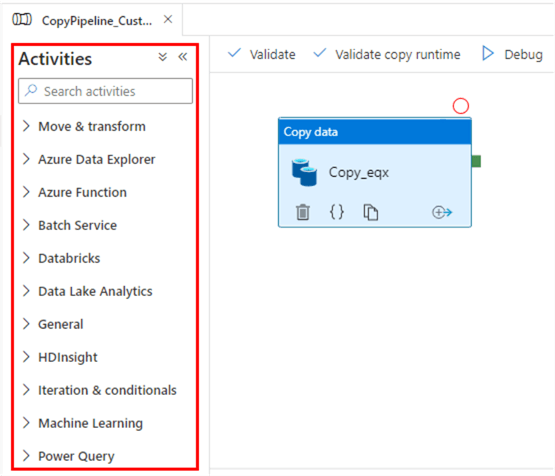

2. Aktivitäten

Aktivitäten sind die funktionalen Bausteine von Pipelines, die jeweils einen bestimmten Vorgang ausführen. Sie werden grob in folgende Kategorien eingeteilt:

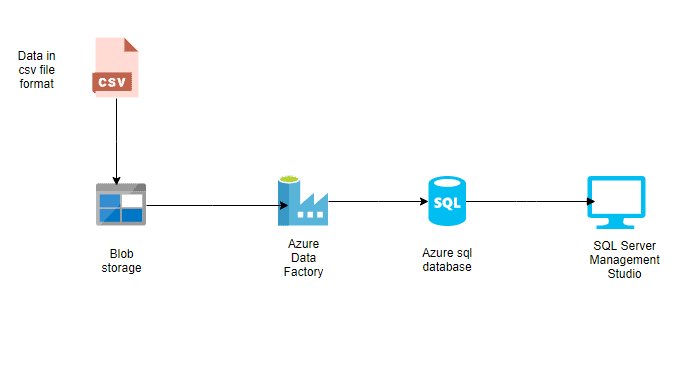

- Aktivitäten zur Datenbewegung: Diese Aktivitäten erleichtern den Datentransfer zwischen verschiedenen Speichersystemen. Die Aktivität "Daten kopieren" verschiebt zum Beispiel Daten von Azure Blob Storage in eine Azure SQL-Datenbank.

- Aktivitäten zur Datenumwandlung: Diese Aktivitäten ermöglichen es dir, Daten zu manipulieren oder zu verarbeiten. Datenflüsse oder benutzerdefinierte Skripte können zum Beispiel verwendet werden, um Datenformate umzuwandeln, Werte zu aggregieren oder Datensätze zu bereinigen.

- Kontrolliere die Flussaktivitäten: Diese verwalten den logischen Ablauf der Ausführung innerhalb der Pipelines. Beispiele dafür sind bedingte Verzweigungen, Schleifen und parallele Ausführung, die Flexibilität bei der Handhabung komplexer Arbeitsabläufe bieten.

Aktivitäten in Azure Data Factory

3. Datensätze

Datensätze sind Darstellungen von Daten, die in Aktivitäten verwendet werden. Sie definieren das Schema, das Format und den Ort der Daten, die aufgenommen oder verarbeitet werden.

Ein Dataset kann zum Beispiel eine CSV-Datei in Azure Blob Storage oder eine Tabelle in einer Azure SQL-Datenbank beschreiben. Datensätze sind die Zwischenschicht, die die Aktivitäten mit den eigentlichen Datenquellen und -zielen verbindet.

Datensätze in Azure Data Factory

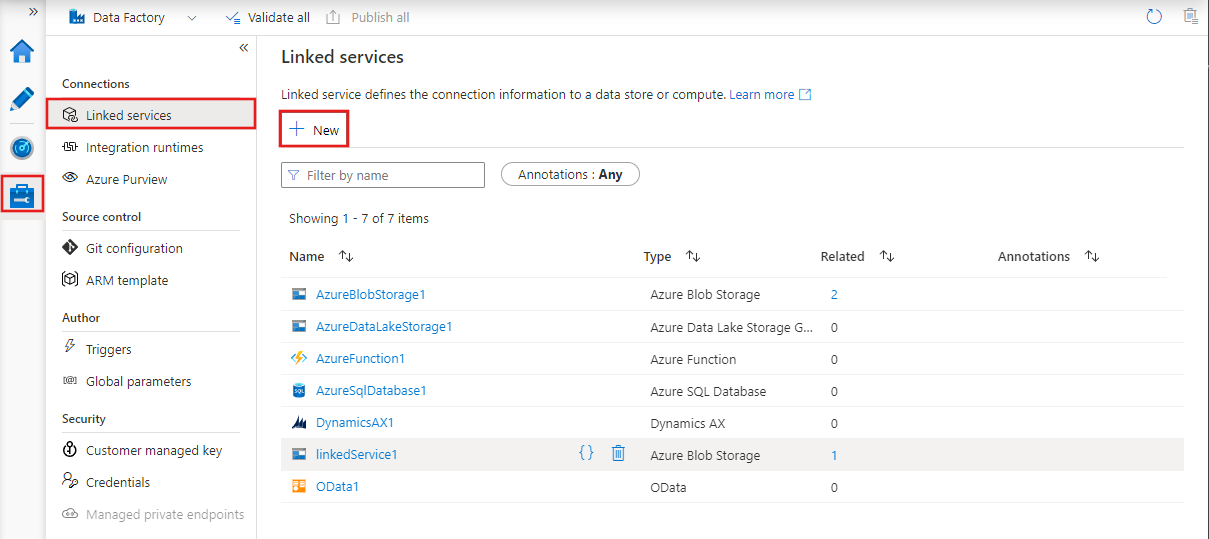

4. Verknüpfte Dienste

Verknüpfte Dienste sind Verbindungsstränge, die es Aktivitäten und Datensätzen ermöglichen, auf externe Systeme und Dienste zuzugreifen.

Sie fungieren als Brücke zwischen Azure Data Factory und den externen Ressourcen, mit denen sie interagiert, wie Datenbanken, Speicherkonten oder Rechenumgebungen.

Ein verlinkter Dienst kann sich zum Beispiel mit einem lokalen SQL Server oder einem Cloud-basierten Data Lake verbinden.

Verknüpfte Dienste in Azure Data Factory

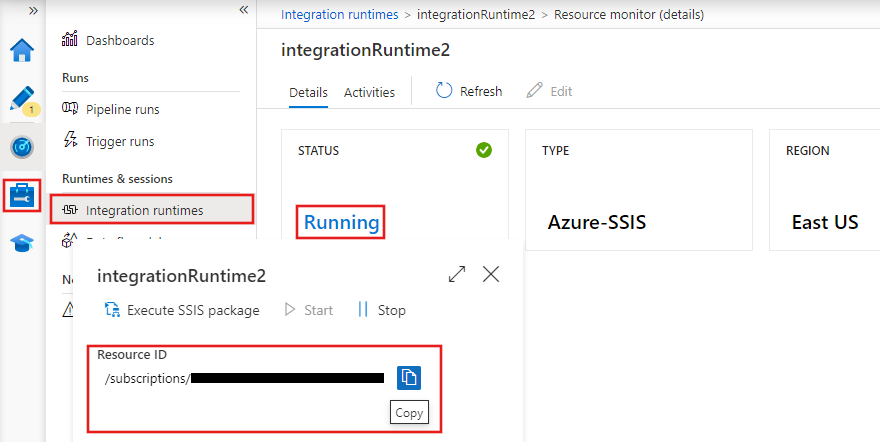

5. Laufzeiten für die Integration

Integration Runtimes (IRs) sind die Rechenumgebungen, die die Datenbewegung, -umwandlung und -ausführung in Azure Data Factory ermöglichen. ADF bietet drei Arten von Integrations-Laufzeiten:

- Azure IR: Erledigt cloudbasierte Datenintegrationsaufgaben und wird vollständig von Azure verwaltet.

- Selbstgehostete IR: Unterstützt den Datenaustausch zwischen lokalen Systemen und der Cloud und ist damit ideal für hybride Szenarien.

- SSIS IR: Ermöglicht die Ausführungn von SQL Server Integration Services (SSIS) -Paketen in Azure, so dass du bestehende SSIS-Workflows in der Cloud wiederverwenden kannst.

Integrations-Laufzeiten in Azure Data Factory

Azure von Grund auf beherrschen

Azure Data Factory einrichten

Kommen wir nun zum praktischen Teil dieses Leitfadens!

1. Voraussetzungen

1. Ein aktivese Azure-Abonnement.

2. Eine Ressourcengruppe zur Verwaltung vonAzure-Ressourcen.

2. Erstellen einer Azure Data Factory-Instanz

1. Melde dich auf im Azure-Portal an.

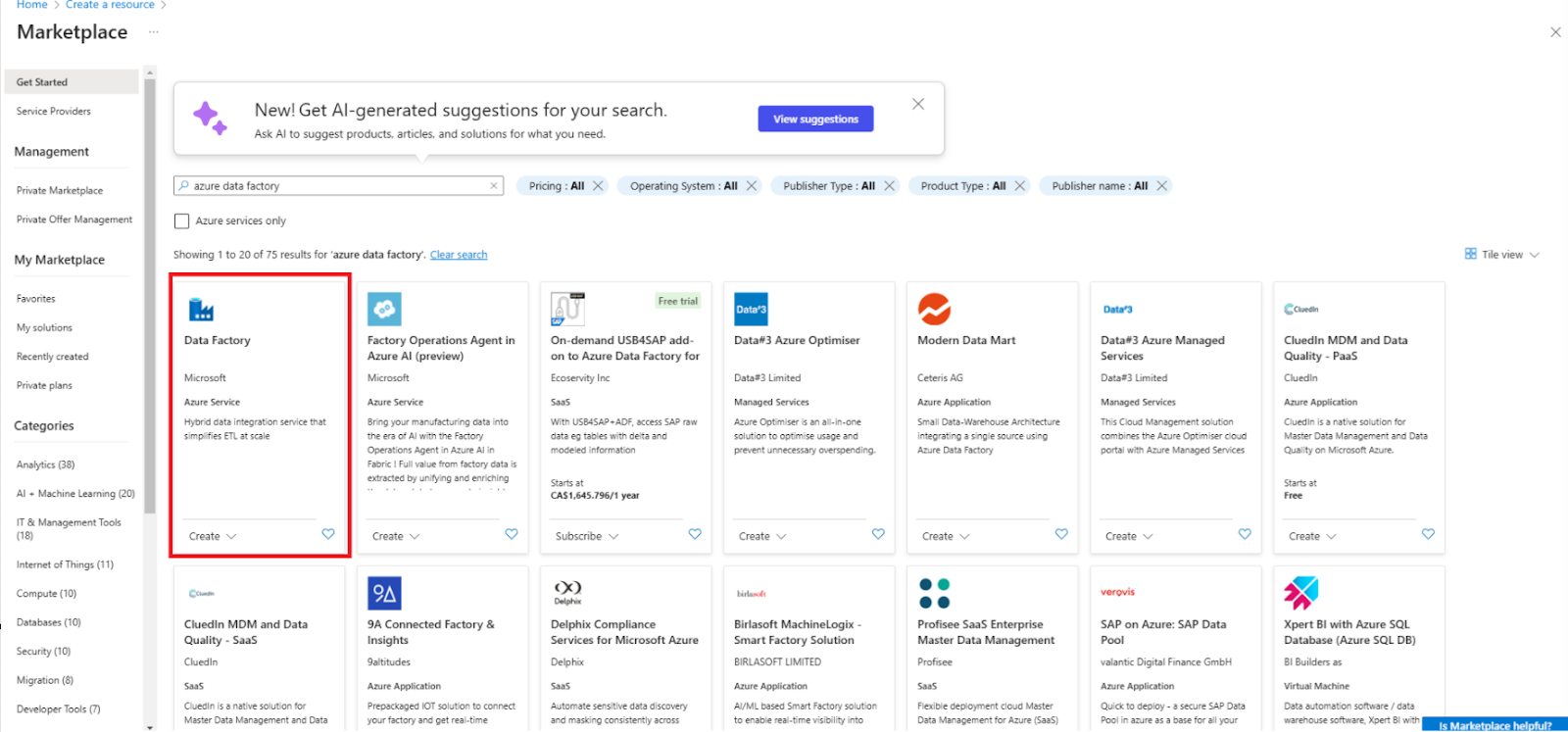

2. Navigiere zu Ressource erstellen und wähle Data Factory.

Erstelle eine neue Data Factory Ressource

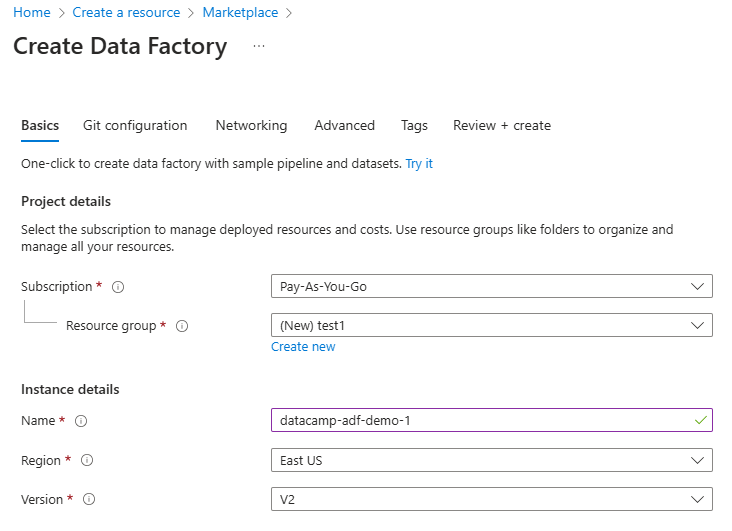

3. Fülle die erforderlichen Felder aus, einschließlich Abonnement, Ressourcengruppe und Region.

Data Factory Ressource konfigurieren

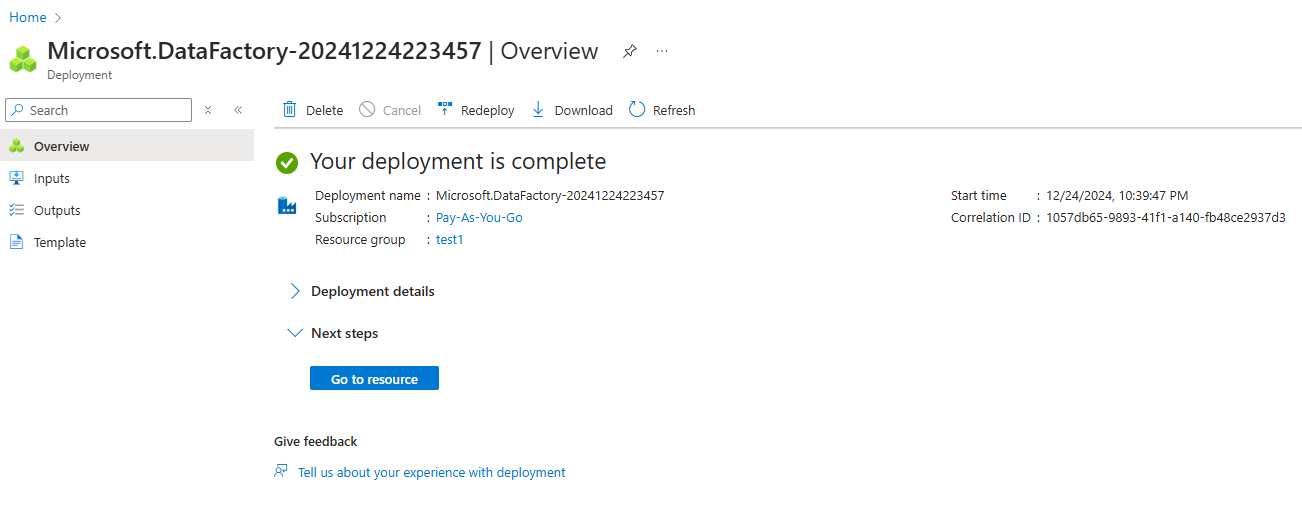

4. Überprüfe und erstelle die Instanz.

Azure Data Factory Instanz erstellt

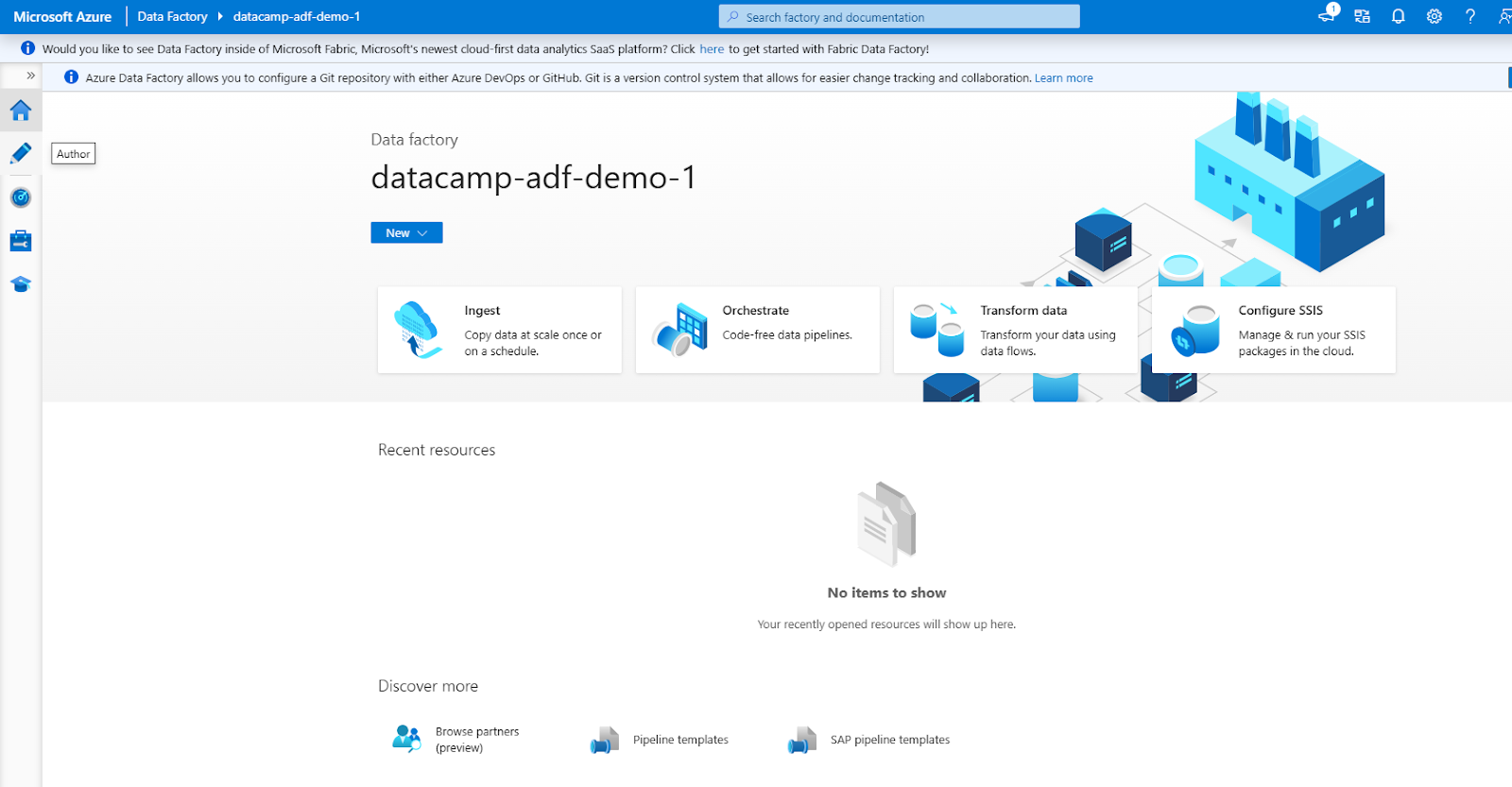

3. Navigieren in der ADF-Oberfläche

Die ADF-Oberfläche besteht aus den folgenden Hauptabschnitten (erreichbar über das linke Navigationsmenü)

1. Autor: Zum Erstellen und Verwalten von Pipelines.

2. Monitor: Um Lernpfade zu verfolgen und Probleme zu beheben.

3. Verwalte: Für die Konfiguration von verknüpften Diensten und Integrationslaufzeiten.

Azure Data Factory Interface

Aufbau deiner ersten Pipeline in Azure Data Factory

Gehen wir die Schritte durch, um eine einfache Datenpipeline zu erstellen.

Schritt 1: Verknüpfte Dienste erstellen

Verknüpften Dienst in Azure Data Factory erstellen

1. Navigiere zur Registerkarte Verwalten

- Öffne deine Azure Data Factory-Instanz und gehe in der ADF-Oberfläche auf die RegisterkarteVerwalten. Hier definierst du verknüpfte Dienste, die deine Datenquellen und -ziele miteinander verbinden.

2. Füge einen verknüpften Dienst für die Datenquelle hinzu

- Klick auf Verknüpfte Dienste unter der Registerkarte Verwalten.

- Wähle + Neu um einen neuen verknüpften Dienst zu erstellen.

- Wählen Sie aus der Liste der verfügbaren Optionen die Datenquelle aus, mit der Sie sich verbinden möchten, z. B. Azure Blob Speicher.

- Gib die erforderlichen Verbindungsdetails an, z. B. den Namen des Speicherkontos und die Authentifizierungsmethode (z. B. Kontoschlüssel oder verwaltete Identität).

- Testen Sie die Verbindung, um sicherzustellen, dass alles richtig eingerichtet ist, und klicken Sie auf erstellen..

3. Füge einen verknüpften Dienst für das Datenziel hinzu

- Wiederholen Sie den Vorgang für das Datenziel, z. B. Azure SQL-Datenbank.

- Wähle den entsprechenden Zieltyp, konfiguriere die Verbindungseinstellungen (z. B. Servername, Datenbankname und Authentifizierungsmethode) und teste die Verbindung.

- Wenn du dich vergewissert hast, speicherst du den verlinkten Dienst.

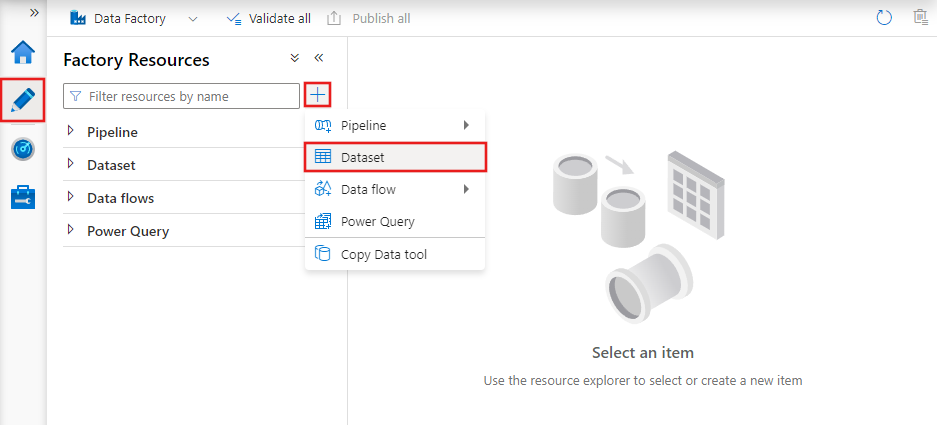

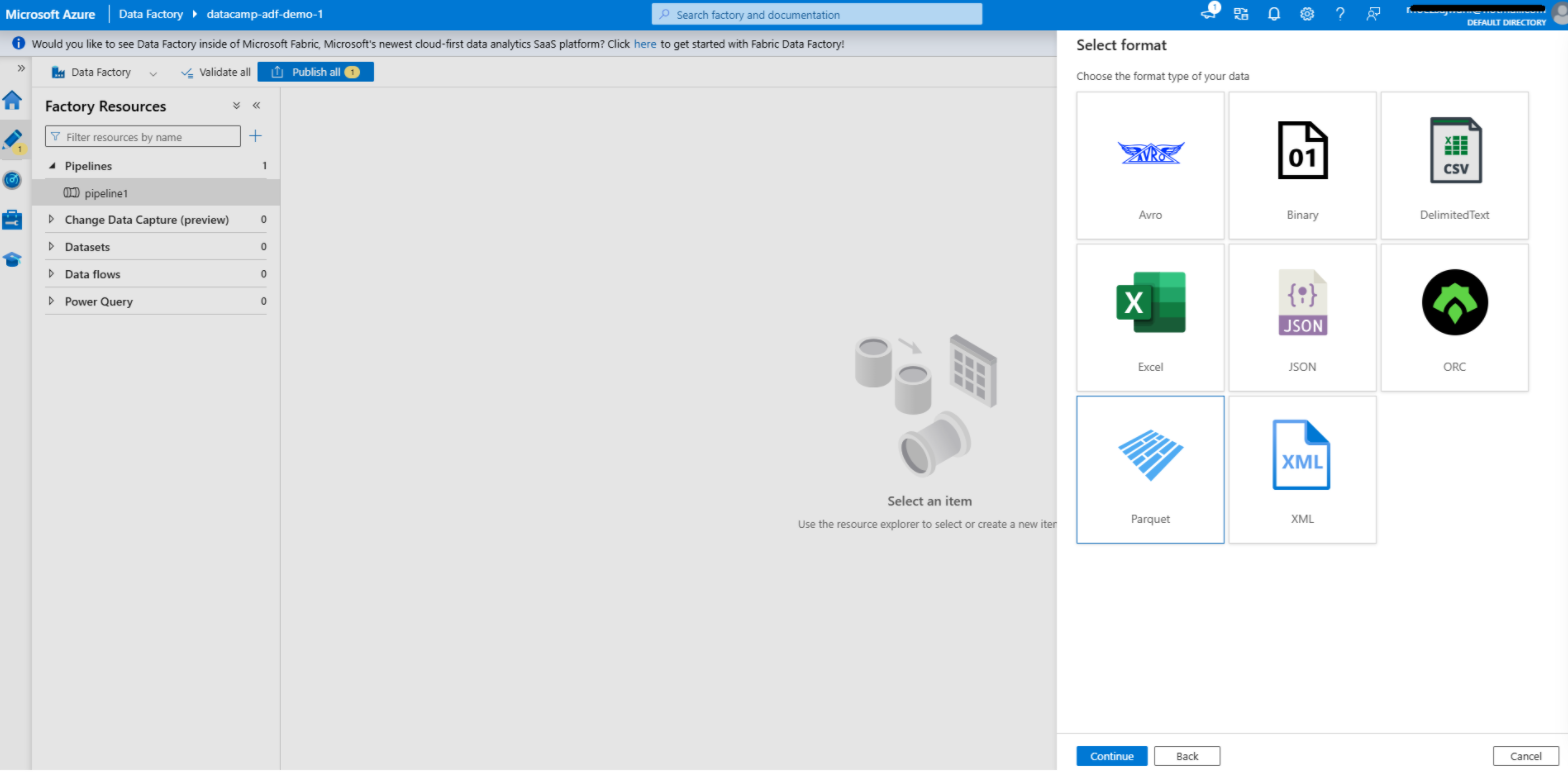

Schritt 2: Einen Datensatz erstellen

Erstellen eines Datensatzes in Azure Data Factory

1. Navigiere zur Registerkarte "Autor

- Öffne die RegisterkarteAutor in deiner Azure Data Factory-Oberfläche. Hier entwirfst und verwaltest du deine Pipelines, Datensätze und andere Workflow-Komponenten.

2. Hinzufügen eines Datensatzes für die Quelle

- Klicken Sie auf das + Schaltfläche und wähle Datensatz aus dem Dropdown-Menü aus.

- Wähle den Datenspeichertyp, der zu deinem verknüpften Quelldienst passt. Wenn deine Quelle zum Beispiel Azure Blob Storage ist, wähle den entsprechenden Datenspeichertyp aus, wie z.B. Delimited Text, Parquet oder eine andere relevante Option.

- Konfiguriere das Dataset:

- Verknüpfter Dienst: Wähle den verknüpften Dienst aus, den du zuvor für die Datenquelle erstellt hast.

- Dateipfad: Gib den Pfad oder Container an, in dem sich deine Quelldaten befinden.

- Schema und Format: Lege das Datenformat fest (z. B. CSV, JSON) und importiere das Schema, falls zutreffend. Dies ermöglicht es ADF, die Struktur deiner Daten zu verstehen.

- Klicke auf OK um den Datensatz zu speichern.

3. Hinzufügen eines Datensatzes für das Ziel

- Wiederhole den Vorgang für den Zieldatensatz.

- Wähle den Datenspeichertyp, der zu deinem verknüpften Zieldienst passt. Wenn dein Ziel z.B. Azure SQL Database ist, wähle den entsprechenden Typ, z.B. Tabelle.

- Konfiguriere das Dataset:

- Verknüpfter Dienst: Wähle den verknüpften Dienst aus, den du für das Ziel erstellt hast.

- Tabellenname oder Pfad: Gib die Tabelle oder den Zielpfad an, in den die Daten geschrieben werden sollen.

- Schema: Definiere oder importiere optional das Schema für den Zieldatensatz, um die Kompatibilität mit den Quelldaten sicherzustellen.

- Speichere den Datensatz.

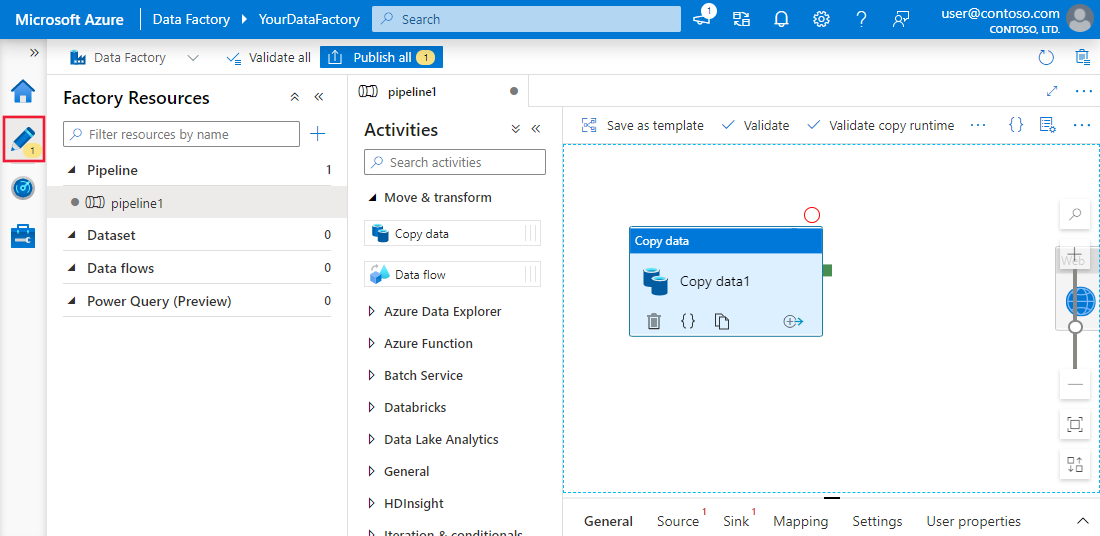

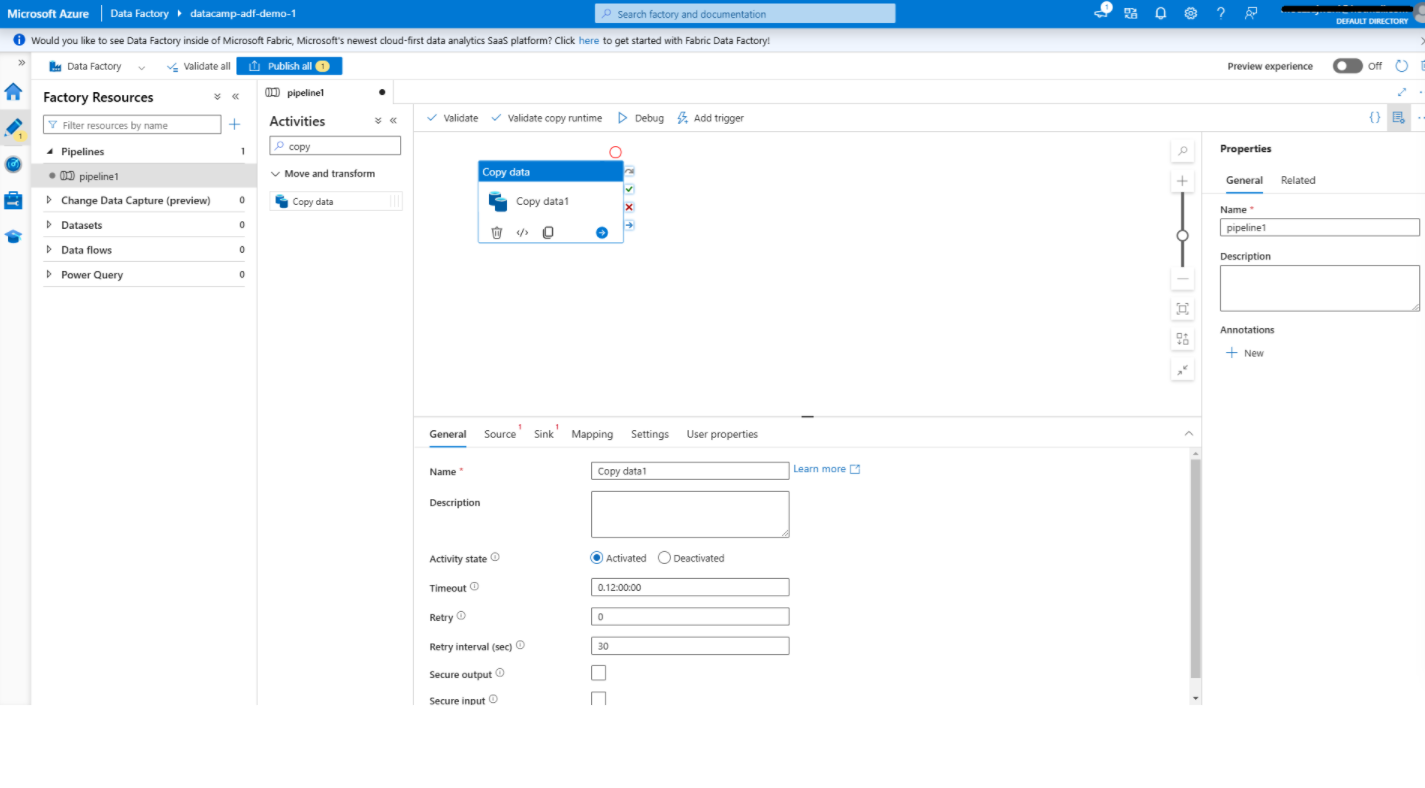

Schritt 3: Aktivitäten hinzufügen

Hinzufügen einer Aktivität zum Kopieren von Daten in Azure Data Factory

1. Öffne den Pipeline-Editor

- Im Autor erstellst du eine neue Pipeline, indem du auf + und wähle Pipeline.

- Dadurch wird der Pipeline-Editor geöffnet, eine visuelle Schnittstelle, mit der du deine Daten-Workflows gestalten kannst.

2. Füge die Aktivität Daten kopieren hinzu

- Suchen Sie in der Toolbox auf der linken Seite die Option Daten kopieren Aktivität unter dem Menüpunkt Verschieben & Transformieren Kategorie.

- Ziehe die AktivitätDaten kopieren auf die Leinwand. Bei dieser Aktivität werden Daten von der Quelle zum Ziel übertragen.

3. Konfiguriere die Aktivität Daten kopieren

- Klicken Sie auf die Schaltfläche Daten kopieren Aktivität, um den Einstellungsbereich zu öffnen.

- Unter der Quelle Registerkarte:

- Wähle den Quelldatensatz aus, den du zuvor erstellt hast.

- Konfiguriere bei Bedarf zusätzliche Optionen wie Datei- oder Ordnerfilter.

- Unter der Spüle tab:

- Wähle den Zieldatensatz aus.

- Gib zusätzliche Einstellungen an, z. B. wie mit vorhandenen Daten im Ziel umgegangen werden soll (z. B., Überschreiben oder anhängen).

- Verwenden Sie die Mapping um die Felder oder Spalten von der Quelle auf das Ziel auszurichten und die Datenkompatibilität sicherzustellen.

- Speichere deine Konfiguration.

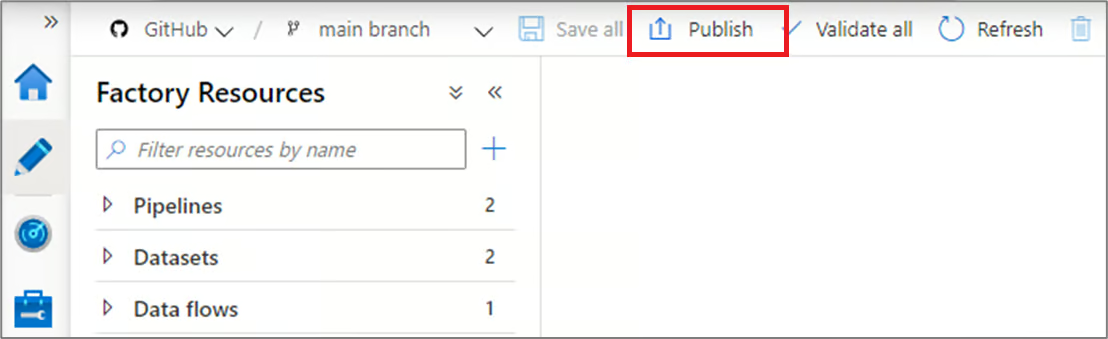

Schritt 4: Veröffentlichen und Ausführen der Pipeline

Veröffentlichung von Pipelines in Azure Data Factory

1. Veröffentliche deine Pipeline

- Sobald deine Pipeline konfiguriert ist, klicke auf Veröffentlichen in der Symbolleiste.

- Dadurch wird deine Pipeline gespeichert und ist bereit für die Ausführung. Ohne Veröffentlichung bleiben die Änderungen an deiner Pipeline als Entwürfe bestehen und können nicht ausgeführt werden.

2. Die Pipeline ausführen

- Um deine Pipeline zu testen, klicke oben auf Auslöser hinzufügen und wähle Jetzt auslösen für einen manuellen Lauf. So kannst du überprüfen, ob die Pipeline wie erwartet funktioniert.

- Alternativ kannst du auch einen automatischen Zeitplan einrichten:

- Gehen Sie zu den Auslöser und erstelle einen neuen Trigger.

- Definiere die Auslösebedingungen, z. B. einen zeitbasierten Zeitplan (z. B. jeden Tag um 8:00 Uhr) oder eine ereignisbasierte Bedingung (z. B. Ankunft einer Datei im Azure Blob Storage).

- Verbinde den Auslöser mit deiner Pipeline, um die Automatisierung zu ermöglichen.

Integration und Transformation von Azure Data Factory-Funktionen

Azure Data Factory bietet leistungsstarke Funktionen zur Datenintegration und -umwandlung, die komplexe Arbeitsabläufe vereinfachen und die Produktivität steigern. In diesem Abschnitt gehen wir auf diese Funktionen ein.

1. Datenströme

Data flows probietet eine visuelle Umgebung für die Definition von Transformationslogik, die es den Nutzern erleichtert, Daten zu manipulieren und zu verarbeiten, ohne komplexen Code schreiben zu müssen. Zu den üblichen Aufgaben, die mit Datenflüssen durchgeführt werden, gehören:

- Aggregationen: Fasse Daten zusammen, um aussagekräftige Erkenntnisse zu gewinnen, wie z.B. die Berechnung des Gesamtumsatzes oder durchschnittlicher Leistungskennzahlen.

- Tritt bei: Kombiniere Daten aus verschiedenen Quellen, um angereicherte Datensätze für nachgelagerte Prozesse zu erstellen.

- Filter: Wähle bestimmte Teilmengen von Daten nach bestimmten Kriterien aus und konzentriere dich so auf relevante Informationen.

Datenflüsse unterstützen auch fortgeschrittene Operationen wie Spaltenableitungen, Datentypkonvertierungen und bedingte Transformationen, was sie zu vielseitigen Werkzeugen für den Umgang mit unterschiedlichen Datenanforderungen macht.

2. Integration mit Azure Synapse Analytics

ADF lässt sich nahtlos in Azure Synapse Analyticsintegrieren und bieteteine einheitliche Plattform für die Verarbeitung von Big Data und erweiterte Analysen. Diese Integration ermöglicht es den Nutzern,:

- Orchestrieren Sie durchgängige Datenworkflows, die Datenaufnahme, -aufbereitung und -analyse umfassen.

- Nutze die leistungsstarke Abfrage-Engine von Synapse, um große Datenmengen effizient zu verarbeiten.

- Erstelle Datenpipelines, die direkt in Synapse Analyticsfür maschinelles Lernen undBerichterstellung eingesetzt werden können.

Diese Synergie zwischen ADF und Synapse trägt dazu bei, Arbeitsabläufe zu rationalisieren und die Komplexität der Verwaltung separater Tools für die Datenintegration und -analyse zu verringern.

3. Planung und Überwachung von Pipelines

- Terminplanung: Wie bereits erwähnt, bieten die ADF-Planungsfunktionen robuste Automatisierungsfunktionen. Nutzer können Auslöser auf Basis von Zeitintervallen (z. B. stündlich, täglich) oder Ereignissen (z. B. das Eintreffen einer Datei in Azure Blob Storage) definieren.

- Überwachung: Der Lernpfad in Azure Data Factory, kombiniertmit Azure Monitor, bieteteine Echtzeitverfolgung und -diagnose für Pipeline-Ausführungen. Die Nutzer können detaillierte Protokolle einsehen, den Fortschritt verfolgen und Engpässe oder Fehler schnell erkennen. Auch Alarme und Benachrichtigungen können einfach konfiguriert werden.

Azure Data Factory Anwendungsfälle

Nach einem ausführlichen Überblick über die Funktionen und Komponenten von ADF wollen wir sehen, wofür wir es verwenden können.

1. Datenmigration

ADF ist ein leistungsfähiges Werkzeug für die Migration von Daten aus lokalen Systemen auf cloudbasierte Plattformen. Es vereinfacht komplexe Migrationen, indem es die Datenbewegung automatisiert, die Datenintegrität sicherstellt und Ausfallzeiten minimiert.

Du kannst ADF zum Beispiel nutzen, um Daten von einem lokalen SQL Serverzu einer Azure SQL-Datenbank zu migrieren, und zwar mith minimalem manuellen Eingriff. Durch die Nutzung von integrierten Konnektoren und Integrationslaufzeiten gewährleistet ADF einen sicheren und effizienten Migrationsprozess, der sowohl strukturierte als auch unstrukturierte Daten berücksichtigt.

2. ETL für Data Warehousing

Extrahier-, Transformier- und Ladeprozesse (ETL) sind das Herzstück des modernen Data Warehousing. Azure Data Factory rationalisiert diese Arbeitsabläufe, indem es Daten aus verschiedenen Quellen integriert, Transformationslogik anwendet und sie in ein Data Warehouse lädt.

ADF kann zum Beispiel Verkaufsdaten aus verschiedenen Regionen konsolidieren, in ein einheitliches Format umwandeln und in Azure Synapse Analytics laden. Dieser optimierte Prozess ermöglicht es dir, aktuelle und hochwertige Daten für die Berichterstattung und Entscheidungsfindung zu erhalten.

|

Schau dir die 23 besten ETL-Tools im Jahr 2024 an und erfahre, warum du sie wählen solltest. |

3. Datenintegration für Data Lakes

Data Lakes dienen als zentraler Speicher für verschiedene Datensätze und ermöglichen erweiterte Analysen und maschinelles Lernen. ADF erleichtert das Einlesen von Daten aus verschiedenen Quellen in Azure Data Lake Storage und unterstützt Batch- und Streaming-Szenarien.

Du kannst ADF zum Beispiel nutzen, um Logdateien, Social Media Feeds und IoT-Sensordaten in einem einzigen Data Lake zu sammeln. Durch die Bereitstellung von Datenumwandlungs- und Integrationswerkzeugen stellt ADF sicher, dass der Data Lake gut organisiert und für nachgelagerte Analysen und KI-Workloads bereit ist.

Best Practices für die Verwendung von Azure Data Factory

Zu guter Letzt lohnt es sich, einige Best Practices für den effektiven Einsatz von ADF zu besprechen.

1. Modularer Aufbau der Pipeline

Um wartbare und skalierbare Workflows zu erstellen, solltest du Pipelines mit wiederverwendbaren Komponenten entwerfen. Der modulare Aufbau erleichtert das Debuggen, Testen und Aktualisieren einzelner Pipelineabschnitte. Anstatt beispielsweise die Logik zur Datenumwandlung in jede Pipeline einzubetten, solltest du eine wiederverwendbare Pipeline erstellen, die über mehrere Workflows hinweg aufgerufen werden kann. Das reduziert Redundanzen und verbessert die Konsistenz zwischen den Projekten.

2. Optimiere die Datenbewegung

- Verwende Kompression: Um die Datenübertragungszeiten zu minimieren und die Nutzung der Netzwerkbandbreite zu reduzieren, solltest du große Datensätze komprimieren, bevor du sie verschiebst. Zum Beispiel kann die Verwendung von gzip oder ähnlichen Methoden die Übertragung großer Dateien erheblich beschleunigen.

- Wähle die richtige Integrationslaufzeit: Die Wahl der Integrationslaufzeit (Azure IR, Self-hosted IR oder SSIS IR) ist entscheidend für die Optimierung der Leistung. Die selbst gehostete IR kann zum Beispiel für die Datenbewegung vor Ort verwendet werden, um sichere und effiziente Übertragungen zu gewährleisten, während die Azure IR ideal für Cloud-native Operationen ist.

3. Robuste Fehlerbehandlung implementieren

- Wiederholungsrichtlinien: Konfiguriere Wiederholungsrichtlinien für vorübergehende Fehler, wie z. B. vorübergehende Netzwerkunterbrechungen oder Server-Timeouts. So wird sichergestellt, dass sich die Pipelines erholen und ohne manuelle Eingriffe erfolgreich abgeschlossen werden können.

- Richte Alarme ein: Implementiere Warnungen und Benachrichtigungen, um dein Team proaktiv über Pipelinesne Ausfälle oder Leistungsprobleme zu informieren. Mit Tools wie Azure Monitor kannst du benutzerdefinierte Warnmeldungen für bestimmte Fehlertypen oder Ausführungsverzögerungen konfigurieren und so eine schnelle Lösung und minimale Ausfallzeiten sicherstellen.

Was ist der Unterschied zwischen Azure Data Factoryund Databricks? Wenn du neugierig bist und die Unterschiede zwischen Azure Data Factory und Databricks kennenlernen möchtest, schau dir Azure Data Factory vs. Databricks an: Ein detaillierter Vergleich blog.

Fazit

Azure Data Factory vereinfacht den Aufbau, die Verwaltung und die Skalierung von Datenpipelines in der Cloud. Sie bietet eine intuitive Plattform, die sowohl technische als auch nicht-technische Nutzer/innen anspricht und es ihnen ermöglicht, Daten aus verschiedenen Quellen effizient zu integrieren und umzuwandeln.

Durch die Nutzung seiner Funktionen, wie z. B. die Erstellung von Pipelines ohne Code, Integrationsfunktionen und Überwachungswerkzeuge, können Nutzer/innen leicht skalierbare und zuverlässige Workflows erstellen.

Wenn du mehr über Azure Data Factory erfahren möchtest, empfehle ich dir die Top 27 Azure Data Factory Interview Fragen und Antworten.

Wenn du das Rückgrat von Azure erkunden willst, einschließlich Themen wie Container, virtuelle Maschinen und mehr, empfehle ich dir diesen tollen kostenlosen Kurs " Understanding Microsoft Azure Architecture and Services".