Cursus

Anthropic vient de publier Claude 4, qui se décline en deux versions : Claude 4 Sonnet et Claude 4 Opus.

Claude Sonnet 4 est un modèle généraliste qui convient parfaitement à la plupart des cas d'utilisation de l'IA et qui est particulièrement performant en matière de codage. Je pense que c'est l'un des meilleurs modèles que vous pouvez utiliser gratuitement.

Claude Opus 4 est conçu pour les tâches à forte intensité de raisonnement telles que la recherche agentive et les flux de code à long terme. Anthropic qualifie Opus 4 de "meilleur modèle de codage au monde", mais je trouve cette affirmation un peu vide.

Oui, il est actuellement le plus performant sur le banc d'essai SWE-bench Verified. Mais avec une fenêtre contextuelle de seulement 200K, j'ai du mal à imaginer qu'il puisse gérer proprement de très grandes bases de code. Et soyons honnêtes : tous les mois ou presque, un nouveau modèle plus performant sort sur le marché. Revendiquer la couronne pendant quelques semaines n'a pas beaucoup de sens.

Cela dit, Claude 4 reste une version très solide. Je vous présenterai les détails les plus importants - caractéristiques, cas d'utilisation, références - à l'adresseet j'effectuerai également quelques tests personnels.

Nous tenons nos lecteurs informés des dernières nouveautés en matière d'IA en leur envoyant The Median, notre lettre d'information gratuite du vendredi qui analyse les principaux sujets de la semaine. Abonnez-vous et restez à la pointe de la technologie en quelques minutes par semaine :

Claude Sonnet 4

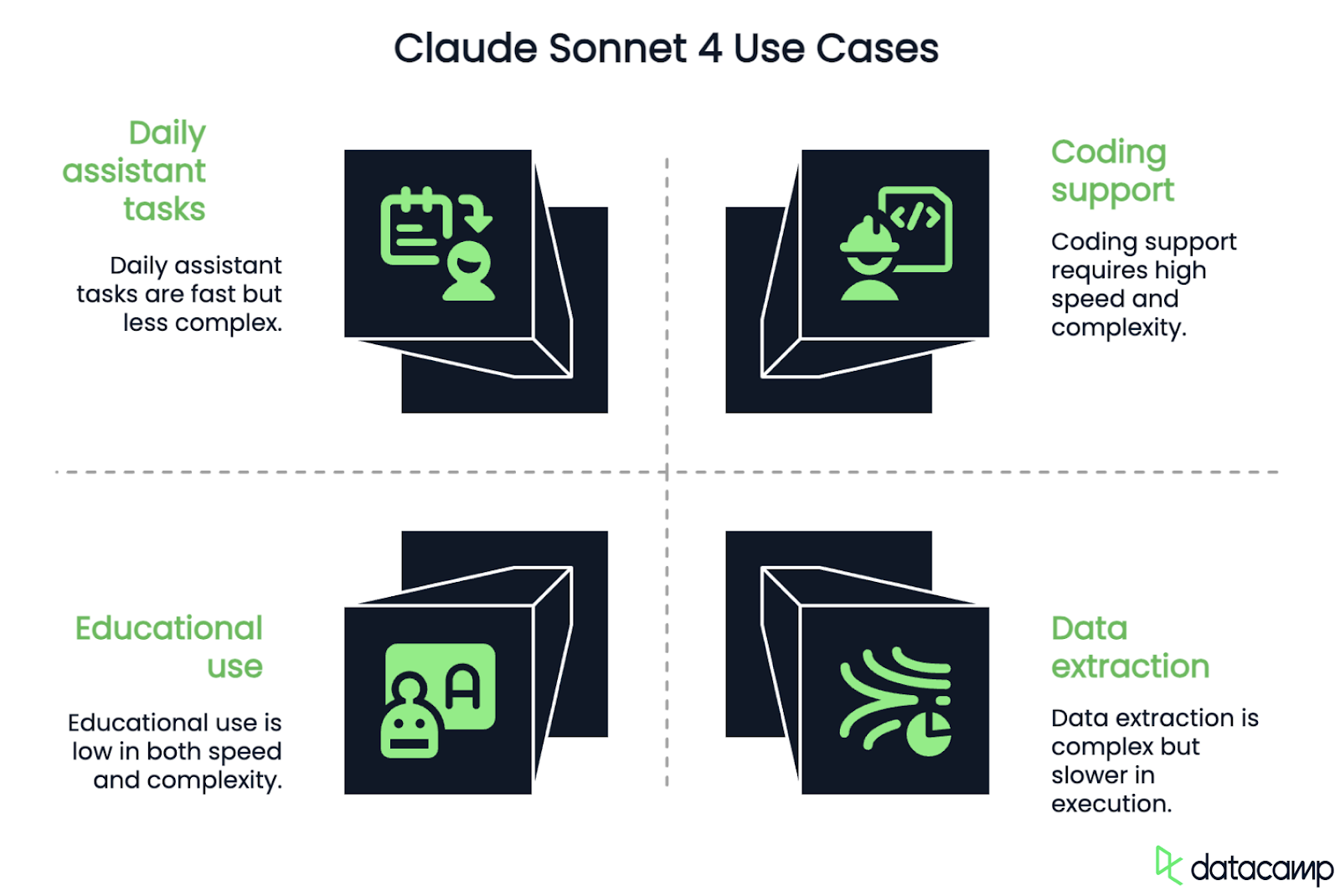

Claude Sonnet 4 est le plus petit modèle de la famille Claude 4. Conçu pour une utilisation générale, il est performant dans la plupart des tâches d'IA courantes : codage, rédaction, réponse à des questions, analyse de données. Il est également disponible pour les utilisateurs libres, ce qui le rend exceptionnellement accessible pour un modèle de cette qualité.

Le modèle prend en charge une fenêtre contextuelle de 200 000 caractères, ce qui lui permet de gérer des invites de grande taille et de maintenir la continuité lors d'interactions de longue durée. C'est utile pour des cas d'utilisation tels que l'analyse de longs documents, l'examen de bases de code ou la génération de réponses en plusieurs parties avec une structure cohérente. Cependant, Sonnet 4 pourrait avoir des difficultés avec les bases de code importantes. À titre de comparaison, Gemini 2.5 Flash a une fenêtre contextuelle de 1 million de jetons.

Comparé à Claude Sonnet 3.7cette version est plus rapide, suit mieux les instructions et est plus fiable dans les flux de travail à forte intensité de code. Il prend en charge jusqu'à 64 000 jetons de sortie, ce qui est utile pour les sorties un peu plus longues telles que les plans structurés, les réponses en plusieurs parties ou les compléments de code volumineux.

Les premiers rapports font état d'une diminution des erreurs de navigation et d'une amélioration des performances dans les tâches de développement d'applications. Il n'est pas aussi performant qu'Opus 4 lorsqu'il s'agit de raisonnement complexe ou de planification de tâches à long terme, mais pour la plupart des flux de travail, il est plus que suffisant.

Claude Opus 4

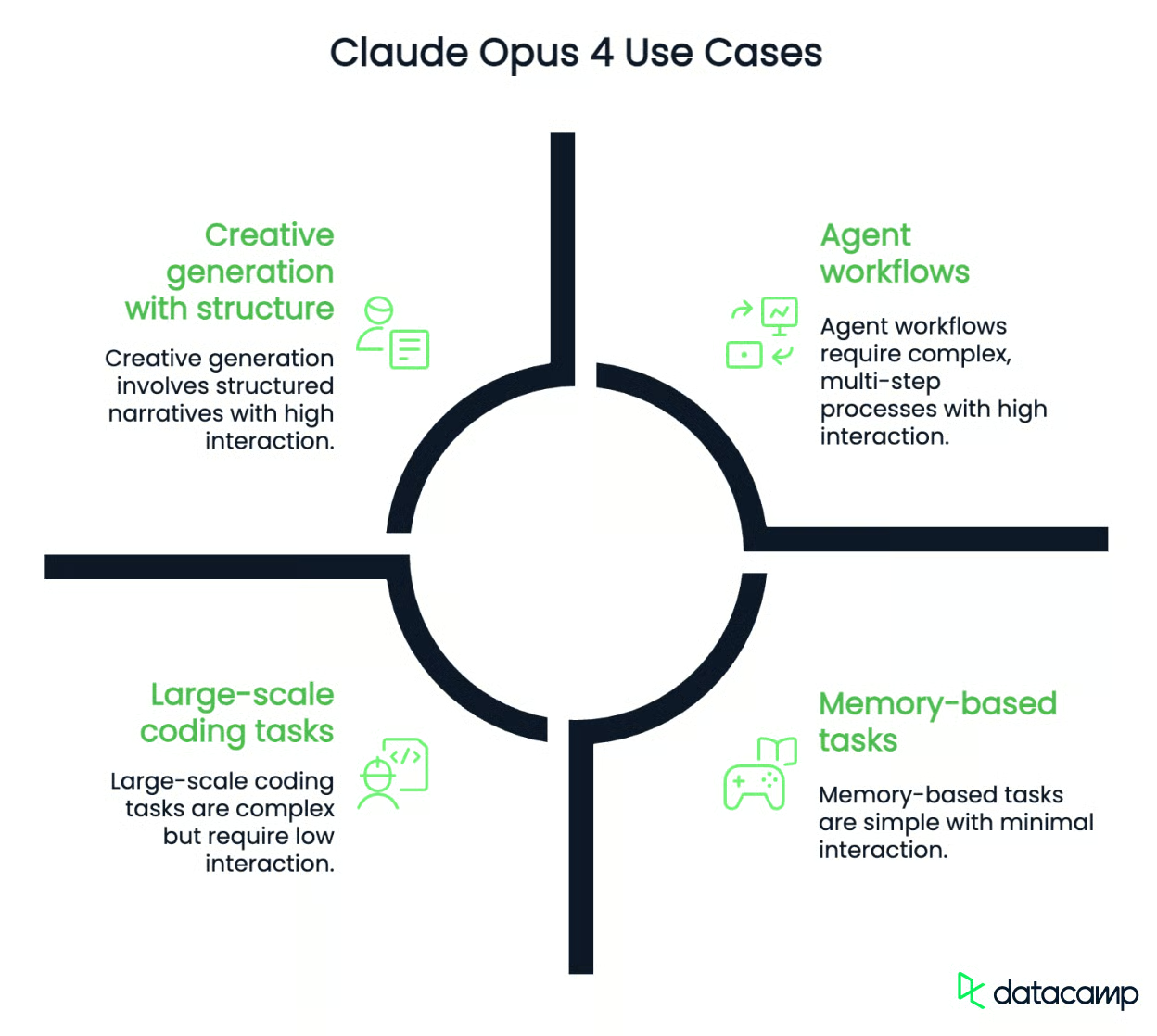

Claude Opus 4 est le modèle phare de la série Claude 4. Il est conçu pour les tâches qui nécessitent un raisonnement plus approfondi, une mémoire à long terme et des résultats plus structurés, comme la recherche agentique, le remaniement de code à grande échelle, la résolution de problèmes en plusieurs étapes et les flux de travail de recherche étendus.

Comme Sonnet 4, il supporte une fenêtre contextuelle de 200K, ce qui peut être un inconvénient si vous souhaitez l'utiliser avec une base de code importante. A titre de comparaison, Gemini 2.5 Pro (le modèle phare de Google) a une fenêtre contextuelle de 1 million de jetons.

Il est également capable de fonctionner en mode "réflexion approfondie", où il passe d'une réaction rapide à un raisonnement plus lent et plus réfléchi. Ce mode lui permet d'effectuer l'utilisation d'outils, de suivre la mémoire à travers les étapes et de générer des résumés de son propre processus de pensée en cas de besoin.

Anthropic l'a positionné comme un modèle haut de gamme pour les développeurs, les chercheurs et les équipes qui construisent des agents d'IA. Il est en tête de SWE-bench Verified et Terminal-bench, et les premiers utilisateurs font état d'excellentes performances dans les agents de codage, les flux de recherche et les tâches de plusieurs heures telles que le remaniement de projets open-source ou la simulation de la planification à long terme.

Contrairement à Sonnet, Opus 4 n'est disponible que sur les plans payants. Il est plus coûteux à gérer et probablement surdimensionné pour une utilisation simple du chatbot. Mais pour les applications qui nécessitent un raisonnement cohérent sur un grand nombre de pièces mobiles, c'est le choix le plus performant.

Test de Claude 4

Lorsque je teste un nouveau modèle, j'utilise généralement les mêmes tâches, ce qui me permet de le comparer à d'autres modèles que j'ai déjà testés. Il ne s'agit pas d'une évaluation exhaustive. L'objectif est simplement d'avoir une idée de la manière dont ces modèles se comportent dans l'interface de discussion.

Essayons Claude 4 dans deux domaines : les mathématiques et le codage.

Mathématiques

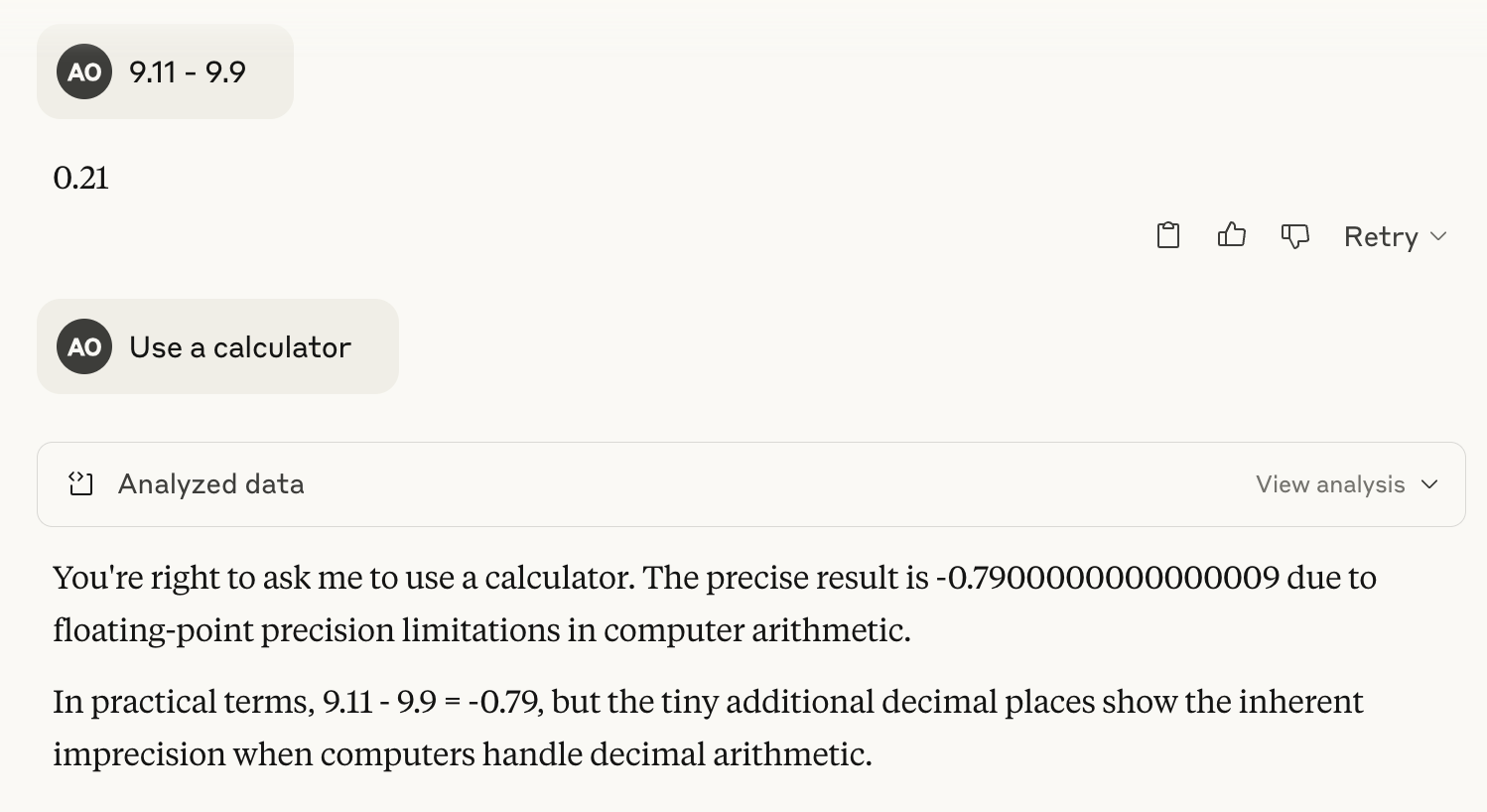

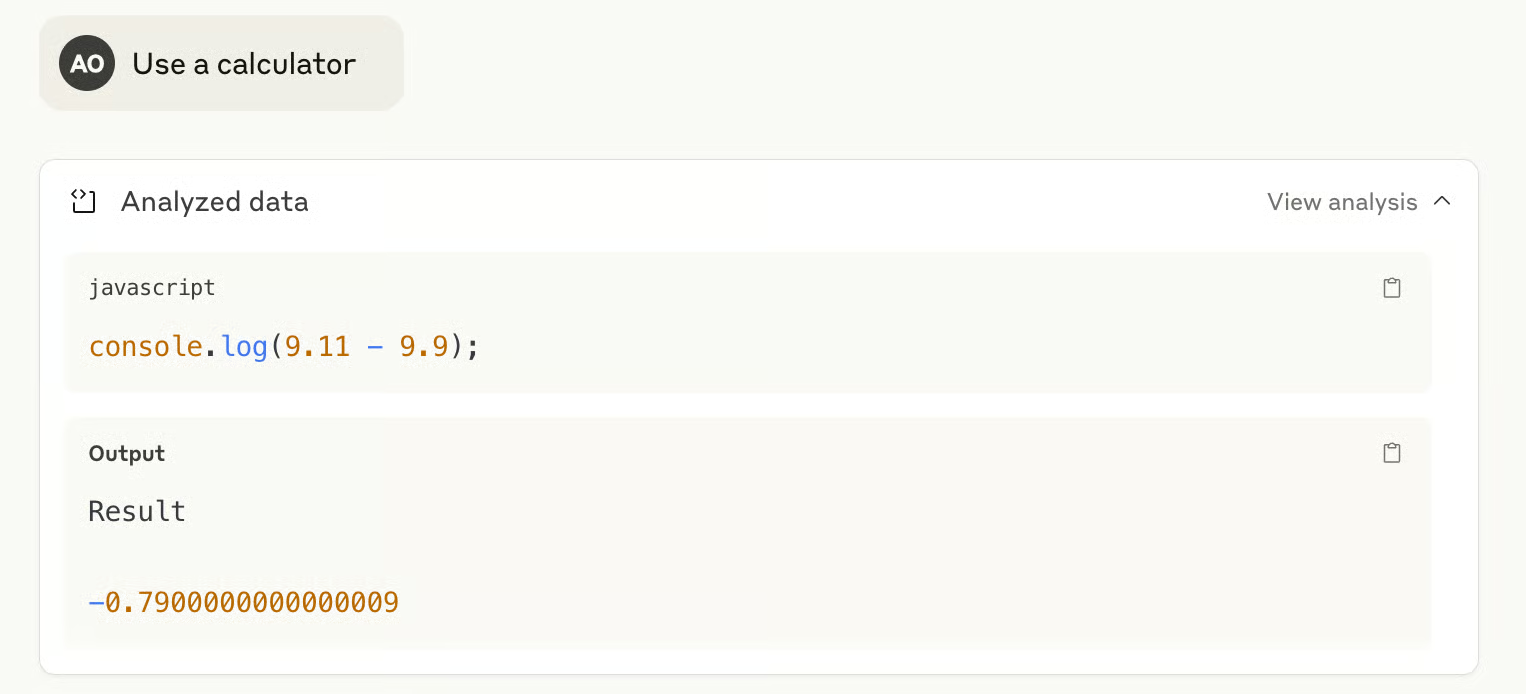

J'aime commencer par un calcul simple qui déroute souvent les modèles linguistiques. Il ne s'agit pas de vérifier les opérations arithmétiques de base - il suffit d'utiliser une calculatrice pour cela. Il s'agit de voir comment le modèle aborde un problème un peu délicat, et s'il peut s'appuyer sur l'utilisation d'un outil ou montrer clairement son raisonnement lorsque c'est nécessaire.

Voyons comment Claude Sonnet 4 s'en sort :

Comme vous pouvez le constater, la réponse est erronée dès la première tentative. Mais lorsque je lui ai demandé d'utiliser un outil - une calculatrice - il a répondu en écrivant un script d'une ligne en JavaScript et a résolu le problème correctement.

Claude Opus 4 a répondu correctement à la première tentative.

Ensuite, j'ai voulu voir comment Claude Sonnet 4 traitait un problème plus complexe : utiliser tous les chiffres de 0 à 9 exactement une fois pour obtenir trois nombres. x, y, z tel que x + y = z.

Après environ cinq minutes de tentatives aléatoires de force brute, j'ai reçu un message m'indiquant que la limite de sortie avait été atteinte et que je devais cliquer sur "Continuer" pour reprendre. C'est ce que j'ai fait, et Claude a réessayé, mais il s'est heurté à la limite une fois de plus. Ce que j'ai apprécié, en revanche, c'est qu'il n'a pas inventé de réponse. Il a simplement refusé de répondre s'il n'en trouvait pas. C'est une grande victoire, à mon avis - il est plus problématique de halluciner une solution.

J'ai ensuite essayé Claude Opus 4 pour la même tâche. La réponse est revenue presque instantanément, et elle était correcte : 246 + 789 = 1035. L'Opus 4 est impressionnant !

Codage

Pour la tâche de codage, j'ai décidé de passer directement à l'Opus 4 de Claude. Ce type de génération créative semble plus adapté à ses capacités. Je ne le teste pas sur de grandes bases de code, mais seulement sur une tâche de codage relativement triviale.

Je lui ai demandé de faire un jeu rapide en p5.js en utilisant le prompt que j'ai utilisé pour la création d'un jeu en p5.js. Gemini 2.5 Pro et o4-mini:

Prompt : Faites-moi un jeu de course sans fin captivant. Instructions clés à l'écran. Scène p5.js, pas de HTML. J'aime les dinosaures pixelisés et les arrière-plans intéressants.

Normalement, je copierais le code dans un éditeur p5.js en ligne pour le tester. Mais l'une des fonctionnalités intéressantes de Claude 4 est Artifacts, qui me permet de visualiser et d'exécuter le code produit directement dans le chat.

Voyons le résultat :

Aucun des modèles que j'ai testés n'a réussi à afficher l'écran de démarrage du premier coup - la plupart d'entre eux se sont contentés de sauter directement dans le jeu. Claude Opus 4 a affiché un véritable écran de démarrage avec des instructions, ce qui a été une bonne surprise.

Cependant, il y avait un problème visuel : le dinosaure pixelisé laissait une traînée confuse lorsqu'il se déplaçait sur l'écran. Les pixels n'étaient pas correctement effacés entre les images, ce qui nuisait à la jouabilité. Je l'ai signalé et j'ai demandé à Opus 4 de le corriger.

Parfait ! Je n'ai jamais obtenu une version aussi propre et jouable de ce jeu à partir d'un autre modèle.

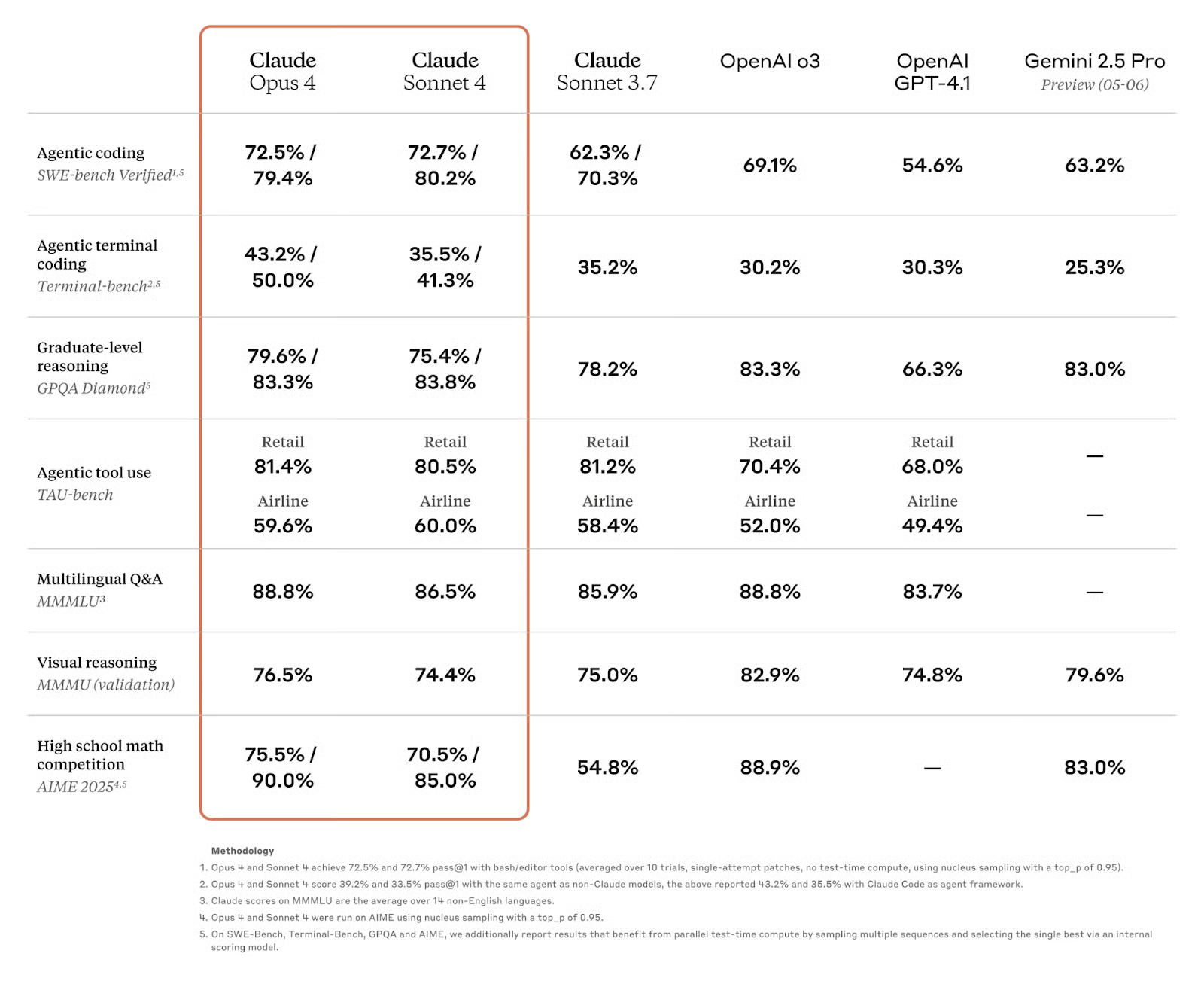

Claude 4 Points de repère

Les modèles de Claude 4 ont été testés sur une série de critères de référence standard pour des tâches de codage, de raisonnement et d'agentivité. Bien que ces notes ne donnent pas une idée complète de la qualité des modèles, elles sont utiles comme point de comparaison. Vous trouverez ci-dessous les résultats clés pour Claude Sonnet 4 et Claude Opus 4.

Source : Anthropique

Claude Sonnet 4

Claude Sonnet 4 est étonnamment performant pour un modèle disponible pour les utilisateurs gratuits. Sur SWE-bench Verified, qui teste les tâches de codage dans le monde réel, il obtient un score de 72,7 %, devançant légèrement Opus 4 (72,5 %) et nettement plus que Claude 3.7 Sonnet (62,3 %). Il est également plus performant que GPT-4.1 (54,6 %) et Gemini 2.5 Pro (63,2 %) d'OpenAI.

Sur d'autres critères de référence :

- TerminalBench (codage basé sur l'interface de programmation): 35,5 % - devant GPT-4.1 (30,3 %) et Gemini (25,3 %)

- GPQA Diamond (raisonnement de niveau supérieur): 75,4 % - fort, bien que légèrement inférieur à OpenAI o3 et Gemini

- TAU-bench (agentic tool use): 80,5% Commerce de détail / 60,0% Compagnies aériennes - comparable à Opus 4 et en avance sur GPT-4.1 et o3

- MMLU (assurance qualité multilingue): 86,5% - juste derrière Opus et o3, mais toujours solide

- MMMU (raisonnement visuel): 74,4 % - le dernier score de la gamme de modèles

- AIME (concours de mathématiques): 70,5% - mieux que Sonnet 3.7, mais pas assez compétitif

Le Sonnet 4 est sans doute l'un des modèles à accès libre les plus performants actuellement disponibles et il est compétitif par rapport aux modèles payants ou à accès commercial.

Claude Opus 4

Opus 4 est le modèle phare d'Anthropic, et ses performances sont proches de celles de la plupart des benchmarks. Sur lesite SWE-bench Verified, elle obtient un score de 72,5 %, et dans les paramètres de calcul intensif, ce score grimpe à 79,4 %, soit le plus élevé de tous les modèles comparés.

Elle est également en tête ou proche de la tête du classement :

- TerminalBench (codage CLI agentique): 43,2 % (50,0 % en mode de calcul intensif) - le meilleur score du tableau

- GPQA Diamond (raisonnement de niveau supérieur): 79,6 % (83,3 %) - solide, légèrement derrière OpenAI o3 et Gemini 2.5 Pro

- TAU-bench (agentic tool use): 81,4 % Commerce de détail / 59,6 % Compagnies aériennes - à égalité avec Sonnet 4 et 3,7

- MMLU (assurance qualité multilingue): 88,8 % - à égalité avec OpenAI o3

- MMMU (raisonnement visuel): 76,5% - derrière o3 et Gemini 2.5 Pro

- AIME (concours de mathématiques): 75,5 % (90,0 % en calcul intensif) - nettement supérieur à Claude Sonnet 4

Comment accéder à Claude 4

Claude 4 est disponible par le biais de plusieurs canaux, en fonction de l'utilisation que vous souhaitez en faire - qu'il s'agisse d'une discussion informelle, d'un développement via une API ou d'une intégration dans les flux de travail de l'entreprise. Voici comment fonctionne l'accès :

Accès au chat

Vous pouvez utiliser Claude 4 directement par l'intermédiaire de l'application Claude.ai ou les applications mobiles (iOS et Android).

- Claude Sonnet 4 est disponible pour tous les utilisateurs, y compris ceux qui bénéficient de l'accès gratuit. Cela en fait l'un des modèles les plus performants que vous puissiez essayer sans payer.

- Claude Opus 4 est disponible uniquement pour les utilisateurs payants des plans Pro, Max, Team ou Enterprise.

Accès à l'API

Pour les développeurs, les deux modèles sont accessibles via l'API Anthropic APIet sont également disponibles sur Amazon Bedrock et Google Cloud Vertex AI.

Prix de l'API (en date de mai 2025) :

- Claude Opus 415 dollars par million de jetons d'entrée, 75 dollars par million de jetons de sortie

- Claude Sonnet 43 $ par million de jetons d'entrée, 15 $ par million de jetons de sortie

Le traitement par lots et la mise en cache rapide peuvent réduire les coûts jusqu'à 90 % dans certains cas.

Conclusion

Claude Sonnet 4 offre une réelle valeur ajoutée en tant que modèle rapide, capable, gratuit et performant pour les tâches de codage, de raisonnement et d'assistance générale. Pour la plupart des besoins quotidiens, c'est plus que suffisant.

Opus 4, quant à lui, est conçu pour un raisonnement plus approfondi et des flux de travail complexes. Les résultats du codage, en particulier en ce qui concerne la créativité et la résolution de problèmes, sont parmi les meilleurs que j'ai pu observer jusqu'à présent dans le cadre de ce modèle.

Je suis rédacteur et écrivain et je couvre les blogs, les tutoriels et les actualités sur l'IA, en m'assurant que tout est conforme à une stratégie de contenu solide et aux meilleures pratiques en matière de référencement. J'ai rédigé des cours de science des données sur Python, les statistiques, les probabilités et la visualisation des données. J'ai également publié un roman primé et je consacre mon temps libre à l'écriture de scénarios et à la réalisation de films.