Cursus

Google vient de publier Gemini 2.5 Proson modèle de raisonnement le plus performant à ce jour et le premier de la famille Gemini 2.5.

À mon avis, sa plus grande force est la fenêtre contextuelle massive de 1 million de jetons, avec des plans pour s'étendre à 2 millions. La combinaison d'un modèle de raisonnement et d'un tel contexte offre une réelle valeur commerciale, surtout si l'on considère que l'adoption de l'IA est encore limitée dans la plupart des entreprises.

Pour mettre les choses en perspective : L'o3-mini d'OpenAI prend en charge 200 000 jetons, Claude 3.7 Sonnet plafonne également à 200 000, DeepSeek R1 plafonne à 128 000, et Grok 3 est le seul autre modèle qui correspond actuellement à Gemini à 1 million.

L'un des cas d'utilisation les plus courants de l'IA étant la génération de code, un modèle capable de raisonner à travers le code et de lire une grande base de code en une seule fois, sans avoir besoin de RAG, peut apporter une valeur commerciale significative. Nous avons déjà montré dans un blog précédent comment traiter des documents volumineux sans RAG en utilisant Gemini 2.0 Flash.

Dans ce billet, je vais vous expliquer ce qu'offre Gemini 2.5 Pro, les types d'entrées qu'il prend en charge et comment y accéder. J'effectuerai également quelques tests pratiques et j'examinerai les résultats obtenus par rapport à Claude, DeepSeek, Grok et aux derniers modèles d'OpenAI.

L'amélioration de l'IA pour les débutants

Qu'est-ce que Gemini 2.5 Pro ?

Gemini 2.5 Pro est le premier modèle de la famille Gemini 2.5 de Google. Elle est actuellement qualifiée d'expérimentale et est disponible dans le cadre du plan Gemini Advanced et de Google AI Studio.

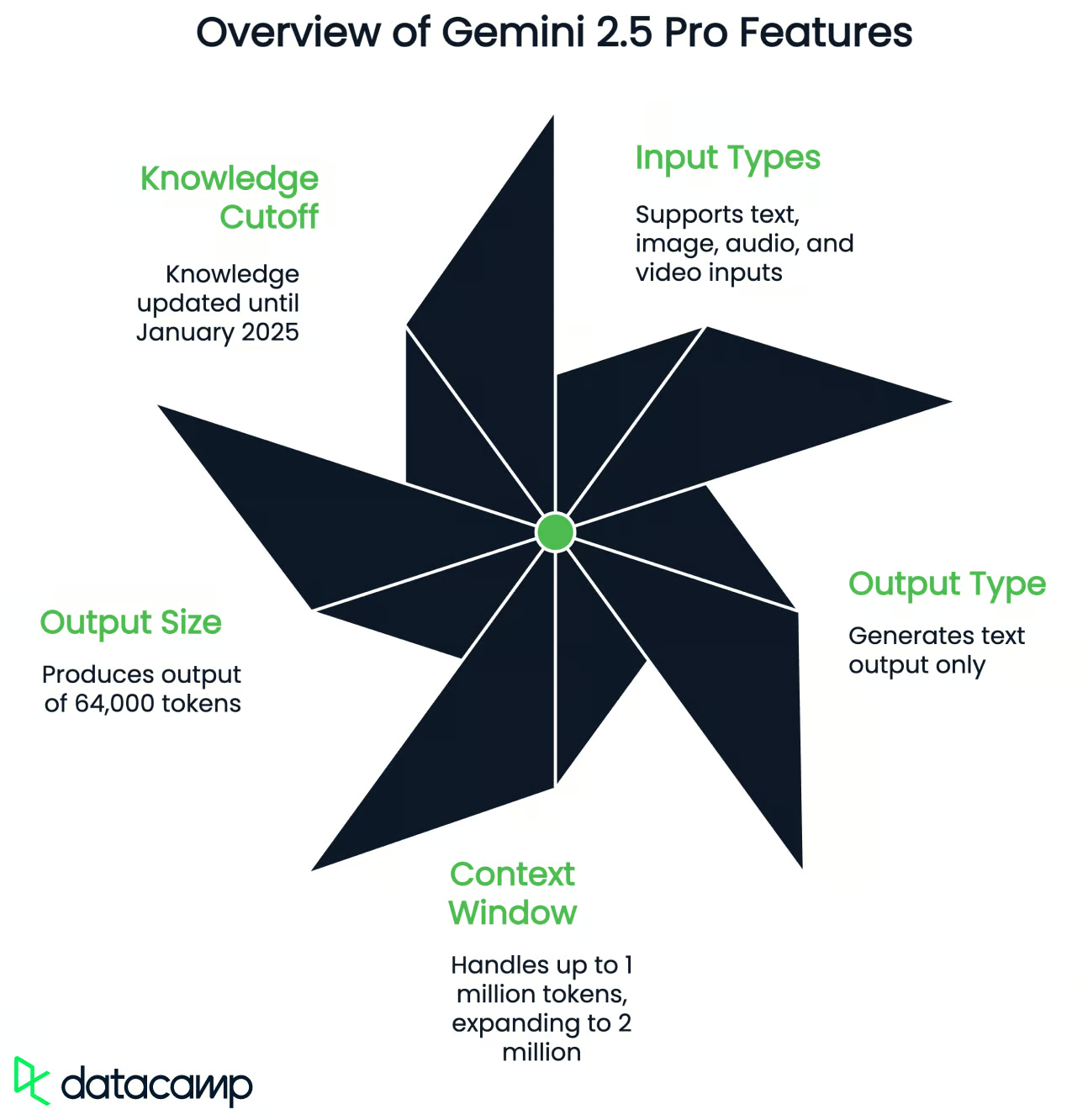

Selon Google, il s'agit du meilleur modèle de raisonnement à ce jour, avec des améliorations au niveau de l'utilisation des outils, de la gestion des entrées multimodales et des performances en contexte long. Voici un aperçu rapide de ce qu'il prend en charge :

- Types d'entrée : Texte, image, audio et vidéo

- Type de sortie : Texte uniquement

- Fenêtre contextuelle : Jusqu'à 1 million de jetons pour l'entrée (extension prévue à 2 millions)

- Taille de sortie : 64 000 jetons

- Critères d'évaluation des connaissances : Janvier 2025

Gemini 2.5 Pro prend en charge l'utilisation d'outils, ce qui signifie qu'il peut appeler des fonctions externes, générer des sorties structurées (comme JSON), exécuter du code et utiliser la recherche. Cela permet au modèle de résoudre des tâches en plusieurs étapes, d'appeler des API ou de formater des réponses pour des systèmes spécifiques en aval.

Comme il s'agit d'un modèle de raisonnement, Gemini 2.5 Pro est particulièrement efficace pour le codage, les mathématiques, la logique et les sciences. Pour la plupart des tâches quotidiennes, vous pouvez toujours utiliser un modèle généraliste comme Gemini 2.0 Flash, car il est beaucoup plus rapide.

Essayons maintenant Gemini 2.5 Pro pour voir s'il est performant.

Test de Gemini 2.5 Pro

Jeu P5js

Tout d'abord, j'ai voulu tester le jeu de dinosaures proposé par Google comme exemple, et j'ai utilisé la même invite que dans la vidéo de démonstration. la vidéo de démonstration (je l'ai essayé dans l'application Gemini) :

Make me a captivating endless runner game. Key instructions on the screen. p5js scene, no HTML. I like pixelated dinosaurs and interesting backgrounds.Voyons le résultat :

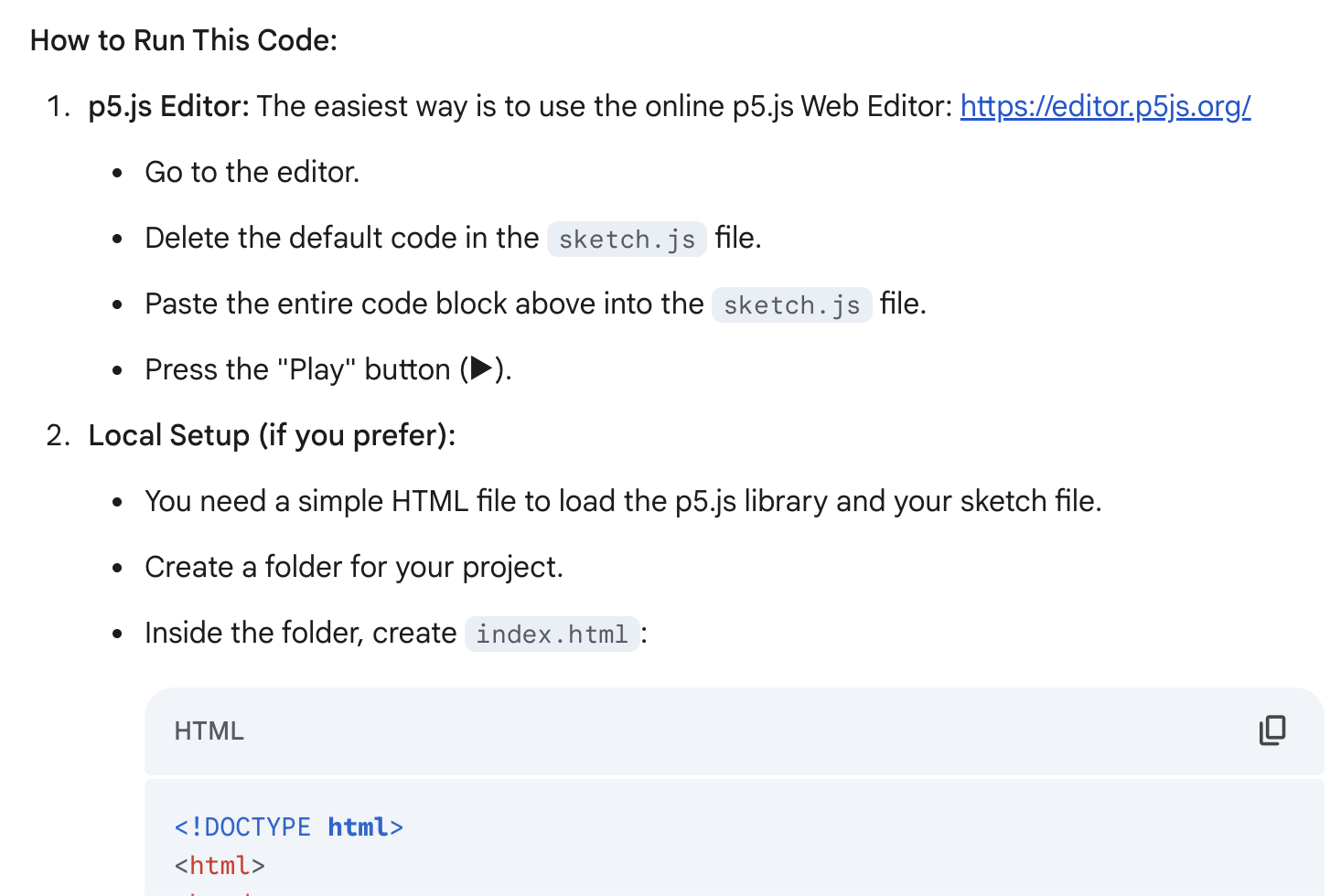

C'est plutôt cool pour un seul message ! La génération a été rapide (moins de 30 secondes), et j'ai également apprécié les instructions détaillées sur la façon d'exécuter ce code - elles m'ont proposé deux façons de l'exécuter :

Je n'aimais pas que le jeu démarre immédiatement après avoir exécuté le code, et j'ai donc voulu changer cela :

I don't like that the game starts immediately after I run the code. Add a starting screen where the user can be the one who starts the game (keep instructions on the screen)Voyons le résultat :

Exactement ce que je voulais ! Il y a encore beaucoup de choses que je changerais, mais le résultat est très bon par rapport à mon effort (deux messages) et à mon objectif (construire un prototype).

Entrée multimodale (vidéo et texte)

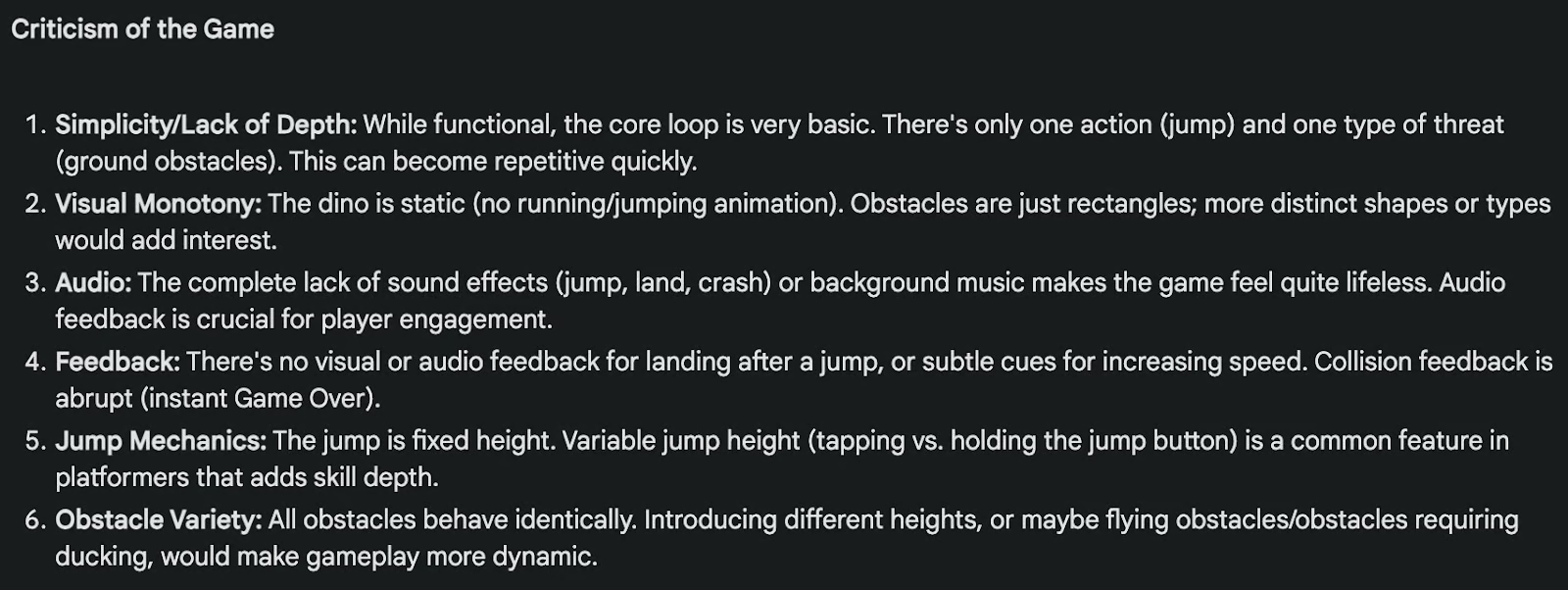

Ensuite, j'ai voulu tester les capacités multimodales de Gemin 2.5 Pro. J'ai téléchargé la vidéo ci-dessus avec le jeu et j'ai donné à Gemini 2.5 Pro cette invite sur Google AI Studio (je n'ai pas pu ajouter la vidéo comme entrée sur l'application Gemini) :

Analyze the game in the video, criticize both the game and the code I will give you below, and indicate what changes I could make to this game to make it better.

Code:

(truncated fo readability)Le résultat était très bon ! Pour des raisons de lisibilité, je ne montrerai ici que la critique du jeu, qui montre indirectement une bonne compréhension de la vidéo et du code :

Traitement de documents volumineux

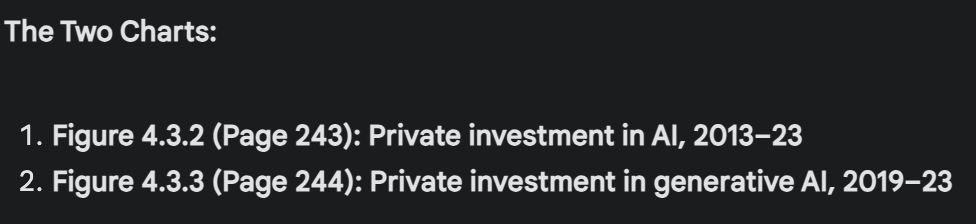

Enfin, j'ai voulu tester Gemini 2.5 Pro sur un document relativement volumineux, et j'ai utilisé Le rapport de Stanford sur l'indice d'intelligence artificielle 2024. Après avoir téléchargé le document de 502 pages (129 517 jetons), j'ai demandé à Gemini 2.5 Pro :

Pick two charts in this report that appear to show opposing or contradictory trends. Describe what each chart says, why the contradiction matters, and propose at least one explanation that reconciles the difference. Mention the page of the charts so I can double-check. If there's no such contradiction, don't try to artificially find one.Pour une raison quelconque, il ne pouvait pas analyser directement les graphiques dans le document PDF sur l'application Gemini. Je suis passé à Google AI Studio, et cela a fonctionné. Gemini 2.5 Pro a réussi à trouver deux graphiques concernant les investissements dans l'IA qui montrent une tendance contradictoire : les investissements privés dans l'IA sont en baisse alors que les investissements privés dans l'IA générative sont en hausse.

Il a parfaitement localisé les graphiques par le numéro de page (comme je l'avais demandé), le numéro de figure, et les titres (je vous recommande de vérifier le le PDF pour vérifier et voir les graphiques).

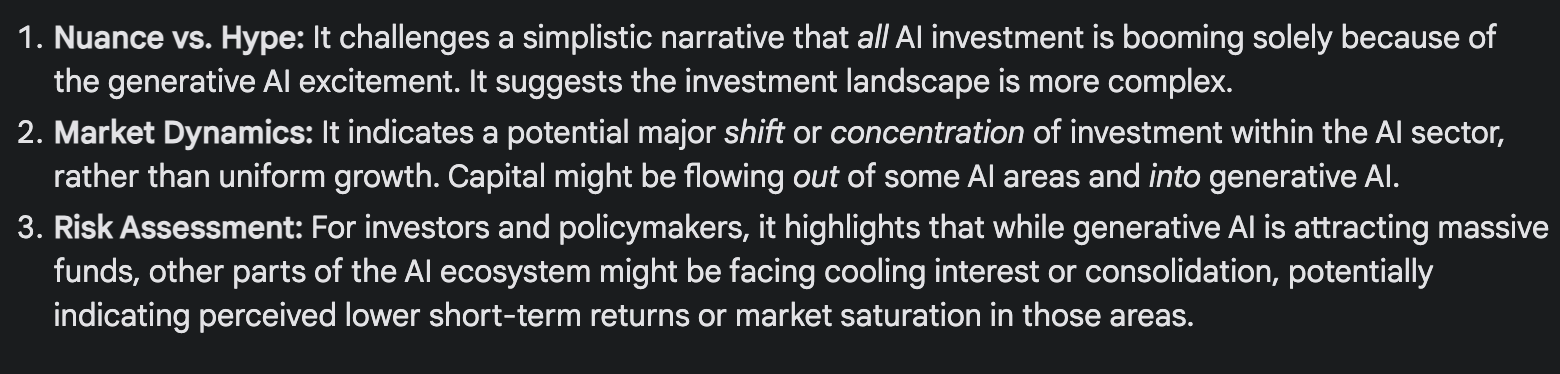

Il résume très bien la tendance contradictoire : Comment l'investissement privé total dans l'IA peut-il diminuer alors que l'investissement dans son sous-domaine le plus médiatisé et le plus visible, l'IA générative, explose ?

Et a expliqué pourquoi nous observons cette tendance apparemment contradictoire :

Gemini 2.5 Pro Benchmarks

Google a comparé Gemini 2.5 Pro à certains des meilleurs modèles disponibles aujourd'hui, notamment Claude 3.7 Sonnet, o3-mini d'OpenAI, DeepSeek R1et Grok 3. Bien que les performances varient d'une tâche à l'autre, Gemini 2.5 Pro obtient généralement de bons résultats dans les tâches de raisonnement, de codage, de mathématiques et dans les tâches à contexte longks.

|

Catégorie |

Référence |

Gemini 2.5 Pro |

Concurrents les plus proches |

|

Raisonnement et connaissances générales |

Le dernier examen de l'humanité (pas d'outils) |

18.8% |

o3-mini (14%), Claude 3.7 (8.9%), DeepSeek R1 (8.6%) |

|

GPQA Diamond (pass@1) |

84.0% |

Grok 3 Beta (80.2%), o3-mini (79.7%), Claude 3.7 Sonnet (78.2%) |

|

|

Mathématiques et logique |

AIME 2024 (pass@1) |

92.0% |

o3-mini (87,3%), Grok 3 Beta (83,9%) |

|

AIME 2025 (pass@1) |

86.7% |

o3-mini (86.5%), Grok 3 Beta (77.3%) |

|

|

Codage |

LiveCodeBench v5 |

70.4% |

o3-mini (74.1%), Grok 3 Beta (70.6%) |

|

Aider Polyglot (édition de fichiers entiers) |

74.0% |

— |

|

|

Banc SWE Vérifié |

63.8% |

Claude 3.7 (70.3%) |

|

|

Contexte long et multimodal |

MRCR (contexte 128K) |

91.5% |

GPT-4.5 (48.8%), o3-mini (36.3%) |

|

MMMU (compréhension multimodale ; pass@1) |

81.7% |

Grok 3 Beta (76.0%), Claude 3.7 Sonnet (75%) |

Doncurce : Google

Raisonnement et connaissances générales

Gemini 2.5 Pro affiche d'excellentes performances sur des benchmarks conçus pour tester le raisonnement en plusieurs étapes et les connaissances du monde réel :

- Le dernier examen de l'humanité (sans outils) : Gemini 2.5 Pro obtient un score de 18,8 %, devant o3-mini (14 %) et bien au-dessus de Claude 3.7 (8,9 %) et de DeepSeek-R1 (8,6 %). Ce test est conçu pour imiter les examens de niveau expert dans plus de 100 matières.

- GPQA Diamond : Une référence factuelle en matière d'assurance qualité pour les STIM et les sciences humaines. Gemini 2.5 Pro arrive en tête avec 84,0 % (pour une tentative unique/passe@1), suivi de Grok 3 Beta avec 80,2 %.

Mathématiques et logique

Il s'agit de points de référence où l'architecture de raisonnement de Gemini semble briller :

- AIME 2024 : Gemini 2.5 Pro arrive en tête avec 92,0 % pour les tentatives simples/passes@1.

- AIME 2025 : Gemini 2.5 Pro tombe à 86,7% sur l'ensemble des problèmes 2025, et mène marginalement ce benchmark pour la tentative unique/passe@1, suivi par o3-mini (86,5%).

Codage

Sur les bancs d'essai qui testent la génération de code, le débogage et le raisonnement multi-fichiers, Gemini obtient de bons résultats, mais ne domine pas :

- LiveCodeBench v5 (génération de code) : Gemini 2.5 Pro obtient un score de 70,4 %, derrière o3-mini (74,1 %) et Grok 3 Beta (70,6 %).

- Aider Polyglotte (fichier complet) : Gemini atteint 74,0 %, ce qui est solide, surtout si l'on considère qu'il gère plusieurs langues. Ce critère de référence mesure l'édition du code.

- SWE-bench vérifié (codage agentique) : Gemini obtient un score de 63,8 %, ce qui le place devant o3-mini et DeepSeek R1, mais derrière Claude 3.7 Sonnet (70,3 %).

Tâches à contexte long et multimodales

C'est sur ce point que Gemini 2.5 Pro se distingue le plus clairement :

- MRCR (compréhension de la lecture en contexte long) : Gemini 2.5 Pro atteint 91,5 % pour une longueur de contexte de 128 000, ce qui le place loin devant o3-mini (36,3 %) et GPT-4.5 (48,8 %).

- MMMU (compréhension multimodale) : Gemini 2.5 Pro arrive en tête avec un score de 81,7 %.

Comment accéder à Gemini 2.5 Pro

Il y a plusieurs façons d'essayer Gemini 2.5 Pro, selon que vous êtes un utilisateur occasionnel ou que vous construisez quelque chose de plus technique.

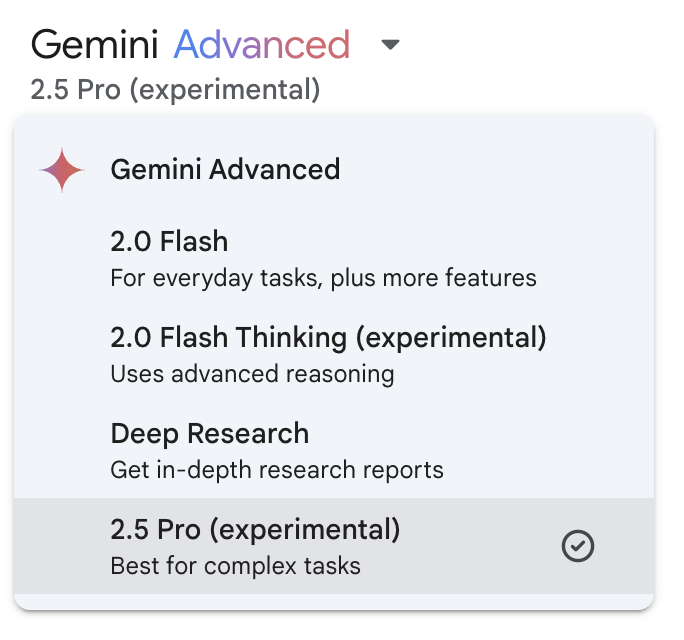

Application Gemini

La manière la plus simple d'accéder à Gemini 2.5 Pro est de passer par l'application Gemini (sur mobile ou sur le web).

Si vous êtes abonné à Gemini Advanced, vous verrez Gemini 2.5 Pro dans le menu déroulant des modèles.

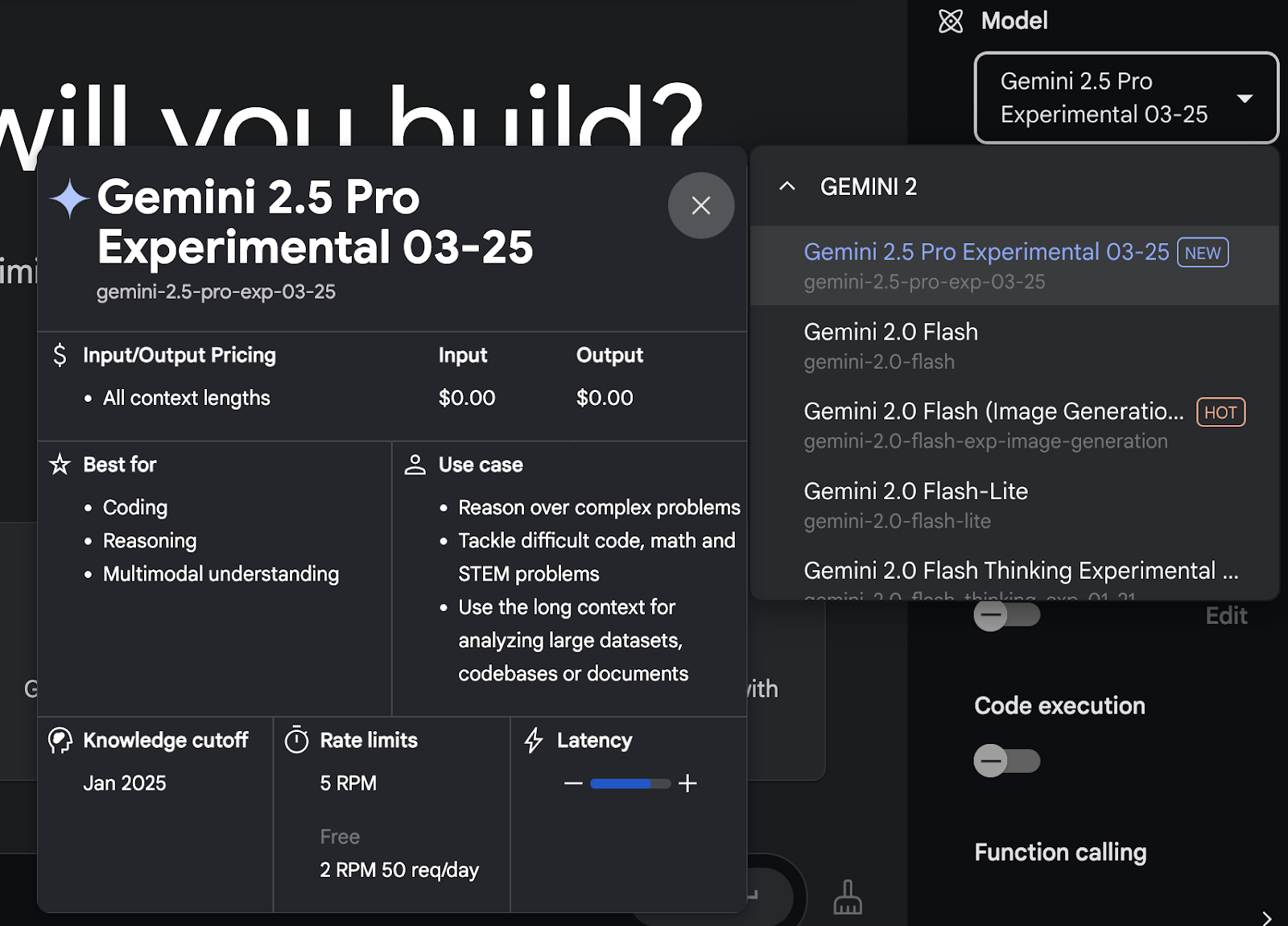

Google AI Studio

Si vous souhaitez mieux contrôler les entrées, l'utilisation des outils ou les messages multimodaux, je vous recommande d'utiliser Google AI Studio.

Cet environnement vous donne accès à Gemini 2.5 Pro gratuitement (pour l'instant) et prend en charge les entrées de texte, d'image, de vidéo et d'audio. Elle fonctionne également mieux que l'application Gemini pour télécharger des fichiers ou tester l'utilisation des outils, en particulier lorsqu'il s'agit de documents volumineux ou de flux de travail personnalisés.

Après avoir créé un compte, vous pouvez sélectionner Gemini 2.5 Pro dans le menu déroulant des modèles.

Gemini 2.5 Pro API

Pour l'accès programmatique, vous pouvez utiliser l'API Gemini, qui prend en charge Gemini 2.5 Pro.

Cela vous donne plus de flexibilité si vous intégrez le modèle dans une application ou un flux de travail. Vous pouvez appeler le modèle directement en activant l'utilisation d'outils, obtenir des réponses structurées ou traiter de longs documents de manière automatisée.

Vous pouvez trouver plus d'informations techniques ici.

Gemini 2.5 Pro sur Vertex AI

Google précise que Gemini 2.5 Pro sera également bientôt disponible dans Vertex AI, qui fait partie de Google Cloud. La principale différence entre l'utilisation directe de l'API Gemini et son accès via Vertex AI réside dans l'infrastructure, l'échelle et l'intégration.

Si vous ne faites que tester ou créer des outils internes, AI Studio ou l'API devraient suffire. Si vous déployez quelque chose en production avec des exigences strictes en matière de performances ou de sécurité, Vertex AI sera la meilleure solution lorsqu'elle prendra en charge Gemini 2.5 Pro.

Conclusion

Il est de plus en plus difficile d'être impressionné par les nouveaux modèles. La plupart des lancements se déroulent selon le même schéma : quelques exemples triés sur le volet, quelques tests de référence tape-à-l'œil et beaucoup d'affirmations sur le fait d'être le meilleur dans tous les domaines. Mais Gemini 2.5 Pro m'a permis de m'arrêter quelques instants et de me dire : "D'accord, c'est vraiment utile".

La fenêtre contextuelle d'un million de jetons modifie la façon dont vous pouvez aborder des tâches qui nécessitaient auparavant un travail supplémentaire, en particulier celles qui impliquent de longs documents, des bases de code désordonnées ou un raisonnement en plusieurs étapes. Je n'ai pas eu besoin d'organiser les entrées ou de mettre en place un pipeline RAG. J'ai simplement téléchargé le fichier, posé ma question et obtenu en retour quelque chose de cohérent et ancré dans la source.

Si la fenêtre contextuelle de 2 millions de jetons est bientôt mise en place, elle pourrait à elle seule en faire l'un des modèles les plus pratiques pour le travail dans le monde réel.

FAQ

Quels sont les types d'entrée pris en charge par Gemini 2.5 Pro ?

Gemini 2.5 Pro prend en charge les entrées texte, image, vidéo et audio.

Où puis-je accéder à Gemini 2.5 Pro ?

Gemini 2.5 Pro est disponible sur Google AI Studio et pour les abonnés à Gemini Advanced via l'application Gemini.

Quels sont les principaux cas d'utilisation de Gemini 2.5 Pro ?

Gemini 2.5 Pro excelle dans le codage, les tâches de raisonnement complexes et la gestion des entrées multimodales.

Gemini 2.5 Pro est-il adapté aux applications en temps réel ?

Bien que puissant, son statut expérimental incite à la prudence pour les déploiements en temps réel jusqu'à ce que la stabilité soit confirmée.

Je suis rédacteur et écrivain et je couvre les blogs, les tutoriels et les actualités sur l'IA, en m'assurant que tout est conforme à une stratégie de contenu solide et aux meilleures pratiques en matière de référencement. J'ai rédigé des cours de science des données sur Python, les statistiques, les probabilités et la visualisation des données. J'ai également publié un roman primé et je consacre mon temps libre à l'écriture de scénarios et à la réalisation de films.