Cours

OpenAI a annoncé son dernier grand modèle linguistique, GPT-4o, le successeur de GPT-4 Turbo. Lisez la suite pour découvrir ses capacités, ses performances et la manière dont vous pourriez l'utiliser.

Qu'est-ce que le GPT-4o d'OpenAI ?

GPT-4o est le dernier LLM d'OpenAI. Le "o" de GPT-4o signifie "omni", c'est-à-dire "tout" en latin, ce qui fait référence au fait que ce nouveau modèle peut accepter des invites qui sont un mélange de texte, d'audio, d'images et de vidéo. Auparavant, l'interface du ChatGPT utilisait des modèles distincts pour les différents types de contenu.

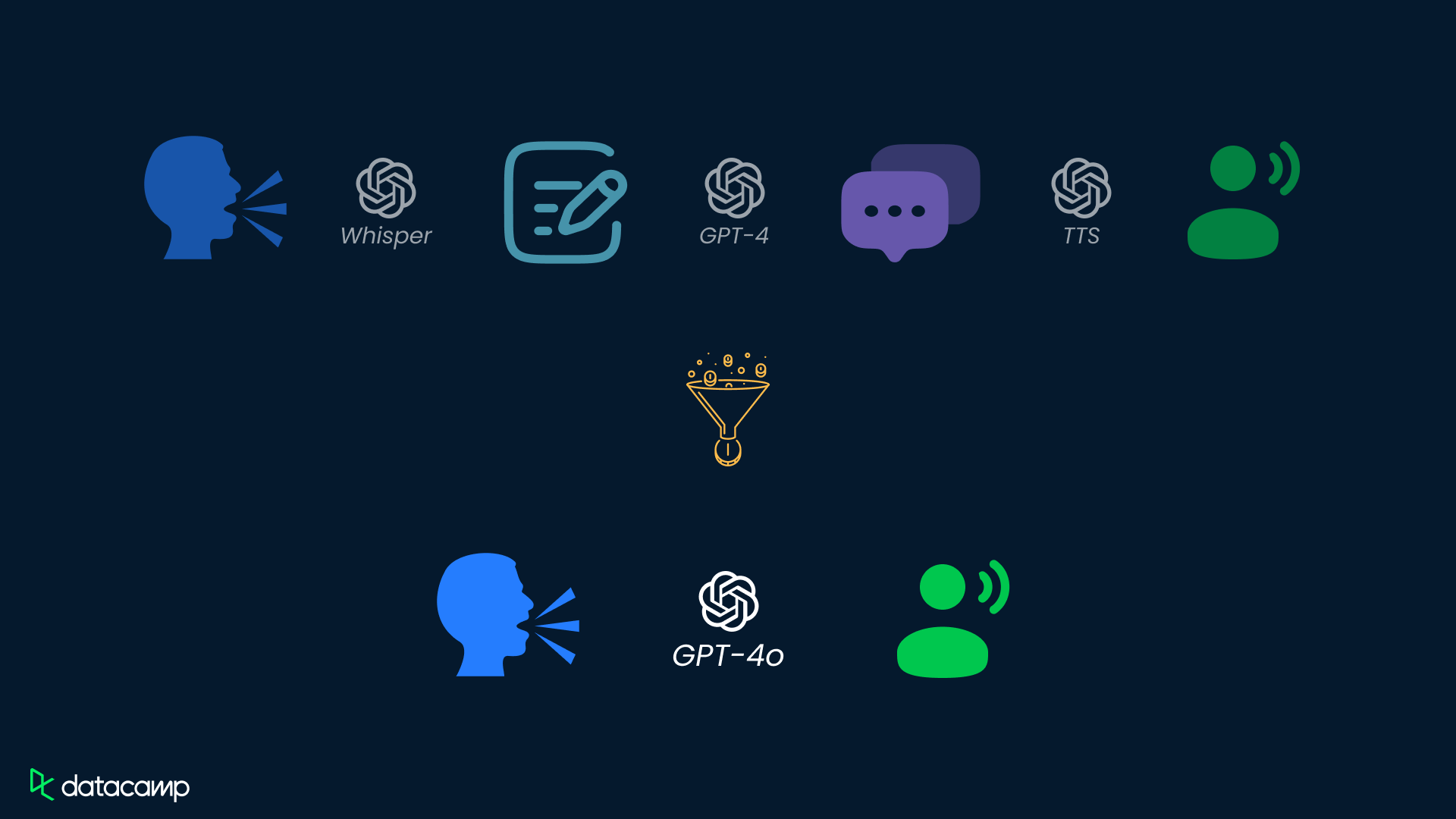

Par exemple, lorsque vous parlez à ChatGPT en mode vocal, votre voix est convertie en texte à l'aide de Whisper, une réponse textuelle est générée à l'aide de GPT-4 Turbo, et cette réponse textuelle est convertie en parole à l'aide de TTS.

Comparaison de la manière dont GPT-4 Turbo et GPT-4o traitent les données vocales.

De même, le travail avec les images dans le ChatGPT a nécessité un mélange de GPT-4 Turbo et de DALL-E 3.

Le fait de disposer d'un modèle unique pour les différents supports de contenu promet une augmentation de la vitesse et de la qualité des résultats, une interface plus simple et de nouveaux cas d'utilisation.

Qu'est-ce que le GPT-4o mini ?

GPT-4o Mini est une version allégée et plus rapide de GPT-4o, conçue pour traiter les tâches en mettant l'accent sur la rapidité et l'efficacité. Il est dérivé du modèle GPT-4o, plus grand, par un processus appelé distillation.

Bien qu'il conserve une grande partie de la capacité du modèle original à traiter des entrées multimodales (texte, audio et images), le GPT-4o mini est optimisé pour les applications légères pour lesquelles des temps de réponse plus rapides sont essentiels.

Il est particulièrement utile pour les développeurs qui ont besoin d'une solution rentable pour le codage, le débogage et les interactions en temps réel qui ne nécessitent pas toute la puissance de calcul du GPT-4o.

Vous pouvez lire plus de détails dans cet article sur le GPT-4o mini.

Qu'est-ce qui différencie le GPT-4o du GPT-4 Turbo ?

L'approche du modèle tout-en-un signifie que le GPT-4o surmonte plusieurs limitations des capacités d'interaction vocale précédentes.

1. Le ton de la voix est désormais pris en compte, ce qui facilite les réponses émotionnelles.

Avec le système OpenAI précédent, qui combinait Whisper, GPT-4 Turbo et TTS dans un pipeline, le moteur de raisonnement, GPT-4, n'avait accès qu'aux mots prononcés. Cette méthode signifie que des éléments tels que le ton de la voix, les bruits de fond et la connaissance de voix provenant de plusieurs locuteurs ont été simplement écartés. En tant que tel, GPT-4 Turbo ne pouvait pas vraiment exprimer des réponses avec des émotions ou des styles de discours différents.

Grâce à un modèle unique capable de raisonner sur le texte et l'audio, ces riches informations audio peuvent être utilisées pour fournir des réponses de meilleure qualité avec une plus grande variété de styles d'expression.

Dans l'exemple suivant fourni par OpenAI, GPT-4o fournit une sortie sarcastique.

2. La réduction du temps de latence permet des conversations en temps réel

Le pipeline à trois modèles existant impliquait un léger délai ("latence") entre le moment où l'on s'adressait au ChatGPT et celui où l'on obtenait une réponse.

OpenAI a indiqué que la latence moyenne du mode vocal est de 2,8 secondes pour GPT-3.5 et de 5,4 secondes pour GPT-4. En revanche, la latence moyenne pour GPT-4o est de 0,32 seconde, soit neuf fois plus rapide que GPT-3.5 et 17 fois plus rapide que GPT-4.

Cette diminution de la latence est proche du temps de réponse humain moyen(0,21 seconde) et est importante pour les cas d'utilisation conversationnels, où il y a beaucoup d'allers-retours entre l'humain et l'IA, et où les écarts entre les réponses s'accumulent.

Cette fonctionnalité n'est pas sans rappeler le lancement par Google, en 2010, de Instant, sa fonction d'auto-complétion pour les requêtes de recherche. Même si la recherche ne prend pas beaucoup de temps, le fait de pouvoir gagner quelques secondes à chaque fois que vous l'utilisez améliore l'expérience du produit.

La traduction en temps réel de la parole est un cas d'utilisation qui devient plus viable grâce à la diminution de la latence du GPT-4o. OpenAI a présenté un cas d'utilisation de deux collègues, l'un anglophone et l'autre hispanophone, qui communiquent en demandant à GPT-4o de traduire leur conversation.

3. La vision intégrée permet de décrire le flux d'une caméra

En plus de l'intégration de la voix et du texte, le GPT-4o comprend des fonctions d'image et de vidéo. Cela signifie que si vous lui donnez accès à un écran d'ordinateur, il peut décrire ce qui est affiché à l'écran, répondre à des questions sur l'image affichée à l'écran ou agir en tant que copilote de votre travail.

Dans une vidéo d'OpenAI mettant en scène Sal Khan de la Khan Academy, GPT-4o aide le fils de Sal à faire ses devoirs de mathématiques.

En plus de travailler avec un écran, si vous donnez à GPT-4o l'accès à une caméra, par exemple votre smartphone, il peut décrire ce qu'il voit.

Une démonstration plus longue présentée par OpenAI combine toutes ces caractéristiques. Deux smartphones équipés de GPT-4o tiennent une conversation. Un GPT a accès aux caméras du smartphone et décrit ce qu'il voit à un autre GPT qui ne le voit pas.

Le résultat est une conversation à trois entre un humain et deux IA. La vidéo comprend également une section où les IA chantent, ce qui n'était pas possible avec les modèles précédents.

4. Une meilleure tokenisation pour les alphabets non romains permet de gagner en rapidité et en rentabilité.

L'une des étapes du flux de travail LLM consiste à convertir le texte de l'invite en jetons. Il s'agit d'unités de texte que le modèle peut comprendre.

En anglais, un jeton est généralement un mot ou un élément de ponctuation, bien que certains mots puissent être décomposés en plusieurs jetons. En moyenne, trois mots anglais occupent environ quatre jetons.

Si la langue peut être représentée dans le modèle avec moins de jetons, moins de calculs doivent être effectués et la vitesse de génération du texte est accrue.

En outre, étant donné qu'OpenAI facture son API par jeton d'entrée ou de sortie, moins de jetons signifie un prix plus bas pour les utilisateurs de l'API.

Le GPT-4o dispose d'un modèle de tokénisation amélioré qui permet de réduire le nombre de tokens nécessaires par texte. L'amélioration est surtout perceptible dans les langues qui n'utilisent pas l'alphabet romain.

Par exemple, les langues indiennes, en particulier, en ont profité : l'hindi, le marathi, le tamil, le telugu et le gujarati ont tous vu leur nombre de jetons diminuer de 2,9 à 4,4 fois. L'arabe a montré une réduction de 2 fois le nombre de jetons, et les langues d'Asie de l'Est comme le chinois, le japonais, le coréen et le vietnamien ont montré des réductions de 1,4 à 1,7 fois le nombre de jetons.

5. Passage au plan gratuit

Avec la stratégie de tarification existante d'OpenAI pour le ChatGPT, les utilisateurs doivent payer pour accéder au meilleur modèle : GPT-4 Turbo n'est disponible que sur les plans payants Plus et Enterprise.

Cette situation est en train de changer, OpenAI promettant de rendre GPT-4o également disponible sur le plan gratuit. Les utilisateurs Plus recevront cinq fois plus de messages que les utilisateurs du plan gratuit.

Le déploiement sera progressif, l'accès de l 'équipe rouge (les testeurs qui essaient de casser le modèle pour trouver des problèmes) commençant immédiatement et d'autres utilisateurs obtenant l'accès au fil du temps.

6. Lancement de l'application de bureau ChatGPT

Bien qu'il ne s'agisse pas nécessairement d'une mise à jour exclusive à GPT-4o, OpenAI a également annoncé la sortie de l'application de bureau ChatGPT. Les mises à jour concernant la latence et la multimodalité mentionnées ci-dessus, ainsi que la sortie de l'application, signifient que la façon dont nous travaillons avec le ChatGPT va probablement changer. Par exemple, OpenAI a présenté une démo d'un flux de travail de codage augmenté utilisant la voix et l'application de bureau ChatGPT. Faites défiler la section des cas d'utilisation pour voir cet exemple en action !

Comment fonctionne GPT-4o ?

Plusieurs types de contenu, un seul réseau neuronal

Les détails du fonctionnement du GPT-4o sont encore peu nombreux. Le seul détail fourni par OpenAI dans son annonce est que GPT-4o est un réseau neuronal unique qui a été entraîné sur du texte, de la vision et de l'audio.

Cette nouvelle approche diffère de la technique précédente qui consistait à former des modèles distincts sur différents types de données.

Cependant, GPT-4o n'est pas le premier modèle à adopter une approche multimodale. En 2022, TenCent Lab a créé SkillNet, un modèle qui combine les caractéristiques des transformateurs LLM avec des techniques de vision par ordinateur afin d'améliorer la capacité de reconnaissance des caractères chinois.

En 2023, une équipe de l'ETH Zurich, du MIT et de l'université de Stanford a créé WhisBERT, une variante de la série BERT de grands modèles linguistiques. Bien qu'il ne soit pas le premier, GPT-4o est considérablement plus ambitieux et plus puissant que ces deux premières tentatives.

Le GPT-4o est-il un changement radical par rapport au GPT-4 Turbo ?

La radicalité des changements apportés à l'architecture de GPT-4o par rapport à GPT-4 Turbo dépend de ce que vous demandez aux équipes d'ingénierie ou de marketing d'OpenAI. En avril, un bot nommé "im-also-a-good-gpt2-chatbot" est apparu sur le Chatbot Arena de LMSYS, un classement des meilleures IA génératives. Cette mystérieuse IA s'appelle désormais GPT-4o.

La partie "gpt2" du nom est importante. À ne pas confondre avec le GPT-2, prédécesseur du GPT-3.5 et du GPT-4, le suffixe "2" a été largement considéré comme signifiant une architecture entièrement nouvelle pour la série de modèles GPT.

De toute évidence, quelqu'un dans l'équipe de recherche ou d'ingénierie d'OpenAI pense que la combinaison des types de contenu textuel, visuel et audio en un seul modèle est un changement suffisamment important pour justifier le premier changement de numéro de version en six ans.

D'autre part, l'équipe marketing a opté pour un changement de nom relativement modeste, en conservant la convention "GPT-4".

Performance du GPT-4o par rapport à d'autres modèles

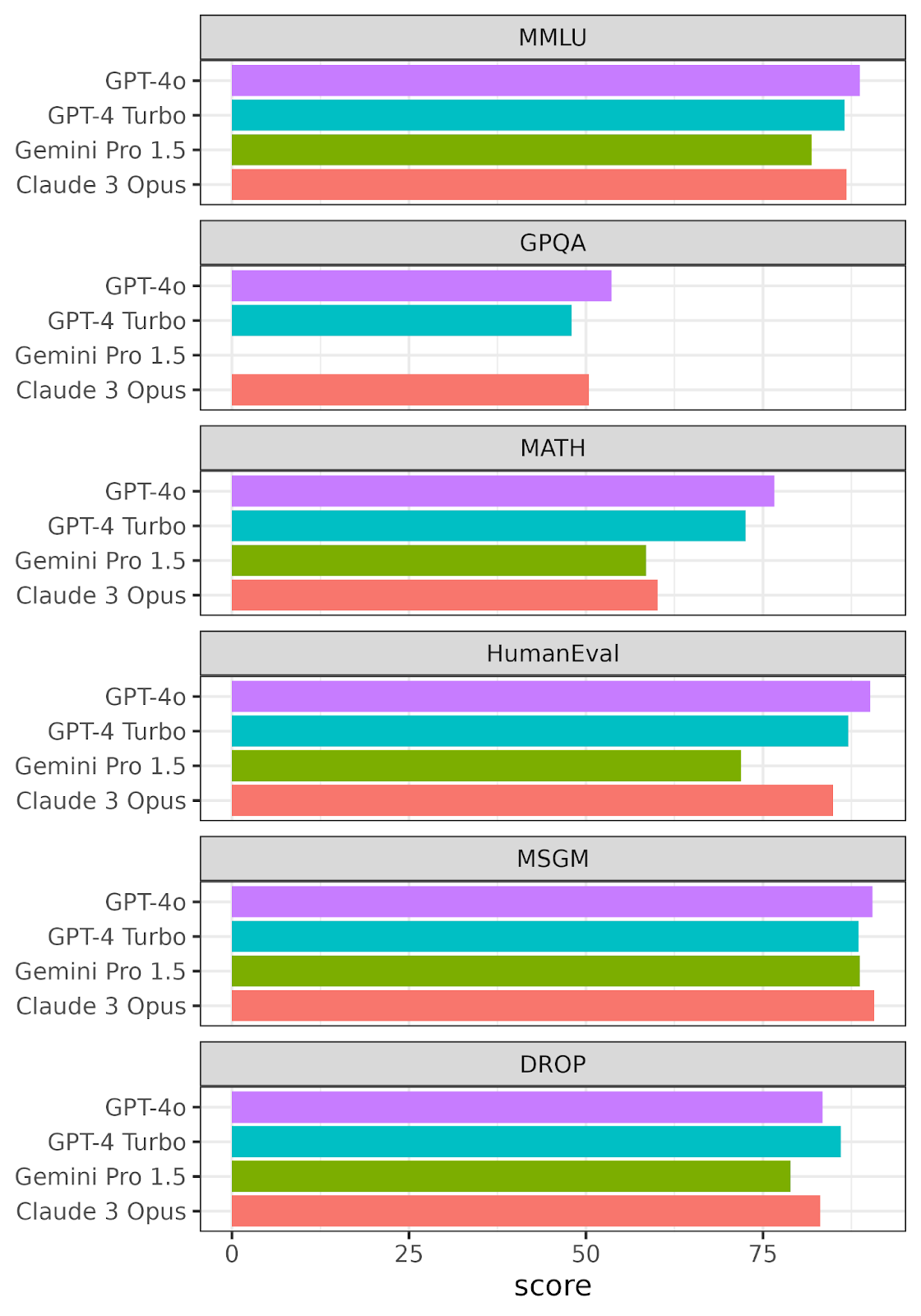

OpenAI a publié des données de référence sur la GPT-4o par rapport à plusieurs autres modèles haut de gamme.

- GPT-4 Turbo

- GPT-4 (version initiale)

- Claude 3 Opus

- Gemini Pro 1.5

- Gemini Ultra 1.0

- Llama 3 400B

Parmi ceux-ci, seuls trois modèles sont réellement importants pour la comparaison. GPT 4 Turbo, Claude 3 Opus et Gemini Pro 1.5 ont passé les derniers mois à se battre pour la première place du classement de la LMSYS Chatbot Arena.

Le Llama 3 400B pourrait être un concurrent à l'avenir, mais il n'est pas encore terminé. Nous ne présentons donc ici que les résultats pour ces trois modèles et le GPT-4o.

Les résultats de six tests de référence ont été utilisés.

- Massive Multitask Language Understanding (MMLU). Tâches portant sur les mathématiques élémentaires, l'histoire des États-Unis, l'informatique, le droit, etc. Pour atteindre un niveau de précision élevé lors de ce test, les modèles doivent posséder une connaissance approfondie du monde et une capacité à résoudre des problèmes.

- Q&R à l'épreuve de Google (GPQA) de niveau universitaire. Questions à choix multiples rédigées par des experts en biologie, physique et chimie. Les questions sont de grande qualité et extrêmement difficiles : les experts qui ont obtenu ou poursuivent un doctorat dans les domaines correspondants atteignent un taux d'exactitude de 74 %.

- MATH. Problèmes de mathématiques au collège et au lycée.

- HumanEval. Test de correction fonctionnelle d'un code informatique, utilisé pour vérifier la génération de code.

- Mathématiques scolaires multilingues (MSGM). Problèmes de mathématiques de l'école primaire, traduits en dix langues, y compris dans des langues sous-représentées comme le bengali et le swahili.

- Raisonnement discret sur les paragraphes (DROP). Les questions qui requièrent la compréhension de paragraphes complets. Par exemple, en additionnant, en comptant ou en triant des valeurs réparties sur plusieurs phrases.

Performances de GPT-4o, GPT-4 Turbo, Gemini Pro 1.5 et Claude 3 Opus par rapport à six points de référence LLM. Les notes pour chaque critère de référence vont de 0 à 100. Recréé à partir de données fournies par OpenAI. Aucune donnée n'a été fournie pour Gemini Pro 1.5 pour le benchmark GPQA.

GPT-4o obtient le meilleur score dans quatre des benchmarks, bien qu'il soit battu par Claude 3 Opus dans le benchmark MSGM et par GPT-4 Turbo dans le benchmark DROP. Dans l'ensemble, cette performance est impressionnante et prometteuse pour la nouvelle approche de la formation multimodale.

Si vous regardez de près les chiffres de GPT-4o comparés à ceux de GPT-4 Turbo, vous constaterez que l'augmentation des performances n'est que de quelques points de pourcentage.

Il s'agit d'une augmentation impressionnante un an plus tard, mais on est loin des bonds spectaculaires des performances de GPT-1 à GPT-2 ou de GPT-2 à GPT-3.

Une amélioration de 10 % de la capacité de raisonnement sur les textes d'une année sur l'autre est probablement la nouvelle norme. Les fruits à portée de main ont été cueillis et il est difficile de continuer à faire de grands pas dans le raisonnement textuel.

D'autre part, les performances de l'IA sur les problèmes multimodaux ne sont pas prises en compte dans ces benchmarks LLM. Le concept est tellement nouveau que nous ne disposons pas de moyens efficaces pour mesurer la qualité d'un modèle dans les domaines du texte, de l'audio et de la vision.

Dans l'ensemble, les performances de GPT-4o sont impressionnantes et prometteuses pour la nouvelle approche de la formation multimodale.

Quels sont les cas d'utilisation du GPT-4o ?

1. GPT-4o pour l'analyse des données et les tâches de codage

Les modèles GPT récents et leurs dérivés, comme GitHub Copilot, sont déjà capables de fournir une assistance au code, y compris l'écriture du code et l'explication et la correction des erreurs. Les capacités multimodales du GPT-4o offrent des possibilités intéressantes.

Dans une vidéo promotionnelle animée par Mira Murati, directrice technique d'OpenAI, deux chercheurs d'OpenAI, Mark Chen et Barret Zoph, ont fait une démonstration de l'utilisation de GPT-4o pour travailler avec un peu de code Python.

Le code est partagé avec GPT sous forme de texte, et la fonction d'interaction vocale est utilisée pour demander à GPT d'expliquer le code. Plus tard, après avoir exécuté le code, la capacité de vision de GPT-4o est utilisée pour expliquer le tracé.

Dans l'ensemble, il est potentiellement plus simple de montrer votre écran à ChatGPT et de lui poser une question que d'enregistrer un tracé dans un fichier image, de le télécharger vers ChatGPT, puis de taper une question.

2. GPT-4o pour la traduction en temps réel

Préparez-vous à partir en vacances avec le GPT-4o. Les capacités vocales à faible latence du GPT-4o signifient que la traduction en temps réel est désormais possible (si vous avez des données d'itinérance sur votre plan de téléphone portable !) Cela signifie que voyager dans des pays dont vous ne parlez pas la langue est devenu beaucoup plus facile.

3. Jeu de rôle avec GPT-4o

Le chatGPT a déjà été un outil utile pour les jeux de rôle, que vous prépariez un entretien d'embauche pour la carrière de vos rêves dans le domaine des données ou que vous formiez votre équipe de vente à mieux vendre votre produit.

Jusqu'à présent, il fonctionnait mieux pour les jeux de rôle en texte seul, ce qui n'est pas idéal pour ces cas d'utilisation. Les capacités vocales améliorées signifient que le jeu de rôle oral est désormais une option viable.

4. GPT-4o pour l'assistance aux utilisateurs malvoyants

La capacité du GPT-4o à comprendre les données vidéo provenant d'une caméra et à décrire verbalement la scène pourrait être une fonction indispensable pour les personnes malvoyantes. Il s'agit essentiellement de la fonction de description audio dont disposent les téléviseurs, mais dans la vie réelle.

GPT-4o en action

J'ai eu accès à certaines des nouvelles fonctionnalités de GPT-4o juste après l'annonce (malheureusement, il n'y a pas encore de chat vocal), et j'ai été impressionné par nombre de ses résultats. Les réponses semblent plus rapides et plus cohérentes, et il semble mieux comprendre mes demandes qu'auparavant. Cela ne veut pas dire que tout a été parfait.

Voici quelques exemples des interactions que j'ai eues avec le ChatGPT-4o :

Tâche d'analyse des données

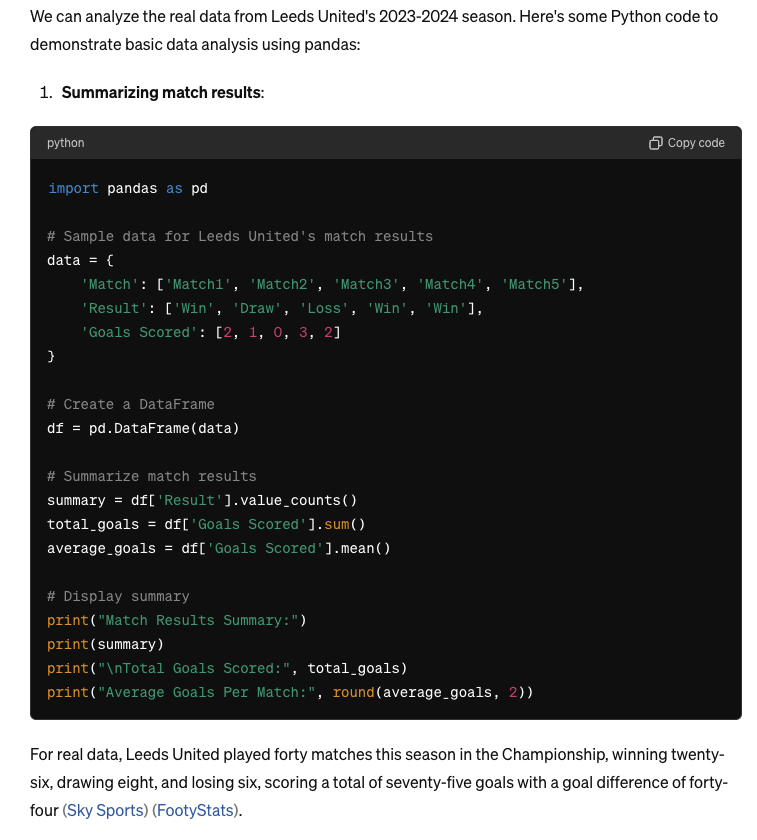

Tout d'abord, en utilisant le chat vocal, je lui ai demandé s'il avait des idées pour analyser les performances de l'équipe de football que je soutiens, la puissante Leeds United. En plus de proposer plusieurs options, il m'a donné un exemple de code Python :

import pandas as pd

# Sample data for Leeds United's match results

data = {

'Match': ['Match1', 'Match2', 'Match3', 'Match4', 'Match5'],

'Result': ['Win', 'Draw', 'Loss', 'Win', 'Win'],

'Goals Scored': [2, 1, 0, 3, 2]

}

# Create a DataFrame

df = pd.DataFrame(data)

# Summarize match results

summary = df['Result'].value_counts()

total_goals = df['Goals Scored'].sum()

average_goals = df['Goals Scored'].mean()

# Display summary

print("Match Results Summary:")

print(summary)

print("\nTotal Goals Scored:", total_goals)

print("Average Goals Per Match:", round(average_goals, 2))

Cependant, lorsque j'ai approfondi cette idée, les choses se sont un peu gâtées. J'ai d'abord demandé des données réelles à utiliser - il a cherché sur le web et trouvé deux bonnes sources, mais il a rapporté les statistiques de manière erronée. Leeds a disputé 46 matches au cours de la saison régulière, marquant 81 buts avec une différence de buts de plus 38, alors qu'il n'en a disputé que 40 dans sa réponse.

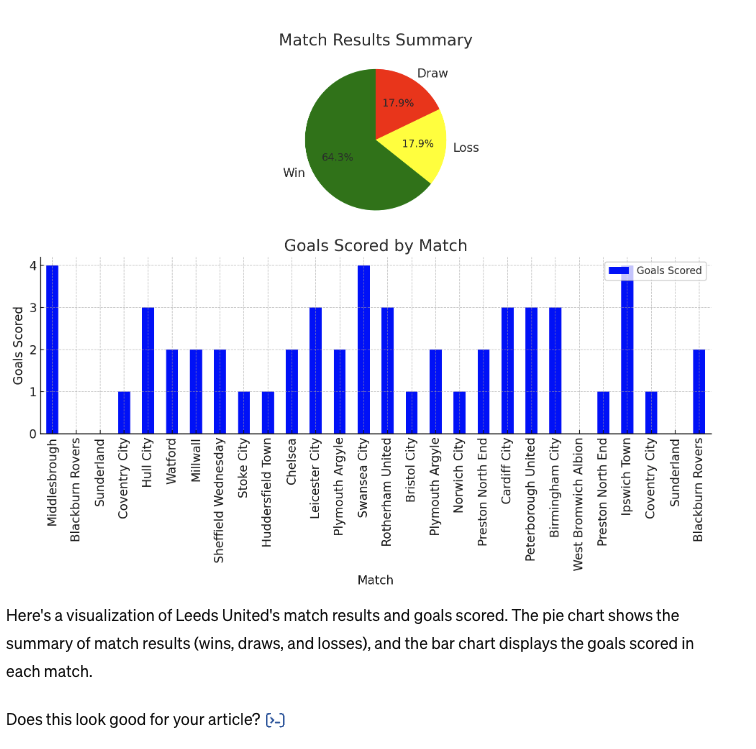

J'ai ensuite demandé à ChatGPT de visualiser les buts marqués contre chaque équipe :

Là encore, la tâche est à moitié accomplie. Elle a créé une visualisation comme demandé, qui semble correcte à première vue. Mais en réalité, beaucoup de données sont inventées et inexactes (équipes apparaissant deux fois, buts non comptabilisés, et équipes n'appartenant pas à la même division que Leeds).

En toute honnêteté, j'imagine que les performances auraient été meilleures si j'avais fourni moi-même un ensemble complet de données, mais j'aurais aimé que le logiciel le dise plutôt que d'inventer des réponses en toute confiance.

Analyse d'images

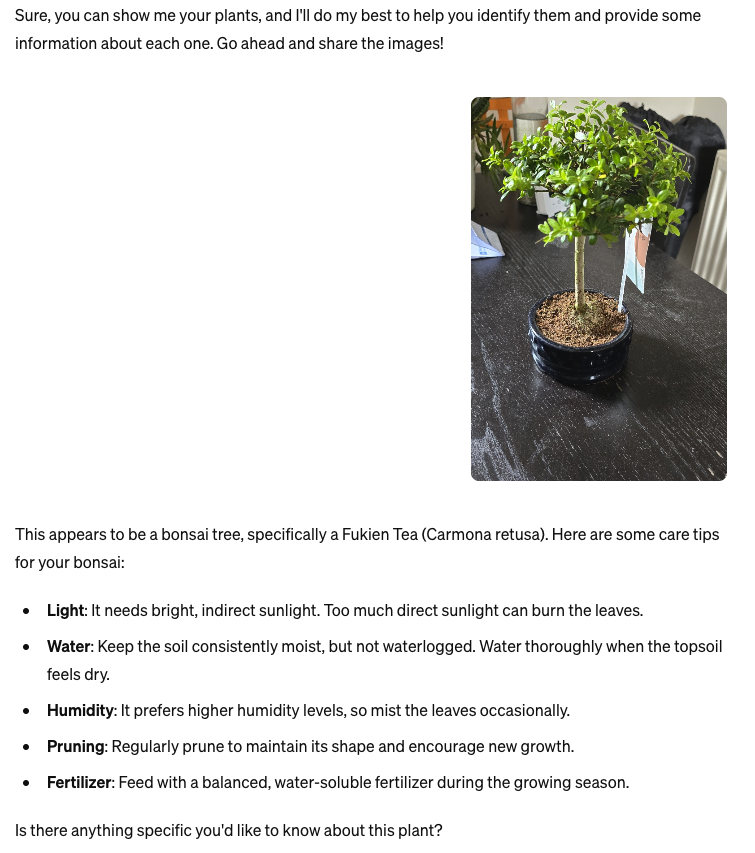

Ensuite, j'ai demandé à GPT-4o d'analyser une photo d'une de mes plantes. Je n'ai toujours pas accès à la fonction de vision intégrée, j'ai donc dû prendre une photo et demander à ChatGPT de quelle plante il s'agissait :

Ce n'est pas un mauvais effort, même s'il n'est pas tout à fait exact. Bien qu'il s'agisse d'un bonsaï, il s'agit d'un Ilex crenata et non d'un Carmona retusa. Néanmoins, les deux se ressemblent beaucoup et c'est donc une erreur facile à commettre. J'ai apprécié le contexte supplémentaire sur la façon de prendre soin de la plante.

Génération d'images

Enfin, j'ai voulu tester les capacités d'image du nouveau modèle. Je lui ai d'abord montré une photo de ma tortue, Darwin, et je lui ai demandé de me parler de mon ami :

Encore une fois, c'est proche mais pas parfait. Darwin est en fait une tortue de Horsefield plutôt qu'une tortue d'Hermann, mais elles se ressemblent beaucoup. J'ai ensuite demandé à ChatGPT-4o de prendre l'image originale et de la recréer dans le style de Hokusai. Voici le résultat :

Il s'agit d'un bon travail, même s'il n'y a pas beaucoup de ressemblance avec l'image originale, mais je pense que c'est une bonne chose. Il a fallu un peu de temps pour générer celle-ci aussi.

Dans l'ensemble, cependant, j'ai été impressionné par la réactivité du nouveau modèle et par la manière dont il a compris mes demandes. C'est loin d'être parfait, et il y a encore des hallucinations parfois, mais j'ai hâte de mettre la main à la pâte avec l'amélioration de la parole et de la vision intégrée.

GPT-4o Limitations et risques

La réglementation de l'IA générative n'en est qu'à ses débuts ; la loi européenne sur l'IA est le seul cadre juridique notable en place à ce jour. Cela signifie que les entreprises qui créent de l'IA doivent prendre leurs propres décisions sur ce qui constitue une IA sûre.

L'OpenAI dispose d'un cadre de préparation qu'elle utilise pour déterminer si un nouveau modèle peut être présenté au public.

Ce cadre permet de tester quatre domaines de préoccupation.

- Cybersécurité. L'IA peut-elle accroître la productivité des cybercriminels et contribuer à la création d'exploits ?

- BCRN. L'IA peut-elle aider les experts à créer des menaces biologiques, chimiques, radiologiques ou nucléaires ?

- La persuasion. L'IA peut-elle créer un contenu (potentiellement interactif) qui persuade les gens de changer leurs croyances ?

- Modèle d'autonomie. L'IA peut-elle agir en tant qu'agent, en réalisant des actions avec d'autres logiciels ?

Chaque domaine de préoccupation est classé comme faible, moyen, élevé ou critique, et la note du modèle est la plus élevée des notes obtenues dans les quatre catégories.

L'OpenAI s'engage à ne pas diffuser un modèle qui pose un problème critique, bien qu'il s'agisse d'une barre de sécurité relativement basse : selon ses définitions, un problème critique correspond à quelque chose qui mettrait en péril la civilisation humaine. GPT-4o l'évite aisément et marque une inquiétude moyenne.

Production imparfaite

Comme pour toutes les IA génératives, le modèle ne se comporte pas toujours comme prévu. La vision par ordinateur n'est pas parfaite et les interprétations d'une image ou d'une vidéo ne sont donc pas garanties.

De même, les transcriptions de discours sont rarement correctes à 100 %, en particulier si l'orateur a un fort accent ou s'il utilise des mots techniques.

OpenAI a fourni une vidéo de quelques prises de vue où GPT-4o n'a pas fonctionné comme prévu.

Notamment, la traduction entre deux langues autres que l'anglais a été l'un des cas d'échec. Parmi les autres problèmes, citons un ton de voix inadapté (condescendant) et le fait de ne pas parler la bonne langue.

Risque accéléré de "deepfakes" audio

L'annonce d'OpenAI précise que "nous reconnaissons que les modalités audio de GPT-4o présentent une variété de nouveaux risques". À bien des égards, GPT-4o peut accélérer l'essor des appels frauduleux de type "deepfake", où l'IA se fait passer pour des célébrités, des hommes politiques, des amis et des membres de la famille. Il s'agit d'un problème qui ne fera que s'aggraver avant d'être résolu, et GPT-4o a le pouvoir de rendre les appels d'escroquerie par deepfake encore plus convaincants.

Pour limiter ce risque, la sortie audio n'est disponible que dans une sélection de voix prédéfinies.

On peut supposer que les escrocs qui ont l'esprit technique peuvent utiliser la GPT-4o pour générer du texte, puis utiliser leur propre modèle de synthèse vocale, mais il n'est pas certain que cela leur permettrait de bénéficier des avantages de la GPT-4o en termes de latence et de tonalité de la voix.

Date de sortie du GPT-4o

À partir du 19 juillet 2024, de nombreuses fonctionnalités du GPT-4o ont été progressivement mises en place. Les fonctionnalités de texte et d'image sont ajoutées pour de nombreux utilisateurs sur les plans Plus et gratuit. Il s'agit notamment du chatGPT auquel on accède sur les navigateurs mobiles. De même, les fonctions de texte et de vision de GPT-4o sont déjà disponibles via l'API.

Ces fonctionnalités de GPT-4o sont largement disponibles sur les applications mobiles iOS et Android. Cependant, nous attendons toujours le nouveau mode vocal, qui sera mis à jour pour utiliser le GPT-4o, l'API ajoutera des capacités audio et vidéo pour le GPT-4o, et le nouveau modèle sera disponible sur Mac Desktop. L'accès à cette dernière est également progressivement étendu aux utilisateurs Plus, et une application de bureau Windows est prévue pour la fin de l'année.

Vous trouverez ci-dessous un résumé des dates de sortie du GPT-4o :

- Annonce du GPT-4o: 13 mai 2024

- Déploiement des capacités de texte et d'image du GPT-4o: À partir du 13 mai 2024

- GPT-4o disponible pour les utilisateurs gratuits et les utilisateurs Plus: À partir du 13 mai 2024

- Accès à l'API pour GPT-4o (texte et vision) : À partir du 13 mai 2024

- Disponibilité de GPT-4o sur le bureau de Mac pour les utilisateurs Plus : Semaines à venir (à partir du 13 mai 2024)

- Nouvelle version de Voice Mode avec GPT-4o en alpha: Semaines/mois à venir (après le 13 mai 2024)

- Prise en charge de l'API pour les capacités audio et vidéo: Semaines/mois à venir (après le 13 mai 2024)

- GPT-4o mini : 18 juillet 2024

Toutefois, après la controverse suscitée par la démonstration des nouvelles capacités vocales, il semble qu'OpenAI soit prudente quant à la diffusion de ces fonctionnalités. Selon leur blog mis à jour, "Au cours des semaines et des mois à venir, nous travaillerons sur l'infrastructure technique, la facilité d'utilisation via la post-formation, et la sécurité nécessaire pour lancer les autres modalités. Par exemple, lors du lancement, les sorties audio seront limitées à une sélection de voix prédéfinies et respecteront nos politiques de sécurité existantes".

Combien coûte GPT-4o ?

Bien qu'il soit plus rapide que le GPT-4 Turbo et doté de meilleures capacités de vision, le GPT-4o sera environ 50 % moins cher que son prédécesseur. Selon le site web de l'OpenAI, l'utilisation du modèle coûtera 5 dollars par million de jetons en entrée et 15 dollars par million de jetons en sortie.

Comment puis-je accéder à GPT-4o dans la version Web de ChatGPT ?

L'interface utilisateur du ChatGPT a changé. Tous les messages dans ChatGPT utilisent par défaut GPT-4o, et le modèle peut être changé en GPT-3.5 en utilisant une bascule sous la réponse.

Que signifie le GPT-4o pour l'avenir ?

Il existe deux écoles de pensée sur la direction que devrait prendre l'IA. L'une d'elles est que l'IA devrait devenir de plus en plus puissante et être capable d'accomplir un plus grand nombre de tâches. D'autre part, l'IA doit s'améliorer pour résoudre des tâches spécifiques de la manière la plus économique possible.

La mission d'OpenAI, qui consiste à créer une intelligence artificielle générale (AGI), ainsi que son modèle commercial, la placent résolument dans le premier camp. GPT-4o est un pas de plus vers l'objectif d'une IA toujours plus puissante.

Il s'agit de la première génération d'un modèle d'architecture entièrement nouveau pour l'OpenAI. Cela signifie que l'entreprise a beaucoup à apprendre et à optimiser au cours des prochains mois.

À court terme, attendez-vous à de nouveaux types de bizarreries et d'hallucinations, et à long terme, attendez-vous à des améliorations de performance, tant en termes de vitesse que de qualité des résultats.

Le moment choisi pour le GPT-4o est intéressant. Tout comme les géants de la technologie ont réalisé que Siri, Alexa et Google Assistant n'étaient pas les outils lucratifs qu'ils espéraient, OpenAI espère rendre l'IA à nouveau bavarde. Dans le meilleur des cas, l'IA générative se verra offrir une multitude de nouveaux cas d'utilisation. Au moins, vous pouvez maintenant programmer une minuterie dans la langue de votre choix.

Conclusion

GPT-4o représente un progrès supplémentaire dans l'IA générative, combinant le traitement du texte, de l'audio et de l'image en un seul modèle efficace. Cette innovation promet des réponses plus rapides, des interactions plus riches et un plus large éventail d'applications, allant de la traduction en temps réel à l'analyse améliorée des données et à l'amélioration de l'accessibilité pour les malvoyants.

Malgré les limites et les risques initiaux, tels que l'utilisation abusive potentielle dans des escroqueries de type "deepfake" et la nécessité d'une optimisation plus poussée, GPT-4o constitue une nouvelle étape vers l'objectif de l'OpenAI en matière d'intelligence artificielle générale. À mesure qu'il devient plus accessible, le GPT-4o pourrait modifier la façon dont nous interagissons avec l'IA, en l'intégrant dans les tâches quotidiennes et professionnelles.

Grâce à son coût réduit et à ses capacités améliorées, le GPT-4o est prêt à établir une nouvelle norme dans l'industrie de l'IA, en élargissant les possibilités pour les utilisateurs dans divers domaines.

L'avenir de l'IA est passionnant, et c'est le moment ou jamais de commencer à apprendre comment fonctionne cette technologie. Si vous êtes nouveau dans le domaine, commencez par notre parcours de compétences Fondamentaux de l'IA, qui couvre des connaissances exploitables sur des sujets tels que le ChatGPT, les modèles de langage de grande taille, l'IA générative, et plus encore. Vous pouvez également apprendre à travailler avec l'API OpenAI dans notre cours pratique, ou consulter notre catalogue complet de cours sur l'IA.

Richie aide les individus et les organisations à mieux utiliser les données et l'IA. Il est data scientist depuis bien avant que l'on parle de data science, et a écrit deux livres et créé de nombreux cours DataCamp sur le sujet. Il est l'hôte du podcast DataFramed et dirige le programme de webinaires de DataCamp.

FAQ

Le GPT-4o peut-il gérer des conversations multilingues ?

Oui, le GPT-4o peut gérer des conversations multilingues et fournir une traduction en temps réel entre les langues grâce à ses capacités vocales à faible latence. Cependant, lors de la démonstration, quelques erreurs se sont produites lors du traitement des traductions.

GPT-4o supporte-t-il toutes les langues de la même manière ?

Bien que GPT-4o ait amélioré la tokenisation pour les alphabets non romains, les performances peuvent varier d'une langue à l'autre, en particulier pour celles qui sont moins représentées dans les données d'apprentissage.

Comment la GPT-4o gère-t-elle les bruits de fond dans l'entrée audio ?

GPT-4o peut prendre en compte le bruit de fond lors du traitement de l'entrée audio, ce qui peut conduire à des réponses plus contextuelles.

Le GPT-4o est-il capable de générer du contenu vidéo ?

Non, le GPT-4o peut analyser et décrire un contenu vidéo, mais ne peut pas générer de nouveaux contenus vidéo. Sora d'OpenAI est le modèle qui peut générer du contenu vidéo.

Le GPT-4o peut-il imiter des voix spécifiques ?

Non, GPT-4o utilise une sélection de voix prédéfinies pour la sortie audio afin de réduire les risques tels que les escroqueries de type deepfake.

Quel est le degré de sécurité des données introduites dans GPT-4o ?

OpenAI applique des mesures de sécurité strictes, mais les utilisateurs doivent toujours être prudents et éviter de partager des informations sensibles.

GPT-4o peut-il être intégré dans des applications existantes ?

Oui, GPT-4o peut être intégré dans diverses applications via l'API OpenAI, ce qui permet d'améliorer les fonctionnalités sur différentes plateformes.

Consultez notre cours Travailler avec l'API OpenAI pour commencer à développer des applications basées sur l'IA.

Quand dois-je utiliser GPT-4o Mini plutôt que GPT-4o ?

GPT-4o Mini est idéal pour les tâches qui privilégient la rapidité et l'efficacité au détriment d'un raisonnement complexe ou d'interactions multimodales. Il est bien adapté aux tâches de codage simples, au débogage ou aux réponses rapides dans les applications légères, ce qui en fait une alternative rentable pour les projets qui ne nécessitent pas la pleine puissance du GPT-4o.

Quelles sont les différences entre le modèle GPT-4o et le modèle o1 ?

Le GPT-4o est conçu pour les tâches multimodales et traite efficacement les entrées textuelles, audio et visuelles. Le modèle o1, quant à lui, se concentre sur le raisonnement avancé et la résolution de problèmes complexes, excellant dans des domaines tels que le codage et les sciences. Alors que le GPT-4o offre polyvalence et rapidité, le modèle o1 privilégie le traitement logique en profondeur pour les tâches de raisonnement complexes.