Programa

A engenharia de dados virou uma das funções mais importantes na indústria de tecnologia, sendo a espinha dorsal da infraestrutura de dados para empresas em todo o mundo. À medida que as empresas dependem cada vez mais da tomada de decisões baseadas em dados, a procura por engenheiros de dados qualificados continua a aumentar.

Se você está se preparando para uma entrevista de engenharia de dados, deve estar bem preparado para responder a perguntas gerais e técnicas que avaliam sua experiência, capacidade de resolução de problemas e habilidades técnicas.

Nesta postagem do blog, a gente traz um guia completo pra te ajudar a se preparar pra diferentes etapas de uma entrevista de engenharia de dados, desde a triagem inicial do RH até avaliações técnicas detalhadas.

Torne-se um engenheiro de dados

Perguntas iniciais para a entrevista de engenheiro de dados de RH

Na primeira rodada de entrevistas com o RH, o gerente de RH vai perguntar sobre sua experiência profissional e o valor que você pode trazer para a empresa. Essa etapa é pra avaliar sua experiência, habilidades interpessoais e se você se encaixa na cultura da empresa.

1. O que faz de você o melhor candidato para essa vaga?

Se o gerente de contratação te escolher para uma entrevista por telefone, é porque viu algo que gostou no seu perfil. Aborde essa pergunta com confiança e fale sobre sua experiência e crescimento profissional.

É importante dar uma olhada no perfil da empresa e na descrição do cargo antes da entrevista. Isso vai te ajudar a entender o que o gerente de contratação está procurando e a adaptar sua resposta de acordo com isso.

Concentre-se em habilidades e experiências específicas que estejam alinhadas com os requisitos do cargo, como projetar e gerenciar pipelines de dados, modelagem e processos ETL. Mostre como sua combinação única de habilidades, experiência e conhecimento faz você se destacar.

2. Quais são as responsabilidades diárias de um engenheiro de dados?

Embora não exista uma resposta definitiva, compartilhar suas experiências de empregos anteriores e referir-se à descrição do cargo pode ajudar a dar uma resposta completa. Em geral, as responsabilidades diárias dos engenheiros de dados incluem:

- Desenvolver, testar e cuidar de bancos de dados.

- Criando soluções de dados com base nas necessidades do negócio.

- Aquisição e integração de dados.

- Desenvolver, validar e manter pipelines de dados para processos ETL, modelagem, transformação e serviço.

- Implantar e gerenciar modelos de machine learning em alguns casos.

- Manter a qualidade dos dados limpando, validando e monitorando os fluxos de dados.

- Melhorando a confiabilidade, o desempenho e a qualidade do sistema.

- Seguir as diretrizes de governança e segurança de dados para garantir a conformidade e a integridade dos dados.

3. Qual é a parte mais difícil de ser engenheiro de dados?

Essa pergunta vai variar de acordo com as experiências de cada um, mas os desafios comuns incluem:

- Acompanhar o ritmo acelerado dos avanços tecnológicos e integrar novas ferramentas para melhorar o desempenho, a segurança, a confiabilidade e o retorno sobre o investimento dos sistemas de dados.

- Entender e implementar protocolos complexos de governança e segurança de dados.

- Gerenciar planos de recuperação de desastres e garantir a disponibilidade e integridade dos dados durante eventos inesperados.

- Equilibrando as necessidades do negócio com as limitações técnicas e prevendo as demandas futuras de dados.

- Tratar grandes volumes de dados de forma eficiente e garantir a qualidade e a consistência dos dados.

4. Com quais ferramentas ou estruturas de dados você tem experiência? Tem algum que você prefere mais do que os outros?

Sua resposta vai depender das suas experiências. Conhecer as ferramentas modernas e integrações de terceiros vai te ajudar a responder com confiança a essa pergunta. Falar sobre ferramentas relacionadas a:

- Gerenciamento de banco de dados (por exemplo, MySQL, PostgreSQL, MongoDB)

- Armazenamento de dados (por exemplo, Amazon Redshift, Google BigQuery, Snowflake)

- Orquestração de dados (por exemplo, Apache Airflow, Prefect)

- Pipelines de dados (por exemplo, Apache Kafka, Apache NiFi)

- Gerenciamento de nuvem (por exemplo, AWS, Google Cloud Platform, Microsoft Azure)

- Limpeza, modelagem e transformação de dados (por exemplo, pandas, dbt, Spark)

- Processamento em lote e em tempo real (por exemplo, Apache Spark, Apache Flink)

Lembre-se, não tem resposta errada pra essa pergunta. O entrevistador está avaliando suas habilidades e experiência.

5. Como você fica por dentro das últimas tendências e avanços em engenharia de dados?

Essa pergunta avalia o seu compromisso com o aprendizado contínuo e com a atualização no seu campo de atuação.

Você pode falar sobre assinar boletins informativos do setor, acompanhar blogs influentes, participar de fóruns e comunidades online, participar de webinars e conferências e fazer cursos online. Destaque fontes ou plataformas específicas que você usa para se manter informado.

6. Você pode contar uma vez em que teve que trabalhar com uma equipe multifuncional pra terminar um projeto?

A engenharia de dados geralmente envolve trabalhar com várias equipes, incluindo cientistas de dados, analistas e pessoal de TI.

Compartilhe um exemplo específico em que você colaborou com sucesso com outras pessoas, destacando suas habilidades de comunicação, capacidade de entender diferentes perspectivas e como você contribuiu para o sucesso do projeto. Explique os desafios que você enfrentou e como você os superou para alcançar o resultado desejado.

Torne-se um engenheiro de dados

Perguntas para entrevista de engenheiro de dados técnicos

A engenharia de dados é altamente técnica, então não é surpresa que a maior parte do seu processo de entrevista envolva perguntas e exercícios técnicos. Nesta seção, vamos falar sobre diferentes tipos de perguntas e respostas técnicas, com foco em perguntas para iniciantes, Python, SQL, baseadas em projetos e de gerenciamento.

Perguntas para entrevista de engenheiro de dados júnior

As entrevistas para engenheiros juniores focam em ferramentas, Python e consultas SQL. Também podem incluir perguntas sobre gerenciamento de banco de dados e processos ETL, incluindo desafios de codificação e testes para fazer em casa.

Quando as empresas contratam recém-formados, elas querem ter certeza de que você consegue lidar com os dados e sistemas delas de forma eficaz.

7. Você pode explicar os esquemas de design relevantes para a modelagem de dados?

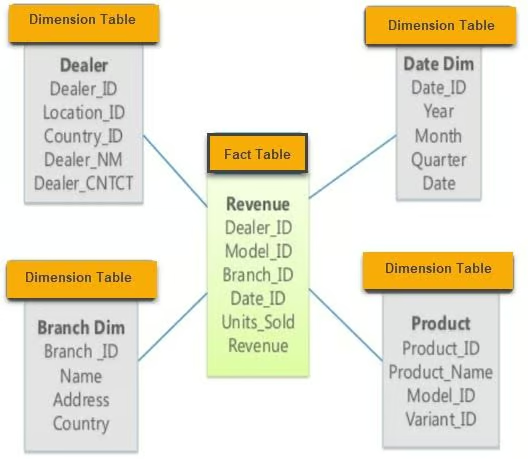

Existem três esquemas principais de modelagem de dados: estrela, floco de neve (Snowflake) e galáxia.

- Esquema em estrela: Esse esquema tem várias tabelas de dimensões conectadas a uma tabela de fatos central. É simples e fácil de entender, o que o torna ideal para consultas diretas.

Exemplo de esquema em estrela. Imagem de guru99

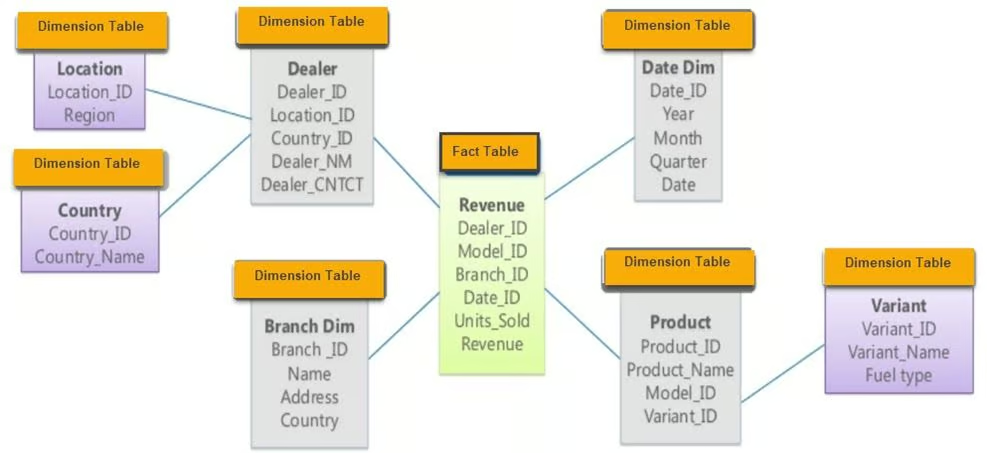

- Snowflake schema: Uma extensão do esquema em estrela, o esquema em floco de neve tem uma tabela de fatos e várias tabelas de dimensões com camadas adicionais de normalização, formando uma estrutura parecida com um floco de neve. Isso reduz a redundância e melhora a integridade dos dados.

Exemplo de esquema Snowflake. Imagem de guru99

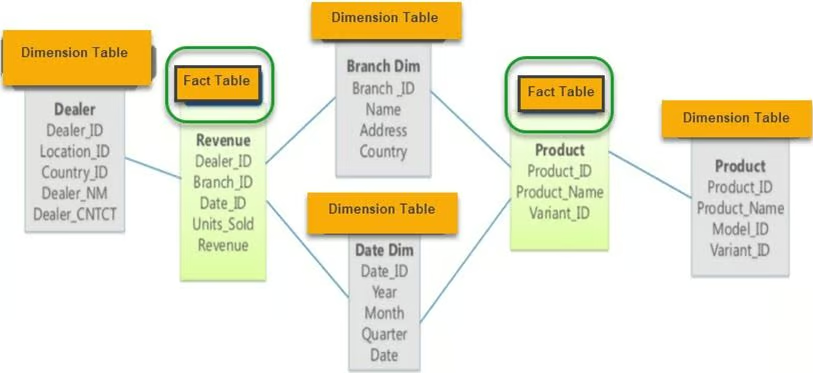

- Esquema da galáxia: Também conhecido como esquema de constelação de fatos, ele tem duas ou mais tabelas de fatos que compartilham tabelas de dimensões. Esse esquema é ideal para sistemas de banco de dados complexos que precisam de várias tabelas de fatos.

Exemplo de esquema Galaxy. Imagem de guru99

8. Com quais ferramentas ETL você já trabalhou? Qual é o seu favorito e por quê?

Ao responder a essa pergunta, fale sobre as ferramentas ETL que você domina e explique por que escolheu ferramentas específicas para determinados projetos. Discuta os prós e contras de cada ferramenta e como elas se encaixam no seu fluxo de trabalho. Ferramentas populares de código aberto incluem:

- dbt (ferramenta de construção de dados): Ótimo pra transformar dados no seu warehouse usando SQL.

- Apache Spark: Ótimo para processamento de dados em grande escala e processamento em lote.

- Apache Kafka: Usado para pipelines de dados em tempo real e streaming.

- Airbyte: Uma ferramenta de integração de dados de código aberto que ajuda na extração e carregamento de dados.

Se você precisa atualizar seus conhecimentos sobre ETL, considere fazer o curso Introdução à Engenharia de Dados.

9. O que é orquestração de dados e quais ferramentas você pode usar pra fazer isso?

A orquestração de dados é um processo automático pra acessar dados brutos de várias fontes, fazer limpeza, transformação e modelagem de dados, e usar isso pra tarefas analíticas. Isso garante que os dados fluam bem entre os diferentes sistemas e etapas do processamento.

Ferramentas populares para orquestração de dados incluem:

- Apache Airflow: Muito usado para planejar e acompanhar fluxos de trabalho.

- Prefeito: Uma ferramenta moderna de orquestração com foco no fluxo de dados.

- Dagster: Uma ferramenta de orquestração feita pra lidar com cargas de trabalho cheias de dados.

- AWS Glue: Um serviço ETL gerenciado que simplifica a preparação de dados para análise.

10. Que ferramentas você usa para engenharia analítica?

A engenharia analítica envolve transformar dados processados, aplicar modelos estatísticos e visualizá-los por meio de relatórios e painéis.

Ferramentas populares para engenharia analítica incluem:

- dbt (ferramenta de construção de dados): Isso é usado para transformar dados no seu warehouse usando SQL.

- BigQuery: Um warehouse totalmente gerenciado e sem servidor para análises de dados em grande escala.

- Postgres: Um sistema de banco de dados relacional poderoso e de código aberto.

- Metabase: Uma ferramenta de código aberto que permite fazer perguntas sobre seus dados e mostrar as respostas de um jeito fácil de entender.

- Google Data Studio: Isso é usado para criar painéis e relatórios visuais.

- Tableau: Uma plataforma líder em visualização de dados.

Essas ferramentas ajudam a acessar, transformar e visualizar dados para obter insights significativos e apoiar os processos de tomada de decisão.

11. Qual é a diferença entre os sistemas OLAP e OLTP?

O OLAP (Processamento Analítico Online) analisa dados históricos e dá suporte a consultas complexas. É otimizado para cargas de trabalho com muitas leituras e costuma ser usado em warehouse para tarefas de inteligência empresarial. O OLTP ( Processamento de Transações Online) foi feito pra cuidar de dados transacionais em tempo real. É otimizado para cargas de trabalho com muitas gravações e é usado em bancos de dados operacionais para as operações diárias dos negócios.

A principal diferença está no objetivo deles: O OLAP ajuda na tomada de decisões, enquanto o OLTP dá suporte às operações do dia a dia.

Se você ainda tiver dúvidas, recomendo ler a postagem do blog OLTP vs OLAP.

Perguntas para entrevista de engenheiro de dados Python

Python é a linguagem mais popular em engenharia de dados por causa da sua versatilidade e do rico ecossistema de bibliotecas disponíveis para processamento, análise e automação de dados. Aqui estão algumas perguntas relacionadas ao Python que você pode encontrar em uma entrevista de engenharia de dados.

12. Quais bibliotecas Python são mais eficientes para o processamento de dados?

As bibliotecas de processamento de dados mais populares em Python incluem:

- pandas: Ótimo pra mexer e analisar dados, oferecendo estruturas de dados como DataFrame.

- NumPy: Essencial para cálculos numéricos, suportando grandes matrizes e arranjos multidimensionais.

- Dask: Facilita a computação paralela e consegue lidar com cálculos maiores que a memória usando uma sintaxe parecida com a do pandas, que todo mundo conhece.

- PySpark: Uma API Python para o Apache Spark, que é útil para processamento de dados em grande escala e análises em tempo real.

Cada uma dessas bibliotecas tem prós e contras, e a escolha depende dos requisitos específicos dos dados e da escala das tarefas de processamento de dados.

13. Como você faz web scraping em Python?

A extração de dados da web em Python geralmente envolve as seguintes etapas:

1. Acesse a página da web usando a biblioteca requests:

import requests

from bs4 import BeautifulSoup

url = 'http://example.com'

response = requests.get(url)

soup = BeautifulSoup(response.text, 'html.parser')2. Extraia tabelas e informações usando o BeautifulSoup:

tables = soup.find_all('table')3. Converta para um formato estruturado usando pandas:

import pandas as pd

data = []

for table in tables:

rows = table.find_all('tr')

for row in rows:

cols = row.find_all('td')

cols = [ele.text.strip() for ele in cols]

data.append(cols)

df = pd.DataFrame(data)4. Limpe os dados usando pandas e NumPy:

df.dropna(inplace=True) # Drop missing values5. Salve os dados como um arquivo CSV:

df.to_csv('scraped_data.csv', index=False)Em alguns casos, pandas.read_html pode facilitar o processo:

df_list = pd.read_html('http://example.com')

df = df_list[0] # Assuming the table of interest is the first one14. Como você lida com grandes conjuntos de dados no Python que não cabem na memória?

Para lidar com grandes conjuntos de dados que não cabem na memória, é preciso usar ferramentas e técnicas feitas para computação fora do núcleo:

- Dask: Permite computação paralela e funciona com conjuntos de dados maiores que a memória usando uma sintaxe parecida com a do pandas.

import dask.dataframe as dd

df = dd.read_csv('large_dataset.csv')- PySpark: Permite o processamento distribuído de dados, o que é útil para lidar com dados em grande escala.

from pyspark.sql import SparkSession

spark = SparkSession.builder.appName('data_processing').getOrCreate()

df = spark.read.csv('large_dataset.csv', header=True, inferSchema=True)- Chunking com pandas: Leia grandes conjuntos de dados em partes.

import pandas as pd

chunk_size = 10000

for chunk in pd.read_csv('large_dataset.csv', chunksize=chunk_size):

process(chunk) # Replace with your processing function15. Como você garante que seu código Python seja eficiente e otimizado para desempenho?

Para garantir que o código Python seja eficiente e otimizado para desempenho, considere as seguintes práticas:

- Perfil: Use ferramentas de perfilagem como

cProfile,line_profileroumemory_profilerpara identificar gargalos no seu código.

import cProfile

cProfile.run('your_function()')- Vetorização: Use

numpyoupandaspara operações vetorizadas em vez de loops.

import numpy as np

data = np.array([1, 2, 3, 4, 5])

result = data * 2 # Vectorized operation- Estruturas de dados eficientes: Escolha as estruturas de dados certas (por exemplo, listas, conjuntos, dicionários) com base no seu caso de uso.

data_dict = {'key1': 'value1', 'key2': 'value2'} # Faster lookups compared to lists- Processamento paralelo: Use multithreading ou multiprocessamento para tarefas que podem ser feitas em paralelo.

from multiprocessing import Pool

def process_data(data_chunk):

# Your processing logic here

return processed_chunk

with Pool(processes=4) as pool:

results = pool.map(process_data, data_chunks)- Evitar cálculos desnecessários: Armazene em cache os resultados de operações caras, caso precisem ser reutilizados.

from functools import lru_cache

@lru_cache(maxsize=None)

def expensive_computation(x):

# Perform expensive computation

return result16. Como você garante a integridade e a qualidade dos dados nos seus pipelines de dados?

A integridade e a qualidade dos dados são importantes para uma engenharia de dados confiável. As melhores práticas incluem:

- Validação de dados: Faça verificações em várias etapas do fluxo de dados para validar formatos, intervalos e consistência dos dados.

def validate_data(df):

assert df['age'].min() >= 0, "Age cannot be negative"

assert df['salary'].dtype == 'float64', "Salary should be a float"

# Additional checks...- Limpeza de dados: Use bibliotecas como

pandaspara limpar e pré-processar dados, lidando com valores ausentes, removendo duplicatas e corrigindo erros.

df.dropna(inplace=True) # Drop missing values

df.drop_duplicates(inplace=True) # Remove duplicates- Testes automatizados: Desenvolva testes unitários para funções de processamento de dados usando frameworks como

pytest.

import pytest

def test_clean_data():

raw_data = pd.DataFrame({'age': [25, -3], 'salary': ['50k', '60k']})

clean_data = clean_data_function(raw_data)

assert clean_data['age'].min() >= 0

assert clean_data['salary'].dtype == 'float64'- Monitoramento e alertas: Configure o monitoramento dos seus pipelines de dados para detectar anomalias e enviar alertas quando surgirem problemas de qualidade dos dados.

from airflow import DAG

from airflow.operators.dummy_operator import DummyOperator

from airflow.operators.email_operator import EmailOperator

# Define your DAG and tasks...17. Como você lida com dados ausentes nos seus conjuntos de dados?

Lidar com dados ausentes é uma tarefa comum na engenharia de dados. As abordagens incluem:

- Remoção: É só tirar as linhas ou colunas com dados faltando, se elas não forem importantes.

df.dropna(inplace=True)- Imputação: Preencha os valores que faltam com medidas estatísticas (média, mediana) ou use métodos mais sofisticados, como imputação KNN.

df['column'].fillna(df['column'].mean(), inplace=True)- Variável indicadora: Adicione uma variável indicadora para especificar quais valores estavam faltando.

df['column_missing'] = df['column'].isnull().astype(int)- Imputação baseada em modelo: Use modelagem preditiva para estimar valores ausentes.

from sklearn.impute import KNNImputer

imputer = KNNImputer(n_neighbors=5)

df = pd.DataFrame(imputer.fit_transform(df), columns=df.columns)18. Como você lida com os limites de taxa da API ao buscar dados em Python?

Pra lidar com os limites de taxa da API, tem estratégias como:

- Recuar e tentar de novo: Implementando o backoff exponencial quando os limites de taxa são atingidos.

- Paginação: Buscando dados em partes menores usando as opções de paginação da API.

- Armazenamento em cache: Armazenando respostas para evitar chamadas API redundantes.

Exemplo usando a biblioteca Python time e o módulo requests:

import time

import requests

def fetch_data_with_rate_limit(url):

for attempt in range(5): # Retry up to 5 times

response = requests.get(url)

if response.status_code == 429: # Too many requests

time.sleep(2 ** attempt) # Exponential backoff

else:

return response.json()

raise Exception("Rate limit exceeded")Python é, sem dúvida, uma das linguagens mais importantes na engenharia de dados. Você pode aprimorar suas habilidades fazendo nosso programa de Engenheiro de Dados em Python, que tem um currículo completo pra te dar conceitos modernos de engenharia de dados, linguagens de programação, ferramentas e estruturas.

Perguntas para entrevista de engenheiro de dados SQL

A etapa de codificação SQL é uma parte importante do processo de contratação de engenheiros de dados. Praticar vários scripts simples e complexos pode te ajudar a se preparar. Os entrevistadores podem pedir pra você escrever consultas pra análise de dados, expressões de tabela comum, classificação, adicionar subtotais e funções temporárias.

19. O que são Expressões de Tabela Comum (CTEs) em SQL?

Os CTEs são usados para simplificar junções complexas e executar subconsultas. Elas ajudam a tornar as consultas SQL mais legíveis e fáceis de manter. Aqui está um exemplo de uma CTE que mostra todos os alunos com especialização em Ciências e nota A:

SELECT *

FROM class

WHERE id IN (

SELECT DISTINCT id

FROM students

WHERE grade = "A"

AND major = "Science"

);Usando um CTE, a consulta fica assim:

WITH temp AS (

SELECT id

FROM students

WHERE grade = "A"

AND major = "Science"

)

SELECT *

FROM class

WHERE id IN (SELECT id FROM temp);Os CTEs podem ser usados para problemas mais complexos e vários CTEs podem ser encadeados.

20. Como você classifica os dados no SQL?

Os engenheiros de dados geralmente classificam os valores com base em parâmetros como vendas e lucro. A função ` RANK() ` é usada para classificar dados com base em uma coluna específica:

SELECT

id,

sales,

RANK() OVER (ORDER BY sales DESC) AS rank

FROM bill;Como alternativa, você pode usar DENSE_RANK(), que não pula as classificações seguintes se os valores forem iguais.

21. Dá pra criar uma função temporária simples e usar numa consulta SQL?

Assim como no Python, você pode criar funções em SQL para deixar suas consultas mais elegantes e evitar declarações case repetitivas. Aqui está um exemplo de uma função temporária get_gender:

CREATE TEMPORARY FUNCTION get_gender(type VARCHAR) RETURNS VARCHAR AS (

CASE

WHEN type = "M" THEN "male"

WHEN type = "F" THEN "female"

ELSE "n/a"

END

);

SELECT

name,

get_gender(type) AS gender

FROM class;Essa abordagem deixa seu código SQL mais limpo e fácil de manter.

22. Como adicionar subtotais no SQL?

Pode adicionar subtotais usando as funções GROUP BY e ROLLUP(). Aqui vai um exemplo:

SELECT

department,

product,

SUM(sales) AS total_sales

FROM sales_data

GROUP BY ROLLUP(department, product);Essa consulta vai te dar um subtotal para cada departamento e um total geral no final.

23. Como você lida com dados ausentes no SQL?

Lidar com dados ausentes é essencial para manter a integridade dos dados. Abordagens comuns incluem:

- Usando

COALESCE(): Essa função mostra o primeiro valor que não é nulo na lista.

SELECT id, COALESCE(salary, 0) AS salary FROM employees;- Usando instruções `

CASE`: Para lidar com valores ausentes de forma condicional.

SELECT id,

CASE

WHEN salary IS NULL THEN 0

ELSE salary

END AS salary

FROM employees;24. Como você faz a agregação de dados no SQL?

A agregação de dados envolve o uso de funções agregadas como SUM(), AVG(), COUNT(), MIN() e MAX(). Aqui vai um exemplo:

SELECT department,

SUM(salary) AS total_salary,

AVG(salary) AS average_salary,

COUNT(*) AS employee_count

FROM employees

GROUP BY department;25. Como você otimiza consultas SQL para melhorar o desempenho?

Para otimizar consultas SQL, você pode:

- Use índices em colunas consultadas com frequência para acelerar as pesquisas.

- Evite o erro “

SELECT *” especificando apenas as colunas necessárias. - Use as junções com sabedoria e evite as desnecessárias.

- Otimize usando subconsultas, substituindo-as por CTEs quando for o caso.

- Analise os planos de execução de consultas para identificar gargalos. Exemplo:

EXPLAIN ANALYZE

SELECT customer_id, COUNT(order_id)

FROM orders

GROUP BY customer_id;Resolver exercícios de codificação SQL é a melhor maneira de praticar e revisar conceitos esquecidos. Você pode avaliar suas habilidades em SQL fazendo o teste de Análise de Dados em SQL do DataCamp (você vai precisar de uma conta para acessar essa avaliação).

Perguntas para entrevista de engenheiro de dados relacionadas ao projeto

Depois das rodadas gerais de entrevistas, você geralmente passa para uma etapa técnica que inclui desafios de programação, resolução de problemas, desenho de sistemas de banco de dados em um quadro branco, uma prova para fazer em casa e perguntas analíticas.

Essa etapa pode ser bem intensa, então conhecer algumas das perguntas e respostas mais comuns em entrevistas de engenharia de dados pode te ajudar a se sair bem na entrevista.

26. Me conta sobre um projeto em que você trabalhou do começo ao fim.

Essa resposta deve surgir naturalmente se você já trabalhou em um projeto de engenharia de dados como estudante ou profissional. Dito isso, se preparar com antecedência é sempre útil. Veja como organizar sua resposta:

- Introdução e problema comercial:

- Comece explicando o contexto do projeto. Descreva o problema comercial que você estava resolvendo e os objetivos do projeto.

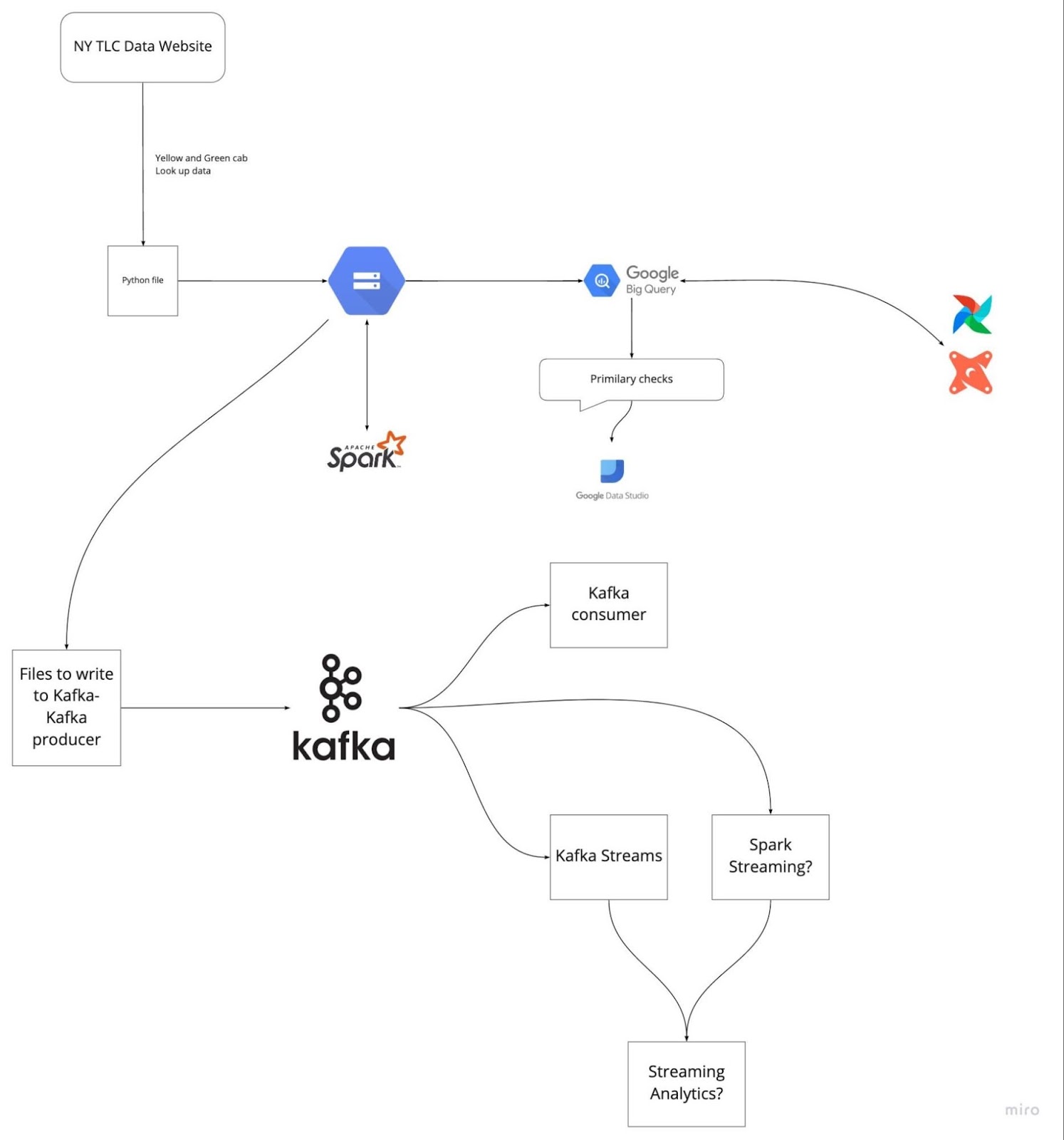

- Exemplo: Nesse projeto, a gente tentou otimizar o fluxo de dados para processar os dados do Registro de Viagens da TLC, pra melhorar o desempenho das consultas e a precisão dos dados pra equipe de análise.

- Ingestão de dados:

- Descreva como você acessou e inseriu os dados brutos.

- Exemplo: A gente pegou os dados brutos do TLC Trip Record usando GCP, Airflow e PostgreSQL pra garantir uma entrada de dados confiável de várias fontes.

- Processamento e transformação de dados:

- Explique as etapas seguidas para limpar, transformar e estruturar os dados.

- Exemplo: Usamos o Apache Spark para processamento em lote e o Apache Kafka para streaming em tempo real para lidar com a transformação de dados. Os dados foram limpos, validados e convertidos em um formato estruturado adequado para análise.

- Armazenamento e warehouse de dados:

- Fala sobre as soluções de armazenamento de dados usadas e por que elas foram escolhidas.

- Exemplo: Os dados processados foram armazenados no Google BigQuery, que ofereceu uma solução de warehouse escalável e eficiente. O Airflow foi usado para gerenciar os fluxos de trabalho de dados.

- Engenharia analítica:

- Dá uma olhada nas ferramentas e métodos usados para fins analíticos.

- Exemplo: Usamos dbt (ferramenta de construção de dados), BigQuery, PostgreSQL, Google Data Studio e Metabase para engenharia analítica. Essas ferramentas ajudaram a criar modelos de dados robustos e a gerar relatórios e painéis informativos.

- Implantação e ambiente de nuvem:

- Fala sobre as estratégias de implantação e a infraestrutura em nuvem usadas.

- Exemplo: Todo o projeto foi implementado usando GCP, Terraform e Docker, garantindo um ambiente de nuvem escalável e confiável.

- Desafios e soluções:

- Fale sobre os desafios que você enfrentou e como você os superou.

- Exemplo: Um dos principais desafios era lidar com um monte de dados em tempo real. Resolvemos isso otimizando nossos trabalhos de streaming do Kafka e implementando transformações eficientes do Spark.

- Resultados e impacto:

- Conclua descrevendo os resultados e o impacto do projeto.

- Exemplo: O projeto melhorou bastante o desempenho das consultas e a precisão dos dados para a equipe de análise, o que ajudou a tomar decisões mais rápidas e ter insights melhores.

Image from DataTalksClub/data-engineering-zoomcamp

Se você se preparar antes, dando uma olhada nos últimos cinco projetos em que trabalhou, vai conseguir evitar aquele frio na barriga durante a entrevista. Entenda o problema e as soluções que você implementou. Pratique explicar cada etapa de forma clara e direta.

Perguntas para entrevista de gerente de engenheiro de dados

Para cargos de gerente de engenharia, as perguntas geralmente são sobre tomada de decisões, entendimento do negócio, organização e manutenção de conjuntos de dados, conformidade e políticas de segurança.

27. Qual é a diferença entre um warehouse e um banco de dados operacional?

Um data warehouse fornece dados históricos para tarefas de análise de dados e tomada de decisões. Ele suporta processamento analítico de alto volume, como Processamento Analítico Online (OLAP). Os data warehouses são feitos pra lidar com consultas complexas que acessam várias linhas e são otimizados pra operações que exigem muita leitura. Eles suportam alguns usuários simultâneos e são projetados para recuperar grandes volumes de dados de forma rápida e eficiente.

Os sistemas operacionais de gerenciamento de banco de dados (OLTP) cuidam de conjuntos de dados dinâmicos em tempo real. Eles suportam o processamento de transações de alto volume para milhares de clientes simultâneos, tornando-os adequados para operações diárias. Os dados geralmente consistem em informações atuais e atualizadas sobre transações e operações comerciais. Os sistemas OLTP são otimizados para operações com muitas gravações e processamento rápido de consultas.

28. Por que você acha que toda empresa que usa sistemas de dados precisa de um plano de recuperação de desastres?

A gestão de desastres é responsabilidade de um gerente de engenharia de dados. Um plano de recuperação de desastres garante que os sistemas de dados possam ser restaurados e continuar funcionando em caso de um ataque cibernético, falha de hardware, desastre natural ou outros eventos catastróficos. Os pontos importantes são:

- Backup em tempo real: Fazendo backup regularmente de arquivos e bancos de dados em locais de armazenamento seguros e externos.

- Redundância de dados: Implementar a replicação de dados em diferentes lugares geográficos para garantir a disponibilidade.

- Protocolos de segurança: Criar protocolos para monitorar, rastrear e restringir o tráfego de entrada e saída para evitar violações de dados.

- Procedimentos de recuperação: Procedimentos detalhados para restaurar dados e sistemas de forma rápida e eficiente, minimizando o tempo de inatividade.

- Testes e exercícios: Testar regularmente o plano de recuperação de desastres por meio de simulações e exercícios para garantir sua eficácia e fazer os ajustes necessários.

29. Como você encara a tomada de decisões quando lidera uma equipe de engenharia de dados?

Como gerente de engenharia de dados, tomar decisões envolve equilibrar considerações técnicas com objetivos de negócios. Algumas abordagens incluem:

- Decisões baseadas em dados: Usar a análise de dados para tomar decisões, garantindo que elas sejam baseadas em insights objetivos, e não na intuição.

- Colaboração entre as partes interessadas: Trabalhar junto com as pessoas interessadas para entender as necessidades do negócio e alinhar os esforços de engenharia de dados com os objetivos da empresa.

- Avaliação de riscos: Avaliar os riscos possíveis e como eles podem afetar os projetos e criar estratégias para diminuir esses riscos.

- Metodologias ágeis: Implementar práticas ágeis para se adaptar às mudanças nos requisitos e entregar valor de forma gradual.

- Orientação e desenvolvimento: Apoiar o crescimento dos membros da equipe, oferecendo orientação e oportunidades de treinamento e promovendo um ambiente colaborativo.

30. Como você lida com a conformidade com as regulamentações de proteção de dados em seus projetos de engenharia de dados?

Cumprir as regras de proteção de dados envolve várias práticas, tipo:

- Entendendo as regras: Ficar por dentro das regras de proteção de dados, tipo GDPR, CCPA e HIPAA.

- Estrutura de governança de dados: Implementar uma estrutura robusta de governança de dados que inclua políticas de privacidade, segurança e controle de acesso aos dados.

- Criptografia de dados: Criptografar dados confidenciais tanto em repouso quanto em trânsito para impedir o acesso não autorizado.

- Controles de acesso: Implementar controles de acesso rigorosos garante que só quem tem autorização possa acessar dados confidenciais.

- Auditorias e monitoramento: Fazer auditorias e monitorar o acesso e uso de dados regularmente para detectar e resolver rapidamente qualquer problema de conformidade.

31. Você pode descrever um projeto desafiador de engenharia de dados que você gerenciou?

Ao discutir um projeto desafiador, você pode se concentrar nos seguintes aspectos:

- Escopo e objetivos do projeto: Defina claramente os objetivos do projeto e o problema comercial que ele visa resolver.

- Desafios encontrados: Fala sobre os desafios específicos, tipo limitações técnicas, restrições de recursos ou problemas de alinhamento entre as partes interessadas.

- Estratégias e soluções: Explique seus métodos para superar esses desafios, incluindo soluções técnicas, práticas de gestão de equipe e envolvimento das partes interessadas.

- Resultados e impacto: Destaque os resultados positivos e o impacto nos negócios, como melhoria na qualidade dos dados, aumento no desempenho do sistema ou maior eficiência operacional.

32. Como você avalia e implementa novas tecnologias de dados?

Avaliar e implementar novas tecnologias de dados envolve:

- Pesquisa de mercado: Ficar por dentro das últimas novidades e tendências em tecnologias de engenharia de dados.

- Prova de conceito (PoC): Fazendo projetos de PoC pra testar se novas tecnologias funcionam e trazem benefícios no seu contexto específico.

- Análise de custo-benefício: Avaliando os custos, benefícios e potencial retorno sobre o investimento da adoção de novas tecnologias.

- Apoio das partes interessadas: Apresentar conclusões e recomendações às partes interessadas para garantir a adesão e o apoio.

- Plano de implementação: Desenvolver um plano de implementação detalhado que inclua cronogramas, alocação de recursos e estratégias de gestão de riscos.

- Treinamento e suporte: Oferecer treinamento e apoio à equipe para garantir uma transição tranquila para as novas tecnologias.

33. Como você prioriza tarefas e projetos em um ambiente acelerado?

Uma maneira eficaz de priorizar tarefas é com base no impacto delas nos objetivos de negócios e na urgência. Você pode usar estruturas como a Matriz de Eisenhower para categorizar tarefas em quatro quadrantes: urgentes e importantes, importantes, mas não urgentes, urgentes, mas não importantes, e nenhuma das duas coisas. Além disso, converse com as pessoas envolvidas para combinar as prioridades e garantir que a equipe se concentre nas atividades mais importantes.

Perguntas para entrevistas de engenheiro de dados FAANG

Nesta seção, vamos ver as perguntas mais frequentes em entrevistas de engenharia de dados feitas por gerentes do Facebook, Amazon e Google para vagas nessa área.

Perguntas para entrevista de engenheiro de dados do Facebook

34. Por que usamos clusters no Kafka e quais são os benefícios disso?

Um cluster Kafka é composto por vários brokers que distribuem dados por várias instâncias. Essa arquitetura oferece escalabilidade e tolerância a falhas sem tempo de inatividade. Se o cluster principal parar de funcionar, outros clusters Kafka podem oferecer os mesmos serviços, garantindo alta disponibilidade.

A arquitetura do cluster Kafka inclui Tópicos, Corretores, ZooKeeper, Produtores e Consumidores. Ele lida com fluxos de dados de forma eficiente para aplicações de big data, permitindo a criação de aplicações robustas baseadas em dados.

35. Que problemas resolve o Apache Airflow?

O Apache Airflow permite que você gerencie e programe pipelines para fluxos de trabalho analíticos, gerenciamento de warehouse e transformação e modelagem de dados. Ele oferece:

- Gerenciamento de pipeline: Uma plataforma para definir, programar e monitorar fluxos de trabalho.

- Registro centralizado: Monitore os registros de execução em um só lugar.

- Tratamento de erros: Callbacks para enviar alertas de falha para plataformas de comunicação como Slack e Discord.

- Interface do usuário: Uma interface de usuário fácil de usar para gerenciar e visualizar fluxos de trabalho.

- Integração: Integrações robustas com várias ferramentas e sistemas.

- Código aberto: É grátis e tem um monte de gente que ajuda.

Perguntas da entrevista para engenheiro de dados da Amazon

36. Você recebe um endereço IP como entrada em forma de string. Como você descobriria se é um endereço IP válido ou não?

Pra saber se um endereço IP tá certo, dá pra dividir a sequência de caracteres em “.” e fazer várias verificações pra validar cada parte. Aqui está uma função Python para fazer isso:

def is_valid(ip):

ip = ip.split(".")

for i in ip:

if len(i) > 3 or int(i) < 0 or int(i) > 255:

return False

if len(i) > 1 and int(i) == 0:

return False

if len(i) > 1 and int(i) != 0 and i[0] == '0':

return False

return True

A = "255.255.11.135"

B = "255.050.11.5345"

print(is_valid(A)) # True

print(is_valid(B)) # False37. Quais são os vários modos no Hadoop?

O Hadoop funciona principalmente em três modos:

- Modo autônomo: Esse modo é usado pra fins de depuração. Ele não usa o HDFS e depende do sistema de arquivos local para entrada e saída.

- Modo pseudo-distribuído: Esse é um cluster de nó único, onde o NameNode e o DataNode ficam na mesma máquina. É usado principalmente para testes e desenvolvimento.

- Modo totalmente distribuído: Esse é um modo pronto para produção, no qual os dados são distribuídos por vários nós, com nós separados para os daemons mestre (NameNode) e escravo (DataNode).

Perguntas da entrevista para engenheiro de dados do Google

38. Como você lidaria com pontos de dados duplicados em uma consulta SQL?

DISTINCT Para lidar com duplicatas no SQL, você pode usar a palavra-chave `DUPLICATE` ou excluir linhas duplicadas usando ` ROWID ` com a função ` MAX ` ou ` MIN `. Aqui estão alguns exemplos:

Usando DISTINCT:

SELECT DISTINCT Name, ADDRESS

FROM CUSTOMERS

ORDER BY Name;Apagando duplicatas usando o ROWID:

DELETE FROM Employee

WHERE ROWID NOT IN (

SELECT MAX(ROWID)

FROM Employee

GROUP BY Name, ADDRESS

);39. Dada uma lista de n-1 números inteiros, esses números estão no intervalo de 1 a n. Não tem nada repetido na lista. Um dos números inteiros está faltando na lista. Você consegue escrever um código eficiente para encontrar o número inteiro que está faltando?

Esse desafio comum de codificação pode ser resolvido usando uma abordagem matemática:

def search_missing_number(list_num):

n = len(list_num)

# Check if the first or last number is missing

if list_num[0] != 1:

return 1

if list_num[-1] != n + 1:

return n + 1

# Calculate the sum of the first n+1 natural numbers

total = (n + 1) * (n + 2) // 2

# Calculate the sum of all elements in the list

sum_of_L = sum(list_num)

# Return the difference, which is the missing number

return total - sum_of_L

# Validation

num_list = [1, 2, 3, 4, 5, 6, 7, 8, 9, 10, 11, 13]

print("The missing number is", search_missing_number(num_list)) # The missing number is 12Como se preparar para a entrevista de engenheiro de dados

Antes de ir para uma entrevista, você deve revisar todos os conceitos e termos padrão usados em engenharia de dados. Aqui estão algumas das áreas mais importantes em que você deve se concentrar:

- Domine o SQL: Você deve praticar a criação, modificação e gerenciamento de bancos de dados. Além disso, você deve dominar a análise, modelagem e transformação de dados.

- Resolva desafios de programação: Resolva desafios de programação em Python, Scala ou C++. A maioria das empresas avalia as habilidades de programação com provas para fazer em casa e desafios de programação ao vivo.

- Crie um pipeline ETL: pratique a criação de pipelines de dados, ETL ou entrega. Você precisa entender como testar, validar, dimensionar e manter pipelines de dados.

- Engenharia analítica: prática de carregamento, transformação e análise de dados. Aprenda a criar um painel para qualidade de dados e desempenho do sistema.

- Dá uma olhada nas possíveis perguntas: Prepare-se para a entrevista revisando exemplos de perguntas simuladas. Uma simples pesquisa no Google vai te dar acesso a centenas de perguntas.

- Aprenda sobre as ferramentas modernas de engenharia de dados: mesmo que você não tenha experiência com essas ferramentas, é bom saber como elas funcionam e como se integram com outras ferramentas. As empresas estão sempre procurando ferramentas melhores para melhorar o desempenho com um custo menor.

- Aprenda sobre processamento em lote e streaming: O Apache Spark é usado para processamento em lote, e o Apache Kafka é usado para streaming de dados. Essas ferramentas são muito procuradas e vão te ajudar a conseguir um emprego nas melhores empresas.

- Ambiente: Às vezes, o entrevistador vai perguntar sobre computação em nuvem (GCP, AWS, Azure), Docker, scripting, Terraform e Kubernetes. Você pode usar essas ferramentas para configurar recursos de computação e armazenamento na nuvem ou no local. Entender essas tecnologias e colocá-las nos projetos do portfólio é uma boa ideia.

Preparar-se para uma entrevista de engenharia de dados pode ser desafiador, mas com os recursos certos e prática, você pode se destacar e conseguir o emprego dos seus sonhos. Para melhorar ainda mais suas habilidades e conhecimentos, confira estes recursos valiosos:

- Entendendo a engenharia de dados: Entenda bem os conceitos e princípios da engenharia de dados.

- Engenheiro de dados em Python: Domine a engenharia de dados com Python através deste programa, que abrange ferramentas e estruturas essenciais.

- Design de banco de dados: Aprenda o básico sobre design de bancos de dados para criar bancos de dados eficientes e escaláveis.

Aproveite esses cursos para fortalecer sua base e se manter à frente na sua carreira em engenharia de dados. Boa sorte nas entrevistas!

Torne-se um engenheiro de dados

Perguntas frequentes

O que posso esperar de uma entrevista para engenheiro de dados?

Você pode esperar uma triagem por telefone com o RH, uma triagem técnica por telefone, um exame para fazer em casa, um desafio de codificação, uma entrevista presencial, projetos de banco de dados e sistemas em quadro branco, uma entrevista sobre SQL e, finalmente, a entrevista “executiva” para verificar a adequação cultural.

Algumas empresas têm três etapas de entrevistas, enquanto outras têm até nove etapas. As organizações geralmente têm uma barreira alta para testar os candidatos em todos os níveis.

Os engenheiros de dados estão em alta?

Sim, toda empresa que gera dados precisa de engenheiros de dados para criar pipelines, gerenciar e entregar dados para vários departamentos. Até 2025, a gente vai estar produzindo 463 exabytes de dados por dia e vai precisar de cada vez mais engenheiros pra extrair, transformar e gerenciar os pipelines e sistemas de dados - weforum.org.

Os engenheiros de dados escrevem código?

Sim, todo mundo que trabalha com TI precisa aprender a programar, mesmo quem está em cargos de gerência. Para engenheiros de dados, Python, SQL, Docker, Yaml e Bash são linguagens de programação necessárias. Eles são usados em infraestrutura como código, pipelines, gerenciamento de banco de dados, streaming, web scraping, processamento de dados, modelagem e análise.

Qual é a diferença entre um analista de dados e um engenheiro de dados?

O engenheiro de dados coleta, transforma e prepara os dados para que os analistas de dados possam extrair insights valiosos para os negócios. Os engenheiros de dados cuidam de todos os sistemas de banco de dados e garantem que eles forneçam dados de alta qualidade para tarefas de análise de dados, como relatórios analíticos, painéis, pesquisas com clientes e previsões.

O que um engenheiro de dados realmente faz?

Pega dados de várias fontes, cria, valida e mantém pipelines de dados, transforma dados usando algoritmos, faz engenharia analítica, garante a conformidade com a governança e segurança de dados e mantém sistemas de banco de dados inteiros. Eles são responsáveis por fornecer fluxos de dados de alta qualidade para vários departamentos de uma empresa. Você pode saber mais sobre engenharia de dados lendo O que é engenharia de dados? blog.

Que habilidades você precisa para ser um engenheiro de dados?

Você precisa saber sobre programação, warehouse, ETL (Extract Transform Load), consultas SQL, análise e modelagem de dados, coisas importantes e habilidades de comunicação. A engenharia de dados é aprendida através da experiência e da superação de desafios complexos na prática. Nossa Certificação em Engenharia de Dados é a iniciativa perfeita para desenvolver suas habilidades e conseguir um cargo de engenheiro de dados.

Sou um cientista de dados certificado que gosta de criar aplicativos de aprendizado de máquina e escrever blogs sobre ciência de dados. No momento, estou me concentrando na criação e edição de conteúdo e no trabalho com modelos de linguagem de grande porte.