Programa

A Snowflake é uma plataforma de dados baseada na nuvem que aborda os desafios fundamentais do gerenciamento de dados moderno. Lançado em 2014, ele oferece às organizações uma solução centralizada para armazenar e processar operações de dados em grande escala.

Os sistemas tradicionais de gerenciamento de dados geralmente apresentam limitações significativas para as organizações. Esses sistemas normalmente exigem que as empresas escolham entre o desempenho da consulta, o acesso simultâneo do usuário e a relação custo-benefício. A arquitetura do Snowflake foi desenvolvida para eliminar essas restrições por meio de sua abordagem de armazenamento de dados e computação.

Este guia examina a estrutura arquitetônica e os mecanismos operacionais do Snowflake. Embora a plataforma incorpore tecnologias complexas, esta explicação se concentrará em tornar esses conceitos acessíveis aos leitores com um conhecimento básico de sistemas de dados.

O guia abordará:

- Os princípios fundamentais do sistema de armazenamento de dados da Snowflake

- Os componentes arquitetônicos que formam sua infraestrutura

- A abordagem da plataforma para acesso simultâneo a dados

- As vantagens técnicas que impulsionam sua adoção

Essa análise fornecerá a você um entendimento básico de como o Snowflake funciona na infraestrutura de dados moderna.

Para os leitores que estão começando a usar o Snowflake, a Introdução ao Snowflake para iniciantes fornece o conhecimento básico essencial.

Conceitos básicos da arquitetura Snowflake

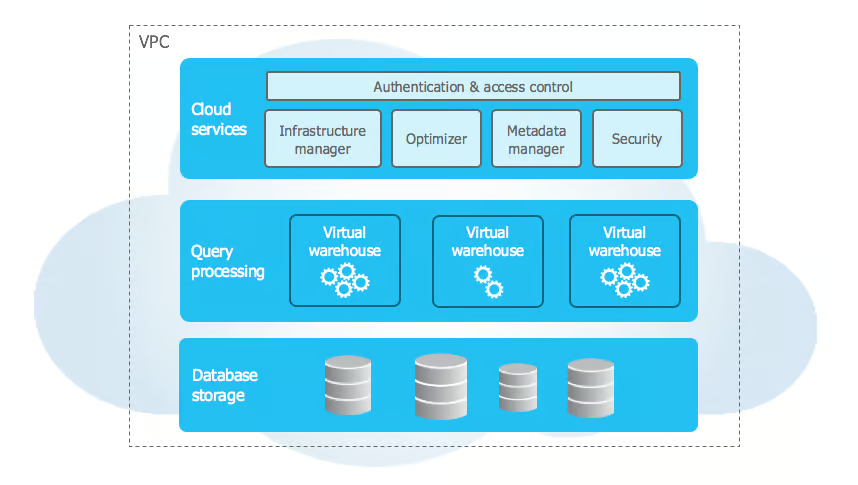

A arquitetura do Snowflake é diferente da tradicional data warehouse tradicionais, pois usa princípios modernos de nuvem para resolver os desafios de escalabilidade e desempenho. A arquitetura implementa uma abordagem em várias camadas que divide o armazenamento, a computação e os serviços em componentes separados, mas conectados.

Camadas da arquitetura Snowflake

Fonte: Documentação do floco de neve

A arquitetura da Snowflake usa um design exclusivo de três camadas que separa as principais funcionalidades e, ao mesmo tempo, mantém uma integração perfeita. Vamos examinar cada camada em detalhes:

1. Camada de armazenamento

A camada de armazenamento do Snowflake se baseia no armazenamento de objetos em nuvem (Amazon S3, Azure Blob Storageou Google Cloud Storage) e organiza os dados em micropartições imutáveis (50 a 500 MB) em um formato colunar compactado. Essas micropartições armazenam metadados, como valores mínimos/máximos de coluna, permitindo a redução eficiente de consultas.

Essa camada é auto-otimizada, não exigindo manutenção manual. Ele seleciona de forma inteligente o melhor algoritmo de compactação por coluna com base no tipo e nos padrões de dados, garantindo altas taxas de compactação e consultas analíticas rápidas por meio da leitura apenas das colunas necessárias.

2. Camada de computação

A camada de computação consiste em armazéns virtuais - clusters MPP independentes que executam consultas SQL e operações DML. Cada depósito executa vários nós em paralelo, operando em isolamento completo para evitar interferência no desempenho.

Esses recursos sem estado podem ser iniciados, interrompidos, redimensionados ou clonados sem afetar os dados. O redimensionamento redistribui as cargas de trabalho automaticamente, enquanto o recurso de suspensão automática pausa os armazéns inativos e os retoma em segundos, quando necessário.

3. Camada de serviços

A camada de serviços orquestra as operações do Snowflake, gerenciando um armazenamento de metadados distribuído que rastreia tabelas, visualizações, políticas de segurança e consultas. O otimizador de consultas aproveita esses metadados para gerar planos de execução eficientes com base na distribuição de dados, nos recursos de computação e nos padrões de acesso.

Ele garante a conformidade com ACID e o controle avançado de simultaneidade, além de lidar com a autenticação por meio de SSO, MFA e controle de acesso baseado em função em todos os níveis. Essa camada também gerencia o tratamento de sessões e a aplicação de segurança.

Como as camadas funcionam juntas

A interação entre as camadas do Snowflake permite recursos avançados, como compartilhamento seguro de dados, computação em vários clusters e escalabilidade dinâmica. O compartilhamento de dados é orientado por metadados - apenas ponteiros são trocados, enquanto o acesso é controlado por políticas de segurança refinadas. Os consumidores podem consultar dados compartilhados usando seus próprios recursos de computação sem duplicação.

A computação com vários clusters permite que clusters de computação independentes acessem a mesma camada de armazenamento, mantendo caches separados e garantindo a consistência. As cargas de trabalho podem ser isoladas por meio de armazéns dedicados a ETL, BI ou ciência de dados. A arquitetura do Snowflake também oferece suporte à escalabilidade dinâmica, permitindo que o armazenamento e a computação sejam dimensionados independentemente, enquanto a camada de serviços otimiza a alocação de recursos e o desempenho das consultas.

Para se aprofundar nesses conceitos e em outros, você pode explorar o curso Introdução ao curso Snowflake.

Arquitetura do Data Warehouse da Snowflake

A arquitetura de data warehouse da Snowflake se baseia em seu design de três camadas para oferecer modelagem de dados flexível e processamento de consultas eficiente. Ele oferece suporte a dados estruturados e semiestruturados, otimizando o desempenho e simplificando o gerenciamento.

Modelo de dados

O Snowflake acomoda dados estruturados usando conceitos de banco de dados relacional, suportando tipos de dados SQL, restrições e relacionamentos por meio de chaves primárias e estrangeiras. As informações confidenciais se beneficiam da criptografia em nível de coluna. Para dados semiestruturados, o Snowflake lida nativamente com JSON, XML, Parquet e Avro usando o tipo de dados VARIANT, inferindo automaticamente esquemas e permitindo consultas eficientes com funções especializadas como FLATTEN e PARSE_JSON.

No nível de armazenamento, os dados são automaticamente divididos em micropartições de 50 a 500 MB, cada uma armazenando metadados como valores mínimos/máximos de coluna e frequências nulas. O Snowflake rastreia o agrupamento natural e reorganiza os dados periodicamente para melhorar a eficiência da consulta, eliminando a necessidade de gerenciamento manual de partições.

Arquitetura de processamento de consultas

O Snowflake processa as consultas por meio de várias camadas coordenadas que otimizam a execução. O otimizador de consultas transforma as consultas SQL em planos de execução lógica e avalia vários planos físicos com base no tamanho da tabela, na indexação e no armazenamento em cache. Usando um modelo de custo, ele seleciona a abordagem mais eficiente, determinando algoritmos de união, métodos de classificação e estratégias de movimentação de dados.

O mecanismo de execução distribui as consultas entre os nós de processamento paralelo. Ao aproveitar os metadados, ele elimina as partições desnecessárias e lê apenas as colunas relevantes no formato de armazenamento colunar do Snowflake, aumentando a eficiência. Um cache de resultados de 24 horas melhora ainda mais o desempenho, reutilizando resultados de consultas computadas anteriormente quando os dados subjacentes permanecem inalterados.

A arquitetura do Snowflake permite padrões eficientes de acesso a dados. A clonagem de cópia zero permite a duplicação instantânea de tabelas sem copiar dados, enquanto a viagem no tempo preserva versões históricas para consultas pontuais. O controle de simultaneidade de várias versões (MVCC) garante a consistência das transações, permitindo cargas de trabalho de alta simultaneidade sem conflitos de bloqueio. Essas otimizações, combinadas com o cache inteligente e o corte de partições, permitem que o Snowflake forneça análises dimensionáveis e de alto desempenho com o mínimo de intervenção manual.

Recursos avançados do Snowflake

O Snowflake oferece recursos avançados de gerenciamento de recursos, segurança, integração e monitoramento para aprimorar os recursos empresariais.

Gerenciamento de recursos

Seu gerenciamento dinâmico de recursos inclui programação e dimensionamento automático de armazéns, pausando automaticamente os armazéns inativos e ajustando os recursos de computação com base nas demandas de carga de trabalho. Os administradores podem definir programações automáticas de início/parada e aproveitar as métricas detalhadas dos recursos para otimizar os custos e o desempenho.

Consulta de governança

Os recursos de governança de consultas oferecem controle preciso sobre o consumo de recursos, incluindo limites dinâmicos, enfileiramento inteligente e roteamento de consultas personalizadas, garantindo um gerenciamento eficiente da carga de trabalho.

Integração empresarial

Para a integração empresarial, o Snowflake oferece suporte a procedimentos armazenados em JavaScript e Java, permitindo que os desenvolvedores implementem lógica comercial complexa além do SQL.

O controle de versão permite uma reversão fácil, enquanto o tratamento de erros garante uma execução tranquila com registro detalhado. A estrutura segura de troca de dados da plataforma permite que as organizações compartilhem e monetizem conjuntos de dados por meio de mercados de dados privados.

As empresas podem controlar o acesso, rastrear o uso e implementar o faturamento automatizado, criando novas oportunidades de receita e mantendo a conformidade e a segurança.

Esses recursos fortalecem coletivamente a posição da Snowflake como uma plataforma de dados abrangente, oferecendo escalabilidade, automação e segurança. Com o gerenciamento inteligente da carga de trabalho, integrações perfeitas e ferramentas robustas de governança, as organizações podem otimizar o desempenho, reduzir custos e colaborar com segurança nos ativos de dados.

Comparações de arquitetura

Vamos comparar a arquitetura do Snowflake com os data warehouses tradicionais e os concorrentes modernos para entender sua proposta de valor exclusiva.

Armazéns de dados tradicionais

Principais diferenças arquitetônicas:

- Os sistemas tradicionais acoplam firmemente o armazenamento e a computação

- O particionamento de dados físicos requer manutenção manual

- Planejamento da capacidade do hardware necessário para cargas de trabalho de pico

- Capacidade limitada de lidar com dados semiestruturados

Comparação de modelos de custo:

- O tradicional requer investimento inicial em hardware

- A capacidade deve levar em conta o crescimento futuro

- Os custos de manutenção incluem hardware e instalações

- Custos de licença normalmente baseados em núcleos de processador

Características de desempenho:

- Limitado por restrições físicas de hardware

- O dimensionamento de usuários simultâneos requer atualizações de hardware

- O desempenho da consulta diminui com o número de usuários

- Contenção de recursos entre cargas de trabalho

Concorrentes modernos

1. Amazon Redshift

- Arquitetura: Baseado em cluster; operações manuais de vácuo; usa mapas de zonas

- Custo: Preço por hora baseado em nó; limitado ao ecossistema da AWS

2. Google BigQuery

- Arquitetura: Sem servidor com preços baseados em slots; cache de consulta automático (retenção de 24 horas)

- Custo: Pagamento por byte digitalizado; controle de computação limitado

3. Azure Synapse

- Arquitetura: Híbrido (pools sem servidor e dedicados); gerenciamento complexo de recursos; suporta rowstore e columnstore

- Custo: Preços baseados em DTU ou vCore; integração com os serviços do Azure

Considerações adicionais sobre o desempenho:

1. Otimização de consultas

- BigQuery: Otimização automática, controle limitado do usuário

- Redshift: Operações manuais de vácuo e análise

- Synapse: Requer atualizações de estatísticas e indexação

2. Tratamento de simultaneidade

- BigQuery: Sistema de alocação de slots

- Redshift: Gerenciamento de carga de trabalho com base em filas

- Synapse: Atribuições de classe de recursos

3. Arquitetura de armazenamento

- BigQuery: Armazenamento em colunas com fragmentação automática

- Redshift: Distribuição baseada em nós com gerenciamento de fatias

- Synapse: Opções de rowstore e columnstore

4. Variações na estrutura de custos

- BigQuery: Pagamento por byte escaneado

- Redshift: Preços por hora baseados em nós

- Synapse: Preços baseados em DTU ou vCore

5. Recursos de integração

- BigQuery: Integração de serviços nativos do GCP

- Redshift: Integração do ecossistema da AWS

- Synapse: Serviços da plataforma Azure

Essas diferenças arquitetônicas afetam:

- Complexidade operacional

- Gerenciamento de recursos

- Previsibilidade de custos

- Otimização do desempenho

- Integração do ecossistema

Para obter uma abordagem estruturada para dominar esses conceitos, consulte o guia de aprendizado abrangente do Snowflake.

Aqui está uma tabela que resume essas diferenças:

| Aspecto | BigQuery | Redshift | Synapse | Floco de neve |

|---|---|---|---|---|

| Arquitetura | Sem servidor | Cluster-based | Híbrido (sem servidor e dedicado) | Multi-cluster, dados compartilhados |

| Armazenamento | Colunar com fragmentação automática | Distribuição baseada em nós | Rowstore e columnstore | Colunar microparticionado |

| Otimização de consultas | Automático, controle limitado | Vácuo/análise manual | Indexação manual e estatísticas | Otimização automática |

| Concorrência | Alocação baseada em slots | WLM baseado em filas | Classes de recursos | Dimensionamento de armazém virtual |

| Modelo de precificação | Por byte escaneado | Baseado em nós por hora | DTU/vCore-based | Uso do armazém por segundo |

| Integração | Serviços nativos do GCP | Ecossistema da AWS | Plataforma Azure | Suporte a várias nuvens |

| Gerenciamento de recursos | Automatizado | Gerenciamento manual de nós | Gerenciamento complexo de piscinas | Automatizado com controle manual |

| Suporte a tipos de dados | Fortemente semiestruturado | Semiestruturado limitado | Semiestruturado limitado | Nativo semiestruturado |

| Manutenção | Mínimo | É necessário aspirar regularmente | Necessidade de manutenção do índice | Manutenção zero |

| Armazenamento em cache | Automático 24 horas | Gerenciado pelo usuário | Incorporado limitado | Cache automático de resultados |

Conclusão

O Snowflake mudou a forma como as empresas trabalham com dados na nuvem, tornando-a mais fácil e mais eficiente do que os sistemas mais antigos. A forma como o Snowflake é construído permite que as empresas armazenem e processem seus dados separadamente, o que as ajuda a economizar dinheiro e, ao mesmo tempo, obter resultados rápidos. Graças aos sólidos recursos de segurança da Snowflake, as empresas podem ter certeza de que seus dados estão seguros. O sistema funciona sem problemas em diferentes provedores de nuvem, proporcionando às empresas mais flexibilidade no local onde mantêm seus dados.

Para quem quiser saber mais sobre o Snowflake, há muitos recursos úteis e materiais de treinamento disponíveis no DataCamp.

- Tutorial de floco de neve para iniciantes: Da arquitetura à execução de bancos de dados

- Introdução à modelagem de dados no curso Snowflake

- Como aprender o Snowflake em 2025: Um guia completo

A plataforma continua a crescer com novos recursos, como os de inteligência artificial, que a tornam ainda mais avançada para as empresas. As empresas que usam o Snowflake podem se adaptar rapidamente à medida que suas necessidades de dados mudam com o tempo. O futuro parece promissor para a Snowflake à medida que mais organizações a escolhem como sua principal plataforma para gerenciar dados.

Perguntas frequentes sobre a arquitetura Snowflake

O que torna a arquitetura da Snowflake diferente dos data warehouses tradicionais?

O Snowflake usa uma arquitetura exclusiva de três camadas que separa o armazenamento, a computação e os serviços. Ao contrário dos sistemas tradicionais que acoplam fortemente esses componentes, o design do Snowflake permite o dimensionamento independente, melhor gerenciamento de recursos e maior eficiência de custos.

Como o Snowflake lida com o acesso de usuários simultâneos?

O Snowflake gerencia o acesso simultâneo por meio de armazéns virtuais - clusters de computação independentes que podem ser ampliados ou reduzidos conforme necessário. Vários depósitos podem acessar os mesmos dados simultaneamente sem degradação do desempenho, enquanto a camada de serviços garante a consistência dos dados.

Qual é a arquitetura do medalhão em Snowflake?

A arquitetura medalhão é um padrão de organização de dados com três camadas: Bronze (dados brutos), Prata (dados padronizados) e Ouro (dados prontos para o negócio). Essa estrutura permite o refinamento progressivo dos dados, mantendo a linhagem de dados e o controle de qualidade.

Como funciona o sistema de armazenamento da Snowflake?

O Snowflake usa micropartições (blocos de 50 a 500 MB) armazenadas em um formato colunar com otimização automática. O sistema mantém metadados sobre o conteúdo de cada partição, permitindo o processamento eficiente de consultas por meio da redução de partições e do armazenamento em cache inteligente.

Como o Snowflake se compara a outros data warehouses em nuvem?

O Snowflake se diferencia dos concorrentes, como Redshift, BigQuery e Synapse, por meio de seu suporte a várias nuvens, recursos de otimização automática e modelo de preço exclusivo com base no uso do warehouse por segundo. Cada plataforma tem abordagens distintas para o gerenciamento de recursos e o processamento de consultas.

Sou um criador de conteúdo de ciência de dados com mais de 2 anos de experiência e um dos maiores seguidores no Medium. Gosto de escrever artigos detalhados sobre IA e ML com um estilo um pouco sarcástico, porque você precisa fazer algo para torná-los um pouco menos monótonos. Produzi mais de 130 artigos e um curso DataCamp, e estou preparando outro. Meu conteúdo foi visto por mais de 5 milhões de pessoas, das quais 20 mil se tornaram seguidores no Medium e no LinkedIn.